SUMÁRIO

1

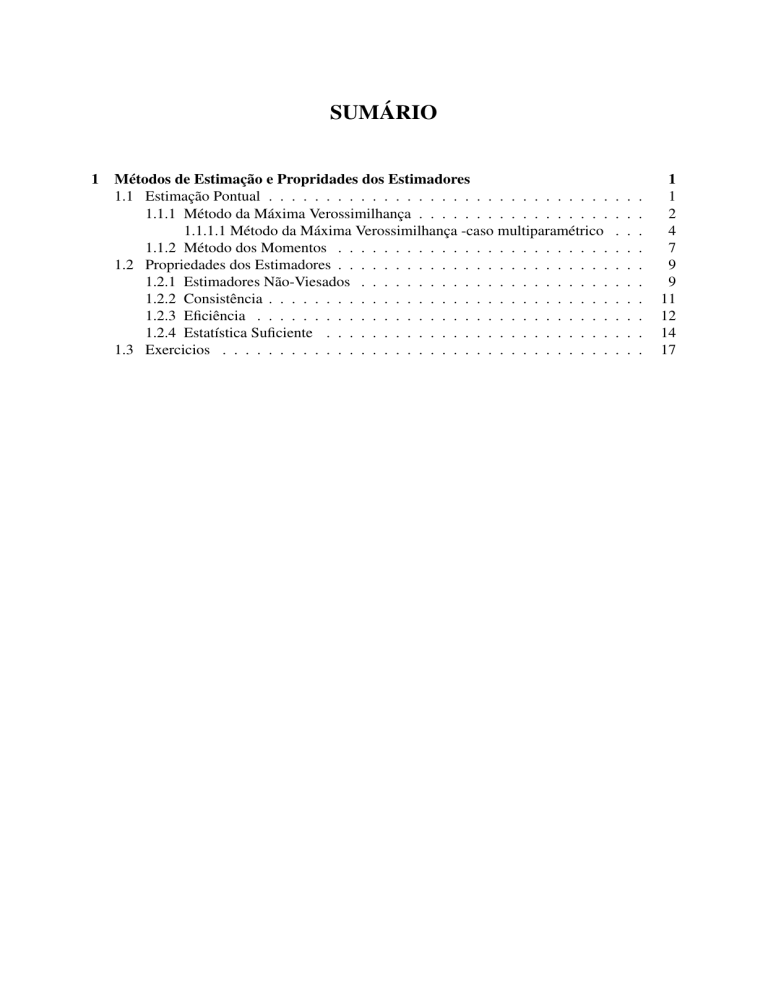

Métodos de Estimação e Propridades dos Estimadores

1.1 Estimação Pontual . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1.1 Método da Máxima Verossimilhança . . . . . . . . . . . . . . . . .

1.1.1.1 Método da Máxima Verossimilhança -caso multiparamétrico

1.1.2 Método dos Momentos . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Propriedades dos Estimadores . . . . . . . . . . . . . . . . . . . . . . . .

1.2.1 Estimadores Não-Viesados . . . . . . . . . . . . . . . . . . . . . .

1.2.2 Consistência . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2.3 Eficiência . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2.4 Estatística Suficiente . . . . . . . . . . . . . . . . . . . . . . . . .

1.3 Exercicios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

2

4

7

9

9

11

12

14

17

1

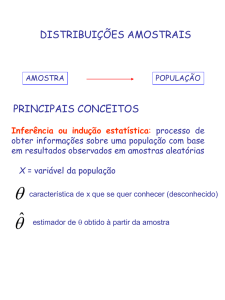

MÉTODOS DE ESTIMAÇÃO E PROPRIDADES DOS ESTIMADORES

Estimação é o processo que consiste em utilizar dados amostrais para estimar valores para

os parâmetros populacionais desconhecidos. Assumindo que uma característica dos elementos

numa população pode ser representada por uma variável aleatória X cuja função de densidade

ou probabilidade é f (x|θ ), , temos que:

θ é um parâmetro com valores desconhecidos. f (x|θ ) tem uma forma conhecida, exceto

pelo parâmetro θ Como θ ∈ Θ, sendo Θ o espaço paramétrico, temos uma familia de densidades, sendo cada valor de θ correspondente a um membro da familia.

Considerando x1 , ..., xn valores de uma amostra aleatória X1 , ..., Xn da variável aleatória X,

com f.d.p. ou f.p. f (x|θ ) O objetivo é a partir dos dados observados estimar um valor parâmetro

θ.

As estatísticas amostrais são utilizadas como estimativas de um parâmetro θ pode ser feita

por duas maneiras

• Estimação pontual - consiste na estimativa um única valor para o parâmetro θ

• Estimação intervalar - consiste na estimativa que especifica um intervalo de valores possíveis, no qual se admite que esteja o parâmetro θ .

Definição 1.1 (Estimação Pontual): Uma estimativa pontual de um parâmetro desconhecido θ é um valor obtido a partir da amostra (através de uma estatística) que se destina a

fornecer valores aproximados do parâmetro.

Definição 1.2 (Estimador): Um estimador θ̂ é uma estatística (i.e. função da amostra) que

fornece estimativas pontuais.

1.1

ESTIMAÇÃO PONTUAL

Seja uma amostra aleatoria X1 , ..., Xn com f.d.p. ou f.p. f (x|θ ) O problema é definir uma

estatística T = T (X1 , ..., Xn ) de tal modo que, após observarmos X1 = x1 , ..., Xn = xn , T =

T (X1 , ..., Xn ) seja uma boa estimativa pontual de θ Para definir a estatística T = T (X1 , ..., Xn ), é

utilizado métodos de estimação, sendo os principais:

Métodos de Estimação e Propridades dos Estimadores

2

• Método da Máxima Verossimilhança

• Método dos momentos

• Método dos Mínimos Quadrados.

1.1.1

Método da Máxima Verossimilhança

Definição 1.3 (Função de Verossimilhança): Se uma amostra aleatória X1 , ..., Xn são variáveis aleatórias independentes e identicamente distruídas (i.i.d) com f.d.p. ouf.p.) f (x|θ ), sua

função de verossimilhança é dada por:

n

L(θ ; x) = f (x1 , ..., xn |θ ) = f (x1 |θ )... f (xn |θ ) = ∏ f (xi |θ )

i=1

Definição 1.4 (Função de Log-Verossimilhança): O logaritmo natural da função de verossimilhança é denominado função de log-verossimilhança e é denotado por

l(θ ; x) = lnL(θ ; x)

A função de densidade (ou de probabilidade) é função da variável aleatória X, assumindo

que o parâmetro θ é conhecido.

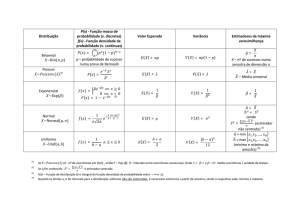

Distribuição Poisson

f (x|λ ) = e−λ

λx

, x = 0, 1, 2, 3, ..., λ ≥ 0

x!

Distribuição Normal

(x−µ)2

1

−

f (x|µ, σ 2 ) = √

e 2σ 2 , −∞ < x < ∞

2πσ 2

A função de densidade se torna uma função de verossimilhança quando os valores da variável X são conhecidos e o valor de parâmetro é desconhecido

os valores da variável X são conhecidos, a função passa a depender do valor do parâmetro

desconhecido θ

Distribuição Poisson - considerando X = 10

L(λ |X = 10) = e−λ

λ 10

10!

Distribuição Normal - considerando X = 2, 5

(2,5−µ)2

1

−

e 2σ 2

L(µ, σ 2 |X = 2, 5) = √

2πσ 2

Métodos de Estimação e Propridades dos Estimadores

3

A função de densidade se torna uma função de verossimilhança quando os valores da variável X são conhecidos e o valor de parâmetro é desconhecido

Definição 1.5 (Função Escore): A função escore, denotada por U(θ ), é definida como a

primeira derivada da função de log-verossimilhança em relação θ

U(θ ) =

∂ l(θ ; x)

∂θ

Definição 1.6 (Função de Informação): A função de informação, denotada por I(θ ), é definida como menos a segunda derivada da função de log-verossimilhança em relação θ

∂ 2 l(θ ; x)

I(θ ) = −

∂θ2

Definição 1.7 (Estimador de Máxima Verossimilhança): O estimador de máxima verossimilhança de θ é o valor θ̂ que maximiza a função de verossimilhança L(θ ; x)

O valor de θ que maximiza a função de verossimilhança L(θ ; x), também maximiza l(θ ; x),

assim pode-se utilizar a função de log-verossimilhança. Como encontrar o estimador de máxima

verossimilhança

1. Encontrar a função de verossimilhança L(θ ; x) e log-verossimilhança l(θ ; x);

2. Encontrar a função Escore U(θ ) e iguala-la a zero para obter o estimador

3. Encontrar a função de informação e verificar se o estimador é ponto de máximo.

Exemplo 1.1 (Bernoulli): Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼

Bernoulli(θ ). Obter o estimador de máxima verossimilhança para θ .

Função de probabilidade

f (x) = θ x (1 − θ )1−x , x = 0, 1 Θ = θ ; 0 < θ < 1

Função de verossimilhança e log-verossimilhança

n

n

L(θ ; x) = θ ∑i=1 xi (1 − θ )n−∑i=1 xi

n

l(θ ; x) =

∑ xilnθ +

i=1

!

n

n − ∑ xi ln(1 − θ )

i=1

Função escore

n

n

n − ∑ xi

∑ xi

U(θ ) =

∂ l(θ ; x) i=1

=

∂θ

θ

−

i=1

1−θ

Métodos de Estimação e Propridades dos Estimadores

4

Igualando a função escore a zero e resolvendo em relação θ , temos

n

n

n

n − ∑ xi

∑ xi

i=1

i=1

−

1 − θ̂

θ̂

∑ xi

= 0 ⇒ θ̂ =

i=1

n

Função de Informação

n

∑ xi

I(θ ) = −

n

n − ∑ xi

∂ 2 l(θ ; x) i=1

i=1

= 2 +

>0

∂θ2

θ

(1 − θ )2

Assim, o estimador de maxima verossimilhança é dador por:

n

∑ xi

θ̂ =

i=1

n

Exemplo 1.2 (Uniforme continua): Sejam X1 , ..., Xn uma amostra aleatória da variável ale

atória X ∼ Uni f orme θ − 21 , θ + 12 . Obter o estimador de máxima verossimilhança para θ .

Função de probabilidade

f (x) =

1

I (x), a ≤ x ≤ b

b − a [a,b]

Função de verossimilhança

n

L(θ ; x) =

n

∏ I[θ − 12 ,θ + 12 ](xi) = ∏ I[x(n)− 12 ,x(1)+ 21 ](θ )

i=1

i=1

Como a função de verossimilhança é constante no intervalo de x(n) − 12 , x(1) + 12 , qualquer

ponto desse intervalo é um estimado de maxima verossimilhança para θ

Assim, o estimador de maxima verossimilhança é dador por:

1

2

1

θ̂ = x(1) +

2

x(n) + x(1)

θ̂ =

2

θ̂ = x(n) −

1.1.1.1

Método da Máxima Verossimilhança -caso multiparamétrico

Definição 1.8 (Vetor Escore): O vetor escore, denotada por U(θ ), é definida como as derivadas parciais de primeira ordem da função de log-verossimilhança em relação a cada θi

∂ l(θ ; x)

∂ l(θ ; x)

U(θ ) =

, ...,

∂ θ1

∂ θk

Métodos de Estimação e Propridades dos Estimadores

5

Definição 1.9 (Matrix de Informação de Fisher): A matrix de informação, denotada por

I(θ ), é definida como menos das derivadas parciais de segunda ordem da função de logverossimilhança em relação a cada θi

∂ 2 l(θ ;x)

2

;x)

... − ∂∂ l(θ

− ∂θ2

θ

θ

1 k

1

..

..

I(θ ) =

..

.

.

.

2

;x)

− ∂∂ l(θ

θ θ

... − ∂

k 1

2 l(θ ;x)

∂ θk2

Seja θ = (θ1 , θ2 , ..., θk ) um vetor de parâmetros de dimensão k. O estimador de máxima

verossimilhança de θ1 , θ2 , ..., θk ) são obtidos como soluções das equações:

∂ L(θ ; x)

=0

∂ θi

Na obtenção do estimador de máxima verossimilhança duas verificações são importantes

i) verificar se a solução esta em no espaço paramétrico Θ

ii) verificar se a solução é máximo local de l(θ ; x)

Para verificar a condição ii, é suficiente que U(θ ) = 0 e que a matriz de informação de fisher

I(θ ) seja positiva definida

a11 a12 ... a1n

a21 a22 ... a2n

Uma matriz A =

.. . .

..

..

é positiva definida se as submatrizes A1 , A2 , A3 , ...An

.

.

.

.

an1 an2 ... ann

têm determinantes forem positivos.

"

#

a11 a12 a13

a11 a12

Sendo: A1 = [a11 ], A2 =

, A3 = a21 a22 a23 ,..., An = A

a21 a22

a31 a32 a33

Exemplo 1.3 (Normal): Vetor Escore

" ∂ l(µ,σ 2 ;x) #

U(µ, σ 2 ) =

∂µ

∂ l(µ,σ 2 ;x)

∂σ2

=

n

1

σ2

∑ (xi − µ)

i=1

− 2σn 2 + 2(σ12 )2

n

∑ (xi − µ)2

i=1

Igualando o vetor score a zero e resolvendo em relação µ e σ 2 , temos

Métodos de Estimação e Propridades dos Estimadores

6

n

1 n

∑ (xi − µ̂) = 0 ⇒ µ̂ =

σ̂ 2 i=1

∑ xi

i=1

n

=X

n

n

−

1

n

+

∑ (xi − µ̂)2 = 0 ⇒ σ̂ 2 =

2

2σ̂

2(σ̂ 2 )2 i=1

∑ (xi − X)2

i=1

n

Matriz de Informação

n

∂ 2 l(µ,σ 2 ;x)

∂ µ2

2

I(µ, σ ) = ∂ 2 l(µ,σ

2 ;x)

∂ σ 2µ

n

∂ 2 l(µ,σ 2 ;x)

σ2

2

∂ µσ

=

∂ 2 l(µ,σ 2 ;x)

n

∂ (σ 2 )2

(x − µ)

∑ i

∑ (xi − µ)

i=1

i=1

(σ 2 )2

n

2

(x

−

µ)

∑ i

(σ 2 )2

− 2(σn2 )2 + i=1

(σ 2 )3

n

(n−1)

∑ (xi − µ)2

2

i=1

|A1 | = σn2 > 0 |A2 | =

− 2(σn 2 )3 > 0

(σ 2 )4

Assim, o estimador de maxima verossimilhança é dador por:

n

∑ xi

µ̂ =

i=1

n

=X

n

∑ (xi − X)2

σ̂ 2 =

i=1

n

Teorema 1.1 (Princípio da invariância): Sejam X1 , ..., Xn uma amostra aleatória da variável

aleatória X com função de densidade (ou de probabilidade) f (x|θ ). Se θ̂ é um estimador de

máxima verossimilhança de θ , então g(θ̂ ) é um estimador de máxima verossimilhança de g(θ ).

Exemplo 1.4: Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼ N(µ, σ 2 ),

n

∑ (xi − X)2

então o estimador σ 2 = é σ̂ 2 =

v

u n

u (x − X)2

t∑ i

dado por σ̂ = i=1 n

i=1

n

. Assim, o estimador do desvio padrão σ =

√

σ2 é

Métodos de Estimação e Propridades dos Estimadores

1.1.2

7

Método dos Momentos

Definição 1.10 (Momentos Populacionais): Se X é uma variável aleatória, o r-ésimo momento de X é definido como, denotado por µr , é definido como

µr = E[X r ]

Definição 1.11 (Momentos Amostrais): Seja X1 , ..., Xn uma amostra aleatória da variável

aleatória X, com f.d.p. ou f.p. f (x|θ ). Então o r-ésimo momento amostral, denotado por mr , é

definido por:

n

∑ Xir

mr =

i=1

n

Definição 1.12 (Estimador pelo Método dos Momentos): O estimador pelo método dos

momento de θ é o valor θ̂ se ele for solução das equações

µr = mr , r = 1, 2, 3, ..., k

Exemplo 1.5 (Bernoulli): Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼

Bernoulli(θ ). Obter o estimador pelo método dos momentos para θ .

Função de probabilidade

f (x|θ ) = θ x (1 − θ )1−x , x = 0, 1 Θ = θ ; 0 < θ < 1

Momentos populacionais

E[X] = θ ⇒ µ1 = θ

Assim,

n

∑ Xi

u1 = m1 ⇒ θ̂ =

i=1

n

Exemplo 1.6 (Normal): Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼

N(µ, σ 2 ). Obter o estimador pelo método dos momentos para µ e σ 2 .

Função de densidade

(x−µ)2

1

−

e 2σ 2 , x ∈ R, µ ∈ R, σ 2 > 0

f (x|µ, σ 2 ) = √

2πσ 2

Métodos de Estimação e Propridades dos Estimadores

8

Momentos populacionais

E[X] = µ ⇒ µ1 = µ

V (X) = σ 2 ⇒ E[X 2 ] − (E[X])2 = σ 2

E[X 2 ] = σ 2 + (E[X])2 ⇒ σ 2 + µ 2

µ2 = σ 2 + µ12

Assim,

n

∑ Xi

µ1 = m1 ⇒ µ̂ =

i=1

n

µ2 = m2 ⇒ σ̂ 2 + µ12 =

=X

∑ni=1 Xi2

n

n

∑ (Xi − X)2

σ̂ 2 =

i=1

n

Exemplo 1.7 (Gama): Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼

Gama(λ , r). Obter o estimador pelo método dos momentos para λ e r.

Função de densidade

λ

(λ x)r−1 e−λ x x ≥ 0, λ > 0, r > 0

f (x|λ , r) =

Γ(r)

Momentos populacionais

r

r

⇒ µ1 =

λ

λ

r

r

2

V (X) =

⇒ E[X ] − (E[X])2 = 2

2

λ

λ

r 2

r

r

+ (E[X])2 = 2 +

E[X 2 ] =

λ2

λ

λ

2

r

r

µ2 =

+

2

λ

λ

E[X] =

Assim,

Métodos de Estimação e Propridades dos Estimadores

9

n

r̂

µ1 = m1 ⇒

∑ Xi

i=1

=

n

λ̂

r̂

= X ⇒ r̂ = X λ̂

λ̂

n

µ2 = m2 ⇒

λ̂ =

r̂

λ̂ 2

+

2

r̂

∑ Xi2

=

i=1

λ̂

X

r̂ =

n

2

∑ (xi − X)

i=1

n

X

n

∑ (xi − X)2

i=1

n

1.2

2

n

PROPRIEDADES DOS ESTIMADORES

Existem vários estimadores para um certo parâmetro. Assim surge as seguintes perguntas:

• O que é um bom estimador?

• Como escolher entre os várias estimadores existentes?

• Quais serão os critérios usados para comparar estimadores e caracterizar os bons estimadores?

As principais qualidades de um estimador devem ser:

• Ausência de vício (estimador não-viciado);

• Consistência (estimador consistente);

• Eficiência (estimador de variância mínima);

• Suficiência (estimador suficiente).

1.2.1

Estimadores Não-Viesados

Definição 1.13 (Estimador não-viesado): Um estimador θ̂ é dito não-viesado (viciado)

para θ se E[θ̂ ] = θ , para todo θ ∈ Θ

Definição 1.14 (Viés ou Vicio): O viés de um estimador θ̂ , denotado por B(θ̂ ), é definido

como

B(θ̂ ) = E[θ̂ ] − θ

.

Definição 1.15 (Estimador assintoticamente não-viesado): Um estimador θ̂ é dito ser assintoticamente não-viesado (viciado) se lim B(θ̂ ) = 0, para todo θ ∈ Θ

n→∞

Métodos de Estimação e Propridades dos Estimadores

10

Definição 1.16 (Erro Quadrático Médio (EQM)): O erro quadrático médio de um estimador

θ̂ é dado por:

EQM[θ̂ ] = E (θ̂ − θ )2

O EQM é medida de da qualidade do estimador, sendo uma composição da variância e viés

do estimador.

2

EQM[θ̂ ] = V (θ̂ ) + B(θ̂ )

Para estimador não-viesados o EQM coincide com a variância do estimador

EQM[θ̂ ] = V (θ̂ )

O Erro quadrático médio é comumente empregado para comparar dois estimadores θ̂1 e θ̂2 .

θ̂1 será o melhor estimador se θ̂2

EQM[θ̂1 ] ≤ EQM[θ̂2 ]

Exemplo 1.8 (Normal): Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼

N(µ, σ 2 ). Temos que o estimador de maxima verossimilhança de µ e σ 2 são dados por:

n

n

∑ (xi − X)2

∑ xi

µ̂ =

i=1

n

=X

σ̂ 2 =

i=1

n

Para o estimador de µ temos que

E X = µ

σ2

V X =

n

Assim, X é um estimador não-viesado para µ

Com relação ao estimador da variância temos que:

E σ̂ 2 =

1

σ2

n−1 2

2

nσ − n

=

σ

2

n

n

n

Assim σ̂ 2 é um estimador viesado para σ 2 , sendo o viés dado por:

B(σ̂ 2 ) =

n−1 2

σ2

σ −σ2 = −

n

n

Fazendo lim B(σ̂ 2 ) = 0, verificamos que σ̂ 2 é assintoticamente não-viesado

n→∞

Métodos de Estimação e Propridades dos Estimadores

11

A variância do estimador σ 2 é dada por

σ4

(n − 1)S2

V [σ̂ ] =

V

n2

σ2

2

Como

(n − 1)S2

2

∼ χn−1

σ2

Então

σ4

(n − 1)S2

V [σ̂ ] =

V

n2

σ2

σ4

2(n − 1) 4

=

2(n − 1) =

σ

2

n

n2

2

Assim o EQM é dado por:

2

2(n − 1) 4

σ2

2n − 1 4

EQM[σ̂ ] =

σ + −

=

σ

2

n

n

n2

2

Para obter um estimador não viesado para σ 2 que seja função de σ̂ 2 , temos

g(σ̂ 2 ) =

Assim

n

σ̂ 2

n−1

n

n

2

E

σ̂ =

E σ̂ 2 = σ 2

n−1

n−1

g(σ̂ 2 ) é um estimador não-viesado para σ 2 , sendo que:

n

g(σ̂ 2 ) =

n

σ̂ 2 =

n−1

∑ (Xi − X)2

i=1

n−1

= S2

Desta forma S2 é um estimador não-viesado para σ 2 e sua variância é dada por:

σ4

(n − 1)S2

(n − 1) σ 2 2

V [S ] = V

S =

V

(n − 1) σ 2

(n − 1)2

σ2

σ4

2σ 4

=

2(n

−

1)

=

(n − 1)2

n−1

2

1.2.2

Consistência

Definição 1.17 (Estimador Consistente): Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X que depende do parâmetro θ . Um estimador θ̂ = θ̂ (X1 , ..., Xn ) é dito consistente

para o parâmetro θ se

lim P |θ̂ − θ | ≥ ε = 0

n→∞

Métodos de Estimação e Propridades dos Estimadores

12

Para verificar essa propriedade em geral utiliza-se a desigualdade de Chebychev.

Consistência não implica em não-viés assintótico.

As condições gerais para a consistência de um estimador θ̂ são:

lim E[θ̂ ] = θ

n→∞

lim V [θ̂ ] = 0

n→∞

Exemplo 1.9 (Normal): Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼

N(µ, σ 2 ). Considerando X e S2 estimadores para µ e σ 2 ,verificar a consistência dos estimadores

Pela desigualdade de Chebychev, temos que:

σ2

V (X)

=

P |X − µ| ≥ ε ≤

ε2

nε 2

2

σ

lim P |X − µ| ≥ ε ≤ lim 2 = 0

n→∞

n→∞ nε

Assim X é consistente para µ

Para S2 pela desigualdade de Chebychev, temos que:

V (S2 )

2σ 4

P |S2 − σ 2 | ≥ ε ≤

=

ε2

(n − 1)ε 2

2σ 4

=0

lim P |S2 − σ 2 | ≥ ε ≤ lim

n→∞

n→∞ (n − 1)ε 2

Assim S2 é consistente para σ 2

1.2.3

Eficiência

Definição 1.18 (Informação de Fisher): O informação de Fisher, denotado por IF (θ ), é

definida a como :

"

#

∂ l(θ ; x) 2

IF (θ ) = E

∂θ

Propriedade da função escore e da Informação de Fisher

• A média da função escore é 0,

E [U(θ )] = 0

• A informação de Fisher de θ é igual a variância da função escore

V [U(θ )] = E (U(θ ))2 = E

"

∂ l(θ ; x)

∂θ

2 #

= IF (θ )

Métodos de Estimação e Propridades dos Estimadores

13

• Se a verossimilhança é duas vezes diferenciável então a informação de Fisher também

pode ser obtida como

"

IF (θ ) = E

∂ l(θ ; x)

∂θ

2 #

2

∂ l(θ ; x)

=E −

∂θ2

Teorema 1.2 (Desigualdade Informação ou Desigualdade de Cramér-Rao): Sejam X1 , ..., Xn

uma amostra aleatória da variável aleatória X e θ̂ um estimador não-viesado de θ . Sob condições de regularidade

1

V [θ̂ ] ≥

IF (θ )

A parte direita de desigualdade é denominada cota inferior de Cramer-Rao e expressa uma

cota inferior para a variância de um estimador não-viesado.

Definição 1.19 (Eficiência): A eficiência de um estimador θ̂ , não viesado para o parâmetroθ

é dada pelo quociente

LI(θ )

e(θ̂ ) =

V [θ̂ ]

1

sendo

LI(θ ) =

IF (θ )

Definição 1.20 (Estimador Eficiente): Um estimador θ̂ é dito eficiente se for não viesado e

sua variância atingir o limite inferior da desigualdede de Cramer-Rao para todos os possíveis

valores de θ .

• Se V [θ̂ ] = LI(θ ) então e(θ̂ ) = 1

Definição 1.21 (Estimador Não-Viesado de Variância Uniformemente Mínima (ENVVUM)):

Sejam X1 , ..., Xn uma amostra aleatória da distribuição da variável aleatória X com função de

densidade (ou de probabilidade) f (x|θ ). Um estimador T = t(X1 , ..., Xn ) de g(θ ) é dito ser um

estimador não-viesado de variância uniformemente mínima de g(θ ) se, somente se,

i) E[T ] = g(θ ), isto é um estimador não-viesado para g(θ ), e

ii) V [T ] ≤ V [U] para qualquer outro estimador U não-viesado de g(θ )

• Se variância de um estimador atingir o limite inferior da desigualdade de Cramer-Rao,

então o estimador é um ENVVUM.

Exemplo 1.10: Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼ Bernoulli(θ ),

n

∑ xi

e seja θ̂ =

i

n

um estimador para θ .

Métodos de Estimação e Propridades dos Estimadores

14

• A Variância do estimador

n

n

n − ∑ xi

∑ xi

V [θ̂ ] =

∂ l(θ ; x) i=1

=

∂θ

θ

i=1

−

1−θ

• Função escore

n

n

n − ∑ xi

∑ xi

U(θ ) =

∂ l(θ ; x) i=1

=

∂θ

θ

−

i=1

1−θ

• Função de Informação

n

I(θ ) = −

∂ 2 l(θ ; x)

∂θ2

n

n − ∑ xi

∑ xi

=

i=1

θ2

+

i=1

(1 − θ )2

• Informação de Fisher

n

n

∑ xi

∑i xi n − i=1

n

=

IF I(θ ) = E[I(θ )) = 2 +

2

θ

(1 − θ )

θ (1 − θ )

• Assim temos que θ̂ é eficiente e ENVVUM :

V [θ̂ ] =

1.2.4

1

IF I(θ )

Estatística Suficiente

Definição 1.22 (Princípio da Suficiência): Seja X uma variável aleatória e seja T (.) uma

estatística obtida como função dos valores amostrais de X, assim,

• T (X1 , ..., Xn ) é suficiente para θ , então qualquer inferência sobre θ dependerá apenas da

amostra X1 , ..., Xn somente através de T (X1 , ..., Xn ).

• Isto é dadas duas realizações amostrais distintas X1 , ..., Xn e X10 , ..., Xn0 , tais que

T (X1 , ..., Xn ) = T (X10 , ..., Xn0 )

então as inferências sobre θ são as mesmas, independente de observamos X1 , ..., Xn ou

X10 , ..., Xn0 .

Definição 1.23 (Estatística suficiente): Dizemos que a estatística T (X1 , ..., Xn ) é suficiente

para θ , quando a distribuição condicional de X1 , ..., Xn dado T for independente de θ

Métodos de Estimação e Propridades dos Estimadores

15

Exemplo 1.11: Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼ Bernoulli(θ ).

n

Verificar se T = ∑ Xi é suficiente para θ

i=1

P[X1 = x1 , ..., Xn = xn , T = t]

P[T = t]

P[X1 = x1 , ..., Xn = xn ]

=

n t

n−t

t θ (1 − θ )

θ t (1 − θ )n−t

= n t

n−t

t θ (1 − θ )

1

= n

f (X1 , ..., Xn = xn |T = t) =

t

n

Assim, T = ∑ Xi é suficiente para θ

i=1

Exemplo 1.12: Sejam X1 , X2 , X3 uma amostra aleatória de tamanho 3 da variável aleatória

n

X ∼ Bernoulli(θ ). Verificar se T = ∑ X1 X2 + X3 é suficiente para θ

i=1

As probabilidades condicionais podem ser calculadas da seguinte forma:

P[X1 = 0, X2 = 0, X3 = 0, T = 0]

P[T = 0]

p(1 − p)3

=

(1 − p)3 + 2(1 − p)2 p

f (X1 = 0, X2 = 0, X3 = 0|T = 0) =

Sendo

P[T = 0] = P[X1 = 0X2 = 0, X3 = 0] + P[X1 = 0, X2 = 1, X3 = 0] +

+P[X1 = 1, X2 = 0, X3 = 0]

Assim

Métodos de Estimação e Propridades dos Estimadores

(X1 , X2 , X3 ) T

(0, 0, 0)

0

(0, 0, 1)

1

(0, 1, 0)

0

(1, 0, 0)

0

(0, 1, 1)

1

(1, 0, 1)

1

(1, 1, 0)

1

(1, 1, 1)

2

16

f (X1 , X2 , X3 |T )

1− p

1+ p

1− p

1 + 2p

p

1+ p

p

1+ p

p

1 + 2p

p

1 + 2p

p

1 + 2p

1

Como a distribuição de depende θ conclui-se que T não é uma estatística suficiente para θ

Teorema 1.3 (Critério da Fatoração): Sejam X1 , ..., Xn uma amostra aleatória da distribuição da variável aleatória X com função de densidade (ou de probabilidade) f (x|θ ), em que e a

função de verosimilhança L(θ |x). Temos, então, que a estatística T = T (X1 , ..., Xn ) é suficiente

para θ , se e somente se pudermos escrever

L(θ |x) = h(x1 , ..., xn )gθ (T (x1 , ..., xn ))

em que h(x1 , ..., xn ) é uma função que só depende de x1 , ..., xn e gθ (T (x1 , ..., xn )) é uma função

que depende de θ e de x1 , ..., xn somente através da função t. As funções h e g são funções

não-negativas.

Exemplo 1.13: Sejam X1 , ..., Xn ma amostra aleatória da variável aleatória X ∼ Poisson(θ ).

Temos que

n

n

n

θ xi

1

L(θ |x) = e−nθ ∏

= ∏ e−nθ θ ∑ i=1 xi

i=1 xi !

i=1 xi !

Tomando

n

1

i=1 xi !

h(x1 , ..., xn ) = ∏

e

gθ (T (x1 , ..., xn )) = e−nθ θ ∑ i=1

nx

i

n

Temos, pelo critério da fatoração, temos que T = ∑ Xi é suficiente para θ .

i=1

Teorema 1.4 (Critério da Fatoração - caso multiparamétrico): Sejam X1 , ..., Xn uma amostra

aleatória da distribuição da variável aleatória X com função de densidade (ou de probabilidade) f (x|θ ), em que θ pode ser um vertor, e a função de verosimilhança L(θ |x). Seja as

estatística Ti = ti (X1 , ..., Xn ), com i = 1, 2, ..., r. Então a estatística T = (T1 , T 2, ...Tr ) é conjun-

Métodos de Estimação e Propridades dos Estimadores

17

tamente suficiente para θ , se e somente se pudermos escrever

L(θ |x) = h(x1 , ..., xn )gθ (T1 (x), ..., Tr (x))

em que h(x1 , ..., xn ) é uma função que só depende de x1 , ..., xn e gθ (T1 (x), ..., Tr (x) é uma função

que depende de θ e de x1 , ..., xn somente através das funções t1 , ...,tn . As funções h e g são

funções não-negativas.

Exemplo 1.14: Sejam X1 , ..., Xn uma amostra aleatória da variável aleatória X ∼ N(µ, σ 2 ).

Temos, então que θ = (µ, σ 2 ). Nesta caso, a função de verossimilhança pode ser escrita como:

n

n

2 − 1 ∑ (x −µ)2

1

2

2σ 2 i=1 i

e

L(µ, σ ; x) =

2πσ 2

n

2

n

n

1 2 1 − 2σ1 2 ∑ xi2 + σµ2 ∑ xi2 −n σµ 2

i=1

i=1

=

n e

2π

σ2

com −∞ < µ < ∞ e σ 2 > 0

Sendo

h(x1 , ..., xn ) =

1

2π

n

2

−

gθ (t1 (x),t2 (x)) = e

µ2

1 n 2 µ n 2

∑ x +

∑ x −n 2

2σ 2 i=1 i σ 2 i=1 i

σ

Assim, pelos critério da fatoração temos que a estatística T = (∑ni=1 Xi , ∑ni=1 Xi2 ) é conjuntamente suficiente para θ = (µ, σ 2 ).

1.3

EXERCICIOS

1.1) Uma variável aleatória X tem função de densidade de probabilidade dada por:

f (x) = (θ + 1)xθ , 0 < x < 1 θ > −1

Foi retirada uma amostra amostra de tamanho 6, x1 = 0, 3; x2 = 0, 8; x3 = 0, 27; x4 = 0, 35;

x5 = 0, 62 e x6 = 0, 55

a) Obtenha o estimador de máxima de verossimilhança e calcule a estimativa de θ para a

amostra. baseado numa amostra de tamanho n.

b) Obtenha o estimador pelo método dos momentos e calcule a estimativa de θ para a amostra.

1.2) Uma amostra de tamanho n1 é obtida de uma população com distribuição normal com

média µ1 e variancia σ12 . Uma segunda amostra de tamanho n2 é obtida de uma população com

distribuição normal com média µ2 e variancia σ22 .

a) Qual o estimador de máxima de verossimilhança de θ = µ1 − µ2 .

Métodos de Estimação e Propridades dos Estimadores

18

b) Verifique a consistência do estimador obtido no item a

1.3) O raio do círculo é medido com um erro de medição, que tem distribuição normal N(0, σ 2 ),

sendo σ 2 desconhecido. Dado que n medições independentes do raio, encontrar um estimador

não viesado da área do círculo.

1.4) Seja X uma observação simples de Bernoulli. Seja dois estimadores de θ T1 (X) = X e

T2 (X) = 12 .

a) Ambos os estimadores são não viesados:

b) Compare os erros quadráticos médios dos estimadores

1.5) Sejam X1 , ..., Xn uma amostra aleatória de variáveis aleatórias independentes e identicamente distribuídas (i.i.d.) com função de densidade dada por:

f (x|θ ) = θ x−2

x>θ

θ >0

a) Obtenha o estimador de máxima de verossimilhança de θ

b) Verifique se o estimador do item a é não viesado

1.6) Sejam X1 , ..., Xn uma amostra aleatória de variáveis aleatórias independentes e identicamente distribuídas (i.i.d.) com distribuição gamma(r, λ ), considere que o parametro r é conhecido.

a) Encontre uma estatística suficiente para λ

b) Encontre o estimador de máxima de verossimilhança para λ

1.7) Sejam X1 , ..., Xn uma amostra aleatória de variáveis aleatórias independentes e identicamente distribuídas (i.i.d.) com distribuição dada por:

f (x|θ ) = θ xθ −1 ,

0 < x < 1,

θ >0

a) Encontre o estimador de máxima de verossimilhança para µ =

θ

1+θ

b) Encontre o estimador UMVUE para θ

c) Encontre o estimador pelo método dos mínimos quadrados para θ e verifique sua consistencia

1.8) Sejam X1 , ..., Xn uma amostra aleatória de uma distribuição uniforme no intervalo (θ , θ +

1). Seja

1

n

θ̂1 = X −

e θ̂2 = X(n) −

2

n+1

a) Verifique se os estimadores são viesados.

Métodos de Estimação e Propridades dos Estimadores

b) Compare os estimadores pelo erro quadrático médio.

c) Compare a eficiência dos estimadores.

19