Probabilidade 1

José Carlos Fogo

Junho 2014

Teoria da Probabilidade

Sumário

Sumário

1 Conceitos Básicos e Definições

3

1.1 Relações entre conjuntos . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

1.2 Algumas definições em probabilidade: . . . . . . . . . . . . . . . . . . . . .

6

1.3 Medidas de probabilidade . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

1.3.1 Axiomas de Kolmogorov e espaço de probabilidade . . . . . . . . .

9

1.4 Propriedades das probabilidades . . . . . . . . . . . . . . . . . . . . . . . . 11

1.5 Probabilidade condicional e teorema de Bayes . . . . . . . . . . . . . . . . 15

1.5.1 Probabilidade condicional . . . . . . . . . . . . . . . . . . . . . . . . 16

1.5.2 Teorema de Bayes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

1.5.3 Independência de eventos . . . . . . . . . . . . . . . . . . . . . . . . 24

1.6 Contagem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

1.6.1 Amostras ordenadas

. . . . . . . . . . . . . . . . . . . . . . . . . . . 29

1.6.2 Permutações . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

1.6.3 Amostras Desordenadas . . . . . . . . . . . . . . . . . . . . . . . . . 33

1.6.4 Partições . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

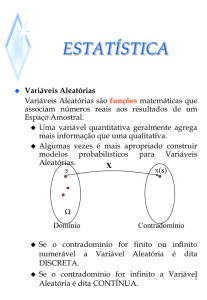

2 Variáveis Aleatórias

42

2.1 Variáveis Aleatórias Discretas . . . . . . . . . . . . . . . . . . . . . . . . . . 43

2.2 Principais modelos de discretos . . . . . . . . . . . . . . . . . . . . . . . . . 48

2.2.1 Variável Aleatória Constante . . . . . . . . . . . . . . . . . . . . . . . 48

2.2.2 Distribuição uniforme discreta . . . . . . . . . . . . . . . . . . . . . . 49

2.2.3 Distribuição de Bernoulli . . . . . . . . . . . . . . . . . . . . . . . . . . 51

2.2.4 Distribuição binomial . . . . . . . . . . . . . . . . . . . . . . . . . . . 52

2.2.5 Distribuição geométrica . . . . . . . . . . . . . . . . . . . . . . . . . . 56

2.2.6 Distribuição binomial negativa . . . . . . . . . . . . . . . . . . . . . . 60

2.2.7 Distribuição hipergeométrica . . . . . . . . . . . . . . . . . . . . . . . 62

2.2.8 Distribuição de Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . 67

2.2.9 Distribuições discretas no R . . . . . . . . . . . . . . . . . . . . . . . 73

3 Valor esperado e momentos de uma v.a. discreta

76

3.1 Valor esperado de uma v.a. discreta . . . . . . . . . . . . . . . . . . . . . . . 76

3.2 Propriedades de Esperança . . . . . . . . . . . . . . . . . . . . . . . . . . . 78

3.3 Variância de uma v.a. discreta . . . . . . . . . . . . . . . . . . . . . . . . . . 82

3.3.1 Propriedades de Variância . . . . . . . . . . . . . . . . . . . . . . . . 83

3.3.2 Covariância e coeficiente de corelação . . . . . . . . . . . . . . . . . 85

2

Teoria da Probabilidade

1

Conceitos Básicos e Definições

Conceitos Básicos e Definições

Estudos de fenômenos ou experimentos aleatórios

⇓

Busca-se avaliar a probabilidade

de ocorrência desses fenômenos.

APLICAÇÕES:

• teoria dos jogos

• evolução de doenças

• controle de defeitos • evolução do crescimento populacional

• teoria da decisão

• indústria bélica

1.1

Relações entre conjuntos

i) UNIÃO: Notação A ∪ B ,

sejam A e B eventos quaisquer, a união entre A e B é dada pelos elementos que

pertencem a A ou a B ;

ii) INTERSECCÃO: Notação A ∩ B ou AB ,

sejam A e B conjuntos quaisquer, a intersecção entre A e B é dada pelos elementos

que pertencem simultaneamente a A e a B ;

iii) COMPLENTAR: Notação Ac ;

sejam A e B conjuntos tais que A ⊂ B , então, o evento complementar Ac de A, em

relação à B , é dado pelos elementos de B que não pertencem a A, ou seja, A∪Ac = B ;

iv) DIFERENÇA: Notação B − A;

sejam A e B conjuntos quaisquer, então, a diferença B − A é dada pelos elementos de

B que não pertencem a A, ou seja, B − A = B ∩ Ac = BAc ;

Nota: Se B ⊃ A, então, B − A = Ac ;

v) DIFERENÇA SIMÉTRICA: Notação A M B ;

é dada pelos elementos que pertencem exclusivamente a A ou a B , ou seja,

A M B = (A ∩ B c ) ∪ (Ac ∩ B)

= (A − B) ∪ (B − A);

3

Teoria da Probabilidade

Conceitos Básicos e Definições

vi) CONJUNTOS DISJUNTOS: dois conjuntos A e B são disjuntos, ou mutuamente exclusivos, se a intersecção entre eles é vazia, ou seja, A ∩ B = ∅;

vi) PARTIÇÃO: os conjuntos A1 , A2 , . . . , Ak ⊂ Ω formam um partição de Ω se são disjuntos

dois-a-dois e se a união entre eles é igual a Ω, ou seja

– Ai ∩ Aj = ∅,

–

k

[

∀ i 6= j ;

Ai = Ω.

i=1

vi) LEIS DE MORGAN: considere uma sequência qualquer de eventos A1 , A2 , . . ., então,

segundo as leis de Morgan, valem as relações

∞

[

!c

Ai

=

i=1

∞

\

∞

\

Aci ;

i=1

!c

Ai

=

i=1

∞

[

Aci .

i=1

DEMONSTRAÇÃO VISUAL DAS LEIS DE MORGAN:

Ω

A

B

AUBUC

C

(AUBUC)c

Figura 1.1: Diagrama de Venn para a união ( A ∪ B ∪ C )c

Ω

Ω

Ω

A

Cc

B

Ac

Bc

C

Figura 1.2: Eventos complementares Ac , B c e C c , respectivamente

4

Teoria da Probabilidade

Conceitos Básicos e Definições

Ω

A

B

C

Figura 1.3: Diagrama de Venn para a intersecção Ac ∩ B c ∩ C c

DEMONSTRAÇÃO FORMAL DAS LEIS DE MORGAN: 1a parte (Magalhães ou Hoel)

IDEIA: mostrar que

i)

∞

[

!c

⊂

Ai

i=1

ii)

∞

[

∞

\

Aci ;

i=1

!c

⊃

Ai

i=1

∞

\

Aci .

i=1

RESULTADO: Sejam A e B conjuntos quaisquer, então, se A ⊂ B e A ⊃ B =⇒ A = B .

Prova da parte (i):

Seja w ∈ (

∞

[

Ai )c =⇒ w ∈

/

i=1

Desta forma, w ∈

∞

[

Ai =⇒ w ∈

/ Ai , ∀ i = 1, 2, . . .

i=1

Aci , ∀i

= 1, 2, . . . =⇒ w ∈

∞

\

Aci ,

i=1

o que prova a parte (i).

Prova da parte (ii):

Seja w ∈

∞

\

Aci =⇒ w ∈ Aci =⇒ w ∈

/ Ai , ∀ i = 1, 2, . . .

i=1

Desta forma, w ∈

/

∞

[

Ai , ∀ i = 1, 2, . . . =⇒ w ∈ (

i=1

∞

[

i=1

5

Ai )c ,

Teoria da Probabilidade

Conceitos Básicos e Definições

o que prova completa a prova.

1.2

Algumas definições em probabilidade:

a) EXPERIMENTO ALEATÓRIO: é um experimento no qual

– todos os resultados possíveis são conhecidos antecipadamente;

– uma realização do experimento resulta num dos possíveis resultados;

– pode ser repetido em condições idênticas.

Exemplo: Considere uma caixa com b bolas numeradas de 1 a b. Uma bola é retirada e

seu número é anotado.

b) ESPAÇO AMOSTRAL: é o conjunto dos resultados possíveis para um experimento aleatório. É denotado por Ω.

Pode ser:

Finito: formado por um conjunto finito de pontos;

i) Discreto

Infinito: conjunto infinito e enumerável de pontos;

ii) Contínuo: formado por um conjunto não enumerável de pontos.

Exemplo: No experimento da retirada de uma bola de uma da caixa, Ω é um espaço

amostral finito dado pelo conjunto com b pontos, no caso Ω = { 1, 2, . . . , b }.

c) EVENTO: um evento é qualquer subconjunto do espaço amostral Ω, associado a um

experimento.

Notas:

1) Os eventos serão identificados por letras de fôrma e maiúsculas do algarismo arábico, por exemplo A, B, C, . . ..

2) Aos eventos é que serão associadas probabilidades;

Exemplo: Na retirada de uma bola da caixa seja o evento A definido por:

A = {o resultado é um número par}.

Casos Especiais:

6

Teoria da Probabilidade

Conceitos Básicos e Definições

i) Evento Complementar: Seja um evento qualquer A ⊂ Ω, então, seu evento complementar Ac será definido pelos elementos de Ω que não estão em A.

Um evento A e seu complementar Ac são tais que A ∪ Ac = Ω.

ii) Eventos Disjuntos: Dois eventos quaisquer A e B são disjuntos, ou mutuamente

exclusivos se A ∩ B = ∅.

iii) Eventos Elementares: Seja um espaço amostral finito Ω = {ω1 , ω2 , . . . , ωN }, em

que ωi , i = 1, 2, . . . , N são resultados elementares.

Um evento formado por um resultado elementar é chamado evento elementar.

Neste caso,

Ai = {ωi }, i = 1, 2, . . . , N ,

são eventos elementares.

Notas:

1) Sejam dois eventos elementares Ai e Aj , i 6= j , então, Ai ∩ Aj = ∅;

2) Qualquer evento pode ser escrito como uniões de eventos elementares.

Particularmente, Ω = A1 ∪ A2 ∪ . . . ∪ AN .

Como o espaço amostral é finito, será associada uma probabilidade pi = 1/N para

cada ωi , i = 1, 2, . . . , N .

É intuitivo que 0 ≤ pi ≤ 1 e que p1 + p2 + . . . + pN = 1.

Se, além disso, o espaço amostral for equiprovável (ou homogêneo), então,

pi =

1

N

∀ ωi ∈ Ω, i = 1, 2, . . . , N .

d) σ -ÁLGEBRA:

Seja uma coleção não vazia A de subconjuntos de Ω aos quais desejamos associar

probabilidades. Então A deve ser tal que, se A e B ∈ A , faz sentido calcular probabilidades de que

i) A ou B ocorra, ou seja, (A ∪ B);

ii) A e B ocorram, ou seja, (A ∩ B);

iii) não ocorra A, ou seja, Ac .

Portanto, para A e B ∈ A , se A atender às propriedades:

7

Teoria da Probabilidade

Conceitos Básicos e Definições

i) Ω ∈ A ;

ii) se A ∈ A =⇒ Ac ∈ A ;

iii) se A ∈ A e B ∈ A =⇒ (A ∪ B) ∈ A .

então A é dita ser uma álgebra de subconjuntos (eventos) de Ω.

Além disso, deseja-se que A seja fechada também para um número infinito e enumerável

de operações (uniões e intersecções).

Definição: A é uma σ -álgebra de subconjuntos (eventos) de Ω se, e só se

i) Ω ∈ A ;

ii) se A ∈ A =⇒ Ac ∈ A ;

iii) se A1 , A2 , . . . ∈ A =⇒

∞

[

Ai ∈ A .

i=1

Notas:

1) toda σ -álgebra é uma álgebra, porém, nem toda álgebra é uma σ -álgebra;

2) Seja A uma σ -álgebra de Ω, então, se A1 , A2 , . . . ∈ A =⇒

∞

\

Ai ∈ A .

i=1

Exemplo: 1) Considere o lançamento de uma moeda, então Ω = { cara, coroa }

• A1 = { ∅, Ω } → menor σ -álgebra;

• A2 = { ∅, {cara}, {coroa}, Ω } → σ -álgebra, classe de todos os subconjuntos de Ω.

Exemplo: 2) Considere o espaço amostral Ω = { 1, 2, 3 }

• A1 = { ∅, Ω, {1}, {2, 3} } → é uma σ -álgebra

(todos os complementares e uniões estão presentes).

• A2 = { ∅, Ω, {1}, {2}, {1, 3}, {2, 3} } → não é σ -álgebra pois: {1} ∪ {2} ∈

/ A2

(todos os complementares estão presentes, mas não todas as uniões).

8

Teoria da Probabilidade

1.3

Conceitos Básicos e Definições

Medidas de probabilidade

a) EM ESPAÇOS FINITOS: número de resultados favoráveis a um evento, dividido pelo

número de resultados possíveis, assumindo que todos os resultados seja equiprováveis

P (A) =

card(A)

card(Ω)

em que Ω é o conjunto de resultados possíveis (espaço amostral).

b) GENERALIZAÇÃO PARA ESPAÇOS INFINITOS: se Ω é uma região com uma medida

bem definida, então

P (A) =

medida de A

medida de Ω

Exemplo: Um indivíduo realiza um tiro ao acaso num alvo circular de raio R. Qual a probabilidade de que acerte o círculo central de raio r (r < R)?

R

P (A) =

Ω

área central (A)

área do alvo (Ω)

r

A

P (A) =

1.3.1

r 2

πr2

=

πR2

R

Axiomas de Kolmogorov e espaço de probabilidade

A definição a seguir é conhecida como Axiomas de Kolmogorov (Kolmogorov, 1933) e

define uma medida de probabilidade.

MEDIDA DE PROBABILIDADE: Seja Ω um espaço amostral e A uma σ -álbegra de eventos de Ω. P (.) é uma medida de probabilidade em (Ω, A ) se satisfaz

i) P (A) ≥ 0, ∀ A ∈ A ;

ii) P (Ω) = 1;

9

Teoria da Probabilidade

Conceitos Básicos e Definições

iii) se A1 , A2 , . . . formam uma seqüência disjunta, então P

∞

[

i=1

!

Ai

=

∞

X

P (Ai ).

i=1

A trinca formada por (Ω, A , P ) é chamada de ESPAÇO DE PROBABILIDADE.

Um espaço de probabilidade é formado por um espaço amostral Ω, uma σ -álgebra de

eventos de Ω e uma medida de probabilidade P (A) ∀ A ∈ A .

Exemplo: 1) Número de ocorrências de um fenômeno.

Espaço amostral: Ω = { 1, 2, 3, . . . };

σ -álbegra: A = classe dos subconjuntos de Ω;

Medida de probabilidade: P (k) =

1

, k = 1, 2, . . .

2k

Checar os axiomas:

i) P (A) é dada pela soma de probabilidades de eventos elementares ωi ∈ A, i = 1, 2, . . .

=⇒ P (A) ≥ 0,

ii)

∞

X

P (k) =

i=1

∀ A;

1/2

= 1 =⇒ P (Ω) = 1;

1 − 1/2

iii) A união de eventos disjuntos, forma um conjunto ao se aplica o resultado (i), que equivale à soma das suas probabilidades individuais.

Exemplo: 2) Tempo de vida de pacientes.

Espaço amostral: Ω = { T ∈ R | 0 ≤ T < ∞ };

σ -álbegra: A = σ -álbegra de Borel;

Z

Medida de probabilidade: P (A) =

dos reais.

e−x dx, em que A ⊆ Ω são intervalos no conjunto

A

10

Teoria da Probabilidade

1.4

Conceitos Básicos e Definições

Propriedades das probabilidades

Considere que os conjuntos abaixo seja, eventos no espaço de probabilidade (Ω, A , P ).

Então, tem-se que

a) P (A) = 1 − P (Ac );

Nota: caso especial P (∅) = 1 − P (Ω) = 0.

b) Sejam A e B eventos quaisquer, então P (B) = P (B ∩ A) + P (B ∩ Ac ).

PROVA: i) para todo conjunto A tem-se que A ∪ Ac = Ω.

ii) Como B = B ∩ Ω = B ∩ (A ∪ Ac ) = (B ∩ A) ∪ (B ∩ Ac )

iii) e como (B ∩ A) e (B ∩ Ac ) são disjuntos, segue-se que

P (B) = P (B ∩ A) + P (B ∩ Ac ).

Nota: Se A ⊂ B , então A ∩ B = A e P (B) = P (A) + P (B ∩ Ac ).

c) Se A ⊂ B , então P (A) ≤ P (B).

PROVA: Sai direto da relação anterior e dos axiomas.

d) Se A e B são eventos quaisquer, então P (A ∪ B) = P (A) + P (B) − P (A ∩ B).

A

A ∩ Bc

B

A∩ B

Ac ∩ B

Ω

Figura 1.4: (A ∪ B ) como união de conjuntos disjuntos

11

Teoria da Probabilidade

Conceitos Básicos e Definições

PROVA:

i) Os conjuntos (A ∩ B c ), (A ∩ B) e (Ac ∩ B) são disjuntos, logo.

→ A ∪ B = (A ∩ B c ) ∪ (A ∩ B) ∪ (Ac ∩ B),

→ P (A ∪ B) = P (A ∩ B c ) + P (A ∩ B) + P (Ac ∩ B).

ii) Tem-se, ainda, que

→ P (A) = P (A ∩ B c ) + P (A ∩ B) e

→ P (B) = P (Ac ∩ B) + P (A ∩ B).

iii) Somando-se as probabilidades em (ii) obtem-se

P (A) + P (B) = P (A ∩ B c ) + P (Ac ∩ B) + P (A ∩ B) + P (A ∩ B), e, de (i) tem-se que

P (A) + P (B) = P (A ∪ B) + P (A ∩ B), de onde se conclui que

=⇒ P (A ∪ B) = P (A) + P (B) − P (A ∩ B).

Notas: 1) Da relação (d) segue-se que P (B ∪ A) ≤ P (A) + P (B);

2) Se A e B são disjuntos, então P (B ∪ A) = P (A) + P (B).

e) Das propriedades (c) e (d) tem-se P (

n

[

Ai ) ≤

i=1

n

X

P (Ai ).

i=1

PROVA: Por indução.

g) Das leis de Morgan tem-se que

P

n

[

!

Ai

=1−P

i=1

g) PARTE 1: Se A1 ⊂ A2 ⊂ . . . e A =

i=1

∞

[

Ai ou

i=1

PARTE 2: Se A1 ⊃ A2 ⊃ . . . e A =

n

\

∞

\

Ai ,

i=1

então segue-se que lim P (An ) = P (A).

n→∞

PROVA: (PARTE 1)

→ seja B1 = A1 ;

12

!

Aci .

Teoria da Probabilidade

Conceitos Básicos e Definições

→ para n ≥ 2, seja Bn o conjunto de pontos que estão em An mas não estão em An−1 ,

ou seja Bn = An ∩ Acn−1 ;

→ os conjuntos Bn , n = 1, 2, . . . são todos mutuamente exclusivos e, ainda

n

∞

[

[

An =

Bi e A =

Bi ;

i=1

i=1

→ conseqüentemente:

n

X

a) P (An ) =

P (Bi ) ,

i=1

b) P (A) =

∞

X

P (Bi ) .

i=1

Desta forma, aplicando-se o limite para n → ∞ em (a), tem-se

lim P (An ) =

n→∞

=

lim

n

X

n→∞

∞

X

P (Bi )

i=1

de (b)

P (Bi ) = P (A) ,

i=1

o que completa a prova.

PROVA: (PARTE 2) Exercício.

→ observar que A1 ⊃ A2 ⊃ . . . ⇒ Ac1 ⊂ Ac2 ⊂ . . ..

Exemplo: 1) Um dado equilibrado é lançado k = 2 vezes e os resultados anotados.

O espaço amostral para o experimento é:

Ω = ω = (i, j) ∈ R2 | i = 1, . . . 6 e j = 1, . . . , 6

Sejam:

A = classe de todos os subconjuntos de Ω e

P = probabilidade uniforme para todos os pontos de Ω, ou seja, P ({ω}) =

1

.

card(Ω)

O número de eventos elementares w’s é dado por card(Ω) = nk , em que

→ n total de resultados possíveis em uma realização do experimento, no caso n = 6,

→ k é o número de realizações do experimento, no caso k = 2.

Nesse caso, tem-se: card(Ω) = 36

⇒

P ({ω}) =

Considere os eventos:

A = a soma dos resultados é um número ímpar;

13

1

, ∀ ω ∈ Ω.

36

Teoria da Probabilidade

Conceitos Básicos e Definições

B = o resaultado do primeiro lançamento é um número ímpar;

C = o produto é um número ímpar.

Encontrar P (A ∪ B) e P (A ∪ B ∪ C).

Pontos favoráveis a cada um dos eventos:

A = { (1,2), (1,4), (1,6), (3,2), (3,4), (3,6), (5,2), (5,4), (5,6),

(2,1), (4,1), (6,1), (2,3), (4,3), (6,3), (2,5), (4,5), (6,5) };

B = { (1,1), (1,2), (1,3), (1,4), (1,5), (1,6), (3,1), (3,2), (3,3),

(3,4), (3,5), (3,6), (5,1), (5,2), (5,3), (5,4), (5,5), (5,6) };

C = { (1,1), (1,3), (1,5), (3,1), (3,3), (3,5), (5,1), (5,3), (5,5) }.

Resultados:

I card(A) = 18 =⇒ P (A) =

1

18

= ;

36

2

I card(B) = 18 =⇒ P (B) =

1

18

= ;

36

2

I card(C) = 9 =⇒ P (C) =

9

1

= .

36

4

Intersecções:

i) A ∩ B = { (1,2), (1,4), (1,6), (3,2), (3,4), (3,6), (5,2), (5,4), (5,6) } ⇒ P (A ∩ B) =

1

;

4

ii) A ∩ C = { ∅ } ⇒ P (A ∩ C) = 0;

iii) como C ⊂ B , segue-se que B ∩ C = C, ⇒ P (B ∩ C) = P (C) =

1

;

4

iv) de (ii), tem-se que A ∩ B ∩ C = { ∅ } ⇒ P (A ∩ B ∩ C) = 0;

Da propriedade (d), tem-se que:

P (A ∪ B) = P (A) + P (B) − P (A ∩ B) =

1 1 1

3

+ − =

2 2 4

4

Para encontrar P (A ∪ B ∪ C) utiliza-se, ainda, a propriedade (d) fazendo:

P (A ∪ B ∪ C)

= P [(A ∪ B) ∪ C] = P (A ∪ B) + P (C) − P [(A ∪ B) ∩ C]

= P (A) + P (B) − P (A ∩ B) + P (C) − P [(A ∩ B) ∪ (B ∩ C)]

= P (A) + P (B) + P (C) − P (A ∩ B) − P (A ∩ C) − P (B ∩ C) + P (A ∩ B ∩ C)

1 1 1 1 1

3

+ + − − =

=

2 2 4 4 4

4

14

Teoria da Probabilidade

Conceitos Básicos e Definições

Esse problema pode ser resolvido escolhendo-se um outro espaço amostral.

O lançamento de um dado pode ser representado por p se o resultado for par e por i se o

resultado for ímpar. Assim sendo, o novo espaço amostral pode ser escrito por:

Ω1 = { (p, p), (p, i), (i, p), (i, i) }

Como o espaço amostral original Ω é um espaço equiprovável, é fácil verificar que:

1

P [(p, p)] = P [(p, i)] = P [(i, p)] = P [(i, i)] = .

4

Pontos favoráveis a cada um dos eventos:

A = {(p, i), (i, p)} =⇒ P (A) =

2

1

= ;

4

2

B = {(p, i), (i, i)} =⇒ P (B) =

2

1

= ;

4

2

1

C = {(i, i)} =⇒ P (C) = .

4

1.5

Probabilidade condicional e teorema de Bayes

Em muitas situações, conhecimentos passados podem influenciar as probabilidades dos

eventos.

Por exemplo, a probabilidade de chuva num determinado dia pode ser influenciada se

choveu no dia anterior.

Sejam A e B eventos quaisquer associados ao espaço de probabilidade (Ω, A , P ), então,

para todo ω ∈ Ω,

→ se ω ∈ B , então ω ∈ A ⇐⇒ ω ∈ (A ∩ B).

Em outras palavras, sabendo que o evento B ocorreu, então, o evento A ocorre se, e só

se, ocorre a intersecção A ∩ B .

Nesse caso, tem-se um novo espaço amostral dado pelo evento B , uma nova σ -álgebra

AB e uma nova medida de probabilidade PB , aplicada em subconjuntos de AB , satisfazendo

os axiomas de Kolmogorov

PB =

P (A ∩ B)

.

P (B)

Portanto, (B , AB e PB ) formam um novo espaço de probabilidade.

Prova: A prova fica como exercício para o leitor.

15

Teoria da Probabilidade

Conceitos Básicos e Definições

Esquematicamente:

A

A∩ B

B

Ω

Figura 1.5: Evento condicional.

1.5.1

Probabilidade condicional

Sejam os eventos A e B tais que P (B) > 0, então, define-se a probabilidade condicional

de B dado que ocorreu A por

P (A|B) =

P (A ∩ B)

.

P (B)

Notas: 1) Se P (B) = 0 =⇒ P (A|B) = P (A) (Magalhães, 2004);

2) Da definição de probabilidade condicional tem-se a relação P (A∩B) = P (A|B)P (B),

conhecida como regra do produto das probabilidades.

Exemplo 1) Uma caixa comtém r bolas vermelhas numeradas de 1 a r e b bolas brancas,

numeradas de 1 a b. Uma bola é extraída, sua cor observada. Sabendo que a bola é vermelha,

qual a probabilidade de que seja a de número 1?

A caixa contém (r + b) bolas logo, a probabilidade de uma bola qualquer é

Censidere os eventos:

A = { a bola extraída é vermelha }, logo, P (A) =

r

(r + b)

B = { a bola extraída é a de número 1 }, logo, P (B) =

16

2

(r + b)

1

.

(r + b)

Teoria da Probabilidade

Como P (B ∩ A) =

Conceitos Básicos e Definições

1

, então,

(r + b)

P (B|A) =

1/(r + b)

1

P (B ∩ A)

=

= .

P (A)

r/(r + b)

r

Exemplo 2) Duas moedas idênticas são lançadas. Determine:

a) A probabilidade de se obter 2 caras sabendo que se obteve cara na primeira moeda.

Espaço amostral

=⇒

Ω = {(c, c); (c, c̄); (c̄, c); (c̄, c̄)}, em que c = cara e c̄ = coroa.

Sejam os eventos:

C1 = { cara na 1a moeda }

2

P (C1 ) = P [(c, c); (c, c̄)] = ;

4

2

P (C2 ) = P [(c, c); (c̄, c)] = .

4

=⇒

C2 = { cara na 2a moeda } =⇒

Como P (C2 ∩ C1 ) = P [(c, c)] =

1

,

4

logo,

P (C2 |C1 ) =

P (C2 ∩ C1 )

P [(c, c)]

1/4

1

=

=

= .

P (C1 )

P [(c, c); (c, c̄)]

2/4

2

b) A probabilidade de se obter 2 caras sabendo que se obteve pelo menos uma cara.

Neste caso os eventos são definidos por:

=⇒

{sair duas caras} = C1 ∩ C2 ;

=⇒

{sair ao menos um cara} = C1 ∪ C2 ;

Desta forma:

P (C1 ∩ C2 |C1 ∪ C2 ) =

P (C1 ∩ C2 )

P [(c, c)]

1/4

1

=

=

= .

P (C1 ∪ C2 )

P [(c, c); (c, c̄); (c̄, c)]

3/4

3

Exemplo 3) (Urna de Polya) Uma caixa comtém r bolas vermelhas e b bolas brancas. Uma

bola é extraída, sua cor observada e, a seguir, a bola é recolocada na caixa com mais c > 0

bolas da mesma cor. Esse procedimento é repetido m vezes.

O interesse aqui consiste em saber qual a probabilidade de se extrair uma bola vermelha

(ou branca) em cada uma das m retiradas.

17

Teoria da Probabilidade

Conceitos Básicos e Definições

Sejam:

i) Rj : a j -ésima bola retirada é vermelha;

ii) Bj : a j -ésima bola retirada é branca, 1 ≤ j ≤ m.

Então:

⇒ Rj e Bj são disjuntos e

⇒ na j -ésima extração tem-se [b + r + (j − 1) c] bolas na urna.

Para j = 1:

i) P (R1 ) =

r

,

b+r

ii) P (B1 ) =

b

.

b+r

Para j = 2:

i) P (R2 |R1 ) =

(r + c)

;

(b + r + c)

ii) P (R1 R2 ) = P (R1 )P (R2 |R1 );

⇒ P (R1 R2 ) =

(r + c)

r

.

(b + r) (b + r + c)

De maneira análoga,

⇒ P (B1 R2 ) =

b

r

.

(b + r) (b + r + c)

Logo, a probabilidade de que se extraia uma bola vermelha na segunda retirada é:

P (R2 ) = P (R1 R2 ) + P (B1 R2 )

r

r+c

b

r

=

+

b+r

b+r+c

b+r

b+r+c

r

r+c

b

=

+

b+r

b+r+c b+r+c

r

r+c+b

=

b+r

b+r+c

r

=

b+r

Portanto:

18

Teoria da Probabilidade

Conceitos Básicos e Definições

i) P (R2 ) = P (R1 ) =

r

,

b+r

ii) P (B2 ) = P (B1 ) =

b

.

b+r

Para j = 3:

Qual a probabilidade de vermelha na 3a extração?

Possibilidades:

i) R1 R2 R3 ⇒ P (R1 R2 R3 ) = P (R3 |R1 R2 )P (R2 |R1 )P (R1 );

ii) R1 B2 R3 ⇒ P (R1 B2 R3 ) = P (R3 |R1 B2 )P (B2 |R1 )P (R1 );

iii) B1 R2 R3 ⇒ P (B1 R2 R3 ) = P (R3 |B1 R2 )P (R2 |B1 )P (B1 );

iv) B1 B2 R3 ⇒ P (B1 B2 R3 ) = P (R3 |B1 B2 )P (B2 |B1 )P (B1 ).

Com um pouco de esforço algébrico obtêm-se:

i) P (R3 ) = P (R1 ) =

r

,

b+r

ii) P (B3 ) = P (B1 ) =

b

.

b+r

Enfim, pode-se provar por indução que, P (Rj ) = P (R1 ) e P (Bj ) = P (B1 ), ∀ 1 ≤ j ≤ m.

1.5.2

Teorema de Bayes

Sejam os eventos E1 , E2 , . . . , Em em (Ω, A , P ) formando uma partição em Ω tal que todos

têm probabilidades positivas, ou seja, P (Ei ) > 0, ∀ i = 1, 2, . . . , m. Considere, ainda, um

evento A qualquer, P (A) > 0, ocorrendo sobre a partição de Ω.

O objetivo, nesta situação, consiste em determinar a probabilidade de ocorrência de uma

das partes de Ω dado que ocorreu o evento A, ou seja, P (Ek |A), k = 1, 2, . . . , m.

Cmo pode-se observar pela Figura (1.6), o evento A pode ser escrito como união de partes

disjuntas, formadas pela intersecção de A com as partes de Ω, ou seja

A = (A ∩ E1 ) ∪ (A ∩ E2 ) ∪ (A ∩ E3 ) ∪ (A ∩ E4 ) ∪ (A ∩ E5 ) ∪ (A ∩ E6 ) =

6

[

(A ∩ Ei )

i=1

19

Teoria da Probabilidade

Conceitos Básicos e Definições

Figura 1.6: Ocorrência de um evento A sobre uma partição de Ω com m = 6.

Para um m qualquer,

A = (A ∩ E1 ) ∪ (A ∩ E2 ) ∪ . . . ∪ (A ∩ Em ) =

m

[

(A ∩ Ei ),

i=1

logo, a probabilidade do evento A é dada por

P (A) = P

"m

[

#

(A ∩ Ei ) =

i=1

m

X

P (A ∩ Ei ).

i=1

Pela regra do produto, tem-se que

P (A) = P

"m

[

#

(A ∩ Ei ) =

i=1

m

X

P (A|Ei )P (Ei ).

i=1

O resultado acima é conhecido como lei da probabilidade total.

Para um Ek qualquer, k = 1, 2, . . . , m, pode-se escrever P (A ∩ Ek ) = P (A|Ek )P (Ek ),

logo, a probabilidade de ocorrência de Ek dado que ocorreu A, é dada por:

P (Ek |A) =

P (Ek |A) =

P (Ek ∩ A)

P (A)

P (A|Ek )P (Ek )

m

X

,

k = 1, 2, . . . , m,

(1.1)

P (A|Ei )P (Ei )

i=1

o resultado em (1.1) é conhecido como teorema de Bayes. Foi obtido pelo Reverendo Thomas

Bayes e publicado em 1763, sendo um dos teoremas mais importantes da teoria estatística.

Exemplo 1) Numa população adulta 40% são homens e 60% mulheres. Sabe-se, ainda,

que 50% dos homens e 30% das mulheres são fumantes. Determine:

20

Teoria da Probabilidade

Conceitos Básicos e Definições

a) A probabilidade de que uma pessoa escolhida ao acaso nesta população seja fumante.

Partição do espaço amostral

=⇒

sexo = {H, M }.

Sejam os eventos:

H = { a pessoa escolhida é do sexo masculino (homem) }

M = { a pessoa escolhida é do sexo feminino (mulher) }

=⇒

=⇒

P (H) = 0.40;

P (M ) = 0.60;

F = { a pessoa escolhida é fumante };

F c = { a pessoa escolhida não é fumante }.

Como P (F |H) = 0.50 e P (F |M ) = 0.30, então, pela regra da probabilidade total:

P (F ) = P (F ∩ H) + P (F ∩ M )

P (F ) = P (F |H)P (H) + P (F |M )P (M )

P (F ) = 0.50 · 0.40 + 0.30 · 0.60

P (F ) = 0.38

b) A probabilidade de que seja um homem sabendo que é um fumante.

Pelo teorema de Bayes, tem-se a relação:

P (H|F ) =

P (H ∩ F )

P (F )

P (H|F ) =

P (F |H)P (H)

P (F )

P (H|F ) =

0.20

0.38

P (H|F ) = 0.5263,

portanto, a probabilidade de ser um homem dado que é fumante é de 0.5263.

Uma forma conveniente para se representar as probabilidades acima é através da ”arvore

de probabilidades”, nas quais representamos as probabilidades das partes e probabilidades

condicionais em ramos, conforme Figura (1.7). Nesse esquema, as probabilidades conjuntas

(das intersecções) são obtidas percorrendo-se os ramos e multiplicando-se as probabilidades.

21

Teoria da Probabilidade

Conceitos Básicos e Definições

Figura 1.7: Diagrama de árvore para o exemplo (1).

Exemplo 2) Sabe-se que numa população 8% das pessoas são infectadas por um vírus

causador de uma doença muito grave. Um teste para detecção do vírus é eficiente em 99%

dos casos nos quais os indivíduos são infectados, mas resulta em 2% de resultados positivos

para os não infectados (falsos positivos).

Se o teste de uma pessoa dessa população der resultado positivo, qual a probabilidade

de que ela seja da fato infectada?

Defindo-se: I ⇒ grupo das pessoas infectadas;

I c ⇒ grupo dos não infectados;

T + ⇒ o resultado do teste é positivo;

T − ⇒ o resultado do teste é negativo;

tem-se as probabilidades: P (I) = 0.08; P (I c ) = 0.92; P (T + |I) = 0.99 e P (T + |I c ) = 0.02.

Porém, deseja-se calcular a probabilidade: P (I|T + )

que pela regra da probabilidade condicional é dada por P (I|T + ) =

P (I ∩ T + )

.

P (T + )

As probabilidades podem ser representadas na seguinte tabela:

Tabela 1.1: Probabilidades

Resultado do teste

−

+

T

T

+

I

P (I ∩ T ) P (I ∩ T − )

Ic

P (I c ∩ T + ) P (I c ∩ T − )

Totais das colunas

P (T + )

P (T − )

Grupo

22

Totais das

linhas

0.08

0.92

1.00

Teoria da Probabilidade

Conceitos Básicos e Definições

Pela regra do produto e pela lei da probabilidade total, encontra-se P (T + ) de:

P (T + ) = P (I ∩ T + ) + P (I c ∩ T + )

= P (T + |I)P (I) + P (T + |I c )P (I c )

= 0.99 · 0.08 + 0.02 · 0.92

= 0.0792 + 0.0184

= 0.0976

e, pelo teorema de Bayes, tem-se

P (I|T + ) =

P (T + |I)P (I)

0.0792

=

= 0.8115.

+

P (T )

0.0976

Qual seria a confiança no teste se o resultado fosse negativo, ou seja, qual a probabilidade

de o teste sendo negativo a pessoa de fato não seja infectada?

Deseja-se: P (I c |T − ) =

P (I c ∩ T − )

.

P (T − )

Como:

P (T − ) = P (I ∩ T − ) + P (I c ∩ T − ) = 0.01 · 0.08 + 0.98 · 0.92 = 0.9024,

então,

P (I c |T − ) =

P (T − |I c )P (I c )

0.9016

=

= 0.9991,

−

P (T )

0.9024

portanto, se o teste for negativo a pessoa pode se sentir segura.

Na Figura (1.8) é apresentada o diagrama de árvore para o resultado acima.

Figura 1.8: Diagrama de árvore para o exemplo (2).

23

Teoria da Probabilidade

1.5.3

Conceitos Básicos e Definições

Independência de eventos

Sejam o espaço de probabilidade (Ω, A , P ) e sejam os eventos A e B ∈ A , tal que

P (B) > 0. Pela regra da multiplicação pode-se escrever

P (A ∩ B) = P (A|B) P (B).

Em alguns casos, no entanto, informações prévias a respeito do evento B não afetam a

probabilidade de ocorrência de A, isto é, a probabilidade concicional de A dado B é igual à

P (A), ou seja

P (A|B) = P (A).

Definição: Sejam dois eventos A e B , com probabilidades maiores do que zero, tais que

a ocorrência de um deles não altera a probabilidade de ocorrência do segundo, então, esses

eventos são ditos indepententes.

Da regra da multiplicação das probabilidades, portanto, se dois eventos A e B são independentes então a probabilidade de ocorrência conjunta dos dois é dada pelo produto das

probabilidades individuais, ou seja,

P (A ∩ B) = P (A) P (B).

Seja A1 , A2 , . . . , Ak , k eventos independentes, então, de (1.2)

P (A1 ∩ A2 ∩ . . . ∩ Ak ) = P (A1 ) · P (A2 ) · . . . · P (Ak )

Exemplo 1) Duas moedas idênticas são lançadas separadamente.

Ω = {(c, c); (c, c̄); (c̄, c); (c̄, c̄)}, em que c = cara e c̄ = coroa.

Sejam os eventos:

=⇒

1

P (A) = P [(c, c); (c̄, c)] = ;

2

B = { cara no 1º lançamento } =⇒

1

P (B) = P [(c, c); (c, c̄)] = .

2

A = { cara no 2º lançamento }

Determine P (A|B).

P (A|B) =

P (A ∩ B)

1/4

1

=

= = P (A).

P (B)

1/2

2

24

(1.2)

Teoria da Probabilidade

Conceitos Básicos e Definições

Portanto, conclui-se que A e B são independentes, ou seja, a ocorrência de cara no

primeiro lançamento não altera a probabilidade de que saia cara no segundo lançamento.

Propriedades de independência:

a) Seja um evento A tal que P (A) = 0, então A é independente de todo evento E ∈ A ,

em que P (E) > 0;

Prova: Se P (A) = 0

=⇒

P (E ∩ A) = P (E|A)P (A) = 0 = P (E) · P (A),

∀ E∈A

b) Se A ∈ A é um evento qualquer tal que P (A) > 0, então A é independente de ∅ e Ω;

Prova:

i) A prova de que A e ∅ são independentes sai direto de (a), já que P (∅) = 0;

ii) Para a prova de que A e Ω são independentes, considere que A = A ∩ Ω, logo

=⇒

P (Ω ∩ A) = P (A) = P (A) · (1) = P (A)P (Ω)

c) Se os eventos de A e B forem independentes, então A e B c ; Ac e B ; Ac e B c também

o são;

Prova: A seguir será apresentada apenas a prova de que A e B c também são independentes. As demais ficam como exerício para o leitor.

O evento A pode ser escrito por A = (A ∩ B) ∪ (A ∩ B c ), (A ∩ B) e (A ∩ B c ) disjuntos,

logo

P (A) = P (A ∩ B) + P (A ∩ B c )

P (A) = P (A)P (B) + P (A ∩ B c )

P (A) − P (A)P (B) = P (A ∩ B c )

P (A)[1 − P (B)] = P (A ∩ B c )

P (A)P (B c ) = P (A ∩ B c )

Definição: Seja A1 , A2 , . . . , Ak , k eventos independentes. Se, para qualquer subconjunto

A1 , A2 , . . . , Ar , tal que r ≤ k , os eventos forem independentes, ou seja,

P (A1 ∩ A2 ∩ . . . ∩ Ar ) = P (A1 ) · P (A2 ) · . . . · P (Ar ),

então A1 , A2 , . . . , Ak são chamados mutuamente independentes.

25

Teoria da Probabilidade

Conceitos Básicos e Definições

Em outras palavras, os eventos A1 , A2 , . . . , Ak são mutuamente independentes se forem

independentes dois-a-dois, três-a-três, e assim por diante . . .

Exemplo 2) A probabilidade de que um homem esteja vivo daqui a 10 anos é de 3/4 e de

sua esposa, é de 5/6. Qual é a probabilidade de que, daqui a 10 anos:

a) Ambos estejam vivos?

Considere os eventos:

H = { homem vivo daqui a 10 anos }

=⇒

P (H) = 3/4

logo

P (H c ) = 1/4;

M = { mulher viva daqui a 10 anos }

=⇒

P (M ) = 5/6

logo

P (M c ) = 1/6.

Espaço amostral Ω = {HM, HM c , H c M, H c M c }

Assumindo independência entre os eventos H e M , a probabilidade de que ambos

estejam vivos daqui a 10 anos é dada por

P (HM ) = P (H)P (M ) =

5

3 5

· =

4 6

8

b) Ao menos um esteja vivo?

Ainda assumindo independência entre H e M , a probabilidade de ao menos um esteja

vivo daqui a 10 anos é dada por

P (HM, HM c , H c M ) = P (H)P (M ) + P (H)P (M c ) + P (H c )P (M )

P (HM, HM c , H c M ) =

3 5 1 5 3 1

· + · + ·

4 6 4 6 4 6

P (HM, HM c , H c M ) =

15

5

3

23

+

+

=

24 24 24

24

A solução acima é simplificada com a aplicação do evento complementar

P (HM ) = 1 − P (H c M c ) = 1 −

Exemplo 3) Aplicação em confiabilidade de sistemas.

26

1 1

23

· =

4 6

24

Teoria da Probabilidade

Conceitos Básicos e Definições

Um sistema de componentes é determinado por um conjunto de itens associados numa

dada configuração. As configrações mais simples são os sistemas em série e em paralelo. A

associação de ambas as configurações são chamadas de sistemas série-paralelo.

Neste sentido, a confiabilidade de um sistema num dado instante t é dada pela probabilidade de que este esteja funcionando normalmente.

Considere um componente tal que a probabilidade de que esteja funcionando num instante t dada por p, 0 ≤ p ≤ 1. Dois destes componentes são colocados em funcionamento

segundo as configurações abaixo. Assumindo que os componentes funcionem de maneira

independente, determine a confiabilidade do sistema em cada um dos casos.

Sejam os eventos:

S = { o sistema funciona no tempo t } =⇒

Ci = { o componente i funciona no tempo t }

confiabilidade do sistema = P (S)

=⇒

P (Ci ) = p

a) Sistema em série: na configuração em série, o sistema funciona se os dois componentes funcionarem simultaneamente, desta forma

P (S) = P (C1 ∩ C2 ) = p2

Figura 1.9: Sistema em série

b) Sistema em paralelo: o sistema funciona se pelo menos um dos componentes estiver

funcionando, logo

P (S) = P (C1 ∪ C2 ) = p + p − p2 = 2p − p2

Figura 1.10: Sistema em paralelo

27

Teoria da Probabilidade

Conceitos Básicos e Definições

c) Sistema série-paralelo: o sistema série-paralelo, com a configuração dada pela Figura

1.11, funciona se C1 funcionar e, (C2 ou C3 funcionar).

Obd: Fica para o leitor mostrar que a confiabilidade deste sistema é dada por

P (S) = 2p2 − p3

Figura 1.11: Sistema série-paralelo

Exemplo 4) Uma moeda equilibrada é lançada tês vezes. Dê o espaço amostral:

i) Ω = {(c, c, c); (c, c, c̄); (c, c̄, c); (c̄, c, c); (c, c̄, c̄); (c̄, c, c̄); (c̄, c̄, c); (c̄, c̄, c̄)},

em que c = cara e c̄ = coroa.

ii) Verifique se os eventos {ocorrem pelo menos duas caras} e {ocorre coroa no 1º lançamento} são independentes.

A = { ocorrem pelo menos duas caras } =⇒ A = {(c, c, c); (c, c, c̄); (c, c̄, c); (c̄, c, c)}

B = { ocorre coroa no 1º lançamento } =⇒ A = {(c̄, c, c); (c̄, c, c̄); (c̄, c̄, c); (c̄, c̄, c̄)}

No lançamento de uma moeda P (c) = P (c̄) = 1/2, logo, os eventos elementares de Ω

têm todos probabilidade 1/8. Desta forma, verifica-se facilmente que

1

P (A) = P (B) = .

2

Ainda, A ∩ B = {(c̄, c, c̄); (c̄, c̄, c); (c̄, c̄, c̄)}

=⇒

3

P (A ∩ B) = ,

8

portanto,

P (A|B) =

3/8

3

= 6= P (A)P (B).

1/2

4

Logo, os eventos A e B não são independentes.

28

Teoria da Probabilidade

1.6

Conceitos Básicos e Definições

Contagem

Considere um espaço amostral finito e equiprovável Ω, no qual cada evento elementar tem

probabilidade

P ({ωi }) =

1

,

card(Ω)

i = 1, 2, . . . , card(Ω).

Considere um evento A pertencente ao espaço de probabilidade (Ω, A , P ), então, a probabilidade do evento A é definida por

P (A) =

card(A)

card(Ω)

Assim sendo, a determinação de P (A) resume-se num problema de contagem do número

de elementos de A e de Ω, o que é um procedimento simples quando tanto Ω tem poucos

pontos, mas pode ser, trabalhoso, ou até mesmo impraticável, quando o número de pontos é

grande (ou mesmo moderado).

1.6.1

Amostras ordenadas

Considere dois conjuntos S e U , com m e n elementos, respectivamente. Ao serem selecionados um elemento de cada conjunto, podem-se formar (m × n) duplas do tipo (xi , yj ), i =

1, 2, . . . , m; j = 1, 2, . . . , n, conforme mostra a Figura 1.12.

Figura 1.12: Seleção alatória em dois conjuntos finitos.

Considere, agora, n conjuntos distintos S1 , S2 , . . . , Sn , de tamanhos s1 , s2 , . . . , sn , respectivamente. Se selecionarmos um elemento de cada conjunto teremos (s1 × s2 × . . . × sn )

n−uplas do tipo (x1 , x2 , . . . , xn ).

29

Teoria da Probabilidade

Conceitos Básicos e Definições

Se, no entanto, os n conjuntos forem o mesmo conjunto S , com s pontos, então existirão

n

s n−uplas do tipo (x1 , x2 , . . . , xn ) para as quais xi , i = 1, 2, . . . , n, é um ponto de S .

Esta situação, em que o número de elementos de S permanece constante, caracteriza

uma ”amostra aleatória com reposição”. Com a condição inicial de que o espaço amostral é

equiprovável, todas as sn n−uplas têm igual probabilidade de serem selecionadas, sendo

essa probabilidade igual a

1

.

sn

(1.3)

Exemplo 1) Uma moeda equilibrada é lançada n vezes. Determine a probabilidade de se

obter ao menos uma cara nos n lançamentos.

Nessa situação, o conjunto S é dado por: S = {c, c̄}, sendo que P ({c}) = P ({c̄}) = 1/2.

Como s = 2, então, o número de n−uplas possíveis é igual a 2n .

Seja o evento de interesse A = { ao menos uma cara nos n lançamentos }.

Definindo Ai = { o evento cara no i−ésimo lançamento }, então,

A=

n

[

Ai ,

i=1

cuja probabilidade é dada por:

P (A) = 1 − P (Ac )

"

P (A) = 1 − P

n

[

!c #

Ai

i=1

Das leis de Morgan, tem-se que

P (A) = 1 − P

n

\

!

Aci

i=1

P (A) = 1 −

n

Y

P (Aci )

i=1

Portanto, a probabilidade desejada é dada por:

n

1

.

P (A) = 1 −

2

30

Teoria da Probabilidade

Conceitos Básicos e Definições

Se, por exemplo, n = 10, P (A) = 1 −

1

1023

=

.

1024

1024

Considere, agora, o conjunto S , contendo s elementos distintos, sendo que o elemento

escolhido não é recolocado no conjunto após a seleção. Neste caso, a amostra alatória é do

tipo ”sem reposição”.

Repetindo o procedimento n vezes, o número de n−uplas possíveis, sem que nenhum xi ,

i = 1, 2, . . . , n, seja repetido, é dado por:

As,n = s × (s − 1) × . . . × (s − n + 1),

(1.4)

sendo que a quantidade As,n representa um arranjo de s elementos tomados n-a-n.

Exemplo 2) Seja um conjunto S com s elementos distintos. Considerendo uma amostragem aleatória com reposição, qual a probabilidade de que nenhum elemento de S apareça

repetido na amostra.

Seja o evento E = { nenhum elemento repetido na amostra }, então

P (A) =

total de amostras para as quais nenhum elemento apareça repetido

.

total de amostras possíveis

Desta forma, de (1.3) e (1.4), temos que a probabilidade acima é dada por

P (E) =

As,n

s(s − 1) . . . (s − n + 1)

=

n

s

sn

(s − n + 1)

s (s − 1)

...

s s

s

1

2

n−1

P (E) =

1−

1−

... 1 −

s

s

s

P (E) =

P (E) =

n−1

Y

k=1

k

1−

s

.

(1.5)

Como na maioria das situações práticas o número de elementos do conjunto S (ou ”população”) é muito grande, calculando o limite em (1.5), tem-se

"n−1 #

Y

k

1−

lim P (E) = lim

= 1,

s→∞

s→∞

s

k=1

ou seja, quando as populações são muito grandes, as amostras aleatórias “com” e “sem”

31

Teoria da Probabilidade

Conceitos Básicos e Definições

reposição se equivalem.

Exemplo 3) Qual a probabilidade de que, num grupo com n pessoas, não existam duas

com aniversário na mesma data?

(este problema é muito popular, sendo conhecido como “problema dos aniversários”)

Seja: S = {1, 2, 3, . . . , 365}, então S é definido como sendo os dias do ano e, s = 365.

Considerando que uma data de nascimento é uma seleção aleatória de um elemento de

S , então, para E = { nenhuma coincidência de datas de aniversário no grupo }:

P (E) =

n−1

Y

k=1

k

1−

365

.

Por exemplo, para um grupo de n = 4 pessoas

P (E) =

1

1−

365

2

3

1−

1−

= 0.9836.

365

365

Desta forma, a probabilidade de que, num grupo de quatro pessoas, pelo duas delas

façam aniversário na mesma data, é de 1 − 0.9836 = 0.0164.

1.6.2

Permutações

Considere n caixas e n bolas distintas, numeradas de 1 a n. De quantas meneiras diferentes podem-se colocar as n bolas nas n caixas, de modo que cada caixa contenha exatamente

1 bola?

O número de bolas possíveis para se colocar na primeira caixa é n, na segunda caixa é

(n − 1), na terceira (n − 2), e assim por diante, sendo que, para a n−ésima caixa, só restará

uma bola. O número de possibilidade, assim definido, é dado pela permutação das n bolas

Pn = n (n − 1) (n − 2) . . . 1 = n!

Na permutação, uma número n de objetos ou items são reorganizados em n posições

distintas, tal que, cada posição seja ocupada por apenas um item.

Assim sendo, uma compsição específica de bolas nas caixas tem probabilidade de ocorrência

1

1

=

Pn

n!

32

Teoria da Probabilidade

Conceitos Básicos e Definições

Qual é a probabilidade de que a bola i seja colocada na caixa j , i, j = 1, 2, ...n?

Fixando uma bola e uma caixa restam (n − 1) bolas para serem permutadas nas (n − 1)

caixas, logo, o número de possibilidade tal que a bola i esteja na caixa j é dado por Pn−1 =

(n − 1)!. Desta forma, a probabilidade do evento A = { a bola i seja colocada na caixa j } é

P (A) =

(n − 1)!

1

Pn−1

=

= .

Pn

n!

n

Por sua vez, a probabilidade de que, permutando-se n bolas em n caixas, exatamente k

bolas caiam em k caixa específicas é dada por:

Pn−k

(n − k)!

1

=

=

.

Pn

n!

An,k

Exemplo 4) Numa festa de final de ano, n = 8 casais concordam em participar de uma

brincadeira na qual, todos os casais participantes são separados e novos pares são formados

por sorteio para dançarem pelo menos uma música. Qual é a probabilidade de que exatamento 4 casais sejam mantidos, ou seja, 4 garotas fiquem com seus respectivos namorados?

Defindo o evento A = { 4 casais sejam mantidos }, então, n = 8 e k = 4, logo

P (A) =

1.6.3

(8 − 4)!

1

=

= 0.000595.

8!

A8,4

Amostras Desordenadas

Considere o conjunto S , com s elementos, logo existem As,n amostras distintas de tamanho n, n < s, extraídas sem reposição. Nesta situação, considera-se a ordem das observações na amostra, ou seja, amostras com os elementos em diferentes ordenações são

consideradas distintas.

Em muitas situações, no entanto, o interesse recai nos elementos da amostras, independente da ordem em que são selecionados. É o caso de amostras desordenadas. Neste

sentido, uma amostra sem reposição {x1 , x2 , . . . , xn } pode ser reordenada de n! maneiras diferentes (todas com os mesmos elementos), fato este, que deve ser considerado no momento

da contagem.

Portanto, dividindo o número de amostras sem reposição pelo total de reordenações,

obtem-se o número de amostras possíveis, sem reposição e sem considerar a ordem dos

33

Teoria da Probabilidade

Conceitos Básicos e Definições

elementos, ou seja,

As,n

n!

Multiplicando-se o numerador e denominador por (s − n)!, tem-se

As,n

s(s − 1) · · · (s − n + 1) (s − n)!

s!

=

=

n!

n! (s − n)!

n! (s − n)!

O termo As,n /n! é conhecido

! como coeficiente binomial ou combinação, podendo ser re-

s

n

presentado por Cs,n ou

. Logo, a combinação de s elementos, tomados n-a-n é dada

por

s

n

!

=

s!

,

n! (s − n)!

n < s.

Exemplo Considere a amostra {3, 1, 7}. como n = 3, o número de reordenações dos seus

elementos é 3! = 6:

{3, 1, 7},

{3, 7, 1},

{1, 3, 7},

{1, 7, 3},

{7, 3, 1} {7, 1, 3}

Notas:

a) O coeficiente

a

x

!

é bem definido para a ∈ R e x ∈ N, por exemplo, se a = −π e

x = 3, então

−π

3

!

=

−π(−π − 1)(−π − 2)

π(π − 1)(π − 2)

=−

= −11.1497.

3!

6

b) Por definição, 0! = 1 e Aa,0 = 1.

c) Para a inteiro positivo, se x > a ou x < 0

p.def.

=⇒

a

x

!

= 0;

Exemplo 5) Considere S = {1, 2, . . . , s}, um conjunto finito. Qual a probabilidade de se

extrair k < s elementos de S tal que os valores estejam em ordem crescente, ou seja, tal que

1 ≤ x1 < x2 < . . . < xk ≤ s?

34

Teoria da Probabilidade

Conceitos Básicos e Definições

O número de amostras de tamanho k < n que podem ser retiradas de S tal que não hajam

repetições é An,k = n(n − 1) . . . (n − k + 1).

Dessas As,k existem k! reordenações, das quais apenas uma contém os valores em

sequência.

Portanto, a probabilidade desejada é:

P (A) =

1

k!

=

As,k

Cs,k

Assumindo S = {1, 2, 3, 4, 5}, então s = 5 e k = 3 (amostras de tamamho 3 de um

conjunto com 5 elementos).

A seguir são apresentadas todas as amostras possíveis, com destaque em negrito para

as amostras nas quais os valores estão em ordem crescente.

1

1

2

2

3

3

2

3

1

3

1

2

3

2

3

1

2

1

1

1

2

2

4

4

2

4

1

4

1

2

4

2

4

1

2

1

1

1

2

2

5

5

2

5

1

5

1

2

5

2

5

1

2

1

1

1

3

3

4

4

3

4

1

4

1

3

4

3

4

1

3

1

1

1

3

3

5

5

3

5

1

5

1

3

5

3

5

1

3

1

1

1

4

4

5

5

4

5

1

5

1

4

5

4

5

1

4

1

2

2

3

3

4

4

3

4

2

4

2

3

4

3

4

2

3

2

2

2

3

3

5

5

3

5

2

5

2

3

5

3

5

2

3

2

2

2

4

4

5

5

4

5

2

5

2

4

5

4

5

2

4

2

3

3

4

4

5

5

4

5

3

5

3

4

5

4

5

3

4

3

. Amostras possíveis A5,3 = 60

. Reordenações 3! = 6

. Probabilidade do evento A = { extrair uma amostra de tamanho 3 com os valores em

ordem crescente }:

P (A) =

6

1

=

= 0.10

60

10

Exemplo 6) Qual é a probabilidade de se obter um royal straight flush numa mão de pôquer,

antes da troca de cartas?

Um royal straight flush é uma sequência com as maiores cartas (A, K, Q, J, 10), sendo

todas do mesmo naipe.

35

Teoria da Probabilidade

Conceitos Básicos e Definições

. Antes da troca de cartas tem-se A52,5 mãos possíveis.

. Reordenações: 5! = 120 possibilidades de se obter a mesma mão.

. Probabilidade do evento A = { obter a mão (A, K, Q, J, 10) com todas as cartas do

mesmo naipe }

P (A) =

4 ∼

4 × 5!

=

= 1.54 × 10−6

A52,5

C5,5

Fica como exercício para o leitor calcular as probabilidades de se obter as demais mãos

no jogo no pôquer (antes da troca das cartas).

. Straight flush (cinco cartas do mesmo naipe, em sequência);

. Quadra (quatro cartas do mesmo valor);

. Full house (uma trinca e um par);

. Flush (as cinco cartas do mesmo naipe);

. Straight (cinco cartas em sequência, sem consideração de naipes);

. Trinca (três cartas do mesmo valor);

. Dois pares (pares com cartas de valores distintos);

. Par (duas cartas do mesmo valor).

Exemplo 7) No jogo da megasena o que mais vantajoso:

A = { escolher d = 10 dezenas e jogar todas as combinações possiveis de 6 dezenas } ou

B = { fazer 210 jogos distintos de 6 dezenas }?

Espaço amostral Ω = {1, 2, 3, . . . , 60}

Total de possibilidades com jogos de 6 dezenas: C60,6 =

60!

.

54! 6!

Total de jogos possíveis de 6 dezenas dentre as d = 10 escolhidas: C10,6 =

10!

= 210.

4! 6!

Portanto, as chances de se ganhar na megasena são iguais para os dois casos visto que:

P (A) = P (B) =

1.6.4

210

≈ 4.2 × 10−6

C60,6

Partições

Seja uma população S , de tamanho s, dividida em k subpopulações S1 , S2 , . . . , Sk com

s1 , s2 , . . . , sk elementos, respectivamente.

Considerando o caso de amostras desordenadas e sem reposição, a probabilidade de

que, numa amostra de tamanho n sejam selecionados exatamente n1 , n2 , . . . , nk elementos

36

Teoria da Probabilidade

Conceitos Básicos e Definições

de S1 , S2 , . . . , Sk , tal que ni < si , i = 1, 2, . . . , k , é dada por

P (n1 , n2 , . . . , nk ) =

em que

k

X

si = s e

i=1

k

X

s1

n1

!

s2

n2

!

···

s

n

sk

nk

!

!

,

ni = n.

i=1

Exemplo 7) Num grupo de com 12 professores e 5 alunos do curso de Estatística, devem

ser escolhidas n = 5 pessoas para formar uma comissão para falar com o Reitor. Quantas

comissões podem ser formadas de tal forma que, dos escolhidos, 3 sejam professores e 2

sejam alunos?

O grupo tem um total de N = 12 + 5 = 17, desta forma, o total de comissões é dado por

17

5

!

=

17!

= 6188 comissões.

12! 5!

O número de copmissões com exatamente 3 professores e 2 alunos é dado por

12

3

!

5

2

!

= 2200 comissões com 3 prof. e 2 alunos.

Desta forma:

P (comissão com 3 professores e 2 alunos) =

12

3

!

17

5

5

2

!

!

=

2200

= 0.355,

6188

Exemplo 8 - Captura e recaptura) Num lago há uma população de peixes de tamanho N .

Uma rede é lançada, m peixes são capturados e marcados, após o que, são devolvidos à

água.

A rede é lançada uma 2ª vez e um total de n peixes são capturados. Qual é a probabilidade

do evento:

A = { exatamente x, dentre os n peixes capturados no 2º lançamento, são marcados }

37

Teoria da Probabilidade

Conceitos Básicos e Definições

Após a primeira captura tem-se N peixes no lago, dos quais m são marcados.

Da partição da população desejamos que no segundo lançamento da rede sejam capturados x peixes marcados e (n − x) não marcados, logo

P (A) =

m

x

!

N −m

n−x

!

N

n

!

(1.6)

Uma situação prática envolvendo o problema da captura e recaptura refere-se à estimação

do tamanho da população N .

Conhecendo m da primeira captura e tendo observado n e x do segundo lançamento da

rede, como podemos estimar o tamanho da população de peixes N ?

Da inferência estatística tem-se que uma estimativa para o tamanho da população é dada

pelo valor de N que maximiza a probabilidade em (1.6).

Assumindo, por exemplo, m = 50 e n = 30, qual é a probabilidade de que exatamente x

peixes do segundo lançamento da rede sejam marcados?

P (A) =

50

x

!

N − 50

30 − x

!

N

30

!

.

(1.7)

Portanto, dado o número de peixes marcados na segunda captura, ou seja, dado x, o

tamanho da população de peixes no lago é estimado pelo valor de N que maximiza (1.7).

Simplificando ainda mais, considere m = 10 e n = 5. A probabilidade de que x = 1 peixe

do segundo lançamento da rede seja marcado é

P (A) =

10

1

!

38

N − 10

4

!

N

5

!

.

Teoria da Probabilidade

Conceitos Básicos e Definições

Com um pouco de álgebra, obtem-se

P (A) =

50(N − 10)(N − 11)(N − 12)(N − 13)

,

N (N − 1)(N − 2)(N − 3)(N − 4)

N > 13.

A seguir são apresentados a tabela com os cálculos para a obtenção de N e a curva com

o valor de P (A) versus N . Pelos valores apresentados, verifica-se que valor de N pode ser

estimatido em N = 49 ou N = 50.

N

P (A)

14

0.0050

20

0.1354

30

0.3400

40

0.4165

48

0.4311

49

0.4313

50

0.4313

51

0.4311

60

0.4217

80

0.3814

100

0.3394

120

0.3029

Exemplo 9 - Jogo da Megasena) Retomando o problema da megasena, considere que

o apostador escolha um número d de dezenas e aposte todos os jogos possíveis com 6

dezenas. Se o apostador conseguir acertar as 6 dezenas sorteadas, além de ganhar na

sena, de quebra, ele consegue algumas quinas e quadras.

Quantas quinas e quadras o apostador consegue ao acertar as seis dezenas sorteadas?

De maneira geral, apostando nos Cd,6 jogos possíveis e acertando as 6 dezenas sorteadas, tem-se

39

Teoria da Probabilidade

Conceitos Básicos e Definições

. ou seja, são 6 dezenas sorteadas, dentre as d escolhidas e (d − 6) não sorteadas;

. Q acertos dentre as 6 dezenas sorteadas e (6 − Q) erros, dentre as dezenas não

sorteadas;

!

6

Q

d−6

6−Q

!

(1.8)

. se o apostador acertar as 6 dezenas, então Q = 6 e o número de senas é igual a

6

6

!

d−6

6−6

!

=

6

6

!

d−6

0

!

=1

Este resultado é óbvio, uma vez que o procedimento de escolha implica a inexistência de

repetições, logo, haverá apenas um jogo de seis dezenas coincidindo com as dezenas sorteadas. Mas, acertando a sena, quantas quinas e quadras são, também, obtidas?

O raciocínio é o mesmo que no caso anterior, isto é, tendo feito a sena, sendo Q acertos

dentre as 6 dezenas sorteadas e (6 − Q) erros dentre as não sorteadas, então

. fazendo Q = 5, o número de quinas obtidas é dado por

6

5

!

d−6

6−5

!

6

5

=

!

d−6

1

!

= 6(d − 6), d > 6

. da mesma forma, para Q = 4, o número de quadras é

6

4

!

d−6

6−4

!

=

6

4

!

d−6

2

!

=

15 (d − 6)(d − 7)

, d > 6.

2

. Se d = 10, como no exercício anterior, então, além de ganhar na megasena, o apostador

conseguirá

6

5

!

6

4

!

4

1

!

4

2

!

= 24 quinas e

= 90 quadras

Pode-se generalizar o resultado em (1.8) para os casos em que o apostador acerte 5

dezenas (faz a quina) ou apenas 4 dezenas (faz a quadra). Desta forma, substituindo-se os

40

Teoria da Probabilidade

Conceitos Básicos e Definições

valores 6 na primeira linha de (1.8) por 5 e 4, respectivamente, pode-se calcular o número de

quinas e quadras, possíveis, para as duas situações.

i) Se o apostador acertar 5 das dezenas sorteadas:

5

Q

!

d−5

6−Q

!

. com Q = 5, serão (d − 5) quinas, d > 6,

. com Q = 4, o número de quadras é igual a

5(d − 5)(d − 6)

, d > 6.

2

ii) Acertando-se 4 dezenas:

4

Q

. com Q = 4, consegue-se

!

d−4

6−Q

!

(d − 4)(d − 5)

, quadras d > 6.

2

Na Tabela 1.2 são apresentados os números de senas, quinas e quadras se acertar 6, 5

ou 4 dezenas, dentre as d escolhidas, com todas as Cd,6 apostas possíveis.

Tabela 1.2: Número de senas, quinas e quadras na megasena nos jogos com d dezenas

escolhidas e combinadas.

Dezenas

Acertos

número

apostadas

6

5

4

de

d

senas quinas quadras quinas quadras quadras

jogos

6

1

0

0

1

0

1

1

7

1

6

0

2

5

3

7

1

12

15

3

15

6

28

8

9

1

18

45

4

30

10

84

10

1

24

90

5

50

15

210

11

1

30

150

6

75

21

462

12

1

36

225

7

105

28

924

13

1

42

315

8

140

36

1716

14

1

48

420

9

180

45

3003

15

1

54

540

10

225

55

5005

41

Teoria da Probabilidade

2

Variáveis Aleatórias

Variáveis Aleatórias

Dado um fenômeno aleatório, definido num espaço de probabilidade (Ω, A , P ), tem-se o

interesse em conhecer a estrutura probabilística de quantidades associadas a esse fenômeno.

Para isso, se faz necessário a introdução do conceito de variável aleatória e a especificação

de modelos para tais variáveis.

Definição 2.1. Seja o espaço de probabilidade (Ω, A , P ), então, define-se por variável aleatória, ou simplesmente v.a., qualquer função X : Ω → R tal que:

X

−1

n

o

(Ω) = ω ∈ Ω : X(ω) ∈ I ∈ A ,

para todo intervalo I ⊂ R.

Uma variável aleatória é uma função que leva os elementos do espaço amostral Ω a um

subconjunto dos reais R (Figura 2.1).

Figura 2.1: Variável aleatória X : Ω → R.

Exemplo 2.1. As variáveis aleatórias são classificadas em dois tipos:

i) VA discreta: é aquela para a qual o conjunto I é um conjunto finito ou infinito enumerável,

por exemplo:

n

o

a) I = 1, 2, 3, 4, 5, 6 ;

42

Teoria da Probabilidade

Variáveis Aleatórias

n

o

b) I = N = 0, 1, 2, 3, 4, ... .

ii) VA contínua: é aquela para a qual o conjunto I é um conjunto infinito não enumerável,

ou seja, é uma v.a. que assume valores em intervalos de números reais, por exemplo:

a) I = R = (−∞, ∞);

b) I = [0, 1] ⊂ R.

Notas:

a) Para v.a.’s contínuas, a função que normalmente associa pontos de Ω ao conjunto I ⊆

R, é a função identidade;

b) Para v.a.’s discretas, a função que normalmente associa pontos de Ω ao conjunto I ⊆ R,

é uma contagem ou soma.

2.1

Variáveis Aleatórias Discretas

X é uma v.a. discreta, num espaço de probabilidade (Ω, A , P ), é uma n

função com doo

mínio em Ω e cujo contradomínio é um conjunto finito ou infinito enumerável x1 , x2 , x3 , . . .

n

o

dos números reais R, tal que, ω ∈ Ω : X(ω) = xi é um evento para todo i e, portanto,

pode-se calcular a sua probabilidade de ocorrência

h

i

P {ω ∈ Ω : X(ω) = xi } ,

i = 1, 2, 3, . . . .

Notas:

n

o

n

o

a) Por simplicidade, representamos o evento ω ∈ Ω : X(ω) = xi por X = xi e as

probabilidades são simplificadas por:

h

i

P {ω ∈ Ω : X(ω) = xi } = P (X = xi )

n

o

∗

b) Se x ∈

/ I, então ω ∈ Ω : X(ω) = x = ∅, que também é um evento. Nesse caso,

∗

P

h

ω ∈ Ω : X(ω) = x

43

∗

i

= P (X = x∗ ) = 0

Teoria da Probabilidade

Variáveis Aleatórias

c) Se o conjunto I de possíveis valores de uma v.a. discreta X é formado por valores

inteiros, ou inteiros não negativos, então, X é uma v.a. inteira, ou uma v.a. interia não

negativa. A maioria das v.a.’s discretas são inteiras não negativas.

Definição 2.2. Função de probabilidade de uma v.a. discreta X é uma função p(x) que

atribui probabilidade a cada um dosnpossíveis valores

o de X .

Seja X assumindo valores I = x1 , x2 , x3 , . . . , então, para todo x ∈ I

p(x) = P (X = x).

Propriedades: A função p(x) de X em (Ω, A , P ) satisfaz:

a) 0 ≤ p(xi ) ≤ 1, ∀ xi ∈ I;

b)

X

p(xi ) = 1.

i

Prova:

a) Como p(x) é uma medida de probabilidade, por definição, 0 ≤ p(x) ≤ 1;

o

n

b) Como, por definição, os eventos w ∈ Ω : X(ω) = xi , i = 1, 2, . . . são disjuntos, então

X

i

p(xi ) =

X

P (X = xi )

i

=P

"

[n

w ∈ Ω : X(ω) = xi

#

o

i

= P (Ω) = 1.

Definição 2.3. Função de distribuição, também chamada de função de distribuição acumulada (fda) de uma v.a. discreta X é uma função F (x) que retorna a probabilidade de X

assumir valores até o ponto x.

n

o

Seja X assumindo valores I = x1 , x2 , x3 , . . . , então, para todo x ∈ I

F (x) = P (X ≤ x).

Propriedades: F (x) apresenta as propriedades:

44

Teoria da Probabilidade

Variáveis Aleatórias

a) F (x) é uma função do tipo escada, ou seja, para os pontos xi , xi+1 ∈ I e x tal que

xi ≤ x < xi+1 ,

F (x) = F (xi ),

isto é, F (x) é constante no intervalo [xi , xi+1 ) (ver Figura 2.2).

b) Dada F (x), para xa e xb ∈ I, tal que xa < xb ,

P (xa < X ≤ xb ) = F (xb ) − F (xa ).

Desta forma, para um valor qualquer xi ∈ I, tem-se

p(xi ) = F (xi ) − F (xi−1 ),

ou seja, a probabilidade num ponto xi é dada pela altura do “degrau” em F (xi ).

Exemplo 2.2. Seja a v.a. X discreta, com distribuição de probabilidade dada por:

x

p(x)

F (x)

0

1

2

3

4

5

0.15

0.28

0.26

0.18

0.08

0.05

0.15

0.43

0.69

0.87

0.95

1.00

Assim, temos:

a) p(3) = P (X = 3) = 0.18;

b) F (2) = P (X ≤ 2) = P (X = 0) + P (X = 1) + P (X = 2) = 0.69;

c) P (1 ≤ X < 5) = P (0 < X ≤ 4) = F (4) − F (0) = 0.80,

Ainda: P (1 ≤ X < 5) =

4

X

P (X = x) = 0.28 + 0.26 + 0.18 + 0.08 = 0.80;

x=1

d) P (2 ≤ X ≤ 4) = F (4) − F (1) = 0.52.

Exemplo 2.3. Considere 2 lançamentos independentes de uma moeda

n equilibrada. oDefinindo

X como sendo o número de caras nos 2 lançamentos, temos Ω =

Logo:

45

cc; cc̄; c̄c; c̄c̄ .

Teoria da Probabilidade

Variáveis Aleatórias

h

i

p(0) = P { c̄c̄ } X( c̄c̄ ) = 0 = 1/4

h

i

p(1) = P { cc̄ } ∪ { c̄c } X( cc̄ ) = X( c̄c ) = 1 = 1/2

i

p(2) = P { cc } X( cc ) = 2 = 1/4

h

Portanto, a função de probabilidade de X , é dada por:

x

p(x)

0

1/4

1

1/2

2

1/4

A função de distribuição da v.a. X , é dada por:

0,

1/4,

F (x) =

3/4,

1,

x < 0;

0 ≤ x < 1;

1 ≤ x < 2;

x ≥ 2.

Figura 2.2: Função distribuição acumulada da v.a. X

Exemplo 2.4. Seja uma v.a. X assumindo os valores { 3, 4, 5, 6 }. Obter k ∈ R de modo que

p(x) seja uma função de probabilidade:

p(x) = k (x − 2)2

46

Teoria da Probabilidade

Variáveis Aleatórias

Das propriedades da função de probabilidade,

X

p(x) = 1, portanto:

x

k [(3 − 2)2 + (4 − 2)2 + (5 − 2)2 + (6 − 2)2 ] =1

k [1 + 22 + 32 + 42 ] =1

30k =1

1

k= .

30

(x − 2)2

, x ∈ {3, 4, 5, 6}.

Desta forma, a função de probabilidade de X é dada por p(x) =

30

Exemplo 2.5. Considere o jogo no qual um alvo circular de raio 1 é dividido em n regiões

anelares concêntricas de raio 1/n, 2/n, . . . , 1. Lança-se um dardo ao acaso e, se ele atingir a

região Ai , delimitada pelos raios (i − 1)/n e i/n, i = 1, 2, . . . , n, ganha-se (n − i) reais (ver

Figura 2.3)

An

0

An−1

1

R=1

A2 n − 2

A1

n−1

Figura 2.3: Regiões anelares identificadas em vermelho e ganho obtido em azul.

Seja a v.a. X = importância ganha em um lançamento, obtenha a função de probabilidade

de X .

Aqui, o espaço de probabilidade (Ω, A , P ) é o espaço uniforme sobre o disco de raio 1.

X é uma v.a. discreta definida neste espaço, assumindo os valores {0, 1, 2, . . . , n − 1}.

Ainda, Ai = {X = n − i} é um evento que ocorre se, e só se, o dardo atinge a região

delimitada pelos círculos de raios (i − 1)/n e i/n.

47

Teoria da Probabilidade

Variáveis Aleatórias

A probabilidade para o evento Ai são dadas por:

P (X = n − i) =

área de Ai

área total

2

2

i−1

i

−π

π

n

n

P (X = n − i) =

π

P (X = n − i) =

i2 − (i2 − 2i + 1)

n2

P (X = n − i) =

2i − 1

,

n2

i = 1, 2, . . . , n.

Com x = n − i, então, a função de probabilidade de X é:

2(n − x) − 1

, x ∈ {0, 1, 2, . . . , (n − 1)}

n2

p(x) =

0,

c.c.

Com p(x) assim definida:

i) Certifique-se de que p(x) é de fato uma função de probabilidade;

ii) Calcule a probabilidade de se acertar a região mais central do alvo (mosca).

2.2

2.2.1

Principais modelos de discretos

Variável Aleatória Constante

Seja uma v.a. X que associa um único valor k ∈ R para todo ω ∈ Ω.

Então {ω ∈ Ω | X(ω) = k} é todo o espaço amostral Ω e, X(ω) = k é uma v.a. discreta

com função de probabilidade:

(

p(x) =

1, x = k

0, x =

6 k.

A função de probabilidade de uma v.a. é também chamada de degenerada em k e sua

48

Teoria da Probabilidade

Variáveis Aleatórias

função de distribuição é dada por

(

F (x) =

0, x < k

1, x ≥ k.

Na Figura (2.4) são apresentadas as funções de probabilidade p(x) e de distribuição F (x)

1

●

p(x)

F(x)

1

para o modelo degenerado num ponto.

●

k

k

X

X

Figura 2.4: Funções de probabilidade (esquerda) e de distribuição (direita) do modelo degenerado num ponto

2.2.2

Distribuição uniforme discreta

Considere a v.a. X assumindo valores em I = {x1 , x2 , . . . , xn }. X tem distribuição uniforme discreta se cada elemento de I tiver mesma probabilidade, ou seja

1

n, x∈I

p(x) = P (X = x) =

0, x ∈

/I

Notação: X ∼ Ud (I)

Notas:

i) O modelo uniforme discreto considera que os elementos x1 , x2 , . . . , xn de I são equiprováveis.

49

Teoria da Probabilidade

Variáveis Aleatórias

ii) Normalmente I é um subconjunto dos naturais (I ⊂ N) definido por limites [a, b], em que

a < b são os parâmetros do modelo. Neste caso

X ∼ Ud (a, b).

A função de distribuição acumulada da v.a. da uniforme discreta é definida por

P

i I[xi |xi ≤x]

F (x) =

n

x ∈ {x1 , x2 , . . . , xn },

em que I[xi |xi ≤x] = 1, se xi ≤ x e I[xi |xi ≤x] = 0, caso contrário.

Exemplo 2.6. Considere o lançamento de um dado equilibrado e seja a v.a. X = valor

observado, então, I = {1, 2, 3, 4, 5, 6} e X ∼ Ud (1, 6)

p(x) =

F (x) =

1

,

6

x

6

x = 1, 2, 3, 4, 5, 6;

x = 1, 2, 3, 4, 5, 6.

Na Figura (2.5) são apresentadas as funções de probabilidade e de distribuição acumulada

●

1

1/6

para o exemplo.

●

p(x)

F(x)

●

●

●

●

●

●

●

●

●

●

1

2

3

4

5

6

1

X

2

3

4

5

6

X

Figura 2.5: Funções de probabilidade (esquerda) e de distribuição (direita) do modelo Ud (1, 6)

50

Teoria da Probabilidade

2.2.3

Variáveis Aleatórias

Distribuição de Bernoulli

Considere, agora, um evento A ⊂ Ω, tal que, X(ω) = 1, se ω ∈ A e X(ω) = 0, se ω ∈ Ac ,

então, A ocorre se, e só se, X(ω) = 1.

A v.a. X é uma variável indicadora de A, pois o valor de X indica a ocorrência de A e,

P (A) = P [{ω ∈ Ω | X(ω) = 1}] = P (X = 1)

Normalmente, o evento A é chamado de sucesso e Ac de fracasso e a v.a. assim definida, é chamada de v.a. de Bernoulli, em que p = P (A) é a probabilidade de sucesso e

(1 − p) = P (Ac ) é a probabilidade de fracasso.

Notas:

i) Uma realização da v.a. de Bernoulli recebe o nome de “ensaio de Bernoulli ”.

ii) Ensaio de Bernoulli é todo experimento com apenas dois resultados possíveis, denotados por sucesso e fracasso. Esses resultados são representados pelos valores 1 e 0 da

v.a. X , com probabilidades de corrência p e (1 − p), respectivamente. Assim,

X = 1, representa um sucesso,

X = 0, representa um fracasso.

iii) A probabilidade de sucesso p é o parâmetro do modelo de Bernoulli.

Seja X uma variável de Bernoulli com probabilidade de sucesso p, então, sua função de

probabilidade é definida por

1 − p, x = 0

p(x) =

p,

x=1

0,

x 6= 1 e x 6= 0.

Notação: para indicar que uma v.a. tem distribuição de Bernoulli, usamos a seguinte

notação:

X ∼ Bernoulli(p).

A função de probabilidade para o modelo de Bernoulli pode ser mais elegantemente representada por:

p(x) = px (1 − p)1−x ,

51

x = 0, 1.

Teoria da Probabilidade

Variáveis Aleatórias

A função de distribuição para o modelo de Bernoulli, por sua vez, é dada por

0,

x<0

F (x) =

1 − p, 0 ≤ x < 1

1,

x ≥ 1.

A Figura (2.6) apresenta as funções de probabilidade e de distribuição acumulada para o

modelo de Bernoulli com parâmetro p.

Nota: Como veremos no restante da seção, a v.a. de Bernoulli serve de base para a

●

●

●

p

p(x)

F(x)

1−p

1

1−p

definição de grande parte dos modelos discretos de probabilidade.

●

0

1

0

X

1

X

Figura 2.6: Funções de probabilidade (esquerda) e de distribuição (direita) do modelo

Bernoulli (p)

2.2.4

Distribuição binomial

Exemplo 2.7. Considere o experimento no qual uma moeda honesta é lançada três vezes,

sendo que a probabilidade de se obter cara em um lançamento é p e de se obter coroa é

(1 − p), 0 ≤ p ≤ 1.

Para este experimento, o espaço amostral é dado por

Ω = {(c, c, c), (c, c, c̄), (c, c̄, c), (c̄, c, c), (c, c̄, c̄), (c̄, c, c̄), (c̄, c̄, c), (c̄, c̄, c̄)}

em que c = cara e c̄ = coroa.

Definindo a v.a. X = número de caras obtidos nos três lançamentos, determinar a função

de probabilidade de X .

52

Teoria da Probabilidade

Variáveis Aleatórias

Para cada elemento do espaço amostral, a v.a. X assume os valores:

⇒ X(c, c, c) = 3

ω = (c, c, c)

ω = (c, c, c̄)

ω = (c, c̄, c)

ω = (c̄, c, c)

⇒ X(c, c, c̄) = X(c, c̄, c) = X(c̄, c, c) = 2

ω = (c, c̄, c̄)

⇒ X(c, c̄, c̄) = X(c̄, c, c̄) = X(c̄, c̄, c) = 1

ω = (c̄, c, c̄)

ω = (c̄, c̄, c)

ω = (c̄, c̄, c̄)

⇒ X(c̄, c̄, c̄) = 0

Uma vez que os lançamentos da moeda são independentes, a v.a. X tem a seguinte

função de probabilidade:

x

0

1

2

3

p(x)

(1 − p)3

3p(1 − p)2

3p2 (1 − p)

p3

Os três elementos de Ω para os quais X = 2, resultam das possíveis combinações nas

quais são obtidas duas cara e uma coroa, implicando que a probabilidade individual p2 (1 − p)

seja multiplicada por 3. Desta forma, a probabilidade P (X = 2) pode ser escrita como

3 2

p(2) =

p (1 − p).

2

O mesmo acontece com X = 1, resultado das possíveis combinações nas quais se obtem

uma cara nos três lançamentos da moeda, sendo a probabilidade P (X = 1) escrita por

3

p(1) =