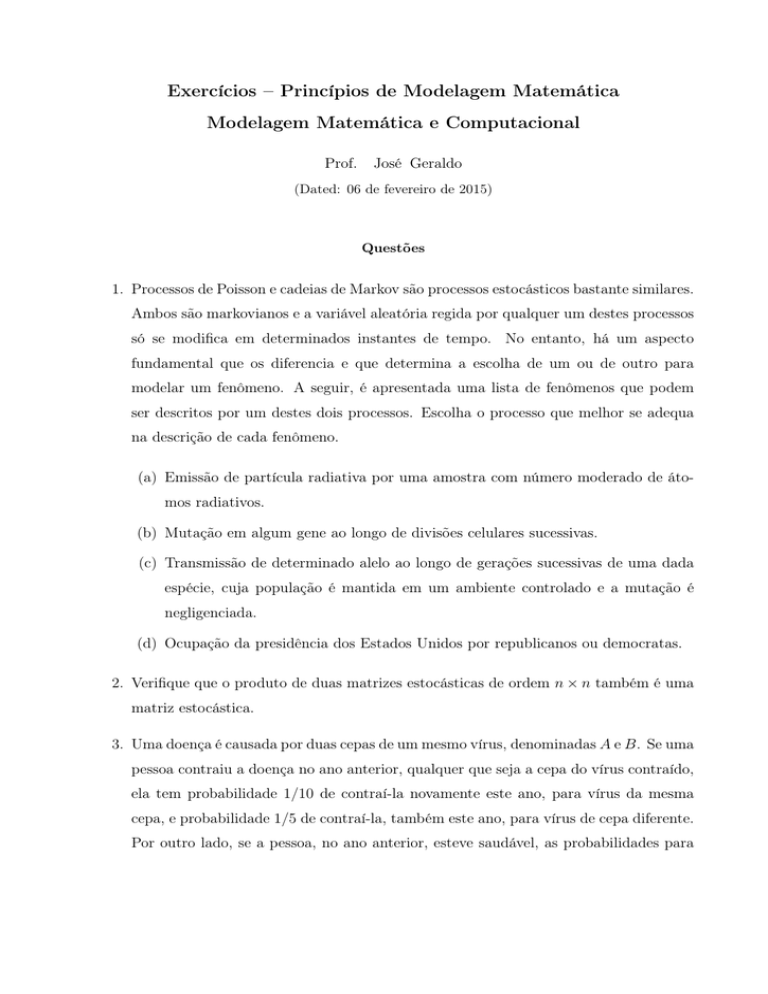

Exercícios – Princípios de Modelagem Matemática

Modelagem Matemática e Computacional

Prof.

José Geraldo

(Dated: 06 de fevereiro de 2015)

Questões

1. Processos de Poisson e cadeias de Markov são processos estocásticos bastante similares.

Ambos são markovianos e a variável aleatória regida por qualquer um destes processos

só se modifica em determinados instantes de tempo. No entanto, há um aspecto

fundamental que os diferencia e que determina a escolha de um ou de outro para

modelar um fenômeno. A seguir, é apresentada uma lista de fenômenos que podem

ser descritos por um destes dois processos. Escolha o processo que melhor se adequa

na descrição de cada fenômeno.

(a) Emissão de partícula radiativa por uma amostra com número moderado de átomos radiativos.

(b) Mutação em algum gene ao longo de divisões celulares sucessivas.

(c) Transmissão de determinado alelo ao longo de gerações sucessivas de uma dada

espécie, cuja população é mantida em um ambiente controlado e a mutação é

negligenciada.

(d) Ocupação da presidência dos Estados Unidos por republicanos ou democratas.

2. Verifique que o produto de duas matrizes estocásticas de ordem n × n também é uma

matriz estocástica.

3. Uma doença é causada por duas cepas de um mesmo vírus, denominadas A e B. Se uma

pessoa contraiu a doença no ano anterior, qualquer que seja a cepa do vírus contraído,

ela tem probabilidade 1/10 de contraí-la novamente este ano, para vírus da mesma

cepa, e probabilidade 1/5 de contraí-la, também este ano, para vírus de cepa diferente.

Por outro lado, se a pessoa, no ano anterior, esteve saudável, as probabilidades para

2

ela contrair a cepa A ou para contrair a cepa B são iguais a 1/10. Supondo que este

processo seja markoviano, responda as questões a seguir:

(a) Obtenha a matriz de probabilidades de transição para este processo estocástico.

(b) Que fração da população, a longo prazo, permanecerá saudável?

4. Considere um processo de Poisson N (t) descrito pela distribuição de probabilidades

0

Pr (N (t) − N (t0 ) = k) = e−λ(t−t )

λk (t − t0 )k

,

k!

onde k = 0, 1, 2 . . . e t > t0 . Por exemplo, a variável aleatória N (t) descreve o número

de chamadas telefônicas que chegaram a uma central até o tempo t. Suponha que o

processo de contagem tenha sido disparado em t = 0 e que, portanto, N (0) = 0.

(a) Obtenha a probabilidade para que, no tempo t > 0, pelo menos uma chamada

tenha sido registrada na central. Em outras palavras, determine Pr (N (t) ≥ 1).

(b) Qual é o tempo médio de espera entre chamadas?

Cadeias de Markov absorventes

Considere uma cadeia de Markov caracterizada pela matriz de probabilidades de transição

W = [wij ] de ordem m × m. Em outras palavras, a cadeia de Markov possui conjunto de m

estados possíveis, S = {s1 , s2 , . . . , sm }. Dizemos que o estado da cadeia si é absorvente se

tivermos wii = 1. Por outro lado, todo estado que não é absorvente é chamado transiente.

Se uma cadeia de Markov possui estados absorventes, ela é chamada de cadeia de Markov

absorvente.

Um exemplo: considere um bêbado que está tentando chegar a um bar que fica a quatro

quarteirões da casa onde mora. Enumere as posições dos quarteirões como 0 (a casa do

bêbado), 1 (o primeiro quarteirão), etc, até 4 (o bar). Se o bêbado está na posição 0 ou na

posição 4, ele permanece aí indefinidamente. Por outro lado, se ele está nos quarteirões 1,

2 ou 3, ele tem iguais probabilidades de seguir para o próximo quarteirão, em direção ao

bar, ou recuar para o quarteirão anterior, em direção a sua casa. A matriz probabilidades

3

de transição, neste caso, é (verifique!)

0

1 1/2 0

0

1

0 0 1/2 0

2

0 1/2 0 1/2

3

0 0 1/2 0

4 0 0 0 1/2

0

0

0

.

0

1

(1)

Os números que aparecem à esquerda indicam a posição do bêbado.

Uma cadeia de Markov absorvente sempre evolui de forma a atingir um dos seus estados

absorventes. Em outras palavras, a probabilidade de uma cadeia de Markov atingir um dos

estados absorventes, após n passos de tempo, é igual a 1. Isto pode ser verificado facilmente,

bastando reordenar o espaço de estados para que os estados absorventes apareçam por

último. Para o exemplo acima, o espaço de estados do bêbado, assim reordenado, ficaria

S = {1, 2, 3, 0, 4}. Com este reordenamento, a matriz de probabilidades de transição é dada

por (verifique!)

0 1/2 0

1/2

W=

0

1/2

0

0 0

0 1/2 0 0

1/2 0 0 0

.

0 0 1 0

0 1/2 0 1

(2)

Note que, de modo geral, usando tal reordenamento, uma matriz de probabilidades de

transição para uma cadeia de Markov absorvente tem a forma “em blocos”

..

Q . 0

.

W = · · · .. · · · ,

..

R . I

(3)

onde Q é a matriz de probabilidades de transição associada aos estados transientes apenas,

I é uma matriz identidade, R uma matriz não-nula e 0 uma matriz nula. Se a cadeia de

Markov possui q estados transientes e r estados absorventes, então as ordens dessas matrizes

são, respectivamente, q × q, r × r, r × q e q × r.

1. O produto de matrizes com o formato em blocos, tais como a matriz apresentada em

Eq. (3), segue o mesmo algoritmo do produto de duas matrizes 2 × 2 ordinárias. Por

4

exemplo, o produto de W por ela mesma produz

..

2

Q

. 0

..

2

W = ···

. ··· .

.

RQ + R .. I

Mostre que

..

Q . 0

..

n

W = ··· . ··· ,

..

∗ . I

n

onde ∗ indica uma matriz r × q que não nos interessa.

2. Para a matriz W dada pela Eq. (2), verifique que os vetores de probabilidade

0

0

0

0

e P4 = 0

P0 =

0

0

1

1

0

são estacionários para a cadeia de Markov que caracteriza o movimento do bêbado.

3. Para o bloco Q da matriz de probabilidades de transição W dada pela Eq. (3),

sabe-se que limn→∞ Qn = 0 . Este resultado é a forma matemática de dizer que,

com probabilidade 1, qualquer vetor de probabilidades inicial vai convergir para um

dos estados absorventes. Para uma cadeia de Markov absorvente, cuja matriz de

probabilidades de transição é dada pela Eq. (3), verifique que a matriz I − Q, onde

I é matriz identidade de ordem q × q, tem uma inversa N e ela é dada por N =

I+Q+Q2 +. . .. N é chamada de matriz fundamental da cadeia de Markov absorvente.

A entrada nij de N dá o número médio de vezes que o estado transiente si é ocupado

caso o processo tenha se iniciado no estado transiente sj .

Adjutório: use, de modo sistemático, o limite limn→∞ Qn = 0.

4. Para a cadeia de Markov do exemplo do bêbado, calcule a matriz fundamental N.