Cadeias de Markov

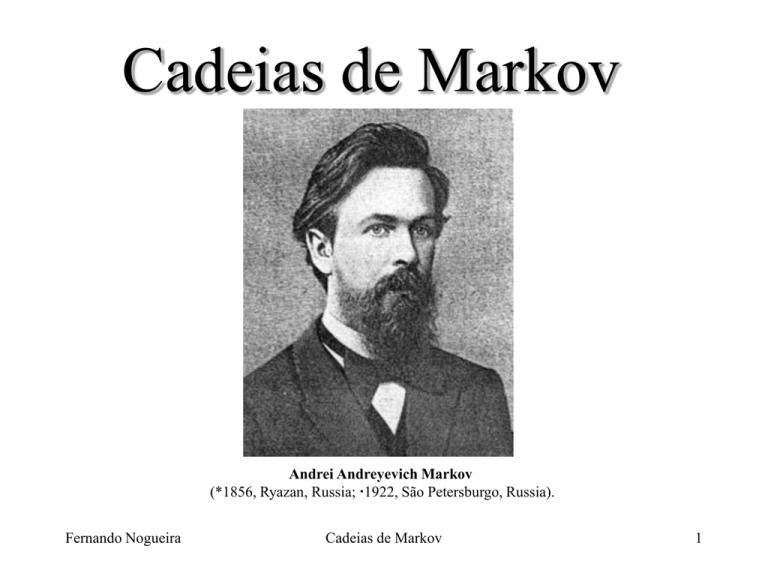

Andrei Andreyevich Markov

(*1856, Ryazan, Russia; 1922, São Petersburgo, Russia).

Fernando Nogueira

Cadeias de Markov

1

Introdução

Processos Estocásticos Processos que evoluem no tempo de maneira probabilística.

Processos Estocásticos (formal) coleção de variáveis randômicas (X(t)) indexadas

por um parâmetro t, com t T . X(t) representa o estado do sistema no parâmetro

(tempo) t. Portanto, X(t) é definido em um espaço denominado Espaço de Estados.

Classificação em relação ao Estado

Estado Discreto (cadeia): X(t) é definido sobre um conjunto enumerável ou finito

Estado Contínuo (seqüência): X(t) caso contrário

Classificação em relação ao Tempo (Parâmetro)

Tempo Discreto: t é finito ou enumerável

Tempo Contínuo: t caso contrário

Exemplos

1) Número de usuários em uma fila em um determinado instante: Estado Discreto e

Tempo Contínuo.

2) Índice pluviométrico diário: Estado Contínuo e Tempo Discreto.

3) Número de dias chuvosos: Estado Discreto e Tempo Discreto.

Fernando Nogueira

Cadeias de Markov

2

Processos Markovianos

Um Processo Estocástico é dito ser um Processo Markoviano se:

PX(t k 1 ) x k 1 X(t k ) x k , X(t k 1 ) x k 1 ,...,X(t 1 ) x1 , X(t 0 ) x 0 PX(t k 1 ) x k 1 X(t k ) x k

para t 0 t1 ...t k t k 1 0,1,...

e toda seqüência

k 0 , k1 ,..., k t 1 , k t , k t 1

Um Processo Markoviano é uma Cadeia de Markov em Tempo Discreto se:

PX(k 1) x k 1 X(k) x k , X(k 1) x k 1 ,...,X(1) x1 , X(0) x 0 PX(k 1) x k 1 X(k) x k

Probabilidade de Transição PX(k 1) x k 1 X(k) x k

Probabilidade de Transição é dita Estacionária se:

PX(k 1) x k 1 X(k) x k PX(1) x1 X(0) x 0

Probabilidade de transição de passo 1

Probabilidade de Transição de passo 1 implica que:

PX(k n) x k n X(k) x k PX(n) x n X(0) x 0

Probabilidade de transição de passo n

Notação simplificada p ij(n) PX(k n) j X(k) i

Matriz de Transição de Passo n

Fernando Nogueira

p 00n

n

p

P n 10

...

n

p M 0

Cadeias de Markov

p 01n

n

p11

...

p Mn1

... p 0nM

... p1nM

...

...

n

... p MM

3

Exemplo 1

O estado no ano de 1993 do uso da terra em uma cidade de 50 Km2 de área é:

Vetor de Estados

x I II III

Vetor de Probabilidade de Estado

0.30 0.20 0.50

O estado no ano de 1998 do uso da terra é

Matriz de Transição

0.8 0.1 0.1

P 0.1 0.7 0.2

0.0 0.1 0.9

0.8 0.1 0.1

1 0 P 30 20 50 0.1 0.7 0.2 26 22 52

0.0 0.1 0.9

Fernando Nogueira

Cadeias de Markov

4

Equações de Chapman - Kolmogorov

Permite computar a matriz de transição para n passos (de t para t + n).

para todo i, j = 0, 1, ..., M

M

n

p ij p ikm p nkj m P n P m .P n m P n P n

qualquer m = 1, 2, ..., n-1

k 0

notação matricial

qualquer n = m+1, m+2, ....

Classificação de Estados em Cadeias de Markov

Estado Alcançável j é alcançável a partir de i se p ijn 0 para algum n 0

Estado Comunicante j é comunicante com i se j é alcançável a partir de i e vice-versa

Estado 0

1

0

0

1

1

0

1 p

P

0 1 p

2

3

0

0

2 3

0 0

p 0

0 p

0 1

1 é comunicante com 2

n

2 não é alcançável a partir de 3 p 32

0, n 0

Se todos estados são comunicantes Cadeia Irredutível

Estado Transiente i é transiente se e somente se existe um estado j j i que é

alcançável a partir do estado i mas não vice-versa.

Estado Recorrente i é recorrente se não é transiente.

Estado Absorvente i é recorrente se pii = 1.

Fernando Nogueira

Cadeias de Markov

5

Um conjunto C de estados é dito ser um Conjunto Fechado se o processo ao entrar em

um destes estados de C, este irá permanecer nos estados de C indefinidamente.

Um conjunto Cm de estados é dito ser um Conjunto Fechado Mínimo se este conjunto

não possui sub-conjuntos fechados.

Estado

0

1

P 2

3

4

0

1

4

1

2

0

0

1

1

3

1

4

2

0

0

0

2

0

0

1

1

3

0

3

0

4

0

0 0

0 0

2

0

3

0 0

0 e 1 são recorrentes 0, 1 e 2 formam um Conj. Fechado

2 é absorvente

0 e 1 formam um Conj. Fechado Mínimo

3 e 4 são transientes 2 Conj. Fechado Mínimo

Estado Periódico i é periódico com período t se um retorno a este estado é possível

somente em t, 2t, 3t,... passos para t>1. p iin 0 sempre quando n não é divisível por t.

Estado Aperiódico se t = 1.

Em uma Cadeia de Markov

1

0

de estado finito, estados

0 1

0

2

2

1

0 1

recorrentes aperiódicos são

0

1

2

2

P

1

2

0

chamados

de

estados

2 12 0

1

3

1

0

0

Ergódicos. Uma Cadeia de

2

2

1e 2 são periódicos todos estados são periódicos Markov é Ergódica se todos

os estados são ergódicos.

com t = 2

com t = 2

Estado 0

1

0

0

1

1 p

1

0

P

0 1 p

2

3

0

0

2 3

0 0

p 0

0 p

0 1

Fernando Nogueira

Estado

0

1

2

3

Cadeias de Markov

6

Probabilidades de Estados Estavéis (Steady-State)

Se a Cadeia de Markov é Ergódica e Irredutível, a distribuição de probabilidade dos

estados a longo período independe da distribuição de probabilidade inicial dos

estados 0 .

0.080

1 0.632

P

0.264

0.080

0.184 0.368 0.368

0.368

0

0

0.368 0.368

0

0.184 0.368 0.368

0.249

0.283

2

P

0.351

0.249

0.286

0.300

0.252

0.233

0.319

0.233

0.286

0.300

0.165

0.233

0.097

0.165

0.286

0.286

8

P

0.286

0.286

0.285

0.264

0.285

0.264

0.285

0.264

0.285

0.264

0.166

0.166

0.166

0.166

0.286

0.286

P

0.286

0.286

0.285

0.285

0.285

0.285

0.264

0.264

0.264

0.264

0.166

0.166

0.166

0.166

0.289

0.282

4

P

0.284

0.289

0.286

0.285

0.283

0.286

0.261 0.164

0.268 0.166

0.263 0.171

0.261 0.164

0 .P

0.286 0.285 0.263 0.166

para qualquer 0

Equações de Estados Estavéis

M

j i p ij para j = 0, 1, 2, . . ., M

M

i 0

j

1

para j = 0, 1, 2, . . ., M

.P

M+2 equações em M+1 incógnitas

0 1 2 3

0 0 p 00 1 p10 2 p 20 3 p 30

0 0 0.080 1 1 0.632 2 0.264 3 0.080

0.286 0.285 0.263 0.166

p p p p

0 0.184 0.368 1 0.368 0.184

0 01

1 11

2 21

3 31

0

1

2

3

1

0.286 0.285 0.263 0.166

0 0 0.368 2 0.368 1 3 0.368

2 0 p 02 1 p12 2 p 22 3 p 32

0.286 0.285 0.263 0.166

()

P

p p p p

0 0 0.368 3 0.368 1

0.286 0.285 0.263 0.166

0 03

1 13

2 23

3 33

3

1 0 1 2 3

1 0 1 2 3

0.286 0.285 0.263 0.166

Fernando Nogueira

Cadeias de Markov

7

j 0

Custo Médio Esperado por Unidade de Tempo

1 n k

lim

pij j , i

Se a Cadeia de Markov é Irredutível, o limite n n

sempre irá existir.

k 1

Seja C(Xt) uma função de custo (C() é uma variável randômica independente de t). O

M

custo médio esperado por unidade de tempo é: lim E 1 n CX t

j0 j C j

n

n

t

1

Exemplo

0

2

CX t

8

18

Se

se

se

se

se

Xt

Xt

Xt

Xt

0

1

2

3

1 n

lim E CX t 0.2860 0.2852 0.2638 0.16618 5.66

n

n t 1

1 se X t j

0 se X t j

CX t

custo médio esperado do estoque por semana

Fração do tempo em que o processo está no estado j

Tempos de Primeira Passagem tempo demandado para o processo atingir o estado j a

partir do estado i. Quando j = i Tempo de Recorrência para o estado i.

Denominando f ijn a probabilidade do Tempo de Primeira Passagem a partir do

estado i para o estado j ser n, pode-se escrever que:

f ij1 p ij1 p ij

Exemplo: Probabilidade do Tempo de Primeira Passagem a partir do

estado 3 (estoque cheio) para o estado 0 (estoque vazio) ser n:

2

1

f ij p ik f kj

k j

f ijn p ik f kjn 1

k j

1 p 0.080

f 30

30

2 p f 1 p f 1 p f 1 0.184 0.632 0.368 0.264 0.368 0.080 0.243

f 30

31 10

32 20

33 30

Fernando Nogueira

Cadeias de Markov

8

f 1 processo inicialmente no estado i, pode nunca alcançar o estado j

n 1

n

ij

n

n

f

1

f

é a distribuição de probabilidade para a variável aleatória Tempo

ij

ij

n 1

de Primeira Passagem

Tempo de Primeira Passagem Esperado

ij

nf ijn

n 1

se

se

n

f ij 1

n 1

n

f ij 1

n 1

Sempre quando

f 1 ij

n

n 1

ij

unicamente satisfaz

ij 1 p ik kj

k j

Exemplo: Tempo de Primeira Passagem Esperado a partir do estado 3 (estoque cheio)

para o estado 0 (estoque vazio):

30 1 p3110 p32 20 p33 30 30 1 0.18410 0.368 20 0.368 30 10 1.58 semanas

20 2.51semanas

20 1 p 2110 p 22 20 p 23 30 20 1 0.36810 0.368 20

30 3.50 semanas

10 1 p1110 p12 20 p13 30 10 1 0.36810

Tempo de Recorrência Esperado

1

1

00

3.50 semanas

jj

0

j

1

11

3.51 semanas

1

Fernando Nogueira

Cadeias de Markov

22

1

3.80 semanas

2

33

1

6.02 semanas

3

9

Classificação de Estados segundo a probabilidade do Tempo de Primeira Passagem

n

f

ii 1 ii Transiente

Um estado recorrente é Nulo se ii

n 0

n

f

ii 1 Re corrente

Um estado recorrente é Não-Nulo ou Positivo se ii

n 0

Um estado é Ergódico se é não-nulo e aperiódico

Estados Absorventes

fik probabilidade de absorção para o estado k dado que o sistema iniciou no estado i.

Seja k um estado absorvente, então o conjunto de probabilidades de absorção fik satisfaz

o seguinte sistema de equações:

M

f ik p ijf jk

j0

sujeito a:

f kk 1

f ik 0 se i é recorrente e i k

Fernando Nogueira

Exemplo: f20 e f24 ?

0

1

P 2

3

4

1

2

3

0

0

0

0

0

2

3

0

0

0

1

3

0

2

3

0

0

0

1

3

0

0

0

0

0

1

3

1

f 10 p10 f 00 p11f 10 p12 f 20 p13f 30 p14 f 40

f 20 p 20 f 00 p 21f 10 p 22 f 20 p 23f 30 p 24 f 40

f p f p f p f p f p f

30 00

31 10

32 20

33 30

34 40

30

Cadeias de Markov

4

5

1

5

f 20

f 24

10