Introdução a Inferência Bayesiana

Helio S. Migon

IM and COPPE - UFRJ

[email protected]

2006

Conteúdo

1. Conceitos Básicos da Inferência

2. Distribuição a Priori

3. Sumariazação

4. Inferência Preditiva

1

1 - CONCEITOS BÁSICOS DA INFERÊNCIA

1.1. Introdução

Informação

Objetivo é sempre máximar a informação para reduzir incerteza

Toda a informação de que dispomos é útil e deve ser aproveitada

Duas visões da Estatı́stica: Bayesiano e clássico

2

Exemplo: Considere os seguintes experimentos

i) Um músico especialista em música clássica: escolhidos ao acaso 10

trechos de partituras desses autores, o músico acerta o autor dos

10;

ii) Um bêbado: Feitos 10 lançamentos da moeda o bêbado acerta os

10 resultados;

iii) Uma velhinha inglesa apreciadora de chá: De 10 xı́caras enchidas

com leite e chá sem nenhuma ordem especı́fica, ela acerta os 10

resultados.

A informação obtida nos 3 experimentos é a mesma

Acreditamos mais na afirmação do músico que a da velhinha

e, certamente, mais que a do bêbado

3

O conceito de probabilidade Subjetiva

• A probabilidade de um evento A mede do grau de confiança em

A

Seja o evento A = ‘está chovendo em Moscou ’

i) Uma pessoa do Rio que não conhece nada sobre o clima de Moscou

poderia ter

P (A | H1 ) = 0, 5

ii) Uma pessoa em Leningrado poderı́amos ter:

0, 8, se chove em Leningrado

P (A | H2 ) =

0, 2, caso contrário

iii) Já para uma pessoa em Moscou:

1, se chove

P (A | H3 ) =

0, caso contrário

4

Construção subjetiva de probabilidade

Perdas quadráticas (de Finetti, 1975)

• A probabilidade p que atribuo

a A é obtida através da minimização da perda quadrática

(p − 1)2 , se E = 1

2

(p − E) =

p2 ,

se E = 0

É possı́vel obter as propriedades básicas de probabilidade.

i) p ∈ [ 0, 1 ]

ii) P (Ē) = 1 − P (E) As perdas possı́veis associadas às especificações

de P (E) = p e P (Ē) = q são:

E=1: (p − 1)2 + q 2

E=0: p2 + (q − 1)2

5

2

2

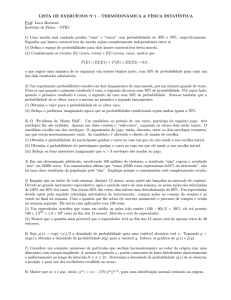

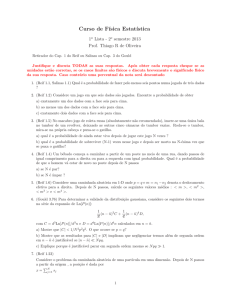

Figure 1: As perdas são dadas por AC quando E = 1 e BC quando E = 0

iii) P (E ∩ F ) = P (E | F )P (F ) Defina-se P (E | F ) como a probabilidade de E se F=1. Chamando essa probabilidade de p, P (F ) de

q e P (E ∩ F ) de r, temos como perda total dessas especificações

(p − E)2 F + (q − F )2 + (r − EF )2 com valores:

E=F=1 : (p − 1)2 + (q − 1)2 + (r − 1)2

E=0, F=1

: p2 + (q − 1)2 + r2

: q 2 + r2

F=0

6

1.2 - Elementos de Inferência

Teorema de Bayes

Quantidade de interesse desconhecida θ com valores em Θ

Informação inicial sumarizada por p(θ | H), onde H história

Dados: observação de uma quantidade aleatória X relacionada com θ

A distribuição amostral de X dada por p(X | θ, H)

7

A questão é como passar de p(θ | H) para p(θ | x, H)

p(θ | x, H) =

p(θ, x | H) p(x | θ, H) p(θ | H)

=

p(x | H)

p(x | H)

onde

Z

p(x | H) =

p(x, θ | H) dθ.

Θ

p(θ | x)

∝

p(x | θ) p(θ)

A constante da fórmula será

k

−1

Z

p(x | θ)p(θ) dθ = Eθ [p(x | θ)]

=

Θ

8

Função de verossimilhança

A função de verossimilhança de θ é

Θ → R+

l( · ; x) :

θ → l(θ ; x) = p(x | θ)

i)

R

R p(x | θ) dx = 1 mas

R

Θ l(θ ; x) dθ

= k 6= 1, em geral.

ii) A função de verossimilhança conecta a priori à posteriori usando

para isso os dados do experimento.

Exemplo: X ∼ Binomial(2,θ)

2 x

p(x | θ) = l(θ; x) =

θ (1 − θ)2−x , x = 0, 1, 2 ; θ ∈ Θ = (0, 1)

x

• Note que:

a) se x=1 então l(θ ; x = 1) = 2θ(1 − θ) e o valor mais provável (ou

verossı́mil) de θ é 1/2.

b) se x=2 então l(θ ; x = 2) = θ2 , valor mais provável é 1.

c) se x=0 então l(θ ; x = 0) = (1 − θ)2 , valor mais provável é 0.

9

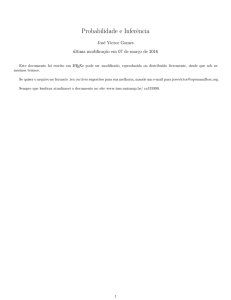

• Essas verossimilhanças estão plotadas na figura 2.1.

Figure 2: Função de verossimilhança para diferentes valores de x.

10

Exemplo

• João vai ao médico e este desconfia da doença A. Toma várias

providências: examina João, observa os sintomas e faz exames de

rotina.

Seja θ o indicador da doença A em João

O médico assume que P (θ = 1|H) = 0, 7

Exame de laboratório X do tipo +/- relacionado com θ

P (X = 1 | θ = 0) = 0, 40,

P (X = 1 | θ = 1) = 0, 95,

João faz o teste e o resultado é X=1

P (θ = 1 | X = 1) ∝ l(θ = 1 ; X = 1)P (θ = 1)

∝ (0, 95)(0, 7) = 0, 665

P (θ = 0 | X = 1)

∝ (0, 40)(0, 30) = 0, 120

11

P (θ = 1 | X = 1) = 0, 665/0, 785 = 0, 847 e

P (θ = 0 | X = 1)

= 0, 120/0, 785 = 0, 153

Médico pede a João teste Y, também, do tipo +/

P (Y = 1 | θ = 1) = 0, 99

P (Y = 1 | θ = 0) = 0, 04

Usando a priori p(θ|x)

p(y | x) =

X

p(y | θ) p(θ | x)

θ∈Θ

e portanto,

P (Y = 1 | X = 1)

= P (Y = 1 | θ = 1)P (θ = 1 | X = 1) +

+P (Y = 1 | θ = 0)P (θ = 0 | X = 1)

= (0, 99)(0, 847) + (0, 04)(0, 153) = 0, 845 e

P (Y = 0 | X = 1)

= 1 − P (Y = 1 | X = 1) = 0, 155

João faz o teste Y e observa-se Y=0

Agora

12

P (θ = 1 | X = 1, Y = 0) ∝ l(θ = 1 ; Y = 0)P (θ = 1 | X = 1)

.

∝ (0, 01)(0, 847) = 0, 0085

P (θ = 0 | X = 1, Y = 0)

∝ (0, 96)(0, 155) = 0, 1466

ou

P (θ = 1 | Y = 0, X = 1) = 0, 0085/0, 1551 = 0, 055

P (θ = 0 | Y = 0, X = 1) = 0, 1466/0, 1551 = 0, 945.

Resumindo

0, 7,

antes de X e Y

P (θ = 1) = 0, 847, após X e antes de Y

0, 055, após X e Y

13

Distribuição Preditiva

• Queremos prever Y cuja descrição probabilı́stica é P (Y | θ), que

pode independer de X

p(y | x) =

R

R

p(y,

θ

|

x)dθ

=

Θ

Θ p(y | θ, x)p(θ | x)dθ

R

= Θ p(y | θ)p(θ | x)dθ = Eθ|x [p(y | θ)]

Exemplo (cont.)

• Antes de observar Y , a nossa previsão atribuia muita chance em

Y = 1, mas o observado foi Y = 0. Isto deve levar o médico a

repensar o modelo.

Deve questionar se:

i) 0,7 refletia adequadamente P (θ = 1) ?

ii) O teste X é tão inexpressivo? A distribuição amostral de X é

correta?

iii) O teste Y é tão poderoso?

14

Natureza sequencial do teorema de Bayes

Observa-se X1 com probabilidade P1 (X1 | θ) levando a

p(θ | x1 ) ∝ l1 (θ ; x1 )p(θ)

Observa-se X2 com probabilidade P2 (X2 | θ), X2 ⊥ X1 |θ

p(θ | x2 , x1 )

∝ l2 (θ ; x2 )p(θ | x1 )

∝ l2 (θ ; x2 )l1 (θ ; x1 )p(θ)

Repetindo-se este processo n vezes

"

p(θ | xn , xn−1 , . . . , x1 ) ∝

n

Y

#

li (θ ; xi ) p(θ)

i=1

O teorema de Bayes satisfaz a

p(θ | xn , . . . , x1 ) ∝ ln (θ ; xn )p(θ | x1 , . . . , xn−1 )

15

Tma 1.1: Observação e priori normais

Sejam θ ∼ N (µ, τ 2 ), (X | θ) ∼ N (θ, σ 2 ), com σ 2 conhecido. Então,

a distribuição a posteriori de θ é (θ | X = x) ∼ N (µ1 , τ12 ) onde

µ1 =

τ −2 µ + σ −2 x

τ −2 + σ −2

e τ1−2 = τ −2 + σ −2

Note que:

1) A precisão a posteriori é a soma das precisões da priori e da

verossimilhança

2) Seja w = τ −2 /(τ −2 + σ −2 ), w ∈ (0, 1), logo

µ1 = wµ + (1 − w)x

3) Não é fácil usar o teorema de Bayes com prioris não normais.

Mistura de Normais

p(θ) =

X

αi pi (θ), αi > 0,

X

onde pi (θ) são normais.

16

αi = 1

Permutabilidade

Permutabilidade é um conceito mais fraco que o conceito de independência

Definição

Quantidades aleatórias X1 , . . . , Xn do tipo 0-1 são permutáveis se as n!

permutações (Xk1 , . . . , Xkn ) tem a mesma distribuição de probabilidade n-dimensional

Exemplo

• Uma urna com m bolas, r das quais com o número 1 e m-r com o

número 0. Selecionamos uma por vez, sem reposição e denotamos

por Xk o dı́gito da k-ésima bola selecionada. Assim X1 , . . . , Xn

é uma sequência permutável, mas as quantidades aleatórias não

são independentes.

• Tma. 1.2: Para toda sequência infinita de quantidades aleatórias

{Xn , n = 1, 2, . . . } permutáveis com valores em {0, 1} corresponde

uma distribuição F em (0,1) tal que:

Z

P (X1 = 1, . . . , Xk = 1, Xk+1 = 0, . . . , Xn = 0) =

0

17

1

θk (1−θ)n−k dF (θ) , ∀ n e k ≤ n

2 - DISTRIBUIÇÕES A PRIORI

• A partir do conhecimento sobre θ pode-se descrever sua densidade

por uma particular forma funcional.

O caso mais importante é o das distribuições conjugadas.

Def.: Seja F = { p(x|θ), θ ∈ Θ} uma famı́lia de distribuições amostrais

A classe Ψ é conjugada a F se

∀ p ∈ F e p(θ) ∈ Ψ então p(θ | x) ∈ Ψ

(i) A classe Ψ pode ser muito ampla.

(ii) A classe Ψ pode ser muito restrita.

Por exemplo: Ψ = {P : P (θ = θ0 ) = 1}

Exemplificando o processo de construção de famı́lias conjugadas

• Considere (Xi |θ) ∼ Ber(θ), θ ∈ (0, 1), i = 1, · · · , n. Logo

t

n−t

p(x | θ) = θ (1 − θ)

onde t =

n

X

xi

xi = 0, 1, i = 1, · · · , n

i=1

Do teorema de Bayes

18

p(θ | x)

∝ p(x | θ) p(θ)

∝ θt (1 − θ)n−t p(θ).

Note que p(θ) e p(θ | x) estão relacionadas através da verosssimilhança

• Assim se constroi a conjugada baseado no núcleo da verossimilhança que é da forma θa (1 − θ)b .

Considere agora a famı́lia Beta

(i) Se θ ∼ Beta(α, β), então

p(θ) =

1

θα−1 (1 − θ)β−1 ,

B(α, β)

0 < θ < 1 e α, β > 0

e

1

Γ(α + β)

=

B(α, β) Γ(α)Γ(β)

(ii) A média, moda e variância de θ são dadas, respectivamente, por

α

,

α+β

α−1

αβ

e

α+β−2

(α + β)2 (α + β + 1)

19

Usando priori Beta obtém-se a posteriori

p(θ | x) ∝ θα+t−1 (1 − θ)β+n−t−1

e portanto

(θ | x) ∼ Beta(α + t, β + n − t)

A famı́lia de distribuições Beta é conjugada à Bernoulli (binomial)

A constante de proporcionalidade será 1/B(α + t, β + n − t)

O método de determinação da classe conjugada consiste em :

(i) identificar a classe Ψ de distribuições para θ tal que l(θ; x) é proporcional a um membro de Ψ ;

(ii) verificar se Ψ é fechada por amostragem.

Se existe k tal que k −1 =

R

l(θ; x)dθ < ∞ e todo p ∈ Ψ é definido

através de p(θ) = kl(θ; x), para algum l(θ; x) então Ψ é dita ser famı́lia

conjugada natural ao modelo amostral gerador de l.

20

Principais Famı́lias Conjugadas

(i) Binomial

A famı́lia de distribições Beta é conjugada à Binomial (ou Bernoulli)

(ii) Normal com variância conhecida

A famı́lia de normais é conjugada à Normal - Tma 1.1

(iii) Poisson

Se X = (X1 , . . . , Xn ) Poisson(θ) então:

p(x | θ) =

n

Y

p(xi | θ) =

i=1

n

Y

e−θ θxi

i=1

xi !

l(θ | x) ∝ e−nθ θΣxi .

Núcleo tem a forma θa e−bθ caracterizando uma Gama

p(θ) ∝ θα−1 e−βθ ,

α, β > 0 e θ > 0

A média e variância a priori são

E(θ) =

α

β

e

V (θ) =

α

β2

p

CV (θ) =

V (θ)

E(θ)

A densidade a posteriori será

p(θ | x) ∝ θα+Σxi −1 exp{−(β + n) θ}

21

3. SUMARIZAÇÃO

Sabemos que a Inferência Classica é:

Estimação não viciada (mı́nima variância)

Intervalo de Confiança

Testes de Significância

E a Inferência Bayesiana. O que é?

Teoria da decisão

Sumarização

Resumir a informação disponı́vel através de uns poucos números para comunicação

22

Estimação Pontual - Teoria da decisão

Sumarização - Intervalo de Credibilidade

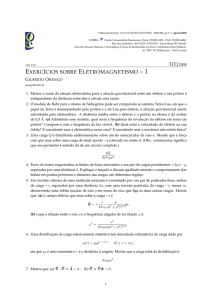

Figure 3: Densidade a posteriori de θ com três regiões distintas: a primeira contendo cerca

de 30 % da probabilidade total, a segunda com 10 % e a terceira com cerca de 60 %. A

moda dessa densidade é 3,5, a média é 5,075 e a mediana 5,27.

23

3.1 Problema de Decisão

i) Espaço do parâmetro ou estados da natureza - Θ

ii) Espaço dos resultados possı́veis de um experimento - Ω

iii) Espaco das ações possı́veis - A

Regra de decisão: δ : Ω → A

Perda: L(δ, θ): Θ × A → R+

Def.: O risco a posteriori é definido por R(δ) = Eθ|x [L(δ, θ)]

Def.: Uma regra de decisão δ ∗ é ótima R(δ ∗ ) < R(δ), ∀δ

24

3.2 Estimação

Estimador é a regra de decisão ótima

O seu valor observado é denominado estimativa

Perda Absoluta

0 ,

se |θ − δ| < ε

∀ε > 0. O es

1 , se |θ − δ| ≥ ε

timador de θ é δ1 = moda(θ), a moda da distribuição atualizada

• Lema 1 Seja L1 (δ, θ) =

de θ ou EMVG.

Perda Quadrática

• Lema 2 Seja L2 (δ, θ) = (δ − θ)2 a perda associada à estimação de

θ por δ. O estimador de θ é δ2 = E(θ), a média da distribuição

atualizada de θ.

25

Perda Zero-Um

• Lema 3 Seja agora L3 (δ, θ) = |δ − θ|. O estimador de θ é δ3 =

med(θ), a mediana da distribuição atualizada de θ.

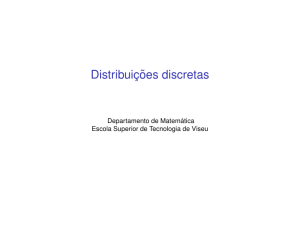

Figure 4: Perdas: quadrática, − − − −; absoluta, · · · · · · ; 0-1 , − − −−.

26

Estimação por intervalos

• Definição C é um intervalo de confiança Bayesiano ou intervalo

de credibilidade de 100(1 − α)% para θ se P (θ ∈ C) ≥ 1 − α.

• Exemplo: Seja X = (X1 , . . . , Xn ) uma amostra da N (θ, σ 2 ) com

σ 2 conhecido.

p(θ) ∝ cte

n n

o

2

l(θ; x) ∝ exp − 2 (θ − x)

2σ

Logo

p(θ | x) ∝ l(θ; x)p(θ) ∝ l(θ; x)

2

Assim θ | x ∼ N (x, σn )

ou

√

n(θ − x)/σ | x ∼ N (0, 1)

(i)

√

n(θ − x̄)

P

≤ zα | x = 1 − α

σ

σ

⇒ θ ≤ zα √ + x com probabilidade 1 − α

n

27

√

• Intervalo C=(−∞, x + zα σ/ n ] cujo comprimento é infinito.

(ii) Sejam zβ e zγ tais que:

√

n(θ − x)

P −zβ ≤

≤ zγ | x = 1 − α.

σ

Usando a simetria da normal tem-se:

Φ(−zβ ) = P (X ≤ −zβ ) = P (X ≥ zβ ) = 1 − P (X < zβ ) = β

e a probabilidade do intervalo acima é dada por

Φ(zγ ) − Φ(−zβ ) = 1 − (γ + β)

e portanto γ + β = α.

O IC 100(1 − α)% será

−zβ ≤

√ (θ − x)

n

≤ zγ

σ

σ

σ

− √ zβ + x ≤ θ ≤ zγ √ + x

n

n

Então

σ

σ

C = x − √ zβ , x + zγ √

n

n

é IC 100(1 − α)% para θ.

28

Figure 5: Densidade da distribuição normal padronizada.

√

O comprimento de C é (zγ + zβ )σ/ n

Permanece ainda a questão de como minimizar este comprimento.

Considere que zγ < zα/2 < zβ e defina a = zα/2 − zγ > 0, b =

zβ − zα/2 > 0 e A e B como as áreas compreendidas entre zβ e

zα/2 e entre zα/2 e zγ

O comprimento do intervalo acima é 2zα/2 + b − a mas A = B

Temos que b > a

Logo, o IC de extremos simétricos −zα/2 e zα2 é o de menor comprimento

A região de credibilidade de menor comprimento é aquela que contém

os valores mais prováveis de θ dado x

29

• Def.: Um IC 100(1 − α)% de MDP para θ é o IC 100(1 − α)%

da forma C = {θ ∈ Θ : p(θ | x) ≥ k(α)} onde k(α) é a maior

constante tal que P (θ ∈ C | x) ≥ 1 − α.

Figure 6: O intervalo de confiança de MDP é dado por C1 ∪ C2 .

30

4. INFERÊNCIA PREDITIVA

Queremos prever Y cuja descrição probabilı́stica é P (Y | θ), que pode

independer de X

p(y | x) =

R

R

p(y,

θ

|

x)dθ

=

Θ

Θ p(y | θ, x)p(θ | x)dθ

R

= Θ p(y | θ)p(θ | x)dθ = Eθ|x [p(y | θ)]

Exemplo

Questão

: qual a probabilidade do 13o filho ser do sexo M ?

Dados

: MMFMMMMFMMMF, M-masculino/F-feminino

P r[X13 = 1|(9, 3)]

onde (9, 3) denota o número de filhos do sexo M/F

P r[X13 = 1|(9, 3)]

=

=

R1

=

0

R1

0

P [X13 = 1, θ|(9, 3)] dθ

P [X13 = 1|θ, (9, 3)] p(θ|(9, 3)) dθ

R1

0

θ p(θ|(9, 3)) dθ = E[θ | (9, 3)]

Distribuição a Priori

31

.

p(θ) = k θa−1 (1 − θ)b−1

p(θ | (9, 3))

0 ≤ θ ≤ 1,

=

(a, b > 0)

p((9,3) |θ) p(θ)

p((9,3))

∝ θ3 (1 − θ)9 θa−1 (1 − θ)b−1 ,

∝ θ3+a−1 (1 − θ)9+b−1

P r[X13 = 1 | (9, 3)] = E[θ|(r, s)] =

a+3

a + b + 12

Qual o valor de a and b?

• Opinião inicial de que as chances de M e F são simétricas e concentradas em 0.5.

Escolhemos a famı́lia das betas com a = b = 2

Ie.: E(θ) = 0.5, P (0.4 < θ < 0.6) = 0.3

e

probabilidade 13o filho ser M será 11/16=0.69

32