REGRESSAO MULTIPLA - complementação

Introdução

O modelo linear de regressão múltipla é da forma:

Y = β 0 + β 1X1 + β 2 X 2 + + β p X p + ε

sendo classificado como modelo de primeira ordem com (p) variáveis independentes.

onde: Y é a variável de estudo (dependente, explicada, resposta ou endógena);

β0 é o coeficiente linear do modelo, isto é, o valor de E(Y) para X = 0; e

βj é o coeficiente angular da ja. variável, ou seja, a variação no componente

determinístico do modelo, E(Y), para 1 unidade de variação na medida de Xj;

Xj é a ja. variável independente, explicativa ou exógena; e

E (Y ) = β 0 + β 1 X 1 + β 2 X 2 + + β p X p é o componente determinístico do modelo;

ε é a parte probabilística do modelo (erro aleatório) com média 0 e variância

constante σ 2 .

Utilizando a notação matricial, podemos expressar essa relação por meio de:

Y = X.β + ε,

Observação: Se p=1, o modelo se identifica ao modelo de regressão linear simples.

Para se obter estimativas para os parâmetros β k , são realizadas n observações da variável

Y, ou sejam Yi , i = 1,2,...,n, conforme o esquema seguinte:

A variável X k será identificada por Xik e indicará o valor de X k correspondente à

observação Yi , i = 1,2,..,n e k = 1,2,...,p. De um modo geral as n observações serão

denotadas pelas n equações abaixo:

Yi = β 0 + β 1 X i ,1 + β 2 X i , 2 + + β p X i , p + ε i

Para i = 1,2,...,n , obtemos as n equações seguintes:

Y1 = β 0 + β 1 X 1,1 + β 2 X 1, 2 + + β p X 1, p + ε 1

Y2 = β 0 + β 1 X 2,1 + β 2 X 2, 2 + + β p X 2, p + ε

2

.......................................................................

.......................................................................

Yn = β 0 + β 1 X n ,1 + β 2 X n , 2 + + β p X n , p + ε

n

Apresentação matricial do modelo

Uma forma simples e muito útil para representar o modelo de regressão linear múltipla é

através da representação matricial das equações acima. Para isto consideremos as

definições dos seguintes vetores e matrizes:

1 X 11

Y1

1 X 21

Y2

X =

Y=

1 X

Y

n1

n nX 1

X 1p

X 2p

X np

nX ( p + 1)

β0

ε1

β1

ε

β =

ε = 2 .

β

ε

p ( p + 1) X 1

n nX 1

De modo que:

Y1 1 X 11

Y2 1 X 21

=

Y 1 X

n1

n

X 1p

X 2p

X np

β 0 ε1

β1 ε 2

+

β ε

p n

A representação matricial das equações se torna:

Y = Xβ + ε

As hipóteses básicas para construir o modelo de regressão linear múltipla são:

β é um vetor de parâmetros desconhecidos.

X é uma matriz de valores fixados.

ε é um vetor aleatório com distribuição normal tal que:

2

E(ε) = 0 e E ( ε ε ′ ) = σ I n .

Com respeito à última hipótese, temos que E ( ε i ) = 0 para todo i =1,2,...,n, e, portanto

ε 1 E ( ε 1 ) 0

ε E ε 0

2 ( 2) r

E . = . = . = 0

. . .

ε n E ( ε n ) 0

Além disso,

ε 1ε 1 ε 1ε 2

ε ε ε ε

2 1 2 2

E( ε ε ′) = E −

−

−

−

ε n ε 1 ε n ε 2

−

−

−

−

−

−

−

−

−

−

ε 1ε n

ε 2ε n

−

−

ε n ε n

ou

Var(ε 1 ) Cov(ε 1ε 2 )

Cov(ε ε ) Var(ε )

2 1

2

E( ε ε ′) =

−

−

−

−

Cov(ε n ε 1 ) Cov(ε n ε 2 )

−

−

−

−

−

−

−

−

−

−

Cov(ε 1ε n )

Cov(ε 2 ε n )

−

−

Var(ε n )

2

Como E ( ε ε ′ ) = σ I n para todo i = 1,2,...,n, a matriz acima se transforma em

σ 2

0

E( ε ε ′) = −

0

0

0

0

0

σ2

0

0

−

−

−

0

0

0 σ2

0 0

0

0

2

− = σ In

0

σ 2

Os termos da diagonal principal mostram que os erros satisfazem a condição de

homocedasticidade, e aqueles fora da diagonal mostram que os erros são não

correlacionados e portanto independentes, pois têm distribuição normal.

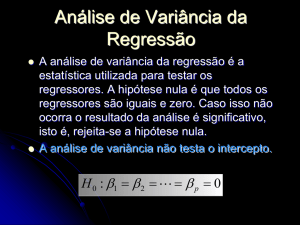

Estimadores de mínimos quadrados do vetor de parâmetros β

Analogamente ao processo de estimação estudado em regressão linear simples, o critério

dos mínimos quadrados consiste em minimizar soma dos quadrados dos erros.

Em termos matriciais, escrevemos:

Y = Xβ + ε

e

E ( Y ) = E ( Xβ + ε ) = Xβ + E ( ε ) = Xβ

De maneira que,

ε = Y − Xβ

A soma dos quadrados dos erros pode ser escrita matricialmente, como segue

SQErros =

n

∑ (ε )

i= 1

2

= ( Y − Xβ

) ' (Y −

Xβ

)

ou

SQErros = Y 'Y − β ' X 'Y − Y ' Xβ + β ' X ' Xβ = Y 'Y − β ' X 'Y − β ' X 'Y + β ' X ' Xβ

escalar

Logo,

SQErros = Y 'Y − 2β ' X 'Y + β ' X ' Xβ .

Derivando S em relação a β,

∂ SQ Erros

= − 2 X ' Y + 2 X ' Xβ

∂β

Igualando-se a zero, obtemos

∂ SQ Erros

= − 2 X ' Y + 2 X ' Xβ

∂β

X′ Y = X′ Xβ

−1

βˆ = ( X′ X ) X′ Y

A reta de mínimos quadrados ajustada é dada pelas equações na forma matricial,

Ŷ = Xβˆ

Cálculo da média do estimador βˆ

Substituindo-se Y = Xβ + ε no estimador de βˆ , temos

−1

βˆ = ( X′ X ) X′ [ Xβ + ε ]

−1

−1

βˆ = ( X′ X ) X′ Xβ + ( X′ X ) X′ ε

−1

βˆ = β + ( X′ X ) X′ ε

Calculando a média

E(βˆ ) = β + ( X′ X ) X′ E(ε )

−1

( )

ou E βˆ = β

Assim, o vetor de estimadores de mínimos quadrados é composto por estimadores não

tendenciosos dos parâmetros β k , k = 0,1,2,...,p.

Cálculo da variância do estimador βˆ

( )

Como E βˆ k = β k para k = 0,1,2,...,p, então a variância de βˆ k é calculada por

2

Var(βˆ k ) = E βˆ k − β k ,

Por outro lado E βˆ − β

(

E

(

'

βˆ − β βˆ − β = E

)(

′

) ( βˆ − β )

para k = 0,1,2,...,p-1.

define a seguinte matriz de covariância.

( βˆ − β )

( βˆ − β )( βˆ − β )

( βˆ − β )( βˆ − β ) ( βˆ − β )

2

0

)

1

(

0

1

0

0

0

βˆ p − β

p

)(

βˆ 0 − β

0

0

1

2

1

) (

1

1

βˆ p − β

p

)(

βˆ 1− β 1

)

( βˆ − β )( βˆ − β )

( βˆ − β )( βˆ − β )

0

0

p

p

1

1

p

p

(

ˆ

β p− β p

)

2

Esta matriz contém as variâncias dos estimadores βˆ em sua diagonal principal e as

covariâncias entre os mesmos estimadores nas demais células.

Por outro lado,

−1

βˆ = β + ( X′ X ) X′ ε

−1

βˆ − β = ( X′ X ) X′ ε

Então a variância de βˆ é calculada por

Var(βˆ ) = E βˆ − β

(

′

) ( βˆ − β ) = E ( X′X )

−1

−1

X′ ε ε ′ X ( X ′ X )

Var(βˆ ) = ( X′ X ) X′ E(ε ε ′ )X ( X′ X )

−1

Var(βˆ ) = σ 2 I n ( X′ X ) (X′ X) ( X′ X )

−1

−1

−1

Finalmente, obtemos a variância do estimador βˆ

Var(βˆ ) = σ 2 ( X′ X )

−1

Estimador da variância σ

2

ˆ , i = 1,2,...,n. Sob a forma matricial

Denotemos o resíduo da regressão por ei = Yi − Y

i

escrevemos

e = Y − Xβˆ

Substituindo-se Y e βˆ por seus respectivos valores, o vetor de resíduos é então:

−1

e = Xβ + ε − X ( X′ X ) X′ Y

−1

e = Xβ + ε − X ( X′ X ) X′ (Xβ + ε )

−1

e = Xβ + ε − X β + ( X′ X ) X′ ε

e = Xβ + ε − Xβ − X ( X′ X ) X′ ε

−1

Finalmente o vetor de resíduos é escrito sob a forma,

−1

e = I n − X ( X′ X ) X′ ε

e isto significa que o vetor de resíduos é uma combinação linear dos erros ε.

−1

Seja H = X ( X ' X ) X ' , H é uma matriz quadrada de ordem n .

Então:

SQRe s = Y ' [ I − H ]Y

A matriz H é chamada de matriz chapéu ou de matriz de projeção pois ela transforma Y

em Ŷ .

HY = X ( X ' X ) X 'Y = Xβˆ

−1

Podemos escrever:

e = Y − Yˆ = Y − HY = ( I − H )Y

(

)

Repare que a matriz H exerce um papel importante na análise dos resíduos na busca de

outliers e valores influentes

A matriz H é uma matriz simétrica, pois: H = X ( X ' X ) X ' = H ' = X ( X ' X ) X '

e idempotente,

−1

[

][

H × H = X(X'X) X ' X(X'X)

−1

−1

] = X(X X )

'

−1

(

X 'X X 'X

−1

)

−1

(

X ' = X X 'X

)

−1

X' = H

[

]

Por outro lado, seja a matriz A = I n − X ( X ' X ) X ' da relação

−1

[

(

)

]

−1

e = In − X X ' X X ' ε

e = Aε .

A é simétrica e idempotente, conforme verificaremos a seguir:

A é simétrica pois:

A = I n − X ( X′ X ) X′

−1

A′ = I′n − X ( X′ X ) X′ = I n − X ( X′ X ) X′ = A

−1

−1

A é idempotente pois:

−1

−1

A × A = I n − X ( X′ X ) X′ I n − X ( X′ X ) X′

A 2 = I n − X ( X′ X ) X′ − X ( X′ X ) X′ + X ( X′ X ) X′ .X ( X′ X ) X′

−1

−1

−1

−1

A 2 = I n − 2X ( X′ X ) X′ + X ( X′ X ) X′

−1

−1

A 2 = I n − X ( X′ X ) X′

−1

Então, a soma dos quadrados dos resíduos é obtida por

e ' e = ε ' A ' Aε

e ' e = ε ' Aε

[

(

e 'e = ε ' I n − X X ' X

)

−1

]

X'ε

Agora abriremos um parênteses para exibir alguns resultados matrizes importantes

para finalizar a demonstração:

1. Se M é uma matriz quadrada de dimensão n e se para i = 1,2,...,n , E( ε i ) = 0 e Var( ε i )

= σ 2 In , então

E [ ε ′ Mε ] = σ 2 tr(M) .

Exemplo:

1 2 ε 1

2

2

2

E[ ε1 ε 2]

ε = E ε 1 + 3ε 1ε 2 + 2ε 1ε 2 + 4ε 2 = 5σ

3

4

2

2. Se M é uma matriz quadrada, tr(M) = tr( M′ ).

3. Dadas as matrizes quadradas A e B, se AB e BA existem, tr(AB)=tr(BA).

4. Dadas as matrizes quadradas A, B e C, se os produtos entre elas existem, então

tr(ABC)=tr(BCA)=tr(CAB).

5. Dadas duas matrizes quadradas A e B, tr(A-B) = tr(A)-tr(B)

Utilizando os resultados acima calculemos a esperança das soma dos quadrados dos

resíduos

( )

{[

(

E e 'e = E ε ' I n − X X ' X

( )

E e 'e = σ

2

)

−1

]}

[tr( I ) − tr[ X ( X X ) X ]

X X ] = σ [ n − tr [ I ]]

X'ε = σ

[n − tr[( X X )

'

( )

E e'e = σ

−1

2

'

−1

'

n

'

2

p

2

[ n − p]

Desta maneira a média da soma dos quadrados dos resíduos é igual à variância dos erros,

multiplicada pela diferença entre o número de observações e o número de parâmetros a

serem estimados no modelo de regressão linear múltipla.

Logo um estimador não tendencioso para a variância do modelo, é:

1

E (e 'e) = σ 2

n− p

e'e

= σ

E

n− p

n

2

σˆ 2 = σˆ ε =

∑

i= 1

ei2

n− p

2