RELATÓRIO TÉCNICO

DISCIPLINA: MINERAÇÃO DE DADOS – PPGCA – fase 3 / 2016

Prof. Celso Kaestner

Aluno: Marcelino Ulica Abel.

1. Objetivo:

Este relatório tem como objetivo, descrever o resultado dos experimentos, do 4º trabalho da

disciplina de Mineração de Dados, nos conceitos de classificação por instâncias e por

probabilidades, r epresentados pelos classificadores Naïve-Bayes e kNN sobre a base Breast

Cancer Wisconsin.

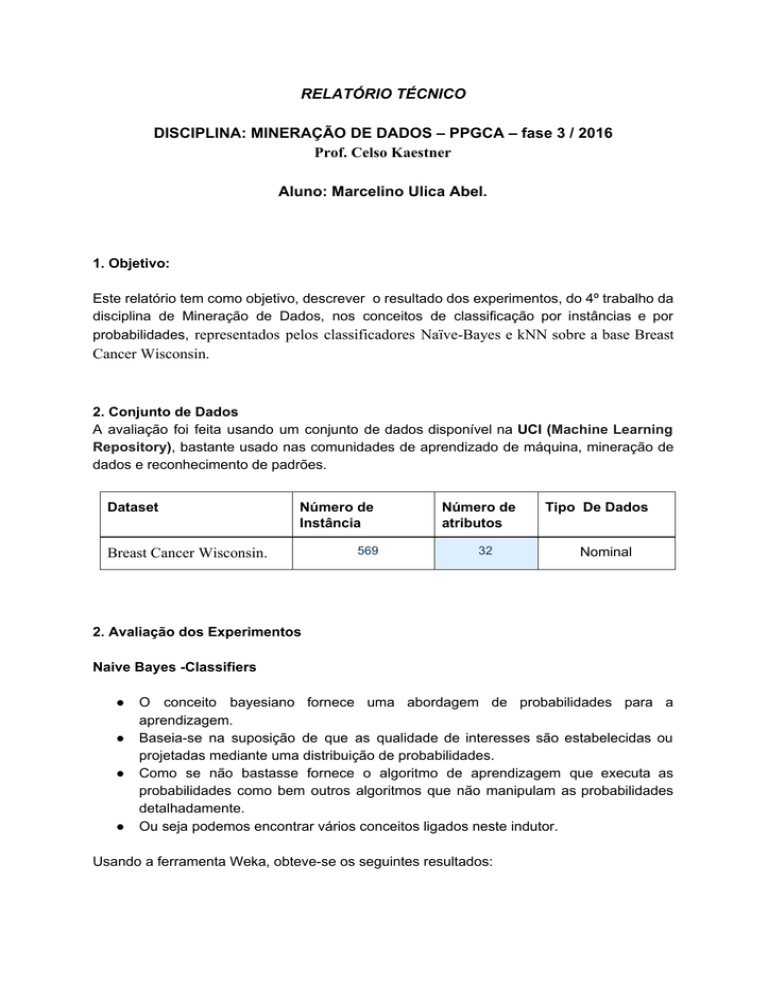

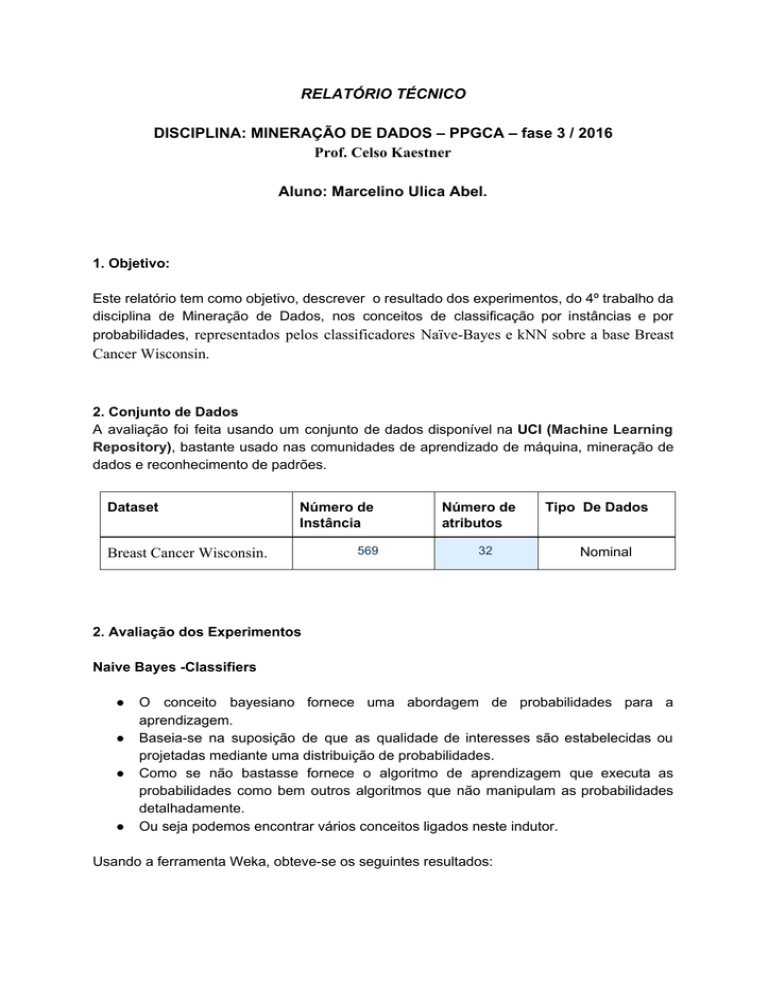

2. Conjunto de Dados

A avaliação foi feita usando um conjunto de dados disponível na UCI (Machine Learning

Repository), bastante usado nas comunidades de aprendizado de máquina, mineração de

dados e reconhecimento de padrões.

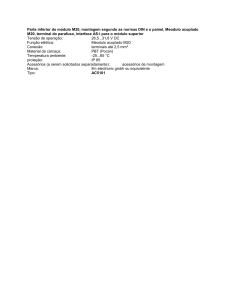

Dataset

Número de

Instância

Breast Cancer Wisconsin.

569

Número de

atributos

32

Tipo De Dados

Nominal

2. Avaliação dos Experimentos

Naive Bayes -Classifiers

●

●

●

●

O conceito bayesiano fornece uma abordagem de probabilidades para a

aprendizagem.

Baseia-se na suposição de que as qualidade de interesses são estabelecidas ou

projetadas mediante uma distribuição de probabilidades.

Como se não bastasse fornece o algoritmo de aprendizagem que executa as

probabilidades como bem outros algoritmos que não manipulam as probabilidades

detalhadamente.

Ou seja podemos encontrar vários conceitos ligados neste indutor.

Usando a ferramenta Weka, obteve-se os seguintes resultados:

Usando as configurações padrão do algoritmo no weka.

●

Uma representação informativa de como os atributos estão representados, “nominal”

e um modelo de validação cruzada “10-pastas” “treinamento, teste e validação”.

Acurácia para cada Classe e acerto geral

●

Com base nas probabilidade das duas classes de acontecerem, o classificador teve

o resultado de 71,6783% de acerto e de 28,3217% como margem de erro.

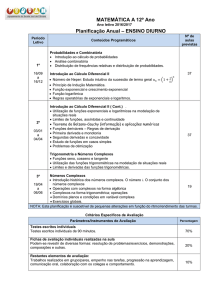

KNN ( k-Nearest Neighbour algorithm) é um simples classificador, onde seu aprendizado é

baseado nas instâncias, ou seja ele não constrói um modelo matemático.

Nesta primeira avaliação usando K= 1 (configuração padrão do weka) , teve-se os seguintes

resultados:

●

Fazendo alteração apenas do K vizinhos mais próximos, rodamos o algoritmo por

duas vezes usando k=6, k=10. fez-se ainda o experimento com valor maior que 10,

mais influencia muito no resultado.

Resultado usando k= 6

Resultado usando k= 10

●

●

●

Após executar o classificador e os parâmetros citados, é notado um índice de acerto

inferior, se comparar com outros classificadores como Redes neurais, apresentado

uma taxa de acerto melhor que do KNN e Naives Baye.

Pode-se notar que ambos os classificadores estão errando bastante na classe “b”,

ou seja acertando quase 100% para classe “a”.

Portanto para este trabalho, conseguimos ver de um modo as taxas de acertos e

erros, e acurácia para cada classe.

Conclusão

Concluímos que estes dois classificadores tem um potencial para problemas

específicos, ou seja se o problema representado por ocorrências/não de exemplos

na base, o Naives Bayes seria o modelo clássico para resolver, e para problemas

simples instanciados o KNN é indutor ideal para classificar os dados.