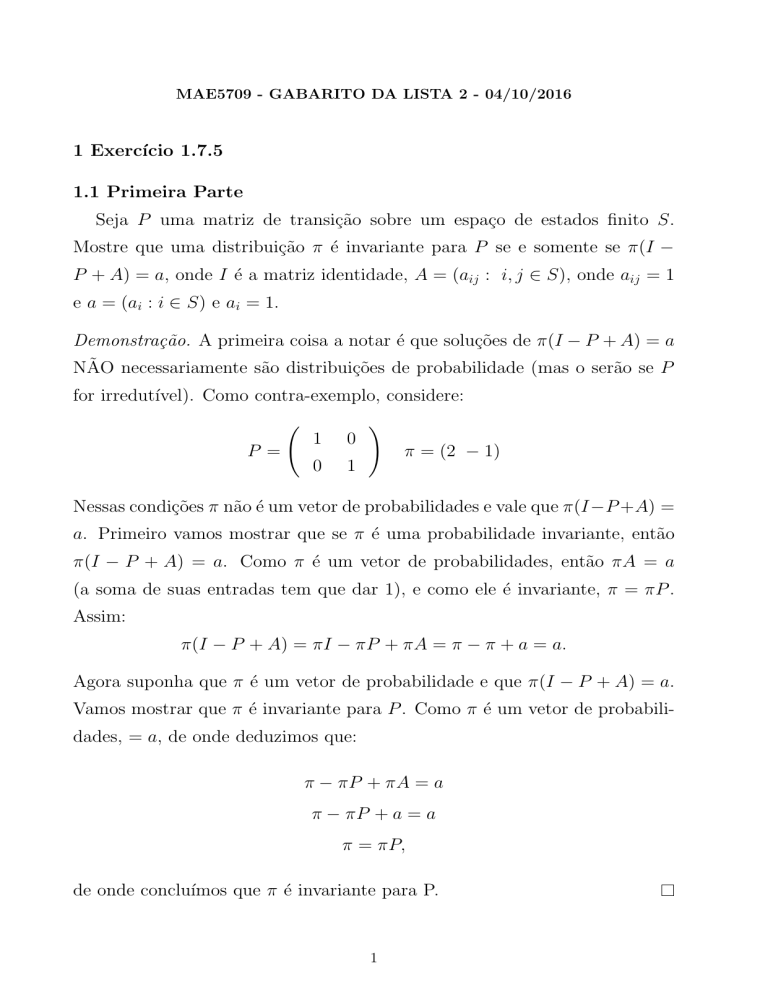

MAE5709 - GABARITO DA LISTA 2 - 04/10/2016

1 Exercı́cio 1.7.5

1.1 Primeira Parte

Seja P uma matriz de transição sobre um espaço de estados finito S.

Mostre que uma distribuição π é invariante para P se e somente se π(I −

P + A) = a, onde I é a matriz identidade, A = (aij : i, j ∈ S), onde aij = 1

e a = (ai : i ∈ S) e ai = 1.

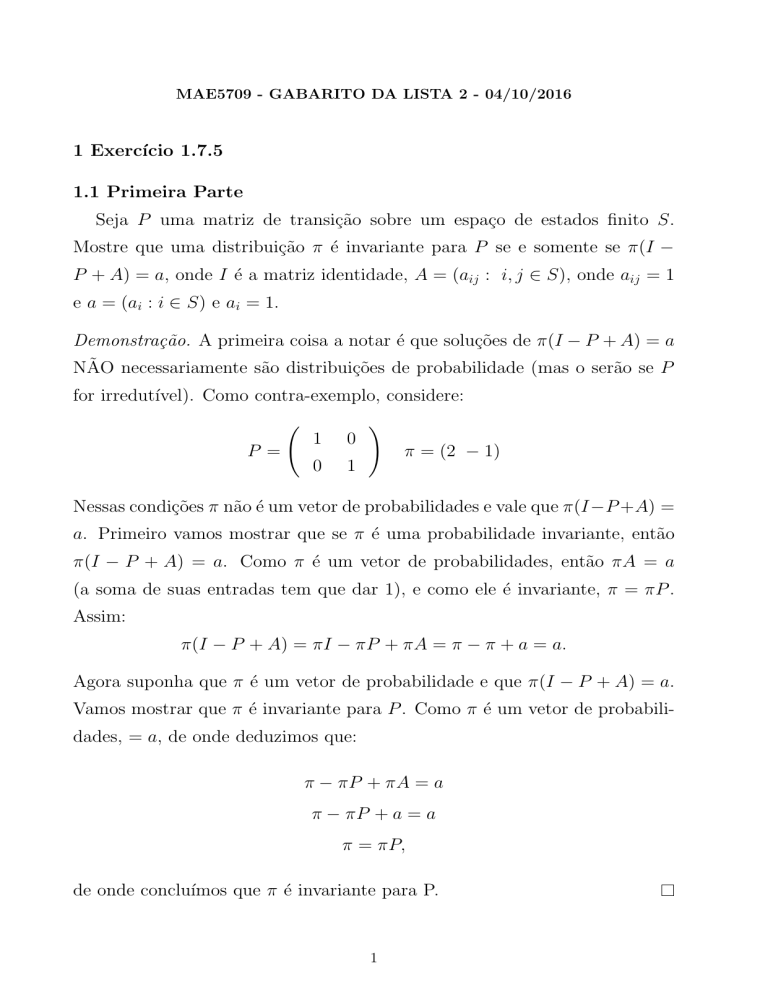

Demonstração. A primeira coisa a notar é que soluções de π(I − P + A) = a

NÃO necessariamente são distribuições de probabilidade (mas o serão se P

for irredutı́vel). Como contra-exemplo, considere:

P =

1

0

0

1

!

π = (2 − 1)

Nessas condições π não é um vetor de probabilidades e vale que π(I −P +A) =

a. Primeiro vamos mostrar que se π é uma probabilidade invariante, então

π(I − P + A) = a. Como π é um vetor de probabilidades, então πA = a

(a soma de suas entradas tem que dar 1), e como ele é invariante, π = πP .

Assim:

π(I − P + A) = πI − πP + πA = π − π + a = a.

Agora suponha que π é um vetor de probabilidade e que π(I − P + A) = a.

Vamos mostrar que π é invariante para P . Como π é um vetor de probabilidades, = a, de onde deduzimos que:

π − πP + πA = a

π − πP + a = a

π = πP,

de onde concluı́mos que π é invariante para P.

1

1.2

Segunda parte

Deduza que se P é uma matriz irredutível, então I − P + A é inversível.

Demonstração. Seja π o único vetor de probabilidades invariante para P e seja

x um vetor que é solução de x(I − P + A) = a, vamos mostrar que x = π.

Depois de demostrado esse fato, seguirá que π é a única solução do sistema

de equações x(I − P + A) = a, de onde seguirá que I − P + A é inversível.

Fixe um i ∈ S. Pela equação dada, temos que:

X

X

xi −

xk pki +

xk = 1

, portanto :

k∈S

k∈S

!

X

xi −

i∈S

X

xk pki +

k∈S

|S|

X

xk

= |S|

k∈S

X

xk = |S|

k∈S

X

xk = 1

k∈S

Assim vale que xA = a, e portanto, como x(I − P + A) = a, também vale

que x = xP .

Note que ainda não afirmamos que todas as entradas são não negativas.

Seja mx = mini∈S xi e mπ = mini∈S πi . Como P é irredutível, então mπ > 0.

mx

|, daí teremos que απ +x será um vetor com todas as entradas

Tome α > | m

π

positivas. Ao normalizar esse vetor obtemos constantes β e γ, ambas diferentes

de zero tais que βπ + γx é um vetor de probabilidades. Denotemos µ = βπ + γx.

Note que µP = (βπ + γx)P = βπP + γxP = βπ + γx = µ. Assim µ é um

vetor de probabilidades invariante. Como P é irredutível, existe apenas uma

distribuição de probabilidades invariante. Assim µ = π.

Portanto:

βπ + γx = π

(β − 1)π + γx = 0

β−1

π,

x=−

γ

Assim x é um múltiplo de π. Como a soma das coordenadas de ambos vale

1, segue que x = π.

2

Exercício 1.8.4

A cada manhã, um estudante pega um de seus 3 livros da estante. A probabilidade de que ele escolha o livro i é 0 < αi < 1, com i = 1, 2, 3, e a cada dia

essa escolha é feita de maneira independente das demais.

2

Ao final do dia ele devolve o livro retirado, colocando-o sempre à esquerda

dos demais livros. Denote por pn a probabilidade de que depois de n dias nós

encontremos na prateleira os livros na ordem 1, 2, 3, da esquerda para a direita.

Mostre que pn converge quando n → ∞ e calcule o limite.

Resolução. Considere (Xn )n∈N uma cadeia de markov, onde o espaço de estados são as permutações de (1, 2, 3), que representam as posições dos livros na

estante, da esquerda para a direita, com matriz de transição como a descrita no

enunciado.

Tome (a, b, c) uma permutação de (1, 2, 3). Se retirarmos o livro c no primeiro

dia, o livro b no segundo e o a no terceiro, a estante ficará na posição (a, b, c),

independente da posição inicial de cada livro. Assim de qualquer estado eu

consigo alcançar qualquer estado com probabilidade positiva, assim a cadeia é

irredutível. Como o espaço de estados é finito, ela também é recorrente positiva,

assim ela tem uma medida invariante.

Note ainda que se estamos num estado (a, b, c), então nós continuamos no

mesmo estado com probabilidade αa . Assim a cadeia é aperiódica.

Portanto pelo teorema 1.8.3 do livro do Norris, P (Xn = •) converge para

π(•), onde π é a única medida invariante do processo.

Fazendo contas é possível mostrar que a medida invariante é:

π(a, b, c) = αa

αb

αb

= αa

αb + αc

1 − αa

Portanto pn converge à:

π(1, 2, 3) = α1

3

α2

α2

= α1

α2 + α3

1 − α1

Exercício 1.8.5

Sejam Y1 , Y2 , . . . variáveis i.i.d, com média finita, que assumem valores em

{1, 2, . . .}. Suponha ainda que o conjunto dos inteiros {n : P (Y1 = n) > 0} tem

maior divisor comum 1. Considere µ = E(Y1 )

Mostre que o processo:

Xn = inf {m ≥ n : m = Y1 + . . . + Yk para algum k ≥ 0} − n

é uma cadeia de Markov. Calcule:

lim P (Xn = 0)

n→∞

Mostre que:

lim P (n = Y1 + . . . + Yk para algum k ≥ 0) =

n→∞

3

1

µ

Resolução. Seja M := inf{n ∈ N : P (Y1 >= n) = 0}, com a convenção de que

inf ∅ = ∞. O espaço de estados será o conjunto S = {n ∈ N : n < M }.

Mostrar que (Xn ) é uma cadeia de Markov pode ser feito calculando explicitamente P (Xn+1 = xn |X0 = x0 , . . . Xn = xn ) e mostrar que essa quantidade

não depende de x0 , . . . , xn−1 .

Note que um estado i alcança o estado 0 em exatamente i passos com probabilidade 1.

Agora vamos mostrar que, saindo do 0, temos uma probabilidade positiva

de alcançar um estado i. Fixe um j ≥ i tal que P (Y1 = j) > 0. Tal j existe pela

nossa contrução do espaço de estados. Assim p(j−i+1) (0, i) ≥ P (Y1 = j) > 0.

Como do 0 eu posso alcançar qualquer estado, e de qualquer estado eu posso

alcançar o 0, a cadeia é irredutível.

Note que E(T 0→0 ) = E(Y1 ) = µ. Assim o 0 é um estado recorrente positivo.

Como a cadeia é irredutível, todos os estados são recorrentes positivos.

Assim existe uma probabilidade invariante π, e ela satisfaz, usando o lema

de Kǎc, π(0) = E(T10→0 ) = µ1 .

Ainda temos que {n ∈ N : p(n) (0, 0) > 0} = {n ∈ N : P (Y1 = n) > 0}, esse

conjunto tem m.d.c. igual a 1. Portanto o estado 0 é aperiódico. Como a cadeia

é irredutível, então todos os estados são aperiódicos.

Como estamos com uma cadeia irredutível aperiódica, que tem uma distribuição invariante π, então podemos calcular:

lim P (Xn = 0) = π(0) =

n→∞

1

µ

Agora note que o evento

{n = Y1 + . . . + Yk } = {inf{m ≥ n : m = Y1 + . . . + Yk } = n}

= {inf{m ≥ n : m = Y1 + . . . + Yk } − n = 0} .

Dessa maneira

{n = Y1 + . . . + Yk para algum k ≥ 0} = {Xn = 0},

e portanto:

lim P (n = Y1 + . . . + Yk para algum k ≥ 0) =

n→∞

4

1

.

µ

Exercício 1.9.2

Duas partículas, X e Y , realizam passeios aleatórios no grafo do diagrama

do livro. Estando em um vértice do grafo, uma partícula escolhe o próximo

vértice com igual probabilidade entre os vizinhos.

Encontre a probabilidade de que X e Y eventualmente se encontrem nos

seguintes casos:

4

1. X inicia em A e Y em B.

Resolução. Elas nunca se encontram. As cadeias são periódicas, de período 2, e A e B são vizinhos.

2. X inicia em A e Y em E.

Resolução. Elas se encontram com probabilidade 1.

Se considerarmos (X, Y ) como uma única cadeia de Markov, veremos que

o estado (A, E) está na mesma classe fechada que todos os estados da

forma (I, I). Assim, como essa classe é finita, todos os estados dela são

recorrentes. Assim o tempo para alcançar qualquer estado, como por

exemplo um estado da forma (I, I), será finito.

Denote por MI o valor esperado do tempo para que, com as duas cadeias

iniciando em I, ambas retornem à I ao mesmo tempo.

Mostre que 9MD = 16MB .

Resolução. Seja S o conjunto de vértices do grafo dado, que também é o espaço

de estados das cadeias X e Y .

Como já comentado, Zn = (Xn , Yn ) é uma cadeia de markov em S 2 , com

probabilidade de transição dada por:

q((a, b), (c, d)) = p(a, c)p(b, d),

onde p(•, •) denota a probabilidade de transição das cadeias X e Y .

Tome C0 e C1 a partição de S, conforme o teorema 1.8.4 de Norris aplicado

para a cadeia (Xn ) (ou (Yn )).

Com a cadeia (Zn ), teremos 2 classes de comunicação fechadas, que denotaremos por K0 e K1 , onde:

K0 = (C0 × C0 ) ∪ (C1 × C1 )

K1 = (C0 × C1 ) ∪ (C1 × C0 )

Como o espaço de estados é finito, e não temos nenhuma classe de comunicação aberta, então todos os estados são recorrentes positivos.

Não é difícil verificar que uma medida invariante de (Zn ) é dada por µ(a, b) =

π(a)π(b). Onde π é a única probabilidade invariante das cadeias (Xn ) e (Yn ).

Como estamos realizando um passeio aleatório, teremos que π(a) = Pd(a)

,

b d(b)

onde d(I) é o número de vizinhos do vértice I no grafo.

Usando o Lema de Kǎc, teremos que, para I ∈ S:

MI =

Pµ (τ (I,I) < ∞)

.

µ(I, I)

5

Como (I, I) ∈ K0

∀I ∈ S, temos que

X

Pµ (τ (I,I) < ∞) =

µ(a, b),

(a,b)∈K0

portanto Pµ (τ (D,D) < ∞) = Pµ (τ (B,B) < ∞).

MD

Pµ (τ (D,D) < ∞)

µ(B, B)

µ(B, B)

π(B)π(B)

d(B)d(B)

16

=

=

=

=

=

MB

µ(D, D)

µ(D, D)

π(D)π(D)

d(D)d(D)

9

Pµ (τ (B,B) < ∞)

5

Exercício 10.4

Uma cantora de ópera vai atuar em uma longa série de concertos. Ela tem um

temperamento complicado, e assim pode amarelar cada noite com probabilidade

1

2 . Uma vez que isso aconteça ela não vai voltar a atuar até que o produtor a

convença do contrário.

Ele faz isso enviando um buque de flores para ela a cada dia que ela não

queira atuar. Ele compra um buque

√ por x mil libras, 0 ≤ x ≤ 1, e isso a

convence a atuar com probabilidade x.

O produtor pretende ter um lucro de 750 libras por concerto bem sucedido.

Supondo que as decisões de cada dia sejam independentes, quanto ele deve

gastar em flores?

Resolução. Podemos representar o estado da cantora em um espaço de estados

S = {0, 1}, onde 0 representa que ela não vai cantar naquela noite e 1 que ela

vai cantar.

Se Xn for o estado dela na n-ésima noite, então (Xn ) será uma cadeia de

Markov, com matriz de transição dada por:

√

√ 1− x

x

P =

.

1

1

2

2

Vamos denotar por f : S → R o lucro obtido em um dia, em milhares de

libras, de acordo com o estado da cantora. Assim f (0) = −x e f (1) = 0, 75.

Suponha que vamos tentar realizar M + 1 concertos, que denotamos por

X0 , . . . , XM . Uma quantidade de interesse é o lucro total, dada por:

L(M ) :=

M

X

f (Xi )

i=0

Vamos primeiramente supor que x > 0. Nesse caso a cadeia é irredutível e

recorrente positiva. Ainda nossa função f é limitada. Assim o teorema ergódico

P

) M →∞ ¯

diz que L(M

i∈S πi f (i), onde π é a única probabilidade invariante

M +1 −−−−→ f =

da nossa cadeia.

6

No caso x = 0, temos que limM →∞ L(M ) é quase certamente finito (assim

que ela parar de cantar, nunca mais cantará). Assim se encontrarmos um valor

de x onde f¯ seja positivo, esse é preferível, já que nesse caso L(M ) ficará cada

vez maior quanto maior for o M (e estamos supondo que o M é bem grande).

Podemos calcular:

√

2 x

1

√

π = 2√x+1

2 x+1

√

2

x

1

f¯ = 0, 75 √

−x √

2 x+1

2 x+1

Assim uma estratégia possível é maximizar f¯, o que acontece quando x =

0, 25. Assim devemos gastar 250 libras.

7