Probabilidade e Estatística

UNIVERSIDADE FEDERAL DA PARAÍBA

Reitora

MARGARETH DE FÁTIMA FORMIGA MELO DINIZ

Vice-Reitor

EDUARDO RAMALHO RABENHORST

EDITORA DA UFPB

Diretora

IZABEL FRANÇA DE LIMA

Vice-Diretor

JOSÉ LUIZ DA SILVA

Supervisão de Editoração

ALMIR CORREIA DE VASCONCELLOS JÚNIOR

Supervisão de Produção

JOSÉ AUGUSTO DOS SANTOS FILHO

CONSELHO EDITORIAL

Prof Dr. Lucídio Cabral ..................................(UFPB)

Prof Dr. Danielle Rousy..................................(UFPB)

Prof. Ms. Eduardo de Santana Medeiros..........(UFPB)

Andrea Vanessa Rocha

Probabilidade e Estatística

Editora da UFPB

João Pessoa

2014

Capa - Projeto gráfico: Renato Arrais e Eduardo Santana

Editoração eletrônica: Eduardo de Santana Medeiros Alexandre

Catalogação na publicação

Universidade Federal da Paraíba

Biblioteca Setorial do CCEN

R672p Rocha , Andrea Vanessa.

Probabilidade e Estatística / Andrea Vanessa Rocha; editor: Eduardo de

Santana Medeiros Alexandre. – João Pessoa: Editora da UFPB, 2014. - João

Pessoa: Curso de Licenciatura em Computação na Modalidade à Distância /

UFPB, Junho de 2014.

154. : il. –

ISBN: XXX-XX-XXX-XXXX-X (PENDENTE)

Curso de Licenciatura em Computação na Modalidade à Distância.

Universidade Federal da Paraíba.

1. Estatística. 2. Teoria dos Conjuntos. 3. Probabilidade. 4. Variáveis

Aleatórias. 5. Esperança de Variável. 5. Distribuições discretas. 6.

Distribuições Contínuas. 7. Inferência estatística. I. Título.

BS-CCEN

Todos os direitos e responsabilidades dos autores.

Este livro e sua versão mais recente pode ser baixado em:

https://github.com/edusantana/estatistica-livro/releases/latest

EDITORA DA UFPB

Caixa Postal 5081 – Cidade Universitária

João Pessoa – Paraíba – Brasil

CEP: 58.051 – 970

http://www.editora.ufpb.br

Impresso no Brasil

Printed in Brazil

CDU 519.2

Probabilidade e Estatística

Probabilidade e Estatística

i

Probabilidade e Estatística

Sumário

1

Estatística Descritiva

1

1.1

Conceitos Básicos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.1.1

Definições importantes . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

Tabelas Estatísticas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

1.2.1

Série Cronológica ou Temporal . . . . . . . . . . . . . . . . . . . . . . . .

3

1.2.2

Série Geográfica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

1.2.3

Série Específica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4

Distribuição de Frequência . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4

1.3.1

Construção de uma distribuição de frequência . . . . . . . . . . . . . . . . .

4

Gráficos Estatísticos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

1.4.1

Histograma . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

1.4.2

Polígono de Frequência . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

1.4.3

Gráfico de Linhas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

1.4.4

Gráfico de Colunas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

1.4.5

Gráfico em Barras . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10

1.4.6

Gráfico de Setores . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

Medidas de Posição . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

1.5.1

Média Aritmética . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

1.5.2

Moda . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13

1.5.3

Mediana . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

14

Medidas de Dispersão . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

16

1.6.1

Amplitude . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

17

1.6.2

Desvio Médio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

17

1.6.3

Variância . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

18

1.6.4

Desvio Padrão . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

19

1.6.5

Coeficiente de Variação . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

21

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

21

1.2

1.3

1.4

1.5

1.6

1.7

ii

Probabilidade e Estatística

2

Teoria dos Conjuntos e Contagem

23

2.1

Teoria dos Conjuntos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

23

2.1.1

Comparação entre conjuntos . . . . . . . . . . . . . . . . . . . . . . . . . .

24

2.1.2

União de conjuntos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

2.1.3

Interseção de conjuntos . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

2.1.4

Diferença entre conjuntos . . . . . . . . . . . . . . . . . . . . . . . . . . .

26

2.1.5

Complementar de um conjunto . . . . . . . . . . . . . . . . . . . . . . . . .

26

2.1.6

Propriedades entre as relações entre conjuntos . . . . . . . . . . . . . . . . .

27

Contagem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

2.2.1

Regra da multiplicação . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

2.2.2

Regra da adição . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

28

2.2.3

Permutação . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

28

2.2.4

Arranjos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

2.2.5

Combinações . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

2.2.6

Binômio de Newton . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

31

2.2

2.3

3

4

Definições Básicas

33

3.1

Fundamentos de Probabilidade . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

34

3.2

Noções de Probabilidade . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

35

3.3

Espaços Amostrais Finitos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

37

3.4

Resultados Equiprováveis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

37

3.5

Probabilidade Condicional . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

38

3.5.1

Teorema da Multiplicação . . . . . . . . . . . . . . . . . . . . . . . . . . .

39

3.5.2

Teorema da Probabilidade Total . . . . . . . . . . . . . . . . . . . . . . . .

40

3.5.3

Teorema de Bayes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

41

3.6

Eventos Independentes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

42

3.7

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

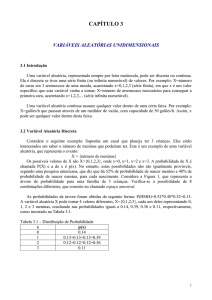

Variáveis Aleatórias e Suas Distribuições

46

4.1

Variáveis Aleatórias Discretas . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

48

4.2

Variáveis Aleatórias Contínuas . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

49

4.3

Função de Distribuição Acumulada . . . . . . . . . . . . . . . . . . . . . . . . . . .

51

4.4

Variáveis Aleatórias Mistas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

54

4.5

Funções de Variáveis Aleatórias . . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

4.6

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

57

iii

Probabilidade e Estatística

5

6

Esperança de uma Variável Aleatória

60

5.1

Variáveis aleatórias independentes . . . . . . . . . . . . . . . . . . . . . . . . . . .

60

5.2

Esperança matemática . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

61

5.3

Esperança de uma Função de Variável Aleatória . . . . . . . . . . . . . . . . . . . .

62

5.4

Propriedades da Esperança . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

65

5.5

Variância de uma variável aleatória . . . . . . . . . . . . . . . . . . . . . . . . . . .

66

5.6

Propriedades da variância . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

68

5.7

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69

Principais Distribuições Discretas

71

6.1

A Distribuição Bernoulli . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

71

6.2

A Distribuição Binomial . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

72

6.3

A Distribuição Geométrica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

76

6.3.1

Perda de Memória . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

77

A Distribuição Pascal (ou Binomial Negativa) . . . . . . . . . . . . . . . . . . . . .

78

6.4.1

Generalização do Binômio de Newton . . . . . . . . . . . . . . . . . . . . .

78

6.4.2

Distribuição Pascal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

79

6.5

Distribuição Hipergeométrica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

82

6.6

Distribuição Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

85

6.6.1

Aproximação da distribuição binomial pela Poisson . . . . . . . . . . . . . .

86

6.6.2

Distribuição Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

88

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

90

6.4

6.7

7

Principais Distribuições Contínuas

92

7.1

Distribuição Uniforme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

92

7.2

A Distribuição Normal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

93

7.2.1

Padronização e Tabulação da Distribuição Normal . . . . . . . . . . . . . .

94

7.2.2

Aproximação da Distribuição Binomial pela Normal . . . . . . . . . . . . .

96

A Distribuição Exponencial . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

97

7.3.1

99

7.3

7.4

7.5

Perda de Memória . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

A Distribuição Gama . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

7.4.1

A Função Gama . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

7.4.2

Distribuição Gama . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102

iv

Probabilidade e Estatística

8

Introdução à Inferência Estatística

8.1

Definições Básicas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104

8.2

Amostragem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 105

8.3

8.4

8.2.1

Tipos de Amostragem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 105

8.2.2

Distribuição Amostral . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 107

8.2.2.1

Distribuição Amostral da Média . . . . . . . . . . . . . . . . . . . 107

8.2.2.2

Teorema Central do Limite . . . . . . . . . . . . . . . . . . . . . 108

8.2.2.3

Distribuição Amostral da Proporção . . . . . . . . . . . . . . . . 109

8.2.2.4

Distribuição Amostral da Diferença entre Médias . . . . . . . . . 110

8.2.2.5

Distribuição Amostral da Diferença entre Proporções . . . . . . . 110

Inferência Estatística . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110

8.3.1

Estimação Pontual . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 111

8.3.2

Propriedades dos Estimadores . . . . . . . . . . . . . . . . . . . . . . . . . 111

8.3.3

Alguns Estimadores Pontuais Importantes . . . . . . . . . . . . . . . . . . . 112

8.3.3.1

Estimador para a Média . . . . . . . . . . . . . . . . . . . . . . . 112

8.3.3.2

Estimador para a Variância . . . . . . . . . . . . . . . . . . . . . 113

8.3.3.3

Estimador para a Proporção . . . . . . . . . . . . . . . . . . . . . 113

8.3.4

Estimação Intervalar . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113

8.3.5

Intervalo de Confiança para a Média . . . . . . . . . . . . . . . . . . . . . . 114

8.3.6

Intervalo de Confiança para a Proporção . . . . . . . . . . . . . . . . . . . . 115

8.3.7

Intervalo de Confiança para a Diferença de Médias . . . . . . . . . . . . . . 115

Regressão e Correlação . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 116

8.4.1

8.4.2

Correlação . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 116

8.4.1.1

Diagrama de Dispersão . . . . . . . . . . . . . . . . . . . . . . . 117

8.4.1.2

Coeficiente de Correlação de Pearson . . . . . . . . . . . . . . . . 119

Regressão . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 120

8.4.2.1

8.5

9

104

O Poder Explicativo do Modelo . . . . . . . . . . . . . . . . . . . 123

Atividades . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

Respostas das Atividades

128

9.1

Capítulo 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

9.2

Capítulo 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

9.3

Capítulo 3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 130

9.4

Capítulo 4 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

9.5

Capítulo 5 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

9.6

Capítulo 6 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 132

9.7

Capítulo 7 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 132

9.8

Capítulo 8 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 133

v

Probabilidade e Estatística

A Apêndice - Tabela da Distribuição Normal

135

10 Índice Remissivo

137

vi

Probabilidade e Estatística

Prefácio

Este livro foi desenvolvido para a introdução do tema Probabilidade e Estatística, não tendo a ambição

de englobar toda esta vasta área do conhecimento humano. Probabilidade e Estatística são as áreas

do conhecimento humano que lidam com a incerteza. Ambas lidam com experimentos em que existe

alguma variável (ou variáveis) que não temos controle, e portanto, mesmo mantendo as mesmas

condições, um experimento pode fornecer vários resultados diferentes.

Probabilidade e Estatística podem ser vistas como ciências inversas. Quando se estuda probabilidade,

conhecemos o modelo em estudo completamente, e estamos interessados em saber como os resultados do experimento se comportam (por exemplo, saber qual a probabilidade de sair um resultado

específico). Já na estatística, temos um conjunto de dados, mas não sabemos qual o modelo probabilístico que gerou estes dados, e portanto, tenta-se descobrir, a partir destes dados, qual o modelo

probabilístico que gerou estes dados.

Fenômenos aleatórios estão cada vez mais presentes em nossas vidas, e cada vez mais estamos interessados em tentar entender estes fenômenos. Gráficos estatísticos estão cada vez mais presentes em

notícias, e é importante saber interpretar esses gráficos corretamente. Quando vemos os resultados de

uma pesquisa eleitoral, é bom sabermos interpretar o seu significado, etc.. Vale a pena citar também

que ferramentas estatísticas são utilizadas pelos bancos, para definir o rendimento em fundos de investimento ou poupança, também são utilizadas pelas seguradoras para definir qual o valor do seguro

que você tem que pagar (na prática eles calculam o seu risco), etc..

Para um aluno, probabilidade e estatística podem ser úteis da seguinte forma: i) são úteis para realizar

pesquisa científica; ii) são úteis caso o aluno queira trabalhar em banco, seguradora, montadoras,

instituições financeiras em geral, controle de qualidade da produção de algum item, etc..; iii) são úteis

no dia-a-dia.

Finalizamos essa primeira parte do prefácio mostrando um exemplo de como a probabilidade pode

mostrar como a nossa intuição nos engana. Suponha que temos uma sala com 50 pessoas. Qual

a probabilidade de que pelo menos duas delas façam aniversário no mesmo dia do ano? Quando

falamos dia do ano, estamos falando dia e mês, não apenas dia. Temos 365 dias (vamos desconsiderar

o ano bissexto) e 50 pessoas. A intuição nos diz que essa probabilidade não deve ser muito grande.

Entretanto, esta probabilidade é de 97%!

Público alvo

O público alvo desse livro são os alunos de Licenciatura em Computação, na modalidade à distância

1 . Ele foi concebido para ser utilizado numa disciplina de Probabilidade e Estatística.

1 Embora

ele tenha sido feito para atender aos alunos da Universidade Federal da Paraíba, o seu uso não se restringe

a esta universidade, podendo ser adotado por outras universidades do sistema UAB.

vii

Probabilidade e Estatística

Como você deve estudar cada capítulo

• Leia a visão geral do capítulo

• Estude os conteúdos das seções

• Realize as atividades no final do capítulo

• Verifique se você atingiu os objetivos do capítulo

NA SALA DE AULA DO CURSO

• Tire dúvidas e discuta sobre as atividades do livro com outros integrantes do curso

• Leia materiais complementares eventualmente disponibilizados

• Realize as atividades propostas pelo professor da disciplina

Caixas de diálogo

Nesta seção apresentamos as caixas de diálogo que poderão ser utilizadas durante o texto. Confira os

significados delas.

Nota

Esta caixa é utilizada para realizar alguma reflexão.

Dica

Esta caixa é utilizada quando desejamos remeter a materiais complementares.

Importante

Esta caixa é utilizada para chamar atenção sobre algo importante.

Cuidado

Esta caixa é utilizada para alertar sobre algo que exige cautela.

Atenção

Esta caixa é utilizada para alertar sobre algo potencialmente perigoso.

Os significados das caixas são apenas uma referência, podendo ser adaptados conforme as intenções

dos autores.

viii

Probabilidade e Estatística

Contribuindo com o livro

Você pode contribuir com a atualização e correção deste livro. A tabela a seguir resume os métodos

de contribuições disponíveis:

Tabela 1: Métodos para contribuição do livro

Método de

contribuição

Habilidades necessárias

Descrição

• Inscrição no site do

github

Consiste em acessar o repositório do livro e

submeter um erro, uma sugestão ou uma crítica —

através da criação de um Issue. Quando

providências forem tomadas você será notificado

disso.

Issue track

• Preenchimento de um

formulário

Submissão

de correção

• Realizar fork de

projetos

• Atualizar texto do livro

Consiste em acessar os arquivos fontes do livro,

realizar a correção desejada e submetê-la para

avaliação. Este processo é o mesmo utilizado na

produção de softwares livres.

• Realizar PullRequest

Importante

Quando for enviar sua contribuição lembre-se de informar qual a versão e página do livro que

está se referindo.

Contribuição através do Issue track

Para contribuir com um erro, sugestão ou crítica através de um envio de uma mensagem acesse:

https://github.com/edusantana/estatistica-livro/issues/new

ix

Probabilidade e Estatística

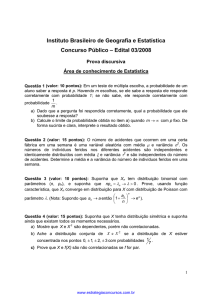

Figura 1: Exemplo de contribuição através do Issue track

Atividades

No final de cada capítulo há uma seção Atividades com exercícios para serem resolvidos.

O significado dos ícones relativos aos exercícios são:

Resposta disponível

a reposta do exercício se encontra disponível no Capítulo 9 [128].

Nota

Você pode contribuir enviando respostas ou soluções dos exercícios.

Baixando a edição mais nova deste livro

Nós estamos constantemente atualizando o nosso material didático. Todas as versões deste livro

encontram-se disponíveis para download.

Dica

Acesse https://github.com/edusantana/estatistica-livro/releases para baixar a versão mais

nova deste livro.

x

Probabilidade e Estatística

Capítulo 1

Estatística Descritiva

O BJETIVOS DO CAPÍTULO

Ao final deste capítulo você deverá ser capaz de:

• Conhecer os conceitos básicos da estatística e, principalmente, a diferença entre população e amostra

• Construir uma tabela estatística

• Conhecer os tipos de variáveis estatísticas

• Construir um histograma

• Identificar e entender o significado dos gráficos estatísticos

• Conhecer e saber calcular as principais medidas de posição

• Conhecer e saber calcular as principais medidas de dispersão

1.1

Conceitos Básicos

A Estatística é a ciência voltada para a construção de técnicas e métodos que permitem tomar decisões

nos mais deferentes setores do conhecimento. O que hoje se conhece por Estatística, é justamente

esse conjunto de ferramentas de pesquisa que envolve, entre outros, o planejamento do experimento

a ser realizado, a coleta qualificada dos dados, os processos de inferência estatística, bem como a

análise e o processamento das informações coletadas.

1.1.1

Definições importantes

Na estatística temos algumas definições importantes:

• População: Qualquer conjunto de informação que tenha entre si uma característica comum que

delimite os elementos pertencentes a ela.

• Amostra: É um subconjunto de elementos pertencentes a uma população.

• Variável: Dados referêntes a uma característica de interesse, coletados a partir de uma amostra.

• Censo: Exame de todos os elementos da população.

1 / 140

Probabilidade e Estatística

Amostra

População

Figura 1.1: População e Amostra

Variável

Figura 1.2: Exemplo de variável

Temos dois tipos de variáveis:

Qualitativa

Nominal :

sexo, cor dos olhos.

Ordinal :

classe social, grau de instrução.

Quantitativa

Discreta :

número de filhos.

Continua :

altura, peso, salário.

2 / 140

Probabilidade e Estatística

1.2

Tabelas Estatísticas

Na estatística é fundamental aprendermos a representar os dados que serão analisados por meio de

tabelas.

Uma tabela deve apresentar a seguinte estrutura:

• Cabeçalho;

• Corpo;

• Rodapé.

O cabeçalho deve conter o suficiente para que sejam respondidas as questões:

• O que está representado?

• Onde ocorreu?

• Quando ocorreu?

Além disso, a tabela é um quadro que resume um conjunto de dados dispostos segundo linhas e

colunas de maneira sistemática.

1.2.1

Série Cronológica ou Temporal

Um exemplo muito comum e muito útil de tabela é dado pelas séries temporais. Uma série temporal

consiste em uma sequência numérica cujos valores variam com o tempo.

Abaixo vemos como inserir os dados de uma série temporal em uma tabela:

Vendas da Companhia Alfa: 2007-2009

Anos

2007

2008

2009

Vendas em R$ 1.000,00

11.425

18.258

15.798

Fonte: Departamento de Marketing.

1.2.2

Série Geográfica

Muitas vezes o dado de interesse pode depender a posição geográfica de onde foram coletados. Assim, uma série geográfica consiste em uma sequência numérica obtidas em diferentes regiões em um

determinado instante do tempo.

Empresas Fiscalizadas em 2008

Regiões

Norte

Nordeste

Sudeste

Sul

Centro-Oeste

Número de Empresas

11.425

18.258

28.157

15.798

9.236

Fonte: Mensário Estatístico.

3 / 140

Probabilidade e Estatística

1.2.3

Série Específica

Uma série importante é formada por dados agrupados por alguma espécie ou característica comum.

Assim, uma série específica é uma série numérica agrupada por tipo. Temos o exemplo abaixo:

Matrículas na Pós-graduação da UFPB - 2008

Áreas de Ensino

Ciências Biológicas

Ciências Exatas e Tecnologia

Ciências Humanas

Matrículas

125

158

128

Fonte: Serviço de Educação e Cultura.

1.3

Distribuição de Frequência

Uma distribuição de frequência é uma tabela que contém um resumo dos dados obtido em uma amostra.

A distribuição é organizada em formato de tabela, e cada entrada da tabela contém a frequência dos

dados em um determinado intervalo, ou em um grupo.

Abaixo vemos um exemplo simplificado de tabela de distribuição de frequência:

Altura dos Alunos da UFPB - 2008

Alturas em metros

1,50 |− 1,60

1,60 |− 1,70

1,70 |− 1,80

1,80 |− 1,90

Número dos Alunos

5

15

17

3

Fonte: Serviço de Saúde.

Na próxima subseção aprenderemos a construir uma distribuição de frequência completa.

1.3.1

Construção de uma distribuição de frequência

Para ilustrar como se constrói uma distribuição de frequência, nós vamos considerar um exemplo

específico.

Assim, suponha que uma pesquisa foi feita, e o seguinte conjunto de dados foi obtido:

• Dados Brutos:

24-23-22-28-35-21-23-33-34-24-21-25-36-26-22-30-32-25-26-33-34-21-31-25-31-26-25-35-33-31.

A primeira coisa que fazemos é ordenar os dados do menor para o maior, formando o rol de dados:

• Rol de dados:

21-21-21-22-22-23-23-24-25-25-25-25-26-26-26-28-30-31-31-31-32-33-33-33-34-34-34-35-35-36.

Em seguida, calculamos a amplitude total, ou seja, o maior valor obtido na amostra subtraído do

menor valor obtido na amostra:

4 / 140

Probabilidade e Estatística

• Amplitude Total R:

R = 36 − 21 = 15.

Vamos agora definir as variáveis de interesse, ou seja, para cada valor distinto obtido na amostra,

atribuiremos uma variável diferente:

• Variável Xi :

X1 = 21,

X2 = 22,

X3 = 23,

X4 = 24,

etc.

O próximo passo é calcular a frequência absoluta das variáveis, ou seja, vamos calcular quantas vezes

cada valor aparece na sequência. Por exemplo, o valor 21 aparece 3 vezes, o valor 22 aparece 2 vezes,

etc.. Assim, obtemos:

• Frequência Absoluta Fi

F1 = 3, F2 = 2, F3 = 2, F4 = 1, etc. Vamos calcular, agora, o tamanho amostral, ou seja, o

número de observações obtidas na amostra.

Desta forma, temos:

• Tamanho Amostral n:

n = 30.

Queremos, agora, dividir a amostra em uma quantidade de grupos que formarão os intervalos. Cada

grupo é chamado de classe, assim, queremos definir o número de classes a ser considerado na tabela

de distribuição de frequência:

• Número de Classes K:

– K = 5 para n ≤ 25 e K ≈

√

n, para n > 25.

– Fórmula de Sturges K ≈ 1 + 3, 22 log n.

√

Logo, pela primeira regra temos K = 30 ≈ 5, 48 ≈ 6, e pela segunda regra K ≈ 1 + 3, 22 log 30 ≈

5, 75 ≈ 6. Desta forma, em ambos os casos temos K = 6, que será o valor considerado.

O próximo passo é saber o comprimento de cada intervalo a ser considerado, ou seja, calcular a

amplitude de cada classe. Queremos que todas as classes tenham a mesma amplitude e portanto,

temos:

• Amplitude das Classes h:

h=

Daí, para o nosso caso, h =

15

6

R

.

K

= 2, 5 ≈ 3.

Vamos agora definir os limites das classes. Ou seja, definir os intervalos propriamente ditos. Para

tanto, começamos com o menor valor obtido da amostra, ou equivalentemente, o primeiro valor do

rol de dados, e vamos somando a amplitude para definir cada limite de intervalo:

5 / 140

Probabilidade e Estatística

• Limites das Classes:

21|− 24

24|− 27

27|− 30

30|− 33

33|− 36

36|− 39

Em seguida, calculamos os pontos médios das classes, que nada mais é que a média aritmética entre

os limites das classes:

• Pontos Médios das Classes pmi :

pm1 =

21 + 24

= 22, 5,

2

pm2 =

24 + 27

= 25, 5,

2

, etc.

Agora, calculamos as frequências dos dados em cada intervalo e, chamada de frequência absoluta, e

também a frequência acumulada, chamada de frequência absoluta acumulada, que considera a soma

das frequências dos intervalos anteriores até o intervalo considerado:

• Frequência Absoluta Acumulada Fac :

Classes

21|− 24

24|− 27

27|− 30

30|− 33

33|− 36

36|− 39

Total

pmi

22,5

25,5

28,5

31,5

34,5

37,5

-

Fi

7

8

2

4

8

1

30

Fac

7

15

17

21

29

30

-

Em seguida, inclui-se as frequências relativas dos dados, ou seja, para cada intervalo calcula-se fi =

Fi /n. A frequência relativa, nos informa a proporção dos dados que pertencem a um determinado

intervalo.

• Frequência Relativa fi :

Classes

21|− 24

24|− 27

27|− 30

30|− 33

33|− 36

36|− 39

Total

pmi

22,5

25,5

28,5

31,5

34,5

37,5

-

Fi

7

8

2

4

8

1

30

Fac

7

15

17

21

29

30

-

fi

0,23

0,27

0,07

0,13

0,27

0,03

1,00

Para finalizar, calculamos a frequência acumulada relativa, ou seja, calculamos para cada intervalo

fac = Fac /n:

6 / 140

Probabilidade e Estatística

• Frequência Relativa Acumulada fac :

Classes

21|− 24

24|− 27

27|− 30

30|− 33

33|− 36

36|− 39

Total

1.4

1.4.1

pmi

22,5

25,5

28,5

31,5

34,5

37,5

-

Fi

7

8

2

4

8

1

30

Fac

7

15

17

21

29

30

-

fi

0,23

0,27

0,07

0,13

0,27

0,03

1,00

fac

0,23

0,50

0,57

0,70

0,97

1,00

-

Gráficos Estatísticos

Histograma

O histograma é uma representação gráfica da distribuição de frequência. O histograma é formado

por uma justaposição de retângulos de bases com mesmo comprimento. O comprimento da base

é justamente a amplitude do intervalo e a altura do retângulo é dada pela frequência absoluta do

intervalo.

Assim, uma vez feita a distribuição de frequência, a construção do histograma é uma tarefa muito

simples.

2

0

1

Fi

3

4

Abaixo vemos um exemplo de histograma:

0

5

10

15

20

25

30

35

Classes

Figura 1.3: Histograma

1.4.2

Polígono de Frequência

O polígono de frequência é uma representação gráfica obtida após ligar os pontos médios de cada

classe entre si. Se já tivermos um histograma, basta ligar os pontos médios das bases superiores dos

retângulos.

7 / 140

Probabilidade e Estatística

4

0

2

Fi

6

8

Abaixo vemos um exemplo de polígono de frequência obtido a partir de um histograma:

5

10

15

20

Classes

Figura 1.4: Polígono de Frequência Obtido a Partir de um Histograma

4

0

2

Fi

6

8

Abaixo vemos um exemplo contendo apenas o polígono de frequência:

6

8

10

12

14

16

18

Classes

Figura 1.5: Polígono de Frequência Obtido a Partir de um Histograma

1.4.3

Gráfico de Linhas

Suponha que temos duas variáveis, por exemplo, podemos ter os dados de uma série temporal, donde

uma variável seria o valor obtido, e a outra variável seria a data em que o valor foi obtido. Outra

8 / 140

Probabilidade e Estatística

possibilidade seria colocar dados de uma série geográfica, onde uma variável seria formada pelos

dados e a outra seria a localização geográfica.

O gráfico de linhas então é formado construindo pontos no plano (a partir das duas variáveis) e, em

seguida, estes pontos são ligados por segmentos de retas.

60

0 20

−40

Rendimento

100

Abaixo vemos um exemplo de gráfico de linhas de uma série temporal

2006

2008

2010

2012

2014

Período

Figura 1.6: Gráfico de linhas

1.4.4

Gráfico de Colunas

Um gráfico de colunas é formado por uma coleção de colunas, com bases de mesmo comprimento, e

igualmente espaçados. O eixo horizontal do gráfico consiste das diferentes categorias consideradas, e

o eixo vertical é proporcional ao valor do dado.

Abaixo vemos um exemplo de gráfico de colunas:

9 / 140

Probabilidade e Estatística

0

2

4

6

8 10

14

Pessoas por categoria

3

4

5

Categorias

Figura 1.7: Gráfico de colunas

1.4.5

Gráfico em Barras

O gráfico em barras pode ser entendido como uma variação do gráfico de colunas. De fato, o gráfico

em barras é formado por uma coleção de barras, de mesma altura e igualmente espaçadas. Entretanto, neste caso o eixo vertical representa as diferentes categorias consideradas e o eixo horizontal é

proporcional ao valor dado.

Abaixo vemos um exemplo de gráfico em barras:

Baixa

Média

Alta

Pessoas por classe

0

2

4

6

8

10

Figura 1.8: Gráfico em barras

10 / 140

12

14

Probabilidade e Estatística

1.4.6

Gráfico de Setores

O gráfico de setores, que também é popularmente conhecido como gráfico pizza, é um gráfico em

que um círculo é dividido em setores (que podem ser pensados como as fatias da pizza), onde cada

setor representa uma categoria considerada pelo conjunto de dados, e os ângulos dos setores são

proporcionais aos valores dos dados em cada categoria. Assim, quanto maior o valor obtido, maior

será o ângulo do setor (e assim, maior será a fatia da pizza).

Abaixo vemos um exemplo de gráfico de setores:

Sudeste

Centro−Oeste

Sul

Nordeste

Norte

Figura 1.9: Gráfico de setores

1.5

Medidas de Posição

As medidas de posição são valores que representam a tendência de concentração dos dados observados.

As mais importantes são as medidas de tendência central. As três medidas de tendência central mais

utilizadas são: média aritmética, moda e mediana.

1.5.1

Média Aritmética

É um valor que representa uma característica do conjunto de dados. Essa característica é tal que a

soma dos dados é preservada. A média é obtida a partir de todos os elementos da distribuição e do

tamanho da amostra n.

Notação: representamos a média de um conjunto de dados por X (lê-se x barra).

Cálculo da Média Aritmética +

• Dados não agrupados (brutos) - média aritmética simples.

11 / 140

Probabilidade e Estatística

No caso de uma lista de dados não-agrupados, calculamos a média aritmética pela fórmula:

n

Xi

.

i=1 n

X=∑

Exemplo 1.1 Exemplo de cálculo de média aritmética com dados brutos

Considere os dados 2, 3, 7 e 8. Então, n = 4 e

X=

2 + 3 + 7 + 8 20

=

= 5.

4

4

• Dados agrupados - média aritmética ponderada.

No caso em que temos os dados agrupados, ou seja, sabemos a frequência de cada observação, o

cálculo da média aritmética pode ser simplificado. Assim, a média aritmética pode ser cálculada pela

fórmula:

n

Xi · Fi

X=∑

.

i=1 n

Exemplo 1.2 Exemplo de cálculo de média aritmética ponderada

Considere a seguinte tabela:

Tempo de Serviço (Xi )

4

6

8

Total

Assim, X =

122

18

Fi

3

5

10

18

Xi · Fi

12

30

80

122

= 6, 78.

• Dados agrupados em intervalos - média aritmética ponderada

No caso em que temos os dados agrupados em intervalos, utilizamos a média aritmética ponderada,

onde os pesos são dados pelo ponto médio do intervalo. Assim, a média aritmética é calculada pela

fórmula:

n

Xi · pmi

X=∑

,

n

i=1

Exemplo 1.3 Exemplo de cálculo de médias com dados agrupados em intervalos

Considere a seguinte tabela:

Anos (Xi ) Fi pmi Xi · pmi

0`4

4

2

8

10

6

60

4`8

8 ` 12

7

10

70

Total

21

138

Assim, X =

138

21

= 6, 57.

12 / 140

Probabilidade e Estatística

1.5.2

Moda

Definimos a moda de um conjunto de dados como o valor mais frequente deste conjunto.

Notação: representamos a moda de um conjunto de dados por Mo.

Exemplo 1.4 Exemplo de modas

• 1, 2, 4, 5 e 8 - não existe valor mais frequente - não existe moda (Amodal).

• 2, 2, 3, 7 e 8 - Mo = 2 (Unimodal).

• 1, 1, 10, 5, 5, 8, 7, 2 - Mo = 1 e 5 (Bimodal).

• Dados agrupados - Neste caso, a moda é definida como “classe modal”, isto é, a classe com a

maior frequencia.

Exemplo 1.5 Exemplo de cálculo de classe modal

Considere a seguinte tabela:

Tempo de Serviço (Xi )

4

6

8

Total

Fi

3

5

10

18

Assim, Mo = 8 (F3 ).

• Dados agrupados em intervalos: Neste caso, utiliza-se a fórmula de Czuber:

h(FMo − Fant )

Mo = lMo +

,

2FMo − (Fant + FPos )

onde:

• h é a amplitude intervalar,

• FMo é a frequência da classe modal,

• lMo é o limite inferior da classe modal,

• Fant é a frequência da classe anterior à classe modal,

• FPos é a frequência da classe posterior à classe modal.

13 / 140

Probabilidade e Estatística

Exemplo 1.6 Exemplo de cálculo de moda pela fórmula de Czuber

Considere a seguinte tabela:

Anos (Xi ) Fi

0`4

4

4`8

10

7

8 ` 12

Total

21

Assim, h = 4, FMo = 10, lMo = 4, Fant = 4 e Fpos = 7. Daí

4 · (10 − 4)

= 6, 67.

Mo = 4 +

2 · 10 − (4 + 7)

1.5.3

Mediana

Definimos a mediana de um conjunto de dados como o valor que divide um conjunto de dados (ordenados) em duas partes com a mesma quantidade de dados.

Notação: representamos a mediana de um conjunto de dados por Md.

O elemento mediano (EMd ) aponta o local (nos dados) onde a mediana está localizada. A mediana

será o valor assumido na posição EMd .

• Dados não agrupados (brutos)

– No caso de dados brutos, se o tamanho amostral (n) é ímpar, temos que EMd = (n + 1)/2.

– Note que no caso tamanho amostral é par, teremos dois valores possíveis para o elemento mediano: n/2 e n/2 + 1. Neste caso a mediana será a média dos valores assumidos nestas posições.

Exemplo 1.7 Exemplo de cálculo de mediana para dados brutos

• 1, 2, 4, 5 e 8. Como n é ímpar, temos EMd = 3, e Md = 4.

• 2, 2, 3, 7, 8 e 10. Aqui n é par, assim EMd,1 = 6/2 = 3 e EMd,2 = 6/2 + 1 = 4. Daí Md = (3 + 7)/2 =

5.

• Dados agrupados

Neste caso, olhar a frequência acumulada ajuda a encontrar a médiana.

• Caso 1: n ímpar.

14 / 140

Probabilidade e Estatística

Exemplo 1.8 Exemplo de cálculo de mediana com dados agrupados para n ímpar

Considere a seguinte tabela:\vfill

Faltas (Xi ) Fi Fac

2

1

1

3

7

8

3 11

4

Total

11 Como n = 11, temos que EMd = (11 + 1)/2 = 6. Daí Md = 3. Note que a frequência acumulada

indica que nas posições de 2 até 8 temos o valor 3.

• Caso 2: n par.

Exemplo 1.9 Exemplo de cálculo de mediana com dados agrupados para n par

Considere a seguinte tabela:

Tempo de Serviço (Xi )

4

6

8

Total

Fi

3

5

10

18

Fac

3

8

18

Neste caso n = 18, daí temos EMd,1 = 18/2 = 9 e EMd,2 = 18/2 + 1 = 10. Portanto Md = (8 + 8)/2 =

8. Note, novamente, que a frequência acumulada indica que nas posições de 9 até 18 temos o valor 8.

• Dados agrupados em intervalos

Neste caso, utilizamos EMd = n/2 independentemente de n ser par ou ímpar.

A classe mediana é a primeira classe tal que Fac ≥ EMd .

Portanto, definimos a mediana pela fórmula

EMd − Fac,ant

Md = lMd + h ·

,

FMd

onde,

• lMd é o limite inferior da classe mediana,

• h é a amplitude do intervalo,

• Fac,ant é a frequência acumulada da classe anterior à classe mediana,

• FMd é a frequência da classe mediana.

15 / 140

Probabilidade e Estatística

Exemplo 1.10 Exemplo do cálculo da mediana para dados agrupados em intervalos

Considere a seguinte tabela:

Anos (Xi ) Fi Fac

0`4

4

4

4`8

10 14

7 21

8 ` 12

Total

21

Assim, EMd = 21/2 = 10, 5, e desta forma temos que a segunda classe é a classe mediana. Daí

lMd = 4, h = 4, Fac,ant = 4 e FMd = 10. Portanto,

10, 5 − 4

= 6, 6.

Md = 4 + 4 ·

10

1.6

Medidas de Dispersão

• As medidas de dispersão medem o grau de variabilidade dos elementos de uma distribuição;

• O valor zero indica ausência de dispersão;

• A dispersão aumenta à medida que aumenta o valor da medida de dispersão.

Exemplo 1.11 Exemplo de motivação para as medidas de dispersão

Notas de alunos em cinco avaliações, UFPB, 2009.

Alunos

Antônio

João

José

Pedro

5

6

10

10

5

4

5

10

Notas

5

5 5

5

4 6

5

5 0

5

0 0

Média

5

5

5

5

Observa-se que: * As notas de Antônio não variaram;

• As notas de João variaram menos do que as notas de José;

• As notas de Pedro variaram mais do que as notas de todos os outros alunos.

Principais Medidas de Dispersão:

• Amplitude,

• Desvio Médio,

• Variância,

• Desvio Padrão,

• Coeficiente de Variação.

16 / 140

Probabilidade e Estatística

1.6.1

Amplitude

A amplitude nos fornece uma idéia do campo de variação dos elementos. Mais precisamente, ela

fornece a maior variação possível dos dados.

A amplitude é dada pela fórmula

A = Xmax − Xmin .

Exemplo 1.12 Exemplo de cálculo de amplitude

No exemplo anterior:

AAntônio = 0;

AJoão = 2;

AJosé = 10;

APedro = 10.

Nota

A amplitude não mede bem a dispersão dos dados porque, usam-se apenas os valores

extremos, ao invés de utilizar todos os elementos da distribuição.

1.6.2

Desvio Médio

Desejando-se medir a dispersão dos dados em relação a média, parece interessante a análise dos

desvios em torno da média. Isto é, análise dos desvios:

di = (Xi − X).

Mas a soma de todos os desvios é igual a zero. Isto é:

n

n

∑ di = ∑ (Xi − X) = 0.

i=1

i=1

Logo, será preciso encontrar uma maneira de se trabalhar com os desvios sem que a soma dê zero.

Dessa forma, define-se o desvio médio.

• Dados não agrupados (brutos):

Neste caso, calculamos o desvio médio como:

n

|di |

|Xi − X|

=∑

.

n

i=1 n

i=1

n

DM = ∑

Nota

Veja que os desvios foram considerados em módulo, evitando-se assim que a soma fosse

nula.

• Dados agrupados:

17 / 140

Probabilidade e Estatística

n

|Xi − X| · Fi

|di | · Fi

=∑

.

n

n

i=1

i=1

n

DM = ∑

Nota

Xi representa um valor individual, no caso de uma distribuição de frequência simples, ou o

ponto médio da classe ( pmi ), no caso de uma distribuição de frequência em classes.

Importante

• O desvio médio é mais vantajoso que a amplitude, visto que leva em consideração todos

os valores da distribuição.

• No entanto, não é tão frequentemente empregado, pois não apresenta propriedades matemáticas interessantes.

1.6.3

Variância

A variância é a medida de dispersão mais utilizada. É o quociente entre a soma dos quadrados dos

desvios e o número de elementos. Assim, temos a seguinte definição de variância populacional:

• Dados não agrupados - (brutos):

Neste caso, a variância é dada pela fórmula:

N

di2

(Xi − X)2

=∑

.

N

N

i=1

i=1

N

σ2 = ∑

• Dados agrupados:

Aqui, podemos utilizar a frequência para simplificar a fórmula:

N

N

di2 · Fi

(Xi − X)2 · Fi

σ =∑

=∑

.

N

i=1 N

i=1

2

Nota

σ 2 indica a variância populacional e lê-se sigma ao quadrado ou sigma dois. Neste caso,

X e N da formúla representam a média populacional e o tamanho populacional, respectivamente.

Temos ainda a seguinte definição de variância amostral:

• Dados não agrupados - (brutos):

Neste caso, a fórmula é dada por

n

n

di2

(Xi − X)2

=∑

i=1 n − 1

i=1 n − 1

S2 = ∑

18 / 140

Probabilidade e Estatística

• Dados agrupados:

Podemos, novamente, utilizar as frequências para simplificar a fórmula:

n

n

di2 · Fi

(Xi − X)2 · Fi

=∑

.

n−1

i=1 n − 1

i=1

S2 = ∑

Nota

Xi representa um valor individual, no caso de uma distribuição de frequência simples, ou o

ponto médio da classe ( pmi ), no caso de uma distribuição de frequência em classes.

Importante

Fórmulas práticas para os cálculos das variâncias são dadas a seguir:

2i

(∑N

1h N 2

i=1 Xi · Fi )

σ =

∑ Xi · Fi −

N i=1

N

2

ou

(∑ni=1 Xi · Fi )2 i

1 h n 2

S =

∑ Xi · Fi −

n − 1 i=1

n

2

que foram obtidas por transformações nas respecitivas fórmulas originais.

1.6.4

Desvio Padrão

Temos também outra medida de dispersão, que é a raiz quadrada da variância, chamada de desvio

padrão. Assim,

√

σ = σ 2 é o desvio desvio padrão populacional

e

S=

√

S2

é o desvio desvio padrão amostral.

Nota

Para o cálculo do desvio padrão deve-se primeiramente determinar o valor da variância e,

em seguida, extrair a raiz quadrada desse resultado.

Exemplo 1.13 Exemplo de cálculo das medidas de dispersão

Calcular a amplitude, o desvio médio, a variância e o desvio padrão da seguinte distribuição amostral:

Xi

5

7

8

9

11

Total

Fi

2

3

5

4

2

16

19 / 140

Probabilidade e Estatística

• Cálculo da amplitude:

A = Xmax − Xmin = 11 − 5 = 6.

• Cálculo do desvio médio:

Primeiramente é preciso do valor da média. Assim,

Xi

5

7

8

9

11

Total

Fi

2

3

5

4

2

16

Xi · Fi

10

21

40

36

22

129

n

Xi · Fi 129

=

= 8, 06.

16

i=1 n

X=∑

Para o cálculo do DM são abertas novas colunas:

Xi

5

7

8

9

11

Total

Fi

2

3

5

4

2

16

Xi · Fi

10

21

40

36

22

129

Portanto,

|Xi − X| = |di |

|5 − 8, 06| = 3, 06

|7 − 8, 06| = 1, 06

|8 − 8, 06| = 0, 06

|9 − 8, 06| = 0, 94

|11 − 8, 06| = 2, 94

-

|di | · Fi

6,12

3,18

0,30

3,76

5,88

19,24

n

|di | 19, 24

=

= 1, 20.

16

i=1 n

DM = ∑

• Cálculo do variância amostral:

Observe que o cálculo será facilitado, pois sabe-se que: n = 16; ∑ Xi · Fi = 129. Resta encontrar

∑ Xi2 · Fi . Para tanto, uma nova coluna é considerada na tabela.

Xi

5

7

8

9

11

Total

Fi

2

3

5

4

2

16

Xi · Fi

10

21

40

36

22

129

Portanto,

Xi2 · Fi

50

147

320

324

242

1083

(∑ni=1 Xi · Fi )2 i

1 h n 2

=

∑ Xi · Fi −

n − 1 i=1

n

h

i

2

1

(129)

1h

16641 i

=

1083 −

=

1083 −

16 h− 1

16i

15

16

1 17328 − 16641

687

=

= 2, 86.

=

15

16

15 · 16

Logo, a variância amostral S2 = 2, 86.

S2

20 / 140

Probabilidade e Estatística

• Cálculo do desvio padrão amostral:

√

√

Como S = S2 , logo S = 2, 86 = 1, 69.

Dessa forma, podemos observar que a distribuição possui média 8, 06. Isto é, seus valores estão em

torno de 8, 06 e seu grau de concentração é de 1, 2, medido pelo desvio médio e de 1, 69, medido pelo

desvio padrão.

1.6.5

Coeficiente de Variação

Trata-se de uma medida relativa de dispersão útil para a comparação em termos relativos do grau de

concentração em torno da média de séries distintas. É dado por

CV =

S

× 100.

X

onde, S é o desvio padrão amostral e X é a média amostral.

O coeficiente de variação é expresso em porcentagens.

Exemplo 1.14 Exemplo de cálculo do coeficiente de variação

Numa empresa, o salário médio dos homens é de R$ 4.000,00, com desvio padrão de R$ 1.500,00, e

o das mulheres é em média de R$ 3.000,00, com um desvio padrão de R$ 1.200,00. Então:

• Para os homens:

CV =

1.500

× 100 = 37, 5%.

4.000

• Para as mulheres:

1.200

× 100 = 40%.

3.000

Logo, podemos concluir que os salários da mulheres apresenta maior dispersão relativa do que o dos

homens.

CV =

Diz-se que a distribuição possui pequena variabilidade, ou dispersão, quando o coeficiente der até

10%; média dispersão quando estiver acima de 10% até 20%; e grande dispersão quando superar

20%. Alguns analistas consideram:

• Baixa dispersão: CV ≤ 15%;

• Média dispersão: 15% < CV < 30%;

1.7

Atividades

1. Em um estado, foram pedidos para 35 empresas os números de empregados demitidos no ano de

2013. Os resultados informados pelas empresas estão dados abaixo:

35-30-30-45-41-48-64-41-47-56-43-36-45-40-33-49-37-34-56

40-41-37-45-48-34-52-25-53-41-38-41-37-45-35-41.

a) Construa uma tabela de distribuição de frequência para estes dados.

21 / 140

Probabilidade e Estatística

b) Construa um histograma para estes dados.

2. Construa uma tabela de distribuição de frequência e histograma para o seguinte conjunto de dados:

26-9-7-5-9-6-3-4-19-25-5-20-21-9-30-8-18-3-22-14-25-1-18-14-24.

3.

Calule a média aritmética dos dados da questão 1.

4.

Calcule a média aritmética dos dados da questão 2.

5.

Calcule a moda dos dados da questão 1.

6.

Calcule a moda dos dados da questão 2.

7.

Calcule a mediana dos dados da questão 1.

8.

Calcule a mediana dos dados da questão 2.

9.

Calcule o desvio médio dos dados da questão 1.

10.

Calcule o desvio médio dos dados da questão 2.

11.

Calcule a variância amostral e populacional dos dados da questão 1.

12.

Calcule a variância amostral e populacional dos dados da questão 2.

13.

Calcule o coeficiente de variação dos dados da questão 1.

14.

Calcule o coeficiente de variação dos dados da questão 2.

Feedback sobre o capítulo

Você pode contribuir para melhoria dos nossos livros. Encontrou algum erro? Gostaria de

submeter uma sugestão ou crítica?

Para compreender melhor como feedbacks funcionam consulte o guia do curso.

22 / 140

Probabilidade e Estatística

Capítulo 2

Teoria dos Conjuntos e Contagem

O BJETIVOS DO CAPÍTULO

Ao final deste capítulo você deverá ser capaz de:

• Entender o que é um conjunto, um elemento de um conjunto

• Entender as relações entre conjuntos

• Conhecer os principais métodos de contagem

• Saber a diferença entre combinação e arranjo e como aplicar essas definições em problemas práticos

• Conhecer o binômio de Newton

O objetivo deste capítulo é apresentar os pré-requisitos necessários para estudar probabilidade.

2.1

Teoria dos Conjuntos

Conjunto é uma coleção de objetos. A natureza desses objetos é arbitrária, ou seja, podemos ter

conjunto de qualquer coisa. Por exemplo, podemos ter conjuntos de pessoas; conjuntos de números;

conjuntos de letras; podemos ter até conjuntos de conjuntos!

Nós representaremos conjuntos por letras maiúsculas A, B,C, . . ..

Chamamos os objetos que formam o conjunto de elementos. Assim, para descrever um conjunto,

basta listar seus elementos. Existem três maneiras de descrever os elementos de um conjunto A:

• Listando os elementos. Por exemplo, A = {1, 2, 3, 4, . . .};

• Descrevendo os elementos. Por exemplo, A é o conjunto de todos os números inteiros;

• Colocando condições. A = {x; x é número real e 0 ≤ x ≤ 1}.

Nota

É importante observar a notação. Sempre escreveremos os elementos que formam um conjunto entre chaves. O ponto-e-vírgula, quando estiver entre chaves deve ser lido como “tal

que”. Por exemplo, no conjunto A = {x; x é número real e 0 ≤ x ≤ 1}, lemos, A é o conjunto

dos números reais tais que 0 ≤ x ≤ 1.

23 / 140

Probabilidade e Estatística

Quando o objeto x é elemento do conjunto A, dizemos que x pertence a A, e escrevemos x ∈ A.

Analogamente, se x não é elemento do conjunto A, dizemos que x não pertence a A, e escrevemos

x∈

/ A.

Existe um conjunto que não possui nenhum elemento. Esse conjunto especial é chamado de conjunto

vazio e é denotado por 0.

/

Importante

É muito importante notar que o conjunto vazio 0/ não possui nenhum elemento, portanto não

há chaves na sua notação. O conjunto {0}

/ NÃO é o conjunto vazio, e sim um conjunto com

um elemento, e esse elemento é o conjunto vazio.

2.1.1

Comparação entre conjuntos

Sejam A e B dois conjuntos. Dizemos que A é subconjunto de B, e escrevemos, A ⊂ B se todo elemento

de A é elemento de B. Ou seja, se sempre que x ∈ A, temos que x ∈ B. Se existe x ∈ A tal que x ∈

/ B,

dizemos que A não é subconjunto de B, e escrevemos A 6⊂ B.

Exemplo 2.1 Exemplo de comparação entre conjuntos

Sejam A = {1, 2, 3, 4, 5}, B = {2, 4} e C = {3, 5, 7}.

Então, temos que B ⊂ A, mas C 6⊂ A, A 6⊂ C, A 6⊂ B, C 6⊂ B e B 6⊂ C.

Exercício

Mostre que para todo conjunto A, o conjunto vazio é subconjunto de A, ou seja, que 0/ ⊂ A.

Solução

Suponha que 0/ 6⊂ A, então por definição, isso significa que existe x ∈ 0/ tal que x 6∈ A. Como 0/

não possui nenhum elemento, é impossível encontrar o tal elemento x.

Portanto, a afirmação 0/ 6⊂ A é falsa. Isso mostra que 0/ ⊂ A.

Definição: Igualdade de conjuntos

Dizemos que os conjuntos A e B são iguais, e escrevemos A = B, se todo elemento de A é

elemento de B e todo elemento de B é elemento de A.

Equivalentemente, temos que A = B se, e somente se, A ⊂ B e B ⊂ A.

2.1.2

União de conjuntos

Suponha que temos dois conjuntos A e B. Podemos definir um terceiro conjunto, chamado de conjunto

união de A e B, formado pelos elementos de A e pelos elementos de B. Matematicamente, escrevemos

A ∪ B = {x; x ∈ A ou x ∈ B}.

24 / 140

Probabilidade e Estatística

Exemplo 2.2 Exemplo de união de conjuntos

Sejam A = {1, 2, 3, 4, 5}, B = {2, 4} e C = {3, 5, 7}.

Então, A ∪ B = {1, 2, 3, 4, 5},

Nota

Se A ⊂ B, então todo elemento de A já é elemento de B, e portanto A ∪ B = B.

De maneira geral, dados conjuntos A1 , A2 , A3 , . . ., definimos o conjunto formado pela união dos conjuntos A1 , A2 , . . ., como o conjunto que contém todos os elementos de A1 , de A2 , etc.. Matematicamente, temos:

∞

[

Ai = {x; existe i tal que x ∈ Ai }.

i=1

Exercício

Forneça a definição da união de n conjuntos A1 , A2 , . . . , An .

Solução

Definimos a união de n conjuntos A1 , . . . , An , como o conjunto formado pelos elementos de

A1 , . . . , An , ou seja, é o conjunto

n

[

Ai = {x; x ∈ A1 ou x ∈ A2 , . . . , ou x ∈ An }.

i=1

2.1.3

Interseção de conjuntos

Suponha que temos dois conjuntos A e B. Considere agora o conjunto formado pelos objetos que são

elementos de A e também são elementos de B. Este conjunto é chamado de conjunto interseção de A

e B. Escrevemos este conjunto, matematicamente, como

A ∩ B = {x; x ∈ A e x ∈ B}.

Exemplo 2.3 Exemplo de interseção de conjuntos

Sejam A = {1, 2, 3, 4, 5}, B = {2, 4} e C = {3, 5, 7}.

Então, A ∩ B = {2, 4}, A ∩C = {3, 5} e B ∩C = 0.

/

Nota

Se A ⊂ B, então todo elemento de A é elemento de B, assim os elementos que estão em A

e B, são os elementos de A. Ou seja, A ∩ B = A.

25 / 140

Probabilidade e Estatística

De maneira geral, dados conjuntos A1 , A2 , A3 , . . ., definimos a interseção entre os conjuntos

A1 , A2 , A3 , . . . como o conjunto formado pelos elementos que estão simultaneamente em todos os

conjuntos. Escrevemos esse conjunto matematicamente como

∞

\

Ai = {x; x ∈ A1 , x ∈ A2 , . . .}.

i=1

Exercício

Forneça a definição da interseção de n conjuntos A1 , A2 , . . . , An .

Solução

Definimos a interseção de n conjuntos A1 , . . . , An , como o conjunto formado pelos elementos

que estão simultaneamente A1 , . . . , An , ou seja, é o conjunto

n

\

Ai = {x; x ∈ A1 e x ∈ A2 , . . . , e x ∈ An }.

i=1

2.1.4

Diferença entre conjuntos

Suponha que temos dois conjuntos A e B. Considere agora o conjunto formado por objetos que são

elementos de B, mas não são elementos de A. Esse conjunto é chamado de B menos A, e é denotado

por B \ A. Matematicamente, temos

B \ A = {x; x ∈ B e x ∈

/ A}.

Exemplo 2.4 Exemplo de diferença de conjuntos

Sejam A = {1, 2, 3, 4, 5}, B = {2, 4} e C = {3, 5, 7}.

Então, A \ B = {1, 3, 5}, A \C = {1, 2, 4}, B \C = {2, 4}, B \ A = 0,

/ C \ A = {7} e C \ B = {3, 5, 7}.

2.1.5

Complementar de um conjunto

Um caso particular e importante de diferenças de conjunto é o complementar. Esta definição é particularmente útil no curso de probabilidade.

Suponha que temos um conjunto de referência, digamos M. Dado qualquer conjunto A ⊂ M, definimos o complementar de A (em M), como o conjunto Ac = M \ A.

Atenção

Quando está claro no contexto quem é o conjunto de referência, o conjunto Ac é referido

apenas como complementar de A.

O complementar de A é descrito como o conjunto dos elementos que não pertencem a A. Fica claro

que é o conjunto dos elementos que não pertencem a A, mas pertencem ao conjunto de referência M.

26 / 140

Probabilidade e Estatística

2.1.6

Propriedades entre as relações entre conjuntos

Valem as seguintes identidades entre união, interseção e complementação entre conjuntos:\\

• A ∪ (B ∩C) = (A ∪ B) ∩ (A ∪C);

• A ∩ (B ∪C) = (A ∩ B) ∪ (A ∩C);

• A ∩ 0/ = 0;

/

• A ∪ 0/ = A;

• (A ∩ B)c = Ac ∪ Bc ;

• (A ∪ B)c = Ac ∩ Bc ;

• (Ac )c = A.

2.2

Contagem

Vamos agora introduzir técnicas de contagem.

2.2.1

Regra da multiplicação

A primeira técnica é conhecida como regra da multiplicação. Para ilustrar a técnica, considere o

seguinte exemplo:

Exemplo 2.5 Exemplo para ilustrar a regra da multiplicação

Fernando possui 10 pares de meias e 3 pares de sapatos. Sabendo que Fernando pode utilizar

qualquer par de meia com qualquer sapato, de quantas formas diferentes, ele pode combinar pares de

meias com sapatos?

Vamos começar colocando rótulos nos sapatos: sapato 1, sapato 2 e sapato 3. O sapato 1 pode ser

usado com 10 pares de meias; o sapato 2 também pode ser usado com 10 pares de meias; e o sapato

3 também pode ser usado com 10 pares de meias. Portanto, como Fernando pode utilizar o sapato 1,

o sapato 2 e o sapato 3, ele poderá fazer 10+10+10 = 30 combinações diferentes entre pares de meias

e sapatos.

Resumindo, cada sapato pode ser associado a 10 pares de meias, e como temos 3 sapatos, o total de

combinações é 30 = 3 · 10. Por isso o nome regra da multiplicação. Pois multiplicamos o número de

sapatos pelo número de pares de meias.

A regra geral é dada por:

Regra da multiplicação

Suponha que temos 2 tipos de objetos: tipo 1 e tipo 2. Suponha que cada objeto do tipo 1 pode

ser combinado com todos os objetos do tipo 2. Assim, se temos n objetos de tipo 1 e m objetos

de tipo 2, teremos n · m combinações possíveis entre objetos de tipo 1 e objetos de tipo 2.

27 / 140

Probabilidade e Estatística

2.2.2

Regra da adição

Vamos agora ilustrar outra técnica de contagem, que é conhecida como a regra da adição. Para

motivar, considere o seguinte exemplo:

Exemplo 2.6 Exemplo para ilustrar a regra da adição

Paulo tem 15 blusas de manga comprida e 10 blusas de manga curta e apenas uma calça. Sabendo

que Paulo não usa duas blusas ao mesmo tempo, de quantas formas ele pode se vestir?

Como Paulo só possui uma calça, o que determina a quantidade de formas de se vestir é a quantidade

de blusas. Como Paulo possui 25 = 10+15 blusas, segue que Paulo pode se vestir de 25 formas

diferentes.

Assim, como Paulo não pode usar uma blusa de manga comprida e outra de manga curta ao mesmo

tempo, segue que temos que escolher uma única blusa entre o total de blusas que é dada pela soma

entre a quantidades de blusas de manga comprida e blusas de manga curta.

A regra geral é dada por:

Regra da adição

Suponha que temos objetos de dois tipos, digamos tipo 1 e tipo 2. Suponha que temos n objetos

do tipo 1 e m objetos do tipo 2. Temos então n + m formas de escolher um objeto (de qualquer

tipo) entre os objetos disponíveis.

Outra forma de escrever essa regra é a seguinte: suponha que temos n formas de executar

uma tarefa usando o procedimento 1, e m formas de executar essa mesma tarefa usando o

procedimento 2. Sabendo que não podemos usar os dois procedimentos conjuntamente, esta

tarefa pode ser realizada de n + m formas diferentes.

2.2.3

Permutação

Suponha que temos k objetos organizados em uma determinada ordem. Se mudarmos a ordem em

que estes objetos estão colocados, dizemos que fizemos uma permutação entre esses objetos. Uma

pergunta importante é saber qual o número de permutações possíveis entre estes k objetos. Para

ilustrarmos a ideia considere o seguinte exemplo:

Exemplo 2.7 Exemplo de permutações

Quantas filas diferentes podemos formar com Pedro, Paulo, Carlos e João?

Também poderíamos escrever a pergunta como: Qual o número de permutações possíveis entre

quatro pessoas?

Vamos enumerar as posições: primeira, segunda, terceira e quarta. Para a primeira posição temos

4 escolhas possíveis. Agora, supondo que já escolhemos a primeira posição, qualquer que seja a

primeira pessoa escolhida, temos possibilidades para a segunda posição. Analogamente, temos 2

possibilidades para a terceira posição e apenas uma para a quarta.

Pela regra da multiplicação, temos 4 · 3 · 2 · 1 = 24 possibilidades.

28 / 140

Probabilidade e Estatística

Notação

O número n! é chamado de fatorial de n e é dado por

n! = n · (n − 1) · (n − 2) · · · 3 · 2 · 1.

Por exemplo, 6! = 6 · 5 · 4 · 3 · 2 · 1. No exemplo anterior, o número de possibilidades é 4! = 24.

Finalmente, temos a regra da permutação:

Permutações

Suponha que temos n objetos, então o número de permutações desses n objetos é n!.

2.2.4

Arranjos

Suponha que temos n objetos, de quantas formas podemos escolher k objetos entre esses n objetos,

sabendo que a ordem em que esses objetos são escolhidos importa?

O número de formas é chamado de número de arranjos. Considere o seguinte exemplo:

Exemplo 2.8 Exemplo de arranjos

Suponha que uma corrida de rua tem 1000 atletas inscritos. Quantos pódios podemos formar com

esses 1000 atletas?

Um pódio consiste de três pessoas, ordenadas pelo campeão, vice-campeão e terceiro lugar. Assim,

temos 1000 formas de escolher o campeão, 999 formas de escolher o vice-campeão e 998 formas de

escolher o terceiro lugar. Portanto, temos 1000 · 999 · 998 pódios possíveis.

Note que 1000 · 999 · 998 =

1000!

997! .

Assim, a regra dos arranjos é:

Arranjo

Suponha que temos n objetos disponíveis. Então, o número de formas de escolher k objetos,

onde a ordem em que os objetos foram escolhidos importa, é dada por

An,k =

n!

.

(n − k)!

No exemplo anterior, podemos pensar nas pessoas como 1000 objetos, e queríamos escolher 3 objetos,

onde a ordem importa (a ordem determina o campeão, vice-campeão e terceiro lugar), e portanto o

número de formas é A1000,3 = 1000!

997! .

2.2.5

Combinações

Suponha que estamos no mesmo cenário dos arranjos, ou seja, temos n objetos e queremos escolher

k objetos. Entretanto, suponha que a ordem não importa mais. Assim, só estamos interessados no

número de formas de escolher os k objetos, mas a ordem em particular pela qual os objetos foram

escolhidos não importa. O número de tais formas é dado pelo número de combinações possíveis.

Considere o seguinte exemplo:

29 / 140

Probabilidade e Estatística

Exemplo 2.9 Exemplo de combinações

Suponha que uma empresa possui 1000 funcionários, e que o presidente da empresa gostaria de saber

o número de equipes de 3 pessoas que podem ser formadas com esses 1000 funcionários. Qual o

número que o presidente procura?

Note que este exemplo é muito parecido com o dos arranjos, inclusive temos 1000 “objetos” e

queremos escolher 3. Entretanto o fato da ordem não importar muda tudo.

Como em uma equipe a ordem das pessoas não importa, devemos levar essa informação em

consideração.

Vamos então fingir que a ordem importa, então a quantidade de formas seria A1000,3 = 1000!

997! . Observe

agora que para cada equipe de formada por 3 pessoas, temos 3! pódios possíveis a se formar. Desta

forma, se C é o número de equipes de 3 pessoas que podemos formar com 1000 funcionários, então

3! · C é o número de pódios que podemos formar com 1000 pessoas, pois cada equipe fornece 3!

pódios (aqui utilizamos a regra da multiplicação).

Como sabemos que o número de pódios possíveis é A1000,3 =

1000!

997! ,

segue que C =

A1000,3

3!

=

1000!

3!997! .

Assim, temos a regra geral das combinações:

Combinação

Suponha que temos n objetos e queremos escolher k objetos, onde a ordem em que os objetos

n!

formas de escolher esses k objetos.

foram escolhidos não importa. Então temos Cn,k = k!(n−k)!

Cn,k é chamado o número de combinações de n, k-a-k.

Nota

n!

Este número de combinações possui uma notação especial, a saber, nk = k!(n−k)!

, e são

chamados de coeficientes binomiais.

Cuidado

Observe que em geral o número de arranjos é bem maior que o número de combinações.

De fato, temos que

An,k = k!Cn,k .

Portanto, é importante não confundir arranjos com combinações porque os resultados podem

ser muito diferentes.

2.2.6

Binômio de Newton

Sejam a, b números reais, e seja n um número natural. Então, temos que

(a + b)n = (a + b)(a + b) · · · (a + b) .

|

{z

}

n termos

30 / 140

Probabilidade e Estatística

É fácil saber, pela distributividade, que o resultado da multiplicação será uma soma da forma:

(a + b)n = (a + b) · · · (a + b) = C0 an +C1 an−1 b + · · ·Cn bn .

Assim, queremos determinar quais são os valores de Ci , para i = 0, . . . , n. Observe que Ci é o número de termos da forma an−i bi que aparecem após a expansão do termo (a + b)n . Este número é

dado pelo número de formas em que podemos escolher (n − i) parcelas da multiplicação iguais a a

(automaticamente as i parcelas restantes serão de termos iguais a b). Como a ordem das parcelas não

importa, o número de formas é justamente

o número de combinações de n, (n − i)-a-(n − i), e é dado

n

n!

por Ci = Cn,(n−i) = (n−i)!i! = Cn,i = i .

Portanto, temos a fórmula do binômio de Newton:

n n n

n n−i i

n n

n n−i i

n

(a + b) =

a +···+

a b +···+

b =∑

a b.

0

i

n

i=0 i

2.3

Atividades

1. Verdadeiro ou Falso?

a.

{a, a, b, c} = {a, b, c};

b.

{a, {a}} = {a};

c.

{a} ∈ {a, {a}};

d.

{a} ⊂ {a, {a}};

e.

{{a}} ⊂ {a, {a}};

f.

{a, b} ⊂ {a, {a, b}};

g.

{a, b} ∈ {a, {a, b}};

h.

b ∈ {a, {a, b}};

i.

0/ ∈ {0};

/

j.

0/ = {0};

/

k.

0/ ⊂ {0};

/

l.

{0}

/ ⊂ {{0}};

/

m.

{0}

/ ∈ {{0}};

/

n.

{0}

/ = {{0}}.

/

2. Sejam A = {1, 2, 3, 4, {5}, {6, 7}}, B = {4, {5}, 6, 7} e C = {5, 6, 7}. Determine os seguintes conjuntos:

a.

A \ 0;

/

b.

A \ A;

31 / 140

Probabilidade e Estatística

c.

A \C;

d.

C \ A;

e.

A \ B;

f.

B \ A;

g.

B \C.

3. Seja M = {1, 2, 3, 4, {1}, {2}, {3}, {4}}. Sejam A = {1, {2}, 3, {4}} e B = {{1}, 2, {3}, 4}.

a. Mostre que A e B são subconjuntos de M, e conclua que podemos falar sobre o complementar

de A e sobre o complementar de B (ambos com relação a M);

4.

b.

Determine os conjuntos: Ac , Bc , A ∪ Bc , Ac ∪ B, Ac ∪ Bc , A ∪ B, A ∪ Ac e B ∪ Bc .

c.

Determine os conjuntos: A ∩ B, Ac ∩ B, Ac ∩ Bc , A ∩ Bc , A ∩ Ac e B ∩ Bc .

Quantas palavras contendo 3 letras diferentes podem ser formadas com um alfabeto de 26 letras?

5. Para fazer uma viagem João Pessoa-Salvador-João Pessoa, posso ir de carro, ônibus ou avião. De

quantos modos posso escolher os transportes se não desejo usar na volta o mesmo meio de transporte

da ída?

6.

Quantos são os gabaritos possíveis de um teste de 10 questões de múltipla escolha, com cinco

alternativas por questão?

7.

De quantos modos 3 pessoas podem sentar-se em 5 cadeiras em fila?

8.

O departamento de computação científica de uma universidade possui 20 professores. De

quantos modos podem ser escolhidos um chefe de departamento, um coordenador da gradução e um

coordenador de pós-graduação?

9.

Quantos são os anagramas da palavra CAPÍTULO?

10. Quantos são os anagramas da palavra CAPÍTULO que têm a letra C no primeiro lugar E a letra

A no segundo lugar E a letra P no terceiro lugar?

11.

João tem 10 frutas diferentes e deseja fazer vários tipos de saladas de frutas, onde cada salada

contém exatamente 4 frutas. Quantos tipos de saladas de frutas ele pode fazer?

12. Em uma prova, o estudante deve escolher exatamente 7 questões entre 10 disponíveis. Quantas

escolhas ele tem?

13.

De quantos modos podemos escolher 6 pessoas, incluindo pelo menos duas mulheres, em um

grupo de 7 homens e 4 mulheres?

Feedback sobre o capítulo

Você pode contribuir para melhoria dos nossos livros. Encontrou algum erro? Gostaria de

submeter uma sugestão ou crítica?

Para compreender melhor como feedbacks funcionam consulte o guia do curso.

32 / 140

Probabilidade e Estatística

Capítulo 3

Definições Básicas

O BJETIVOS DO CAPÍTULO

Ao final deste capítulo você deverá ser capaz de:

• As principais definições da probabilidade

• Reconhecer um modelo com resultados equiprováveis e modelos com resultados que

não são equiprováveis

• Entender e saber aplicar o conceito de probabilidade condicional

• Saber enunciar e aplicar o teorema da probabilidade total e o teorema de Bayes

• Saber a definição e intuição de eventos independentes

Modelos Matemáticos

• Modelo Determinístico: Um modelo no qual as condições impostas ao modelo determinam

o resultado do experimento.

• Modelo Probabilístico: Modelos nos quais, mesmo mantendo as mesmas condições, o resultado do experimento pode variar. Isso se deve a um fator aleatório o qual não podemos

controlar.

Experimento aleatório

Consiste em um experimento em que, mesmo mantendo as mesmas condições, o resultado do

experimento pode variar.

Exemplo 3.1 Exemplos de experimentos aleatórios

1. Lançar um dado e observar o resultado.

2. Jogar três moedas e contar o número de vezes que o resultado foi cara.

3. Medir o número de nascimentos na cidade de João Pessoa na última hora.

33 / 140

Probabilidade e Estatística

3.1

Fundamentos de Probabilidade

Definição: Espaço amostral

Espaço amostral é o conjunto de todos os resultados possíveis de um experimento. Denotamos

o conjunto de todos os resultados por Ω.

Exemplo 3.2 Espaços amostrais associados aos exemplos anteriores

1. Ω = {1, 2, 3, 4, 5, 6};

2. Ω = {0, 1, 2, 3};

3. Ω = {0, 1, 2, 3, . . .}, Ω = {0, 1, 2, ..., 7000000000}, . . ..

Nota

Observe que no último exemplo tivemos mais de uma opção de espaço amostral. Isto não

contradiz a definição de espaço amostral. De fato, podemos ter mais de uma opção de espaços amostrais, o importante é que cada uma dessas opções contenha todos os resultados

possíveis.

Definição: Evento

Seja Ω o espaço amostral de um experimento. Todo conjunto A ⊂ Ω tal que podemos calcular

a probabilidade de A é chamado de evento.

Destacamos dois eventos importantes:

1. Ω é chamado de evento certo;

2. 0/ é chamado de evento impossível.

Nota

O conjunto de todos os eventos possui uma estrutura chamada de σ -álgebra. Apesar da

definição de σ -álgebra ser muito simples, não há necessidade de estudarmos σ -álgebras,

pois todos os conjuntos que utilizaremos ao longo do livro serão eventos. Além disso, as

aplicações onde é realmente necessário o uso de σ -álgebras fogem do escopo deste livro.

Como cada evento é um conjunto, vale a pena descrever os eventos obtidos após realizarmos as

operações clássicas de conjuntos entre eventos.

34 / 140

Probabilidade e Estatística

Exemplo 3.3 Eventos

• A ∪ B: é o evento “A ou B”;

• A ∩ B: é o evento “A e B”;