4

CAPÍTULO 2. ÁLGEBRA DE MATRIZES.

2.1. MATRIZES E VETORES

2.1.1. Matrizes, vetores e escalares.

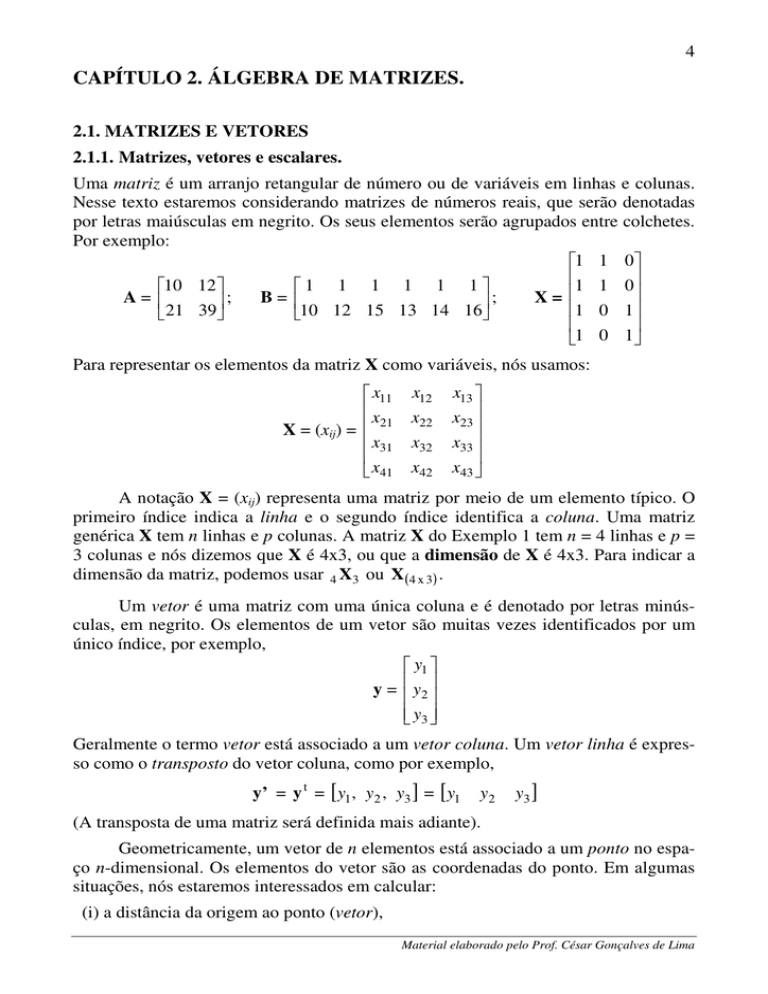

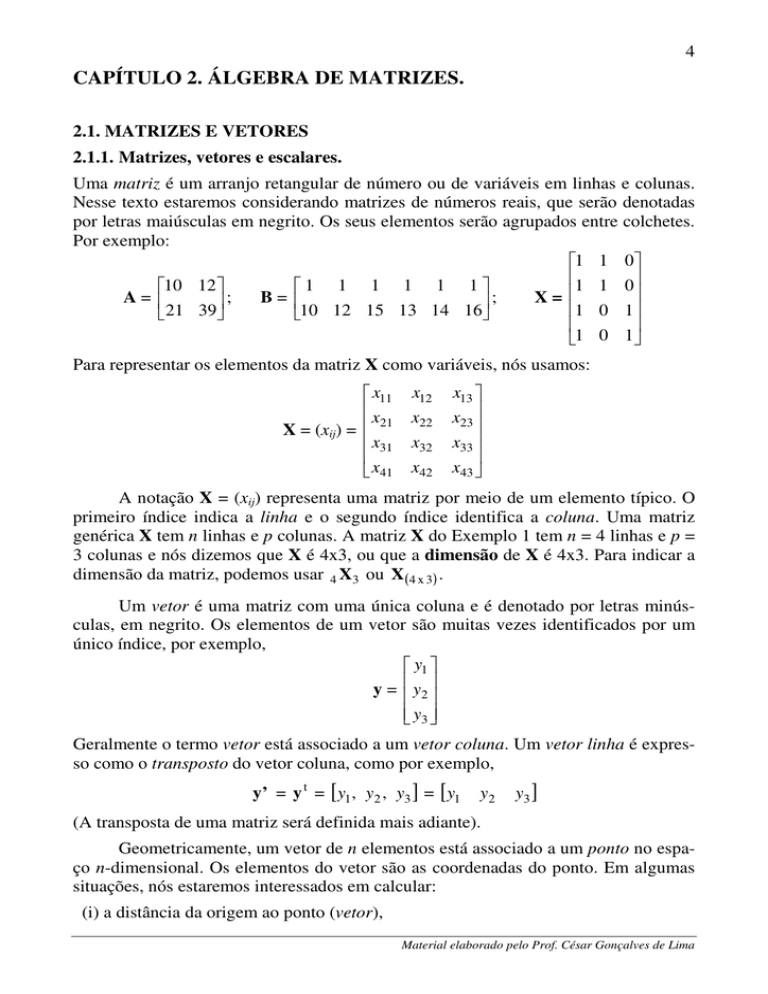

Uma matriz é um arranjo retangular de número ou de variáveis em linhas e colunas.

Nesse texto estaremos considerando matrizes de números reais, que serão denotadas

por letras maiúsculas em negrito. Os seus elementos serão agrupados entre colchetes.

Por exemplo:

1 1 0

1 1 0

10 12

1 1 1 1 1 1

A=

B=

X=

;

;

21

39

10

12

15

13

14

16

1

0

1

1 0 1

Para representar os elementos da matriz X como variáveis, nós usamos:

x11

x

X = (xij) = 21

x31

x41

x12

x22

x32

x42

x13

x23

x33

x43

A notação X = (xij) representa uma matriz por meio de um elemento típico. O

primeiro índice indica a linha e o segundo índice identifica a coluna. Uma matriz

genérica X tem n linhas e p colunas. A matriz X do Exemplo 1 tem n = 4 linhas e p =

3 colunas e nós dizemos que X é 4x3, ou que a dimensão de X é 4x3. Para indicar a

dimensão da matriz, podemos usar 4 X3 ou X (4 x 3) .

Um vetor é uma matriz com uma única coluna e é denotado por letras minúsculas, em negrito. Os elementos de um vetor são muitas vezes identificados por um

único índice, por exemplo,

y1

y = y2

y3

Geralmente o termo vetor está associado a um vetor coluna. Um vetor linha é expresso como o transposto do vetor coluna, como por exemplo,

y’ = y t = [ y1 , y2 , y3 ] = [ y1

y2

y3 ]

(A transposta de uma matriz será definida mais adiante).

Geometricamente, um vetor de n elementos está associado a um ponto no espaço n-dimensional. Os elementos do vetor são as coordenadas do ponto. Em algumas

situações, nós estaremos interessados em calcular:

(i) a distância da origem ao ponto (vetor),

Material elaborado pelo Prof. César Gonçalves de Lima

5

(ii) a distância (d) entre dois pontos (vetores), ou

(iii) o ângulo (θ) entre as linhas formadas da origem até os dois pontos.

No contexto de matrizes e vetores, um número real é chamado de um escalar.

Assim, os números 2,5, -9 e 3,14 são escalares. Uma variável representando um escalar será denotada por uma letra minúscula e sem negrito. Por exemplo: c = 3,14 indica um escalar.

2.1.2. Igualdade de Matrizes

Duas matrizes (ou dois vetores) são iguais se têm a mesma dimensão e se os elementos de posições correspondentes são iguais. Por exemplo:

3 − 2 4 3 − 2 4

=

1

3 7 1

3 7

mas

2 − 9 5

3 − 9

5

≠

8 − 4

6 8 − 4

6

2.1.3. Matriz Transposta

Se nós trocarmos de posição as linhas e as colunas de uma matriz A, a matriz resultante é conhecida como a transposta de A e é denotada por A’ ou A t . Formalmente,

se nAp = (aij) então a sua transposta é dada por:

t

(2.3)

p A'n = A = (aij)’ = (aji)

3 − 2 4

Por exemplo: Se A =

⇒ A’ =

3 7

1

3 1

− 2 3 é a sua transposta.

4 7

A notação (aji) indica que o elemento da i-ésima linha e j-ésima coluna de A é encontrado na j-ésima linha e i-ésima coluna de A’. Se A é nxp então A’ é pxn.

Teorema 2.1.A. Se A é uma matriz qualquer, então

(A’)’ = A

(2.4)

Material elaborado pelo Prof. César Gonçalves de Lima

6

2.1.4 Alguns tipos especiais de matrizes

Se a transposta de uma matriz A é a mesma da matriz original, isto é, se A’ = A ou,

equivalentemente, (aji) = (aij), então dizemos que a matriz A é simétrica. Por exemplo,

2

6

3

A = 2 10 − 7

6 − 7

9

é simétrica. É evidente que toda matriz simétrica é quadrada.

A diagonal de uma matriz quadrada pAp= (aij) consiste dos elementos a11, a22,

…, app, ou seja, diag(A) = (aii). No exemplo anterior, a diagonal da matriz A é formada pelos elementos 3, 10 e 9.

Se a matriz nAn contém zeros em todas as posições fora da diagonal ela é uma

matriz diagonal, como por exemplo,

0 0

8

0 −3 0

D=

0

0 0

0

0 0

0

0

0

4

que também pode ser denotada como

D = diag(8, –3, 0, 4)

Nós usamos a notação diag(A) para indicar a matriz diagonal com os mesmos elementos da diagonal de A, como por exemplo,

2

6

3

A = 2 10 − 7

6 − 7

9

⇒

3 0 0

diag(A) = 0 10 0

0 0 9

Uma matriz diagonal com o número 1 em cada posição da sua diagonal é chamada de matriz identidade e é denotada por I, como por exemplo,

1 0 0

I(3) = diag(1, 1, 1) = 0 1 0

0 0 1

Material elaborado pelo Prof. César Gonçalves de Lima

7

Uma matriz triangular superior é uma matriz quadrada com zeros abaixo da

diagonal, como por exemplo,

7

0

T=

0

0

2 3 − 5

0 −2 6

0 4

1

0 0

8

Um vetor de 1’s é denotado por j:

1

1

j=

M

1

Uma matriz quadrada de 1’s é denotada por J, como por exemplo,

1 1 1

J(3x3) = 1 1 1

1 1 1

Nós denotamos um vetor de zeros por 0 e uma matriz de zeros por Ο ou Φ ,

por exemplo,

0

0 = 0 ,

0

0 0 0

Ο = Φ = 0 0 0 .

0 0 0

2.2. OPERAÇÕES COM MATRIZES

2.2.1 Adição de duas matrizes

Se duas matrizes têm a mesma dimensão, sua soma é encontrada adicionando os elementos correspondentes. Assim, se A(nxp) e B(nxp), então C = A + B também é nxp e é

encontrada como C = (cij) = (aij + bij). Por exemplo,

4 11 5 − 6 18 2 − 2

7 − 3

+

=

2

8 − 5 3 4

2 5 12 − 3

Material elaborado pelo Prof. César Gonçalves de Lima

8

A diferença D = A – B entre as matrizes A e B é definida similarmente: D = (dij) =

(aij – bij). Duas propriedades importantes da adição de matrizes são dadas a seguir:

Teorema 2.2A. Se A e B são nxp, então:

(i) A + B = B + A

(2.9)

(ii) (A + B)’ = A’ + B’

(2.10)

2.2.2 Produto de duas matrizes

Para que o produto AB de duas matrizes seja possível, o número de colunas da matriz

A deve ser igual ao número de linhas de B. Neste caso, dizemos que as matrizes A e

B são conformes. Então, o (ij)-ésimo elemento do produto C = AB é definido como:

cij =

∑ aik bkj

(2.11)

k

que é igual à soma dos produtos dos elementos da i-ésima linha de A pelos elementos

da j-ésima coluna de B. Assim, nós multiplicamos todas as linhas de A por todas as

colunas de B. Se A é (nxm) e B é (mxp) então C = AB é (nxp). Por exemplo,

2 1 3

A(2x3) =

e B(3x2) =

4

6

5

1 4

2 6

3 8

Então

2AB2

(2)(1) + (1)(2) + (3)(3) (2)(4) + (1)(6) + (3)(8) 13 38

= 2C2 =

=

(4)(1) + (6)(2) + (5)(3) (4)(4) + (6)(6) + (5)(8) 31 92

18 25 23

3BA3 = 3D3 = 28 38 36

38 51 49

Se A é nxm e B é mxp, onde n ≠ p, então o produto AB é definido, mas BA não

é definido. Se A é nxp e B é pxn, então AB é nxn e BA é pxp. Neste caso, certamente, AB ≠ BA, como ilustrado no exemplo anterior. Se A e B são nxn então AB e BA

têm o mesmo tamanho, mas, em geral:

AB ≠ BA

(2.12)

A matriz identidade I(n) é o elemento neutro da multiplicação de matrizes. Isto

quer dizer que, se A é n x n então AI = IA = A.

A multiplicação de matrizes não é comutativa e algumas manipulações familiares com números reais não podem ser feitas com matrizes. Entretanto, a multiplicação

de matrizes é distributiva em relação à soma ou subtração:

Material elaborado pelo Prof. César Gonçalves de Lima

9

A(B ± C) = AB ± AC

(2.13)

(A ± B)C = AC ± BC

(2.14)

Usando (2.13) e (2.14) nós podemos expandir produtos como (A – B)(C – D):

(A – B)(C – D) = (A – B)C – (A – B)D

= AC – BC – AD + BD

(2.15)

A multiplicação envolvendo vetores segue as mesmas regras das matrizes. Suponha A(nxp), b(px1), c(px1) e d(nx1). Então:

•

Ab é um vetor coluna nx1

•

d’A é um vetor linha de dimensão 1xp

•

b’c é um escalar correspondendo à soma de produtos

•

bc’ é uma matriz pxp

•

cd’ é uma matriz pxn

Desde que b’c é uma soma de produtos (um escalar!) tem-se que b’c = c’b:

b’c = b1c1 + b2c2 + … + bpcp

c’b = c1b1 + c2b2 + … + cpbp

⇒ b’c = c’b

(2.16)

A matriz cd’ é dada por

c1

c

2

cd’ = [d1 d2 … dn] =

M

c p

c1d1 c1d 2

c d c d

2 2

2 1

M

M

c p d 1 c p d 2

L c1d n

L c2 d n

O

M

L c pdn

(2.17)

Similarmente:

b1

b

2

b’b = [b1 b2 … bp] = b12 + b22 + … + b 2p =

M

b p

b1

b

2

bb’ = [b1 b2 … bp] =

M

b p

b12 b1b2

2

b2b1 b2

M

M

b p b1 b p b2

p

∑ bi2

(2.18)

i =1

L b1b p

L b2b p

O

M

L b 2p

(2.19)

Assim, b’b é uma soma de quadrados e bb’ é uma matriz quadrada e simétrica.

Material elaborado pelo Prof. César Gonçalves de Lima

10

A raiz quadrada da soma de quadrados dos elementos de um vetor bpx1 é igual à

distância da origem ao ponto b e é referida como norma euclidiana, ou comprimento

do vetor b:

p

comprimento de b = || b || =

b' b =

∑ bi2

(2.20)

i =1

Se j é um vetor nx1 de 1’s como definido em (2.6), então por (2.18) e (2.19),

nós temos que:

j’j = n,

1

1

jj’ =

M

1

1 L 1

1 L 1

= J(nxn)

M O M

1 L 1

(2.21)

onde Jnxn é uma matriz quadrada de 1’s como ilustrada em (2.7), Se a é um vetor nx1

e A é uma matriz nxp, então

a’j = j’a =

n

∑ ai

(2.22)

i =1

j’A =

[∑i ai1 ∑i ai 2

L

∑i aip ]

∑ j a1 j

a

∑

j 2j

e Aj =

M

∑ j anj

(2.23)

Assim, a’j = j’a é a soma dos elementos em a, j’A contem as somas das colunas de A

e Aj contem as somas das linhas de A. Note que em a’j, o vetor j é nx1; em j’A, o

vetor j é nx1 e em Aj, o vetor j é px1.

1 − 2 3 4

Exemplo: Seja a matriz A = 5

1 6 4 e o vetor a =

2

5 4 0

1 − 2 3 4

i) j'A = [1 1 1] 5

1 6 4 = [8 4 13 8]

2

5 4 0

1

1 − 2 3 4 6

1

ii) Aj = 5

1 6 4 = 16

1

2

5 4 0 11

1

2

5

então:

1

8

(totais das colunas de A)

(totais das linhas de A)

Material elaborado pelo Prof. César Gonçalves de Lima

11

1

2

1

5

iii) a’j = [2 5 1 8]

= j’a = [1 1 1 1] = 16 (total dos elementos de a)

1

1

1

8

O produto de um escalar por uma matriz é obtido multiplicando-se cada elemento da matriz pelo escalar:

ca11 ca12

ca

ca22

cA = (caij) = 21

M

M

can1 can 2

L ca1m

L ca2m

.

O

M

L canm

(2.24)

Desde que caij = aijc o produto de um escalar por uma matriz é comutativo:

cA = Ac

(2.25)

A transposta do produto de duas matrizes é igual ao produto das transpostas

em ordem reversa.

Teorema 2.2B. Se A é nxp e B é pxm, então:

(AB)’ = B’A’

(2.26)

p

Prova: Seja C = AB. Então por (2.11), temos que C = (cij) = ∑ aik bkj

k =1

Por (2.3), a transposta de C = AB é dada por:

(AB)’ = C’ = (cij)’ = (cji)

p

p

= ∑ a jk bki = ∑ bki a jk = B’A’.

k =1

k =1

Para ilustrar os passos dessa prova, vamos usar as matrizes A2x3 e B3x2:

a

a

AB = 11 12

a21 a22

a13

a23

b11 b12

b

b

21 22

b31 b32

a11b12 + a12b22 + a13b32

a b + a b + a b

= 11 11 12 21 13 31

a21b11 + a22b21 + a23b31 a21b12 + a22b22 + a23b32

Material elaborado pelo Prof. César Gonçalves de Lima

12

a b + a b + a b

(AB)’ = 11 11 12 21 13 31

a11b12 + a12b22 + a13b32

a21b11 + a22b21 + a23b31

a21b12 + a22b22 + a23b32

b11a21 + b21a22 + b31a23

b a + b a + b a

= 11 11 21 12 31 13

b12 a11 + b22 a12 + b32 a13 b12 a21 + b22 a22 + b32 a23

a11

b11 b21 b31

⇒ (AB)’ =

a12

b12 b22 b32 a

13

a21

a22 = B’A’

a23

Corolário 1. Se A, B e C são conformes, então (ABC)’ = C’B’A’.

Exemplo: Seja y = [y1, y2, …, yn]’ um vetor de pesos de n frangos de corte.

Para calcularmos a média e a variância dos pesos desses frangos, nós usamos:

1 n

1 n

y = ∑ yi

s2 =

( yi − y )2

∑

n i =1

n − 1 i =1

1

Matricialmente, a média pode ser calculada por y = j’y, onde j é um vetor nx1 de

n

1’s e n = j’j. Para calcularmos a variância precisamos, primeiramente, calcular o

vetor de desvios:

1

1

1

1

y – y = y – y j = y – j j’y = y – jj’y = y – Jy = I − J y

n

n

n

n

Onde I é a matriz identidade nxn e J é uma matriz nxn de 1’s. Para calcularmos a

soma de quadrados de desvios fazemos:

n

2

∑ ( yi − y )

i =1

1

= I − J y

n

t

1

I − J y

n

t

1

1

1

1 1

= y’ I − J I − J y = y’ I' I − IJ – J' I + 2 J' J y

n n

n

n

n

Mas J = J’, I’I = I, IJ = J; J’I = J’ = J e j’j = n, então:

n

∑ ( yi − y )2

i =1

1

1

2

2

= y’ I − J + 2 jj' jj' y = y’ I − J + 2 j(n) j' y

n

n

n

n

1

2

1

= y’ I − J + J y = y’ I − J y

n

n

n

Então, a variância pode ser calculada por:

s2 =

1 n

( yi − y )2 = 1 y' I − 1 J y

∑

n − 1 i =1

n −1

n

Material elaborado pelo Prof. César Gonçalves de Lima

13

Supondo que A é nxm e B é mxp, seja a ti a i-ésima linha da matriz A e bj, a jésima coluna da matriz B, de tal forma que:

a11

a

A = 21

M

a n1

a12

a 22

M

an 2

L a1m a1t

L a 2 m a t2

=

, B=

O M M

L a nm a tn

b11 b12

b

b22

21

M

M

bm1 bm 2

L b1 p

L b2 p

= [b1, b2, …, bp]

O M

L bmp

Então, por definição, o (ij)-ésimo elemento de AB é a ti bj:

a1t b1 a1t b 2

t

a 2b1 at2b 2

AB =

M

M

t

t

a nb1 a nb 2

L a1t b p

L a t2b p

O

M

L a tnb p

a1t (b1 , b 2 , L, b p )

t

a

(

b

,

b

,

L

,

b

)

p

= 2 1 2

=

M

t

a n (b1 , b 2 , L , b p )

a1t B a1t

t t

a 2 B = a 2 B

M M

t t

a n B a n

(2.27)

A primeira coluna de AB pode ser expressa em termos de A como

a1t b1 a1t

t t

a 2b1 = a 2 b1 = Ab1

M M

t t

a nb1 a n

De forma análoga, a segunda coluna de AB é Ab2 e assim por diante. Assim AB pode

ser escrita em termos das colunas de B:

AB = A[b1, b2, …, bp] = [Ab1, Ab2, …, Abp]

(2.28)

Qualquer matriz A pode ser multiplicada pela sua transposta para formar A’A

ou AA’. Algumas propriedades desses produtos são dadas no próximo Teorema.

Teorema 2.2C. Seja A uma matriz nxp. Então A’A e AA’ têm as seguintes propriedades:

(i) A’A é pxp e é obtida como produto das colunas de A.

(ii) AA’ é nxn e é obtida como produto das linhas de A.

(iii) Ambas as matrizes A’A e AA’ são simétricas.

(iv) Se A’A = Φ então A = Φ.

Material elaborado pelo Prof. César Gonçalves de Lima

14

Seja A uma matriz quadrada n x n e D = diag(d1, d2, … , dn). No produto DA, a

i-ésima linha de A é multiplicada por di e em AD, a j-ésima coluna de A é multiplicada por dj. Por exemplo, se n = 3, nós temos:

DA

d1 0

= 0 d2

0 0

0 a11 a12

0 a21 a22

d 3 a31 a32

AD

a11 a12

= a21 a22

a31 a32

a13

a23

a33

a13

a23 =

a33

d1 0

0 d

2

0 0

d1a11 d1a12

d a

d 2 a22

2 21

d 3a31 d 3a32

d1a13

d 2 a23

d 3a33

(2.29)

0 d1a11 d 2 a12

0 = d1a21 d 2 a22

d 3 d1a31 d 2 a32

d 3a13

d 3a23

d 3a33

(2.30)

d12 a11 d1d 2 a12

DAD = d 2 d1a21 d 22 a22

d d a

3 1 31 d 3d 2 a32

d1d 3a13

d 2 d 3a23

d 32 a33

(2.31)

Vale notar que DA ≠ AD. Entretanto, no caso especial onde a matriz diagonal é

a matriz identidade, (2.29) e (2.30) temos:

IA = AI = A

(2.32)

Se A é retangular, (2.32) continua valendo, mas as duas identidades são de dimensões diferentes.

Se A é uma matriz simétrica e y é um vetor, o produto:

y’Ay =

∑ aii yi2

+ 2 ∑ aij yi y j

(2.33)

i≠ j

i

é chamado de forma quadrática. Se x é nx1, y é px1 e A é nxp, o produto:

x’Ay =

∑ aij xi y j

(2.34)

ij

é chamado de forma bilinear.

2.2.3. Soma Direta

Dadas as matrizes A(mxn) e B(rxs) definimos a sua soma direta como

A 0

A⊕B=

= C(m+r,n+s)

0

B

Material elaborado pelo Prof. César Gonçalves de Lima

15

Algumas propriedades da soma direta de matrizes:

(i) A ⊕ (–A) ≠ Φ

(ii) Se as dimensões são favoráveis, então:

(A ⊕ B) + (C ⊕ D) = (A + C) ⊕ (B + D)

(A ⊕ B)(C ⊕ D) = AC ⊕ BD

Exemplo: Sejam as matrizes

3 5

A = [10 11 15] , B =

, C = [− 10 − 11 − 15]

4

−

1

Então,

10 11 15 0 0

A ⊕ B = 0 0 0 3 5

0 0 0 4 − 1

0

0

0

10 11 15

A⊕C=

≠Φ

0 0 0 − 10 − 11 − 15

(Perceba que A+C = Φ)

2.2.4. Produto direto ou de Kronecker

Dadas as matrizes A(mxn) e B(rxs) definimos o produto direto ou produto de Kronecker

de A por B como a matriz C(mr x ns) de tal forma que:

a11B a12B

a B a B

22

C(mr x ns) = A ⊗ B = 21

M

M

am1B am 2B

L a1 n B

L a2 n B

O

M

L amn B

Algumas propriedades interessantes do produto direto de matrizes:

(i) A ⊗ B ≠ B ⊗ A , em geral

(ii) Se u e v são vetores, então u’ ⊗ v = v ⊗ u’ = vu’.

(iii) Se D(n) é uma matriz diagonal e A é uma matriz qualquer, então:

D ⊗ A = d11A ⊕ d22A ⊕ … ⊕ dnnA

(iv) Se as dimensões são favoráveis

(A ⊗ B)(C ⊗ D) = AC ⊗ BD

Material elaborado pelo Prof. César Gonçalves de Lima

16

Exemplo: Sejam as matrizes:

1 2

A(2x2) =

,

3 4

0

1 1

B(2x3) =

,

3 5 − 6

1

y(3x1) = − 1 .

0

Então

0 2 2

0

1 1

3 5 − 6 6 10 − 12

,

A⊗B=

3 3

0 4 4

0

9 15 − 18 12 20 − 24

2

1

− 1 − 2

0

0

A⊗y=

4

3

− 3 − 4

0

0

0

0

1 2 1 2

3 4 3 4

0

0

B⊗A=

3 6 5 10 − 6 − 12

9 12 15 20 − 18 − 24

2

1

3

4

− 1 − 2

y⊗A=

− 3 − 4

0

0

0

0

2.2.5 Potência de matriz quadrada

Dada uma matriz quadrada A e um número k ∈ Z (conjunto dos números inteiros e

positivos), definimos a k-ésima potência da matriz A como:

A k = AAA

A

142L

43

k vezes

Em relação à sua segunda potência, uma matriz quadrada A, será chamada de:

(i) idempotente, se A 2 = A.

(ii) nilpotente, se A 2 = Φ.

(iii) unipotente, se A 2 = I.

Teorema. Se P(n) é uma matriz idempotente e se I(n) é a matriz identidade de ordem n,

então a matriz I – P é idempotente.

Material elaborado pelo Prof. César Gonçalves de Lima

17

2.3. MATRIZES PARTICIONADAS

Muitas vezes é conveniente particionar uma matriz em submatrizes. Por exemplo,

uma partição de uma matriz A em quatro submatrizes (quadradas ou retangulares) de

dimensões apropriadas, pode ser indicada simbolicamente como:

A

A = 11

A 21

A12

A 22

Para ilustrar, seja a matriz A(4x5) particionada como:

7

− 3

A=

9

3

2 5 8

4 0 2

4

7

A

= 11

A

3 6 5 − 2

21

1 2 1

6

A12

A 22

Onde:

7 2 5

8 4

9 3 6

A11 =

,

A

=

,

A

=

12

21

2 7

3 1 2 e A22 =

− 3 4 0

5 − 2

1

6

Se duas matrizes A e B são conformes, e se A e B são particionadas de tal forma que as submatrizes sejam apropriadamente conformes, então o produto AB pode

ser encontrado usando a maneira usual de multiplicação (linha-por-coluna) tendo as

submatrizes como se fossem elementos únicos; por exemplo:

A

AB = 11

A 21

A12 B11 B12

A 22 B 21 B 22

A B + A12B 21

= 11 11

A 21B11 + A 22B 21

A11B12 + A12B 22

A 21B12 + A 22B 22

(2.35)

Se B é trocada por um vetor b particionado em dois conjuntos de elementos e

se A é correspondentemente particionada em dois conjuntos de colunas, então (2.35)

fica:

b

Ab = [A1, A2] 1 = A1b1 + A2b2

(2.36)

b 2

Onde o número de colunas de A1 é igual ao número de elementos de b1 e A2 e b2 são

similarmente conformes.

A multiplicação particionada em (2.36) pode ser estendida para colunas individuais de A e elementos individuais de b:

Material elaborado pelo Prof. César Gonçalves de Lima

18

b1

b

2

Ab = [a1, a2, …, ap] = b1a1 + b2a2 + … + bpap

M

b p

(2.37)

Assim, Ab pode ser expressa como uma combinação linear de colunas de A, na qual

os coeficientes são os elementos de b. Nós ilustramos (2.37) no seguinte exemplo:

Exemplo 2.3. Sejam:

6 − 2 3

A = 2

1 0 , b =

4

3 2

4

2

−1

⇒

17

Ab = 10

20

Usando uma combinação linear de colunas de A como em (2.37), nós obtemos:

Ab = b1a1 + b2a2 + b3a3

6

− 2

3 24 − 4 3 17

= 4 2 + 2 1 + (–1) 0 = 8 + 2 – 0 = 10

4

3

2 16 6 2 20

Por (2.28) e (2.29), as colunas do produto AB são combinações lineares das colunas de A. Os coeficientes para a j-ésima coluna de AB são os elementos da j-ésima

coluna de B.

O produto de um vetor linha por uma matriz, a’B, pode ser expresso como uma

combinação linear das linhas de B, na qual os coeficientes são os elementos de a’:

b1t

t

b

a’B = [a1, a2, …, an] 2 = a1 b1t + a2 b t2 + … + an b tn

M

t

b n

(2.38)

Por (2.27) e (2.38), as linhas do produto AB são combinações lineares das linhas de

B. Os coeficientes da i-ésima linha de AB são os elementos da i-ésima linha de A.

Finalmente, notamos que se uma matriz A é particionada como A = [A1, A2], então:

A1t

A’ = [A1, A2]’ = t

A 2

(2.39)

Material elaborado pelo Prof. César Gonçalves de Lima

19

2.4 POSTO (RANK) DE UMA MATRIZ

Antes de definirmos o posto (ou rank) de uma matriz, nós introduziremos a noção de

independência linear e dependência. Um conjunto de vetores {a1, a2, …, ap} é dito

linearmente dependente (l.d.) se pudermos encontrar um conjunto de escalares c1, c2,

…, cp (nem todos nulos) de tal forma que:

c1a1 + c2a2 + … + cpap = 0

(2.40)

Se não encontrarmos um conjunto de escalares c1, c2, …, cp (nem todos nulos) que satisfaçam (2.40), o conjunto de vetores {a1, a2, …, ap} é dito linearmente independente

(l.i.). Por (2.37), podemos reescrever essa definição da seguinte forma:

“As colunas de A são linearmente independentes se Ac = 0 implica em c = 0”.

Observe que se um conjunto de vetores inclui um vetor nulo, o conjunto de vetores é

linearmente dependente.

Se (2.40) é satisfeita, então existe pelo menos um vetor ai que pode ser expresso como uma combinação linear dos outros vetores do conjunto. Entre vetores linearmente independentes não existem redundâncias desse tipo.

Definição: O posto (rank) de qualquer matriz A (quadrada ou retangular) é definido

como o número de colunas (linhas) linearmente independentes de A

Pode-se mostrar que o número de colunas l.i. de qualquer matriz é igual ao número de

linhas l.i. dessa matriz.

Se a matriz A tem um único elemento diferente de zero, com todos os demais

elementos iguais a zero, então rank(A) = 1. O vetor 0 e a matriz Φ têm posto zero.

Se a matriz retangular A(nxp) de posto p, onde p < n, então A tem o maior posto

possível e é dito ter posto coluna completo.

Em geral, o maior posto possível de uma matriz A(nxp) é o min(n, p). Assim, em

uma matriz retangular, as linhas, as colunas ou ambas são linearmente dependentes.

Nós ilustramos esse fato no próximo exemplo.

Exemplo 2.4(a). A matriz

1 − 2 3

A=

2 4

5

tem posto 2, porque as duas linhas são linearmente independentes, pois nenhuma

linha é múltipla da outra. Conseqüentemente, pela definição de posto, o número de

colunas l.i. também é 2. Portanto, as três colunas de A são l.d. e por (2.40) existem

constantes c1, c2 e c3 (nem todas nulas) tais que:

Material elaborado pelo Prof. César Gonçalves de Lima

20

1

− 2

3 0

c1 + c2 + c3 =

5

2

4 0

(2.41)

Por (2.37) nós escrevemos (2.41) na forma

c1

1 − 2 3 0

c2 =

ou Ac = 0

5

2 4 0

c3

(2.42)

14

A solução (não trivial) para (2.42) é dada por qualquer múltiplo de c = − 11 . Neste

− 12

caso o produto Ac = 0, mesmo com A ≠ 0 e c ≠ 0. Isso só é possível por causa da dependência linear dos vetores-colunas de A.

Nem sempre é fácil perceber que uma linha (ou coluna) é uma combinação linear de outras linhas (ou colunas). Nesses casos pode ser difícil “calcular” o posto de

uma matriz. Entretanto, se conseguirmos obter a forma escalonada canônica (f.e.c.)

da matriz, o seu posto corresponderá ao número de linhas (ou colunas) que tenham o

número 1 como líder. A obtenção da f.e.c. de uma matriz é feita através de operações

elementares em suas linhas (ou colunas).

Definição: São chamadas de operações elementares nas linhas da matriz A (e de

modo similar nas suas colunas):

(i) trocar a posição de duas linhas da matriz.

(ii) multiplicar uma linha da matriz por um escalar k ≠ 0 (li = kli).

(iii) somar a uma linha da matriz um múltiplo de outra linha (li = li + klj).

Teorema: Uma matriz A é equivalente por linhas a uma matriz B se B pode ser obtida de A aplicando-se uma seqüência de operações elementares sobre as suas linhas.

Definição: Dizemos que uma matriz A(nxm) está na sua forma escalonada canônica ou

reduzida se ocorrer simultaneamente que:

(a) o primeiro elemento não nulo de cada linha não nula é o número 1 (pivô);

(b) toda coluna que tem um pivô, tem todos os outros elementos nulos;

(c) o pivô da linha i +1 ocorre à direita do pivô da linha i (i = 1, 2, …, n–1).

(d) todas as linhas nulas (formadas inteiramente por zeros) ocorrem abaixo das

linhas não nulas.

Material elaborado pelo Prof. César Gonçalves de Lima

21

Definição: Dizemos que uma matriz está na forma escalonada se ela satisfaz as propriedades (c) e (d), mas não necessariamente as propriedades (a) e (b).

Das matrizes apresentadas a seguir, B não está na forma escalonada, A e C estão nas suas formas escalonadas canônicas e D, na forma escalonada.

1 0 0

A = 0 1 0 , B =

0 0 0

1

0

0

0

0 0 0

0 0 1

, C =

0 1 0

1 0 0

1 2 1 2

0 0 0 0 , D =

4 0 3

0 3 0

0 0 1

Teorema. Dada uma matriz real A(nxp) é sempre possível obtermos a sua forma escalonada canônica (f.e.c.) através de operações elementares.

Assim, calcular o posto da matriz A é o mesmo que calcular o posto da f.e.c. de A,

pois são equivalentes. Portanto, calcular o posto da f.e.c. de A é o mesmo que contar

o seu número de 1’s pivôs.

Exemplo. Vamos obter a f.e.c. da matriz A do Exemplo 2.4(a):

1 − 2 3

A=

2 4

5

(i) Fazendo l2 = l2 – 5l1, nós obtemos:

3

1 − 2 3 1 − 2

~

.

5

2 4 0 12 − 11

(ii) Fazendo l2 = l2 /12, nós obtemos:

3 1 − 2

3

1 − 2

~

.

0 12 − 11 0

1 − 11 / 12

(iii) Fazendo l1 = l1 + 2l2, obtemos:

3 1 0

7 / 6

1 − 2

~

0

1 − 11 / 12 0 1 − 11 / 12

7 / 6

1 0

Então a f.e.c. de A é a matriz

e o rank(A) = 2.

0 1 − 11 / 12

Definição: Dizemos que uma matriz quadrada está na forma de Hermite (Graybill

1969, p.120) se satisfaz as seguintes condições:

(a) é uma matriz triangular superior;

Material elaborado pelo Prof. César Gonçalves de Lima

22

(b) tem apenas valores zero ou um na sua diagonal;

(c) se tem o valor zero na diagonal, os elementos restantes na linha são zeros;

(d) se tem o valor um na diagonal, os elementos restantes da coluna em que aparece o número um, são nulos.

Definição: Dizemos que uma matriz quadrada está na forma de Echelon (Graybill,

1969, p.286) se ela satisfaz as condições de uma forma de Hermite e apresenta as

linhas de zeros abaixo das linhas que não são nulas.

Nós podemos estender (2.42) para produtos de matrizes. É possível encontrar

matrizes A ≠ 0 e B ≠ 0, tais que:

AB = 0,

(2.43)

Por exemplo,

6 0 0

1 2 2

2 4 − 1 − 3 = 0 0 .

Nós também podemos explorar a dependência linear das linhas ou colunas de

uma matriz para criar expressões tais como AB = CB, onde A ≠ C. Assim em uma

equação matricial, nós não podemos, em geral, cancelar uma matriz de ambos os

lados da equação. Uma exceção a essa regra ocorre quando as matrizes envolvidas

são quadradas e B é uma matriz não-singular (será definida na Seção 2.5).

Exemplo 2.4(b). Nós ilustramos a existência de matrizes A, B e C tais que AB = CB,

onde A ≠ C. Sejam as matrizes:

1 2

1

1

3 5

1 3 2

0 1 , C = 2

A =

B

=

⇒

AB

=

CB

=

,

5 − 6 − 4

1 4 .

2 0 −1

1 0

O teorema seguinte dá um caso geral e dois casos especiais para o posto do produto

de duas matrizes.

Teorema 2.4A.

(i) Se as matrizes A e B são conformes, então rank(AB) ≤ rank(A) e rank(AB) ≤

rank(B).

(ii) A multiplicação por uma matriz não-singular (ver Seção 2.5) não altera o posto

da matriz, isto é, se B e C são não-singulares⇒ rank(AB) = rank(CA) = rank(A).

(iii) Para qualquer matriz A, rank(A’A) = rank(AA’) = rank(A’) = rank(A).

Material elaborado pelo Prof. César Gonçalves de Lima

23

Prova:

(i) Todas as colunas de AB são combinações lineares das colunas de A (ver um comentário no Exemplo 2.3) conseqüentemente, o número de colunas l.i. de AB é

menor ou igual ao número de colunas l.i. de A, e rank(AB) ≤ rank(A). Similarmente, todas as linhas de AB são combinações lineares das linhas de B [ver

comentário em (2.38)] e daí, rank(AB) ≤ rank(B).

(ii) Se B é não singular, existe uma matriz B -1 tal que B B -1 = I [ver (2.45) a seguir].

Então, de (i) nós temos que:

rank(A) = rank(AB B -1 ) ≤ rank(AB) ≤ rank(A).

Assim ambas as desigualdades tornam-se igualdades e rank(A) = rank(AB). Similarmente, rank(A) = rank(CA) para C não-singular.

2.5. INVERSA DE UMA MATRIZ

Uma matriz quadrada de posto completo é dita não-singular. Uma matriz A,

–1

não-singular, tem inversa única, denotada por A , com a propriedade que:

–1

–1

AA =A A=I

(2.45)

Um algoritmo simples (mas trabalhoso se a dimensão da matriz é grande!) para

obtenção da inversa de uma matriz consiste em justapor à matriz A uma matriz identidade de mesma ordem. Opera-se simultaneamente sobre as linhas das duas matrizes

até que no lugar da matriz A apareça a sua f.e.c. (neste caso, uma matriz identidade).

–1

Nesse momento, no lugar da matriz identidade estará a inversa A de A. Ou seja:

–1

[A | I ] ~ … ~ [I | A ]

Exemplo 2.5. Seja a matriz quadrada:

4 7

A=

.

2 6

(1) Fazendo l2 = l2 – (1/2) l1:

7

1 0

4 7 1 0 4

~

2 6 0 1 0 5 / 2 − 1 / 2 1

(2) Fazendo l2 = (2/5)l2:

1

0 4 7

1

0

4 7

~

0 5 / 2 − 1 / 2 1 0 1 − 1 / 5 2 / 5

(3) Fazendo l1 = l1 + (–7) l2:

Material elaborado pelo Prof. César Gonçalves de Lima

24

1

0 4 0 12 / 5 − 14 / 5

4 7

0 1 − 1 / 5 2 / 5 ~ 0 1 − 1 / 5

2 / 5

(4) Fazendo l1 = (1/4) l1:

3 / 5 − 7 / 10

4 0 12 / 5 − 14 / 5 1 0

~

0 1 − 1 / 5

2 / 5 0 1 − 1 / 5

2 / 5

Então

4 7 1 0

2 6 0 1 ~ … ~

3 / 5 − 7 / 10

1 0

–1

⇒A =

0 1 − 1 / 5

2 / 5

0.6 − 0.7

− 0.2

0.4

Se a matriz B é não-singular e AB = CB, então nós podemos multiplicar à direita por

–1

B os dois lados da igualdade, obtendo:

–1

–1

AB = CB ⇒ ABB = CBB ⇒ A = C

Importante: Se a matriz B é singular ou retangular, ela não pode ser cancelada nos

dois lados da igualdade AB = CB.

Similarmente, se A é não-singular então o sistema Ax = c tem a solução única:

–1

x=A c

(2.47)

Teorema 2.5A. Se A é não singular, então A’ é não singular e a sua inversa pode ser

encontrada como:

–1

–1

(A’) = (A )’

(2.48)

Teorema 2.5B. Se A e B são matrizes não singulares de mesma dimensão, então AB

é não-singular e

–1

–1

(AB) = B A

–1

(2.49)

Se a matriz A é simétrica, não-singular e particionada como:

A12

A

A = 11

A 21 A 22

–1

–1

–1

e se B = A22 – A21(A11) A12, então supondo que (A11) e B existem, a inversa de A

é dada por

-1

-1

-1

-1

A11

− A11

A12B −1A 21A11

− A11

A12B −1

–1

A =

(2.50)

−1

-1

−1

B

A

A

B

−

21 11

Material elaborado pelo Prof. César Gonçalves de Lima

25

Como um caso especial de (2.50), consideremos a matriz não singular:

A

A = 11 t

(a12 )

a12

a22

–1

onde A11 é quadrada, a22 é um escalar e a12 é um vetor. Então se (A11)

inversa de A pode ser expressa como:

1

A =

b

–1

-1

-1

-1

-1

bA11

a12 (a12 )t A11

a12

+ A11

− A11

-1

− (a12 )t A11

1

existe, a

(2.51)

–1

onde b = a22 – (a12)t(A11) a12. Como um outro caso especial de (2.50) nós temos:

A

A = 11

Φ

Φ

A 22

que tem a inversa

−1

A11

A =

Φ

Φ

A −221

–1

(2.52)

Se uma matriz quadrada da forma B + cc’ é não singular, onde c é um vetor e B

é uma matriz não singular, então:

B −1cc' B −1

–1

–1

(B + cc’) = B –

(2.53)

1 + c' B −1c

2.6 MATRIZES POSITIVAS DEFINIDAS

Formas quadráticas foram introduzidas em (2.33). Por exemplo, a forma quadrática

3 y12 + y22 + 2 y32 + 4 y1 y2 + 5 y1 y3 – 6 y2 y3 pode ser expressa como:

3 y12 + y22 + 2 y32 + 4 y1 y2 + 5 y1 y3 – 6 y2 y3 = y’Ay

onde

y1

y = y2 ,

y3

3 4 5

A = 0 1 − 6 .

0 0 2

Entretanto, essa forma quadrática pode ser expressa em termos da matriz simétrica:

2 5 / 2

3

1

(A + A’) = 2

1 −3.

2

5 / 2 − 3 2

Material elaborado pelo Prof. César Gonçalves de Lima

26

Em geral, qualquer forma quadrática y’Ay pode ser expressa como:

A + A'

y’Ay = y’

y

2

(2.54)

Assim a matriz-núcleo da forma quadrática pode sempre ser escolhida como uma

matriz simétrica (e única!).

Exemplo. A variância definida como s2 =

1

1

y' I − J y = y’Ay é uma

n −1

n

forma quadrática e a sua matriz núcleo é simétrica:

1

1 1

1

L

−

−

1 − n

n

n n

1

1

1

−1

1 −

1− L

−

A=

n

n = n(n − 1)

n

n −1

M

M

M M

1

1 − 1

−1

−

L 1 −

n

n

n n(n − 1)

−1

−1

L

n(n − 1)

n(n − 1)

−1

1

L

n(n − 1)

n

M

M

−1

1

L

n(n − 1)

n

As somas de quadrados encontradas na análise de regressão (Capítulos 6 a 10)

e análise de variância (Capítulos 11 a 14) podem ser expressas na forma y’Ay, onde y

é um vetor de observações. Tais formas quadráticas são positivas (ou no mínimo nãonegativas) para todos os valores de y.

Se a matriz simétrica A tem a propriedade de y’Ay > 0 para todos os possíveis

vetores de observações y, com exceção de y = 0, então a forma quadrática y’Ay é dita

positiva definida e A é dita matriz positiva definida.

Similarmente, se y’Ay ≥ 0 para todos os possíveis vetores de observações y,

com exceção de y = 0, então a forma quadrática y’Ay é dita positiva semidefinida e A

é dita matriz positiva semidefinida.

Exemplo 2.6. Para ilustrar uma matriz positiva definida, considere:

2 − 1

A=

− 1 3

A forma quadrática associada

y’Ay = 2 y12 – 2 y1 y2 + 3 y22 = 2( y1 – 0,5 y2 )2 + (5/2) y22

que é claramente positiva a menos que y1 e y2 sejam ambos iguais a zero.

Material elaborado pelo Prof. César Gonçalves de Lima

27

Para ilustrar uma matriz positiva semidefinida, considere:

(2 y1 – y2 )2 + (3 y1 – y3 )2 + (3 y2 – 2 y3 )2

que pode ser expresso como y’Ay, com

13 − 2 − 3

A = − 2 10 − 6

− 3 − 6

5

Se 2 y1 = y2 , 3 y1 = y3 e 3 y2 = 2 y3 , então (2 y1 – y2 )2 + (3 y1 – y3 )2 + (3 y2 – 2 y3 )2

= 0. Assim y’Ay = 0 para qualquer múltiplo de y = [1, 2, 3]’. Para todos os outros

casos, y’Ay > 0 (com exceção de y = 0).

Teorema 2.6A.

(i) Se A é positiva definida, então todos os elementos aii da sua diagonal são positivos.

(ii) Se A é positiva semidefinida, então todos aii ≥ 0.

(Ver prova na página 23 do livro do Rencher)

Teorema 2.6B. Seja P uma matriz não-singular.

(i) Se A é positiva definida, então P’AP é positiva definida.

(ii) Se A é positiva semidefinida, então P’AP é positiva semidefinida.

(Ver prova na página 23 do livro do Rencher)

Corolário 1. Seja A(pxp) uma matriz positiva definida e seja a matriz B(kxp) de posto

k ≤ p. Então a matriz BAB’ é positiva definida.

Corolário 2. Seja A(pxp) uma matriz positiva definida e seja a matriz B(kxp). Se k > p

ou se rank(B) = r, onde r < k e r < p, então a matriz BAB’ é positiva semidefinida.

Teorema 2.6C. Uma matriz simétrica A é positiva definida se e somente se existe

uma matriz não singular P tal que A = P’P.

(Ver prova na página 23 do livro do Rencher)

Corolário 1. Uma matriz positiva definida é não-singular.

Material elaborado pelo Prof. César Gonçalves de Lima

28

Um método de fatorar uma matriz positiva definida A em um produto P’P é

chamado de decomposição de Cholesky [ver Seber (1977, pág.304-305)], pelo qual A

pode ser fatorado de modo único em A = T’T, onde T é uma matriz não singular e

triangular superior.

Para qualquer matriz quadrada ou retangular B, a matriz B’B é positiva definida ou positiva semidefinida.

Teorema 2.6D. Seja a matriz B(nxp).

(i) Se rank(B) = p, então B’B é positiva definida.

(ii) Se rank(B) < p, então B’B é positiva semidefinida.

Prova:

(i) Para mostrar que y’B’By > 0 para y ≠ 0, nós notamos que y’B’By = (By)’(By) é

uma soma de quadrados e portanto, é positiva definida, a menos que By = 0. Por

(2.37) nós podemos expressar By na forma:

By = y1b1 + y2b2 + … + ypbp

Essa combinação linear não é igual a 0 (para qualquer y ≠ 0) porque rank(B) = p

e as colunas de B são l.i.

(ii) Se rank(B) < p, então nós podemos encontrar y ≠ 0 tal que

By = y1b1 + y2b2 + … + ypbp = 0

porque as colunas de B são l.d. [ver (2.40)]. Daí, y’B’By ≥ 0.

2

Note que se B é uma matriz quadrada, a matriz B = BB não é necessariamente

positiva semidefinida. Por exemplo, seja a matriz:

1 − 2

B=

1 − 2

Então:

− 1 2

2 − 4

B2 =

,

B’B

=

− 4

8

− 1 2

Neste caso, B2 não é positiva semidefinida, mas B’B é positiva semidefinida, porque

2

y’B’By = 2(y1 – 2y2) ≥ 0.

–1

Teorema 2.6E. Se A é positiva definida, então A é positiva definida.

Prova: Pelo Teorema 2.6C, A = P’P, onde P é não singular. Pelos Teoremas 2.5A e

–1

–1

–1

–1

–1 –1

2.5B, A = (P’P) = P (P’) = P (P )’, que é positiva definida pelo Teorema 2.6C.

Material elaborado pelo Prof. César Gonçalves de Lima

29

Teorema 2.6F. Se A é positiva definida e é particionada na forma

A

A = 11

A 21

A12

A 22

onde A11 e A22 são quadradas, então A11 e A22 são positivas definidas.

I

Prova: Nós podemos escrever A11 como A11 = [I, 0] A , onde I tem a mesma di0

mensão de A11. Então, pelo Corolário 1 do Teorema 2.6B, A11 é positiva definida.

2.7 SISTEMAS DE EQUAÇÕES

O sistema de equações de n equações (lineares) e p incógnitas

a11x1 + a12x2 + … + a1pxp = c1

a21x1 + a22x2 + … + a2pxp = c2

(2.55)

…

an1x1 + an2x2 + … + anpxp = cn

pode ser escrito na forma matricial como

Ax = c

(2.56)

onde A é nxp, x é px1 e c é nx1.

Note que:

•

Se n ≠ p então os vetores x e c são de tamanhos diferentes.

•

Se n = p e A é não-singular, então por (2.47), existe um único vetor solução x =

–1

A c.

•

Se n > p, tal que A tenha mais linhas que colunas (mais equações do que incógnitas), então, geralmente, o sistema Ax = c não tem solução.

•

Se n < p, tal que A tenha menos linhas que colunas, então o sistema Ax = c tem

um número infinito de soluções.

•

Se o sistema (2.56) tem uma ou mais vetores soluções, ele é chamado de sistema

consistente. Se não tem solução, ele é chamado de sistema inconsistente.

Para ilustrar a estrutura de um sistema consistente, suponha que A seja pxp

tenha posto r < p. Então as linhas de A são linearmente dependentes e existe algum b

tal que [ver (2.38)]:

b’A = b1 a1t + b2 a t2 + … + bp a tp = 0’

Material elaborado pelo Prof. César Gonçalves de Lima

30

Então, nós também podemos ter b’c = b1c1 + b2 c2+ … + bp cp = 0, porque a multiplicação de Ax = c por b’ (de ambos os lados) dá:

b’Ax = b’c

0’x = b’c.

ou

Por outro lado, se b’c ≠ 0, não existe x tal que Ax = c. Portanto, para que Ax = c seja

consistente, a mesma relação (qualquer que seja) que existe entre as linhas de A deve

existir entre os elementos (linhas) de c. Isso é formalizado comparando o posto de A

com o posto da matriz aumentada [A, c]. A notação [A, c] indica que c foi justaposta

à matriz A como uma coluna adicional.

Teorema 2.7A O sistema de equações Ax = c é consistente (tem no mínimo uma

solução) se e somente se rank(A) = rank[A, c].

Prova: Suponha que rank(A) = rank[A, c], de tal forma que justapor não altera o

posto da matriz A. Então c é uma combinação linear das colunas de A; isto é,

existe pelo menos um x tal que

x1a1 + x2a2 + … + xpap = c

que, por (2.38) pode ser escrito como Ax = c. Assim, x é uma solução do sistema Ax = c.

Por outro lado, suponha que existe um vetor solução x tal que Ax = c. Em geral,

tem-se que rank(A) ≤ rank[A, c] [ver Harville (1997, p.41)]. Mas desde que

existe um x tal que Ax = c, nós temos:

rank[A, c] = rank[A, Ax] = rank[A(I, x)]

≤ rank(A)

[Teorema 2.4A(i)]

Por isso,

rank(A) ≤ rank[A, c] ≤ rank(A)

e daí nós temos que rank(A) = rank[A, c].

Um sistema de equações consistente pode ser resolvido pelos métodos usuais

apresentados nos cursos básicos de álgebra (método da eliminação de variáveis, por

exemplo). No processo, uma ou mais variáveis podem terminar como constantes arbitrárias, gerando assim um número infinito de soluções. Um método alternativo para

resolver o sistema será apresentado na Seção 2.8.2.

Exemplo 2.7(a) Considere o sistema de equações:

x1 + 2x2 = 4

x1 – x2 = 1

x1 + x2 = 3

ou

1 2

4

1 − 1 x1 = 1

x2

1 1

3

Material elaborado pelo Prof. César Gonçalves de Lima

31

A matriz aumentada é:

1 2 4

[A, c] = 1 − 1 1

1 1 3

que tem rank[A, c] = 2 porque a terceira coluna é igual à soma de duas vezes a primeira coluna com a segunda coluna. Desde que rank[A, c] = 2 = rank(A), existe ao

menos uma solução para o sistema.

Se adicionarmos duas vezes a primeira equação à segunda equação, o resultado

é um múltiplo da terceira equação. Assim, a terceira equação é redundante e as duas

primeiras podem ser resolvidas para obter a solução única x = [2, 1]’.

4

x2

3

2

1

0

0

1

2

x1

3

4

5

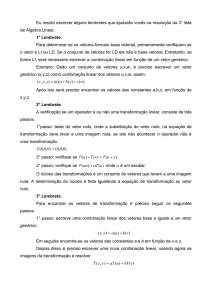

Figura 2.1 Três linhas representando as equações do sistema do Exemplo 2.7(a)

A Figura 2.1 mostra as três linhas que representam as três equações do sistema.

Note que as três linhas cruzam no ponto de coordenadas (2, 1), que é a solução única

do sistema de três equações.

Exemplo 2.7(b). Se trocarmos o número 3 por 2 na terceira equação do Exemplo

2.7(a), a matriz aumentada fica

1 2 4

[A, c] = 1 − 1 1

1 1 2

que tem posto 3, já que nenhuma combinação linear das colunas é 0. Como rank[A,c]

= 3 ≠ rank(A) = 2, o sistema é inconsistente.

As três linhas que representam as três equações são apresentadas na Figura 2.2,

onde nós percebemos que as três linhas não têm um ponto comum de interseção. Para

encontrar a melhor solução aproximada, uma abordagem consiste em usar o método

dos mínimos quadrados, que consiste em buscar os valores de x1 e x2 que minimizam

2

2

2

(x1 + 2x2 – 4) + (x1 – x2 – 1) + (x1 + x2 – 2) = 0.

Material elaborado pelo Prof. César Gonçalves de Lima

32

4

x2

3

2

1

0

0

1

2

x1

3

4

5

Figura 2.2 Três linhas representando as equações do sistema do Exemplo 2.7(b)

Exemplo 2.7(c) Considere o sistema:

x1 + x2 + x3 = 1

2x1 + x2 + 3x3 = 5

3x1 + 2x2 + 4x3 = 6

A terceira equação é a soma das duas primeiras, mas a segunda não é um múltiplo da

primeira. Assim rank(A) = 2 = rank[A, c] e o sistema é consistente. Resolvendo as

duas primeiras equações para x1 e x2 em termos de x3, nós obtemos:

x1 = –2x3 + 4,

x2 = x3 – 3

O vetor solução pode ser expresso como:

− 2 x3 + 4

− 2 4

x=

x3 − 3 = x3 1 + − 3

x3

1 0

onde x3 é uma constante arbitrária. Geometricamente, x é uma linha representando a

interseção dos dois planos correspondentes às duas primeiras equações.

2.8. INVERSA GENERALIZADA

Vamos considerar inversas generalizadas daquelas matrizes que não têm inversas no

sentido usual [ver (2.45)]. Uma solução de um sistema consistente de equações Ax =c

pode ser expresso em termos de uma inversa generalizada de A.

2.8.1 Definição e Propriedades

–

Uma inversa generalizada de uma matriz A nxp é qualquer matriz A , que satisfaz:

–

AA A = A

(2.57)

Material elaborado pelo Prof. César Gonçalves de Lima

33

–

Uma inversa generalizada não é única exceto quando A é não-singular, neste caso A

–1

= A . Uma inversa generalizada que satisfaz (2.57) é também chamada de inversa

condicional.

Toda matriz (quadrada ou retangular) tem uma inversa condicional. Isso é garantido mesmo para vetores. Por exemplo:

1

2

x=

3

4

então x1− = [1, 0, 0, 0] é uma inversa generalizada de x que

satisfaz (2.57). Outros exemplos são x −2 = [0, 1/2, 0, 0], x 3− = [0,

0, 1/3, 0] e x −4 = [0, 0, 0, 1/4]. Para cada x i− , nós temos que:

x xi− x = x 1 = x,

i = 1, 2, 3.

Nessa ilustração, x é um vetor coluna e x i− é um vetor linha. Esse modelo é generalizado no seguinte teorema.

–

Teorema 2.8A. Se A é nxp então qualquer inversa generalizada A é pxn.

Exemplo 2.8.1. Seja:

2 2 3

A = 1 0 1

3 2 4

(2.58)

Como a terceira linha de A é a soma das duas primeiras linhas, e a segunda linha não

é um múltiplo da primeira, o rank(A) = 2. Sejam

1 0

0

A1− = 1 / 2 − 1 0 ,

0 0 0

1

0

0

A −2 = 0 − 3 / 2 1 / 2

0

0

0

(2.59)

Facilmente podemos verificar que A A1− A = A e A A −2 A = A.

Teorema 2.8B. Suponha que A é nxp de posto r e que A é particionada como

A

A = 11

A 21

A12

A 22

Onde A11 é rxr de posto r. Então a inversa generalizada de A é dada por

−1

A11

Ο

A =

Ο Ο

–

–

Onde as três matrizes nulas 0 têm dimensões apropriadas para que A seja pxn.

(Ver prova na pág. 30 no livro do Rencher)

Material elaborado pelo Prof. César Gonçalves de Lima

34

Corolário 1. Suponha A (nxp) de posto r e que A é particionado como no Teorema

2.8B, onde A22 é rxr de posto r. Então a inversa generalizada de A é dada por

–

0 0

A =

−1

0 A 22

–

onde as três matrizes nulas são de dimensões apropriadas, tais que A é pxn.

A submatriz não-singular não precisa estar na posição A11 ou A22, como no

Teorema 2.8B e no seu corolário. O Teorema 2.8B pode ser estendido para o seguinte

–

algoritmo para encontrar uma inversa condicional A , para qualquer matriz A (nxp)

de posto r [ver Searle, 1982, p.218]:

1. Encontre qualquer submatriz não-singular C(rxr). Não é necessário que os elementos de C ocupem posições (linhas e colunas) adjacentes em A.

–1

–1

2. Encontre C e a sua transposta (C )’.

–1

3. Substitua em A os elementos de C pelos elementos de (C )’.

4. Substitua todos os outros elementos de A por zeros.

5. Transponha a matriz resultante.

1 1 0

1 1 0

Exemplo. Calcular uma inversa generalizada (condicional) de X =

1 0 1

1 0 1

Usando o algoritmo de Searle (e lembrando que o posto da matriz X é 2), escolhemos

convenientemente:

1 0

–1

C=

⇒ C =

0 1

0

0

⇒

0

0

0 0

1 0

⇒ X– =

0 1

0 0

1 0

–1

0 1 ⇒ (C )’ =

1 0

0 1

0 0 0 0

0 1 0 0 é uma inversa condicional de X

0 0 1 0

Vale lembrar que escolhendo outras matrizes C e usando o algoritmo, podemos encontrar outras inversas condicionais de X.

–

Teorema 2.8C. Seja A (nxp) de posto r, seja A uma inversa generalizada de A e

–

seja (A’A) uma inversa generalizada de A’A. Então:

(i) posto(A’A) = posto(AA’) = posto(A) = r.

Material elaborado pelo Prof. César Gonçalves de Lima

35

–

–

–

(ii) (A’) é uma inversa generalizada de A’; isto é (A’) = (A )’.

–

–

(iii) A = A(A’A) A’A e A’ = A’A(A’A) A’.

–

–

–

(iv) (A’A) A’ é uma inversa generalizada de A, isto é, A = (A’A) A’.

–

–

(v) A(A’A) A’ é simétrica, rank[A(A’A) A’] = r e é invariante à escolha de

–

–

–

(A’A) ; isto é, A(A’A) A’ permanece a mesma, para qualquer (A’A) .

Uma inversa generalizada de uma matriz simétrica não é necessariamente simétrica. Entretanto, também é verdade que uma inversa generalizada simétrica de

uma matriz simétrica, sempre pode ser encontrada; ver Problema 2.45. Neste livro,

nós assumimos que as inversas generalizadas de matrizes simétricas também são

simétricas.

Além da inversa generalizada (condicional) definida em (2.57) existem outras,

mq

+

como a inversa de mínimos quadrados (A ) e a inversa de Moore-Penrose (A ) que

é muito útil em demonstrações envolvendo modelos lineares.

Definição: Dada a matriz A(nxp) então toda matriz A mq (pxn) que satisfaz as duas

condições seguintes, é uma inversa de mínimos quadrados da matriz A:

mq

(a) AA A = A

mq

(b) AA

é uma matriz simétrica

mq

–

Teorema. Toda matriz do tipo A = (A’A) A’ é uma inversa de mínimos qua–

drados de A [qualquer que seja a inversa condicional (A’A) ].

1

1

Exemplo. Obter uma inversa de mínimos quadrados de X =

1

1

4 2 2

Primeiramente calculamos X’X = 2 2 0 . Escolhendo C =

2 0 2

goritmo de Searle, obtemos:

1 0

1 0

0 1

0 1

2 0

0 2 e usando o al

0

0 0

(X’X) = 0 0,5 0

0 0 0,5

–

Material elaborado pelo Prof. César Gonçalves de Lima

36

Então uma inversa de mínimos quadrados de X é igual a:

mq

X

0

0

0

0

= (X’X) X’ = 0,5 0,5 0

0

0

0 0,5 0,5

–

Vale observar que escolhendo outras matrizes C e, correspondentemente, calculando outras inversas condicionais de X’X, podemos encontrar outras inversas de

mínimos quadrados da matriz X.

+

Definição: Dada a matriz A (nxp) de posto r, então a matriz A (pxn), de posto r, que

satisfaz às quatro condições seguintes, é definida como a inversa generalizada de

Moore-Penrose da matriz A:

+

(a) AA A = A

+

+

+

(b) A AA = A

+

(c) A A é simétrica

+

(d) A A é simétrica

+

Teorema 2. Para cada matriz A (nxp) existe sempre uma e só uma matriz A que

satisfaz as condições de Moore-Penrose.

A obtenção da inversa de Moore-Penrose é bastante trabalhosa. Geralmente elas são

obtidas através de algum pacote estatístico. No proc iml do SAS, por exemplo, ela é

obtida com o comando ginv.

2.8.2. Inversas Generalizadas e Sistemas de Equações

Uma solução para um sistema de equações pode ser expressa em termos de uma inversa generalizada.

–

Teorema 2.8D. Se o sistema de equações Ax = c é consistente e se A é uma inversa

–

generalizada de A, então x = A c é uma solução.

Ver prova na pág.32 do livro do Rencher.

–

Vale lembrar mais uma vez que diferentes escolhas de A , resultarão em diferentes

soluções para Ax = c.

Material elaborado pelo Prof. César Gonçalves de Lima

37

Teorema 2.8E. Se o sistema de equações Ax = c é consistente, então todas as possíveis soluções podem ser obtidas das duas seguintes maneiras:

–

–

–

–

–

(i) Use uma A específica em x = A c + (I – A A)h e use todos os possíveis valores para o vetor arbitrário h.

(ii) Use todas as possíveis inversas A em x = A c.

Ver prova em Searle (1982, p.238)

Uma condição necessária e suficiente para que o sistema Ax = c seja consistente pode

ser dado em termos de uma inversa generalizada (ver Graybill 1976, p.36).

Teorema 2.8F. O sistema de equações Ax = c é consistente se e somente se para

–

qualquer inversa generalizada A de A

–

AA c = c.

Ver prova na pág. 33 do livro do Rencher.

Observe que o Teorema 2.8F fornece uma alternativa ao Teorema 2.7A para decidir

se um sistema de equações é consistente.

2.9. DETERMINANTES

O determinante de uma matriz A (nxn) é uma função escalar de A definida como a

soma algébrica de todos os seus n! possíveis produtos elementares. Denota-se geralmente por

δ(A) = | A | = det(A) =

n!

∑ pi

i =1

• Cada produto elementar é do tipo pi = a1_ a2_ a3_ … an_ em que, nos espaços

(índices) são colocados os números de alguma permutação simples do conjunto

{1, 2, …, n}.

• Em cada produto pi existe um e um só elemento de cada linha e coluna.

• Cada produto elementar recebe o sinal + ou –, conforme o número de inversões

envolvidas em pi seja par ou ímpar, respectivamente.

Essa definição não é muito útil para calcular o determinante de uma matriz, exceto

para o caso de matrizes 2x2 ou 3x3. Para matrizes maiores, existem programas específicos (proc iml do SAS, Mapple e MathCad por exemplo) para calcular os determinantes.

Material elaborado pelo Prof. César Gonçalves de Lima

38

a11

Exemplo. Seja a matriz A = a 21

a31

a12

a 22

a32

a13 2 0 1

a 23 = 3 − 1 4

a33 − 5 6 7

• Como n = 3, temos 3! = 6 permutações, a saber:

i

pi

Permutação

No de inversões

Sinal

Valor de pi

1

a11 a22 a33

123

0

+

+p1 = –14

2

a11 a23 a32

132

1

–

–p2 = –48

3

a12 a21 a33

213

1

–

–p3 = 0

4

a12 a23 a31

231

2

+

+p 4 = 0

5

a13 a21 a32

312

2

+

+p5 = 18

6

a13 a22 a31

321

3

–

–p6 = –5

∴det(A) =

6

∑ pi

= –49

i =1

Teorema 2.9A.

(i) Se D = diag(d1, d2, …, dn) então det(D) =

n

∏ di

i =1

(ii) O determinante de uma matriz triangular é o produto dos elementos da diagonal.

(iii) Se A é singular, det(A) = 0. Se A é não-singular, det(A) ≠ 0.

(iv) Se A é positiva definida, det(A) > 0.

(v) det(A) = det(A’)

–1

(vi) Se A é não singular, det(A ) = 1/det(A)

Teorema 2.9B. Se a matriz A é particionada como

A

A = 11

A 21

A12

,

A 22

e se A11 e A22 são quadradas e não singulares (mas não necessariamente do mesmo

tamanho) então

–1

det(A) = |A11| |A22 – A21(A11) A12|

(2.70)

–1

= |A22| |A11 – A12(A22) A21|

(2.71)

Note a analogia de (2.70) e (2.71) com o caso do determinante de uma matriz A, 2x2:

det(A) = a11 a22 – a21 a12 = a11 (a22 – a21 a12/ a11) = a22 (a11 – a12 a21/ a22)

Material elaborado pelo Prof. César Gonçalves de Lima

39

(ver os Corolários 1 a 4 nas páginas 35 e 36 do livro do Rencher)

Teorema 2.9C. Se A e B são quadradas e de mesmo tamanho, então o determinante

do produto é igual ao produto dos determinantes:

|AB| = |A| |B|

(2.76)

|AB| = |BA|

(2.77)

Corolário 1.

Corolário 2.

2

|A | = |A|

2

(2.77)

2.10. VETORES ORTOGONAIS E MATRIZES

Dois vetores nx1 a e b são ditos ortogonais se

a'b = a1b1 + a2b2 + … + anbn = 0

(2.79)

Note que o termo ortogonal se aplica aos dois vetores e não a um único vetor.

Geometricamente, dois vetores ortogonais são perpendiculares um ao outro.

Para mostrar que os vetores a e b são perpendiculares podemos calcular o ângulo

formado entre eles.

cos(θ) =

a' b

(a' a)(b' b)

(2.80)

Quando θ = 90º, a’b = 0 porque cos(90º) = 0. Assim a e b são perpendiculares quando a’b = 0.

4

− 1

Exemplo. Sejam os vetores a = e b = . Então a’b = 0 ⇒ cos(θ) = 0 ⇒ o ân 2

2

gulo formado entre eles é de 90º, ou seja, os vetores a e b são perpendiculares.

Se a’a = 1, dizemos que o vetor a está normalizado. Um vetor b pode ser normalizado dividindo-o pelo seu comprimento (ou norma), b' b . Assim

c=

b

b' b

(2.81)

está normalizado, porque c’c = 1.

Material elaborado pelo Prof. César Gonçalves de Lima

40

Um conjunto de vetores c1, c2,…, cp de dimensões px1 que são normalizados

(ci’ci = 1, para toto i) e mutuamente ortogonais (ci’cj = 0, para todo i ≠ j) é dito ser um

conjunto ortonormal de vetores. Se a matriz C = [c1, c2,…, cp] pxp tem colunas ortogonais e normalizadas, C é chamada matriz ortonormal. Desde que os elementos de

C’C são produtos de colunas de C [ver Teorema 2.2C(i)], uma matriz ortonormal C

tem a propriedade:

C’C = I

(2.82)

Pode ser mostrado que uma matriz ortonormal C também satisfaz

CC’ = I

(2.83)

Assim, uma matriz ortonormal C tem linhas ortonormais como também colunas

–1

ortonormais. É evidente que de (2.82) e (2.83), C’ = C , se C é ortonormal.

Exemplo 2.10. Para ilustrar uma matriz ortonormal, partimos de:

1 1

1

A = 1 − 2 0

1

1 − 1

Que tem colunas mutuamente ortogonais, mas que não são ortonormais. Para normalizar as três colunas, nós as dividimos pelos seus respectivos comprimentos, 3 , 6

e 2 , obtendo assim a matriz:

1 3

1 6

1 2

C = 1 3 − 2 6

0

1 3

1 6 − 1 2

cujas colunas são ortonormais. Note que as linhas de C também são ortonormais, tal

que C satisfaz (2.83) e (2.82).

A multiplicação de um vetor por uma matriz ortogonal tem o efeito de rotacionar os eixos; isto é, se um ponto x é transformado para z = Cx, onde C é uma matriz

ortonormal, então a distância da origem a z é a mesma que a distância da origem a x:

z’z = (Cx)’(Cx) = x’C’Cx = x’x

(2.84)

Aqui, a transformação de x para z é uma rotação.

Teorema 2.10A. Se uma matriz C (pxp) é ortonormal e se A (pxp) é uma matriz

qualquer, então:

(i) |C| = +1 ou –1

(ii) |C’AC| = |A|

(iii) –1 ≤ cij ≤ 1, onde cij é qualquer elemento da matriz C

Material elaborado pelo Prof. César Gonçalves de Lima

41

2.11. TRAÇO DE UMA MATRIZ

O traço de uma matriz (nxn) A = (aij) é uma função escalar definida como a soma dos

elementos da diagonal de A; isto é,

tr(A) =

∑i=1 aii

n

8 4 2

Por exemplo, se A = 2 − 3 6 ⇒ tr(A) = 8 + (–3) + 9 = 14.

3 5 9

Teorema 2.11A.

(i) Se A e B são (nxn) então

tr(A ± B) = tr(A) ± tr( B)

(2.85)

(ii) Se A é (nxp) e B é (pxn), então

tr(AB) = tr(BA)

(2.86)

Note que em (2.86) n pode ser menor, igual ou maior que p

(iii) Se A é (nxp)

tr(A’A) =

p

∑ a tj a j

(2.87)

j =1

onde aj é a j-ésima coluna de A.

(iv) Se A é (nxp)

tr(AA’) =

n

∑ a i a ti

(2.88)

i =1

onde a ti é a i-ésima linha de A.

(v) Se A = (aij) é uma matriz nxp então:

n

p

∑∑ aij2

tr(A’A) = tr(AA’) =

(2.89)

i =1 j =1

(vi) Se A é (nxn) e P (nxn) é qualquer matriz não-singular, então:

–1

tr(P AP) = tr(A)

(2.90)

(vii) Se A é (nxn) e C (nxn) é qualquer matriz ortogonal, então:

tr(C’AC) = tr(A)

(2.91)

–

(viii) Se A é (nxp) de posto r e A (pxn) é uma inversa generalizada de A, então:

–

–

tr(A A) = tr(A A ) = r

(2.92)

Material elaborado pelo Prof. César Gonçalves de Lima

42

2.12 AUTOVALORES E AUTOVETORES

Definição: Para qualquer matriz quadrada A, um escalar λ e um vetor não-nulo x

podem ser encontrados, de tal forma que:

Ax = λx

(2.93)

Em (2.93), λ é chamado um autovalor de A e x é um autovetor de A (também

são chamados de valor característico e vetor característico de A, respectivamente).

Note que em (2.93) o vetor x é transformado por A, em um múltiplo de si próprio, de

tal forma que o ponto Ax está sobre a linha que passa por x e a origem.

Para encontrar λ e x para uma matriz A, nós escrevemos (2.93) como:

(A – λI)x = 0

(2.94)

Por (2.37), (A – λI)x é uma combinação das colunas de A – λI e por (2.40) e (2.94)

essas colunas são linearmente dependentes. Assim a matriz quadrada A – λI é singular, e pelo Teorema 2.9A(iii) nós podemos resolver para λ usando

|A – λI| = 0

(2.95)

que é conhecido como equação característica.

Se A é (nxn) a equação característica (2.95) terá n raízes, isto é, A terá n autovalores λ1, λ2, …,λn. Os λ’s não serão necessariamente distintos ou todos diferentes de

zero, ou todos números reais. (Entretanto, os autovalores de uma matriz simétrica

serão reais, ver Teorema 2.12C). Depois de encontrar λ1, λ2, …,λn usando (2.95) os

autovetores poderão ser encontrados usando (2.94).

Se λi = 0, o correspondente autovetor não é o vetor nulo, 0. Para ver isso, note

que se λ = 0 então (A – λI)x = 0 fica Ax = 0 que tem solução para x porque A é singular, e as colunas são linearmente dependentes [a matriz A é singular porque ela

tem, ao menos, um autovalor nulo].

Exemplo 2.12.1 Para ilustrar autovalores e autovetores, considere a matriz:

1 2

A=

− 1 4

Por (2.95), a equação característica é:

2

1 − λ

|A – λI| =

= (1 – λ)(4 – λ) + 2 = 0

−

1

4

−

λ

ou seja

λ2 – 5λ + 6 = (λ – 3)(λ – 2) = 0

Material elaborado pelo Prof. César Gonçalves de Lima

43

que tem raízes λ1 = 3 e λ2 = 2. Para encontrar o autovetor x1 correspondente a λ1 = 3,

nós usamos (2.94),

2 x1 0

(1 − 3)

(A – 3I)x = 0 ⇒

=

− 1 (4 − 3) x2 0

que pode ser escrito como:

–2x1 + 2x2 = 0

–x1 + x2 = 0

Como a segunda equação é um múltiplo da primeira, então x1 = x2. Um vetor solução

pode ser escrito com x1 = c como uma constante arbitrária.

x x

1

1

x 1 = 1 = 1 = x1 = c

x2 x1

1

1

Se c = 1/ 2 para normalizar o vetor, nós obtemos:

1 / 2

x1 =

1 / 2

Similarmente, correspondente a λ2 = 2, nós obtemos:

2 / 5

x2 =

1 / 5

2.12.2. Funções de uma matriz

Se λ é um autovalor da matriz quadrada A com um correspondente autovetor x, então

para certas funções g(A), um autovalor é dado por g(λ) e x é o autovetor correspondente de g(A) como também de A. Nós ilustramos para alguns casos:

1. Se λ é um autovalor de A, então cλ é um autovalor de cA, onde c é uma constante

arbitrária, tal que c ≠ 0. Esse resultado é facilmente demonstrado multiplicando-se

a relação de definição Ax = λx por c:

cAx = cλx

(2.96)

2. Se λ é um autovalor de A e x é o autovetor correspondente de A, então cλ + k é um

autovalor da matriz cA + kI e x é o autovetor de cA + kI, onde c e k são escalares.

Para mostrar isso, adicionamos kx a (2.96):

cAx + kx = cλx + kx

(cA + kI)x = (cλ + k)x

(2.97)

Assim cλ + k é o autovalor de cA + kI e x é o correspondente autovetor de cA + k.

Note que (2.97) não se estende a (A + B), onde A e B são matrizes nxn arbitrárias;

isto é, A + B não tem autovalores λA + λB, onde λA é um autovalor de A e λB, de B.

Material elaborado pelo Prof. César Gonçalves de Lima

44

2

2

3. Se λ é um autovalor de A, então λ é um autovalor de A . Isto pode ser demonstrado, multiplicando-se a relação de definição Ax = λx por A:

2

2

AAx = Aλx ⇒ A x = λAx = λ(λx) = λ x

2

2

(2.98)

2

Assim λ é um autovalor de A e x é o autovetor correspondente de A . Isso pode

ser estendido para:

k

k

Ax =λx

(2.99)

–1

4. Se λ é um autovalor da matriz não-singular A, então 1/λ é um autovalor de A .

–1

Para demonstrar isso, nós multiplicamos Ax = λx por A para obter

–1

–1

–1

–1

A Ax = A λx ⇒ x = λA x ⇒ A x = (1/λ)x

–1

(2.100)

–1

Assim 1/λ é um autovalor de A e x é um autovetor tanto de A quanto de A .

5. Os resultados em (2.96) 2 (2.99) podem ser usados para obter autovalores e autovetores de um polinômio em A. Por exemplo, se λ é um autovalor de A, então

3

2

3

2

(A + 4A – 3A + 5I)x = A x + 4A x – 3Ax + 5x

3

2

= λ x + 4λ x – 3λx + 5x

3

2

= (λ + 4λ – 3λ + 5)x

3

2

3

2

Assim, λ + 4λ – 3λ + 5 é um autovalor de A + 4A – 3A + 5I, e x é o autovetor

correspondente.

Para certas matrizes, a propriedade (5) pode ser estendida para séries infinitas.

Por exemplo, se λ é um autovalor de A, então por (2.97), 1 – λ é um autovalor de

I – A. Se I – A é não-singular, então, por (2.100), 1/(1 – λ) é um autovalor de

–1

(I – A) . Se –1 < λ < 1, então 1/(1 – λ) pode ser representado pela série (de Fourier)

1

2

3

=1+λ+λ +λ +…

1− λ

Correspondentemente, se todos os autovalores de A satisfazem –1 < λ < 1, então

–1

2

3

(I – A) = I + A + A + A + …

(2.101)

2.12.3. Produtos

Similar ao comentário feito após a apresentação de (2.97), os autovalores de AB não

são produtos da forma λAλB. Entretanto, os autovalores de AB são os mesmos de BA.

Teorema 2.12A. Se A e B são nxn ou se A é nxp e B é pxn, então os autovalores

(não nulos) de AB são os mesmos daqueles de BA. Se x é um autovetor de AB então

Bx é um autovetor de BA.

Material elaborado pelo Prof. César Gonçalves de Lima

45

Teorema 2.12B. Seja A uma matriz nxn.

–1

(i) Se P é qualquer matriz não-singular nxn, então P AP tem os mesmos autovalores.

(ii) Se C é qualquer matriz ortogonal nxn, então C’AC tem os mesmos autovalores.

2.12.4. Matrizes simétricas

Teorema 2.12C. Seja A (nxn) uma matriz simétrica

(i) Os autovalores de A são números reais.

(ii) Os autovetores x1, x2, …,xn são mutuamente ortogonais; isto é, xi xj = 0 para i ≠ j

Teorema 2.12D. Se A é uma matriz simétrica com autovalores λ1, λ2, …,λn e autovetores normalizados x1, x2, …,xn então A pode ser expressa como

A = CDC’

=

(2.102)

n

∑ λ i x i x ti

(2.103)

i =1

onde D = diag(λ1, λ2, …,λn) e C é a matriz ortonormal C = [x1, x2, …,xn]. O resultado

mostrado em (2.102) ou (2.103) é chamado de decomposição espectral de A.

Ver prova nas pág. 46-47.

Corolário 1. Se A é uma matriz simétrica e C e D são definidas como no Teorema

2.12D, então C diagonaliza A, isto é,

C’AC = D = diag(λ1, λ2, …,λn)

(2.105)

Teorema 2.12E. Se A é uma matriz com autovalores λ1, λ2, …,λn então

(i) det(A) = | A | =

n

(2.106)

∏ λi

i =1

(ii) tr(A) =

n

∑ λi

(2.107

i =1

2.12.5. Matriz positiva definida e positiva semidefinida

Os autovalores λ1, λ2, λ3,…, λn de matrizes positiva definidas (semidefinidas) são

positivos (não negativos).

Material elaborado pelo Prof. César Gonçalves de Lima

46

Teorema 2.12F. Se A é uma matriz com autovalores λ1, λ2, …,λn então

(i) Se A é positiva definida então λi > 0 para i = 1, 2, …, n

(ii) Se A é positiva semidefinida então λi ≥ 0 para i = 1, 2, …, n. O número de

autovalores λi para os quais λi > 0 é igual ao posto de A.

Teorema A.5.2 Seja A uma matriz real e simétrica, n x n, e D = diag(λ1, λ2, ...,λn) é a

matriz diagonal que exibe as raízes características de A. Então:

a) λi > 0, ∀i ⇔ A é positiva definida.

b) λi ≥ 0, ∀i, ∃ λi = 0 ⇔ A é positiva semi-definida.

c) λi < 0, ∀i ⇔ A é negativa definida.

d) λi ≤ 0, ∀i, ∃ λi = 0 ⇔ A é negativa semi-definida.

e) λi muda de sinal ⇔ A é não definida.

Se uma matriz A é positiva definida, nós podemos encontrar a raiz quadrada

1/2

de A, denotada por A , como segue. Desde que os autovalores são positivos, nós podemos substituir a raiz quadrada λ i na decomposição espectral de A em (2.102)

para obter:

1/2

1/2

A = CD C’

(2.108)

1/2

onde D

dade:

= diag( λ1 , λ 2 , …,

1/2

A

1/2

λ n ). A matriz A

1/2

A

1/2

1/2

é simétrica e tem a proprie-

CD C’CD C’= A

(2.109)

2.13. MATRIZES IDEMPOTENTES

2

Uma matriz quadrada A é dita idempotente se A = A. Neste texto, muitas das matrizes idempotentes são quadradas. Muitas das somas de quadrados nas análises de regressão e de variância (Capítulos 11-14) podem ser expressas como formas quadráticas y’Ay. A idempotência de A ou de um produto envolvendo A será usada para estabelecer que y’Ay (ou um múltiplo de y’Ay) tem distribuição de qui-quadrado.

Teorema 2.13A. A única matriz não-singular idempotente é a matriz identidade.

Teorema 2.13B. Se A é singular, simétrica e idempotente então A é positiva semidefinida.

Material elaborado pelo Prof. César Gonçalves de Lima

47

Teorema 2.13C. Se A é uma matriz nxn, simétrica, idempotente e de posto r, então

A tem r autovalores iguais a 1 e n – r autovalores iguais a 0.

Teorema 2.13D. Se A é uma matriz nxn, simétrica, idempotente e de posto r, então

posto(A) = tr(A) = r.

Teorema 2.13E. Se A é uma matriz nxn idempotente, P é uma matriz nxn não

singular e C é uma matriz nxn ortogonal, então:

(i) I – A é idempotente.

(ii) A(I – A) = 0 e (I – A)A = 0

-1

(iii) P AP é idempotente

(iv) C’AC é idempotente (se A é simétrica, C’AC é uma matriz simétrica e idempotente).

–

Teorema 2.13F. Seja A uma matriz nxp de posto r, seja A qualquer inversa genera–

–

–

lizada de A e seja (A’A) uma inversa generalizada de A’A. Então A A, AA e

–

A(A’A) A’ são todas idempotentes.

Teorema 2.13G. Supondo que a matriz simétrica A nxn possa ser escrita como A =

∑i=1 A i para algum k, onde cada Ai é uma matriz simétrica nxn. Então, quaisquer

k

duas das seguintes condições implicam na terceira condição:

1. A é idempotente.

2. Cada A1, A2, …, Ak é idempotente.

3. AiAj = 0 para i ≠ j.

Teorema 2.13H. Se I =

se n =

∑i=1 A i , onde cada matriz Ai nxn é simétrica e de posto ri e

k

∑i=1 ri , então são verdadeiras as seguintes afirmações:

k

1. Cada A1, A2, …, Ak é idempotente.

2. AiAj = 0 para i ≠ j.

2.14 DERIVADAS DE FUNÇÕES LINEARES E FORMAS QUADRÁTICAS

Seja u = f(x) uma função das variáveis x1, x2, …, xp em x = [x1, x2, …, xp]’ e sejam

∂u / ∂x1 , ∂u / ∂x2 , …, ∂u / ∂x p as derivadas parciais.

Material elaborado pelo Prof. César Gonçalves de Lima

48

Nós definimos ∂u / ∂x como:

∂u / ∂x1

∂u ∂u / ∂x2

=

∂x M

∂u / ∂x p

(2.110)

Em alguns casos nós podemos encontrar um máximo ou um mínimo de u resolvendo

∂u / ∂x = 0.

Teorema 2.14A. Seja u = a’x = x’a , onde a’ = [a1, a2, …, ap] é um vetor de constantes. Então

∂u

∂ (a' x) ∂ (x' a)

=

=

=a

∂x

∂x

∂x

(2.111)

(Ver prova na pág. 51 do livro do Rencher).

Teorema 2.14B. Seja u = x’Ax, onde A é uma matriz simétrica de constantes. Então

∂u

∂ (x' Ax)

=

= 2Ax

∂x

∂x

(2.112)

(Ver prova nas pág. 51-52 do livro do Rencher).

Exemplo. Admitamos o modelo de regressão linear yi = β0 + β1xi + εi, para i = 1, …,

n, expresso matricialmente como y = Xβ + ε, onde:

y1 1 x1

ε1

y 1 x β

ε

2

2

0

=

+ 2

M M M β1 M

y n 1 x n

ε n

Procuraremos os estimadores de β0 e β1 que minimizam a soma de quadrados dos

desvios dos n valores observados de y em relação aos valores preditos ŷ :

n

n

∑ εˆi2 =

∑ ( yi − yˆ i )2

i =1

i =1

=

n

2

∑ (yi − βˆ0 − βˆ1 xi )

i =1

Matricialmente, nós temos que:

n

∑ εˆi2 = ε̂ε ’ ε̂ε = (y – X β̂β )’ (y – X β̂β ) = y’y – 2ββ̂β ’X’y + β̂β ’X’X β̂β

i =1

Para encontrarmos β̂

β que minimiza ε̂ε ’ ε̂ε , calculamos a diferencial de ε̂ε ’ ε̂ε em relação

aβ

β̂ . Observando que:

Material elaborado pelo Prof. César Gonçalves de Lima

49

∂

∂

(y’y) = 0 ⇒

(2 β̂

β ’X’y) = –2X’y,

∂β̂

∂β̂

β

β

∂

(β

β̂

β ’X’X β̂

β ) = 2X’X β̂

β,

∂β̂

β

por (2.111)

por (2.112)

Daí tem-se que:

∂εˆ ' εˆ

= – 2X’y + 2X’X β̂

β

∂βˆ

Igualando o resultado a um vetor de zeros, obtemos o sistema de equações normais:

X’X β̂

β = X’y