Teoria das Filas e Aplicações

Celso C. Ribeiro

Reinaldo Vallejos

PETROBRAS

Novembro 1998

Programa

...

Teoria da probabilidade

Variáveis aleatórias

Distribuições discretas

Distribuições contínuas

Variáveis aleatórias conjuntas e probabilidade

condicional

Teoria das filas

Cadeias de Markov discretas

Programa

…

Cadeias de Markov de tempo contínuo

Lei de Little

Aplicações da Lei de Little

Processos de nascimento e morte

Filas M/M/1

Filas M/M/C

Aplicações

Teoria da probabilidade

Teoria da probabilidade

Modelagem de fenômenos aleatórios

quantidades não previsíveis antecipadamente

variação inerente que deve ser considerada

Permitir que o modelo tenha natureza

probabilística modelo probabilístico

Teoria da probabilidade

Experimento cujo resultado não seja previsível

antecipadamente

Espaço amostral: S = {resultados possíveis}

Lançamento de uma moeda: S = {cara,coroa}

Lançamento de um dado: S = {1,2,3,4,5,6}

Lançamento de duas moedas: Acara, Bcoroa

S = {(A,A),(A,B),(B,A),(B,B)}

Vida útil de um carro: S = [0,)

Teoria da probabilidade

Evento: subconjunto E do espaço amostral S

E = {cara}, E = {coroa}

E = {2,4,6}: resultado do lançamento é par

E = {(A,A),(A,B)}: primeira moeda é cara

E = [1,2): carro dura pelo menos um ano sem

completar o segundo

Teoria da probabilidade

Eventos E e F

Evento união: EF

Evento interseção: EF

Evento vazio:

E e F mutuamente exclusivos: EF =

E ={cara}, F ={coroa}: ou dá cara, ou dá coroa

Evento complementar: Ec = S\E

Teoria da probabilidade

Espaço S, evento E

Probabilidade P(E) do evento E:

0 P(E) 1

P(S) = 1

E1E2 = P(E1E2) = P(E1) + P(E2)

P({cara}) = P({coroa}) = 1/2

Moeda viciada, com chance duas vezes maior

de dar cara: P({cara}) = 2/3, P({coroa}) = 1/3

Teoria da probabilidade

P({2,4,6}) = P({2}) + P({4}) + P({6}) =

= 1/6 + 1/6 + 1/6 = 1/2

Teoria da probabilidade

P(Ec) = 1 - P(E)

1 = P(S) = P(EEc) = P(E) + P(Ec)

EF

E

P(E) + P(F) = P(EF) + P(EF)

P(EF) = P(E) + P(F) - P(EF)

EF

EF = P(EF) = P(E) + P(F)

P(EFG) = P(E) + P(F) + P(G) - P(EF) - P(EG) - P(FG) + P(EFG)

F

Teoria da probabilidade

Probabilidade condicional: probabilidade de

que um determinado evento ocorra,

conhecendo-se a ocorrência de outro

Dois dados são lançados e todas os 36 pares de

resultados são equiprováveis. Qual é a

probabilidade da soma dos dois valores ser

igual a 10?

P({4,6}) + P({5,5}) + P({6,4}) = 31/36 =1/12

Teoria da probabilidade

Sabendo-se que a primeira observação é um 4,

qual é a probabilidade da soma dos dois

valores ser igual a 10?

Resultados possíveis, sendo 4 o primeiro valor:

(4,1), (4,2), (4,3), (4,4), (4,5), (4,6)

Se o primeiro valor é 4, a probabilidade

(condicional) de cada um destes pares é 1/6

Probabilidade dos 30 pares restantes: zero

Probabilidade da soma ser igual a 10: 1/6

Teoria da probabilidade

Probabilidade condicional do evento E dado

que o evento F ocorre:

F

E

P(E|F) = P(EF)/P(F)

EF

Teoria da probabilidade

Uma moeda é lançada 2 vezes. Qual é a

probabilidade condicional de que sejam

observadas duas caras, dado que pelo menos

uma cara é observada?

E = {(cara,cara)} = {(A,A)}

cara A

F = {(A,B),(B,A),(A,A)}

P(E|F) = P(EF)/P(F) = P({(A,A)})/

P({(A,B),(B,A),(A,A)}) = (1/4)/(3/4) = 1/3

Teoria da probabilidade

Uma urna contém sete bolas pretas e cinco

bolas brancas. Duas bolas são retiradas. Qual a

probabilidade de que ambas sejam pretas,

considerando-se que a primeira bola não é

devolvida para a urna após ser retirada?

F = primeira é preta E = segunda é preta

P(EF) = P(E|F) P(F) = 6/117/12 = 7/22

Teoria da probabilidade

Uma urna contém sete bolas pretas e cinco

bolas brancas. Duas bolas são retiradas. Qual a

probabilidade de que ambas sejam pretas,

considerando-se que, neste caso, a primeira

bola é devolvida para a urna após ser retirada?

F = primeira é preta E = segunda é preta

P(EF) = P(E|F) P(F) = 7/127/12 = 49/144

Teoria da probabilidade

Cada uma de três pessoas possui uma ficha de

cor diferente que é lançada em uma urna. Em

seguida, cada pessoa retira aleatoriamente uma

ficha da urna. Qual é a probabilidade de que

ninguém recupere sua ficha original?

Idéia: calcular a probabilidade do evento

complementar, isto é, de que pelo menos uma

pessoa recupere sua ficha original.

Teoria da probabilidade

Ei: i-ésima pessoa recupera sua ficha; i=1,2,3

P(Ei) = 1/3,

i=1,2,3

P(EiEj) = P(Ej|Ei) P(Ei) = 1/21/3 = 1/6 ij

P(E1E2E3) = P(E3|E1E2) P(E1E2) = 1/6

P(E1E2E3) = P(E1) + P(E2) + P(E3) - P(E1E2) - P(E1E3) - P(E2E3) +

+ P(E1E2E3) = 3 1/3 - 3 1/6 + 1/6 = 2/3

P(ninguém recuperar) = 1 - 2/3 = 1/3

Teoria da probabilidade

E e F independentes: P(EF) = P(E) P(F)

P(E|F) = P(E)

P(F|E) = P(F)

Teoria da probabilidade

Espaço amostral S, eventos E e F

E = ES = E(FFc) = (EF) (EFc)

EF e EFc mutuamente exclusivos

P(E) = P((EF)(EFc)) =

= P(EF) + P(EFc) =

= P(E|F) P(F) + P(E|Fc) P(Fc) =

= P(E|F) P(F) + P(E|Fc) (1-P(Fc))

Teoria da probabilidade

A primeira de duas urnas contém 2 bolas

brancas e 7 bolas pretas, enquanto a segunda

contém 5 brancas e 6 pretas. Uma moeda é

lançada e uma bola é retirada da primeira ou da

segunda urna, dependendo do resultado ter

sido cara ou coroa, respectivamente. Qual é a

probabilidade (condicional) de ter ocorrido

uma cara, dado que a bola retirada foi branca?

Teoria da probabilidade

Deseja-se calcular P(cara|branca)

P(cara|branca) = P(cara e branca) / P(branca) =

= P(branca|cara) P(cara) / P(branca)

P(branca) = P(branca|cara) P(cara) +

+ P(branca|coroa) P(coroa)

P(cara|branca) =

= 2/91/2/(2/91/2+5/111/2) = 22/67

Teoria da probabilidade

Um teste detecta com 95% de certeza uma

determinada doença, quando ela está presente.

Entretanto, este teste aponta “falsos positivos”

em 1% das pessoas que não contraíram a

doença. Sabendo-se que 0.5% da população

estão contaminados por esta doença, qual é a

probabilidade de que determinada pessoa tenha

a doença dado que o resultado de seu teste foi

positivo?

Teoria da probabilidade

Deseja-se calcular P(doente|positivo)

P(doente|positivo) = P(doente e positivo) /

/ P(positivo) =

= P(positivo|doente) P(doente) / P(positivo)

P(positivo) = P(positivo|doente) P(doente) +

+ P(positivo|sadia) P(sadia)

P(doente|positivo) =

0.950.05/(0.950.005+0.010.995) = 95/294

Teoria da probabilidade

Fórmula de Bayes:

eventos F1, F2, …, Fn mutuamente exclusivos

F1 F2 … Fn= S

P(E) = P(ES) = P(EF1) + … + P(EFn) =

= P(E|F1) P(F1) + … + P(E|Fn) P(Fn)

P(Fj|E) = P(EFj) / P(E) = P(E|Fj) P(Fj) / P(E)

P(Fj|E) = P(E|Fj) P(Fj) /

/ [P(E|F1) P(F1) + … + P(E|Fn) P(Fn)]

Teoria da probabilidade

Sabe-se que determinada carta está em uma de

três pilhas diferentes, com a mesma

probabilidade. A probabilidade da carta ser

encontrada examinando-se rapidamente a pilha

em que ela realmente está é 20%. Suponha que

a pilha 1 foi verificada, mas a carta não foi

encontrada. Qual a probabilidade da carta

efetivamente estar na pilha 1?

Teoria da probabilidade

Fi: carta está na i-ésima pilha; i=1,2,3

E: carta não encontrada na pilha 1

Deseja-se calcular P(F1|E)

P(F1|E) = P(E|F1) P(F1) /

/ [P(E|F1)P(F1)+P(E|F2)P(F2)+P(E|F3)P(F3)]

P(F1|E) = 0.81/3 / (0.81/3 + 11/3 + 11/3)=

= 0.8/2.8 = 2/7

Variáveis aleatórias

Variáveis aleatórias

Variável aleatória: função real definida sobre o

espaço amostral

soma dos valores obtidos após o lançamento de

dois dados

número de caras após um certo número de

lançamentos de uma moeda

tempo entre duas chegadas sucessivas a uma

fila

tempo de processamento de uma tarefa

Variáveis aleatórias

Valor de uma variável aleatória (v.a.) é

determinado pela saída de um experimento

é possível associar probabilidades aos

valores que podem ser assumidos por uma

X: v.a. definida pela soma dos valores obtidos

após o lançamento de dois dados

P{X=1} = P{} = 0

P{X=2} = P{(1,1)} = 1/36

P{X=3} = P{(1,2),(2,1)} = 2/36 = 1/18 ...

Variáveis aleatórias

Y: v.a. definida pelo número de caras

observadas após dois lançamentos de uma

moeda

P{Y=0} = P{(B,B)} = 1/4 Acara Bcoroa

P{Y=1} = P{(A,B),(B,A)} = 1/2

P{Y=2} = P{(B,B)} = 1/4

P{Y=0} + P{Y=1} + P{Y=2} = 1

Variáveis aleatórias

N: v.a. definida pelo número de lançamentos

de uma moeda até aparecer a primeira cara,

sendo p a probabilidade de observar-se cara em

cada lançamento

P{N=1} = P{A} = p

P{N=2} = P{(B,A)} = (1-p)p

P{N=3} = P{(B,B,A)} = (1-p)2p

…

P{N=n} = P{(B,B,…,B,A)} = (1-p)n-1p

Variáveis aleatórias

Função de distribuição acumulada (fda) ou

função de distribuição F(.) da v.a. X:

F(b) = P{X b}

- < b < +

F(b): probabilidade de que a v.a. X assuma um

valor menor ou igual a b

Propriedades:

F(b) é uma função não-decrescente de b

limbF(b) = F() =1, limb-F(b) = F(-) = 0

p{a<Xb} = P{Xb} - P{Xa} = F(b) - F(a)

Variáveis aleatórias

Variáveis aleatórias discretas: a v.a. assume um

número finito ou contável de valores possíveis.

Variáveis aleatórias contínuas: a v.a. assume

valores dentro de um contínuo de valores

possíveis.

Variáveis aleatórias discretas

Variáveis aleatórias discretas: a v.a. assume um

número finito ou contável de valores possíveis.

Função de massa de probabilidade:

p(a) = P{X=a}

Se X pode assumir os valores x1, x2,… então

p(xi) > 0, i=1,2,…

p(x) = 0, outros valores de x

Variáveis aleatórias discretas

Função de distribuição acumulada:

F(a) =

p(xi)

i=1,2,…: xi a

Exemplo: p(1) = 1/2, p(2) = 1/3, p(3) = 1/6

0,

a < 1,

F(a) = 1/2, 1 a < 2

5/6, 2 a < 3

1,

3a

Variáveis aleatórias discretas

F(a)

1

5/6

1/2

1

a

2

3

Variáveis aleatórias discretas

Seja X uma v.a. discreta. Então, seu valor

esperado é dado por:

E[ X ] x. p( x)

x: p ( x )0

Funções de variáveis aleatórias

g(X) função da v.a. X

Caso discreto: E[ g ( X )]

Caso contínuo: E[ g ( X )]

g ( x) p( x)

x: p ( x )0

g ( x) f ( x)dx

Exemplo: a,b R

E[a.X+b] = a.E[X] + b

Funções de variáveis aleatórias

Variância da v.a. X:

VAR[ X ] E[( X E[ X ]) ]

2

Pelo resultado anterior:

VAR[ X ] E[ X 2 2 X .E[ X ] E[ X ]2 ]

2

2

VAR[ X ] E[ X ] 2E[ X ].E[ X ] E[ X ]

2

2

VAR

[

X

]

E

[

X

]

E

[

X

]

Logo,

Funções de variáveis aleatórias

Variância da v.a. X:

VAR[X ] E[(X ) 2 ] E[X ]2

VAR[X ] E[ 2 X 2 ] E[X ]E[X ]

2

2

2

2

VAR[X ] E[ X ] E[ X ]

VAR[X ] (E[ X ] E[ X ] )

2

2

VAR[X ] VAR[ X ]

2

2

Funções de variáveis aleatórias

X e Y variáveis aleatórias independentes:

E[ g ( X )h(Y )] E[ g ( X )].E[h(Y )]

VAR[ X Y ] VAR[ X ] VAR[Y ]

Distribuições discretas

Distribuição de Bernoulli

Um experimento de Bernoulli tem somente

dois resultados aleatórios possíveis:

sucesso

fracasso

A variável aleatória que corresponde ao

experimento anterior é uma variável aleatória

de Bernoulli.

A notação de uma distribuição de Bernoulli é

Be(p), onde 0 p 1 é a probabilidade de

obter-se sucesso.

Distribuição de Bernoulli

Exemplos

Lançamento de uma moeda

Caso obtenha-se uma cara: sucesso

Caso obtenha-se uma coroa: fracasso

A direção que segue um veículo em uma

bifurcação (caminho A ou B)

Se segue o caminho A: sucesso

Se segue o caminho B: fracasso

(o resultado deste experimento é uma v.a. somente para um

observador externo, mas não para o condutor)

Distribuição de Bernoulli

Os resultados possíveis deste experimento podem ser

“mapeados” nos números reais, logo:

X v.a. Be(p) (X é uma variável aleatória

discreta do experimento de Bernoulli de

parâmetro p).

Domínio de X:

X {0, 1}

Função de massa de probabilidade:

P{X = 0} = P(0) = 1 - p

P{X = 1} = P(1) = p

Distribuição de Bernoulli

Função de distribuição acumulada:

lim F ( x h) P(X < x)

h 0

1 p,

F ( x)

1,

Valor esperado:

0 x <1

x 1

E[ X } p.1 (1 p).0 p

Distribuição de Bernoulli

Gráficos

Função de massa de probabilidade

p(X)

1

p

1-p

p

0

1

X

E[X]

2s X

Função de distribuição acumulada

F(X)

1

p

Graficos

3D

1-p

0

1

X

Distribuição de Bernoulli

Parâmetros

Considerando as funções anteriores tem-se

para Be(p):

Valor esperado

E [X

]

Variância

VAR

Desvio padrão

s

Função geradora de momento

f ( z)

n-ésimo momento

E X

p

[X ]

p (1 p )

p (1 p )

X

p

[ ]

n

( z 1) 1

p

Distribuição de Bernoulli

Exemplo em comunicações

info

T

R

Um pacote de informações é enviado pelo

transmissor ao receptor através de uma

conexão, sendo p a probabilidade de que o

pacote chegue corretamente ao receptor.

info chega corretamente a R: X = 1

info não chega corretamente a R: X = 0

Distribuição binomial

Considere n experimentos independentes

identicamente distribuídos (iid), cada um com

distribuição Bernoulli de parâmetro p.

Se a variável de interesse Y corresponde ao

número de sucessos obtidos nestes n

experimentos, então Y é conhecida como uma

variável aleatória binomial de parâmetros n e p.

Distribuição binomial

Sejam X1, X2, …, Xn, onde as variáveis {Xi},

i=1,2,…,n são v.a.’s iid Be(p). Seja a v.a. Y

definida por sua soma:

n

Y Xi

i 1

Y Bi(n, p)

Distribuição binomial

Uma distribuição binomial de parâmetros n e p se

denota Bi(n,p), onde:

n é o número de experimentos de Bernoulli

independentes realizados.

p é a probabilidade de obter um sucesso em

cada um dos n experimentos, 0 p 1.

Distribuição binomial

Exemplos

Uma moeda é lançada n vezes. Se em cada

lançamento se obtém cara (sucesso) com

probabilidade p, qual é a probabilidade de que

em 0 i n experimentos se obtenha sucesso?

Observam-se n veículos em uma bifurcação.

Cada veículo segue o caminho A (sucesso) com

probabilidade p. Qual é a probabilidade de que

0 i n veículos sigam o caminho A (sucesso)?

Distribuição binomial

Seja Y v.a. Bi(n,p) (Y é v.a. binomial de

parâmetros n e p), onde n N+ e 0 p 1

Domínio de X:

Y {0, 1, 2, …, n}

Função de massa de probabilidade:

n i

P{ Y i} P(i ) p (1 p) n i

i

, 0 i n

Função de distribuição acumulada:

n

P { Y i }

j 0 j

i

j

p (i p ) n j

, 0 i n

Distribuição binomial

Valor esperado:

n

n n

E[X]= ip (i ) i p i (1 p) ni

i 0

i 0 i

n

n!

i

n i

=

p (1 p)

i 1 ( n i )!(i 1)!

(n 1)!

np

p (i 1) (1 p) ni

i 1 ( n i )!(i 1)!

n

=

n 1 k

Seja k=i-1, então E[X]= np

p (1 p ) n1k

k 0 k

n 1

Como

n 1

k 0

n 1 k

n 1 k

1

p (1 p)

k

então, E[X]=np

Distribuição binomial

Parâmetros

Considerando-se as funções anteriores tem-se

para Bi(n, p):

Valor esperado

E [Y

]

Variância

VAR

Desvio padrão

sY

Função geradora de momento

f ( z)

n-ésimo momento

E [Yk ]

np

[Y ]

np ( 1 p )

np ( 1 p )

( p ( z 1 ) 1)

f (k) ( 1)

n

Distribuição binomial

Observando-se a esperança e a variância da

distribuição binomial se verifica que correspondem

à soma de v.a.’s iid com distribuição de Bernoulli.

A transformada Z de uma fmp corresponde à sua

função geradora de momento:

P( z ) Pn z

n 0

n

;

dP(z )

nPn E[ X ]

dz z 1 n0

Distribuição binomial

Gráficos

P(Y = y)

Função de massa de probabilidade

Bi(10,0.7)

sY = 1.449

0.3

0.2

0.1

E[Y]=7

0

0

5

y

E[Y]

2sY

10

Graficos

3D

Distribuição binomial

Gráficos

Função de massa de probabilidade

Bi(10,0.5)

P(X=x)

0.3

0.2

0.1

0

0

2

4

6

8

10

12

x

Função de distribuição acumulada

Bi(10,0.5)

P(X<=x)

1.5

1

0.5

0

0

2

4

6

x

8

10

12

Distribuição binomial

Gráficos

Função de massa de probabilidade

Bi(10,0.7)

P(X=x)

0.3

0.2

0.1

0

0

2

4

6

8

10

12

x

P(X<=x)

Função de distribuição acumulada

Bi(10,0.7)

1.5

1

0.5

0

0

2

4

6

x

8

10

12

Distribuição binomial

Gráficos

Função de massa de probabilidade

Bi(10,0.5)

P(X=x)

0.3

0.2

0.1

0

0

2

4

6

8

10

12

x

Função de distribuição acumulada

Bi(10,0.5)

P(X<=x)

1.5

1

0.5

0

0

2

4

6

x

8

10

12

Distribuição binomial

Gráficos

P(X=x)

Função de massa de probabilidade

Bi(15,0.5)

0.25

0.2

0.15

0.1

0.05

0

0

5

10

x

15

20

Função de distribuição acumulada

Bi(15,0.5)

P(X<=x)

1.5

1

0.5

0

0

5

10

x

15

20

Bi (10,p)

0,4

0,35

0,3

0,25

Bi (10,p)

0,2

0,15

0,1

0,05

0

0

1

2

3

p=0.9

4

i

p=0.6

5

p=0.3

6

7

p=0.1

8

9

10

Graficos

3D

Distribuição binomial

Com relação à fmp de uma binomial tem-se que:

valor máximo se encontra em X = E[X] = np

estritamente decrescente para X > E[X]

simétrica em relação a p (e.g., p = 0.1 e p = 0.9)

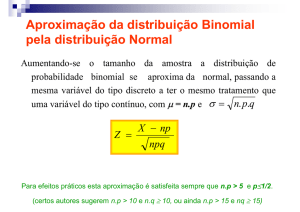

Pelo teorema do limite central:

a v.a. da soma infinita de experimentos

independentes (com qualquer distribuição) tende à

distribuição gaussiana

Distribuição binomial

Exemplo em comunicações

infon

T

...

info2

info1

R

n pacotes de informação são enviados pelo

transmissor ao receptor através de uma

conexão. A probabilidade de cada um dos

pacotes chegar corretamente a R é igual a p.

Qual é a probabilidade de que 0 i n pacotes

de informação enviados cheguem corretamente

ao receptor?

Distribuição binomial

Exemplo em comunicações

infon

T

...

info2

info1

R

n: número de pacotes enviados

p: probabilidade de cada pacote chegar

corretamente

Y = i: número de pacotes enviados que

chegarão corretamente, 0 i n

Y v.a. ~ Bi(n,p), n {0,1,2,3, ...}

n i

P{ Y i} P(i ) p (1 p) n i

i

, 0 i n

Distribuição binomial

Exemplo em tolerância a falhas

Vários computadores executam um mesmo

algoritmo. O resultado final do algoritmo se

determina por votação dos computadores, por

maioria simples. Por exemplo, se o resultado

de dois ou mais computadores coincide, então

esse é o resultado final. Cada computador tem

probabilidade de falha igual a 1-p. Para que

valores de p convém escolher 1, 3 ou 5

computadores?

Distribuição binomial

Exemplo em tolerância a falhas

n: número total de computadores

X: número de computadores funcionando

corretamente (fornecem o resultado correto)

X v.a. ~ Bi(n,p), n {1,3,5}

Por exemplo: probabilidade de sucesso do

sistema com n computadores (maioria

proporciona o resultado correto)

m = ((n-1)/2)+1: número mínimo de

computadores (n ímpar) que devem dar o

resultado correto para o sistema ter sucesso

Distribuição binomial

Exemplo em tolerância a falhas

Para n {1,3,5}:

n i

n i

P( X m) p (1 p)

i m i

n

Caso n = 1

Caso n = 3

Caso n = 5

Pe = p

1

Pe3=

Pe5=

3 2

3 3

p (1-p) +

p

2

3

()

()

2

5 3

5 4

p (1-p) + 5 p5

p (1-p) +

3

4

5

()

()

()

Distribuição binomial

Exemplo em tolerância a falhas

Probabilidade de sucesso

do sistema

Probabilidade de sucesso

1.2

1

0.8

Pe1

Pe3

Pe5

0.6

0.4

0.2

0

0

0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9

Probabilidade de sucesso de cada

computador

1

Distribuição geométrica

Considere n experimentos de Bernoulli

independentes, cada um com probabilidade de

êxito p

X v.a. Ge(p) representando o número de

tentativas até conseguir o primeiro êxito

Função de massa de probabilidade:

PX n p(n ) (1 p ) p n 1,2,...

n 1

Função de distribuição:

n

F(n) (1-p) p

k 1

k -1

Distribuição geométrica

Valor esperado:

n 1

E[X]= n1 n(1 p) p

Fazendo q = 1 - p:

E[X]

1

Logo, E[X]= p

=

d

p (q n )

n 1 dq

=

d k

p qq

dq k 0

=

p

(1 q ) 2

=

=

d n

p q

dq n1

p

d q

dq 1 q

Distribuição geométrica

Exemplo: lançar a moeda até o primeiro êxito

Êxito = cara

Fracasso = coroa

Exemplo: número de automóveis não

específicos até que um siga o caminho A da

bifurcação

Êxito = A

Fracasso = B

Experimentos independentes

Distribuição geométrica

F(n)

1

0.9

0.8

Função de distribuição

0.7

0.6

0.5

p=0.2

0.4

0.3

0.2

Função de massa de probabilidade

0.1

0

0

F(n)

5

10

15

20

n

25

1

0.9

Função de distribuição

0.8

0.7

0.6

p=0.6

0.5

0.4

0.3

Função de massa de probabilidade

0.2

0.1

0

0

5

10

15

20

n

25

Distribuição geométrica

p(n)

0,3

0,3

0,25

0,25

p = 0.3

0,2

E[X]=3,33

p = 0.3

sx=2.79

0,2

0,15

0,15

0,1

0,1

0,05

0,05

0

1

0

1

2

3

2

3

4

E[X]

4

5

5

6

6

7

7

8

8

9

10 11 12 13 14 15 16 17 18 19 20

9

10 11 12 13 14 15 16 17 18 19 20

n

Distribuição geométrica

p(n)

Função de massa para distintos valores de p

0,9

0,8

0.1

0.5

0,7

0.9

0,6

0,5

0,4

0,3

0,2

0,1

0

1

2

3

4

5

6

7

8

9

n

10

Distribuição geométrica

0,9

0,8

0,7

0,6

P{X=n}

0,5

0,4

0,3

0,2

0.9

0.7

0,1

0.5

0

1

3

0.3

5

7

9

n

11

13

0.1

15

17

19

p

Distribuição geométrica

0,25

P{X=n}

0,2

0,15

0,1

0,05

1

0,8

0

2 3

4 5

n

0,6

6

0,4

7

8

9

0,2

10

11

12

13

0

14

15

p

Distribuição geométrica

P{X=n} decai mais rápidamente com n quando

p aumenta

Distribuição em função de p varia com n:

para n = 1 é una reta crescente

para n < 7 é crescente e logo decresce

para n 7 é decrescente

Função de massa tem dois pontos degenerados:

p = 0: necessárias infinitas tentativas (nunca se

consegue êxito)

p = 1: êxito sempre é conseguido na primeira

tentativa.

Distribuição geométrica

Parâmetros

E[X

]

V A R [X

s

X

f (t)

1

p

(1

]

1

p

p

p2

(1

)

p

pet

1 (1 p ) e

)

t

Propriedade: falta de memória

Elevador em um prédio de três andares

Estado #n : elevador no andar n

Sem memória: estados #1 e #3

Com memória: estado #2

Propriedade: falta de memória

Exemplo relacionado com a distribuição

geométrica, duas situações equivalentes:

Propriedade: falta de memória

Distribuição geométrica caracterizada pela

seguinte propriedade:

P( x s t | x > t ) P( x s )

A informação de nenhum sucesso até a

tentativa t é “esquecida” nos cálculos

subseqüentes.

Propriedade: falta de memória

Propriedade: falta de memória

P( x s t x t )

Demonstração: P( x s t | x t )

P( x t )

P( x s t )

Logo, P( x s t | x t )

P( x t )

Propriedade: falta de memória

P( x s t )

Substituindo-se

(1 p)

i 1

p (1 p)

s+t 1

i s t

P( x t )

(1 p)

i 1

p (1 p)

t

i t 1

(1 p )s t 1

s 1

(

)

1

p

Logo, P( x s t| x t )

(1 p )t

com

i 1

P( x s) (1 p) p (1 p)

s1

is

portanto P( x s t | x > t ) P( x s)

propriedade de

falta de memória

Protocolo Stop & Wait

Protocolo de retransmissão mais simples

Idéia básica: ter certeza de que cada pacote

transmitido é recebido corretamente antes de

transmitir o seguinte

Protocolo half-duplex

Retransmissão devido a:

erro na recepção do pacote

time-out

Protocolo Stop & Wait

Numeração de pacotes:

Se ocorre time-out no transmissor, retransmite

pacote i

Receptor não sabe distinguir se é uma

retransmissão do pacote i ou uma primeira

transmissão do pacote i+1

Logo, necessidade de numerar os pacotes,

assim como os acks/nacks

Numeração módulo 2 é suficiente

Esquema físico

tI

Tx

tP

Rx

tAck

Definições:

ti

= tempo de transmissão de um pacote

tp = tempo de propagação

tout = tempo máximo de espera de um reconhecimento

(ack/nack)

tproc= tempo de processamento do pacote

Diagrama temporal

Caso 1

Retransmissão por time-out

t

Tx

t

t out

i

proc Tx

t

F1

F1

F2

A1

Rx

tp

t

t proc Rx

Caso 2

Retransmissão por erro

ti

Tx

t

proc

Tx

t

F1

F1

N1

F2

A1

Rx

tp

t

t

proc Rx

Fi = transmissão do frame i

Ni = mensagem de frame i recebida com problemas

Ai = reconhecimento do frame i

Diagrama de transição de estados

Transmissor

Receptor

+ : Entradas

- : Saídas

Q2

+M1

Q0

+Ack 1

Q2

+M0

+Error

-Error

Q0

Q1

-M0

Q4

-M1

+Error

-Ack

Q3

+M0

Q1

+Ack 0

Q0: Transmite Mensagem 0

Q1: Espera Ack 0

Q2: Transmite Mensagem 1

Q3: Espera Ack 1

-Ack

Q3

+M1

-Error

Q5

Q0: Espera Mensagem 0

Q1: Transmite Ack 0

Q2: Transmite Erro

Q3: Espera Mensagem 1

Q4: Transmite Ack 1

Q5: Transmite Erro

Tabelas de transição de estados

Transmisor

Estado

Q0

Q1

Q1

Q2

Q3

Q3

Error:

Entrada

Ack 0

Erro

Ack 1

Erro

Receptor

Saída

Prox. Estado

Mensagem 0

Q1

Q2

Q0

Mensagem 1

Q3

Q0

Q2

Devido a erro de bits no frame,

ou erro devido a Timeout

Q0: Transmite Mensagem 0

Q1: Espera Ack 0

Q2: Transmite Mensagem 1

Q3: Espera Ack 1

Estado

Q0

Q0

Q1

Q2

Q3

Q3

Q4

Q5

Entrada

Mensagem 0

Mensage m1

Saída

Ack 0

Erro

Mensagem 0

Mensagem 1

Q0: Espera Mensagem 0

Q1: Transmite Ack 0

Q2: Transmite Erro

Q3: Espera Mensagem 1

Q4: Transmite Ack 1

Q5: Transmite Erro

Ack 1

Erro

Prox. Estado

Q1

Q2

Q3

Q0

Q5

Q4

Q0

Q3

Medidas de desempenho

Desempenho pode ser avaliado sob dois pontos

de vista:

do usuário:

menor tempo de resposta

menor buffer

do sistema:

máximo throughput

menor memória

Espaço

Tempo

Usuário

Buffer

Sistema

Memória

tempo de

resposta

Throughput

Máximo throughput

Transmissor sempre dispõe de pacotes para

transmitir

Time-out é o menor possível

Tout = 2Tp + Tack

Existem erros

Pe > 0 existem retransmissões

0

I1

I2

I3

In

tT

tT

tT

tT

p

p

p

(1-p)

Definições:

Ii = i-ésima tentativa de transmitir o pacote

tT = ti + tout = ciclo de operação

p = probabilidade de receber o pacote com erro

n = número de tentativas até transmitir um pacote

pa= probabilidade de transmissão correta na

n-ésima tentativa

tu = tempo utilizado nas n tentativas

E[t] = tempo médio de recepção com sucesso (1)

t

Diagrama de lógica temporal

F1

F1

F1

F1

t

Errado

p

Errado

1-p

p

Errado

1-p

Correto

p

Errado

1-p

Correto

p: probabilidade de erro no pacote

Correto

Máximo throughput

Certamente,

max

1

E[t ]

Por definição de valor médio

Da figura anterior: (3)

(2) E[ t ] t( n) p( n)

n1

t(n) n t T

Como n é uma v.a. com distribuição Ge(1-p):

(4) p(n) p

n 1

(1 p)

Máximo throughput

Substituindo-se (2), (3) e (4) em (1), obtém-se:

E[ t ] n t p (1 p)

n 1

n 1

T

Simplificando (4):

tT

E[t]

(1 p )

Por definição:

max

1 (1 p) (1 p)

E[t ]

tr

a ti

com

tT

a 1

ti

Throughput normalizado

Transmissão

0

p

1-p

p

p

p

1-p T

Transmissão

efetiva

T

0

ti

(1 p)

a

1

lim Tempo em transmissoes efetivas

ti

T

T

Máximo throughput

O throughput normalizado pode ser

interpretado como a percentagem do tempo

ocupado na transmissão efetiva de pacotes

Se o tempo para receber um ack ou um nack é

desprezível, também o é o time-out:

a = 1 = (1- p)

max=F(p,a)

p

a

a=1 : Rede da área local

a=3 : Rede com enlaces menores a 500 Km

a=10 : Rede de enlace satelital

max=F(p,a)

a=1

a=1,4

a=1,8

a=2,1

max=F(p,a)

p=0

p=0.2

p=0.4

p=0.6

Distribuição de Poisson

X v.a. discreta com domínio e com a

seguinte função de massa de probabilidade:

i

P X = i = e

,i 0

i!

X: distribuição de Poisson com parâmetro

Função de distribuição de probabilidade:

i

n

P X n = e

,n 0

i!

i 0

Distribuição de Poisson

P{X=i}

Função de massa de probabilidade

0,1

0,08

0,06

0,04

0,02

0

0

5

10

15

20

i

25

30

35

40

Distribuição de Poisson

Função de distribuição de probabilidade

P X n

1,2

1

0,8

0,6

0,4

0,2

0

0

5

10

15

20

n

25

30

35

40

Distribuição de Poisson

1,2

= 20

1

0,8

Fn. de distribuição

0,6

Fn. de massa

0,4

0,2

0

0

5

10

15

20

25

30

35

40

Distribuição de Poisson

P{X=i}

Função de massa de probabilidade

0,4

0,35

0,3

0,25

0,2

0,15

0,1

0,05

0

0

5

10

15

20

25

30

35

40

i

Distribuição de Poisson

Valor esperado:

ie

E[X] = i 0

i

i!

i 1

= e i1

(i 1)!

Fazendo k = i - 1:

E[X] =

Como k 0

k

k!

E[X] =

e

e

k 0 k!

k

Distribuição de Poisson

Parâmetros

E[X ]

Var[X ]

sx

j (t)

(e t 1 )

e

Processo de contagem

Processo estocástico {N(t), t 0} é de

contagem se N(t) representa o número total de

eventos que ocorrem entre (0,t]

Por definição, N(t) satisfaz:

N(t) 0

N(t) assume valores inteiros

s < t N(s) N(t)

s < t N(t) - N(s) = número de eventos durante o

intervalo (s,t]

Processo de contagem

Número de pessoas que entraram

em um supermercado no intervalo de

tempo (0,t]

Número de veículos que entraram em

um túnel num intervalo dado

Número de gols que um

determinado jogador fez num

determinado intervalo (0,t]

Processo de contagem

Incrementos independentes: processo de

contagem no qual o número de eventos

ocorridos em intervalos de tempos disjuntos

são independentes

Exemplo: o processo de contagem no

intervalo (5,10] não depende do processo de

contagem em (0,5]

Processo de contagem

Incrementos independentes

Número de pessoas que entraram em

um supermercado num intervalo de tempo

Incrementos não-independentes

Número de nascimentos num intervalo de

tempo, quando existe controle da natalidade

Processo de contagem

Incrementos estacionários: número de eventos

em (t1+s,t2+s] depende somente da amplitude

do intervalo (t2-t1)

Ou seja, N(t2+s)-N(t1+s) tem a mesma

distribuição que N(t2)-N(t1), onde t2 > t1 e

s>0

0

t1

t2

s+t1

s+t2

Processo de contagem

Incrementos não-estacionários

A

quantidade de ligações telefônicas é

maior em determinadas horas do dia

Incrementos estacionários

Número de veículos que entram

em um túnel num ano

Processo de Poisson

N(t) é um processo de Poisson se:

N(t) é um processo de contagem

N(0) = 0 (reset)

Tem incrementos independentes e estacionários

- t i

Número de eventos em qualquer intervalo

de amplitude t é distribuído como uma

variável de Poisson com média t, ou seja:

-t

i

e (t )

P{N(t s) - N(s) = i } =

, i = 0,1,; s, t 0

i!

e (t)

Processo de Poisson

A última condição implica em incrementos

estacionários

N(t) não se refere apenas a uma variável

aleatória com uma distribuição de Poisson,

mas sim que para cada t > 0 se tem uma v.a.

com uma distribuição de Poisson de parâmetro

t (dependente de t)

Esta coleção (infinita) de variáveis aleatórias é

conhecida como um processo de Poisson

Processo de Poisson

Tempo entre chegadas

Seqüência {Tn, n=1,2,...}, onde Tn representa

o tempo entre o evento (chegada) n e o evento n-1

Eventos (contagem do P.P.)

0

t1

T1

t2

T2

t3 · · · tn-1

T3

· · ·

tn

Tn

Conjunto de v.a.s com distribuição Exp()

Processo de Poisson

Tempo entre chegadas

Evento {T1 > t } significa que não aconteceu

chegada alguma do processo de Poisson no

intervalo (0,t]

P{T1 > t} = P{N(t) = 0} = e-t

Além disso,

P{T2>t | T1=s} = P{0 eventos em (s,s+t]} = e-t

Repetindo-se o experimento, conclui-se que Tn,

n=1,2,... são v.a. exponenciais independentes e

identicamente distribuídas