1

Parte I

1. Inferência Estatística

Trata-se do processo de se obter informações sobre uma população a partir dos

resultados observados numa amostra.

De um modo geral, tem-se uma população com um grande número de elementos e

deseja-se, a partir de uma amostra dessa população, “conhecer o mais próximo possível”

algumas características da população.

Toda conclusão tirada por uma amostragem, quando generalizada para a população, virá

acompanhada de um grau de incerteza ou risco.

Ao conjunto de técnicas e procedimentos que permitem dar ao pesquisador um grau de

confiabilidade, de confiança nas afirmações que faz sobre a população, baseados nos resultados

provenientes de uma amostra, damos o nome de Inferência Estatística.

O problema fundamental da estatística é, portanto, medir o grau de incerteza ou risco

dessas generalizações. Os instrumentos da Inferência Estatística permitem a viabilidade das

conclusões por meio de afirmações estatísticas.

1.1. Definições importantes

- População é uma coleção completa de todos os elementos a serem estudados. (valores,

pessoas, medidas, etc). A população é o conjunto Universo, podendo ser finita ou infinita.

- Finita - apresenta um número limitado de observações, que é passível de contagem.

- Infinita - apresenta um número ilimitado de observações que é impossível de contar e

geralmente.

Exemplos:

– Todos as cabeças de gado criados em confinamento;

– Todas as plantas de uma determinada cultivar de milho;

– Todos os estudantes da UFVJM.

- Amostra é uma subcoleção de elementos extraídos de uma população e deverá ser considerada

finita. A amostra deve ser selecionada seguindo certas regras e deve ser representativa, de modo

que ela represente todas as características da População. Se esses elementos são selecionados de

tal maneira que cada um deles tenha a mesma chance de ser selecionado, temos uma Amostra

Aleatória.

- Parâmetro é uma medida numérica que descreve uma característica de uma população.

Geralmente é representada pela letra grega θ. Alguns parâmetros recebem nomes especiais. A

2

média (µ), a variância (σ2) e o coeficiente de correlação (ρ) são exemplos de parâmetros

populacionais.

- Estimador: também chamado “estatística de um parâmetro populacional” é uma medida

numérica que descreve uma característica determinada na amostra, uma função de seus

elementos. Genericamente, é representada por θ. A média amostral () e a variância amostral

(s2) são exemplos de estimadores.

Os estimadores são funções de variáveis aleatórias e , portanto, eles também são variáveis

aleatórias, desta forma, eles também possuem distribuições de probabilidade associadas.

- Estimativa: aos valores numéricos assumidos pelos estimadores, denominamos estimativas.

POPULAÇÃO

PARÂMETROS

AMOSTRAS

ESTIMADORES

2. Distribuição Amostral

Como foi visto, o problema da Inferência Estatística é fazer uma afirmação sobre os

parâmetros da população por meio de amostras.

2.1. Distribuição Amostral da Média

Suponha uma população identificada pela variável aleatória X, cujos parâmetros média

populacional e variância são supostamente conhecidos. Vamos

retirar todas as amostras possíveis de tamanho n dessa população e para cada uma delas,

calcular a média .

Vamos supor a seguinte população {2,3,4,5} com média 3,5 e variância 1,25.

Vamos relacionar todas as amostras possíveis de tamanho 2, com reposição, desta

população.

(2,2)

(2,3)

(2,4)

(2,5)

(3,2)

(3,3)

(3,4)

(3,5)

(4,2)

(4,3)

(4,4)

(4,5)

3

(5,2)

(5,3)

(5,3)

(5,5)

Agora, vamos calcular a média de cada amostra. Teremos:

2,0

2,5

3,0

3,5

2,5

3,0

3,5

4,0

3,0

3,5

4,0

4,5

3,5

4,0

4,5

5,0

Por fim, vamos calcular a média das médias, ou seja,

2,0 2,5 5,0

16

Agora, vamos calcular a variância:

1

1

1

2,0 3,5 2,5 3,5 5,0 3,5

Sendo assim, !"#$

, em que n é o tamanho das amostras retiradas da

população. No nosso exemplo,

1,25

2

______________________________________________________________________

Teorema: para amostras casuais simples , , … , retiradas de uma população com média

e variância , a distribuição amostral da média distribuição normal com média e variância

,.

1 2 , aproxima-se de uma

Dessa forma:

2

e Logo, o desvio padrão amostral é dado por

Assim, se ~0 1;

,3

4 ~0 1;

,3

,

√

.

5 6 1.

Para padronizar a variável aleatória, temos:

4

4 7~00; 1

√

7

____________________________________________________________________________

2.2. Distribuição amostral da proporção

Outro parâmetro populacional de interesse em estudos estatísticos é a proporção (p).

Exemplo: para detectar o apoio popular a um projeto governamental de reforma agrária, foram

entrevistadas 400 pessoas espalhadas em varias capitais. A amostra consiste das 400 pessoas

que responderam sim (concordam com o projeto) ou não (discordam).

Neste caso, a informação desejada é a PROPORÇÃO das pessoas que concordam com o

referido projeto. Então, o parâmetro de interesse é p (proporção) e seu estimador é dado por:

8̂ Genericamente,

8̂ ú;<= >< <?<@AB?>=B CD< 8=@; = 8=E<?=

400

ú;<= >< A?<B G=; GG?<íB?AGB ;=B?

em que n é o tamanho da amostra. ,

Quando 4 ∞, 8̂ J 0 18;

KLK

3

em que 8̂ 8 e 8̂ KLK

.

Note que a variância da proporção amostral é a variância da população dividida pelo

número de elementos na amostra, e para n grande,

7

8̂ 8

M81 8

J 00,1

Exemplo dado em sala de aula.

3. Teoria da Estimação

3.1. Propriedades dos Estimadores

Algumas propriedades dos estimadores são desejáveis no processo de inferência. A escolha de

um estimador de um parâmetro θ qualquer em detrimento de outro, depende de uma criteriosa

avaliação dessas propriedades. São elas:

5

(a) Ausência de Vício (viés)

Um estimador θ é não viciado ou não viesado para um parâmetro θ se NθO θ. Em

outras palavras, um estimador é não viciado se seu valor esperado coincide com o

parâmetro de interesse.

(b) Consistência

Um estimador θ é consistente se à medida que o tamanho da amostra aumenta, seu valor

esperado converge para o parâmetro de interesse e sua variância converge para zero. Ou

seja, θ é consistente se as duas propriedades são satisfeitas:

(i)

(ii)

lim4Q NθO θ

lim4Q NθO 0

Note que na definição de consistência estamos implicitamente usando o fato de que o

estimador depende de n, o tamanho da amostra. Na definição de vício, o resultado deve

valer para qualquer que seja o valor de n, isto é, NθO θ 5 n.

(c) Eficiência :Um estimador eficiente θ é aquele, dentre os estimadores não viciados de θ,

que possui a menor variância. Dados dois estimadores θ e θ não viesado para um

parâmetro de interesse θ. Dizemos que θ é mais eficiente que θ se θ S

θ .

Em todas as áreas do conhecimento existe a necessidade de se obter conclusões a respeito

dos parâmetros de uma população. Para tanto, é necessário estimar os parâmetros em questão.

Existem dois tipos de estimação: a estimação pontual e a estimação intervalar.

3.2. Estimação Pontual:

Quando a estimativa de um parâmetro é representada apenas por um valor. A principal

desvantagem é que a estimativa pontual é pouco informativa. Ela não fornece nenhuma idéia do

erro que se comete ao assumir o valor da estimativa como igual ao verdadeiro valor do

parâmetro desconhecido.

O Método da Máxima Verossimilhança:

O método da Máxima Verossimilhança foi introduzido por R.A. Fisher em 1922. Esse

método exige que a função de verossimilhança seja conhecida ou pressuposta.

A função de verossimilhança é a distribuição de probabilidade da amostra aleatória dada,

em geral, pelo produtório das distribuições de probabilidade individualmente.

6

Para apresentar o conceito vamos considerar , , … , uma amostra de uma população

com densidade TU, determinada pelos parâmetros V , A 1,2,3 … , W. Inicialmente, vamos

considerar a situação específica de apenas um parâmetro V W 1.

Para uma amostra aleatória particular , , … , , o

estimador de máxima

verossimilhança, θ, do parâmetro V é aquele que maximiza a função de verossimilhança

conjunta de , , … , .

Pelo fato de os valores amostrais , , … , , é possível definir a densidade conjunta da

função de verossimilhança X pelo produtório das densidades de cada , A 1,2,3 … , .

Assim, a função de verossimilhança PE dada por:

X T T T Y T O estimador de máxima verossimilhança (EMV) é aquele que maximiza X. Para obtermos

tal estimador, basta tomarmos a primeira derivada de X em relação ao parâmetro V, igualar a

zero e resolver para V. Quando se tem mais de um parâmetro, tomam-se as derivadas parciais de

X com respeito a cada um deles, iguala-se cada derivada a zero e resolve-se o sistema formado,

obtendo-se o EMV dos parâmetros.

Algumas propriedades matemáticas da função X garantem a possibilidade de se usar a

função suporte Z lnX em seu lugar, já que apresentam o mesmo máximo para o valor de V.

Isso é feito para facilitar a obtenção do máximo, uma vez que o produtório se transforma em

somatório.

Exemplo em sala

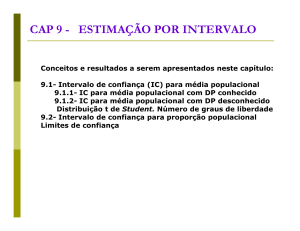

3.3. Estimação Intervalar

A estimação pontual não fornece a idéia da margem de erro que se comete ao estimar um

parâmetro de interesse. A estimação por intervalo procura corrigir essa lacuna a partir da criação

de um intervalo que garanta uma alta probabilidade de conter o verdadeiro valor do parâmetro

desconhecido.

Uma da maneira de se expressar a precisão da estimação é estabelecer limites da forma

[a,b], que com certa probabilidade, incluam o verdadeiro valor do parâmetro de interesse.

Sendo assim, a estimação por intervalo consiste na fixação de dois valores, a e b, tais que

1 [ seja a probabilidade de que o intervalo, por eles determinado, contenha o real valor de

V.

O intervalo [a,b] pode ser constituído a partir das distribuições amostrais. Ou seja,

utilizando as distribuições de amostragem, podemos obter expressões do tipo:

\ S S ] 1 [

7

\ S S ] 1 [

Tais expressões podem ser interpretadas da seguinte maneira: Existe 100(1- [)% de

confiança que o verdadeiro valor de ou (

) esteja contido no intervalo [a,b].

Logo, [a,b] pode ser considerado uma estimativa para ou (

) em que a probabilidade

(1- [) ou 100(1- [)% expressa o grau de confiança que se tem na estimação.

Se [a,b] é uma estimativa com 100(1- [)% de confiança para θ, então,

i.

O intervalo [a,b] é chamado intervalo de confiança para θ.

ii.

a e b são chamados “limite inferior” e “limite superior” do intervalo de confiança

para θ.

iii.

iv.

3.3.1.

A probabilidade (1- [) = 100(1- [)% é chamada coeficiente de confiança.

A probabilidade [ é chamada nível de significância.

Intervalo de Confiança para a média populacional (^) com variância (_` )

conhecida.

Seja ~0 1;

,3,

logo, ~0 1;

Assim,

7

,3

então, o desvio padrão amostral é dado por

,

√

~00; 1

√

Então temos que,

Sendo assim, o intervalo com 1-α ou 100(1- [)% de confiança para com conhecida é:

.

8

e f[ h

abLc d

g

2

√

e f[ h

;

g

2

√

i

Obs: os níveis de confiança de confiança mais usados são:

1-α = 90%

1-α = 95%

1-α = 99%

fcg j1,64

fcg j1,96

fcg j2,58

Exemplo dado em sala

3.3.2.

Distribuição t de Student

Foi visto que ~0 1;

,3

e que 7 $Lm

n

√o

~00; 1.

No entanto, quando não se conhece a variância populacional, situação mais comum na

prática, se as amostras forem pequenas (n < 30) e s2 (variância da amostra), sujeita a variação

amostral for utilizada como estimador de , os valores estandartizados, de uma população

normal:

?p B ~?L

√

Em palavras, ?p segue uma distribuição t com (n-1) graus de liberdade.

Características da distribuição t

- simétrica em relação a media;

- forma de sino;

- quando 4 ∞, a distribuição t se torna equivalente a distribuição normal;

- possui (n-1) graus de liberdade.

3.3.3. Intervalo de Confiança para a média populacional (^) com variância (_` )

desconhecida.

Um intervalo com 1-α ou 100(1- [)% de confiança para será:

B

B

e ?1; [ h

e ?1; [ h i

;

abLc d

g2

g2

√

√

em que:

s é o desvio padrão amostral

?L; cg é o valor tabelado da distribuição t de Student.

9

Exercícios

1. Por meio de uma amostra aleatória simples referente ao numero de ocorrências

criminais num certo bairro na cidade de São Paulo, coletada durante 30 dias, obteve-se

os seguintes valores:

7

8

8

11

10

6

8

14

8

9

12

13

10

14

10

14

12

14

6

9

5

8

11

14

8

13

10

7

13

10

Construa um intervalo de confiança com:

a) 90%

b) 95%

c) 99%

3.3.4. Intervalo de confiança para diferença de médias ( µ1 − µ2 ) com variâncias σ 12 e σ 22

conhecidas.

(

)

(

)

Seja X 1 ∼ N µ1 ; σ 12 e X 2 ∼ N µ 2 ; σ 22 variáveis aleatórias associadas às populações

1 e 2. Os estimadores por intervalo para µ1 − µ2 , obtidos a partir de amostras n1 e n2 retiradas

dessas populações serão dados pelos seus intervalos de confiança.

Para σ 12 e σ 22 conhecidos, temos:

σ 12 σ 22

σ 12 σ 22

IC(1−α ) ( µ1 − µ 2 ) = ( X 1 − X 2 ) − zα ×

+

; ( X 1 − X 2 ) + zα ×

+

n1 n2

n1 n2

2

2

Em que X 1 é a média da amostra n1 e X 2 é a média da amostra n2 .

10

OBS: a intenção nesse caso é concluir se há diferença entre as duas médias. Assim, se o

intervalo de confiança contiver o valor “zero”, não temos evidencias significativas para afirmar

que uma média difere da outra.

Exemplo: duas variáveis aleatórias X 1 e X 2 seguem distribuições normais com variâncias

σ 12 = 3, 64 e σ 22 = 4, 03 . Construa um intervalo de confiança para a diferença de médias

sabendo que em amostras recolhidas obteve-se:

AMOSTRA 1

n1 = 32

X 1 = 16, 20

AMOSTRA 2

n2 = 40

X 2 = 14,85

RESOLUÇÃO:

3, 64 4, 03

3, 64 4, 03

IC(95% ) ( µ1 − µ 2 ) = (16, 20 − 14,85 ) − 1,96 ×

+

; (16, 20 − 14,85 ) + 1,96 ×

+

32

40

32

40

IC( 95% ) ( µ1 − µ2 ) = [ 0, 44; 2, 26]

COMO O INTERVALO DE CONFIANÇA NÃO CONTEM O ZERO, PODEMOS DIZER

QUE HÁ EVIDENCIAS ESTATÍSTICAS PARA AFIRMAR QUE EXISTE DIFERENÇA

ENTRE AS MÉDIAS.

3.3.5. Intervalo de confiança para diferença de médias ( µ1 − µ2 ) com variâncias σ 12 e σ 22

desconhecidas, porém iguais ( σ 12 = σ 22 ).

Neste caso, um intervalo de confiança 100 (1 − α ) % de confiança para µ1 − µ2 será:

1

1

2 1

2 1

IC(1−α ) ( µ1 − µ 2 ) = ( X 1 − X 2 ) − t

×

s

+

;

X

−

X

+

t

×

s

+

( 1

p

2)

p

α

α

n

n

n

n

n1 + n2 − 2;

n1 + n2 − 2;

1

2

1

2

2

2

2

em que s p é a variância amostral ponderada

s 2p =

( n1 − 1) s12 + ( n2 − 1) s22

n1 + n2 − 2

3.3.6. Intervalo de confiança para diferença de médias ( µ1 − µ2 ) com variâncias σ 12 e σ 22

desconhecidas, porém diferentes ( σ 12 ≠ σ 22 ).

11

Neste caso, um intervalo de confiança 100 (1 − α ) % de confiança para µ1 − µ2 será:

s2 s2

s2 s2

IC(1−α ) ( µ1 − µ2 ) = ( X 1 − X 2 ) − t α × 1 + 2 ; ( X 1 − X 2 ) + t α × 1 + 2

v;

v;

n1 n2

n1 n2

2

2

Em que, os graus de liberdade são dados pela fórmula de Satterthwaite, 1946.

2

s12 s22

n + n

2

1

v=

2

s 2 s 2 2

1 2

n1 n2

n −1 + n −1

1

2

3.3.3.

Intervalos de Confiança para a Proporção

Um intervalo com 100 (1 − α ) % de confiança para p é dado por:

p (1 − p )

p (1 − p )

IC(1−α ) ( p ) = p − zα ×

; p + zα ×

n

n

2

2

Exemplo: Pretende-se estimar a proporção p de cura, através do uso de certo medicamento em

doentes contaminados com cercaria, que é uma das formas da esquistossomose. Um

experimento consistiu de aplicar o medicamento em 200 pacientes, escolhidos ao acaso, e

observou-se que 160 deles foram curados. O que podemos dizer da proporção pna população em

geral?

Uma estimativa pontual para p é 8̂ 160⁄200 0,8. entretanto, podemos dizer mais que isso.

Apesar da proporção amostral 8̂ não ter distribuição Normal, o Teorema Central do Limite nos

garante que, para um tamanho de amostra grande, podemos aproximá-la para a Normal. Desse

modo, segue que:

8̂ ~0 d8;

81 8

i

Assim, um intervalo de confiança para a proporção com 95% de confiança é dado por:

12

0,8(1 − 0, 2)

0,8(1 − 0, 2)

IC( 0,95 ) ( p ) = 0,8 − 1, 96 ×

; 0,8 + 1,96 ×

200

200

Assim,

IC( 0,95) ( p ) = [ 0, 745;0,855]

Exercícios

1. Retiramos de uma população uma amostra de 100 elementos e encontramos 20

sucessos. Sendo [ 1%, determine um intervalo de confiança para a proporção real de

sucessos na população.

Resposta: IC( 0,99% ) ( p ) = [9, 72%;30, 28%]

2. Para se estimar a porcentagem de alunos de um curso favoráveis a modificação do

currículo escolar, tomou-se uma amostra de 100 alunos, dos quais, 80 foram favoráveis.

Construa um intervalo de confiança a 96% para a proporção de todos os alunos

favoráveis a modificação.

Resposta: IC( 0,96% ) ( p ) = [ 71,8%;88, 2%]

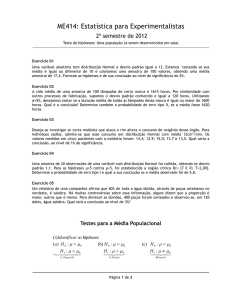

Parte II

Testes de Hipóteses

Trata-se de uma técnica estatística para se fazer inferência. A partir de um teste de

hipóteses, realizado com os dados amostrais, pode-se fazer inferência sobre a população e

tomar decisões.

No caso dos intervalos de confiança, buscava-se “cercar” o parâmetro de interesse.

Agora serão formuladas hipóteses quanto ao valor dos parâmetros populacionais, e pelos

elementos amostrais, é realizado um teste, que indicará a aceitação ou rejeição das hipóteses

formuladas.

1. Principais conceitos

13

a) Hipótese estatística: trata-se de uma suposição quanto ao valor de um parâmetro

populacional, ou quanto à natureza da distribuição de probabilidade de uma variável

aleatória populacional.

Exemplos:

(i)

A altura média da população brasileira é 1,65m, ou seja, t: 1,65.

(ii)

A variância populacional dos salários num determinado país é de $5.000,002,

ou seja, 5000.

b) Teste de hipótese: é uma regra de decisão para aceitar ou rejeitar uma hipótese

estatística com base nos elementos de uma amostra.

c) Tipos de hipóteses: designa-se por tv , chamada “hipótese nula”, a hipótese a ser

testada, e por t ou t" , a hipótese alternativa. A hipótese nula expressa uma igualdade,

enquanto a hipótese alternativa é dada por uma desigualdade.

Exemplos:

(i)

tv : 1,65

versus

tv : 1,65

Esse tipo de formulação dará origem a um teste bicaudal ou bilateral.

(ii)

tv : 1,65

versus

tv : 6 1,65

Esse tipo de formulação dará origem a um teste unicaudal ou unilateral à

direita.

(iii)

tv : 1,65

versus

tv : 1,65

Esse tipo de formulação dará origem a um teste unicaudal ou unilateral à

esquerda.

OBS1: Estabelecer tv e t depende exclusivamente da natureza do problema.

OBS2: A rejeição de tv implicará na aceitação de t .

d) Tipos de Erros: como a tomada de decisões sobre a aceitação ou rejeiçã ode uma

hipótese estatística é baseada apenas nas informações contidas numa amostra, dois tipos

de erros podem ser cometidos:

(i)

(ii)

Erro Tipo I: rejeitar tv quando ela é verdadeira.

Erro Tipo II: aceitar tv quando ela é falsa.

14

A probabilidade de se cometer Erro do Tipo I é denotada por [ e é chamada nível de

significância do teste. A probabilidade se cometer Erro do Tipo II é denotada por w. Sendo

assim,

P(Erro Tipo I) = P(rejeitar Hv |Hv verdadeira) = [

P(Erro Tipo II) = P(aceitar Hv |Hv falsa) = w

O quadro a seguir resume a natureza dos erros envolvidos no processo de tomada de

decisões por meio de testes de hipóteses:

Hv verdadeira

Hv falsa

Rejeição de Hv

Erro Tipo I ([)

Decisão correta (1- w)

Aceitação de Hv

Decisão correta (1- [)

Erro Tipo I (w)

O tomador de decisões deseja, obviamente, reduzir ao mínimo a probabilidade de se

cometer os dois tipos de erro. Tarefa difícil, pois, para um determinado tamanho de amostra, a

probabilidade de se cometer Erro Tipo II aumenta à medida que diminui a probabilidade de se

cometer Erro Tipo I e vice versa.

A redução simultânea dos dois tipos de erros só poderá ser alcançada pelo aumento do

tamanho da amostra.

2. Testes de Significância

Os passos para a execução de um teste de hipótese são:

(i)

(ii)

(iii)

Formular as hipóteses tv e t seguindo a natureza do problema em estudo.

Especificar o nível de significância [

Estabelecer a estatística adequada (z, t, y , F), segundo as informações disponíveis

e determinar as regiões de rejeição e aceitação de tv .

(iv)

Calcular o valor da estatística que definirá a decisão.

(v)

Se o valor da estatística pertencer à região de aceitação de tv , aceita-se a hipótese

nula, caso contrário, rejeita-se tv com nível de significância [.

2.1. Teste de hipótese para a média (^) de uma população Normal com variância (_` )

conhecida:

15

(i)

Formular as hipóteses

tv : v

t : uma das alternativas

t : z v (teste bilateral)

t : 6 v (teste unilateral à direita)

t : S v (teste unilateral à esquerda)

(ii)

Nível de significância [.

(iii)

Estatística do teste:

7

Se t : z v , então:

Se t : 6 v , então,

Se t : S v , então,

~00; 1

√

16

em que {{tv é a região de rejeição de tv e {|tv é a região de aceitação de tv .

(iv)

Sob tv calcular

7p (v)

v

√

Rejeita-se tv com nível de significância [ se 7p } {{tv

Exemplo: técnicas do INMETRO desejam avaliar um processo para conservar alimentos

enlatados, cuja principal variável de interesse é o tempo de duração dos alimentos. O tempo

segue uma distribuição normal com variância 100. A indústria que utiliza o processo afirma que

o tempo médio de duração é de 70 dias. Foi retirada uma amostra de 25 latas e a média

encontrada foi 60 dias. O que se pode concluir sobre o tempo médio de duração dos enlatados?

Utilize [ 0.01.

tv : 70

t : S 70

[ 0.01

7p v

√

Então,

17

7p Conclusão:

60 70

5

10

√25

existe

evidencia

estatística

para

rejeitar

tv : 70

ao

nível

[ 0.01. Portanto, pode-se concluir que o tempo médio de duração dos enlatados é menor que

70 dias.

2.2. Teste de hipótese para a média (^) de uma população Normal com variância (_` )

desconhecida:

(i)

tv : v

t : uma das alternativas

t : z v (teste bilateral)

t : 6 v (teste unilateral à direita)

t : S v (teste unilateral à esquerda)

(ii) Nível de significância [.

(iii) Estatística do teste:

?

Se t : z v , então:

~?L

√

18

Se t : 6 v , então,

Se t : S v , então,

em que {{tv é a região de rejeição de tv e {|tv é a região de aceitação de tv .

(vi)

Sob tv calcular

?p (vii)

v

B

√

Rejeita-se tv com nível de significância [ se 7p } {{tv

Exemplo: Deseja-se investigar certa moléstia que ataca o rim, alterando o consumo de oxigênio

desse órgão. Para indivíduos sadios, admite-se que esse consumo tem distribuição Normal com

média 12 cm3/min. Os valores medidos em cinco pacientes com a moléstia foram: 14,4; 12,9;

15,0; 13,7; 13,5. Qual seria a conclusão ao nível de 1% de significância? E a 5%?

tv : a moléstia não altera a média do consumo renal de oxigenio

t : indivíduos portadores da moléstia tem média alterada.

Ou seja:

tv : 70

t : z 70

19

[ 0.01

?p v

B

√

Então,

7p Conclusão:

12

13,90 12

5,18

B

0,82

√5

√5

existe

evidencia

estatística

para

rejeitar

tv

ao

nível

[ 0.01. Portanto, pode-se concluir que a moléstia tem influencia sobre o consumo renal

médio de oxigênio.