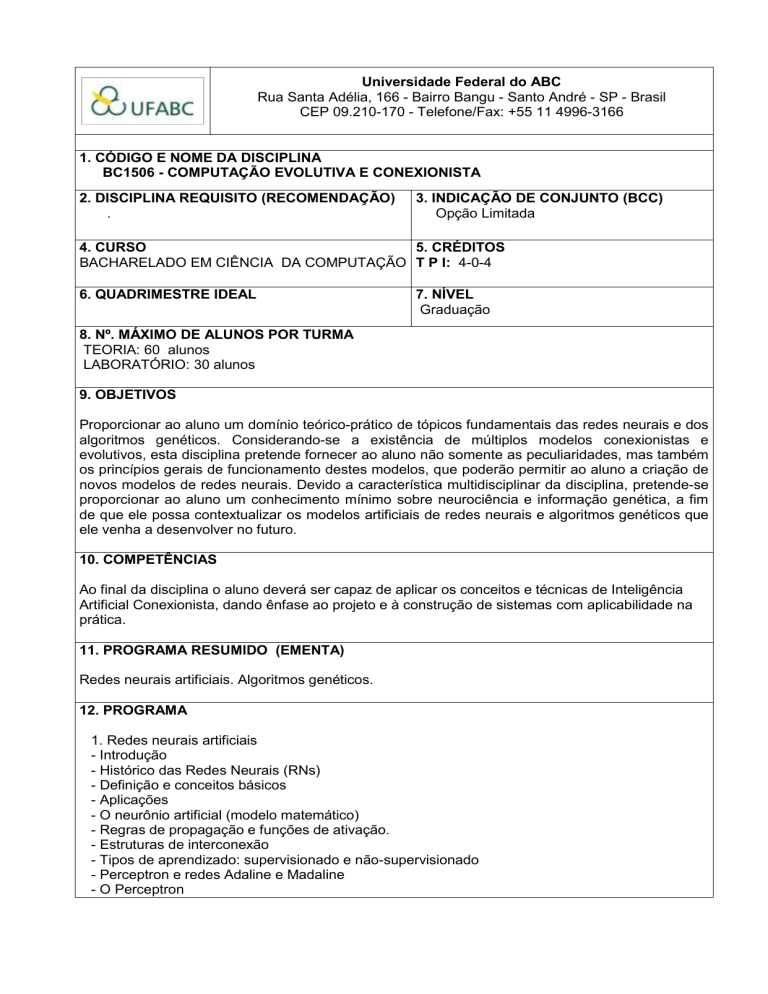

Universidade Federal do ABC

Rua Santa Adélia, 166 - Bairro Bangu - Santo André - SP - Brasil

CEP 09.210-170 - Telefone/Fax: +55 11 4996-3166

1. CÓDIGO E NOME DA DISCIPLINA

BC1506 - COMPUTAÇÃO EVOLUTIVA E CONEXIONISTA

2. DISCIPLINA REQUISITO (RECOMENDAÇÃO)

.

3. INDICAÇÃO DE CONJUNTO (BCC)

Opção Limitada

4. CURSO

5. CRÉDITOS

BACHARELADO EM CIÊNCIA DA COMPUTAÇÃO T P I: 4-0-4

6. QUADRIMESTRE IDEAL

7. NÍVEL

Graduação

8. Nº. MÁXIMO DE ALUNOS POR TURMA

TEORIA: 60 alunos

LABORATÓRIO: 30 alunos

9. OBJETIVOS

Proporcionar ao aluno um domínio teórico-prático de tópicos fundamentais das redes neurais e dos

algoritmos genéticos. Considerando-se a existência de múltiplos modelos conexionistas e

evolutivos, esta disciplina pretende fornecer ao aluno não somente as peculiaridades, mas também

os princípios gerais de funcionamento destes modelos, que poderão permitir ao aluno a criação de

novos modelos de redes neurais. Devido a característica multidisciplinar da disciplina, pretende-se

proporcionar ao aluno um conhecimento mínimo sobre neurociência e informação genética, a fim

de que ele possa contextualizar os modelos artificiais de redes neurais e algoritmos genéticos que

ele venha a desenvolver no futuro.

10. COMPETÊNCIAS

Ao final da disciplina o aluno deverá ser capaz de aplicar os conceitos e técnicas de Inteligência

Artificial Conexionista, dando ênfase ao projeto e à construção de sistemas com aplicabilidade na

prática.

11. PROGRAMA RESUMIDO (EMENTA)

Redes neurais artificiais. Algoritmos genéticos.

12. PROGRAMA

1. Redes neurais artificiais

- Introdução

- Histórico das Redes Neurais (RNs)

- Definição e conceitos básicos

- Aplicações

- O neurônio artificial (modelo matemático)

- Regras de propagação e funções de ativação.

- Estruturas de interconexão

- Tipos de aprendizado: supervisionado e não-supervisionado

- Perceptron e redes Adaline e Madaline

- O Perceptron

- Redes Adaline e Madaline

- A metodologia feedforward e backpropagation

- O modelo feedforward de propagação

- O modelo backpropagation

- Aplicações

- Tipos de RNs

- Rede de Hopfield

- Redes de Função de Base Radial

- Redes ART (Adaptive Resonance Theory)

- Redes IAC (Interactive Activation and Competition)

- Aplicações gerais

2. Algoritmos genéticos (24h/a)

- Introdução

- Revisão de genética, evolução e seleção natural

- Definição e conceitos básicos

- Métodos de busca global e otimização de funções complexas

- Aplicações

- Componentes de um AG

- Representação binária (cromossomas)

- Avaliação

- Seleção e reprodução

- Operadores genéticos: crossover, mutação, inversão

- Desenvolvimento de AGs

- Representação: binário codificando real

- Decodificação e avaliação de cromossomas

- Parâmetros: taxas de crossover e mutação, tamanho da população, gerações

- Avaliação de desempenho de um AG: curvas offline, online e Média de Experimentos

- Reprodução e Seleção

- Métodos de seleção de genitores baseados em aptidão

- Aptidão relativa, probabilidade de seleção

- Aptidão como avaliação, normalização linear e windowing

- Aptidão para problemas de máximo e mínimo

- Elitismo, reprodução steady-state com e sem duplicados

13. MÉTODOS UTILIZADOS

A teoria e os métodos da disciplina são apresentados através de aulas expositivas, intercaladas

com aulas de laboratório.

14. ATIVIDADES DISCENTES

Aulas teóricas expositivas, exercícios e trabalhos extra-classe (em grupo ou individual), pesquisa

bibliográfica, seminários e debates, atividades de avaliação propostas.

15. CARGA HORÁRIA

AULAS TEÓRICAS: 48 horas

TOTAL: 48 horas

RECOMENDADO PARA DEDICAÇÃO INDIVIDUAL: 4 horas semanais

16. CRITÉRIOS DE AVALIAÇÃO DE APRENDIZAGEM

Média ponderada de duas provas, exercícios e trabalho de conclusão da disciplina.

17. NORMAS DE RECUPERAÇÃO (CRITÉRIOS DE APROVAÇÃO E ÉPOCAS DE REALIZAÇÃO

DAS PROVAS OU TRABALHOS)

As notas serão dadas por conceito, conforme estabelecido pelas normas internas da UFABC.

Alunos que não atingiram um nível de aprendizado adequado, e sem reprovação por faltas,

poderão fazer uma prova de exame para mais uma oportunidade de avaliação. A prova de exame

será realizada após as provas normais, no final do trimestre.

18. BIBLIOGRAFIA RECOMENDADA

BIBLIOGRAFIA BÁSICA:

1. BRAGA, Antônio de Pádua; CARVALHO, André Ponce de Leon F de; LUDERMIR, Teresa

Bernarda. Redes neurais artificiais: teoria e aplicações. 2 ed.. Rio de Janeiro: LTC, 2007.

225 p. ISBN 9788521615644.

2. HAYKIN, Simon. Redes neurais: princípios e prática. 2 ed. Porto Alegre: Bookman, 2001.

900 p. ISBN 9788573077186.

3. REZENDE, Solange Oliveira. Sistemas inteligentes: fundamentos e aplicações. Barueri:

Manole, 2005. xxxiii, 517 p. (RECOPE-IA - Rede cooperativa de pesquisa em inteligência

Artificial). ISBN 9788520416839.

BIBLIOGRAFIA COMPLEMENTAR:

1. BISHOP, Christopher M.. Neural networks for pattern recognition. New York: Oxford

University Press, 1995. xvii, 482 p. ISBN 9780198538646.

2. FAUSETT, Laurene. Fundamentals of neural networks: architectures, algorithms, and

applications. Englewood Cliffs, N.J: Prentice-Hall, 1994. xvi, 461 p. Includes bibliographical

references and index. ISBN 9780133341867.

3. GOLDBERG, David E. Genetic Algorithms: in Search, Optimization, and Machine Learning.

Boston: Addison Wesley, 1989. 412 p. ISBN 9780201157673.

4. KOZA, John R.. Genetic programming: on the programming of computer by means of natural

selection. London: Cambridge, 1992. 819 p. (Complex adaptive systems). ISBN

9780262111706.

5. MITCHELL, Tom m. Machine learning. Boston: WCB McGraw-Hill, c1997. 414 p. (McgrawHill series in computer science). ISBN 9780070428072.

6. Genetic Algorithm TOOLBOX For Use with MATLAB. Disponível em

http://www.sheffield.ac.uk/content/1/c6/03/35/06/manual.pdf.

7. Townsend, A.A.R. Genetic Algorithms, a tutorial. Disponível em http://wwwcourse.cs.york.ac.uk/evo/Resources/TutorialGAs.pdf

19. PLANO SUGERIDO PARA AS AULAS (em semanas letivas)

Semana 1

Aula 1.1:Teórica:

Introdução às redes neurais biológicas e artificiais. Comparação do neurônio biológico

e o neurônio artificial. O primeiro modelo de neurônio artificial:o modelo de McCullochPitts.

Aula 1.2: Laboratório:

Introdução ao Matlab/WEKA. Implementação (em planilha de cálculo e/ou no

Matlab/WEKA) do modelo de McCulloch-Pitts.

Semana 2

Aula 2.1:Teórica:

O modelo de McCulloch-Pitts como discriminador linear básico. Efeito da mudança do

limiar e dos pesos no discriminador. Limitações do discriminador na porta ou-exclusivo.

Efeito do aumento da dimensionalidade do espaço de entrada no discriminador linear.

Aula 2.2:Laboratório:

Implementação (em planilha de cálculo e/ou no Matlab) de modelo de McCulloch-Pitts

para modelagem de funções lógicas básicas (AND, OR e EX-OR).

Semana 3

Aula 3.1:Teórica: Plasticidade sináptica e reforço Hebbiano. Limitações da ley de Hebb. Efeito

de ajuste do fator de treinamento. Regra delta. Adaline. Limitações da regra delta.

Outras regras para o ajuste de pesos. Regra de Oja. Regra pré-sináptica e regra póssináptica. Perceptron de Rosemblatt.

Aula 3.2: Laboratório:

Implementação (em planilha de cálculo e/ou no Matlab) do Perceptron de Rosemblatt.

Semana 4

Aula 4.1:Teórica: Redes feed-forward e representação matricial destas redes. A regra de Hebb

matricial. Padrões, iterações e épocas. Mínimos locais e mínimos globais. Fenômeno

do “crosstalk”. Ortogonalidade dos padrões de entrada para evitar o crosstalk no

aprendizado de Hebb. Independencia linear dos padrões de entrada para evitar o

crosstalk na regra delta.

Aula 4.2: Laboratório:

Implementação (em planilha de cálculo e/ou no Matlab) de modelo de rede feedforward e teste destas redes com diversos padrões.

Semana 5

Aula 5.1:Teórica: Redes multicamada. e regra de retropropagação do erro para ajuste dos

pesos. Sobre-treinamento e generalização em função do número de neurônios na

camada intermediária. “Momentum” e fator de aprendizado. Efeito no treinamento da

adição de ruído aos padrões de entrada. Redes auto-associativas. Redes de base

radial.

Aula .2: Laboratório:

Implementação em Matlab de modelos de redes multicamada e teste destas redes

alteando-se o número de neurônios, o fator de aprendizado e o “momentum”.

Semana 6

Aula 6.1:Teórica: Redes não supervisionadas. Rede SOM de Kohonen. Distorção de borda na

rede SOM. Rede Linear Vector Quantization. Modelos biológicamente plausíveis de

redes não supervisionadas.

Aula 6.2: Laboratório:

Implementação (em planilha de cálculo e/ou no Matlab) da rede SOM. Exemplos.

Semana 7

Aula 5.1:Revisão para a 1ª Avaliação. Exemplos de aplicações de redes neurais.

Aula .2: Prova 1

Semana 8

Aula 8.1:Teórica: Introdução aos algoritmos genéticos. O DNA, cromossomos, genes

nucleotídeos e informação genética. Codificação e seleção da população inicial.

Medida de aptidão da população inicial

Aula 8.2: Laboratório:

Utilização do Matlab para criar codificar e avaliar a aptidão da população inicial.

Semana 9

Aula 9.1: Operadores genéticos: cruzamento, mutação, inversão. Cruzamento de um ponto,

multipontos e uniforme.

Aula 9.2: Laboratório:

Utilização do Matlab para implementar os operadores genéticos.

Semana 10

Aula 10.1: Seleção e métodos de seleção: método da roleta, método de amostragem

estocástico universal, seleção por ranking, etc. cruzamento, mutação, inversão.

Cruzamento de um ponto, multipontos e uniforme. Mutação e taxa de mutação

Aula 10.2: Laboratório:

Utilização do Matlab num projeto completo de algoritmos genéticos.

Semana 11

Aula 11.1: Revisão para a 2ª Avaliação

Aula 10.2: Prova 2

Semana 12

Aula 12.1: Apresentação trabalhos da disciplina.

Aula 12.2: Apresentação trabalhos da disciplina e/ou prova substitutiva.

20. PROFESSOR(A) RESPONSÁVEL

Francisco Javier Ropero Peláez