Agência Nacional

do Petróleo,

Gás Natural e Biocombustíveis

PROGRAMA DE RECURSOS HUMANOS DA ANP PARA O SETOR

PETRÓLEO, GÁS NATURAL E BIOCOMBUSTÍVEIS (PRHANP/MME/MCT)

UNIVERSIDADE FEDERAL DO PARANÁ

PROGRAMA INTERDISCIPLINAR EM ENGENHARIA DO PETRÓLEO,

GÁS NATURAL E BIOCOMBUSTÍVEIS (PRH 24)

Coordenador: Prof. Dr. Haroldo de Araújo Ponte

TRABALHO DE GRADUAÇÃO

“Calibração Multivariada Aplicada a Gasolina Automotiva Brasileira”

Aluno: André Ferraz

Orientador: Prof. Dr. Carlos I. Yamamoto

Co-orientadora: Lilian Cocco

Curitiba

Março/2007

Dedico este trabalho aos meus pais, meus heróis, que sempre

estiveram, mesmo longe, ao meu lado.

i

2

Agradeço:

A minha família, o pai herói, a mãe batalhadora, a avó

zelosa, a irmã idealista e ao primo irmão de alma e

sangue por sempre me incentivar na realização dos meus

ideais...

Aos verdadeiros amigos por estarem sempre por perto

nas horas boas e ruins, aos amigos que estão distantes

Wagner Ridão e Matheus Panizzi, mas principalmente a

Adriano Alberto Gonsalves e José Danilo Taveres por

fazerem o papel do irmão mais velho longe de casa...

A CELU por fornecer um local aconchegante tanto para

a diversão com muitos amigos quanto para o estudo com

os mesmos...

Ao PRH24 e LACAUT por fornecerem o incentivo e

estrutura para que o trabalho pudesse ser concluído...

E principalmente a Lílian Cristina Côcco e Claudia

Marino por sempre estarem dispostas a ajudar nos

momentos em que precisei...

Obrigado

ii

3

“Quem luta com monstros deve velar por que, ao fazê-lo, não se transformar também

em monstros. E se tu olhares, por muito tempo, para dentro de um abismo, ele olhará

pra dentro de ti”

Friedrich Nietzsche

iii

4

Sumário

1.Introdução...................................................................................................................... 6

2.Analise bibliográfica...................................................................................................... 9

2.1 Métodos Analíticos para Identificação da Composição do Combustível............... 9

2.2 Conceitos Estatísticos ........................................................................................... 10

2.2.1 Desvio Padrão (SD) ....................................................................................... 10

2.2.2 Covariância.................................................................................................... 11

2.3 PCA (Principal Component Analisys).................................................................. 12

2.3.1 Caracterização Matemática............................................................................ 14

2.4 PLS (Partial Least Squares).................................................................................. 18

2.4.1 Caracterização Matemática............................................................................ 20

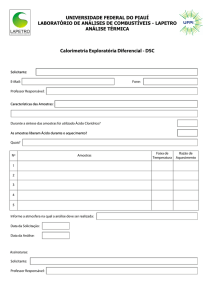

3. Materiais e Métodos ................................................................................................... 22

3.1 Densidade ASTM a 20 °C .................................................................................... 22

3.2 Curva de Destilação.............................................................................................. 22

3.2.1 Terminologia (NBR 9619) ............................................................................ 23

3.3 Espectrometria por Infravermelho........................................................................ 25

4. Resultados................................................................................................................... 25

5. Conclusão ................................................................................................................... 36

6. Outras Realizações ..................................................................................................... 37

6.1 Organização do 16º Congresso Nacional de Estudantes de Engenharia Química

(CONEEQ) ................................................................................................................. 37

7. Revisão Bibliográfica ................................................................................................. 39

5

1.Introdução

A expansão da frota automotiva brasileira leva cada vez mais uma

cobrança da população em relação à qualidade dos combustíveis distribuídos no

país, isso acarreta em analises mais precisas e resultados mais rápidos. Com o

intuito de aumentar a velocidade e o dinamismo das analises nos postos

brasileiros correlações entre propriedades de fácil medição em equipamentos

portáteis e propriedades mais complexas são uma alternativa para este cenário.

Alem de resultados mais rápidos, estas correlações também podem reduzir custos

laboratoriais de analises mais complexas como as de MON (Motor Octane

Number) e ROM (Reshearch Octane Number). Ainda, alguns equipamentos que

utilizam correlações para preverem propriedades da gasolina não se adaptam bem

à gasolina automotiva brasileira, devido ao acréscimo de álcool etílico anidro à

mesma, para a redução de emissões tóxicas, alem de ser característica da

conjuntura política nacional em relação à indústria canavieira e de usinas de

álcool/açúcar. Este acréscimo altera significativamente os resultados obtidos

nestes equipamentos.

A relevância de utilizar correlações é fundamentada em cima da

possibilidade de utilizar poucos testes, ou até mesmo apenas um teste no

monitoramento do controle de qualidade feito pela ANP nos postos distribuidores

de combustível brasileiros. Admitindo uma faixa pequena de desvio de um

modelo bem estruturado uma grande parcela das analises seriam poupadas de

serem executadas em laboratórios muitas vezes a muitos kilometros de distancia

do local, prejudicando o cumprimento da legislação.

Existem inúmeras maneiras de se utilizar correlações entre propriedades

físico-químicas da gasolina, tanto na obtenção dos dados de entrada do modelo

quanto nos dados de saída. Ainda há uma variedade de ferramentas matemáticas

usadas de base para a correlação.

A entrada dos dados pode ser feita por espectrometria por infravermelho,

ultravioleta ou massa atômica, cromatografia liquida ou gasosa ou ainda

6

espectrometria por ressonância magnética. Como dados de saída podemos usar

alguns ensaios padrão do monitoramento de qualidade como pontos da curva de

destilação (PIE, T10, T50, T90, PFE), teor de álcool etílico anidro (AEAC) e a

densidade a 20°C.

Apesar de não ser a técnica mais precisa na obtenção dos dados, foi usado

como dados de entrada a espectrometria por infravermelho. Esta técnica pode

apresentar alguns problemas com ruídos e sobreposição de componentes, porem

um pré-tratamento no espectro elimina boa parte destes problemas. Mas o fator

que mais influenciou na escolha do método é a rapidez e facilidade de obtenção

dos dados, ao contrario da cromatografia, por exemplo, que exige certo tempo de

analise do equipamento. Outro fator baseia-se no fato de o equipamento de

analise de espectrometria por infravermelho ser relativamente menor que os

outros métodos, podendo ser portátil. Isso implica em analises feitas diretamente

no posto ou distribuidoras de combustível.

Existem dois principais métodos de regressão para os dados, primeiro os

métodos baseados na estatística e na ortogonalização das matrizes de dados como

o MLR (Multiply Linear Regression), PCA (Principal Component Analisys),

PLS (Partial Least Squares) entre outros e os métodos baseados nas redes

neurais.

O método mais tradicional utilizado é o MLR, que consiste em:

Y=X.B

(1)

Onde:

Y = matriz [n x m] de variáveis dependentes

n = número de amostras

m = número de variáveis dependentes (por exemplo as propriedades

físico-químicos da gasolina).

X = matriz [n x k] de variáveis independentes

k = número de variáveis independentes (composição química).

B = matriz [k x m] dos coeficientes de regressão

7

O método consiste em encontrar um coeficiente de regressão linearmente

dependente entre a matriz X, no caso o espectro infravermelho da gasolina

automotiva e a matriz Y, composta por vetores das propriedades físico químicas

da gasolina. O grande problema em utilizar o a regressão linear múltipla é que

esta utiliza toda a informação do espectro infravermelho (incluindo os ruídos

irrelevantes) para modelar o sistema. Em casos onde existe colinearidade o

numero de amostras deve exceder o número de variáveis, um numero

relativamente extenso. Já o algoritmo PLS resolve este problema por trabalhar

com pesos entre as variáveis, concedendo maior importância às variáveis mais

importantes enquanto os ruídos e alguns erros de medição exercem pouca

influencia na construção do modelo. O método PCR também soluciona este

problema, pois atribui os mesmo pesos às variáveis a partir dos dados da matriz

Y. Ambos os modelos são robustos, ou seja, são pouco influenciados com a

adição de novas amostras no conjunto.

A Analise de Componentes Principais (PCA) é à base da maioria dos

métodos de calibração. Ela é estruturada no conceito da manipulação da matriz

de dados no intuito de representar as variações presentes em muitas variáveis em

um menor número de variáveis, construindo um novo sistema de eixos, uma

combinação linear das variáveis, que represente melhor o conjunto de dados.

Cada novo eixo recebe o nome de PC (Principal Component) e esses se ajustam a

um determinado grupo de valores. A primeira PC é a que ajusta uma maior

quantidade de dados do sistema e assim por diante até que as ultimas PC’s

apenas correlacionam variações pequenas no conjunto.

No PCA, a dimensão do conjunto de dados é drasticamente diminuída,

pois o antigo sistema axial que descrevia as variáveis é transformado em um

sistema axial ortogonal, forçando os eixos a serem independentes. Com eixos

independentes é necessário um numero muito menor para descrever um conjunto

de dados, isto facilita a detecção de amostras fora do padrão do conjunto

conhecidas como “outliars”.

Outro método de regressão de dados são as chamadas redes neurais

artificiais (RNAs), um tipo de estrutura matemática que é capaz de implementar

8

padrões de associações, desenvolvendo automaticamente modelos implícitos, o

que difere dos métodos clássicos de regressão onde existe a necessidade de um

modelo explícito gerado analiticamente do sistema sob estudo. Um programa

computacional é utilizado para realizar um cálculo iterativo e encontrar os

parâmetros necessários.

Têm sido extensamente estudadas, teórica e experimentalmente, com

vastas aplicações na área da química. A utilização de redes neurais possui grande

potencialidade de aplicação prática, principalmente em processos onde os

modelos fenomenológicos não são conhecidos ou não podem ser desenvolvidos

facilmente.

Levando-se em conta que as redes neurais não necessitam de um modelo

matemático para iniciar o estudo, apenas de dados de entrada e saída os quais se

supõe que exista relação entre eles.

2.Analise bibliográfica

2.1 Métodos Analíticos para Identificação da Composição do

Combustível

A química analítica tem desenvolvido diversas ferramentas que fornecem

informações sobre a composição química dos combustíveis. Trabalhos na área de

espectrometria no infravermelho (IV) são atrativos devido ao curto tempo de

análise. O princípio básico da técnica é a radiação infravermelha, que quando

absorvida por uma molécula, converte-se em energia de vibração molecular. As

vibrações moleculares formam um espectro devido às deformações axiais e

angulares. A posição exata da banda de absorção e a mudança nos contornos das

bandas revelam detalhes importantes da estrutura, porém uma molécula simples

pode gerar um espectro complexo utilizou-se espectrometria no infravermelho

para determinar a composição de 33 amostras de gasolina preparadas. Em um

estudo posterior, utilizaram a mesma técnica de análise para determinar o teor de

9

oxigenados em outras 102 amostras preparadas em laboratório. utilizaram

espectrometria no infravermelho próximo (NIR) com 325 amostras de gasolina

determinando-se sua composição química também utilizou-se o infravermelho

médio (MIR) em 310 amostras de nafta com alguns problemas para diferenciação

entre naftas que classificou-se como sendo do tipo A e B. A diferenciação das

naftas está na quantidade de aromáticos presentes, sendo que a nafta do tipo A

possui baixa quantidade de aromáticos enquanto que a nafta do tipo B, mais

comum que a outra, possui alto teor de aromáticos.

Trabalhos desenvolvidos em espectrometria no ultravioleta (UV) também

podem ser interessantes devido ao curto tempo de análise, porém não foi

encontrado nenhum que pudesse fornecer uma identificação de algum tipo de

combustível. O princípio básico da espectrometria no ultravioleta é a absorção de

energia na região do ultravioleta que depende da estrutura eletrônica da molécula.

Essa absorção de energia é quantizada e conduz à passagem dos elétrons de

orbitais do estado fundamental para orbitais de maior energia em um estado

excitado. Com isto podem-se reconhecer grupos característicos através dos

espectros gerados. Porém podem existir espectros de moléculas simples

semelhantes ao de complexas. Talvez devido a esse tipo de complexidade os

trabalhos nesta área são raros.

2.2 Conceitos Estatísticos

2.2.1 Desvio Padrão (SD)

O desvio padrão é a medida do grau de dispersão dos dados, ou seja, quão

bem o valor se comporta em relação ao conjunto de dados. O termo “desvio

padrão” foi introduzido na estatística por Karl Pearson em 1894 em seu livro

"Sobre a dissecção de curvas de freqüência assimétricas".

10

A definição usada nos tempos de hoje é “A distancia média de um ponto

em relação à média do conjunto de dados” ou a raiz quadrada da variância e é

dada pela equação:

(2)

Onde:

s = Desvio Padrão

Xi = Valor da variavel

X = Média do conjunto de dados

n = Numero de amostras do conjunto de dados

O desvio padrão sempre será um numero não negativo e estará nas

mesmas unidades dos dados, facilitando a interpretação dos dados.

2.2.2 Covariância

A covariância é similar a variância porem, mede a relação entre duas

variáveis aleatórias X e Y e é dada por:

S XY =

∑(X

i

− X )(Yi − Y )

N −1

(3)

Onde:

S XY = Covariância

X i = Valor da variável X

X = Média do conjunto de dados x

Yi = Valor da variável Y

Y = Média do conjunto de dados em y

N = Numero de amostras

11

A covariância não é palpável como estimador de relacionamento, no

sentido de que assume valores de menos até o mais infinito, sem ter um ponto

de referência que delimita um grau forte de relacionamento de um grau fraco.

Portanto, a covariância não consegue revelar o que seria uma relação forte nem

fraca. Para resolver esse problema, a covariância é dividida pelo produto dos

desvios padrão das amostras das duas variáveis X e Y (SX e SY), e

conseqüentemente essa nova expressão fica padronizada. Essa nova medida de

relacionamento é chamada justamente de coeficiente de correlação (r). Os

valores do coeficiente de correlação estão sempre contidos no intervalo

[−1, +1], ou seja, −1 ≤ rXY ≤ 1.

Este é um resultado muito importante, por que pelo fato de ser

padronizado, o coeficiente de correlação não depende da escala nem da locação

das variáveis X e Y. Quando o coeficiente de correlação for igual a menos um

(r = – 1) a relação entre as variáveis é perfeitamente negativa e quando for

unitária positiva, a relação é perfeitamente positiva. Na prática, esses valores

extremos não são encontrados em pesquisas no mundo real, mas servem de

pontos de referência. Um valor igual à zero significa ausência de

relacionamento linear.

2.3 PCA (Principal Component Analisys)

A análise de componentes principais é uma técnica estatística poderosa

que pode ser utilizada para redução do número de variáveis e para fornecer uma

visão estatisticamente privilegiada do conjunto de dados. A análise de

componentes principais fornece as ferramentas adequadas para identificar as

variáveis mais importantes no espaço das componentes principais.

A análise de componentes principais consiste em reescrever as variáveis

originais em novas variáveis denominadas componentes principais, através de

uma transformação de coordenadas. A transformação de coordenadas é um

processo trivial quando feito usando matrizes. A transformação matemática das

12

coordenadas pode ser feita de diversas maneiras conforme o interesse. A

transformação das variáveis originais em componentes principais tem algumas

especificidades.

Os componentes principais (PC’s) são as novas variáveis geradas através

de uma transformação matemática especial realizada sobre as variáveis originais.

Esta operação matemática está disponível em diversos softwares estatísticos

especializados. Cada componente principal é uma combinação linear de todas as

variáveis originais. Por exemplo, um sistema com oito variáveis, após a

transformação, terá oito componentes principais. Cada uma destas componentes

principais, por sua vez, será escrita como uma combinação linear das oito

variáveis originais. Nestas combinações, cada variável terá uma importância ou

peso diferente.

Duas são as características das componentes principais que as tornam mais

efetivas que as variáveis originais para a análise do conjunto das amostras. As

variáveis podem guardar entre si correlações que são suprimidas nas

componentes principais. Ou seja, as componentes principais são ortogonais entre

si. Deste modo, cada componente principal traz uma informação estatística

diferente das outras. A segunda característica importante é decorrente do

processo matemático-estatístico de geração de cada componente que maximiza a

informação estatística para cada uma das coordenadas que estão sendo criadas.

As variáveis originais têm a mesma importância estatística, enquanto que as

componentes principais têm importância estatística decrescente. Ou seja, as

primeiras componentes principais são tão mais importantes que podemos até

desprezar as demais. Destas características podemos compreender como a análise

de componentes principais: a) podem ser analisadas separadamente devido à

ortogonalidade, servindo para interpretar o peso das variáveis originais na

combinação das componentes principais mais importantes b) podem servir para

visualizar o conjunto da amostra apenas pelo gráfico das primeiras componentes

principais, que detêm maior parte da informação estatística.

A analise de componentes principais também é útil em sistemas onde o

número de variáveis é muito grande, como o caso da analise de perfis de

13

temperatura e espectros infravermelhos. O PCA reduz drasticamente o número de

variáveis agrupando um grande numero de informações relevantes de várias

variáveis em apenas um componente principal, facilitando a analise dos dados.

2.3.1 Caracterização Matemática

A analise PCA decompõe a matriz de dados X em uma soma de produtos

de vetores ti e pi e um valor residual E

X = t1pT1 + t2pT2 + ... + tkpTk + E

(4)

Onde o índice k tem de ser menor ou igual à dimensão da matriz. O vetor t

é conhecido como o vetor de “scores” e descreve como as amostras se

correlacionam entre si, já o vetor p é conhecido como o vetor de “loadings” e

contem informações de como as variáveis se relacionam entre si.

No PCA os loadings são os autovetores da matriz da covariância:

cov(X)pi = λi pi

(5)

Onde λi é o autovalor associado ao autovetor pi. O vetor de scores t forma

uma base ortogonal enquanto p é ortonormal, assim:

Xpi = ti

(6)

O vetor ti é uma combinação linear das variáveis originais de X definidas

por pi.

A analise de componentes principais pode ser mais bem vista na Figura 1.

Na figura estão apresentados os valores de 3 variáveis coletadas em um conjunto

de dados. Quando plotado em três dimensões aparentemente as amostras se

dispões em um plano e podem ser agrupadas em uma elipse. O gráfico evidencia

14

que as amostras se variam mais em relação a um eixo da elipse que ao outro. A

primeira componente principal (PC) descreve a direção de maior variação do

conjunto de dados, ou seja, o maior eixo da elipse. Já a segunda componente

principal descreve segunda maior direção de variação das amostras, o menor eixo

da elipse. Neste caso um modelo PCA (vetores de scores e loadings associados

por autovetores) com 2 componentes principais descreve adequadamente a

variação das medições.

Figura 1. Representação Gráfica da Analise de Componentes Principais.

Podemos usar alguns parâmetros estatísticos associados ao PCA para

analisarmos a distribuição dos scores e loadings. Admitindo que os scores da

matriz X tem media zero (assumindo que esta foi centrada na media para a

decomposição) e variância igual ao seu autovalor associado. Ainda podemos

assumir que os scores têm distribuição normal, podemos calcular os limites de

confiança aplicando o teste de distribuição T-Student. O limite de confiança para

a inésima PC é calculado pela seguinte equação:

ti,α = ± sqrt(λi)*tm-1,α/2

(7)

15

Também é possível utilizar o teste Q, que nada mais é que a soma dos

quadrados de cada coluna (amostras) da matriz E (da equação 4), pela seguinte

equação:

Qi = eieiT = xi(I - PkPkT)xiT

(8)

Onde ei é a inésima coluna de E, Pk é a matriz dos loadings do modelo

PCA e I é a matriz identidade. O teste que indica quão bem a amostra se adequa

ao modelo PCA. É o residual entre a amostra e sua projeção nas k componentes

principais que compões o modelo. Analisando geometricamente, o teste Q indica

a distancia em que a amostra esta do plano que as PC’s foram, é a indicação da

variação fora da componente principal. Quanto maior o valor de Q em uma

amostra mais distante ela esta do padrão do conjunto de dados, este teste é crucial

para a analise de “outliars”. Autos valores de Q normalmente significam

amostras anômalas ou erros de medição.

Outro teste utilizado é a soma dos quadrados normalizados dos scores

conhecida como a Estatística T² de Hotelling que mede a variação de cada

amostra dentro do modelo PCA. É dado pela equação:

Ti2 = tiλ-1tiT = xiPλ-1PTxiT

(9)

Onde ti se refere à inésima coluna de Tk, a matriz dos k vetores de scores

do modelo e λ-1 é a matriz diagonal contendo o inverso dos autovalores aos k

autovetores (PC’s) que compões o modelo.

A estatística T² indica a distancia que a amostra se encontra da média

multivariada, ou seja, a intersecção (no caso descrito) entre as PC’s. O limite de

T² define a elipse descrita na figura 1, que descreve a distribuição normal.

Normalmente os modelos apresentam alto grau de complexidade e não são

distribuídos normalmente, o que, torna o T² pouco confiável, pois a média

multivariada não é confiável. Porem o teste Q mesmo em casos mais complexos

ainda tem boa resposta.

16

Nestes tipos de modelos de variáveis com distribuição não lineares

usamos métodos de pré-tratamento dos dados para que a analise de componentes

principais seja mais confiável, a seguir alguns tipos de pré-tratamento.

a) Centramento na Média

Este método desloca o eixo para o centro de gravidade do conjunto de

dados, subtraindo o valor da média de todos os valores das amostras. Este

procedimento concede maior estabilidade numérica para amostras em que os

valores zero são esperados em vários fatores, como é o caso de espectros em

quimiometria em que um valor zero de concentração significa o valor zero na

absorvância. Centrar os valores na média remove o “tamanho” das amostras,

sendo interessante usar em situações em que este não é relevante.

b) Auto-escalonamento

Consiste me conceder a cada variável o mesmo peso. Primeiramente as

variáveis são divididas por seus desvios padrão, resultando em uma variância

unitária e posteriormente é subtraído o valor da média. Um auto-escalonamento

apropriado foca o modelo nas variáveis relevantes da matriz Y e ainda concede e

as variáveis com maior numero de informações de X exercem maior influencia

no modelo.

c) Normalização

A normalização faz com que a soma das variáveis sejam valores de

potencias de 10 multiplicando os valores por um fator. O procedimento é muito

usado na química, pois remove a influencia de ruídos nas analises de

espectrometria, cromatografia entre outras.

d) Correção Ortogonal de Sinal (OSC)

17

Este procedimento é usando para remover variações ortogonais

sistemáticas entre as matrizes X e Y nas correlações multicomponentes. Ruídos

estruturados da matriz Y prejudicam a projeção de X baseada nos métodos PCA,

PLS e PCR. As variações ortogonais de Y incorporam-se no primeiro vetor ti de

scores da matriz X prejudicando a correlação entre ti e Y propagando-se para a

interpretação dos dados. Deve-se tomar cuidado na aplicação da OSC para que

não ocorra overfiting.

2.4 PLS (Partial Least Squares)

Em meados dos anos 70 um ramo da estatística, a analise multivariada,

começou a ser utilizado com êxito para modelar um conjunto de variáveis

complicadas pelo grande numero por Herman Wold, este método foi chamado

inicialmente de NIPALS ( non – linear interative Partial Least Squares) e mais

tarde de PLS ( partial least square) ou mínimos quadrados parciais. A partir da

década de 80 este método se tornou extremamente útil na química analítica,

tendo que um grande número de parâmetros e dados estavam sendo obtidos, com

a matemática disponível o tratamento desses dados se tornava extremamente

complexa, e a implementação da ferramenta PLS resolveu muitos desses

problemas, já que, na época os computadores já tinham uma capacidade para

cálculos relativamente complexos e robustos. Mais recentemente com os avanços

na área de inteligência artificial proporcionados pela rápida ascensão da

capacidade dos microcomputadores uma outra ferramenta se tornou útil suprindo

as deficiências que o PLS detém, esta ferramenta são as RNA´s ( Redes Neurais

Artificiais).

A analise multivariada aplicada na química analítica é conhecida como

Calibração Multivariada que consiste em estabelecer uma correlação entre duas

matrizes (blocos). Este processo consiste basicamente em 2 fases, primeiramente

a calibração e seguida da validação do modelo. Na primeira, uma matriz (X)

18

consiste em “n” linhas e “p” colunas, as linhas correspondem a diferentes

propriedades, características ou tipos de uma variável, como o espectro do

infravermelho, a concentração da amostra ou o nível de atividade iônica e as “p”

colunas correspondem a diferentes amostras, nota-se que quanto maior o numero

de colunas “p” mais confiável será o modelo obtido. Já a matriz (Y) corresponde

aos dados aos quais se deseja obter após ter um modelo que consiga relacionar a

entrada de dados (matriz X) e fornecer os dados da matriz (Y).

Ao se ter várias propriedades de uma mesma amostra (as linhas “n”)

durante a modelagem percebem-se que algumas informações são mais relevantes

que outras isso se verifica quando aplicamos o PCA (Analise dos principais

componentes). No PCA decompõe-se a matriz de dados (X) em uma soma de

matrizes (Gi), produto de vetores chamados escores (scores) e pesos que podem

ser calculados por mínimos quadrados. Assim cada matriz Gi tem uma relevância

diferente na correlação com a matriz de resultados (Y).

Na regressão por mínimos quadrados parciais (PLS) , expande-se a

matriz de dados em uma soma de matrizes que não podem ser mais expandidas

mais uma matriz de erro (que não corresponde a parte modelada).As matrizes de

dados se transformam em matrizes que são formadas por um produto de dois

vetores t (escores) por p (pesos).

X = G1 + G2 + ...Ga + E

X = t1 p1 + t 2 p 2 + ...t a p a + E

(10)

(11)

Para se determinar o número de componentes principais utiliza-se um

método chamado da Validação Cruzada, que consiste em primeiramente fazer um

modelo, e depois de pronto retira-se uma amostra “i” do conjunto de calibração e

é feito um novo modelo, então se tenta prever, no novo modelo, a amostra i

retirada. Após calcula-se o erro de previsão (y-yi) , e depois o quadrado dos erros

de previsão que é chamado de PRESS.

PRESS = ∑ ( y − y1 ) 2

(13)

19

Onde y é o valor conhecido e yi é o valor obtido. Assim menor o valor

PRESS mais adequado é o componente.

Para um modelo ser o aceito ele precisa ter a capacidade de prever com

uma precisão desejada um conjunto de valores correspondentes a novos dados,

novas entradas, para verificar isto utilizamos métodos para validação do modelo

que consiste na determinação do erro padrão de calibração (SEC) e o erro padrão

de previsão (SEP). Modelos com uma boa capacidade de previsão apresentam

baixos valores ou as vezes mínimos dos 2 erros e valores de ambos próximos.

Normalmente os dados de entrada do modelo são de alta complexidade e

não linearidade alem de apresentarem um grande número de variáveis, para

obter-se modelos mais precisos os mesmos métodos de pré-tratamento utilizados

nos modelos PCA são utilizados nos modelos PLS.

2.4.1 Caracterização Matemática

Na regressão por mínimos quadrados parciais uma matriz X de amostras é

correlacionada com uma matriz Y de dados dessas amostras por um coeficiente

como demonstram as equações

T = XW*

(14)

X = TP’ + E

(15)

Y= U’C’ + G

(16)

Y = TC’ + F

(17)

Y = XW*C’ + F

(18)

B = W*C’

(19)

20

Y = XB + F

(20)

Na equação (14) matriz T de escores é composta pelo produto da matriz de

amostras X e um determinado peso W*. A matriz T descreve a similaridade

entre as amostras da entrada, e o peso W* descreve como as variáveis da matriz

X se combinam para correlacionar a matriz de amostra X e a de dados Y.

A matriz X pode ser decomposta, assim como no PCA, em vetores de

scores ti e uma matriz de resíduos E, cujo não é usada para a construção do

modelo. O vetor pi corresponde aos loadings, que descreve a maneira quem a

variáveis de X se combinam, assim como o vetor de pesos W*, como descrito na

equação (15). A equação (16) é similar à (15) porem correspondendo a matriz de

dados Y. A matriz de scores U’ de loadings C’ e de resíduos G, estes resíduos

são a parte da matriz Y que não é descrita pelo modelo PLS.

Fazendo uma combinação de variáveis chegamos à equação (20), onde a

matriz B chamada de matriz dos coeficientes do PLS aparece proveniente da

combinação linear das de loadings tanto de X quanto de Y. Esta matriz descreve

as variáveis latentes (LV’s) que nada mais são que, uma combinação linear entre

os componentes principais de cada matriz.

Para a identificação de outliars nos modelos PLS utiliza-se o “leverage”

que define a influencia de uma amostra na construção do modelo. O leverage é

relacionado com a estatística T². Baixos valores de leverage significam pouca

influencia na construção do modelo, porem há de se ter cuidado na analise deste

parâmetro. Amostras com valores anômalos têm alta influencia na construção do

modelo, porém uma influencia ruim. Geometricamente o leverage significa a

distancia da amostra do centróide do conjunto de dado, daí a relação com a

estatística T².

21

3. Materiais e Métodos

3.1 Densidade ASTM a 20 °C

Método do Densímetro Automático O equipamento utilizado neste estudo

é o densímetro automático modelo DMA 4500 da Antoon Paar apresentado na

figura 4.3, que determina a densidade da gasolina a 20 oC em g/cm3. Este ensaio

atende às normas ASTM D 4052 /NBR 14065. A amostra é introduzida, com

auxílio de uma seringa, em um tubo capilar em forma de U, vibrando com

freqüência definida. Um banho controlado ajusta a temperatura da amostra a

20oC. A modificação da freqüência, provocada pela introdução da amostra, em

conjunto com os parâmetros de calibração determina a massa específica da

amostra, na temperatura escolhida. O tempo de análise para este método é de dois

minutos. A densidade da gasolina está relacionada às características de

estocagem, mas também pode indicar presença de contaminantes.

3.2 Curva de Destilação

Este ensaio atende às normas ASTM D 86 e NBR 9619.

Os equipamentos disponíveis em laboratório para este estudo são:

a) Destilador automático Herzog mod. HDA628 (master) n.s.

6280977 e 6280978 (máquina 1 e 3).

b)

Destilador

automático

Herzog

mod.

HDA627

(slave)

n.s.16271209 e 16271208 (máquina 2 e 4).

22

3.2.1 Terminologia (NBR 9619)

PIE – Ponto inicial de ebulição: é a leitura corrigida do termômetro que é

observada no instante que a primeira gota de condensado cai na extremidade

mais baixa do tubo condensador .

PFE – Ponto final de ebulição: é a máxima temperatura corrigida do

termômetro obtida durante o teste. Esta geralmente ocorre depois da evaporação

de todo líquido do fundo do frasco.

Porcentagem recuperada: o volume de condensado observado na proveta

coletora, expresso como a porcentagem do volume carregado, associado com a

leitura simultânea da temperatura.

Ponto seco: a leitura do termômetro corrigida que é observada no instante

em que a última gota de líquido (excluindo quaisquer gotas ou película de líquido

nas paredes do frasco ou do sensor de temperatura) evapore da parte mais baixa

do fundo do frasco. Existe uma aproximação deste ponto para o ponto final de

ebulição em amostras onde não se consegue diferenciá-los.

Neste ensaio, 100 ml de gasolina é evaporado e condensado sob condições

padronizadas. A taxa de destilação da amostra deve estar entre 4 a 5 ml/min,

proporcionando uma destilação uniforme ao longo do tempo. O condensado é

recolhido em uma proveta graduada calibrada, permitindo a leitura do volume de

destilado. São feitas observações sistemáticas de temperatura a cada volume

especificado de condensado, possibilitando o levantamento da curva de

destilação do produto. É um teste básico de determinação das características de

volatilidade do combustível, sendo utilizado para verificar se as proporções leves

e pesadas do combustível produzido estão adequadas, visando obter uma boa

performance na combustão. É utilizado também para detecção de contaminação

com outros produtos leves ou pesados. A especificação define valores máximos

de temperatura para os pontos 10%, 50% e 90% evaporados ou recuperados,

além do ponto final de ebulição (PFE) e o resíduo da destilação. O tempo de

análise para destilar uma amostra de gasolina comum é de 40 minutos (em

média).

23

Ao destilar-se a gasolina, mistura complexa de hidrocarbonetos com

número de carbonos variando de 4 a 12, obtemos dados a respeito de seu

desempenho em um motor. Os dados mais importantes são:

a) PIE - ponto inicial de ebulição. É o ponto de bolha da gasolina,

relacionado diretamente com o teor de voláteis na gasolina. É importante

para a partida do motor a frio.

b) T10 - temperatura na qual 10% (em volume) do líquido foi

destilado. Está relacionada com a partida do motor a frio. Voláteis em excesso

ocasionam o “vapor lock” .

c) T50 - temperatura na qual 50% do líquido foi destilado. Está

relacionada com o aquecimento do motor (temperatura ótima de operação).

d) T90 - temperatura na qual 90% do líquido foi destilado.

Relaciona-se com a performance e economia do motor, além da temperatura

ótima de operação do mesmo. Hidrocarbonetos pesados em excesso podem

causar combustão irregular, já que não volatilizam tão fácil e permanecem mais

tempo dentro do motor causando a diluição do lubrificante.

e) PFE - ponto final de ebulição. Relacionado com o teor de

hidrocarbonetos pesados.

Os resultados do teste são normalmente expressos como porcentagem recuperada

versus temperaturas correspondentes, em uma tabela ou graficamente plotando-se

a curva de destilação. Algumas considerações do fabricante (HERZOG, 2000)

relevantes para o estudo:

O equipamento possui um sensor DP (Dry Point) que detecta automaticamente o

ponto seco, que capta a mudança de temperatura na parte de cima do balão de

destilação. A temperatura eleva-se rapidamente após a saída da última gota.

O ponto inicial de ebulição é detectado por um sensor infravermelho de nível. O

nível zero da proveta receptora deve ser calibrado cada vez que a mesma é

trocada, mesmo sendo do mesmo fabricante ou também quando o equipamento é

trocado.

24

O termômetro utilizado para medida das temperaturas é um PT 100, que possui

um material sensível à temperatura (platina) com uma resistência elétrica que

muda com a mesma.

O equipamento possui velocidade de destilação controlada que fica entre 4 a 5 ml

por minuto.

3.3 Espectrometria por Infravermelho

O equipamento utilizado para obter os espectros e infravermelho é um

Excalibur, com kit ATR, com transformada de fourier, situado no Departamento

de Química da UFPR. A faixa de aquisição de dados foi de 4000 a 400 cm-1,

referente ao infravermelho médio, com resolução de 4cm-1 , com 32 scans de

varredura.

4. Resultados

O modelo PLS construído foi baseado em amostras de infravermelho de

gasolinas aprovadas no controle de qualidade. Apesar destas amostras seguirem

padrões mais definidos, podendo causar overfiting, o modelo com 12 amostras de

gasolinas tanto comum como aditivada mostro-se coerente com os dados

experimentais..

Foram analisadas 6 propriedades: 4 pontos da curva de destilação (T10,

T50, T90, PFE), Densidade ASTM a 20° e o teor de álcool etílico anidro

combustível (AEAC).

.

O espectro infravermelho obtido em laboratório varia de 0 a 8000nm de

faixa de banda como mostrado na figura 2, porem nos dois extremos do espectro

a incidência de ruídos provenientes do equipamento é muito grande, então se

utilizou uma faixa de 600 a 4000nm (Figura 3). Esta faixa cobre a maior parte do

espectro relevante ao modelo.

25

1,40E+02

1,20E+02

1,00E+02

8,00E+01

6,00E+01

4,00E+01

2,00E+01

0,00E+00

-2,00E+01

0

1000

2000

3000

4000

5000

6000

7000

8000

Figura 2 – Espectro infravermelho obtido no equipamento

120

100

80

60

40

20

0

1

133 265 397 529 661 793 925 1057 1189 1321 1453 1585 1717

Figura 3 – Espectro infravermelho utilizado no modelo

Após reduzir o espectro, o mesmo foi pré-tratado de duas maneiras:

Primeiramente foi normalizado para remover os ruídos restantes no espectro

devido aos dados utilizados para a previsão serem relativamente diferentes

utilizou-se o método OSC (Orthogonal Signal Corretion) já descrito acima.

Apesar de ser muito difundido o método “Mean Center”, os pré-tratamentos

utilizado no modelo em questão se mostram melhores.

A matriz Y de dados contento as propriedades físico químicas da gasolina

sofreu um pré-tratamento centrando na média, como dito anteriormente se

tratando de propriedades com valores relativamente diferentes. O método de

auto-escalonamento produziu bons resultados também, porem piores que o

método anterior.

26

Na cross-validação foi utilizada do tipo “leave one out” que consiste em

fazer sucessivos modelos retirando uma amostra e prevendo-a a partir do modelo

sem a mesma. É uma técnica relativamente simples e para modelos de

complexidade modera porta-se muito bem.

A tabela abaixo mostra o numero de variáveis latentes (LV’) obtidas no

modelo, a variância capturada por cada LV e a variância acumulada.

-----Infravermelho---LV #

----

This LV

Total

------- -------

----Propriedades----This LV

Total

------- -------

1

74.91

74.91

36.40

36.40

2

7.21

82.12

25.67

62.07

3

10.79

92.91

5.91

67.98

4

1.40

94.31

15.19

83.17

5

1.45

95.76

6.64

89.80

6

1.75

97.51

3.38

93.19

7

1.13

98.64

2.95

96.14

8

0.78

99.42

0.89

97.03

9

0.25

99.67

1.34

98.37

10

0.24

99.91

0.49

98.87

11

0.09

100.00

1.13

100.00

Tabela 1 – Variáveis Latentes

A figura 4 mostra a relação entre o numero de variáveis latentes para a

matiz Y, a matriz das propriedades físico químicas e a variância de cada uma das

LV’s. A partir de 8 LV’s a variância capturada pela variável latente é pouco

relevante, foi então fixado o numero de 8 LV’s para o modelo.

27

Figura 4 – Num de LV’s x Variância Capturada

Foram usadas amostras de gasolina adulterada para testar o modelo, as

amostras foram escolhidas aleatoriamente. As tabelas a seguir apresentam os

valores obtidos em laboratório confrontados com os previstos pelo modelo.

GA07

GA09

GA10

GA11

GC01

GC02

GC03

GC04

GC05

GC06

GC07

GC08

GC09

GC10

GC22

GC23

GC24

GC25

GC27

GC28

GC30

GC31

GC38

GC39

GC50

GC51

GC52

T10

54,6

55,4

55,3

54,9

53,8

57,3

56,3

55,4

65,1

55

56,6

56

56,2

54,6

54,1

56,1

54,9

54

55,1

55,7

54,4

53,6

56,6

53,2

55,6

59,5

50,1

T50

72,8

73

72,1

73,4

72

74,5

72,5

72,4

73,1

98,9

72,4

73,7

73,7

72,3

72

72,7

72,6

72

72,6

73,2

73

72,4

72,6

72,4

72,8

71,2

70,7

T90

160,2

168,1

167,1

162,9

162,7

151,3

166,4

161,7

155,2

169,8

170,8

167

155,5

165

161,8

162

161,2

165

163,2

166

168,1

167,6

165,5

159,7

187,1

149,5

157,6

PFE

203,1

217

212,1

209,4

206,4

206,3

221,4

207,5

198,1

210,7

248,3

194,3

204,6

233,2

206,3

212,1

206,1

220,5

208,4

213,9

211,2

209,5

233,7

206,7

327,9

198,9

210,7

Densidade

752,8

759,2

755,9

760,8

752,3

766,3

754,5

753,2

758,6

741,7

755,4

757,4

762,1

754,2

751,9

754,4

753,5

752,7

756,4

760,17

758,3

756,3

756,9

753,8

760,5

750,1

742,7

AEAC

27

29

26

31

27

32

25

27

23

2

25

27

28

25

26

28

26

26

30

29

27

25

29

29

25

26

26

Tabela 2 – Valores Experimento

28

GA07

GA09

GA10

GA11

GC01

GC02

GC03

GC04

GC05

GC06

GC07

GC08

GC09

GC10

GC22

GC23

GC24

GC25

GC27

GC28

GC30

GC31

GC38

GC39

GC50

GC51

GC52

T10

55,318

54,233

54,596

55,391

55,115

58,127

54,876

55,700

55,303

55,205

54,318

57,539

55,040

54,466

55,738

55,625

55,082

54,311

54,699

58,570

53,051

53,645

54,226

53,651

54,855

54,432

56,626

T50

71,857

72,214

72,213

72,225

71,498

72,948

71,658

71,844

71,827

71,969

71,719

72,756

71,760

71,814

72,647

72,273

72,390

71,835

72,079

73,100

71,730

71,548

71,798

71,557

71,316

71,226

71,717

T90

163,520

168.14

166,820

165,020

166,120

165,300

164,440

162,890

163,320

164,190

166,480

165,780

163,910

166,070

167,720

165,510

167,890

166,760

165,040

162,880

168,140

164,580

164,980

164,210

159,420

159,740

156,310

PFE

Densidade

212,610

750,080

215,210

751,460

217,270

749,630

220,160

748,530

208,190

754,000

226,650

748,190

208,680

752,530

210,240

751,080

198,230

756,550

208,790

752,160

209,150

752,780

222,740

749,850

207,710

752,560

211,870

751,720

215,220

752,070

212,980

751,490

211,470

753,200

210,530

751,750

217,140

749,200

232,030

744,950

210,520

752,190

211,600

749,980

211,230

750,940

206,510

751,210

208,210

748,680

206,930

749,390

207,590

748,890

AEAC

26,774

24,671

26,350

28,412

27,139

33,053

25,408

26,706

21,444

24,665

25,496

31,473

24,917

26,102

27,013

26,246

25,140

26,067

26,433

33,322

22,898

24,126

24,756

23,559

25,764

24,469

25,537

Tabela 3 – Valores Obtidos pelo modelo

Agora analisando graficamente as propriedades físico químicas

isoladamente, as figuras mostram a comparação entre o valor experimental

(pontos pretos e quadrados) e o previsto pelo modelo (pontos circulares e

vermelhos) e ainda o desvio relativo das amostras.

29

Figura 5 – Ponto Experimental x Ponto Calculado para AEAC

Figura 6 – Desvio de Previsão para AEAC

30

Figura 7 – Ponto Experimental x Ponto Calculado para Densidade

Figura 8 – Desvio de Previsão para Densidade

31

Figura 9 – Ponto Experimental x Ponto Calculado para PFE

Figura 10 – Desvio de Previsão para PFE

32

Figura 11 – Ponto Experimental x Ponto Calculado para T10

Figura 12 – Desvio de Previsão para T10

33

Figura 13 – Ponto Experimental x Ponto Calculado para T50

Figura 14 – Desvio de Previsão para T50

34

Figura 15 – Ponto Experimental x Ponto Calculado para T90

Figura 16 – Desvio de Previsão para T90

35

5. Conclusão

O modelo partiu inicialmente com mais amostras (50 amostras).

Utilizando analise de componentes principais (PCA) foram retirados outliars.

Apesar de poucos componentes principais descreverem o espectro, quando

aplicado o PLS o numero de variáveis latentes devido à necessidade de um maior

numero delas para descrever a matriz das propriedades físico químicas.

Outro fator a se considerar é a forma de construção do modelo.

Primeiramente correlacionando as 6 propriedades simultaneamente, visto que

houve pouca diferença entre o modelo global e modelos correlacionando apenas

1 propriedade, sendo mais vantajoso lidar com apenas 1 modelo.

O modelo respondeu bem principalmente à densidade, onde não alcançou

erros maiores que 2,5% fato este podendo ser explicado primeiramente por os

valores experimentais já serem provenientes de correlações no equipamento e

também pela alta precisão do mesmo. Os valores da curva de destilação também

responderam relativamente bem ao modelo com erros de até no máximo 5%,

porem erros já considerados altos para esse tipo de método estatístico. Os pontos

T10, T50 e T90 principalmente, já o ponto final de ebulição apresentou algumas

amostras que ficaram afastadas dos valores previstos. O equipamento usado

apesar de ser um equipamento automático, pode ser levemente impreciso nas

medições visto que o controle de temperatura e outros fatores físicos podem

influenciar nos dados recolhidos. Por ultimo o teor de álcool etílico anidro

(AEAC) apresentou comportamento bem ruim em relação às outras propriedades.

Este tipo de análise é efetuado manualmente em uma proveta e os valores obtidos

para uso em modelos matemáticos não são confiáveis.

36

6. Outras Realizações

6.1 Organização do 16º Congresso Nacional de Estudantes de

Engenharia Química (CONEEQ)

O 16° Congresso Nacional dos Estudantes de Engenharia Química

(CONEEQ), que foi realizado dos dias 20 a 27 de Janeiro na Cidade de Curitiba,

foi um evento anual que teve o objetivo de estimular o intercambio cientifico e

cultural entre todos os estudantes de engenharia química, engenharia ambiental,

engenharia de bioprocessos e química industrial do país. O evento foi organizado

pelos alunos do curso de graduação em Engenharia Química da Universidade

Federal do Paraná, em parceria com os professores e o Setor de Tecnologia da

mesma Universidade.

O PRH 24 teve participação crucial no evento, tanto como principal

patrocinador como tendo na Coordenação Geral, o principal posto do evento, um

bolsista do PRH 24.

Alem disso, alunos de outros PRH’s tiveram a oportunidade de se

encontrarem e discutirem sobre o programa e os mais variados temas. Vale

lembrar que o evento foi o maior dos últimos 10 anos tanto em número de

participantes como em número de trabalhos de iniciação cientifica apresentados,

somando mais de 70 pôsteres e 10 classificados para apresentação oral para uma

banca examinadora que contava com professores do programa como a Prof Drª

Agnes de Paula Scheer e a ex-pesquisadora do programa Lillian Cristina Côcco.

O tema central do congresso foi “Petróleo: Auto-suficiência e

sustentabilidade” com o objetivo de integrar os alunos de todo o Brasil com esta

nova fase que o país esta passando.

Após o estouro da auto-suficiência na produção de petróleo nacional na

mídia, é pertinente a discussão sobre o que realmente esta auto-suficiência

significa para a nação e como ela influenciará no futuro do país.

A auto-suficiência levada em conta é quando consideramos que há

disponibilidade de petróleo produzido nos campos nacionais em volume igual ou

37

superior ao consumo e à capacidade de refino do país para atender à demanda do

mercado brasileiro.

Hoje, esta demanda é de 1,8 milhões de barris/dia, e a produção nacional,

em torno de 1,9 milhões de barris/dia.

Apesar de ser tentador ao mercado uma crescente produção, esta não pode

causar danos ao meio ambiente, e isto deve ser um foco importante nas

discussões: como conseguiremos manter essa auto-suficiência por muitos anos

sem agredir a natureza.

Durante uma semana mais de 500 estudantes ficaram reunidos na cidade.

O cronograma girou em torno dos cursos e palestras, ofertados de segunda a

quarta feira. Apesar de o foco central ser a indústria petrolífera, foi discutido os

mais variados temas como papel e celulose, equipamentos da indústria química e

o enpreendedorismo. Na quinta feira o dia foi para a amostra de iniciação

cientifica dos alunos pré classificados para apresentação oral, julgados por uma

banda de professores. Entre eles professores orientadores do PRH24

Ainda na quinta feira foi realizado o 1° Encontro Nacional de Empresas

Juniores de Eng Química, uma iniciativa da Federação Nacional de Estudantes de

Eng Química (FENEEQ) para incentivar e consolidar essa importante atividade

dentro das instituições de ensino. Finalizando a parte acadêmica do congresso na

sexta feira os alunos tiveram a oportunidade de visitar as indústrias da área na

região de Curitiba.

Compareceram ao evento mais de 900 alunos dos mais variados locais do

Brasil, desde estudantes de Porto Alegre até uma delegação com 50 alunos de

Natal no Rio Grande do Norte, a organização também se preocupou em

proporcionar um calendário de festas para que todos alem de durante o dia

participar das atividades acadêmicas, possam se divertir na capital paranaense.

A importância da troca de experiências entre as mais de 20 instituições de

ensino que estarão presente no evento é o que move a cada ano, congressos

maiores e mais bem sucedidos.

Assim como a FENEEQ, alem de integrar os alunos de todo o pais, busca

aproximar os mesmos de sua futura profissão.

38

7. Revisão Bibliográfica

1. WOLD. S, SJÖSTRÖM. M , ERIKSSON. L ; PLS-regression: a basic tool of

chemometrics , Elsevier Science B.V., 2001

2.WENDLANT, W . W. M.; HECHT, H. G.; Reflectance Spectroscopy, New York ,

Interscience , 1996

3. BARROS A. S.; RUTLEDGE D. N. ; Principal Components transform-partial

least squares: a novel method to accelerate cross-validation in PLS regression ,

Elsevier Science B.V., 2004.

4. SAVITZKY,A.; GOLLAY, M. J. E.; Anal. Chem., 36: 1627, 1994.

5.OTTO. M ; Chemometrics Statistics and Computer Appilcation in Analytical

Chemistry; Wiley-VHC; New York, 1998

6. JOBSON J. D.; Applied Multivariate Data Analysis vol.1; Springer-Verlag , New

York, 1991

7. HAYKIN, S.; Neural Networks – A Comprehensive Foundation. 2. ed.: , Prentice

Hall ,New Jersey, 1999.

8. FERREIRA MÁRCAI M. C., ANTUNES ALEXANDRE M, MELGO MARISA S.,

VOLPEPEDRO L. O.; Quimiometria I: Calibração Multivariada, Um Tutorial,

Campinas, 1999

9. SMITH LINDSAY I.;A tutorial on Principal Components Analysis, 2002

10. WISE BARYY M., GALLAGHER NEAL B., BRO RASMUS., SHAVER

JEREMY M., PLS Toolbox 3.0 for use with MATLAB, Manson WA, 2003

11.HANSELMAN DUANE; Mastering MATLAB 6, Prntice Hall Inc, 2001

12.CÔCCO, Lílian Cristina; YAMAMOTO, Carlos Itsuo; von MEIEN, Oscar

Felippe. Previsão de Propriedades da Gasolina a partir de sua Composição

Química utilizando-se Rede Neural, Curitiba, 2003

39