UMA VALIDAÇÃO MATEMÁTICA PARA UM ALGORITMO QUE

SIMULA MISTURAS DE DISTRIBUIÇÕES

Ana Paula Coelho MADEIRA1

Lucas Monteiro CHAVES1

Devanil Jaques de SOUZA1

Resumo: Uma validação matemática, utilizando o conceito de soma de Riemann, é apresentada

para um algoritmo que simula a densidade de probabilidade da mistura de duas distribuições.

PALAVRAS-CHAVE: Mistura de distribuições; simulação; soma de Riemann.

1 Introdução

Novas distribuições de probabilidade são obtidas quando se admite que o parâmetro

de uma família de distribuições também varia segundo uma outra distribuição de

probabilidade, isto é, o parâmetro passa a ser considerado também uma variável aleatória

com sua própria distribuição. A distribuição resultante desse processo é denominada

mistura. Um exemplo bem conhecido é a distribuição beta binomial, que surge quando se

permite que o parâmetro p de uma binomial varie segundo uma distribuição beta. Outra

distribuição obtida por esse processo é a binomial negativa, muito usada no ajuste de

dados biológicos. Essa distribuição é resultado da mistura das distribuições Poisson e

gama. O conceito de mistura é suficientemente flexível para, a partir de distribuições

conhecidas, obterem-se novas e interessantes distribuições.

O presente trabalho tem por objetivo apresentar uma validação matemática de um

algoritmo usado para simular distribuições obtidas pelo processo de mistura.

Mistura de distribuições

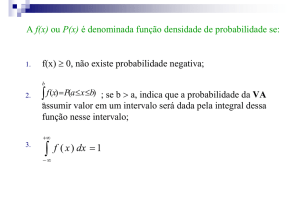

Seja f0 (.), f1 (.),..., f n (.),... uma sequência de funções densidades de probabilidades e

p0 , p1 ,..., pn ,... uma sequência dos números satisfazendo pi 0 e

pi 1 ,

i 0

então

h x pi fi x é também uma densidade de probabilidade, pois

i 0

h x dx i pi fi x dx i pi fi x dx

x

x

x

1 Departamento de Ciências Exatas, Universidade Federal de Lavras – UFLA, Caixa Postal 3037, CEP: 37200000, Lavras, MG, Brasil, E-mail: [email protected] / [email protected] / [email protected]

603

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

pi fi x dx pi 1 .

i

x

i

A densidade h x é denominada uma mistura de distribuições (Mood, et al., 1974) . Tal

procedimento é útil para se obterem novas distribuições de probabilidade com

propriedades adequadas. Um exemplo de interesse é:

Exemplo 1: Mistura de normais.

h x p

2

1 ,1

x 1 p

2

2 , 2

x ,

em que

j ,1 x

1

1

exp x j

2

2

, j 1,2 ,

2

é uma mistura envolvendo duas densidades normais com médias diferentes 1 e 2 e

variâncias iguais a 1, em que p é chamado peso ou proporção da mistura.

1

Para p , tem-se

3

1 1

2 2 1

2

1

1

h x

exp x 1

exp x 2 .

3 2

2

3 2

2

Uma observação interessante é:

Proposição: Se X e Y são variáveis aleatórias com densidade de probabilidade f X e

fY , e se W é uma variável de Bernoulli com P W 1 p e P W 0 1 p , então a

mistura h z p f X z 1 p fY z é a função densidade de probabilidade da variável

aleatória Z W X 1 W Y .

Prova:

FWX 1W Y z

P WX 1 W Y z

P Y z W 0 P X z W 1

P Y z P W 0 P X z P W 1

FY z 1 p FX z p

O conceito de mistura pode ser estendido para um número não enumerável de

distribuições: seja f x ; ; uma família de funções densidade de probabilidade

parametrizadas por em um espaço paramétrico , em que é um intervalo da reta

real.

Se g é uma função densidade de probabilidade definida em , então

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

604

h x f x; g d

é uma nova densidade de probabilidade, pois

h x dx IR f x; g d dx IR f x; g dxd

g f x; dx d g d 1 .

IR

A distribuição h x também é denominada mistura das distribuições f x ; e

g .

A definição para espaços paramétricos mais gerais é análoga, mas não será tratada

neste artigo.

Exemplo 2: Seja X uma variável aleatória com distribuição normal de média e

variância 1.

1

2

1

,1 x

exp x .

2

2

Suponha que é também uma variável aleatória com distribuição normal com

média 0 e variância 1.

1

1

0,1

exp 2 .

2

2

A mistura é dada por

h x

1

2 1

1

1

exp x

exp 2 d

2

2

2

2

1

1

1

1

exp x 2

exp 2 2 2 x d

2

2 2

2

1

1

x2

exp x 2

2

2

2

1

1

2 exp 2 2

2

2

2

x x

2

d

2

2

Fazendo y 2 d 1 dy ,

2

605

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

h x 1

2

1

2

2

1

1

1

x2

x

1

exp x 2

exp y

dy

2

2

2

2

2

2

2

1

1 x ,

exp

2

2 2

e, portanto, tem distribuição normal com média 0 e variância 2.

Exemplo 3: Suponha que fêmeas de insetos depositem ovos em determinados locais que

denominaremos de unidades, folhas, por exemplo. A probabilidade de uma unidade conter

x indivíduos (larvas) é modelada por uma distribuição de Poisson ,

e x

I

x .

x! 0,1,2,...

Essa situação encontra-se representada na Figura 1.

X ~Poisson f x;

Figura 1 - Padrão espacial aleatório.

Considerando que as unidades são heterogêneas, algumas provêm de ambientes mais

favoráveis que outras, a média de indivíduos varia de unidade para unidade. Tal

pressuposição faz sentido, pois uma folha mais exposta ao sol, por exemplo, pode ser

menos propícia ao desenvolvimento dos ovos. Uma forma de modelar a variação de é

supor que varia segundo uma distribuição Gama , . Assim, essa mistura de

distribuições é dada por

h x

0

x

e 1

e d

x !

0

f x; g d

x 1 1

e

d

x! 0

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

606

x

x 1

1

x 1e d

x! 1 x 0 x

x

x 1 1

1 1 I 0,1,2,... x .

x

A distribuição resultante para o número de indivíduos por unidade é, portanto, uma

binomial negativa com parâmetros e p

.

1

A distribuição binomial negativa pode também ser obtida como uma distribuição

generalizada de uma Poisson com uma logarítmica (Madeira, 2009). Deste modo¸ temos a

mesma distribuição sendo obtida por modelos matemáticos diferentes, o que implica em

pressupostos biológicos diferentes. Portanto o conceito de mistura explicita um problema

que geralmente origina polêmicas, como observado em Pielou (1977): “... o ajuste de

distribuições de freqüência teóricas a dados observados não é suficiente para explicar o

padrão natural de uma população”.

2 Simulação de distribuições obtidas por misturas.

Para a simulação de distribuições resultantes de uma mistura, o seguinte algoritmo é

de uso corrente:

Algoritmo mistura: Simula uma amostra da distribuição obtida pela mistura das

distribuições f x ; e g .

Um valor do parâmetro é simulado a partir de g ;

ii) Com o valor de obtido no passo anterior, um valor x é simulado a partir

de f x ; ;

i)

iii) Os passos i) e ii) são repetidos n vezes resultando na amostra aleatória de

tamanho n.

Esse algoritmo tem sido implementado em vários pacotes computacionais, em

particular, utilizado no aplicativo R. Em Devroye (1986) esse algoritmo é denominado

algoritmo de composição. Em Gamerman (1996) é observado que, para variáveis

aleatórias bidimensionais, como a densidade conjunta pode ser expressa pelo produto da

densidade condicional vezes a densidade marginal f x, y f x | y f y ‚ pode-se utilizar

o conceito de mistura para simular amostras de f x, y . Gamerman (1996) também

apresenta outros processos de simulação de densidades utilizando misturas.

Apesar de extremamente simples e intuitivo é necessário uma validação matemática

que nos garanta que tal algoritmo realmente simula uma distribuição obtida por mistura.

No entanto, os autores não conseguiram obter, na literatura, nenhum resultado nessa

direção. Primeiramente deve-se observar que não se trata de estudar a convergência do

algoritmo uma vez que tal fato não faz sentido. Uma amostra de tamanho 1, gerada pelo

607

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

algoritmo, seria uma amostra de tamanho 1 da distribuição h x . Uma idéia para se

validar matematicamente o algoritmo é a mesma utilizada no teste de aderência quiquadrado: suponha h x com domínio D I i , em que I1 , I 2 , , I n são intervalos

disjuntos. Se o algoritmo gera uma amostra de tamanho n, espera-se que as proporções

1

pˆ i número de elementos da amostra em I i , sejam aproximadamente iguais aos

n

números pi h x dx , isto é, deve acontecer que em uma longa sequência de amostras

Ii

de tamanho n geradas, o número de amostras em que todos os valores pˆ i são próximos

aos pi ocorre com alta freqüência.

Proposição: O algoritmo mistura simula uma amostra da distribuição

h x f x ; g d .

Prova: Suponha que e o domínio de f x; sejam intervalos reais finitos. Considere

em uma partição em k subintervalos de tamanho , com pontos centrais

denominados 1 ,..., j ,...,k . Da mesma forma, uma partição para o domínio de f x; ,

com subintervalos de tamanho x , é realizada, obtendo-se os pontos centrais

x1,..., xi ,..., xm . Tal construção está representada na Figura 2.

k

j

1

x1

xi

xm

Figura 2 - Discretização do parâmetro e da variável x.

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

608

Assim, pode ser obtida a distribuição discreta, com valores 1 ,..., j ,...,k :

g

j

P j

, j 1,..., k ,

S

em que S

k

g ,

j

j 1

De forma similar:

f x ; x

i j

P X xi | j

, i 1,..., m ,

S

em que S

m

f x ; x .

i

j

i 1

Essas distribuições aproximam as densidades g e f xi ; j , no seguinte sentido:

g j

S

j

2

j

2

g d .

Portanto, a distribuição h x é aproximada por

xi

x

2

1

h x dx S S j f x ; g j x,

i

x

xi

2

j

i 1,..., m .

g j

Utilizando-se a distribuição discreta

, j 1,..., k , uma amostra de

S

tamanho n , com n k e n m , é gerada. Ordena-se essa amostra. Valores repetidos de

j são obtidos, uma vez que o tamanho da amostra n é maior que o número k de valores

possíveis para . Considerando-se que n é grande, tem-se, pela lei dos grandes números

(Feller, 1968), que o número de vezes que um determinado j aparece na amostra é

g j

aproximadamente igual a

n . Esquematicamente temos, onde as quantidades

S

são aproximadas:

g 1 n

S

1 1

g 2 x n

g k n

S

1 2 2

2

...

S

k k

k

n

609

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

Para cada valor de j , um valor xs é simulado utilizando-se a distribuição

f x ; x

. Valores de x ocorrem repetidas vezes. Novamente, pela lei

i j

,

i

1,...,

m

s

S

dos grandes números, o número repetições de um valor xs na amostra de tamanho n é

f x ; x g

s j j

aproximadamente

n

.

S

S

g n

j

S

j ... j

j ... j

j ... j

...

...

x1 ... x1

x2 ... x2

xm ... xm

f x ; x g n

f x ; x g n f x ; x g n

1

j

j

2

j

S S

m

j

j

j

S S

S S

Portanto, o número de vezes que um valor xi aparece na amostra de tamanho n é

aproximadamente

1

S S

j f x g j x .

i

j

Tal somatório é exatamente a soma de Riemann da função da variável

f xi ; g em relação à partição do espaço paramétrico. Fazendo 0 , que é

equivalente a n , obtém-se

1

lim

n S S

f x g j x f x g d x h x x

n

i

j

j 1

i

j

i

isto é, o número de vezes que xi aparece na amostra é aproximadamente igual a

h xi x . Portanto, como h xi x

amostra aproxima a distribuição h x .

x

xi

2

h x dx , o histograma de frequências desta

x

xi

2

No caso em que e o domínio de f x; não são limitadas, (por exemplo, a

média de uma normal), basta truncar as distribuições g e f x; .

No intuito de ilustrar o comportamento do algoritmo apresentamos o exemplo a

seguir:

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

610

Exemplo 4: Simulando a distribuição binomial negativa.

Supondo que o parâmetro de uma Poisson tem distribuição Gama 10,1 , uma

amostra de tamanho n 100.000 é obtida. Para cada valor do parâmetro obtido, um

valor x é simulado pela Poisson correspondente. O histograma de frequências é

apresentado na Figura 3.

Figura 3 - Histograma de freqüências obtido pelo algoritmo mistura.

Desta forma simula-se uma amostra de uma binomial negativa com parâmetros

10 e p 0,5 .

Conclusões

O algoritmo mistura tem uma validação matemática bastante simples e intuitiva.

MADEIRA, A. P. C.; CHAVES, L. M.; SOUZA, D. J. A mathematical validation for an

algorithm that simulates mixture of distributions. Rev. Bras. Biom., São Paulo, v.27, n.4,

p.603-612, 2009.

ABSTRACT: A mathematical validation using the concept of the Riemann sum is given to an

algorithm that simulates the density probability of the mixture of distributions.

KEYWORDS: Mixture of distributions; simulation; Riemann sum.

Referências

DEVROYE, L. Non-uniform random variate generation. New York: Springer-Verlag,

1986. 864p.

611

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

GAMERMAN, D. Simulação estocástica via cadeias de markov. São Paulo: Associação

Brasileira de Estatística, 1996, 196p.

GURLAND, J. Some interrelations among compound and generalized distributions.

Biometrika, London, v.44, n.1-2, p.265-268, 1957.

MADEIRA, A. P. C. A distribuição Beta Binomial Negativa. 2009. 81f. Dissertação

(Mestrado em Estatística e Experimentação Agropecuária) – Universidade Federal de

Lavras, Lavras, 2009.

MOOD, A. M.; GRAYBILL, F.A.; BOES, D. C. Introduction to the theory of statistics.

New York: McGraw-Hill, 1974. 564p.

MOTWANI, R., RAGHAVAN, P. Randomized algorithms.

University Press, 1995, 476p.

Cambridge: Cambridge

R DEVELOPMENT CORE TEAM. R: a language and environment for statistical

computing. Vienna, Austria: R Foundation for Statistical Computing 2007.

Recebido em 31.03.2009.

Aprovado após revisão 29.11.2009.

Rev. Bras. Biom., São Paulo, v.27, n.4, p.603-612, 2009

612