02/04/2014

Aula 02: Revisão de

Probabilidade e Estatística

Prof. Leonardo Menezes

Tópicos em Telecomunicações

Sumário

•

•

•

•

•

•

•

O que é estatística

O que é probabilidade

Variáveis aleatórias

Distribuição de Probabilidade

Momentos

Aplicações

Mapeamentos

O que é estatística

• Estatística é o estudo de dados

– Coleta

– Organização

– Análise

– Interpretação

– Apresentação

• O que significa isso?

– Estatística tenta fazer estabelecer parâmetros a

partir dos dados que são coletados

1

02/04/2014

O que é estatística

• Coleta

– Como devo coletar os dados

– Quantas amostras são necessárias

– Que informação eu posso extrair desta coleta

– Qual é o erro que tenho ao assumir que a

informação extraída é a informação verdadeira.

O que é estatística

• Exemplo 1: Na 2ª Guerra Mundial os aliados

precisavam determinar o número de tanques

dos alemães. Ao capturar tanques alemães

eles encontraram um número de série em

cada um deles

– A partir destes números, eles estimaram quantos

tanques alemães tinham sido produzidos.

O que é estatística

• Pergunta: Quantos tanques alemães foram

produzidos em dado ano?

• Neste caso:

– A coleta e a quantidade de amostras foi

especificada externamente

• O que falta:

– A informação que posso extrair desses dados

– O erro que tenho ao assumir que a informação

extraída é a informação verdadeira

2

02/04/2014

O que é estatística?

• Dados:

– 10 tanques foram capturados

– Números de série dos tanques capturados:

• 239, 23, 251, 219, 91, 154, 436, 408, 500, 123.

• Depois vamos voltar a este problema.

O que é estatística

• Exemplo 2: Queremos saber a preferência de

forma de deslocamento para UnB. As opções

são:

– Somente de carro

– Outros

• Pergunta: Quantas pessoas usam somente

carro para vir a UnB?

• Depois voltamos a este problema...

O que é probabilidade

• Probabilidade é o estudo de fenômenos

aleatórios

– Usa informações do conjunto de total dados para

obter estimativas para amostras (muito

importante em estatística)

– É a fundação matemática da estatística:

• Somente com probabilidade é que conseguimos

responder as perguntas formuladas nos dois exemplos.

3

02/04/2014

O que é probabilidade

• Então se queremos diferenciar probabilidade

de estatística:

– Probabilidade usa informações do conjunto

completo de dados para estimar informações em

amostras

– Estatística usa informações de amostras para

estimar informações do conjunto completo de

dados.

• Na realidade, precisamos das duas na análise

de dados.

O que é probabilidade

• A probabilidade está mais ligada a chance. Mas

com este parâmetro permite estimar outros

• Exemplo 3: Moeda honesta (cara ou coroa). Qual

é a chance de obter 3 caras e 3 coroas em 6

jogadas da moeda?

• Exemplo 4: Moeda desonesta (60% cara e 40%

coroa). Qual é a chance de obter 3 caras e 2

coroas em 5 jogadas da moeda?

• Depois voltamos a estes problemas

O que é probabilidade

• Para definirmos a estatística de um experimento

(ou teste), precisamos definir antes o conjunto de

todos os resultados possíveis deste experimento.

– Este conjunto é chamado de espaço amostral {A}

– Qualquer subconjunto de {A} é chamado de evento

• A probabilidade de ocorrência do evento {B} ( que

é um subconjunto de eventos aleatórios

pertencente a A) é um número real que

representa a chance de ocorrência de A1

4

02/04/2014

O que é probabilidade

• No caso de uma coleção de eventos:

B A1 A2 ... Ak

• Temos que, se os mesmos forem disjuntos

Ai Aj {}

• Então

P B P A j

j

O que é probabilidade

• Com estas informações podemos começar a

entender probabilidade a partir de um caso

mais próximo a nossa realidade: uma moeda.

– Espaço amostral de A : Cara {X1} e Coroa {X2}

– Cara e Coroa são eventos disjuntos e compõem

todo o espaço amostral {X}

• Portanto:

X X1 X 2

P X P X 1 X 2 P X 1 P X 2 1

O que é probabilidade

• Voltemos ao Exemplo 3: Moeda honesta (cara

ou coroa). Qual é a chance de obter 3 caras e

3 coroas em 6 jogadas da moeda?

– Como a moeda é honesta, então a chance de

obter cara é igual a de obter coroa, logo:

P(cara) p P(coroa) q

p q 1

pq

1

pq

2

5

02/04/2014

O que é probabilidade

• O próximo passo é listar todas as chances de

acontecimento

• Como jogar as moeda não afeta as

probabilidades (elas não se alteram a cada

jogada), então 6 jogadas equivalem a:

p q p q p q p q p q p q 1

p q 6 1

p 6 6 p 5 q 15 p 4 q 2 20 p 3q 3 15 p 2 q 4 6 pq 5 q 6 1

1

1 6 15 20 15 6 1 1

64

O que é probabilidade

• Portanto a chance de obter 3 caras e 3 coroas em

6 jogadas da moeda é

20 p 3q 3

20

0.3125

64

• Com base neste resultado podemos encontrar a

resposta ao exemplo 4: Moeda desonesta (60%

cara e 40% coroa). Qual é a chance de obter 3

caras e 2 coroas em 5 jogadas da moeda?

O que é probabilidade

• Neste caso, como a moeda é não honesta,

então as chances são fornecidas:

P(cara) p

6

10

P(coroa) q

• Listando as possibilidades

4

10

p q p q p q p q p q 1

p q 5 1

p 5 5 p 4 q 10 p 3 q 2 10 p 2 q 3 5 pq 4 q 5 1

1

243 162 216 144 48 32 1

625

6

02/04/2014

O que é probabilidade

• Portanto a chance de obter 3 caras e 2 coroas

em 5 jogadas da moeda é

10 p 3q 2

216

0.3456

625

• Note que a chave é encontrar as

probabilidades adequadamente

representadas

Variáveis Aleatórias

• Mas ao invés de simplesmente nomear

eventos (Cara ou Coroa), podemos associar

números a estes eventos

• Por exemplo:

– Cara = 1 & Coroa = 0 (ou vice-versa)

• Ao fazermos isto, estamos associando

variáveis aleatórias a eventos.

– Isto ampliará em muito a representação de

chance.

Variáveis Aleatórias

• Assim como podemos associar um número ao

evento (x) também podemos representar a

probabilidade, no caso de Cara {x=1} ou Coroa

{x=0} como:

P(cara) P X 1 p

P(coroa) P X 0 q

P X p q 1

7

02/04/2014

Variáveis Aleatórias

• As variáveis aleatórias podem ser contínuas

(também descontínuas) ou discretas

– As discretas assumem valores bem definidos

PY y1

P y1

– As contínuas tem sua probabilidade definida por

intervalos

PY y

Variáveis Aleatórias

• No caso das variáveis aleatórias (VA)

contínuas, há um mapeamento entre os

números reais e as variáveis de modo que:

– Se

– Então

y1 y2

PY y1 PY y2

• Este mesmo raciocínio é aplicado para VA

discreta

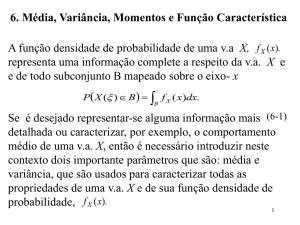

Distribuição de Probabilidade

• Desta forma podemos definir a função de

distribuição de probabilidade acumulada F(x)

(tanto para VA contínua quanto discreta):

F x P X x

x1 x2 F x1 F x2

lim x F x 0

lim x F x 1

8

02/04/2014

Distribuição de Probabilidade

• Apesar do conceito de probabilidade poder

ser usado tanto para o caso de VA contínua

quanto discreta

– É mais simples entender probabilidade através de

VA discreta

• A probabilidade de um evento X1 ocorrer em

n tentativas é

p X 1 lim n

nX 1

n

Distribuição de Probabilidade

• Isto quer dizer que a probabilidade é dada

pela razão do número de vezes que ocorreu

X1 sobre o número total de tentativas

– Esta abordagem é chamada de frequentista (em

oposição a abordagem bayesiana).

• No caso contínuo podemos definir a função

densidade de probabilidade como

p x

dF x

dx

Distribuição de Probabilidade

• Há várias densidades de probabilidades

conhecidas. No caso de uma variável aleatória

temos as mais conhecidas:

– Normal (ou Gaussiana)

– Uniforme

p x

1

px b a

0

1

e

2

x 2

2

a xb

c.c

9

02/04/2014

Distribuição de Probabilidade

• Distribuição Normal

Distribuição de Probabilidade

• Distribuição Uniforme (contínua)

Distribuição de Probabilidade

• Distribuição Uniforme (discreta)

10

02/04/2014

Distribuição de Probabilidade

• Através das distribuições de probabilidade

estimar regiões de maior probabilidade

– Basicamente este é o conceito dos intervalos de

confiança

– Isto é mais fácil de entender na distribuição de

probabilidade uniforme contínua

– A Função distribuição é

F x

xa

ba

Distribuição de Probabilidade

• Note que podemos calcular a probabilidade

do ponto estar em determinado intervalo (por

exemplo de x1 a x2)

x2 x1

Px 2 Px1

ba

ba

x x

2

ba

x1

x x

2

x2

Distribuição de Probabilidade

• Centrando em torno da média e fazendo

pontos equidistantes da média podemos

encontrar os intervalos de confiança

P x P x

2x

ba

P x P x

x

ba

2

• Podemos também definir em função do desvio

padrão

12

P x P x

x

2

x 3P x P x

11

02/04/2014

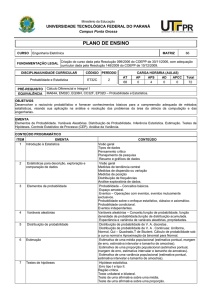

Momentos

• A partir do conhecimento da definição,

podemos encontrar os momentos da

distribuição

– Podem ser “puros” (não centrados) ou “centrais”

(centrados)

E x

E xk

k

– Os momentos centrais são medidos com relação a

média .

Momentos

• Os momentos tem algumas propriedades

úteis:

Ea a

Eax by aEx bEy

E x y E x 2 E y 2 2 Exy

2

Momentos

• O momento de ordem k é dado por

– No caso discreto temos variáveis discretas

N

nxi

i 1

n

E x k lim n

N

N

i 1

i 1

xik pxi xik pi xik

– No caso contínuo temos variáveis contínuas

Ex k x k px dx

12

02/04/2014

Momentos

• O momento de ordem zero é sempre 1

N

N

i 1

i 1

E x 0 pxi xi0 pxi 1

Ex 0 x 0 px dx px dx 1

Momentos

• O primeiro momento é a média da

distribuição (mesma equação da média

ponderada)

N

N

i 1

i 1

E x1 pxi xi1 pxi xi

Ex1 x1 px dx xpx dx

Momentos

• Os momentos seguintes são definidos em

termos dos momentos centrais

• Temos

2

– Variância – ordem 2

Ex

Ex

E x varx

3

– Skewness (distorção) – ordem 3

– Kurtosis (curtose) – ordem 4

4

13

02/04/2014

Momentos

• Variância:

Momentos

• Skewness:

Momentos

• Kurtosis:

14

02/04/2014

Momentos

• A relação da variância com os momentos

puros:

E x E x 2 2x 2

2

E x E2x E 2

2

E x 2 2Ex 2 E x 2 2

varx Ex 2 Ex

2

Momentos

• A variância da soma de duas variáveis

aleatórias

2

varx y E x x y y

E x y 2x y

E x E y 2 Ex y

2

2

x

y

x

2

y

2

x

y

varx vary 2 covxy

x

y

Momentos

• Naturalmente, se

covxy 0

• Ou seja a covariância entre as variáveis é nula.

Então

varx y varx vary

• Se a covariância é nula, estas variáveis são ditas

não correlacionadas

15

02/04/2014

Momentos

• Se duas variáveis são não correlacionadas então

px, y px p y

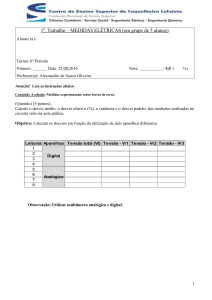

• Exemplo 5. Um divisor de tensão entre dois

resistores, tem que um deles é uma VA de

distribuição uniforme entre 1 e 2 W. O outro,

aonde a tensão é medida também é uma VA de

distribuição uniforme entre 1 e 2 W. As duas VAs

não tem correlação. Qual é a média e o desvio

padrão da tensão?

• Voltaremos a este exemplo depois

Momentos

• Mas o que significa variância?

– Usando a analogia de circuitos

• Consideremos a janela de tempo de 0 a T como uma

distribuição uniforme

1

pt T 0

0

0t T

c.c

• A nossa “variável aleatória” será a tensão nos terminais

de um resistor R

Momentos

• Portanto

T

1

Evt vt dt VDC

T

0

V2

1

v 2 t 1

Ept vt it dt

dt RMS

T

R T

R

0

0

T

T

2

E v 2 t VRMS

16

02/04/2014

Momentos

• Portanto

– O primeiro momento puro equivale o “valor DC”

Evt VDC

– O segundo momento “puro” é equivalente ao

quadrado do valor RMS.

2

E v 2 t VRMS

Momentos

• Com isso podemos pensar no segundo

momento central como

– A energia do sinal “fora” do valor médio (DC), ou

seja, uma forma de dispersão do sinal.

• Se o segundo momento for zero a energia está toda

concentrada na média

• A medida que o momento aumenta, mais energia

estará espalhada ao redor da média

– A raiz quadrada da variância é chamada de desvio

padrão

2

2

2

E vt VDC E vt Evt

V

2

RMS

V

2

DC

Wmédio WDC

Momentos

• Primeiros momentos das distribuições

contínuas apresentadas

– Normal

Ex

E x 2

2

– Uniforme

Ex

ba

2

2

b a 2

b a

2

E x

12

2

17

02/04/2014

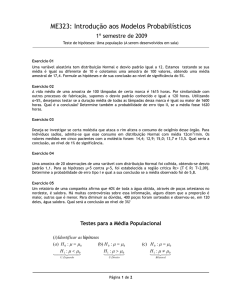

Momentos

• Ligando a probabilidade e a estatística

– Vamos considerar que foram retirados N amostras

de uma distribuição com média e desvio .

– Esta distribuição pode ter uma densidade de

probabilidade a priori desconhecida.

• Agora temos dados ao invés de ligações

matemáticas abstratas.

– Como podemos saber quais os momentos da

distribuição das amostras?

Momentos

• Sabemos que

Ex

E x 2

2

• O que temos é:

X1, X 2 ,..., X N

• Estes foram obtidos aleatoriamente!

Momentos

• Vamos considerar a soma de todos os dados

amostrados

N

sN X 1 X 2 ... X N X k

k 1

• Se repetirmos a amostragem infinitas vezes, o

valor esperado desta soma é

N

N

N

Es N E X k EX k N

k 1

k 1 k 1

18

02/04/2014

Momentos

• Como: N Es

N

1

• Definindo a média amostral X

N

X

N

k 1

k

• Então a expectativa da média amostral é:

1 N

1 N

EX E X k E X k

N k 1 N k 1

1

1

Es N N

N

N

Momentos

• Pergunta: De que isso adianta? Afinal teremos

que repetir infinitas vezes...

– Não é o caso, pois podemos provar que a

diferença entre a média amostral e converge

para zero com aumento do número de amostras...

– Basta provar que a variância da diferença da

média amostral e tende a zero quando o

número de amostras tende ao infinito

• Vamos encontrar a variância da diferença (que

é a variância da média amostral)

Momentos

• O segundo momento central é:

1 N

1

N

varX var X k 2 var X k

N k 1 N

k 1

1 N

1

2

varX k N 2 N 2 N

N 2 k 1

• Portanto a variância diminui linearmente com o

aumento do número de amostras

– Note que para que isto seja verdade a covariância

entre as amostras tem de ser zero

covxy 0

19

02/04/2014

Momentos

• Alternativamente:

E X E X 2 2 X 2 E X 2 2

2

1 N

1 N

E X k 2 2 E X k2 2

N k 1

N k 1

2

1 N

N

2

2 E X k E X k 2

N k 1

k 1

2

1

2

N 2 N 2 2 2

2

N

N

Momentos

• Temos então um estimador do primeiro

momento da distribuição (média)

X

1

N

N

X

k 1

k

lim N X

• E o segundo momento (variância)?

Momentos

• Vamos calcular o estimador da variância da

amostra considerando a média .

S2

1

N

N

X

k 1

2

k

1

N

X

N

k 1

X X

2

k

1 N

2

2

X k X 2X k X X X

N k 1

20

02/04/2014

Momentos

• Calculando o valor esperado

1 N

2

2

E S 2 2 E X k X 2X k X X X

N k 1

2 N

1 N

1 N

2

2

E X k X X k X X X

N k 1

N k 1

N k 1

1 N

2 N

1

2

E X k X E X k X X E

N k 1

N k 1

N

1 N

2

2

E X k X 0

N k 1

N

X

N

2

k 1

Momentos

• Rearranjando

1 N

2

2

E X k X 0

N k 1

N

N

2

2

E X k X N 1 N 1E S 2

k 1

2

• Portanto, há um desvio no estimador que

pode ser corrigido fazendo

N

1

2

E s2 E

X k X 2

N 1 k 1

N

1

2

s2

X

X

k

N 1

k 1

Aplicações

• Muito bem, mas e como vamos aplicar isso?

• Voltamos ao problema do tanque (exemplo 1):

– 10 tanques foram capturados

– Números de série dos tanques capturados:

• 239, 23, 251, 219, 91, 154, 436, 408, 500, 123.

• A distribuição em questão é uniforme (os

números vão de 1 até M)

– Sabemos quanto é a média de uma distribuição

uniforme e a variância

21

02/04/2014

Aplicações

• Média

M 1

M 2 1

2

• Variância

2

M 12 M

12

12 2 1

Aplicações

• Para calcular a média e a variância usamos os

estimadores das amostras

N

1 N

X k X 2

N 1 k 1

k 1

• Além disto temos a relação entre o desvio da

média amostral e real

X

1

N

X

s2

k

E X

2

2

N

M 12

12 N

Aplicações

• Resultados:

– Média da amostra: 244.4

– Variância da amostra: 25998.3

– Desvio padrão da amostra: 158.1

• Resultados do espaço amostral original

–

–

–

–

Média: 250.5

Variância: 20750.1

Desvio padrão: 144.1

Variância da média da amostra em relação a média

real: 2075.0

– Desvio padrão: 45.6

22

02/04/2014

Aplicações

• Resultados:

– Estimador pela média: 487.8000

– Estimador pela variância: 547.7045

– Média dos dois: 517.7523

– Considerando distribuição uniforme:

M 244.4 158.1 3

518

– Valor real de M: 500

Aplicações

• Voltemos ao exemplo 2: Quantas pessoas

usam somente carro para vir a UnB?

• Vamos dizer que você entrevistou N pessoas

aleatoriamente e descorrelacionadas e

obteve as proporções p e q

– M pessoas vinham de carro (p)

– N-M pessoas não vinham de carro (q)

– O que podemos dizer a respeito do seu resultado?

Aplicações

• Primeiro associamos VA a cada probabilidade

– 1 para p & 0 para q

p

M

N

q

N M

N

– M amostras escolheram p e N-M escolheram q

• Então usando a relação da média amostral:

1 N

1

M

X X k M 1 N M 0

p

N k 1

N

N

23

02/04/2014

Aplicações

• Então usando a relação da variância da

amostra:

s2

1 N

1

2

2

2

X k X N 1 M 1 p N M 0 p

N 1 k 1

M 2Mp Np 2

N M

M

2

p p2

N 1

N 1 N

N

N

N

N

2

2

p 2p p

p1 p

pq

N 1

N 1

N 1

Aplicações

• Pelas relações de variância da média sabemos

que:

E X

2

2

N

pq

N 1

• Portanto, a proporção de pessoas que vem de

carro para UnB é aproximadamente

p' p

p1 p

N 1

Aplicações

• Só para fazer uma idéia: digamos que foram

entrevistadas 101 pessoas e que a proporção

p foi de 30%

– Temos então

p' 0.30 0.05

24

02/04/2014

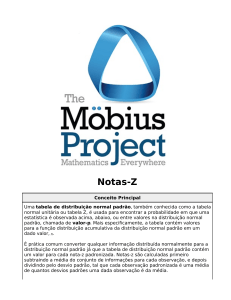

Mapeamentos

• Em muitas aplicações em engenharia temos uma

combinação de entradas (ou estímulos)

aleatórios com determinísticos

• Por exemplo:

– Variações na fabricação de componentes

– Incertezas com relação a posicionamento

– Incertezas devido a variáveis muito complexas

• Nestes casos, temos uma relação (equação ou

procedimento determinístico) associado a efeitos

aleatórios

Mapeamentos

• Nestas situações temos um mapeamento

definido de entradas aleatórias (combinadas

com determinísticas)

– Desejamos saber qual é a estatística da saída

• Frequentemente média e desvio padrão

• Por vezes intervalos de confiança ou mesmo a

distribuição de probabilidade (ou sua densidade) do

resultado

– A técnica mais comum é Monte Carlo

Mapeamentos

• Como funciona Monte-Carlo?

– Temos o mapeamento definido

– Geramos uma quantidade de pontos aleatórios

suficiente para nossa finalidade

– Submetemos cada um desses pontos ao

mapeamento

– Investigamos a estatística da saída

• Média, desvio, distribuição, etc...

25

02/04/2014

Mapeamentos

• Exemplo: mapeamento f(x)

– Geramos os pontos aleatórios (a distribuição tem

de ser conhecida)

X 1 , X 2 ,... X k ,... X N

– Submetemos ao mapeamento e obtemos a

estatística da saída

f X

1

N

N

f X

k

k 1

s

2

f

1 N

f X k f X 2

N 1 k 1

Mapeamentos

• Em casos aonde o problema possa ser

definido de forma analítica, calculamos os

momentos da saída

E f x f x px dx

k

k

Mapeamentos

• Exemplo 6. Um divisor de tensão entre dois

resistores, tem que um deles é uma VA de

distribuição uniforme entre 1 e 2 W. O outro,

aonde a tensão é medida é um resistor de 1

W. Qual é a média e o desvio padrão da

tensão?

V

1

V0

1 x

26

02/04/2014

Mapeamentos

• Usando a definição

1

3

dx ln 0.4054651084V0

1

x

2

1

2

V EV V0

2

1

3

ln dx

1

x

2

1

2

2 V0

3 1

2

2 ln 2 ln ln 3 0.002264712V02

2 6

Mapeamentos

• O desvio padrão é a raiz da variância, logo

0.04758899032V0

• Podemos que dizer (com o erro de 1 desvio)

V 0.4054651084 0.0475889903V0

• Note que o valor considerando tudo

determinístico é 0.4V0

Mapeamentos

• Vamos calcular este resultado por Monte

Carlo

– Para simplificar fazemos V0=1

• Calculamos a tensão em N amostras aleatórias do valor

da resistência (distribuição uniforme entre 1 e 2)

• Resultados

V 0.4046 0.0558V0

V 0.4056 0.0445V0

V 0.4038 0.0483V0

V 0.4054651084 0.0475889903V0

– N=10

– N=100

– N=1000

27

02/04/2014

Mapeamentos

• Código MATLAB – Monte Carlo para o Problema

•

•

•

•

•

•

•

•

•

•

•

•

•

•

% Teste para Monte Carlo

clear

% Número de amostras

N=100000;

% Amostras de resistencia

R=1+rand(1,N);

% Calculo da tensão

V=1./(1+R);

% Média da tensão

Vm=mean(V);

% Desvio da tensão

Vd=sqrt(var(V));

% Escreve a média e o desvio

[Vm Vd]

Mapeamentos

• Note que a convergência não é monotônica

– Monte Carlo tem convergência lenta

• Para N=1.000.000

V 0.4053 0.0475V0

V 0.4054651084 0.0475889903V0

• Este é o maior problema de Monte Carlo –

demanda muitas amostras

Mapeamentos

• E se fizermos pela UT?

– De novo para simplificar fazemos V0=1

• Calculamos a tensão em 3 amostras do valor da

resistência (distribuição uniforme entre 1 e 2)

– R=1.1125, R=1.5, R=1.8875

– w1=0.278, w2=0.444, w3=0.278

• Resultados

V 0.4055 0.0476V0

V 0.4054651084 0.0475889903V0

28

02/04/2014

Mapeamentos

• Código MATLAB – UT para o Problema

•

•

•

•

•

•

•

•

•

•

•

•

•

•

•

•

•

% Teste para UT

clear

% Pontos sigma

sg=[-0.775 0 0.775]';

% Pesos

w=[0.278 0.444 0.278];

% Valores de Resistência

R1=1+1/2*(1+sg);

% Valores de Tensão

V1=1./(1+R1);

% Média

Vm=w*V1;

% Variancia

Va=w*((V1-Vm).^2);

% Desvio

Vd=sqrt(Va);

[Vm Vd]

Mapeamentos

• Finalmente, voltemos ao exemplo 5. Um

divisor de tensão entre dois resistores, tem

que um deles é uma VA de distribuição

uniforme entre 1 e 2 W. O outro, aonde a

tensão é medida também é uma VA de

distribuição uniforme entre 1 e 2 W. As duas

VAs não tem correlação. Qual é a média e o

desvio padrão da tensão?

y

V

yx

V0

Mapeamentos

• Usando a definição

2 2

V EV V0

1 1

y

1

dxdy 0.5V0

yx

2

2

y

1

dxdy

y x 2

1 1

2 2

2 V0

3

9 ln 2 5 ln 3 0.004736820V02

4

29

02/04/2014

Mapeamentos

• O desvio padrão é a raiz da variância, logo

0.06882455957V0

• Podemos que dizer

V 0.5 0.06882455957V0

• Note que o valor considerando tudo

determinístico é 0.5V0

Mapeamentos

• E com relação a distribuição?

– Caso contínuo: Utiliza-se o jacobiano do

mapeamento y=g(u) da função densidade de

probabilidade p(u)

dg 1 y

dg 1 y

pT y p g 1 y

p g 1 y

dg

dy

– A função distribuição de probabilidade

dgdww dw

F y pT wdw p g 1 w

y

y

1

Mapeamentos

• No caso de mapeamentos polinomiais este

cálculo é menos complicado

– A inversa do polinômio pode ser calculada (mas

nem sempre é simples)

– Mapeamento

y g u a2u 2 a1u a0

– Função densidade de probabilidade

pu

u2

1 2

e

2

30

02/04/2014

Mapeamentos

• Portanto

a a 2 4a y 4a a

1

2

2 0

1

2a2

1

u g y

2

a1 a1 4a2 y 4a2 a0

2a2

1

d g 1 y d g 1 y a12 4a2 y 4a2 a0

1

dg

dy

a12 4a2 y 4a2 a0

Mapeamentos

• Portanto, a nova função densidade de

probabilidade

2

1 1 a1 a12 4a2a0 4a2 y

1 1 a1 a1 4 a2 a0 4 a2 y

a2

22

a2

22

1 e

e

p y

2

2

2 a1 4a2 a0 4a2 y

a1 4a2 a0 4a2 y

2

• Para a0=a1=0:

2

y

e 2 a2

p y

2a2 y

Conclusão

• Apresentados os conceitos básicos de

estatística e probabilidade

• Revisados os conceitos de momentos

• Revisados os conceitos de distribuição de

probabilidade e densidade de probabilidade

• Apresentado o conceito de mapeamento

31