Horário T2: 3a feira 10:00-12:00 & 5a feira 8:00-10:00

Horário T8: 3a feira 8:00-11:00 & 5a feira 10:00-12:00

II UNIDADE

“comment ouser parler des lois du hazard?

L'hazard n'est-il pas l'antithèse de toute loi?”.

J. Bertrand

Hélio Magalhães de Oliveira, docteur, ENST, Paris

DE-CCEN

Website do curso

http://www2.ee.ufpe.br/codec/introducao_a_estatistica.html

Variáveis Aleatórias Multidimensionais

Muitas vezes estamos interessados “conjuntamente” na descrição

probabilística

de

mais

de

uma

característica

numérica

de

um

experimento aleatório.

Definição: Seja (Ω, A, P) um espaço de probabilidades. Uma função

X

:Ω →

n

Boreliano de

é chamada de um vetor aleatório se para todo evento B

n

,

X

−1

(B) ∈ A.

Dado um vetor aleatório

X

P X no espaço mensurável (

definimos P X (A) =P( X

−1

, pode-se definir uma probabilidade induzida

n

,Bn) da seguinte maneira: para todo A∈Bn,

(A)).

FUNÇÃO DE DISTRIBUIÇÃO CONJUNTA

Definição: A função de distribuição acumulada conjunta de um vetor

aleatório

X

, representada por F X ou simplesmente por F, é definida por

F X ( X ) = P(C X ) = P(X1≤x1, X2≤x2, ... , Xn ≤ xn), ∀ X ∈

n

.

CASO DISCRETO

(a) Se

X

for um vetor aleatório discreto, ou seja assumir um número

enumerável de valores { x1 , x 2 , ..., }, podemos definir uma função de

probabilidade de massa conjunta, p tal que

• p( x i ) ≥ 0.

•

p ( x ) 1.

i

i 1

VETORES ALEATÓRIOS

O conceito de variável aleatória pode ser estendido para

mapeamento no espaço euclidiano

X:

n-dimensional.

n

exemplo: mapeamento em

3

.

Um vetor aleatório é um mapeamento vetorial tal que:

1) x

, o conjunto no espaço amostral X:={w | X x }

n

corresponde a um evento.

O vetor de

x :=(x1,x2,x3,...,xn) e

X x (X1(w) x1, X2(w) x2, X3(w) x3,…, Xn(w) xn)

2) P(X1(w) x1, X2(w) x2, …,Xi(w)=-,…, Xn(w) xn)=0 (i)

FUNÇÃO DISTRIBUIÇÃO DE UM VETOR ALEATÓRIO

A função distribuição de um vetor aleatório é descrita por

FX:

n

x FX( x ).

Lembrete: o resultado é sempre um número real.

FX( x )=P(X x )=P(X1(w) x1, X2(w) x2, X3(w) x3,…, Xn(w) xn)

A notação mais usual é:

FX 1 , X 2 ,..., Xn ( x1 , x2 ,..., xn ) .

PROPRIEDADES DA FUNÇÃO DISTRIBUIÇÃO DE UM VETOR

ALEATÓRIO

i)

FX 1 , X 2 ,..., Xn ( x1, x2 ,...,,...xn ) 0

ii)

FX1 , X 2 ,..., Xn (,,...,,...,) 1

(normalização AX3)

iii) F é monótona não-decrescente em cada argumento.

iv) F é contínua pela direita em cada argumento.

v) i FX1 , X 2 ,..., X i ,..., Xn (,,..., xi ,...,) FX i ( xi ) .

A aplicação usual de (v) é a reobtenção das distribuições marginais

em cada dimensão:

Partindo de

FX ,Y ( x, y ) :

FX ,Y ( x,) FX ( x)

FX ,Y (, y ) FY ( y ) .

A função densidade de um vetor aleatório também pode ser

definida por extensão:

n

f X ( x ) :

FX 1 , X 2 ,..., X n ( x1 , x2 ,..., xn )

.

x1x2 ...xn

FX 1 X 2 ... X n ( x1 , x2 ,..., xn )

x1

x2

...

xn

f X 1 X 2 ... X n (1 , 2 ,... n )d1d 2 ...d n

PROPRIEDADES DAS DENSIDADES DE VETORES

1) Normalização:

...

f X1X 2 ... X n (1 , 2 ,... n )d1d 2 ...d n 1

2) Não-negatividade:

f X 1 , X 2 ,..., X n ( x1 , x2 ,..., xn ) 0

3) Distribuição Marginal:

xi

FX i ( xi )

...

... f X1X 2 ... X n (1 , 2 ,... n )d1d 2 ...d n

4) Densidade Marginal (caso usual):

f X ( x)

f XY ( x, y )dy e fY ( y ) f XY ( x, y )dx

Há que se estudar e ler detalhadamente definição e propriedades

de densidades de probabilidade condicionadas.

Exercício. Duas linhas de produção fabricam um certo tipo de peça.

Suponha que a capacidade em qualquer dia seja 4 peças na linha

1 e 3 peças na linha 2. Admita que o número de peças realmente

produzida em uma dada linha em um dado dia seja uma variável

aleatória.

Sejam X e Y o número de peças produzido pela linha 1 e 2 em um

dado dia, respectivamente. A tabela a seguir dá a distribuição

conjunta de (X, Y ):

(a) Determine a probabilidade que mais peças sejam produzidas pela

linha 2.

(b) Determine as funções probabilidade de massa marginais de X e Y .

Solução. Em sala.

Exercício:

A distribuição conjunta de duas variáveis aleatórias X e Y é constante (e

igual a c) na superfície S mostrada na figura, e zero fora dela. Encontre

o valor de c e avalie as FDP marginais de X e Y.

Solução. A área total é S=4. Logo c=1/4 e integrando, tem-se

Exercício: Suponha que um vetor aleatório bidimensional (X, Y )

tenha densidade conjunta dada por:

(a) Determine a probabilidade que Y − X > 0.

(b) Determine as densidades marginais de X e Y .

Solução:

parte (a)

parte (b)

etc.

Distribuição condicional de X dada Y discreta

Seja A um evento aleatório tal que P(A)>0. Usando o conceito

de probabilidade condicional, podemos definir a distribuição

condicional de X dado o evento A por

A função de distribuição associada à distribuição condicional é

chamada função distribuição condicional de X dado A:

Seja Y uma variável aleatória discreta, tomando somente os valores y1,

y2, . . .. Então, os eventos An = [Y = yn] formam uma partição de Ω. Neste

caso, a distribuição

Distribuição condicional de X dada Y contínua

desde que fY (y) > 0.

A densidade condicional é

desde que fY (y)> 0 e y não seja ponto de descontinuidade de fY .

Independência entre Variáveis Aleatórias

Teorema: As seguintes condições são necessárias e suficientes para testar

se um conjunto {X1, . . . , Xn} de variáveis aleatórias é mutuamente

independente:

a) Se X for um vetor aleatório contínuo,

b) Se X for um vetor aleatório discreto,

c) Se X for um vetor aleatório contínuo,

Relação entre densidades e INDEPENDÊNCIA ESTATÍSTICA

Independência entre duas v.a.’s X e Y. (desacoplamento)

X e Y Independentes FXY ( x, y) FX ( x).FY ( y)

De modo equivalente:

Independência entre duas v.a.’s X e Y. (desacoplamento)

X e Y independentes f XY ( x, y) f X ( x). fY ( y) .

Do ponto de vista de densidades condicionais, a independência

implica em:

f X |Y y ( x) f X ( x) e fY | X x ( y ) fY ( y ) .

Def. VETORES ALEATÓRIOS INDEPENDENTES.

No caso mais geral de vetores aleatórios, a independência é

definida quando

n

FX1X 2 ... X n ( x1 , x2 ,..., xn ) FX i ( xi )

i 1

Independência simplifica substancialmente as coisas! ...

Funções de Variáveis Aleatórias

[TRANSFORMAÇÕES DE VARIÁVEIS ALEATÓRIAS]

Se existe uma função determinista em cuja entrada é

aplicada uma variável aleatória, a saída TAMBÉM será uma

variável aleatória.

Exemplo.

X é v.a.

Uma função quadrática y=x2. (função)

A variável Y=X2 é aleatória.

=> transformação da v.a. X

Como determinar a distribuição de probabilidades da nova

variável (transformada) Y em termos da distribuição da entrada

X, conhecida?

Vejamos. Y=g(X),

(em termos de f.d.p)

FX(x)=P(Xx)

FY(y)=P(Yy)=P(g(X) y).

[Yy] => [Xx1 ou x2Xx3 ou x4Xx5] disjuntos (P é aditiva)

FY(y)=P(Xx1)+P(x2Xx3)+P(x4Xx5).

Escrevendo agora em termos de integrais:

x1

x3

x5

FY ( y ) f X ( x)dx

x2

x4

1

x

g

1 ( y ) (imagem inversa)

Ora, i

Exercício

f X ( x) e xu ( x) . Seja a transformação Y=X2, quem é fY(.)? y>0:

FY ( y )

0

y

y

f X ( x )dx e x dx 1 e

y

0

FY ( y ) 1 e y u(y) . (deriva-se e obtém-se a densidade).

GENERALIZAÇÃO

x1

x3

x5

FY ( y ) ... f X ( x)dx

x2

x4

xn

Para a determinação da densidade de probabilidade, usa-se a

REGRA DE LEIBNITZ

d

d

a ( )

b( )

a ( )

da( )

db( )

f ( x, )dx f a( ),

f b( ),

f ( x, )dx

b

(

)

d

d

(digam-me: um “cabra” vendo uma expressão destas, não fica

feliz em fazer Engenharia ou Ciências exatas?)

Aplicando-a na expressão de FY

fY ( y )

FY ( y )

dx

dx

dx

dx

dx

dx

f X ( x1 ) 1 f X ( x3 ) 3 f X ( x2 ) 2 f X ( x5 ) 5 f X ( x4 ) 4 ... f X ( xn ) n

y

dy

dy

dy

dy

dy

dy

f Y ( y ) f X ( xi )

i

dx i

dy

fY ( y )

i

dxi

f X ( g ( y ))

dy

1

i

g i1 ( y )

.

JACOBIANO da transformação

No caso de vetores aleatórios,

f Y ( y ) f X ( g i1 ( y )) || J ||1

i

g i1 ( y )

Funções biunívocas e diferenciáveis:

Y=g(X), Y=(g1(X), g2(X),..., gn(X)).

g1

x1

g 2

J ( X ) x1

g n

x

1

g1

x2

g 2

x2

g n

x2

g1

xn

g 2

xn

g n

xn

use |det(J(X))|.

Exemplo resolvido.

A transformação de um vetor bidimensional gaussiano em

coordenadas polares, X e Y independentes.

(X,Y) (r,).

Qual a distribuição conjunta da amplitude e da fase, fr( r,)?

Sejam r

x y ;

2

2

y

x

tg 1

O jacobiano da transformação é

r

x

J

x

x

r

x2 y2

y

y

y

x2 y2

y

x2 y2

x

x2 y2

| J | det J

Assim,

Como

f r ( r , )

f XY ( x, y )

r

e

2

| J |

2

1

x2 y2

x2 y2

2 2

1

r.

r

2

2

e

r2

2

2

não aparece em fr, f() deve ser constante (v.a.

uniforme). Como a variável fase é distribuída entre (0,2):

r2

1 r 2 2

f r ( r , )

. 2e

f r ( r ). f ( )

2

As variáveis transformadas são independentes:

amplitude Rayleigh e fase uniforme.

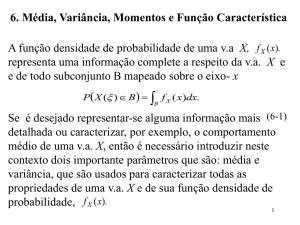

VALOR ESPERADO E MOMENTOS

Uma variável assume valore REAIS. Assim, é possível realizar cálculos,

médias, modas, desvios...

Existem quatro tipos de interpretações da Esperança:

1. Parâmetro m de uma medida de probabilidade, função de

distribuição,

ou

função

probabilidade

de

massa,

também

conhecido como média. Interprete como médias “ponderadas” pela

probabilidade de ocorrência.

2. Um operador linear em um conjunto de variáveis aleatórias

que retorna um valor típico da variável aleatória interpretado

como uma medida de localização da variável aleatória.

3. média do resultado de repetidos experimentos independentes

no longo prazo.

4. preço justo de um jogo com pagamentos descritos por X.

O valor esperado de uma variável aleatória X é definido por

n

E ( X ) : P ( X xi ) xi

k 1

E ( X ) :

xf X ( x)dx

CASO DISCRETO

CASO CONTINUO

Exemplo:

Considere uma variável aleatória X tal que: P(X=−a)=P(X=a)=1/2. Então,

EX=−a(0.5)+a(0.5)=0.

Muitas variáveis aleatórias diferentes podem ter o mesmo valor esperado

ou esperança (e.g. variar o valor de “a” no exemplo anterior).

Exercício: Se X∈{1,2,...,n} for uma variável aleatória com

distribuição de probabilidade uniforme, então a esperança é dada

por:

1

1 n(n 1) (n 1)

E( X ) i .

n

2

2 .

i 1 n

n

BERNOULLI & BINOMIAL.

Bernoulli. Se X∈{0,1} for uma variável aleatória com distribuição de

probabilidade Bernoulli com parâmetro p, sua esperança é dada por:

EX=0(1−p)+1(p)=p.

Binomial. Se X for uma variável aleatória com distribuição de

probabilidade Binomial com parâmetros n e p, sua esperança é dada por:

n

n k

n!

nk

E ( X ) k . p (1 p ) k .

p k (1 p ) n k

k!(n k )!

k 0 k

k 1

n

(n 1)!

p.n.

p k 1 (1 p ) n k np.

k 1 ( k 1)!( n k )!

n

Propriedades da Esperança

1. P(X=c)=1 ⇒ EX=c.

2. P(X≥0)=1 ⇒ EX≥0.

3. E(aX)=aEX, em que “a” um número real qualquer.

4. E(X +Y) = EX + EY .

5. P (X ≥ Y) = 1 ⇒ EX ≥ EY.

6. Se {X1,...,Xn} são variáveis aleatórias mutuamente

n

n

X i E ( X i ) .

independentes, então E

i 1

i 1

Pode-se definir outras medidas de posição de uma variável aleatória, tais

como: mediana e moda.

A mediana de uma v.a. X é qualquer número m tal que

P(X≥m)≥0,5 e P(X≤m)≥0,5.

Se X assume os valores −1,0,1 com probabilidades

1/4,1/4,1/2,

respectivamente,

então

qualquer

número no intervalo [0, 1) é mediana de X.

A moda de uma v.a. discreta é o seu valor mais provável.

A moda da v.a. X do exemplo anterior é 1.

VARIÂNCIA

var X : E X E ( X ) 2 resultando em: var X EX 2 EX 2 .

O segundo momento é uma medida do “espalhamento da v.a.”.

Pode ser calculado “centrado” em qualquer ponto, digamos c:

s : E X c . A

2

variância

(2o

momento

central)

é

o

espalhamento calculado com relação ao “centro” da distribuição.

Proposição.

2

2

var X E X E ( X ) Min E X c

, i.e., a variância é uma medida

cR

do mínimo espalhamento de uma distribuição.

Prova.

(X-c)=(X-E(X)+c-E(X)), quadrando e tomando E(.), tem-se:

E(X-c)2=varX-2E(X-E(X))(c-E(X))+(c-E(X))2. Então,

varX=E(X-c)2+, com >0, pois =(c-E(X))2.

Q.E.D.

Propriedades da Variância

As seguintes propriedades são consequências imediatas.

1. VarX ≥ 0.

2. Se X=c, Var(X)=0.

Prova: Temos que EX=c,

logo Var(X)=E(X−c)2=E(0)=0.

3. Var(X+a)=VarX, em que a é uma constante real.

Prova:

Var(X+a)=E(X+a)2−(E(X+a))2=

=EX2+2aEX+a2−(EX)2−2aEX−a2=EX2−(EX)2=VarX.

4. V ar(aX) = a2VarX

Prova:Var(aX)=E(aX)2−(E(aX))2=a2EX2−a2(EX)2=a2VarX.

5. Se X e Y forem variáveis aleatórias mutuamente

independentes, então Var(X+Y)=VarX +VarY.

Prova:Var(X+Y)=E(X+Y)2−[E(X+Y)]2=E(X2+2XY+Y2)−(EX)2−2EX

EY−(EY)2=EX2+EY2−(EX)2−(EY)2+2E(XY)−2EXEY =VarX+VarY.

6. Se X1,..., Xn são variáveis aleatórias independentes, então

Var(X1+···Xn)=VarX1+···+VarXn. Por indução matemática.

Exemplo. (Uniforme Discreta) Se X tem uma distribuição

uniforme discreta assumindo os valores {x1, x2, . . . , xn} com

mesma probabilidade, então:

var X

2

1

1

2

x

x

.

i

2 i

n i 1

n i 1

n

n

Isto permite definir uma série de médias (momentos) de uma v.a.

E(X), E(X2), E(X3),..., E(Xn)

E os respectivos momentos centrais, relativos à média

=E(X)

(funcionam com o cálculo do centro de massa, momentos de

inércia etc.)

E(X-), E((X-)2), E((X-)3),..., E((X-)n).

Os momentos relevantes são sempre os primeiros, de ordem mais

baixa:

E(X), média ()

E(X2), 2º momento

E(X-)=0 (sem uso),

E((X-)2), variância (2)

Primeiro (medida do comportamento médio)

Segundo (medida de espalhamento e variação, daí o nome)

O desvio padrão é também largamente usado, expressando ideia

similar à variância, mas com interpretação física atrativa

2 : E{( X ) 2 }

Momentos de ordem mais elevada são menos usados.

Entre estes:

LIGADO AO 3º MOMENTO

Coeficiente de assimetria da distribuição

3 :

E ( X )3

3

LIGADO AO 4º MOMENTO CENTRAL

Coeficiente de curtose da distribuição

4 :

E ( X )4

4

.

CASO DE DUAS VARIÁVEIS: momentos conjuntos

X, Y

E(XnYm)

E{(X-X)n(Y-Y)m}.

Se n ou m são nulos, os momentos são marginais, não cruzados.

Para momentos “cruzados”, requer-se n,m0. Os momentos de

menor ordem deste tipo são

CORRELAÇÃO

E(XY):= corr(X,Y)=RX,Y ou

COVARIÂNCIA

E{(X-X)(Y-Y)}:=cov(X,Y)=KX,Y.

Observe o nome co-variância (variância, 2º momento, co=entre

variáveis).

Significado como medida de dependência.

(relação linear => correlação)

Proposição. Variáveis aleatórias

X i in1

n

n

var X i var( X i ) 2 cov( X i , X j )

.

i j

i 1 i 1

Corolário. Variáveis aleatórias

X i in1

independentes

n

n

var X i var( X i )

.

i 1 i 1

INDEPENDÊNCIA E MOMENTOS

X e Y independentes (usando o desacoplamento entre densidades)

E(XnYm)=E(Xn).E(Ym) n,m

Existem os dois tipos de momentos (cruzados) de 2ª ordem

E(XY)

E{(X-X).(Y-Y)}=E(XY)-XY.

Cov e corr são relacionados.

Teste preliminar:

Se E(XY)=E(X)E(Y), então há um “desacoplamento parcial”, de 2ª

ordem.

Neste caso, cov(X,Y)=corr(X,Y)-E(X).E(Y)=0

ISTO É REFERIDO (por abuso) como correlação nula.

Karl Pearson (coef. de correlação).

O coeficiente dito coeficiente de correlação normalizado (deveria

ser de covariância!) é

XY :

K XY

X Y

Mostra-se (próximo slide) que -1 +1.

O caso =0 é definido na literatura como correlação nula.

(não covariacionados, termos “mais correto”, soa estranho e

nunca é usado!)

Teorema: (E(XY))2≤EX2EY2 e (Cov(X,Y))2≤VarX.VarY.

Prova: (aX+Y)2≥ 0 ⇒ E(aX+Y)2≥ 0 ⇒ a2EX2+2aEXY + EY2≥0.

Observe que está equação do segundo grau em “a” não pode ter

duas raízes reais diferentes, pois caso contrário essa expressão

seria negativa para os valores intra-raízes. Pela regra do

discriminante, tem-se: 4(EXY)2−4EX2EY2≤0, e prova-se a

primeira desigualdade.

A

segunda

parte

segue

da

primeira

trocando

X

X−EX e Y por Y−EY na expressão da primeira desigualdade.

por

Exemplo:

Se X é uma variável aleatória gaussiana normalizada ~N(0, 1) e

Y:=X2, mostre que X e Y são não correlacionadas, i.e Corr(X,Y)=0.

Elas são independentes? O que nos ensina este exercício?

Veja que cov(X,Y)=E(XY)-E(X)E(Y)=E(XY)=E(X3)=0, mas X e X2

são obviamente DEPENDENTES!

Lição: Uma ilustração que a recíproca da proposição

«Se X e Y forem independentes, então cov(X,Y)=0» nem sempre

é verdadeira: cov entre duas v.a.’s pode ser nula e elas não serem

independentes.

Cuidados com correlações espúrias

Sempre que há alguma relação (quase) linear entre as variáveis,

há uma alta correlação. Porém a reciproca não é verdadeira: a

existência de alta correlação (até próximo à unidade) não

assegura dependência entre as variáveis.

relação correlação, mas correlação

relação...

Exemplos (consulte, e.g. http://tylervigen.com/)

:-) Correlação entre US spending on science, space, and technology

correlates with Suicides by hanging, strangulation and suffocation

r=0,9979

r=0,9926

SIMULAÇÃO MONTE CARLO*

Estimativa de algibeira para o número de simulações necessárias

para estimar a frequência relativa de evento de probabilidade p

(p desconhecida).

Suponha que você deseja simular um sistema e avaliar uma taxa

de erros ou taxa de acertos (e.g. de peças em uma linha de

montagem, de uma transmissão digital, taxa de colisão de

partículas etc.).

A cada simulação, efetuam-se n repetições do evento e obtendo

um resultado diferente cada vez que a simulação for realizada. O

valor médio é um estimador da probabilidade p (vide anexo).

Embora p<<1 seja desconhecida (típico), deve simular de modo a

garantir um espalhamento pequeno em trono da média, digamos

10% (ou 1%).

=0,1

(critério 10%)

Exemplo. Ao estimar em computador a probabilidade de um

evento que você “desconfia” em uma estimativa grosseira ter

probabilidade da ordem de 10-4, (querendo simular para

encontrar uma estimativa probabilisticamente confiável), use:

N.B. Se o valor da estimativa for

, por exemplo, bem

inferior a sua estimativa inicial, refaça as contas sobre n e refaça

a simulação...

O método clássico de simulação, chamado MONTE CARLO (N.B.

nome inspirado nos casinos no principado de Monte Carlo),

certamente não é indicado para avaliar a taxa de eventos com

probabilidades muito pequenas, e.g., 10-9. (see importance

sampling)

ANEXO. Para um experimento de Bernoulli, k sendo o número de sucessos e n

o número de repetições do experimento, k é uma variável aleatória com

distribuição binomial.

E(k)=np e var(k)=2(k)=np(1-p).

Seja a estimativa de frequência relativa para a probabilidade p do evento

estudado (e repetido):

. Como k é uma variável aleatória,

também o é.

1.

, o estimador é não enviezado.

(o valor médio das diversas simulações tende a fornecer o valor de p)

2.

de modo que o espalhamento relativo à média vale

.

(p pequeno)

Integração Monte Carlo

Hit or miss technique

0g(x)c em axb.

Seja o espaço amostral

b

Deseja-se avaliar S : a g ( x)dx

: {( x, y ) a x b,0 y c}

E uma distribuição 2D-uniforme

p :

S

area ()

N realizações

1

se ( x, y )

f X ,Y ( x, y ) : c(b a)

caso contrário

0

aleatória.

estimador de frequência relativa

pˆ :

nhits

N

ALGORITMO

1. Gere 2N números aleatórias uniformes {Uj}

2. Arranje-os em N pares (U1,U’1), ..., (UN,U’N)

g ( X i ) i=1,2,...,N.

3. Calcule X i a U i (b a) e

4. Conte o número de casos n hits para os quais g(Xi)>cU’i

5. Estime a integral por c(b a) pˆ z

p.(1 p)c(b a)

N

J. Von Neumann (EUA, imigrante Húngaro)

Aplicações

Otimização global (programação matemática)

Sistemas de equações lineares

Integrais múltiplas

Cadeias de Markov

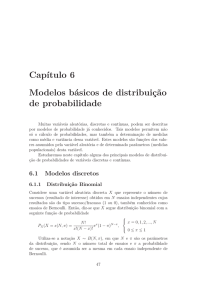

DISTRIBUIÇÃO DE BERNOULLI

Uma v.a. X tem uma distribuição Bernoulli com parâmetro p, em

que 0≤p≤1, se X(w)∈{x0,x1} e p(x1)=p=1−p(x0).

A função de probabilidade Bernoulli pode ser utilizada para

modelar a probabilidade de sucesso em uma única realização de

um

experimento.

Em

geral,

qualquer

variável

aleatória

dicotômica, ou seja que assume somente dois valores, pode ser

modelada por uma distribuição

Bernoulli.

Denomina-se

de

ensaio

de

Bernoulli,

qualquer

experimento que tem uma resposta dicotômica.

Binomial. X~B(n,p)

Dizemos que X tem uma distribuição Binomial com parâmetros n

e p, em que n é um número inteiro e 0≤p≤1, se X(w)∈{0,1,...,n}

e p(k) para k∈{0,1,...,n}. Note que utilizando o Teorema Binomial,

temos que

n k

nk

n

p

(

k

)

p

(

1

p

)

(

p

1

p

)

1

k

.

k 0

k 0

n

n

valor mais provável: examinar a função probabilidade de massa

binomial analiticamente. Note que a razão entre as probabilidades

de dois valores consecutivos da binomial

n!

p k (1 p ) n k

p(k )

n k 1 p

k!(n k )!

.

n

!

p (k 1)

k

1 p .

p k 1 (1 p ) n k 1

(k 1)!(n k 1)!

p (1)

np

1,

Portanto, se p (0) 1 p

então as probabilidades são sempre

decrescentes em k, e o valor mais provável é 0.

p ( n)

1 p

1,

No outro extremo, se p (n 1) n 1 p

então as

probabilidades são estritamente crescentes em k, e o valor mais

provável é n.

1

p

n

Se n 1 p

então a função começa crescendo em k, enquanto

n k 1 p

1

k

1 p

, e depois decresce em

k.

p(k )

n k 1 p

1

k

1 p

Assim, se p (k 1)

para algum valor de k*, tem-se

que k* e k* −1 são os valores mais prováveis.

Caso contrário, o valor mais provável será o maior valor de k para

p(k )

n k 1 p

1

k

1 p

o qual p (k 1)

, i.e., o valor mais provável será o

maior valor de k tal que k<(n+1)p.

Resumindo o comportamento da binomial B(n,p):

p

Avalie-se 1 p . Verifique a faixa em que este valor situa-se:

0

p

1

1 p n

1

p

n

n 1 p

Sempre decrescente Cresce, decresce

p

n

1 p

Sempre crescente

Valor mais provável =pico da distribuição = moda

*

k =0

k * (n 1) p

k*=n

Ilustração dos três casos:

B(3, 0.2)

B(10, 0.1)

B(3, 0.8)

p

0.25

1 p

p

0.111 ...

1 p

p

4

1 p

k*=0

k*=1

k*=n=3

A função geradora de MOMENTOS G(t)

V.A. discreta, assumindo valores {pk}

função polinomial em t, com coeficientes pk:

G(t):=

Bernoulli:

n n

G t = p k q n k t k

k =0 k

G t = q + pt

n

Todo o “conteúdo” disponível na distribuição de probabilidade está

contido nela!

NOTE QUE

1)

E(X0)=G(1)=1

2)

E(X)=G'(1)

3)

E(X2)=G''(1)+G'(1)

4)

Var(X)=G''(1)+G'(1)-[G'(1)]2

Média e variância da Binomial:

G(1)=1

G'(1)=n.p

daí:

◦

◦

média = n.p

variância= n.p.(1-p)

G''(1)=n(n-1)p2

DISTRIBUIÇÃO GEOMÉTRICA X~Geo()

Um v.a. X tem uma distribuição Geométrica com parâmetro β,

em que 0≤β<1, se X(w)∈{1,2,3,...} e p(k)=(1−β)βk−1, para

k∈{1,2,3,...}.

Utilizando o resultado de uma soma infinita de uma Progressão

Geométrica, tem-se que

k 1

k 1

k 1

p

(

k

)

(

1

)

1

.

A função de probabilidade Geométrica pode ser utilizada para

modelar:

o número de repetições do lançamento de uma moeda até a

primeira ocorrência de cara

O tempo de espera medido em unidades de tempo inteira até

a chegada do próximo consumidor em uma fila

a próxima emissão de um fóton.

Memória (ou falta dela)

Distribuição

sem

memória:

Suponha

que

X

tenha

uma

distribuição geométrica com parâmetro β. Mostre que para

quaisquer dois inteiros positivos s e t, P(X>s+t |X>s)=P(X>t).

P( X s t , X s) P( X s t )

P( X s t | X s)

.

Prova.

P( X s)

P( X s)

Mas:

Também

P( X s t )

(1 )

k 1

s t .

k s t 1

P( X s)

k 1

s

(

1

)

. O resultado segue.

k s 1

DISTRIBUIÇÃO BINOMIAL NEGATIVA OU PASCAL X~Pas(p,r)

Esta distribuição é uma generalização óbvia da distribuição

geométrica.

Suponha que ao invés de estarmos interessados no número de

repetições

de

um

experimento

até

a

primeira

ocorrência de um evento, estejamos interessados em calcular o

número de repetições até a r-ésima ocorrência de um evento.

Seja X o número de repetições necessário a fim de que

um evento A possa ocorrer exatamente r vezes.

Tem-se que X= k se, e somente se, A ocorrer na k-ésima repetição

e A tiver ocorrido r−1 vezes nas (k−1) repetições anteriores.

Assumindo

independência

entre

os

experimentos,

k 1 r

p (1 p ) k r

probabilidade é igual r 1

. Portanto,

k 1 r

p (1 p ) k r

P ( X k )

, em que k≥r.

r 1

r

Momentos: E(X)= p

r (1 p )

var(X)= p 2 .

esta

Note que se r=1, temos que X tem uma distribuição geométrica

com parâmetro β=1−p. No caso geral, dizemos que X tem uma

distribuição Binomial Negativa ou Pascal.

DISTRIBUIÇÃO DE POISSON X~Poi().

Dizemos que X tem uma distribuição Poisson com parâmetro λ,

em que λ≥0, se X(w)∈{0,1,...} e

p(k ) e

k

k! , para k∈{0,1,...}.

Efetuando a soma usando a expansão McLaurin da exponencial,

k

p(k ) e k! e .e 1.

k 0

k 0

Logo, esta é uma legítima função probabilidade de massa.

Simeon Poisson (Sceaux, France).

Se X for uma v.a. com distribuição de probabilidade Poisson de

parâmetro λ:

k.e

k

e

k 1

.

Média

E(X)= k 0

Variância

VarX = E(X2)-(EX)2=λ2+λ−(λ)2 = λ.

k!

k 0

(k 1)!

A função de probabilidade Poisson é utilizada para modelar a

contagem do número de ocorrências de eventos aleatórios em um

certo tempo T : número de fótons emitidos por uma fonte de luz

de intensidade I fótons/seg em T segundos (λ =I.T), número de

clientes chegando em uma fila no tempo T (λ=CT), número de

ocorrências de eventos raros no tempo T (λ=CT).

A distribuição de Poisson pode ser introduzida como uma

binomial quando o número de tentativas cresce indefinidamente,

n ,

com

p 0,

mas de forma que

np .

k

n

n k

nk

nk

P ( X k ) p (1 p ) (1 )

.

n

k

k n

Quando n é suficientemente grande,

k

n 1

1

k! ;

k n

Deste modo

(1 ) k 1 ;

n

(1 ) n e .

n

k

lim

p(k ) e

n

k! , k=0,1,2...

Exercício:

Suponha que o número de clientes que chegam em um banco

segue uma distribuição de Poisson. Se a probabilidade de

chegarem 3 clientes for o triplo da de chegarem 4 clientes em um

dado período de 10 minutos. Determine:

(a) Qual o número esperado de clientes que chegam em um

período de 1 hora neste banco?

(b) Qual o número mais provável de clientes que chegam em um

período de 1 hora neste banco?

Moda de uma distribuição de Poisson: razão de dois valores

sucessivos da função probabilidade de massa

pk 1

.

pk

k 1

pk

.

então vale também: p

k

k 1

Um valor mais provável de uma distribuição de Poisson é k∗ tal

que pk+1≤pk∗ e pk-1≤pk∗ . Mas esta condição é equivalente a:

K*≤λ≤k*+1, ou λ−1≤k*≤λ.

Esse é um máximo local. Porém a distribuição é unimodal (tem

um único máximo, ou seja, máximo local é o máximo global). Isso

pode ser inferido do comportamento monotonico em k, em

ambos os lados de k* (crescente à esquerda, decrescente à direita).

Poisson: =<k>. N.B. Raias

Exercício: Os dados da tabela abaixo compilam, em um período de

50 dias, o número X de acidentes de automóvel ocorridos em uma

pequena cidade de interior.

# de acidentes

# de dias

1

18

3

3

0

2

4

21

7

1

a) Calcule E(X)

b) ajuste por uma distribuição de Poisson, recalcule os valores

de P(X=k), para k=0,1...4 e compare com os dados fornecidos.

Comente.

Solução (em sala).

O processo de Poisson corresponde ao caso em que é constante,

expresso por unidade de tempo, de modo que

p(k ) e

t

( t ) k

k! .

Mecânica Quântica⇒ emissão de fótons é modelada com extrema

precisão por um processo de Poisson.

Aplicação em quimiometria:

espectroscopia (espectroscopia por correlação de fótons)

DISTRIBUIÇÃO HIPERGEOMÉTRICA X~H(r,n,N)

A distribuição hipergeométrica descreve o número de sucessos em

uma sequência de n amostras de uma população finita sem

reposição.

Ex: uma carga com N objetos dos quais D têm defeito.

A distribuição hipergeométrica descreve a probabilidade de que em uma

amostra de n objetos distintos escolhidos da carga aleatoriamente

exatamente k objetos sejam defeituosos.

Em geral, se uma variável aleatória X segue uma distribuição

hipergeométrica com parâmetros N, D, e n, então a probabilidade

de termos exatamente k sucessos é dada por:

D N D

k

n

k

.

p (k )

N

n

Esta probabilidade é positiva se: N−D ≥ n−k, ou seja,

k≥max(0,D+n−N), e k ≤ min(n,D).

Esta fórmula pode ser entendida assim:

N

existem n possíveis amostras sem reposição.

D

existem k maneiras de escolher k objetos defeituosos e

N D

existem n k maneiras de preencher o resto da amostra com

objetos sem defeito.

Exercício: Por engano 3 peças defeituosas foram misturadas com

boas formando um lote com 12 peças no total. Escolhendo ao

acaso 4 dessas peças, determine a probabilidade de encontrar:

(a) Pelo menos 2 defeituosas.

(b) No máximo 1 defeituosa.

(c) No mínimo 1 boa.

Solução. N=12, D=3, n=4. max(0,3+4−12)≤ k ≤ min(4,3).

a) k=2 ou (xor) k=3.

p(2)+p(3)

b) K=0 ou (xor) k=1. p(0)+p(1)

c) p(0)+p(1)+p(2)+p(3)=1.

RESUMOS

http://www.wolframalpha.com/input/?i=bernoulli+distribution

http://www.wolframalpha.com/input/?i=binomial+distribution

http://www.wolframalpha.com/input/?i=geometric+distribution

http://www.wolframalpha.com/input/?i=pascal+distribution

http://www.wolframalpha.com/input/?i=poisson+distribution

http://www.wolframalpha.com/input/?i=hypergeometric+distribution

RELAÇÃO ASSINTÓTICA

Quando a população é grande quando comparada ao tamanho da

amostra (ou seja, N>>n) a distribuição hipergeométrica é

aproximada razoavelmente bem por uma distribuição binomial

com parâmetros

n (tamanho da amostra) e

p=D/N (probabilidade de sucesso em um único ensaio).

E(X)=nD/N

var( X )

nD ( N D)( N n)

N

N ( N 1)

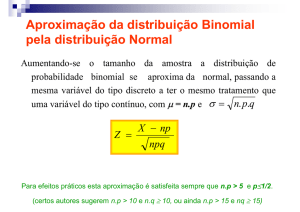

TEOREMAS ASSINTÓTICOS

Dá um “trabalhão” calcular estas expressões quando n é grande!

TEOREMA DE “DE MOIVRE-LAPLACE”

Assumindo que

n é grande e também de modo que n.p.(1-p)>>1, então

Vale uma aproximação Gaussiana para a Binomial:

n k

p (1 p ) k

k

( k np ) 2

1

e 2 np (1 p )

2np (1 p )

Assim, o cálculo da probabilidade da ocorrência entre

evento nos

k1 e k2 vezes o

n ensaios pode ser estimado por:

k2

k k1

k2

n k

1

k

p (1 p )

e

k

1

2np (1 p )

k

( x np ) 2

2 np (1 p )

dx

Integral Gaussiana – Tabelada.

k2

k k1

Função Q(.) ou erf(.) ou (.)

k 2 np

k1 np

n k

nk

p (1 p )

n. p.(1 p )

n. p.(1 p )

k

(tirar pirulito de criança!)

Aproximação

II. n

A aproximação proposta por De Moivre requer

Nos casos em que

n.p>>1.

n.p1, isto não é válido. Considera-se agora:

TEOREMA DE POISSON n

k

n k

nk

np ( np )

p (1 p ) e

k!

k

Se n e p0, mas com a relação n.pa, tem-se

k

n k

nk

a (a)

p (1 p) e

k!

k

.

Isto definirá a variável aleatória de Poisson.

Teorema: Se limn→∞ npn = α > 0, então

k

lim n k

nk

a (a)

pn (1 pn ) e

.

n k

k!

Exercício: Ao formar números binários com n dígitos, a

probabilidade de que um dígito incorreto possa aparecer é 0,002.

Se os erros forem independentes, qual é a probabilidade

de encontrar k dígitos incorretos em um número binário de 25

dígitos?

Solução: A probabilidade de que k dígitos sejam incorretos em um

25

(0,002) k (0,998) 25 k

número binários de 25 dígitos é igual a k

.

Em particular, a probabilidade de que pelo menos um dígito seja

incorreto é 1−(0,998)25≈0,049.

Ao adotar a aproximação de Poisson, considera-se uma Poisson

com parâmetro 25×0,002=0,05 o que resulta (complemento de

k=0) em 1−e0,05≈0,049.

Aproximação assintótica para a distribuição de Poisson

O teorema de De Moivre-Laplace estabelece que, sob certas

condições, uma binomial pode ser aproximada por uma gaussiana.

A distribuição de Poisson foi desenvolvida como sendo o limite de

uma binomial quando o n. de tentativas cresce indefinidamente.

De se esperar, a distribuição de Poisson também pode ser

aproximada por uma gaussiana quando >>1.

f X ( x)

1

22

( x ) 2

e

2 2

Resumo de alguns modelos discretos

V.a. discreta

Valor esperado

variância

Uniforme ~U(1,K)

1 K

2

K 2 1

12

Bernoulli ~B(p)

p

p(1-p)

Binomial ~B(n,p)

np

np(1-p)

Geométrica ~G()

1

1

(1 ) 2

Pascal ~Pas(p,r)

r

p

r (1 p )

p2

Poisson ~P()

Hipergeométrica~H(r,N,n)

nr

N

nr ( N n)( N r )

N 2 ( N 1)

DISTRIBUIÇÕES CONTÍNUAS

Uniforme

Normal (Gaussiana)

t-student.

GAUSSIANA

f X ( x)

1

2 2

e

( x )2

2 2

UNIFORME

1

f X ( x) b a

0

a xb

caso contrário

Distribuição Uniforme

X~U[a,b]

Dizemos que X tem uma distribuição uniforme com parâmetros a

e b (números reais, a<b), se a função densidade de X é igual a

fX(x)= b 1 a .u(x−a)u(b−x).

http://www.wolframalpha.com/input/?i=uniform+distribution

Este modelo é frequentemente usado impropriamente para

representar

“completa

ignorância”

sobre

valores

de

um

parâmetro aleatório sobre o qual apenas sabe-se estar no

intervalo finito [a, b].

Exercício. (Uniforme Contínua.) Se X tem uma distribuição

uniforme em [a,b], então:

E( X )

1

1 x2

x.

dx

ba

ba 2

b

a

E( X )

2

b

a

b

a

3 b

1

1 x

x .

dx

ba

ba 3

2

a

ab

2 (o valor esperado é o esperado!)

b3 a 3

3(b a )

(b-a)2

varX

Variância:

12 .

Variável Aleatória Uniforme

1

f X ( x) b a

0

a xb

caso contrário

Distribuição uniforme ~U(-1,1)

Exercício: Sabe-se que é igualmente provável que um dado cliente

possa requisitar um serviço no tempo disponível de serviço [t0, t1].

Se o tempo necessário para executar este serviço é igual a τ<t1-t0,

qual a probabilidade que o serviço será executado antes do

término do intervalo de tempo disponível de serviço?

Solução: Para que o serviço seja executado em tempo hábil, é

necessário que o cliente o requisite antes de t1−τ. Logo,

1

P(X≤t1−τ)= t t

1

0

t1

t0

dt

t1 t0

t1 t0 .

NORMAL OU GAUSSIANA

X ∼N(µ,σ)

Diz-se que X tem uma distribuição Normal (ou Gaussiana) com

parâmetros µ e σ (em µ e σ>0 são números reais), se a função

1

f

(

x

)

e

densidade de X é igual a X

2

2

( x )2

2 2

.

http://www.wolframalpha.com/input/?i=normal+distribution

Esta é realmente uma função densidade de probabilidade:

Fazendo a substituição de variáveis t=(x−µ)/σ, obtém-se:

1

e

2

( x )2

2 2

dx

2

1 t2

e dt : I

2

Para o cálculo de I, usa-se o seguinte artifício:

1

I

2

2

e

t 2 / 2

dt e

s2 / 2

1

ds

2

e

(t 2 s 2 ) / 2

dtds.

Fazendo a mudança de variável t=rcos e s=rsen (polar),

1

dtds=rdrd I 2

2

2

0

0

re

r 2 / 2

drd . Integrando, vem: I2=1.

Historicamente, esta distribuição foi chamada de

“normal” porque ela era amplamente aplicada em fenômenos

biológicos e sociais que era sempre tida como a distribuição

antecipada ou normal.

Os parâmetros µ e σ2 devem ser

ajustados de modo que a representação seja válida.

1) a densidade é simétrica em torno do parâmetro µ,

2) quanto menor o parâmetro σ mais concentrada é a densidade

em torno deste parâmetro µ.

3) os pontos µ−σ e µ+σ são os pontos de inflexão do gráfico de fX.

4) µ e σ2 são a esperança e a variância da distribuição, respect.

5) Se µ=0 e σ2=1 esta densidade é chamada normal reduzida.

Cálculo da esperança (média).

x

E( X )

e

2

( x )2

2 2

dx

, fazendo a mudança de variável

Z:=(x-)/, vem

z

E( X )

e

2

z

e

2

z2

2

z2

2

dz

dz

e

2

z2

2

dz 0

Cálculo do 2o momento.

x

2

E( X )

2

2

e

( x )2

2 2

dx

, fazendo a mudança de variável

Z:=(x-)/, vem

(z )

E( X )

e

2

2

2

z

e

2

2 2

z2

2

z2

2

dz

2z

dz

e

2

z2

2

dz

2

2

e

z2

2

dz .

Então:

E( X )

2

2

2

2

z e

z2

2

2

dz

2

ze

z2

2

dz

2

2

e

z2

2

dz

A 2a parcela é nula (média da normal padrão). A última parcela

decorre da área normalizada. Resta:

E( X )

2

Logo

2

2

var X 2

z2

2

2

z e

Q.E.D.

dz 2

. Integrando:

E( X 2 ) 2 2

Distribuição normal (variando a média e desvio).

Transformações lineares de distribuições normais

Conservação: Transformações lineares de variáveis aleatórias com

distribuição normal também são distribuídas normalmente.

Teorema: Se X ∼N(µ,σ2) e se Y =aX +b, em que a>0 e b∈ , então

Y tem distribuição Y∼N(aµ+b, a2σ2).

Prova.

fY ( y )

FY ( y ) P (Y y ) P ( X

y b

y b

) FX (

).

a

a

1 1

1

y b

e

fX (

). Então fY ( y )

a 2

a

a

y b

)2

a

2 2

(

Derivando,

1

f

(

y

)

e

ou Y

a 2

( y [ b a ]) 2

2 a 2 2

.

Corolário.

Se

X∼N(µ,σ2),

então

Y=X/σ−µ/σ=(x-)/

tem

distribuição normal padrão.

Tabulação da Distribuição Normal

A

integral

de

uma

gaussiana

não

pode

ser

resolvida

analiticamente, contudo métodos de integração numérica podem

ser empregados para calcular integrais. A função de distribuição

acumulada de uma normal padrão é usualmente denotada por Φ.

1

(

t

)

:

2 e

Portanto,

t

para qualquer X∼N(µ,σ

2

2

2

d .

b

a

), o valor de P(a<X≤b) é

Exercício: Suponha que X tenha uma distribuição N(2;0,16).

Empregando a tábua de distribuição normal, calcule P(X ≥ 2,3).

2,3 2

P

(

X

2

,

3

)

1

P

(

X

2

,

3

)

1

1 0,7734 0,2266.

Solução.

0,4

A seguinte aproximação (cálculo numérico) pode ser útil:

( x) 1

1

1 x

1

1

x 2 2 3

.

1 x2 / 2

e

2

Exercício: Certo tipo de bateria elétrica dura, em média, três anos

com um desvio padrão de 0,5 anos. Partindo que a vida da

bateria é normalmente distribuído, encontrar a probabilidade

que uma bateria selecionada ao acaso dure menos de 2,3 anos.

Solução. X~N(=3,=0,5). Deseja-se avaliar P(X<2,3). As

unidades de , e X são em anos.

Expressando em termos de escore Z,

Z

2,3 3

1,4

0,5

.

Assim, P (X < 2,3) = P (Z < −1,4) = 0,0808.

Vide: P[- infinity<X<-1.4] for X~normal(0,1) in Wolfram alpha online calculator

(1,4) 0,9192

1 (1,4) 0,0808

Exercício:

A resistência à compressão de corpos de prova de cimento pode

ser modelada por uma distribuição normal, com média 6000

kg/cm2 e desvio de 100 kg/cm2.

a) qual a probabilidade da resistência de uma amostra ser menor

do que 6250 kg/cm2?

b) que resistência

é excedida por 95% das amostras?

Solução.

X~N(6000, 100). As unidades são todas kg/cm2.

Deseja-se calcular P(X<6250).

Expressando em termos de escore Z,

Z

6250 6000

2,5

100

.

Assim, P (X < 6250) = P (Z < 2,5) = (2,5) 0,9938 .

Vide: P[- infinity<X<2.5] for X~normal(0,1) in Wolfram alpha online calculator

Resp. 99,38%

Para calcular a resistência que é excedida por 95% dos corpos de

prova, deseja-se encontrar o valor de z tal que P(Z<z)=0,95.

Buscando na tabela padrão da normal, tem-se z=z95%=1,65.

Esta é a resistência em escore reduzido, z95%

x95% 6000

1,65

100

x95%=6165 kgf/cm2. Veja que, por simetria:

5875 -- 6000 --- 6125

P(X<6165)=0,95 e, portanto, P(X>5875)=0,95 como solicitado.

Exercício: As notas finais na disciplina ESTATISTICA referentes a

duas turmas distintas são:

Turma T2:

média = 75, desvio = 10

Turma T8:

média = 65, desvio = 8,6

Dois alunos, com notas 85 na turma T2, e 75 na turma T8,

respectivamente, concorrem à monitoria da disciplina. Que

candidato apresenta nota relativamente maior?

Vide:

z score calculator in Wolfram alpha online calculator

Solução.

Em termos absolutos, o candidato 1 tem nota maior. Porém,

calculando relativamente às suas respectivas turmas, pode-se

recalcular as notas expressas em escore reduzido:

z1=(85-75)/10=1.0 e z2=(75-65)/8.6=1.16.

A preferência poderia recair no candidato 2, pois ele apresenta

melhor desempenho relativo, dentro da sua turma. Assim, o

critério de classificação com base na nota escore reduzido poderia

ser adotado no edital de seleção. A dificuldade é que os históricos

contém apenas informações sobre as médias... Isso é pouco.

N.B. Com um sistema automatizado como o sig@, seria fácil indicar também a

nota relativa do aluno na disciplina.

Exercício: Num canal de comunicação, a taxa de erro de bit

recebido é modelada por uma variável de Bernoulli,

p(bit errado)=p=10-5, p(bit correto)=1−p.

Um enlace transmite 16 milhões de bits em uma sessão de

conexão. Deseja-se avaliar a probabilidade de se receber 150 (ou

menos) bits errados nesta transmissão. Avalie esta probabilidade:

a) modelando com uma distribuição binomial (comente sobre os

cálculos envolvidos).

b) Vale o uso de uma aproximação ’grandes números’ ? Normal ou

Poisson? Justifique. Calcule numericamente.

Solução.

a) X é modelada como ~B(16.000.000, 10-5).

n=16.000.000 e p=10-5

A probabilidade P(X=k) de haver k bits recebidos com erros é

calculada via:

16.000.000

.(10 5 ) k .(1 10 5 )16.000.000 k

P ( X k )

k

.

Deseja calcular quanto vale

16.000.000

.(10 5 ) k .(1 10 5 )16.000.000 k

P ( X 150)

k

k 0

150

.

Comentário: avaliar numericamente o somatório é pouco prático,

mesmo com computador.

b) Note que o número médio de bits errados é E(X)=n.p=160 bits.

A variância é var(X)=n.p.(1-p)≈160 donde =12,65.

Usar uma aproximação assintótica pode ser atrativo. Como

n.p>>1, a aproximação pode ser feita por uma gaussiana.

X~N(160, 12,65)

Deseja-se avaliar* P(X<150). Usando escore Z,

Z

150 160

0,79

12,65

(0,79) 0,7852

1 (0,79) 0,2148

Resp. ≈21,48%.

N.B. sem correção de continuidade. Para melhor estimativa, para

aproximar P(a≤X≤b) usa-se P(a-0.5≤X≤b+0.5) antes de usar Z.

t de Student

Diz-se que X tem uma distribuição t de Student com parâmetro

n, em que n é número natural, se a função densidade de X é

f X ( x)

[(n 1) / 2] x

1

n

[n / 2] n

2

( n 1)

2

.

Foi publicada por um autor que se chamou de Student,

pseudônimo de William Gosset, que não podia usar seu nome

verdadeiro para publicar trabalhos enquanto trabalhasse para a

cervejaria Guinness.

Willian Gosset (1876-1937)

http://www.wolframalpha.com/input/?i=t-student+distribution

x 1

Gamma é a função de Euler, ( x) : 0 e d .

O número n nesta expressão é conhecido como número de graus

de liberdade da distribuição t de Student.

Distribuição t de student (vários df).

Ver tabela da distribuição t

Ou consulte Wolfram alpha online calculator: t score

Exercício. Qual o valor de t com =14 graus de liberdade que deixa

uma área de 0,025 à esquerda, e, consequentemente, uma área

de 0,975 à direta?

t0.975 = −t

0.025

= −2,145.

Resposta: -2,145.

CASOS PARTICULARES

1) Se n=1, temos que a distribuição t de Student é igual a

distribuição Cauchy(0,1).

2) Se n→∞, a distribuição t de Student converge para a

distribuição normal padrão.

Esta distribuição é fundamental em Testes de hipóteses, análise de

variância (ANOVA) e em muitas outras situações.

A Distribuição Normal Bivariada

Diz-se que um vetor aleatório (X, Y) possui distribuição normal

bivariada quando tem densidade:

f X ,Y ( x, y )

1

2 1 2

1

1

1

1

2

2

exp

.

( x 1 ) 2

( x 1 ).( y 2 ) 2 ( y 2 )

2 1 2 12

2

1 2

1

2

em que σ1>0, σ2>0, −1<ρ<1, µ1∈ , µ2∈ . Se ρ=0, esta densidade fatora

e temos que X e Y são independentes. Se ρ0, esta densidade não fatora

e X e Y não são independentes.

Propriedades da distribuição normal bivariada:

1. As distribuições marginais de X e de Y são N(µ1,σ12) e N(µ2,σ22).

2. O parâmetro ρ é igual ao coeficiente de correlação entre X e Y.

Esboço da curva normal bivariada, com ρ=µ1=µ2=0 e σ1=σ2=1.

OUTRAS VARIÁVEIS ALEATÓRIAS: ANÚNCIO

Contínuas

exponencial, Cauchy, 2, Laplace, Maxwell,

beta, log-normal, Weibul, F-Senedecor, Pareto

Exponencial

X~E()

fT (T ) .e T u (T ) .

Uma variável aleatória contínua X tem uma distribuição

exponencial de parâmetro λ se sua função densidade de

probabilidade f(x) for do tipo:

e x , x 0

f ( x)

0, caso contrário

Média E(X)=1/λ. Var(X)=1/λ2.

exponencial

chi2 (pronuncia: qui quadrado) X~2(n,)

f X ( x)

2

n 1 x 2 / 2 2

x

e

u ( x)

n/2

n

2 ( n / 2)

n é conhecido como número de graus de liberdade da distribuição

chi-quadrado.

EX=n e VarX=2n.

X~Beta( , )

Beta

Função

fatorial

( x) : x 1e d

0

generalizado

(função

gama

de

Euler)

particular: (n+1)=1.2.3 . . . (n-1)n=n!

EULER

B(a, b) :

Função beta

(a).(b)

( a b)

f X ( x) B ( , ) x 1.(1 x) 1

phibeta ( t )

M ( )

T( )

α β 1

( t a( س) )ﺲ

α 1

( b ( س )ﺲ t )

β 1

Limitada à direita e a esquerda. Pode ser simétrica ou assimétrica.

A simetria é controlada pelos parâmetros.

Weibul

X~W( , )

1 ( x / )

f X ( x; , ) x e

u ( x)

,>0.

F-Senedecor

X~F(n,m) ou F(1,2)

m

f X ( x) B(n, m).

n

m/2

.

x ( m2) / 2

m

1 x

n

(n m) / 2

.u ( x)

1, 2= Graus de liberdade do numerador e do denominador

Log-Normal

f X ( x)

(ln x m ) 2

1

2 x

2

e

2 2

u ( x)

Gamma

X~( , ) ou (r,)

1 x

f X ( x; , )

x e u ( x)

( )

Maxwell

X~M(2)

f X ( x)

Logística

1

2

2

2

/ 2 2

u ( x)

X~L

f X ( x)

Pareto

x 2e x

ex

1 e

x 2

X~Par

f X ( x; , c)

c

c x

1

u ( x c)

,c>0

Mensagem de fechamento:

FIM DO ASSUNTO PARA A SEGUNDA UNIDADE!

APRENDA E FAÇA UM BOM EXERCÍCIO ESCOLAR!