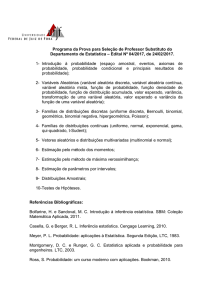

Cálculo das Probabilidades I

Departamento de Estatistica

Primeira Edição - 2008

Sumário

iii

Capítulo 1

Introdução a Probabilidade

Objetivo: O objetivo da teoria da Probabilidade é criar modelos teóricos que reproduzam de

maneira razoável a distribuição de freqüências de fenômenos(experimentos) aleatórios de interesse. Tais modelos são chamados modelos probabilísticos.

Definição 1.1 (Experimento aleatório). Um experimento que pode fornecer diferentes resultados,

muito embora seja repetido toda vez da mesma maneira, é chamado experimento aleatório.

Características de um experimento aleatório:

• Imprevisibilidade: o resultado do experimento não pode ser conhecido a priori;

• É conhecido o conjunto de todos os resultados possíveis do experimento;

Exemplos de experimentos aleatórios

(E1) Lançar uma moeda uma vez. Anota-se o resultado;

(E2) Lançar uma moeda duas vezes. Anota-se a seqüência obtida;

(E3) Lançar uma moeda duas vezes. Anota-se o número de caras obtido;

(E4) Numa linha de produção conta-se o número de peças defeituosas num dia de trabalho;

(E5) Uma urna contém duas bolas brancas e três bolas vermelhas. Retira-se uma bola ao acaso da

urna. Se for branca, lança-se uma moeda; se for vermelha, ela é devolvida à urna e retira-se

outra bola. Anota-se o resultado obtido.

Definição 1.2 (Espaço amostral). É o conjunto de todos os resultados possíveis de um experimento

aleatório. Notação: Ω

Cada resultado possível é denominado ponto ou elemento de Ω e denotado genericamente por

ω. Assim, escrevemos ω ∈ Ω para indicar que o elemento ω está em Ω.

Exemplos de espaço amostral:

(E1) Ω = c , r , em que c=cara e r=coroa;

1

(E2) Ω = (c , c ), (c , r ), (r, c ), (r, r ) ;

(E3) Ω = 0, 1, 2 ;

(E4) Ω = 0, 1, 2, . . . ;

(E5) Ω = (B, c ), (B, r ), (V, B ), (V, V ) , em que B=bola branca, V=bola vermelha;

Definição 1.3. Sejam A e B dois conjuntos. Então diz-se que A é um subconjunto de B se, e somente

se ω ∈ A implicar ω ∈ B . Notação: A ⊂ B .

Observação 1.1. Da Definição ?? segue que A ⊂ A, pois ω ∈ A implicar ω ∈ A.

Observação 1.2. Se A não é um subconjunto de B , então existe pelo menos um ω ∈ A tal que ω ∈

/ B.

Notação: A * B .

Definição 1.4 (Igualdade de conjuntos). Sejam A e B dois conjuntos. Então diz-se que A = B se, e

somente se, A ⊂ B e B ⊂ A, isto é, ω ∈ A implicar ω ∈ B e ω ∈ B implicar ω ∈ A.

Observação 1.3. Se A não é igual a B , então existe pelo menos um ω ∈ A tal que ω ∈

/ B ou um ω ∈ B

tal que ω ∈

/ A.

Definição 1.5 (Evento). É um subconjunto do espaço amostral Ω.

Os subconjuntos de Ω serão denotados por letras latinas maiúsculas (A,B,C,. . . ). Se A é um

subconjunto de Ω então denotamos A ⊂ Ω.

Exemplo 1.1. Considere o experimento aleatório (E2). Seja A=Obtenção de faces iguais. Portanto,

A = (c , c ), (r, r ) ;

Observação 1.4. Diz-se que "‘ocorre o evento A"’ quando o resultado do experimento aleatório for

um elemento de A.

Observação 1.5. O espaço amostral Ω e o conjunto vazio ∅ também são eventos, em que Ω é o evento

certo e ∅ é o evento impossível.

Operações básicas entre conjuntos

Sejam A ⊂ Ω e B ⊂ Ω, então:

• Complementar: A c = ω ∈ Ω : ω ∈

/A ;

• Interseção: A ∩ B = ω ∈ Ω : ω ∈ A e ω ∈ B ;

• União: A ∪ B = ω ∈ Ω : ω ∈ A ou ω ∈ B = ω ∈ Ω : ω a pelo menos um dos eventos ;

• Diferença: A − B = ω ∈ Ω : ω ∈ A e ω ∈

/ B , deste modo segue que A − B = A ∩ B c ;

• Diferença simétrica: A∆B = ω ∈ Ω : ω ∈ A e ω ∈

/ B ou ω ∈

/ A e ω ∈ B , deste modo segue

que A∆B = (A ∩ B c ) ∪ (A c ∩ B ).

Definição 1.6 (Eventos disjuntos). Dois eventos são disjuntos se e somente se A ∩ B = ∅.

Observação 1.6. Da Definição ?? segue que o conjunto vazio é disjunto de qualquer outro evento,

pois para todo evento A tem-se que A ∩ ∅ = ∅.

Definição 1.7 (Partição de um evento). Seja A um subconjunto de Ω. Então A 1 , . . . , A n formam uma

partição de A se e somente se A i ∩ A j = ∅ para todo i 6= j e ∪ni=1 A i = A.

Deste modo, se A = Ω então A 1 , . . . , A n formam uma partição de Ω se e somente se A i ∩ A j = ∅

para todo i 6= j e ∪ni=1 A i = Ω.

Definição 1.8 (Espaço Produto). Sejam Ω1 e Ω2 dois espaços amostrais. Então o espaço produto

Ω = Ω1 × Ω2 é dado por,

n

o

Ω1 × Ω2 = (ω1 , ω2 ) : ω1 ∈ Ω1 e ω2 ∈ Ω2

Observação 1.7. Se Ω1 = Ω2 = Ω então o espaço produto Ω1 × Ω2 é denotado por Ω2 .

Definição 1.9 (Produto entre eventos). Sejam A ⊂ Ω1 e B ⊂ Ω2 . Então o evento produto, denotado

por A × B é dado por,

n

o

A × B = (ω1 , ω2 ) ∈ Ω : ω1 ∈ A e ω2 ∈ B

1.1

Propriedades das operações entre conjuntos(eventos)

Sejam A, B,C subconjuntos de Ω, então:

1. A ⊂ A ∪ B e B ⊂ A ∪ B ;

2. A ∩ B ⊂ A e A ∩ B ⊂ A;

3. A ⊂ B ⇔ A ∪ B = B ;

4. A ⊂ C e B ⊂ C ⇔ A ∪ B ⊂ C ;

5. Idempotente: A ∪ A = A e A ∩ A = A;

6. Distributiva:

• A ∪ (B ∩ C ) = (A ∪ B ) ∩ (A ∪ C );

• A ∩ (B ∪ C ) = (A ∩ B ) ∪ (A ∩ C );

• A ∪ (B − C ) = (A ∪ B ) − (C − A) 6= (A ∪ B ) − (A ∪ C );

• A ∩ (B − C ) = (A ∩ B ) − (A ∩ C );

• (A − B ) − C = A − (B ∪ C ) 6= A − (B − C );

• A − (B ∪ C ) = (A − B ) ∩ (A − C ) 6= (A − B ) ∪ (A − C );

• A − (B ∩ C ) = (A − B ) ∪ (A − C ) 6= (A − B ) ∩ (A − C );

• A ∩ (B ∆C ) = (A ∩ B )∆(A ∩ C );

• A ∪ (B ∆C ) = (A ∪ B ∪ C ) − (A c ∩ B ∩ C ) 6= (A ∪ B )∆(A ∪ C );

7. Comutativa:

• A ∪ B = B ∪ A;

• A ∩ B = B ∩ A;

• A∆B = (A − B ) ∪ (B − A) = (B − A) ∪ (A − B ) = B ∆A = A ∪ B − A ∩ B ;

• A − B 6= B − A, pois A − B = A ∩ B c e B − A = A c ∩ B ;

8. Associativa:

• (A ∪ B ) ∪ C = A ∪ (B ∪ C );

• (A ∩ B ) ∩ C = A ∩ (B ∩ C );

• (A∆B )∆C = A∆(B ∆C );

• (A − B ) − C 6= A − (B − C ), pois

(A − B ) − C = (A ∩ B c ) ∩ C c = A ∩ (B c ∩ C c ) = A ∩ (B ∪ C )c = A − B ∪ C

e

A − (B − C ) = A ∩ (B ∩ C c )c = A ∩ (B c ∪ C ) = (A ∩ B c ) ∪ (A ∩ C ) = (A − B ) ∪ (A ∩ C ).

9. Identidade: A ∪ ∅ = A, A ∩ Ω = A e A ∪ Ω = Ω, A ∩ ∅ = ∅;

10. Complemento: A ∪ A c = Ω, A ∩ A c = ∅ e (A c )c = A, Ωc = ∅ e ∅c = Ω.

Proposição 1.1 (Leis de De Morgan). Sejam A 1 , . . . , A n tal que A i ⊂ Ω para todo i, então:

c

(i) ∪ni=1 A i = ∩ni=1 A ci Imterpretação: o complementar da ocorrência de pelo menos um dos eventos é a não ocorrência de todos os eventos;

c

(ii) ∩ni=1 A i = ∪ni=1 A ci . Imterpretação: o complementar da ocorrência de todos os eventos é a não

ocorrência de pelo menos um dos eventos.

Demonstração. Para

que:

(i) tem-se

c

Para todo ω ∈ ∪ni=1 A i tem-se que ω ∈

/ ∪ni=1 A i , logo ω ∈

/ A i para todo i, pois se ω ∈ A i para

n

c

algum i então ω ∈ ∪i =1 A i . Conseqüentemente ω ∈ A i para todo i, portanto ω ∈ ∩ni=1 A ci . Logo,

c

(1.1)

∪ni=1 A i ⊂ ∩ni=1 A ci .

Por outro lado tem-se que, para todo, ω ∈ ∩ni=1 A ci implica que ω ∈ A ci para todo i. Logo ω ∈

/ Ai

c

n

n

para todo i. Conseqüentemente, ω ∈

/ ∪i =1 A i . Deste modo, ω ∈ ∪i =1 A i . Nestas condições segue

que,

c

∩ni=1 A ci ⊂ ∪ni=1 A i

(1.2)

Logo, de (??) e (??)

segue a igualdade (i). Para (ii) tem-se que:

c

Para todo ω ∈ ∩ni=1 A i implica que ω ∈

/ ∩ni=1 A i . Logo, ω ∈

/ A i para pelo menos um i, conc

n

seqüentemente ω ∈ A i para pelo menos um i. Portanto, ω ∈ ∪i =1 A ci . Assim,

c

∩ni=1 A i ⊂ ∪ni=1 A ci .

(1.3)

Por outro lado tem-se que, para todo, ω ∈ ∪ni=1 A ci implica que ω ∈ A ci para pelo menos um i. Con

c

seqüentemente, ω ∈

/ A i para pelo menos um i, portanto ω ∈

/ ∩ni=1 A i , logo, ∩ni=1 A i . Assim,

c

∪ni=1 A ci ⊂ ∩ni=1 A i .

(1.4)

De (??) e (??) segue a igualdade (ii).

1.2

Função indicadora

Definição 1.10 (Função indicadora). Seja A ⊂ Ω, então

(

1 se ω ∈ A

I A (ω) =

0 se ω ∈

/A

Propriedades da função indicadora

Sejam A ⊂ Ω e B ⊂ Ω, então:

(i) I A c (ω) = 1 − I A (ω);

(ii) I A∪B (ω) = I A (ω) + I B (ω) − I A (ω)I B (ω) = min I A (ω), I B (ω) ;

(iii) I A∩B (ω) = I A (ω)I B (ω) = max I A (ω), I B (ω) ;

(iv) I A−B (ω) = I A (ω)I B c (ω) e I B −A (ω) = I A c (ω)I B (ω);

(v) I A∆B (ω) = I A (ω)I B c (ω) + I A c (ω)I B (ω).

(vi) I A (ω) = I B (ω) se e somente se A = B ;

(vii) I A (ω) ≤ I B (ω) se e somente se A ⊆ B ;

Demonstração. Para (i) tem-se que: tome ω ∈ A c então I A c (ω) = 1 e I A (ω) = 0 pois ω ∈

/ A logo

c

1−I A (ω) = 1. Do mesmo, modo se ω ∈

/ A então I A c (ω) = 0 e I A (ω) = 1 pois ω ∈ A logo 1−I A (ω) = 0.

Por outro lado, se ω ∈ A então I A (ω) = 1 e I A c (ω) = 0 pois ω ∈

/ A c . Do mesmo, modo se ω ∈

/A

c

então I A (ω) = 0 e I A c (ω) = 1 pois ω ∈ A . Logo, I A c (ω) = 1 − I A (ω).

1.3

Álgebra e Sigma álgebra

Definição 1.11 (Álgebra). Seja Ω um conjunto não vazio. Uma classe A de subconjuntos de Ω,

satisfazendo:

(A1) Ω ∈ A ;

(A2) Se A ∈ A então A c ∈ A ;

(A3) Se A ∈ A e B ∈ A então A ∪ B ∈ A ;

é denominada uma álgebra de subconjuntos de Ω.

Proposição 1.2. Seja A uma álgebra de subconjuntos de Ω. Então, valem as seguintes propriedades:

(A4) ∅ ∈ A ;

(A5) A é fechada para uniões e intersecções finitas, isto é, se A 1 ∈ A , . . . , A n ∈ A então ∪ni=1 A i ∈ A

e ∩ni=1 A i ∈ A .

Demonstração. (A4) é direto visto que o complementar de Ω é ∅.

k

Para (A5)

tem-se

S por indução que, A 1 ∪ A 2 ∈ A . Agora suponha que ∪i =1 A i ∈ A , assim,

+1

+1

∪ki =1

A i = ∪ki=1 A i

A k +1 . Deste modo, como ∪ki=1 A i ∈ A e A k +1 ∈ A segue que ∪ki =1

Ai ∈ A .

Logo, vale a relação para todo n finito.

Para a segunda parte de (A5) tem-se que: como A 1 ∈ A , . . . , A n ∈ A segue por (A2) que A c1 ∈

A , . . . , A cn ∈ A , portanto da primeira parte de (A5) segue que ∪ni=1 A ci ∈ A . Agora de (A2) segue que

c

c

∪ni=1 A ci ∈ A . Mas da lei de Morgan sabe-se que ∪ni=1 A ci = ∩ni=1 A i .

Exemplo 1.2. Exemplos de álgebras:

1. A = {∅, Ω}, esta é a álgebra trivial;

2. A = {A, A c , ∅, Ω}, para Ω = A ∪ A c ;

3. Seja Ω = {ω1 , ω2 , ω3 } então A = {ω1 , ω2 , ω3 , {ω1 , ω2 }, {ω1 , ω3 }, {ω2 , ω3 }, ∅, Ω} é uma álgebra

de subconjuntos de Ω. Neste caso, A é chamado de álgebra das partes de Ω e é denotado por

P.

Exemplo 1.3. Seja Ω infinito, enumerável ou não, e seja C uma classe de subconjuntos de Ω que são

finitos ou cujos complementos são finitos, isto é, C = {A ⊂ Ω : A ou A c é finito}. Prove que C é uma

álgebra.

Demonstração. De fato, pois:

1. Ωc = ∅ que é finito, portanto, Ω ∈ C ;

2. Seja A ∈ C , logo A ou A c é finito. Se A é finito segue que A c ∈ C pois A c

é finito, então A c ∈ C ;

c

= A é finito. Se A c

3. Seja A ∈ C e B ∈ C ,logo A ou A c é finito e B ou B c é finito, assim:

• Se A e B forem finitos segue que A ∪ B é finito, portanto A ∪ B ∈ C ;

c

• Se A ou B ou ambos forem infinitos então A ∪ B = A c ∩ B c é finito pois A c ou B c ou

ambos são finitos. Logo A ∪ B ∈ C .

Definição 1.12 (σ-Álgebra). Uma classe F de subconjuntos de Ω é denominada uma σ-álgebra se

ela satisfaz:

(F1) Ω ∈ F ;

(F2) Se A ∈ F então A c ∈ A ;

(F3) Se A i ∈ F para todo i ≥ 1 então

S∞

i =1

Ai ∈ F ;

Observação 1.8. Da Definição ?? segue que:

1. Toda σ-álgebra é uma álgebra;

2. Nem toda álgebra é uma σ-álgebra.

Observação 1.9. O par (Ω, F ) é chamado de espaço mensurável.

1.4

Medida de Probabilidade

Definição 1.13 (Definição Clássica). Seja (Ω, F ) um espaço finito de eventos equiprováveis. Assim,

para todo A ∈ F tem-se que,

#A

P(A) =

#Ω

em que # é o número de elementos do conjunto.

Exemplo 1.4. Considere o experimento aleatório (E2). Seja A=Obtenção de faces iguais. Portanto,

A = (c , c ), (r, r ) . Deste modo,

2

P(A) = = 0, 5.

4

1.4.1

Alguns conceitos básicos de Contagem

Nesta seção vamos apresentar os princípios aditivo e multiplicativo e mostrar como a aplicação destes princípios podem ser feitas para obter as fórmulas de permutação, arranjo e combinação.

Pn

Definição 1.14 (Princípio Aditivo). Sejam A 1 , . . . , A n uma partição, então # ∪ni=1 A i = i =1 a i . Se

A 1 , . . . , A n for uma partição de Ω então # ∪ni=1 A i = #Ω = n , em que n é número de elementos de Ω.

Da Definição ?? segue que, se A = ∪ni=1 A i então,

Pn

P(A) =

i =1

n

ai

.

Exemplo 1.5. Numa confeitaria há 5 sabores de picolés e 3 sabores de salgados. Suponha que Maria

só tenha permissão para tomar um picolé ou comer um salgado. Quantos são os possíveis pedidos

de Maria?

Solução: Tem-se os seguintes eventos: Ω = {P1 , . . . , P5 ,S 1 ,S 2 ,S 3 },

A 1 = {ω ∈ Ω : ω = p i col } e A 2 = {ω ∈ Ω : ω = s a l g a d o}

Assim, o evento A ="‘tomar um picolé ou comer um salgado"’ é A = A 1 ∪ A 2 . Logo, tem-se que Maria

pode escolher entre #A 1 ∪ A 2 = 5 + 3 = 8 pedidos possíveis.

Exemplo 1.6. Uma caixa contém quatro lâmpadas de 40 W , cinco de 60 W e seis de 75 W . Uma

lâmpada é sorteada ao acaso, qual a probabilidade que seja uma lâmpada de 40 W ou 75 W ?

Solução: Tem-se os seguintes eventos: Ω = {L401 , . . . , L404 , L601 , . . . , L605 , L751 , . . . , L756 },

A 1 = {ω ∈ Ω : ω = L40i , i = 1, . . . , 4} e A 2 = {ω ∈ Ω : L75 j , j = 1, . . . , 6}

Portanto,

P(A 1 ∪ A 2 ) =

4+6 2

= .

15

3

Definição 1.15 (Princípio Multiplicativo). Sejam A 1 , . . . , A n n eventos em que A i ∈ Ωi . Se cada evento

A i pode ocorrer de m i maneiras diferentes. Então esses n eventos podem ocorrer em sucessão de

m 1 ×· · ·×m n maneiras diferentes, isto é, o evento produto A 1 ×· · ·×A n tem cardinalidade m 1 ×· · ·×m n .

Exemplo 1.7. Suponha mo exemplo anterior que Maria tenha permissão para tomar um picolé e

comer um salgado. Quantos são os possíveis pedidos de Maria, neste caso?

Solução: Tem-se os seguintes eventos: Ω = {P1 , . . . , P5 ,S 1 ,S 2 ,S 3 },

A 1 = {ω ∈ Ω : ω = p i col } e A 2 = {ω ∈ Ω : ω = s a l g a d o}

Assim, o evento A ="‘tomar um picolé e comer um salgado"’ é A = A 1 × A 2 . Logo, tem-se que Maria

pode escolher entre #A 1 × A 2 = 5 × 3 = 15 pedidos possíveis.

Vamos agora mostrar como combinar os dois princípios.

Exemplo 1.8. Um amigo mostrou-me 5 livros diferentes de Matemática, 7 livros diferentes de Física

e 10 livros diferentes de Química e pediu-me para escolher 2 livros com a condição de que eles não

fossem da mesma matéria. De quantas maneiras eu posso escolhê-los?

Solução: Tem-se os seguintes eventos: A 1 = {M 1 , . . . , M 5 }, A 2 = {F1 , . . . , F7 } e A 3 = {Q 1 , . . . ,Q 10 }.

Agora note que posso fazer as seguintes escolhas: A 1 × A 2 ou A 1 × A 3 ou A 2 × A 3 . Logo,

#(A 1 × A 2 ) ∪ (A 1 × A 3 ) ∪ (A 2 × A 3 ) = #(A 1 × A 2 ) + #(A 1 × A 3 ) + #(A 2 × A 3 )

= 5 × 7 + 5 × 10 + 7 × 10 = 155.

Exemplo 1.9. No Exemplo ??, suponha que duas lâmpadas sejam selecionadas ao acaso, qual a

probabilidade que:

(a) Exatamente duas sejam de 75 W ?

Solução: Seja,

Ω1 = {L401 , . . . , L404 , L601 , . . . , L605 , L751 , . . . , L756 }

e

Ω2 = {L401 , . . . , L404 , L601 , . . . , L605 , L751 , . . . , L755 },

com A 1 = {L75}, # A 1 = 6 e A 2 = {L75} e # A 2 = 5.. Assim, tem-se que # A 1 × A 2 = 6 ∗ 5 = 30 e

# Ω1 × Ω2 = 15 ∗ 14 = 210,

1

30

= .

P(A 1 × A 2 ) =

210 7

(b) Sair uma de 40 W e uma de 60 W ? (combinando os dois princípios)

Solução: Seja,

Ω1 = {L401 , . . . , L404 , L601 , . . . , L605 , L751 , . . . , L756 },

# Ω1 = 15,

Ω2 = {L401 , . . . , L403 , L601 , . . . , L605 , L751 , . . . , L756 },

# Ω2 = 14 ou

Ω3 = {L401 , . . . , L404 , L601 , . . . , L604 , L751 , . . . , L756 },

# Ω3 = 14, com A 1 = {L401 , . . . , L404 } e # A 1 = 4, A 2 = {L601 , . . . , L605 } e # A 2 = 5. Assim,

”Sair uma de 40 W e uma de 60 W ” = A 1 × A 2 ou A 2 × A 1 ,

logo,

P((A 1 × A 2 ) ∪ (A 2 × A 1 )) = P(A 1 × A 2 ) + P(A 2 × A 1 ) =

5×4

4×5

+

15 × 14 15 × 14

Permutação Simples

Uma permutação de n elementos distintos é qualquer agrupamento ordenado desses objetos.

Assim, seja A i o conjunto de elementos quando da escolha do i-ésimo elemento sem reposição.

Assim, se inicialmente tivermos n elementos, então #A i = n − i + 1. Deste modo, o número de

elementos em uma permutação simples será dada por,

#(A 1 × · · · × A n ) = n × (n − 1) × · · · × 1 = n!

Notação: Pn = n!.

Exemplo 1.10. Considere uma urna com 5 bolas numeradas de 1 a 5 e seja o seguinte experimento:

retirar 3 bolas sem reposição. Qual a probabilidade dos três números sorteados serem o 1,2 e o 3, não

necessariamente nessa da ordem? Qual a a probabilidade dos três números sorteados serem o 1,2 e

o 3, nessa da ordem?

Solução: Tem-se que A ="’os três números sorteados são o 1,2 e o 3"’. Como a ordem não importa

tem-se que #A = P3 = 3! = 6, que são as permutações simples dos 3 números. Vamos agora calcular o número de elementos de Ω. Utilizando o princípio multiplicativo tem-se que: seja A 1 =as 5

bolas numeradas, A 2 =as 4 bolas numeradas restantes depois da primeira retirada e A 3 =as 3 bolas

numeradas restantes depois da segunda retirada. Assim,

#Ω = #(A 1 × A 2 × A 3 ) = 5 × 4 × 3 = 60.

Note que nesse cálculo foi considerado as permutações simples de cada elemento. Assim,

P(A) =

6

#A

=

= 0, 1.

#Ω 60

Para o segundo caso, tem-se que: #A = 1 assim,

P(A) =

#A

1

= .

#Ω 60

Arranjos Simples

Arranjos simples de n elementos distintos tomados r a r, r ≤ n, são todos os grupos distintos(ordenados), que diferem pela ordem e pela natureza dos r elementos que compõe cada grupo.

Note que o arranjo simples é semelhante é o caso geral e a permutação simples é o caso particular

quando r = n. Assim, seja A i o conjunto de elementos quando da escolha do i-ésimo elemento

sem reposição. Assim, se inicialmente tivermos n elementos, então #A i = n − i + 1. Deste modo, o

número de elementos em um arranjo simples será dada por,

#(A 1 × · · · × A r ) = n × (n − 1) × · · · × (n − r + 1)

multiplicando em cima e em baixo por (n − r )! obtém-se,

#(A 1 × · · · × A r ) =

n!

n × (n − 1) × · · · × (n − r + 1) × (n − r )!

=

.

(n − r )!

(n − r )!

Notação: A rn = (nn!

.

−r )!

Combinações Simples

Combinações simples de n elementos distintos tomados r a r, r ≤ n, são todos os grupos não

ordenados de p elementos que diferem entre si apenas pela natureza dos elementos e não pela

ordem. Deste modo, basta dividir o número de arranjos simples tomados r a r pelo número de

permutações r a r. Assim,

A rn

n!

n

=

=

Pr

r !(n − r )!

r

n

Notação: C nr =

.

r

Observação 1.10. Note que

C nr

n

n

=

=

= C nn−r .

r

n −r

Os valores C nr são chamados de coeficientes binomiais, por causa do fato que,

(a + b )n =

n

X

C nr a r b n −r .

r =0

Definição 1.16. Seja (Ω, F ) um espaço não enumerável, com Ω ⊂ Rn , n ≥ 1. Então, para todo A ∈ F

segue que a probabilidade de A é dada por,

P(A) =

|A|

|Ω|

em que || poderá ser: um comprimento, uma área, um volume, etc. Esse é o conceito geométrico de

probabilidade.

Exemplo 1.11. Um ponto (a ,b ) é escolhido aleatóriamente no quadrado definido por −1 ≤ x ≤ 1 e

−1 ≤ y ≤ 1. Qual a probabilidade que a equação a z + b = 0 tenha solução positiva.

Solução: Note que,

−b

z=

≥0

a

se e somente se (a ,b ) ∈ [−1, 0) × [0, 1] ou (a ,b ) ∈ (0, 1] × [−1, 0]. Assim, |Ω| = 2 × 2 = 4 e |A| = 1 × 1 +

1 × 1 = 2. Portanto,

2

P(A) = = 0, 5.

4

Definição 1.17. Seja Ω um espaço amostral de um experimento aleatório. Seja n repetições independentes de um experimento aleatório e n A o número de ocorrências do evento A ⊂ Ω. Então, a

probabilidade de A é dada por,

nA

P(A) = lim

n →∞ n

Esse é o conceito frequencista de probabilidade.

Definição 1.18. Seja (Ω, F ) um espaço mensurável. Então uma função P : F → [0, 1] é uma probabilidade se,

(P1) P(Ω) = 1;

(P2) Para todo A ∈ F tem-se P(A) ≥ 0;

(P3) P é σ-aditiva, isto é, se A 1 , A 2 , . . . , são dois a dois disjuntos então,

!

∞

∞

X

[

P

An =

P(A n ).

n =1

n =1

Esta é a definição axiomática devida a Kolmogorov. A trinca (Ω, F , P) é chamada de espaço de

probabilidade.

Observação 1.11. Note que de um modo geral a medida de probabilidade P não precisa assinalar

uma probabilidade para todo evento, isto é, não precisa ter uma probabilidade associada a todo

ponto amostral de Ω, mas apenas para os eventos em F .

n

o

Exemplo 1.12. Seja Ω = 1, 2, 3 e considere a σ-álgebra das partes,

n

o

P = ∅, Ω, {1}, {2}, {3}, {1, 2}, {1, 3}, {2, 3}

n

o

e uma outra σ-álgebra F = ∅, Ω, {3}, {1, 2} . Seja P1 a medida de probabilidade em (Ω, P ) dada

por

2

1

P1 ({1}) = P1 ({2}) = P1 ({3}) = e P1 ({1, 2}) = P1 ({1, 3}) = P1 ({2, 3}) = .

3

3

Seja P2 a medida de probabilidade em (Ω, F ) dada por P2 ({3}) = 13 e P2 ({1, 2}) = 23 . Consideremos

agora dois eventos, A = {1, 2} e B = {2, 3}, então P1 (A) = P2 (A) = 23 e P1 (B ) = 31 entretanto P2 (B ) não

está definido. Neste caso diz-se que o evento B é P -mensurável mas não é F -mensurável.

Observação 1.12. Observe que para o espaço mensurável (Ω, P ) foi definido uma probabilidade

para todo ω ∈ Ω. Note que nestes casos a probabilidade de qualquer outro evento A ∈ P é dada por,

X

P(A) =

P(ω).

n

o

ω∈Ω:ω∈A

Deste modo, se P for definida para todo ω ∈ Ω então estará bem definida para qualquer σ-álgebra

F.

Propriedades de uma medida de probabilidade

Seja (Ω, F , P), então para todo A ∈ F e B ∈ F , tem-se que:

(P4) P(A c ) = 1 − P(A).

Demonstração. De fato, como Ω = A ∪ A c e A ∩ A c = ∅ segue que,

P(Ω) = 1 = P(A ∪ A c ) = P(A) + P(A c ) ⇒ P(A c ) = 1 − P(A) ≥ 0;

(P5) P(∅) = 0, pois Ω = ∅c logo por (C1)

P(∅) = 1 − P(Ω) = 1 − 1 = 0;

(P6) P é uma função não decrescente, isto é, para todo A, B ∈ F tal que A ⊆ B tem-se que P(A) ≤

P(B ).

Demonstração. De fato, como B = (A ∩ B ) ∪ (A c ∩ B ) e A ∩ B = A pois A ⊆ B , segue que

P(B ) = P(A ∩ B ) + P(A c ∩ B ) = P(A) + P(A c ∩ B ) ≥ P(A);

| {z }

≥0

(P7) Para todo A, B ∈ F tal que A ⊆ B tem-se que P(B − A) = P(B ) − P(A); Este resultado segue

diretamente do anterior;

(P8) Para todo A, B ∈ F arbitrários tem-se que:

P(A − B ) = P(A) − P(A ∩ B ) e P(B − A) = P(B ) − P(A ∩ B ).

Demonstração. De fato, como A = (A ∩ B )∪(A ∩ B c ) = (A ∩ B )∪(A − B ) e B = (A ∩ B )∪(A c ∩ B ) =

(A ∩ B ) ∪ (B − A) segue que,

P(A) = P(A ∩ B ) + P(A − B ) e P(B ) = P(A ∩ B ) + P(B − A)

Logo,

P(A − B ) = P(A) − P(A ∩ B ) e P(B − A) = P(B ) − P(A ∩ B ).

(P9) Para todo A ∈ F tem-se que 0 ≤ P(A) ≤ 1. Este resultado segue de (P1), (P2) e (C3) e do fato

que A ⊆ Ω;

(P10) Para todo A, B ∈ F arbitrários tem-se que:

P(A ∪ B ) = P(A) + P(B ) − P(A ∩ B ).

Demonstração. De fato, como A = (A ∩ B ) ∪ (A ∩ B c ) e B = (A ∩ B ) ∪ (A c ∩ B ) tem-se que,

A ∪ B = (A ∩ B ) ∪ (A ∩ B c ) ∪ (A ∩ B ) ∪ (A c ∩ B )

= (A ∩ B ) ∪ (A ∩ B c ) ∪ (A c ∩ B ) = (A ∩ B ) ∪ (A − B ) ∪ (B − A)

Perceba que A ∩ B , A − B e B − A são disjuntos. Assim, por (P3) e (P8) segue que,

P(A ∪ B ) = P(A ∩ B ) + P(A − B ) + P(B − A)

= P(A ∩ B ) + [P(A) − P(A ∩ B )] + [P(B ) − P(A ∩ B )] = P(A) + P(B ) − P(A ∩ B ).

1.5

Probabilidade Condicional

Seja (Ω, F , P) o espaço de probabilidade para um determinado experimento aleatório. Suponha que tenhamos a priori alguma informação a respeito do resultado do experimento aleatório.

Por exemplo, suponha que saibamos que um determinado evento B ∈ F ocorreu. Isto elimina

qualquer incerteza que tínhamos a respeito da ocorrência ou não do evento B. Além do mais, esta

nova informação a respeito do experimento aleatório pode mudar as incertezas a respeito de outros eventos em F e portanto uma nova medida de probabilidade deve ser considerada. Esta nova

medida de probabilidade é também uma medida no espaço mensurável (Ω, F ), será chamada de

Probabilidade condicional.

Exemplo 1.13. Seja Ω = 1, 2, 3, 4, 5, 6 um espaço de eventos equiprováveis. Seja F = P a σ-álgebra

das partes de Ω e P a medida de probabilidade definida em (Ω, F ) assim,

P(A) =

#A

#Ω

para todo A ∈ F . Considere os seguintes eventos,

A = {1, 2, 6} e B = {2, 3, 5}.

Deste modo, tem-se que

3 1

3 1

= e P(B ) = = .

6 2

6 2

Suponha agora que tenhamos a informação que o evento B ocorreu. Essa informação poderá alterar

a probabilidade atribuída aos eventos em F . A nova medida de probabilidade será denotada por

P(.|B ). Observe que podemos considerar que temos um novo espaço amostral Ω B = B e uma nova

σ-álgebra

F B = C ⊂ B : C = A ∩ B, para algum A ∈ F .

P(A) =

Desta maneira, tem-se que F B ⊂ F , por este motivo F B é denominada uma restrição de F ao evento

B . Assim, o novo espaço de probabilidade seria B, F B , P(.|B ) . Para o exemplo acima, dado que o

evento B ocorreu, então o evento A só irá ocorrer se o evento C = {1} = A ∩ B ocorrer, assim

P(A|B ) =

#(A ∩ B ) 1

= .

#(B )

3

Entretanto, não é necessária a construção deste novo espaço de probabilidade, pois pode-se considerar apenas uma nova medida de probabilidade para o mesmo espaço mensurável (Ω, F ). Para fazer

isso, basta que a nova medida de probabilidade P(.|B ) seja válida para todo A ∈ F e não apenas

para A ∈ F B . Deste modo, para um dado evento B ∈ F tem-se

P(A) P A ∩ (B ∪ B c )

=

P(A) =

P(Ω)

P(B ∪ B c )

P(A ∩ B ) + P(A ∩ B c )

=

P(B ) + P(B c )

Nestas condições segue que, dado que o evento B ocorreu, tem-se que

P(B c ) = 0 e P(A ∩ B c ) = 0

logo pode-se definir P(.|B ) para todo A ∈ F , com segue,

P(A|B ) =

P(A ∩ B )

.

P(B )

Para o exemplo assim tem-se que,

1

P(A|B ) = .

3

Definição 1.19 (Probabilidade Condicional). Seja (Ω, F , P) um espaço de probabilidade. Seja B ∈

F um evento tal que P(B ) > 0. Então a probabilidade condicional, dado o evento B, é uma função

denotada por P(.|B ) e definida para todo A ∈ F como segue,

P(A|B ) =

P(A ∩ B )

.

P(B )

(1.5)

em que P(A|B ) é chamada a probabilidade condicional de A dado B.

Suponhamos agora que tenhamos Ω1 , F1 , P1 e Ω2 , F2 , P2 dois espaços de probabilidade e

Ω, F , P o espaço produto associado. Considere A 1 ∈ Ω1 e A 2 Ω2 , então quem seria P1 (A 1 |A 2 ) e

P2 (A 2 |A 1 ) ? Para poder utilizar a Definição ?? temos que colocar os eventos A 1 e A 2 no mesmo

espaço. Para fazer isso, vamos verificar quem seria os eventos associados no espaço produto

Ω, F , P . Note que, o evento associcado a A 1 em F é A = A 1 × Ω2 pois se ω1 ∈ A 1 então ω =

(ω1 , ω2 ) ∈ A, do mesmo modo se ω = (ω1 , ω2 ) ∈ A então ω1 ∈ A 1 , logo P(A) = P1 (A 1 ). De maneira

análoga segue que para B = Ω1 × A 2 , tem-se P(B ) = P2 (A 2 ). Note ainda que,

A ∩ B = (A 1 × Ω2 ) ∩ (Ω1 × A 2 ) = A 1 × A 2 .

Portanto, da Definição ?? tem-se que,

P1 (A 1 |A 2 ) = P(A|B ) =

P(A ∩ B ) P(A 1 × A 2 )

P(A ∩ B ) P(A 1 × A 2 )

=

e P1 (A 2 |A 1 ) = P(B |A) =

=

.

P(B )

P2 (A 2 )

P(A)

P1 (A 1 )

Lema 1.1. A função P(.|B ) é uma medida de probabilidade em (Ω, F ).

Demonstração. De fato,

1. P(Ω|B ) = 1, pois

P(Ω|B ) =

P(Ω ∩ B ) P(B )

=

= 1;

P(B )

P(B )

2. Para todo A ∈ F segue que,

P(A|B ) =

P(A ∩ B )

≥0

P(B )

pois P(B ) > 0 e P(A ∩ B ) ≥ 0;

3. Seja A 1 , A 2 , . . . ∈ F tal que A i ∩ A j = ∅ para i 6= j então,

!

S∞

S∞

∞

[

P

A ∩B

P

(A n ∩ B )

n =1 n

n=1

P

=

An B =

P(B )

P(B )

n =1

P∞

∞

P(A n ∩ B ) X

P(A n ∩ B )

=

= n =1

P(B )

P(B )

n=1

=

∞

X

P(A n |B ).

n =1

Teorema 1.1 (Regra do Produto). Seja A 1 , A 2 , . . . , A n ∈ F eventos tais que,

!

n\

−1

P

An > 0

i =1

então,

P

n

\

!

An

= P(A 1 )P(A 2 |A 1 )P(A 3 |A 1 ∩ A 2 ) · · · P(A n |A 1 ∩ A 2 ∩· · · ∩ A n −1 ).

i =1

Se A i ∈ Fi para i = 1, . . . , n então,

!

n

\

P

A n = P1 (A 1 )P2 (A 2 |A 1 )P3 (A 3 |A 1 ∩ A 2 ) · · · Pn (A n |A 1 ∩ A 2 ∩· · · ∩ A n−1 ).

i =1

Demonstração. Fazer por indução. Tem-se que P(A 1 ∩ A 2 ) = P(A 1 )P(A 2 |A 1 ) pela Definição ?? de

probabilidade condicional. Suponha que é valido para k , isto é,

−1

P(A 1 ∩· · · ∩ A k ) = P(A 1 )P(A 2 |A 1 ) × · · · × P A k ∩ki =1

Ai

e então mostrar que vale para n = k + 1. Assim, seja B k = ∩ki=1 A i , logo

P(B k ∩ A k +1 ) = P(B k )P(A k +1 |B k ).

Exemplo 1.14. Uma urna contém 2 bolas brancas, 3 pretas e 4 verdes. Duas bolas são retiradas ao

acaso sem reposição. Qual a probabilidade de que:

(a) Ambas sejam verdes?

(b) Ambas sejam da mesma cor?

Solução: Seja (Ω1 , F1 , P1 ) o espaço de probabilidade na primeira retirada com Ω1 = {b, v, p }, (Ω1 , F1 , P1 )

o espaço de probabilidade na segunda retirada com Ω2 = {b, v, p }, e Ω = Ω1 × Ω2 o espaço amostral

do experimento, assim

(a) sejam os seguintes eventos: A 1 = {v } =”retirar verde na primeira retirada” e A 2 = {v } =”retirar

verde na segunda retirada” e no espaço produto, A = A 1 × Ω2 = {(v,b ), (v, v ), (v, p )} =”retirar

verde na primeira retirada” e B = Ω1 × A 2 = {(b, v ), (v, v ), (p, v )} =”retirar verde na segunda

retirada”. Assim,

P(A 1 × A 2 ) = P(A)P(B |A) = P1 (A 1 )P2 (A 2 |A 1 ) =

4 3 1

× = .

9 8 6

(b) sejam os seguintes eventos: B i = {b } =”retirar branca na i-ésima retirada” e C i = {p } =”retirar

preta na i-ésima retirada”. O evento desejado é (A 1 × A 2 ) ∪ (B 1 × B 2 ) ∪ (C 1 × C 2 ), portanto,

P (A 1 × A 2 ) ∪ (B 1 × B 2 ) ∪ (C 1 × C 2 ) = P(A 1 × A 2 ) + P(B 1 × B 2 ) + P(C 1 × C 2 )

= P1 (A 1 )P2 (A 2 |A 1 ) + P1 (B 1 )P2 (B 2 |B 1 ) + P1 (C 1 )P2 (C 2 |C 1 )

2 1 3 2 4 3

= × + × + ×

9 8 9 8 9 8

20

5

=

=

72 18

Exemplo 1.15. Um carcereiro informa a três prisioneiros que um deles foi sorteado para ser executado no dia seguinte, enquanto que os outros dois serão libertados. O prisioneiro João Espeto se

aproxima do carcereiro e cochicha no seu ouvido, solicitando que ele lhe conte qual dos outros dois

prisioneiros será solto. O prisioneiro argumenta que isso não altera em nada a situação, visto que

pelo menos um desses prisioneiros será solto. Entretanto, o carceiro não atende seu pedido, acreditando que isto poderia dar ao João Espeto alteração nas suas expectativas de ser libertado. Você

acha que o carcereiro tem razão?

Solução: Note que neste problema temos dois espaços amostrais: o espaço amostral de quem será

sorteado para ser executado,

Ω1 = A, B,C

em que, A = o prisioneiro João Espeto será executado, e o espaço amostral sobre a informação que o

carcereiro poderá fornecer,

Ω2 = b, c

em que b = o segundo prisioneiro será solto e c = o terceiro prisioneiro será solto. Assim, o espaço

amostral do nosso problema será o espaço produto,

Ω = Ω1 × Ω2 = (A,b ), (A, c ), (B,b ), (B, c ), (C ,b ), (C , c ) .

Agora note que,

P

Do mesmo modo,

1 1 1

(A,b ) = P A P b A = × =

3 2 6

1

(A, c ) = ,

6

1

P (B,b ) = P B P b B = × 0 = 0 = P (C , c )

3

1

1

P (B, c ) = P B P c B = × 1 = = P (C ,b ) .

3

3

P

e

Nestas condições segue que, se por exemplo o carcereiro disser que o segundo prisioneiro será solto

então

1

P (A,b )

1

= 61 = = P A

P A b =

3

P b

2

.

Teorema 1.2 (Probabilidade Total). Seja {A i , i = 1, . . . , n} uma partição de Ω com P(A i ) > 0 para

todo i = 1, . . . , n . Então, para todo B ∈ F tem-se que,

P(B ) =

n

X

P(A i )P(B |A i ).

i =1

Demonstração. De fato, pois

B = B ∩ Ω = B ∩ ∪ni=1 A i ,

assim,

P(B ) = P B ∩ ∪ni=1 A i

= P ∪ni=1 (A i ∩ B )

n

n

X

X

=

P(A i ∩ B ) =

P(A i )P(B |A i ).

i =1

i =1

Exemplo 1.16. No curso de Engenharia Mecânica 5% dos homens e 2% das mulheres estão acima

dos pesos ideais. Um aluno é escolhido aleatoriamente. Sabendo-se que 60% dos alunos são homens

calcule a probabilidade que:

a) O estudante esteja acima do peso;

Solução: Seja Ω1 = {h, m } o espaço amostral relacionado ao sexo dos alunos e Ω2 = {l , f } o

espaço amostral relacionado ao peso dos alunos. Assim, o espaço amostral do experimento é

dado por Ω = Ω1 × Ω2 . Seja A 1 = {h} o evento o aluno é do sexo masculino e A 2 = { f } o evento

o aluno está acima do peso ideal. Assim,

P2 (A 2 |A 1 ) = 0, 05, P2 (A 2 |A c1 ) = 0, 02, P1 (A 1 ) = 0, 60 e P1 (A c1 ) = 0, 40

No espaço produto, o evento o aluno está acima do peso ideal é

A = Ω1 × A 2 = (A 1 ∪ A c1 ) × A 2 = (A 1 × A 2 ) ∪ (A c1 × A 2 )

assim, a probabilidade do aluno está acima do peso ideal é dada por,

P2 (A 2 ) = P(A) = P (A 1 × A 2 ) ∪ (A c1 × A 2 ) = P A 1 × A 2 + P A c1 × A 2

= P1 (A 1 )P2 (A 2 |A 1 ) + P1 (A c1 )P2 (A 2 |A c1 ) = 0, 6 × 0, 05 + 0, 4 × 0, 02 = 0, 038.

b) Seja mulher sabendo que o estudante está acima do peso.

Solução: temos que

P1 (A c1 |A 2 ) =

P(A c1 × A 2 ) P1 (A c1 )P2 (A 2 |A c1 ) 0, 4 × 0, 02

=

=

= 0, 21.

P2 (A 2 )

P2 (A 2 )

0, 038

Exemplo 1.17. Seja U1 e U2 duas urnas. A urna U1 contém 3 bolas pretas e 2 vermelhas e a urna U2

contém 4 bolas pretas e 2 vermelhas. Escolhe-se ao acaso uma urna e dela retira-se ao acaso uma

bola. Qual a probabilidade de que a bola

n seja preta?

o

Solução: Tem-se que: Ω = Ω1 × Ω2 = (u 1 , p ), (u 1 , v ), (u 2 , p ), (u 2 , v ) , em que u 1 =“bola da urna 1”,

u 2 =“bola da urna 2”, p =“bola preta” e v =“bola vermelha”. Sejam os eventos: A 1 = {u 1 }“bola da

urna 1” e A 2 = {p }“bola preta”. Do problema tem-se que: P1 (A 1 ) = P1 (A c1 ) = 0, 5, P2

O evento de interesse é (U1 ∩ P) ∪ (U2 ∩ P), assim:

P (U1 ∩ P) ∪ (U2 ∩ P) = P(U1 ∩ P) + P(U2 ∩ P), pois os eventos são disjuntos

= P(U1 )P(P|U1 ) + P(P|U2 ) =

=

1 3 1 4

× + ×

2 5 2 6

3

1 19

+ =

10 3 30

Teorema 1.3 (Fórmula de Bayes). Seja {A i , i = 1, . . . , n} uma partição de Ω com P(A i ) > 0 para todo

i = 1, . . . , n. Então, para todo B ∈ F para o qual P(B ) > 0 tem-se que,

P(A j )P(B |A j )

P(A j |B ) = Pn

P(A i )P(B |A i )

i =1

Exemplo 1.18. Do exemplo anterior, calcule a probabilidade de que dado uma bola preta tenha

sido sorteada, ela seja da urna U1 ?

Solução: Primeiro note que U1 e U2 são uma partição de Ω. Assim,

P(U1 |P) =

=

=

P(U1 )P(P|U1 )

P(U1 )P(P|U1 ) + P(U2 )P(P|U2 )

1

× 35

2

1

× 35 + 12

2

3

9

10

=

19

19

30

× 46

Definição 1.20. Sejam A, B ∈ F e ((Ω, F ), P) um espaço de probabilidade. Então A e B são independentes se

P(A|B ) = P(A) ou se P(B |A) = P(B ).

Isto é, o fato de um dos eventos ocorrer não altera a probabilidade do outro ocorrer, assim da Definição ?? de probabilidade condicional segue que,

P(A ∩ B ) = P(A)P(A|B ) = P(A|B )P(B ) = P(A)P(B ).

Exemplo 1.19. Sejam dois eventos A e B tal que P(A) = 12 , P(A|B ) =

são independes?

Solução: Os eventos A e B são independentes, pois,

1 1 1

× =

2 4 8

P(A ∩ B )

P(A ∩ B ) = P(B )P(A|B ) ⇒ P(B ) =

=

P(A|B )

1

2

e P(B |A) = 14 . Esses eventos

1

8

1

2

=

P(A ∩ B ) = P(A)P(B |A) =

P(A)P(B ) =

1

4

1 1 1

× = = P(A ∩ B )

2 4 8

Definição 1.21. Seja ((Ω, F ), P) um espaço de probabilidade e A 1 , . . . , A n eventos em F . Então os

eventos são independentes(ou completamente independentes) se,

P(A i 1 ∩ · · · ∩ A i k ) = P(A i 1 ) × . . . × P(A i k )

para k = 2, . . . , n e i 1 , . . . , i k = 1, . . . , n tal que 1 ≤ i 1 < . . . < i k ≤ n . Diz-se também que estes eventos

são dois a dois independentes se,

P(A i ∩ A j ) = P(A i )P(A j ), para todo i 6= j .

1.6

Problemas

1. Na copa do mundo de futebol em 2006, os jogos das semi-finais foram Alemanha versus

Itália e França versus Portugal. Supondo que não sabemos os resultados destes jogos, responda:

a) Qual o espaço amostral da classificação final dos quatro times?

b) Seja A o evento em que a Itália é a campeã da copa do mundo. Descreva o evento A;

c) Seja B o evento em que Portugal seja um dos finalistas. Descreva o evento B ;

d) Descreva os eventos A ∪ B e A ∩ B .

2. Considere os veículos que passam pela BR-230 na altura da UFPB, no ponto em que podem

continuar na BR-230(f ), seguir em direção à UFPB(d) ou seguir em direção ao centro pela

Pedro II(e). Considerando a direção tomada por três veículos quaisquer que passam sucessivamente, descreva os seguintes eventos:

a) Ω;

b) A = os três veículos seguem na mesma direção;

c) B = cada veículo toma uma direção diferente;

d) C = exatamente dois seguem em direção à UFPB;

e) D = exatamente dois seguem na mesma direção;

f) A ∩ B , A ∩C , A ∩ D, B ∩C , B ∩ D e C ∩ D. Quais desses eventos formam uma partição de

Ω?

3. Uma empresa de construção civil está construindo três prédios(1,2,3) em João Pessoa. Seja

A i o evento em que a empresa entrega o prédio i no prazo previsto. Descreva os eventos a

seguir em termos dos eventos dados A 1 , A 2 , A 3 e desenhe o diagrama de Venn sombreando a

região correspondente ao evento descrito.

a) B 1 = ao menos um prédio é entregue no prazo previsto;

b) B 2 = todos os prédios são entregues no prazo previsto;

c) B 3 = apenas o prédio 1 é entregue no prazo previsto;

d) B 4 = Exatamente um prédio é entregue no prazo previsto;

e) B 5 = nenhum prédio é entregue no prazo previsto;

4. Dois dados são lançados. Sejam os eventos:

A: o primeiro número é maior que o segundo;

B: o primeiro número é igual ao dobro do segundo;

C: a soma dos dois números é maior ou igual a 8.

a) Descreva o espaço amostral e os eventos A, B e C ;

b) Calcule a probabilidade dos eventos A, B e C ;

c) Calcule P(A ∩ C ), P(B ∩ C c ) e P(A|C c ).

5. Uma caixa contém fichas de duas cores sendo 4 vermelhas(v) e 3 pretas(p). Uma segunda

caixa contém 2 vermelhas(v) e 4 pretas(p). Uma ficha é selecionada aleatoriamente da primeira caixa e colocada na segunda. Em seguida uma ficha é retirada da segunda caixa.

a) Descreva o espaço amostral do experimento. Obs.: Este experimento é composto pois

são observadas duas variáveis: a cor da ficha retirada da 1a. caixa e a cor da ficha

retirada da segunda caixa.

b) Seja A o evento a segunda ficha é vermelha. Descreva o evento A e calcule a sua probabilidade.

6. Um sistema de alarme que indica quando a temperatura de uma máquina está elevada a

ponto de provocar um incêndio utiliza três sensores(1,2,3) que agem independentemente

um do outro. A probabilidade de cada sensor não funcionar é de 0,1 quando a temperatura

ultrapassa 80o C . O alarme é ativado se pelo menos um dos sensores entrar em funcionamento.

a) Descreva o espaço amostral do experimento. Obs.: o experimento é a observação do

funcionamento ou não dos sensores;

b) Seja A o evento o alarme dispara quando a temperatura ultrapassar 80o C . Descreva o

evento A c e calcule P(A) utilizando a relação entre P(A) e P(A c ).

7. Uma máquina pode parar por defeito mecânico ou elétrico. Se há defeito elétrico a probabilidade da máquina parar é de 0,3 e se há defeito mecânico a máquina para na proporção

de 1 para 4. Em 80% das vezes que a máquina é ligada não há defeito mecânico, em 10% das

vezes que a máquina é ligada há defeito elétrico. Considere que não pode ocorrer mais de

um defeito quando a máquina é ligada.

a) Descreva o espaço amostral do experimento. Obs.: Este experimento é composto pois

são observadas duas variáveis: estado da máquina e defeito. Deste modo, o espaço

amostral é o resultado de um produto de dois espaços amostrais. Um espaço amostral

é o da variável estado da máquina(parada ou em funcionamento) e o outro espaço

amostral é o da variável defeito(nenhum defeito, defeito elétrico, defeito mecânico).

b) Se a máquina parar, qual a probabilidade de ser por defeito mecânico?

c) Qual a probabilidade da máquina parar?

8. Para verificar o perfil de seus empregados o gerente de uma indústria coletou as seguintes

informações:

Homens(h)

Mulheres(m)

Menor que 25 anos(l)

20

8

Entre 25 e 40 anos(b)

45

25

Maior que 40 anos(u)

18

42

Um empregado é selecionado ao acaso:

a) Descreva o espaço amostral desse experimento;

b) Qual a probabilidade que ele seja homem ou tenha entre 25 e 40 anos de idade;

c) Qual a probabilidade que tenha mais de 40 anos e seja homem;

d) Qual a probabilidade que tenha menos de 25 anos sabendo que é mulher;

Considere agora que dois empregados são selecionados ao acaso e sem reposição:

e) Descreva o espaço amostral desse experimento;

f) Ambos tenham menos de 25 anos;

g) Exatamente 1 tenha mais de 40 anos;

h) A idade dos funcionários independe do sexo?

9. No curso de Engenharia Mecânica 5% dos homens e 2% das mulheres estão acima dos pesos

ideais. Um estudante é escolhido aleatoriamente. Sabendo-se que 60% dos estudantes são

homens calcule a probabilidade de que:

a) O estudante esteja acima do peso;

b) Seja mulher sabendo que o estudante está acima do peso.

10. Na disciplina de Cálculo das Probabilidades e Estatística I, apenas dois alunos, Paulo e João,

ficaram para fazer o exame final. A probabilidade de Paulo resolver a prova em mais de 1

hora é 0,6 e a probabilidade de que João resolva a prova em menos de 1 hora é de 0,7. Qual a

probabilidade da prova ser resolvida em menos de 1 hora?

11. A probabilidade de uma mulher estar viva daqui a 30 anos é de 3/4 e de seu marido é de 3/5.

Calcule a probabilidade de que:

a) Apenas o homem estar vivo;

b) Apenas a mulher estar viva;

c) Pelo menos um estar vivo;

d) Ambos estarem vivos.

12. Três empresa, 1,2 e 3, de informática disputam a obtenção de um contrato para a produção

de um software. O diretor do departamento de vendas da empresa 1 estima que sua companhia tem probabilidade igual à da empresa 2 de obter o contrato que por sua vez é igual

a duas vezes a probabilidade da empresa 3 obter o mesmo contrato. Determine a probabilidade da empresa 1 ou 3 obter o contrato.

13. Suponha que temos dois lotes nas seguintes condições: O primeiro lote(l 1 ) contendo 200

peças das quais 10 tem defeito(d) de fabricação, e o segundo lote(l 2 ) contendo 300 peças

das quais 12 tem defeito(d) de fabricação. Se uma peça for retirada de cada lote, qual é a

probabilidade de que:

a) Pelo menos uma das peças escolhidas seja perfeita;

b) Ambas tenham defeito de fabricação?

c) Nenhuma delas tenha defeito de fabricação?

d) Apenas a peça do primeiro lote tenha defeito de fabricação?

e) Somente uma delas tenha defeito de fabricação?

14. Numa cidade 20% dos carros são da marca K, 30% dos carros são táxis e 40% dos táxis são da

marca K. Se um carro é escolhido, ao acaso, determinar a probabilidade de que:

a) Ser táxi e ser da marca K;

b) Ser táxi e não ser da marca K;

c) Não ser táxi, sabendo-se que é da marca K;

d) Não ser táxi e não ser da marca K;

e) Não ser táxi e ser da marca K.

15. Em uma empresa a probabilidade de que uma nova política de mercado tenha sucesso(A)

foi estimada em 0,6. A probabilidade de que a despesa para o desenvolvimento da estratégia

seja mantida dentro dos limites do orçamento previsto(B) é de 0,5. Admitindo que ambos

os eventos A e B sejam independentes, determine a probabilidade de que:

a) Pelo menos um dos objetivos seja atingido;

b) Somente A seja atingido;

c) Somente B seja atingido.

16. Em uma universidade, 40% dos estudantes praticam vôlei e 30% praticam natação. Dentre

os que praticam vôlei, 20% praticam também natação. Que porcentagem de estudantes não

praticam nenhum dos dois esportes?

17. Sejam A e B dois eventos tais que P(A) = 0, 4 e P(A ∪ B ) = 0, 7. Seja P(B ) = p . Para que valor

de p , A e B serão mutuamente exclusivos? Para que valor de p A e B serão independentes?

18. Uma caixa contém 5 bolas brancas e três bolas pretas. Duas bolas são retiradas simultaneamente ao acaso e substituídas por três bolas azuis. Em seguida duas novas bolas são

retiradas da caixa.

a) Descreva o espaço amostral deste experimento;

b) Calcule a probabilidade de as duas últimas bolas retiradas sejam da mesma cor;

c) Se as duas últimas bolas retiradas forem uma branca e uma preta, calcular a probabilidade de que, na primeira extração, tenham saído duas bolas brancas.

19. Dois jogadores jogam alternadamente uma moeda, ganhando o jogo aquele que primeiro

obtiver uma cara.

a) Descreva o espaço amostral deste experimento;

b) Qual a probabilidade do primeiro jogador ganhar o jogo?

c) Qual a probabilidade do segundo jogador ganhar o jogo?

20. Em um lote de 12 lâmpadas, duas são defeituosas. Considere o experimento: três lâmpadas

são escolhidas aleatoriamente.

a) Descreva o espaço amostral deste experimento;

b) Qual a probabilidade de que nenhuma seja defeituosa;

c) Qual a probabilidade de que exatamente uma seja defeituosa;

d) Qual a probabilidade de que pelo menos uma seja defeituosa;

e) Qual a probabilidade de que exatamente duas sejam defeituosas.

21. Em uma festa beneficente serão sorteados um DVD(a) e uma máquina fotográfica digital(b).

São vendidos 400 bilhetes para o primeiro prêmio e 200 para o segundo. Uma mulher compra 4 bilhetes para concorrer a cada prêmio. Encontre a probabilidade de que:

a) Descreva o espaço amostral deste experimento;

b) Ela ganhe exatamente um prêmio;

c) Ela ganhe alguma coisa.

Capítulo 2

Variáveis aleatórias

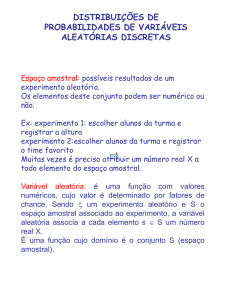

Neste capítulo serão estudados o conceito de variável aleatória, sua classificação: discreta e

contínua; os tipos de distribuição de probabilidade: função de probabilidade, função de distribuição e densidade de probabilidade; e os conceitos de esperança, variância e função geradora de

momentos.

2.1

Conceitos e definições

Definição 2.1 (Variável aleatória). Seja (Ω, F , P) um espaço de probabilidade associado. Então uma

função X : Ω → R, que associa a cada elemento de ω ∈ Ω um número real é uma variável aleatória

se a imagem inversa de todo boreliano da reta B for um elemento de F , isto é,

n

o

X −1 (B ) = ω ∈ Ω : X (ω) ∈ B ∈ F

Os borelinos da reta é a classe de todos os tipos de intervalos da reta

n

o

(−∞, x ), (−∞, x ], (x , ∞), [x , ∞), (x , y ), [x , y ), (x , y ], [x , y ]

Observação 2.1. A função X deve ser unívoca, isto é, para cada ω ∈ Ω deve haver apenas um X (ω)

associado. Entretanto, diferentes valores de ω podem levar a um mesmo valor de X .

Observação 2.2. Uma função X satisfazendo as condições da Definição ?? é chamada de variável

aleatória F −mensurável.

Exemplo 2.1. Considere o seguinte experimento: selecionar uma peça em uma linha de produção e

observar se a peça é boa ou ruim. Nestas condições, segue que Ω = {b, r } em que b=boa e r=ruim.

Consideremos a seguinte variável aleatória,

(

0 se ω = b,

X (ω) =

1 se ω = r,

n

o

Assim, considerando a σ−álgebra das partes de Ω, isto é, F = ∅, Ω,b, r tem-se que para todo

boreliano B ⊂ R tal que:

25

• {0, 1} ∈

/ B , por exemplo B = (−5, 0), assim X −1 (B ) = ∅ ∈ F ;

• 0∈B e1∈

/ B , por exemplo B = 0, 21 , assim

X −1 (B ) = X −1 (0) = {b } ∈ F ;

• 0∈

/ B e 1 ∈ B , por exemplo B = [1, 2], assim

X −1 (B ) = X −1 (1) = {r } = {r } ∈ F ;

• {0, 1} ∈ B , por exemplo B = [0, 1], assim

X −1 (B ) = X −1 ({0, 1}) = {b, r } = Ω ∈ F ;

Portanto X como definido é uma variável aleatória.

Observação 2.3. Note que para todo boreliano B da reta tal que B ∩ Im(X ) = ∅ tem-se X −1 (B ) = ∅ ∈

F , em que Im(X ) é o conjunto imagem de X . Logo, é suficiente fazer a verificação apenas para o

conjunto imagem de X que denotaremos de ΩX .

Definição 2.2. Seja (Ω, F , P) um espaço de probabilidade

e X uma

variável aleatória. Então PX será

a medida de probabilidade induzida por X no espaço R, B R , tal que para todo A = X −1 (B ) ∈ F

tem-se que

PX (B ) = P X −1 (B ) = P(A).

Portanto R, B R , PX será o espaço de probabilidade induzido pela variável aleatória X .

Observação

2.4. Visto que PX (B ) = 0 para todo B ∩ ΩX = ∅, ao invés de utilizarmos o espaço

(R, B R , PX ) utilizaremos (ΩX , FX , PX ), em que FX é a σ-álgebra gerada por ΩX .

Observação 2.5. De um modo geral, sempre que estamos trabalhando com a medida de probabilidade induzida por uma variável aleatória X utilizamos a notação PX , entretanto para que a notação

não fique muito carregada e desde que não possa haver confusão não utilizaremos o subescrito.

Definição 2.3 (Função de Distribuição). Seja X uma variável aleatória, então sua função de distribuição é definida como,

−1

F (x ) = P(X ≤ x ) = P X (ω) ∈ (−∞, x ] = P X

− ∞, x

,

para todo x ∈ R. F é também conhecida como função de distribuição acumulada de X .

Propriedades: As condições necessárias e suficientes para que uma função seja uma função de

distribuição são:

(P1) limx →−∞ F (x ) = 0 e limx →∞ F (x ) = 1;

(P2) F é contínua à direita, isto é, para x n ↓ x tem-se que limx n →x F (x n ) = F (x + ) = F (x );

(P3) F é não decrescente, isto é, F (x ) ≤ F (y ) para todo x , y ∈ R tal que x ≤ y .

Exemplo 2.2. Seja X uma variável aleatória e F uma função dada por

0

se x < 1

1

F (x ) = c 1 − e −(x −1)

se 1 ≤ x < 2

1

−1

−2

−2(x

−1)

1−e +e −e

se x ≥ 2.

c

a) Verifique se F pode ser uma função de distribuição;

Solução: F é uma função de distribuição para c = 1 − e −1 + e −2 . De fato,

(a)

lim F (x ) = 0 pois F (x ) = 0 para x < 1

x →−∞

1

1

1 − e −1 + e −2 − e −2(x −1) =

1 − e −1 + e −2 = 1

x →∞

x →∞ c

c

−1

−2

Assim, para c = 1 − e + e tem-se limx →∞ F (x ) = 1;

lim F (x ) = lim

(b) F é continua à direita pois é contínua nos intervalos x < 1, 1 ≤ x < 2 e x ≥ 2 e nos pontos

x = {1, 2} tem-se que F (1) = F (1+ ) e F (2) = F (2+ ). Alem disso, note que F é continua pois

F (1) = F (1+ ) =

1

1 − e −(1−1) = 0 = F (1− )

c

e

F (2) = F (2+ ) =

1

1

1

1 − e −1 + e −2 − e −2(2−1) =

1 − e −1 = F (2− ) =

1 − e −(2−1)

c

c

c

(c) F é não decrescente, pois

1

e −(x −1)

d F (x )

= c2 e −2(x −1)

dx

0

c

se 1 ≤ x < 2

se x ≥ 2

≥ 0 para todo x ∈ R.

caso contrário

b) Calcule P X ≥ 1, 5X < 4 .

Solução:

P X ≥ 1, 5X < 4 = 1 − P X < 1, 5X < 4 = 1 − P X ≤ 1, 5X ≤ 4 pois F é contínua

P X ≤ 1, 5 , X ≤ 4

=1−

P X ≤4

P X ≤ 1, 5

F (1, 5)

=1−

=1− F (4)

P X ≤4

=1−

0, 39347

= 0, 4856.

0, 76498

2.2

Classificação das variáveis aleatórias

As variáveis aleatórias podem ser discretas ou contínuas. A classe das variáveis aleatórias contínuas ainda pode ser subdividida em três: absolutamente contínua, singular e mista. Neste curso

será abordada apenas a variável aleatória discreta e a absolutamente contínua.

Definição 2.4 (Variável aleatória discreta). Uma variável aleatória X é discreta se o número de valores que X possa assumir for enumerável.

Definição 2.5 (Função de Probabilidade). A função de probabilidade de uma variável aleatória X

discreta é uma função que atribui probabilidade a cada um dos possíveis valores x i de X , isto é,

PX (x i ) = P(X = x i ) = P({ω ∈ Ω : X (ω) = x i })

para todo i ∈ {1, 2, . . . , n}, n ∈ N e satisfaz as seguintes condições,

(i) para todo i ∈ {1, 2, . . . , n} tem-se que 0 ≤ P(X = x i ) ≤ 1;

Pn

(ii)

P(X = x i ) = 1.

i =1

Exemplo

2.3. Seja E =lançamento

moeda, seja X =número de caras ocorridos. Assim,

n

o

n de duas

o

Ω = (c , c ), (c , r ), (r, c ), (r, r ) ΩX = 0, 1, 2 e

1

PX (0) = P X −1 (0) = P(r, r ) = ,

4

2 1

PX (1) = P X −1 (1) = P (c , r ), (r, c ) = P(c , r ) + P(r, c ) = = ,

4 2

1

PX (2) = P X −1 (2) = P(c , c ) = .

4

Deste modo, a função de probabilidade de X é dada por

X

0

1

2

PX (x )

1

4

1

2

1

4

Definição 2.6. Para uma variável aleatória discreta a função de distribuição é dada por,

X

X

F (x ) =

PX (x i ) =

P(X = x i ).

x i ≤x

x i ≤x

para todo x ∈ R.

Exemplo 2.4. Do exemplo anterior tem-se que,

0

1

F (x ) = 43

4

1

se x < 0

se 0 ≤ x < 1

se 1 ≤ x < 2

se x ≥ 2

Observação 2.6. Da Definição ?? segue que

• P(a < X ≤ b ) = F (b ) − F (a );

h

i

• P(a ≤ X ≤ b ) = F (b ) − F (a ) − P(X = a ) = F (b ) − F (a − );

h

i

• P(a < X < b ) = F (b ) − P(X = b ) − F (a ) = F (b − ) − F (a );

h

i h

i

• P(a ≤ X < b ) = F (b ) − P(X = b ) − F (a ) − P(X = a ) = F (b − ) − F (a − );

De fato,

F (b ) − F (a ) =

X

P(X = x i ) −

X

P(X = x i )

x i ≤a

x i ≤b

=

X

P(X = x i ) +

X

P(X = x i ) −

a <x i ≤b

x i ≤a

=

X

X

P(X = x i )

x i ≤a

P(X = x i ) = P(a < X ≤ b ).

a <x i ≤b

Exemplo 2.5. Remessas de carne são feitas periodicamente por um grande frigorífico industrial. O

período de entrega, isto é, o tempo transcorrido entre o recebimento do pedido e a entrega da carne,

é uma variável aleatória X (medida em dias), com a seguinte função de probabilidade.

(

PX (x ) =

c (9 − x ) se x = {4, 5, 6, 7}

caso contrário .

0

Determinar:

1

;

(a) O valor da constante c; Resposta: c = 14

(b) A probabilidade de o período de entrega ser no mínimo 5 dias; Resposta: P(X ≥ 5) = 0, 6429.

Definição 2.7 (Variável aleatória contínua). Uma variável aleatória X é contínua se o número de

valores que X possa assumir for não enumerável.

Definição 2.8 (Variável aleatória absolutamente contínua). Uma variável aleatória X é absolutamente contínua se existir uma função não negativa f tal que para todo x ∈ R,

Z

x

F (x ) =

f (t )d t .

−∞

em que F é a função de distribuição da variável aleatória X .

Observação 2.7. Note que toda variável aleatória absolutamente contínua é uma variável aleatória contínua mas nem toda variável aleatória contínua é uma variável aleatória absolutamente

contínua.

A função f da Definição ?? é chamada de função densidade de probabilidade, e da Definição

??, segue que,

d F (x )

f (x ) =

dx

para todo x ∈ R aonde F for derivável.

Propriedades da função densidade: As condições necessárias e suficientes para que uma função seja uma função densidade são:

(i) f (x ) ≥ 0 para todo x ∈ R;

R∞

(ii) −∞ f (x )d x = 1.

A partir da definição de função de distribuição para uma variável aleatória contínua tem-se

que,

P X (ω) ∈ (a ,b ] = P(a < X ≤ b ) = P(a ≤ X ≤ b ) = P(a ≤ X < b ) = P(a < X < b )

Zb

f (x )d x = F (b ) − F (a ).

=

a

para todo a ,b ∈ R tal que a < b .

Exemplo 2.6. Seja X uma variável aleatória contínua. Seja f uma função como segue,

(

2x se 0 ≤ x ≤ 1

f (x ) =

0

caso contrário.

(a) Mostre que f é uma função densidade de probabilidade;

(b) Calcule P(X ≤ 0, 75)?

(c) Calcule P(X ≤ 0, 75|0, 5 ≤ X ≤ 1)?

Solução:

(a) f é uma fdp pois,

(i) f (x ) ≥ 0 para todo x ∈ R, pois

(1) Para x ∈ [0, 1] tem-se que 2x ≥ 0;

(2) Para x ∈

/ [0, 1] tem-se que f (x ) = 0.

(ii)

Z

−∞

Z

−∞

1

2x d x = x 2 0 = 1

f (x )d x =

∞

Portanto,

∞

0

F (x ) = x 2

1

se x < 0

se 0 ≤ x ≤ 1

se x > 1.

(b) Do ítem anterior tem-se que,

2

9

3

= .

P(X ≤ 0, 75) = F (0, 75) =

4

16

(c) temos que,

P ((X ≤ 0, 75) ∩ (0, 5 ≤ X ≤ 1)) P(0, 5 ≤ X ≤ 0, 75)

=

P(0, 5 ≤ X ≤ 1)

P(0, 5 ≤ X ≤ 1)

1

9

F (0, 75) − F (0, 5) 16 − 4

5

=

=

=

1

F (1) − F (0, 5)

12

1− 4

P(X ≤ 0, 75|0, 5 ≤ X ≤ 1) =

2.2.1

Independência de Variáveis Aleatórias

Vamos agora definir o conceito de independência entre variáveis aleatórias. Como será visto,

este conceito difere um pouco do conceito de independência entre eventos, pois agora cada variável aleatória gera uma σ-álgebra, deste modo para que um conjunto de variáveis aleatórias sejam

independentes, as σ-álgebras deverão ser independentes, isto é, se tivermos n variáveis aleatórias, então elas serão independentes se as n σ-álgebras fores independentes. Se isto ocorrer então

quaisquer subconjunto das n variáveis aleatórias serão independentes. É exatamente este fato que

difere do conceito de independência entre eventos, isto é, n eventos independentes não implica

que são 2 a 2 independentes.

Definição 2.9 (Independência entre variáveis aleatórias). Sejam X 1 , . . . , X n , n variáveis aleatórias

definidas no espaço de probabilidade (Ω, F , P). Então, X 1 , . . . , X n são independentes se para todo

boreliano da reta B i ∈ B R , i ∈ {1, . . . , n} tivermos,

P(X 1 ∈ B 1 , . . . , X n ∈ B n ) =

n

Y

P(X i ∈ B i );

i =1

Pela definição acima segue que,

1. Se X 1 , . . . , X n tem função de distribuição F1 , . . . , Fn respectivamente, então,

F (x 1 , . . . , x n ) =

n

Y

Fi (x i ).

i =1

2. Se X 1 , . . . , X n tem função densidade f 1 , . . . , f n respectivamente, então,

f (x 1 , . . . , x n ) =

n

Y

f i (x i ).

i =1

Exemplo 2.7. Considere o experimento de lançar um moeda honesta duas vezes. Assim,

n

o

Ω = (c , c ), (c , r ), (r, c ), (r, r ) .

Considere as seguintes variáveis aleatórias: X 1 =“número de caras nos dois lançamentos mais o número de coroas nos dois lançamentos”, X 2 =“número de caras nos dois lançamentos menos o número

de coroas nos dois lançamentos” assim,

Ω

(c,c)

(c,r)

(r,c)

(r,r)

X1

2

2

2

2

X2

2

0

0

-2

Deste modo, tem-se que,

X1

2

2

2

2.3

P(X 1 = x )

1

1

1

X2

2

0

-2

P(X 2 = y )

P(X 1 = x , X 2 = y )

1

4

1

2

1

4

1

4

1

2

1

4

Função de Variáveis Aleatórias

Seja (Ω, F , P) um espaço de probabilidade, X uma variável aleatória neste espaço e (ΩX , FX , PX ).

Seja h : ΩX → R uma função FX -mensurável, nestas condições Y = h(X ) também será uma variável

aleatória e sua função de probabilidade induzida PY será para todo boreliano da reta B ,

n

o

P(Y ∈ B ) = P X ∈ h −1 (B ) = P x ∈ ΩX : h(x ) ∈ B .

Definição 2.10. Chama-se supremo de um conjunto B à menor de suas cotas superiores. Assim, se

s for o supremo de B então:

• para todo b ∈ B tem-se que b ≤ s ;

• para todo ε > 0 existe um b ∈ B tal que s − ε < b

Definição 2.11. Chama-se ínfimo de um conjunto B à maior de suas cotas inferiores. Assim, se i for

o ínfimo de B então:

• para todo b ∈ B tem-se que b ≥ i ;

• para todo ε > 0 existe um b ∈ B tal que i + ε > b

Se h for uma função monótona não decrescente então a função de distribuição de Y é dada

por,

FY (y ) = P(Y ≤ y ) = P X ≤ h −1 (y ) = FX h −1 (y )

em que h −1 (y ) = inf x ∈ ΩX : h(x ) ≥ y é a inversa generalizada para este caso. Se h for uma função

monótona não crescente então a função de distribuição de Y é dada por,

FY (y ) = P(Y ≤ y ) = P X ≥ h −1 (y ) 1 − FX h −1 (y )−

em que h −1 (y ) = inf x ∈ ΩX : h(x ) ≤ y é a inversa generalizada para este caso.

Se X for uma variável aleatória absolutamente contínua e h for uma função derivável e bijetora,

então a densidade de Y é dada por,

d FX h −1 (y ) d h −1 (y )

d FY (y ) d FX h −1 (y )

=

=

= f X h −1 (y ) J (x , y ).

f Y (y ) =

−1

dy

dy

d h (y )

dy

em que

J (x , y ) =

d h −1 (y )

dy

=

−1 d h(x )

dx

x =h −1 (y )

é chamado de jacobiano da transformação. Se h não for bijetora, então pode-se obter uma partição do domínio da função de modo que em cada partição a função seja bijetora, nestas condições

segue para B 1 , . . . , B k uma partição, h i a restrição da função h na partição B i e J i é o Jacobiano da

transformação na partição B i que,

f Y (y ) =

k

X

(y

)

J i (x , y ).

f X h −1

i

i =1

Exemplo 2.8. O tempo T em minutos necessário para um operário processar certa peça, é uma

variável aleatória com a seguinte distribuição de probabilidade:

T(min)

P(t )

2

0,1

3

0,1

4

0,3

5

0,2

6

0,2

7

0,1

t∈

/ {2, 3, 4, 5, 6, 7}

0

(a) Para cada peça processada o operário ganha um fixo de R$2, 00, mais R$0, 50 por cada minuto

inferior a 6 minutos. Determine a variavél aleatória X ganho do operário e a sua função de

distribuição;

Solução: Seja X = h(T ) a variável aleatória ganho do operário. Do problema tem-se que:

(

2

se t = {6, 7}

h(t ) =

2 + 0, 5 × (6 − t ) se t = {2, 3, 4, 5}

●

3.0

●

●

2.5

X

3.5

4.0

Gráficamente, temos que,

2.0

●

2

3

4

5

●

●

6

7

T

Figura 2.1: Ganho do operário

Note que h é monótona não crescente, assim

h −1 (4, 0) = inf {t ∈ ΩT : h(t ) ≤ 4, 0} = inf {2, 3, 4, 5, 6, 7} = {2}

Portanto,

• Para x < 2, 0 tem-se que F (x ) = 0;

• Para 2 ≤ x < 2, 5 tem-se que,

h −1 (x ) = inf {t ∈ ΩT : h(t ) ≤ x } = inf {6, 7} = {6}

assim,

F (x ) = P T ≥ h −1 (x ) = P(T ≥ 6) = 0, 2 + 0, 1 = 0, 3;

• Para 2, 5 ≤ x < 3, 0 tem-se que,

h −1 (x ) = inf {t ∈ ΩT : h(t ) ≤ x } = inf {5, 6, 7} = {5}

assim,

F (x ) = P T ≥ h −1 (x ) = P(T ≥ 5) = 0, 2 + 0, 1 + 0, 2 = 0, 5;

• Para 3, 0 ≤ x < 3, 5 tem-se que,

h −1 (x ) = inf {t ∈ ΩT : h(t ) ≤ x } = inf {4, 5, 6, 7} = {4}

assim,

F (x ) = P T ≥ h −1 (x ) = P(T ≥ 4) = 0, 2 + 0, 1 + 0, 2 + 0, 3 = 0, 8;

• Para 3, 5 ≤ x < 4, 0 tem-se que,

h −1 (x ) = inf {t ∈ ΩT : h(t ) ≤ x } = inf {3, 4, 5, 6, 7} = {3}

assim,

F (x ) = P T ≥ h −1 (x ) = P(T ≥ 3) = 0, 2 + 0, 1 + 0, 2 + 0, 3 + 0, 1 = 0, 9;

• Para x ≥ 4, 0 tem-se que,

h −1 (x ) = inf {t ∈ ΩT : h(t ) ≤ x } = inf {2, 3, 4, 5, 6, 7} = {2}

assim,

F (x ) = P T ≥ h −1 (x ) = P(T ≥ 3) = 0, 2 + 0, 1 + 0, 2 + 0, 3 + 0, 1 + 0, 1 = 1;

F (x ) =

0

0, 3

0, 5

se x < 2

0, 8

0, 9

1

se 3, 0 ≤ x < 3, 5

se 2, 0 ≤ x < 2, 5

se 2, 5 ≤ x < 3, 0

se 3, 5 ≤ x < 4, 0

se x ≥ 4, 0

2.4

Esperança de uma variável aleatória

A esperança de uma variável aleatória nada mais é que o valor médio esperado da variável. Por

este motivo a esperança é usualmente denominado de valor esperado.

Definição 2.12 (Valor Esperado). Seja Ω, F , P um espaço de probabilidade, X variável aleatória

neste espaço e ΩX , FX , PX o espaço de probabilidade induzido por X . Então o valor esperado de X ,

denotado por E (X ), é para o caso em que X é discreta,

E (X ) =

X

x P(x )

x ∈ΩX

e para o caso em que X é contínua

∞

Z

E (X ) =

x f (x )d x

−∞

em ambos os casos uma condição suficiente para a existência do valor esperado é E |X | < ∞.

O incômodo desta definição é que temos que provar cada teorema duas vezes para caso discreto e para o caso absolutamente contínuo, isto sem levar em conta os outros tipos de variáveis

aleatórias. Uma maneira de unificar estas definições e torna-la um pouco mais geral é utilizar o

conceito da integral de Riemann-Stieltjes.

Definição 2.13 (Riemann-Stieltjes). Sejam h e F duas funções reais definidasnno intervaloo[a ,b ],

com F uma função monótona não decrescente contínua à direita. Seja B = x 0 , x 1 , . . . , x n uma

partição de [a ,b ] em que a = x 0 < x 1 < . . . < x n −1 < x n = b . Então a integral de Riemann-Stieltjes é

definida como,

Zb

X

h(x )d F (x ) =

lim

h(x k i )[F (x i ) − F (x i −1 )]

max |x j −x j −1 |→0

a

x i ∈B

se o limite existir, em que x i ≤ x k i ≤ x i −1 . Neste caso, diz-se que h é Riemann-Stieltjes integrável com

relação a F .

Se F for uma função degrau contínua à direita então

Z

b

h(x )d F (x ) =

X

h(x )[F (x ) − F (x − )],

{x ∈(a ,b ]:F (x )−F (x − )>0}

a

se F for uma função de distribuição então observe que F (x ) − F (x − ) = P(X = x ). Se F = f (x ) em

[a ,b ] então,

Zb

Zb

0

h(x )d F (x ) =

a

h(x )f (x )x d x .

a

Note que para F (x ) = x então tem-se a integral de Riemann. O caso em que o intervalo é infinito é

tratado tomando-se o limite nos extremos de integração.

Definição 2.14. Seja X uma variável aleatória com função distribuição F . O valor esperado de X é

dado por,

Z

∞

E (X ) =

x d F (x )

−∞

se E |X | < ∞.

Exemplo 2.9. Seja X uma variável aleatória com função de distribuição,

0

se x < 0

0, 5

se 0 ≤ x < 1

F (x ) =

0, 75 se 1 ≤ x < 2

1

se x ≥ 2.

então,

X

E (x ) =

x [F (x ) − F (x − )]

{x ∈R:F (x )−F (x − )>0}

X

=

x [F (x ) − F (x − )]

{x ∈{0,1,2}}

= 0 × [F (0) − F (0− )] + 1 × [F (1) − F (1− )] + 2 × [F (2) − F (2− )]

3

= 0 × 0, 5 + 1 × 0, 25 + 2 × 0, 25 = 0, 75 =

4

Considere agora que X tem função de distribuição dada por

0 se x < 0

F (x ) = x 2 se 0 ≤ x ≤ 1

1 sex ≥ 1

então,

(

0

F (x ) = f (x ) =

assim,

Z

∞

E (X ) =

se 0 ≤ x ≤ 1

0

caso contrário.

0

1

Z

x d F (x ) =

−∞

2.4.1

Z

2x

x × 0d x +

−∞

∞

Z

x × 2x d x +

0

1

2

x × 0d x = .

3

Propriedades da Esperança

1. Seja c ∈ R uma constante, então E (c ) = c ;

2. Seja h uma função uma função FX -mensurável, então para Y = h(X ) tem-se que

Z

∞

E (Y ) =

Z

∞

y d FY (y ) =

−∞

h(x )d FX (x ).

−∞

Assim, se X for uma variável aleatória discreta então,

X

E (Y ) =

h(x )P(x )

x ∈ΩX

e, se X for uma variável aleatória for absolutamnte contínua então,

Z∞

E (Y ) =

h(x )f (x )d x .

−∞

3. Sejam X 1 , . . . , X n n variáveis aleatória então

E

n

X

!

=

Xi

i =1

2.5

n

X

E (X i ).

i =1

Variância de uma variável aleatória

Definição 2.15. Seja X uma variável aleatória definida no espaço de probabilidade (Ω, F , P). Então

a variância da variável aleatória X , denotado por V a r (X ) ou σ2 é,

Z∞

2

V a r (X ) = E (X − E (X ))2 =

(x − µX )2 d F (x ) = E (X 2 ) − E (X ) .

−∞

Assim, se X é uma variável aleatória discreta, então

2

V a r (X ) =

X

(x − µX ) P(X = x ) =

2

x ∈ΩX

X

X

x P(X = x ) −

2

x ∈ΩX

x P(X = x )

x ∈ΩX

em que µX = E (X ). Se X é uma variável aleatória contínua, então

Z

∞

V a r (X ) =

Z

∞

(x − µX ) f (x )d x =

−∞

Z

x f (x )d x

2

−∞

2

∞

x f (x )d x −

2

.

−∞

Exemplo 2.10. Seja X uma variável aleatória com função de distribuição,

0

se x < 0

0, 5

se 0 ≤ x < 1

F (x ) =

0, 75 se 1 ≤ x < 2

1

se x ≥ 2.

então,

E (x ) =

2

X

x 2 [F (x ) − F (x − )] = 02 × [F (0) − F (0− )] + 12 × [F (1) − F (1− )] + 22 × [F (2) − F (2− )]

{x ∈{0,1,2}}

5

= 0 × 0, 5 + 1 × 0, 25 + 4 × 0, 25 = 1, 25 = .

4

logo,

2

5

3

11

V a r (X ) = −

= .

4

4

16

Considere agora que X tem função de distribuição dada por

0 se x < 0

F (x ) = x 2 se 0 ≤ x ≤ 1

1 sex ≥ 1

então,

(

0

F (x ) = f (x ) =

2x

se 0 ≤ x ≤ 1

0

caso contrário.

assim,

Z

∞

Z

E (X ) =

x × 0d x +

∞

Z

x × 2x d x +

2

−∞

assim,

1

Z

2

−∞

2.5.1

0

x d F (x ) =

2

2

0

1

1

x 4 = .

x × 0d x =

2 0 2

2

1

2

2

1

1

= .

V a r (X ) = −

2

3

18

Propriedades da Variância

1. V a r (c ) = 0, pois E ((c − E (c ))2 ) = 0;

2. V a r (X ± c ) = V a r (X ), pois

V a r (X + c ) = E (X + c − E (X + c ))2 = E (X + c − E (X ) − c )2

= E (X − E (X ))2 = V a r (X ).

3. V a r (c X ) = c 2 V a r (X ), pois

2

2

V a r (c X ) = E (c X )2 − E (c X ) = E c 2 X 2 − c E (X )

h

2

2 i

2

2

2

2

2

= c 2 V a r (X ).

= c E X − c E (X ) = c E X − E (X )

4. Sejam X 1 , . . . , X n n variáveis aleatória então,

!

n

n

n −1 X

n

X

X

X

Var

=

V a r (X i ) + 2

Cov (X j X i ).

i =1

i =1

j =1 i =j +1

em que,

Cov (X j , X i ) = E (X j − E (X j ))(X i − E (X i ))

Z ∞Z ∞

=

(x − µX j )(y − µX i )d F (x , y ) = E (X i X j ) − E (X i )E (X j ),

−∞

−∞

é a covariância entre as variáveis X i e X j , também denotada por σX ,Y , e F (x , y ) é a função

de distribuição conjunta de X i e X j . A covariância é uma medida de dependencia linear.

Entretanto, para que se possa fazer comparações é mais adequado padronizar esta medida,

assim

Cov (X j , X i )

ρX ,Y = p

V a r (X i )V a r (X j )

A medida resultante desta padronização é denominada coeficiente de correlação linear e

denotada por ρX ,Y ou ρ(X , Y ). Deste modo, pode-se provar que −1 ≤ ρX ,Y ≤ 1. Se X 1 , . . . , X n

forem independentes então, ρX ,Y = 0 logo Cov (X j , X i ) = 0, assim,

!

n

n

X

X

Var

=

V a r (X i ).

i =1

i =1

De fato, note que

n

X

(z 1 + . . . + z n )2 =

i =1

=

n

X

!

n

n

n

X

XX

zjzi

zj=

zi

j =1 i =1

j =1

z i2 + (z 1 z 2 + z 1 z 3 + · · · + z 1 z n ) + (z 2 z 1 + z 2 z 3 + · · · + z 2 z n )

i =1

+ (z 3 z 1 + z 3 z 2 + · · · + z 3 z n ) + · · · + (z n z 1 + z n z 2 + z n z 3 + · · · + z n z n −1 )

=

n

X

z i2 + 2

n−1 X

n

X

zjzi.

j =1 i =j +1

i =1

assim,

Var

n

X

!

Xi

=E

n

X

i =1

Xi

2

!

− E

i =1

n

X

i =1

!2

Xi

n −1 X

n

n

n

X

X

X

2

2

X j Xi −

E (X i )

=E

Xi + 2

j =1 i =j +1

i =1

=E

n

X

!

X i2

i =1

=

n

X

E (X i2 ) −

i =1

=

n −1 X

n

n

n −1 X

n

X

X

X

+ E 2

X j X i − [E (X i )]2 + 2

E (X j )E (X i )

j =1 i =j +1

n

X

[E (X i )]2 + 2

i =1

n

X

=

i =1

n−1 X

n

X

i =1

E (X j X i ) − 2

j =1 i =j +1

j =1 i =j +1

n−1 X

n

X

E (X j )E (X i )

j =1 i =j +1

n −1 X

n

X

E (X i2 ) − [E (X i )]2 + 2

E (X j X i ) − E (X j )E (X i )

i =1

n

X

i =1

j =1 i =j +1

V a r (X i ) + 2

n −1 X

n

X

j =1 i =j +1

Cov (X i , X j ).

Se X 1 , . . . , X n forem independentes então, FX i ,X j (x i , x j ) = FX i (x i )FX j (x j ) para todo i 6= j , assim

Z

∞

Z

∞

Z

∞

∞

Z

x i x j d FX i (x i )d FX j (x j )

x i x j d FX i ,X j (x i , x j ) =

E (X j X i ) =

−∞ −∞

Z

∞

Z

∞

−∞

x j d FX j (x j ) = E (X j )E (X i ).

x i d FX i (x i )

=

−∞

−∞

−∞

Logo,

Cov (X i , X j ) = E (X i X j ) − E (X i )E (X j ) = 0.

Observação 2.8. Note que se X e Y são variáveis aleatórias independentes então ρX ,Y = Cov (X , Y ) =

0, entretanto, ρX ,Y = Cov (X , Y ) = 0 não implica que X e Y são variáveis aleatórias independentes.

Um resultado interessante que relaciona a probabilidade de um evento com sua sua variância é

dada pela desigualdade de Chebyschev.

Teorema 2.1 (Desigualdade de Chebyschev). Seja X uma variável aleatória tal que a variância

exista. Então para qualquer constante c > 0, tem-se que

V a r (X )

.

P |X − µX | ≥ c ≤

c2

Demonstração. De fato,

Z

∞

V a r (X ) =

(x − µX )2 d F (x )

Z−∞

Z

=

(x − µX ) d F (x ) +

(x − µX )2 d F (x )

2

{x ∈R:|X −µX |<c }

{x ∈R:|X −µX |≥c }

Z

(x − µX )2 d F (x )

≥

{x ∈R:|X −µX |≥c }

Agora note que, como c > 0 tem-se que |X − µX | ≥ c implica que (X − µX )2 ≥ c 2 , assim

Z

V a r (X ) ≥

(x − µX )2 d F (x )

{x ∈R:|X −µX |≥c }

Z

c 2 d F (x )

≥

{x ∈R:|X −µX |≥c }

Z

= c2

d F (x ) = c 2 P |X − µX | ≥ c

{x ∈R:|X −µX |≥c }

2.6

Função Geradora de Momentos

Até o momento exploramos duas características importantes sobre variáveis aleatórias que foram o valor esperado e a variância. Nesta seção, vamos apresentar o conceito de momentos e

de função geradora de momentos(FGM). A função geradora de momentos é assim chamada pois

através da FGM pode-se determinar os momentos de uma variável aleatória. Outra característica