Questão 2(pás 56). Explique por que é importante que uma companhia aérea use um data

warehouse em tempo real.

Resposta: Dados disponibilizados em tempo real para os tomadores de decisão criaram

vantagens estratégicas sobre os concorrentes; Um data base warehouse em tempo real,

combinado a uma estratégia para seu uso no suporte a decisão, pode melhorar o uso dos

dados e oferecer benefícios financeiros gigantescos para uma organização.

As aplicações da Continental para o data warehouse em tempo real incluem:

*Gestão e contabilidade de receita

*Gerenciamento de Relacionamento com o cliente (CRM)

*Operações e folha de pagamento da equipe

*Segurança de Fraude

*Operações de vôo

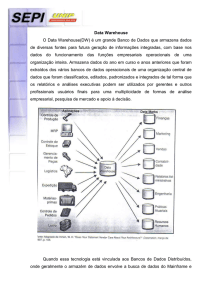

Questão 2.2-2(pag. 60). Como um data warehouse se diferencia de um banco de dados?

Resposta: Enquanto um banco de dados é constituído por um conjunto de informações,

registros dispostos em estrutura regular, normalmente agrupando registros que serão

utilizados para o mesmo fim; Já o data warehouse é um conjunto de dados produzido para

oferecer suporte à tomada de decisão, é também um repositório de dados atuais e históricos

de possível interesse aos gerentes de toda a organização. Os dados normalmente são

estruturados de modo a estarem disponíveis em um formato pronto para as atividades de

processamento analítico.

Questão 2.3-2(pag. 62). Descreva os principais componentes de um data warehouse.

Questão 2.4-2(pag. 70). Como a Web influenciou os projetos de data warehouse?

Resposta: Foi criado o Data warehouse baseado na Web, possuindo 3 camadas (PC cliente,

servidor de aplicação e servidor web). No lado do cliente, o usuário necessita de uma

conexão à internet e um navegador web (de preferência com suporte a java). A internet é o

meio de comunicação entre os clientes e os servidores. No lado do servidor, o servidor web é

utilizado para administrar os fluxos de entrada e saída de informações entre o cliente e o

servidor. Ele é auxiliado por um data warehouse e por um servidor de aplicação. O data

warehouse baseado na Web oferece algumas vantagens atraentes, que incluem facilidades de

acesso, independência de plataforma e custo baixo.

Questão 2.5-3(pag. 74). Por que o processo de ETL é tão importante para os

empreendimentos de data warehousing?

Resposta: Pois o processo de ETL está no coração da parte técnica do data warehouse. O

processo de ETL é um componente integral de qualquer projeto concentrado em dados. O

processo de ETL consiste em extração (leitura dos dados de um ou mais banco de dados),

transformação (Conversão dos dados extraídos de sua forma anterior na forma em que

precisam estar para que sejam colocados em um data warehouse ou um outro banco de dados)

e carga (Colocação dos dados no data warehouse). As ferramentas de ETL também

transportam dados entre fontes e alvos, documentam como os elementos de dados (p. ex.

metadados) mudam conforme se movimentam entre fonte e alvo, trocam metadados com

outras aplicações conforme necessário e administram todos os processos e operações de

tempo de execução (como programação, gerenciamento de erros, registros de auditorias,

estatísticas). A ETL é extremamente importante na integração dos dados e também no data

warehouse. O objetivo do ETL é carregar dados integrados e limpos no warehouse. Os dados

usados nestes processos podem ser oriundos de qualquer fonte: Aplicação de main frame,

aplicação ERP, ferramenta CRM, arquivo Excel.

Questão 3.2-1(pag. 109). Defina a BA e explique seu valor estratégico.

Resposta: BA (business analyse) é uma ampla categoria de aplicações e técnicas para reunir,

armazenar e fornecer acesso aos dados com o objetivo de ajudar os usuários da empresa a

tomarem melhor as decisões comerciais e estratégicas. A BA também é conhecida como

processamento analítico, ferramentas de BI, aplicações de BI ou simplesmente BI. Ela tem

um grande valor estratégico, pois a BI está se tornando uma ferramenta estratégica para a

maioria das empresas, médias e grandes. O processo de BI geralmente, mas não

necessariamente envolve o uso de um data warehouse, ou até mesmo a construção de um.

Uma aplicação analítica é um passo avante rumo a sofisticação, em comparação ao simples

oferecimento de técnicas ou ferramentas de análise. Ela permite atividades como:

*Automatização do pensamento e, na maioria dos casos, de uma parte da tomada de

decisão de um ser humano.

*Uso comum de técnicas quantitativas complexas, como análise de regressão

multivariada, data mining, inteligência artificial e programação não-linear.

A BA, em conjunto com um software, oferece ao usuário a possibilidade de fazer consultas,

requisitar relatórios ad hoc1ou realizar análises. É possível realizar análises executando

consultas em várias camadas. Todos os bancos de dados estão vinculados, e por isso você

1

Ferramentas OLAP relacionadas são usadas para permitir que os usuários avançados façam uma consulta no

banco de dados buscando qualquer resposta, executem com visões parciais em todo o banco e realizem drill

down até o nível mais detalhado de informações transacionais. Esta consulta investigativa é direcionada aos

exploradores de informações a aos usuários avançados.

consegue pesquisar quais produtos estão sobrando no estoque de uma determinada loja. Você

pode determinar quais desses produtos normalmente são vendidos como itens populares,

baseado em vendas anteriores. Após planejar uma promoção para unir o excesso de estoque

com os produtos populares (como em um pacote de produtos), é possível explorar os dados

mais a fundo para ver onde esta promoção seria mais popular (e mais rentável). Os resultados

de sua solicitação podem vir em forma de relatórios, previsões, alertas e/ou apresentações

gráficas, os quais são difundidos entre os tomadores de decisão.

Por ter uma função excepcional no auxílio à tomada de decisão, podemos verificar o porquê a

BA tem seu valor estratégico tão elevado.

Questão 3.3-1(pag. 113). Defina OLAP e compare ao OLTP.

Resposta: Durante muitos anos, a TI concentrou-se em construir sistemas essenciais que

permitissem principalmente o processamento de transações corporativas. Tais deveriam ser

praticamente tolerantes a falhas e oferecer execução eficiente e resposta rápida. O

processamento de transações online (OLTP) ofereceu uma solução eficaz, que gira em torno

de atividades repetitivas e de rotina, usando um ambiente de banco de dados relacional

distribuído. Tanto as aplicações de OLTP quanto de sistema de suporte a gerência (MSS)

constantemente necessitam de acesso ao banco de dados. Infelizmente, tentar servir os 2 tipos

de solicitação pode ser problemático. Por isso algumas empresas preferem separar o sistema

de informação em OLTP e OLAP.

O OLTP é voltado para o processamento de transações repetitivas em grandes quantidades e

manipulações simples. O OLAP envolve o exame de muitos itens de dados (constantemente

milhares ou até milhões) em relacionamentos complexos. Além de responder as consultas dos

usuários, o OLAP consegue analisar esses relacionamentos e buscar padrões, tendências e

exceções. Em outras palavras o OLAP é um método direto de suporte a decisão.

O OLAP se diferencia do OLTP (e do data mining) no sentido em que os usuários podem

fazer perguntas específicas e abertas. Os usuários, geralmente analistas, guiam o OLTP ao

passo que o data mining busca relações usando apenas alguma orientação do analista.

Questão 3.4-1(pag. 117). Defina relatório de rotina e relatório ad hoc.

Resposta: Os relatórios de rotina são gerados automaticamente e distribuídos periodicamente

aos assinantes em listas de discussão. Os relatórios podem ser gerados diretamente de dados

operacionais (p.ex. ERP, sistemas de pontos de venda [PDV]) e/ou um data warehouse.

Os relatórios ad hoc são criados para um usuário específico sempre que necessário. Esses

relatórios podem ser semelhantes aos de rotina, mas com intervalos de tempo diferentes ou

apenas para um subconjunto de dados. Um exemplo seria fornecer uma lista de todos os

clientes que adquiriam produtos de uma empresa por mais de US$5.000 por produto, durante

janeiro de 2006.

Questão 3.5-3(pag. 120). Defina cubo e cubo de dados.

Resposta: Cubo de dados: Um cubo de dados é usado para representar dados em conjunto

com alguma medida de interesse. Embora seja chamado de “cubo”, pode ser bidimensional,

tridimensional ou com uma dimensão superior. Cada dimensão representa algum atributo no

banco de dados, e as células no cubo de dados representam medidas de interesse. Cubos de

dados oferecem a oportunidade de obter informações para suporte á decisão de maneira

eficiente. A análise de cubo permite ás pessoas realizar consultas através da busca de uma

serie de visualizações de relatórios, usando recursos de softwares OLAP, como Page-by, pivot,

classificação, filtro e drill down/up, que permitem os usuários fazerem “visões parciais” de

um cubo de dados ou analisar um cubo usando o simples clique do mouse.

Cubo: Se refere a um conjunto de dados altamente correlacionados que são organizados para

permitir que os usuários combinem qualquer atributo em um cubo (p.ex. lojas, produtos,

clientes, fornecedores) com qualquer métrica no cubo (p.ex. vendas, lucro, unidades, época) a

fim de criar diversas visões bidimensionais, ou cubos, que podem ser exibidas em uma tela de

computador.

Questão 3.6-2(pag. 123). Liste algumas ferramentas de BA avançada.

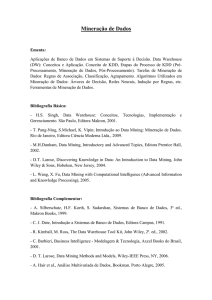

Questão 4.2-1(pag. 161). Defina data mining.

Resposta: Data mining é o termo usado para descrever a descoberta de informações em um

banco de dados. É um processo que usa técnicas estatísticas, matemáticas, de inteligência

artificial e de aprendizagem automática para extrair e identificar informações úteis e

conhecimento subseqüente de banco de dados. Antigamente, o termo era utilizado para

descrever o processo no qual padrões desconhecidos eram identificados nos dados. Entretanto

ao longo do tempo, a definição original foi modificada para incluir a maioria dos tipos de

análises (Automática) de dados. Data mining é o processo de descoberta de padrões

matemáticos em grandes conjuntos de dados, geralmente. Esses padrões podem ser regras,

semelhanças, correlações, tendências ou modelos preditivos.

Questão 4.2-4(pag. 161). Quais são as principais características do data mining?

Questão 4.3-1(pag. 173). Identifique pelo menos três dos principais métodos de data mining.

Resposta:

Métodos estatísticos: Eles incluem regressão linear e não-linear, estimativa de ponto,

teorema de Bayes (ou seja, distribuição de probabilidade), correlação e análise de

cluster.

Árvore de Decisão: As árvores de decisão são usadas em métodos de classificação e

agrupamento. Elas decompõem os problemas em subconjuntos progressivamente

discretos ao trabalhar de generalizações a informações cada vez mais específicas.

Uma árvore de decisão pode ser definida como uma raiz seguida de nós internos.

Cada nó, incluindo a raiz, é rotulado com uma questão. Os arcos associados a cada nó

abrangem todas as respostas possíveis. Cada resposta apresenta um resultado provável.

Raciocínio baseado em casos: Essa abordagem usa casos históricos para reconhecer

padrões.

Computação Neural: Redes neurais usam muitos nós relacionados (que funcionam de

maneira semelhante aos neurônios do cérebro humano). Essa abordagem examina

uma quantidade volumosa de dados históricos em busca de padrões. Assim, podemos

percorrer grandes bancos de dados, por exemplo, identificar possíveis clientes para

um produto novo ou empresas cujo perfil sugere que está indo a falência. Aplicações

neurais são comuns em serviços financeiros e fabricação.

Agentes inteligentes: Uma das abordagens mais promissoras para recuperar

informações de banco de dados, especialmente externos, é o uso de agentes

inteligentes. Com a disponibilidade de uma vasta e crescente quantidade de

informações pela internet, encontrar a informação certa está cada vez mais difícil.

Aplicações de data mining baseadas na Web normalmente são por agentes de software

inteligente.

Outras ferramentas: Muitas ferramentas podem ser usadas para data mining, incluindo

indução de regras e visualização de dados. A melhor fonte de informação sobre o

desenvolvimento de novas ferramentas é o site do fornecedor.

Questão 4.4-5(pag. 177). Identifique alguns dos mitos sobre data mining.

Questão 4.4-6(pag. 177). Quais são alguns dos erros comuns cometidos nos projetos de data

mining?