Tipos de Dependência entre Variáveis Aleatórias e Teoria

de Cópulas

Autor: Márcio Luis Lanfredi Viola

Supervisora: Profa. Dra. Verónica Andrea González-López

Instituto de Matemática, Estatística e Computação Científica (IMECC-UNICAMP)

Dezembro/2009

Sumário

1 Tipos de Dependência entre Variáveis Aleatórias

1

1.1

Introdução . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.2

Funções Totalmente Positivas e Totalmente Negativas . . . . . . . . . . . . .

2

1.3

Dependência do Quadrante Positivo (e Negativo) e do Octante . . . . . . .

9

1.3.1

Variáveis Aleatórias Estocasticamente Crescentes e Decrescentes,

Dependência Crescente na Cauda à Direita e Dependência Decrescente na Cauda à Esquerda

. . . . . . . . . . . . . . . . . . . . . . . . .

12

1.4

Variáveis Aleatórias Negativamente Associadas . . . . . . . . . . . . . . . . .

17

1.5

Implicações e Contra-exemplos envolvendo os Conceitos de Dependência .

19

1.6

Tabelas referentes ao Capítulo . . . . . . . . . . . . . . . . . . . . . . . . . . . .

23

2 Teoria de Cópulas

27

2.1

Introdução . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

2.2

Cópula e Teorema de Sklar . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

2.3

Cópulas Arquimedianas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

39

2.4

Cópulas Multivariadas e a Transformada de Laplace . . . . . . . . . . . . . .

45

3 Variável BIPIT

55

3.1

Variáveis PIT e BIPIT . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

3.2

Propriedades da função K . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

62

4 Tau de Kendall

4.1

67

Concordância . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

i

67

5 Kendall Plot

79

5.1

Introdução . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

79

5.2

Construção do Kendall Plot . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

80

5.2.1

QQplot . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

80

5.2.2

Kendall Plot . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

81

Resultados e Fundamentos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

84

5.3

Referências Bibliográficas

94

ii

Lista de Figuras

2.1

Scatterplots: Dados exponenciais independentes (primeira figura); dados exponenciais

independentes transformados pelas acumuladas (segunda figura). . . . . . . . . . . .

30

2.2

Gerador φ não estrito e pseudo-inversa φ[−1] para a cópula Arquimediana W . . . . .

44

2.3

Gerador φ estrito e pseudo-inversa φ[−1] para a cópula Arquimediana Π. . . . . . . .

45

3.1

QQplot entre a amostra Hi = H(xi , yi ) da BIPIT H associada distribuição normal

bivariada do Exemplo 3.1 e uma amostra {U1 , . . . , U100 } com distribuição U (0, 1). . .

3.2

56

QQplot das amostras das BIPITS H e H1 : {H1 , . . . , Hn } e {H11 , . . . , H1n } respectivamente, n = 100, onde Hi = H(ui , vi ) = ui vi sendo ui , vi amostras de U (0, 1)

e H1i = H(x1i , y1i ) = F1 (x1i )G1 (y1i ) sendo x1i com distribuição exp(2) e y1i com

distribuição exp(10). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.3

57

Funções distribuição de Kendall das cópulas M (linha cheia preta), W (linha cheia

cinza) e família de Gumbel para θ = {1, 3, 7} (primeira figura); família de Clayton

para θ = {1, 3, 4} (segunda figura). . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.4

64

Funções λ(v), v ∈ I, das cópulas M (linha cheia preta), W (linha cheia cinza)

e família de Gumbel para θ = {1, 3, 7} (primeira figura); família de Clayton para

θ = {1, 3, 4}. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1

65

QQplots referentes Exemplo 4.5: H0i = Π(ui , vi ), H1i = C−0.5 (ui , vi ), H2i = C2 (ui , vi )

com Cθ cópula de Clayton com parâmetro θ (A linha com ponto e tracejado é a diagonal principal do gráfico). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

iii

77

5.1

b (dnpe) ≡ K −1 (p) proveniente

Gráficos da inversa da função distribuição K −1 (p) vs. H

n

de n = 100 pseudo-observações da cópula 4.2.12 (primeira figura); e Wdnpe:n,K =

E(H(dnpe) ), n = 100, sob hipótese da mesma cópula (segunda figura). . . . . . . . . .

5.2

88

Kendall Plot sob hipótese nula de independência para a amostra {(x1 , y1 ), . . . , (x100 , y100 )}

sendo xi com distribuição exp(2) e yi com distribuição exp(10) com {xi } gerados de

forma independente de {yi }. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.3

Kendall Plot sob hipótese nula de independência de n = 100 pares de observações do

vetor aleatório (X, Y ) com Y = 1 − X. . . . . . . . . . . . . . . . . . . . . . . . . . .

5.4

90

Kendall Plot sob hipótese nula de independência, de n = 100 pares de observações

do vetor aleatório (X, Y ) com Y = X. . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5

89

91

Kendall Plot sob hipótese nula de cópula de Clayton θ = 2 (Wi:n,K0 referente a

Clayton com θ = 2) de amostras aleatórias de tamanho n = 100 associadas a cópula

de Clayton com os respectivos parâmetros θ = {0.5, 2, 5}. . . . . . . . . . . . . . . . .

iv

92

Lista de Tabelas

6.1

Função de probabilidade conjunta de (X1 , X2 , X3 , X4 ) . . . . . . . . . . . . . . . . .

24

6.2

Função de probabilidade conjunta de X e Y . . . . . . . . . . . . . . . . . . . . . . .

24

6.3

Função de probabilidade conjunta de X e Y . . . . . . . . . . . . . . . . . . . . . . .

24

6.4

Função de probabilidade conjunta de X e Y . . . . . . . . . . . . . . . . . . . . . . .

24

6.5

Função de probabilidade conjunta de (Y1 , Y2 ) . . . . . . . . . . . . . . . . . . . . . .

25

3.1

Algumas famílias paramétricas de cópulas Arquimedianas com seus geradores e espaços paramétricos (*na cópula de Clayton o gerador é estrito se θ ≥ 0, caso contrário

é não estrito). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1

Cópulas Arquimedianas da Tabela 3.1 com os respectivos geradores φ e funções distriuição K. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1

44

62

Medida de associação τ de Kendall expressa em função do parâmetro θ para algumas

famílias de cópulas Arquimedianas. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

70

2

Capítulo 1

Tipos de Dependência entre Variáveis

Aleatórias

1.1

Introdução

Os conceitos e análise de dependência são necessários para o entendimento do modelo a ser

considerado e quando este pode ser aplicado. Isto inclui a análise da estrutura de dependência

conveniente ao modelo e se a dependência do modelo aumenta quando os parâmetros multivariados

aumentam, isto é, um modelo multivariado pode ser analisado a partir das estruturas de dependência

que ele consiga cobrir em relação ao universo das estruturas de dependência possíveis. Assim,

as propriedades de dependência são importantes para a avaliação da adequação de um modelo

particular perante uma dada aplicação ou um conjunto de dados. No entanto, na prática, pode ser

difícil a comprovação das propriedades teóricas assumidas pelos modelos.

O estudo dos vários tipos de dependência é importante pois um dado modelo de cópula pode ser

mais adequado para um tipo de dependência pretendido do que para outro. Por exemplo, há modelos

de cópula que modelam dependências positivas (limitante superior de Fréchet [25]) enquanto que

há modelos de cópula que modelam dependências negativas (limitante inferior de Fréchet [25]).

Há várias formas para definir dependências sendo que há conceitos que podem ser considerados

mais fortes como, por exemplo, dependência M T P2 ou M RR2 , e outros que podem ser considerados

1

2

mais fracos como, por exemplo, dependência PQD ou NQD.

1.2

Funções Totalmente Positivas e Totalmente Negativas

As definições dadas a seguir referem-se à funções gerais sendo que a função densidade ou a função

de probabilidade são casos particulares. Nesta seção, por simplicidade, serão dadas as definições e

propriedades utilizando-se funções contínuas. O caso discreto é análogo.

Definição 1.1. Seja uma função f (x) uma função não-negativa definida em χ = χ1 × χ2 × ... × χn

onde cada χi é totalmente ordenado, satisfazendo

f (x ∨ y)f (x ∧ y) ≥ f (x)f (y)

(2.1)

onde ∨ e ∧ são operações definidas como sendo

x ∨ y = (max(x1 , y1 ), ...., max(xn , yn ))

e

x ∧ y = (min(x1 , y1 ), ...., min(xn , yn ));

∀x, y onde x = (x1 , ..., xn ) e y = (y1 , ..., yn ). A função densidade que satisfizer (2.1) será denominada função multivariada totalmente positiva de ordem 2 (“multivariate totally positive of order 2”)

denotada por M T P2 . Um vetor aleatório X = (X1 , ..., Xn ) de n componentes será chamado M T P2

se sua função densidade for M T P2 [27].

A função f (x) que satisfizer a desigualdade (2.1) considerando-se ≤ no lugar de ≥ será chamada

função multivariada totalmente negativa de ordem 2 (“multivariate reverse rule of order 2”) denotada

por M RR2 [28].

Para a análise das definições acima será considerado o caso n = 2. Para este caso, será dada

uma interpretação para cada um dos conceitos citados.

Definição 1.2. Seja uma função f (x, y) não-negativa de duas variáveis definidas em χ = χ1 × χ2

sendo χ1 e χ2 totalmente ordenados. A função será totalmente positiva de ordem r, denotada por

T Pr , se para todo x1 < ... < xm , y1 < .... < ym , xi ∈ χ1 , yi ∈ χ2 , 1 ≤ m ≤ r, o determinante da

matriz quadrada de ordem r, |f (xi , yi )|i,j=1,...,m , 1 ≤ m ≤ r, é definido como sendo [26]

3

|f (xi , yi )|i,j=1,2,...,m

f (x , y ) f (x , y ) ... f (x , y )

1 1

1 2

1 m

f (x2 , y1 ) f (x2 , y2 ) ... f (x2 , ym )

.

.

.

= .

.

.

.

.

.

f (xm , y1 ) f (xm , y2 ) ... f (xm , ym )

(2.2)

for não-negativo.

Quando r = 2, a partir da condição de que o determinante (2.2) seja não-negativo, obtém-se

f (x1 , x2 )f (y1 , y2 ) − f (x1 , y2 )f (y1 , x2 ) ≥ 0 para toda escolha x1 < x2 , y1 < y2 , xi ∈ χ1 , yi ∈ χ2 ,

i = 1, 2. Neste caso, a função f (x, y) será totalmente positiva de ordem 2 (“totally positive of order

2”) [27]. Este conceito foi generalizado por meio da Definição 1.1.

Uma função f (x, y), não-negativa, de duas variáveis reais, definidas em χ1 × χ2 sendo χ1 e χ2

totalmente ordenados será totalmente negativa de ordem 2 (“reverse rule of order 2”), denotado por

RR2 se f (x1 , x2 )f (y1 , y2 ) − f (x1 , y2 )f (y1 , x2 ) ≤ 0 para toda escolha x1 < x2 e y1 < y2 , xi ∈ χ1 ,

yi ∈ χ2 , i = 1, 2 [28].

Quando a função f for uma função densidade, o seu domínio será real, ou seja, χi = R,

i = 1, ...., n.

A condição de dependência positiva f (x1 , x2 )f (y1 , y2 ) ≥ f (x1 , y2 )f (y1 , x2 ) significa que é mais

provável que ocorram dois pares com componentes assumindo valores grande-grande ou pequenopequeno do que dois pares com componentes assumindo valores grande-pequeno ou pequeno-grande.

Os conceitos T P2 e RR2 podem ser estendidos. Considere µ uma medida de probabilidade nos

conjuntos de Borel em Rn . Se I1 , ..., In forem intervalos em R, define-se µ

e(I1 , ..., In ) = µ(I1 ×...×In ).

Se I e J forem intervalos em R, I < J se x ∈ I, y ∈ J implicar em x < y . Define-se [2, 23]:

Definição 1.3. Seja µ

e uma medida de probabilidade em R2 . Esta medida será RR2 se

0

0

0

0

0

0

µ

e(I1 , I2 )e

µ(I1 , I2 ) ≤ µ

e(I1 , I2 )e

µ(I1 , I2 ) para todos os intervalos I1 < I1 , I2 < I2 em R.

Definição 1.4. Seja µ

e uma medida de probabilidade em Rn , n ≥ 2. Esta medida será RR2 aos

pares se µ

e(I1 , ..., In ) for RR2 nos pares Ii , Ij para todo 1 ≤ i < j ≤ n sendo que as demais variáveis

(intervalos) são mantidas fixas. As v.a. X1 , ..., Xn (ou o vetor aleatório X ou sua f.d.a F) serão

RR2 aos pares se sua correspondente medida de probabilidade em Rn for RR2 aos pares.

4

A seguir, serão apresentadas algumas propriedades referentes ao conceito M T P2 . A demonstração das propriedades podem ser encontradas em [27]. As propriedades 1 à 4 são úteis para a

obtenção de funções densidade M T P2 a partir de outras funções densidade M T P2 e as propriedades

5 à 7 são úteis para a obtenção de funções densidade M T P2 a partir de funções densidade P F2 e/ou

T P2 .

1. Seja f uma função densidade M T P2 em χ. Então a função densidade marginal, ϕ, em

Qk

i=1 χi

dada por

Z

Z

ϕ(x1 , ..., xk ) =

....

χn

f (x1 , ..., xk , xk+1 , ..., xn )dxk+1 ...dxn

χk+1

é M T P2 ;

2. Se f e g forem funções densidade M T P2 . Então, a função f g será M T P2 ;

3. Sejam χ =

Qn

i=1 χi ,

ξ=

Qn

i=1 ξi ,

ζ=

Qn

i=1 ζi

onde χi , ξi e ζi são espaços totalmente ordenados.

Sejam f e g funções densidade M T P2 , respectivamente, em ξ × χ e χ × ζ. Define-se,

R

h(y, z) = χ f (y, x)g(x, z)dσ(x), σ = σ1 × ... × σn . Então, h é uma função M T P2 em ξ × ζ;

4. Se f (x) for M T P2 , x ∈ χ, ϕ1 , ..., ϕn forem todas funções crescentes (ou todas funções decrescentes), respectivamente, em χ1 , ..., χn e {φk (xk )}nk=1 forem funções positivas. Então, a

Q

função ψ(x) = ψ(x1 , ..., xn ) = ( ni=1 φi (xk ))f (ϕ1 (x1 ), ..., ϕn (xn )) será M T P2 em χ;

5. Seja X = (X1 , ..., Xn ) um vetor aleatório composto por variáveis aleatórias X1 , ..., Xn independentes onde cada Xi , i = 1, ..., n, possui função densidade, fXi , P F2 1 . Seja Y = (Y1 , ..., Yn )

um vetor aleatório com função densidade conjunta, fY , M T P2 em Rn e suponha que X e Y

são independentes. Então, Z = X + Y possui uma função densidade M T P2 ;

6. Seja X = (X1 , ..., Xn ) um vetor aleatório composto por variáveis aleatórias X1 , ..., Xn independentes onde cada Xi , i = 1, ..., n, possui função densidade, fXi , P F2 e seja Xo uma v.a.

independente de X possuindo função densidade fXo . Define-se Zi = Xi + Xo , i = 1, ..., n.

Então, a função densidade conjunta de Z = (Z1 , ..., Zn ) é M T P2 ;

1

Uma função f (x) definida em (−∞, ∞) é P Fr (“Pólya frequency function of order r) se f (x − y) for T Pr ,

−∞ < x, y < ∞ [26].

5

7. Seja X = (X1 , ..., Xn ) um vetor aleatório composto por variáveis aleatórias X1 , ..., Xn independentes onde cada Xi , i = 1, ..., n possui função densidade, fXi . Seja Xo uma variável aleatória

positiva. Se, para i = 1, ..., n, fXi (u/v) for T P2 em −∞ < u < ∞ e v > 0, ou fXi (uv) for

T P2 em −∞ < u < ∞ e v > 0, então ambos os vetores aleatórios Z = (X1 Xo , ..., Xn Xo ) e

W = (X1 /Xo , ..., Xn /Xo ) terão funções densidade M T P2 ;

8. Seja X = (X1 , ..., Xn ) um vetor aleatório possuindo densidade conjunta M T P2 . Sejam ψ e ϕ,

ambas funções crescentes (ou ambas funções decrescentes), em Rn . Então,

E[ϕ(X)ψ(X)] ≥ (E[ϕ(X)])(E[ψ(X)]).

Vale observar que, utilizando-se as propriedades 1 e 2, obtém-se a propriedade 3 e que da

propriedade 2, obtém-se: Variáveis aleatórias independentes possuem função densidade conjunta

M T P2 .

Da propriedade 1 obtém-se: Se X = (X1 , ..., Xn ) for M T P2 então qualquer subconjunto formado

pelas componentes de X, por exemplo, (Xi , ..., Xk ) será M T P2 onde 2 ≤ i, k < n

E, da propriedade 8, obtém-se que

Cov(ϕ(X), ψ(X)) ≥ 0

(2.3)

a qual sugere a seguinte definição [11, 27]:

Definição 1.5. Seja X = (X1 , ..., Xn ) um vetor aleatório satisfazendo a expressão (2.3) para qualquer par de funções crescentes (ou decrescentes) ψ e ϕ. As componentes de X, X1 , ..., Xn , são

denominadas variáveis aleatórias associadas.

Utilizando-se a definição anterior, obtém-se o seguinte resultado:

Teorema 1.1. Seja X = (X1 , ..., Xn ) um vetor aleatório formado por v.a. associadas e sejam

ϕ1 , ..., ϕk funções não-negativas em Rn sendo todas crescentes (ou todas decrescentes). Então,

" k

#

k

Y

Y

E

ϕi (X) ≥

E [ϕi (X)]

(2.4)

i=1

i=1

6

Demonstração: Para a demonstração consulte [27].

Em particular, se ϕi (X) = ϕi (Xi ), i = 1, ..., n, a expressão (2.4) do teorema anterior fornece

E[ϕ1 (X1 )...ϕn (Xn )] ≥

n

Y

E[ϕi (Xi )]

(2.5)

i=1

Especialmente, a expressão (2.5) permite demonstrar

Q

Q

P (X1 ≥ c1 , ..., Xn ≥ cn ) ≥ ni=1 P (Xi ≥ ci ) e P (X1 ≤ c1 , ..., Xn ≤ cn ) ≥ ni=1 P (Xi ≤ ci ). Na

próxima seção, tais desigualdades designarão outros tipos de dependência.

Vale observar que a partir do conceito de dependência M T P2 obteve-se o conceito de variáveis

aleatórias associadas. Com isso, o conceito de dependência M T P2 é mais forte do que o conceito

de variáveis aleatórias associadas no sentido de que o primeiro implica no segundo.

A seguir, serão apresentadas algumas propriedades referentes à v.a. associadas [11].

1. Um subconjunto de v.a. associadas é associado;

2. Se dois conjuntos de v.a. associadas forem independentes, então a união será um conjunto de

v.a. associadas;

3. Funções não-decrescentes de v.a. associadas são associadas;

4. Um conjunto formado por uma única v.a. é associado;

5. Variáveis aleatórias independentes são associadas;

(k)

(k)

(k)

6. Se T(k) = (T1 , ..., Tn ) for um vetor aleatório com Ti , i = 1, ..., n, associadas para cada k

e T(k) → T, em distribuição, então as componentes do vetor aleatório T = (T1 , ..., Tn ) serão

associadas.

Serão apresentados, a seguir, alguns exemplos de funções densidade M T P2 [27].

• Exemplo 1: Seja X = (X1 , ..., Xn ) uma amostra aletória formada por variáveis aleatórias i.i.d.

Xi , possuindo função densidade f . Então, a densidade conjunta das estatísticas de ordem

X1,n , ..., Xn,n é M T P2 ;

7

P

• Exemplo 2: Considere que X = (X1 , ..., Xn ) ∼ N (0, ). Esta distribuição será M T P2 se e

P

somente se − −1 possuir elementos fora da diagonal não-negativos;

• Exemplo 3: A função densidade da Distribuição Logística Multivariada é definida como sendo

(

f (x1 , ..., xn ) = n!exp −

n

X

)(

1+

xi

i=1

n

X

)−(m+1)

−xi

e

i=1

O Núcleo Generalizado de Cauchy é dado por

k(y) =

(1 +

1

Pn

α

i=1 yi )

onde yi > 0, i = 1, ..., n. Este núcleo é T P2 em cada par de variáveis. Com isso, a Distribuição

Logística Multivariada é M T P2 pelas propriedades 2 e 4 referentes à função densidade M T P2 ;

• Exemplo 4: Seja X1 , ..., Xn v.a. independentes com Xi ∼ Gama(αi , βi ), αi ≥ 1, βi > 0,

i = 1, ..., n. A função densidade fXi (x) = ci xαi −1 e−βi x , x > 0 é P F2 . Se Xo for independente de X1 , ..., Xn , Xo ∼ Gama(αo , βo ), então o vetor Z = (X1 + Xo , ...., Xn + Xo ) possui

Distribuição Gamma Multivariada e, pela propriedade 6 referente à função densidade M T P2 ,

tem-se que a sua densidade conjunta será M T P2 ;

• Exemplo 5: Seja X1 , ..., Xn v.a. independentes com Xi ∼ Gama(αi , βi ), αi > 0, βi > 0,

i = 1, ..., n. A função densidade fXi (u/v) = ci (u/v)αi −1 e−βi (u/v) , é T P2 para u e v positivos.

Se Xo for independente de X1 , ..., Xn e Xi ∼ χ2νi , então o vetor

Z = ((X1 /ν1 )(Xo /νo )−1 , ...., (Xn /νn )(Xo /νo )−1 ) possuirá Distribuição F Multivariada e, pela

propriedade 7 referente à função densidade M T P2 , tem-se que a sua densidade conjunta será

M T P2 ;

• Exemplo 6: Seja X = (X1 , ..., Xn ) ∼ N (0, I) e S ∼ χ2 , X e S independentes.

Seja

Z = (Z1 , ..., Zn ) = (X1 /S, ..., Xn /S). O vetor aleatório Z possui Distribuição de Cauchy

multivariada. Então, (|Z1 |, ..., |Zn |) possui densidade conjunta M T P2 considerando o mesmo

argumento do exemplo prévio desde que e−u

2 /v 2

é T P2 com u > 0, v > 0.

A seguir, serão apresentadas algumas propriedades referentes às funções M RR2 [28].

8

1. Se f e g forem funções M RR2 . Então, a função f g será M RR2 ;

2. Se f (x) for M RR2 com x ∈ χ e ϕ1 , ..., ϕn forem todas funções crescentes (ou todas funções decrescentes), respectivamente, em χ1 , ..., χn . Então, a função ψ(x) = ψ(x1 , ..., xn )=f (ϕ1 (x1 ), ...ϕn (xn ))

será M RR2 em χ;

A seguir, serão apresentados alguns exemplos de distribuições M RR2 [28].

• Exemplo 1: Seja X = (X1 , ..., Xn ) um vetor aleatório composto por v.a. independentes tais

P

P

que Xi ∼ Binomial(ni , pi ), ni=1 pi = 1, ni=1 Xi = N . A distribuição de X é dada por

n

Y x

N!

Pn

PX (x) = Qn

pi i

x

!

(N

−

x

)!

i

i

i=1

i=1

1−

n

X

i=1

!N −Pni=1 xi

pi

(2.6)

i=1

onde x = (x1 , ..., xn ) representa um dado valor que o vetor aleatório X assume e pi ≥ 0,

i = 1, ..., n. Esta distribuição é denominada Distribuição Multinomial e, pode-se mostrar, que

esta é M RR2 ;

• Exemplo 2: Seja X = (X1 , ..., Xn ) um vetor aleatório. A função de probabilidade da Distribuição Hipergeométrica Multivariada é dada por

"

PX (x) =

com

Pn

i=1 xi

Qn

i=1

Mi

!#

xi

= m, 0 ≤ xi ≤ Mi , i = 1, ..., n e

M−

m−

Pn

Pn

i=1 Mi

Pn

i=1 xi

i=1 Mi

!

M

!−1

(2.7)

m

= M onde x = (x1 , ..., xn ) representa

um dado valor que o vetor aleatório X assume. Esta distribuição é M RR2 ;

• Exemplo 3: Seja X = (X1 , ..., Xn ) um vetor aleatório. A função densidade da Distribuição de

Dirichlet é dada por

θ0 −1

P

n

n

X

Y

Γ( nj=0 θj )

θ −1

1 −

f (x) = Qn

xj

xj j

Γ(θ

)

j

j=0

j=1

onde

Pn

j=1 xj

(2.8)

j=1

≤ 1, 0 ≤ xj e θj ≥ 1, j = 0, .., n sendo Γ(.) a Função Gama. A Distribuição de

Dirichlet é M RR2 .

9

1.3

Dependência do Quadrante Positivo (e Negativo) e do Octante

Considere X um vetor aleatório de dimensão n (n ≥ 2) com f.d.a. F . Define-se a dependência do

octante superior positivo (“positive upper orthant dependent”) e a dependência do octante inferior

positivo (“positive lower orthant dependent”) [25] como sendo:

Definição 1.6. X = (X1 , ..., Xn ) ou F possuem dependência do octante superior positivo (PUOD)

Q

se P (Xi > ai , i = 1, ..., n) ≥ ni=1 P (Xi > ai ), ∀a = (a1 , ..., an ) ∈ Rn .

Definição 1.7. X = (X1 , ..., Xn ) ou F possuem dependência do octante inferior positivo (PLOD)

Q

se P (Xi ≤ ai , i = 1, ..., n) ≥ ni=1 P (Xi ≤ ai ), ∀a = (a1 , ..., an ) ∈ Rn .

Se X verifica as Definições 1.6 e 1.7 então X ou F possuem dependência do octante positivo(“positive orthant dependent”) denotada por POD.

Intuitivamente, a expressão da Definição 1.6 significa que é mais provável que X1 , ..., Xn assumam, simultaneamente, valores grandes comparado com o vetor de v.a. independentes com as

mesmas correspondentes distribuições marginais univariadas.

Similarmente, serão enunciados os conceitos de dependência do octante inferior negativo (“negative lower orthant dependent”), dependência do octante superior negativo (“negative upper orthant

dependent”) e dependência do octante negativo (“negative orthant dependent”) [25].

Definição 1.8. X = (X1 , ..., Xn ) ou F possuem dependência do octante superior negativo (NUOD)

Q

se P (Xi > ai , i = 1, ..., n) ≤ ni=1 P (Xi > ai ), ∀a = (a1 , ..., an ) ∈ Rn .

Definição 1.9. X = (X1 , ..., Xn ) ou F possuem dependência do octante inferior negativo (NLOD)

Q

se P (Xi ≤ ai , i = 1, ..., n) ≤ ni=1 P (Xi ≤ ai ), ∀a = (a1 , ..., an ) ∈ Rn .

Se X verifica as Definições 1.8 e 1.9 então X ou F possuem dependência do octante negativo

(NOD).

As expressões que compõem as definições 1.6 e 1.7, em geral, para n ≥ 3, não se equivalem (veja

um contra-exemplo na seção 3.2.5). Porém, para n = 2, elas se equivalem. Isto, também, vale para

as definições 1.8 e 1.9. Com isso, definições acima se reduzem, para n = 2, às seguintes:

Seja X = (X1 , X2 ) um vetor aleatório bivariado com f.d.a. F . Então, define-se a dependência

do quadrante positivo (“positive quadrant dependent”) [30, 25] como sendo:

10

Definição 1.10. X ou F possuem dependência do quadrante positivo (PQD) se

P (X1 > a1 , X2 > a2 ) ≥ P (X1 > a1 )P (X2 > a2 ), ∀a1 , a2 ∈ R, ou equivalentemente,

P (X1 ≤ a1 , X2 ≤ a2 ) ≥ P(X1 ≤ a1 ) P(X2 ≤ a2 ), ∀a1 , a2 ∈ R.

A expressão da definição 1.10 representa uma condição de dependência positiva e significa que é

mais provável que X1 e X2 assumam, conjuntamente, valores grandes ou pequenos comparado com

0

d

0

0

d

0

0

0

X1 e X2 onde X1 = X1 e X2 = X2 sendo X1 e X2 ) v.a. independentes.

Similarmente, será apresentada a dependência do quadrante negativo(“negative quadrant dependent”)

[30, 25] definido a seguir.

Definição 1.11. X ou F possuem dependência do quadrante negativo (NQD) se

P (X1 > a1 , X2 > a2 ) ≤ P (X1 > a1 )P (X2 > a2 ), ∀a1 , a2 ∈ R, ou equivalentemente,

P (X1 ≤ a1 , X2 ≤ a2 ) ≤ P(X1 ≤ a1 ) P(X2 ≤ a2 ), ∀a1 , a2 ∈ R.

A seguir, serão apresentadas algumas propriedades referentes ao conceito de dependência PQD

e NQD [30].

1. O vetor de v.a. (X, X) será PQD para todo X;

2. Se o vetor de v.a. (X, Y ) for PQD, então o vetor (X, −Y ) será NQD;

3. Se o vetor de v.a. (X, Y ) for PQD então o vetor (r(X), s(Y )) será PQD se r e s forem funções

não-decrescentes;

4. Sejam (X1 , Y1 ), ..., (Xn , Yn ) pares independentes de v.a. com funções de distribuição F1 , ...., Fn .

Sejam r e s funções de n variáveis e sejam X = r(X1 , ..., Xn ) e Y = s(Y1 , ..., Yn ). Então:

(a) (X, Y ) será PQD se, para cada i, as seguintes condições forem válidas:

2

i. Fi é PQD e r, s são concordantes

2

para a i-ésima coordenada ou;

ii. Fi é NQD e r, s são discordantes

3

para a i-ésima coordenada.

Duas funções reais r e s de n variáveis independentes serão concordantes para a i-ésima coordenada se,

considerando-as funções da i-ésima coordenada, deixando as demais fixas, ambas são funções não-decrescentes ou

ambas são funções não-crescentes.

3

Duas funções reais r e s de n variáveis independentes serão concordantes para a i-ésima coordenada se,

considerando-as funções da i-ésima coordenada, deixando as demais fixas, uma das funções é não-decrescente e a

outra é não-crescente.

11

(b) (X, Y ) será NQD se, para cada i, as seguintes condições forem válidas:

i. Fi é PQD e r, s são discordantes para a i-ésima coordenada ou;

ii. Fi é NQD e r, s são concordantes para a i-ésima coordenada.

5. Sejam (X1 , Y1 ), ..., (Xn , Yn ) pares independentes de v.a. com funções de distribuição F1 , ...., Fn .

Sejam U e V v.a. independentes e independentes de (X1 , Y1 ), ..., (Xn , Yn ) e sejam

X = r(U, X1 , ..., Xn ) e Y = s(V, X1 , ..., Xn ). Então, as conclusões dos ítens (a) e (b) na

propriedade 4. continuam válidas.

6. Se (X, Y ) for PQD e se existirem E(XY ), E(X) e E(Y ), então E(XY ) ≥ E(X)E(Y ).

A seguir, serão apresentados alguns exemplos de v.a. PQD [30]. As justificativas dos exemplos

baseiam-se nas propriedades anteriores.

• Exemplo 1: Para qualquer v.a. X e para qualquer função não-decrescente s, o vetor (X, s(X))

será PQD;

• Exemplo 2: (X = U + aZ, Y = V + bZ) será PQD se as constantes a e b tiverem o mesmo

sinal para quaisquer v.a. independentes U , V e Z;

• Exemplo 3: Para quaisquer v.a. independentes X e V , (X, Y = X + V ) será PQD;

• Exemplo 4: (X = r(U, Z), Y = s(V, Z)) será PQD se U , V e Z forem v.a. independentes e r

e s forem funções não-decrescentes em Z (arbitrárias para as demais v.a.).

Agora, serão apresentadas algumas propriedades relativas ao conceito NOD [8]:

1. Qualquer conjunto de v.a. independentes será NOD;

2. Qualquer subconjunto de tamanho ≥ 2 formado por v.a. NOD será NOD;

3. Se X1 , ..., Xn forem v.a. NOD e ϕ1 , ..., ϕn forem funções Borel-mensuráveis crescentes com

valores reais. Então, ϕ1 (X1 ), ..., ϕn (Xn ) serão v.a. NOD;

4. A união de conjuntos independentes de v.a. NOD será NOD.

12

Também, serão apresentados alguns exemplos de distribuições NOD [23].

• Exemplo 1: A Distribuição Multinomial dada por (2.6) é NOD;

• Exemplo 2: A Distribuição Hipergeométrica Multivariada dada por (2.7) é NOD;

• Exemplo 3: A Distribuição de Dirichlet dada por (2.8) é NOD.

1.3.1

Variáveis Aleatórias Estocasticamente Crescentes e Decrescentes,

Dependência Crescente na Cauda à Direita e Dependência Decrescente

na Cauda à Esquerda

Denotando-se =(F1 , ..., Fn ) como a classe das distribuições multivariadas que possuem funções

de distribuição marginais F1 , ..., Fn , considere X = (X1 , X2 ) um vetor aleatório bivariado possuindo

f.d.a F ∈ =(F1 , F2 ). Define-se:

Definição 1.12. A variável aleatória X2 será estocasticamente crescente (“stochastically increasing”),

denotada por SI, em X1 ou a distribuição condicional F2|1 será estocasticamente crescente (↑) se

P (X2 > x2 |X1 = x1 ) = 1 − F2|1 (x2 |x1 ) ↑ x1 , ∀x2 [25].

Se, na Definição 1.12, trocarmos os índices 1 por 2 e 2 por 1, ter-se-á que X1 será SI em X2 ou

F1|2 será SI.

A expressão da definição 1.12 representa uma condição de dependência positiva e significa que

a probabilidade de que X2 ultrapasse um limiar x2 é crescente quando X1 aumentar.

Se, na Definição 1.12, trocarmos ↑ por ↓, a variável aleatória X2 será estocasticamente decrescentes (“stochastically decreasing”), denotada por SD, em X1 [25].

Há dois conceitos de dependência que podem ser considerados como uma extensão multivariada

do conceito SI (Definição 1.12): dependência positiva através da ordenação estocástica (“positive dependence through the stochastic ordering”) e dependência condicionalmente crescente em sequência

(“conditional increasing in sequence”)[8].

Definição 1.13. O vetor aleatório (X1 , ..., Xn ) possuirá dependência positiva através da ordenação

estocástica, denotada por PDS, se [X1 , ..., Xi−1 |Xi = xi ] for estocasticamente crescente quando xi

aumentar, para todo i = 1, ..., n.

13

Definição 1.14. O vetor aleatório (X1 , ..., Xn ) possuirá dependência condicionalmente crescente

em sequência, denotada por CIS, se Xi for estocasticamente crescente em X1 , ..., Xi−1 , isto é, se

P (Xi > xi |X1 = x1 , ..., Xi−1 = xi−1 ) ↑ (for crescente em) x1 , ..., xi−1 , ∀xi , i = 1, ..., n.

Note que, para n = 2, PDS equivale à X2 SI em X1 e X1 SI em X2 . Da mesma forma, CIS

equivale à SI.

Os conceitos de v.a. PDS e CIS possuem as seguintes versões para dependência negativa:

dependência negativa através da ordenação estocástica (“negative dependence through the stochastic

ordering”) e dependência condicionalmente decrescente em sequência (“conditional decreasing in

sequence”).

Definição 1.15. O vetor aleatório (X1 , ..., Xn ) possuirá dependência negativa através da ordenação

estocástica, denotada por NDS, se [X1 , ..., Xi−1 |Xi = xi ] for estocasticamente decrescente em xi ,

para todo i = 1, ..., n [23].

Definição 1.16. O vetor aleatório (X1 , ..., Xn ) possuirá dependência condicionalmente decrescente

em sequência, denotada por CDS, se P (Xi > xi |X1 = x1 , ..., Xi−1 = xi−1 ) ↓ (for decrescente em)

x1 , ..., xi−1 , ∀xi , i = 1, ..., n [8].

Para v.a. CDS (veja a Definição 1.16) e NOD (veja as Definições 1.8 e 1.9), tem-se a seguinte

propriedade [23]: Sejam Xo , X1 , ..., Xn v.a. independentes sendo que cada v.a. possui função densidade ou função de probabilidade P F2 . Então, para x fixo, as v.a. condicionais

(X1 , ..., Xn |Xo + X1 + ... + Xn = x) são RR2 aos pares e, consequentemente, serão CDS e NOD.

Nas Definições 1.14 e 1.16, ao invés, das v.a. X1 , ..., Xi−1 serem condicionadas, respectivamente,

aos valores fixo x1 , ..., xi−1 , pode-se considerar X1 , ..., Xi−1 condicionadas, respectivamente, em

X1 > x1 , ..., Xi−1 > xi−1 ou X1 ≤ x1 , ..., Xi−1 ≤ xi−1 . Dessa forma, tem-se as seguintes definições

[8].

Definição 1.17. As v.a. X1 , ..., Xn serão crescentes na cauda à direita em sequência (“right-tail

increasing in sequence”), denotada por RTIS, se P (Xi > xi |X1 > x1 , ..., Xi−1 > xi−1 ) ↑ (for

crescente em) x1 , ..., xi−1 , ∀xi , i = 1, ..., n.

14

Definição 1.18. As v.a. X1 , ..., Xn serão crescentes na cauda à esquerda em sequência (“left-tail

decreasing in sequence”), denotada por LTIS, se P (Xi ≤ xi |X1 ≤ x1 , ..., Xi−1 ≤ xi−1 ) ↑ x1 , ..., xi−1 ,

∀xi , i = 1, ..., n.

Se n = 2, a Definição 1.17 torna-se: A v.a. X2 será crescente na cauda à direita (“right-tail

increasing”), denotada por RTI, em X1 se P (X2 > x2 |X1 > x1 ) =

1−F (x1 ,x2 )

1−F1 (x1 )

↑ x1 , ∀x2 [25].

Se n = 2, a Definição 1.18 torna-se: A v.a. X2 será crescente na cauda à esquerda (“left-tail

incresing”), denotada por LTI, em X1 se P (X2 ≤ x2 |X1 ≤ x1 ) =

F (x1 ,x2 )

F1 (x1 )

↑ x1 , ∀x2 [8].

As expressões nas Definições 1.17 e 1.18 são condições de dependência positiva. Pela Definição

1.17, para o caso em que n = 2, tem-se que é mais provável que X2 assuma valores grandes quando

X1 aumentar. E, pela Definição 1.18, para o caso em que n = 2, tem-se que é mais provável que X2

assuma valores pequenos quando X1 diminuir.

Se, nas Definições 1.17 e 1.18, a monocidade ↑ for trocada por ↓, ter-se-á os conceitos referentes

à dependência negativa.

Se, na Definição 1.17, a monocidade ↑ for trocada por ↓ tem-se que as v.a. X1 , ..., Xn serão

decrescentes na cauda à direita em sequência (“right-tail decreasing in sequence”), denotada por

RTDS, ou seja, P (Xi > xi |X1 > x1 , ..., Xi−1 > xi−1 ) ↓ x1 , ..., xi−1 , ∀xi , i = 1, ..., n [8] sendo que,

para n = 2, a v.a. X2 será decrescente na cauda à direita (“right-tail decresing”), denotada por

RTD, em X1 , ou seja, P (X2 > x2 |X1 > x1 ) =

F (x1 ,x2 )

F1 (x1 )

↓ x1 , ∀x2 [8, 25].

Se, na Definição 1.18, a monocidade ↑ for trocada por ↓ tem-se que as v.a. X1 , ..., Xn serão

decrescentes na cauda à esquerda em sequência (“left-tail decreasing in sequence”), denotada por

LTDS, se P (Xi ≤ xi |X1 ≤ x1 , ..., Xi−1 ≤ xi−1 ) ↓ x1 , ..., xi−1 , ∀xi , i = 1, ..., n [8] sendo que, para

n = 2, a v.a. X2 será decrescente na cauda à esquerda (“left-tail decreasing ”), denotada por LTD,

em X1 , ou seja, P (X2 ≤ x2 |X1 ≤ x1 ) =

F (x1 ,x2 )

F1 (x1 )

↓ x1 , ∀x2 [8, 25].

A seguir, algumas propriedades referentes às dependências SI, SD, CDS, RTDS, RTD serão

dadas [8]:

1. X2 será SD em X1 se e somente se X2 for SI em −X1 . Além disso, X2 será SD em X1 se e

somente se −X2 for SI em X1 ;

2. Seja o vetor aleatório (X, Y ) possuindo função densidade f (x, y) satisfazendo

15

f (x , y ) f (x , y )

1 1

1 2

f (x2 , y1 ) f (x2 , y2 )

≤0

para cada escolha x1 < x2 , y1 < y2 . Então, Y será SD em X;

3. Sejam:

(a) (X1 , ..., Xn ) um vetor aleatório possuindo função densidade f (x1 , ..., xn ) que satisfaz

f (x , ..., x , ..., x , ..., x ) f (x , ..., x , ..., x0 , ..., x )

1

i

j

n

1

i

n

j

f (x1 , ..., x0 , ..., xj , ..., xn ) f (x1 , ..., x0 , ..., x0 , ..., xn )

i

i

j

≤0

0

(3.9)

0

para cada par de variáveis permanecendo as demais fixas onde xi < xi e xj < xj ;

(b) Todas as funções de densidade marginais fk (x1 , ..., xk ), 1 ≤ k < n satisfazendo (3.9) para

cada par de variáveis permanecendo as demais fixas.

Então, (X1 , ..., Xn ) será CDS e cada permutação de (X1 , ..., Xn ) será CDS;

4. Seja o vetor aleatório (X1 , ..., Xn ) CDS. Então, E(ϕ(Xi )|X1 = x1 , ..., Xi−1 = xi−1 ) será decrescente em x1 , ..., xi−1 para cada função integrável crescente ϕ;

5. Seja a sequência {Xn , n ≥ 1} de vetores aleatórios CDS p-dimensionais com f.d.a. {Hn , n ≥ 1}

tais que Hn → H fracamente quando n → ∞ onde H é a f.d.a. do vetor aleatório p-dimensional

X. Então, X será CDS;

6. Qualquer conjunto de v.a. independentes é RTDS;

7. Qualquer subconjunto de v.a. RTDS é RTDS;

8. Se X1 , ..., Xn forem v.a. RTDS e ϕ1 , ..., ϕn forem funções Borel-mensuráveis crescentes, então

ϕ1 (X1 ), ..., ϕn (Xn ) será RTDS;

9. Seja X = (X1 , X2 ). Então, X2 é RTD em X1 ⇔ P (X2 ≥ x2 |X1 > x1 ) ↓ x1 para todo

x2 ⇔ E(ϕ(X2 )|X1 > x1 ) ↓ x1 para toda função real ϕ crescente;

16

10. Seja X2 v.a. RTD na v.a. X1 e seja Z uma v.a. independente de (X1 , X2 ). Definindo

X = X1 + aZ e Y = X2 + bZ, a e b constantes, tem-se que Y é RTD em X;

11. Seja a sequência {Xn , n ≥ 1} de vetores aleatórios RTDS p-dimensionais com f.d.a.

{Hn , n ≥ 1} tais que Hn → H fracamente quando n → ∞ onde H é a f.d.a. do vetor aleatório

p-dimensional X. Então, X será RTDS;

12. Seja (U, V ) RTD e seja Z uma v.a. independente de (U, V ). Definindo ϕ1 e ϕ2 , funções

Borel-mensuráveis que mapeiam R2 em R com ϕ1 (u, .) crescente em u e ϕ2 (., v) crescente em

v. Então, (X, Y ) é RTD onde X = ϕ1 (U, Z) e Y = ϕ2 (Z, V );

13. Sejam X = (X1 , ..., Xn ) um vetor aleatório formado por v.a. RTDS, ϕl : R → R uma função

Borel-mensurável crescente para cada l = 1, ..., n. Sejam Z = (Z1 , ...Zn ) um vetor aleatório

formado por v.a. RTDS sendo X e Z independentes. Definindo Yl = ϕl (Xl ) + Zl , l = 1, ..., n,

tem-se que Y1 , ..., Yn são RTDS;

14. Sejam

(a) Seja (X1 , ..., Xn ) um vetor aleatório tal que F n (x1 , ..., xn ) = P (X1 > x1 , ..., Xn > xn )

satisfaça:

i.

F (x , ..., x , ..., x , ..., x ) F ((x , ..., x , ..., x0 , ..., x )

i

j

n

n

1

i

n

n 1

j

0

0

0

F n (x1 , ..., x , ..., xj , ..., xn ) F n ((x1 , ..., x , ..., x , ..., xn )

i

i

j

≤0

0

(3.10)

0

para cada par de variáveis permanecendo as demais fixas xi < xi e xj < xj ;

ii. Se F k (x1 , ..., xk ) = P (X1 > x1 , ..., Xk > xk ), 1 ≤ k < n, verificar (3.10) para cada

par de variáveis permanecendo as demais fixas;

Então, (X1 , ..., Xn ) será RTDS e qualquer permutação de (X1 , ..., Xn ) será RTDS;

A seguir, serão apresentados alguns exemplos relativos à alguns conceitos de dependência apresentados nesta seção [8, 23]:

• Exemplo 1: A Distribuição Multinormal com vetor de médias µ = (µ1 , ..., µn ) e matriz de

P

variância-covariância

definida positiva é CDS;

17

• Exemplo 2: A Distribuição Multinomial dada por (2.6) é CDS e NDS;

• Exemplo 3: A Distribuição de Dirichlet dada por (2.8) é CDS.

1.4

Variáveis Aleatórias Negativamente Associadas

Definição 1.19. As variáveis aleatórias X1 , ..., Xn possuem associação negativa (“negative association”),

denotada por NA, se para cada par de subconjuntos disjuntos A1 , A2 de {1, ..., n} tem-se

Cov(ϕ(Xi , i ∈ A1 ), ψ(Xj , j ∈ A2 )) ≤ 0

(4.11)

sempre que ϕ e ψ forem funções crescentes [23].

Vale observar que (4.11) continua válida se ϕ e ψ forem funções decrescentes.

A seguir, serão apresentadas algumas propriedades referentes ao conceito de v.a. NA [23].

1. Sejam A1 , ..., Am subconjuntos disjuntos de índices {1, ..., n} e φ, ..., φm funções crescentes e

positivas. Se as variáveis aleatórias, X1 , ..., Xn , forem NA, então:

E

"m

Y

#

φi (Xj , j ∈ Ai ) ≤

i=1

m

Y

E[φi (Xj , j ∈ Ai )]

i=1

2. Um subconjunto de duas ou mais v.a. NA é NA;

3. Um conjunto de v.a. independentes é NA;

4. Funções crescentes definidas em subconjuntos disjuntos de um conjunto de v.a. NA são NA;

5. A união de conjuntos independentes de v.a. NA é NA;

6. Sejam X1 , ..., Xn v.a. independentes e suponha que a esperança condicional

P

P

E(φ(Xi , i ∈ A)| i∈A Xi ) seja crescente em i∈A Xi , para cada função crescente φ e para

cada subconjunto apropriado A de índices {1, ..., n}. Então, a distribuição condicional de

P

X1 , ..., Xn dado

Xi é NA, quase certamente;

18

7. Sejam X1 , ..., Xn v.a. independentes possuindo funções densidade P F2 . Então, a distribuição

P

condicional conjunta de X1 , ..., Xn dado

Xi é NA, quase certamente.

Uma consequência da propriedade 1 é a dada a seguir: Se A1 , A2 forem subconjuntos disjuntos

de índices {1, ..., n} e x1 , ..., xn ∈ R. Então,

P (Xi ≤ xi , i = 1, ..., n) ≤ P (Xi ≤ xi , i ∈ Ai )P (Xj ≤ xj , j ∈ A2 )

e

P (Xi > xi , i = 1, ..., n) ≤ P (Xi > xi , i ∈ Ai )P (Xj > xj , j ∈ A2 );

Então, em particular, X1 , ..., Xn são NOD.

A seguir serão apresentados alguns exemplos de distribuições NA [23].

• Exemplo 1: Seja x = (x1 , ..., xn ) um conjunto de n números reais. Uma distribuição de

permutação é a distribuição conjunta do vetor X = (X1 , ..., Xn ) que assume os valores de

todas a n! permutações de x com igual probabilidade, sendo cada probabilidade igual à

1

n! ,

n > 1. Temos que uma distribuição de permutação é NA;

• Exemplo 2: A Distribuição Multinomial dada por (2.6) é NA;

• Exemplo 3: A Distribuição Hipergeométrica Multivariada dada por (2.7) é NA;

• Exemplo 4: Seja X = (X1 , .., Xn ) uma amostra aleatória de uma população. Seja Ri o posto

de Xi , i = 1, ..., n. Como R = (R1 , ..., Rn ) possui distribuição de permutação, tem-se que R

será NA;

• Exemplo 5: Variáveis aleatórias que possuem distribuições normais negativamente correlacionadas são NA;

• Exemplo 6: A Distribuição de Dirichlet dada por (2.8) é NA.

19

1.5

Implicações e Contra-exemplos envolvendo os Conceitos de Dependência

Teorema 1.2. Todos os tipos de dependências, definidos nas seções anteriores, são invariantes com

respeito às transformações estritamente crescentes sobre as componentes do vetor aleatório.

Demonstração: Para a demonstração consulte [25].

Teorema 1.3. Relações para o caso bivariado:

(a) densidade T P2 ⇒ SI ⇒ LTD, RTI;

(b) LTD ou RTI ⇒ associação ⇒ PQD;

(c) densidade T P2 ⇒ f.d.a. T P2 e função de sobrevivência T P2 ;

(d) f.d.a T P2 ⇒ LTD e função de sobrevivência T P2 ⇒ RTI.

Demonstração: Para a demonstração consulte [25].

Pelo teorema anterior, observa-se que a dependência T P2 é uma dependência forte pois esta

implica nas dependências SI, LTD, RTI, associação e PQD entre v.a. . A dependência mais fraca é

a PQD.

Teorema 1.4. Relações para o caso multivariado:

(a) um subvetor aleatório de um vetor aleatório associado é associado;

(b) associação ⇒ PUOD e PLOD;

20

(c) PDS ⇒ PUOD e PLOD;

(d) CIS ⇒ associação.

Demonstração: Para a demonstração consulte [25].

A seguir, serão dadas outras implicações entre os conceitos de dependência:

1. Um par de v.a. NQD é NA [23];

2. Um par de v.a. NA é NOD [23];

3. RTDS equivale à NUOD [8];

4. LTI equivale à NQD. Porém, para n ≥ 3, LTIS não implica em NUOD [8];

5. RTIS implica em PUOD [8];

6. Se (X1 , X2 ) for SD, ele será também RTD.

Na sequência, serão dados exemplos de implicações que não são válidas. Na seção 1.6 são

mostradas as tabelas utilizadas em alguns contra-exemplos.

• Contra-Exemplo 1: Para n ≥ 3, NUOD e NLOD não se equivalem [23]

Sejam as v.a. X1 , X2 e X3 assumindo valores (0, 1, 1), (1, 0, 1), (1, 1, 0) e (0, 0, 0) sendo que

cada valor assume a probabilidade 1/4. Então,

P (X1 > 0, X2 > 0, X3 > 0) = 0 <

1

= P (X1 > 0)P (X2 > 0)P (X3 > 0)

8

mas

P (X1 ≤ 0, X2 ≤ 0, X3 ≤ 0) =

1

1

> = P (X1 ≤ 0)P (X2 ≤ 0)P (X3 ≤ 0);

4

8

• Contra-Exemplo 2: Nem v.a. NUOD e nem v.a. NLOD implica em v.a. NA [23]

No contra-exemplo seguinte, X = (X1 , X2 , X3 , X4 ) será NOD mas não será NA.

21

Seja o vetor aleatório X = (X1 , X2 , X3 , X4 ) onde cada v.a. Xi possui Distribuição de Bernoulli

com P (Xi = 1) = 0, 5, i = 1, ..., 4. Considere os pares (X1 , X2 ) e (X3 , X4 ) possuindo a mesma

distribuição bivariada. A função de probabilidade conjunta de (X1 , X2 , X3 , X4 ) é dada pela

Tabela 6.1.

Pode-se verificar que todas as condições NLOD e NUOD são válidas.

Porém, P (Xi = 1, i = 1, ..., 4) > P (X1 = X2 = 1)P (X3 = X4 = 1) viola o conceito NA;

• Contra-Exemplo 3: RTD não implica em LTI [8]

Sejam (X, Y ) duas v.a. tendo função de probabilidade conjunta dada pela Tabela 6.2.

Como P (Y > 0|X ≥ 0) =

3

10 ,

P (Y > 0|X ≥ 1) =

44

165 ,

P (Y > 0|X ≥ 2) =

30

165

e

P (Y > 0|X ≥ 3) = 0 tem-se que Y é RTD em X.

Porém, P (Y = 0|X ≤ 0) =

3

5

>

5

9

= P (Y = 0|X ≤ 1) e, assim, Y não é LTI em X;

• Contra-Exemplo 4: LTI não equivale à RTD [8]

Para mostrar que LTI não implica em RTD, considere (X, Y ) duas v.a. tendo distribuição

conjunta de probabilidade dada pela Tabela 6.3.

Como P (Y = 0|X ≤ 0) = 52 , P (Y = 0|X ≤ 1) = 12 , P (Y = 0|X ≤ 2) =

P (Y = 0|X ≤ 3) =

3

5

3

5

e

tem-se que Y é LTI em X.

Porém, P (Y = 1|X > 1) = 0, 30 < 0, 40 = P (Y = 1|X > 2) e, assim, Y não é RTD em X;

• Contra-Exemplo 5: Para n ≥ 3, LTIS não equivale à NUOD [8]

Considere as v.a. X, Y e Z tais que Z condicionado em X ≤ x e Y ≤ y, possui função

densidade

P (Z ≤ z|X ≤ x, Y ≤ y) = 1 − exp{−z(x + y)}

(5.12)

com z > 0. As v.a. X e Y possuem função de distribuição conjunta dada pela Tabela 6.3.

Desde que lado direito de (5.12) é crescente em x e y e, a partir do exemplo supra-citado,

(X, Y ) é LTI e a sequência (X, Y, Z) é LTIS.

22

Porém, desde que

P (Z ≤ z|X ≤ x) = 1 − exp{−z(x + 1)}

e

P (Z ≤ z|Y ≤ y) = 1 − exp{−z(y + 3)}

segue que

P (X > 2, Y > 0, Z > 2) = e−8 −1, 35e−6 +0, 45e−4 > 0, 1e−8 = P (X > 2)P (Y > 0)P (Z > 2);

• Contra-Exemplo 6: CDS não implica em RTDS [8]

Para mostrar que CDS não implica em RTDS, considere X1 , X2 e X3 v.a. tais que

fX3 |X1 ,X2 (x3 |x1 , x2 ) = x2 e−x2 x3

com x3 > 0. As v.a. X1 e X2 possuem função de probabilidade conjunta dada pela Tabela

6.4.

Como P (X2 > 1|X1 = 0) = 1, P (X2 > 1|X1 = 1) = 31 , P (X2 > 1|X1 = 2) = 14 ,

P (X2 > 2|X1 = 0) = 31 , P (X2 > 2|X1 = 1) =

1

3

e P (X2 > 2|X1 = 2) = 0 tem-se que X2 é

SD em X1 . Além disso, como P (X3 > x|X1 = x1 , X2 = x2 ) = exp{−x2 x} ↓ x2 tem-se que

(X1 , X2 , X3 ) é CDS.

Por outro lado, utilizando-se a identidade

P (C|A ∪ B) = P (C|A)

P (B)

P (A)

+ P (C|B)

P (A) + P (B)

P (A) + P (B)

quando P (A ∩ B) = 0, P (A) > 0 e P (B) > 0, obtém-se

P (X3 > x|X1 > 0, X2 > 1) =

=

1

P (X3 > x|X1 = 1, X2 = 3) + P (X3 > x|X1 = 2, X2 = 2) =

2

1 −3x

e

+ e−2x

2

enquanto que P (X3 > x|X1 > 1, X2 > 1) = P (X3 > x|X1 = 2, X2 = 2) = e−2x .

23

Como P (X3 > x|X1 > 1, X2 > 1) > P (X3 > x|X1 > 0, X2 > 1), ∀x > 0 tem-se que

(X1 , X2 , X3 ) não é RTDS;

• Contra-Exemplo 7: NA não implica em RR2 aos pares, CDS ou NDS [23]

No contra-exemplo seguinte, será mostrado que Y é NA mas não é RR2 aos pares, CDS ou

NDS.

Seja X = (X1 , X2 , X3 ) um vetor aleatório possuindo uma função de probabilidade multinomial

trivariada f com probabilidades p1 , p2 e p3 estritamente positivas e X1 + X2 + X3 = 3.

Considere o vetor aleatório induzido Y = (Y1 , Y2 ) onde Y1 = X1 X2 e Y2 = X3 . A função de

probabilidade conjunta de (Y1 , Y2 ) será denotada por g e é dada pela Tabela 6.5.

A Distribuição Multinomial é RR2 aos pares, CDS e NDS [2, 28]. Será mostrado que a função

de probabilidade conjunta g não é nem RR2 , nem CDS e nem NDS.

Pela função de probabilidade conjunta g de (Y1 , Y2 ) obtém-se que

g(0, 0) g(0, 1)

P (x) = g(1, 0) g(1, 1)

>0

Então, conclui-se que g não é RR2 .

Notando que P (Y2 > 0|Y1 = 0) = 1 − P (Y2 = 0|Y1 = 0) < 1 enquanto que

P (Y2 > 0|Y1 = 1) = 1 − P (Y2 = 0|Y1 = 1) = 1, conclui-se que Y não é CDS.

Como, para um vetor bivariado, CDS equivale à NDS, segue que Y não é NDS.

Pelas propriedades 7 e 4 da seção 1.4, conclui-se, respectivamente, que X é NA e Y é NA.

Portanto, NA não implica em RR2 aos pares, CDS ou NDS já que Y é NA mas não é RR2 ,

CDS ou NDS.

Além das implicações, citadas anteriormente, que não são válidas, tem-se, também, que CIS não

implica RTIS [8], RTIS não implica CIS [8].

1.6

Tabelas referentes ao Capítulo

24

Tabela 6.1: Função de probabilidade conjunta de (X1 , X2 , X3 , X4 )

Y /X

(0,0)

(0,1)

(1,0)

(1,1)

(0,0)

0,0577

0,0623

0,0623

0,0577

(0,1)

0,0623

0,0677

0,0677

0,0623

(1,0)

0,0623

0,0677

0,0677

0,0623

(1,1)

0,0577

0,0623

0,0623

0,0577

Tabela 6.2: Função de probabilidade conjunta de X e Y

Y /X

0

1

2

3

0

0,15

0,10

0,20

0,25

1

0,10

0,10

0,10

0

Tabela 6.3: Função de probabilidade conjunta de X e Y

Y /X

0

1

2

3

0

0,10

0,15

0,20

0,15

1

0,15

0,10

0,05

0,10

Tabela 6.4: Função de probabilidade conjunta de X e Y

Y /X

0

1

2

1

0

0,20

0,30

2

0,20

0

0,10

3

0,10

0,10

0

25

Tabela 6.5: Função de probabilidade conjunta de (Y1 , Y2 )

Y /X

0

1

2

0

f (0, 3, 0) + f (3, 0, 0)

0

f (1, 2, 0) + f (2, 1, 0)

1

f (0, 2, 1) + f (2, 0, 1)

f (1, 1, 1)

0

2

f (0, 1, 2) + f (1, 0, 2)

0

0

3

f (0, 0, 3)

0

0

26

Capítulo 2

Teoria de Cópulas

2.1

Introdução

Desde que Joe (1997) [25] e Nelsen (1999) [31] pela primeira vez introduziram o conceito de cópulas para uso em modelagem padrão, tem havido um interesse crescente nesta abordagem. Cópulas

tornaram-se uma ferramenta popular de modelagem multivariada em muitos domínios onde a dependência multivariada é de interesse e o uso da habitual normalidade multivariada está em questão.

Em ciências autuárias cópulas são usadas na modelagem de mortalidade e perdas [13, 14, 15]. Em

finanças, cópulas são usadas na classificação de crédito e modelagem de risco [3, 9, 7]. Em estudos

biomédicos, cópulas são utilizadas na modelagem de eventos correlacionados e riscos competitivos

[37]. Em engenharia, cópulas são utilizadas no controle de processo multivariado e modelagem

hidrológica [16].

Quando se fala em modelagem de dependência, hoje em dia um dos primeiros temas a ser levado

em consideração é a recente teoria de cópulas discutida por Joe [25] e Nelsen [31]. Esta teoria

se torna atrativa devido às cópulas abrangerem um grande leque de estruturas de dependência e

conseguirem modelar completamente a estrutura de dependência dos dados.

A modelagem através da distribuição normal é amplamente utilizada por sua simplicidade

analítica e fácil estimação da matriz de correlação, seu único parâmetro de dependência, e por

conta da vasta gama de estruturas que podem ser modeladas por esta distribuição. Porém algumas

27

28

de suas característica, de simetria e curtose, por exemplo, limitam sua utilização. Como Embrechts

et. al. [10] mostram, há muitos obstáculos à suposição de normalidade. Para os mercados de crédito

e financeiro, o principal é a característica de pequena probabilidade em eventos extremos conjuntos.

Evidências empíricas sugerem que no comportamento destes mercados verificam-se eventos extremos

mais prováveis que os previstos pela distribuição normal, não só nas marginais, mas também em

dimensões superiores. Neste contexto, a modelagem através das cópulas torna-se atraente devido a

sua maior variedade de estruturas de dependência.

A cópula é uma distribuição multivariada cujas marginais são U (0, 1). Seja o vetor aleatório

U = (U1 , . . . , Ud ) ∈ Id com cópula d-dimensional C, temos

C(u1 , . . . , ud ) = P (U1 ≤ u1 , . . . , Ud ≤ ud ), (u1 , . . . , ud ) ∈ Id

e combinado com o fato de que qualquer v.a. contínua pode ser transformada por sua acumulada

para uma v.a. com distribuição U (0, 1), cópulas podem ser usadas para fornecer uma estrutura de

dependência multivariada separadamente das distribuições marginais. Seja H uma f.d.a. de X =

(X1 , . . . , Xd ) com marginais F1 , . . . , Fd , Sklar [36] mostrou que existe uma cópula C d-dimensional

tal que para todo xi ∈ Dom Fi ,

H(x1 , . . . , xd ) = C(F1 (x1 ), . . . , Fd (xd ))

(1.1)

Como visto, com cópulas pode-se trabalhar a estrutura de dependência em um contexto multivariado, porém esta dissertação trata apenas do contexto bidimensional, apresentando todos os

resultados para esta dimensão. Também não há impedimento para se trabalhar com o Kendall Plot,

objeto central da tese, em um contexto multivariado, por uma questão de exemplificação trabalha-se

em um contexto bivariado.

A função cópula C associada ao vetor aleatório (X, Y ) também é conhecida como função dependência, já que a cópula contém toda informação de dependência entre as variáveis X e Y . Desta

maneira a utilização da equação (1.1) possibilita trabalhar com a estrutura de dependência de

(X, Y ) de forma livre de medida de escala e locação, restringindo-se apenas ao intervalo [0, 1]. A

característica da informação de dependência que a cópula contém pode ser vista através do seguinte

exemplo.

29

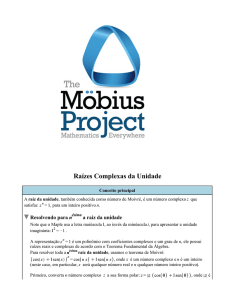

Exemplo 2.1. São geradas duas amostras, de forma independente. Sejam (x1 . . . x100 ) e (y1 . . . y100 )

pseudo observações independentes com distribuição F1 (x) = 1 − exp(−2x) e F2 (y) = 1 − exp(−10y)

respectivamente. Observando o scatterplot de X e Y na Figura 2.1 vê-se que não fica evidente a

independência entre essas variáveis. Porém, ao plotar (F1 (xi ), F2 (yi )), as amostras transformadas

pelas respectivas acumuladas F1 e F2 , fica evidente a independência entre X e Y . Visto que a cópula

é a distribuição conjunta entre F1 (X) e F2 (Y ). Mostra-se que a cópula evidencia a verdadeira independência existente entre X e Y e como a forma das marginais pode produzir uma falsa impressão

de dependência.

Como a cópula é uma função de (U1 , ..., Un ) onde Ui = Fi (Xi ), i = 1, .., n, observa-se que quando

se tem valores observados de duas v.a. X e Y , a cópula modela a ordem dos valores observados das

v.a. X e Y pois considera-se a f.d.a. de cada v.a. sendo que a ordem da amostra é algo inerente à

esta função. Esta ordem é evidenciada através do Gráfico de Dispersão dos valores uniformizados

F1 (x) e F2 (y).

2.2

Cópula e Teorema de Sklar

Definição 2.1. Sejam S1 e S2 subconjuntos não vazios de R̄, função H : S1 × S2 → R e o retângulo

B = [x1 , x2 ] × [y1 , y2 ], (xi , yi ) ∈ Dom H com i, j = 1, 2, . . .. Define-se H-volume de B como

VH (B) = H(x2 , y2 ) + H(x2 , y1 ) − H(x1 , y2 ) + H(x1 , y1 )

(2.2)

Definição 2.2. Uma função H bidimensional é bicrescente se VH (B) ≥ 0, ∀B, com VH (B) dado

pela Definição 2.1.

Exemplo 2.2. Uma função não decrescente marginalmente pode não ser bicrescente. Seja H : I2 →

I definida por H(x, y) = max(x, y), temos VH (I2 ) = −1, ou seja, H não é bicrescente.

Exemplo 2.3. Uma função pode ser bicrescente e decrescente em alguns de seus argumentos. Seja

H : I2 → I definida por H(x, y) = (2x − 1)(2y − 1). Note que VH (B) pode ser reescrito como

VH (B) = (y2 − y1 )(4x2 − 4x1 ) ≥ 0, pois x1 ≤ x2 e y1 ≤ y2 no retângulo B, logo H é bicrescente.

Porém H é uma função decrescente de x para cada y ∈ (0, 1/2) e função decrescente de y para cada

x ∈ (0, 1/2).

30

Figura 2.1: Scatterplots: Dados exponenciais independentes (primeira figura); dados exponenciais

independentes transformados pelas acumuladas (segunda figura).

31

Definição 2.3. Uma aplicação H : S1 × S2 → R é aplanada se H(x, a1 ) = 0 = H(a1 , y), ∀(x, y) ∈

S1 × S2 , onde ai = min{z : z ∈ Si }.

Definição 2.4. Uma subcopula é uma função C 0 com as seguintes propriedades:

1. Dom C 0 = S1 × S2 , onde S1 e S2 são subconjuntos de I contendo 0 e 1;

2. C 0 é aplanada e bicrescente;

3. C 0 é marginalmente uniforme, ou seja, para todo u ∈ S1 e v ∈ S2 ,

C 0 (u, 1) = u e C 0 (1, v) = v

(2.3)

Exemplo 2.4. Sejam S1 = S2 = {0, 1}. A função C 0 : S1 × S2 7−→ R definida por

C 0 (0, 0) = C 0 (0, 1) = C 0 (1, 0) = 0 e C 0 (1, 1) = 1

é a mais simples subcopula.

Definição 2.5. Uma cópula é uma subcopula cujo domíno é I2 .

Exemplo 2.5. As funções W, M : I2 → I dadas por W (u, v) = max(u + v − 1, 0) e M (u, v) =

min(u, v) são exemplos particulares de cópulas denotadas respectivamente por M e W . É trivial

mostrar que a função M (u, v) é aplanada e marginalmente uniforme. Para verificar que esta função é

bicrescente, considere o retângulo B = [x1 , x2 ] × [y1 , y2 ], x1 , x2 , y1 e y2 ∈ I, para o caso y2 ≥ x2 ≥ x1

e x1 ≤ y1 ≤ x2 e desta maneira

VM (B) = M (x2 , y2 ) − M (x2 , y1 ) − M (x1 , y2 ) + M (x1 , y1 ) = x2 − y1 ≥ 0

Para os demais casos a demonstração é análoga. A cópula W pertence a classe das cópulas

Arquimedianas e será vista na próxima seção.

Como toda cópula é uma subcopula, os próximos conceitos são apresentados para subcopulas,

logo válidos paracópulass.

Teorema 2.1. Uma subcopula bidimensional C 0 é marginalmente não decrescente.

32

Demonstração. Primeiro, provemos que a aplicação t → C 0 (t, y2 ) − C 0 (t, y1 ), y1 , y2 ∈ I, y1 ≤ y2 é

não decrescente. Consideremos T (t) = C 0 (t, y2 )−C 0 (t, y1 ), se t1 ≤ t2 , ti ∈ I, temos T (t2 )−T (t1 ) ≥ 0,

pois

T (t2 ) − T (t1 ) = C 0 (t2 , y2 ) − C 0 (t2 , y1 ) − C 0 (t1 , y2 ) + C 0 (t1 , y1 ) = VC0 (B)

onde B = [t1 , t2 ] × [y2 , y1 ]. Como C 0 é bicrescente, então VC0 (B) ≥ 0, logo a aplicação é não

decrescente. Analogamente verifica-se que a aplicação T ∗ (t) = C 0 (x2 , t) − C 0 (x1 , t), x1 , x2 ∈ I, x1 ≤

x2 é não decrescente. Agora, seja x1 = y1 = 0 nas aplicações T e T ∗ , como C 0 é aplanda, segue que

C 0 é marginalmente não decrescente.

Teorema 2.2. Seja C 0 uma subcopula. Então para todo (u, v) ∈ Dom C 0 ,

max(u + v − 1, 0) ≤ C 0 (u, v) ≤ min(u, v)

(2.4)

Demonstração. Como C 0 é aplanada, marginalmente uniforme e não decrescente temos

0 = C 0 (0, v) ≤ C 0 (u, v) ≤ C 0 (1, v) = v

e

0 = C 0 (u, 0) ≤ C 0 (u, v) ≤ C 0 (u, 1) = u

(2.5)

Logo,

C 0 (u, v) ≤ min(u, v)

Como C 0 também é bicrescente, então VC 0 (B) ≥ 0. Sendo B = [u, 1] × [v, 1] temos

VC 0 (B) = C 0 (1, 1) + C 0 (u, v) − C 0 (u, 1) − C 0 (1, v)

= 1 + C 0 (u, v) − u − v ≥ 0

(2.6)

Portanto pelas equações (2.5) e (2.6), temos C 0 (u, v) ≥ max(u + v − 1, 0).

Conforme Exemplo 2.5, os limites na equação (2.4) são as cópulas M e W . Então para toda

cópula C e para todo (u, v) ∈ I2 ,

W (u, v) ≤ C(u, v) ≤ M (u, v)

(2.7)

A desigualdade (2.7) é denominada desigualdade dos limites de Frechét, a cópula M é nomeada por

limite superior de Frechét e a cópula W por limite inferior de Frechét.

A ligação entre funções distribuição multivariada e suas marginais univariadas é feita pelo Teorema de Sklar apresentado a seguir, por meio das cópulas. O nome cópula foi escolhido para enfatizar

a maneira como a cópula une uma função distribuição conjunta às suas marginais univariadas.

33

Teorema 2.3. Seja H uma função distribuição conjunta com marginais F e G. Então existe uma

cópula C tal que para todo x, y ∈ R̄,

H(x, y) = C(F (x), G(y))

(2.8)

Se F e G são contínuas, então C é única; caso contrário, C é unicamente determinada em Im(F ) ×

Im(G). Inversamente, se C é uma cópula e F e G são f.d.a., então a função H definida pela equação

(2.8) é uma função distribuição conjunta com marginais F e G.

Demonstração. A prova segue dos lemas 2.1 e 2.2 apresentados a seguir.

Lema 2.1. Seja H uma função distribuição conjunta com marginais F e G. Então existe uma única

subcopula C 0 tal que

1. Dom C 0 = Im(F ) × Im(G);

2. ∀x, y ∈ R̄, H(x, y) = C 0 (F (x), G(y))

Demonstração. Sejam (x1 , y1 ), (x2 , y2 ) ∈ Dom H. Pela desigualdade triangular, temos

|H(x2 , y2 ) − H(x1 , y1 )| ≤ |H(x2 , y2 ) − H(x1 , y2 )| + |H(x1 , y2 ) − H(x1 , y1 )|

Considere x1 ≤ x2 . Como H é uma função distribuição conjunta, então

0 ≤ H(x2 , y2 ) − H(x1 , y2 ) ≤ F (x2 ) − F (x1 )

por H ser marginalmente decrescente, aplanada, H(x, ∞) = F (x) e H(∞, y) = G(y). Uma desigualdade análoga é válida quando x2 ≤ x1 . Portanto segue que para qualquer x1 , x2 ∈ S1 ,

|H(x2 , y2 ) − H(x1 , y2 )| ≤ |F (x2 ) − F (x1 )|. Similarmente para qualquer y1 , y2 ∈ S2 , |H(x1 , y2 ) −

H(x1 , y1 )| ≤ |G(y2 ) − G(y1 )|, logo

|H(x2 , y2 ) − H(x1 , y1 )| ≤ |F (x2 ) − F (x1 )| + |G(y2 ) − G(y1 )|

(2.9)

Desta forma, segue que se F (x1 ) = F (x2 ) e G(y1 ) = G(y2 ), então H(x1 , y1 ) = H(x2 , y2 ) e consequentemente o conjunto de pares {(F (x), G(y)), H(x, y)} permite definir uma função

C0

(F (x), G(y)) → H(x, y)

34

sendo C 0 única com domínio Im(F ) × Im(G). A prova que a função C 0 é uma subcopula segue

diretamente das propriedades da distribuição conjunta H [22]. Para cada u ∈ Im(F ), existe um

x ∈ R̄ tal que F (x) = u, então

C 0 (u, 1) = C 0 (F (x), G(∞)) = H(x, ∞) = F (x) = u

C 0 (u, 0) = C 0 (F (x), G(−∞)) = H(x, −∞) = 0

Como H é bicrescente por definição, logo C 0 é bicrescente.

Lema 2.2. Seja C 0 uma subcopula. Então existe uma cópula C tal que C(u, v) = C 0 (u, v), ∀(u, v) ∈

Dom C 0 ; isto é, qualquer subcopula pode ser extendida a umacópulaa. A extensão é geralmente não

única.

Demonstração. Da equação (2.9) e usando o item 2. do Lema 2.1, concluímos que C 0 é uniformemente contínua em seu domínio Im(F ) × Im(G), ou seja,

|C 0 (u2 , v2 ) − C 0 (u1 , v1 )| ≤ |u2 − u1 | + |v2 − v1 |

Denotemos Im(F ) por S1 e Im(G) por S2 .

Da continuidade de C 0 podemos estender C 0 a uma função C 00 , ainda subcopula, com domínio

em S̄1 × S̄2 , onde S̄1 é o fecho de S1 e S̄2 é o fecho de S2 . O próximo passo é estender a subcopula C 00

a uma função C com domínio em I2 . Para este fim, seja (a, b) ∈ I2 , e sejam a1 e a2 , respectivamente,

o menor e o maior elemento de S̄1 que satisfaça a1 ≤ a ≤ a2 ; e sejam b1 e b2 , respectivamente, o

menor e o maior elemento de S̄2 que satisfaça b1 ≤ b ≤ b2 . Se a ∈ S̄1 , defina a1 = a2 = a; e se

b ∈ S̄2 , defina b1 = b2 = b. Desta maneira, sejam

(

λ1 =

1, se a1 = a2

(

µ1 =

(a − a1 )/(a2 − a1 ), se a1 < a2

(b − b1 )/(b2 − b1 ), se b1 < b2

1, se b1 = b2

e define-se

C(a, b) = (1 − λ1 )(1 − µ1 )C 00 (a1 , b1 ) + (1 − λ1 )µ1 C 00 (a1 , b2 )

+ λ1 (1 − µ1 )C 00 (a2 , b1 ) + λ1 µ1 C 00 (a2 , b2 ).

(2.10)

35

É trivial que Dom C = I2 e que C(a, b) = C 00 (a, b), ∀(a, b) ∈ Dom C 00 . Como λ1 e µ1 são

lineares em a e b, a forma C(a, b) da equação (2.10) é bilinear em (a, b) propriedade que permite

demonstrar que C é aplanada e marginalmente uniforme. Conforme Definição 2.5, para C ser uma

cópula falta provar que C é bicrescente. Seja (c, d) outro ponto em I2 tal que c ≥ a e d ≥ b, e

sejam c1 , d1 , c2 , d2 , λ2 , µ2 relacionados a c e d assim como a1 , b1 , a2 , b2 , λ1 , µ1 são relacionados a a e

b. Deve-se provar que VC (B) ≥ 0 para o retângulo B = [a, c]×[b, d]. Diversos casos são considerados

para esta prova. O mais simples dos casos é aquele em que não existe ponto em S̄1 estritamente

entre a e c e não há ponto em S̄2 estritamente entre b e d, então temos c1 = a1 , c2 = a2 , d1 = b1 e

d2 = b2 . Substituindo a equação (2.10) e os termos correspondentes para C(a, d), C(c, b) e C(c, d)

na expressão dada pela equação (2.2) para VC (B), temos

VC (B) = VC ([a, c] × [b, d]) = (λ2 − λ1 )(µ2 − µ1 )VC ([a1 , a2 ] × [b1 , b2 ]),

de que segue que VC (B) ≥ 0 neste caso, pois c ≥ a e d ≥ b implica λ2 ≥ λ1 e µ2 ≥ µ1 .

Outro caso de interesse é quando pelo menos um ponto está em S̄1 estritamente entre a e c, e

pelo menos um ponto está em S̄2 estritamente entre b e d, então a < a2 ≤ c1 < c e b < b2 ≤ d1 < d.

Para este caso, substituindo a equação (2.10) e os termos correspondentes para C(a, d), C(c, b) e

C(c, d) na expressão dada pela equação (2.2) para VC (B) e reordenando os termos temos

VC (B) = (1 − λ1 )µ2 VC ([a1 , a2 ] × [d1 , d2 ]) + µ2 VC ([a2 , c1 ] × [d1 , d2 ])

+ λ2 µ2 VC ([c1 , c2 ] × [d1 , d2 ]) + (1 − λ1 )VC ([a1 , a2 ] × [b2 , d1 ])

+ VC ([a2 , c1 ] × [b2 , d1 ]) + λ2 VC ([c1 , c2 ] × [b2 , d1 ])

+ (1 − λ1 )(1 − µ1 )VC ([a1 , a2 ] × [b1 , b2 ])

+ (1 − µ1 )VC ([a2 , c1 ] × [b1 , b2 ]) + λ2 (1 − µ1 )VC ([c1 , c2 ] × [b1 , b2 ]).

O lado direito da expressão acima é a soma de combinações de nove quantidades não negativas, representadas por C-volumes, com coeficientes não negativos, logo é não negativa. Os casos

remanescentes são similares, que completam a prova.

Antes de apresentar o próximo resultado é necessária a definição de quasi-inversa.

Definição 2.6. Seja F uma função distribuição acumulada. Então a quasi-inversa de F é qualquer

função F (−1) com domínio em I tal que

36

1. Se t ∈ Im(F ), então F (−1) (t) = x com x ∈ R tal que F (x) = t, ou seja, ∀t ∈ Im(F ),

F (F (−1) (t)) = t;

2. Se t ∈

/ Im(F ), então

F (−1) (t) = inf{x|F (x) ≥ t} = sup{x|F (x) ≤ t}.

Corolário 2.1. Sejam H, F, G e C 0 como no Lema 2.1, e sejam F (−1) e G(−1) as quasi-inversas de

F e G, respectivamente. Então para qualquer (u, v) ∈ Dom C 0 ,

C 0 (u, v) = H(F (−1) (u), G(−1) (v))

(2.11)

Sejam x ∈ Dom(F ) e y ∈ Dom(G) conforme Teorema 2.3 se u = F (x) e v = G(y), então

x = F (−1) (u) e y = G(−1) (v). Quando F e G são contínuas o Corolário 2.1 é válido para cópulas

e temos U, V com distribuição U (0, 1) onde U = F (X) e V = G(Y ). Deste modo a cópula C é

distribuição conjunta do vetor aleatório (U, V ) com marginais U (0, 1).

Exemplo 2.6. Um método para construção de cópulas é resultante do último corolário. Seja H a

distribuição da independência

H(x, y) = F (x)G(y)

(2.12)

com marginais F (x) = 1 − exp(−2x) e G(y) = 1 − exp(−y), onde as respectivas quasi-inversas são

dada por

(

F

(−1)

(u) =

(

G

(−1)

(v) =

,

− log(1−u)

2

se

x≥0

0, c.c.

− log(1 − v),

se

x≥0

0, c.c.

Logo, a cópula associada a H é dada por

C(u, v) = H(F (−1) (u), G(−1) (v))

= F {F (−1) (u)}G{G(−1) (v)}

= [1 − e−2 log(1−u)/2 ][1 − e− log(1−v) ]

= uv

37

Esta cópula recebe a notação especial Π e é denominada cópula produto. Sua estrutura caracteriza

a independência entre as v. a. X e Y quando as f.d.a. F e G são contínuas. Note que se a conjunta

H é definida pela equação (2.12), a estrutura de dependência entre as v.a. X e Y independe de suas

marginais, pois

C(u, v) = H(F (−1) (u), G(−1) (v)) = F {F (−1) (u)}G{G(−1) (v)} = uv

pela definição de quasi-inversa (Definição 2.6).

Muito da utilidade de cópulas no estudo de estatísticas não paramétricas deriva do fato que sob

transformações monótonas estritas de v.a. as cópulas são invariantes, ou são alteradas de modo

previsível como visto nos próximos dois resultados.

Teorema 2.4. Sejam X e Y v.a. contínuas com cópula CX,Y . Se α e β são funções estritamente

crescentes na Im(X) e Im(Y ) respectivamente, então Cα(X),β(Y ) = CX,Y .

Demonstração. Sejam F1 , G1 , F2 e G2 as respectivas distribuições de X, Y, α(X) e β(Y ), respectivamente. Assim, para qualquer x, y ∈ R̄,

Cα(X),β(Y ) (F2 (x), G2 (y)) = P [α(X) ≤ x, β(Y ) ≤ y] = P [X ≤ α−1 (x), Y ≤ β −1 (y)]

= CX,Y (F1 (α−1 (x)), G1 (β −1 (y))) = CX,Y (F2 (x), G2 (y))

Desde que X e Y são contínuas, Im(F2 ) = Im(G2 ) = I, logo segue que Cα(X),β(Y ) = CX,Y em

I2 .

Quando pelo menos uma função, α ou β, é estritamente decrescente, a cópula das v.a. α(X) e

β(Y ) é uma simples transformação de CX,Y .

Teorema 2.5. Sejam X, Y v.a. contínuas com cópula CX,Y e α e β funções estritamente monótonas

na Im(X) e Im(Y ) resprectivamente.

1. Se α é estritamente crescente e β é estritamente decrescente, então

Cα(X),β(Y ) (u, v) = u − CX,Y (u, 1 − v), u, v ∈ I.

38

2. Se α é estritamente decrescente e β é estritamente crescente, então

Cα(X),β(Y ) (u, v) = v − CX,Y (1 − u, v), u, v ∈ I.

3. Se α e β ambas são estritamente decrescentes, então

Cα(X),β(Y ) (u, v) = u + v − 1 + CX,Y (1 − u, 1 − v), u, v ∈ I.

Demonstração. Sejam F1 , G1 , F2 e G2 as distribuições de X, Y, α(X) e β(Y ) respectivamente. Tomemos

u ∈ Im(F2 ) e v ∈ Im(G2 ) tais que u = F2 (x) para algum x ∈ Im(F2 ) = I (devido a v.a. α(X) ser

contínua) e v = G2 (y) para algum y ∈ Im(G2 ) = I (devido a v.a. β(X) ser contínua).

Demonstração item 1.:

(2.8)

Cα(X),β(Y ) (u, v) = Cα(X),β(Y ) (F2 (x), G2 (y)) = P (α(X) ≤ x, β(Y ) ≤ y)

= P (X ≤ α−1 (x), Y ≥ β −1 (y))

(2.13)

Como,

F2 (x) = P (α(X) ≤ x) = P (X ≤ α−1 (x)) = F1 (α−1 (x))

= P (X ≤ α−1 (x), Y ≤ β −1 (y)) + P (X ≤ α−1 (x), Y ≥ β −1 (y))

(2.14)

e

G2 (y)

=

P (β(Y ) ≤ y) = P (Y ≥ β −1 (y)) = 1 − G1 (β −1 (y))

⇒ G1 (β −1 (y)) = 1 − G2 (y)

(2.15)

temos

P (X ≤ α−1 (x), Y ≤ β −1 (y)) = CX,Y (F1 (α−1 (x)), G1 (β −1 (y)))

= CX,Y (F2 (x), 1 − G2 (y))

= CX,Y (u, 1 − v)

onde a segunda igualdade se refere às equações (2.14) e (2.15).

(2.16)

39

Substituindo a equação (2.16) na equação (2.14)

F2 (x)

=

P (X ≤ α−1 (x), Y ≥ β −1 (y)) + CX,Y (u, 1 − v)

⇒ P (X ≤ α−1 (x), Y ≥ β −1 (y)) = u − CX,Y (u, 1 − v)

(2.17)

Desta forma, substituindo a equação (2.17) na equação (2.13), se completa a prova.

Demonstração item 2.: análoga a demonstração item 1.

Demonstração item 3.:

(2.8)

Cα(X),β(Y ) (u, v) = Cα(X),β(Y ) (F2 (x), G2 (y)) = P (α(X) ≤ x, β(Y ) ≤ y)

= P (X ≥ α−1 (x), Y ≥ β −1 (y))

= 1 − [P (X ≤ α−1 (x)) + P (Y ≤ β −1 (y)) − P (X ≤ α−1 (x), Y ≤ β −1 (y))]

= 1 − F1 (α−1 (x)) − G1 (β −1 (y)) + P (X ≤ α−1 (x), Y ≤ β −1 (y))

(2.18)

Reescrevendo F1 (α−1 (x)), temos

F1 (α−1 (x)) = 1 − P (X ≥ α−1 (x)) = 1 − P (α(X) ≤ x) = 1 − F2 (x)

(2.19)

e, analogamente

G1 (β −1 (y)) = 1 − G2 (y)

(2.20)

Substituindo as equações (2.19) e (2.20) na equação (2.18) e utilizando o Teorema 2.3,

Cα(X),β(Y ) (u, v) = 1 − [1 − F2 (x)] − [1 − G2 (y)] + CX,Y (F1 (α−1 )(x), G1 (β −1 (y))

= u + v − 1 + CX,Y (1 − u, 1 − v)

2.3

Cópulas Arquimedianas

O termo cópula Arquimediana foi mencionado pela primeira vez na literatura estatística em dois

artigos de Genest & Mackay (1986ab) [17] e [18]. Cópulas Arquimedianas também são mencionadas

por Schweizer and Sklar (1983) [34], mas sem o nome Arquimediana.

40

A Classe das cópulas Arquimedianas abrange uma grande variedade de estruturas de dependência, incluindo estruturas próprias de estudos financeiros. Algumas questões em finanças exigem

modelos que permitem uma forte dependência entre as perdas extremas (por exemplo, bolsas em

colapso) e ganhos extremos. Em particular, as cópulas Arquimedianas podem assumir dependência

caudal assimétrica, sendo uma propriedade a favor de sua aplicação à modelagem de dados com

estrutura de dependênica assimétrica.

Em estudos financeiros um aspecto importante a ser analisado é a dependência caudal. Dependência caudal inferior e superior entre dois mercados financeiros existe quando a probabilidade

de valores conjuntos negativos (positivos) em eventos extremos é maior que a que poderia ser prevista a partir das distribuições marginais. Recentes estudos empíricos mostram que períodos de

turbulência e calma em finanças são caracterizados por diferentes níveis de dependência caudal,

sendo a dependência mais forte sobre a cauda inferior do que na cauda superior.

As cópulas Arquimedianas podem ser construídas facilmente e a forma fechada para sua expressão é simples. Estas facilidades se devem ao fato da representação da cópula Arquimediana

permitir reduzir o estudo de cópula multivariada ao estudo de uma função univariada denotada por

gerador de uma cópula Arquimediana φ. A seguir esta função é apresentada com mais detalhes.

Definição 2.7. Seja φ : I → [0, ∞] uma função contínua e estritamente decrescente tal que φ(1) = 0.

A pseudo-inversa de φ é a função φ[−1] : [0, ∞] → I dada por

(

φ[−1] (t) =

φ−1 (t), se 0 ≤ t ≤ φ(0)

0, se φ(0) ≤ t ≤ ∞

Note que φ[−1] é contínua e não crescente em [0, ∞], e estritamente decrescente em [0, φ(0)].

Além disso,

φ[−1] (φ(u)) = u, ∀u ∈ I

(3.21)

e

(

[−1]

φ(φ

(t)) =

t, se 0 ≤ t ≤ φ(0)

φ(0), se φ(0) ≤ t ≤ ∞

Finalmente, se φ(0) = ∞, então φ[−1] = φ−1 .

= min(t, φ(0))

41

Lema 2.3. Seja φ e φ[−1] como na Definição 2.7. Seja a função C : I2 → I dada por

C(u, v) = φ[−1] (φ(u) + φ(v))

(3.22)

Então C satisfaz duas das três condições para uma cópula, é aplanada e marginalmente uniforme.

Demonstração.

C(u, 0) = φ[−1] (φ(u) + φ(0)) = 0

A última igualdade segue da definição de pseudo-inversa, pois φ(u) + φ(0) ≥ φ(0) sendo φ uma

função que assume somente valores positivos.

(3.21)

C(u, 1) = φ[−1] (φ(u) + φ(1)) = φ[−1] (φ(u)) = u

(3.23)

Analogamente, por simetria, C(0, v) = 0 e C(1, v) = v.

O seguinte lema apresenta uma condição necessária e suficiente para que a função C na equação

(3.22) seja bicrescente, e portanto, uma cópula.

Lema 2.4. Sejam φ,φ[−1] e C satisfazendo as hipóteses do Lema 2.3. Então C é bicrescente, se e

somente se, sempre que u1 ≤ u2 ,

C(u2 , v) − C(u1 , v) ≤ u2 − u1

(3.24)

Demonstração. (⇒)

VC ([u1 , u2 ] × [v, 1]) = C(u1 , v) + C(u2 , 1) − C(u1 , 1) − C(u2 , v) ≥ 0 ⇔ u2 − u1 ≥ C(u2 , v) − C(u1 , v)

Então, a equação (3.24) é equivalente à condição VC ([u1 , u2 ]×[v, 1]) ≥ 0 que é sempre válida quando

C é bicrescente.

(⇐) Considere C satisfazendo a equação (3.24). Sejam v1 , v2 ∈ I, v1 ≤ v2 , temos C(0, v2 ) = 0 ≤

v1 ≤ v2 = C(1, v2 ). Como C é contínua, desde que φ e φ[−1] também são, existe t ∈ I tal que

C(t, v2 ) = v1 , ou seja, φ(v2 ) + φ(t) = φ(v1 ). Então

C(u2 , v1 ) − C(u1 , v1 )

=

φ[−1] (φ(u2 ) + φ(v1 )) − φ[−1] (φ(u1 ) + φ(v1 ))

=

φ[−1] (φ(u2 ) + φ(v2 ) + φ(t)) − φ[−1] (φ(u1 ) + φ(v2 ) + φ(t))

=

φ[−1] (φ(C(u2 , v2 )) + φ(t)) − φ[−1] (φ(C(u1 , v2 )) + φ(t))

=

C(C(u2 , v2 ), t) − C(C(u1 , v2 , t))

(3.24)

≤

C(u2 , v2 ) − C(u1 , v2 ) ⇔ VC ([u1 , u2 ] × [v1 , v2 ]) ≥ 0

42

O próximo teorema mostra que a condição da função C ser bicrescente dada pelo Lema 2.4

também encontra-se relacionada com uma propriedade da função φ, bem como as outras duas

condições para que C seja uma cópula (Lema 2.3).

Deste modo, somente a estrutura da função φ pode determinar se a função C da equação (3.22)

é ou não uma cópula.

Teorema 2.6. Sejam φ e φ[−1] como na Definição 2.7. Então a função C : I2 → I dada pela

equação (3.22) é uma cópula se e somente se φ é convexa.

Demonstração. Como consequência do Lema 2.4 é necessário provar que a equação (3.24) é válida

se e somente se φ é convexa.

(⇒) Observe que a equação (3.24) é equivalente a