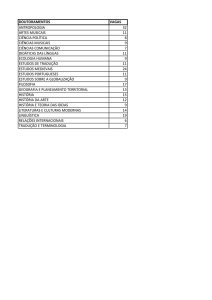

50

Fronteiras

Digital:

muito além do óbvio

Processamento de Linguagem Natural, um dos campos de estudo da Inteligência

Artificial, auxilia atividades ligadas à linguagem, como revisão gramatical e tradução

Fabricio Mazocco

Até mesmo os que possuem apenas conhecimentos básicos em computadores sabem

operar softwares processadores de texto, principalmente o Word, da Microsoft. Ao

utilizarmos esse programa, um traço verde indica quando há algo de errado com a

sentença, seja na concordância de gênero, grau ou número, em espaços a mais

ou a menos, na colocação de vírgulas e em relação a diversas outras

regras gramaticais. Além de indicar o erro, o programa sugere a

forma correta a ser empregada. Esses são os atributos do revisor gramatical. Até aqui, nada de novo.

O que muitos não sabem é que, utilizando o aplicativo,

estão lidando com a Inteligência Artificial (IA); mais

precisamente, com um dos campos de estudo da IA: o

Processamento de Linguagem Natural (PLN).

dez|2002

Fronteiras

Definindo: PLN é o estudo voltado para a

construção de programas capazes de compreender a linguagem natural (interpretação) e gerar

textos, falados ou escritos. Assim como outros campos da IA, este também tem o objetivo de aperfeiçoar a interação entre as pessoas e os computadores. Entre os projetos possíveis com o uso

do PLN estão o revisor gramatical, a sumarização

automática, a recuperação de informações, o dicionário online e o tradutor automático.

Por lidar com linguagem natural e linguagem

computacional, as pesquisas nessa área têm

reunido cientistas de áreas distintas, como computação e lingüística. Este é o caso do grupo NILC

(Núcleo Interinstitucional de Lingüística Computacional), criado em 1993. A coordenação do grupo é

dividida entre os pesquisadores, sendo três da

Universidade de São Paulo, campus de São Carlos

(dois do Instituto de Ciências Matemáticas e de

Computação – ICMC e um do Instituto de Física –

IFSC), um da Faculdade de Ciências e Letras da Universidade Estadual Paulista (Unesp), campus de

Araraquara, e um do Departamento de Computação da Universidade Federal de São Carlos

(UFSCar). Todos os campi estão localizados no interior paulista.

dez|2002

O ReGra uniu pesquisadores das áreas de computação e lingüística.“Começamos do zero”, conta

uma das coordenadoras do NILC, Maria das Graças

Volpe Nunes, professora do ICMC-USP. O primeiro

passo foi desenvolver um léxico com mais de 1,5

milhão de vocábulos. Para cada um deles, foi

necessário estabelecer as categorias gramaticais, ou

seja, se é um substantivo, verbo, adjetivo e assim

por diante. Também foram incluídas cerca de 600

regras gramaticais e mil regras de correção. Na

primeira versão do projeto, o revisor apontava somente erros pontuais. Não era feita a análise

sintática, desenvolvida para a versão seguinte.

Maria das Graças Volpe Nunes, da USP:

“Não existe nenhum revisor com 100% de

acerto, em razão da complexidade da

análise automática de uma língua natural”

Fabricio Mazocco

Por lidar com

linguagem natural e

linguagem

computacional,

pesquisas reúnem

cientistas de áreas

distintas, como

computação e

lingüística

O primeiro projeto do grupo, denominado

ReGra, de 93, teve como objetivo criar um revisor

gramatical da língua portuguesa, solicitado pela

empresa Itautec. Na época, só existia o corretor

ortográfico. Em 94, foi concluída a primeira versão

comercial. Depois, o sistema passou por modificações,continua sendo aperfeiçoado e,hoje,é parte

integrante das ferramentas do Office (versão em

português), da Microsoft. O NILC continua assessorando o projeto.

51

52

Fronteiras

Redes neurais, que são

conjuntos de

“neurônios artificiais”,

possibilitam a tomada

de decisões complexas

Os erros que o ReGra detecta referem-se aos

desvios da norma culta da língua, incluindo concordância nominal e verbal,regência,uso de pronomes e crase, pontuação e outros. Um corpus

com cerca de 40 milhões de palavras dá suporte

às atividades de extração de padrões válidos e

de testes do revisor.

Atualmente, a equipe trabalha na inserção de

regras estilísticas que não são erros gramaticais,

como o pleonasmo. O novo recurso deve ser

finalizado em fevereiro do próximo ano.

Redes neurais

Outra abordagem de revisão investigada pela

equipe é a que procura ensinar o computador a

verificar os erros. Nesse caso, usam-se técnicas

estatísticas e as baseadas em redes neurais, o

que elimina a necessidade de formular grandes

e complexas gramáticas computacionais.

O processo da rede neural baseia-se no neurônio artificial, ou nó artificial. A denominação

assusta, mas um neurônio artificial nada mais é

que um simples processador.O sistema funciona

da seguinte maneira: recebe as informações do

mundo exterior ou de outros nós, toma uma

única decisão e a repassa, por meio de um canal

de saída, para o próximo nó neural. Quando é

constituída uma rede, o resultado é a tomada

de decisões complexas.

No caso do revisor gramatical, a partir de

exemplos do que é correto e do que não é, a

rede neural é treinada para verificar novos erros.

A grande diferença na utilização de métodos

estatísticos ou empíricos para essa atividade é

que, embora apresentem uma taxa de erro

maior, eles têm menor custo de operação.

Site de busca já existente: problema é a

enxurrada de informações devolvidas, que

nem sempre atendem às expectativas do

usuário

Mesmo com todo o avanço em pesquisas

na área, a tarefa de revisão gramatical tem

suas limitações. “Não existe nenhum revisor

com 100% de acerto, em razão da complexidade da análise automática de uma

língua natural”, explica Maria das Graças.

As principais limitações do projeto são as

omissões de revisão e os falsos erros, devidos

à ambigüidade sintática e à variedade de

padrões sintáticos a serem reconhecidos.

Além disso,“o revisor não tem compreensão

do que está escrito”,comenta a pesquisadora,

sobre a impossibilidade de a máquina entender o significado das palavras.

Tradução

Se a Inteligência Artificial está aí, a serviço

da linguagem, porque não utilizá-la para

auxiliar na comunicação entre as várias nações, ou seja, traduzir toda e qualquer língua?

Para essa pergunta há duas respostas: a primeira é que a tradução automática existe há

muito tempo e é considerada o primeiro problema da IA; a segunda é que a tradução

ainda é uma questão em aberto. O grau de

erro varia de acordo com a especificidade da

linguagem. Quanto mais limitado o vocabulário, mais eficiente é a tradução.

dez|2002

Fronteiras

Atualmente, são utilizadas três

linhas de estudo para a tradução

automática: direta, por transferência e por interlíngua.A primeira

é a mais simples, porém com

maior grau de erro. Nessa linha,

toda a tradução é fortemente

baseada em dicionário de palavras e expressões. A tradução é

feita palavra por palavra, sem

qualquer regra gramatical. Aquela

feita por transferência é mais

sofisticada: o programa tem o

conhecimento das gramáticas e

dos léxicos das línguas utilizadas.

Por exemplo: o computador recebe um texto em inglês a ser traduzido para o português; o programa compara as regras gramaticais das duas línguas e em seguida traduz as palavras. O resultado,

nesse caso, é melhor do que no

anterior, mas ainda longe do ideal.

Sandra Maria Aluísio, pesquisadora

da USP que desenvolve projeto com o

objetivo de construir arquitetura

favorável para busca de informações

baseada em tema-assunto

Fabricio Mazocco

Tradução: quanto mais

limitado o vocabulário,

maior é a eficiência

A tradução por interlíngua, por

sua vez, supõe o uso de uma

linguagem intermediária artificial,

cujo papel é representar o significado das sentenças a serem

traduzidas.O projeto UNL (Universal Networking Language), da

UNU (Universidade das Nações

Unidas), é um exemplo de iniciativa nessa direção. A UNL é a

interlíngua que faz a ponte entre

mais de 15 sistemas de traduções

(15 línguas). O cenário seria o seguinte: o emissor escreve um

texto, por exemplo, na língua

portuguesa e aciona o codificador

UNL, que estará disponível na

Internet. O texto estará, então, disponível em formato de arquivo

UNL, sendo possível sua tradução

dentro das línguas disponíveis.

Um receptor quer ler o texto, por

exemplo, na língua japonesa.

Tendo o arquivo UNL em seu

computador, ele decodifica o

texto, por esse programa, e o terá

em sua língua. O que ocorre nesse

caso é que, o emissor, ao codificar

o texto em UNL, torna-o disponível para tradução nas 15

línguas que compõem o programa.Este, por uso do PLN,realiza

o processo semelhante à linha de

transferência, comparando as

regras gramaticais e os léxicos das

línguas do emissor e do receptor.

Os sistemas de tratamento da

língua portuguesa, dentro do

projeto UNL, estão sendo desenvolvidos pelo NILC.

dez|2002

Sistema de busca

O sistema de buscas na Internet, ou Recuperação de Informação (RI), como é conhecido

no meio acadêmico, é atualmente um dos recursos mais

utilizados na rede. Estamos

falando de sites como o Google,

o Cadê e o Alta Vista, nos quais

inserimos uma ou mais palavraschave e temos os resultados de

páginas eletrônicas que contêm

essas palavras. O problema é a

enxurrada de informações devolvidas, que nem sempre

atendem às nossas expectativas.

Fizemos um teste, utilizando o

Google: ao inserirmos somente

PLN (sigla de Processamento de

Linguagem Natural, campo de

estudo da Inteligência Artificial,

que está sendo tratado nesta

reportagem), encontramos 2.380

ocorrências, incluindo um site que

dispõe de endereços eletrônicos

cujo servidor é PLN e outro cuja

sigla é indicada como um código

da moeda da Polônia. Os dois

nada têm a ver com nosso objetivo de busca. Que tal buscar a

expressão completa PROCESSAMENTO DE LINGUAGEM NATURAL? O número de ocorrências

pulou para 7.000! Entre elas,há um

site sobre a área de Informática

Jurídica, no qual as palavras que

buscamos estão no texto, porém

isoladas umas das outras. Para

finalizar, colocamos PROCESSAMENTO DE LINGUAGEM NATURAL PLN. O número de ocorrências caiu para 222.

53

Fronteiras

Arquivo pessoal

54

Renata Vieira, da Unisinos: protótipo

fará busca de informações no site da

própria Universidade

Sandra Maria Aluísio, pesquisadora do ICMC-USP e uma das

coordenadoras do NILC,está desenvolvendo um projeto que objetiva

a construção de arquitetura

favorável para busca de informações baseada em tema-assunto,

o que deve resolver algumas

dificuldades hoje encontradas.

A idéia central do projeto é

utilizar o recurso do PLN em todo

o fluxo do sistema, ou seja, desde

o processamento de consultas e

de documentos até a apresentação de resultados. O PLN será

fundamental para melhorar a

busca. Quando o usuário digitar

uma ou mais palavras, o sistema

fará uma análise de sinônimos,

gramática e sintática da sentença.

Isto permitirá, utilizando um

exemplo simples, que ao ser digitado “carro”, também apareçam

ocorrências com “automóvel”, o

que não ocorre atualmente. “A

busca faz associações para levar

ao lugar correto”, explica Sandra.

A utilização do PLN para recuperação de informações está criando

uma nova proposta de organização da rede: a “web semântica”.

Esses estudos são desenvolvidos

na Universidade do Vale do Rio dos

Sinos (Unisinos), no Estado do Rio

Grande do Sul. Com o uso da sistemática do PLN, isto é, o significado das palavras ou expressões

e sua representação para que

sistemas computacionais possam

fazer uso desse conhecimento,está

sendo construído um protótipo

para busca de informações no site

da própria Universidade.

Três projetos foram desenvolvidos para aplicação nessa área: o

APSCO (Análise da Polissemia

Sistemática para a Construção de

uma Ontologia), o ONTOVERB

(Construção de Ontologias e Semântica Verbal) e o MLXML (Marcação Lingüística de Textos e

Documentos utilizando o XML –

Extensible Markup Language, sistema que permite a comunicação

entre diferentes computadores e

aparelhos portáteis, integrando a

infra-estrutura de tecnologia da

informação de empresas e órgãos

públicos). Os dois primeiros projetos, coordenados pela pesquisadora Rove Luiza de Oliveira

Chishman, do Centro de Ciências

da Comunicação da Unisinos,

estão mais ligados à lingüística, e

o terceiro, coordenado por Renata

Vieira, pesquisadora dos centros

de Ciências da Comunicação e de

Ciências Exatas e Tecnológicas da

mesma instituição, tem a preocupação de estudar as tecnologias

da“web semântica”e desenvolver

o protótipo. “As informações poderão ser recuperadas de maneira

mais eficiente”, resume Renata.

Já um grupo de pesquisa da

Pontifícia Universidade Católica

(PUC) do Rio Grande do Sul está

em fase de desenvolvimento da

RI em bibliotecas digitais. O projeto SEMA, como é denominado,

pretende melhorar as taxas de

recuperação de informações e de

dez|2002

Fronteiras

A história da Inteligência Artificial

A história da Inteligência Artificial (IA) começa nos anos

40. Após a Segunda Guerra Mundial, o computador

começou a ser gradualmente utilizado, principalmente por

empresas, indústrias e universidades, o que estimulou a

pesquisa sobre softwares, hardwares e linguagens de

programação. O rápido progresso, desde o surgimento dos

primeiros computadores eletrônicos (Collossus, na Inglaterra – 1943 – e o ENIAC, nos Estados Unidos – 1946) até

o surgimento dos microcomputadores, na década de 70,

demonstra que essa área recebeu grandes investimentos e

atenção por parte dos pesquisadores.

A primeira notícia que se tem do uso da denominação

Inteligência Artificial é de 1956, nos Estados Unidos, quando

John McCarthy reuniu, em uma conferência no Dartmouth

College, vários pesquisadores de renome para estudar

ferramentas construídas pelo homem para que a máquina

pudesse ter comportamentos inteligentes.

Ainda na década de 50, a introdução da programação

por meio de comandos de lógica de predicados proporcionou um grande avanço para a construção de sistemas

documentos, em domínios específicos de conhecimento. Esse

sistema será executado com o uso

de um thesaurus que incorpore

relações semânticas entre as palavras. O thesaurus é uma função

finita de termos para um conjunto

de relações, como a antonímia. A

proposta do grupo, que é coordenado pela pesquisadora Vera

Lúcia Strube de Lima, da Faculdade de Informática da PUC-RS,

prevê que tanto a construção de

índices como a representação da

busca façam uso dessa estrutura.

Sumarização

Resumir um livro, um texto ou

um filme não é tarefa fácil. Devemos levar em conta que, para cada

mente humana, a forma de redez|2002

que utilizam esquemas de raciocínio. Também obtiveram

bons resultados, na linha biológica, o primeiro simulador

de redes neurais artificiais e o primeiro neurocomputador.

Nas décadas de 60 e 70, também na linha biológica, foram desenvolvidos conceitos relativos às redes neurais. Já

na linha psicológica, os pesquisadores acreditavam que, com

a Inteligência Artificial, seria possível realizar tarefas

humanas como o pensamento e a compreensão da

linguagem por meio do computador.

Em 1982, o físico John Hopfield provou ser possível a

simulação de um sistema físico por meio de um modelo

matemático baseado na teoria das redes neurais. Nessa

mesma década, surgem novas técnicas e aplicações da IA e

começam a surgir trabalhos em conjunto com outras áreas,

como interfaces inteligentes e controle de robôs.

As redes neurais alcançam uma explosão exponencial de

aplicações e desenvolvimento de modelos na década de

90. Pesquisadores passam a reconhecer que os paradigmas

biológico e psicológico são complementares para sistemas

mais evoluídos.

sumir se diferencia, devido a

aspectos culturais, conhecimentos prévios e, até mesmo, à capacidade de síntese de cada pessoa.Com a velocidade com que os

fatos ocorrem atualmente e com

o volume de informações disponíveis, principalmente pelas

possibilidades que a Internet nos

oferece, o resumo ou sumário

deixou de ser um mero suporte

textual e passou a assumir a

função de transmitir informação.

A Sumarização Automática,

como é denominada a “capacidade” do computador em resumir, começa a tomar forma e caminha em direção a uma operacionalização eficiente.Um trabalho

que vem sendo desenvolvido por

Lúcia Helena Machado Rino, do

Departamento de Computação da

Universidade Federal de São Carlos,

tem esse objetivo.

Os estudos buscam a especificação de um modelo que organize as informações essenciais de

um texto. Para essa análise, são

necessários três processos: reconhecer o que há de essencial em

um texto; elaborar um novo texto

a partir do resultado do processo

anterior; e verificar se há relação

entre o produto apresentado e o

original. Essa verificação tem de

ser calcada em algumas premissas. Entre elas está a necessidade de manter a idéia central do texto e seu objetivo comunicativo; ou seja, se o texto original é descritivo, o seu resumo

também deve ser.

55

56

Fronteiras

Para a execução do projeto, duas áreas distintas devem atuar

em conjunto: a de interpretação e a de geração (organização)

de texto. A pesquisa de Lúcia, que também é uma das coordenadoras do NILC, é voltada à segunda área. O primeiro passo na

execução do projeto foi construir uma representação interna

que indica o que é mais relevante. O próximo passo, que está

em estudo, é o reconhecimento dos significados. “Não trabalhamos propriamente com palavras e sim com conceitos e idéias”,

explica Lúcia.

A pesquisadora propõe duas arquiteturas do sistema de sumarização automática: o de abordagem fundamental e o de

abordagem empírica. Na primeira, a fase de análise, no geral,

corresponde a uma tarefa de avaliação, resultando em sua

representação conceitual (representação conceitual I),ou seja,sua

estrutura sintática. A fase seguinte, a de transformação, consiste

na sumarização propriamente dita, na qual ocorre a seleção do

conteúdo e a possível reestruturação do que já foi selecionado, a

fim de garantir a coerência textual. Assim,

surge uma outra representação conceitual

(representação conceitual II). Por fim, a

última fase,a de síntese,implica na realização

superficial da representação conceitual,

agora condensada.

Hiperdicionário Online

Entre os problemas citados

para que a tradução, o revisor gramatical, a sumarização e o sistema

de busca de informações operem

com o máximo de eficiência estão

a complexidade da análise automática de uma língua natural, a

ambigüidade sintática e a variedade de padrões sintáticos a

serem reconhecidos. O computador não consegue distinguir os

Arquivo pessoal

Na arquitetura de abordagem empírica,

o processo é mais simples, podendo gerar

resultados menos eficientes. A análise do

documento é produto de uma distribuição

de relevância dos segmentos textuais

originais. Ou seja, a representação con-

ceitual descrita anteriormente é

substituída por um resultado

extraído de processos matemáticos ou estatísticos. A fase de

transformação do processo anterior se dá pela seleção dos segmentos do texto-fonte e sua

inserção no sumário,indicada pela

distribuição de relevância. A seleção pode ser pela freqüência das

palavras e por sua localização, entre outras. O título do texto também serve de base para o processo de seleção. Na última etapa,

os resultados são justapostos na

mesma ordem do texto original.

Carmelita Pádua Dias, da

PUC-RJ: grupo está

desenvolvendo dicionário

eletrônico de unidades

complexas do português do

Brasil

Arquitetura de um

sumarizador automático

fundamental

Arquitetura de um

sumarizador automático

empírico

dez|2002

Fronteiras

vários sentidos de uma palavra, o

que acarreta conclusões errôneas.

Com o intuito de utilização não

só como hiperdicionário, mas também como um componente para

diversos aplicativos no âmbito do

PLN,o lingüista Bento Carlos Dias da

Silva, da Faculdade de Ciências e

Letras da Universidade Estadual

Paulista (Unesp), campus de Araraquara, desenvolve o projeto

“Construção da Base da RedeWordNet para o Português do Brasil”.

“Não se trata de um dicionário

convencional, posto que os sentidos das unidades lexicais não são

listados e colocados por meio de

definições ou paráfrases (uma

forma de tradução livre e desenvolvida), mas são inferidos

pelo usuário por meio das relações léxico-conceituais que estruturam a rede”,explica Dias da Silva.

A intenção não é listar palavras e

seus respectivos sinônimos, como

diversos sites já fazem, mas sim

colocar à disposição uma rede de

palavras da língua portuguesa

semântica e conceitualmente

interconectadas por meio de relações de semelhança, oposição de

sentido, hierárquicas, conceituais

entre parte e todo e lógicas.

Para realizar o projeto, cuja

finalização da primeira versão está

prevista para 2004, o grupo de

trabalho liderado por Dias da Silva

utilizará o PLN, ou seja, o sistema

será construído por meio do fornecimento de uma base de conhecimentos. O aplicativo computacional, no formato WordNet,

será desenvolvido a partir da base

de um thesaurus eletrônico construído pelo NILC, grupo ao qual

Dias da Silva também pertence,

para o projeto ReGra. Essa base é

composta, atualmente, por mais

de 44 mil unidades lexicais da

língua portuguesa (cerca de 17

Lingüistas reconhecem avanços da área de

computação, mas afirmam que máquina não

substituirá o “escritor”

A Inteligência Artificial foi criada para auxiliar em algumas

atividades realizadas pelo homem e até para substituí-lo

em outras. Na opinião de lingüistas, o uso do PLN deverá

ficar restrito ao auxílio de algumas funções como, por

exemplo, a tradução.

(USP), campus de São Paulo, afirma que alguns aspectos são

possíveis de serem traduzidos pelo computador, mas a parte

convencional, como os fraseologismos e expressões

idiomáticas, quando feita pela máquina, “deixa muitíssimo

a desejar”.

O lingüista Bento Carlos Dias da Silva, da Faculdade de

Ciências e Letras da Universidade Estadual Paulista (Unesp),

campus de Araraquara, um dos coordenadores do NILC,

afirma que, no caso do Brasil, há particularidades da língua

portuguesa, como a polissemia e a idiossincrasia, que são

vistas como os principais problemas para os projetistas de

sistemas PLN.“Não há como evitá-los”,declara. O que se pode

fazer, segundo o lingüista, é fornecer o máximo de

conhecimentos léxico-semânticos, lógico-conceptuais, cotextuais e contextuais detalhados, para que o computador

possa “resolver” os casos de polissemia.

Lenita Rimoli Esteves, também do Departamento de

Letras Modernas da USP, conta que a sua visão sobre a

tradução automática mudou nos últimos dez anos. “O que

me fez mudar de postura foi a evolução que tenho visto”,

relata a pesquisadora, citando como exemplo as correções

de erros sintáticos.

No caso específico da tradução automática, a pesquisadora Stella Esther Ortweller Tagnin, do Departamento

de Letras Modernas da Faculdade de Filosofia, Letras e

Ciências Humanas (FFLCH) da Universidade de São Paulo

dez|2002

Sobre a possibilidade futura de o computador substituir o

homem, Stella responde que “numa área técnica, é possível

alcançar uma margem de erro menor; mas, na área literária...

nem pensar!”. Para Dias da Silva, o ser humano está longe de

dominar e domar as línguas naturais.“ Diria que somente uma

‘genuína inteligência artificial’ seria capaz de resolver o

enigma da linguagem articulada”, afirma.“Pessoalmente não

gostaria que o computador substituísse o trabalho humano,

e no fundo nem acho que isso seja possível”,completa Lenita.

57

58

Fronteiras

mil substantivos, 11 mil verbos, 15

mil adjetivos e mil advérbios),

estruturadas em função da sinonímia e da antonímia.

A pesquisa irá contribuir para a

construção da rede WordNet

(desenvolvida pela Universidade

de Princeton, EUA) para o português e será interligada a esta e

a outra rede, a EuroWordNet, em

desenvolvimento para as línguas

da Comunidade Européia. Assim,

esse hiperdicionário eletrônico do

português do Brasil, que poderá

ser acessado online, também possibilitará consultas às outras línguas que fazem parte da rede.

O grupo CLIC (Centro de Estudos em Lingüística Computacional) da PUC do Rio de Janeiro

também está elaborando um

dicionário eletrônico de unidades

complexas do português do Brasil.

“As pesquisas desenvolvidas pelo

grupo consideram unidades complexas que possam atuar como

itens lexicais, tais como expressões idiomáticas, substantivos

compostos, expressões com verbos suporte e locuções”, explica

Maria Carmelita Pádua Dias, que

ao lado de Violeta Quental, ambas

do Departamento de Letras da

PUC-RJ, responde pela coordenação dos estudos na área de PLN.

Para a elaboração do corpus de

palavras, o grupo está usando

como base um dicionário vasto

elaborado pela Universidade de

Lisboa. Nesse dicionário, existe um

certo número de palavras compostas retiradas do português

europeu. Com a colaboração do

professor Eric Laporte, da Universidade de Marne-la-Vallée, da

França, o grupo agora trabalha na

avaliação de textos brasileiros e na

definição das palavras compostas

do português do Brasil que estarão presentes no dicionário, de

acordo com alguns critérios previamente estabelecidos. “Estudos

de línguas,como o francês,revelam

que a maior parte das unidades

lexicais reconhecidas pelos falantes é composta. Assim, qualquer

sistema que processe a língua

portuguesa deve levar esse fator

em conta”,justifica Maria Carmelita.

Por estar em desenvolvimento,

ainda não foi resolvido como o

dicionário, depois de concluído,

será disponibilizado, e quantas

palavras farão parte do corpus.

Conclusões

Seria uma tarefa impossível

descrever em poucas páginas

tudo o que vem sendo desenvolvido em termos de pesquisa

na área da Inteligência Artificial

(IA) no Brasil. A IA não é restrita

a um universo limitado. Se a

entendermos como uma ferramenta auxiliar que expande a

capacidade da inteligência humana, substituindo-a em diversas funções, algumas questões

emergerão: o que é “inteligência”? Qual a possibilidade de

existirem “máquinas inteligentes”? O matemático inglês Alan

Turing, em 1950, realizou o que

ficou conhecido como o “Teste

de Turing”, em que foi provado

que não existe uma “máquina

inteligente”. E, até hoje, ela não

existe.

Entretanto, desde quando foi

criada (início da década de 40 do

século passado), a IA vem ocupando cada vez mais espaço em

diversas áreas do conhecimento,

por meio de campos de estudo

como o PLN, o Reconhecimento

de Padrões, a Programação de

Jogos, a Robótica, as Redes Neurais e a Lógica Fuzzy.

Tratando do assunto abordado nesta matéria, é possível

perceber como a IA pode e deve

auxiliar o desenvolvimento de

pesquisas em áreas distintas.

Mesmo considerando que as

pesquisas aqui apresentados são

bastante recentes (a maioria

iniciou suas atividades na década

passada), é notório que, apesar

de alguns problemas, mais de

ordem estrutural do que operacional, o avanço é significativo e

de grande utilidade, com possibilidades de ir muito mais além.

dez|2002