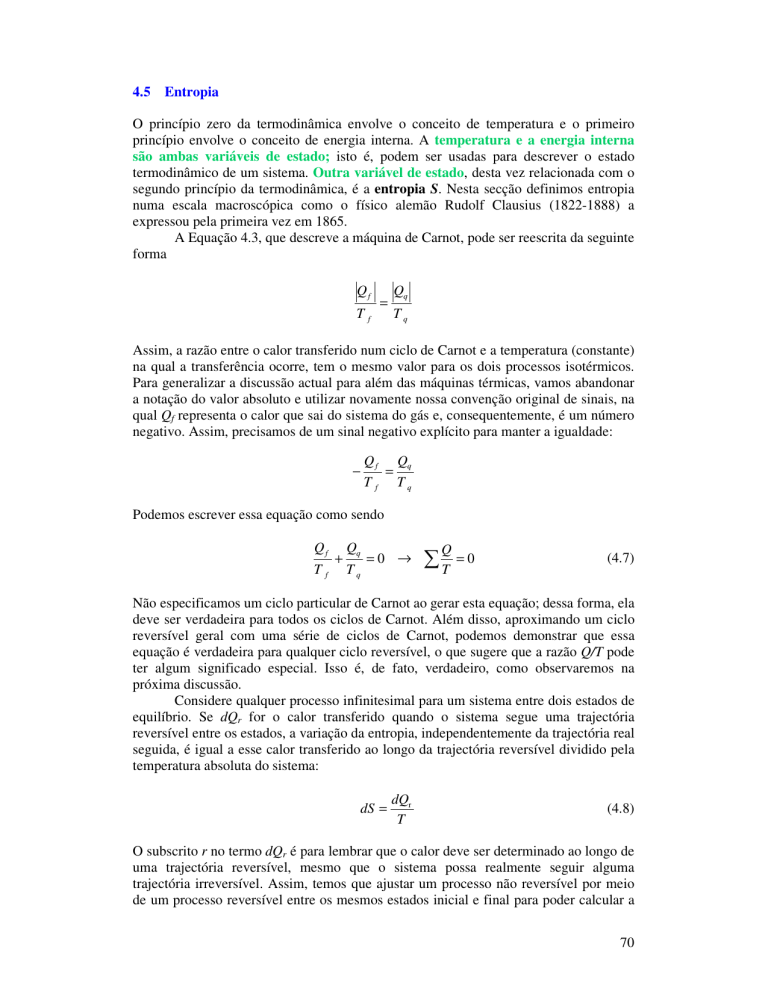

4.5 Entropia

O princípio zero da termodinâmica envolve o conceito de temperatura e o primeiro

princípio envolve o conceito de energia interna. A temperatura e a energia interna

são ambas variáveis de estado; isto é, podem ser usadas para descrever o estado

termodinâmico de um sistema. Outra variável de estado, desta vez relacionada com o

segundo princípio da termodinâmica, é a entropia S. Nesta secção definimos entropia

numa escala macroscópica como o físico alemão Rudolf Clausius (1822-1888) a

expressou pela primeira vez em 1865.

A Equação 4.3, que descreve a máquina de Carnot, pode ser reescrita da seguinte

forma

Qf

Tf

=

Qq

Tq

Assim, a razão entre o calor transferido num ciclo de Carnot e a temperatura (constante)

na qual a transferência ocorre, tem o mesmo valor para os dois processos isotérmicos.

Para generalizar a discussão actual para além das máquinas térmicas, vamos abandonar

a notação do valor absoluto e utilizar novamente nossa convenção original de sinais, na

qual Qf representa o calor que sai do sistema do gás e, consequentemente, é um número

negativo. Assim, precisamos de um sinal negativo explícito para manter a igualdade:

−

Q f Qq

=

T f Tq

Podemos escrever essa equação como sendo

Q f Qq

+

=0 →

T f Tq

Q

∑T

=0

(4.7)

Não especificamos um ciclo particular de Carnot ao gerar esta equação; dessa forma, ela

deve ser verdadeira para todos os ciclos de Carnot. Além disso, aproximando um ciclo

reversível geral com uma série de ciclos de Carnot, podemos demonstrar que essa

equação é verdadeira para qualquer ciclo reversível, o que sugere que a razão Q/T pode

ter algum significado especial. Isso é, de fato, verdadeiro, como observaremos na

próxima discussão.

Considere qualquer processo infinitesimal para um sistema entre dois estados de

equilíbrio. Se dQr for o calor transferido quando o sistema segue uma trajectória

reversível entre os estados, a variação da entropia, independentemente da trajectória real

seguida, é igual a esse calor transferido ao longo da trajectória reversível dividido pela

temperatura absoluta do sistema:

dS =

dQr

T

(4.8)

O subscrito r no termo dQr é para lembrar que o calor deve ser determinado ao longo de

uma trajectória reversível, mesmo que o sistema possa realmente seguir alguma

trajectória irreversível. Assim, temos que ajustar um processo não reversível por meio

de um processo reversível entre os mesmos estados inicial e final para poder calcular a

70

variação da entropia. Neste caso, o modelo pode não ser totalmente próximo do

processo real, mas esta não é uma preocupação porque a variação da entropia depende

somente dos estados inicial e final. As únicas exigências são que o processo do modelo

deve ser reversível e deve conectar os estados iniciais e final dados.

Quando o calor é absorvido pelo sistema, dQr é positivo e, assim, a entropia

aumenta. Quando o calor é rejeitado pelo sistema, dQr é negativo e a entropia diminui.

Observe que a Equação 4.8 não define a entropia, mas a variação da entropia. Assim, a

quantidade significativa na descrição de um processo é a variação da entropia.

Com a Equação 4.8, temos uma representação matemática da variação da

entropia, mas não desenvolvemos nenhuma representação mental do seu significado.

Nesta e nas secções seguintes, exploramos diversos aspectos da entropia que permitirão

que obtenhamos dela uma compreensão conceptual.

A entropia originalmente encontrou seu lugar na termodinâmica, mas sua

importância cresceu tremendamente à medida que o campo da física chamado mecânica

estatística se desenvolveu, porque este método de análise forneceu uma maneira

alternativa de interpretar a entropia. Na mecânica estatística, o comportamento de uma

substância é descrito em termos do comportamento estatístico de seu grande número de

átomos e moléculas. A teoria cinética, que estudamos anteriormente, é um excelente

exemplo do enfoque da mecânica estatística. Um dos principais resultados desse

tratamento é o princípio de que sistemas isolados tendem à desordem e a entropia é

uma medida dessa desordem.

Para compreender essa ideia, introduzimos a definição de microestados e

macroestados de um sistema. Podemos fazê-lo observando um exemplo bem distante

da termodinâmica, jogar dados num casino. Para dois dados, um microestado é a

combinação particular dos números nas faces dos dados viradas para cima; por

exemplo, 1-3 e 2-4 são dois microestados diferentes (Figura 4.9). O macroestado é a

soma dos números. Assim, os macroestados para os dois microestados do exemplo são 4

e 6. Agora, aqui está a noção central de que necessitaremos para compreender a

entropia: o número de microestados associados a um determinado macroestado não

é o mesmo para todos os macroestados e o macroestado mais provável é aquele

como maior número de microestados possíveis. Um macroestado de 7 em nosso par

de dados tem seis microestados possíveis: 1-6, 2-5, 3-4, 4-3, 5-2 e 6-1 (Figura 4.10a).

Para um macroestado de 2, há somente um microestado possível: l-1 (Figura 4.l0b).

Assim, um macroestado de 7 tem seis vezes mais microestados que um macroestado de

2 e é, consequentemente, seis vezes mais provável. De facto, o macroestado 7 é o

macroestado mais provável para dois dados. O jogo de dados é construído em torno das

probabilidades de vários macroestados.

Figura 4.10. Dois diferentes microestados para uma jogada de dois dados. Estes

correspondem a dois macroestados que têm os valores de (a) 4 e (b) 6.

71

Considere o macroestado de baixa probabilidade 2. A única maneira de

consegui-lo é obter um valor 1 em cada dado. Dizemos que esse macroestado tem um

elevado grau de ordem – temos de obter um valor 1 em cada dado para que ele exista.

Figura 4.10. Possíveis microestados de dois dados para um macroestado de (a) 7 e (b)

2. O macroestado de 7 é mais provável porque existem mais formas de obtê-lo - mais

microestados são possíveis.

Entretanto, considerando os microestados possíveis para um macroestado de 7,vemos

seis possibilidades. Este macroestado é mais desordenado, porque são possíveis

diversos microestados que resultarão no mesmo macroestado. Assim, concluímos que

os macroestados de elevada probabilidade são macroestados desordenados e os

macroestados de baixa probabilidade são macroestados ordenados.

Como um exemplo mais físico, considere as moléculas no ar da sala de aula.

Vamos comparar dois macroestados possíveis. O macroestado 1 é a condição na qual as

moléculas de oxigénio e de nitrogénio estão uniformemente misturadas em toda a sala.

O macroestado 2 é aquele no qual as moléculas de oxigénio estão na metade dianteira

da sala e as moléculas de nitrogénio estão na metade traseira. A partir de nossa

experiência diária, podemos dizer que é extremamente improvável que o macroestado 2

exista. Por outro lado, o macroestado 1 é o que normalmente esperaríamos ver. Vamos

relacionar isso aos microestados, que correspondem às possíveis posições das moléculas

de cada tipo. Para o macroestado 2 existir, cada molécula de oxigénio teria de estar em

uma metade do quarto e cada molécula de nitrogénio na outra metade – uma situação

altamente ordenada e improvável. A probabilidade de ela ocorrer é infinitesimal. Para o

72

macroestado 1 existir, os dois tipos de moléculas estão simplesmente distribuídos de

maneira uniforme pelo quarto – este é um nível muito mais baixo de ordem e uma

situação altamente provável. Assim, o estado misturado é muito mais provável do que o

estado separado e é o que normalmente vemos.

Agora vamos tentar entender a ideia de que sistemas isolados tendem à

desordem. A causa dessa tendência à desordem pode ser observada facilmente. Para

qualquer energia dada do sistema, somente determinados microestados são possíveis ou

acessíveis. Vamos supor que todos os microestados são igualmente prováveis.

Entretanto, quando os macroestados possíveis associados com os microestados são

examinados, a grande maioria deles é de macroestados desordenados em vez de

macroestados ordenados. Como cada um dos microestados é igualmente provável, é

altamente provável que o macroestado real será um dos macroestados altamente

desordenados.

Vamos relacionar isso ao nosso exemplo dos dados. Uma grande diferença entre

dados e sistemas físicos é que, uma vez que um par de dados é jogado, o macroestado

está determinado e permanece determinado. Até que os dados sejam recolhidos e

jogados novamente, o resultado de uma determinada jogada está fixo no tempo. Por

outro lado, os sistemas físicos estão mudando constantemente no tempo. Vamos usar os

dados para modelar um sistema físico ao abanar repetida e violentamente a mesa onde

estão os dados, de tal forma que os resultados dos dados mudem a cada fracção de

segundo. À medida que observamos os macroestados dos dados por um longo período,

vemos que um 7 ocorre mais frequentemente do que um 2 ou um 12 porque o 7 pode ser

formado por um número maior de microestados do que um 2 ou um 12. Poderíamos

também interpretar esse fato dizendo que um 2 se transforma em um 7 mais

frequentemente do que um 7 se transforma em um 2. Assim, para o sistema de dois

dados, é mais provável que um macroestado menos provável se transforme em um

macroestado mais provável do que o contrário.

Em sistemas físicos, não estamos falando de duas moléculas; estamos falando de

um número de moléculas da ordem do número de Avogadro. Se você imaginar jogar o

número de Avogadro de dados, o jogo perderia o sentido – você poderia prever quase

perfeitamente o resultado quando todos os números nas faces dos dados viradas para

cima fossem somados (se os números nas faces dos dados fossem somados ao ritmo de

um dado por segundo, mais de 19 mil triliões de anos seriam necessários para calcular

os resultados de somente uma jogada!) porque você está lidando com as estatísticas de

um número enorme de dados. É com este tipo de estatística que temos de lidar quando

trabalhamos com um número de Avogadro de moléculas. O macroestado pode ser bem

previsto – mesmo que um sistema se inicie em um estado muito baixo de probabilidade

(por exemplo, as moléculas de nitrogénio e oxigénio que estejam separadas em um

quarto por uma membrana que é, então, perfurada); ele se transforma rapidamente em

um estado de elevada probabilidade (as moléculas misturam-se rápida e uniformemente

por todo o quarto).

Podemos agora apresentar isso como um princípio geral para processos físicos –

todos os processos físicos tendem a estados mais prováveis para o sistema e seus

arredores. O estado mais provável é sempre o estado de desordem mais elevada.

Agora, o que toda essa conversa sobre dados e estados tem a ver com entropia?

Para responder à pergunta, mostraremos que a entropia é uma medida da desordem de

um estado. Então, usaremos essas ideias para criar um novo enunciado da segunda lei da

termodinâmica.

Como já vimos, a entropia pode ser definida utilizando os conceitos

macroscópicos de calor e temperatura. A entropia também pode ser tratada de um ponto

73

de vista microscópico com a análise estatística de movimentos moleculares.

Utilizaremos um modelo microscópico para investigar a expansão livre de um gás ideal.

Na teoria cinética dos gases, as moléculas do gás são consideradas como

partículas que se deslocam de forma aleatória. Suponha que todo o gás está inicialmente

confinado a um lado de um recipiente de tal forma que o gás ocupe o volume Vi (Figura

4.11a). Quando a divisória que separa os dois lados do recipiente maior é removida, as

moléculas eventualmente serão distribuídas de alguma forma por todo o volume maior

Vf (Figura 4.11b). A natureza exacta da distribuição é uma questão de probabilidade.

Tal probabilidade pode ser determinada primeiramente encontrando-se as

probabilidades para a variedade das posições moleculares envolvidas no processo da

expansão livre.

Figura 4.11. Em uma expansão livre permite-se que o gás se expanda para ocupar um

volume maior indo para a região que anteriormente era vácuo.

Logo depois que a divisória é removida (e antes que as moléculas tenham a

oportunidade de rapidamente ocupar a outra metade do recipiente), todas as moléculas

estão no volume inicial Vi. Vamos estimar a probabilidade das moléculas chegarem a

uma determinada configuração com os movimentos aleatórios naturais dentro de um

volume maior Vf. Suponha que cada molécula ocupa um volume microscópico Vm e

cada posição desta molécula é igualmente provável. Assim, o número total de posições

possíveis desta molécula em um volume inicial macroscópico Vi é a razão w i= Vi/Vm,

que é um número enorme (ver Figura 4.12).

Vm

Figura 4.12. O número total de posições que uma molécula de volume Vm ocupa num

volume V (Vi ou Vf) é w = V/Vm.

Nesta expressão, utilizamos w para representar o número de maneiras de encontrar a

molécula no volume, e cada uma delas é um microestado.

74

À medida que mais moléculas são adicionadas ao sistema, os números de

microestados possíveis se multiplicam. Ignorando a pequena probabilidade de duas

moléculas ocuparem a mesma posição, cada molécula pode ir para qualquer uma das

(Vi/Vm) posições. Assim, o número de microestados possíveis para N moléculas é

N

Wi = wiN = (Vi / Vm ) . Embora um grande número de microestados possíveis possa ser

considerado invulgar (por exemplo, todas as moléculas num canto do espaço

disponível), o número total de microestados é tão grande que esses microestados

invulgares representam uma fracção infinitesimal de todos os microestados possíveis.

Similarmente, se o volume for aumentado para Vf o número de microestados aumenta

N

para W f = w Nf = (V f / Vm ) .

A probabilidade de um determinado macroestado é proporcional ao número de

microestados que correspondem ao macroestado. Assim, as probabilidades de

ocorrência de determinados macroestados iniciais e finais são Pi = cWi e Pf = cWf

onde a constante c foi deixada indeterminada. A razão entre essas probabilidades é

N

Vf

N

Pf cW f W f Vm

Vf

=

=

=

=

Pi

cWi Wi V N Vi

i

Vm

Tomando o logaritmo natural desta equação, sua multiplicação pela constante de

Boltzmann kB nos fornece

W

k B ln f

Wi

V

= nN Ak B ln f

Vi

onde escrevemos o número N das moléculas como nNA, o número de moles vezes o

número de Avogadro. Sabemos que NAkB é a constante universal dos gases R e, assim, a

equação pode ser escrita como

V

kB ln W f − kB ln Wi = nR ln f

(4.9)

Vi

Pelas considerações termodinâmicas macroscópicas (veremos este cálculo na Secção

4.7), sabemos que, quando um gás realiza uma expansão livre de Vi a Vf a variação da

entropia ∆S é

V

S f − Si = nR ln f

Vi

(4.10)

Observe que os lados direitos das Equações 4.9 e 4.10 são idênticos. Fazemos, assim, a

seguinte conexão entre a entropia e o número de microestados associados a um

determinado macroestado:

S ≡ k B ln W

(4.11)

75

Como os macroestados mais prováveis são os com maiores números de microestados e

os maiores números de microestados estão associados a mais desordem, a equação 4.11

nos mostra que a entropia é uma medida da desordem microscópica. Embora nossa

discussão tenha utilizado o exemplo específico da expansão livre de um gás ideal, um

desenvolvimento mais rigoroso da interpretação estatística da entropia conduz à mesma

conclusão.

4.6 Entropia e o Segundo Princípio da Termodinâmica

Como a entropia é uma medida da desordem e os sistemas físicos tendem para

macroestados desordenados, podemos afirmar que a entropia do Universo aumenta

em todos os processos naturais. Esta afirmação é uma outra maneira de enunciar a

segunda lei da termodinâmica.

Para calcular a variação da entropia para um processo finito, devemos

reconhecer que T geralmente não é constante. Se dQr é o calor transferido

reversivelmente quando o sistema está na temperatura T, então a variação da entropia

num processo reversível arbitrário entre um estado inicial e um estado final é

f

f

∆S = ∫ dS = ∫

i

i

dQr

T

(trajectória reversível)

(4.12)

A variação da entropia de um sistema depende somente das propriedades dos estados

inicial e final do equilíbrio porque a entropia é uma variável de estado, como a energia

interna. Isso é consistente com a relação entre entropia e desordem. Para um

determinado macroestado de um sistema, existe uma determinada quantidade de

desordem, medida por W, o número de microestados correspondentes ao macroestado.

Esse número não depende da trajectória seguida quando um sistema vai de um estado a

outro.

No caso de um processo adiabático reversível, nenhum calor é transferido entre

o sistema e o exterior e, consequentemente, ∆S = 0 . Como não ocorre nenhuma

variação da entropia, tal processo é frequentemente considerado como um processo

isentrópico.

Considere as variações da entropia que ocorrem numa máquina térmica de

Carnot que opera entre as temperaturas Tf e Tq. A Equação 4.7 nos diz que, para um

ciclo de Carnot,

∆S = 0

Considere agora um sistema realizando um ciclo reversível arbitrário. Como a entropia

é uma variável de estado e, assim, depende somente das propriedades de um

determinado estado de equilíbrio, concluímos que ∆S = 0 para qualquer ciclo

reversível. Em geral, podemos escrever esta condição na forma matemática

∆S = ∫

onde o símbolo

∫

dQr

=0

T

(4.13)

indica que a integração é sobre uma trajectória fechada.

76

Exemplo 4.3 Variação da Entropia – Processo de Fusão

Uma substância sólida que tem calor latente de fusão Lf derrete a uma temperatura Tf.

Calcule a variação da entropia quando uma massa m desta substância é derretida.

Solução

Vamos supor que o processo de fusão ocorre tão lentamente que pode ser considerado

um processo reversível – podemos inverter o processo extraindo calor muito lentamente

para congelar o líquido na forma sólida. Neste caso, a temperatura pode ser considerada

como constante e igual a Tf. Empregando a Equação 4.12 e o facto de que o calor latente

de fusão é dado por Q = mLf, obtemos

f

∆S = ∫

i

dQr

1

Q mL f

= ∫ dQ =

=

T

Tf

Tf

Tf

Observe que podemos colocar Tf fora da integral porque o processo de mudança de

estado é isotérmico.

4.7 Variações de Entropia em Processos Irreversíveis

Até aqui, calculamos variações da entropia usando a informação sobre uma trajectória

reversível que conecta os estados inicial e final de equilíbrio. Para calcular variações da

entropia para processos reais (irreversíveis), primeiro relembre que a entropia é uma

variável de estado. Assim, a variação da entropia quando um sistema se desloca entre

quaisquer dois estados de equilíbrio depende somente dos estados inicial e final.

Podemos calcular variações da entropia para processos irreversíveis encontrando

um processo reversível (ou uma série de processos reversíveis) entre os mesmos dois

estados de equilíbrio e calculando ∫ dQr / T para o processo reversível. Nos processos

irreversíveis, é de importância crítica distinguir entre Q, a transferência de calor real no

processo, e Qr o calor que seria transferido ao longo de uma trajectória reversível entre

os mesmos estados. Apenas o segundo valor fornece a variação correcta da entropia. Por

exemplo, como veremos, se um gás ideal se expandir adiabaticamente no vácuo, Q = 0,

mas ∆S ≠ 0 porque Qr ≠ 0. A trajectória reversível entre os mesmos dois estados é a

expansão reversível isotérmica que fornece ∆S > 0 .

Como veremos nos exemplos seguintes, a variação da entropia para o sistema

mais o exterior é sempre positiva para um processo irreversível. Em geral, a entropia

total (e a desordem) sempre aumenta nos processos irreversíveis. A partir dessas

considerações, a segunda lei da termodinâmica pode ser enunciada corno se segue: A

entropia total de um sistema isolado que realiza uma mudança não pode diminuir.

Além disso, se o processo for irreversível, a entropia total de um sistema isolado sempre

aumenta. Por outro lado, num processo reversível, a entropia total de um sistema

isolado permanece constante.

Ao lidar com corpos que interagem e que não estão isolados do ambiente,

devemos considerar a variação da entropia para o sistema e seu ambiente. Quando dois

corpos interagem em um processo irreversível, o aumento na entropia de uma parte do

Universo é maior do que a diminuição na entropia de outra parte. Assim, concluímos

que a variação na entropia do Universo deve ser maior que zero para um processo

irreversível e igual a zero para um processo reversível. Finalmente, a entropia do

77

Universo deve alcançar um valor máximo. Neste momento, o Universo estará em um

estado de temperatura e densidade uniformes. Todos os processos físicos, químicos e

biológicos cessarão porque um estado de desordem perfeita implica que nenhuma

energia está disponível para realizar trabalho. Esta situação triste é, às vezes,

denominada de "morte térmica" do Universo.

Variação da entropia numa expansão livre

Um gás ideal em um recipiente isolado inicialmente ocupa um volume Vi (veja a Figura

4.11). A divisória que separa o gás da região onde se fez vácuo é rompida de tal forma

que o gás se expande (irreversivelmente) até o volume Vf. Vamos encontrar a variação

da entropia do gás e do Universo.

O processo não é nem reversível nem quase-estático. É nulo o trabalho realizado

sobre o gás, e como as paredes são isolantes, nenhum calor é transferido durante a

expansão. Isto é, W = 0 e Q = 0. O primeiro princípio diz que a variação da energia

interna U é nula; consequentemente, Ui = U,f. Como o gás é ideal, U depende apenas da

temperatura e, assim, concluímos que Ti = Tf.

Para aplicar a equação 4.12, devemos encontrar Qr; isto é, devemos encontrar

uma trajectória reversível equivalente que compartilhe os mesmos estados inicial e final.

Uma escolha simples é uma expansão isotérmica reversível na qual o gás empurra

lentamente um pistão. Como T é constante neste processo, a equação 4.12 fornece

f

f

dQ

1

∆S = ∫ r = ∫ dQr

T

T i

i

Como este é um processo isotérmico, ∆Eint = 0 , e o primeiro princípio da

termodinâmica nos diz que o fornecimento de calor é igual ao negativo do trabalho feito

sobre o gás, dQr = – dW = P dV. Usando esse resultado, obtemos que

V

f

f

V

1

1

1 nRT

dV

∆S = ∫ dQr = ∫ PdV = ∫

dV =nR ∫

= nR ln f

T i

T

T V

V

Vi

Vi

(4.18)

Como Vf > Vi, concluímos que ∆S é positivo e, assim, a entropia e a desordem do gás (e

do Universo) aumentam em consequência da expansão irreversível adiabática.

Exemplo 4.4 Expansão Livre de um Gás Ideal

Considere outra vez a expansão livre de um gás ideal. Vamos verificar que os enfoques

macroscópicos e microscópicos conduzem à mesma conclusão. Suponha que 1 mol de

um gás ideal realiza uma expansão livre até atingir quatro vezes seu volume inicial. A

temperatura inicial e final são, como já vimos, as mesmas.

(a) Utilizando um enfoque macroscópico, calcule a variação da entropia.

(b) Encontre o número de maneiras em que todas as moléculas podem ser distribuídas

no volume original.

(c) Utilizando as considerações da alínea (b), calcule a variação da entropia para a

expansão livre e mostre que ela está em concordância com a alínea (a).

78

Solução

(a) Da Equação 4.14 obtemos

V

∆S = nR ln f

Vi

4V

= (1)R ln i = R ln 4

Vi

(b) Como já foi discutido anteriormente, o número de estados disponíveis para uma

única molécula no volume inicial Vi é wi = (Vi/Vm). Para um mol (NA moléculas), o

número de estados disponíveis é

V

Wi = wi N A = i

Vm

NA

(c) O número de estados para todas as NA moléculas no volume Vf = 4 Vi; é

Wi = wi

NA

V

= f

Vm

NA

4V

= i

Vm

NA

Da equação 4.9, obtemos

4V

∆S = k B ln W f − k B ln Wi = k B ln i

Vi

NA

NA

= kB ln (4)

= N AkB ln 4 = R ln 4

A resposta é a mesma da alínea (a), que lidou com parâmetros macroscópicos.

79