Artigo Científico 4 – Aplicações de Matemática e Física na Informática

Caroline de Souza Tidra

Informática – Manhã

[email protected]

•

Introdução

A Informática é uma tecnologia que abrange muitas áreas no mundo atual, e

provavelmente a tende a crescer cada vez mais o conhecimento alternativo que os caminhos

da Informática possibilitam. Por esse motivo e também por outros que vou abordar que

escolhi o tema aplicações de Matemática e Física na Informática para o meu artigo.

Neste artigo abordarei as aplicações de Matemática e Física mais usadas na

Informática no cotidiano atual. Primeiramente aplicações de Matemática, e após aplicações de

Física.

•

Aplicações de Matemática na Informática

A Matemática e a Informática têm construído uma relação em dois sentidos. A

Matemática tem contribuído assiduamente para o surgimento de novas tecnologias e

aperfeiçoamento tanto de computadores como das Ciências da Computação. E a Matemática

que está sempre em evolução pode fortemente influenciar a Informática, em várias áreas.

Para os computadores tudo são números. Números são números, letras são números,

sinais de pontuação são números, símbolos, até mesmo as instruções do próprio computador

são números. Os computadores não usam o nosso sistema numérico, são programados vários

sistemas numéricos distintos, sistema binário (base 2), sistema decimal (base 10) e sistema

hexadecimal (base 16).

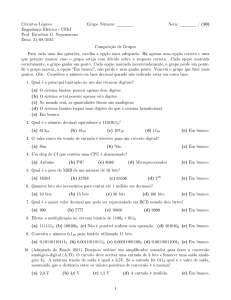

Sistema numérico Binário – Quando os computadores começaram a ser desenvolvidos,

o problema de armazenamento de dados foi um dos mais difíceis de solucionar. Baseado no

Código de Morse criou-se então condições de armazenamento de dados que são utilizados até

hoje. A CPU do computador é composta por pequenos interruptores, chamados de

transistores. Os transistores só podem guardar um dado: ligado ou desligado. Para o

computador o transistor fechado representa 1 binário, e o transistor aberto representa O.

Exemplo:

Notação decimal

0

1

2

3

4

5

6

7

Notação binária

0 (0 × 20 )

1 (1 × 20 )

10 (1 × 21 + 0 × 20)

11 (1 × 21 + 1 × 20)

100 (1 × 22 + 0 × 21 + 0 × 20)

101 (1 × 22 + 0 × 21 + 1 × 20)

110 (1 × 22 + 1 × 21 + 0 × 20)

111 (1 × 22 + 1 × 21 + 1 × 20)

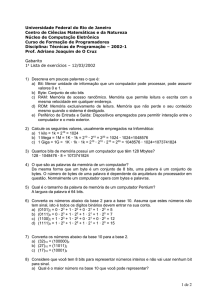

Sistema numérico Decimal – Sistema numérico utilizado desde a antiguidade. O

sistema binário de computação já era conhecido na China uns 3000 a.C., de acordo com os

manuscritos da época. Acredita-se que usamos esse sistema, por que temos dez dedos nas

mãos. O sistema decimal é um sistema de numeração de posição, ou seja, a ordem dos

algarismos que estamos acostumados a usar; 1, 2, 3, 4, 5, 6, 7, 8, 9, 0.

Sistema numérico Hexadecimal – Esse sistema foi idealizado como método para

representar todos os 1 e 0 que formam números binários de uma maneira mais fácil de ler,

escrever e compreender. Um hexa é capaz de representar qualquer combinação possível de 4

bits, portanto, como byte é composto por oito bits, qualquer byte pode ser representado por

exatamente dois dígitos em hexa. A matemática elementar nos ensinou que um número

comum na base 10, como 123, pode ser dividido e recombinado conforme na seguinte

maneira:

1 × 102 = 100

2 × 101 = 20

3 × 100 = 3

Somando é igual a 123.

O 1 em 123, representa o 100 que é 102, o 2 é realmente 20, ou seja, 2 × 10 e 3 é

apenas 3, ou seja, 3 × 1. Podemos fazer a mesma computação (123) com número demais com

benefício adicional encontra seu equivalente na base 10. A única diferença é que devemos

substituir o 10 por 16:

→ Em hexadecimal: 7 × 161 = 112

7 × 160 = 11

Somando é igual a 123.

→ Em Binário: 1 ×

= 64

1×

= 32

1×

= 16

1×

=8

2

0×2 =0

1× 21 = 2

1 × 20 = 1

Somando é igual 123.

Enfim, as aplicações de matemática são usadas na programação do computador e nós

nem reparamos, mas se não tivesse a programação binária, decimal e hexadecimal

provavelmente o computador não seria o mesmo atualmente.

•

Aplicações de Física na Informática

Aplicações de Física na Informática são difíceis de notar e também de achar, pois, o

computador é um mecanismo que se encontra mais programações por códigos e interface

gráfica. Então vou aborda uma pequena parte de um assunto que é novidade para mim, mas é

muito interessante.

Computação Quântica

Um computador quântico que é um dispositivo que executa cálculos fazendo o uso

direto de propriedade da mecânica quântica, como a teoria da sobreposição, ou seja, a

computação quântica nada mais é do que a aplicação das teorias e propriedades da mecânica

quântica ao computador.

Um computador quântico é construído a partir de fótons, nêutrons, prótons, elétrons,

são aquelas partículas presentes no átomo estudamos em química, ou seja, é de se imaginar

que os computadores quânticos possuirão um tamanho menor, em escala atômica.

— Recomendo este vídeo para que você entenda mais sobre Mecânica Quântica, e

como os elétrons agem em visão ampliada. Clique aqui para ver o vídeo!

Há grandes mudanças na criação de um computador quântico e computador normal.

“Na teoria, os computadores quânticos são imensamente mais

rápidos do que os computadores que temos hoje, mas a própria

física quântica possui seus limitadores. O fato de trabalhar com

partículas atômicas tornam possível a construção de computadores

que sejam tão pequenos a ponto de não serem visíveis a olho nu.

Enganam-se aqueles que pensaram que a velocidade de

processamento é similar ao tamanho. Os computadores quânticos

são centenas de milhares de vezes mais rápidos que todos os PCs e

notebooks que existem atualmente juntos. Tal velocidade se dá

justamente pela utilização de partículas atômicas em sua

construção, uma vez que elas possuem velocidade próxima à da

luz, e o processamento das informações poderia ser feito em total

paralelismo, e até mesmo em outra dimensão.” Por Elaine Martins.

Mas toda essa velocidade tem suas vantagens resolve problemas básicos atuais como,

por exemplo, a fatoração de números inteiros com milhares de bits, logaritmos e simulações

de física quântica. Para um computador normal isso demoraria muito, e a máquina teria que

ser um tamanho imensamente maior, portanto, é impossível um computador normal fazer algo

parecido com o computador quântico.

Um computador normal tem por sua informação menor o bit, e a computador

quântico também tem sua versão denominada Qubit. A principal diferença entre eles é a

capacidade de armazenamento. Enquanto o bit só possui estados de 1 ou 0, o qubit pode

possuir estados 1, 0 ou 1 e 0 ao mesmo tempo. Comparação de valores quânticos:

2 qubits = 4 bits

10 qubits = 1.024 bits

3 qubits = 8 bits = 1 byte

20 qubits = 1.048.576 bits

4 qubits = 16 bits

30 qubits = 1.073.741.824 bits

5 qubits = 32 bits

40 qubits = 1.099.511.627.776 bits

6 qubits = 64 bits

41 qubits = 2.199.023.255.552 bits

7 qubits = 128 bits

42 qubits = 4.398.046.511.104 bits

8 qubits = 256 bits

43 qubits = 8.796.093.022.208 bits = 1 terabyte

9 qubits = 512 bits

Exponencialmente cresce o número de bits conforme o número decimal qubit.

Matemática → f(x) =

Imagem Ilustrativa:

“Até o momento, apenas alguns elementos dos computadores

quânticos foram criados. Diversas universidades e empresas no

mundo se esforçam para a criação de uma máquina quântica que

demonstre com maior eficácia o poder de um computador. No

entanto, especialistas dizem que a concretização de um

computador quântico ainda está bem longe de acontecer, mesmo

que seja em pequena escala. No Brasil, há diversos núcleos de

pesquisa em universidades públicas (Rio de Janeiro e Paraíba).

Além disso, há pesquisadores trabalhando no desenvolvimento de

softwares quânticos, mas ainda não há resultados promissores.

Por enquanto, as versões desenvolvidas dos computadores

quânticos não possuem nenhuma aplicação comercial. Alguns

cientistas acreditam que as primeiras máquinas que estejam de

fato funcionando serão empregadas no meio acadêmico para

simulações da física e da mecânica quântica. Resta saber se as

empresas irão aceitar isto sem questionar.” Por Elaine Martins.

Enfim, computação quântica é uma das aplicações de física na informática que além

de obter vantagens incríveis, abre portas para um mundo de informações em uma escala

imensa a partir de um clique.

•

Considerações finais

Realmente as aplicações de matemática e física na informática abrangem muitos

assuntos, e esse artigo foi resumidamente às aplicações em informações de dados que são os

bits, byte ou até mesmo o qubit, como vimos na mecânica quântica.

Enfim, eu gostei muito desse assunto e gostaria de continuar e debater idéias com os

professores Aline de Bona e Humberto Oliveira e colegas do curso de Informática do IFRS

Campus Osório.

•

Glossário (palavras sublinhadas):

Código

de

de letras, números e

Morse

sinais

–

O Código

Morse é

de pontuação através

de

um

sistema

um

sinal

de

representação

codificado

enviado

intermitentemente. Foi desenvolvido por Samuel Morse em 1835, criador do telégrafo elétrico

(importante meio de comunicação à distância), dispositivo que utiliza correntes elétricas para

controlar eletroímãs que funcionam para emissão ou recepção de sinais.

Bits – Bit, menor unidade de informação que o computador entende. Possui dois

estados: ligado ou desligado, 0 ou 1, verdadeiro ou falso.

Byte – É a combinação de oito bits. Um caráter é um bit. Ex.: A.

Mecânica quântica – A mecânica quântica é a teoria física que obtém sucesso no

estudo dos sistemas físicos cujas dimensões são próximas ou abaixo da escala atômica, tais

como moléculas, átomos, elétrons, prótons e de outras partículas subatômicas, muito embora

também possa descrever fenômenos macroscópicos em diversos casos. A Mecânica Quântica

é um ramo fundamental da física e com vastas aplicações.

Qubits – Um qubit é semelhante ao bit, mas tem algumas diferenças. Como o bit, um

qubit pode ter dois possíveis estados 0 ou 1. A diferença é que enquanto um bit deve ser 0 ou

1, um qubit pode ser 0, 1, ou uma superposição de ambos.

•

Referências bibliográficas

Computador Quântico http://pt.wikipedia.org/wiki/Computador_qu%C3%A2ntico

Computação Quântica http://www.tecmundo.com.br/2666-e-hora-de-descobrir-ossegredos-da-computacao-quantica.htm

Qubit http://pt.wikipedia.org/wiki/Qubit

Mecânica Quântica http://pt.wikipedia.org/wiki/Mec%C3%A2nica_qu%C3%A2ntica