Instituto Politécnico de Coimbra

Instituto Superior de Engenharia de Coimbra

Departamento de Engenharia Informática e de Sistemas

Ferramentas de Business Intelligence

Open Source para PMEs

Marco Tereso

Mestrado em Informática e Sistemas

Coimbra, Dezembro, 2011

Instituto Politécnico de Coimbra

Instituto Superior de Engenharia de Coimbra

Departamento de Engenharia Informática e de Sistemas

Mestrado em Informática e Sistemas

Projecto Industrial

Relatório Final

Ferramentas de Business Intelligence

Open Source para PMEs

Marco Tereso

Orientador:

Dr. Jorge Bernardino

ISEC - DEIS

Coimbra, Dezembro, 2011

Agradecimentos

A conclusão desta dissertação é o culminar da realização de um grande objetivo. Este

foi o maior desafio ao nível académico e só se tornou possível graças ao grupo de

pessoas que diariamente me apoiaram e incentivaram. Como tal, deixo aqui os meus

agradecimentos:

Ao Professor Doutor Jorge Rodrigues Bernardino que orientou e acompanhou de forma

assídua o meu trabalho, tornando possível esta dissertação.

Aos meus pais, por todo o esforço que fazem diariamente e que sempre me

incentivaram a estudar.

À minha irmã, que me incentivou a entrar no ensino superior.

A todos os professores e colegas do Mestrado que directa ou indirectamente

contribuíram para a minha formação.

Ao Engº Jorge Vieira que se disponibilizou a apoiar o processo de implementação

prática num caso real.

E a todos os amigos de longa data que são inúmeros e teria uma lista infindável para

referir, sem esquecer as pessoas que mais de perto acompanharam todo este trajecto,

que prestaram um apoio essencial, mesmo preferindo o anonimato.

"Se não puder se destacar pelo talento, vença pelo esforço."

(Dave Weinbaum)

Ferramentas Open Source BI para PMEs

Resumo

RESUMO

Em época de contenção de despesas e oscilações constantes dos mercados, inovação e

otimização devem ser os fatores chave para o desbloqueio da economia. A sustentabilidade e

presença no mercado de pequenas e médias empresas é constantemente ameaçada face à

concorrência e competitividade apresentadas pelas grandes empresas. Uma das soluções para

o aumento da competitividade e rentabilidade das pequenas e média empresas é a aquisição de

ferramentas de Business Intelligence. Face às dificuldades de investimento encontradas, por

parte das empresas apresentamos no contexto do nosso trabalho um conjunto de ferramentas

de Business Intelligence open source que garantidamente apresentam qualidade suficiente

para servir interesses e necessidades de pequenas e médias empresas. O nosso trabalho

contempla uma investigação em torno de ferramentas Business Intelligence open source,

avaliando-as e comparando-as em diversos parâmetros. A nossa avaliação baseou-se

inicialmente na descrição das ferramentas e posteriormente na implementação e exploração

prática das mesmas. Os resultados preliminares são bastante atrativos e realçam a qualidade

das ferramentas de Business Intelligence open source analisadas. Para valorizar o nosso

trabalho recorremos à implementação de uma das ferramentas sobre um projeto numa PME,

com o principal objetivo de demonstrarmos na prática que a implementação destas

ferramentas é simples e é claramente viável. Em suma, as ferramentas de Business

Intelligence existentes no mercado constituem uma alternativa viável às soluções comerciais e

não envolvem gastos acrescidos. As ferramentas analisadas apresentam alguma maturidade, e

uma interface com o utilizador aceitável, traduzindo-se numa menor dificuldade de adaptação

por parte do utilizador. Em suma as ferramentas de Business Intelligence open source

representam uma solução alternativa viável perante as soluções comerciais, com a mais-valia

de serem gratuitas e não implicarem custos de aquisição por parte das empresas.

i

Ferramentas Open Source BI para PMEs

Resumo

ABSTRACT

In times of cost containment and constant fluctuations of markets, innovation and

optimization should be the keys to unlocking the economy. The market for small and medium

enterprises is constantly threatened in the face of competition and competitiveness made by

large companies. One solution to increase the competitiveness and profitability of small and

medium business is the acquisition of business intelligence tools. Given the difficulties of

business investment, we present in our work a toolkit of open source Business Intelligence. It

is guaranteed to have sufficient quality to serve the interests and needs of small and medium

enterprises. Our work includes one research about open source Business Intelligence tools,

evaluating them and comparing them on various parameters. Our assessment was initially

based on the description of tools and later in implementation. Preliminary results are very

attractive and allow highlight the quality of business intelligence tools open source analyzed.

To enhance our work we resorted to implementing one of the tools on a real project in an

SME, with the main objective to demonstrate in practice that the implementation of these

tools is simple and is clearly feasible. In short, the business intelligence tools on the market

are a viable alternative to commercial solutions and do not involve a big investment. The

analyzed tools have some maturity, and a user interface acceptable, translating into lower

difficulty of adaptation by the user. The open source Business Intelligence tools represent a

viable alternative before the paid solutions, with the advantage of being free and do not

involve acquisition costs, for companies.

ii

Ferramentas Open Source BI para PMEs

Palavras-Chave

Palavras-Chave

Open Source

Business Intelligence

PMEs

Data Warehousing

Keywords

Open Source

Business Intelligence

SMEs

Data Warehousing

i

Ferramentas Open Source BI para PMEs

Símbolos e Abreviaturas

ABREVIATURAS

AGPL – Affero General Public License

AJAX – Asynchronous Javascript and XML

API – Application Programming Interface

BAM - Business Activities Monitoring

BD – Base de Dados

BI – Business Intelligence

BIRT – Business intelligence Reporting Tools

BPM - Business Process Management

CE – Community Edition

CRM – Customer Relationship Management

CSS – Cascading Style Sheets

CSV – Comma-Separated Values

DBMS – Database Management System

DFSG - Debian Free Software Guidelines

DSP – Decision Studio Professional

DW – Data Warehouse

EJB – Enterprise Java Beans

ERP – Enterprise Resource planning

ETL - Extract, Transform, Load

FSF - Free Software Foundation

GEO – Geo-referenced

GIS - Geographic Information System

GPL – General Public License

HTML – Hypertext Markup language

IDE - Integrated Development Environment

J2EE – Java 2 Enterprise Edition

JDBC – Java Database Conectivity

JVM – Java Virtual Machine

JOLAP – Java Online Analytical Processing

JSP – Java Server Pages

KPI – Key Performance Indicator

MDX - Multidimensional Expressions

ODBC – Open Data Base Connectivity

OLAP – On-line Analytical Processing

ii

Ferramentas Open Source BI para PMEs

Símbolos e Abreviaturas

OLTP – Online Transaction Processing

OSI - Open Source Iniciative

PDF – Portable Document Format

PDI – Pentaho Data Integration

PHP – Hypertext Preprocessor

PMEs – Pequenas e médias empresas

POJO – Plain Old Java Objects

QBE - Query by Example

RDBMS – Relational Database Management System

ROI – Return On Investment

SaaS – Software as a Service

SGBD - Sistema de Gestão de Base de Dados

SI – Sistemas de Informação

SIG – Sistema de Informação Geográfica

SQL – Structured Query Language

SWF - Shockwave Flash

TOS – Talend Open Studio

UE – União Europeia

XML - Extensible Markup Language

XMLA – Extensible Markup Language for Analysis

WCAG - Web Content Accessibility Guidelines

WEKA - Waikato Environment for Knowledge Analysis

iii

ÍNDICE

CAPÍTULO 1 - INTRODUÇÃO

CAPÍTULO 2 - ESTADO DA ARTE

CAPÍTULO 3 - BUSINESS INTELLIGENCE

3.1 - Descrição do conceito de Business Intelligence

3.1.1 - Benefícios e Objetivos

3.1.2 – Vantagens

3.1.3 – Desvantagens

3.1.4 - Fracassos de BI

3.1.5 - Arquitetura de BI

3.2 - Propriedades de BI

3.2.1 - Data Warehouse

3.2.2 - Data Marts

3.2.3 – Metadados

3.2.4 – ETL

3.2.5 - Cubos de dados

3.2.6 – OLAP

3.2.6.1 - Arquiteturas OLAP

3.2.6.2 - Elementos OLAP

3.2.7 – Dashboards

3.2.8 - Data Mining

3.2.9 - GEO/GIS

3.2.10 – KPIs

3.2.11 - Importação e Exportação de dados

3.2.12 – OLTP

3.2.13 – Relatórios

CAPÍTULO 4 – SOFTWARE OPEN SOURCE E PMES

4.1 - Vantagens do Software Open Source

4.2 - Desvantagens do Software Open Source

4.3 - Onde encontrar Software Open Source?

4.4 – Descrição de PME

CAPÍTULO 5 - FERRAMENTAS BI OPEN SOURCE

5.1 - Suites BI Open Source

5.1.1 – JasperSoft

5.1.2 – OpenI

5.1.3 – Palo

5.1.4 – Pentaho

5.1.5 – SpagoBI

5.1.6 – Vanilla

5.2 – Comparação entre as ferramentas Suite BI Open Source

1

5

9

9

10

11

12

13

14

15

15

15

16

17

17

18

19

20

21

21

22

23

23

23

23

25

26

27

27

30

33

33

33

36

38

40

42

45

47

i

5.3 - Outras Ferramentas BI

5.3.1 – Eclipse BIRT

5.3.2 – Mondrian

5.3.3 – Kettle

5.3.4 – Jpivot

5.3.5 – Weka

5.3.6 - RapidMiner

CAPÍTULO 6 - AVALIAÇÃO PRÁTICA DAS FERRAMENTAS

6.1. – Instalação de requisitos comuns às quatro ferramentas

6.2 – Instalação de JasperSoft

6.3 – Instalação de Pentaho

6.4 – Instalação de SpagoBI

6.5 – Instalação de Vanilla

6.6 - Avaliação técnica das ferramentas

6.6 - Conclusão da avaliação

CAPÍTULO 7 - IMPLEMENTAÇÃO NUMA PME

7.1 - Instalação de Pentaho em Windows

7.2 - Construção da Data Warehouse

7.2.1 - Descrição do negócio

7.2.2 - Objectivo

7.2.3 - Desafio

7.2.4 - Estratégia

7.2.5 - Questões às quais a DW deve conseguir responder

7.2.6 - Granularidade

7.2.7 - Identificação de estrelas e dimensões

7.2.8 - Tabela de factos Factos_Energy

7.2.9 - Dimensão Park

7.2.10 - Dimensão Element

7.2.11 - Dimensão Time

7.2.12 - Tabela de factos Factos_Average

7.2.13 - Dimensão Incident

7.2.14 - Dimensão Responsability

7.2.15 - Gerar código MySQL para a construção da DW

7.3 - Processo de ETL

7.3.1 - Dimensão Park

7.3.2 - Dimensão Element

7.3.3 - Dimensão Responsability

7.3.4 - Dimensão Incident

7.3.5 - Dimensão Time

7.3.6 Tabela de factos Factos_Energy

ii

50

50

51

52

53

53

54

57

57

59

60

62

63

64

69

71

71

73

82

82

82

82

82

83

83

86

86

87

87

87

88

89

89

89

90

94

97

99

102

103

7.3.7 - Tabela de factos Factos_Average

7.4 - Construção de cubos OLAP

7.4.1 - Linguagem MDX

7.4.2 - PAT Analysis Tool

7.4.2.1 - Instalação de PAT Plugin 0.8 no Pentaho CE 3.8

7.4.2.2 - Criação de análises com PAT Analysis

7.4.2.3 - Exemplos práticos do projeto utilizando PAT Analysis

7.4.3 - Saiku

7.4.3.1 Instalação de Saiku 2.0 no Pentaho BI Server CE 3.8

7.4.3.2 - Exemplos práticos do projeto utilizando Saiku

7.4.4 - Pentaho Mondrian

7.5 - Criação de dashboards

7.5.1 - Instalação CDF-DE

7.6 - Criação de relatórios

CAPÍTULO 8 - CONCLUSÕES E TRABALHO FUTURO

REFERÊNCIAS

ANEXOS - A

Open Source Business Intelligence tools for SMEs

ANEXOS - B

Commercial or open source business intelligence tools?

ANEXOS - C

Open Source CRM Systems for SMEs

ANEXOS - D

Top Busines Intelligence Software for Small and Medium Enterprises

ANEXOS - E

Better Decisions With Open Source Business Intelligence Tools

106

109

109

110

111

111

112

115

115

115

117

119

120

125

131

135

139

147

153

167

171

iii

ÍNDICE DE FIGURAS

Figura 3.1. Ilustração da pirâmide de processos de Business Intelligence

Figura 3.2. Arquitetura de processos de Business Intelligence

Figura 3.3. Cubo tridimensional com o total de vendas

Figura 4.1. Gráfico da percentagem dos tipos de empresas a nível Mundial

Figura 5.1. Arquitectura JasperSoft

Figura 5.2. Relatório JasperSoft

Figura 5.3. Arquitectura da aplicação OpenI

Figura 5.4. Elementos gráficos OpenI

Figura 5.5. Ambiente Microsoft Excel composto do separador Palo

Figura 5.6. Conjunto de funcionalidades Pentaho

Figura 5.7. Ilustração de funcionalidades GEO de Pentaho

Figura 5.8. Conjunto de funcionalidades SpagoBI

Figura 5.9. Painel de visualização SpagoBI

Figura 5.10. Painel de visualização Vanilla

Figura 5.11. Painel de visualização Vanilla

Figura 5.12. Versão de Vanilla a correr em dispositivos móveis

Figura 5.13. Ambiente de trabalho Eclipse BIRT

Figura 5.14. Ambiente de trabalho Mondrian

Figura 5.15. Ambiente de trabalho Pentaho Data Integration (PDI)

Figura 5.16. Representação de um cubo de dados e respetivo gráfico em JPivot

Figura 5.17. Ilustração de um exemplo de uma análise Weka

Figura 5.18. Análise de Data Mining

Figura 6.1. Percentagem de referências encontradas, relativamente a cada ferramenta

Figura 7.1. Configuração da variável JAVA_HOME

Figura 7.2. Configuração da variável JRE_HOME

Figura 7.3. Servidor Pentaho BI CE 3.8 instalado com sucesso

Figura 7.4. Opção de Reverse Engineer

Figura 7.5. Escolha do tipo de base de dados a converter

Figura 7.6. Selecção do script SQL da base de dados

Figura 7.7. Progresso da ação de Reverse Engineer

Figura 7.8. Modelo físico da base de dados

Figura 7.9. Opção de Seleção de tipo de base de dados actual e futuro

Figura 7.10. Seleção do tipo da nova base de dados

Figura 7.11. Seleção da opção para gerar a nova base de dados

Figura 7.12. Escolha de diretório e nome do ficheiro

Figura 7.13. Ficheiro gerado

Figura 7.14. Script base dados em Bloco de Notas

Figura 7.15. Ambiente de trabalho da ferramenta HeidiSQL 6.0

iv

10

14

18

30

36

36

37

38

39

41

42

43

45

46

46

47

51

52

52

53

54

55

70

72

72

73

74

75

76

76

77

78

78

79

79

80

80

81

Figura 7.16. Modelo concetual da DW

84

Figura 7.17. Modelo físico da DW

85

Figura 7.18. Tabela de factos “Factos_Energy”

86

Figura 7.19. Dimensão Park

86

Figura 7.20. Dimensão Element

87

Figura 7.21. Dimensão Time

87

Figura 7.22. Tabela de factos, Factos_Average

88

Figura 7.23. Dimensão Incident

88

Figura 7.24. Dimensão Responsability

73

Figura 7.25. Esquema de ETL de carregamento da dimensão Park

90

Figura 7.26. Ilustração do elemento tMap_1

92

Figura 7.27. Constituição da dimensão Park da DW.

92

Figura 7.28. Ilustração dos dados visíveis através do visualizador de dados

93

Figura 7.29. Ficheiro Excel gerado pelo processo de ETL

93

Figura 7.30. Esquema do processo ETL da dimensão Element

94

Figura 7.31. Representação do elemento tMap_1

96

Figura 7.32. Dimensão Element

96

Figura 7.33. Processo de ETL para a dimensão responsability

97

Figura 7.34. Representação do elemento tMap_1 do processo de ETL

98

Figura 7.35. Dimensão Responsability

99

Figura 7.36. Modelo de ETL da dimensão Incident

99

Figura 7.37. Representação do elemento tMap_1

100

Figura 7.38. Definição de uma expressão para obter o valor da duração de tempo 101

Figura 7.39. Dimensão Incident

101

Figura 7.40. Processo de ETL da tabela de factos factos_energy

103

Figura 7.41. Representação do elemento tMap_2

105

Figura 7.42. Ilustração do elemento tMap_1

106

Figura 7.43. Tabela de factos “factos_energy”

106

Figura 7.44. Processo de ETL da tabela de factos factos_average

107

Figura 7.45. Representação do elemento tMap_2

107

Figura 7.46. Representação do elemento tMap_1

108

Figura 7.47. Tabela de factos factos_average

108

Figura 7.48. Visualização dos dados com o elemento tLogRow_1

109

Figura 7.49. Ícones do ambiente de trabalho de Pentaho

111

Figura 7.50. Ambiente de trabalho PAT Analysis

112

Figura 7.51. Cubo de dados por dia por hora

113

Figura 7.52. Valores de radiação solar por dia por hora

114

Figura 7.53. Quantidade de incidentes por estado

114

Figura 7.54. Ícone Saiku no ambiente de trabalho de Pentaho

115

Figura 7.55. Ambiente de trabalho Saiku

116

v

Figura 7.56. Ícone New Analysis View no ambiente de trabalho de Pentaho

117

Figura 7.57. Janela para seleção de cubo de dados

118

Figura 7.58. representação OLAP com a ferramenta do servidor 3.8

118

Figura 7.59. Ambiente de trabalho Pentaho atualizado com a nova funcionalidade

CDE

121

Figura 7.60. Ambiente de trabalho de CDE.

121

Figura 7.61. Seleção de um Template existente disponível no plugin.

122

Figura 7.62. Separador Components

123

Figura 7.63. Representação do separador Data Sources.

123

Figura 7.64. Dashboards do caso prático.

124

Figura 7.65. Primeiro passo para a contrução de um relatório de dados

126

Figura 7.66. Segundo passo para a criação de um relatório

126

Figura 7.67. Terceiro passo para a criação de um relatório de dados.

127

Figura 7.68. Quarto passo para a criação de um relatório

128

Figura 7.69. Ilustração do relatório produzido no formato de HTML.

128

Figura 7.70. Ilustração do relatório produzido no formato PDF.

129

vi

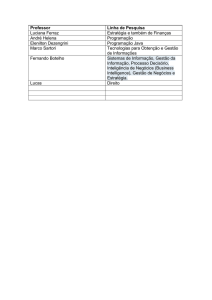

ÍNDICE DE TABELAS

Tabela 3.1. Demonstração elementos OLAP

Tabela 4.1. Características das PME

Tabela 5.1 Comparação de funcionalidades

Tabela 5.2. Comparação das ferramentas quanto à linguagem de programação

de desenvolvimento

Tabela 5.3. Tipo de sistemas operativos que suportam as ferramentas

Tabela 5.4. Comparação das ferramentas relativamente às suas versões disponíveis

Tabela 5.5. Informações relevantes de cada uma das ferramentas

Tabela 6.1. Avaliação das funcionalidades de BI e caraterísticas das ferramentas

Tabela 6.2. Distribuições e suporte

Tabela 6.3. Avaliação quanto aos tipos de base de dados suportados

Tabela 6.4. Funcionalidades OLAP

Tabela 6.5. Funcionalidades de Dashboards

Tabela 6.6. avaliação aos elementos de KPIs

Tabela 6.7. avaliação das caraterísticas dos relatórios

Tabela 6.8. Avaliação do portal quanto à internacionalização

Tabela 6.9. Classificação das ferramentas na escala de 1 a 5

Tabela 6.10. Classificação das ferramentas de 1 a 4 tendo em conta a preferência

Tabela 7.1. Arquitectura da DW a construir

19

30

47

48

48

49

49

64

65

65

66

67

67

67

68

68

69

83

vii

CAPÍTULO 1

1. INTRODUÇÃO

Os graves problemas económicos que afetam atualmente a economia global, conduzem à

instabilidade dos mercados. As tendências de oscilação da economia mundial são um

entrave à inovação e ao desenvolvimento das empresas, face à incapacidade de

investimento e à insegurança demonstrada relativamente à sua rentabilização. Os fatores

condicionantes da estabilidade da economia obrigam todo o tecido empresarial a fazer

esforços de contenção na despesa e à redução dos custos da atividade. Focando a nossa

visão sobre o continente europeu, somos constantemente confrontados com informações

que nos revelam o atual estado caótico da economia europeia. O crescimento económico

caminha de mãos dadas com a produção e as exportações, na ausência destes dois fatores

não existe crescimento económico.

Face aos elevados custos de produção, resultantes da atividade laboral diária das

empresas, e face às várias medidas de austeridade que vigoram em alguns países da união

europeia, torna-se difícil para as empresas produzirem em larga escala e a preços que

permitam competir com os preços apresentados pelos produtos comercializados pelos

mercados externos e pelas grandes empresas. A incapacidade de investimento por parte

das pequenas e médias empresas (PMEs) na otimização dos seus processos de negócio,

representa um grave problema. A produção em larga escala muitas vezes contrapõe-se

com a necessidade de investir e inovar nos métodos de trabalho e de produção, é a estes

investimentos que na generalidade as empresas não se expõem, faltando-lhes a

capacidade para investir, otimizar e rentabilizar o seu negócio. Os fatores de fixação no

mercado das PMEs bem como a sua rentabilidade, estão diretamente relacionados com a

sua capacidade de produção em larga escala, e com a sua capacidade de resposta.

As grandes empresas de um modo geral não têm problemas de inovar e investir porque

normalmente têm capacidade económica para o fazerem, mas, representam uma

percentagem reduzida de todo o conjunto empresarial.

O contexto do nosso trabalho são as PMEs, focando-nos nas dificuldades apresentadas

pelas PMEs em fixarem-se de forma sólida no mercado e em competir com as grandes

empresas. Com isto, o nosso trabalho tem como principal objetivo apresentar soluções

viáveis para PMEs, que representam 99,9 % do número total de empresas portuguesas,

98% da totalidade das empresas da União Europeia (UE a 27) (ECEI, 2010/2011) e mais

de 98% das empresas à escala mundial (Global Alliance of SMEs, 2010). Atendendo a

estes números é fácil perceber a importância das PMEs e qual o nosso interesse de

solucionar medidas de rentabilidade e crescimento, tendo em conta alguns fatores

1

CAPÍTULO 1

especiais como a incapacidade destas empresas em investir, diminuir os custos resultantes

da sua atividade de produção e aumentar os seus lucros.

Neste contexto pretendemos solucionar parte das dificuldades de otimização e melhoria

dos processos de negócio das empresas. Para isto, sugerimos a adoção de práticas e

ferramentas de Business Intelligence (BI). O conceito de BI não é novo, mas só nos

últimos anos tem conhecido uma maior divulgação e aceitação junto das empresas. O

recurso a práticas de BI subentende que existam dados provenientes da atividade

empresarial, que se possam processar de forma a obter informação e conhecimento

capazes de suportar o apoio a tomada de decisão por parte de gestores e analistas de

negócio. Os dados resultantes da atividade empresarial são a matéria-prima de processos

e ferramentas de BI. As ferramentas de BI têm como principal objetico o cruzamento dos

dados da atividade económica e exibindo-os de forma gráfica. O recurso a ferramentas BI

permite através do cruzamento de dados extrair informações relevantes (p.ex: no sector

das energias renováveis, identificar qual a localização do parque eólico que produz mais

energia), identificar problemas no processo de negócio (p.ex: identificar qual a marca de

motores das torres eólicas que apresentam maior taxa de indisponibilidade), estes dois

exemplos permitem gestores e analistas de negócio tomar decisões (p.ex: reforçar os

parques que produzem mais; adquirir motores das marcas que apresentam maior taxa de

atividade).

Tendo em conta o custo das ferramentas de BI comerciais, dificilmente suportados por

PMEs, focaremos a nossa investigação essencialmente em ferramentas open source. As

ferramentas open source são desenvolvidas por comunidades de programadores sem fins

lucrativos, que se dedicam à produção de software seguindo um conjunto de regras

estabelecidas pela OSI (Open Source Iniciative), de entre as quais a disponibilização de

software de forma gratuita. A disponibilização do código para a comunidade por parte das

comunidades de desenvolvimento open source permite solucionar em parte a capacidade

de investimento por parte das PMEs. Apesar do foco do nosso trabalho ser essencialmente

a divulgação de ferramentas de BI open source, existe no mercado inúmeras ferramentas

que apresentam uma alternativa de qualidade às ferramentas comerciais (p.ex: Mozilla

Firefox, MySQL, PHP, Open Office).

Após a investigação e a análise às ferramentas de BI open source existentes no mercado,

iremos analisar e comparar um conjunto de ferramentas elegendo as melhores, mediante

um plano de avaliação. Para justificarmos que as ferramentas de BI open source são

viáveis iremos proceder à demonstração prática da utilização de uma ferramenta, Pentaho,

num projeto empresarial de âmbito real. A nossa demonstração prática detalha todos os

passos da implementação de uma ferramenta de BI, tais como: a construção de uma Data

Warehouse (DW); especificação de processos de ETL (Extract, Transform, Load); criação

de cubos de dados OLAP (On-Line Analytical Processing); criação de dashboards;

criação de relatórios de dados.

2

CAPÍTULO 1

A demonstração prática do nosso trabalho tem por base sustentar a nossa conclusão, de

que as ferramentas de BI open source apresentam uma solução claramente viável e que

permite a inovação, desenvolvimento e otimização dos processos de negócio das

empresas. Se por um lado a aquisição de software BI open source não implica custos, a

sua implementação e utilização podem significar alguns custos para as empresas, tendo

em conta que as ferramentas requerem utilizadores que possuam conhecimentos base de

informática, especialmente nas áreas de base de dados, Data Warehousing, ETL e OLAP.

As comunidades de desenvolvimento de ferramentas BI open source ao longo dos últimos

anos têm tentado acompanhar os desenvolvimentos das ferramentas comerciais.

Destacamos que um dos maiores desenvolvimentos está relacionado com o aumento da

facilidade de interação com o utilizador. As versões mais recentes apresentam uma

interação com o utilizador mais amigável, incluindo funcionalidades de drag and drop em

alguns processos. Face a este desenvolvimento reconhecido, prevemos que num curto

período de tempo as ferramentas de BI open source, se tornem ainda mais fáceis de

utilizar e estejam acessíveis a qualquer utilizador sem conhecimentos base de informática.

1.1. Principais Contribuições deste trabalho

O principal objetivo do nosso trabalho é contribuir para o avanço da ciência e do

conhecimento. Neste contexto, identificámos um problema, a necessidade de rentabilizar

e otimizar o processo de negócio das PMEs. Identificado o problema vamos tentar. De um

modo geral as nossas principais contribuições do nosso trabalho são:

•

•

•

•

•

•

•

•

•

•

Solucionar a redução de custos da atividade normal das PMEs.

Identificar um problema que apresenta facilidade de retorno sobre o investimento.

A divulgação da importância do conceito de BI.

Divulgação de ferramentas open source como uma solução viável para o

problema.

A demonstração prática da utilização de ferramentas open source e consequentes

avaliações.

Comparação prática de várias ferramentas BI, e consequente avaliação.

Apresentar um conjunto de elementos que suporte a escolha de ferramentas open

source como uma opção de redução de custos.

Ajudar na decisão do processo de aquisição.

Apoiar os processos de implementação e desenvolvimento.

Mostrar que as ferramentas BI open source são claramente uma solução

alternativa às ferramentas comerciais.

De um modo geral são estas as contribuições que pretendemos acrescentar com o

desenvolvimento desta investigação.

3

CAPÍTULO 1

1.2. Estrutura do relatório

Este trabalho encontra-se estruturado em oito capítulos. O capítulo atual, é o capítulo

introdutório no qual procurámos descrever o problema, e apresentar a nossa solução para

a resolução do mesmo.

O capítulo 2, estado da arte, tem como por base a divulgação de outros trabalhos

desenvolvidos na área e que de certa forma suportaram (através da sua informação) e

incentivaram o desenvolvimento do nosso trabalho, pretendendo dar a conhecer outros

trabalhos relacionados.

O capítulo 3 apresenta uma descrição detalhada sobre o conceito de Business Intelligence

e todas as suas propriedades. É feita ainda referência aos benefícios e objetivos da

utilização de BI, vantagens, desvantagens e fracassos.

O capítulo 4 apresenta uma descrição base sobre software open source e sobre PMEs, que

são o foco do nosso trabalho. Neste capítulo são apresentadas vantagens e desvantagens

do software open source e ainda referência aos repositórios Web onde é possível adquirir

software open source.

O capítulo 5 apresenta um estado da arte relativamente aos pacotes de soluções de BI

open source, comparação das ferramentas e ainda uma secção de ferramentas auxiliares,

especificas para determinados processos.

No capítulo 6 procede-se à descrição dos processos de instalação dos quatro melhores

pacotes de ferramentas, consequente avaliação técnica e uma conclusão da avaliação da

qual resulta a eleição da melhor ferramenta BI open source que será utilizada para

implementação no caso prático.

O capítulo 7 apresenta todos os passos de implementação prática de uma ferramenta de BI

open source numa PME. Este é o capítulo mais extenso e que descreve em detalhe a

construção de uma DW, a implementação de processos de ETL, a construção de cubos de

dados OLAP, a criação de relatórios e a utilização de plugins para os processos de criação

de cubos de dados e dashboards.

Por fim, o capitulo 8, apresenta as conclusões a nível prático e teórico de todo o

desenvolvimento do nosso trabalho.

De referir ainda a existência do capítulo 9 de referências e em anexo um conjunto de

cinco artigos científicos desenvolvidos e publicados no âmbito do nosso trabalho de

investigação.

4

CAPÍTULO 2

2. ESTADO DA ARTE

O trabalho desenvolvido em torno da área da nossa investigação é um pouco escasso,

existindo poucas referências bibliográficas no contexto da nossa investigação.

Ainda assim destacamos alguns trabalhos nesta área de investigação. Num trabalho de

investigação, Christian Thomsen e Torben Pedersen identificaram que se notava um

aumento de empresas a procurarem soluções de BI open source, mas que a confiança

sobre este tipo de ferramentas estava um pouco aquém, quando comparada com a

aceitação registada em torno de ferramentas open source de outras áreas (Thomsen &

Pedersen, 2008). A sua investigação procurou classificar as soluções de BI existentes no

mercado, avaliando os seus aspetos técnicos e a mais-valia que estas representam. Nesta

investigação foram comparadas dez ferramentas de ETL, seis sistemas de gestão de bases

de dados (SGBD), dois servidores OLAP e sete ferramentas cliente OLAP.

Os mesmos autores desenvolveram uma investigação semelhante no ano 2005 e

procuraram comparar a evolução das ferramentas durante esse período de tempo.

Relativamente ao tipo de ferramentas em análise os autores definem os SGBDs como as

ferramentas open source mais desenvolvidas e que maior número de funcionalidades

adquiriram durante aquele período de tempo. Relativamente às ferramentas de ETL

identificam a existência de uma evolução clara nas suas funcionalidades. Relativamente

aos servidores OLAP identificam Mondrian como melhor ferramenta disponível, quanto

às ferramentas cliente OLAP defendem que existe várias ferramentas no mercado ainda

que se apresentem pouco desenvolvidas.

Numa publicação da Pentaho (Pentaho, 2008), a comunidade alerta para o facto de as

empresas estarem a procurar a aquisição de ferramentas BI como solução para a

rentabilização dos seus processos de negócio sem a certeza de se as ferramentas que estão

a adquirir são as mais indicadas para os seus processos de negócio. O problema

identificado pela comunidade é que, gestores de negócio se deixam levar pelas

campanhas de marketing por parte das empresas que produzem ferramentas BI, sem

avaliar se as caraterísticas das ferramentas suportam as suas necessidades, ação que

muitas vezes se traduz em maus investimentos. Desta forma, Pentaho tenta alertar os

mercados para o facto das soluções open source terem como vantagem o facto de

poderem ser alteradas à medida do negócio e por outro lado a facilidade de mudar de

ferramenta sempre que se justifique, sem que isso traduza perdas excessivas.

Por sua vez, Matteo Golfarelli desenvolveu uma investigação (Golfarelli, 2009), que

identificou a desconfiança dos mercados perante a potencialidade das soluções de BI open

source como alternativa às ferramentas comerciais. O objetivo da sua investigação era

avaliar quais as potencialidades das ferramentas de BI open source e quais os limites da

sua adoção em projetos reais. Golfarelli procurou desta forma avaliar se o contexto de

5

CAPÍTULO 2

software open source representaria uma alternativa válida às plataformas comerciais na

área de BI. Para fundamentar a sua investigação recorreu à análise de três pacotes de

soluções de BI open source, sendo eles: JasperSoft, Pentaho e SpagoBI (versões

disponíveis até dezembro de 2008). Golfarelli na sua investigação não procurou medir

resultados de eficiência mas procurar uma resposta para o seu problema relativamente à

viabilidade da sua aplicação em ambientes reais. As conclusões a que chegou foi que o

principal defeito das soluções de BI open source é a ausência de uma camada de

Metadados. Da comparação entre as ferramentas concluiu que face à versão comercial a

versão open source de Pentaho poderia ser mais abrangente e que a versão SpagoBI open

source é idêntica à versão comercial das ferramentas Pentaho e SpagoBI. Num outro tipo

de análise referiu que PMEs procuram cada vez mais a aquisição de software deste tipo

para colmatar despesas. Identifica ainda que a prematuridade, permanência no mercado e

evolução levantam dúvidas no mercado, defendendo que um 20 anos de conhecimento

nesta área e a experiência poderão fazer a diferença no futuro.

Em (JasperSoft, 2009) é descrita uma análise interessante, sustentada por um estudo

(Ventana Research, 2006) que concluiu que 48% dos inquiridos esperam que a

implementação de ferramentas open source BI signifiquem um corte de 50% nas

despesas, quando comparada com o custo das ferramentas comerciais. O mesmo estudo

refere ainda que 25% dos inquiridos estimam que os custos dispendidos com os dois tipos

de software sejam equivalentes. O estudo (JasperSoft, 2009) procura apresentar resultados

relativamente aos custos ocultos da implementação de ferramentas de BI open source e

comparar com os custos das ferramentas comerciais, verificando se as ferramentas open

source são uma alternativa viável. Deste estudo o autor conclui que a implementação de

do conceito BI tem significado um grande investimento de alto retorno, considerando que

os preços de software das versões comerciais se têm tornado um entrave para aquisição

por parte das empresas. O autor conclui ainda que a implementação de ferramentas de BI

open source em empresas constituídas por equipas ágeis e com conhecimentos poderão

significar pouco investimento e um maior retorno sobre o investimento. A distribuição do

código permite a empresas com conhecimentos na área de informática adaptarem o

software tendo em conta as necessidades das empresas, construindo desta forma uma

solução viável e funcional sem grandes investimentos.

No mesmo contexto, destacamos também (Damiani et al., 2009) que identificaram a

ausência de documentação relativamente ao conjunto de soluções de BI no mercado,

destacando que o trabalho de investigação existente na área se prendia com comparações

das funcionalidades das ferramentas. Posto isto, os autores apresentam uma visão geral

sobre as diversas ferramentas e frameworks relacionadas com a área de BI, descrevendo

um caso prático, modelos de custo e o seu risco de adoção. No âmbito da sua investigação

os autores referem que um dos principais problemas das versões comerciais para o

cliente, prende-se com o facto de antes do cliente obter resultados já efetuou gastos

dispendiosos com a aplicação, enquanto que ao implementar soluções open source pode

6

CAPÍTULO 2

controlar o seu investimento à medida que vai obtendo resultados. Os autores concluem

que os fatores de risco relacionados com a implementação de soluções de BI open source,

são o facto de não conterem trabalhadores com conhecimentos de informática na sua

estrutura empresarial e o receio de que os projetos sejam desapoiados/abandonados.

É importante perceber quais os valores que pretendemos poupar na implementação de

ferramentas open source que possam substituir ferramentas comerciais, em (Ferreita et

al., 2010) é efetuada uma análise comparativa entre as principais ferramentas comerciais e

open source mediante vários critérios, de entre os quais o valor dos custos de aquisição

entre uma das principais ferramentas comercial, Microsoft e a ferramenta gratuita

Pentaho. Segundo esse estudo, os custos com a ferramenta comercial rondam os 25.000

reais o que equivale a cerca de 10.000 euros. Uma quantia que pesa no orçamento de

qualquer PME. A estes custos acrescem o valor das licenças anualmente, e uma restrição

ao número de utilizadores.

O nosso trabalho de investigação foca-se essencialmente nas ferramentas de BI open

source, tendo em conta que a sua aquisição não implica custos. Os custos das ferramentas

comerciais são bastante elevados, muitas vezes inflacionados pelos custos das licenças e

renovação das mesmas dentro de um período de tempo. Face à fraca capacidade de

investimento por parte das PMEs, neste tipo de ferramentas pretendemos solucionar o

nosso problema com ferramentas gratuitas. Neste contexto existe algum trabalho já

desenvolvido, ainda que se considere escasso. Já existe algum trabalho realizado

relacionado com o estado da arte de ferramentas de BI open source e comparação das

funcionalidades disponibilizadas pelas diversas ferramentas. Relativamente à comparação

de custos da aplicação de ferramentas comerciais e ferramentas open source a informação

é mais escassa. Quanto a informação relacionada com a comparação dos custos das

ferramentas BI comerciais também não existe muita informação.

7

8

CAPÍTULO 3

3. BUSINESS INTELLIGENCE

No âmbito do nosso trabalho, pretendemos investigar de forma aprofundada o conceito de

Business Intelligence (BI). Para melhor compreendermos o conceito de BI, iremos

apresentar a sua definição, os seus benefícios e objetivos, as suas vantagens e

desvantagens, os seus fracassos e a sua arquitetura. Numa segunda fase, descrevemos as

propriedades e conceitos relacionados com a área de BI. Neste capítulo pretendemos

apresentar a definição de todos os conceitos relacionados com o termo de BI de modo a

facilitar a compreensão dos capítulos seguintes.

3.1. Descrição do conceito de Business Intelligence

O conceito de Business Intelligence foi definido em 1989 por Howard Dresner como:

“concepts and methods to improve business decision making by using fact-based support

systems” (Power, 2007), ou seja, conjunto de conceitos e métodos que pretendem

melhorar a atividade de tomada de decisão de negócio por parte de gestores e analistas,

apoiadas pelos sistemas de suporte à decisão. O conceito BI não tem a finalidade de

decidir, apenas tem o objetivo de reunir elementos visuais capazes de suportar a tomada

de decisões por parte de gestores e analistas de negócio. Como podemos constatar o

conceito de BI não é recente, a sua definição surgiu há mais de duas décadas ainda assim,

possui atualmente um maior reconhecimento, sendo classificado como um conceito de

topo atualmente. O facto de o conceito não ser novo mas só ter atingido recentemente o

reconhecimento das suas potencialidades, pode ser justificado com o facto da adoção

tardia de sistemas de informação (SI), por parte das empresas (Varajão et al. 2011). Os

sistemas de informação ganharam um relevo enorme na atividade das empresas, passando

a ser essencial a sua utilização nas atividades laborais. Os sistemas de informação

permitem auxiliar a atividade das empresas, através do registo de dados. Os dados

registados e guardados num sistema de gestão de base de dados permitem gerar

informação, é esta informação que permite após ser trabalhada, gerar métricas para a

otimização do negócio. Foi com base na necessidade de implementar processos de análise

de informação e a partir dela extrair conhecimento que nasceu o termo BI. O conceito de

BI é mais vantajoso quanto maior for a quantidade de dados relacionados com a atividade

empresarial disponíveis. Uma empresa que não possua dados da sua atividade de negócio

não possui elementos que sustentem a instalação de ferramentas de BI.

Os dados são a matéria-prima das ferramentas de BI, quando agrupados originam

informação. Por sua vez, um conjunto de informação origina conhecimento. É através do

conhecimento extraído dos dados que se torna possível otimizar processos e métodos de

trabalho.

As ferramentas BI existem para apoiar gestores e analistas de negócio. As ferramentas BI

simplesmente ilustram o cruzamento de dados, não tomam decisões por si, apenas reúnem

9

CAPÍTULO 3

elementos capazes de suportar a tomada de decisão de gestores e analistas de negócio. A

análise da informação proveniente dos aglomerados de dados permite aos analistas de

negócio extraírem conhecimentos e por conseguinte: estabelecerem métricas e estratégias

de negócio, estimar e prever oscilações de mercado e apoiar a tomada de decisão.

A Figura 3.1 ajuda a ilustrar o processo de BI, representado por uma pirâmide, em que o

conjunto de dados representados na base da pirâmide suporta o conjunto de informações.

Por sua vez, a informação sustenta o topo da pirâmide, que coincide com o processo de

tomada de decisão.

Decisão

Informação

Dados

Figura 3.1. Ilustração da pirâmide de processos de Business Intelligence

Uma ferramenta de BI deve apresentar funcionalidades que permitam:

•

•

•

•

•

•

Obter e modelar dados provenientes de sistemas de gestão de base de dados

(SGBDs);

Extrair, transformar, efetuar limpeza e carregamento de dados;

Visualizar análises de dados;

Mostrar dados em forma de dashboards;

Implementação de processos de Data Mining;

Criação de relatórios de dados.

3.1.1. Benefícios e objetivos

O principal objetivo de um sistema de BI é promover o cruzamento de dados e facilitar a

tomada de decisão. Os principais objetivos e benefícios da utilização de BI são

(Rodrigues, 2006):

•

•

•

•

•

10

Antecipar alterações de mercados;

Antecipar ações dos competidores diretos;

Descobrir novos ou potenciais agentes competidores;

Aprender com os sucessos e falhas dos outros

Conhecer melhor as capacidades próprias

CAPÍTULO 3

•

•

•

•

Conhecer novos conceitos e metodologias que causem impacto na atividade de

negócio

Conquistar novos mercados

Avaliar e rever os processos de negócio

Auxiliar na implementação de novas práticas de negócio

3.1.2. Vantagens

À medida que o conhecimento avança vão se verificando novos progressos, baseados na

melhoria de práticas e costumes. O desenvolvimento de novas práticas e de novos

conceitos, coincide com a necessidade de descobrir e desenvolver novas estratégias que

facilitem e melhorem os processos existentes. Deste modo, o conceito de BI surge no

âmbito de acrescentar vantagens aos métodos inicialmente existentes. Para melhor

classificar as capacidades das ferramentas de BI, passamos a enumerar as vantagens da

sua implementação, nas empresas e organizações (Rodrigues, 2006).

•

•

•

•

•

•

•

•

•

•

•

•

Aumento da qualidade no planeamento operacional e estratégico: o conhecimento

extraído dos resultados obtidos permite um planeamento mais sustentado.

Agilização do processo de tomada de decisão: a monitorização dos dados através

de representações gráficas torna os processos de tomada de decisão mais simples e

menos morosos.

Diminuição dos custos da atividade empresarial: cortes na atividade

administrativa.

Maior credibilidade na previsão de mudança de ações.

Aumento da credibilidade sobre as ações e sobre a qualidade dos produtos.

Aumento da competitividade: a redução dos custos da atividade empresarial

conduz a um aumento da competitividade.

Maior rentabilidade: a identificação de problemas e de fatores de sucesso permite

rentabilizar os processos de negócio.

Redução de custos operacionais: a implementação de ferramentas de BI permite

diminuir gastos com agentes de decisão.

Ampliação da carteira de clientes: o agrupamento de dados relativos aos clientes,

permite traçar um perfil e conhecer as necessidades do cliente, ajudando a definir

estratégias capazes de amealhar maior número de clientes.

Aumento da lealdade dos clientes: a possibilidade de traçar um perfil dos clientes

da empresa ajuda a identificar os grupos de clientes que maiores garantias de

lealdade oferecem.

Retorno sobre o investimento (ROI) mais rápido em projetos BI: a redução dos

gastos com analistas de negócio e gestores, bem como a rentabilidade oferecida

pela implementação de soluções de BI, acelera a recuperação do investimento.

Maior controlo e menor percentagem de erro: fruto da segurança coordenada, com

acesso restrito a dados mediante cada tipo de utilizador; garantia de qualidade da

11

CAPÍTULO 3

•

•

•

informação; cruzamento de dados diversos, provenientes de sistemas de

informação (SI) e fontes de dados diversas.

Partilha de informação entre grupos distintos: a monitorização dos problemas dos

diferentes setores empresariais, numa única ferramenta facilita a partilha de

informação.

Melhor interação com os utilizadores: é possível obter respostas/análises em

tempo real e proceder à realização de análises de setores de negócio distintos na

mesma ferramenta.

Informação on-line: possibilidade de decidir em qualquer lugar e a qualquer hora.

3.1.3. Desvantagens

Do conceito de Business Intelligence não advêm só vantagens, também existem algumas

desvantagens resultantes da implementação de ferramentas de BI. De entre as

desvantagens enumeramos:

•

•

•

•

•

•

•

12

Custo: a aquisição de ferramentas BI tem um custo elevado, as ferramentas

proprietárias são dispendiosas e as ferramentas open source não dispensam

conhecimentos e formação base para a sua utilização; os sistemas que oferecem

suporte a este tipo de ferramentas necessitam de hardware com boa capacidade de

processamento e resposta. O processamento de grandes quantidades de dados pode

representar um congestionamento das redes internas.

Suporte: a utilização deste tipo de ferramentas requer algum conhecimento base,

alguma documentação de suporte e/ou formação; aspetos relacionados com o

suporte aos sistemas muitas vezes também representam uma desvantagem, tendo

em conta que este tipo de ferramentas requer sistemas com uma boa capacidade de

processamento.

ROI: o retorno sobre o investimento pode levar algum tempo, tudo depende do

volume de negócio e dos gastos dispendidos com a obtenção, configuração e

assistência.

Uso limitado: de um modo geral este tipo de soluções, nomeadamente as

proprietárias, possui licenças restritas a um número de utilizadores ou

computadores.

Complexidade: a utilização de ferramentas de BI requer pessoas com

conhecimentos básicos na área de informática para a sua utilização.

Implementação morosa: o processo de construção de uma Data Warehouse,

implementação de processos ETL (Extract, Transform, Load), construção de

cubos de dados OLAP (On-line Analytical Processing) e posteriormente a

construção de dashboards é um processo moroso.

Acumulação de dados históricos: o conceito é mais viável quão maior for a

quantidade de dados e o intervalo de tempo da sua recolha, isto representa um

CAPÍTULO 3

•

•

enorme avolumado de dados, que requer uma grande capacidade de

processamento.

A adoção deste tipo de ferramentas por parte das empresas e organizações ainda

não atingiu a maioridade: tendo em conta fatores como o custo e a capacidade de

investimento por parte das empresas.

Fracassos de BI (descritos na secção seguinte).

3.1.4. Fracassos de BI

Com base num estudo desenvolvido pela Information Builders (empresa de

desenvolvimento de soluções BI proprietárias), é possível verificar que o interesse pela

adoção de ferramentas BI aumentou, mas que nem sempre a adoção de ferramentas BI é

sinónimo de sucesso. Segundo esse estudo existe um enorme número de projetos BI que

terminam em fracasso. No mesmo estudo são identificadas as principais razões que

conduzem a esse fracasso (Pino, 2011).

Das dez razões expressas temos como principais responsáveis pelo fracasso:

•

•

•

•

•

•

•

O processo de levantamento de requisitos pouco claro: é importante definir KPIs

(Key Performace Indicators) de forma concisa e correta para que o processo de

tomada de decisão seja o mais correto e coerente.

Existência de dados incorretos ou incompletos: é vulgar a existência de dados

desatualizados, incorretos ou inacessíveis. Este tipo de dados com pouca

qualidade representa um problema nos projetos de BI.

Envolvimento de utilizadores finais tardiamente: tal como noutros tipos de

projetos é importante integrar utilizadores finais no desenvolvimento do projeto,

de forma a precaver anomalias e tornar o projeto mais acessível e à medida do

utilizador e dos seus processos normais de trabalho.

Resultados finais num prazo médio de dois anos: nos casos em que o cliente não

recebe versões provisórias do projeto para ir testando e avaliando o projeto,

conhecendo apenas o projeto na sua parte final, pode representar um fracasso na

abordagem e implementação de requisitos.

Falta de gestão da mudança: é importante existir um grupo de pessoas responsável

por acompanhar o desenvolvimento do projeto de modo a gerir atempadamente

ajustes e mudanças. Da ausência de gestão de mudanças resultam custos

adicionais e atrasos na entrega final do projeto.

Cumprimento e segurança descuidados: muitas vezes as equipas de

desenvolvimento não se preocupam com questões de segurança, este é um aspeto

que deve ser tido em conta para sigilo de dados.

Documentação pobre sobre o ambiente de trabalho da aplicação: é comum nas

ferramentas de BI pouca documentação sobre a ferramenta que normalmente varia

de versão para versão.

13

CAPÍTULO 3

•

•

•

Recursos de hardware

ardware estimados de forma incorreta:: a capacidade necessária por

vezes é subestimada, resultando desse erro de cálculos clientes insatisfeitos.

Funcionários centrados no Excel:

Excel a mudança de costumes é uma barreira para os

utilizadores, tornando-se

tornando se difícil abandonar hábitos que foram adquirindo ao longo

do tempo, em que se familiarizaram com determinada aplicação.

Orçamentação

ação inadequada:

inadequada: erros de orçamentação resultam sempre em clientes

insatisfeitos.

3.1.5. Arquitetura de BI

Para uma melhor compreensão de todos os passos dos processos de BI vamos analisar a

sua arquitetura. A Figura 3.2

3. ilustra a arquitetura de um processoo de BI.

BI

Figura 3.2. Arquitetura de processos de Business Intelligence

A arquitetura de BI,, ilustrada na Figura 3.2, pode ser analisada em cinco passos.

Passamos a descreve-los:

Passo 1 •

Recolha de dados:: os dados podem ser provenientes de bases de dados

dado de sistemas

de informação diversos, ERP (Enterprise Resource planning), CRM (Customer

Relationship Management),

Management) ‘flat files’ ou de ficheiros de dados externos

(normalmente ficheiros Excel e/ou CSV (Comma-Separated

(Comma Separated Values)).

Passo 2 •

14

Processo de tratamento

tratamento de dados: processo de ETL (Extract, Transform, Load),

neste passo os dados são trabalhados, extraídos, transformados e carregados para

uma DW, Data Marts ou cubos de dados.. Por vezes existe incoerência de dados ou

necessidade de transformar dados para outro

outro formato que não o original, este é o

CAPÍTULO 3

processo de ”Transformação”, (p. ex: transformar mês 1 em ‘janeiro’; Sim ou Não

em ‘1’ e ‘0’ respetivamente, etc.).

Passo 3 •

Carregamento de dados: após o passo 1 e 2, a última operação de ETL é o

carregamento de dados, este carregamento de dados pode ser efetuado para DWs

(Data Warehouses), Data Marts (DWs mais pequenas, normalmente associadas a

um setor do negócio) e cubos de dados.

Passo 4 •

Criação de elementos BI: após o carregamento dos dados é possível usufruir das

várias funcionalidades das ferramentas de BI, nomeadamente, construção de

relatórios, análises de Data Mining, consultas ad-hoc, consultas OLAP, criação de

dashboards e análises geográficas.

Passo 5 •

Monitorização e interação com o utilizador: o último passo é a apresentação de

resultados ao utilizador, o utilizador tem a possibilidade de visualizar os

resultados obtidos dos processos de cruzamento de dados e interagir com a

ferramenta.

3.2. Propriedades de BI

Antes de avançarmos, e para percebermos melhor os conceitos presentes na Figura 3.2,

que representa a arquitetura de BI, vamos conhecer melhor, de forma detalhada cada um

dos elementos.

3.2.1. Data Warehouse

Data Warehouse é o termo que designa armazém de dados, na prática uma DW é um

sistema de armazenamento de dados de grandes dimensões, desenvolvido para guardar

grandes quantidades de dados de vários processos de negócio. A sua estrutura foi

desenvolvida a pensar num acesso menos moroso aos dados, a sua arquitetura dispensa as

normalizações conhecidas da arquitetura de bases de dados relacionais, aumentando o

desempenho das consultas à base de dados. A estrutura de um Data Warehouse é

constituída por dois tipos de elementos, tabelas de factos (guardam os valores resultantes

da medição de negócio) e dimensões (elementos chave de um negócio ou de cada

processo de negócio) (Wikipédia, Data Warehouse).

3.2.2. Data Marts

Os Data Marts são repositórios de dados que representam um subconjunto de dados de

um Data warehouse. Habitualmente os Data Marts surgem associados a conceitos

específicos ou processos de negócio próprios. Vendas, controlo de stocks, vendas

15

CAPÍTULO 3

semanais, são alguns exemplos do que é um Data Mart. Os Data Marts são atualmente

estruturas bastante flexíveis, preferencialmente constituídas por dados atómicos.

3.2.3. Metadados

O conceito de metadados surgiu em 1969 e foi criado por Jack Myres (Pereira et al,

2005), designando os dados que descreviam registos de arquivos convencionais. Por

outras palavras, metadados são dados utilizados para descrever outros dados, isto é, dados

que guardam informação relativamente aos dados a que se referem.

Os metadados são utilizados como um dicionário de informação, neste contexto são

metadados todas as informações relacionadas com (Wikipédia-Data Warehouse, 2011):

•

•

•

•

•

•

•

•

•

•

•

•

16

Origem dos dados: informação que permite saber a proveniência dos dados.

Fluxo de dados: os elementos de dados necessitam de ter identificado os fluxos

nos quais sofrem transformações.

Formato dos dados: todos os elementos possuem designação relativamente ao tipo

e tamanho de dados.

Nomes e ‘alias’: todos os elementos devem ser identificados por um nome. O

nome pode ser da área de negócio ou um nome técnico, os alias também estão

inseridos neste contexto.

Definições de negócio: esta informação tem bastante importância, tendo em conta

que especifica o tipo de negócio ou o processo de negócio.

Regras de transformação: esta informação retrata as ações praticadas no processo

de extração, transformação e limpeza dos dados.

Atualização de dados: a referência temporal é importante para definir atualizações

sobre os dados.

Requisitos de teste: devem conter informação relativamente aos intervalos de

valores corretos no preenchimento de dados.

Indicadores de qualidade de dados: é possível integrar informação relativamente à

qualidade dos dados, tendo em conta a sua origem e o número de processamentos

efetuados sobre esse dado, por exemplo.

Triggers automáticos: podem existir processos automáticos associados aos

metadados definidos.

Responsabilidade sobre a informação: deve ser identificado o responsável pelo

registo dos dados e o responsável pelos processos de transformação sobre os

mesmos.

Acesso e segurança: restrição de utilizadores com acesso aos dados e informações

relativamente à segurança são aspetos muito importantes.

CAPÍTULO 3

3.2.4. ETL

O conjunto de processos de ETL (Extract, Transform, Load) divide-se em três passos,

Extração, Transformação e Carregamento. Este é um dos processos mais críticos de BI.

No processo de extração é importante que se conheça a validade dos dados a fim de os

transformar da melhor forma. O processo de transformação pode ser dispensável em

alguns casos e bastante complexo noutros. No processo de transformação podem ocorrer

diversos tipos de transformações, tais como (Kimball, 2008):

•

•

•

•

•

•

•

•

•

Seleção de determinadas colunas de dados a carregar.

Limpeza de dados (Transformação de “Masculino” da fonte de dados para “M” na

Data Warehouse, por exemplo).

Codificação de valores de forma livre (Transformar “Masculino” e “Sr.” Em “M”,

por exemplo).

Derivação de um novo valor calculado (Intervalo_tempo = data_final –

data_inicial).

Junção de dados, provenientes de fontes distintas.

Resumo de várias linhas de dados (p. ex: a soma de totais de vendas por loja e por

região).

Gerar valores de chaves substitutas (Surrogate Keys).

Transposição ou rotação (converter colunas em linhas e vice versa).

Separação de uma coluna por várias colunas (p. ex: a separação de um campo data

do tipo ‘aaaa-mm-dd’ em ‘aaaa’, ‘mm’ e ‘dd’).

Após a estruturação do modelo de ETL, procede-se ao último passo, que retrata o

processo de carregamento dos dados para uma Data Warehouse ou Data Mart.

3.2.5. Cubos de dados

O cubo de dados é a representação de um formato lógico que permite modelar e visualizar

dados em diversas perspetivas. O cubo de dados é constituído por dimensões e tabelas de

factos.

As dimensões representam atributos do repositório de dados, apresentando as suas células

os valores relativos às medidas de interesse registadas pelas tabelas de factos (Veras,

2009).

A Figura 3.3 ilustra um cubo tridimensional com o total de vendas de um produto num

determinado mês numa região específica.

17

CAPÍTULO 3

Figura 3.3. Cubo tridimensional com o total de vendas

Na Figura 3.3 é possível visualizarmos um cubo de dados com três dimensões, a partir da

representação do cubo é possível conhecer o total de vendas relativamente aos produtos

(A, B, C, D, E e F), nos meses de (Janeiro, Fevereiro, Março, Abril, Maio e Junho), por

região (Norte, Sul, Este e Oeste).

3.2.6. OLAP

O conceito OLAP (On-Line Analytical Processing) define o processamento analítico

online dos dados. Permite a visualização de conjuntos de dados organizados em cubos

multidimensionais. A sua finalidade é a de reunir conjuntos de dados de forma organizada

e hierárquica fornecendo uma melhor organização dos dados, ajudando a uma melhor

compreensão por parte dos utilizadores. Estes processos são extremamente importantes

no auxílio à tomada de decisão (Anzanello, 2007).

Para uma melhor compreensão das caraterísticas das aplicações OLAP passamos a

enumerá-las:

•

•

•

18

Cubo de dados – é uma estrutura multidimensional que permite analisar dados de

forma simples (elemento descrito anteriormente em 3.2.5).

Dimensão – é uma unidade de análise que agrupa dados de negócio. As dimensões

fazem parte dos cabeçalhos de linhas e colunas.

Hierarquia – composta por todos os níveis de uma dimensão. Existem dois tipos

de hierarquias, as balanceadas e as não balanceadas. Na hierarquia balanceada os

níveis são equivalentes, nas hierarquias não balanceadas não existe equivalência

de níveis. Como exemplo, olhemos para uma dimensão geográfica país, Portugal

não possui estados enquanto que os Estados Unidos da América (EUA) possuem

CAPÍTULO 3

•

cinquenta estados. Este é um exemplo de hierarquia não balanceada em que

Portugal não possui o subnível estado e os EUA possuem. Por outro lado, Portugal

possui distritos enquanto que os EUA não.

Membro – é um subconjunto de uma dimensão, a tabela seguinte ilustra um

exemplo prático, apresentando o sub nível e os seus membros de uma dimensão

geográfica.

Tabela 3.1. Demonstração elementos OLAP

Nível

Região

Países

Estados/províncias

•

Membros

Europa, América do Norte, Ásia

Portugal, Brasil, EUA

Califórnia, Boston

Medida – dimensão especial utilizada para fazer comparações. Esta dimensão

surge associada a elementos como somas de totais, médias, custos, lucros, taxas,

etc.

3.2.6.1. Arquiteturas OLAP

Mediante a forma de armazenamento de dados necessários a uma aplicação OLAP, devese procurar aplicar a arquitetura que melhor satisfaça as pretensões do utilizador/cliente.

As arquiteturas OLAP de armazenamento são (Araújo, 2009):

•

•

MOLAP – Multidimensional On-Line Analytical Processing, representa a

arquitetura OLAP tradicional. Nesta arquitetura os dados são guardados em cubos

multidimensionais e não na base de dados. O utilizador trabalha os dados do cubo

e manipula-os diretamente no servidor. Esta arquitetura tem como vantagens o

alto desempenho (os cubos são construídos previamente e no servidor) e a

execução de cálculos complexos (todos os cálculos são gerados previamente

aquando da criação do cubo de dados). Esta arquitetura tem como desvantagens a

baixa escalabilidade (a vantagem de performance adquirida com a execução

prévia de cálculos torna-a numa arquitetura limitada relativamente à quantidade de

dados) e investimentos altos (esta arquitetura exige bastantes investimentos

adicionais na projeção de cubos).

ROLAP – Relational On-Line Analytical Processing, os dados são provenientes

de bases de dados relacionais. A manipulação de dados da base de dados aparenta

as operações de Slice/Dice (descritas em 3.2.6.2) e cada ação Slice/Dice equivale

à junção de uma cláusula ‘WHERE’ em uma consulta SQL (Structured Query

Language). Esta arquitetura tem como vantagens a alta escalabilidade (utilizando

esta arquitetura não existe limitação à quantidade de dados a serem analisados) e a

possibilidade de recorrer a funcionalidades implícitas no próprio SGBD (Sistema

de Gestão de Base de Dados). Esta arquitetura apresenta como desvantagens, o

baixo desempenho (tendo em conta que cada relatório de dados representa pelo

19

CAPÍTULO 3

•

•

menos uma consulta SQL, estas consultas podem ser morosas nos casos em que a

base de dados possua grandes quantidades de dados) e o facto de ser limitada

pelas funcionalidades SQL (torna-se constrangedor executar cálculos complexos

utilizando SQL).

HOLAP – Hybrid On-Line Analytical Processing, tecnologia recente que tem por

base a junção de MOLAP e ROLAP, oferecendo uma junção de performance

existente no MOLAP e escalabilidade proveniente do ROLAP. HOLAP utiliza

cubos de dados multidimensionais, em casos de necessidade de maior informação,

esta arquitetura possibilita acesso à base de dados relacional. As vantagens são o

alto desempenho (cubos de dados armazenam a síntese da informação) e a alta

escalabilidade (a informação detalhada fica guardada na base de dados relacional).

A desvantagem desta arquitetura é o seu custo, sendo a que detém o custo mais

elevado de entre as arquiteturas OLAP.

DOLAP – Desktop On-Line Analytical Processing, arquitetura que permite ao

utilizador emitir uma consulta para o servidor obtendo o cubo de dados respetivo,

posteriormente o cubo de dados será analisado na estação cliente. As vantagens

desta arquitetura são o pouco tráfego na rede (o processamento OLAP é todo ele

efetuado na estação cliente), ausência de sobrecarga do servidor de base de dados

(tendo em conta que todo o processamento acontece na estação cliente) e a

portabilidade de dados oferecida pela arquitetura. A desvantagem desta arquitetura

é a limitação do tamanho do cubo de dados (caso o cubo de dados seja grande, a

análise passa a ser morosa colocando até em causa a capacidade de suporte da

estação cliente).

3.2.6.2. Elementos OLAP

As ferramentas OLAP permitem fazer várias ações sobre os cubos de dados. Para melhor

conhecermos os conceitos vamos descreve-los:

•

•

•

20

Consultas ad-hoc: o termo ad-hoc deriva do latim, e tem o significado de “para

isto” ou “para esta finalidade”, que atribui um valor de especificidade por parte do

termo. Este é um tipo de consultas geradas pelo utilizador da aplicação a dada

altura, tendo em conta as suas necessidades, procedendo ao cruzamento de dados

de forma espontânea e aplicando métodos que o conduzam à obtenção dos

resultados pretendidos.

Slice-and-Dice: funcionalidade que possibilita alteração de visão e perspetivas.

Permite a alteração da posição dos dados e a troca de linhas por colunas, com o

objetivo de facilitar a análise por parte dos utilizadores.

Drill-down/up: funcionalidade que permite visualizar informação em maior

detalhe (p. ex: na dimensão tempo a informação pode ir até ao detalhe hora,

minuto, segundo).

CAPÍTULO 3

•

•

Drill-Through: funcionalidade que permite realizar uma consulta SQL, associando

as instruções SQL como filtros da consulta.

Drill-across: processo de consultas combinadas a várias tabelas de factos,

agrupando os resultados num único conjunto de dados. Um exemplo da utilização

de este conceito é a criação de duas estrelas idênticas em que a primeira estrela

guarda uma previsão de dados e a segunda estrela será composta por dados reais.

Neste caso prático as duas estrelas devem ser compostas pelas mesmas dimensões

de forma a ser possível a comparação entre dados previstos e dados reais

(Thornthwaite, 2005).

Para além destas funcionalidades, as ferramentas de OLAP permitem normalmente

visualizar gráficos ilustrativos dos dados representados nas dimensões do cubo

(Anzanello, 2007).

3.2.7. Dashboards

O termo dashboard pode ser entendido como um painel de bordo. São responsáveis por

demonstrar de forma ilustrada o desempenho dos processos de negócio de toda a

organização (Wikipédia-Dashboards, 2011). Podem ser representados num painel virtual

composto por uma ou mais camadas constituídas por instrumentos virtuais, como: Knobs

(espécie de manómetros), mostradores e gráficos diversos (barras, colunas, bolhas, área,

etc.), e tabelas.

Os dashboards relativamente à sua aplicação podem classificar-se como (Eckerson,

2006):

•

•

•

Dashboards operacionais: Permitem a monitorização e acompanhamento dos

processos de negócio, por parte de supervisores e trabalhadores.

Dashboards táticos: voltados para o acompanhamento de processos

departamentais. Este tipo de dashboards é destinado a gerentes e analistas de

negócio.

Dashboards estratégicos: permitem acompanhar a execução dos objetivos

estratégicos delineados pelas empresas. Este tipo de dashboards é destinado a

gestores, executivos e restante organização.

No conceito de BPM (Business Process Management) os dashboards devem ser o

resultado final da fase de BAM (Business Activities Monitoring).

3.2.8. Data Mining

O conceito de Data Mining, ou prospeção de dados (traduzido para português), é o

processo responsável pela exploração de grandes quantidades de dados. Este processo tem

como principal objetivo a procura de padrões consistentes, como regras de associações ou

sequências temporais. Estes padrões permitem detetar relacionamentos sistemáticos entre

variáveis, em busca de subconjuntos de dados (Wikipédia-Data Mining, 2011).

21

CAPÍTULO 3

Os processos de Data Mining partem geralmente da seleção de algumas colunas de DWs

ou Data Marts. Este conceito trabalha sobre sequências de dados, implementando

técnicas das áreas de estatística, recuperação de informação através da área de

inteligência artificial e reconhecimento de padrões. Vejamos um exemplo prático para

uma melhor perceção das capacidades de Data Mining.

Sequência original: ABCXYABCZKABDKCABCTUABEWLABCWO

Após analisarmos atentamente a sequência acima, podemos verificar que:

•

•

Existem sequências de dados que se repetem, “AB” e “ABC”.

Existe segmentação de carateres tendo “AB” e “ABC” como prefixo.

"ABCXY"

"ABCZK"

"ABDKC"

"ABCTU"

"ABEWL"

"ABCWO"

Atendendo aos dados representados acima, podemos descrever estes segmentos de dados

recorrendo a representações genéricas.

"ABC??", "ABD??", "ABE??" e "AB???"

O carater ‘?’ representa qualquer letra. Pegando nesta representação podemos partir para

um caso prático de exemplo. Suponhamos que ‘A’ representa a compra de um produto,

(p. ex: pão), ‘B’ representa a aquisição de leite enquanto que ‘C’ possa indicar um tipo de

leite (p. ex: meio gordo). Na prática com estes dados ficamos a saber que os clientes que

compraram pão também compraram leite. Esta é uma das várias abordagens que o

conceito Data Mining nos permite avaliar. Este tipo de informação permite tomar

medidas de incentivo ao cliente. Normalmente as superfícies comerciais, tendem a expor

este tipo de produtos lado a lado para facilitar a ação do cliente e ao mesmo tempo

incentivar a sua compra.

Este é um dos conceitos BI recente mas que tem evoluído bastante nos últimos anos.

3.2.9. GEO/GIS

Um Sistema de Informação Geográfica (SIG), ou Geographic Information System (GIS),

é um sistema composto de hardware, software, informação espacial e procedimentos

computacionais. Estes procedimentos permitem uma melhor análise de forma

simplificada, e uma melhor gestão ou representação do espaço e dos factos que nele

22

CAPÍTULO 3

ocorrem. Este tipo de sistemas é utilizado com o intuito de detetar e delinear

acontecimentos no espaço físico.

Em BI, este tipo de sistemas é utilizado para análises no espaço, permitindo a utilização

de mapas (p. ex: Google Maps) para especificar zonas com maior poder de compra, maior

número de vendas, maior venda a nível de produtos, etc (Wikipédia-GEO, 2011).

3.2.10. KPIs

Os Key Performance Indicators (KPIs), são indicadores chave de desempenho, tem como

principal objetivo medir quaisquer resultados das medidas implementadas. Nos

dashboards é comum existirem várias referências de KPIs, servindo essencialmente para

verificar se os resultados obtidos estão a superar ou a falhar as metas pretendidas. É uma

funcionalidade bastante importante em BI, facilitando a visualização de resultados e

comparando-os com as metas a alcançar.

3.2.11. Importação e Exportação de dados

O processo de importação de dados está relacionado com a introdução de dados no

sistema provenientes de fontes externas. Estes dados podem ser provenientes de bases de

dados externas ou ficheiros de dados.

A exportação de dados é o processo disponibilizado pelas aplicações de BI, que permite

exportar dados para fontes externas, normalmente para suporte Excel, PDF (Portable

Document Format) e visualizações em HTML (Hypertext Markup Language), por

exemplo.

3.2.12. OLTP

Online Transaction Processing (OLTP), termo que designa os sistemas de processamento

de transações, isto é, são sistemas concebidos para registar todas as transações implícitas

a uma determinada organização. No dia a dia utilizamos alguns sistemas deste tipo, como

são os casos dos processos de transações bancárias que registam todas as atividades afetas

a cada cliente, reservas on-line, utilização de cartões de crédito, etc. Também os sistemas

ERP (Enterprise Resource Planning) se enquadram nesta categoria (Wikipédia-OLTP,

2011).

3.2.13. Relatórios

Relatórios BI são constituídos por um conjunto de elementos diversos de BI. Ilustram

relatórios construídos à medida de uma necessidade, compostos de elementos distintos

como: tabelas de dados, dashboards, cubos de dados, análises de Data Mining, análises

de referenciação geográfica, KPIs etc. É possível configurar a sua construção de modo a

obter relatórios relativos a períodos de tempo específicos (hora, dia, semana, mês,

trimestre, semestre, ano, etc.) ou elementos exclusivos (nº de vendas de determinado

23

CAPÍTULO 3

produto, total de vendas de determinada loja, etc.). Os relatórios representam um dos

elementos mais importantes de visualização dos processos de BI.

24

CAPÍTULO 4

4. SOFTWARE OPEN SOURCE E PMEs

Neste capítulo abordamos os conceitos de software open source e apresentamos uma

descrição sobre PMEs, definindo as suas caraterísticas.

O termo open source (código aberto) foi criado pela open source Iniciative (OSI) em

1988. De um modo geral, estamos perante um tipo de software que respeita as políticas de

liberdade estipuladas pela Free Software Foundation (FSF), que são também partilhadas

pelo projeto Debian Free Software Guidelines (DFSG).

Por vezes o software open source é vulgarizado por software gratuito, no entanto, existem

algumas diferenças entre “software gratuito” e “software open source”; a principal