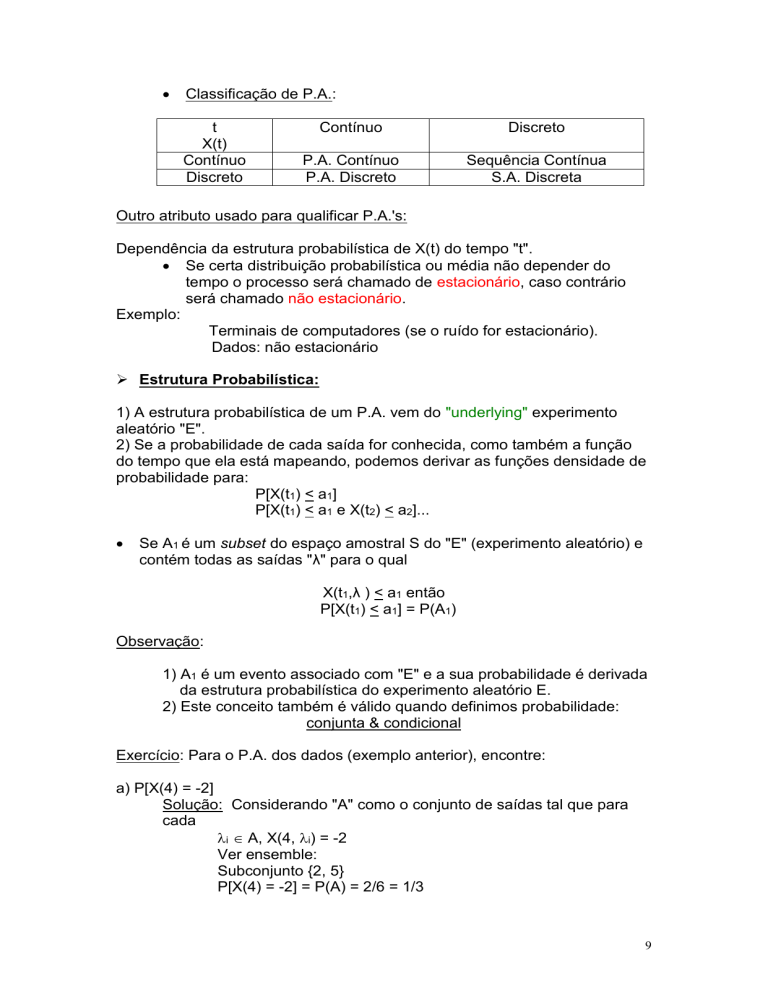

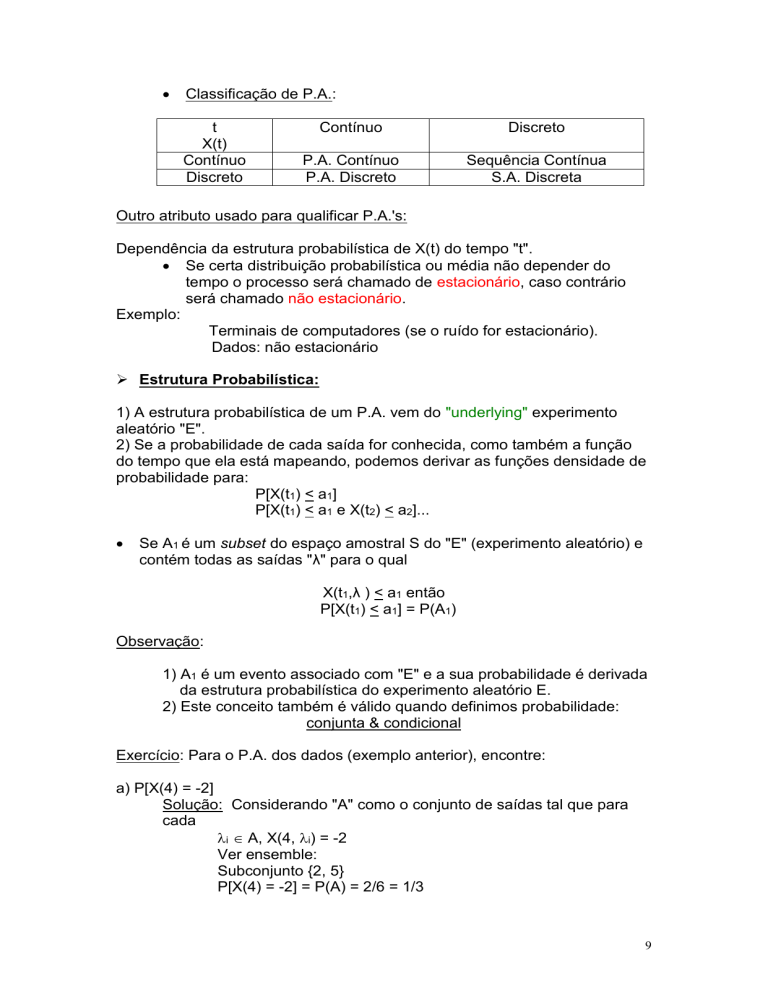

Classificação de P.A.:

t

X(t)

Contínuo

Discreto

Contínuo

Discreto

P.A. Contínuo

P.A. Discreto

Sequência Contínua

S.A. Discreta

Outro atributo usado para qualificar P.A.'s:

Dependência da estrutura probabilística de X(t) do tempo "t".

Se certa distribuição probabilística ou média não depender do

tempo o processo será chamado de estacionário, caso contrário

será chamado não estacionário.

Exemplo:

Terminais de computadores (se o ruído for estacionário).

Dados: não estacionário

Estrutura Probabilística:

1) A estrutura probabilística de um P.A. vem do "underlying" experimento

aleatório "E".

2) Se a probabilidade de cada saída for conhecida, como também a função

do tempo que ela está mapeando, podemos derivar as funções densidade de

probabilidade para:

P[X(t1) < a1]

P[X(t1) < a1 e X(t2) < a2]...

Se A1 é um subset do espaço amostral S do "E" (experimento aleatório) e

contém todas as saídas "λ" para o qual

X(t1,λ ) < a1 então

P[X(t1) < a1] = P(A1)

Observação:

1) A1 é um evento associado com "E" e a sua probabilidade é derivada

da estrutura probabilística do experimento aleatório E.

2) Este conceito também é válido quando definimos probabilidade:

conjunta & condicional

Exercício: Para o P.A. dos dados (exemplo anterior), encontre:

a) P[X(4) = -2]

Solução: Considerando "A" como o conjunto de saídas tal que para

cada

i A, X(4, i) = -2

Ver ensemble:

Subconjunto {2, 5}

P[X(4) = -2] = P(A) = 2/6 = 1/3

9

b) P[X(4) < 0]

Solução: P[X(4) < 0] = P[conjunto de saídas tal que

X(4) < 0] = 3/6 = ½ ]

c) P[X(0) = 0, X(4) = -2] Probabilidade conjunta

Solução: Sendo B o conj. das saídas que mapeia X(0) = 0 e X(4) = -2

Então B={5} (Ver ensemble)

Assim sendo P[X(0) = 0, X(4) = -2] = P(B) = 1/6

d) P[X(4) = -2 | X(0) = 0]

Probabilidade condicional

P[ X (4) 2, X (0) 0] 1 / 6

Solução: P[X(4) = -2 | X(0) = 0] =

=

= 1/2

P[ X (0) 0]

2/6

Considerando os seguintes três ensambles - Figuras 1, 2 e 3:

X1(t)

X2(t)

X3(t)

0

t

Fig.1: Ensamble de gravações de ruído - cada gravação se estende

de t = 0 até ±∞ (teoricamente). O ensamble contém todas

gravações possíveis do ruído...)

O valor de cada função amostral de ruído num tempo arbitrário "t" é:

Xj(t), j = 1, 2, 3, ...

Observação:

1) Os valores de Xj(t) são medições de uma variável aleatória X(t) e,

juntas (Xj(t)) formam o espaço amostral de X(t).

2) Em geral, uma V.A. X(t) tem uma função densidade probabilística

x2

fX(t)(x,t)=

.

1

2( x )2

e

2( ) 2

que é função do tempo e de xj(t).

Aqui a V.A. depende do tempo porém sua pdf é independente do tempo.

10

Para qualquer tempo "t" selecionado na Fig.1, os valores medidos do

"ensemble" serão

Gaussianos com média zero

Variância = cte

E[X(t)] = 0 VAR[X(t)] = x2

Quando um P.A. tiver uma p.d.f. independente do tempo, o processo

aleatório é estacionário na primeira ordem.

A

X1(t)

X2(t)

X3(t)

0

t

Fig.2: P.A. estacionário na primeira ordem consistindo de senóides com

ângulo de fase aleatório .

Y(t) = A cos (0t + )

Cada senóide do ensemble tem a phase aleatória entre . Independente

do tempo t, a equação da V.A. Y(t) é função da variável aleatória . Fazendose uma mudança de variável:

Y(t) = A cos(x), onde x=cos-1(y/a) e derivando em relação à “x”

dx

1

g' (x)

2

y

y

d

1

a

a

(Jacobiano)

f y( t ) ( y, t )

Assim sendo

g' x

k

fy ( y)

fx x i

i1

1

y A

A y2

E[Y(t)] = 0

2

VARYt

(i)

A2

2

Podemos então dizer que este P.A. é também estacionário na primeira

ordem.

11

3)

A

X1(t)

X2(t)

X3(t)

.

0

t

Fig3: P.A. estacionário na primeira ordem constindo de um a seqüência

aleatória de pulsos sem sincronismo.

Cada função de ensemble é constituída de sequências de pulsos positivos

ou negativos com a mesma probablilidade de ocorrência.

O tempo no qual os pulsos mudam não sincronizados entre os membros

do ensemble.

fz(t)(z,t) = 0,5 (z + v) + 0,5 (z - v)

E[z(t)] = 0

e

VAR[z(t)] = V2

O processo aleatório da figura 3 é também estacionário na prmeira ordem.

Se um P.A. fosse apenas uma V.A. variando no tempo, as únicas

expectâncias que seriam usadas para descrever o P.A. seriam a média e

variância.

Nestes três casos apresentados nas figs. 1,2 e 3, todos possuem a média

igual a zero e uma variância constante, porém mesmo assim os

processos, são muito diferentes.

,

Fig.1 Ruído gaussiano: extremamente aleatório

Fig.2 Cada senóide: determinística exceto a fase.

.Fig.3 Sequência de pulsos: certamente não é deterministico, porém por

causa da largura do pulso T, não é tão aleatório quanto o ruído

gaussiano.

Nestes três casos ficou claro que a p.d.f. para uma simples V.A. não é

suficiente para descrever dados tão complicados como o de um P.A.

Para descrever um P.A. completamente ou de uma forma mais completa

é necessário introduzir-se as funções "Densidade Probabilística conjunta"

Uma pdf conjunta de segunda ordem é:

fX(t)(x1, x2: t1, t2) -<t1, t2 <+

12

Correlação:

Usa uma p.d.f.

Com 2 tempos

diferentes

Descreve um processo aleatório de uma maneira

que é impossível ser descrito usando-se apenas a

média e a variância

(a média e x2 dependem de uma p.d.f. que inclue

tempo em apenas um instante).

Rxx(t1, t2) = E[X(t1)X(t2)]

Voltamos a Fig.1. (ruído gaussiano)

As funções de amostra flutuam tão rapidamente e aletóriamente que

os valores calculados em tempos distintos são estatísticamente

independentes, isto é, os produtos, quando forem calculados, terão

o valor médio igual a zero.

x1(t1) x1(t2),

,x2(t1) x2(t2),

,x3(t1) x3(t2),

Rxx(t1, t2) = E[X(t1) X(t2)]

= E[X(t1)] E[X(t2)]

= x2=0

O segundo passo é tomado quando t1=t2

Rxx(t1, t2) = E[X2(t1)] =x2

A variância será independente do tempo porque o ensemble da

Fig.1 é estacionário em primeira ordem.

Na prática, enquanto t1 se aproxima de t2, existe uma transição na

medida que a função de correlação muda de zero a um valor igual a

variância.

Ruído ideal é definido, na prática, como aquele cuja região de

transição é muito pequena.

Rxx(t1,t2) = E[X(t1) X(t2)] = x2 t2 = t1

= 0 para

t2t1

Rxx()

x2

0

Obs: Como t1 e t2 são arbitrários t1 = t

t2 = t + , logo

2

Rxx() = E[X(t) X(t + )] =x

=0

13

0

Rxx() =0

A função de correlação neste exemplo não depende da localização

da origem do tempo "t", mas sim da diferença = t2 - t1.

Estacionário no sentido amplo (Wss) é o nome dado a um processo no

qual:

1) Média e variância são independentes do tempo:

E[X(t)] = x , VAR[X(t)] = x2

2) Função de correlação é independente da origem de tempo

Rxx() = E[X(t)] X(t + )]

Considerando agora Y(t) = A cos (0t1 + j) A cos (0t2 + j)

Para j = 1, 2, 3, ...

A fase é determinada aletóriamente, porém possui o mesmo valor no produto

acima

Ryy(t1, t2) = E[Y(t1) Y(t2)]

1

y j t 1 y j t 2 d j

2

A2

cos0 t 1 j cos0 t 2 j d j

2

A2

cos 0 t 2 t 1

2

Ryy()

A2

2

A função de correlação, neste exemplo depende apenas da diferença t2 -t1 =.

Como a média E[Y(t)]=0 e VAR[Y(t)]=A2/2 (independente do tempo), este

ensemble é também wss.

14

Voltando agora para o sinal da Fig.3.

Dois casos distintos:

1) |t2 - t1| >T

Os valores da função de amostra Z(t1) e Z(t2) devem ser

obtidos em pulsos diferentes logo as V.A.'s serão

descorrelacionadas.

Rzz(t1, t2) = E[Z(t1) Z(t2)]

= E[Z(t1)] E[Z(t2)] = z2 = 0

0

0

2) |t2 - t1| T Os valores da função amostral poderão ser obtidos em pulsos

diferentes ou no mesmo pulso.

Assumindo "A" como sendo o evento no qual os dois valores da função de

amostra são obtidos do mesmo pulso.

Como diferentes funções de amostra não são sincronizadas, a probabilidade

de A é

t 2 t1

P(A) = 1 =

A Probabilidade ocorr. no

T

mesmo pulso

A

Probabilidade ocorrer em

pulsos diferntes

A probabilidade de que dois valores da função de amostra sejam obtidos

de pulsos diferentes (e independentes) é:

_

P(A) =1 - P(A) = |t2 -t1|/T

Utilizando-se a expectância condicional definida anteriormente

Rzz(t1, t2) = E[Z(t1) Z(t2) | A] P(A) +

_

_

E[Z(t1) Z(t2) | A] P(A)

(1)

(2)

Se t1 e t2 estão no mesmo pulso, a equação (2) = 0

Rzz(t1, t2) E[Z(t1) Z(t2) | A] = (V)2 = V2

Para o caso em que t1 e t2 estão em pulsos diferentes:

descorrelacionados

E[Z(t1) Z(t2) | A] = E[Z(t1) Z(t2) ] = 0

t 2 t1

Logo Rzz(t1, t2) = V2 1

T

15

.

ou, como é independente da origem de t,

R zz EZt Zt V 2 1

T

Rzz()=0

|| T

|| > T

Rzz()

V2

-T

0

T

Observações:

Aqui se pode ver como a função correlação pode caracterizar um P.A.

Para o ruído podemos ver que para valores || > 0 os valores das funções

(aleatórias) amostrais são descorrelacionados.

Para a função coseno com fase aleatória, a correlação é periódica na

medida que as funções amostrais se repetem periódicamente.

A função correlação para a sequência de pulsos aleatórios é zero se || for

maior que a largura dos pulsos T, porém cresce na medida que a

dimensão finita dos pulsos, é levada em consideração.

Todos os 3 "ensembles" são estacionários no sentido amplo (wss).

Um ensemble contém muita informação. Temos então que buscar

maneiras de descrever este ensemble, de forma eficiente.

Exemplo:

1- Enconte a p.d.f. de 1a ordem do seguinte P.A.

X(t) = At + b

Onde "A" é uma variável aleatória do tipo gaussiano com

mA= 0

A2=1 e b = cte

Solução:

b

b

Valores

amostrais.

Neste caso a

inclinação

das retas é

aleatório.

b

16

t

Queremos fX1(x1) sendo dado que:

f A a

1

e

2

a2

2

"a" é a variável de saída do experimento

aleatório A

|a|<

Passo1: Resolver a seguinte equação:

X1 = a t1 + b = g(a)

Esta equação tem uma solução real para cada "a" x1

x b

a1 1

t1

Também g'(a) = t1 |g'(a)| = t1

Passo 2:

fX1(x1,t1) =

então

fX1(x1,t1) =

- < x1 <

f A a 1

g ' a 1

1

2 t 1

e

x1 b 2

8

gaussiano com média b

Função Distribuição Conjunta - Joint Distribuition Function

A função distribuição conjunta Fxy de duas variáveis aleatórias X e Y é a

probabilidade do evento {X x , Y y}, i. é:

Fxy(x,y) = P{ X x , Y y} = P{(X,Y) D}

Algumas propriedades da Fxy:

1. Fxy (-, y) = 0; Fxy(x, -) = 0

Fxy(, ) = 1

y

x

y

x

2. P{x1 < X < x2, Y y} = Fxy(x2,y) - Fxy(x1,y)

y

x

x1

x2

17

3. P{X<x, y1<Y<y2} = Fxy(x, y2) - Fxy(x, y1)

4. P{x1< X x2, y1<Yy2} = Fxy(x2, y2) - Fxy(x1, y1) + Fxy(x2,y1)

- Fxy(x1,y2)

Função Densidade Conjunta

A função densidade conjunta fxy das V.A. X e Y é definida por

Fxy(x, y) dxdy = P{x X x +dx, y Y y + dy} =d2Fxy(x,y)

A probabilidade então de um evento D ocorrer é:

P{(X,Y) D} =

d F x, y

2

xy

D

= f xy x, ydxdy

D

quando a integral existe

Exemplo: utilização de uma variável auxiliar

Determine a função densidade da variável aleatória:

a, b 0 e constantes

z= ax + by

Solução:

Definir uma variável auxiliar =y o sistema

z= ax + by

=

y

}

g(x,y)

h(x,y)

tem uma solução única:

x = (1/a)(z - b) x = q(z,w)

y=

y = r (z,w)

O Jacobiano de é J(x, y) = a

g

x

J( x, y )

h

x

g

y

a

h

y

1 z b

f z z, f xy

,

a

J

x

18

f zy z, y

1 z by

f xy

, y

a

a

finalmente (eliminando a variável auxiliar)

fz

1

a

z by

f

xy

a , y dy

Independência Estatística

Duas variáveis aleatórias X e Y são chamadas estatísticamente

independentes se os eventos {xA} e {yB} são independentes:

P{xA, yB} = P{xA} P{yB}

Então, se X e Y são estatísticamente independentes:

Fxy(x,y) = Fx(x) Fy(y)

e

fxy(x, y) = fx(x) fY(y)

Covariância e Coeficiente de Correlação

A covariância de duas variáveis aleatórias X e Y, é por definição

xy

E{(x - x)(y - y)}

= E{xy - xy - xy + xy}

= E{xy} - xE{y} - yE{x} + xy

= E{xy} - xy

xy = E{xy} - E{x}E{y}

O coeficiente de correlação das variáveis aleatórias x e y é:

xy

xy

com |xy| 1

xy

Exemplos: Coefficientes de Correlação

xy +1

xy 1

xy 1

19

xy -1

xy 0

Não Correlacionadas (Descorrelatas) e Ortogonais.

Duas variáveis x e y são chamadas de descorrelacionadas de xy=0. Isto é

equivalente a

xy=0 E{xy} = E{x}E{y}

Obs: Duas variáveis aleatórias x e y que são independentes, são

descorrelacionadas.

Não podemos dizer no entanto que duas variáveis

descorrelacionadas são independente E[xy] - xy = 0

Duas variáveis x e y são chamadas de ortogonais se:

E[xy] = 0

Variância da soma de duas variáveis aleatórias

Se z= x +y, então z=x + y

A variância z2= E{(z-z)2}

z2 =E{[(x-x) + (y-y)]2}

20

z2 = x2 + y2 + 2xyxy

Logo, se x e y são descorrelacionados:

z2 = x2 +y2

Isto também é válido se x e y forem independentes.

Revisão:

1) Algumas propriedades de 2a ordem:

Média (t) = E{X(t)} =

x f x, t dx

pdf

Função autocorrelação:

R(t1,t2) = E {X(t1) X(t2)} =

x x

1

2

f x 1, x 2 ; t 1, t 2 d x1 , d x 2

pdf

conjunta

Potência média:

E{X2(t)} = R(t,t)

Autocovariância (função)

C(t1,t2) = R(t1, t2) - (t1)(t2)

Variância (t1=t2)

2(t) = C(t,t)

Relações entre dois processos aleatórios

Considere dois P.A. que possuem a seguinte função de distribuição conjunta:

F(X(t1)x1,...X(tn) xn , Y(t'1) y1,...Y(t'n) yn)

Função correlação-cruzada:

Rxy(t1,t2) E{X(t1)Y(t2)}

X e Y são ortogonais se Rxy(t1,t2)=0 para t1, t2

Função covariância-cruzada:

Cxy(t1,t2) Rxy(t1,t2) - x(t1)y(t2)

X e Y são ortogonais se Rxy(t1,t2)=0 para t1, t2

X e Y são descorrelacionados se a função distribuição conjunta puder ser

escrita como:

F(X(t1) x1,...X(tn) xn) . F(Y(t'1) y1,...Y(t'n) yn)

Para n, m e ti, t'j Jt

21

Propriedades da função correlação de dois P.A.'s X eY:

1. Rxy() = Ryx(-)

2. |Rxy()| R xx (0)R yy (0)

3. |Rxy()| [Rxx(0) + Ryy(0)|

Observação:

A função autocorrelação é uma função par (even)

Rxx(-) = Rxx()

Rxx(-) = E[X(t) X(t-)] fazendo =t -

Rxx(-) = E[X( + ) X()]

Rxx(-) = Rxx()

Para o caso de correlação cruzada ou cross-correlation função odd

(Ímpar).

Rxy(-) = Ryx() = E[X(t) Y(t - )] = t -

Rxy(-) = E[X( + ) Y()] =E[Y() X( + )]

Rxy(-) = Ryx()

Se um processo aleatório é periódico com um período T, então a função

de autocorrelação também é periódica com um período T.

Rxx( + T) = Rxx()

Logo: Rxx( + T) = E [X(t) X(t + + T)]

= E [X(t) X(t + )

Rxx( + T) = Rxx()

Uma relação similar é válida para a correlação cruzada:

Rxy( + T) = Rxy()

Ryx( + T) = Ryx()

Relações para a magnitude da função autocorrelação:

E[{X(t) X(t + )}2] 0

Esta expectância é não negativa porque temos uma função elevada

ao quadrado.

E[X2(t) 2X(t) X(t + ) + X2(t + )] > 0

Rxx(0) 2Rxx() + Rxx(0) 0

Temos então que

22

Rxx(0) |Rxx()|

Importante:

A magnitude da função de autocorrelação nunca pode execeder o seu valor

na origem (que é sempre um valor +)

Examinado dois processos X(t) e Y(t)

E[{X(t) kY(t + )}2] 0

k=cte

2

2

2

E[X (t) 2kX(t)Y(t + ) + k Y (t + )] 0

Rxx(0) 2kRyx() + k2Ryy(0) 0

Para k=1 Rxx(0) + Ryy(0) 2Rxy() 0

|Rxy()| (1/2) (Rxx(0) + Ryy(0)|

Se intercambiamos X(t) por Y(t)

|Ryx()| (1/2) (Rxx(0) + Ryy(0)|

Assumindo agora "k" positivo e real:

k2Ryy(0) + 2kRxy() + Rxx(0) 0

Esta relação pode ser vista como uma função quadrática de k. A

função quadrática nunca será negativa se seu discriminante for negativo

4Rxy2() - 4Rxx(0)Ryy(0) 0

onde

|Rxy()|

R xx 0R yy 0

|Ryx()|

R yy 0R xx (0)

Invertendo X e Y

A média geométrica e mais "forte" que a média aritimética

|Ryx()|

R xx (0)R yy (0) (1/2) (Rxx(0) + Ryy(0)|

23