Prof. Edberto Ferneda

INFORMÁTICA

INSTRUMENTAL

Informática Instrumental

BUSCA DE

INFORMAÇÃO NA WEB

Interfaces da Escrita

Livro

◦ Numeração de páginas;

◦ Subdivisão em partes (capítulos);

◦ Sumários e índices;

◦

◦

◦

◦

Exame rápido do conteúdo;

Acesso não linear e seletivo ao texto;

Segmentação do saber em módulos;

Conexões a outros livros (bibliografia)

Interfaces da Escrita

Livro

Interfaces da Escrita

Jornais

◦ Adaptados a uma atitude de “atenção

flutuante”;

◦ No território quadriculado do livro

precisamos de índices, sumários, etc. O leitor

do jornal realiza diretamente uma navegação a

olho nu;

◦ As manchetes chamam a atenção, dando uma

primeira idéia, pinçam-se aqui e ali algumas

frases, uma foto e, de repente, encontramos

algo que nos atrai.

Interfaces da Escrita

Jornais

Interfaces da Escrita

Revistas

Interfaces da Escrita

Computador

◦ “pacote terrivelmente redobrado, com pouquíssima

superfície que seja diretamente acessível em um

mesmo instante. A manipulação deve então substituir

o sobrevôo”.

◦ Tela gráfica de alta resolução;

◦ Representação icônica (figurada) das estruturas de

informação e dos comandos;

◦ Uso do mouse, permitindo agir sobre o que ocorre

na tela;

◦ Menus que mostram as operações que se pode

realizar;

Interfaces da Escrita

Computador

Interfaces da Escrita

Computador

Interfaces da Escrita

Computador

Interfaces da Escrita

Computador

Interfaces da Escrita

Computador

WebBrain

BUSCANDO

INFORMAÇÕES NA

WEB

Buscando informações na Web

Sites/mecanismos de busca

◦ permitem ao usuário submeter sua expressão de

busca e recuperar uma lista (geralmente ordenada) de

endereços de páginas (URLs) que presumivelmente

são relevantes para a sua necessidade de informação

◦ Maioria de uso geral

◦ Em um acervo extremamente grande como é a Web

é essencial uma indexação antecipada de seus

documentos (páginas). A maioria dos mecanismos de

busca da Web gera índices. Pelo caráter dinâmico da

Web esses índices devem permanecer em constante

processo de atualização

Buscando Informações na Web

Sites/mecanismos de busca

◦ Índexação

Não Automáticos

O autor fornece dados sobre sua página e associa a ela uma

ou mais categorias que descrevem o assunto tratado na

página

Automáticos

Spiders (robôs, crawlers ou worms)

Partindo de uma lista inicial de URLs, rastreiam a

estrutura hipertextual da WEB, colhendo informações

sobre as páginas que encontram;

Indexam cada página utilizando métodos de indexação

automática

Buscando Informações na Web

Indexação não-automática (manual)

◦ Indexadores profissionais especificam uma hierarquia de assuntos

e indexam as páginas Web utilizando tais categorias.

◦ Uma URL submetida pode ser associada a uma categoria de

qualquer nível. Por exemplo, ela pode ser ligada a uma categoria

principal, “Ciência”, ou à subcategoria, “Ciências Humanas”, ou à

sub-subcategoria, “Biblioteconomia e Ciência da Informação”.

◦ A URL cadastrada é avaliada por profissionais, que podendo

alterar os dados fornecidos pelo usuário.

◦ Caso um usuário não consiga encontrar uma categoria

apropriada para descrever sua página, ele pode sugerir uma nova

categoria.

Buscando Informações na Web

Buscando Informações na Web

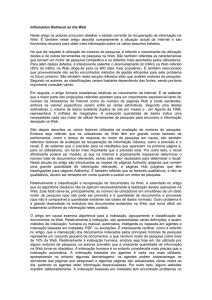

Indexação automática

◦ A indexação automática é realizada através de duas etapas:

Seleção de endereços (URLs) de páginas;

Indexação das páginas, gerando para cada uma um conjunto de

termos de indexação.

◦ Existem programas que “viajam” através da Web a fim de

selecionar URLs de páginas de potencial interesse para

que sejam indexadas. Utilizando a metáfora da Web, esses

programas são chamados de spiders (aranhas) ou ainda

robôs, crawlers ou worms.

◦ Partindo de uma lista inicial de URLs, esses robôs

rastreiam a estrutura hipertextual da Web colhendo

informação sobre as páginas que encontram.

Buscando Informações na Web

Buscador

(yahoo, google, etc)

Banco de dados de URLs

Buscando Informações na Web

Buscador

(yahoo, google, etc)

URLs

(links)

Banco de dados de URLs

Buscando Informações na Web

Buscador

(yahoo, google, etc)

Banco de dados de URLs

URLs

(links)

Buscando Informações na Web

Indexação automática

◦ Duas estratégias podem ser adotadas pelos robôs para rastrear as

páginas da Web

breadth-first

visa maximizar a amplitude da pesquisa descendo apenas poucos níveis de cada site

deep-first

visa maximizar a profundidade buscando um maior detalhamento do assunto tratado

pelo site.

◦ Quando uma nova página é recuperada, o robô extrai todas os links

(URLs) dessa página e os adiciona na sua base de dados.

◦ Para aumentar a velocidade de cobertura da Web podem ser usados

vários robôs trabalhando em paralelo, cada um cobrindo uma região ou

um domínio diferente da Web e enviando suas URLs para a base de

dados.

Buscando Informações na Web

Indexação automática

◦ Depois de formado o banco de dados de

URLs o robô poderá acessar cada página e

indexa-la usando métodos de indexação

automática.

Buscando Informações na Web

Buscas

◦ Geralmente dois níveis de busca: básico e

avançado

◦ Básico:

Buscas booleanas utilizando os operadores AND,

OR, NOT

◦ Avançado:

Buscas por proximidade: NEAR, ADJ

Buscas por tipo de mídia ou tipo de arquivo: “.JPG”,

“.MPEG”, “.GIF”, etc.

Buscando Informações na Web

www.google.com.br

Buscando Informações na Web

História da Internet

Buscando Informações na Web

Meta-buscadores

◦ Realizam buscas utilizando diversos

mecanismos de busca;

A expressão de busca é traduzida e enviada para

cada um dos mecanismos que o meta-buscador

utiliza.

Cada buscador retornará uma lista de URLs

O meta-buscador agrega as listas em uma única

lista, eliminando possíveis duplicações.

Buscando Informações na Web

Buscando Informações na Web

http:///www.metacrawler.com