Distribuições Comuns de Variáveis

Aleatórias Discretas

1.

2.

3.

4.

5.

6.

Constante

Uniforme

Bernoulli

Binomial

Geometrica

Poisson

Variável Aleatória Constante

• pmf

1.0

c

• CDF

1.0

c

Distribuição Discreta Uniforme

• A v.a. discreta X que assume n valores discretos

com probabilidade pX(i) = 1/n, 1 i n

• pmf

1 / n, se xi X

p X ( xi )

0, caso contrário

t

• CDF:

t

F (t ) p X (i )

n

i 1

Variável de Bernoulli

– V.A gerada por um experimento único de Bernoulli tem um resultado

binário {1, 0} ou {sucesso, falha}

– A v.a. binária X é chamada variável de Bernoulli tal que:

–Função de massa de probabilidade:

p P( X 1)

q 1 p P( X 0)

Distribuição de Bernoulli

• CDF

p+q=1

q

0.0

1.0

x

Binomial

•

•

•

•

•

A v.a. X representa o numero de sucessos em

uma sequencia de experimentos de Bernoulli.

Todos experimentos são independentes.

Cada resultado é um “sucesso” ou “falha”.

A probabilidade de sucesso de um

experimento é dado por p. A probabilidade

de uma falha é 1- p.

Uso do modelo: número de processadores

“down” num cluster; número de pacotes que

chegam ao destino sem erro.

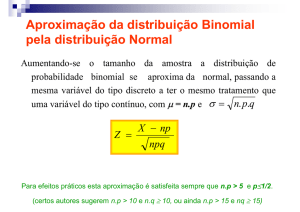

Distribuição Binomial

A distribuição binomial com parâmetros

n 0 and 0 < p < 1, is

n x

p( x) p (1 p)n x

x

Qual a média e variância????

Distribuição Binomial

A distribuição binomial com parametros

n 0 and 0 < p < 1, is

n x

p( x) p (1 p)n x

x

A média e variância da binomial são:

np

2 np(1 p)

V.A. Binomial: pmf

pk

V.A. Binomial: CDF

1.2

1

CDF

0.8

0.6

0.4

0.2

0

0

1

2

3

4

5

x

6

7

8

9

10

Distribuição Geométrica

• Número de experimentos até incluir o 1o sucesso.

•

Em geral , S pode ter um tamanho infinitamente contável

• Definir a v.a Z ( S): amostra: 0 i-1 1 = i

• Por causa da independência:

Geométrica

• A distribuição geometrica é a única distribuição

discreta que exibe a propriedade MEMORYLESS.

• Resultados futuros são independentes de eventos

passados.

• Exemplo: Z: numero de experimentos ate sucesso. Ja

observamos n experimentos: todos com falhas. Y:

numero de experimentos adicionais necessarios ate

que um sucesso ocorra, i.e. Z = n+Y ou Y=Z-n

Geométrica: ausência de memória

• Y=Z-n

P (Y i | Z n)

P ( Z n i | Z n)

P ( Z n i | Z n)

P ( Z n i and Z n)

P ( Z n)

P ( Z n i ) P ( Z n i ) pZ (n i )

P ( Z n)

1 FZ (n)

1 FZ (n)

pq n i 1

i 1

pq

pZ (i )

n

1 (1 q )

V.A. Geometrica

• Exercício: Mostre que

P ( x) 1

x 1

X

and

1

E ( x)

p

VA Poisson

• Número de eventos independentes que ocorrem

em um intervalo de tempo (veja discussão em

Ross, 4.8)

• Número de chegadas em um servidor em 1 hora

• Número de erros de impressão em uma página de

um livro

•

= # médio de eventos que ocorrem no período

• Aproximação para VA Binomial com n grande e p

pequeno (Ross)

• Se X = Binomial(n,p), X Poisson( = np)

Poisson: propriedades

• Considere que um servidor espera receber 100

transações em um minuto:

– = 100 (constante)

• Espera-se que:

– O início de cada transação é independente dos outros;

– Para cada pequeno intervalo de tempo t, a probabilidade

de uma nova transação chegar é t

– A probabilidade de chegar duas transações ao mesmo

tempo é zero!

• O processo de Poisson tem as propriedades acima

• A VA X~Poisson representa o numero de transacoes

que chegam durante um periodo t.

VA Poisson: Aplicacao

• A v.a. de Poisson é boa para modelar vários fenômenos, como o número

de transações que chega num servidor em uma hora, ou o número de

queries que chega numa máquina de busca em 1 minuto ou número de

pacotes que chega num roteador em 1 segundo.

• Muito comumente usado para modelar chegada de sessões de usuários

– servidores Web, multimídia, banco de dados, ftp, e-mail

• Sessões são iniciadas por usuários

– Chegada de duas sessões tendem a ser independentes: Poisson é uma boa

aproximação

• Contra-exemplo:

– Chegada de requisições em um servidor Web

– Premissa de independência não é válida: existe dependência entre requisições

para o arquivo HTML e as imagens embutidas nele

Distribuição de Poisson

•

Função de massa de probabilidade (pmf):

k

(

t

)

pk PN (t ) k e t

k!

•

CDF:

( t )

F x e

k 0

k!

x

t

k

Poisson pmf

pk

t=1.0

Poisson CDF

CDF

1

t=1.0

0.5

0.1

1

2

3

4

5

6

7

8

9

10

t

Poisson pmf

pk

t=4.0

t=4.0

Poisson CDF

CDF

1

t=4.0

0.5

0.1

1

2

3

4

5

6

7

8

9

10

t

Poisson

• Uma v.a. de Poisson X tem sua pmf::

P( X x)

x

x!

e

x 0,1, 2,...

Onde > 0 é uma constante

E(X)= Var(X) =

Search Algorithms: Is the WebGraph a Random graph? No!

• Random graph Gn,p:

– n nodes

– Every directed edge occurs with probability p

• Is the Web-graph a random graph Gn,p?

• The probability of high degrees decrease exponentially

• In a random graph degrees are distributed according to a Poisson

distribution

• Therefore: The degree of a random graph does not obey a power law

(observed for web graphs)

Exercícios

1.

Considere que o número de mails que chegam a um servidor de

mails no intervalo t segundos é distribuído como Poisson com

parâmetro 0.3t Calcule a seguintes probabilidades:

–

–

–

2.

Exatamente tres mensagens chegarão num intervalo de 10 seg.

No máximo 20 msgs chegarão num período de 20seg.

O número de msgs num intervalo de 5 seg está

entre 3 e 7 mails.

A probabilidade de um query falhar (não ser bem sucedido) é

10(-4). Qual a probabilidade de falharem mais de 3 queries numa

sequência de 1000 queries?

Solução

1)

k

(0.3t ) 0.3t

P( Xt k )

e

k!

2)

P(X10 = 3) = 0.224

3)

P(X20 20) = 0.973

7

4)

k

(1.5) ( 1.5)

P(3 X 5 7)

e

0.1909

k!

k 3

Solução

1000 4 i

(10 ) (1 104 )1000i

P(# erros 3)

4 i

1000

• 2)

1000 4 i

(10 ) (1 104 )1000i 3.825 *10 6

P(# erros 3) 1

0 i

3

Distribuições Discretas

• Zipf()

– Comumente usada quando a distribuição é altamente

concentrada em poucos valores

• Popularidade de arquivos em servidores Web/multimídia

– 90% dos acessos são para 10% dos arquivos

• Popularidade de palavras na língua inglesa

– Seja i, o elemento que ocupa a i-esima posição no ranking

de concentração

C

P( X i )

i

i 1,2,...

C é a constante de normalização

Zipf: lei das Potências

Distribuição Zipf

• Modela popularidade dos remetentes de e-mails

para a UFMG

Distribuições de Variáveis

Aleatórias Contínuas

•

•

•

•

•

•

Normal

Exponencial

Weibull

Lognormal

Pareto

....

Distribuições de Variáveis

Aleatórias Contínuas

• Variáveis aleatórias contínuas

–

–

–

–

Assumem um intervalo infinito de diferentes valores

W=% percentual de crescimento do PIB em 2005

V=tempo para retornar a resposta de um “query”

Valores específicos-particulares de uma v.a. contínua

tem probabilidade 0

– Intervalos de valores tem probabilidade 0

Função Densidade de Probabilidade

Para f (x) ser uma pdf

1. f (x) > 0 x.

2.A area da região entre o grafico de f e o

eixo do x é igual a 1.

y f ( x)

Area = 1

Distribuição de Probabilidade

Seja X uma va contínua. Então a a

função de probabilidade (pdf) de X é

uma função f (x) tal que para dois

números quaisquer a and b,

P a X b f ( x)dx

b

a

O gráfico de f é a curva de densidade.

PDF

P(a X b) é dada pela área da função

sombreada.

y f ( x)

a

b

Distribuição Normal (Gaussiana)

• Distribuição mais comum na análise de dados

• pdf is:

( x )2

1

2 2

f ( x)

2

• -x +

• Média é , desvio padrão

e

Notação para Distribuições

Gaussianas

• Geralmente denotada N(,)

• Normal unitária é N(0,1)

• Se x tem N(,),

x

tem N(0,1)

• O -quantil de uma normal unitária z ~ N(0,1) é denotado

por z tal que

x

z ) P( x) z

P(

Parâmetros

• A distribuição de v.a. contínua contém

toda a informação que a estatística pode

descobrir sobre ela

– Distribuição pode ser expressa pela pdf ou CDF

Parâmetros

• Geralmente a informação existente numa distribuição pode

ser excessiva para ser processada

• Quando isso é verdade, nós queremos sumarizar as

métricas de informção:

–

–

–

–

Média

Variancia

Mediana

Percentis

• São também chamados de parâmetros de uma distribuição

Distribuição Normal

• Função de densidade

– Dois parâmetros, e

– Assim se X é distribuído com uma normal:

X ~ N , 2

EX

V X 2

Normal

• Função de densidade para =0, =1

0.45

0.4

0.35

f(x)

0.3

0.25

0.2

0.15

0.1

0.05

0

-5

-4

-3

-2

-1

-6E-14

x

1

2

3

4

5

Normal

• Função de densidade para =1

0.45

=2

0.4

0.35

0.3

0.25

0.2

0.15

=5

0.1

0.05

0

-5

-4

-3

-2

-1

0

1

2

3

4

5

6

7

Normal

• Funções de densidade para =1

0.45

0.4

=1

=2

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

-5

-4

-3

-2

-1

0

1

2

3

4

5

6

7

Distribuicao Exponencial

• Quantidade de tempo até que determinado evento

ocorra

f X x e

- λx

FX x 1 e

λx

for x 0

for x 0

= taxa de chegadas

1/ = tempo médio entre chegadas

Exemplo: v.a. exponencial

• pdf: f ( x) e , x 0

x

• CDF: F ( x) 1 e

f(x)

x

pdf

x

• v.a. muito frequentemente usada em computacao

• Modelos:

– Tempo entre duas submissões de queries a uma maquina de busca

– Tempo de execução de processos

– Tempo entre chegadas de pacotes em um roteador

– Tempo entre chegadas de sessões em um servidor

Exponential distribution

• Density

1.2

1

0.8

0.6

0.4

0.2

0

0

1

2

3

4

5

Distribuicao Exponencial

P(X 1/ ) = 1 – e-1/ = 1 – 1/e

E(X) = 1/

Var(X) = 1/2 SD(X) = 1/ CV(X) = 1

CV = 1 exponencial

Distribuições Exponencial e Poisson

• Seja uma distribuição Poisson que denote o número de eventos

N(t) em um intervalo de tempo t

• Seja T1 o momento do 1o evento

• Seja Tn o tempo entre o (n-1)-esimo e o n-esimo eventos

• Sequência {Tn, n=1, 2, ...}: tempos entre chegadas

P(T1 t) = P(N(t) = 0) = e

-t

T1 exponencial()

P(T2 t | T1 = s) = Prob (0 eventos em (s, s+t) | T1 = s)

= Prob (0 eventos em (s, s+t)) (eventos Poisson

são independentes)

=e

-t

T2 exponencial()

T1 , T2, ..., Tn são independentes e têm mesma

distribuição exponencial()

Distribuições Exponencial e Poisson

Processo de

Chegadas

Poisson

Tempo entre

Chegadas

Exponencial

Independência

entre eventos

Distribuição Exponencial

• Exponencial () :

P ([ X t x] [ X t ])

P( X t x | X t )

P( X t )

P (t X t x)

1 P( X t )

P( X t x) P( X t )

Propriedade

sem memória

1 P( X t )

(memoryless)

1 e ( t x ) (1 e t )

1 (1 e t )

1 e t e x 1 e t

e t

e t (1 e x )

x

1

e

P( X x)

t

e

Propriedade Memoryless

• Tempo de residência R de um cliente depende do # de clientes na

fila quando ele chega ao centro, nos tempos de serviços destes

clientes e no tempo que o cliente que está sendo servido no

momento de chegada ainda permanecerá em serviço.

– Seja Xi a VA para o tempo de serviço de cliente i na CPU

– Seja Xi: exponencial() para todos os clientes

– Seja Y a VA que denota o tempo residual que o cliente que está em

serviço no momento de chegada ainda permanecerá em serviço

• Y também tem distribuição exponencial com parâmetro

• Tempo que ainda falta independe do tempo que já esteve em

serviço

• Estado futuro não depende do estado passado

Propriedade Memoryless

• Distribuição exponencial é a única

distribuição contínua que tem a

propriedade memoryless

• Por sua vez, distribuição geométrica

é a única discreta que tem a propriedade

memoryless

Outras Distribuições Contínuas

• Weibull

• Lognormal

• Pareto

Distribuição de Weibull

A va contínua T tem uma distribuição de

Weibull se a pdf é

f (t ) t

1 t

F (t ) 1 e

e

t

Onde os parâmetros satisfazem t0 > 0 > 0

Distribuição Lognormal

Uma va X tem uma distribuição

lognormal se a va Y = ln(X) X eY tem

uma distribuição normal com a pdf

resultante com parâmetros e

1

f ( x; , ) 2 x e

0

ln( x ) 2

( 2 2 )

x0

x0

Muito utilizada para modelar duracao de sessao de usuarios em

servicos web

Média e Variância

A média e variância de uma va X que

tem uma distribuição lognormal são:

E( X ) e

2 / 2

V (X ) e

2 2

e

2

1

Distribuição Lognormal

=1

Distribuição de Pareto

• Uma das distribuições heavy

tailed.

ab a

f ( x) ( a 1) ab a x ( a 1)

x

x 1

High Variability Phenomena

Walter Willinger

AT&T Labs-Research

[email protected]

Motivation

• Internet is full of “high variability”

–

–

–

–

–

Link bandwidth: Kbps – Gbps

File sizes: a few bytes – Mega/Gigabytes

Flows: a few packets – 100,000+ packets

In/out-degree (Web graph): 1 – 100,000+

Delay: Milliseconds – seconds and beyond

• How to deal with “high variability”

– High variability = large, but finite variance

– High variability = infinite variance

A Working Definition

• A distribution function F(x) or random variable X

is called heavy-tailed if for some 0

P[ X x] 1 F ( x) cx , x

where c>0 and finite

•

•

•

•

F is also called a power law or scaling distribution

The parameter is called the tail index

1< < 2, F has infinite variance, but finite mean

0 < < 1, the variance and mean of F are infinite

Some Illustrative Examples

• Some commonly-used plotting techniques

– Probability density functions (pdf)

– Cumulative distribution functions (CDF)

– Complementary CDF (CCDF = 1- CDF)

• Different plots emphasize different features

– Main body of the distribution vs. tail

– Variability vs. concentration

– Uni- vs. multi-modal

Probability density functions

Cumulative Distribution Function

1

0.9

Lognormal(0,1)

Gamma(.53,3)

Exponential(1.6)

Weibull(.7,.9)

Pareto(1,1.5)

0.8

0.7

F(x)

0.6

0.5

0.4

0.3

0.2

0.1

0

0

2

4

6

8

10

x

12

14

16

18

20

Complementary CDFs

10

log(1-F(x))

10

10

10

10

0

-1

-2

-3

Lognormal(0,1)

Gamma(.53,3)

Exponential(1.6)

Weibull(.7,.9)

ParetoII(1,1.5)

ParetoI(0.1,1.5)

-4

10

-1

10

0

10

log(x)

1

10

2

Why “Heavy Tails” Matter …

•

•

•

•

Risk modeling (insurance)

Load balancing (CPU, network)

Job scheduling (Web server design)

Towards a theory for the Internet …

20th Century’s 100 largest disasters worldwide

2

10

Technological ($10B)

Log(rank)

Natural ($100B)

Most 101

events are

small

US Power outages

(10M of customers)

0

10

-2

10

-1

0

10

But the large

events are huge

10

Log(size)

Distribuição de Erlang

• Uma variável aleatória X que iguala o comprimento do

intervalo até que r contagens ocorram num processo de

Poisson com média > 0 tem uma v.a. de Erlang com

parâmetros e r. As pdf e CDF de X são:

f ( x)

r 1 x

x e

r

(r 1)!

for x > 0 and r = 1, 2 , …

(x) k x

F ( x) 1

e

k!

k 0

r 1

Erlang: Soma de Exponenciais

• Genericamente: X1, X2, ... Xr, todas independentes e

exponencial(): Z = X1 + X2 + ... Xr Erlang de n estágios

(z ) k z

F (Z z)

e

k!

k 0

r 1

z0

• Ex: tempo de processamento dividido em várias (r) etapas. A

duração de cada etapa é exponencialmente distribuída

com mesmo

Exp()

Exp()

Exp()

Exp()

1

2

3

r

Erlang(r,)

• Se Xi exponencial (i), onde i são diferentes

Z = X1 + X2 + ... Xr Hipoexponencial

Exercícios

• O tempo de CPU de um query típico medida em ms segue uma

distribuição de Erlang de três estágios com = 0.5. Determine qual a

probabilidade que a demanda de CPU da query excederá 1

milisegundo.

• O tempo de vida em dias de um componente de software é modelado

por uma distribuição de Weibull com = 2. A partir de um grande

número de componentes, foi observado que 15% dos componentes que

duraram mais de 90 dias falharam antes de 100 dias. Determine o

parâmetro

Solução #1

• O tempo de CPU de um query típico medida em ms segue uma

distribuição de Erlang de três estágios com = ½. Determine qual a

probabilidade que a demanda de CPU da query excederá 1

milisegundo.

( x ) i x

FX ( x) 1 (

)e

i!

i 0

P( X 1) 1 P( X 1) 1 FX (1)

2

1 1

(1 ) e

2 8

1

( )

2

0.9856

Solução #2

•

O tempo de vida em dias de um componente de software é modelado por

uma distribuição de Weibull com = 2. A partir de um grande número de

componentes, foi observado que 15% dos componentes que duraram mais

de 90 dias falharam antes de 100 dias. Determine o parâmetro

FX ( x) 1 e

x 2

P( X 100 | X 90) 0.15

P (90 X 100)

P( X 90)

FX (100) FX (90)

1 FX (90)

e

( 90) 2

e

(100) 2

( 90) 2

e

0.00008554

0.15

Distribuição dos Mínimos

• Sistema composto de n componentes. Sistema funciona se

todos componentes estão operando corretamente

• Tempo de falha : X1, X2, ...., Xn exponencial ()

• Tempo de de vida do sistema Z = min (X1, X2, ...., Xn)

P(Z z) = P (pelo menos um Xi z) = ?

P (exatamente um Xi z) = ?

Distribuição dos Mínimos

• Sistema composto de n componentes. Sistema funciona se

todos componentes estão operando corretamente

• Tempo de falha : X1, X2, ...., Xn exponencial ()

• Tempo de de vida do sistema Z = min (X1, X2, ...., Xn)

P(Z z) = P (pelo menos um Xi z) = ?

P (exatamente um Xi z) = ?

n

n 1

P(exatamente 1 X i z ) FX ( z )1 FX ( z )

1

n

z

z n 1

1 e 1 (1 e )

1

Distribuição dos Mínimos

• P(Z z) = P (pelo menos um Xi z)

Distribuição dos Mínimos

• P(Z z) = P (pelo menos um Xi z)

n

n j

j

P ( pelo menos 1 X i z ) FX ( z ) 1 FX ( z )

j 1 j

n

n

z n j

z j

1 e e

j 1 j

n

Z tem distribuição

exponencial com

parâmetro n

n j

n j

p 1 p

j 1 j

n

n j

n j

p 1 p

j 0 j

p = (1-e-z)

n

n 0

n

p 1 p

0

1 (1 p ) 1 1 1 e

n

z

n

1 e nz

Distribuição dos Máximos

• n tarefas independentes : X1, X2, ...., Xn: exponencial ()

• Tempo de resposta = tempo de execução da tarefa mais longa

Z = max (X1, X2, ...., Xn)

– Ex: tempo de resposta de máquina de busca composta de n

processadores executando em paralelo. Cada máquina processa

consulta em uma partição do dicionário

Front-end:

atraso desprezível

Distribuição dos Máximos

• n tarefas independentes : X1, X2, ...., Xn: exponencial ()

• Tempo de resposta = tempo de execução da tarefa mais

longa

Z = max (X1, X2, ...., Xn)

P( Z z ) P(max( X i ) z )

P( X 1 z X 2 z ... X n z )

P( X n z ) P( X 2 z )... P( X n z )

(1 e z )(1 e z )...(1 e z ) (1 e z ) n

Gerando Distribuições

• Como gerar amostras de uma distribuição a

partir de um gerador de números

aleatórios uniformemente distribuídos

(Unix: random(), drand48())?

Gerando Distribuições

Ex: geração de amostras de uma distribuição exponencial

F(X) = 1 – e-x

Y = F-1(X) = - 1/ ln(1 – Z), onde Z uniforme(0,1)

F(Z z) = z

F(Y) = P(Y y) = P(- 1/ ln(1 – Z) y )

= P (ln(1 – Z) -y)

= P( 1 – Z e-y)

= P(Z 1 - e-y ) = 1 - e-y

Y é exponencial

O mesmo procedimento pode ser utilizado para gerar

amostras de diferentes distribuições, partindo da

inversa da CDF da distribuição desejada

Gerando Distribuições

Gerador de números aleatórios

retorna valor entre 0 e 1. Ex: 0.52

0.8

F(X) = P(X < x)

Z: uniforme (0,1)

1

0.6

X: distribuição que

você quer gerar

0.4

0.2

0

0

20

40

60

80

100

x

Aplicando o número aleatório na função inversa de F(X),

consegue-se gerar um ponto amostral

Para-Casa (próxima aula!)

• Converse com seu orientador, e traga um exemplo

exepcionalmente bom ou ruim (de preferência) de

apresentação e sumarização de dados de

proceedings de conferências importantes de sua

área. Prepare um texto de no máximo 1 folha com

suas críticas e ou elogios ao métodos usados.