UNIVERSIDADE DO SUL DE SANTA CATARINA

MARCELO FEIJÓ VARGAS

DATA WAREHOUSE E BIG DATA:

INTELIGÊNCIA COMPETITIVA COM SOFTWARE LIVRE

Florianópolis

2016

MARCELO FEIJÓ VARGAS

DATA WAREHOUSE E BIG DATA:

INTELIGÊNCIA COMPETITIVA COM SOFTWARE LIVRE

Trabalho de Conclusão de Curso apresentado ao Curso

de Especialização em Redes e Segurança da Informação

da Universidade do Sul de Santa Catarina, como

requisito parcial à obtenção do título de Especialista.

Orientador: Profa. Vera Rejane N. Schuhmacher. Dra.

Co-Orientador: Eder Carlos Querino. Esp.

Florianópolis

2016

MARCELO FEIJÓ VARGAS

DATA WAREHOUSE E BIG DATA:

INTELIGÊNCIA COMPETITIVA COM SOFTWARE LIVRE

Este Trabalho de Conclusão de Curso foi julgado

adequado à obtenção do título de Especialista em Redes

e Segurança da Informação e aprovado em sua forma

final pelo Curso de Especialização em Engenharia de

Redes e Segurança da Universidade do Sul de Santa

Catarina.

Florianópolis, 15 de fevereiro de 2016.

______________________________________________________

Profa. Vera Rejane N. Schuhmacher. Dra.

Universidade do Sul de Santa Catarina

“A única maneira de fazer um bom

trabalho é amando o que você faz. Se você

ainda não encontrou, continue procurando.

Não se desespere. Assim como no amor,

você saberá quando tiver encontrado.”

Steve Jobs.

RESUMO

O BI, também conhecido por Inteligência de Negócios ou Inteligência Empresarial, é o

conjunto de tecnologias orientadas a disponibilizar informação e conhecimento em

uma empresa. Sua implementação inclui ferramentas como Customer Relationship

Management (CRM), Data Mining, Data Warehouse, entre outras. Data Warehouse

(DW) e Big Data (BD) são ferramentas cuja concepção e administração são voltados à

bancos de dados ou um volume de dados para apoio à tomada de decisão. O

surgimento de ferramentas que podem ser obtidas gratuitamente (ou a custos

reduzidos), as médias e pequenas empresas começam a se beneficiar da utilização

dessa

tecnologia.

Neste

trabalho

busca-se

demonstrar

a

viabilidade

de

desenvolvimento de um DW e BD a partir de ferramentas distribuídas como software

livre. Para tanto, utiliza-se o Pentaho como pacote de software livre para

desenvolvimento e demonstra-se o uso do mesmo através de um exemplo da própria

ferramenta. Ao final, espera-se contribuir para que as empresas adotem uma postura de

trabalho mais voltada à gestão da informação e à criação de estratégias competitivas.

Palavras-chave: Data Warehouse; Business Intelligence; Big Data; software livre;

estratégias competitivas.

ABSTRACT

The BI, also known as Business Intelligence, is a set of technologies used to provide

information and knowledge on a company. Its implementation includes tools like

Customer Relationship Management (CRM), Data Mining, Data Warehouse, among

others. Data Warehouse (DW) and Big Data (BD) is a tool whose design and

administration are focused on databases or volume of data that support decision

making. The emergence of tools that can be obtained for free (or low-cost), the

medium and small businesses start to benefit from the use of this technology. The

present study attempts to demonstrate the feasibility of developing a DW and BD from

tools distributed as free software. In order to achieve this, the Pentaho is used as a free

software package for DW development and it demonstrates the use of it through an

example of the tool itself. With this work, it is expected to help companies to adopt a

posture more focused on information management and on the creation of competitive

strategies.

Keywords: Data Warehouse; Business Intelligence; Big Data; free software;

competitive strategies.

LISTA DE ILUSTRAÇÕES

Figura 1 - Representação do modelo dimensional.................................................................... 18

Figura 2 - Representação do modelo estrela ............................................................................. 19

Figura 3 - Representação do modelo floco de neves ................................................................ 19

Figura 4 - Drill-Down .............................................................................................................. 25

Figura 5 - Drill Up ................................................................................................................... 26

Figura 6 - Slice and Dice .......................................................................................................... 26

Figura 7 – Imagem mostra como Big Data pode dar retorno através de dados sobre o mercado.

.................................................................................................................................................. 29

Figura 8 - Face do sistema Continuuity – EUA – 2012. .......................................................... 31

Figura 9 - Bubble Chart sobre educação e professores nos EUA – 2009. ............................... 32

Figura 10 - Arquitetura do Pentaho BI..................................................................................... 36

Figura 11 - Inicialização do Pentaho BI Plataform ................................................................. 38

Figura 12 - Login Pentaho ........................................................................................................ 39

Figura 13 - Menu Solutions ...................................................................................................... 39

Figura 14 - Visualização do exemplo disponível ..................................................................... 40

LISTA DE ABREVIATURAS E SIGLAS

BI

BD

CRM

DM

DW

ER

ETC

IBM

JRE

PCI

PPL

SAD

SGBD

OLAP

TI

- Business Intelligence

- Big Data

- Customer Relationship Management

- Data Mining

- Data Warehouse

- Entidade Relacionamento

- Extração, Transformação e Carga

- International Business Machines

- Java Runtime Environment

- Pre-Configured Installation

- Pentaho Public License

- Sistemas de Apoio à Decisão

- Sistema Gerenciador de Banco de Dados

- On-line Analytical Processing

- Tecnologia da Informação

SUMÁRIO

1 INTRODUÇÃO ............................................................................................................................. 10

1.1 APRESENTAÇÃO .......................................................................................................................10

1.2 JUSTIFICATIVA .........................................................................................................................11

1.3 OBJETIVO GERAL .....................................................................................................................14

1.4 OBJETIVOS ESPECÍFICOS........................................................................................................14

1.5 METODOLOGIA .........................................................................................................................14

2 DATA WAREHOUSE .................................................................................................................. 16

2.1 CONCEITOS E CARACTERÍSTICAS DE DATA WAREHOUSE .............................................16

2.2 MODELAGEM DIMENSIONAL ................................................................................................17

2.3 ETAPAS PARA A CRIAÇÃO DE UM DW ...............................................................................21

2.4 EXTRAÇÃO, TRANSFORMAÇÃO E CARGA.........................................................................22

2.5 ON-LINE ANALYTICAL PROCESSING - OLAP ....................................................................24

2.6 OPERAÇÕES BÁSICAS EM DATA WAREHOUSE ...................................................................25

2.7 CONCLUSÃO ..............................................................................................................................27

3 BIG DATA ..................................................................................................................................... 28

3.1 CONCEITOS E MERCADO COM BIG DATA ...........................................................................28

3.2 GRANDES VOLUMES DE DADOS ..........................................................................................30

3.3 BIG DATA E O FUTURO ...........................................................................................................30

3.4 EMPRESAS E OS DADOS .........................................................................................................32

3.5 CONCLUSÃO ..............................................................................................................................33

4 PLATAFORMA PENTAHO ....................................................................................................... 34

4.1 PROCESSOS E DEFINIÇÕES ....................................................................................................34

4.2 LICENÇAS E FORMAS DE OBTENÇÃO DO PENTAHO .......................................................35

4.3 ARQUITETURA ..........................................................................................................................35

4.4 INSTALAÇÃO .............................................................................................................................37

5

CONCLUSÔES E TRABALHOS FUTUROS............................................................................ 41

REFERÊNCIAS .................................................................................................................................. 42

BIBLIOGRAFIA COMPLEMENTAR .....................................................................................................44

10

1

INTRODUÇÃO

1.1 APRESENTAÇÃO

Quanto mais conhecimento a humanidade adquire, mais complexos se

tornam os sistemas, as empresas e a sociedade. Os administradores de empresas

passam a maior parte de seu tempo identificando e analisando informações que os

levam às decisões necessárias para o gerenciamento de seus empreendimentos e

negócios. Vários fatores contribuem para mudanças no modo de se tomar decisões

estratégicas nos negócios e nas empresas (DATAMIND TECHNOLOGY CENTER,

1998).

Pensando nisso, introduziu-se alguns conceitos no mercado, o primeiro e

mais antigo, é o conceito de Data Warehouse (DW), com sua concepção e

administração voltados a bancos de dados para apoio à tomada de decisão. Esse

conceito consiste em organizar os dados corporativos da melhor maneira, para dar

subsídio de informações para a tomada de decisão por parte dos gerentes e diretores

das empresas. Tudo isso em um banco de dados paralelo aos sistemas transacionais da

empresa.

O Data Warehouse (DW) é uma ferramenta no contexto do Business

Intelligence (BI). O BI, também conhecido por Inteligência de Negócios ou

Inteligência Empresarial, é o conjunto de tecnologias orientadas a disponibilizar

informação e conhecimento em uma empresa e inclui ferramentas como Customer

Relationship Management (CRM), Data Mining (DM), Data Warehouse, entre outras

(MACHADO, 2004).

Outro conceito que surgiu no mercado chama-se Big Data, essa tecnologia

descreve uma nova geração de arquiteturas, projetadas para economicamente extrair

11

valor de um grande volume, sobre uma grande variedade de dados, permitindo alta

velocidade de captura, e/ou análise (GANTZ, 2011).

Conhecer mais sobre essas tecnologias permite aos administradores

descobrir novas maneiras de criar diferenciais para uma empresa em uma economia

globalizada, deixando-os mais seguros para definirem metas e adotarem diferentes

estratégias em uma organização. Assim, eles conseguem visualizar, antes de seus

concorrentes, novos mercados e oportunidades, além de atuar de maneiras diferentes

conforme o perfil de seus consumidores.

Esta monografia contribui no sentido de conhecer alguns conceitos sobre

Data Warehouse e Big Data. Além de analisar uma suíte completa de ferramentas

computacionais que podem auxiliar nos processos de tomada de decisões, por

intermédio de um Data Warehouse e Big Data.

O presente trabalho está dividido em cinco capítulos. Este primeiro capítulo

faz a apresentação do tema do trabalho, seguida da definição do problema e da

justificativa desta pesquisa. Os objetivos gerais e específicos também são relacionados,

finalizando com a descrição da metodologia a ser seguida para o desenvolvimento da

pesquisa e para alcançar os objetivos. O segundo capítulo descreve conceitos de DW,

modelagem dimensional, além de dar ênfase às etapas para construção de um DW, o

processo de Extração, Transformação e Carga (ETC) dos dados, modelo dimensional

OLAP (On-line Analytical Processing) e as operações básicas em um DW. No terceiro

capítulo é apresentado a novo conceito chamado de Big Data. Por fim, no quarto

capítulo são registradas as considerações finais e após, as referências bibliográficas

que nortearam o desenvolvimento deste trabalho.

1.2 JUSTIFICATIVA

Para competir no mercado e superar a concorrência, médias e pequenas

empresas precisam saber mais sobre seus clientes, mercado e tecnologias. Torna-se

necessário ter informações confiáveis e no momento certo (HEINRICHS e LIM,

12

2003). Um gerente, para tomar decisões, baseia-se em uma série de relatórios com

informações da empresa. Ter informações em mãos é, portanto, um elemento

importante para quem quer tomar decisões rápidas e que podem trazer vantagens na

hora da competição.

Algumas aplicações dão suporte às empresas no processo de tomada de

decisão, pode-se destacar os Sistemas de Apoio à Decisão (SAD) e os sistemas de

Business Intelligence (BI). Esses sistemas contam com algumas ferramentas para a sua

construção, entre elas, estão os Data Warehouse (DW).

Segundo Inmon (1997), “Data Warehouse (DW) é um conjunto de dados

baseados em assuntos, integrados, não-voláteis e variáveis em relação ao tempo, para

apoio às decisões gerenciais”. Kimball (1997), por sua vez, amplia esse conceito,

incluindo um conjunto de ferramentas e técnicas de projeto que, quando aplicadas às

necessidades específicas dos usuários, permite o planejamento e a construção do DW.

Segundo Torres (1995), no mundo atual dificilmente se pode competir na

grande maioria dos negócios sem o uso da Tecnologia da Informação (TI). Em outras

palavras, existe um relacionamento muito grande entre a TI e o comportamento

estratégico de uma organização. Nesse sentido, a TI não é apenas um elemento

operacional ou integrante de produtos e serviços, pois tem seu valor estratégico em

uma de suas funções mais tradicionais, que é o fornecimento de informações para a

gestão. Dessa forma, um bom conjunto de informações de natureza estratégica pode

tornar a empresa mais competitiva na medida em que melhora a tomada de decisão.

O uso estratégico da informação tem se tornado uma necessidade cada vez

mais clara para as empresas. Quando a informação é bem utilizada, ela pode agregar

valor ao negócio, além de gerar outros benefícios para a empresa, como reduzir custos

ou identificar novos nichos de mercado.

Empresas de maior porte geralmente têm seus sistemas de informação

construídos sob as plataformas de grandes fabricantes de hardware e software, como

IBM, Oracle e Microsoft, os quais apresentam módulos próprios para BI.

Entre as empresas de pequeno e médio porte, esse tipo de sistema tem

aplicação limitada devido ao alto custo das ferramentas proprietárias. Essas empresas,

pressionadas por custos, geralmente buscam soluções tecnológicas insuficientes, pois

13

não têm poder para investir nos recursos necessários para uma estratégia voltada à

inteligência de negócios. Projetos de Business Intelligence e Big Data utilizam

softwares para análise de padrões e gestão da informação, além de outros recursos,

muitas vezes fora do seu alcance.

No entanto, nos últimos anos vem ocorrendo uma interessante mudança

para as empresas, que não envolve grandes investimentos em infra-estrutura

tecnológica. Esta mudança está associada à existência de excelentes softwares livres e

confiáveis, que podem ser utilizados de maneira muito profissional, como bancos de

dados, suítes de escritório, bem como, programas para a implantação de BI e Big Data.

A promessa inovadora do big data é a sua capacidade de tornar as redes

complexas não apenas mais compreensíveis, mas também mais previsíveis e mais

controláveis. A afirmação vem dos pesquisadores da novíssima Ciência das Redes

(ZUPPO, 2013).

Uma das principais colaborações da Ciência das Redes para as organizações

que desejam desenvolver metodologias e ferramentas em big data vem da afirmação de

que devemos ver os dados como parte de um ecossistema. Isso quer dizer que não deve

existir uma abordagem a partir de uma única perspectiva e que todos os participantes

da rede deverão ser levados em conta nos estudos das ameaças e oportunidades na

modelagem de novos empreendimentos (ZUPPO, 2013).

Em consistência com a diversidade dos dados existentes é necessário que a

abordagem metodológica não seja prerrogativa de uma única ciência. Os dados que

temos são universais, gerados por todos (usuários ou não da internet) e com um

potencial de inovação que não deve respeitar fronteiras geográficas ou de domínio do

conhecimento (ZUPPO, 2013).

Diante dessas afirmações, e concordando com elas, aceitamos o desafio de

esquematizar o que seria um ecossistema Big Data. A descrição mais básica de um

sistema de geração de conhecimento a partir de dados digitais seria: a partir de dados

armazenados, aplicamos tecnologias de processamento cujas informações geram

insights para os tomadores de decisão (ZUPPO, 2013)..

Portanto, a importância do BI e Big Data, no planejamento estratégico

começam a ser sentida a partir do momento em que a pequena e média empresa

14

adotam uma postura de trabalho mais voltada à gestão da informação. Somente com

informação íntegra e confiável é possível criar estratégias que atendam melhor seus

clientes e colocar a empresa em um patamar de competitividade mais lucrativo. Com

as ferramentas distribuídas sob a filosofia do software livre, as pequenas e médias

empresas passam a se beneficiar da utilização dessa tecnologia, reduzindo seu custo de

implantação.

1.3 OBJETIVO GERAL

O objetivo geral desse trabalho é os mostrar os conceitos para a viabilidade

de desenvolvimento de um Data Warehouse integrada à Big Data, a partir de um

conjunto de ferramentas distribuídas como software livre.

1.4

OBJETIVOS ESPECÍFICOS

Os objetivos específicos desse trabalho são:

a) Descrever os conceitos de um Data Warehouse e Big Data

b) Definir um pacote de software livre que pode ser utilizado para

desenvolvimento de Data Warehouse e Big Data;

1.5

METODOLOGIA

O presente trabalho de monografia para conclusão do curso foi dividido em

duas etapas. Inicialmente, tem-se uma visão geral do trabalho, na qual descreveu a

15

apresentação do tema, bem como os objetivos, a justificativa, o cronograma, a

metodologia e as referências bibliográficas.

Ainda na primeira etapa, foi realizado um levantamento bibliográfico em

que foram abordados os conceitos de Data Warehouse e Big Data, para inclusão em

projetos de software livre para construção de uma plataforma integrada e completa,

contemplando as tecnologias de Big Data e DW.

Na segunda etapa foi apresentado e dado ênfase para a plataforma Pentaho,

bem como a apresentação, configuração e instalação da mesma.

Ao final, espera-se contribuir para que os usuários finais adotem uma

postura de trabalho mais voltada à gestão da informação, com a informação íntegra e

confiável, criando estratégias e, ainda, colocando a empresa em um patamar de

competitividade lucrativo.

16

2

DATA WAREHOUSE

Neste capítulo é apresentada uma descrição geral do que é um Data

Warehouse (DW), juntamente com alguns conceitos relacionados. Entre os conceitos,

destacam-se a modelagem dimensional, aplicada na fase de projeto de um DW, o

processo de ETC (Extração, Transformação e Carga) e o OLAP (On-Line Analytical

Processing), que permite visualizar e analisar grandes quantidades de dados. As etapas

para a criação de um Data Warehouse também são discutidas, com alguns exemplos

ilustrativos.

2.1 CONCEITOS E CARACTERÍSTICAS DE DATA WAREHOUSE

Inicialmente, são analisadas algumas definições de Data Warehouse

elaboradas por especialistas da área. Segundo Inmon (1997), idealizador do conceito,

Data Warehouse “é uma coleção de dados integrados, orientados por assunto,

variáveis com o tempo e não voláteis, usados para dar suporte ao processo gerencial de

tomada de decisão”.

A partir da definição de DW feita por Inmon (1997) e vista anteriormente, é

possível encontrar as principais características de Data Warehouse, que são:

• Integrado - A integração dos dados ocorre quando os dados são passados

do ambiente transacional, através de diversas fontes de dados, para o

ambiente de DW. Todo dado trazido dos sistemas transacionais para o

ambiente de DW é, anteriormente, consolidado, de forma que passe a ter

um único significado;

• Orientado por assuntos - os dados do Data Warehouse são organizados

de modo a facilitar a análise dos dados, para isso o DW contém

informações orientadas a assuntos importantes para o negócio da empresa

(análise de vendas) e não por aplicação, como em bancos de dados

17

transacionais (aplicação de vendas);

• Variante no Tempo - os dados não são atualizáveis, ou seja, são relativos

a um determinado instante de tempo, o que proporciona o

armazenamento histórico dos dados;

• Não volátil – significa dizer que o Data Warehouse permite apenas a

carga inicial dos dados e consultas a estes dados, ou seja, após serem

integrados, transformados e incluídos, os dados não podem ser alterados.

2.2 MODELAGEM DIMENSIONAL

Nos bancos de dados relacionais, usados nos sistemas transacionais

tradicionais, a redundância dos dados é evitada, sendo aceita somente em

determinados casos em que é realmente necessária. Esta redundância é eliminada

através de processos de normalização. A normalização das tabelas traz benefícios nos

casos em que muitas transações são efetuadas, pois estas se tornam mais simples e

rápidas. No caso de Data Warehouses, ocorre o contrário, as transações operam sobre

um grande volume de dados e não são simples, nem freqüentes, não sendo conveniente

a normalização das tabelas, pois no ambiente de Data Warehouse ocorrem poucas

transações concorrentes e cada transação acessa um grande número de registros

(PERNAS, 2003).

Conforme Pernas (2003), outro ponto que distingue o banco de dados

relacional do Data Warehouse está relacionado à modelagem dos dados. Enquanto que

em um banco de dados relacional geralmente utiliza-se a modelagem Entidade–

Relacionamento (ER), em um DW utiliza-se de uma modelagem lógica denominada de

modelagem dimensional, também chamada de modelagem multidimensional. Assim,

modelagem dimensional é a técnica utilizada para se ter uma visão multidimensional

dos dados.

Segundo Kimball (1997), a modelagem dimensional “é uma técnica de

projeto lógico que busca apresentar os dados em uma estrutura padrão e intuitiva que

18

permite um acesso de alta performance”. Essa é uma técnica antiga usada para criar

bancos de dados simples e compreensíveis.

Um modelo dimensional é composto, basicamente, pela tabela de fatos e

pelas tabelas de dimensões (Figura 1). A tabela de fatos traz o resultado da consulta,

ou seja, os valores de medição representando transações ou eventos referentes aos

negócios da organização e que podem ser passíveis de análise. Uma dimensão pode

agregar sob nomes distintos, um conjunto de itens com características e posições

próprias, tais como meses e trimestres em relação a um período anual (FROZZA,

2006).

Figura 1 - Representação do modelo dimensional

(FONTE: SHIGUNOV, 2007)

Existem várias técnicas para fazer a modelagem dimensional, sendo as

principais: o modelo estrela (Star Schema), que se assemelha a uma estrela, e o modelo

floco de neves (Snow Flake).

Dominante no projeto de DW (KIMBALL, 1997), a modelagem

dimensional no modelo estrela possui as seguintes características:

• Distingue bem as dimensões dos fatos medidos;

• Simplifica a visualização dimensional;

• É eficiente para a realização de consultas;

• Acomoda mudanças mais facilmente.

19

A Figura 2 ilustra um esquema dimensional na forma de estrela para um

DW de vendas, com as dimensões tempo, região, produto, vendedor, cliente e as

medidas da tabela de fatos (valor das vendas, média das vendas).

Figura 2 - Representação do modelo estrela

No modelo floco de neves as tabelas de dimensão são normalizadas, evitam

redundância e requerem mais junções para as consultas (Figura 3).

Figura 3 - Representação do modelo floco de neves

20

De acordo com Barbieri (2001, p. 74), “a modelagem de dados é

seguramente um dos fatores críticos de sucesso num projeto de Data Warehouse, e

pode representar a fronteira entre o sucesso e o seu fracasso”.

Como o modelo relacional trabalha com normalização, suas tabelas

possuem menos registros e não têm redundâncias, apresentando assim uma melhor

performance nas tarefas do dia-a-dia, como inclusões, alterações e exclusões de

registros. Mas ele só é adequado para consultas simples de poucos registros. Para

análises mais complexas, com um universo de registros maior, o modelo dimensional

oferece uma melhor alternativa, economizando em junções com várias tabelas e

armazenando dados que facilitam a análise das informações (HOKAMA et al., 2004,

p. 32).

Para se elaborar um esquema dimensional deve-se levar em conta a

granularidade desejada para a análise. Granularidade se define como o nível com que

os dados estão sumarizados. O grão é o maior nível de detalhamento. O nível

adequado de granularidade deve ser definido de tal forma que atenda às necessidades

do usuário, tendo como limitação os recursos disponíveis (SHIGUNOV, 2007). A

granularidade afeta diversas características em um DW, como o número de diferentes

cruzamentos de dados que podem ser realizados, a infra-estrutura e o espaço em disco

necessário.

Uma dimensão de um cubo é uma coleção de hierarquias de membros,

organizados de maneira conveniente para análise. Um membro é um ponto em uma

hierarquia de uma dimensão, determinado por um conjunto particular de valores de

atributo. Um nível da hierarquia é uma coleção de membros que possuem a mesma

distância da raiz da hierarquia. Cada hierarquia de dimensão está associada a um

atributo da tabela de fatos (MACDONALD e RUBIK, 2007).

21

2.3 ETAPAS PARA A CRIAÇÃO DE UM DW

Kimball (1997) propõe nove etapas para a criação de um banco de dados

dimensional:

a) selecionar o processo de negócio a ser modelado - sendo um processo

executado na organização. Portanto, é importante não se referir a um

departamento ou função de negócio da organização, já que se trata do

processo do negócio. Um exemplo é um modelo dimensional único para

tratar de dados de pedidos, em vez de criar um modelo dimensional para

o departamento de vendas e um para o de marketing, em que ambos

desejam acessar dados de pedidos;

b) declarar o grão (nível de detalhes) do processo de negócio - declarar o

grão significa especificar exatamente o que uma linha da tabela de fatos

representa;

c) escolher as dimensões que se aplicam a cada linha da tabela de fatos quando não há dúvidas a respeito do grão, geralmente as dimensões

podem ser identificadas facilmente;

d) identificar os fatos numéricos que preenchem cada linha da tabela de

fatos - o interesse é analisar as medidas de desempenho do processo de

negócio. Todos os fatos candidatos em um projeto devem ser verdadeiros

para o grão definido na etapa da declaração do grão e fatos típicos são

valores numéricos aditivos, como quantidade vendida ou valor de custo;

e) armazenar os dados pré-calculados na tabela de fatos - para evitar

possíveis inconsistências para o usuário final, todos os dados calculados

são armazenados fisicamente na tabela de fatos;

f) fazer a carga das tabelas de dimensão - neste ponto, a tabela de fatos está

completa e o papel das tabelas de dimensão é fornecer entradas para a

tabela de fatos diretamente de atributos dimensionais;

g) preparar dimensões para suportar evoluções (mudanças) – verifica-se a

possibilidade de determinados valores de atributos das tabelas de

22

dimensões, os quais dificilmente sofrem alterações, necessitarem de

atualizações;

h) definir a amplitude de tempo do histórico do banco de dados - ou seja, a

duração do banco de dados. Esta escolha está relacionada com o período

de tempo da tabela de fatos no Data Warehouse, de acordo com o

processo de negócio da empresa;

i) definir o espaço de tempo com que os dados devem ser extraídos e

carregados no DW – define o intervalo de tempo do processo de extração

de dados dos sistemas transacionais e sua conseqüente carga no DW.

2.4 EXTRAÇÃO, TRANSFORMAÇÃO E CARGA

A etapa de ETC (Extração, Transformação e Carga) é uma das fases mais

críticas de um Data Warehouse, pois divide-se em três fases (BORTOLINI, 2008):

a) a fase de extração dos dados dos sistemas transacionais ou de outras fontes

(planilhas, arquivos e textos);

b) a fase de filtragem, que consiste basicamente em garantir a integridade dos

dados;

c) a fase de carga dos dados no Data Warehouse.

Quando os dados são copiados de sistemas transacionais para o ambiente de

Data Warehouse parece que nada além de simples extrações de dados de um local para

outro está ocorrendo. Em virtude desta enganosa simplicidade, muitas vezes as

empresas acabam perdendo tempo e dinheiro por ter que refazer toda esta parte de

extração. A etapa de ETC tem influência em quase todas as nove etapas de criação de

um DW definidas na seção anterior.

A extração de dados do ambiente operacional para o ambiente de Data

Warehouse demanda uma mudança na tecnologia, pois, muitas vezes, os dados são

23

transferidos de um banco de dados hierárquico, para uma nova tecnologia de SGBD

(Sistema Gerenciador de Banco de Dados) para DW (BORTOLINI, 2008).

Os bancos de dados transacionais armazenam as informações das transações

diárias da empresa. São utilizados por todos os funcionários para registrar e executar

operações pré-definidas, por isso seus dados podem sofrer constantes mudanças. Por

não ocorrer redundância nos dados e as informações históricas não ficarem

armazenadas por muito tempo, este tipo de banco de dados não exige grande

capacidade de armazenamento (BORTOLINI, 2008).

Um DW, por sua vez, armazena dados analíticos, destinados às

necessidades da gerência no processo de tomada de decisões. Isto pode envolver

consultas complexas que necessitam acessar um grande número de registros. Um DW

armazena informações históricas de muitos anos e por isso deve ter uma grande

capacidade de processamento e armazenamento dos dados, os quais se encontram em

dois formatos: detalhados e resumidos (BORTOLINI, 2008).

A seleção de dados do ambiente operacional pode ser muito complexa, pois,

em geral, é necessário selecionar vários campos de um sistema transacional para

compor um único campo no Data Warehouse (por exemplo, o percentual de

lucratividade, que é dado pelo valor do custo sobre o valor da venda), ou integrar

campos de vários sistemas transacionais em um campo com representação única no

DW (por exemplo, um campo representando o sexo de uma pessoa). Ainda, os dados

podem ser reformatados, por exemplo: um campo data do sistema transacional, do tipo

DD/MM/AAAA, pode ser exportado para o outro sistema com o tipo ano e mês como

AAAA/MM/DD (BORTOLINI, 2008).

Podem existir várias fontes de dados diferentes para compor uma

informação, que pode ser oriunda de uma planilha Excel, por exemplo, enquanto uma

outra informação que serve para compor um mesmo fato vem de um arquivo texto.

Quando há vários arquivos de entrada, a escolha das chaves deve ser feita

antes que os arquivos sejam intercalados. Isso significa que, se diferentes estruturas de

chaves são usadas nos diferentes arquivos de entrada, então se deve optar por apenas

uma dessas estruturas (BORTOLINI, 2008). Os arquivos devem ser gerados

obedecendo a mesma ordem das colunas estipuladas no ambiente de Data Warehouse.

24

Pode haver vários resultados e dados podem ser produzidos em diferentes níveis de

resumo pelo mesmo programa de criação do Data Warehouse.

Valores padrões devem ser fornecidos. Às vezes pode existir um campo no

Data Warehouse que não possui fonte de dados. Então, a solução é definir um valor

padrão para estes campos.

Após a definição de como devem ficar os dados no Data Warehouse, há a

necessidade de filtragem dos dados para colocá-los no padrão definido. Por exemplo,

em um sistema transacional, o campo de sexo é preenchido como F ou M, e em um

outro sistema este mesmo dado é preenchido com 0 ou 1. É justamente nesta hora que

entra a parte de filtragem, que é transformar os dados para um padrão definido, que no

exemplo pode ser F ou M.

2.5 ON-LINE ANALYTICAL PROCESSING - OLAP

On-Line Analytical Processing (OLAP) significa analisar uma grande

quantidade de dados para dar suporte ao processo decisório através de consultas ou

análises feitas por analistas, gerentes e executivos. OLAP está associado à interface de

consulta de dados no DW. O termo on-line implica que, até mesmo com a grande

quantidade de dados envolvida, tipicamente muitos milhões de registros, ocupando

muitos gigabytes, o sistema deve responder às consultas (queries) rápidas o suficiente

para permitir uma exploração interativa dos dados (MACDONALD e RUBIK, 2007).

OLAP emprega uma técnica chamada Multidimensional Analysis, ou

Análise Multidimensional. Enquanto um banco de dados relacional armazena todos os

dados na forma de linhas e colunas, um conjunto de dados multidimensional consiste

em eixos e células (MACDONALD e RUBIK, 2007).

As ferramentas OLAP permitem aos usuários analisar os dados em

dimensões múltiplas, como produto, tempo e vendedor. Cada dimensão pode conter

hierarquias, por exemplo, a dimensão tempo pode conter as hierarquias ano, mês e dia.

Os dados nestas dimensões são agregados, ou seja, são resumidos, mas pode-se

25

navegar livremente de uma hierarquia para outra, até se chegar à máxima

granularidade dos dados.

2.6 OPERAÇÕES BÁSICAS EM DATA WAREHOUSE

Em um sistema de Data Warehouse, as principais operações disponíveis nas

interfaces OLAP são:

• Drill Down

A operação Drill Down é utilizada para solicitar uma visão mais

detalhada de um conjunto de dados. Conforme Machado (2004), quando

o usuário aumenta o nível de granularidade, diminui o nível de

detalhamento da informação, como mostra a Figura 4.

• Drill Up

Conforme Machado (2004), com a capacidade de Drill up o usuário pode

navegar do nível de maior detalhe até o mais alto nível de maior

sumarização de dados.

Figura 4 - Drill-Down

26

Fonte: CARUSO - 2007

Figura 5 - Drill Up

Fonte: CARUSO - 2007

• Slice and Dice

A tradução livre é corte e picadinho. Possibilita selecionar apenas uma

parte do cubo para análise dos dados.

São operações para realizar a navegação dos dados na visualização de um

cubo. Slice and Dice significa, em uma forma simplista, a redução do

escopo dos dados em análise, além de mudar a ordem das dimensões,

mudando desta forma a orientação segundo a qual os dados são

visualizados (MACHADO, 2004).

Figura 6 - Slice and Dice

Fonte: CARUSO - 2007

27

2.7

CONCLUSÃO

Para a elaboração de um Data Warehouse é de extrema importância ter

conhecimento de sua estrutura e seus recursos. Com este capítulo, pode-se ter noção

dos conceitos, características, e etapas para o desenvolvimento de um sistema de BI –

Business Intelligence, no caso específico, um Data Warehouse.

Observa-se a necessidade de seguir algumas regras para desenvolver um

DW, as quais são: planejamento, obtenção da fonte de dados, modelagem dimensional,

extração, transformação e carga dos dados e, por fim, as operações básicas em

interfaces OLAP Drill Down, Drill Up e Slice and Dice, importantes para que o

usuário saiba utilizar os recursos de navegação e detalhamento, sumarização das

granularidades e enfim, a disponibilização dos dados para análise e posterior validação

do usuário final.

No caso desta monografia, este capítulo representa a fase de estudos sobre

os conceitos e processos de desenvolvimento de um DW.

28

3

BIG DATA

Neste capítulo mostraremos uma ideia geral sobre o novo conceito chamado

Big Data, além de técnicas e ferramentas para extração de um grande volume de

dados.

O capítulo está organizado da seguinte forma, inicialmente será abordado os

conceitos de Big Data, em seguida será tratado o futuro dessa técnica. Após isso

explicaremos como o mundo empresarial anda fazendo com a utilização do Big Data,

por fim as considerações finais.

3.1 CONCEITOS E MERCADO COM BIG DATA

Já pensou uma situação onde dados de uma loja virtual que vende tanto para

o Brasil como para o exterior, rodando numa plataforma que não suporte nem metade

das informações contida em seu banco de dados, e ainda seu retorno e extração deveria

ser em tempo real?

Há alguns anos atrás o mercado sofria com essas situações apesar de que

seu volume de dados não era tão imenso como é hoje. Com tantas informações para

serem gerenciadas as empresas terão que buscar um modo de lidar com essa montanha

de informações e coletar apenas os dados de valor para os negócios. Um estudo foi

feito recentemente pela Oracle informavam que a falta de controle de dados faz as

empresas perderem em média 14% de seu faturamento.

Um bom exemplo mesmo é a bolsa de valores que antigamente, mesmo

possuindo grandes dados, fazia suas transações de negócios na própria bolsa, em cada

cidade de todos os pais, o famoso pregão viva-voz. Hoje essas transações são cada vez

mais realizadas em tempo real. O mercado está cada dia mais consciente que

informação é tudo para os negócios, investir em dados está dando a muitas empresas

grandes retorno financeiro e a visão de como interagir com esses dados tirando

29

proveito dos mesmos. Hoje as corretoras se organizam e possuem ferramentas que tem

o objetivo de gerenciar e retornar dados que darão um norte aqueles que pretendem

investir.

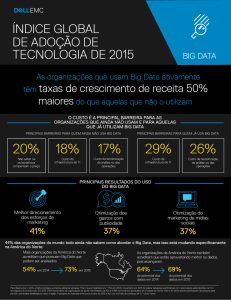

Abaixo a Figura 07 retirada do site visual.ly mostra como o Big Data pode

mapear grande informações e apresentá-los de forma simples ao mundo.

Figura 7 – Imagem mostra como Big Data pode dar retorno através de dados sobre o

mercado.

Fonte: VISUAL. LY – 2012.

O Business Intelligence já era bem chamativo para o setor de análise de

dados e negócios quando o Big Data apareceu se mostrando bem mais atrativo e

rápido para as respostas, que necessitavam de maior precisão em seu retorno. Hoje no

século 21 “Inteligência de Negócio” é o carro chefe tanto para o mundo Business

Intelligence como para o mundo de TI. Na feira CeBit na Alemanha o Big Data foi

mostrado como o mais novo meio de pesquisa de negócios, como no filme Moneyball

com Brad Pitt onde ele usa ferramentas e o conceito do Big Data para coletar dados

com o objetivo de formar o melhor time de beisebol, assim popularizando a ideia.

30

3.2

GRANDES VOLUMES DE DADOS

Em 2014, durante a Copa do Mundo, o Big Data foi utilizado, mostrando

como o método de extração e análise de dados, esta cada vez mais tomando espaço no

mercado, a metodologia que pode prever os negócios. Também usado nos Jogos

Olímpicos o método está crescendo cada vez mais.

Hoje a busca por cientista de dados esta imensa, salários altíssimos para

esses profissionais.

Em reportagem do jornal O Globo, o executivo de operações da EMC, Pat

Gelsinger, afirmou que o mercado global de Big Data já movimenta US$ 70 bilhões

por ano. (DARROW, 2012, s/p)

Muitas novas ferramentas foram criadas para à utilização desses métodos de

análise de grandes dados, no Vale do Silício várias empresas criam projetos que

procuram imitar a eficaz ferramenta de análise de dados construído pelo Google que

usa a metodologia do Big Data.

3.3

BIG DATA E O FUTURO

Como foi dito anteriormente o acúmulo de dados tem sido imenso de uns

tempos para cá e nos últimos anos esse volume absurdamente cresceu. Com estudos e

pesquisa de que isso seria um problema empresas como Yahoo, Amazon, Intel, IBM e

outros se dedicaram a essa solução, tanto para aumento financeiro como inovação de

mercado.

A Amazon que oferece um conjunto de serviços baseados em Cloud

Computing como o seu Amazon Web Services (AWS) e Amazon Elastic MapReduce,

torna mais fácil e econômico aos clientes extrair e processar informações de grandes

volumes de dados, volume esse que é através do AWS, tem a análise de mapeamento,

análise de dados de serviços e análise de logs da web, principalmente, entre outros.

31

Abaixo matéria tirada da ComputerWorld Blakeley mostra os investimentos dessa

técnica.

A Mazda Motor Corp, que possui 900 revendedores e 800 funcionários nos EUA,

gerencia cerca de 90 terabytes de dados. O arquiteto de infraestrutura das operações

da Mazda na América do Norte, Barry Blakeley, diz que as unidades de negócios e

os revendedores estão gerando quantidades cada vez maiores de arquivos de dados

analíticos, materiais de marketing, bases de dados para inteligência de negócios,

dados do Microsoft SharePoint e muito mais. "Temos tudo virtualizados, incluindo o

armazenamento", afirma Blakeley. (BRANDON,2011, s/p)

Recentemente o Yahoo e o Facebook investiram na análise de grande dados

e adotou um serviço em uma nova plataforma chamada Continuuity, sendo em nuvem

é um ambiente de desenvolvimento em tempo de execução que fica em cima da

infraestrutura do Hadoop e abstrai a complexidade de escrever apps. Abaixo a Figura

08 mostra a interface dessa ferramenta que tem como objetivo extrair grandes

informações geradas por essas redes sociais. (HARRY, 2015)

Figura 8 - Face do sistema Continuuity – EUA – 2012.

Fonte: CONTINUUITY – 2012.

Mas é a IBM que está investindo pesado, já tem um web site educacional

com direito a vídeo aulas, material, downloads das ferramentas e certificações,

mostrando como o Big Data funciona e as ferramentas utilizadas. A buscar por

grandes dados de forma organizada estão aumentando cada vez mais entre as

empresas, como é o caso da Terada, HP, Walmart, Google e muitos outros gigantes

que estão aproveitando essa febre.

32

3.4

EMPRESAS E OS DADOS

Tanto o BigSheets, Hadoop e o MapReduce são excelentes ferramentas

utilizadas para o levantamento de grandes dados. Em diversos sistemas, como as

cotações da bolsa, são gigantescas, precisando muitas vezes ser simples de ser

analisada, o Big Data já foi recomendando para ser utilizado na área de cotações da

bolsa, mas por falta de profissionais na área encontrasse só em especulações.

Com o Hadoop é possível iniciar uma busca organizada por esses valores

colocando palavras chaves, retornando com isso algumas informações que ainda pode

ser peneirada para um melhor entendimento. No caso do BigSheets essas respostas são

bem mais rápidas e eficientes buscando através do twitter ou facebook dados

estatísticos para ser aplicado no negocio.

Um dos módulos interessantes das ferramentas do Big data é o bubble chart

‘gráfico de bolhas’ ele mostra de uma forma bem macro todas as informações

desejadas e uma visão de como será aplicadas, pode passar o mouse sobre cada bolha

para ver o que os projetos têm e quanto eles valem. Abaixo um exemplo do bubble

chart é a Figura 09, que mostra resultados obtidos através do BigSheets.

Figura 9 - Bubble Chart sobre educação e professores nos EUA – 2009.

Fonte: OUSEFUL.INFO – 2009.

33

3.5

CONCLUSÃO

Os conceitos vistos para a elaboração desse trabalho foram técnica de

mapeamento de análises, as ferramentas open source usadas nesse processo, como o

meio empresarial está aceitando a ideia e qual as vantagens que essa nova metodologia

está trazendo para os negócios, tornando assim mais fácil a buscar por informações.

Os resultados encontrados através da busca feita pelas ferramentas que

rodam o Hadoop em sua plataforma trouxeram em formas de gráficos e números

dados que antes não tinham um retorno tão direto e tão rápido, utilizado anteriormente

pelas ferramentas Business Intelligence.

Mesmo essa técnica sendo nova, existe muitas empresas que estão

começando a buscar informações sobre o Big Data e o valor que os dados têm para os

negócios, fazendo com que seja fácil disseminar essa ideia tanto no Brasil como em

outros países. Quando começarmos a utilizar essa técnica para buscar informações do

dia a dia de alguma empresa, fazendo uma avaliação de simples palavras, cruzando

assim dados e disponibilizando informações sobre qual empresa será mais viável para

investir e uma previsão sobre o futuro da empresa que estiver em análise.

O Big Data se for usado de maneira correta, permite também aos analistas

identificar tendências e dá ideias de nicho que ajudam a criar valor e inovações muito

mais rápido do que os métodos convencionais.

34

4

PLATAFORMA PENTAHO

Neste capítulo é apresentada uma descrição geral da plataforma Pentaho,

juntamente com algumas definições e processos. Logo após, é abordado como pode ser

obtida e sua licença de uso. Ainda, descreve-se a arquitetura do Pentaho, sua

instalação, como funciona o Mecanismo de Solução e os demais componentes que

formam a arquitetura.

4.1 PROCESSOS E DEFINIÇÕES

A plataforma Pentaho é um conjunto de software open source para criação

de soluções de BI (Business Intelligence) e Big Data. Ela possui ferramentas para

atender ao processo de criação de soluções de BI de ponta-a-ponta, integrada à uma

gama de opções para banco de dados e outras ferramentas. (TEMATEC, 2008)

Quando uma organização precisa tomar uma decisão é indispensável ter

dados corretos e disponíveis para consulta. Para conseguir isso, ela deve tratar e

consolidar as informações armazenadas nos sistemas e fontes de dados que apóiam seu

negócio em um repositório centralizado, criando “uma única versão da verdade”,

limpa e confiável (processo ETC). Depois, pessoas que entendem do negócio da

empresa devem ter acesso a esse repositório e, usando ferramentas de visualização e

exploração de dados, interpretá-los para finalmente tomar uma decisão (TEMATEC,

2008).

O conjunto destes componentes de softwares, dados, operações e processos

usados para atender uma necessidade específica, para tomar uma decisão, são

chamados de solução.

A Pentaho Inc. integrou e promoveu o desenvolvimento de várias

ferramentas open source que fornecem os recursos necessários para criação de

soluções de BI e Big Data. Esse conjunto é conhecido por Pentaho Open BI Suite e

35

inclui ferramentas para consolidar dados de fontes diversas, criar interfaces visuais

para exploração desses dados e montar soluções para necessidades específicas

(TEMATEC, 2008).

4.2 LICENÇAS E FORMAS DE OBTENÇÃO DO PENTAHO

A plataforma Pentaho é distribuída como código aberto, através da Licença

Pública da Pentaho (PPL - Pentaho Public License). A PPL é uma licença para

software livre de código aberto, similar à Licença Pública do Mozilla (versão 1.1)

(PENTAHO, 2015).

A plataforma Pentaho pode ser baixada gratuitamente, através do endereço

http://www.sourceforge.net/projects/pentaho. Existem várias versões disponíveis.

Através do endereço http://www.pentaho.org pode-se ter acesso a um wizard que ajuda

a determinar a versão correta para cada caso.

Para iniciantes, é recomendável fazer o download de uma versão de

demonstração. Estas versões incluem uma aplicação pré-configurada em um servidor

Jboss, juntamente com alguns exemplos e dados em um servidor Sun Microsystems

JRE.

4.3 ARQUITETURA

O projeto Pentaho BI é constituído de um conjunto completo de

ferramentas de BI e bibliotecas que fornecem funcionalidades de BI aos

desenvolvedores. É uma solução com suporte a relatórios, análises, data mining,

workflow e big data através de uma série de componentes que podem ser distribuídos

juntos ou separados (PENTAHO, 2015).

36

O servidor roda de acordo com o padrão de servidores Java, tais como

Apache TomCat e JBoss. Ele utiliza um método de desenvolvimento, distribuição e

suporte que torna possível o modelo de negócios open source (PENTAHO, 2015).

A Figura 10 apresenta a arquitetura do Pentaho, a qual é composta por

componentes de integração de dados, infra-estrutura e apresentação dos dados e a

origem destes dados.

Figura 10 - Arquitetura do Pentaho BI

Fonte: PENTAHO - 2015

O Pentaho abrange, principalmente, as seguintes áreas de aplicação

(PENTAHO, 2015):

• Relatórios (Reporting): Fornece desde simples relatórios em uma página

web, até relatórios de alta qualidade, tais como relatórios de indicações

financeiras e relatórios ricos em conteúdos, como tabelas, gráficos, entre

outros;

• Análises (Analysis): Permite consultas, exploração interativa com

operações slice-and-dice, drill-down e pivoting. Inclui front-end gráfico

para exploração dos cubos OLAP;

• Painéis (Dashboards): Reúne relatórios, análises e outras exposições em

um único local para simplificar o acesso, podendo ser customizado por

37

usuário ou assunto;

• Data mining: Descobre relacionamentos ocultos nos dados, que podem

ser utilizados para otimizar os processos de negócio e prever resultados

futuros. Permite que os resultados sejam exibidos em um formato de fácil

entendimento ao usuário;

• Workflow: Liga diretamente as medidas de desempenho de negócio aos

processos, promovendo um ciclo contínuo de melhorias.

• Big Data: Fornece algumas ferramentas de desenvolvimento que

permitem extrair e preparar os dados para que analistas de dados e

negócios possam tomar decisões.

Todos os componentes da plataforma são de código aberto. O projeto

Pentaho BI oferece uma solução que pode ser utilizada por desenvolvedores Java, os

quais podem utilizar os componentes do projeto para montar rapidamente soluções BI

sob medida. O Pentaho pode ser utilizado por empresas desenvolvedoras de software

para adicionarem as funcionalidades de BI em seus produtos. O projeto pretende,

ainda, permitir que usuários finais tenham acesso a soluções de BI com a qualidade

dos softwares comerciais tradicionais, porém com um custo bem mais acessível.

4.4 INSTALAÇÃO

A instalação pré-configurada (biserver-ce-5.0.1-stable), usada neste

trabalho, é uma instalação completa de servidor, projetada para avaliar as

características da plataforma de BI Pentaho. A suíte disponibiliza um servidor de

aplicação pré-configurado, bases de dados de aplicação pré-povoadas, dados de

amostra e exemplos plenamente funcionais. Há uma versão do PCI que inclui o Java

Runtime Environment (JRE) também.

O desempenho desta instalação depende de muitos fatores, mas ela deve

executar sem problemas em quase todas as plataformas e configurações.

38

O processo de instalação é bastante simples:

• Cria-se uma nova pasta no disco rígido, selecionando-se um nome e

localização, preferencialmente na raiz do disco;

• Assegura-se

que

o

diretório

contenha

espaço

suficiente

(aproximadamente 1GB);

• Utiliza-se uma ferramenta de descompactação para extrair na nova pasta

os arquivos copiados;

• Para executar o PCI usa-se o arquivo start-pentaho.bat e aguarda-se a

inicialização. Deve aparecer na tela a mensagem “[STDOUT] [pt_47]

Pentaho BI Platform server is ready” (Figura 11);

Figura 11 - Inicialização do Pentaho BI Plataform

• Abre-se o browser e informa-se o endereço http://localhost:8080;

• Seleciona-se o usuário Admin e senha Password (Figura 12);

39

Figura 12 - Login Pentaho

• Escolhe-se no botão Browse Files a opção Public, e após isso, Steel

Wheels, que contém alguns exemplos (Figura 13);

Figura 13 - Menu Solutions

• Deve-se escolher Dashboards, no qual há um exemplo disponível para

visualização (Figura 14).

40

Figura 14 - Visualização do exemplo disponível

41

5

CONCLUSÔES E TRABALHOS FUTUROS

As contribuições deste trabalho acadêmico consistem no estudo de uma

tecnologia existente para o auxílio às empresas que têm limitações no

desenvolvimento de aplicações para a tomada de decisão. Com a suíte de ferramentas

Pentaho, o desenvolvedor pode criar aplicações completas para Business Intelligence e

Big Data.

As contribuições de cunho social baseiam-se no fato de que este estudo

serve como base para a disseminação de tecnologias de software livre, tanto para

conhecimento e construção de um Data Warehouse, quanto para adquirir

conhecimento e criação da nova tecnologia de Big Data em pequenas empresas no

Brasil e para o domínio da mesma, além da redução no seu custo.

Diante deste cenário, foi descrito alguns conceitos sobre Data Warehouse,

também foi descrito sobre Big Data, e sobre todo o ecossistema a qual faz parte dentro

da novíssima Ciência das Redes, bem como a plataforma Pentaho, um software livre

capaz de coletar, consolidar e analisar informações referentes às práticas institucionais

que possam futuramente servir de base para uma melhor compreensão e um melhor

planejamento de qualquer empresa interessada em desenvolver um DW ou Big Data.

Os objetivos específicos propostos para o trabalho foram alcançados. Foi

apresentada a plataforma Pentaho BI, com a descrição de sua arquitetura e as

tecnologias que compõe esta suíte.

Como alternativas de trabalhos futuros, sugere-se aplicar os conhecimentos

aqui apresentados e aprofundar o conceito de Ciência das Redes, aplicarem em um

caso de empresa real, com o objetivo de validar as informações que podem ser obtidas

com o uso de um Data Warehouse e Big Data.

Para estudos mais avançados, a plataforma Pentaho BI também

disponibiliza ferramentas para a realização de processos de mineração dos dados (Data

Mining). O estudo destas ferramentas abre outras frentes para descoberta do

conhecimento em bancos de dados corporativos.

42

REFERÊNCIAS

BARBIERI, C. Business Intelligence: modelagem e tecnologia. Rio de Janeiro: Axcel

Books, 2001.

BORTOLINI, A. L. de. Um projeto de data warehouse. Disponível em:

<http://materdei.ceicom.com.br >. Acessado em: 15 dez. 2015.

HOKAMA, D. D. B. et al. A modelagem de dados no ambiente Data Warehouse.

2004. 121 f. Trabalho de Conclusão de Curso (Bacharelado em Sistemas de

Informação) – Faculdade de Computação e Informática, Universidade Presbiteriana

Mackenzie.

DARROW, BARB, Amazon Launches home-grown NoSQL database, Disponível

em: <http://gigaom.com/cloud/amazon-launches-home-grown-nosql-database>.

Acessado em: 20 dez. 2015.

DATAMIND TECHNOLOGY CENTER. Agent network technology. Disponível em:

<http://datamindcorp.com/paper_agetnetwork.html>. Acessado em: 02 dez. 2015.

HARRY, D. For now, Sparks looks like the future of big data. Disponível em:

<https://gigaom.com>. Acessado em: 20 dez. 2015.

HEINRICHS, J. H.; LIM, J. Integrated web-based data mining tolls with business

models for knowledge management. Decision Support Systems, v. 35, n. 1, p. 103112, 2003.

HOKAMA, D. D. B. et al. A modelagem de dados no ambiente Data Warehouse.

2004. 121 f. Trabalho de Conclusão de Curso (Bacharelado em Sistemas de

Informação) – Faculdade de Computação e Informática, Universidade Presbiteriana

Mackenzie.

INMON, W. H. Como Construir o Data Warehouse. Rio de Janeiro: Campus, 1997.

387 p.

KIMBALL, R. Data Warehouse Toolkit. São Paulo: Makron Books, 1997. 388 p.

MACDONALD, G. C.; RUBIK, J. R. Pesquisa e seleção de ferramentas livres e

baseadas em padrões de sistemas abertos para a elaboração de interfaces OLAP

sobre a web. 2007. 114 p. Trabalho de Conclusão de Curso (Bacharelado em Sistemas

de Informação) - Departamento de Informática e Estatística, Universidade Federal de

Santa Catarina, Florianópolis, 2007.

MACHADO, F. N. R. Tecnologia e projeto de Data Warehouse: uma visão

43

multidimensional. São Paulo: Érica, 2004. 318 p.

MICROSOFT. Microsoft Corporation. Disponível em: <http://www.microsoft.com>.

Acessado em: 01 dez. 2015.

SHIGUNOV, F. Uma Aplicação OLAP sobre a Web para Análise dos Dados do

Vestibular da UFSC e Diretrizes para a sua Integração com GIS. 2007. 88 f.

Trabalho de Conclusão de Curso (Bacharelado em Sistemas de Informação) Departamento de Informática e Estatística, Universidade Federal de Santa Catarina UFSC, Florianópolis.

TEMATEC. Por dentro da Pentaho Open BI Suite: Conceitos, Arquitetura e

Componentes. Disponível em: <http://br.groups.yahoo.com/group/pentahobr/>.

Acessado em: 05 dez. 2015.

TORRES, N. A. Competitividade empresarial com a tecnologia de informação.

São Paulo: Makron Books, 1995. 230 p.

ZUPPO, D. ; COSTA, L. S.; FERNANDES, S. Big Data: Estudo do Ambiente,

Desafios e Analise Estratégica para o Brasil. 2013. 56 f. Trabalho de Conclusão de

Curso (Pós-graduação em Engenharia de Produção) - COPPE, Rio de Janeiro.

44

BIBLIOGRAFIA COMPLEMENTAR

BALLARD, C.; HERREMAN, D. Data Modeling Techniques for Data

Warehousing. IBM, International Technical Support Organization, February, 1998.

BISPO, C. A. F. Uma Análise da Nova Geração de Sistemas de Apoio à Decisão.

1998. 174 f. Dissertação (Mestrado em Engenharia de Produção) - Departamento de

Engenharia da Produção, Universidade de São Paulo - USP, São Paulo.

GANTZ, D. R. J. Extracting Value from Chaos. Framingham, MA, 2011. Disponível

em: http://www.emc.com/collateral/analyst-reports/idc-extracting-value-from-chaosar.pdf. Acessado em: 20 dez. 2015.

FELBER, E. J. W. Proposta de uma ferramenta OLAP em um Data Mart

comercial: Uma aplicação prática na industria calçadista. 1997. 156 f. Trabalho de

Conclusão de Curso (Bacharelado em Ciência da Computação) – Instituto de Ciências

Exatas e Tecnológicas, Centro Universitário Feevale, Novo Hamburgo, 1997.

PENTAHO. Pentaho Open Source Business Intelligence. Disponível em:

<http://www.pentaho.com>. Acessado em: 12 dez. 2015.