MESTRADO INTEGRADO PROFISSIONAL EM

COMPUTAÇÃO APLICADA – MPCOMP

Universidade Estadual do Ceará - UECE

Centro de Ciências Tecnológicas - CCT

Instituto Federal de Educação, Ciência e Tecnologia do

Ceará - IFCE

Pró-Reitoria de Pós-Graduação – ProPG

Mário Côrtes Duarte

SAD baseado em Lógica Proposicional aplicado na Detecção

de Fraudes em Seguros

Rio de Janeiro

2013

i

Mário Côrtes Duarte

SAD baseado em Lógica Proposicional aplicado na Detecção

de Fraudes em Seguros

Dissertação apresentada ao Programa de

Mestrado

Integrado

Profissional

em

Computação Aplicada da Universidade

Estadual do Ceará e do Instituto Federal de

Educação, Ciência e Tecnologia do Ceará,

como requisito parcial para obtenção do Grau

de Mestre em Computação Aplicada.

Orientador: Prof. DSc. Flávio Luis de Mello.

Rio de Janeiro

2013

ii

Dados Internacionais de Catalogação na Publicação

Universidade Estadual do Ceará

Biblioteca Central Prof. Antônio Martins Filho

A999x

Duarte, Mário Côrtes

SAD Baseado em Lógica Proposicional Aplicado na Detecção de Fraudes em

Seguros / Mário Côrtes Duarte. – 2013.

XXf. :il. color., enc. ; 30 cm.

Dissertação (Mestrado) – Universidade Estadual do Ceará, Centro de Ciências e

Tecnologia, Curso de Mestrado Profissional em Computação Aplicada, Fortaleza,

2013.

Área de concentração: Sistemas de Apoio a Decisão

Orientação: Prof. DSc. Flávio Luis de Mello

1. Colaboração. 2. Arquitetura Empresarial. 3. Inteligência Artificial. 4. Sistemas

Distribuídos. I. Título.

CDD: 999.99

iii

iv

v

DEDICATÓRIA

Dedico esse trabalho a minha filha Mariana Duarte que proveu a inspiração

necessária em todos os momentos desta pesquisa e aos meus pais Mario Duarte e Mariza

Duarte que sempre me incentivaram ao estudo e conhecimento.

Todos me ajudaram na frase abaixo:

“Tudo é considerado impossível até acontecer” (Nelson Mandela).

vi

AGRADECIMENTOS

Agradeço ao Professor Flávio Mello, que me deu total orientação e apoio ao

desenvolvimento e pesquisa deste trabalho.

Agradeço aos Professores Edilberto Strauss e Marcos José Negreiros Gomes no

apoio na coordenação do curso.

Agradeço aos meus gestores Paulo Duarte, Alexis Sauer e Marcus Felippe pela

facilitação junto com a empresa no apoio financeiro do curso.

Agradeço ao amigo Thomaz Caldas que me ajudou muito na definição das regras

de fraude de seguros.

Agradeço ao meu amigo Maurício Quintela com seu apoio junto à entrevista com

a seguradora que me forneceu dados de sinistros.

Agradeço ao meu amigo Álvaro Roberto, proprietário de corretora de seguros que

gentilmente me cedeu sua base de dados de seguros e sinistros para apoio na geração do

produto de combate à fraude.

vii

RESUMO

No mundo inteiro as empresas seguradoras de qualquer ramo de atuação (saúde,

automotivo, etc.) tendem a se proteger contra processos fraudulentos, melhorando cada vez

mais a eficácia de seus negócios. O entendimento das razões facilitadoras para criação de

processos fraudulentos, e posteriormente uma definição e execução de planos de combate à

fraude, constitui a principal estratégia do negócio securitário. A aplicação de sistemas de

apoio à decisão tem se mostrado uma eficiente ferramenta para o negócio de seguros,

principalmente a partir de modelos probabilísticos, mas também há espaço para o emprego da

técnica de lógica proposicional. Este trabalho sugere o uso da lógica proposicional para o

desenvolvimento de uma aplicação para atender a análise antifraude para o negócio

securitário de automóveis.

Palavras-Chave: Prevenção de fraude em seguros, detecção de fraude em seguros,

fraudes em seguros, sistemas de apoio à decisão, lógica proposicional.

viii

ABSTRACT

Insurance companies of any kind (health, vehicles, etc.) tend to protect themselves

against fraudulent processes, in order to improve the effectiveness of their business. By

understanding the reasons that allow the creation of fraudulent processes, it is possible to

define and implement plans to combat fraud, which is the main strategy of the securitybusiness. The application of decision support systems have been shown to be an efficient tool

for the insurance business, primarily from probabilistic models. However, it is possible to

employ an approach using the propositional logic technique. This work proposes the use of

propositional logic in an application for development of an anti-fraud application concerning

the security car business.

Keywords: Prevention of insurance fraud, insurance fraud detection, fraud in

insurance, support systems for decision making, propositional logic.

ix

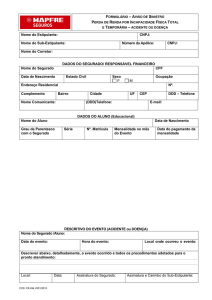

LISTA DE FIGURAS

Figura 1 - Fluxo de produção de conhecimento. ................................................. 13

Figura 2 - Modelo do Data Mining - Fonte: M_Square Systems Inc (M_Square,

2012) ................................................................................................................................... 14

As RNA’s têm uma estrutura topológica peculiar que depende do problema de

aprendizado que será aplicada, uma estrutura Multi-Layer-Perceptron (MLP) pode ser vista na

Figura 3. Nessa estrutura, a camada de entrada é responsável por receber os padrões que se

buscam reconhecer pela RNA. Na primeira e segunda camada, também conhecidas como

intermediárias ou ocultas, é realizada grande parte do processamento. A camada de saída trata

do resultado final, ou reconhecimento. ................................................................................. 15

Figura 4 - Rede neural artificial de três camadas ................................................ 16

Figura 5 - Arquitetura do Witty (FONTE: Witty, 2000) ..................................... 28

Figura 6 - Diagrama de componentes do sistema ................................................ 33

Figura 7 - Fluxo de trabalho da solução SPCF.................................................... 35

Figura 8 - Modelo de Dados do Sistema de Gestão de Seguros da Seguradora ... 36

Figura 9 - Identificação do sinistro pelo Witty.................................................... 40

x

LISTA DE TABELAS

Tabela 1 - Indicadores de avaliação.................................................................... 38

Tabela 2 - Valor médio associado aos sinistros falsos negativos pagos ............... 43

Tabela 3 - Economia da seguradora no reconhecimento de fraudes segundo

diversos cenários de prêmio de apólice e grau de efetividade do sistema .............................. 45

xi

LISTA DE ACRÔNIMOS

BI

Business Intelligence

CAIF

Coalition Against Insurance Fraud

CNIS

Cadastro Nacional e Informação e Serviços

EUA

Estados Unidos da América

ETL

Extraction, Transformation and Load

FENASEG Federação Nacional de Seguros Gerais

IA

Inteligência Artificial

IASIU

International Association of Special Investigation Units

IFPA

The Pennsylvania Insurance Fraud Prevention Authority

LP

Lógica Proposicional

NHCAA

National Health Care Anti-Fraud Association

NICB

National Insurance Crime Bureau

RNA

Rede Neural Artificial

SAD

Sistema de Apoio à Decisão

SAFO

Sistema Automático para Formalização do Conhecimento

SGBD

Sistema de Gerenciamento de Banco de Dados

SOA

Service-Oriented Architecture (arquitetura orientada a serviços)

SPCF

Sistema de Prevenção e Combate à Fraude

TCP/IP

Internet Protocol

xii

SUMÁRIO

1. INTRODUÇÃO .................................................................................................................... 1

1.1.

TEMA .................................................................................................................................. 1

1.2.

DELIMITAÇÃO ..................................................................................................................... 1

1.3.

JUSTIFICATIVA .................................................................................................................... 1

1.4.

OBJETIVOS .......................................................................................................................... 2

1.5.

METODOLOGIA ................................................................................................................... 3

1.6.

ORGANIZACÃO DA DISSERTAÇÃO ....................................................................................... 3

2. FRAUDES............................................................................................................................. 4

2.1.

CONCEITO DE FRAUDE E ERRO............................................................................................ 5

2.2.

SITUAÇÃO DAS FRAUDES NO MERCADO DE SEGUROS ......................................................... 6

2.3.

TIPOS DE FRAUDES DE SEGUROS MAIS COMUNS................................................................... 7

2.4.

SOLUÇÕES EXISTENTES AO COMBATE A FRAUDE ............................................................... 8

3. MÉTODOS TRADICIONAIS DE APOIO COMPUTACIONAL PARA O

PROCESSO DECISÓRIO ..................................................................................................... 10

3.1.

SISTEMAS DE APOIO A DECISÃO ....................................................................................... 10

3.2.

MINERAÇÃO DE DADOS .................................................................................................... 12

3.3.

REDE NEURAL ARTIFICIAL................................................................................................ 15

3.4.

LÓGICA FUZZY .................................................................................................................. 17

4. USO DE LÓGICA SIMBÓLICA PARA PROBLEMAS DE CLASSIFICAÇÃO ...... 20

4.1.

LÓGICA ............................................................................................................................. 20

4.2.

LÓGICA PROPOSICIONAL ................................................................................................... 21

4.3.

LÓGICA DOS PREDICADOS ................................................................................................. 22

4.4.

FORMA NORMAL NA LÓGICA PROPOSICIONAL .................................................................. 23

4.5.

DEDUÇÕES LÓGICAS ......................................................................................................... 24

4.6.

SISTEMAS FORMAIS .......................................................................................................... 25

4.7.

FERRAMENTA – WITTY ..................................................................................................... 27

5. SOLUÇÃO PROPOSTA ................................................................................................... 30

5.1.

DECISÕES PRELIMINARES ................................................................................................. 30

5.2.

SISTEMA DE PREVENÇÃO E COMBATE À FRAUDE (SPCF) ................................................. 31

xiii

5.3.

ESTRUTURA/MODELO DE DADOS ...................................................................................... 35

5.4.

BASE DE CONHECIMENTO ................................................................................................. 37

5.5.

CLASSIFICAÇÃO AUTOMATIZADA ..................................................................................... 40

5.6.

ECONOMIA COM A UTILIZAÇÃO DA FERRAMENTA ............................................................. 42

5.7.

COMPARAÇÃO COM AGENTE HUMANO ............................................................................. 46

6. CONCLUSÃO .................................................................................................................... 48

7. BIBLIOGRAFIA ............................................................................................................... 50

8. ANEXO A – CONVERSÃO DO MODELO DE DADOS EM PREDICADOS ........... 54

9. ANEXO B – ESTRUTURA DE UMA LINHA DE COMANDO DO SPCF PARA O

WITTY .................................................................................................................................... 56

xiv

1. INTRODUÇÃO

1.1. Tema

O tema deste trabalho versa sobre o suporte computacional com vistas a apoiar o

processo de combate à fraude de seguros em uma empresa fictícia.

1.2. Delimitação

Este trabalho está voltado para a detecção de fraudes de sinistros no mercado

securitário do ramo de automóveis, porém é possível aplicá-lo na prevenção de fraudes nos

demais ramos de seguros. Neste sentido, a aplicação da solução ora proposta implicaria em

alterações inexpressivas na arquitetura que foi desenhada. Por outro lado, a construção da

base de conhecimento sobre fraudes deverá ser refeita de acordo com o entendimento das

regras de negócio da nova aplicação.

Além disto, não serão tratados aqui temas relativos a auditorias fiscais, sendo

abordada apenas a fraude em sinistros de seguros. As auditorias fiscais buscam coibir fraudes

em seguros relacionadas com o incorreto cumprimento das obrigações tributárias por parte

dos segurados, e principalmente pela empresa seguradora. Apesar deste tipo de fraude

também ter potencial para causar um impacto negativo na seguradora, entende-se que seus

mecanismos de gestão estão significativamente mais amadurecidos do que o processo interno

de detecção e fraudes em sinistros.

1.3. Justificativa

As atividades de levantamento de informações normalmente são complexas,

devido à maneira como as informações estão distribuídas e armazenadas pela corporação.

Utilizar uma ferramenta colaborativa para o registro e comunicação de informações

empresariais traz à equipe de arquitetura empresarial uma grande agilidade na manipulação

1

dos mapas e modelos corporativos. Estes benefícios são desejáveis em qualquer ramo de

atividade, entre eles o securitário.

No Brasil a situação de combate à fraude encontra-se em estágio atrasado de

amadurecimento. Os poucos órgãos FENASEG (Federação Nacional de Seguros Gerais,

2012), CNIS (Cadastro Nacional de Informações e Serviços, 2012), IASIU (International

Association of Special Investigation Units-BR, 2012) que atuam nessa questão colaboram

entre si de forma muito esporádica. O uso de “redflags” (ou indicadores) é pouco explorado

pelas seguradoras nacionais. Além disso, no Brasil encontram-se vários agentes facilitadores

de ações fraudulentas, entre eles pode-se citar:

Inadequadas regulações de sinistros;

Inadequada inspeção de riscos;

Carência de investigação;

Ausência de travas em sinistros suspeitos;

Falhas nos controles internos das empresas de seguros.

Neste sentido, as fraudes em seguros podem impactar significativamente o mercado

securitário porque o cliente/segurado paga um valor maior de seguro, uma vez que embute-se

ao mesmo os custos associados ao risco do negócio. As seguradoras, corretores e prestadores

de serviços veem seu número de negócios menor do que poderia ser, haja vista que o valor

maior do seguro diminui a demanda pela contratação do serviço.

Os seguros podem ter seus preços reduzidos caso a situação de fraudes em seguros

diminua significativamente, pois hoje o custo da fraude é compartilhado com todos. Este

custo pode ser de até 25% no cálculo da apólice.

Sob esta ótica, o presente trabalho busca identificar formas de como este tipo de

fraude pode ser prevenido, busca ajudar a encontrar a resposta, apresentando modelos

computacionais para apoio a decisão e seus passos para implantação. Entre os modelos

computacionais, será apresentada uma proposta de utilização de ferramentas para apoio a

tomada de decisão, com a criação de um modelo baseado em lógica proposicional, para

combate a fraudes em sinistros de seguros de automóveis.

1.4. Objetivos

2

O objetivo principal do trabalho é propor um sistema de apoio à decisão capaz de

auxiliar o processo de detecção e prevenção de fraudes em seguros empregando mecanismos

de inferência dedutivos.

Pode-se enumerar como objetivos secundários a implementação de um sistema capaz

de semi-automatizar o processo de detecção de fraude no momento da regulação, além da

ampliação da capacidade de análise dos pedidos de seguro e da potencial redução de custos

relacionados com o pagamento de seguros fraudulentos.

1.5. Metodologia

A metodologia utilizada neste trabalho foi baseada em leitura de livros e artigos

sobre Sistemas de Apoio a Decisão e sobre o mercado securitário. No que diz respeito ao

mercado securitário, a experiência de trabalho do autor no assunto também foi significativa no

entendimento dos problemas relacionados com fraudes e na construção de uma solução viável

de ser implantada e alinhada com a realidade brasileira.

Além disto, foram realizadas entrevistas técnicas com especialistas em seguros de

auto e fraudes, visando à criação do modelo proposto. A consulta a estes especialistas foi

essencial para caracterizar não só qualitativamente a manifestação das fraudes em questão,

mas também quantitativamente para prover uma dimensão razoável do impacto das fraudes no

mercado securitário.

Por fim, foi empregado um sistema provador automático de teoremas já conhecido

e testado pela literatura a fim de agilizar a construção do sistema especialista em detecção de

fraudes.

1.6. Organizacão da Dissertação

Esta dissertação está organizada do seguinte modo. No capítulo 1 apresenta em

linhas gerais o trabalho. O capítulo 2 traz uma definição sobre fraudes e a situação no cenário

securitário de forma a contextualizar o leitor no assunto.

O capítulo 3 descreve uma

prospecção sobre os métodos computacionais para apoio ao processo decisório. No capítulo 4

aborda-se a utilização da lógica simbólica em problemas de classificação. O capítulo 5

detalha a solução proposta. O capítulo 6 traz a conclusão do estudo e os trabalhos futuros.

3

2. Fraudes

Desde o início da formação das primeiras sociedades existem pessoas mal

intencionadas com finalidade de ganho próprio utilizando meios ilícitos, criando assim

armadilhas e esquemas para roubar o próximo. Estas pessoas que se locupletam subvertendo

as regras da sociedade são conhecidas como fraudadores.

O Código de Hamurabi, um conjunto de leis criadas na Mesopotâmia no século

XVIII A.C. pelo rei Hamurabi da primeira dinastia babilônica, já previa punições para os

casos de fraudes, (Vieira, 2011).

Acredita-se que antigos egípcios, por volta de 500 A.C., utilizavam da prática

fraudulenta ao comercializar falsos gatos e outros animais sagrados embalsamados para suas

cerimônias fúnebres. Estes objetos fraudulentos continham apenas gravetos e algodão e em

alguns casos pedaços de ossos de outros animais. Na Idade Média, eram muito comuns as

fraudes com uso de pesos e medidas, adulteração de alimentos e bebidas, prática esta que se

perpetua até os dias de hoje.

Por volta de 1100 D.C., ocorre o advento e difusão das letras de câmbio. Deu-se

início em uma nova era de fraudes conhecidas como "documentais" contextualizadas em um

período no qual a palavra tinha mais valor do que hoje.

Na Holanda, aproximadamente em 1637 aconteceu a famosa "bolha" das Tulipas,

uma fraude coletiva que faliu milhares de pessoas que tinham especulado no comércio dos

bulbos desta flor. Outra referência significativa de fraude foi a de 1720, onde investidores

perderam seu dinheiro na bolha conhecida como “South SeaCo.”, criada por uma empresa

inglesa de navegação e comércio que divulgava informações falsas aos investidores

orientando-os a comprarem sempre mais ações com valores maiores até que uma corrida por

posições vendidas quebrou o investimento.

Algumas expressões conhecidas e utilizadas até hoje como “Conto do Vigário” ou

“Vigarista” são originarias de compras de ouro roubado, onde párocos compravam de

escravos o ouro roubado por estes por um preço muito baixo. Alguns pesquisadores citam que

várias igrejas foram construídas com apoio do “Conto do Vigário”.

Tal cenário vem reforçar que o assunto fraude é muito antigo. Fraudadores são

muito espertos, bem informados, ágeis e adaptáveis a novas situações, motivo pelo qual novas

fraudes aparecem continuamente.

4

Um ponto forte a se destacar é que mundialmente as fraudes prejudicam governos,

os negócios e a sociedade, não sendo diferente no mercado securitário. Nos dias de hoje são

encontrados os mesmos esquemas de fraudes aplicadas a seguros. Sendo assim, quanto maior

o combate às fraudes em seguros, melhor é para o mercado.

O aumento na eficácia do combate à fraude minimiza cada vez mais as

oportunidades aos fraudadores. Consequentemente, o custo do seguro sofre uma redução

devido ao risco menor de sinistralidade, o que torna o preço dos seguros mais atrativos e

invariavelmente trará novos clientes ampliando as oportunidades de mercado. Outra

oportunidade é uma visão melhorada do negócio de seguro no Brasil na qual o segurado passa

a pagar menos por maiores benefícios.

2.1. Conceito de Fraude e Erro

Fraude é o ato de má-fé praticado com o objetivo de enganar ou prejudicar alguém ou

uma instituição e ocorre quando são apresentados documentos falsos, quando são omitidas

informações ou são simuladas situações com o objetivo de obtenção de vantagens ou

indenizações indevidas. Segundo o dicionário Aurélio (2010):

“Todo artifício empregado com o fim de enganar uma pessoa e causar-lhe prejuízo. A

fraude traduz a intenção de procurar uma vantagem indevida, patrimonial ou não. O Código

Penal Brasileiro, nos artigos 171 e seguinte, prevê diversas modalidades de fraude,

comparáveis ao estelionato”.

Segundo as Normas Brasileiras de Auditoria (2012) as definições de fraude e erro são:

Fraude é o ato intencional de omissão ou manipulação de transações,

adulteração de documentos, registros e demonstrações contábeis. Exemplos de

fraude são:

o Manipulação de registros ou documentos;

o Apropriação indevida de ativos;

o Omissão de registros contábeis;

Erro é ato não intencional resultante de omissão, desatenção ou má

interpretação de fatos na elaboração de registros e demonstrações contábeis.

Exemplos de erro são:

5

o Erros matemáticos na demonstração contábil;

o Interpretação errada de valores patrimoniais;

2.2. Situação das Fraudes no Mercado de Seguros

O mercado mundial de seguros sofre de forma considerada pela cultura da fraude,

onde a situação de fraude no mercado de seguros dos EUA perde apenas para as evasões

fiscais como maiores crimes financeiros. Segundo o site Monitor das Fraudes (Parodi, 2012)

estima-se que para cada seguro pago nos EUA 10 a 15% são fraudulentos, na Itália 2,8 a

3,5%, na Espanha 13%, França 5 a 6%, Suíça 8 a 10% e Inglaterra 3,9 a 4,5%.

No Brasil encontra-se uma dificuldade muito grande de transparência, dificultando a

aproximação à realidade. Preocupada com a imagem do setor de seguros no Brasil, a

Federação Nacional das Empresas de Seguros Privados e de Capitalização (FENASEG, 2012)

solicitou em 2004 ao Instituto Brasileiro de Opinião Pública e Estatística (IBOPE, 2012) a

primeira pesquisa de opinião pública.

Nesta pesquisa foram mapeadas as intenções dos brasileiros com relação a fraudes de

seguro além de apontar uma estimativa de 11,6% de fraudes no universo de sinistros pagos.

Foram abordados todos os ramos de seguros, sendo que os setores saúde e previdência

ficaram de fora. Este valor estimado de processos fraudulentos aproxima-se de R$ 1,5 bilhão,

existem estimativas de mercado onde 25% dos sinistros podem ser fraudulentos. Em 2010 a

Confederação Nacional das Empresas de Seguros Gerais, Previdência Privada e Vida, Saúde

Suplementar e Capitalização (CNSEG, 2012) realizou nova pesquisa, objetivando comparar e

estudar possíveis mudanças nos resultados da primeira pesquisa, atualizando seus indicadores.

Esta pesquisa teve o foco na avaliação sobre a propensão dos brasileiros em fraudar

sinistros. A facilidade e impunidade são os principais agentes motivadores da fraude contra o

seguro. Entre os segurados, 40% apresentam comportamentos tendenciosos em realizar

fraudes, onde a predominância é masculina da faixa etária entre 18 e 24 anos e ensino médio

completo.

6

2.3. Tipos de fraudes de seguros mais comuns

Alguns ramos de seguros mais visados pelos fraudadores são: automóvel, saúde,

transporte, vida e acidentes pessoais.

Dentre eles destacamos alguns tipos de fraudes, que são:

Automóvel

Dados incorretos/omissão de informações nas propostas e vistorias;

Falsa declaração de roubo ou furto;

Permitir vistoria em veículo diferente do informado na contratação do

seguro;

Simular furto de veículo escondido ou desmontado;

Simular furto de veículo negociado em desmanche em pais vizinho;

Troca de motorista por não estar habilitado com a categoria do veículo

ou estar sem condições de conduzir o veículo;

Aumentar os danos após o acidente;

Omissão de informações ou entrega de informações falsas na

Saúde

declaração da proposta;

Empréstimo de cartão pessoal de seguro saúde;

Mudança de procedimentos médicos;

Declaração de consultas inexistente;

Superfaturamento de remédios e materiais médicos;

Transporte

Desvio de carga;

Contratação de mais de um seguro, visando receber indenização de

sinistro de mais de uma seguradora;

Aviso de sinistro sem que tenha ocorrido;

Sinistro ocorrido antes ou depois da vigência do contrato;

Omissão do valor real das mercadorias;

Desvio de cargas com consentimento do responsável;

7

Troca de motorista por não estar habilitado com a categoria do veículo

ou estar sem condições de conduzir o veículo;

Vida e Acidentes Pessoais

Segurado falecido antes da contratação do seguro;

Falsidade de informação na proposta;

Automutilação;

Omissão de doença preexistente de conhecimento do contratante;

Omissão de preexistência de invalidez do contratante;

Simular acidente por morte do contratante que teve morte natural;

Simular acidente em membros do corpo do contratante que já estavam

lesionados.

2.4. Soluções Existentes ao Combate a Fraude

Alguns países adotam ações que vão desde o fortalecimento de leis antifraudes a

campanhas publicitárias de conscientização. Na Europa apenas Alemanha, Itália, Dinamarca e

Portugal possuem leis especificas antifraude. Nos EUA em cada estado existem leis

especificas criminalizando praticas fraudulentas.

Neste sentido, existem diversas iniciativas de criação de órgãos especializados para

atuarem no combate a fraude.

Nos EUA existem os seguintes órgãos: National Insurance Crime Bureau (NICB,

2012), National Health Care Anti-Fraud Association (NHCAA, 2012), The Pennsylvania

Insurance Fraud Prevention Authority (IFPA, 2012), Coalition Against Insurance Fraud

(CAIF, 2012).

No Brasil a FENASEG busca melhorias no setor através da implantação de um banco

de dados de sinistros, fraudes e fraudadores. Além disso, criou campanhas publicitárias na

mídia e organizou seminários referentes ao assunto e criou o Disque Fraude em Seguros. Por

fim, foi criada a IASIU Brasil (IASIU, 2012), organização sem fins lucrativos, que se propõe

em atuar fortemente no combate a fraudes de seguros, propondo-se em atuar da seguinte

forma:

8

Coordenar o combate à fraude no mercado securitário;

Prover treinamentos, buscando educar, formar e qualificar investigadores;

Apoiar na divulgação da situação da fraude de seguro;

Outra pratica eficaz é utilização indicadores de suspeita (“redflags”) que, baseados em

um conjunto de indicadores pré-definidos, pontua cada sinistro e sinaliza os candidatos a uma

análise mais detalhada na regulação do sinistro.

Segundo o site Monitor das Fraudes (Parodi, 2012) os principais indicadores de

suspeita de fraude em seguros são divididos em dois grupos, um voltado à subscrição do

seguro e outra voltada ao sinistro, caracterizados da seguinte maneira:

Voltados à subscrição:

o Contratos recentes

o Ausência de profissão

o Histórico de tentativas ou de situações agravantes.

o Falsas declarações ou contradições

o Segurado com saúde financeira difícil

Voltados ao sinistro

o Denúncia tardia

o Comportamento duvidoso do segurado ou beneficiário

o Número muito grande de testemunhas

o Ausência de testemunhas

o Discrepância entre causas e efeito do sinistro

o Local do sinistro em ambiente familiar ou de amigos

o Dificuldades ou demora em fornecer os documentos solicitados

o Dificuldades ou contradições na hora da perícia

o Documentos suspeitos fornecidos pelos segurado

Vale ressaltar a inexistência na literatura de sistemas comerciais que possam ser

usados como referência para apoio ao estudo proposto.

9

3. Métodos Tradicionais de Apoio Computacional para o Processo

Decisório

3.1. Sistemas de Apoio a Decisão

Sistemas de Apoio a Decisão (SAD) são aplicações computacionais baseadas em

modelos para processamento de grandes volumes de dados cujo objetivo é servir de apoio aos

gestores na utilização destes modelos onde serão identificados os problemas e na orientação

de suas decisões, suportadas por algoritmos. Estes algoritmos se apropriam de uma linguagem

computacional, uma base de conhecimento e o módulo de processamento para descoberta e

tratamento de problemas. São estruturados com três componentes básicos (Laudon e Laudon,

2008):

Interface com o usuário;

Repositório de dados;

Ferramentas de análise de dados.

Além disto, esses sistemas podem utilizar modelos de algoritmos estatístico-matemáticos

(Bernus, 2008), tais como:

Árvores de decisão;

É um dos modelos mais práticos e mais usados em inferência indutiva,

tais árvores são treinadas de acordo com um conjunto de treinamento (exemplos

previamente classificados) e posteriormente, outros exemplos são classificados de

acordo com essa mesma árvore. Para a construção destas árvores são usados

algoritmos como o ID3, ASSISTANT e C4.5;

Agrupamentos;

Análise de agrupamento ou clustering é o nome dado para o grupo de

técnicas computacionais cujo propósito consiste em separar objetos em grupos,

baseando-se nas características que estes objetos possuem. A ideia básica consiste

em colocar em um mesmo grupo objetos que sejam similares de acordo com

10

algum critério pré-determinado. O critério baseia-se normalmente em uma função

de dissimilaridade, função esta que recebe dois objetos e retorna a distância entre

eles.

Regressão Simples;

É uma metodologia estatística que utiliza a relação entre duas ou mais

variáveis quantitativas (ou qualitativas) de tal forma que uma variável pode ser

predita a partir da outra ou outras. A análise de regressão, assim como a ANOVA,

também representa os dados através de um modelo linear aditivo, onde o modelo

inclui um componente sistemático e um aleatório.

Regressão Múltipla;

É uma coleção de técnicas estatísticas para construir modelos que

descrevem de maneira razoável relações entre várias variáveis explicativas de um

determinado processo. A diferença entre a regressão linear simples e a múltipla é

que na múltipla são tratadas duas ou mais variáveis explicativas.

Regressão linear;

Método para se estimar a condicional (valor esperado) de uma

variável y, dados os valores de algumas outras variáveis x. É chamada "linear"

porque se considera que a relação da resposta às variáveis é uma função linear de

alguns parâmetros.

Regressão não linear;

Método de análise observacional em que os dados são modelados por

uma função que é uma combinação não linear de parâmetros do modelo e depende

de uma ou mais variáveis independentes. Os dados são ajustados geralmente

pelo método dos mínimos quadrados ou por algum método de aproximações

sucessivas. Um modelo de regressão é não linear se pelo menos um dos seus

parâmetros aparecem de forma não-linear.

Lógica Proposicional;

11

Na lógica proposicional procura-se sentenças que podem assumir

valores verdadeiro ou falso, conhecidos como valores verdade, e tradicionalmente

representados por 1 e 0 respectivamente. A estas sentenças dá-se o nome de

proposições.

Aplicações SAD trazem vantagens por terem processamento rápido, serem capazes de

ultrapassar limites do aprendizado, serem eficazes na gestão de descoberta de

relacionamentos, apoiarem a tomada de decisão baseadas em fatos com um ciclo mais ágil.

Por outro lado, inabilidade de lidar com problemas desestruturados, indisponibilidade dos

dados e elevados custos são as desvantagens das aplicações SAD.

A Unimed Seguros (Convergência Digital, 2013), por exemplo, está utilizando o SAS

Fraud Framework (SAS, 2014), ferramenta para apoio a prevenção e gestão de fraude em

seguros voltados para saúde, odontologia, vida e previdência. A seguradora prevê colher

resultados a partir de 2014.

3.2. Mineração de Dados

Data Mining (M_Square, 2012), é a técnica para descoberta e definição de padrões de

dados visando facilitar a gestão e descoberta do conhecimento, assim como a execução de

predições dos mesmos.

As etapas da mineração de dados começam no sistema transacional, passando pelo

repositório de dados históricos, pela higienização dos dados, e chegando ao processo de busca

por padrões. As Figuras 1 e 2 ilustram o processo de transição dos dados em seus sistemas

transacionais para a base histórica (data warehouse), processamento e transformação, busca

por padrões até o conhecimento.

12

Figura 1 - Fluxo de produção de conhecimento.

O processo de produção do conhecimento em um sistema de mineração de dados funciona

da seguinte maneira:

1. Entendimento: Fase que consiste no entendimento do negócio e dos dados que

o transitam;

2. Seleção: Etapa onde são selecionados os dados de acordo com critérios

definidos;

3. Pré-processamento: Fase de validação de dados, visando remoção de

informações desnecessárias e assegurar consistência dos dados;

4. Transformação: Nesta fase os dados são transformados nos formatos

adequados às técnicas de mineração de dados definidas;

5. Descoberta de padrões: Neste momento é processada a busca e extração dos

padrões e seus comportamentos;

6. Interpretação/avaliação do conhecimento: Etapa final onde o sistema identifica

os padrões e começa a interpretação dos dados, fornecendo os artefatos

necessários para a descoberta e consolidação do conhecimento;

Este é o momento em que o sistema fornecerá dados ao ser humano para suas

decisões.

13

Figura 2 - Modelo do Data Mining - Fonte: M_Square Systems Inc (M_Square, 2012)

A Figura 2 pode ser melhor detalhada conforme a explicação a seguir:

1. Entendimento/desenvolvimento do negócio: Fase de entendimento do negócio.

2. Entendimento dos dados: Fase de entendimento dos dados e de seus fluxos. Aqui é

proposto um modelo que esteja aderente ao negócio e posterior execução de

algoritmos mineração. Aqui também é definido o algoritmo de mineração a ser

executado.

3. Preparação dos dados: Fase de preparação dos dados para execução do algoritmo

de mineração. Os dados são extraídos do ambiente transacional para o ambiente

analítico.

4. Solução: Fase de execução do algoritmo de mineração.

5. Entrega: Fase final do ciclo do processo, onde o algoritmo de mineração apresenta

o resultado.

A mineração de dados utiliza modelos que privilegiam uma aproximação maior com o

mundo real e podem ser construídos e mantidos com agilidade. Permite análise e descoberta

de padrões, comportamentos e informações inesperadas em grandes bases de dados. Estas e o

14

aumento do conhecimento do comportamento do negócio são algumas das vantagens da

mineração de dados.

Entre as desvantagens encontram-se o elevado custo operacional, requerer ambientes

ideais e grande interação com humanos. Além disso, exige uma modelagem de dados muito

estruturada e rígida, e o fato de buscar valores em uma informação nova e sem estrutura pode

vir a atrapalhar no processo de mineração.

O uso do data mining na área de detecção de fraudes não é comum. O analista de

fraude trabalha com uma demanda volumosa e com necessidade de um tempo de resposta

muito escasso. Estas características não privilegiam o uso do data mining no negócio de

detecção de fraudes, porém a técnica é bastante adequada em outros nichos de negócio.

Considerando alguns exemplos da literatura que usa data mining para detecção de

fraudes, Passini e Toledo (2002) aplicam mineração de dados para encontrar fraudes de

ligações clandestinas de água, Queiroga (2005) discute o emprego no melhoramento da

seleção de consumidores suspeitos de fraude no consumo de energia elétrica, Silva et al.

(2012) aplicam a técnica na análise de uma base de dados de IPTU para fins de detecção de

fraudes na arrecadação.

3.3. Rede Neural Artificial

Rede neural artificial (RNA) faz parte de uma família de técnicas para aprendizado de

máquina, baseada no conceito de ativação e desativação de neurônios. São sistemas

computacionais formados por ligações conectadas a nós, cujo objetivo é um ter

processamento mímico similar ao sentimento humano, mas com uma velocidade muito maior

que a humana (Haykin, Simon, 2011).

As RNA´s estão presentes em aplicações de reconhecimento de fala, jogos, linguagem

natural, previsão do tempo/séries temporais, entre outras.

As RNA’s têm uma estrutura topológica peculiar que depende do problema de

aprendizado que será aplicada, uma estrutura Multi-Layer-Perceptron (MLP) pode ser vista na

Figura 3. Nessa estrutura, a camada de entrada é responsável por receber os padrões que se

buscam reconhecer pela RNA. Na primeira e segunda camada, também conhecidas como

intermediárias ou ocultas, é realizada grande parte do processamento. A camada de saída trata

do resultado final, ou reconhecimento.

15

Figura 4 - Rede neural artificial de três camadas

As etapas do processo de desenvolvimento de uma RNA começam pela coleta dos

dados, passando por separação, configuração da rede, treinamento, testes e integração. Abaixo

é descrito cada passo:

1. Coleta de dados: Fase captação das informações relacionadas ao problema. Tais

informações devem fazer sentido ao problema além de ter uma abrangência total

que vão das situações normais até as exceções do problema. Esta ação requer uma

análise minuciosa a fim de evitar dados duvidosos ou errados.

2. Separação: Neste momento os dados coletados são separados em dois grupos, um

voltado para treinamento da RNA e outro para testes e análise de desempenho da

rede.

3. Configuração: Etapa de configuração da RNA, onde serão definidas qual

topologia adotada, quantidade de camadas e as unidades de cada camada e

configuração dos parâmetros do algoritmo utilizado.

4. Treinamento: Fase de treinamento da RNA, onde serão refinados os pesos das

conexões. A definição desses pesos impactará no tempo de treinamento. O

treinamento poderá ser interrompido no momento em que a rede apresentar

resultados satisfatórios se seu percentual de erro for pequeno.

16

5. Teste: Nesta etapa a RNA passará por testes para verificação do desempenho da

rede, que será indicativo para o desempenho real da rede. Além disso, deverá ser

prevista uma análise dos pesos da rede.

6. Integração: Etapa final, onde a RNA está configurada e treinada. Aqui se coloca a

rede no ambiente de produção. A rede deverá ter um monitoramento de seu

desempenho periodicamente.

As RNA´s são vantajosas por possibilitar melhores análises baseadas em técnicas

estatísticas, são melhores para competitividade com concorrência, dispensam especialistas

para tomada de decisão, são imunes a ruídos e ágeis na implementação.

Entre as desvantagens das RNA´s, podemos citar que não são suscetíveis às mudanças,

treinamento lento, exige calibração precisa, tendem a convergir a um resultado às vezes

equivocado quando o volume de entradas é elevado e não são boas para problemas

relacionados com classificação. Uma alternativa para o problema de classificação é o uso de

uma RNA não supervisionada proposta por Kohonen (2000).

Grande parte dos sistemas de prevenção à fraude tem utilizado RNA´s devido a sua

capacidade de reconhecimento de padrões criados no passado e melhor precisão que seus

concorrentes. Um exemplo é a pesquisa e dissertação de Fontenelle (2011) referente ao uso de

RNA´s na detecção de fraudes em seguros. Entretanto, o ônus de re-treinamento da RNA

quando as características do que está sendo classificado se alteram ao longo do tempo podem

muitas vezes dificultar o processo operacional de negócio.

O uso de redes neurais para a detecção de fraudes é comum na literatura. Por

exemplo, (Fontenelle, 2011) discute sobre o uso de redes neurais na identificação de fraudes

em serviços odontológicos, Oliveira et al. (2003) utilizam redes neurais para detecção de

fraudes no uso de verbas públicas, Dorronsoro et al. (1997) em operações de cartão de crédito,

Oretega (2008) descreve o uso de redes neurais na identificação de fraudes na distribuição de

energia no Brasil.

3.4. Lógica Fuzzy

Trata-se de uma técnica de inteligência voltada a aproximar ao modo de raciocínio,

buscando o conhecer e aproximar-se à habilidade humana na tomada de decisões com

informações difusas (Braz, 2004).

17

A lógica fuzzy, ou difusa, é uma extensão da lógica booleana que permite valores

lógicos intermediários, como, por exemplo, verdadeiro/falso (verdadeiro, falso, talvez

verdadeiro e talvez falso), sim/não (sim, não, talvez), frio/quente (frio, quente, morno, muito

quente, muito frio). São expressões linguísticas cuja interpretação pode variar de um

indivíduo para outro. O valor difuso ou nebuloso é qualquer valor no intervalo booleano e

apoia conceitos estatísticos, como, por exemplo, proposições de inferência.

A lógica fuzzy é muito utilizada em pesquisas com tratamento de dúvidas e incertezas,

onde os resultados podem assumir vários graus de pertinência. Ela está presente em vários

domínios de mercado, entre eles:

Análise de Crédito

Detecção de Fraude em Seguradoras

Análise de Investimentos

Previsão do Consumo de Energia

Avaliação de Risco em Seguros

Avaliação de Risco no Mercado de Ações

O processo da lógica fuzzy segue as seguintes etapas:

1. Fuzzificação: Fase de transformação das variáveis necessárias do problema em

valores fuzzy.

2. Aplicação dos operadores: Fase onde são aplicados os operadores fuzzy (AND

e o OR) com objetivo de definir o maior e o menor grau de pertinência do

conjunto de informações.

3. Utilização dos pesos: Fase de aplicação da implicação onde são definidos os

pesos nos resultados.

4. Combinação de saídas possíveis: Fase de compilação de todas as possíveis

saídas fuzzy em um conjunto fuzzy.

5. Defuzzificação: Fase da saída dos valores/resultados.

Alguns pontos vantajosos da lógica fuzzy são: a utilização de linguagem natural

onde se aproxima do pensamento humano, processo fácil de construir, exigência de poucas

regras e decisões, facilidade na manutenção e a simplificação de problemas e agregação da

base de conhecimento.

18

O fato de exigir mais simulação e testes, de apresentar dificuldade de aprendizado,

ser mais resistente em estabelecer regras facilmente, e não ter um modelo matemático preciso,

cria alguns dos seus pontos fracos.

Uma boa referência de pesquisa da lógica difusa pode ser encontrada na dissertação

de Costa (2012), que a utiliza para representação cartográfica de fenômenos com limites

indeterminados.

Lin et al. (2003) utilizam lógica nebulosa para detecção de fraude em relatórios

financeiros, Estévez et al. (2006) estudam o uso de lógica nebulosa e redes neurais na

identificação de fraude de subscrição de serviços de telecomunicações em operadoras

Chilenas, Meneses (2011) apresenta uma proposta para automação da detecção de fraudes em

sistemas de medição de energia elétrica.

19

4. Uso de Lógica Simbólica para Problemas de Classificação

Em um problema de classificação tradicional temos um conjunto de n objetos e

um conjunto de m classes. Nesta situação, deseja-se atribuir cada objeto a uma única classe

dada, de modo que esta atribuição seja consistente com alguns dados que se tem sobre o

problema, (Mello, 2012). Este capítulo apresenta um estudo do problema de classificação

através de lógica matemática.

4.1. Lógica

Lógica é a ciência das leis do raciocínio, dedicada ao estudo das regras que

permitam validar um pensamento, garantindo que tais pensamentos tenham uma sequência

correta a fim de obter conhecimentos e sentenças verdadeiras. Após estes conhecimentos

reconhecidos como verdadeiros, cabe à lógica formular leis gerais de encadeamentos lógicos

que possibilitem à descoberta de novas verdades (Rosa, 2011).

Este encadeamento é chamado em lógica de argumento, que é a sequência de

sentenças afirmativas podendo ser reais ou falsas (proposições) onde uma delas é a conclusão

e as demais afirmações são ditas premissas.

Exemplo:

O peixe respira por guelras (premissa P1).

A garoupa é um peixe (premissa P2).

A garoupa respira por guelras (conclusão C da premissa P2 seguida da P1).

Logo, fica claro que “a garoupa, que é um peixe, respira por guelras”.

Matematicamente, tem-se que “se P2 e P1 então C”. Este é o processo chamado

dedutivo, isto é, uma modalidade de raciocínio lógico que faz uso da dedução para

obter uma conclusão a respeito de determinadas premissas.

George Boole (Hawking, 2005), nascido na cidade de Lincoln/Norte da Inglaterra,

contribuiu para a lógica matemática, ou simbólica, através de suas pesquisas em operações

matemáticas com o objetivo de criar um sistema simples baseado em símbolos. Seu trabalho

20

contribuiu de forma significativa para o que mais tarde viria a se chamar lógica de Boole

(lógica booleana) (Hawking, 2015).

O uso da simbologia matemática permite explicar com mais objetividade as

estruturas lógicas das proposições e dos argumentos, que podem ficar confusas ao apresentar

em linguagem natural. Outra vantagem da lógica simbólica é o fato dos computadores serem

construídos de forma a se adaptarem melhor a este paradigma e não terem a mesma adaptação

com a linguagem natural.

A lógica simbólica substitui a palavra pela ideia, isto é, o valor semântico, e suas

expressões dizem se a ideia é verdadeira ou falsa. É dividida em lógica proposicional e lógica

dos predicados.

4.2. Lógica Proposicional

A lógica proposicional é encontrada em sistemas especialistas e principalmente nos

problemas de classificação. Trata-se de um sistema formal (Carvalho, 1998) baseado em

relações lógicas sobre proposições, onde uma proposição é igual a uma sentença de

linguagem natural. As proposições são formadas por conectivos, descrevendo como calcular o

valor verdade de qualquer sentença. Estes conectivos podem ser:

¬ negação (NOT)

∧ Conjunção (AND)

∨ Disjunção (OR)

→ Implicação (se... então)

Equivalência

A cada sentença se pode atribuir, na maioria dos casos, valores booleanos. Observe o

exemplo:

“Este CPF já cometeu uma fraude”, ou é_fraudador(CPF)

Além das sentenças que possuem valor verdade, existem também aquelas que

possuem múltiplos valores verdade, e também os paradoxos (Mello, 2012). Estas questões

serão melhor abordadas na seção 4.5.

21

Entre as vantagens do uso de lógica matemática na solução de problemas de

classificação, pode-se citar (Rosa, 2011):

Boa compreensão de lógicas mais complexas;

Facilita as demonstrações;

Versatilidade de representação;

Elimina a ambiguidade presente em notações infixadas;

Permite um simples teste para separar fórmulas bem-formadas de

fórmulas mal formadas.

A desvantagem mais relevante da lógica matemática está relacionada com o fato

de que a solução computacional de um problema qualquer tende a ser mais lenta do que

soluções dedicadas. Isto ocorre porque o processo de classificação envolve sucessivas

determinações de valores-verdade. Estes cálculos dos valores-verdade utilizam algoritmos

indiretos que exigem a análise combinatória de soluções, um processo exaustivo, e que em

casos extremos pode ser demorado. Desta forma, há de se analisar a abordagem de solução de

problema de classificação pelo pior caso, no qual toda a análise combinatória deverá ser

avaliada.

4.3. Lógica dos Predicados

A lógica dos predicados é uma extensão da lógica proposicional. Além de ter

objetos desta ela possui elementos de quantificação, símbolos e predicados (Mello, 2012).

Esta situação pode ser representada da seguinte forma:

(∀x) é_homem(x) → é_mortal(x)

Um exemplo de inferência da lógica dos predicados (Mello, 2012) é:

Todo homem é mortal. Uma vez que João é homem, João é mortal.

Esta sentença pode ser representada matematicamente como:

( (∀x) é_homem(x) → é_mortal(x) ∧ é_homem(João) ) → é_mortal(João)

22

Os elementos da lógica dos predicados (Mello, 2012) são representados a seguir:

Símbolos de pontuação: ( , ) ;

Constantes: a, b, c, João, ...;

Variáveis: x, y, z, ...;

Funções: f, g, h, ...;

Predicados: p, q, r, é_homem, É_mortal , ...;

Conectivos: ¬, ∧, ∨,→, e ;

Quantificadores: ∀, ∃

4.4. Forma Normal na Lógica Proposicional

As proposições que não usam conectivos são chamadas de fórmulas atômicas, ou

átomos (Mello, 2012). Chama-se de literal uma formula atômica ou sua negação. Existem

dois tipos de literais:

Positivo: Fórmula atômica, átomo (Ex: possui_CNH(João,12345678))

Negativo: Negação de um átomo (Ex: not é_fraudador(João))

Na lógica proposicional existem duas fórmulas de formato predefinido que são a

forma normal conjuntiva e forma normal disjuntiva. Para ser uma forma normal conjuntiva a

sentença deverá ser (Mello, 2012):

Uma sentença literal conjuntiva (Ex: é_fraudador(João) ∨ not

é_fraudador(João)), ou;

Uma

disjunção

de

literais

(Ex:

é_fraudador(João)

∨

(é_prenchimento_errado(23563) ∧ é_falha_regulação (23563))),

ou;

Uma conjunção com sentenças literais ou disjunções de literais;

Já uma sentença será normal disjuntiva deve atender as características abaixo:

Uma

sentença

literal

conjuntiva

é_roubado(LLA7512)), ou;

23

(Ex:

é_fraudador(João)

∧

Uma conjunção de literais (Ex: é_falha_regulação (23563) ∧ (not

apólice_paga(23563) ∨ apólice_negada(23563))), ou;

Uma disjunção com sentenças literais ou conjunções de literais;

4.5. Deduções Lógicas

Uma dedução é a ação de consequência tirada de um raciocínio, uma conclusão. O

método dedutivo é uma modalidade da forma lógica para obter uma conclusão a respeito de

determinada(s) premissa(s), sendo esta(s) verdadeira(s) (Rosa, 2011).

Usando o raciocínio lógico as conclusões são obtidas, derivadas das premissas e

são incontestáveis. Um argumento lógico dedutivo baseia-se na premissa (ou hipótese),

conclusão e inferência.

Exemplo:

Todo vertebrado possui vértebras.

Todos os cachorros são vertebrados.

Logo (conclusão), todos os cachorros têm vértebras.

Já o método indutivo segue o caminho da experiência, ao contrário da dedução.

Exemplo:

O cobre conduz eletricidade;

Da mesma forma que ouro, alumínio, prata e outros metais;

Logo, todo metal conduz eletricidade.

Existem também os raciocínios incorretos que tem por objetivo induzir ao erro, ou

seja, dissimular uma ilusão de verdade. São conhecidos como sofisma ou falácia, que

possuem falhas formal ou material. Podemos encontrar nos dicionários a definição de sofisma

que é uma inverdade, propositalmente maquiada por argumentos verdadeiros de forma que

pareça verdade.

Exemplo:

Toda regra tem uma exceção;

Isto é uma regra, sendo assim, tem uma exceção;

24

Logo, nem toda regra tem exceção;

Chamamos também de sofisma ou falácia à generalização, ou seja, o que é correto

para um grupo é generalizado para todo o restante.

4.6. Sistemas Formais

A computação é conhecida como uma ciência formal, onde os computadores

seguem fielmente as regras definidas sem exceção, ficando por responsabilidade do ser

humano o papel de especificar, codificar, testar e manter o código, sem a garantia de que o

programa funcionará. Enganos são muito comuns, como por exemplo, a substituição de “0”

por “O”, entre outras situações semelhantes que consequentemente irão impactar no resultado

esperado.

Quando isso acontece teremos ciência de que foi um erro de natureza formal.

Segundo (Mello, 2012), “O grande desafio dos sistemas amigáveis é a eliminação dos erros

formais.”. Ainda segundo o mesmo autor, a definição de formal não é uma tarefa trivial, tendo

em vista que os dicionários definem formal com as seguintes hipóteses:

a. Formal - Originário do latim formale, relativo à forma;

b. Forma – Originário do latim forma, que configura e exibe a aparência do

corpo de um objeto, modelo, norma;

c. Forma – Originário do latim forma, molde sobre como se forma qualquer

coisa baseado nesse molde;

Após essas definições aprendemos que “formal” é derivado de “forma”, ficando

com a tarefa de definir a escolha entre as opções “b” ou “c”, reforçando que há uma diferença

fonética, onde em “b.” o “o” tem pronuncia aberta e em “c.” o mesmo “o” tem pronuncia

fechada.

Todo sistema formal tem sua linguagem nativa formal, possuindo na sua

composição símbolos primitivos. Tais símbolos atuam em determinada regra de formação e

são desenvolvidos através de inferência a partir de um conjunto de axiomas, passando os

25

sistemas a serem constituídos por fórmulas desenvolvidas através de finitas combinações de

seus símbolos primitivos respeitando suas regras estabelecidas.

Matematicamente um sistema S = {∑, L, A, R}, é baseado nos seguintes

elementos (Carvalho, 1998):

Símbolos - ∑ (Alfabeto), conjunto finito de símbolos ou caracteres

chamados de letras, onde símbolo é todo sinal gráfico, como exemplo

, , , , , , ;

Linguagem – L, conjunto finito de símbolos terminais - recursivo em

∑;

Axiomas - A: um subconjunto recursivo em L, também chamado de

símbolos iniciais;

Regras de inferência – R, conjunto recursivo de relações em L,

designadas por produções ou derivações;

Exemplo:

Dado um sistema formal, com alfabeto, linguagem, axiomas e regras que

estejam definidas:

∑ = {,€},L = {∑}, A = {,€}, R = {r1, r2}, onde:

r1= {<x€,x>x ∈ ∑*}

r2= {<x, x€>x ∈∑*}

Pode-se deduzir € a partir do axioma € aplicando as regras r1 e r2

sucessivamente: € €

São três os tipos básicos de sistemas formais: geradores, reconhecedores e

transdutores. Os geradores são sistemas formais que objetivam a produção de cadeias apenas

a partir dos axiomas. Os reconhecedores aceitam outras cadeias como entrada e validam se

tais cadeias estão adequadas, sem produzir cadeias de saída. Os transdutores fazem a

transformação da cadeia de entrada em cadeia de saída. Em geral, os sistemas de classificação

são compostos por sistemas formais reconhecedores, enquanto que os sistemas que adquirem

conhecimento são geradores.

26

4.7. Ferramenta – Witty

Witty (2013) é um framework que permite o desenvolvimento de aplicações

voltadas para apoio ao aprendizado, informações e conhecimento. Sua linguagem é

semelhante ao Prolog, porém com lógica de variáveis e registros, e dispõe de uma máquina de

inferência possibilitando a execução de deduções em bases de conhecimento.

O Witty tem como base o sistema SAFO (Sistema Automático para Formalização

do Conhecimento), que foi projetado pelo professor Roberto Lins de Carvalho e seus alunos

de mestrado e doutorado, sendo resultado de pesquisa em inteligência artificial para

demonstração automática de teoremas desenvolvida na PUC/RJ em 1974 (Carvalho, 1974). O

Witty foi criado por Claudia Maria Garcia Medeiros de Oliveira para uso em sua tese de

doutorado (Oliveira, 1995), é um produto 100% de inteligência brasileira e sua utilização não

é condicionada a nenhuma linha de conhecimento específico.

Com uma arquitetura modular (conforme a figura 4), o Witty é dividido nos

seguintes módulos:

Principal: Responsável pela inicialização do sistema, criando suas estruturas e

carregando seu conjunto de comandos. Além disso, inicia e mantém o laço de

execução do sistema;

Linguagem: Responsável pela interpretação e validação dos comandos com

apoio da tabela de símbolos;

Controle: Responsável por controlar o fluxo de execução dos comandos e

programas, construindo e interpretando sua árvore de execução. Mantém os

estados de falha e sucesso dos comandos;

Máquina de Inferência: Responsável em implementar máquina de inferência

lógica, que tem base no algoritmo de resolução linear com oráculos e filtros.

Tal algoritmo é responsável em selecionar proposições da base de

conhecimento, unificação destes predicados, execução de oráculos e/ou filtros,

execução do backtracking e manter as proposições de comunicação para

respostas;

Bases de Conhecimento: Responsável em criar e manter as bases de

conhecimento do Witty;

Casamento de Padrões: Responsáveis pelo tratamento de linguagens através

de gramáticas e gerenciar funções de casamento de padrões;

27

Interfaces: São duas as interfaces disponíveis no Witty: Com disco, utilizando

arquivos para manutenção, leitura, escrita e execução dos programas externos e

com teclado e vídeo onde utiliza caixas de diálogo;

Máquina de Estados: Módulo de gestão de estados da aplicação;

ODBC: Responsável pela implementação de acessos a bases de dados externas,

utilizando o padrão ODBC (Open Database Connectivity);

Aritmética: Responsável pela implementação de funções aritméticas, seja em

ponto fixo ou flutuante;

Gerência de Memória: O Witty faz sua própria gestão de memória (alocação,

liberação e garbage collection) na execução de comandos e inferência;

Oráculo e Filtros: Responsáveis pela gestão do poder dedutivo da máquina de

inferência;

API: Responsável por gerenciar a comunicação com outros programas;

Frame de Programa: Responsável pelas análises léxica e sintática dos

comandos. Com base na tabela de símbolos cria a expressão a ser interpretada;

Comandos: Módulo responsável pelo processo de construção do banco de

conhecimento pelo usuário. Esses comandos são agrupados em gestão de fatos

e regras, respostas às perguntas, execução de programas externos, gestão de

textos explicativos de provas de dedução.

Figura 5 - Arquitetura do Witty (FONTE: Witty, 2000)

28

A arquitetura do Witty apresenta algumas características que são úteis no

desenvolvimento do Sistema de Apoio a Decisão (SAD) proposta nesta dissertação. A

primeira é o conceito de bases de conhecimento que permite a criação de um ambiente no

qual todos os dados relativos a um pedido de sinistro podem ser armazenados para fins de

dedução, sem que estes se misturem a demais pedidos. Como o processo de classificação

usando lógica pode se tornar combinatorial, passa a ser interessante que um número reduzido

de fatos esteja disponível para essa dedução.

A segunda característica importante está relacionada justamente com a dedução. O

Witty já possui um módulo de máquina de inferência que se dedica à execução do processo

dedutivo, o que elimina a necessidade de implementação dos algoritmos clássicos como

aqueles descritos em Lins e Oliveira (1998) e Genaro (1986).

Por fim, existe o módulo de rede que permite a comunicação com programas

externos. Essa característica permite a comunicação com sistemas de terceiros, tal como será

necessário neste trabalho. Os dados dos pedidos de pagamento de sinistro se encontram em

bancos de dados das seguradoras, e será necessário uma comunicação TCP/IP com estes

sistemas para que o sistema de detecção de fraude possa ser acionado.

29

5. Solução Proposta

5.1. Decisões Preliminares

Um sistema computacional para identificação de fraudes deve respeitar os

seguintes requisitos:

1. Interação com humanos limitada à notificação de um especialista;

2. Ambiente de trabalho flexível e mutável;

3. Dados que algumas vezes podem ou não estarem estruturados;

4. Não promover alterações nos modelos de dados dos bancos das

seguradoras;

5. Decisão determinística para o especialista;

6. Explicação detalhada da decisão deve ser facilmente encontrada e

entendida;

7. Capacidade de suportar mudanças de requisitos de negócio de forma

dinâmica, sem causar impacto significativo na recalibração do sistema;

8. Flexível ao uso de uma grande quantidade de regras;

9. Necessidade de precisão na solução, não havendo espaço para aceitar

soluções não determinísticas;

Nesse sentido as opções 1, 2 e 3 sugerem uma inadequação da técnica de

mineração de dados no caso em estudo, as opções 4 a 6 debilitam o uso de RNA´s e as opções

8 e 9 enfraquecem a utilização da lógica fuzzy. Além disso, foi descartado o uso de árvore de

decisão por motivos meramente operacionais: a todo o momento em que o cenário modelado

sofrer mudanças, torna-se necessário um recálculo ou recalibração, e possivelmente uma

intervenção humana, operação que não é desejável no sistema. Por outro lado, a utilização da

lógica proposicional se mantém alinhada convenientemente às decisões preliminares. Observe

que estas características conduzem à escolha da lógica proposicional como técnica para a

implementação do sistema, mas é importante chamar a atenção do leitor que tal argumentação

não é derradeira. Existem soluções particulares para cada uma das técnicas aqui mencionadas

30

que podem sanar as questões deficitárias apresentadas. Contudo, o que é definitivo é a

intenção de utilizar mecanismos de inferência dedutivos na solução do problema, tal como

previsto no objetivo deste trabalho. Sob esta ótica, deve-se entender que a argumentação

apresentada não desqualifica outras técnicas, mas sim reforça que há razões favoráveis ao uso

da lógica proposicional.

A recalibração dos pesos do red flag, não é ágil nem assertiva para definir o que é

um limiar de classificação de fraude. De fato, o valor de limiar utilizado em sistemas de red

flags é subjetivo e sensível ao contexto onde é aplicado. Suponha um conjunto de variáveis

que contribuem para a definição de um valor indicativo do quanto determinada situação se

aproxima de uma característica procurada. A função de avaliação deste valor indicativo é

geralmente incremental. Os fraudadores, por sua vez, buscam sucesso em suas atividades

ilícitas, e por isso criam novos métodos e estratagemas. Estas novas articulações serão

modeladas mais tarde por novas variáveis de pontuação que também irão contribuirão

incrementalmente para a função de avaliação. Ora, se o limiar de classificação de fraude é

estático, e mais variáveis contribuem incrementalmente para a função de avaliação, então

mais facilmente será atingido este limiar. Desta forma, aumenta-se o número de casos falsopositivos identificados. Por outro lado, pode-se aumentar o valor de limiar, mas corre-se o

risco de aumentar o número de casos falso-negativos. Logo, o fraudador tem agilidade, e o red

flag não acompanha essa agilidade.

A partir destas considerações será proposta a criação de uma solução baseada no

provador automático de teoremas do Witty. Sua escolha acontece por ser uma ferramenta

leve, possuir arquitetura SOA, e apresentar rapidez no processamento de provas. Além disso,

possui flexibilidade e agilidade nas necessidades de mudanças do negócio. Por fim possui um

suporte fácil e é estável, pois já atua há 20 anos no mercado.

5.2. Sistema de Prevenção e Combate à Fraude (SPCF)

Para apoio no combate à fraude em seguros propõem-se a criação do Sistema de

Prevenção e Combate à Fraude (SPCF) utilizando a ferramenta Witty que atuará como

bloqueio/travas em sinistros que possam ser suspeitos. Para isto serão fornecidos ao Witty os

padrões para criação da base de conhecimento de forma que o mesmo realize seus

processamentos em busca de reconhecimento e definição do sinistro. Observe que a estrutura

31

do SPCF poderá ser utilizada em outros nichos de negócio (saúde, contratos, etc), enquanto

suas regras são particulares do negócio em questão, no caso, fraudes em seguros de

automóveis.

O desenvolvimento desta solução tem grande valia sabendo-se que pesquisas

apontam que 25% dos sinistros pagos sejam fraudulentos e que não há no mercado uma

ferramenta precisa e eficaz para identificar o comportamento do sinistro a ser regulado.

Conforme o exemplo da figura 5, a seguradora usará seu sistema legado de gestão

de sinistros para exportação dos sinistros a serem identificados, utilizando um arquivo texto.

O formato deste arquivo texto é um dump de dados do banco, o que significa que não há

impacto significativo para o administrador do banco de dados quando ocorre a geração deste

material. O arquivo chega ao SPCF para separação e preparação da cadeia de caracteres a

serem enviados via TCP/IP ao Witty. Este processamento é necessário por duas razões: (1)

nem todo dado será enviado ao Witty, visto que não é uma condição necessária que todos

estes dados sejam utilizados no processo classificatório utilizando regras; (2) o gerenciador de

bases de conhecimento do Witty exige que os fatos lógicos sejam apresentados segundo um

padrão descrito na linguagem nativa (Witty, 2000), que será mais detalhado na seção 5.3.

32

Figura 6 - Diagrama de componentes do sistema

Observe que as duas fases descritas até o presente momento se assemelham com o

processo de extração-transformação-carga de ferramentas ETL para a construção de um data

warehouse. A analogia é bastante útil, mas deve-se ter em mente que, diferente de um data

warehouse, haverá fluxo de informações no sentido contrário do pipeline. De fato, trata-se de

um padrão arquitetural conhecido como camadas, e não o pipes and filters de um data

warehouse.

Os dados do sinistro são depositados na base de conhecimento do Witty como

fatos lógicos. Complementando esta base, já se encontram previamente depositadas, as regras

lógicas que sumarizam o conhecimento de um especialista humano na tarefa de identificação

de fraudes. Em seguida é disparado o processo dedutivo de identificação do sinistro, onde

uma máquina de inferência passa a ser responsável por verificar se é possível concluir uma

situação de fraude a partir das premissas e regras fornecidas.

Sob esta ótica, se tem por finalizado o processo de requisição que foi disparado

inicialmente pelo sistema legado de gestão de sinistros da seguradora. Nesta etapa, é iniciado

o processo de notificação, retornando um resultado para o gerador do evento. Desta forma, o

33

Witty retorna ao SPCF, também através de comunicação TCP/IP, o resultado do processo

dedutivo sobre a possibilidade de identificação de uma fraude. Em seguida o SPCF repassa ao

sistema de gestão de sinistros da seguradora o resultado obtido, indicando que o sinistro em

questão é candidato à auditoria de campo ou que pode seguir para sua regulação normal.

De forma a avaliar uma prova de contexto do sistema proposto, foi usada uma

massa de dados de uma corretora que cedeu seu banco de dados com aproximadamente três

mil e oitenta e sete registros de sinistros, retroativos dos últimos dez anos, permitindo assim a

construção de um conjunto de teste significativo. Conforme será detalhado, as regras para

detecção foram obtidas através de entrevistas com especialistas da área de seguros, e toda a

massa de dados foi utilizada exclusivamente para testes do sistema. O cenário de sinistros

esperado contém eventos lícitos, eventos ilícitos e eventos duvidosos, conforme descrito no

Capítulo 2.

O fluxo de trabalho segue os seguintes passos, conforme Figura 6:

1. Segurado entra com aviso de sinistro no Setor de Sinistros da Seguradora;

2. A Seguradora recebe o aviso de sinistro;

3. O setor de regulação separa os dados referentes ao segurado, veículo

sinistrado e sua apólice e faz as validações preliminares;

4. O setor de regulação faz a entrada dos dados na aplicação de Gestão de

Seguros da Seguradora que envia para o SPCF uma cadeia de caracteres

(string) para processamento;

5. De posse das informações do sinistro, o SPCF inicia o processo, divido nas

seguintes etapas:

a. Identificação da cadeia de caracteres enviada;

b. Processamento em busca de reconhecimento de padrões;

c. Identificação do sinistro enviado, que poderá ser:

Sinistro OK, sem comportamento fraudulento;

Sinistro suspeito que deva sofrer uma auditoria de

campo/sindicância;

Não foi possível identificar o sinistro com a cadeira enviada;

6. Retorno para a Seguradora com a identificação do sinistro;

34

Figura 7 - Fluxo de trabalho da solução SPCF

5.3. Estrutura/Modelo de Dados

Para a aplicação de sinistros da Seguradora e o Witty atuarem juntos, é necessária

à criação de uma interface entre o sistema de banco de dados e o provador automático de

teoremas. Neste sentido, será utilizado o banco de dados MySQL, que absorverá os dados

oriundos do banco da seguradora, obedecendo o modelo de dados da Figura 7.

Este modelo de dados foi gentilmente cedido por uma corretora do ramo, cuja

base de dados é adotada no estado do Rio de Janeiro. A adoção incondicional do modelo de

dados acontece porque o sistema se propõe a ser acoplado às ferramentas da seguradora

cliente, priorizando uma minimização de impacto. Sob esta ótica, cabe ao sistema processar

os dados do banco, na forma como eles lhe são fornecidos.

35

Figura 8 - Modelo de Dados do Sistema de Gestão de Seguros da Seguradora

A base de dados originalmente fornecida utiliza o repositório Microsoft Access e

suas tabelas não possuem relacionamento referencial, pois a aplicação do cliente faz esse

controle por código. Neste momento, houve uma opção de projeto por buscar um ambiente de

prova de conceito compatível com o ambiente de trabalho esperado das grandes seguradoras.

Nesse sentido, houve a necessidade de converter o repositório de dados em um

Sistema Gerenciador de Banco de Dados. Deve-se observar que esta decisão não agride o

conceito de minimizar o impacto de implantação do sistema no cliente, mas sim provê uma

maior abrangência no processo de importação de dados. Desta forma, a base de dados cedida

teve sua estrutura e dados importados para o banco MySQL. Foram criados relacionamentos

entre as tabelas e a massa de dados foi importada sem nenhuma restrição, pois os dados

estavam íntegros, apesar da base original não possuir relacionamento referencial.

Além disso, foram adicionadas algumas tabelas ao modelo para atender as

necessidades do negócio de prevenção à fraude, tais como tabelas de listas negras. Essas

tabelas tiveram registros criados de forma aleatória, buscando representar um espaço amostral

36

de pessoas física (indivíduos, despachantes) e jurídica (oficina, empresas, escritórios de

advocacia).

A utilização da base de dados da seguradora não traz impacto na aplicabilidade e

adaptação com integração do modelo de dados do SPCF, pois ele suporta importação com

arquivos texto, webservices ou outros serviços de integração de dados.

Em seguida, o modelo de dados precisou ser convertido em proposições para que

pudesse ser empregado o provador automático de teoremas. De modo geral, trata-se de um

problema muito semelhante à conversão de expressões em linguagem natural para a lógica

matemática. Neste caso, é convertido um atributo de banco de dados para um predicado

lógico. Por exemplo, o atributo de banco “Número do sinistro” é representado pelo predicado

sinistro(*x), e o atributo “Data de início de vigência da apólice” é representado pelo predicado

inicio_vigencia_apolice(*d,*m,*a). No Anexo A é apresentada a conversão completa do

modelo de dados em proposições a serem utilizados no provador automático de teoremas.

Todas as colunas do banco de dados são enviadas ao Witty sem formatação,

pontuação e respeitando o alfabeto utilizado pela ferramenta. Caso uma coluna não seja

utilizada, não há necessidade de geração de predicados.

5.4. Base de Conhecimento

A base de conhecimento foi dividida em fatos e regras. Os fatos são os dados de

sinistro enviados pela conexão TCP/IP e oriundos do sistema legado de gestão de sinistros da

seguradora. As regras, por sua vez, fazem parte da solução proposta neste trabalho e

representam o conhecimento (explícito ou tácito) dos especialistas em fraudes. Para que os

fatos possam ser compreendidos pelo Witty, foi necessário montar linhas de comando

compatíveis com a linguagem de programação nativa do mesmo. Por exemplo, um sinistro a

ser classificado é caracterizado por uma base de conhecimento, e a criação desta base é feita

pelo comando newbase. Os fatos que descrevem o sinistro são inseridos na base de

conhecimento pelo comando assert. Assim, uma linha de comando do SPCF que informa ao

Witty sobre um sinistro poderia ser descrita com a seguinte estrutura:

newbase(número do sinistro)&

assert(número do sinistro, nome_condutor(nome condutor))

37

É claro que outros asserts precisam ser realizados para que todos os atributos do

banco de dados possam ser representados em lógica matemática. O Anexo B apresenta a

estrutura completa de uma linha de comando do SPCF que é enviada ao Witty.

A complementação da base de conhecimento é feita com um conjunto de regras

associadas ao conhecimento especializado sobre o processo de identificação de fraudes. Neste

sentido, foram realizadas duas entrevistas:

(1) com um analista especialista em sistemas de travas em sinistros suspeitos com

mais de 20 anos de experiência na regulação de sinistros de automóveis;

(2) com o proprietário de uma corretora de seguros de automóveis que possui uma

carteira de aproximadamente 800 assegurados e 15 anos de existência.

As entrevistas permitiram a construção das regras e também apontaram que, uma

das três maiores seguradoras do Brasil processa em média 300 mil sinistros por ano, sendo

esperados 18% de falsos negativos. Sendo assim, sabe-se que são esperados 54.000 sinistros

fraudulentos neste caso.

Nessas entrevistas também foi prospectado que o tempo de análise e regulação

máximo de um sinistro é de 30 dias, e que quando um sinistro é tratado como suspeito tem 7

dias no máximo para análise de possíveis fraudes. Não foi apontada nenhuma solução