Uma Estratégia de Preparação de Dados para Aumento de

Precisão de Modelos de Classificação da Produtividade de

Cana-de-açucar

Maria das Graças J.M. Tomazela¹, Luiz Antônio Daniel¹

¹Faculdade de Tecnologia de Indaiatuba (FATEC-ID)

Rua Dom Pedro I, 65 - Cidade Nova - Indaiatuba – SP – Brasil

[email protected], [email protected]

Abstract. This research has the objective of applying data preparation techniques to

the sugarcane productivity information related to the 2009/2010 harvest, supplied by

a group that produces sugar and ethanol from Ribeirão Preto region, in order to

increase the precision of productivity classification model. Were used to attribute

selections techniques and balance methods as strategy to achieve the aim.. The

classification of reduced model compared with the full model showed similar

accuracy, which enable the use of reduced model that allow a simpler analysis. The

balance SMOTE method used for “very high” class resulted in a great classifier

performance and lower error rate.

Resumo. Este trabalho objetivou a aplicação de técnicas de preparação de dados a

partir dos dados de produtividade de cana-de-açúcar referentes à safra 2009/2010,

cedidos por um grupo produtor de açúcar e etanol da região de Ribeirão Preto,

visando ao aumento da precisão de um modelo de classificação de produtividade.

Foram utilizadas técnicas de seleção de atributos e de balanceamento de membros

por classe como estratégia para obtenção do objetivo proposto. A classificação do

modelo reduzido de dados apresentou acurácias semelhantes àquelas obtidas para o

modelo completo, o que viabiliza a utilização do modelo reduzido, pois as análises

podem ser mais simples. A utilização do método SMOTE de balanceamento para a

classe “muito alta” resultou em ótimo desempenho dos classificadores e baixa taxa

de erro.

1. Introdução

O agronegócio brasileiro desempenha um importante papel na economia brasileira,

destacando-se nesse contexto a cana-de-açúcar. O aquecimento global e a busca por

alternativas à queima de combustíveis fósseis tornam o etanol uma importante fonte de

energia renovável. Além disso, destaca-se a produção de açúcar, cujo valor médio da

tonelada vem apresentando um crescimento ao longo dos últimos anos, passando de US$

279,35 a US$ 458,04, de 2005 a 2009 respectivamente (MAPA 2009).

Destaca-se nesse cenário, o desempenho do estado de São Paulo, tanto em

produção quanto em produtividade. Neste trabalho são utilizados os dados do censo

varietal qualitativo - safra 09/10, referentes à cana-de-açucar, cedidos por um dos maiores

Grupos sucroenergéticos do Brasil, segundo a União da Indústria de Cana-de-Açúcar

(UNICA), sediado na região de Ribeirão Preto. O Grupo possui três usinas em operação,

duas delas produzem açúcar e etanol e uma é dedicada à produção exclusiva de etanol. As

1

três usinas geram energia elétrica a partir da queima do bagaço da cana, garantindo

autossuficiência e venda do excedente.

O índice médio de mecanização da colheita do Grupo é de 82%, chegando a 100%

em uma das usinas, índices considerados referência no setor. O Grupo processou na safra

2009/2010 12,9 milhões de toneladas de cana, resultando em cerca de 702 mil toneladas de

açúcar, 594 milhões de litros de etanol e 158 mil MWh de energia elétrica.

Uma das principais componentes da estratégia do Grupo é continuar a reduzir

custos operacionais e aumentar a eficiência das operações, por meio de investimentos em

tecnologia, incluindo processos agrícolas, industriais, logísticos e de tecnologia da

informação.

Para dar subsídio a esta redução de custos e aumento de eficiência propõe-se a

utilização de técnicas de mineração de dados, que segundo HAN e KAMBER (2006) é a

”extração ou mineração de conhecimento de grande quantidade de dados”. Ferramentas de

mineração de dados podem ajudar no processo decisório das organizações por meio de

análise nos dados e descoberta de padrões interessantes, novos e úteis.

A Mineração de dados faz parte de um processo denominado “Descoberta de

Conhecimento em Bases de Dados”, conhecido como KDD (Knowledge Discovery in

Databases). O processo de KDD pode ser dividido em três etapas operacionais

(GOLDSCHMIDT e PASSOS, 2005):

1)Pré-Processamento- Nesta etapa é realizada a preparação dos dados até que

fiquem no formato necessário para a execução mineração. Consiste nas atividades de

limpeza, integração, seleção e transformação de dados.

2)Mineração de Dados- Durante essa etapa é realizada a busca do conhecimento

conforme o contexto a ser analisado através da ferramenta de KDD. É a principal etapa no

processo e consiste na aplicação de técnicas inteligentes para obter a extração de padrões

de interesse do usuário.

3)Pós-Processamento- Etapa responsável por realizar o tratamento do conhecimento

obtido na Mineração de Dados. É importante, nesta etapa, a análise dos resultados por

especialistas da área do problema que está sendo minerado.

O objetivo deste trabalho é aplicar técnicas de preparação de dados a partir dos dados

de produtividade de cana-de-acúcar referentes à safra 2009/2010, cedidos pelo do Grupo

sucroenergético citado, visando ao aumento da precisão de um modelo de classificação de

produtividade. Utilizam-se técnicas de seleção de atributos e de balanceamento de

membros por classe como estratégia para obtenção do objetivo proposto.

2.Material e Métodos

Como citado, neste trabalho foram utilizados os dados do censo varietal qualitativo - safra

09/10, referentes à cana-de-açucar, cedidos por um dos maiores Grupos sucroenergéticos

do Brasil sediado na região de Ribeirão Preto.

A planilha com os dados do censo contém em cada instância os seguintes atributos:

código da fazenda, código da gleba, código do talhão, tipo de solo, variedade da cana,

espaçamento, datas (divididas em: plantio, corte 1, corte anterior e corte atual), estágio de

2

corte, tipo de corte, condição de corte, vinhaça, fórmula do adubo, adubação (Kg/ha) e

produtividade (t/ha).

Os atributos código da fazenda, código da gleba e código do talhão identificam

cada instância, mas não é necessária a utilização destes atributos no processo de mineração

de dados, as datas também não foram usadas porque o atributo estágio de corte resume

estas informações. Também não foi utilizado o atributo vinhaça por não ser relevante para

o contexto de produtividade em análise. Desta forma o conjunto de dados resultante para

este estudo é composto por 9 atributos e 6730 instâncias.

Na Tabela 1 são apresentadas as características de cada atributo utilizado neste

trabalho. Ressalta-se que o atributo Produtividade*, com valores entre 12.51 e 201.81

toneladas por hectare, foi discretizado pelo método de particionamento baseado em

distância (Equi-width) que divide os valores de um determinado atributo em um número

de intervalos, especificado pelo usuário, com tamanhos iguais (HAN e KAMBER, 2006).

Foram utilizados 5 intervalos, classificando a produtividade como: “muito baixa”, “baixa”,

“média”, “alta” e “muito alta”. Esta classificação da produtividade foi feita com a ajuda de

um especialista na área agrícola.

Tabela 1 – Atributos utilizados no modelo

Atributo

Tipo

Valores

distintos

Solo

nominal

38

Variedade

nominal

65

Espaçamento

nominal

3

Estágio de corte

nominal

16

Tipo de corte

nominal

4

Condição de corte

nominal

2

Fórmula do adubo

nominal

13

Adubação

numérico

779

Produtividade*

numérico

3935

Para atingir o objetivo da pesquisa foi utilizada a ferramenta WEKA (Waikato

Environment for Knowledge Analysis). WEKA é uma ferramenta de mineração de dados

de código aberto, desenvolvida pelo departamento de Ciência da Computação da

Universidade de Waikato da Nova Zelândia. Implementa os principais algoritmos das

tarefas de mineração: classificação, associação e clusterização. Implementa também

diversos métodos de seleção de atributos e de balanceamento de classes.

Neste estudo de caso foi utilizada inicialmente a tarefa de classificação para todo o

conjunto de dados. A Classificação é citada por GOLDSCHIMIDT e PASSOS (2005)

como uma das tarefas de KDD mais populares e importantes, consiste na busca por uma

função que permita associar corretamente cada instância do banco de dados a uma classe.

Para isso é necessário encontrar um modelo para o atributo alvo, utilizando uma função

3

aplicada nos valores de outros atributos. A produtividade da cana-de-acúcar foi definida

como atributo alvo neste estudo.

Para a realização da tarefa de classificação foram utilizados alguns dos principais

métodos classificadores propostos na literatura: árvores de decisão, classificador Bayesiano

simples e K-vizinhos mais próximos (K-NN). Estes métodos são descritos em detalhes em

HAN e KAMBER (2006) e também em GOLDSCHMIDT e PASSOS (2005). A utilização

de métodos de classificação tem o objetivo de verificar a capacidade preditiva do modelo

estudado.

Os algoritmos de classificação utilizam uma parte do conjunto de dados para

treinamento e uma parte para validação do modelo. Na primeira etapa do trabalho foram

utilizadas duas abordagens para esta divisão: 1) Percentage Split: que divide os dados em

dois grupos – geralmente dois terços para o conjunto de treinamento e um terço para o

conjunto de teste e 2)k-fold cross-validation (validação cruzada), que divide o conjunto de

dados em K partes, separa uma parte para teste e realiza o treinamento com as demais

partes; este procedimento é repetido para todas as partes. A acurácia final do modelo é a

média das acurácias parciais calculadas para cada parte. A validação cruzada apresenta

bons resultados quando o conjunto de dados é pequeno.

Quanto melhor a qualidade dos dados melhores serão os resultados do processo de

mineração de dados. Neste sentido o segundo passo deste trabalho foi a utilização de

métodos de seleção de atributos. O objetivo da seleção de atributos é remover atributos

irrelevantes ou redundantes, reduzindo desta forma o tamanho do conjunto de dados e

facilitando a análise dos resultados no processo de mineração. Os atributos selecionados

devem resultar na distribuição dos dados nas classes o mais próximo possível da

distribuição obtida utilizando todos os atributos (HAN e KAMBER, 2006).

Os métodos de seleção de atributos são geralmente classificados como filtros e

wrappers ((DASH e LIU,1997), (GUYON e ELISSEEFF A, 2003), ( HALL e HOLMES, 2006)

(MARK et all., 2003), (PRATI et all, 2006)). Wrappers avaliam os atributos utilizando a

acurácia obtida por um algoritmo de aprendizado especificado. Filtros se baseiam nas

características dos dados e trabalham de forma independente dos algoritmos de

aprendizado. Segundo HALL e HOLMES (2003) uma taxonomia útil das técnicas de

seleção de atributos é a que divide os algoritmos em: 1)aqueles que avaliam e definem o

ranqueamento dos atributos de forma individual em relação ao atributo classe e 2)aqueles

que avaliam subconjuntos de atributos, para pares de atributos com forte correlação um

deles pode ser descartado para reduzir redundância, os atributos escolhidos são aqueles

que possuem alta correlação com o atributo classe.

Na Tabela 2 são apresentados os métodos de seleção de atributos utilizados neste

estudo de caso. Após análise dos resultados obtidos com estes métodos foram selecionados

4 atributos e o processo de classificação foi realizado novamente, utilizando-se a mesma

metodologia utilizada no conjunto completo.

Tabela 2 – Métodos de seleção de atributos utilizados

Método

Característica

CFS - Correlation-based feature selection

Correlação baseada em subconjunto de

atributos

4

Qui-quadrado (Chi-squared Ranking Filter)

Avalia relação de cada atributo com a classe

Ganho de informação (Information Gain Ranqueia os atributos através do ganho de

informação

Ranking Filter)

Taxa de ganho de informação (Gain Ratio Ranqueia os atributos através da incorporação

de quantidade de informação

feature evaluator)

segmentada

Wrapper (utilizando árvore de decisão)

Avalia conjuntos de atributos usando um

algoritmo de aprendizado de máquina

Muitos aspectos influenciam o desempenho dos classificadores, a existência de

classes desbalanceadas é um dos fatores que podem interferir negativamente no

desempenho dos algoritmos de aprendizado de máquina (PRATI et all., 2007). A

existência de classes desbalanceadas ocorre quando o número de elementos entre as classes

é desproporcional, nestes casos, exemplos da classe minoritária são geralmente

classificados erroneamente. Na Tabela 3 é apresentado o número de instâncias de cada

classe do modelo sob análise. A classe “muito baixa” representa 1.85% das instâncias, a

classe “baixa” representa 34.8%, a classe “média” possui 56% das instâncias, a classe

“alta” representa 7.2% do conjunto e a classe “muito alta” contribui apenas com 0.15% dos

elementos.

Tabela 3 – Distribuição das Instâncias por classe

Classes

Num. Elementos

“muito baixa”

125

“baixa”

2341

“média”

3768

“alta”

486

“muito alta”

10

A partir dos dados da Tabela 3 pode-se verificar que as classes “muito baixa”,

“alta” e “muito alta” podem ser consideradas classes minoritárias, em especial a

porcentagem de instâncias da classe “muito alta” é extremamente menor que as demais.

Desta forma a terceira etapa deste processo de preparação de dados se constituiu na

utilização de métodos de balanceamento de classes. Os métodos de balanceamento de

classes trabalham de duas formas diferentes: inserem elementos na classe minoritária (over

sample) ou, eliminam elementos da classe majoritária (under sample). Neste trabalho

foram usados dois métodos, que utilizam heurísticas com base no algoritmo K- vizinhos

mais próximos (K-NN), para a inserção/ remoção dos exemplos : Smote, que é um método

over sample e NCL (Neighborhood Cleaning Rule), que é um método under sample.

Experimentos foram realizados também utilizando uma técnica de amostragem

(Resample, no Weka) que balanceia um conjunto de dados por meio de uma amostragem

com reposição. A utilização desta técnica permite variar a proporção de exemplos entre as

classes, que pode ser similar à distribuição inicial ou próxima da distribuição balanceada.

5

Como os métodos de balanceamento devem ser aplicados apenas sobre o conjunto

de treino, utilizou-se, nesta etapa, a abordagem de divisão dos conjuntos de treinamento e

teste, denominada holdout. Desta forma primeiramente foi criado um conjunto de testes em

um arquivo separado, com 10% das amostras e, em seguida, os métodos de balanceamento

foram aplicados no conjunto de treinamento com 90% das amostras.

Para medir o desempenho dos métodos de classificação após o balanceamento das

classes foi utilizada a área abaixo da curva ROC1 (AUC - Area Under Curve), a medida

AUC especifica a probabilidade de um exemplo positivo ser ranqueado acima de um

exemplo negativo. Quanto maior a área, melhor é o desempenho médio do classificador.

ROC é um método gráfico para avaliação, organização e seleção de sistemas de

diagnóstico e/ou predição, a análise ROC é uma ferramenta especialmente útil para a

avaliação de modelos de classificação em que as classes são desbalanceadas (PRATI et

all., 2007).

Apresentam-se a seguir os resultados obtidos em cada etapa da realização do

método proposto para a preparação dos dados deste estudo de caso.

3. Resultados e Discussão

Este estudo foi realizado em três etapas, inicialmente foi realizada a tarefa de classificação

para o conjunto completo dos dados do estudo de caso. Foram selecionadas algumas das

principais técnicas de classificação propostas na literatura. Para cada técnica os seguintes

classificadores listados na Tabela 4 foram escolhidos:

Tabela 4 – Classificadores utilizados na ferramenta Weka

Técnica

Classificador

Árvores de decisão

J48

K-vizinhos mais próximos (K-NN)

IBK – K=1

K-vizinhos mais próximos (K-NN)

IBK –K =5

Classificador Bayesiano simples

Naïve Bayes

Da análise da Tabela 5 pode ser verificado que o modelo apresentou melhores acurácias

para a abordagem cross validation em três dos quatro algoritmos de classificação

utilizados. É interessante notar que, enquanto o algoritmo IBK para K =1 resultou em um

decréscimo na acurácia (0.45%) em relação à acurácia obtida utilizando-se percentage

split, o mesmo algoritmo para K = 5 resultou na maior taxa de acréscimo de acurácia (1.39

%) da abordagem cross validation em relação à abordagem percentage split.

Tabela 5 – Acurácia para o conjunto completo dos dados

1

Algoritmo

Acurácia –cross validation

Acurácia – percentage split

J48

87.6226 %

86.3636 %

IBK – K=1

87.3997 %

87.8497 %

IBK –K =5

86.2259 %

84.8339 %

ROC - Receiver Operating Characteristic

6

Naïve Bayes

70.5052 %

69.6374 %

A segunda etapa deste trabalho foi a utilização dos métodos de seleção de atributos

que resultou na classificação apresentada na Tabela 6. Ressalta-se que os métodos quiquadrado, ganho de informação e taxa de ganho de informação apresentam o

ranqueamento das variáveis, enquanto os métodos CFS e Wrapper apresentam apenas os

atributos que devem ser mantidos. Para o método qui-quadrado todos os atributos

apresentaram valores de ranqueamento superiores ao ponto de corte definido para o

método que é 3.841. Comparando-se os resultados obtidos nos cinco métodos de seleção

de atributos foram escolhidos os seguintes atributos: Adubação, Solo, Variedade, Estágio

Corte.

Tabela 6 – Ranqueamento dos atributos

Método

Atributos selecionados

CFS - Correlation-based feature selection

Adubação

Método de pesquisa: best first

Qui-quadrado (Chi-squared Ranking Filter)

Adubação,Solo, Variedade, Estágio Corte,

Formula Adubo, Tipo de Corte, Condição de

Corte,

Método de pesquisa: Attribute ranking

Espaçamento

Ganho de informação (Information Gain Adubação, Variedade, Solo, Estágio Corte,

Ranking Filter)

Formula Adubo, Espaçamento ,Tipo de Corte,

Condição de Corte

Método de pesquisa: Attribute ranking

Taxa de ganho de informação (Gain Ratio Adubação, Variedade, Solo, Estágio Corte,

feature evaluator)

Formula Adubo, Tipo de Corte, Condição de

Corte, Espaçamento

Método de pesquisa: Attribute ranking

Wrapper (utilizando J48)

Solo, Variedade, Estágio Corte, Tipo de Corte,

Adubação

Método de pesquisa: best first

Na Tabela 7 são apresentados os resultados obtidos com a classificação realizada a

partir do conjunto reduzido de dados. Para este conjunto a abordagem cross validation

obteve melhores acurácias para todos os algoritmos, vale lembrar que esta abordagem é

melhor para conjuntos pequenos, portanto com a redução dos atributos, e respectiva

redução do conjunto de dados, faz sentido que a utilização de cross validation produza

resultados ainda melhores quando comparados à abordagem percentage split.

Tabela 7 – Acurácia para o conjunto com seleção de atributos

Algoritmo

Acurácia –cross validation

Acurácia – percentage split

J48

87.2511 %

84.9213 %

IBK – K=1

85.6612 %

85.4458 %

IBK –K =5

85.3195 %

82.7797 %

Naïve Bayes

71.263 %

70.8042 %

7

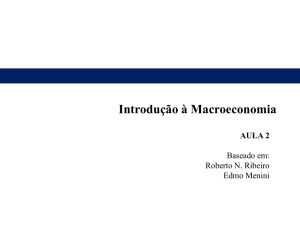

Na Figura 1 pode-se observar um gráfico comprarativo dos resultados obtidos para

os quatro algoritmos de classificação utilizados, tanto para o conjunto completo de dados

como para o conjunto gerado após a seleção de atributos. Verifica-se que os resultados

estão bem próximos para todos os classificadores, ressalta-se que para o classificador

Naïve Bayes a acurácia obtida foi ligeiramente maior para o conjunto de dados com

seleção de atributos, isto se deve ao fato que o melhor desempenho deste algoritmo se dá

quando as variáveis são independentes (HAN e KAMBER, 2006).

Acurácias

70

.5

71

.2

86

.2

85

.3

85

.6

87

.4

100

90

80

70

60

50

40

30

20

10

0

87

.6

87

.2

Comparação das acurácias do conjunto completo e do

conjunto com seleção de atributos ( utilizando cross validation)

conj.completo

seleção de atributos

J48

K-NN K=1

K-NN k=5

Naïve Bayes

Classificadores

Figura 1 – Comparação das acurácias obtidas para o conjunto completo e com Seleção de

atributos utilizando cross validation

A terceira etapa do trabalho consistiu na aplicação de métodos de balanceamento de

classes. Embora as classes “muito baixa” e “alta” estivessem com porcentagem de

instâncias bem inferior às instâncias das classes “baixa” e “média”, os valores de precisão

dessas duas classes minoritárias foram bem razoáveis para a maioria dos classificadores.

Analisando os resultados das classificações para o conjunto de dados com seleção

de atributos por meio da porcentagem de instâncias classificadas corretamente para cada

classe – taxa verdadeiro positivo (taxa TP –True Positive), verificou-se que a menor

porcentagem obtida para a classe “muito baixa” foi de 37.7%, para o algoritmo IBK – K=5,

utilizando percentage split e a maior taxa TP para esta mesma classe foi de 62.4% para os

algoritmos J48 e IBK com K=1, ambos utilizando cross validation.

Para a classe “alta” a menor taxa TP obtida foi de 16.7% para o algoritmo Naïve

Bayes utilizando percentage split e a maior taxa para esta mesma classe foi de 71.7% para

o algoritmo IBK – K=1, utilizando percentage split.

Com base nestes resultados optou-se pela análise dos resultados dos métodos de

balanceamento apenas para a classe “muito alta” que obteve taxa TP de 0% para a maioria

dos classificadores.

Na Tabela 8 estão resumidos os dados obtidos utilizando a técnica de amostragem

Resample, ajustando o parâmetro “biasToUniformClass” (Weka) para variar a proporção

de exemplos entre as classes, 0 indica distribuição similar à distribuição inicial e 1 indica

distribuição próxima da balanceada. A coluna Erro(%) diz respeito à porcentagem de erro

do classificador e a coluna AUC(%) contém os valores AUC para a classe “muito alta”.

8

Observa-se que para a técnica Resample o algoritmo J48 possui resultados muito bons para

os valores 0.5 e 1 do parâmetro “biasToUniformClass” – 100%, com a 2ª. menor

porcentagem de erro. O algoritmo IBK – K=1 possui as menores porcentagens de erro, mas

os valores AUC variam em torno de 50%.

Tabela 8 – Desempenho dos classificadores utilizando Resample

Conjunto Algoritmo

0

de dados

J48

Resample

AUC (%)

IBK – K=1

IBK –K =5

Naïve Bayes

Erro (%)

0.5

48.7

50

56.8

99.7

100

49.93

61.5

100

1

0

99.9

49.78

66.15

100

14.11

13.07

14.11

28.23

0.5

15.45

14.56

18.87

36.99

1

20.05

16.64

26.89

47.54

Na Tabela 9 são apresentados os dados dos métodos de balanceamento Smote e

NCL, as porcentagens de erro de cada classificador são, em sua maioria, menores que as

taxas de erro utilizando Resample, além disso os valores de AUC são superiores a 98%

para todos os classificadores. O classificador Naïve Bayes possui as maiores taxas de erro

para todas as técnicas de balanceamento utilizadas neste experimento. Comparando-se as

taxas de erro de cada classificador para os métodos Smote e NCL verifica-se que o método

Smote possui taxa de erros menores.

Tabela 9 – Desempenho dos classificadores com Smote e NCL

Algoritmo

AUC (%)

Erro (%)

J48

99.78

13.5215

IBK – K=1

100

11.4413

IBK –K =5

98.81

14.2645

Smote

NaïveBayes

99.7

28.529

J48

99.93

16.0475

IBK – K=1

100

14.8588

IBK –K =5

99.55

16.3447

NCL

NaïveBayes

99.85

32.838

Após o balanceamento com Resample, ajustado para 0.5 e para 1, todos os classificadores

foram capazes de identificar 100% das instâncias da classe “muito alta”. Utilizando Smote

somente o classificador IBK K=1 obteve esta porcentagem e utilizando NCL os

classificadores IBK K=1 e Naïve Bayes conseguiram classificar corretamente as instâncias

da classe minoritária.

9

Na Figura 2 tem-se a matriz de confusão para o algoritmo J48, utilizando-se a técnica de

amostragem Resample, ajustado para 0.5. Uma matriz de confusão resume o total de

instâncias que foram classificadas corretamente e as que foram incorretamente

classificadas para cada classe, na diagonal principal da matriz estão as instâncias

corretamente classificadas. Pode-se observar que o único elemento da classe “muito alta”

foi corretamente classificado, entretanto existem 4 instâncias classificadas incorretamente

como “muito alta” (falsos positivos). Existem domínios em que o custo de não se

determinar um verdadeiro positivo para a classe minoritária é muito maior do que o custo

de se classificar erroneamente uma instância como positiva, como por exemplo, nos casos

de diagnósticos de doenças graves. Portanto a decisão da utilização da técnica de

balanceamento deve ser cuidadosamente avaliada para cada domínio.

=== Confusion Matrix ===

a

b

c d

e

<-- classified as

8

2

2

0

0

| a = 'muito baixa'

13 187 24 9

1

| b = 'baixa'

2 25 337 11 2

| c = 'média'

0 3 15

30 1

| d = 'alta'

0 0 0

0

| e = 'muito alta'

1

Figura 2 – Matriz de confusão utilizando J48 e Resample

4. Conclusões

Neste trabalho foram realizados experimentos para a preparação de dados referentes à

produtividade de cana-de-açúcar da safra 2009/2010 de um Grupo sucroenergético do

Estado de São Paulo. O objetivo da realização destes experimentos é aumentar a precisão

de um modelo de classificação de produtividade.

O experimento foi realizado em três etapas. Na primeira etapa foram utilizados os

algoritmos de classificação J48, IBK para K=1 e K=1 e Naive Bayes, com as abordagens

cross validation e porcentage split. Na segunda etapa foram aplicados os métodos de

seleção de atributos CFS, Qui-quadrado, Ganho de informação, Taxa de ganho de

informação e Wrapper. A partir da análise dos resultados destes métodos os seguintes

atributos foram escolhidos: Adubação, Solo, Variedade, Estágio Corte. Os algoritmos de

classificação utilizados na primeira etapa do estudo de caso foram utilizados para o

conjunto de dados reduzido pela seleção de atributos. A classificação utilizando cross

validation apresentou melhores resultados tanto para o conjunto completo como para o

conjunto reduzido pelo número de atributos. As acurácias de cada classificador,

comparando-se os valores obtidos no conjunto completo e no conjunto reduzido, foram

muito próximas, o que viabiliza a utilização do conjunto reduzido, uma vez que a análise

de conjuntos menores pode ser mais simples.

10

A terceira etapa do experimento consistiu na utilização de métodos de

balanceamento uma vez que havia três classes, das cinco utilizadas para a classificação,

com porcentagem muito pequena de instâncias. A análise do balanceamento aplicado foi

realizada somente para a classe “muito alta”, que possui apenas 0.15% das instâncias. Foi

utilizada a técnica de amostragem Resample e os métodos de balanceamento Smote e NCL.

Da análise dos métodos de balanceamento verificou-se que o método Smote obteve valores

acima de 98% para a AUC, que verifica o desempenho médio do classificador, e também

obteve as menores taxas de erro de classificação para todos os classificadores utilizados no

experimento. Além disso, após a utilização da técnica de amostragem Resample, ajustada

para 0.5 e 1, obteve-se 100% de classificação correta (verdadeiro positivo) para as

instâncias da classe minoritária “muito alta”, para todos os classificadores utilizados no

experimento.

5. Referências

Dash, M.; Liu, H. Feature Selection For Classification. Intelligent Data Analysis 1, P.

131–156, Elsevier, 1997.

Goldschmidt R.; Passos E. Data Mining – Um Guia Prático. Rio De Janeiro: Elsevier,

2005.

Guyon I. ; Elisseeff A. An Introduction To Variable And Feature Selection. Journal Of

Machine Learning Research 3, 2003.

Hall, M.A.; Holmes, G. Benchmarking Attribute Selection Techniques For Discrete Class

Data Mining. Ieee Transactions On Knowledge And Data Engineering, Vol. 15, No. 3,

May/June, 2003.

Han, J. ; Kamber, M. Data Mining: Concepts And Techniques. Second Edition, Morgan

Kaufmann, 2006.

Mapa - Ministério Da Agricultura, Pecuária E Abastecimento. Estatísticas. Disponível

Em:

<Http://Www.Agricultura.Gov.Br/Pls/Portal/Docs/Page/Mapa/Estatisticas/Co

Mercio_Exterior_Brasileiro/21exp.%20anual%20a%C7ucar.Pdf>.

Acesso

Em:

27/11/2009.

Prati, R. C. ; . Batista G. E. A. P. A E; Monard, M. C. Curvas Roc Para Avaliação De

Classificadores, 2006.

11