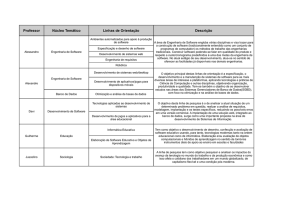

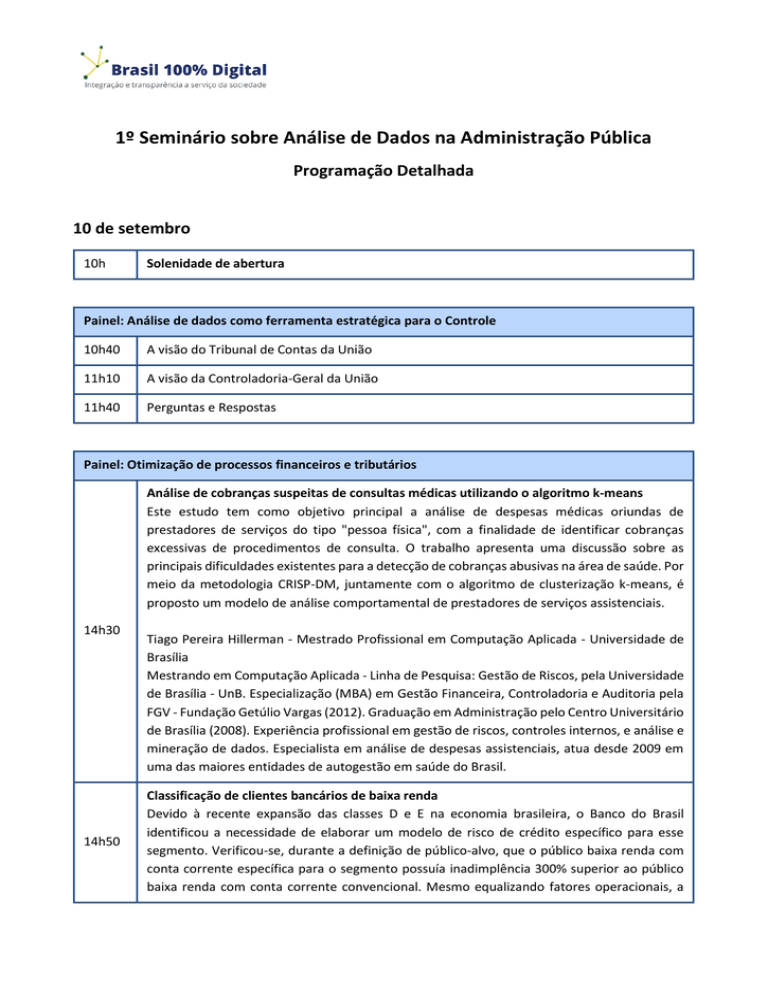

1º Seminário sobre Análise de Dados na Administração Pública

Programação Detalhada

10 de setembro

10h

Solenidade de abertura

Painel: Análise de dados como ferramenta estratégica para o Controle

10h40

A visão do Tribunal de Contas da União

11h10

A visão da Controladoria-Geral da União

11h40

Perguntas e Respostas

Painel: Otimização de processos financeiros e tributários

Análise de cobranças suspeitas de consultas médicas utilizando o algoritmo k-means

Este estudo tem como objetivo principal a análise de despesas médicas oriundas de

prestadores de serviços do tipo "pessoa física", com a finalidade de identificar cobranças

excessivas de procedimentos de consulta. O trabalho apresenta uma discussão sobre as

principais dificuldades existentes para a detecção de cobranças abusivas na área de saúde. Por

meio da metodologia CRISP-DM, juntamente com o algoritmo de clusterização k-means, é

proposto um modelo de análise comportamental de prestadores de serviços assistenciais.

14h30

14h50

Tiago Pereira Hillerman - Mestrado Profissional em Computação Aplicada - Universidade de

Brasília

Mestrando em Computação Aplicada - Linha de Pesquisa: Gestão de Riscos, pela Universidade

de Brasília - UnB. Especialização (MBA) em Gestão Financeira, Controladoria e Auditoria pela

FGV - Fundação Getúlio Vargas (2012). Graduação em Administração pelo Centro Universitário

de Brasília (2008). Experiência profissional em gestão de riscos, controles internos, e análise e

mineração de dados. Especialista em análise de despesas assistenciais, atua desde 2009 em

uma das maiores entidades de autogestão em saúde do Brasil.

Classificação de clientes bancários de baixa renda

Devido à recente expansão das classes D e E na economia brasileira, o Banco do Brasil

identificou a necessidade de elaborar um modelo de risco de crédito específico para esse

segmento. Verificou-se, durante a definição de público-alvo, que o público baixa renda com

conta corrente específica para o segmento possuía inadimplência 300% superior ao público

baixa renda com conta corrente convencional. Mesmo equalizando fatores operacionais, a

diferença se mantinha. Era necessário, portanto, investigar melhor a diferença entre os

públicos.

Durante o estudo sobre os públicos, foi construído modelo para prever em qual segmento um

novo cliente se enquadraria (público com alta inadimplência X público com baixa

inadimplência). Foi avaliado também o perfil dos clientes para desenvolvimento de estratégias

negociais.

Felipe Alves Fonseca - Banco do Brasil

Bacharel em Estatística (UnB) e pós-graduado em Mercado Financeiro e Investimentos (UnB),

é funcionário do Banco do Brasil desde 2009. Atuou como assessor na área de CRM,

desenvolvendo modelos de propensão ao consumo de produtos bancários, e exerce, desde

2012, a função de assessor na área de Modelagem de Risco de Crédito, desenvolvendo

modelos de classificação de risco de operações de crédito e modelos preditivos de risco de

crédito para os públicos pessoa física, produtor rural e micro e pequenas empresas.

15h10

Algoritmo para classificação de empresas em setores econômicos

A Fiscalização das obrigações tributárias de uma empresa passa, muitas vezes, por uma análise

comparativa entre contribuintes semelhantes. Essa semelhança pode se dar sob várias óticas,

sendo a do setor econômico, certamente, uma de grande relevância. Essa estratificação em

setores torna possível a crítica de valores declarados ou arrecadados e sugere distorções ou

incompatibilidades. Nesse contexto, o projeto de um algoritmo que possibilite uma

classificação automatizada de contribuintes em códigos da CNAE, é visto com muito interesse

pela Adm. Tributária. O trabalho, por meio de dados como a cesta de produtos comercializada

ou produzida, detecta possíveis similaridades entre contribuintes e infere seus setores

econômicos principais por meio da CNAE.

Leonardo Teles de Carvalho - Receita Federal do Brasil

Auditor Fiscal da Receita Federal do Brasil desde 2013. Engenheiro de Controle e Automação,

graduado pela UFMG em 2006. Mestre em Engenharia Elétrica, pela UFMG, em 2012.

15h30

Análise das comunicações de movimentações em espécie da administração pública para a

identificação de padrões nos saques e depósitos, visando a mitigação do risco de lavagem

de dinheiro

A missão do Conselho de Controle de Atividades Financeiras consiste em prevenir a utilização

dos setores econômicos para a lavagem de dinheiro e financiamento do terrorismo,

promovendo a cooperação e o intercâmbio de informações entre os Setores Público e Privado.

Para tanto, realiza constantemente análises estratégicas visando a mitigação do risco de

lavagem de dinheiro. Tendo em vista a previsão legal que limita o saque em espécie de entes

públicos, este trabalho utilizou técnicas de mineração de dados visando a identificação de

padrões nas movimentações em espécie da administração pública e dos principais atores

responsáveis por essas movimentações. A partir dos resultados foi possível identificar

determinados padrões associados a saques e depósitos em espécie de entes públicos,

juntamente com os respectivos responsáveis.

Clesito Cezar Arcoverde Fechine - Conselho de Controle de Atividades Financeiras

Graduado em estatística pela Universidade Federal do Rio Grande do Norte e Especialista em

Métodos Quantitativos pela Universidade de Brasília, foi Coordenador-Geral de Informações

Estratégicas e Diretor do Siconv na SLTI do MPOG. Atualmente é Coordenador-Geral de Gestão

da Informação no COAF

15h50

Perguntas e Respostas

Painel: Análise de textos e dados não estruturados

16h30

Aplicação de técnicas de mineração de textos para classificação automática de denúncias:

um estudo de caso da automatização da triagem de denúncias na CGU

O uso de classificação automática de textos tem se tornado cada vez mais comum nos últimos

anos. Contudo, ao se trabalhar com classificação em larga escala, a complexidade aumenta

consideravelmente. Foi realizado um estudo de caso, aplicado à triagem de denúncias na

Controladoria Geral da União, utilizando uma grande quantidade de categorias a serem

classificadas. A solução proposta empregou aprendizagem de máquina e classificação multilabel. Essas técnicas tiveram como objetivo a construção de um modelo capaz de solucionar

adversidades inerentes a este contexto, apresentando ganhos significativos

Patrícia Helena Maia Alves de Andrade - Controladoria-Geral da União

Analista de Finanças e Controle da CGU, atuando na área de mineração de textos e análise de

dados, na Diretoria de Pesquisa e Informações Estratégicas. Atualmente está finalizando o

Mestrado Profissional em Computação Aplicada na Universidade de Brasília

16h50

Classificação automatizada de produtos em compras públicas

A correta classificação dos bens e serviços licitados pelo governo federal ajuda nas tarefas de

controle e fiscalização das compras públicas. Hoje, porém, essa classificação é feita

manualmente e baseada em duas taxonomias (CATMAT e CATSER) altamente imperfeitas.

Além disso estados e municípios frequentemente não usam qualquer taxonomia, o que torna

ainda mais difícil a tarefa dos órgãos de controle. O objetivo desta palestra é discutir como

automatizar essa classificação com base na descrição dos bens e serviços

Thiago Marzagão - Conselho Administrativo de Defesa Econômica

Cientista de dados, doutor pela Ohio State University, Especialista em Políticas Públicas e

Gestão Governamental

17h10

Identificação automática de tipos de pedidos mais frequentes da LAI

Essa palestra apresenta o uso de Mineração de Textos para identificar os principais tipos de

pedidos diferentes que são feitos no sistema e-SIC através da LAI. Foram analisados mais de

300 mil pedidos. O processamento desses dados na forma tradicional leva mais de 240 horas,

ou 10 dias corridos. Já com o uso de técnicas de Big Data, foi possível diminuir esse

processamento para menos de 8 horas

Rommel Novaes Carvalho - Controladoria-Geral da União

Coordenador-Geral do Observatório da Despesa Pública da CGU, realizou seu PhD e Pós-Doc

na George Mason University, EUA, na área de Inteligência Artificial, Web Semântica e

Mineração de Dados e também é professor do Mestrado Profissional em Computação

Aplicada da UnB

17h30

Perguntas e Respostas

11 de setembro

Painel: Classificação de risco na Administração Pública

10h

Detecção preventiva de fracionamento de compras

Essa palestra apresenta o uso de Mineração de Dados para identificar fracionamentos de

forma proativa, ou seja, antes mesmo do fracionamento se concretizar. Dessa forma, é

possível alertar o usuário e evitar que a irregularidade aconteça. Nesse trabalho, foram

utilizados diversos algoritmos diferentes de classificação, todos baseados em redes

bayesianas. Foram analisadas mais de 50 mil compras na área de TI e o modelo final foi capaz

de classificar corretamente todos os casos de fracionamento de forma proativa e obteve uma

acurácia geral de 99,197%

Rommel Novaes Carvalho - Controladoria-Geral da União

Coordenador-Geral do Observatório da Despesa Pública da CGU, realizou seu PhD e Pós-Doc

na George Mason University, EUA, na área de Inteligência Artificial, Web Semântica e

Mineração de Dados e também é professor do Mestrado Profissional em Computação

Aplicada da UnB

10h20

Classificação de risco de transferências voluntárias

Transferências voluntárias são transferências de recursos da União para estados, municípios

e entidades privadas para a implementação de políticas públicas, normalmente em caráter

local, restrito ao âmbito de atuação do beneficiário dos recursos. A partir de exemplos com

resultado conhecido e com uso de mineração de dados, criou-se modelo de predição de

fracasso ou êxito da política pública em nível local, associando-se uma probabilidade para cada

valor predito.

Partindo do fato de que transferências voluntárias são similares apenas em aspectos formais,

notadamente os instrumentos de celebração e execução, e heterogêneas em relação ao

conteúdo e finalidade, em razão das especificidades de cada política pública, o desafio do

trabalho consistiu em prever o resultado da execução – um aspecto finalístico – a partir de

aspectos formais constantes dos respectivos instrumentos.

João Batista Rodrigues Fonseca - Tribunal de Contas da União

Auditor Federal de Controle Externo do TCU desde 2004, servidor da Secretaria Federal de

Controle Interno, atualmente órgão da Controladoria-Geral da União, de 1995 a 2004,

bacharel em matemática pela Universidade de Brasília, especialista em Regulação de

Telecomunicações pela Universidade de Brasília

10h40

Identificação algorítmica de cartéis

Como automatizar a identificação de cartéis em compras públicas? O governo federal sozinho

abre cerca de 300 licitações por dia. Somem-se a isso as licitações estaduais e municipais e fica

claro que é impossível inspecionar cada licitação individualmente. A Administração precisa

portanto de métodos automatizados de detecção de cartéis. O CADE vem desenvolvendo

esses métodos e o objetivo desta palestra é apresentar o que foi feito até agora

Lucas Freire - Conselho Administrativo de Defesa Econômica

Advogado, mestrando em economia do setor público na Universidade de Brasília, Especialista

em Políticas Públicas e Gestão Governamental

11h

Análise de risco nos contratos públicos de infraestrutura rodoviária

Primeiramente, serão apresentados aspectos essenciais do SAR (Sistema de Análise de Risco

em Contratos Rodoviários), atualmente utilizado pela Seinfrarodovia para a seleção de objetos

a serem fiscalizados (editais ou obras)

Em seguida, serão apresentados outros possíveis indicadores de riscos, associados aos

contratos de concessão da infraestrutura rodoviária, bem como as perspectivas de

aperfeiçoamento da seleção de objetos de auditoria, sobretudo baseadas na metodologia de

formação de indicadores de riscos para detecção de corrupção e conluio (Corruption Risk

Profiling in Public Procurement), desenvolvida pelo pesquisador Mihály Fazekas, produto de

parceria entre o Centro de Pesquisa de Budapeste e a Universidade de Cambridge

André Luiz Francisco da Silva Vital - Tribunal de Contas da União

Secretário da Secretaria de Fiscalização de Infraestrutura Rodoviária (Seinfrarodovia)

11h20

Perguntas e Respostas

Painel: Análise de créditos, orçamentos e preços

14h30

Uso de mineração de dados e textos para cálculo de preços de referência em compras do

governo brasileiro

Uma das grandes responsabilidades da CGU é identificar as compras do governo com valores

diferentes dos praticados pelo mercado. Dessa forma, é possível mensurar o grau de eficiência

das compras realizadas pelos órgãos governamentais. Essa informação é útil tanto para o

auditor, que é responsável por fiscalizar o uso dos recursos públicos, como para o gestor, que

pode melhorar seus processos observando as melhores práticas de outras unidades do

governo. Dada a enorme quantidade e a diversidade das compras realizadas pelo Governo,

essa análise se torna praticamente inviável sem a ajuda de algum mecanismo automatizado.

No entanto, para que essa análise automatizada seja possível, é preciso ter antes de tudo, uma

base de dados com os preços médios, ou de referência, para cada produto que se deseja

analisar. Apesar de todas as compras do Governo Federal serem inseridas em um sistema

único e centralizado, as informações armazenadas não são detalhadas e estruturadas o

suficiente para se calcular esses preços de referência.

Essa palestra apresenta a metodologia desenvolvida na CGU, baseada em técnicas de

mineração de dados, para extrair as informações necessárias desse sistema centralizado de

forma a possibilitar o cálculo de preços de referência para produtos comprados pelo Governo

Federal. Além disso, são apresentadas também algumas análises feitas com base no banco de

preços criado a partir dessa metodologia de forma a enfatizar sua importância para a melhoria

da gestão dos recursos públicos

Rommel Novaes Carvalho - Controladoria-Geral da União

Coordenador-Geral do Observatório da Despesa Pública da CGU, realizou seu PhD e Pós-Doc

na George Mason University, EUA, na área de Inteligência Artificial, Web Semântica e

Mineração de Dados e também é professor do Mestrado Profissional em Computação

Aplicada da UnB

Análise de orçamentos de obras de infraestrutura

14h50

Jedson Freire Passos - Tribunal de Contas da União

15h10

Análise de variáveis e construção de modelos preditivos para melhoria na seleção de

processos de compensação de crédito tributário

Um dos principais objetivos das administrações tributárias é promover a justiça fiscal e uma

forma de alcança-la é selecionar corretamente os contribuintes e processos para fiscalização.

Com a tendência global de redução de custos, recursos e quadro de profissionais, em contraste

com o aumento de contribuintes e processos a serem analisados, é primordial que as

administrações tributárias trabalhem de forma mais eficiente. Este trabalho utiliza técnicas de

mineração de dados para avaliar quais características dos contribuintes mais influenciam na

decisão de deferir ou indeferir uma solicitação de compensação tributária. Ademais, a partir

da seleção de algumas variáveis, criamos alguns modelos preditivos e realizamos comparações

para escolher a melhor para os dados disponíveis. A partir dos resultados foi possível

identificar possíveis aplicações práticas numa escolha mais eficiente de processos de

compensação na administração tributária brasileira

Leon Sólon da Silva - Secretaria da Receita Federal do Brasil

Auditor-Fiscal da Receita Federal e aluno do Mestrado Profissional em Computação Aplicada

15h30

Perguntas e Respostas

Painel: Relacionamentos e riscos na Administração Pública

16h10

Filiação partidária e risco de corrupção de servidores públicos federais

Esta palestra apresenta o trabalho referente a um estudo de caso de aprendizagem de

máquina aplicada para mensurar o risco de corrupção de servidores públicos federais usando

dados de filiação partidária. Inicialmente, um teste de hipótese verifica a dependência entre

corrupção e filiação partidária. Em seguida, são preparados três conjuntos de dados com

normalização e três técnicas diferentes de discretização. Usando o ambiente Weka, este

trabalho mostra a aplicação de quatro algoritmos de classificação para construir modelos de

previsão de risco de corrupção: Redes Bayesianas, Support Vector Machines, Random Forest

e Redes Neurais Artificiais com backpropagation.

Para avaliar os modelos, são usadas métricas como precisão, sensibilidade, kappa e acurácia.

Por último, o estudo de caso compara o modelo de melhor desempenho construído com um

modelo dos especialistas em combate à corrupção. A comparação não apenas confirma

afirmações dos especialistas, como também fornece novas visões sobre a relação filiaçãocorrupção

Ricardo Silva Carvalho - Controladoria-Geral da União

Graduado em Engenharia da Computação pelo Instituto Tecnológico de Aeronáutica (ITA).

Atualmente está finalizando Mestrado em Computação Aplicada na Universidade de Brasília

(UnB) trabalhando com projeto na área de Aprendizagem de Máquina. Ocupa cargo de

Analista de Finanças e Controle na Controladoria-Geral da União (CGU) com foco na

construção de modelos preditivos para mapeamento de risco de corrupção usando mineração

de dados. Tem experiência na área de Ciência da Computação, com ênfase em Inteligência

Artificial, Aprendizagem de Máquina, Mineração de Dados, Análise de Algoritmos e

Engenharia de Software

Um modelo bayesiano de análise de risco de conluio na relação UG x Fornecedor

Utilizamos um modelo baseado em probabilidade bayesiana para classificar os pares unidade

gestora X fornecedor em função da possibilidade de haver conluio ou algum tipo de

favorecimento ilícito entre eles. O modelo utiliza dados do sistema SIASG e é baseado numa

série de dimensões e regras de negócio levantadas junto aos auditores do TCU.

16h30

16h50

Remis Balaniuk é Auditor Federal de Controle Externo do Tribunal de Contas da União, Pósdoutor em Realidade Virtual pela Stanford University - EUA (2002), Doutor em Informática

pelo Institut National Polytechnique de Grenoble - França (1996), Mestre em Ciências da

Computação pela Universidade Federal do Rio Grande do Sul (1989) e Tecnólogo em

Processamento de Dados pela Universidade de Brasília (1986). No TCU ocupa cargo de

Especialista Sênior atuando com inteligência de negócio e mineração de dados.

Busca de vínculos na Administração Pública

Diversos são os bancos de dados da Administração Pública que contém relacionamentos entre

pessoas físicas e jurídicas. Combinados, eles têm o potencial de se tornar uma rica fonte de

identificação de vínculos, informação de grande utilidade em trabalhos de controle.

O desafio está em disponibilizar aos analistas soluções capazes de lidar com o grande volume

de dados dessas bases. Nessa apresentação, TCU e CGU apresentarão os trabalhos conjuntos

que vêm desenvolvendo para atacar esse problema

Gustavo Cordeiro Galvão Van Erven é Mestre em Computação Aplicada pela UnB e Analista de

Finanças e Controle na Diretoria de Pesquisas e Informações Estratégicas da ControladoriaGeral da União

Markus Buhatem Koch é Engenheiro de Controle e Automação e Auditor Federal de Controle

Externo no Tribunal de Contas da União, onde exerce a função de Diretor de Informações

Estratégicas

17h10

Perguntas e Respostas