UNIVERSIDADE DE PERNAMBUCO

ESCOLA POLITÉCNICA DO RECIFE

TRADUÇÃO DO CAPÍTULO 9 DO LIVRO

Spiegel, M, Schiller, J & Srinivisan, A. SHAUM’S EASY OUTLINES:

Probability and Statistics. Crash Course. McGraw-Hill, New York,

2001

RECIFE – 2010

Capitulo 9

Ajuste de Curvas, Regressão e Correlação

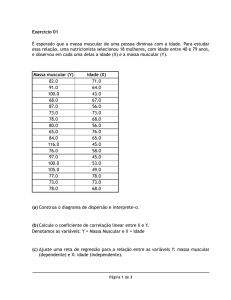

Muito frequentemente é constatado a existência de uma relação entre duas

variáveis( ou mais) e se deseja expressar tal relação sob forma matemática,

estabelecendo-se uma equação entre as variáveis. O primeiro passo para isso é a

coleta de dados exibindo os valores correspondente das variáveis. Por exemplo, sejam

x e y, respectivamente, altura e o peso de adultos de qualquer sexo. Uma amostra de

n indivíduos acusaria alturas x1,x 2,..., xn e os correspondentes pesos y1,y2,..., yn . Um

próximo passo é traçar os pontos ( x1, y1), (x2,y2)....(xn,yn) em um sistema de

coordenadas retangulares. O conjunto chama-se diagrama de dispersão.

A partir do diagrama de dispersão é visualizado uma curva aproximativa dos

dados.Curva essa chamada curva aproximadora. Na figura 9.1, por exemplo, os dados

parecem bem aproximados por uma linha reta , é nós dizemos que há uma relação

linear entre as variáveis. Na figura 9.2, conquanto exista uma relação entre as variáveis

, tal relacionamento não é linear, diz-se então que há uma relação não-linear entre as

variáveis. Na figura 9.3 não há nenhuma relação entre as variáveis.

O problema de determinar equações de curvas que se ajustem a determinados

conjuntos de dados observados é chamado ajustamento de curvas, ou simplesmente

ajustamento. Na prática, frequentemente o próprio diagrama de dispersão sugere o tipo de

curva a ser adotado. Para a Figura 9-1, poderíamos usar uma linha reta :

Y= a + bx

Enquanto que, para a fig, 9-2, tentaríamos uma parábola, ou uma curva quadrática

Y= a + bx + cx2

Algumas vezes ajuda a montar o diagrama, em termos de variáveis transformadas. Por

exemplo, se log y VS. log x trata uma linha reta, nós poderíamos testar log y= a +bx como uma

equação que se aproxima da curva.

Regressão

Um dos principais objetivos do ajustamento é estimar uma das variáveis ( variável

dependente) em função da outra ( Variavel independente). Processo esse designado regressão.

Se y deve ser estimado em função de x por meio de uma equação, equação essa denominada

equação de regressão de y sobre x e a curva correspondente é a curva de regressão de y sobre

x.

O método dos mínimos quadrados

Geralmente, mais de uma curva é ajustada a determinado conjunto de dados.

Para evitar critérios individuais na escolha de retas, parábolas, etc..., é necessário

chegar-se a um acordo quanto ao que se deve entender por “ melhor reta”, “ melhor

parábola ”.

A fim de evitar uma possível definição, consideramos a fig 9-4, em que os

pontos dados são ( x1, y1),........, (x2, y2).

Para determinado valor de x, digamos x1, existira uma diferença ente o valor y1

e o correspondente valor “ajustado”, determinado pela curva C. Denotamos tal

diferença por d1, e chamamos de desvio, erro ou resíduo; seu valor pode ser positivo,

negativo ou zero. Analogamente, para os valores x2,........,xn obtemos os desvios

d2,....., dn.

Uma medida da “aderência ”, ou “validade do ajustamento “ da curva C aos dados do

problema é dada pela quantidade d12 + d22+........dn2. Se esta quantidade é pequena, o

ajustamento é bom; se é grande, o ajustamento é mau. Formulamos , então, a

Definição : De todas as curvas que se aproximam de determinados conjunto de

pontos, a curva que goza da propriedade

d12+ d22+.....+ dn2= mínimo ( é a melhor curva ajustadora)

Uma curva com esta propriedade se ajusta aos dados no sentido dos mínimos

quadrados, e é chamada curva de regressão de mínimos quadrados, ou simplesmente

curva de mínimos quadrados. Temos então reta de mínimo quadrados, parábolas de

mínimos quadrados, etc.

É usual empregar a definição acima quando x é a variável

independente e y é a variável dependente. Se x é variável dependente, modifica-se a

definição, considerando- se desvios horizontais ao invés de verticais; o que equivale a

permutar os eixos x e y. Essas duas definições conduzem em geral a duas curvas de

mínimos quadrados diferentes. A menos que se especifique o contrário,

consideraremos x como variável independente e y como variável dependente.

Você precisar saber

Outra possibilidade consiste em considerar distâncias perpendiculares dos pontos

observados à curva, em lugar de distâncias horizontais ou verticais. Tal processo,

entretanto,não é muito usado.

A reta de mínimos quadrados

Pela definição acima, pode mostrar que a reta de mínimos quadrados que aproxima,

ou ajusta, o conjunto de pontos ( x1, y1),........, (xn,yn) tem por equação:

Y= a + bx

(1)

Onde as constantes a e b são determinadas resolvendo-se o sistema

(2)

Chamado sistema de equações normais para a reta de mínimos quadrados. Note-se

que, para abreviar, usamos

em lugar de

As equações normais ( 2) podem ser facilmente memorizadas notando-se que,

formalmente, a primeira equação se obtém somando-se ambos os membros de (1), enquanto

que a segunda equação se obtém multiplicando-se primeiro ambos os membros de (1) por x e

somando-se em seguida. Obviamente, isto não é uma dedução das equações normais mas

apenas um processo para memorizá-las. Os valores de a e b obtidos (2) são dados por:

(3)

O resultado de b pode escrever-se também:

(4)

O traço superior indica média, isto é,

primeira equação de (2) por n dá:

. A divisão de ambos os membros da

(5)

Assim, se quisermos, podemos primeiro determinar b a partir de (3) e (4) e então usar (5) para

determinar

Isto equivale a escrever a reta de mínimos quadrados como

(6)

O resultado ( 6) mostra que a constante b, que é o coeficiente angular da rela (1), é a

constante fundamental para determinar a reta. De ( 6) vê-se também que a reta de mínimos

quadrados passa pelo ponto

, chamado centróide, ou centro de gravidade dos dados.

O coeficiente angular b da reta de regressão é independente da origem de

coordenadas. Isto significa que, se fizermos a transformação ( translação dos eixos) dada por:

(7)

Onde h e k são constantes quaisquer , então b será tambem dado por:

(8)

Onde x , y foram substituídos por x’, y’( por esse motivo dizemos que b é invariante

sob a transformação (7)). Note-se, todavia, que a ; intercepto da reta sobre o eixo 0x; depende

efetivamente da origem(assim, não é variante).

No caso particular em que

, ( 8) se simplifica para :

(9)

Os resultados (8) ou (9) são úteis para simplificar o trabalho de calculo na

determinação da reta de mínimos quadrados. As observações acima valem também para a

reta de regressão de x sobre y. Formalmente, os resultados se obtêm simplesmente

permutando x e y. Assim, por exemplo, a reta de mínimos quadrados de x sobre y é:

(10)

Note-se porém que, em geral, (10) não é a reta que ( 6).

Lembrança

Você deve tentar encontrar a equação por regressão linear somente se seus dados

tiverem uma relação linear.

Exemplo9.1 A Tabela 9-1 mostra o as respectivas alturas x e y da amostra de 12 pais e

seus respectivos filhos mais velhos. Encontre a regressão dos mínimos quadrados de y em x.

Altura x do Pai (polegadas)

Altura y do Filho (polegadas)

65 63 67 64 68 62 70 66 68 67 69 71

68 66 68 65 69 66 68 65 71 67 68 70

A linha de regressão de y em x é dada por y= ax+b que são obtidas resolvendo as

equações normais:

Os dados são computados como seguem abaixo:

Usando esses dados, a equação normal é encontrada:

Para tanto econtramos a=35.82 e b=0,476, então y=35,82+0,476x é a equação de

regressão linear.

A Reta de Mínimos quadrados em termos da

variância e covariância amostrais

As variâncias e covariâncias amostrais de x e y são dadas por

(11)

Em função dessas expressões, as retas de regressão de mínimos quadrados de y sobre x

e de x sobre y podem escrever-se respectivamente como:

e

(13)

(12)

Se definirmos formalmente o coeficiente de correlação amostral por

então (12) pode escrever-se :

(14)

Em razão do fato de

serem valores amostrais

padronizados ou escores padronizados, os resultados (14) proporcionam um modo muito

simples de memorizar as retas de regressão. È claro que as duas retas em ( 14) são distintas, a

menos que r= +- 1, quando então todos os pontos amostrais se encontram sobre um reta,

havendo assim correlação e regressão linear perfeitas.

É necessário notar também que, se as duas retas de regressão ( 14), se escrevem

como

respectivamente , então :

( 15)

Até agora não levamos em conta a significação precisa do coeficiente de correlação;

definimo-lo apenas formalmente em termos das variâncias e da covariância.

Erro de Padrão Estimado

Seja yest o valor estimado de y, correspondente a determinado valor de x, e obtido da

curva de regressão de y sobre x; então uma medida da dispersão em torno da curva de

regressão é dada por:

(16)

Que se chama erro padrão da estimativa de y sobre x. Como

,

Vemos que, de todas as possíveis curvas de regressão, a curva de mínimos quadrados é

a que apresenta menor erro padrão de estimativa. No caso de uma reta de regressão

, como a e b dados por (2), temos :

(17)

Ou

(18)

Podemos também exprimir

para a reta de mínimos quadrados em termos da

variância e do coeficiente de correlação como:

(19)

Donde, incidentalmente, decorre, como corolário, que

i.e.,

O erro padrão da estimativa goza de propriedades análogas às do desvio

padrão. Por exemplo, se construirmos pares de retas paralelas à reta de regressão de y sobre x,

às distancias de Sx.y, 2Sx.y e 3 Sx.y respectivamente, encontramos, para n suficientemente

grande, cerca de 68%, 95%, 99,7%, respectivamente, dos pontos amostrais compreendidos

entre pares de retas.

Assim como existe um estimador não-tendencioso da variância amostral, dado

por

existe também um estimador não tendencioso do quadrado do erro

padrão da estimativa. Este estimador é dado por

Por esta razão,

alguns estatísticos preferem tomar ( 16) com n-2 em lugar de n no denominador.

As observações acima modificam-se facilmente para a reta de regressão de x sobre

y ( quando então o erro padrão da estimativa se denota por S x,y) ou para regressão não-linear

ou múltipla.

O coeficiente de correlação linear

Até agora definimos formalmente o coeficiente de correlação mediante (13), mas

não examinamos sua significação. Para tal, notemos que, de (19) e das definições de Sy.x e Sy

temos:

(20)

Podemos agora mostrar que :

(21)

A quantidade a esquerda de ( 21) é chamada de variação total. O primeiro somatório à

direita de (21) é a variação não- explicativa, e o segundo somatório é a variação explicada.

Esta terminologia decorre do fato de que os desvios y- yest se comportam de maneira aleatória

ou imprevisível, enquanto que os desvios

são explicados pela reta de regressão de

mínimos quadrados e tendem, assim, a seguir um padrão definido. Decorre (20) e (21) que:

( 22)

Obs: O numerador é chamado de variação explicada e o denominador de variação

total.

Assim, r2 poded ser interpretado como fração da vaiação total que é explicada pela

reta de regressão de minimos quadrados. Em outras palavras, r mede quão bem a reta de

regressão de minimos quadrados se ajusta aos dados amostrais. Se a variação total é toda

explicada pela reta de regressão, isto é, se r2=1 ou r=+- , dizemos que há correlação linear

perfeita. Por outro lado, se a variação explicada é zero, isto é, se a variação total é toda ela

não- explicada, r=0. Na prática, a quantidade r2, por vezes denominada coeficiente de

determinação, situa-se entre 0 e 1.

O coeficiente de correlação pode ser calculado a partir de um dos dois resultados:

(23)

ou

(24)

Os quais, para regressão linear, são equivalentes. A formula (23) costuma chamar-se

formula do momento- produto para correlação linear.

(25)

e

(26)

Utilizando a transformação (7):

(27)

O que mostra que r é invariante por translação de eixo. Em particular se h=,

k=

, (27) se escreve:

(28)

Fórmula que costuma ser bastante útil nos calculos.

O coeficiente de correlação linear pode ser positivo ou negativo. Se r é positivo, y

tende aumentar com x( o coeficiente angular da reta de mínimos quadrados é positivo)

enquanto que se r é negativo, y tende a decrescer quando x cresce ( o coeficiente angular é

negativo). O sinal é automaticamente levado em conta se ussarmos o resultado ( 23), (25),

(26), (27) 2 (28). Contudo, ao utilizarmos (24) para obter r, devemos aplicar o sinal conveniente.

Coeficiente de correlação Generalizado

A definição (23) ( ou de suas formas equivalentes (35) a (28)) do coeficiente de

correlação envolve somente valores amostrais x, y. Consequentemente, dá o mesmo número

para todas as formas de curvas de regressão e é inoperante como medida de aderência de

ajustamento, exceto no caso da regressão linear, quando coincide com(24). Contudo, a ultima

definição, ou seja:

(29)

Obs: O numerador é chamado de variação explicada e o denominador variação total.

Reflete efetivamente a forma da curva de regressão (através de y est)e é, assim,

adequadra como definição de um coeficiente de correlação generelizada r. Utilizamos (29) para

obter coeficientes de correlação não-linear( que medem quão bem uma curva de regressão

não-linear se ajusta aos dados) ou, mediante generelização apropriada, coeficientes de

correlação multipla. A relação ( 19) entre o coeficiente de correlação e o erro padrão da

estimativa vale também para correlação não-linear.

Exemplo 9.2 Econtre o coeficiente de determinação e o coeficiente de correlação do

Exemplo 8.2

Relembre que a correlação de determinação é r2

Variação explicada

--------------------------Variação Total

O coeficiente de correlação é r.

Desde que y est aumenta quando x aumenta, a correlação é positiva,e podemos escrever

escrever r= 0.7027, ou r= 0.70 para duas significâncias figuradas.

Como coeficiente de correlação mede simplesmente quão bem determinada curva de

regressão ( ou superfície) se ajusta aos dados amostrais, não tem tem sentido utilizarmos um

coeficiente de correlação linear quando os dados não são lineares. Suponha-se, Contudo, que

apliquemos (23) a dados não lineares e obtenhamos um valor numérico consideravelmente

inferior a 1. Então a conclusão a ser tirada não é que exista pequena correlação, e sim que

existe pequena correlação linear. Na verdade, pode haver até uma grande correlação não

linear.

Correlação e Dependência

Sempre que duas variáveis aleatórias X e Y têm coeficientes de correlação diferente de

zero, sabemos que elas são dependentes no sentido probabilístico. Além disso, quando p≠ 0,

podemos utilizar uma equação da forma(6) para predizer o valor de Y a partir de X.

Você precisa saber

É Importante notar que correlação e dependência no sentido acima não implicam

necessariamente causal direta de X e Y. Os exemplos que seguem ilustram este fato.

Exxemplo 9.3