JDSS-LAC/INPE

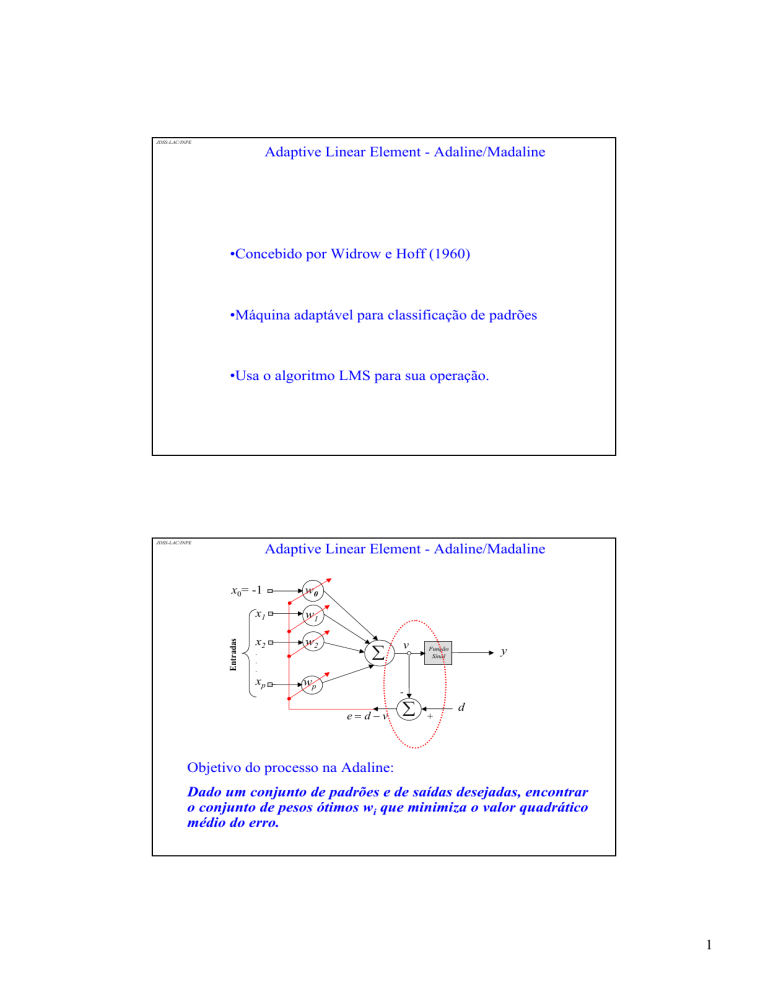

Adaptive Linear Element - Adaline/Madaline

•Concebido por Widrow e Hoff (1960)

•Máquina adaptável para classificação de padrões

•Usa o algoritmo LMS para sua operação.

JDSS-LAC/INPE

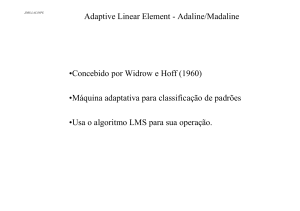

Adaptive Linear Element - Adaline/Madaline

w0

x1

w1

x2

w2

Entradas

x0= -1

¦

.

.

.

xp

wp

v

y

Função

Sinal

-

e

d v

¦

+

d

Objetivo do processo na Adaline:

Dado um conjunto de padrões e de saídas desejadas, encontrar

o conjunto de pesos ótimos wi que minimiza o valor quadrático

médio do erro.

1

JDSS-LAC/INPE

LMS - Regra Delta - Regra de Aprendizagem de Widrow-Hoff

(Lin e Lee, 1996)

Dado: ^( x (1), d (1)), ( x ( 2), d ( 2)),/ , ( x ( p ), d ( p ))`

Função Custo:

H ( n)

Linearmente

separáveis

p

·

1§

¨ d ( n) ¦ w j (n) x j (n) ¸

¸

2 ¨©

j 0

¹

w j (n 1)

2

w j ( n ) 'w j ( n )

JDSS-LAC/INPE

LMS - Regra Delta - Regra de Aprendizagem de Widrow-Hoff

(Lin e Lee, 1996)

Gradiente Descendente

w j (n 1)

'w j ( n )

w j ( n ) 'w j ( n )

'w j (n)

K

wH (n)

ww j (n)

p

·

§

K ¨¨ d ( n ) ¦ w j ( n ) x j ( n ) ¸¸ x j ( n ) j 0

¹

©

p

§

·

¨

K ¨ d ( n ) ¦ w j ( n ) x j ( n ) ¸¸ x j ( n )

j 0

©

¹

2

JDSS-LAC/INPE

Exemplo 1:

Padrões

Pesos e Limiar iniciais

ª 1 1º

« 1 1»

«

»

«¬ 1 1»¼

P

d

> 1

1@

Parâmetros

K 0.2

ª0.7266º

«0.8353»

«

»

«¬0.0972»¼

w

0.3662

b

S oma dos e rros qua drá ticos

0.2

Erro _ alvo 0.01

Max _ epoca 200

0.18

0.16

0.14

0.12

JDSS-LAC/INPE

Fonte de

Informação

Erro

Pesos Finais

ª0.6415º

w ««0.9860»»

«¬0.1823»¼

b 0.4513

0.1

0.08

0.06

0.04

0.02

0

1

1.5

2.5

3

Cancelamento de Ruído (Filtro Adaptativo)

Sinal de

Informação

+

+

Sinal de

Interferência

filtrado

Filtro

Interferência

p

Sinal de

Informação

Restaurado

Sinal de Informação

Contaminado +

x

Fonte de

Interferência

2

e poca s

w1

¦

Sinal

de Erro

y

w0

-1

Entrada

da Adaline

Saída da

Adaline

Adaptado de Hagan et ali., 1996

Capítulo 10, pp. 10-15

3

JDSS-LAC/INPE

JDSS-LAC/INPE

4

JDSS-LAC/INPE

Madaline

W1

Camada

de entrada

x1

1

x2

2

x3

3

W2

Camada

de Saída

y1

y2

MRI (Widrow e Hoff, 1960): W1 ajustáveis e W2 fixos

MRII (Widrow, Winter e Baxter, 1987): W1 e W2 ajustáveis

Fonte: Fausett, 1994

JDSS-LAC/INPE

Algoritmo - LMS

Algoritmo LMS - bloco processamento adaptável de sinais

baseado no uso das estimativas instantâneas da autocorrelação e

da correlação cruzada das entradas.

•Simplicidade de Implementação

•Habilidade de operação em ambiente desconhecido

•Habilidade para acompanhar no tempo as variações nas

estatísticas das entradas

5

JDSS-LAC/INPE

LMS - Inspiração na teoria de filtragem adaptativa

Entradas

produzidas

pelos

sensores

x1

w1

x2

w2

¦

.

.

.

xp

p

y

wp

Relação

entre a

entrada e a

saída

¦w x

k

k

k 1

Pesos

Filtro Espacial

Problema: Encontrar os pesos ótimos que minimizam o erro

quadrático

e dy

J

> @

1

E e2

2

d - saída desejada ou alvo

Solução: Uso das equações de Wiener-Hopf

JDSS-LAC/INPE

Problema da Filtragem Linear Ótima

•Performance ou função custo - Erro Quadrático Médio

J

> @

1

E e2

2

•Determinar os pesos ótimos que minimizem J

•Solução: Filtro de Wiener

J

> @

1

E e2

2

>

1

E (d y) 2

2

@

>

1

E d 2 2dy y 2

2

@

6

JDSS-LAC/INPE

Problema da Filtragem Linear Ótima

> @

>

1

E (d y) 2

2

@

>

J

1

E e2

2

J

1

1

1

E d 2 E>2dy @ E y 2

2

2

2

> @

1

E d 2 2dy y 2

2

@

> @

> @

> @

1

1

E d 2 E>dy @ E y 2

2

2

º

ª p

º 1 ª p p

1

E d 2 E «¦ wk xk d » E «¦¦ w j wk x j xk »

2

¬k 1

¼ 2 ¬j 1 k

¼

> @

JDSS-LAC/INPE

> @

>

p

1

1 p p

E d 2 ¦ wk E> xk d @ ¦¦ w j wk E x j xk

2

2 j1 k

k 1

J

@

•Valor quadrático médio da resposta desejada

rd

E[d 2 ]

•Correlação cruzada entre a entrada e a saída desejada

rdx (k )

E > xk d @,

k 1,2,..., p

•Autocorrelação entre as entradas

rx ( j , k )

J

E[ x j xk ],

j, k

1,2,..., p

p

1

1 p p

rd ¦ wk rdx (k ) ¦¦ w j wk rx ( j , k )

2

2 j1 k

k 1

7

JDSS-LAC/INPE

Gráfico de J

w1,w2,...,wp ==> Superfície de erro do filtro

X

•Forma de tigela (parabolóide) com um mínimo global bem

definido => o filtro é ótimo no sentido de que o erro

quadrático atinge o valor mínimo Jmin

Solução:

wJ

,

wwk

wk J

<=

Gradiente

da

superfície em relação

ao peso

k 1,2,..., p

JDSS-LAC/INPE

wk J

p

rdx (k ) ¦ w j rx ( j , k )

0

<= Condição ótima do filtro

j 1

p

¦ w r ( j, k )

rdx (k ),

j x

k 1,2,..., p

j 1

• wok - conjunto de pesos ótimos:

p

¦w

r ( j, k )

oj x

rdx (k ),

k 1,2,..., p

j 1

•Sistema de equações de Wiener-Hopf.

•Filtro de Wiener satisfaz estas equações.

8

JDSS-LAC/INPE

Método do Gradiente Descendente

Solução para o sistema de equações de Wiener-Hopf:

•É um conjunto de pesos ótimos para o filtro espacial.

•Necessita do cálculo da inversa de uma matriz p x p dos valores

da função de autocorrelação rx(j,k), j,k = 1,2,...,p

•Método do Gradiente Descendente evita o cálculo

•Procura iterativa pelo o ponto de mínimo da superfície de erro

•Os ajustes dos pesos acontece na direção do passo descendente

da superfície de erro, ou seja, em direção oposta ao vetor gradiente

JDSS-LAC/INPE

Método do Gradiente Descendente

J

wk J

p

rdx ( k ) ¦ w j rx ( j , k )

j 1

wJ

ww

'w K

Jmin

0

wo

w(n)

wJ

ww

w

w(n+1)

Adaptação de Haykin, 1994, p. 124

9

JDSS-LAC/INPE

Método do Gradiente Descendente

wk J ( n)

p

rdx ( k ) ¦ w j ( n) rx ( j , k )

Diferente sensores

no espaço

j 1

'w(n)

w(n 1)

K wk J (n)

k 1,2,..., p

w(n) K wk J (n)

Método da descida íngrime:

“O valor atualizado do k-ésimo peso de um filtro de Wiener

(projetado para operar no sentido do erro quadrático médio

mínimo) é o valor do peso atual mais um correção proporcional ao

negativo do gradiente da superfície de erro em relação ao peso

particular.”

JDSS-LAC/INPE

Método do Gradiente Descendente

wk J ( n)

p

rdx ( k ) ¦ w j ( n) rx ( j , k )

j 1

w(n 1)

p

·

§

w(n) K ¨¨ rdx (k ) ¦ w j (n)rx ( j , k ) ¸¸

j 1

¹

©

p

·

§

w(n) K ¨¨ rdx (k ) ¦ w j (n)rx ( j , k ) ¸¸

j 1

¹

©

Método exato - não há aproximações

10

Deficiências (Haykin, 1994)

•Análise difícil pela presença de não linearidade

•Visualização difícil do processo de aprendizagem devido as

camadas internas.

LMS

Usa estimativas instantâneas da função de autocorrelação

rˆx ( j , k ; n)

x j ( n ) xk ( n )

e da função de correlação cruzada.

rˆdx (k ; n)

xk (n)d (n)

11

LMS

wˆ (n 1)

p

·

§

wˆ (n) K ¨¨ xk (n)d (n) ¦ wˆ j (n) x j (n) xk (n) ¸¸

j 1

¹

©

p

·

§

wˆ (n) K ¨¨ d (n) ¦ wˆ j (n) x j (n) ¸¸ xk (n)

j 1

¹

©

wˆ (n) K >d (n) y (n)@xk (n) , k 1,2,..., p

Resumo do algoritmo LMS

•

Inicialização.

wˆ k (1) 0,

•

k 1,2,..., p

Filtragem.

p

y ( n)

¦ wˆ (n) x (n)

j

j

j 1

e( n )

d ( n ) y ( n)

wˆ k (n 1)

wk (n) Ke(n) xk (n),

k 1,2,..., p

12

Considerações

•Método do gradiente descendente (para um ambiente

conhecido):

•Partindo de uma configuração inicial, o vetor de pesos

segue

uma

trajetória

definida

precisamente

e

eventualmente atinge uma solução ótima.

Considerações

•LMS (para um ambiente desconhecido):

Estimativa inicial do vetor de pesos segue uma trajetória

aleatória.

•LMS:

•conhecido como um algoritmo de gradiente estocástico

•se o número de alterações tende a infinito, o vetor de

peso faz uma busca aleatória (random walk) sobre a

superfície de erro.

13