U NIVERSIDADE F EDERAL DE G OIÁS

I NSTITUTO DE I NFORMÁTICA

M ARIANA S OLLER R AMADA

Um Método de Análise Semântica de

Consultas com Palavras-chave para

acesso a Informações Armazenadas em

Múltiplos Bancos de Dados

Goiânia

2013

M ARIANA S OLLER R AMADA

Um Método de Análise Semântica de

Consultas com Palavras-chave para

acesso a Informações Armazenadas em

Múltiplos Bancos de Dados

Dissertação apresentada ao Programa de Pós–Graduação do

Instituto de Informática da Universidade Federal de Goiás,

como requisito parcial para obtenção do título de Mestre em

Mestrado em Ciência da Computação.

Área de concentração: Banco de Dados.

Orientador: Prof. Dr. João Carlos da Silva

Goiânia

2013

M ARIANA S OLLER R AMADA

Um Método de Análise Semântica de

Consultas com Palavras-chave para

acesso a Informações Armazenadas em

Múltiplos Bancos de Dados

Dissertação defendida no Programa de Pós–Graduação do Instituto de

Informática da Universidade Federal de Goiás como requisito parcial

para obtenção do título de Mestre em Mestrado em Ciência da Computação, aprovada em 26 de Fevereiro de 2013, pela Banca Examinadora

constituída pelos professores:

Prof. Dr. João Carlos da Silva

Instituto de Informática – UFG

Presidente da Banca

Prof. Dr. Thierson Couto Rosa

Instituto de Informática – UFG

Profa. Dra. Mirella Moura Moro

Departamento de Ciência da Computação – UFMG

Todos os direitos reservados. É proibida a reprodução total ou parcial do

trabalho sem autorização da universidade, do autor e do orientador(a).

Mariana Soller Ramada

Graduou-se em Ciência da Computação na UFG - Universidade Federal de

Goiás. Durante sua graduação, foi estagiária do Centro de Recurso Computacionais (Cercomp) da UFG. Durante o Mestrado, foi bolsista REUNI e monitora no Instituto de Informática na disciplina Banco de Dados do curso de

Ciência da Computação. Atualmente é Analista de Tecnologia da Informação

do Instituto de Informática da Universidade Federal de Goiás.

Aos meus pais

Agradecimentos

Primeiramente, agradeço ao meu pai e minha mãe que acreditaram e investiram

em mim, dando todo o suporte e educação e não medindo esforços para que eu chegasse

onde estou agora. Ao meu irmão Marcelo que é um exemplo de pessoa e aluno, e um

dos principais motivos pelo qual eu decidi fazer o mestrado. Agradeço ao meu namorado

Murilo, pelo carinho, dedicação, paciência, incentivo e principalmente por sua capacidade

de me trazer paz na correria de cada semestre.

Agradeço também ao professor Dr. João Carlos que desempenhou um papel

imensamente importante em minha vida acadêmica, desde a graduação quando lecionou a

matéria de Banco de Dados, descobrindo então minha paixão pela área, até a monografia

de conclusão do curso sob sua orientação. Agradeço principalmente pela insistência a qual

me levou a fazer o mestrado e pela confiança em mim depositada. Agradeço também pela

disponibilidade, pela paciência, pelas correções, pelos seus conhecimentos repassados

durante todo o desenvolvimento deste trabalho e pela oportunidade de ser monitora da

disciplina de Banco de Dados, a qual me proporcionou grande satisfação e aprendizagem.

Ao professor Dr. Plínio que foi imprescindível para este trabalho. Sempre disposto a me atender, mesmo sem marcar horário, e gastava horas de seus dias discutindo

as próximas tarefas a serem feitas durante a implementação, sanando dúvidas e levantando novas ideias que agregaram muito valor a este trabalho. Obrigada pelas reuniões

esclarecedoras e principalmente motivadoras, e também pela preocupação, afinal como

você mesmo dizia: “Você não se preocupa porque já tem gente se preocupando por você

né?”. Obrigada também pela correção do texto, pelas sugestões, melhorias, pelo tempo

dedicado e pela boa vontade de me ajudar a concluir esse trabalho.

Aos colegas de trabalho que muitas vezes deixaram de lado seus afazeres e me

ajudaram durante o desenvolvimento deste trabalho. Em especial ao Danillo, pela ajuda

na implementação, com algumas dicas e melhorias; e ao Afonso, pela ajuda na escrita do

texto.

Aos colegas do curso pela convivência, estudo, alegrias, tristezas e dores compartilhadas. Em especial ao Alison que sempre esteve acompanhando meu trabalho, sugerindo ideias, discutindo problemas e soluções; a Elisabete que sempre foi solicita respondendo meus e-mails, enviando-me seu material e sanando minhas inúmeras dúvidas; e ao

Adriano, Roussian, Douglas e Lucas, com vocês as pausas entre um parágrafo e outro de

produção se tornaram mais prazerosas e proveitosas.

Aos meus amigos e familiares que apesar da distância estiveram torcendo e

apoiando.

Ao REUNI pelo apoio financeiro.

E por fim, a todos que direta ou indiretamente me ajudaram a concretizar mais

esta etapa da minha vida.

“Você nunca sabe que resultados virão da sua ação. Mas se você não fizer

nada, não existirão resultados.”

Mahatma Gandhi

Resumo

Ramada, Mariana Soller. Um Método de Análise Semântica de Consultas

com Palavras-chave para acesso a Informações Armazenadas em Múltiplos

Bancos de Dados. Goiânia, 2013. 107p. Dissertação de Mestrado. Instituto de

Informática, Universidade Federal de Goiás.

A Web representa o principal canal de circulação de informações na sociedade atual.

Essas informações estão dispersas nos mais diversos meios de armazenamento, fazendose necessário uma interface de recuperação. A técnica de consulta com palavras-chave,

por ser simples e eficaz, mostrou-se ideal para este tipo de necessidade e tornou-se então

o padrão de interação entre o usuário e a Web.

Contudo, a maioria das informações da Web encontra-se armazenada em bancos de dados

relacionais, e tais repósitorios oferecem suporte limitado para a pesquisa com palavraschave. Para se realizar consultas em banco de dados relacionais é necessário o conhecimento das estruturas de armazenamento e da sintaxe de uma linguagem estruturada,

conhecimentos os quais não são familiares para a maioria dos usuários comuns.

Neste sentido, o propósito deste trabalho é apresentar um método para realizar consultas

com palavras-chave em banco de dados relacionais, a fim de eliminar a necessidade deste

conhecimento prévio e permitir uma recuperação simplificada dos dados dos múltiplos

bancos de dados disponíveis na Web.

Palavras–chave

Consulta com palavras-chave, Banco de dados relacionais, Semântica

Abstract

Ramada, Mariana Soller. An Analysis Semantic Method of Keyword Queries

over Multiple Databases. Goiânia, 2013. 107p. MSc. Dissertation. Instituto de

Informática, Universidade Federal de Goiás.

Information flows mainly through the Web in the present society. This information

is scattered and stored in different data storages, which requires an access interface

to retrieve it. Keyword query proved to be a simple and effective way to access the

information, becoming the standard user-Web interaction.

However, most Web information is stored in relational databases, and such repositories

offer limited support for keyword queries. To perform queries in relational databases is

necessary to know the data schema and the syntax of a structured query language, which

are not familiar to most of ordinary users.

In this sense, the purpose of this paper is to present a method for performing keyword

queries in relational databases in order to eliminate the need of this prior knowledge, and

enable a simplified recovery of data from multiple databases available on the Web.

Keywords

Keyword query, Relational database, Semantics.

Sumário

Lista de Figuras

12

Lista de Tabelas

13

Lista de Algoritmos

15

Lista de Códigos de Programas

16

1

17

17

18

20

21

Introdução

1.1

1.2

1.3

1.4

Contexto e Motivação

Objetivos

Principais Problemas

Organização do Texto

2

Trabalhos Relacionados

22

3

Contexto e Arquitetura para o Método Proposto

26

26

30

31

32

33

34

34

35

36

37

38

38

3.1

3.2

Contexto

Arquitetura

3.2.1

Pré-processamento

Verificação de Função Agregada/Ordenação/Valores Compostos

Expansão da consulta

3.2.2

Processamento da consulta

Identificação dos bancos de dados relevantes

Ranking dos bancos de dados relevantes

Mapeamento

Execução

Ranking dos resultados

3.3

4

Considerações Finais

Análise Semântica da Consulta

4.1

4.2

Definição do problema

Análise Semântica segundo a Keymantic

4.2.1

Cálculo dos pesos intrínsecos (Passo 1)

Cálculo dos pesos intrínsecos dos termos de esquema do banco de dados

Cálculo dos pesos intrínsecos dos termos de valor do banco de dados

4.2.2

Seleção dos Melhores Mapeamentos para os termos de esquema (Passo 2)

Processo de Seleção dos Melhores Mapeamentos

39

39

41

43

44

44

46

47

4.2.3

Contextualização de VW e Seleção dos Melhores Mapeamentos para os

termos de valor (Passo 3)

Regras e Processo de Contextualização

4.3

5

Geração das Configurações (Passo 4)

4.2.5

Geração das Interpretações (Passo 5)

Consideração Finais

Contribuições à Analise Semântica

5.1

5.2

5.3

6

4.2.4

Limitações da Keymantic

Modificações à abordagem da Keymantic

Considerações Finais

Aplicação do Método Proposto

6.1

6.2

Estudos de Caso

6.1.1

Estudo de Caso - Funções Agregadas e Ordenação

6.1.2

Estudo de Caso - Valores Compostos

Comparação com a Keymantic

6.2.1

6.2.2

Suposições à implementação Keymantic

Exemplo selecionado para Comparação

Cálculo dos pesos intrínsecos (Passo 1)

Seleção dos Melhores Mapeamentos para os termos de esquema (Passo 2)

49

51

54

54

55

56

56

57

64

66

66

67

77

82

82

83

84

85

Contextualização de VW e Seleção dos Melhores Mapeamentos para os

termos de valor (Passo 3)

Geração das Configurações (Passo 4)

Geração das Interpretações (Passo 5)

Impacto das Modificações Internas à Keymantic

Ranking dos resultados

6.3

7

Considerações Finais

Conclusão

7.1

7.2

7.3

Contribuições

Trabalhos Futuros

Produção Bibliográfica

Referências Bibliográficas

87

88

89

89

91

93

94

94

96

97

98

A

Estrutura da Tabela de Metadados para Exposição (TME)

102

B

Banco de dados COMPANY

103

103

104

105

106

B.1

B.2

B.3

B.4

Requisitos de Dados em Forma Textual

Esquema Conceitual

Esquema Lógico

Esquema Físico

Lista de Figuras

3.1

3.2

Arquitetura do método proposto (inspirado em [28])

Banco de dados COMPANY (retirado de [8])

(a)

(b)

Esquema lógico do banco de dados COMPANY com suas restrições

de integridade referencial.

Fração dos dados do banco de dados COMPANY.

30

31

31

31

4.1

Mapeamento das palavras-chave (retirado de [3])

42

5.1

Processo de Mapeamento com as etapas modificadas em destaque

58

Número de configurações e interpretações geradas por ambos os sitemas

90

90

90

91

91

91

92

6.1

(a)

(b)

6.2

Número de configurações geradas por ambos os sistemas

Número interpretações geradas por ambos os sistemas

Métrica de precisão para ambos os sistemas

(a)

(b)

6.3

Gráfico MRR-Tamanho da consulta (inspirado em [10])

B.1

Diagrama de esquema ER para o banco de dados COMPANY (retirado

de [8])

Esquema lógico do banco de dados COMPANY (retirado de [8])

B.2

104

106

Lista de Tabelas

3.1

3.2

4.1

4.2

4.3

4.4

4.5

4.6

4.7

5.1

5.2

5.3

5.4

6.1

6.2

6.3

6.4

6.5

6.6

6.7

6.8

6.9

6.10

6.11

6.12

6.13

6.14

6.15

6.16

Atributos da Tabela de Metadados para Exposição (TME) [20]

Informações da Tabela de Metadados para Exposição(TME) do banco de

dados COMPANY (inspirado em [20])

28

35

Matriz de peso com a submatrizes SW (claro) e VW (escuro) (retirado de

[4])

Pesos intrínsecos da Submatriz SW (inspirado em [4])

Pesos intrínsecos da Submatriz VW (inspirado em [4])

Mapeamento para a consulta “employees dependent relationship”

Primeira matriz gerada a partir do mapeamento da Tabela 4.4

Segunda matriz gerada a partir do mapeamento da Tabela 4.4

Terceira matriz gerada a partir do mapeamento da Tabela 4.4

43

44

46

47

49

49

49

Mapeamento onde todas as palavras-chave são mapeadas para termos

de esquema

Mapeamento parcial das palavras-chave para termos de esquema

Mapeamento parcial das palavras-chave para termos de valor

Mapeamento considerando a proximidade entre as palavras-chave

61

62

62

64

Pesos intrínsecos da Submatriz SW (consulta “quantity employees for

each department order by name”)

Pesos intrínsecos da Submatriz VW (consulta “quantity employees for

each department order by name”)

Mapeamento da consulta “quantity employees for each department order

by name”

Primeiro mapeamento gerado a partir do mapeamento da Tabela 6.3

Segundo mapeamento gerado a partir do mapeamento da Tabela 6.3

Terceiro mapeamento gerado a partir do mapeamento da Tabela 6.3

Primeiro mapeamento gerado a partir do mapeamento da Tabela 6.6

Segundo mapeamento gerado a partir do mapeamento da Tabela 6.6

Terceiro mapeamento gerado a partir do mapeamento da Tabela 6.6

Mapeamento gerado a partir do mapeamento da Tabela 6.9

Mapeamento da consulta “quantity employees for each department order

by department”

Pesos intrínsecos da Submatriz SW (consulta “ employees ‘Houston Tx’ ”)

Pesos intrínsecos da Submatriz VW (consulta “ employees ‘Houston Tx’ ”)

Mapeamento da consulta “employees ‘Houston Tx”’

Submatriz VW contextualizada com base no mapeamento da Tabela 6.14

Mapeamento para termos de valor (consulta “employees ‘Houston TX”’)

69

69

69

70

70

70

70

70

71

71

73

78

78

78

79

79

6.17

6.18

6.19

6.20

6.21

6.22

6.23

6.24

6.25

6.26

6.27

6.28

6.29

6.30

Mapeamento gerado a partir do mapeamento da Tabela 6.16

Mapeamento gerado após negativar os pesos iguais à 75

Pesos intrínsecos da Submatriz SW calculados pelo MP

Pesos intrínsecos da Submatriz SW calculados pela Keymantic

Pesos intrínsecos da Submatriz VW calculados pelo MP

Pesos intrínsecos da Submatriz VW calculados pela Keymantic

Mapeamento gerado pelo MP

Mapeamento gerado pela Keymantic

Mapeamento gerado a partir do mapeamento da Tabela 6.24 (Keymantic)

Submatriz VW contextualizada com base no mapeamento da Tabela 6.23

(MP)

Submatriz VW contextualizada com base no mapeamento da Tabela 6.24

(Keymantic)

Submatriz VW contextualizada com base no mapeamento da Tabela 6.25

(Keymantic)

Conjunto de consultas com palavras-chave

Mapeamento a partir do qual são gerados mapeamentos que não estão

de acordo com a ordem decrescente de pontuação

79

80

84

84

85

85

85

86

86

87

87

87

90

92

Lista de Algoritmos

4.1

4.2

4.3

5.1

Intrinsic SW Matrix Computation (retirado de [4])

Keyword to db term mapping selection (retirado de [4])

Contextualizing ValueWeight Sub-MatrixVW(retirado de [4])

Modificação do Algoritmo 4.1

45

49

53

59

Lista de Códigos de Programas

6.1

Código da primeira configuração para a consulta “quantity employees for

each department order by department”

6.2 Código SQL da segunda configuração para a consulta “quantity employees for each department order by department”

6.3 Código SQL da quarta configuração para a consulta “quantity employees

for each department order by department”

6.4 Código SQL gerado para consulta “ employees ‘Houston Tx’ ”

A.1 Código SQL para a criação da Tabela de Metadados para Exposição

(TME) [20]

B.1 Esquema físico do banco de dados COMPANY

74

75

76

81

102

107

CAPÍTULO 1

Introdução

Este capítulo introdutório apresenta o problema a ser tratado neste trabalho,

elucidando a solução que será proposta e os desafios a serem superados. Na Seção 1.1

são apresentados o contexto e a motivação que deram origem a este trabalho, seguidos

dos objetivos traçados na Seção 1.2 e as principais dificuldades a serem solucionadas na

Seção 1.3. E por fim, a Seção 1.4 descreve a organização do restante deste trabalho.

1.1

Contexto e Motivação

A Internet representa o principal meio de comunicação existente na atualidade,

uma vez que possibilita a rápida difusão do conhecimento gerado. A informação, uma vez

produzida, circula instantaneamente e se torna disponível em qualquer parte do mundo.

A rede mundial de computadores é uma maneira muito eficiente de se ter acesso

a uma grande quantidade de informações de forma simultânea, transpondo barreiras

geográficas e temporais, e possibilitando a troca de dados, informações, decisões e

conhecimento de uma maneira surpreendentemente ágil. A quantidade de informações

disponíveis no universo online está além da capacidade que uma pessoa poderia assimilar

durante uma vida inteira.

As informações estão dispersas nos mais diversos meios de armazenamento e o

usuário normalmente não sabe como e onde encontrá-las. Neste sentido, é necessário uma

interface de recuperação de informação, de modo que o usuário submeta sua necessidade

de informação e o sistema busque pelas fontes que contenham informações relevantes

para a consulta submetida e retorne os resultados encontrados ao usuário.

Uma técnica simples, porém eficaz de buscar e explorar informações, é a técnica

de consulta com palavras-chave. A última década presenciou o emprego cada vez maior

desta tecnologia de pesquisa que tornou-se de fato um padrão para a interação do usuário

com a World Wide Web (WWW). Porém, a técnica não é utilizada de forma generalizada

por todos os meios de armazenamento. Dentre eles, estão os bancos de dados relacionais

que são uma forma importante de armazenamento de dados.

1.2 Objetivos

18

Apesar dos sistemas gerenciadores de banco de dados relacionais (SGDBR’s)

armazenarem a maior quantidade de dados do mundo empresarial, eles fornecem suporte

limitado para pesquisa com palavras-chave e esses dados permanecem então “escondidos”

na Web. De fato, apenas alguns poucos dados da Web podem ser encontrados pelos

motores de busca, uma vez que a maioria dos dados são armazenados em bancos de dados

e são necessárias interfaces de pesquisa especiais para encontrá-los.

Os dados armazenados em bancos de dados formam a Web Invisível. Bergman

[5] constatou em 2001, que a quantidade de informações armazenadas na Web Invisível

era 400 ou 550 vezes maior do que a Web visível. Em 2008, estimou-se que 70 a 75% de

todos os dados da Web estavam armazenados na Web Invisível, ou seja, cerca de um trilhão

de páginas não indexadas pelos motores de busca [33]. O problema da Web Invisível é

causado pela incompatibilidade de interfaces de pesquisa entre os motores de busca e

bancos de dados. Permitir consulta com palavras-chave em bases de dados relacionais

seria um bom começo para a solução deste problema.

Assim, nos últimos anos tem-se empregado um grande esforço em atividades

de pesquisa e desenvolvimento para estender as capacidades de busca com palavraschave para fontes de dados que seguem o paradigma relacional. No entanto, as técnicas

que utilizam palavras-chave para busca na Web não podem ser aplicadas diretamente em

dados armazenados em bancos de dados. Nos bancos de dados relacionais, a informação

é representada através de tabelas de dados, sendo necessário descobrir as estruturas do

banco de dados que contenham as palavras-chave da consulta e explorar como estas

estruturas são conectadas entre si. Isto exige, por parte do usuário, um conhecimento

prévio da estrutura do banco de dados e de uma linguagem estruturada, como a SQL, para

formular uma consulta. Contudo, nem todos os usuários possuem tal conhecimento, o que

se torna uma limitação ao acesso destes dados.

Nesse sentido, o propósito deste trabalho é apresentar um método para solucionar

consultas com palavras-chave em bancos de dados relacionais, a fim de eliminar a

necessidade deste conhecimento prévio e permitir uma recuperação simplificada dos

dados dos múltiplos bancos de dados disponíveis na Web.

1.2

Objetivos

Dado um conjunto de banco de dados disponíveis na Web, o objetivo do presente

trabalho é permitir que a partir de uma consulta com palavras-chave submetida por um

usuário, sejam identificados os bancos de dados relacionais que contêm informações

relevantes para a consulta, e esta seja então submetida a cada banco de dados subjacente

e os resultados por eles retornados sejam exibidos ao usuário.

1.2 Objetivos

19

Como mencionado anteriormente, a técnica de consultas com palavras-chave

é comum no contexto da Web, mas não no contexto de banco de dados relacionais.

Para estes, é necessário converter a consulta com palavras-chave em consultas SQL

correspondentes. Contudo, uma consulta SQL é uma consulta estruturada onde as tabelas,

os atributos e suas condições são precisamente especificadas, enquanto que uma consulta

com palavra-chave é formada por termos indefinidos que expressam a necessidade de

informação do usuário.

Como mencionado anteriormente, um grande esforço tem sido despendido visando estender as capacidades de busca com palavras-chave para bancos de dados relacionais. Contudo, as técnicas existentes possuem algumas limitações.

A primeira limitação é que tais abordagens consideram que toda palavra-chave

desempenha algum papel no banco de dados e cada palavra-chave é mapeada para uma

estrutura do banco de dados correspondente. Considere o esquema de relação Employee

(Fname, Minit, Lname, Ssn, Bdate, Address, Sex, Salary, Superssn, Dno) do exemplo

do banco de dados Company proposto por Elmasri e Navathe [8]. A consulta “higher

salary” espera como resultado uma estatística, o maior salário, e não um conjunto de

tuplas interconectadas que possuam as palavras-chave higher e salary.

A segunda limitação é que a consulta é segmentada de modo que cada palavrachave represente isoladamente um papel no banco de dados. Ainda considerando a

relação Employee, uma possível interpretação para a consulta “employee Houston Tx” é

o funcionário que reside no endereço Houston Tx. Espera-se, então, que as palavras-chave

Houston Tx sejam mapeadas conjuntamente para o atributo Address da tabela Employee,

ao invés de cada uma ser mapeada para uma estrutura do banco de dados isoladamente.

A terceira limitação diz respeito ao fato de muitos trabalhos não considerarem a

interdependência entre as palavras-chave. Apesar do fato de uma consulta ser uma lista

simples de palavras-chave, o significado de cada palavra-chave não é independente do

significado das demais, todos eles representam coletivamente os conceitos pretendidos

que o usuário tinha em mente ao construir a consulta.

A abordagem inerente à ferramenta Keymantic [3] foi escolhida como um ponto

de partida para o propósito deste trabalho, pois ela trata parcialmente a terceira limitação anteriormente discutida, levando em consideração as várias interpretações que uma

consulta pode assumir.

Assim, o presente trabalho tem também como objetivo abordar as limitações

mencionadas acima e agregar semântica a este processo de conversão, a fim de fazer uma

melhor suposição do significado pretendido pela consulta com palavra-chave e construir

consultas SQL que representem as intenções do usuário.

1.3 Principais Problemas

1.3

20

Principais Problemas

Os problemas identificados durante o desenvolvimento deste trabalho dizem

respeito à aplicação de técnicas de consultas com palavras-chave em banco de dados

relacionais, nas quais é necessário um processo de conversão da consulta com palavraschave em consultas SQL correspondentes.

Uma das primeiras dificuldades deste processo de conversão é a decisão sobre

qual papel cada palavra-chave desempenha no contexto da consulta, isto é, se ela é um

valor de um dado, ou uma metainformação que descreve o conceito de outra palavrachave. Por exemplo, na consulta “nome João” a palavra-chave nome descreve o fato da

palavra-chave João ser um nome.

Uma vez descoberto o papel desempenhado por cada palavra-chave, é preciso

descobrir como cada palavra-chave é modelada no banco de dados, ou seja, a palavrachave representa um atributo, uma tabela ou um valor de um atributo? É pertinente

saber também como estas estruturas se relacionam. Em bancos de dados relacionais,

as informações são fragmentadas e representadas como dados. Os dados são então

modelados em forma de tabelas e atributos. Uma informação pode estar espalhada em

mais de uma estrutura do banco de dados, sendo necessário fazer a junção destes dados

de modo a obter a informação pretendida. A junção em banco de dados é realizada

por meio de relacionamentos entre chave primária e chave estrangeira ou por meio do

relacionamento tabela-atributo-valor.

Em adição, uma única palavra-chave pode ser modelada de várias maneiras no

banco de dados subjacente, porém nem todas as maneiras representam a informação

pretendida pelo usuário. Tal fato, se torna mais uma dificuldade a ser solucionada: como

identificar qual estrutura do banco de dados melhor modela ou representa o significado da

palavra-chave pretendida no contexto da consulta?

E se existir mais de um banco de dados com informações úteis para a consulta

com palavras-chave? É necessário mapear a consulta para os termos de cada banco de

dados, considerando o fato de que cada um deles pode possuir um esquema de dados

diferente. Por exemplo, a palavra “carro” poderia ser representada como uma tabela

em um banco de dados, enquanto que em outro poderia ser representada como um

atributo. Desta forma, durante o processo de conversão é necessário considerar esta

heterogeneidade de esquemas, de modo que a partir de uma única consulta com palavraschave seja construída uma série de consultas SQL, cada qual considerando o contéudo do

banco de dados ao qual será submetida.

Outro problema identificado neste trabalho e que se apresenta como uma limitação, se refere ao fato das técnicas de consulta com palavras-chave em banco de dados relacionais dependerem das informações do esquema e/ou dos dados para realizar o processo

1.4 Organização do Texto

21

de conversão. Caso estas informações não sejam disponibilizadas pelo administrador do

banco de dados, não é possível realizar tal processo e consequentemente não é possível

consultar os dados.

1.4

Organização do Texto

Após este capítulo inicial, o presente documento possui outros seis capítulos. O

Capítulo 2 apresenta alguns trabalhos relacionados ao contexto de consulta com palavraschave em bancos de dados relacionais. O Capítulo 3 apresenta uma descrição mais detalhada do problema a ser solucionado neste trabalho, bem como a arquitetura da solução

proposta. A solução proposta se baseia no uso da Keymantic, uma ferramenta já existente

de consulta com palavras-chave em banco de dados relacionais. O Capítulo 4 apresenta tal

ferramenta e detalha seu funcionamento. O Capítulo 5 descreve as adaptações realizadas

nesta ferramenta para compor a solução final. O Capítulo 6 exemplifica o funcionamento

da solução proposta, bem como realiza uma análise comparativa entre a Keymantic e o

método proposto. E por fim, o Capítulo 7 expõe as conclusões e contribuições obtidas

com este trabalho e os possíveis trabalhos futuros.

CAPÍTULO 2

Trabalhos Relacionados

A adaptação de consultas com palavras-chave para extrair informações de bancos

de dados estruturados já atraiu a atenção de vários pesquisadores e há muitas propostas

interessantes na literatura científica. Para identificar tais propostas e verificar o estado da

arte desta área de pesquisa foi realizada uma revisão sistemática [29]. Por meio deste

estudo, foi possível identificar duas principais abordagens para solucionar o problema de

consultas com palavras-chave em banco de dados relacionais: a abordagem baseada em

Candidate Networks e a abordagem baseada em Steiner Trees.

Na abordagem baseada em Candidate Networks, o banco de dados é modelado

como um grafo de esquema Gs (V, E), onde cada relação Ri é representada como um nó

no grafo, e existe uma aresta Ri → R j para cada relacionamento entre chave primária

e chave estrangeira de Ri para R j [16]. Esta abordagem é dividida em duas etapas: a

etapa de geração dos Candidade Networks (CNs) e a etapa de avaliação dos Candidade

Networks. Na etapa de geração dos CNs, são construídos índices sobre o conjunto dos

dados e das palavras-chave da consulta, de modo a identificar diretamente as tuplas

que contém tais palavras-chave. Tais indíces são construídos em uma etapa anterior ao

processamento da consulta. A partir destas tuplas de interesse são gerados os CNs, que

são conjuntos de tuplas que contêm todas as palavras-chave da consulta e são conectados

através de relações entre chave primária e chave estrangeira. Na etapa de avaliação, estes

CNs gerados são convertidos em consultas SQL e estas consultas são, então, executadas

e os resultados apresentados aos usuários.

Na abordagem baseada em Steiner Tree, o banco de dados é modelado como um

grafo de dados Gd (V, E) ponderado, onde cada nó corresponde a uma tupla do banco de

dados e as arestas correspondem às relações entre chave primária e chave estrangeira [22].

Dado um grafo G(V, E) e um conjunto de vértice V 0 ∈ V , uma subárvore T em G é uma

Steiner Tree de V 0 se T cobre todos os vértices em V’ [23]. Assim, nesta abordagem o

problema de consultas com palavras-chave é modelado como o problema de se encontrar

Steiner Trees no grafo de dados, onde V 0 representa o conjunto de palavras-chave da

consulta. Em síntese, esta abordagem retorna subgrafos como resposta, onde os subgrafos

conectam os nós (isto é, tuplas) contendo as palavras-chave da consulta.

23

DBXplorer [2], DISCOVER [17] e BANKS [1] estão entre os primeiros sistemas

de consultas com palavras-chave em banco de dados relacionais. Os dois primeiros

implementam a abordagem baseada em Candidate Networks, enquanto que o último

aplica a abordagem baseada em Steiner Tree.

DBXplorer retorna todas as tuplas que contêm as palavras-chave, tanto de tabelas

individuais como de múltiplas tabelas por meio de junções de chaves estrangeiras. Para

tanto, faz uso de sua própria estrutura de dados, conhecida como Tabela de Símbolos,

para encontrar os respectivos locais em que se encontram as palavras-chave da consulta

no banco de dados.

Durante a etapa de geração dos CNs, DISCOVER produz, sem redundância,

todos os CNs relevantes para a consulta. Além disso, durante a etapa de avaliação dos

CNs, o sistema propõe um algoritmo guloso que cria um plano de execução quase ideal

para avaliar o conjunto de CNs gerados. Contudo, DISCOVER possui duas limitações.

Primeiro, ele não considera soluções que incluem duas tuplas da mesma relação e

segundo, ele considera apenas correspondências exatas, onde uma palavra-chave deve

corresponder exatamente ao valor de um atributo.

O sistema BANKS provê uma rica interface que permite navegar sobre os dados

armazenados em um banco de dados. O sistema gera automaticamente visões navegáveis

sobre as relações do banco de dados e os resultados da consulta. Cada tabela apresentada é

acompanhada com uma variedade de ferramentas para interagir com os dados, tais como:

as colunas em uma tabela selecionada podem se projetadas (apresentadas), as tuplas

em uma tabela selecionada podem ser ordenadas por colunas, os resultados podem ser

agrupados por coluna e o usuário pode clicar em qualquer valor do resultado para ver as

tuplas associadas a este valor, etc.

Nos três sistemas, uma consulta pode obter mais de um resultado, sendo assim

desejável ordenar os resultados de acordo com sua relevância. As funções de ranking

atribuem uma pontuação para cada resultado e classifica a lista de resultados de acordo

com suas pontuações. Intuitivamente, os resultados do topo da lista são mais relevantes

para a consulta do que aqueles que estão no final.

Algumas teorias e práticas para ordenação de documentos foram desenvolvidas

na comunidade de Recuperação de Informação a fim de agregar funções de ranking. Por

exemplo, o esquema de pontuação tf-idf (term frequency-inverse document frequency) é

amplamente usado no contexto de documentos. Este peso é uma medida estatística usada

para avaliar o quão importante é uma palavra para um documento em uma coleção. A

importância aumenta proporcionalmente ao número de vezes que uma palavra aparece no

documento, mas é compensado pela freqüência da palavra na coleção.

Os resultados dos trabalhos desenvolvidos por Luo et al. [25], Hristidis et al. [16]

e Liu et al. [24] são ordenados usando métodos de ranking de Recuperação de Informação

24

(RI). Hristidis et al. [16] usa o método simples de tf-idf, e Liu et al. [24] aplica medidas

mais complexas de RI. Enquanto Hristidis et al. [16] e Liu et al. [24] pontuam cada

atributo e então os combinam para estimar a pontuação dos resultados, Luo et al. [25]

pontua os resultados diretamente.

Além dos métodos de ranking de RI, algumas outras métricas foram identificadas

e aplicadas no contexto de banco de dados relacionais. Nos sistemas DISCOVER [17] e

DBXplorer [2], os resultados da consulta com palavras-chave contêm todas as palavraschave da consulta e são ordenados por métodos simples, por exemplo, com base no

número de junções. Já no sistema BANKS [1], o cálculo das pontuações dos resultados

levam em consideração os pesos das arestas do grafo de dados.

Além das particularidades em relação à técnica aplicada e o método de ranking,

os trabalhos desta área de pesquisa também podem ser classificados em duas abordagens:

abordagem AND-semantics e OR-semantics. A abordagem AND-semantics requer que

a resposta contenha todas as palavras-chave da consulta, enquanto que a abordagem

OR-semantics requer apenas que a resposta contenha alguma, mas não necessariamente

todas as palavras-chave da consulta. DBXplorer, DISCOVER e BANKS se enquadram

na abordagem AND-semantics, enquanto que no trabalho de Hristidis et al. [16] foi

proposto um aprimoramento do DISCOVER, adicionando suporte para a abordagem ORsemantics.

Em relação às pesquisas existentes na área, existem diversos focos de estudo. Li

et al. [21] e Peng et al. [27] apresentam estratégias de feedback que permitem aos usuários

não satisfeitos com os conjuntos de resultados iniciais realizarem outras execuções,

a fim de obter melhores resultados. Além disso, Li et al. [21] também apresenta um

sistema que permite não apenas consultas exatas, mas também consultas que possuem

dissimilaridades. Para tanto, propõe um método de classificação dos resultados com base

na dissimilaridade e a correlação entre diferentes tipos de objetos. A dissimilaridade

d(i, j) entre dois objetos é denotada por um valor numérico que representa a diferença

entre eles, onde se i é mais similar à j, então d(i, j) é mais próximo de 0. Particularmente,

d(i, i) = d( j, j) = 0. Enquanto que a correlação c(i, j) entre dois objetos é calculada como

c(i, j) = 1 − d(i, j).

No sistema TASTIER [23], o objetivo é guiar o usuário na formulação da

consulta por meio do uso da autocomplementação, enquanto que Koutrika et al. [19]

busca guiar os usuários e permitir um melhor refinamento da consulta por meio do uso

das capacidades de sumarização e navegação das nuvens de dados.

Hassan et al. [15], Yu et al. [34] e Sayyadian et al. [30] permitem o uso de consultas com palavras-chave sobre banco de dados relacionais distribuídos e heterogêneos.

Em [15], dado um conjunto de banco de dados distribuídos, e uma consulta q, formada

por palavras-chave e operadores lógicos, o sistema proposto identifica os bancos de da-

25

dos mais propensos a retornar resultados relevantes para a consulta q, e então pesquisa

somente estes bancos de dados. Para calcular a utilidade de cada um deles para a consulta

q, é criado um índice invertido que armazena as estatísticas do banco de dados e estas estatísticas são então utilizadas para representar quão útil ele é para a consulta. De maneira

semelhante, o propósito do trabalho em [34] é identificar os bancos de dados relevantes

para uma determinada consulta com palavras-chave. Para Hassan et al. [15], a utilidade de

um banco de dados é calculada apenas com base na frequência com que a palavra-chave

aparece em um termo do banco de dados, enquanto que em [34] além do fator frequência,

também é considerado um novo fator, o fator de proximidade, que é definido como um

parâmetro que é o inverso da distância do caminho de junção que conecta duas palavraschave. Desta forma, além de considerar a representativade da palavra-chave no banco de

dados, também é considerada a relevância do resultado retornado, onde o número de junções entre as palavras-chave é inversamente proporcial à relevância do relacionamento

entra elas, ou seja, quanto mais distante as palavras-chave, mais fraca é a relação entre

elas e consequentemente menos significativa ela é para a consulta.

Sayyadian et al. [30] assumem que a resposta para uma consulta com palavraschave pode não residir em apenas um único banco de dados e sim em múltiplos bancos

de dados. Neste sentido, é necessário combinar as tuplas de vários bancos de dados

para obter a resposta desejada. Assim, neste trabalho é proposto o algoritmo Kite que

encontra junções aproximadas entre chaves estrangeiras de múltiplos bancos de dados

heterogêneos.

O sistema FRISK [28] faz uso de um algoritmo de programação dinâmica para

computar as melhores segmentações da consulta e apresentá-las ao usuário, que por sua

vez escolhe a que mais se aproxima de sua intenção.

E por fim, Keymantic [3] e Keyword++ [13] são ferramentas que levam em

consideração as várias interpretações que uma consulta pode assumir, considerando

a ambiguidade da consulta, e prezando pela completude e precisão das respostas. A

completude se refere a retornar todos os resultados relevantes, enquanto que a precisão se

refere aos resultados mais relevantes, que correspondem com a intenção do usuário.

O presente trabalho visa propor um método de consulta com palavras-chave

que englobe os aspectos propostos por Hassan et al. [15], Yu et al. [34], Keymantic

[3] e FRISK [28]. Em outras palavras, o método proposto tem por objetivo identificar

os bancos de dados que possuem informações relevantes para a consulta com palavraschave, realizar um tratamento semântico de tal consulta e segmentar a consulta de modo a

considerar a possibilidade de mapear conjuntamente duas ou mais palavras-chave. Além

desses aspectos, o método proposto leva em consideração consultas com palavras-chave

que representam estatísticas e não estruturas do banco de dados para as quais devem ser

mapeadas.

CAPÍTULO 3

Contexto e Arquitetura para o Método Proposto

Segundo Hopcroft [26], uma das grandes áreas atuais de pesquisa é a de Recuperação de Informação, pois “existem todos os tipos de informação em um banco de dados

que as pessoas que criaram o banco nem sabiam que elas tinham colocado lá”. Contudo,

recuperar os dados destes repositórios é uma tarefa que exige um conhecimento a respeito

das estruturas do banco de dados e de uma linguagem de consulta estruturada. A fim de

simplificar o acesso a estes dados, o presente trabalho propôs um método de consulta com

palavras-chave em bancos de dados relacionais.

O contexto introduzido no Capítulo 1 será expandido na Seção 3.1. A Seção 3.2

apresenta a arquitetura do método proposto, bem como a descrição do seu funcionamento,

e a Seção 3.3 sintetiza o capítulo realçando aspectos importantes do método.

3.1

Contexto

É crescente o número de usuários que utilizam a Internet, uma vez que esta se tornou o principal canal de circulação e disseminação de informações. As informações estão

espalhadas nos mais diversos meios de armazenamento, sejam eles textuais, de imagens,

páginas Web, documentos ou banco de dados, a maior parte na abordagem relacional.

Tal heterogeniedade de repositórios digitais dificulta a recuperação das informações devido à dispersão das fontes, divergências nas interfaces de busca, falta de integração dos

conteúdos, dentre outros.

Nesse sentido, foi criada a Open Archives Initiative (OAI), uma iniciativa para

desenvolver e promover padrões de interoperabilidade entre repositórios digitais. Para

tanto, a OAI criou o protocolo OAI-PMH (Open Archives Initiative - Protocol for Metadata Harvesting) que permite a publicação e compartilhamento de coleções digitais com

o objetivo de facilitar a disseminação eficiente de conteúdo entre esses repositórios.

A interoperabilidade entre os repositórios digitais promovida pelo protocolo

OAI-PMH permite a criação de novos serviços, como a busca federada, que consiste em

submeter uma consulta a um grupo de bases de dados dispersas, agrupando os resultados

coletados destas bases de dados e apresentando-os em um formato sucinto e unificado, ou

3.1 Contexto

27

seja, consiste no acesso simultâneo aos dados contidos nestes repositórios. Desta forma,

é possível maximizar o resultado da busca e reduzir o tempo de resposta.

Ao invés de realizar a busca em cada um dos diversos repositórios, o protocolo

OAI- PMH realiza uma busca automática de metadados (harvesting) de recursos que

adotam o protocolo e cria uma base de dados que armazena esses metadados coletados.

Uma vez que um usuário submete uma consulta, essa base de dados, que agrupa os

metadados de todos os repositórios pesquisado, é consultada.

A publicação e compartilhamento de coleções digitais são mecanismos utilizados de forma mais ampla por bibliotecas digitais e sites da Internet. Porém, uma grande

quantidade de informação encontra-se armazenada em bancos de dados, principalmente

relacionais. Quando um usuário submete uma consulta na Internet, utilizando algum programa de busca, o mecanismo de execução da pesquisa não alcança aquelas informações

armazenadas em bancos de dados, uma vez que esses ou são restritos às organizações,

que por algum motivo não querem (ou não podem) expor seus dados, ou inexiste um mecanismo que permita a divulgação dessas fontes de informação. Assim, a publicação e

o compartilhamento de metadados de bancos de dados são uma vertente que ainda não

foi explorada a contento [20]. Com a finalidade de permitir a busca por informações em

bancos de dados relacionais através da Web, Kowata define em [20] um mecanismo que

permite a consulta a bibliotecas digitais e a bancos de dados de forma homogênea, por

meio da definição de um conjunto comum de metadados utilizados para exportar (disponibilizar) essas fontes de informação.

Para permitir a publicação e o compartilhamento de recursos digitais, o protocolo

OAI- PMH necessita de um formato padrão de metadados. O padrão utilizado no contexto

de bibliotecas digitais é o padrão Dublin Core [11]. Em [20] é feito um estudo dos

elementos do padrão Dublin Core utilizados para representar metadados para bibliotecas

digitais, de modo a identificar quais elementos seriam necessários para descrever um

banco de dados relacional.

As informações a respeito da estrutura de um banco de dados podem ser encontradas no catálogo de um sistema gerenciador de banco de dados que armazena informações como esquemas dos bancos criados no sistema, descrição das tabelas de cada

esquema, definição das colunas que compõem cada tabela, definição de restrições, usuários e permissões de acesso, dentre outras informações. Entretanto, em um estudo descrito

em [20] a respeito dos catálogos dos principais gerenciadores de banco de dados disponíveis atualmente, demonstrou-se que em tais catálogos não há os metadados necessários

para descrever um recurso de informação em repositórios digitais. Nesse sentido, o estudo

resultou na definição de um conjunto comum de metadados para descrever um banco de

dados a fim de promover a interoperabilidade entre estas bases de dados e outras fontes de

informações, tais quais as bibliotecas digitais, e permitir a publicação (disponibilização)

3.1 Contexto

28

do conteúdo destes bancos de dados por meio de um protocolo também comum.

Durante o estudo realizado a respeito dos elementos definidos no padrão Dublin

Core para representar metadados para bibliotecas digitais, foram identificados 15 elementos. Além desses 15, foram propostos mais 8 elementos necessários para a descrição dos

metadados de banco de dados relacionais, totalizando assim 23 elementos. A Tabela 3.1

resume o conjunto destes atributos definidos para descrever os metadados de um banco

de dados. Os nomes dos elementos iniciados com dc_ representam os elementos que pertencem ao padrão Dublin Core e que são utilizados no contexto de bibliotecas digitais. Os

elementos que não são iniciados por dc_ representam os elementos adicionais propostos

pelo trabalho para permitir a descrição dos bancos de dados.

Tabela 3.1: Atributos da Tabela de Metadados para Exposição

(TME) [20]

serial

dc_title

dc_date

dc_relation

provider

dc_creator

dc_type

dc_coverage

url

dc_subject

dc_format

dc_rights

email

dc_description

dc_identifier

loginbd

oai_set

dc_contributor

dc_source

passwordbd

dispquery

dc_publisher

dc_language

-

Estes elementos armazenam as seguintes informações [20]:

• serial: utilizado para gerar uma sequência do repositório cadastrado;

• provider: utilizado para informar o endereço do provedor de dados do banco de

dados;

• url: utilizado para informar a url ou endereço do sítio vinculado ao banco de dados;

• email: utilizado para informar o endereço eletrônico do administrador do banco de

dados;

• oai_set: utilizado para informar a url do sítio ou endereço onde o sistema está

hospedado;

• dispquery: este campo é um flag que indica se o conteúdo do banco de dados está

disponível ou não para consulta na Web;

• dc_title: utilizado para apresentar o título do banco de dados;

• dc_creator: utilizado para informar o nome do autor ou entidade responsável pelo

recurso;

• dc_subject: na recomendação do Dublin Core, este campo deverá ser representado

pelo uso de palavras-chave, frases-chave ou código de classificação. O Dublin Core

recomenda ainda que a melhor prática é usar vocabulários controlados. É utilizado

para informar as palavras-chave associadas ao conteúdo do banco de dados;

• dc_description: utilizado para apresentar um resumo (textual) sobre o conteúdo do

banco de dados;

• dc_contributor: utilizado para informar o nome da pessoa/instituição responsável

por qualquer contribuição para o conteúdo do recurso;

3.1 Contexto

29

• dc_publisher: utilizado para informar o nome da entidade/instituição responsável

por tornar o recurso acessível;

• dc_date: utilizado para informar a data da publicação do recurso;

• dc_type: utilizado para informar o gerenciador adotado para implementar o banco

de dados com o valor padrão de “database” seguido pelo seu tipo. Ex.: MySQL,

PostGreSQL;

• dc_format: utilizado para descrever o formato do banco de dados, com o valor

padrão de “SGBDR”;

• dc_identifier: utilizado para descrever o nome do banco de dados conforme criado

por seu administrador;

• dc_source: utilizado para informar o principal departamento que faz uso do banco

de dados;

• dc_language: utilizado para informar o idioma que descreve o recurso;

• dc_relation: utilizado para relacionar os sistemas que utilizam o banco de dados;

• dc_coverage: utilizado para descrever as áreas de interesse do banco de dados

(financeira, cadastro, administrativo, vendas, acadêmico etc.);

• dc_rights: utilizado para registrar os direitos sobre o recurso;

• loginbd: usuário do banco de dados utilizado para acessar o banco de dados;

• passwordbd: senha do banco de dados utilizada para acessar o banco de dados.

Visto que esses metadados necessários para descrever um banco de dados não

estão disponíveis no catálogo do sistema, o mecanismo proposto em [20] sugere que estes

metadados sejam fornecidos pelo administrador do banco de dados e armazenados em

uma tabela que representará uma extensão do catálogo do sistema gerenciador de banco de

dados. Essa tabela para armazenamento de metadados, denominada Tabela de Metadados

para Exposição (TME), contém um atributo para cada um dos elementos descritos na

Tabela 3.1. O Código SQL para a criação da tabela TME encontra-se no Anexo A.

Uma vez definida a Tabela de Metadados para Exposição, esses metadados

são extraídos e exportados utilizando o protocolo OAI-PMH, permitindo, desta forma,

a identificação e a localização dos bancos de dados disponibilizados na rede. Isto permite

a indexação destes bancos de dados e o compartilhamento dos seus dados com os demais

usuários da rede.

De forma geral, esse trabalho permite a exposição dos metadados dos bancos

de dados relacionais que podem então ser indexados. Contudo, isso não é suficiente

para permitir a recuperação dos dados destas fontes de informações. Para se realizar

consultas em banco de dados relacionais é necessário o conhecimento das estruturas de

armazenamento e da sintaxe de uma linguagem estruturada, como o SQL. Contudo, a

maioria dos usuários não possui esse conhecimento, tornando-se assim uma limitação ao

acesso desses dados. Nesse sentido, surge a ideia de expandir a técnica de consulta com

3.2 Arquitetura

30

palavras-chave para banco de dados relacionais, uma vez que elimina a necessidade desse

conhecimento prévio por parte do usuário e por ser uma técnica com a qual os usuários já

estão familiarizados.

Desta forma, visto que o trabalho [20] permite a exposição e indexação dos

bancos de dados relacionais, mas não a consulta a estes dados, o presente trabalho visa

propor um método de recuperação dos dados destes bancos por meio do uso da técnica de

consulta com palavra-chave.

3.2

Arquitetura

Dada uma única consulta com palavras-chave, o método proposto neste trabalho

identifica os bancos de dados disponíveis e relevantes para tal consulta, e converte esta

consulta em consultas SQL correspondentes, as quais são submetidas aos bancos de dados

identificados como relevantes. Como resposta à consulta com palavras-chave, o método

retorna os resultados obtidos pela execução das consultas SQL.

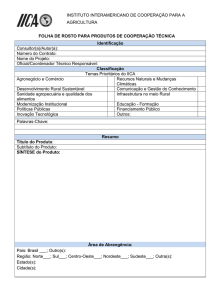

Uma visão geral da arquitetura do método proposto é apresentada na Figura 3.1.

Figura 3.1: Arquitetura do método proposto (inspirado em [28])

Para exemplificar os conceitos explorados nesta seção utilizaremos o banco

de dados COMPANY proposto por Elmasri e Navathe [8]. A Figura 3.2(a) apresenta o

esquema de relações enquanto que a Figura 3.2(b) ilustra a fração dos dados do banco

de dados COMPANY. Maiores informações a respeito deste banco de dados podem ser

encontradas no Apêndice B.

3.2 Arquitetura

3.2.1

31

Pré-processamento

A fase de Pré-processamento da consulta é responsável por “limpar” a consulta

com palavras-chave, identificar a melhor segmentação da consulta para valores compostos

por mais de uma palavra-chave, e por fim agregar semântica à consulta.

(a) Esquema lógico do banco de dados COMPANY com suas

restrições de integridade referencial.

(b) Fração dos dados do banco de dados COMPANY.

Figura 3.2: Banco de dados COMPANY (retirado de [8])

3.2 Arquitetura

32

Algumas palavras-chave da consulta podem não ter um significado em relação

aos termos do banco de dados. Por exemplo, considere a consulta “higher salary”. A

palavra-chave salary poderia ser mapeada para o atributo Salary da relação Employee,

porém a palavra-chave higher não possui nenhum elemento representativo no banco de

dados para o qual poderia ser mapeada. Nesse caso, a melhor interpretação dessa consulta

é que a palavra-chave higher represente a necessidade do uso da função agregada max.

Ou seja, é necessário “limpar” a consulta de forma a deixar apenas as palavras-chave que

possuem um significado real na base de dados.

Outro fator considerado nessa fase de pré-processamento é a segmentação da

consulta. Palavras-chave que podem ser mapeadas para valores de atributos, ou seja, para

os dados em si, devem receber uma atenção especial durante o momento de segmentação

da consulta. Se a consulta for segmentada de tal maneira que cada palavra-chave represente um termo do banco de dados para a qual será mapeada, valores como endereço e

descrição de um produto poderão perder seu significado. Por exemplo, considere a consulta “employee Houston TX”. Uma possível interpretação dessa consulta é encontrar os

empregados que moram em Houston, TX. Assim, espera-se que as palavras-chave Houston e TX sejam mapeadas conjuntamente para o domínio do atributo Address. Posto isso,

durante a segmentação da consulta deve-se levar em consideração os valores que são compostos por mais de uma palavra-chave, de modo que eles sejam mapeados conjuntamente.

Em relação à agregação de semântica à consulta, nem sempre as palavras-chave

da consulta estão representadas da mesma maneira nas estruturas do banco de dados.

Por exemplo, considere a consulta “department workers”. A palavra-chave department

poderia claramente ser mapeada para a relação Department, porém para a palavra-chave

workers não existe nenhum termo no banco de dados da Figura 3.2(a) que forneça uma

correspondência exata. Mas se for considerado que o conceito de employee é similar ao

conceito de workers, então é possível mapear workers para a relação Employee.

A fase de Pré-processamento é composta por duas etapas, as quais consideram os fatores mencionados acima. As duas etapas, Verificação de Função Agregada/Ordenação/Valores Compostos e Expansão da consulta, estão descritas a seguir.

Verificação de Função Agregada/Ordenação/Valores Compostos

Esta etapa permite a identificação de palavras-chave que representam a intenção

do uso de funções agregadas e ordenação, bem como a identificação de palavras-chave

que devem ser consideradas conjuntamente para formar o valor de um atributo.

A identificação das palavras-chave que sugerem o uso de funções agregadas e

ordenação é feita por meio de uma lista de palavras “reservadas”. Essas palavras reservadas nada mais são que um conjunto de palavras pré-definidas com base na observação

de como os usuários formulam suas consultas. Além disso, outro fato observado é que

3.2 Arquitetura

33

as palavras-chave que representam o uso de funções agregadas são seguidas da palavra

em que será aplicada a função. Por exemplo, na consulta “higher salary” a palavra-chave

higher é identificada na lista de palavras reservadas e por meio dessa lista descobre-se que

ela pertence ao grupo pré-definido de palavras que representam a função agregada max.

Uma vez que a palavra-chave salary é adjacente e posterior à palavra-chave higher, ela

será a palavra sobre a qual a função max será aplicada. No contexto do banco COMPANY,

considere que a palavra-chave salary seja mapeada para o atributo Salary da relação Employee. Dessa forma, a consulta “higher salary” pode ser então convertida para a consulta

SQL: select max(Salary) from Employee. A identificação do uso de ordenação e agrupamento segue o mesmo raciocínio.

A identificação das palavras-chave que devem ser consideradas conjuntamente

para formar o valor de um atributo é feita por meio do uso de aspas simples. Por

exemplo, no caso da consulta “employee Houston TX”, as palavras-chave Houston TX

devem aparecer entre aspas simples para representar a necessidade de serem mapeadas

conjuntamente para o mesmo domínio de um atributo. Assim, a consulta deve ser

“employee ‘Houston TX’ ”.

Expansão da consulta

Uma vez eliminadas as palavras-chave que representam o uso de funções agregadas e ordenação, a consulta permanece apenas com palavras-chave que representam

algum termo do banco de dados. Porém, como mencionado anteriormente, nem sempre

as palavras-chave são uma representação exata do termo que está no banco. Para lidar

com esse problema, é necessário considerar também outras palavras relacionadas à essas

palavras-chave.

Para tanto, foi utilizado o dicionário WordNet que provê sinônimos, hiperônimos,

hipônimos e outros termos relacionados à uma dada palavra. Como o WordNet é uma base

de dados com palavras na língua inglesa, o presente trabalho considera apenas consultas e

banco de dados com conteúdo em Inglês. Caso as palavras que compõem a consulta ou os

metadados e o contéudo do banco de dados estejam em outra língua, como o Português, a

consulta poderá ser realizada, porém não será agregada semântica à ela. Ou seja, essa fase

de expansão da consulta não encontrará sinônimos e a consulta permanecerá a mesma.

Caso existam palavras-chave na consulta que possuem a mesma grafia em Inglês, serão

adicionados à consulta original os sinônimos retornados pelo WordNet, porém na fase de

mapeamento provavelmente eles serão desconsiderados. Um exemplo disso é a palavra

item, que possui a mesma grafia em inglês.

3.2 Arquitetura

3.2.2

34

Processamento da consulta

Até este momento foram identificados os possíveis usos de funções agregadas

e ordenação, valores compostos por mais de uma palavra-chave e foram adicionados à

consulta termos relacionados às palavras-chave. Dessa forma, tem-se uma consulta que

possui apenas palavras-chave que possuem um significado real no banco de dados e um

conjunto de sinônimos para o caso de não existir uma correspondência exata entre os

termos do banco de dados e as palavras-chave da consulta.

Dado um conjunto de banco de dados disponibilizados por meio do protocolo

OAI-PMH usando a extração de metadados sugerida por Kowata [20], é necessário identificar quais bancos contêm informações úteis para a consulta com palavras-chave. Uma

vez identificados, é necessário criar a partir dessa única consulta com palavras-chave,

várias consultas SQL que serão executadas nos múltiplos bancos de dados selecionados

como relevantes. Esse processo de criação das consultas SQL é feito pelo mapeamento

das palavras-chave para os termos do banco subjacente. Uma vez executadas as consultas

SQL, os resultados são retornados ao usuário ordenados por relevância. Todo esse processamento é realizado em 5 etapas: Identificação dos bancos de dados relevantes, Ranking

dos bancos de dados relevantes, Mapeamento, Execução e Ranking dos resultados. A

explicação sobre cada uma dessas etapas está abaixo.

Identificação dos bancos de dados relevantes

Em concordância com o método de exposição dos metadados de bancos de

dados relacionais, proposto em [20], cada banco possui uma tabela TME que representa

a extensão do catálogo do banco de dados e que contém informações a respeito do

conteúdo do banco de dados. Essas informações são descritas por meio dos 23 elementos

apresentados na Tabela 3.1.

A identificação e seleção dos bancos de dados que possuem conteúdo relevante

para a consulta com palavra-chave é feita com base na análise das informações contidas

na tabela TME. Considere as informações fictícias da tabela TME do banco COMPANY

apresentada na Tabela 3.2. Nem todos os elementos desta tabela contêm informações a

respeito do conteúdo do banco de dados. Alguns elementos como login, url, dispquery,

dentre outros, dizem respeito à localização e ao acesso. Essa etapa de identificação

dos bancos de dados relevantes considera apenas os elementos que contêm ou sugerem

informações a respeito do conteúdo do banco de dados. Os elementos considerados

são: dc_title, dc_subject, dc_description e dc_identifier. Caso as informações de um

desses quatro elementos contenha alguma palavra-chave da consulta, o banco de dados

é considerado como relevante para a consulta.

3.2 Arquitetura

35

Tabela 3.2: Informações da Tabela de Metadados para Exposição(TME) do banco de dados COMPANY (inspirado

em [20])

Elemento

serial

provider

url

email

oai_set

dispquery

dc_title

dc_creator

dc_subject

dc_description

dc_contributor

dc_publisher

dc_date

dc_type

dc_format

dc_identifier

dc_source

dc_language

dc_relation

dc_coverage

dc_rights

dc_login

dc_passwordbd

Informação

1

http://localhost/website/xyzsystem/database/oai

http://localhost/website/xyzsystem/

[email protected]

http://localhost/website/system/systemname

sim

COMPANY

Elmasri e Navathe

Department. Dependent. Location. Employee. Project. Management.

Salary. Working hours. Address.

Records the staff of the company, which department they belong to,

which department they manage, in which project they work, the

location of the department and project, the employees dependents.

XYZ

ABC

2001-11-01

Database - MYSQL

SGBDR

bdcompany

DEF

Inglês

GHI

JKL

MNO

********

********

Ranking dos bancos de dados relevantes

Dado o conjunto de bancos de dados relevantes para a consulta, estes são

ordenados de modo que o banco de dados mais relevante para a consulta fique no topo da

lista.

A relevância de um banco de dados em relação à uma consulta é computada

com base no número de vezes que as palavras-chave da consulta aparecem nas informações dos quatro elementos considerados na etapa anterior. Por exemplo, para a consulta

“department employees”, a pontuação do banco de dados COMPANY é 5. Esta pontuação é computada da seguinte maneira: a palavra-chave department aparece 1 vez no

elemento dc_subject e 3 vezes no elemento dc_description, enquanto que a palavra-chave

employees aparece 1 vez no elemento dc_description, totalizando assim 5, o número de

vezes que ambas palavras-chave aparecem nos elementos descritores de conteúdo.

3.2 Arquitetura

36

Mapeamento

A consulta com palavra-chave é executada em cada um dos bancos de dados

considerados como relevante e a ordem de execução em cada banco de dados é baseada

na ordenação gerada na etapa anterior.

Responder uma consulta com palavras-chave em banco de dados relacionais

requer o entendimento do significado de cada palavra-chave e a construção de uma

consulta SQL que ofereça uma interpretação da consulta em termos do banco de dados

relacional. Ou seja, é necessário mapear as palavras-chave em termos das estruturas do

banco de dados, tais como relações, atributos e valores de atributos.

Nesse sentido, diversas técnicas e ferramentas foram propostas a fim de solucionar o problema de consulta com palavras-chave em banco de dados relacionais. Geralmente, essas técnicas consideram o banco de dados como uma rede de tuplas interconectadas e detectam as tuplas que contêm as palavras-chave da consulta. Componentes

conectados são gerados, com base em como essas tuplas são associadas, e retornam estas

tuplas conectadas como uma resposta à consulta. Para tanto, estruturas especializadas que

indexam o conteúdo da base de dados são utilizadas. Ao usar esses índices, as tuplas de

interesse podem ser diretamente identificadas.

Contudo, para construir tais índices é necessário um acesso prévio ao dados do

banco de dados. Tal fato torna-se uma limitação caso não seja permitido o acesso aos

dados. Exemplos de tais situações incluem banco de dados restritos às organizações, que

por algum motivo não querem (ou não podem) dispor de seus dados e normalmente expõe

apenas as informações do esquema ou parte delas.

Levando isto em consideração, é necessário o uso de uma ferramenta ou técnica

de consulta com palavra-chave que não necessite do acesso ao dados do banco para construir expressões SQL que correspondam à consulta. Baseado nesse fato, a ferramenta escolhida para realizar a etapa de mapeamento foi a ferramenta conhecida como Keymantic

[3]. Tal sistema responde à consulta com palavras-chave sobre banco de dados relacionais baseando-se apenas no conhecimento intensional, ou seja, informações extraídas (ou

fornecidas) pelas fontes de dados, tais como, esquemas e tipos de dados e conhecimento

adicional que está publicamente disponível na Web, como recursos lexicais, vocabulários,

ontologias, etc [3]. Além desse motivo, a ferramenta também foi escolhida pelo fato de

considerar as várias interpretações que uma consulta pode assumir, condizendo com o

objetivo deste trabalho.

Apesar de não requerer acesso aos dados, a ferramenta necessita do esquema

para realizar o mapeamento das palavras-chave e necessita do acesso ao banco de dados

apenas para executar as consultas SQL geradas. Com base nisso, temos dois cenários.

Para identificar qual cenário deve ser considerado é necessário verificar o conteúdo do

elemento dispquery da tabela TME. Considere que as etapas de pré-processamento e

3.2 Arquitetura

37

identificação e ordenação dos bancos de dados relevantes já tenham sido executadas.

No primeiro cenário, um dos bancos considerados como relevantes foi disponibilizado pelo administrador do banco de dados, expondo os metadados do mesmo por meio

da tabela TME, porém não disponibilizou o esquema do banco de dados e/ou o acesso à

esse banco de dados. Nesse caso, o elemento dispquery conterá a informação que o banco

de dados não está disponível para consulta. Não será possível realizar o processo de mapeamento das palavras-chave da consulta e consequentemente não será possível realizar

as demais etapas, impedindo assim que os resultados sejam gerados e retornados para

o usuário. Uma solução para esse cenário, seria repassar a consulta com palavra-chave

para o administrador do banco de dados. Este então, deveria possuir uma implementação

própria da técnica de consulta com palavras-chave em bases de dados relacionais e então

executar a consulta que lhe foi entregue. Uma vez realizada a consulta, o administrador

do banco de dados retornaria os resultados desta consulta.

O outro cenário considera que o administrador além de expor os metadados,

disponibiliza o esquema e o acesso ao banco de dados. O acesso ao banco é fornecido

por meio dos elementos loginbd e passwordbd, presentes na tabela TME. Desta forma,

as etapas de mapeamento, execução e ranking dos resultados podem ser realizadas e os

resultados são então retornados ao usuário.

Para o propósito deste trabalho, o último cenário será considerado. O processo

de mapeamento e o funcionamento da ferramenta Keymantic serão descritos em maiores

detalhes no Capítulo 4.

Execução

O processo de mapeamento realiza a correspondência entre as palavras-chave da

consulta e os termos do banco de dados subjacente. Com base nessa correspondência, a

ferramenta Keymantic constroi uma consulta SQL correspondente. Porém, uma consulta

com palavras-chave pode ter mais de uma interpretação, e cada interpretação pode corresponder a um mapeamento diferente das palavras-chave em termos das estruturas do

banco de dados. Dessa forma, uma consulta com palavras-chave pode ser convertida em

várias consultas SQL. Logo, para cada banco de dados relevante são construídas várias

consultas SQL. Cada consulta SQL é então executada no banco de dados correspondente,

e os resultados destas consultas representam os resultados esperados pela consulta com

palavras-chave. Porém, estes resultados não são igualmente significativos, alguns representam melhor a semântica pretendida pela consulta do usuário. Nesse sentido, é interessante apresentar ao usuário, primeiramente, os resultados mais significativos. O ranking

destes resultados é executado na próxima etapa que será descrita a seguir.

3.3 Considerações Finais

38

Ranking dos resultados

Para gerar um ranking dos resultados é necessário ter uma medida quantitativa

que indica quão significativo um resultado é para a consulta. Considerando que a ferramenta Keymantic computa uma pontuação para cada consulta SQL gerada e, consequentemente, o resultado obtido pela execução dessa consulta possui a mesma pontuação, os

resultados retornados ao usuário podem atender a seguinte ordenação: os resultados do

banco de dados mais relevante para consulta aparecem primeiro e, em seguida, os resultados dos demais, na ordem definida na etapa de ranqueamento dos bancos de dados

relevantes; os resultados de cada banco de dados são então ordenados primariamente pela

pontuação de sua consulta SQL correspondente, e secundariamente pelo tamanho do caminho de junção.

O tamanho do caminho de junção é baseado no número de junções necessárias

na consulta SQL. Por exemplo, considere que dois resultados de um dos bancos de dados

relevantes possuam pontuação 283, e que as consultas SQL que os originou possuam

4 junções e 3 junções, respectivamente. Ambos possuem a mesma pontuação, porém um

possui menor caminho de junção. Então, o resultado com o tamanho de caminho de junção

3 irá aparecer antes do resultado que possui tamanho de caminho de junção 4.

3.3

Considerações Finais

Como visto na Figura 3.1 e detalhado neste capítulo, o método proposto engloba outras funcionalidades além da simples aplicação de uma técnica de consulta

com palavras-chave para realizar o mapeamento das palavras-chave. As etapas de préprocessamento, seleção e ordenação dos bancos de dados relevantes e ordenação dos

resultados são cruciais para a identificação de fontes com conteúdo de interesse para a

consulta e para permitir uma melhor interpretação da consulta de modo a encontrar os

resultados mais proeminentes. Puramente, a técnica de consulta com palavras-chave aplicada engloba apenas as etapas de Mapeamento e Execução. Essas duas últimas etapas

nada mais são que a representação do uso da ferramenta Keymantic.

Assim, como foram agregadas funcionalidades externas ao contexto da ferramenta Keymantic, também foram realizadas algumas modificações internas à ferramenta,

mais precisamente, no processo de Mapeamento, a fim de aprimorar a qualidade dos resultados retornados. O funcionamento da ferramenta, ou seja, a técnica utilizada pela Keymantic, bem como as melhorias propostas à esta técnica, serão apresentados nos próximos

capítulos.

CAPÍTULO 4

Análise Semântica da Consulta

Apesar de ser uma alternativa atraente para consultas SQL tradicionais, eliminando a necessidade de um conhecimento prévio por parte dos usuários, a consulta com

palavras-chave em banco de dados relacionais mostra-se como um problema complexo

e desafiador. Neste sentido, diversos esforços têm sido feitos para propor técnicas que

solucionem este problema, entre elas, a Keymantic.

Nas próximas seções será descrito de forma mais detalhada o problema de

consulta com palavra-chave em banco de dados relacionais, modelado de acordo com

a solução proposta pela ferramenta Keymantic (Seção 4.1); e as particularidades da

ferramenta e a técnica utilizada para solucionar o problema (Seção 4.2).

4.1

Definição do problema

Considere um banco de dados D como um conjunto de tabelas relacionais. Uma

tabela relacional é denotada como R(A1 , A2 , ... , An ), onde R é o nome da tabela e A1 , A2 ,

... , An são os atributos da tabela. O vocabulário do banco de dados D, denotado como VD ,

é o conjunto de todos os nomes de suas relações, atributos e o respectivos domínios destes

atributos. Um termo de banco de dados é um membro do seu vocabulário.

Uma consulta com palavra-chave q é uma lista ordenada de palavras-chave, onde

cada uma delas é uma especificação do elemento de interesse. A especificação pode ter

sido modelada no banco de dados como uma tabela relacional, um atributo, ou um valor

de um atributo. Uma configuração é uma função que mapeia cada palavra-chave com

respeito aos termos do banco de dados.

Definição 4.1 Uma configuração C de uma consulta com palavra-chave q sobre um

banco de dados D é um mapeamento injetivo das palavras-chave em q para os termos

de banco de dados do vocabulário de D. Cki denota a função de mapeamento aplicada a

palavra-chave ki [4].

Algumas suposições são consideradas pela Keymantic nesse processo de mapeamento das palavras-chave. A primeira suposição é que cada palavra-chave não pode ter

4.1 Definição do problema

40

mais de um significado na mesma configuração, ou seja, cada palavra-chave só pode ser

mapeada para um único termo do banco de dados. Além disso, também é considerado que

duas palavras-chave não podem ser mapeadas para o mesmo termo do banco de dados. E

por fim, também é feita a suposição de que toda palavra-chave desempenha um papel na

consulta, ou seja, toda palavra-chave é mapeada para um termo do banco de dados.

Uma vez mapeadas as palavras-chave, ou seja, construída uma configuração, responder uma consulta com palavras-chave sobre um banco de dados D significa encontrar

um conjunto de consultas SQL. Tais consultas SQL são referidas como interpretações da

consulta com palavras-chave, uma vez que oferecem um possível significado da consulta

em termos do vocabulário do banco de dados.

Devido aos múltiplos caminhos de junção existentes em uma base de dados D,

a partir de uma dada configuração C é possível gerar múltiplas interpretações de uma

dada consulta com palavra-chave q. Assim, a notação I(q, C, D) é usada para se referir

ao conjunto das interpretações possíveis para uma configuração, enquanto que a notação

I(q, D) se refere à união de todos esses conjuntos para todas as possíveis configurações da

consulta q.

Definição 4.2 Uma resposta para uma consulta com palavra-chave q sobre um banco de

dados relacional D é o conjunto res(q) = {t | t ∈ execD (q0 ) ∧ q0 ∈ I(q,D)}, onde execD (q0 )

denota a execução da consulta SQL q0 no banco de dados D [4].

Uma vez que cada palavra-chave em uma consulta pode ser mapeada para um

nome de uma relação, nome de um atributo ou para o domínio de um atributo, existem

|D|

2×∑i=1 |Ri | + |D| diferentes configurações, com |Ri | denotando a aridade da relação Ri

e |D| o número de tabelas no banco de dados. Baseado nisso, e considerando que duas