Introdução aos Sistemas Operacionais

Eleri Cardozo

EA876/EA879 - 2014

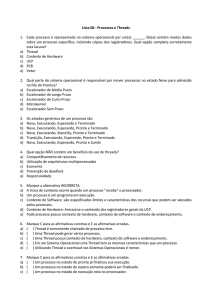

Sumário

1

2

Introdução

1.1

O que é um sistema operacional?

. . . . . . . . . . . . . . . .

5

1.2

Sistema operacionais embarcados

. . . . . . . . . . . . . . . .

7

1.3

Relacionamento com o hardware . . . . . . . . . . . . . . . . .

8

1.4

Componentes de um sistema operacional

. . . . . . . . . . . .

10

1.5

Chamadas de sistema . . . . . . . . . . . . . . . . . . . . . . .

12

1.6

Sistemas operacionais e linguagens de programação

. . . . . .

14

1.7

Exercícios

. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

Subsistema de Processos

17

2.1

Estrutura de um processo

. . . . . . . . . . . . . . . . . . . .

17

2.2

Criação de processos

. . . . . . . . . . . . . . . . . . . . . . .

22

2.3

Troca de contexto . . . . . . . . . . . . . . . . . . . . . . . . .

26

Escalonamento de processos

29

2.4

3

5

. . . . . . . . . . . . . . . . . . .

2.4.1

Processos interativos e servidores

2.4.2

Processos de tempo real

. . . . . . . . . . . .

30

. . . . . . . . . . . . . . . . .

31

2.5

Sinalização de processos

. . . . . . . . . . . . . . . . . . . . .

32

2.6

Comunicação e sincronização interprocesso . . . . . . . . . . .

36

2.6.1

Comunicação interprocesso . . . . . . . . . . . . . . . .

36

2.6.2

Sincronização interprocesso

38

2.6.3

O problema da inversão de prioridades

. . . . . . . . . . . . . . .

. . . . . . . . .

41

2.7

A tabela de processos . . . . . . . . . . . . . . . . . . . . . . .

42

2.8

Na prática . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

42

2.9

Exercícios

43

. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Threads

3.1

Motivações para threads

3.2

Gerenciamento de threads

47

. . . . . . . . . . . . . . . . . . . . .

47

. . . . . . . . . . . . . . . . . . . .

48

1

3.3

3.4

4

Comunicação e sincronização interthreads

50

. . . . . . . . . . .

51

3.4.1

Variáveis de condição . . . . . . . . . . . . . . . . . . .

52

3.4.2

Threads e a chamada

. . . . . . . . . . . . . . . .

54

3.4.3

Threads em sistemas de tempo real . . . . . . . . . . .

55

fork

3.5

Escalonamento de threads

3.6

Na prática . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

56

3.7

Exercícios

57

. . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

Subsistema de Memória

59

4.1

O mapeamento de endereços . . . . . . . . . . . . . . . . . . .

61

4.2

Unidade de gerenciamento de memória

. . . . . . . . . . . . .

66

4.3

5

Utilização de threads . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69

4.3.1

Paginação

O princípio da localidade . . . . . . . . . . . . . . . . .

69

4.3.2

Gerenciamento do espaço virtual

4.3.3

Gerenciamento do espaço físico

4.3.4

Gerenciamento de páginas

. . . . . . . . . . . .

72

. . . . . . . . . . . . .

72

. . . . . . . . . . . . . . . .

74

4.4

Paginação e sistemas de tempo real . . . . . . . . . . . . . . .

78

4.5

Comentários nais

79

4.6

Na prática . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

80

4.7

Exercícios

81

. . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Subsistema de Arquivos

84

5.1

Introdução . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

84

5.2

Dispositivos de armazenamento

. . . . . . . . . . . . . . . . .

85

5.3

Gerenciamento do espaço físico

. . . . . . . . . . . . . . . . .

86

5.4

Organização de arquivos

. . . . . . . . . . . . . . . . . . . . .

87

5.5

Organização de diretórios . . . . . . . . . . . . . . . . . . . . .

87

Esquemas de cache de disco

5.6

. . . . . . . . . . . . . . . . . . .

89

5.6.1

O cache de buers

. . . . . . . . . . . . . . . . . . . .

89

5.6.2

O cache de páginas . . . . . . . . . . . . . . . . . . . .

91

5.7

Arquivos mapeados em memória . . . . . . . . . . . . . . . . .

92

5.8

Suporte a múltiplos sistemas de arquivos . . . . . . . . . . . .

93

5.9

Conabilidade do sistema de arquivos . . . . . . . . . . . . . .

95

5.9.1

Journaling . . . . . . . . . . . . . . . . . . . . . . . . .

95

5.9.2

RAID

. . . . . . . . . . . . . . . . . . . . . . . . . . .

96

5.9.3

Vericadores de consistência . . . . . . . . . . . . . . .

97

5.9.4

Backups . . . . . . . . . . . . . . . . . . . . . . . . . .

99

2

5.10 Sistemas de arquivos e sistemas de tempo real

. . . . . . . . .

99

5.11 Na prática . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

5.12 Exercícios

6

7

Subsistema de Entrada e Saída

103

6.1

Módulos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103

6.2

Acionadores de dispositivos

6.3

Acesso direto à memória

6.4

Na prática . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 109

6.5

Exercícios

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110

Virtualização

112

. . . . . . . . . . . . . . . . . . . 105

. . . . . . . . . . . . . . . . . . . . . 108

7.1

Introdução . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 112

7.2

Requisitos para virtualização . . . . . . . . . . . . . . . . . . . 113

7.3

Virtualização com suporte do hardware . . . . . . . . . . . . . 115

7.4

7.5

8

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101

7.3.1

Virtualização da memória

7.3.2

Virtualização da CPU

. . . . . . . . . . . . . . . . 115

7.3.3

Virtualização de entrada e saída . . . . . . . . . . . . . 119

. . . . . . . . . . . . . . . . . . 117

Modelos de virtualização . . . . . . . . . . . . . . . . . . . . . 121

7.4.1

Virtualização plena . . . . . . . . . . . . . . . . . . . . 122

7.4.2

Virtualização assistida pelo hardware . . . . . . . . . . 123

7.4.3

Paravirtualização . . . . . . . . . . . . . . . . . . . . . 124

7.4.4

Virtualização suportada pelo sistema operacional

Exemplo de soluções de virtualização

. . . 125

. . . . . . . . . . . . . . 126

7.5.1

VirtualBox

. . . . . . . . . . . . . . . . . . . . . . . . 126

7.5.2

KVM . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

7.5.3

Xen

7.5.4

LXC . . . . . . . . . . . . . . . . . . . . . . . . . . . . 127

. . . . . . . . . . . . . . . . . . . . . . . . . . . . 127

7.6

Na prática . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

7.7

Exercícios

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 130

Segurança em Sistemas Operacionais

131

8.1

Introdução . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

8.2

Ataques à Segurança

8.3

Criptograa . . . . . . . . . . . . . . . . . . . . . . . . . . . . 133

8.4

Certicados e assinaturas digitais

. . . . . . . . . . . . . . . . 135

8.5

Segurança do sistema operacional

. . . . . . . . . . . . . . . . 138

8.5.1

. . . . . . . . . . . . . . . . . . . . . . . 132

Assinatura de código . . . . . . . . . . . . . . . . . . . 139

3

9

8.5.2

Cifragem do sistema de arquivos . . . . . . . . . . . . . 140

8.5.3

Sandboxes . . . . . . . . . . . . . . . . . . . . . . . . . 141

8.5.4

Biometria

8.5.5

Armazenamento de senhas e chaves criptográcas

8.5.6

Ações adicionais de proteção . . . . . . . . . . . . . . . 142

. . . . . . . . . . . . . . . . . . . . . . . . . 141

. . . 142

8.6

Na prática . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 144

8.7

Exercícios

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 144

Desenvolvimento de Aplicações Embarcadas

146

9.1

Aplicações de laço único

9.2

Aplicações controladas por interrupções . . . . . . . . . . . . . 147

9.3

Aplicações multitarefa cooperativas . . . . . . . . . . . . . . . 148

9.4

Aplicações multitarefa preemptivas

9.5

Arquitetura em camadas . . . . . . . . . . . . . . . . . . . . . 150

9.6

. . . . . . . . . . . . . . . . . . . . . 147

. . . . . . . . . . . . . . . 149

9.5.1

Camada de controle de tempo real

9.5.2

Camada executiva

9.5.3

Camada de aplicação . . . . . . . . . . . . . . . . . . . 153

Exercícios

. . . . . . . . . . . 151

. . . . . . . . . . . . . . . . . . . . 152

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 153

4

Capítulo 1

Introdução

Neste capítulo introdutório apresentaremos os principais conceitos relacionados aos sistemas operacionais.

Inicialmente, deniremos um sistema

operacional e analisaremos sua relação com o hardware sobre o qual o sistema

operacional é instalado. A seguir apresentaremos uma visão arquitetural do

sistema operacional, ou seja, seus principais componentes e interrelações.

Na sequência, deniremos chamadas de sistema e avaliaremos o papel das

linguagens de programação no desenvolvimento e utilização de sistemas operacionais.

1.1 O que é um sistema operacional?

Na literatura encontramos várias denições de sistema operacional. Tanenbaum [1] dene um sistema operacional como um gerenciador de recursos

de hardware ou como uma máquina virtual que oferece uma interface mais

simples para interagir com os recursos de hardware. Silberschatz [2] dene

um sistema operacional como um intermediário entre o usuário e o harware

de modo que o usuário possa executar seus programas de maneira eciente

e conveniente. Vahalia [3] dene um sistema operacional como um ambiente

de execução no qual programas do usuário podem executar. A Wikipedia [4]

dene um sistema operacional como um conjunto de programas que gerencia

o hardware e provê serviços para os programas manipulados pelo usuário

(aplicativos).

Destas denições podemos concluir que um sistema operacional gerencia

os recursos de hardware e facilita o desenvolvimento e a utilização de progra-

5

mas aplicativos. Precisamos de mais uma denição de sistema operacional?

Talvez possamos fornecer um denição mais geral: um sistema operacional

é um software que facilita o processamento, armazenamento e transferência

de informação. Note que nesta denição não aparecem os termos hardware,

usuário ou programa aplicativo, sendo centrada na informação. De fato, na

atualidade, um sistema operacional pode executar sobre um hardware virtualizado, ou seja, sobre um outro sistema de software. Nem sempre um usuário

interage com o sistema operacional como quando manipulamos arquivos ou

executamos programas aplicativos. Em um roteador de rede, por exemplo, o

sistema operacional se dedica a transferir informação (na forma de pacotes

de rede) de uma interface de rede para outra, sem nenhuma intervenção

de usuário.

Finalmente, o conceito de programa aplicativo pode ser visto

também como um software de processamento, armazenamento e transferência

de informação, mas com operações de mais alto nivel comparadas àquelas

fornecidas pelo sistema operacional.

Por exemplo, o sistema operacional

fornece a abstração de arquivos e diretórios para o armazenamento de informação, enquanto um aplicativo de banco de dados fornece abstrações de mais

alto nível como tabelas, relacionamentos e consultas parametrizadas. Desta

forma, o processamento, armazenamento e transferência de informação se

dá, recursivamente, em vários níveis, desde o nível do harware até o nível

visível ao usuário. O sistema operacional é um componente de manipulação

da informação situado imediatamente acima de um harware real ou virtual.

Em sendo um software de alta complexidade, sistemas operacionais são

compostos de diversos subsistemas interrelacionados. Alguns destes subsistemas são mais voltados ao processamento da informação, como o subsistema

de processos. Outros subsistemas são mais voltados ao armazenamento da

informação, como o subsistema de arquivos, e outros à transferência da

informação, como o subsistema de entrada e saída.

Ainda devido à alta

complexidade, sistemas operacionais devem passar por constantes aprimoramentos, por exemplo, correção de falhas (

bugs ),

otimização de desempenho

e eliminação de funcionalidades redundantes. Com a internet, estes aprimoramentos passaram a ser feitos de forma automática, sem a necessidade de

intervenção direta do usuário.

6

1.2 Sistema operacionais embarcados

Certamente o leitor já teve contato com um ou mais sistemas operacionais,

seja em seu computador de mesa ou portátil, em seu

tablet

smartphone,

em seu

ou em uma máquina virtual (capítulo 7) mantida por um provedor

de computação em nuvem. Sistemas como o Windows da Microsoft, o iOS

da Apple, o Linux e o Android são exemplos de sistemas operacionais que

utilizamos no nosso dia a dia. Estes sistemas são instalados em dispositivos

que têm como função precípua processamento, armazenamento e transferência de informação.

Sistemas operacionais são também empregados em

dispositivos que não têm esta função precípua, por exemplo, TVs, automóveis, aeronaves, robôs, brinquedos, e uma innidade de outros artefatos.

Estes sistemas operacionais são denominados embarcados (ou embutidos) por

serem integralmente dedicados aos dispositivos que os abrigam. O projeto

destes sistemas operacionais e as aplicações que controlam e supervisionam o

dispositivo apresentam um grande número de desaos. Tais desaos, em última análise, são devidos ao limitado poder computacional dos processadores

onde estes sistemas operacionais executam (os processadores embarcados).

Tal limitação se deve principalmente a:

•

custo: produtos de consumo de massa têm no preço sua principal restrição de projeto, o que limita a capacidade do processador embarcado;

•

tamanho: dispositivos altamente portáteis requerem processadores de

dimensões reduzidas, o que implica capacidade também reduzida;

•

consumo de energia: dispositivos alimentados por baterias devem limitar o consumo de energia nos seus processadores, ou seja, empregar

processadores com menos componentes integrados;

•

conabilidade:

a atualização de processadores em sistemas críticos

1

demandam onerosos procedimentos de testes e homologações, o que

torna sua atualização muito menos frequente.

O investimento no desenvolvimento de aplicações que executam em sistemas embarcados (as aplicações embarcadas) superam em muito o desenvolvimento de aplicações convencionais tais como editores de texto, navegadores

1 Sistemas

que requerem alta conabilidade, por exemplo, aplicações nas áreas

aeroespacial, médica e nuclear.

7

Web, planilhas, reprodutores de mídia, etc. Um indicativo é o fato que que

mais de 90% dos processadores fabricados se destinam a sistemas embarcados.

Obviamente, nem todos estes processadores utilizam sistemas operacionais.

2

A plataforma Arduino , por exemplo, não utiliza sistema operacional, o que

signica que nesta plataforma as aplicações executam diretamente sobre o

hardware. Entretanto, com a disponibilidade de processadores cada vez mais

poderosos, compactos e ecientes, a utilização de sistemas operacionais em

sistemas embarcados é uma tendência irreversível. Por exemplo, a plataforma

3

Raspberry Pi e variantes utilizam uma versão do sistema Linux como sistema

operacional.

1.3 Relacionamento com o hardware

Para entender como funciona um sistema operacional, é necessário entender

como o mesmo se relaciona com o hardware. Felizmente, para o desenvolvedor

de sistemas opeacionais o hardware contribui para tornar este relacionamento

menos complicado. Vamos examinar inicialmente como o hardware executa

um programa (sequência de instruções em linguagem de máquina). Inicialmente o programa deve ser carregado na memória. Vamos considerar por ora

a memória como um espaço de armazenamento linear de

de zero a

N −1.

N

bytes endereçado

Uma vez na memória, um registrador especial, o contador de

programa, é inicializado com o endereço da primeira instrução a ser executada. Em um programa compilado a partir da linguagem C este endereço é o

endereço da função

main.

A seguir, o ciclo de busca-decodicação-execução

de instruções é iniciado com a transferência da primeira instrução em outro

registrador, o registrador de instruções.

Após a decodicação e execução

desta instrução, o contador de programa é incrementado para o endereço da

próxima instrução do programa (caso a instrução corrente seja uma instrução

de desvio, o endereço da próxima instrução pode não ser o da instrução

subsequente).

A instrução apontada pelo contador do programa é então

carregada para o registrador de instruções e o processo se repete até que

a última instrução seja executada, uma instrução de parada é executada (o

retorno da função

main, por exemplo) ou um evento reportado pelo hardware

impede a continuação do programa.

Eventos reportados pelo hardware incluem exceções aritméticas como

2 http://arduino.cc

3 http://www.raspberrypi.org/

8

over/underows

e divisão por zero, instruções que não podem ser decodi-

cadas (que não pertencem ao jogo de instruções do processador), acesso

a posições inválidas de memória, dentre outros.

eventos por meio de interrupções.

O hardware reporta estes

Cada processador tem um conjunto de

eventos que é capaz de monitorar e reportar, denominado

rupções.

vetor de inter-

Cada posição neste vetor dene o evento e o seu conteúdo é

um endereço de memória que contém uma rotina que é invocada assim que

o evento ocorrer.

O processador invoca esta rotina independentemente de

qualquer ação do programa sendo executado. Estas rotinas são denominadas

manipuladores de interrupção.

Um manipulador de interrupção deve realizar

uma ação compatível com o evento reportado. Por exemplo, pode-se denir

um manipulador de interrupções que força o término do programa face à

ocorrência de uma exceção aritmética.

Manipuladores de interrupção muitas vezes necessitam acessar registradores do processador para desempenhar suas funções. Por exemplo, o manipulador de interrupção que termina o programa face a exceções aritméticas

deve acessar o contador de programas para informar qual instrução causou

a interrupção ou, melhor ainda, o registrador de instruções para identicar

qual a operação e operandos que provocaram tal exceção.

Outro conceito importante de hardware para os sistemas operacionais é

o chamado

modo do processador.

Por simplicidade, vamos considerar dois

modos: restrito (ou usuário) e irrestrito (ou supervisor). No modo usuário

algumas instruções, denominadas privilegiadas, são proibidas, o que não

ocorre no modo supervisor.

Instruções privilegiadas incluem desabilitação

de interrupções, manipulação de certos registradores e adição de endereços

de manipuladores de interrupções no vetor de interrupções.

Ao iniciar o

tratamento de interrupções o processador altera o modo de execução para

supervisor. Isto signica que manipuladores de interrupções, por executar no

modo supervisor, têm acesso às instruções privilegiadas. Antes de nalizar,

o manipulador de interrupções pode alterar o modo do processador para

usuário, caso necessário.

A passagem do modo usuário para o modo supervisor se dá quando ocorre:

•

uma interrupção assíncrona, por exemplo, gerada por um periférico de

entrada/saída;

•

uma exceção durante a execução de um programa, por exemplo, exceções ariméticas como divisão por zero;

9

•

um

trap. Traps

são instruções de máquina que alteram o modo do pro-

cessador de usuário para supervisor. Na arquitetura x86 esta alteração

se dá pela instrução INT. Ao ser executada, esta instrução gera uma

interrupção de hardware.

Com os conceitos de interrupções e modos do processador podemos responder a uma importante questão: como o sistema operacional toma conta

do hardware impedindo, por exemplo, que um programa malicioso assuma o

seu controle? A resposta reside em duas ações:

1. Apenas o sistema operacional pode manipular interrupções geradas

pelo hardware.

2. Apenas o sistema operacional (a rigor, uma parte deste) pode executar

em modo supervisor.

Com estas ações um programa do usuário jamais poderá alterar o vetor

de interrupções registrando um manipulador de interrupções próprio pois

este programa jamais executará no modo supervisor.

Desta forma, um

programa do usuário não poderá monopolizar o hardware pois, como veremos

no próximo capítulo, para tal ação ocorrer o programa deverá desabilitar as

interrupções ou tratá-las com seus próprios manipuladores de interrupção.

1.4 Componentes de um sistema operacional

A gura 1.1 ilustra a arquitetura de um sistema operacional. O núcleo do

sistema operacional executa funções de controle direto sobre o hardware,

notadamente tratamento de interrupções e funções básicas de gerência de

recursos (memória, disco, etc.)

e de entrada e saida.

Os processos de

sistema complementam as funcionalidades providas pelo núcleo, por exemplo, fornecendo funções auxiliares de gerenciamento de memória, serviços de

rede, segurança e ambiente gráco. As chamadas de sistema são bibliotecas

para acesso às funcionalidades oferecidas pelo núcleo, detalhadas na próxima

seção.

Podemos identicar quatro subsistemas importantes cujas funções são

desempenhadas pelo núcleo e por processos de sistema:

1. Subsistema de processos.

2. Subsistema de memória.

10

Figura 1.1: Arquitetura típica de um sistema operacional.

3. Subsistema de arquivos.

4. Subsistema de entrada e saida.

Note que os manipuladores de interrupções agem sobre todos estes subsistemas, por exemplo:

•

No subsistema de processos uma interrupção de relógio faz com que o

sistema operacional comute o processo (programa) que detem a posse

da CPU (Unidade Central de Processamento).

•

No subsistema de memória uma interrupção gerada pela CPU pode

indicar que o programa em execução tentou acessar uma região inválida

de memória.

•

No subsistema de arquivos uma interrupção gerada pelo controlador de

acesso direto à memória (DMA -

Direct Memory Access ) pode indicar

que a cópia de um bloco do disco para a memória foi concluída.

•

No subsistema de entrada e saída uma interrupção gerada por um

device driver ) pode indicar que uma operação

acionador de dispositivo (

de entrada e saída foi concluída.

11

1.5 Chamadas de sistema

Para facilitar o processamento, armazenamento e transferência de informação, o sistema operacional deve expor aos programas aplicativos um conjunto

de serviços.

calls ).

Estes serviços são denominados

chamadas de sistema (system

Chamadas de sistema são funções em uma dada linguagem de progra-

mação, usualmente na linguagem C. Estas funções permitem obter serviços

dos subsistemas que compõem um sistema operacional, por exemplo:

•

Iniciar, terminar, suspender e retomar a execução programas aplicativos (subsistema de processos).

•

Alocar, realocar e desalocar segmentos de memória durante a execução

de um programa (subsistema de memória).

•

Criar, renomear e remover arquivos e diretórios (subsistema de arquivos).

•

Ler e escrever dados em arquivos e conexões de rede (subsistema de

entrada e saída).

O que chamadas de sistema têm de especial em relação às funções denidas pelos programas aplicativos? Simplesmente, chamadas de sistema são

executadas em modo supervisor, ou seja, são capazes de executar instruções

privilegiadas do processador, o que não ocorre com as funções denidas pelos

aplicativos.

Chamadas de sistema são consideradas operações de baixo nível de abstração.

Por este motivo, os sistemas operacionais usualmente disponibili-

zam bibliotecas que oferecem funções de mais alto nível que as chamadas

de sistema.

Estas funções são comumente confundidas com chamadas de

sistemas, talvez por terem um correspondência muito próxima em certos

casos. Por exemplo, a chamada de sistema

arquivos, enquanto a função

fprintf

write

da biblioteca

permite escrever bytes em

libc permite escrever dados

formatados em arquivos (números inteiros e em ponto utuante, cadeias de

caracteres e ponteiros).

É usual dizer que um programa que efetua uma chamada de sistema

incorre em um (

trap ).

Isto se dá pelo fato da chamada de sistema executar

a instrução que altera o modo do processador de usuário para supervisor

trap ).

(

O uxo de execução de uma chamada de sistema é dado abaixo:

12

1. O programa do usuário efetua a chamada de sistema (o processador

encontra-se no modo usuário).

2. A interface de chamadas de sistema identica a chamada e armazena

seu índice (número inteiro) em um registrador da CPU. Em seguida

executa um

trap

alterando o modo do processador para supervisor.

3. O tratador de interupção associado ao

trap (código do sistema operara-

cional) busca o índice da chamada no registrador e executa a chamada

de sistema correspondente (em modo supervisor).

4. Quando a chamada de sistema retorna, o tratador de interrupção comuta o modo do processador de supervisor para usuário e retorna.

5. O programa do usuário retoma sua execução em modo usuário como se

tivesse executado uma função de seu próprio código.

Muitas chamadas de sistema são demoradas em comparação com a velocidade da CPU, como no caso de chamadas que efetuam operações de entrada e

saída. Ao efetuar estas chamadas de sistema (ditas bloqueantes) o programa

é bloqueado, ou seja, perde a posse da CPU. A posse da CPU somente será

retomada quando a operação que causou o bloqueio é nalizada. Além da

execução em modo supervisor, a perda da posse da CPU é outro fator que

diferencia as chamadas de sistema das funções do próprio programa.

Os núcleos dos sistemas operacionais atuais possuem duas propriedades:

1. Preempção:

o núcleo é capaz de interromper a qualquer momento

qualquer programa em execução e retomar a CPU para, por exemplo,

proceder a troca de contexto (alocá-la a outro programa).

2. Reentrância: o núcleo é capaz de interromper processos executando em

modo supervisor (ou seja, durante o processamento de uma chamada

de sistema) e retomar para si a CPU.

Reentrância requer chamadas de sistemas reentrantes, ou seja, podem

existir várias cópias da mesma chamada executando independentemente.

Chamadas de sistema reentrantes não devem armazenar estado no seu próprio

código. O estado da execução deve ser armazenado no programa que chamou

a função, por exemplo, na área de pilha do processo, como veremos no

capítulo seguinte.

13

1.6 Sistemas operacionais e linguagens de programação

Um sistema operacional é escrito em uma linguagem de alto nivel e uma

pequena porção em linguagem de montagem do processador sobre o qual

executa. Esta pequena porção refere-se a operações especícas do processador, por exemplo, operações sobre os registradores da CPU, alterar o modo

de execução do processador e desabilitar interrupções.

Tais operações não

são suportadas pela linguagem de alto nível e são necessárias principalmente

no tratamento de interrupções.

Praticamente a linguagem de alto nível empregada no desenvolvimento

de sistemas operacionais é a linguagem C. Esta linguagem é estável, eciente

e portável entre diferentes processadores. Por ter seu código escrito em C, é

natural que a interface para com o sistema operacional (chamadas de sistema)

também seja oferecida nesta linguagem.

Entretanto, funções similares às

chamadas de sistema podem ser oferecidas em outras linguagens tais como

Java, Python e C#. Por serem escritos em C ou C++, os sistemas de

time

run

destas linguagens têm pleno acesso às chamadas de sistema do sistema

operacional e, desta forma, são capazes de oferecer construções de mais alto

nível que as chamadas de sistema.

É o caso, por exemplo, da classe

File

da linguagem Java que oferece métodos para a manipulação de arquivos e

diretórios de forma mais abstrata que as chamadas de sistema do subsistema

de arquivos.

Um caso interessante de sistema operacional que esconde as chamadas

de sistema de baixo nível é o Android [5]. Este sistema é construído sobre

o núcleo do sistema operacional Linux.

máquina virtual Java.

Sobre este núcleo é instalada uma

A máquina virtual Java é um interpretador, mas

não um interpretador direto da linguagem como no caso do interpretador

Python. A máquina virtual interpreta um código intermediário entre o código

fonte e o código executável. Este código, denominado

bytecode, é produzido

pelo compilador Java e interpretado pela máquina virtual Java. A vantagem

deste código intermediário é a portabilidade, pois o mesmo código pode ser

produzido por compiladores distintos e interpretado por máquinas virtuais

Java também distintas.

De volta ao Android, o desenvolvedor para este

sistema operacional manipula apenas as classes Java disponibilizadas pelo

sistema, não interagindo diretamente com as chamadas de sistema oferecidas

pelo núcleo.

14

1.7 Exercícios

1. Explique porque denir sistemas operacionais em termos de hardware,

usuário e aplicativo não é mais apropriado.

2. Quais as características encontradas nos processadores atuais que são

fundamentais para o desenvolvimento de sistemas operacionais?

3. Descreva quatro interrupções que o hardware comumente gera.

4. O que é um vetor de interrupções?

5. Sob que condições o modo do processador muda de supervisor para

usuário?

6. O que é um

trap ?

7. Cite algumas extensões da linguagem C que permitiriam codicar um

sistema operacional integralmente nesta linguagem (sem necessidade de

código em linguagem de montagem do processador).

8. O que as chamadas de sistema têm de especial em relação às funções

denidas em um programa?

9. Sob quais condições é possível trocar o núcleo de um sistema operacional sem afetar os seus demais componentes e aplicativos do usuário?

10. Cite uma maneira pela qual um virus de computador poderia assumir plenamente o controle do hardware. Como o sistema operacional

impede esta situação?

11. As propriedades preempção e reentrância do núcleo estão relacionadas?

Caso estejam, como?

12. É comum programadores utilizarem chamadas de sistema sem vericar

o seu retorno com base no seguinte argumento: como chamadas de sistema são implementadas pelo sistema operacional sua correta execução

é sempre garantida. Você concorda com este argumento? Justique.

13. Muitos super-computadores atuais utilizam o mesmo sistema operacional presente no seu computador pessoal. Como isto é possível?

15

14. Para cada um dos quatro subsistemas de um sistema operacional (processos, memória, arquivos e entrada/saída), forneça um exemplo de

interrupção de hardware que afeta o subsistema.

Descreva também

uma chamada de sistema típica do subsistema.

15. O que acontece se um programa executar um

código?

16

trap

em seu próprio

Capítulo 2

Subsistema de Processos

Neste capítulo apresentaremos processo, um conceito central em sistemas

operacionais.

Um processo é um programa em execução sob controle do

sistema operacional. A estrutura dos processos, seu gerenciamento por parte

do sistema operacional e os mecanismos de comunicação e sincronização

interprocesso são os temas principais abordados neste capítulo.

2.1 Estrutura de um processo

Além de um programa em execução, podemos denir mais precisamente

processo como uma unidade de controle, alocação e compartilhamento de

recursos (CPU, memória, etc.)

processo

•

não

por parte do sistema operacional.

Um

é:

Um programa residente em memória primária ou secundária (disco,

memória USB, etc.) que não iniciou sua execução.

•

Um componente do núcleo do sistema operacional como um manipula-

device driver ).

dor de interrupção ou um acionador de dispositivo (

•

Um componente de software como uma biblioteca ou um

Um processo é também denominado

corrente.

processo sequencial

ou

shell script.

processo con-

O primeiro termo enfatiza a execução de instrução após instrução,

uma por vez, enquanto o segundo enfatiza a execução concorrente (ao mesmo

tempo) de vários processos por parte do sistema operacional.

17

Um sistema

operacional capaz de executar processos de forma concorrente é denominado

sistema

multitarefa.

Inicialmente, vamos considerar que um processo ocupa uma área contínua

de memória. O conteúdo desta área de memória foi preenchido por um software de sistema, o carregador, a partir de um código executável armazenado

em memória secundária, tipicamente disco. Durante o carregamento, o carregador transforma endereços relativos presentes nas instruções de máquina

em endereços absolutos. Endereços relativos são produzidos pelo compilador

e ligador e têm como base o início de um segmento de código.

Endereço

absoluto é um endereço físico na memória.

Um processo em memória pode ser dividido em três áreas (regiões de

memória):

texto, dados e pilha.

A área de texto armazena as instruções

de máquina do programa em execução. A área de dados armazena os dados

manipulados pelo programa. Comumente esta área é dividida em três partes:

1. Data: dados inicializados, por exemplo, a variável k na declaração

int k = 10.

2. Bss (

Block Started by Symbol

- nome histórico): dados não inicializados

no programa que recebem o valor inicial zero quando carregados em

memória, por exemplo o vetor

v

na declaração

oat v[20].

3. Heap: área reservada à alocação dinâmica de memória, por exemplo,

via funções

malloc

em C ou operador

new

em C++.

Convém observar que as áreas de data e bss são estáticas enquanto a

área heap pode crescer durante a execução do programa. Vamos considerar

doravante as áreas data, bss e heap como uma única área de dados.

A área de pilha é necessária durante a chamada de funções.

Nela são

armazenados os parâmetros passados à função e o endereço da próxima

instrução a ser executada quando a função retornar. Esta área também cresce

durante a execução do programa, notadamente durante chamadas recursivas

ou encadeadas de funções.

A gura 2.1 ilustra um processo em memória.

A área sombreada é

reservada ao crescimento das áreas de heap e pilha. A região que o processo

ocupa na memória é denominada

espaço de endereçamento

do processo. Ao

processo é permitido acessar posições de memória apenas neste espaço.

Na realidade, o que a gura 2.1 mostra é um espaço de endereçamento

ctício ou virtual.

Este espaço de endereçamento é grande (por exemplo,

18

Figura 2.1: Estrutura de um processo em memória.

de tamanho 3 Gigabytes) e contínuo. Por ser virtual, o sistema operacional

concede este espaço de endereçamento a cada processo, independentemente

da quantidade de memória física existente no computador. Mas, também por

ser virtual, este espaço de endereçamento não pode ser acessado pela CPU.

O truque, detalhado no capítulo dedicado ao subsistema de memória, é

associar porções do espaço de endereçamento virtual ao espaço de endereçamento físico. Por ora é suciente o seguinte modelo simplicado. Vamos

dividir o espaço de endereçamento virtual e o físico (memória física) em

blocos contínuos de tamanho xo (por exemplo, de 4 KBytes) denominados

páginas.

Vamos agora substituir o espaço de endereçamento virtual por uma

tabela de páginas por processo como ilustra a gura 2.2. Nesta tabela:

•

A i-ésima entrada na tabela corresponde à página virtual

•

Cada entrada na tabela possui um campo com o número da página

i.

correspondente na memória física. Por exemplo, a página

i

do espaço

de endereçamento virtual pode estar associada (mapeada) à página

j

da memória física.

mapeamento

i−j

Nesta gura a ag P (presente) indica que o

é válido.

19

•

Cada entrada na tabela possui também um campo com um conjunto

de ags, indicando, por exemplo, se a região é de leitura apenas, como

á área de texto, ou de leitura e gravação, como as demais áreas do

processo.

Figura 2.2: Mapeamento página virtual - página física por meio da tabela de

páginas por processo.

O processo referencia o espaço de endereçamento virtual. Este endereço

pode ser decomposto em página e deslocamento na página (

oset ).

Por

exemplo, supondo páginas de 4 KBytes, o endereço virtual 8358 corresponte

à página 3 (endereços de 8192 a 12287) e um deslocamento de 166 bytes do

início da página. Ainda neste exemplo, para transformar o endereço virtual

em endereço físico, o hardware determina qual página de memória física a

página 3 do espaço de endereçamento virtual está mapeada, uma simples

consulta à tabela de páginas por processo. Supondo que esta página esteja

mapeada na página 7 do espaço de endereçamento físico, o endereço físico é

28838 (7 × 4096 + 166). Este procedimento é computado para cada instrução

do processo que acessa a memória. Felizmente, esta computação é realizada

com a assistência de hardware dedicado como veremos no capítulo 4.

20

Como temos muito mais memória virtual que física, é natural que apenas

um subconjunto de páginas do espaço de endereçamento virtual estejam

mapeadas em páginas da memória física. Vamos postergar a resolução deste

problema até o capítulo que trata do subsistema de memória.

Por ora,

consideremos que todas as páginas do espaço de endereçamento virtual de

um processo estão mapeadas em páginas da memória física.

A gura 2.3 ilustra como o sistema Linux mantem controle sobre as áreas

de texto, dados e pilha dos processos.

As áreas (regiões contínuas) que

um processo utiliza em seu espaço de endereçamento virtual é identicada

por uma estrutura de dados tipo lista ligada denominada

vm_struct_area.

Esta estrutura aponta para o início e m de de uma região, ags relativos a

região (por exemplo, permissões) e ponteiro para a estrutura que identica

a próxima região. Cada página virtual destas regiões são mapeadas nas suas

respectivas páginas físicas por meio da tabela de páginas por processo.

Figura 2.3: Manutenção das áreas de memória de um processo no Linux.

21

Esta breve introdução à tecnica de memória virtual é necessária para

entendermos a criação de processos e o compartilhamento de memória por

processos distintos.

2.2 Criação de processos

O gerenciamento de processos por parte do sistema operacional compreende

atividades relacionadas ao ciclo de vida de um processo, deste a sua criação

até o seu término, passando por sua execução.

Um processo sofre ações

de gerenciamento iniciadas pelo núcleo do sistema operacional ou por outro

processo em execução, neste caso via chamadas de sistema. Exemplo de ação

iniciada pelo nucleo é a mudança de contexto. Exemplo de ação iniciada por

um processo é a criação de um novo processo.

O sistema operacional mantém as informações necessárias para gerenciar

os processos em uma tablela, a tabela de processos. Cada processo possui

uma entrada nesta tabela que armazena os recursos utilizados pelo processo

tais como arquivos abertos, memória utilizada, tempo de uso da CPU, etc.

Processos são criados via chamadas de sistemas especícas, por exemplo,

exec no Linux e createProcess no Windows.

Usualmente estas chamadas rece-

bem o nome do arquivo executável e os parâmetros a serem passados à função

main, pela qual o programa inicia sua execução.

A chamada

exec 1

o programa que a chamou por outro especicado na chamada.

substitui

O sistema

operacional utiliza a mesma entrada na tabela de processos e a mesma tabela

de páginas por processo do processo original.

Portanto, o novo processo

possui o mesmo identicador de processo e recursos atribuídos ao processo

original, por exemplo, arquivos abertos, prioridade, etc. Entretanto, o novo

processo não tem como recuperar estes recursos, por exemplo, o descritor

createProcess, ao

exec, cria um processo novo, preservando o processo que efetuou

de um arquivo aberto pelo processo original. A chamada

contrário de

a chamada. Neste caso é criada uma nova entrada na tabela de processos e

uma nova tabela de páginas para o novo processo.

Outra forma de criar um processo é via clonagem.

A chamada

fork,

presente desde as primeiras versões do Unix, efetua as seguintes operações:

•

Cria uma nova entrada na tabela de processos para o novo processo

(denominado processo lho). Copia o conteudo da entrada da tabela

1 Na

realidade exec é uma família de chamadas cada qual com parâmetros diferentes.

22

de processos do processo que efetuou a chamada (denominado processo

pai) para a entrada correspondente ao processo lho.

•

Cria uma nova tabela de páginas por processo para o processo lho.

Copia as entradas da tabela de páginas do processo pai para as entradas

correspondentes ao processo lho.

•

Marca uma ag nas tabelas de páginas dos processos pai e lho como

copy-on-write

(CoW).

A gura 2.4 ilustra a criação de um processo via chamada

Figura 2.4: Criação de processos via chamada

fork.

fork.

O processo lho compartilha o espaço de endereçamento virtual do processo pai e, portanto, herda todo o seu histórico de execução presente em suas

áreas de texto, dados e pilha. Entretanto, a partir do retorno da chamada

fork

temos dois processos idênticos, exceto pelo fato que o retorno da chamada

no pai é o identicador de processo lho e no recém criado processo lho a

chamada retorna um identicador nulo.

Apesar do processo lho ser criado idêntico ao processo pai, ambos podem

seguir caminhos de execução independentes.

Neste caso, a alteração de

uma variável pelo processo pai não deve ser visível ao processo lho e vice-

copy-on-write. Ao acessar uma

página para escrita o hardware verica se a ag copy-on-write está ativado.

versa.

Como isto é garantido?

Pela ag

23

Caso esteja, é gerada uma interrupção e o sistema operacional desmembra a

página. O sistema operacional aloca uma nova página na memória física (não

mapeada ainda), copia o conteúdo da página a ser desmembrada para esta

nova página e refaz o mapeamento conforme ilustrado na gura 2.5. Após

o desmembramento, ambas as páginas têm a ag

copy-on-write

ressetada.

Agora a escrita é realizada apenas na página que foi desmembrada.

Figura 2.5: Desmembramento da página física

i

j após escrita na página virtual

do processo lho (veja gura 2.4).

Para se atingir um comportamento similar à chamada

createProcess

do

Windows, nos sistemas Unix é comum empregar-se uma combinação das

fork e exec, esta invocada no processo lho logo após o retorno da

chamada fork. Neste caso é recomendado o uso da chamada vfork. vfork é

similar à chamada fork exceto que as tabelas de páginas dos processos pai

e lho não são copiadas nem marcadas como copy-on-write. Isto evita uma

chamada

série enorme de desmembramentos de páginas durante o carregamento do

exec já que todas as páginas do processo lho serão

sobrescritas com o carregamento do novo processo. A chamada vfork mantém

novo processo na chamada

a tabela de páginas do processo pai intacta e ativa uma ag nas entradas da

tabela de páginas do processo ho marcando-as como não mapeadas (ag

A - ausente). Isto signica que quando estas páginas forem acessadas pelo

processo criado por

exec

o sistema operacional deve mapeá-las em páginas

novas da memória física e copiar o conteúdo relativo à esta página a partir

do do código executável.

Fica aqui uma observação pouco intuitiva:

24

um

programa pode iniciar sua execução com o carregamento de uma única página

na memória, a que contém o início da função

main.

A gura 2.6 ilustra a criação de um processo via chamada

quadro 2.1 ilustra o uso desta chamada.

Figura 2.6: Criação de processos via chamada

25

vfork.

vfork

e o

Quadro 2.1: Chamada de sistema

vfork.

i n t pid = v f o r k ( ) ;

i f ( pid == 0) {

// p r o c e s s o f i l h o

execve (" novo_prog " , NULL, NULL) ;

p r i n t f (" Erro −− execve nao p o d e r i a r e t o r n a r " ) ;

}

// f l u x o normal do p r o c e s s o p a i

2.3 Troca de contexto

O gerenciamento de processos tem como meta garantir que os processos evoluam. Para tanto, o sistema operacional deve alocar os recursos necessários

à execução dos processos. Portanto, a alocação de recursos é uma atividade

central no gerenciamento de processos, notadamente os recursos de processamento (CPU) e armazenamento primário (memória). O compartilhamento

de CPU demanda um procedimento denominado

troca de contexto.

Vamos iniciar com um sistema operacional capaz de executar um único

programa por vez, como o antigo MS-DOS. No interpretador de comandos

(interface de texto do sistema operacional) o usuário digita o nome do programa. O sistema operacional invoca o carregador passando o endereço de

memória a partir do qual o programa será carregado. Efetivado o carregamento, o sistema operacional atualiza o contador de programa para a primeira

execução do programa carregado e transfere esta primeira instrução para

o registrador de instruções, iniciando o ciclo busca-decodicação-execução

de instruções, até o programa terminar.

Com o termino do programa, o

interpretador de comando espera a próxima ação do usuário.

este modelo se presta a um sistema operacional

monotarefa.

Obviamente

Vamos agora considerar um sistema multitarefa como os atuais. Uma primeira estratégia seria executar os programas na sua integridade, em sequência, como nos antigos computadores

mainframes.

Entretanto, o que acontece

se um program não termina, por exemplo, na presença de erros como um laço

innito.

Nos

mainframes

o operador humano abortava este programa e o

próximo iniciava sua execução. Mesmo considerando que todos os programas

terminem em um tempo nito, surgiram dois tipos de programas ausentes

na era dos

•

mainframes :

Programas servidores que executam permanentemente a espera de re-

26

quisições.

•

Programas interativos que devem responder de pronto às ações do

usuário.

Para estes tipos de programa, os sistemas operacionais multitarefa são

capazes de executar os programas um pouquinho por vez (durante algumas

dezenas de milisegundos).

temporal da CPU, ou

Esta técnica é denominada compartilhamento

time sharing.

O sistema operacional aloca a CPU

para um processo durante um determinado tempo e, expirado este tempo,

aloca a CPU para outro processo.

processo é denominado

quantum

O tempo que a CPU é alocada a um

de CPU e a troca de um processo por outro

é denominada troca de contexto. Neste esquema, o sistema operacional não

aloca a CPU para processos que não tem tarefa a realizar no momento, por

exemplo, um servidor sem requisições para atender.

Como o compartilhamento temporal é realizado pelo sistema operacional?

Resposta, via interrupções. Vamos considerar que o quantum de CPU acabou

de expirar para o processo

Pi .

Neste momento acorre uma interrupção de

relógio que será tratada pelo sistema operacional (lembremos que somente

o sistema operacional tem o poder de tratar interrupções de hardware). O

manipulador de interrupções de relógio inicialmente salva o estado da CPU

(contexto do processo) na entrada correspondente da tabela de processos.

Este estado é composto dos registradores da CPU, incluindo o contador de

Program Status Word ).

programa e PSW (

A seguir o sistema decide qual

processo deve assumir a CPU. Esta decisão é denominada

processos

escalonamento de

e será detalhada na seção 2.4. Escolhido o processo

Pj ,

o sistema

operacional carrega a partir da tabela de processos o contexto deste processo

(salvo no momento em que

Pj

perdeu a posse da CPU da última vez).

O

sistema operacional programa o relógio para gerar uma interrupção daqui a

um quantum de tempo e desvia a execução para a instrução apontada pelo

contador de programa.

Neste momento o programa que retomou a CPU

inicia sua execução exatamente do ponto em que estava quando a perdeu.

Note que para o processo

Pj

é como se o tempo tivesse parado entre a perda

e a retomada da CPU. A gura 2.7 ilustra o esquema de compartilhamento

temporal da CPU.

Durante a posse da CPU por um processo, alguns eventos podem ocorrer.

O processo pode terminar, executar uma instrução ou operação ilegal, ou

efetuar uma chamada de sistema bloqueante. O término de um processo se

dá por uma chamada de sistema (a chamada

27

exit ), invocada explicitamente

Figura 2.7:

Time sharing

entre os processo

Pi

e

Pj .

main ).

pelo programador ou implicitamente pelo retorno da função principal (

Portanto, a implementação da chamada

exit

inicia a troca de contexto, além

de outras ações tais como atualização da tabela de processos, liberação de

páginas de memória ocupadas pelo processo, liberação de recursos mantidos

pelo processo tais como arquivos abertos, conexões de rede, dentre outros.

Uma instrução ilegal (não suportada pelo processador) ou a execução de

uma operação ilegal tal como uma divisão por zero ou ainda um acesso à

uma região de memória fora do espaço de endereçamento do processo causa

uma interrupção de hardware. O tratamento desta interrupção usualmente

força o término do processo, com ações similares às descritas para a chamada

exit.

O caso mais interessante é quando o processo efetua uma chamada de

sistema bloqueante, por exemplo, uma chamada para ler dados de um arquivo

em disco (chamada

read ).

Por ser uma chamada de sistema, o sistema

operacional verica se a chamada é bloqueante ou não. Esta decisão depende

do tempo para completar a chamada. Por exemplo, a chamada

read, pode ser

bloqueante ou não. Se o dado a ser lido do disco já estiver em memória (como

veremos no capítulo referente ao subsistema de entrada e saída) a chamada

é considerada não bloqueante. Se o dado necessita ser acessado do disco, a

chamada é considerada bloqueante. Neste caso o processo perde a posse da

CPU para evitar que a mesma que ociosa até a informação ser acessada (o

que provavelmente ocorreria após o término do quantum para este processo).

Assim podemos visualisar três estados para um processo (Figura 2.8):

1. Em execução: o processo está de posse da CPU executando suas instruções ou chamadas de sistema não bloqueantes.

28

2. Bloqueado: o processo efetuou uma chamada de sistema bloqueante e

está aguardando a conclusão da operação que causou o bloqueio para

prosseguir sua execução.

3. Pronto: o processo está apto a retomar a CPU, dependendo apenas de

sua escolha por parte do sistema operacional.

Figura 2.8: Estados de um processo e eventos que causam as transições de

estado.

Como o processo transita do estado de bloqueio para pronto?

mente, via o tratamento de interrupções.

Nova-

Operações de entrada e saída

são programadas em hardware (usualmente por meio de DMA) e, quando

concluída, o hardware gera uma interrupção.

Por exemplo, o controlador

de DMA gera uma interrupção assim que um dado do disco foi copiado

para uma área de memória.

o processo seja desbloqueado.

O tratamento desta interrupção faz com que

Na tabela de processos são armazenados os

eventos (interrupções) que o processo está aguardando para ser desbloqueado.

2.4 Escalonamento de processos

Escalonamento de processos é uma decisão que retorna qual processo, dentre

os processos prontos, deve ter a posse da CPU. Esta decisão deve ser rápida

pois é efetuada a cada troca de contexto. Uma estratégia simples, caso não

hajam processos interativos ou servidores, é manter os processos prontos

em uma la. O primeiro processo da la é escolhido e, após consumir seu

29

quantum de tempo e perder a posse da CPU, o processo é deslocado para a

nal da la. Esta estratégia de escalonamento é denominada

round robin

e

foi utilizada nos primeiros sistemas multitarefa.

2.4.1 Processos interativos e servidores

Processos interativos passam a maior parte do tempo bloqueados aguardando

uma ação do usuário como pressionar uma tecla ou clicar o mouse.

En-

tretanto, assim que a ação for realizada, o processo deve assumir a CPU

prontamente, de preferência já no próximo quantum. Isto para propiciar uma

resposta rápida à ação do usuário tal como ecoar a tecla pressionada ou mover

o ponteiro do mouse na tela.

Processos servidores também permanecem

bloqueados até que uma requisição seja recebida.

Também neste caso, a

requisição deve ser processada o quanto antes.

Uma estratégia de escalonamento que privilegia processos interativos e

servidores é empregar múltiplas las, atribuindo-se a cada la uma prioridade. Um percentual do tempo da CPU é dedicada aos processos na la de

acordo com a prioridade da la, quanto maior a prioridade maior o percentual

da CPU atribuido aos processos da la. A gura 2.9 ilustra este esquema.

Figura 2.9: Escalonamento com múltiplas las.

A estratégia de múltiplas las opera da seguinte maneira.

Quando um

processo passa do estado de bloqueado para o estado de pronto o sistema

operacional analisa o evento que causou a transição.

O tipo de evento dá

uma boa idéia do tempo que o processo cou no estado de bloqueado, por

30

exemplo, uma espera por entrada do usuário é bem mais longa que uma

espera por uma leitura do disco. Com base no evento, o sistema operacional

adiciona o processo em uma dada la de prioridade. Quanto maior a espera

maior a prioridade da la que o processo será inserido, ou seja, processos que

não consumiram tempo de CPU no passado recente, têm maior prioridade.

Toda a informação necessária para se determinar qual la um processo pronto

está disponível na tabela de processos.

Obviamente, um processo que está em uma la de alta prioridade não deve

permanecer nesta la indenidamente. Caso o processo bloqueie novamente,

o problema está resolvido pois ele sairá da la até se tornar pronto novamente.

Mas, e se o processo após bloquear uma vez não bloqueia mais? A estratégia

de múltiplas las, da mesma forma que privilegia processos que não consumiram CPU recentemente, penaliza os processos que a consumiram. Desta

forma, os processos são deslocados para uma la de menor prioridade de

acordo com a quantidade de CPU que consumiram recentemente. Esta mudança de la é realizada periodicamente (este período é denominado época).

Dado que a prioridade dos processos variam com o tempo, esta prioridade é

denominada prioridade dinâmica.

2.4.2 Processos de tempo real

Processos de tempo real são aqueles que desempenham tarefas que exigem

certa previsibilidade, por exemplo, tempo máximo de acesso à CPU quando

se tornam prontos, tempo máximo para realizar uma tarefa antes de bloquear,

etc. Exceto em sistemas operacionais projetados para aplicações de tempo

real, processos de tempo real convivem com outros tipos de processos.

Entretanto, processos de tempo real devem ter tratamento especial por parte

do escalonador. A estratégia comumente empregada para o escalonamento de

processos de tempo real é baseada em prioridades estáticas. Estas prioridades

podem ser atribuídas apenas a processos executando com privilégio de superusuário. Uma prioridade estática é maior que qualquer prioridade dinâmica.

O sistema operacional mantém processos de mesma prioridade estática em

las correspondentes a esta prioridade. Uma la de dada prioridade estática

é servida apenas quando as las de prioridade superior estiverem vazias (ou

seja, todos os processos nestas las superiores terminaram ou bloquearam).

Processos de prioridade dinâmica são escalonados apenas quando todas as

las de prioridade estática estiverem vazias, ou seja, quando não existe

processo de tempo real pronto.

No escalonamento por prioridades, assim

31

que um processo de prioridade mais alta em relação àquele que tem a posse

da CPU torna-se pronto, o sistema operacional realiza a troca de contexto

imediatamente a m de que o processo de mais alta prioridade assuma a CPU

de imediato. Esta tomada da CPU antes do quantum expirar é denominada

preempção.

O sistema Linux oferece duas opções para a manipulação das las de

prioridade estática:

•

FIFO (

First In First Out ):

um processo que assume a CPU é executado

até bloquear, mesmo que haja outros processos prontos em sua la de

prioridades.

•

Round Robin ): processos nas la de prioridade são escalonados por

Round Robin, ou seja, após executar um quantum de CPU, o processo

RR (

é posicionado no nal de sua la de prioridade e o primeiro processo

da la terá a posse da CPU.

Conforme mencionado anteriormente, atribuir prioridades estáticas e denir como as las de prioridade estática serão manipuladas (FIFO ou RR)

exige que o processo execute com privilégio de super-usuário.

Linux estas operações são realizadas com a chamada

No sistema

sched_setscheduler.

No

manual desta chamada há um conselho sábio: Como um laço innito em

um processo de tempo real escalonado com FIFO ou RR bloqueará todos os

processos de menor prioridade, um desenvolvedor de software deve sempre

manter disponível um interpretador de comandos com prioridade estática

mais alta que a aplicação em teste. Isto permitirá um término forçado da

aplicação de tempo real que não terminou ou bloqueou como o esperado.

É importante notar que o escalonamento por prioridade estática apenas

não garante as restrições de tempo real impostas pelos sistemas físicos serão

atendidas pelo sistema operacional.

Da parte do sistema operacional, o

problema da inversão de prioridades deve ser equacionado (seção 2.6.3).

Da parte do desenvolvedor de software, algumas ações relacionadas com o

gerenciamento de

threads

e com o gerenciamento de memória devem ser

observadas. Estes ações serão detalhadas nos capítulos subsequentes.

2.5 Sinalização de processos

A sinalização de processos é um mecanismo por meio do qual processos são

noticados da ocorrência de eventos gerados pelo núcleo do sistema opera-

32

cional ou por outros processos. Exemplos de tais eventos incluem exceções

aritméticas, requisições de mudança de estado (suspenção da temporária da

execução, por exemplo) e noticação de falhas de hardware. Processos podem

denir funções para o tratamento de cada evento sinalizado denominadas

manipuladores de sinais.

A base deste mecanismo de noticação são os

sinais.

Um sinal pode

ser entendido como uma interrupção gerada por software. O próprio sistema

operacional faz uso de sinais para informar aos processos a ocorrência de eventos. Nos sistemas Unix estes eventos são identicados por números inteiros

positivos denidos como constantes (em letras maiúsculas), por exemplo:

•

SIGCHLD: informa ao processo pai o término ou suspensão de um

processo lho.

overow ).

•

SIGFPE: exceção aritmética (divisão por zero,

•

SIGSEGV: exceção de segmentação (tentativa de acesso à posição de

memória fora de seu espaço de endereçamento).

•

SIGTRAP: informa que um

breakpoint

de depuração foi atingido.

Para o envio de sinais a partir de um processo utiliza-se uma chamada

de sistema, por exemplo, a chamada

kill

do Unix. Esta chamada, apesar do

nome, não necessáriamente causa o término forçado (morte) do processo. Os

sinais que podem ser gerados por processo incluem:

•

SIGKILL: termina o processo.

•

SIGSTOP: suspende (bloqueia) a execução de um processo.

•

SIGCONT: retoma a execução de um processo.

•

SIGINT: interrupção gerada pelo teclado (control-C).

Para cada sinal é denida uma ação padrão para o processo que recebeu

o sinal. Para os sistemas Unix as ações são:

• abort :

termina o processo gerando um mapa de mapa de memória (

dump ) para ns de depuração.

• exit :

termina o processo sem gerar o mapa de memória.

33

core

• ignore :

• stop :

ignora o sinal.

suspende a execução do processo.

• continue :

retoma a execução do processo.

Com o uso de sinais um processo pode terminar, bloquear e retomar

(tornar pronto) outros processos, dependendo de permissões. Processos com

permissão de super-usuário são capazes de sinalizar qualquer processo enquanto processos com permissão de usuário comum são capazes de sinalizar

apenas processos de seu grupo (tipicamente processos que pertencem ao

mesmo usuário).

Ao receber um sinal a ação padrão é executada pelo sistema operacional, a

menos que o processo dena um manipulador de sinal (não confundí-los com

os manipuladores de interrupção do sistema operacional). O manipulador de

sinal é uma função invocada assincronamente para o processo. O processo

retoma seu uxo normal de execução quando o manipulador de sinal retornar.

Quando um sinal é enviado a um processo, o mesmo é armazenado na entrada

deste processo na tabela de processos.

O manipulador para este sinal é

invocado nos seguintes instantes em que o sistema operacional tem a posse

da CPU:

•

o processo retorna da execução em modo usuário após terminar uma

chamada de sistema;

•

imediatamente antes do processo de iniciar uma chamada de sistema;

•

quando o processo iniciar um novo quantum de CPU.

Nota-se pelos momentos acima que, contrário às interrupções de hardware, interrupções de software (sinais) não são tratadas de imediato. Nem

todos os sinais podem ser tratados, por exemplo o sinal SIGKILL. Outros, mesmo que tratados, podem causar um comportamento imprevisível ao

processo, por exemplo os sinais SIGFPE (exceção aritmética) e SIGSEGV

(exceção de segmentação).

Um manipulador de sinal é uma função que

recebe um inteiro e nada retorna (void). A incorporação de um manipulador

ao processo se dá com a chamada

signal

que recebe o número do sinal

e um ponteiro para a função de manipulação do sinal.

Por exemplo, o

quadro 2.2 ilustra um programa que solicita uma conrmação quando recebe

uma interrupção de teclado (SIGINT gerado por control-C).

34

Quadro 2.2: Exemplo de manipulador de sinal.

#i n c l u d e <s i g n a l . h>

void confirma ( i n t i ) {

p r i n t f ("Tem c e r t e z a que quer t e r m i n a r [ s /n ] ? " ) ;

i f ( g e t c h a r ( ) == ' s ' ) e x i t ( 0 ) ;

}

main ( ) {

s i g n a l ( SIGINT , confirma ) ;

...

}

// a s s o c i a manipulador ao s i n a l

Duas observações quanto a sinais são importantes para o desenvolvedor

de sistemas de software:

1. Em alguns sistemas a manipulação de sinais não é recursiva, ou seja, se

durante a manipulação de um sinal outro sinal for recebido, o sistema

operacional executará a ação padrão para o novo sinal.

2. Chamadas de sistema bloqueantes podem ser interrompidas por sinais.

Por exemplo, suponha um processo servidor aguardando uma conexão

de rede (bloqueado na chamada

accept ).

Se um processo lho terminar

o sistema operacional irá enviar ao processo o sinal SIGCHLD que fará

com que a chamada

accept

retorne um erro (-1). O sistema operacional

interrompe a chamada de sistema para dar chance ao processo de tratar

o sinal.

Devido à primeira observação, diz-se que o mecanismo de sinais é não

conável caso o sistema operacional não utilize recursaão no tratamento de

sinais.

De fato, ao executar a ação padrão, pode ocorrer duas situações

altamente indesejáveis para o processo que recebeu sinais em sequência. A

primeira é o término do processo se a ação padrão for esta como no caso do

sinal SIGINT. A segunda é a perda do sinal se a ação padrão for ignorar o

sinal como no caso de SIGCHLD.

Devido à segunda observação, o desenvolvedor de sistema deve sempre

vericar se o erro retornado por uma chamada de sistema foi causado por

uma interrupção. No Unix, basta vericar se o valor da variável global

errno

é a constante EINTR. Se for, a chamada de sistema deve ser repetida.

variável

errno

A

fornece o motivo que causou a falha em chamadas de sistema.

35

2.6 Comunicação e sincronização interprocesso

Comunicação e sincronização interprocessos são facilidades oferecidas pelo

sistema operacional para que processos possam cooperar, trocando informações e sincronizando suas ações. Comunicação e sincronização são necessárias

quando uma aplicação é composta de vários processos, estrutura esta utilizada pelo próprio sistema operacional.

2.6.1 Comunicação interprocesso

Como dois ou mais processos podem trocar informação?

Existem basica-

mente duas possibilidades. A primeira emprega meios diretamente disponíveis às aplicações tais como arquivos em disco e banco de dados. A segunda

emprega mecanismos nativos de comunicação interprocesso oferecidos pelo

sistema operacional por meio de chamadas de sistema. Os mecanismos nativos mais comuns são troca de mensagens e compartilhamento de memória.

Troca de mensagens pode se dar por meio de um canal de comunicação

estabelecido entre dois processos ou por meio de las de mensagens instaladas

pelos processos. Um canal de comunicação deve ser estabelecido por ambos

os processos e permite que um processo escreva dados (cadeia de bytes) no

canal e outro processo leia estes dados do canal.

O mecanismo de

pipe,

oferecido por vários sistemas operacionais, permite estabelecer este canal de

comunicação entre dois processos (tipicamente entre processos pai e lho).

A escrita e leitura de dados no canal se dá por meio das chamadas padrão

write e read.

O mecanismo de

pipe

é mais comumente empregado em comandos pro-

cessados pelo interpretador de comandos. O interpretador de comandos cria

pipe

um

conectando a saída padrão de um processo com a entrada padrão

de outro processo por meio da barra vertical. Por exemplo, o comando

ls

|

grep "*.pdf"

faz com que a saída padrão produzida pelo comando

(listagem de diretório) seja a entrada padrão do comando

grep

ls

que, neste

exemplo, listará apenas as linhas que contenham a sequência .pdf .

Filas de mensagens são buers alocados pelo sistema operacional aos

processos e identicados unicamente no sistema por meio de um identicador

numérico.

Conhecendo o identicador de uma la de mensagem de outro

processo, um processo pode enviar uma mensagem (cadeia de bytes) para

esta la. O envio e recuperação de mensagens se dá por meio de chamadas

de sistema especícas tipo

send e receive.

36

Atualmente, aplicações que utilizam troca de mensagens comumente em-

sockets. sockets são canais

sockets tipo

via rede (sockets tipo INET).

pregam as chamadas de sistema denominadas

de comunicação que interligam processos na mesma máquina (

UNIX) ou em máquinas distintas conectadas

Sockets

tipo UNIX empregam o próprio sistema de arquivo para armazenar

temporariamente as mensagens trocadas entre os processos.

O compartilhamento de memória se dá quando uma área de memória

alocada pelo sistema operacional é incorporada à área de dados de dois ou

mais processos como ilustrado na gura 2.10.

Neste caso dois processos

possuem entradas na tabela de páginas por processo mapeadas na mesma

página de memória física sem a marcação

copy-on-write.

Figura 2.10: Compartilhamento de memória: páginas virtuais

P1

e

j

do processo

P2

mapeadas na mesma página física

i

do processo

k.

Se troca de mensagens é uma comunicação do tipo um-para-um, memória

compartilhada é do tipo um-para-muitos no sentido que um dado armazenado por um processo pode ser acessado por vários outros processos.

A

comunicação por troca de mensagens pode ser síncrona no sentido que um

processo pode bloquer até que uma mensagem seja enviada a ele. Memória

compartilhada é uma comunicação sempre assíncrona, ou seja, processos

nunca bloqueiam no acesso à memória compartilhada.

Para operar memória compartilhada o sistema operacional oferece chamadas de sistema para alocar um bloco de memória compartilhada e associar

este bloco ao espaço de endereçamento de processos. Como no caso de la

de mensagens, um bloco de memória compartilhada alocado pelo sistema

37

operacional possui um identicador único no sistema. Após incorporada ao

espaço de endereçamento do processo, a memória compartilhada pode ser

operada como uma área de memória do próprio processo, por exemplo, via

memcpy ), operação com ponteiros, etc.

cópia binária (

2.6.2 Sincronização interprocesso

Não raro processos devem tem suas ações sincronizadas.

É o caso, por

exemplo, de processos que operam sobre um mesmo recurso, seja um arquivo

em disco, um dispositivo de entrada e saída ou uma estrutura de dados em

uma região de memória compartilhada.

O compartilhamento temporal da

CPU garante a integridade dos processos mas não garante a integridade dos

recursos manipulados concorrentemente pelos processos.

Para ilustrar isso

vamos considerar dois processos como na Figura 2.11 onde o processo

P1

(produtor) captura imagens de uma câmera e as armazena em um buer

em memória compartilhada. Um processo

P2

(consumidor) lê este buer e

apresenta a imagem após algum processamento.

Figura 2.11: Arranjo produtor-consumidor.

Neste exemplo as operações de escrita e leitura no buer devem ser

sincronizadas sob pena de processo

P1

cópia da imagem no buer e o processo

apenas em parte.

perder a CPU antes de completar a

P2

ler todo o buer, este autualizado

Esta competição pelo recurso, denominada

corrida (reace condition ), pode tornar seu estado inconsistente.

condição de

Condições de

corrida podem ser evitadas operando o recurso compartilhado atomicamente

com o auxílio de técnicas de sincronização.

Esta sincronização é feita via a introdução de um conceito denominado

região crítica.

Uma região crítica é um trecho de código que protege um

recurso compartilhado. Regiões críticas protegendo um mesmo recurso compartilhado têm a propriedade de exclusão mútua, ou seja, um único processo

38

pode estar executando a região crítica em um dado instante de tempo.

Regiões críticas são delimitadas por um protocolo de entrada na região e um

protocolo de saída da região. Estes protocolos, implementados em chamadas

de sistema, apresentam as seguintes propriedades:

•

O protocolo de entrada, quando retorna, garante que nenhum outro

processo está executando uma região crítica protegendo o mesmo recurso compartilhado.

•

O protocolo de entrada bloqueia o processo até que a condição anterior

seja satisfeita. Este bloqueio não pode durar indenidamente.

•

O protocolo de saída nunca bloqueia o processo que o invocou.

Uma questão crucial é porque os protocolos de entrada e saída devem

ser implementados na forma de chamadas de sistema, e não funções comuns.

A razão é que, para garantir as propriedades acima, os protocolos de entrada e saída devem executar atomicamente. Imagine que um processo

P1

executando um procedimento de entrada perca a CPU no momento em que

verica que acesso é possível, mas antes que possa atualizar as estruturas de

dados indicando que este processo ingressará na região crítica. Suponha que

um processo

P2

assuma a CPU e execute integralmente o mesmo protocolo

de entrada e ingressa na região crítica, perdendo a CPU no interior da

mesma.

Ao retomar a CPU o processo

P1

completa o procedimento de

entrada e ingressa na região crítica, violando a propriedade de exclusão

mútua. Isto pode ser evitado desabilitando interrupções durante a execução

dos protocolos de entrada e saída da região critica. Entretanto, lembremos

que somente o sistema operacional pode desabilitar interrupções.

Desta

forma, a única maneira segura de implementar protocolos de entrada e saída

de regiões críticas é via chamadas de sistema.

Existem várias propostas de protocolos de entrada e saída de regiões

críticas, mas apenas um teve ampla aceitação: o protocolo de semáforos. O

protocolo de semáforos foi concebido por Edsger Dijkstra, um dos maiores

cientistas da computação de todos os tempos. Dijkstra chamou o protocolo

de entrada na região crítica de

P

e o protocolo de saída de

V.

Um semáforo é uma estrutura de dados mantida pelo sistema operacional

com um contador

c e uma lista b com identicadores de processo bloqueados

como ilustrado no quadro 2.3.

39

Quadro 2.3: Estrutura de dados de um semáforo.