Process of Knowledge Discovery in Databases to Decision-Making System

Sonia Kaoru Shiba (Escola Politécnica, Universidade de São Paulo, São Paulo,

Brasil) – [email protected]

Francisco Javier Ramirez Fernandez (Escola Politécnica,Universidade de São

Paulo, São Paulo, Brasil) – [email protected]

This paper presents the result obtained with a process of knowledge discovery as

an auxiliary base to a Decision-Making System. The work approaches the viability

of helping process of knowledge discovery in companies where the strategy of

extraction is not automated. Additionally, the knowledge discovery process is

discussed from a perspective of data mining technologies of information and

pattern evaluation, in order to facilitate the application of knowledge for specialist

systems. The process of extraction applied is divided in three main stages

including the pre-processing, the data mining of information and the posprocessing. A set of essential activities are applied, inside a flow of interactive and

iterative work in each of these stages. Information data mining justifies itself by the

relevance of choosing the technologies more suitable and adherent to the problem

domain of the importance of methodologies, the organization of tasks in the data

mining and the disponibilization of the results for a final user. The experiments for

the extracion of the knowledge were applied to optimize processes in which the

manegement activities choose for the storage of a large amount of information,

and where the technologies of information analysis are still focused on the profile

of some specialists with restrictions of time and cost. A case was analyzed by a

bayesian classifier as a tool for the risk analysis, by means of the total number of

contracted insurances and the declared disasters.

Keywords: Knowledge Discovery in Databases, data mining, classification,

predictive model, probabilistic reasoning, Naïve Bayes

3882

Extração de Conhecimento para Sistemas de Apoio à Decisão

Este trabalho apresenta os resultados obtidos com a elaboração de um Processo

de Extração de Conhecimento a partir de Bancos de Dados, para formar uma

base auxiliar a Sistemas Especialistas de Apoio à Decisão. O trabalho aborda a

viabilidade da implementação de processos de extração de conhecimento em

empresas cujas estratégias de extração não estão automatizadas. Além disso,

discute-se o direcionamento do processo de extração do conhecimento para

técnicas de mineração de dados e avaliação de padrões, com o objetivo de

facilitar o emprego das bases de conhecimento por sistemas especialistas. O

processo de extração aplicado é divido em três etapas principais: o préprocessamento, a mineração de dados e o pós-processamento, sendo que em

cada uma dessas etapas, um conjunto de atividades essencias é aplicado, dentro

de um fluxo de trabalho interativo e iterativo. Na etapa de mineração de dados,

discute-se a importância de se avaliar as técnicas mais adequadas e aderentes

ao domínio do problema, a importância das metodologias, a organização de

tarefas de mineração e a disponibilização dos resultados para o usuário final. Os

experimentos para a extração de conhecimento foram aplicados para otimizar

processos onde as atividades organizacionais optam pelo armazenamento de

uma grande quantidade de dados, e onde as técnicas de análise de dados ainda

estão concentradas no perfil de alguns especialistas do domínio, com restrições

de prazo e custo. Como estudo de caso se adotou um classificador bayesiano

como uma ferramenta para a análise de risco, utilizando como fontes de dados

os registros de apólices de seguros emitidas e os respectivos registros de

sinistros.

1- Introdução

Uma mudança cultural na composição dos elementos essenciais para o

processo de decisão têm orientado a busca e a utilização de ferramentas de

apoio. Os processos decisórios oriundos de práticas com pouco embasamento

vem sendo sistematicamente abandonados pelas corporações. Além disso, a

automatização de muitas atividades organizacionais, através de softwares, e a

diminuição dos custos de armazenamento de dados facilitaram o acesso à

informação confiável de forma consideravelmente rápida (Berry & Linoff, 2004).

No início da década de 80, o desenvolvimento dos primeiros sistemas de

gerencimento de banco de dados relacionais permitiu gerar modelos de dados e

implementá-los em uma estrutura organizada de informações, garantindo um

melhor desempenho nas operações relacionadas ao manuseio dos dados

(Fayyad, Piatetsky-Shapiro & Smyth, 1996).

Nesse cenário recente, onde as limitações físicas no armazenamento

de dados foram consideravelmente minimizadas, houve um grande impulso no

desenvolvimento de softwares de suporte às atividades corporativas em diversas

áreas, desde instituições de pesquisa até entidades governamentais e privadas.

Conseqüentemente, a aquisição dos dados característicos de um evento e seu

mapemento para entidades físicas inter-relacionadas em uma estrutura de banco

3883

de dados tornou-se bastante simples. Embora a aquisição dos dados e a sua

manutenção sejam de extrema importância para os usuários, este não é o

objetivo final para os investimentos realizados em torno da informação (Dunkel et

al., 1997). Além da aquisição da informação, deseja-se atingir a plena utilização

dos dados armazenados para responder a questionamentos simples, tais como:

identificação rápida e precisa de novos comportamentos nos negócios;

composição e evolução de novos produtos; construção de modelos para a

predição de eventos, dentre outros (Kurgan & Musilek, 2006). Desta forma, a

quantidade de informação necessária para uma tomada de decisão vem

aumentando sistematicamente, fazendo com que os processos de análise de

dados se tornassem caros e demorados, e as ferramentas utilizadas, tais como

planilhas eletrônicas e relatórios, pouco elucidativas para visualizar um

comportamento novo ou tendência nos dados.

Na atualidade, verifica-se em muitas empresas que o processo de

transformação dos dados pertencentes a uma determinada base, em

conhecimento útil, é resultado de uma análise tradicional, por meio de relatórios

ou de ferramentas específicas. Esses recursos permitem a visibilidade de um

conjunto de informações cuja avaliação é executada por analistas com grande

conhecimento nas respectivas áreas de atuação. Em termos práticos, isso

significa delegar a tarefa de elucidar os comportamentos e tendências refletidas

nos dados a um grupo restrito de indivíduos especialistas, os analistas de

negócio, que avaliam as informações obtidas a partir de alguma ferramenta ou

software com o intuito de identificar elementos significativos para uma futura

tomada de decisão (Fayyad, Piatetsky-Shapiro & Smyth, 1996).

Por muitos anos, essa prática tradicional de análise de dados foi o

único procedimento utilizado para a extração de conhecimento, empregado e

aceito para as tomadas de decisões estratégicas dentro de uma empresa.

Entretanto, esses procedimentos vem se revelando cada vez mais onerosos e

demorados, além de gerar resultados extremamente subjetivos e imprecisos,

considerando o volume de dados a serem manipulados (Yoon &

Kerschberg,1993; Fayyad & Stolorz, 1997). A identificação de um padrão, ou seja,

de uma informação útil, tornou-se uma tarefa exaustiva e difícil de ser executada

por um especialista, devido à necessidade de se analisar um conjunto cada vez

maior de dados dentro de prazos cada vez mais restritos. Além disso, mesmo que

as corporações ainda se utilizem desse método para a extração de

conhecimento, esta estratégia não garante que o comportamento dinâmico do

negócio estaria sendo considerado nos processos de seleção de dados.

Com a grande oferta de recursos para a captação e armazenamento de

dados, tornou-se comum encontrar sistemas de bancos de dados capazes de

gerenciar mais de 20 milhões de transações diárias, como ocorre, por exemplo

com o banco de dados criado para a empresa Wal-Mart (Babcock, 1994). A

empresa Mobil Oil Corporation desenvolveu um data warehouse capaz de

armazenar mais de 10 terabytes de dados relacionados à exploração de petróleo.

Num contexto acadêmico, a base de dados para o projeto do Genoma Humano

foi preparada para coletar vários gigabytes de informações sobre o código

genético humano (Fasman, Cuticchia & Kingsbury, 1994). Diante desse cenário,

a necessidade de se desenvolver técnicas e ferramentas com a capacidade de

extração de conhecimento de forma inteligente e automatizada levou ao

surgimento de um campo de pesquisa conhecido por Knowledge Discovery in

Databases – ou KDD (Fayyad, Piatetsky-Shapiro & Smyth, 1996).

3884

Este trabalho apresenta uma proposta para formalizar o processo de

extração de conhecimento em corporações, onde a complexidade dos processos

de negócio e a grande massa de dados armazenados tornou crítica a tarefa de

aquisição de conhecimento. O processo de extração de conhecimento aqui

proposto tem como propósito a apresentação de um modelo aplicável a qualquer

domínio de conhecimento .

Metodologia:

A partir de modelos de processos amplamente divulgados na literatura

da área, três modelos se destacam: Fayad, Piatetsky-Shapiro e Smyth (Fayyad,

Piatetsky-Shapiro, Smyth, 1996), Williams e Huang (Williams & Huang, 1996) e o

modelo CRISP – Hipp (Chapman et al., 2000; Wirth & Hipp, 2000), cujas etapas

foram agrupadas de acordo com seus objetivos em torno da mineração de dados,

conforme destacado na tabela 1.

Tabela 1. Modelos de processos KDD.

Macro-etapas

Préprocessamento

Modelo de Fayyad,

Piatetsky-Shapiro e

Smyth

Compreensão

da

área de domínio

Modelo

Hipp

CRISP- Modelo

de

Williams e Huang

Compreensão do Seleção e Préprocessamento

Negócio

Compreensão do

modelo de dados

Preparação

dos

Pré- Dados

Seleção

Limpeza

e

processamento

Redução e Projeção

Mineração de Escolha da tarefa de Modelagem

mineração de dados

Dados

Escolha do algoritmo

de mineração de

dados

Mineração de dados

Interpretação

dos Avaliação

Pósprocessamento padrões

Consolidação

Implantação

3885

Mineração

Avaliação

- Pré-processamento: de um modo geral, a fase de pré-processamento envolve as

atividades de compreensão da área de domínio do problema e a seleção de

registros que serão utlizados na etapa de mineração de dados. O objetivo desta

etapa é simplesmente preparar um ambiente propício para a aplicação das

técnicas de mineração (Tan, Steinbach & Kumar, 2006). Podem ser consideradas

como parte da etapa de pré-processamento as atividades executadas para a

compreensão da área de domínio, o estudo do modelo de dados, a seleção de

dados e o tratamento dos registros selecionados. Os projetos de extração de

conhecimento devem prever algumas atividades adicionais para esta etapa, de

acordo com a organização da base de dados e dos processos que alimentam

essa base, dentre as quais destacam-se a concorrência e a convergência de

dados. Para evitar problemas de desempenho e uma possível indisponibilidade de

sistemas que processam informações e armazenam os dados, a atividade de

seleção de amostras deve ser realizada com algumas restrições, de acordo com

seu porte – avaliada pela quantidade de registros esperada em cada acesso, e

tipo de acesso, principalmente as que envolvem tabelas de diferentes fontes.

Quanto à convergência, há um fator crítico na atividade de seleção de dados que

se altera à medida que utilizamos, no mesmo processo de seleção de dados, o

tratamento de registros com a padronização de tipos de atributos, categorização

de valores, agrupamento em faixas de valores e limpeza de registros. Por esta

razão, a etapa de pré-processamento acaba sendo a mais demorada, se

comparada às demais etapas do processo KDD. O modelo CRISP-Hipp propõe

que o processo KDD seja cíclico e dividido em iterações menores (Hipp, Güntzer

& Nakhaeizadeh, 2002), que essencialmente minimiza os impactos de prazo caso

seja necessário retomar alguma atividade do pré-processamento. Como forma de

atender às necessidades do pré-processamento, alguns recursos são indicados,

tais como data-warehouse (Fayyad & Stolorz, 1996) e seleção automática de

atributos a partir dos métodos “filtro” e “wrapper” (Witten & Frank, 2000).

- Mineração de dados: na etapa de mineração de dados ocorre a definição da

tarefa de mineração de dados que será aplicada ao conjunto de dados

selecionados e uma técnica de suporte para a mineração. A mineração de dados

contempla um conjunto de tarefas, apoiadas por técnicas e algoritmos, para a

extração automática de padrões em dados (Tan, Steinbach & Kumar, 2006).

Historicamente, a mineração de dados teve como um dos pontos de partida as

pesquisas realizadas em diversas disciplinas para o desenvolvimento de

ferramentas eficientes no gerenciamento de diversos tipos de dados, sendo

atualmente considerada uma confluência das disciplinas de estatística,

inteligência artificial, reconhecimento de padrões, aprendizagem de máquina, com

suporte tecnológico dos sistemas de gerenciamento de banco de dados, data

warehouse, computação paralela e distribuída (Fayyad, Piatetsky-Shapiro &

Smyth, 1996; Tan, Steinbach & Kumar, 2006).

Os modelos gerados pelas tarefas de mineração de dados podem ser

divididos em duas categorias relevantes: os modelos preditivos e os modelos

descritivos. Na modelagem preditiva, o objetivo é identificar o valor de um atributo

– variável dependente, com base nos valores de outros atributos, as variáveis

independentes. A modelagem descritiva objetiva a derivação de padrões que

3886

expliquem um relacionamento verificado em um conjunto de registros. As tarefas

descritivas exigem técnicas de pós-processamento que avaliem os resultados

obtidos. A partir dos objetivos a serem alcançados com a aplicação da mineração

de dados, Tan, Steinbach e Kumar, definem como principais tarefas a modelagem

preditiva, a análise de agrupamentos, a análise de associações e a detecção de

anomalias. A tabela 2 apresenta um resumo dos tipos de tarefas mais comuns na

mineração de dados e suas aplicações.

Tabela 2: Tarefas de mineração de dados e aplicações.

Categoria

Preditiva

Descritiva

Tarefa

Exemplos de Aplicações

Classificação de novas espécies de plantas e

animais. Avaliação de risco em contratos de

seguros, transporte de cargas

Acessos às páginas web que ocorrem aos

pares.

Organização

de

produtos

em

supermercados que são adquiridos aos pares.

Filtro de perfil de clientes para campanhas

direcionadas.

Detecção de fraudes em transações de cartão

de crédito. Sinais de intrusão em sistemas de

monitoramento de patrimônio.

Classificação

Regressão

Análise de Associação

Análise de Agrupamentos

Detecção de Anomalias

A obtenção dos modelos preditivos ocorre com a aplicação de dois tipos

de tarefas de mineração de dados: a classificação e a regressão. Um modelo

preditivo permite verificar a classe a que uma variável pode ser atribuída em

função de outras variáveis. Na classificação, a variával dependente ou a classe é

discreta, enquanto que na regressão, a variável dependente é contínua.

As técnicas de mineração de dados são recursos que dão suporte às

tarefas de mineração. No caso da tarefa de classificação, foco desta investigação,

dentre as técnicas mais comuns, podemos destacar a indução por árvores de

decisão, o classificador baseado em regras, o classificador Nearest-Neighbor, o

classificador Bayesiano e as redes neurais artificais.

- Pós-processamento: na etapa de pós-processamento, ocorre a finalização de

uma iteração do processo de extração de conhecimento, com a avaliação dos

padrões descobertos e sua disponibilização ao usuário final. Esta implantação

pode ser através da alimentação de uma base de conhecimento que será utilizada

por uma máquina de inferência ou por uma ferramenta que permite a visualização

de resultados para o auxílio a um especialista humano no suporte às decisões.

Em relação à representação do conhecimento, há varios formatos que permitem a

visualização das saídas de um processo de mineração, tais como a árvore de

decisão, as regras de associação e classificação, a visualização de agrupamentos

são estilos de representação básicos do processo KDD. Para os modelos de

classificação, cujo desempenho pode ser avaliado pela taxa de erro, cada

3887

classificação correta e incorreta de reigstros é registrada e ao final do

processamento, é feita a avaliação do desempenho do modelo.

O modelo de classificação

A classificação é uma das tarefas de mineração de dados em que um

registro composto por um conjunto de de atributos de entrada x, é mapeado a

uma classe y, quando submetido a um modelo de classificação. A técnica de

classificação permite construir modelos de classificação a partir de dados

obtidos a partir extrações realizadas na etapa de pré-processamento, conforme

representado na figura 1. Técnicas como áreas de decisão, redes neurais e

inferência probabilística bayesiana permitem a construção dos modelos de

aprendizagem. O modelo gerado permite a classificação de novos registros, sem

que nada se saiba previamente sobre os novos dados.

Conjunto de Atributos (X)

Classe (Y)

Modelo de

Classificação

Input

Output

Figura 1: Esquema básico para classificação de eventos.

Classificação para modelagem descritiva: um modelo de classificação pode ser

utilizado como ferramenta para distinguir objetos de diferentes classes, por

exemplo, quando os atributos de um conjunto de apólices são utilizados para

classificar diferentes categorias de perdas, por exemplo, os atributos

categoria_veículo e local_circulação, são atributos comuns às apólices de

automóveis e que podem ser utilizadas como atributos de um modelo que

represente dois tipos diferentes de perdas: por roubo e colisão.

Classificação para modelagem preditiva: consite na utilização dos modelos de

classificação para predizer a classe de um novo registro. O registro novo é

submetido ao modelo de forma a obter a classe mais provável a que pertence.

Inferência Probabilística para o Tratamento de Incertezas em Modelos de

Classificação

A inferência probabilística é uma das ferramentas mais utilizadas para

minimizar a incerteza presente nas bases de conhecimento. Nos projetos de

sistemas de apoio à decisão, um fator importante que não deve ser

desconsiderado é o porte da base de conhecimento, pois a inferência

probabilística – utilizando como base o Teorema de Bayes, pode apresentar

problemas de desempenho, considerando a grande matriz de probabilidades

gerada pela quantidade de evidências presentes nos cenários. Por outro lado,

deve se considerar que um sistema de apoio à decisão, implementado para

3888

realizar classificações ou predições, terá maior desempenho se possuir um

registro que mapeie a maior quantidade possível de experiências – as lições

aprendidas. Com isso, as questões de “banco de dados vazio” ou uma condição

oposta, pode afetar a precisão de suas saídas, ou uma queda de desempenho.

Em algumas situações, onde a modelagem da base de conhecimento expõe uma

grande quantidade de atributos, opta-se por descartar os menos relevantes,

avaliando-se que a ausência desses atributos não torna o modelo menos

confiável.

Como forma de contornar os problemas citados acima, os primeiros

sistemas de apoio à decisão, desenvolvidos nos anos 60, tratavam a incerteza de

forma restritiva. Dessa forma, os sistemas de diagnóstico médico, por exemplo,

assumiam um conjunto de possíveis doenças a serem diagnosticadas e que estas

eram mutuamente exclusivas, sendo que a evidência fosse condicionalmente

independente dada qualquer hipótese. Assim, somente uma doença era assumida

para ser diagnosticada para cada paciente. O resultado é que os sistemas

implementados nessa abordagem inferiam sobre um conjunto com pequeno

número de hipóteses e evidência limitada. Por essa razão, o interesse na época,

de utilizar a inferência probabilística diminuiu pela crença de ser inadequada para

expressar a estrutura do conhecimento humano e devido ao fato de que, se

aplicado a domínios maiores, as simplificações adotadas produziam resultados

incorretos e as conclusões a que esses sistemas chegavam não eram vistas

como confiáveis para os especialistas do domínio.

Novamente, na década de 80, ocorreu uma motivação para a utilização

dessa abordagem, desta vez, com a consideração do relacionamento causal e a

independência condicional entre variáveis do domínio. Neste caso, seria

necessário representar probabilidades condicionais somente entre variáveis

diretamente dependentes, e com isso tornar viável a implementação de

aplicações utilizando a inferência probabilística. Essa retomada se deveu às

pesquisas direcionadas em modelos baseados em representações gráficas

denominadas redes probabilísticas, e através das quais, permitem representar e

manipular a incerteza com base em princípios matemáticos fundamentados e

modelar o conhecimento do especialista do domínio de forma intuitiva.

A utilização da representação gráfica das redes probabilísticas permite

explicitar as relações de dependências, tornando-se uma ferramenta poderosa na

aquisição de conhecimento e no processo de validação do modelo gerado, uma

vez que, existindo uma representação do domínio sob forma de rede causal, se

houver uma evidência, é possível determinar quais variáveis devem ter a crença

atualizada (Jensen, 1990).

Estudo de Caso: Aplicação do Classificador Bayesiano para Análise de

Risco em Contratos de seguro

O classificador Naive Bayes é considerado um dos classificadores

Bayesianos mais elementares, sendo naturalmente incremental devido à sua

simplicidade (Yang, 2003; Roure, 2002; Keogh & Pazzani, 1999). Dessa forma, é

facilmente aplicado a uma grande quantidade de problemas e em diversas áreas

do conhecimento (Duda & Hart, 2001; Langrey, 1992).

Avaliar o desempenho de um tipo de seguro depende de uma análise

detalhada de seu histórico no mercado e de peculiaridades do produto que podem

3889

afetar o retorno desejado. A informação mais atualizada sobre o desempenho de

uma determinada carteira é particularmente importante para uma companhia

manter sua competitividade e rentabilidade no mercado. Por outro lado, sem

conhecer as áreas de risco significativas para sua carteira, uma companhia

seguradora não pode sustentar suas operações, mesmo que essa carteira mostre

um bom desempenho dentro de um período em que foi monitorada. A carteira

deve ter sua exposição ao risco de forma balanceada (Williams & Huang (2),

1996).

A análise geral de uma carteira de seguros pode ser feita através da

utilização de técnicas estatísticas diretas, baseadas nos prêmios totais ganhos e

no total das solicitações de resgates pagas aos clientes. Uma abordagem mais

sofisticada, no entanto, seria necessária para analisar os elementos da carteira

de seguros, que normalmente levam a dividir o risco da carteira em pequenas

áreas de risco, cada qual representada por um conjunto de fatores de risco.

Quando uma carteira é particionada, um modelo pode ser concebido para

identificar um grupo, relacionando os fatores de risco à taxa de requisição de

indenização por perdas e os valores requisitados. Dados históricos podem ser

utilizados para identificar os parâmetros desse modelo e o modelo pode ser

utilizado para predizer a frequência de solicitação de indenizações e o custo das

indenizações para diferentes níveis de risco.

Uma forma alternativa às técnicas estatísticas para a análise de risco

de seguros trata o problema da análise de risco no contexto da mineração de

dados, utilizando a teoria das probabilidades (Siebes, 1994). Para as companhias

de seguro, um boa alternativa para avaliar sua exposição a um determinado risco

é o constante monitoramento de sua carteira, de modo a identificar de forma ágil

as variações dos fatores de risco em grupos específicos que compõem a base de

clientes e bens segurados. Desta forma, pode-se balancear os prêmios

competitivos a uma menor exposição ao risco.

Contextualização: Em muitos produtos de seguro a exposição ao risco consiste

na análise do segurado e do objeto do seguro. O perfil do segurado e do bem

informado numa proposta contratual é então submetida a um critério de

pontuação, que verifica a exposição ao risco da empresa seguradora na

aceitação do contrato. Essa análise permite ajustar os prêmios conforme o perfil

apresentado pelo cliente. O objetivo da análise de risco é classificar os contratos

de seguros quanto aos seu grau de sinistralidade e com isso, ofecerer um produto

com preço justo ao consumidor que estiver fora da faixa considerada como risco

para a empresa. Dentre as tarefas de Mineração de Dados disponíveis, adotamos

a Classificação como uma ferramenta para Análise de Risco, utilizando como

fontes de dados os registros de apólices e sinistros.

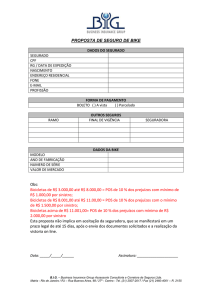

Na etapa de pré-processamento, identificamos o processo de emissão

de contratos, especificamente o critério utilizado para avaliação de perfil na figura

1, demonstramos parte desse processo através de uma representação gráfica de

processo organizacional, cuja notação é conhecida como IDEF0 (De Marco,

1979). Dessa forma, foi possível identificar os primeiros conceitos candidatos

para uma investigação do modelo de dados.

3890

Regras

Pontuação

Formulário Avaliação de Risco

Analisar Perfil de

Risco

A0

Pontos de Agravo /

Desconto

Notificação de

Aceitação

Aplicação

Tabela de

Calculo Ponto Pontuação

Figura 2: Atividade de Análise de Perfil de Risco.

Numa atividade posterior, identificamos nos repositórios de dados as

tabelas e atributos de interesse para a seleção de registros, com a formatação

dos valores, através de implementação de programa para essa finalidade. Na

tabela 3, representamos parte do resultado da atividade de seleção de dados.

Tabela 3: Exemplo de conjunto de treinamento para classificação.

Faixa

Localização Etária

Oeste

Centro

Leste

Sul

oeste

centro

oeste

centro

leste

sul

oeste

centro

leste

Estado

civil

1c

1c

1c

1c

1c

1c

2s

2s

2s

2c

2c

2s

2s

SexoGrau de Uso

m

Desloc Trabalho

m

Desloc Trabalho

m

Desloc Trabalho

m

Desloc Trabalho

m

Desloc Trabalho

m

Desloc Trabalho

f

Desloc Trabalho

f

Desloc Trabalho

f

Desloc Trabalho

f

Profissional

f

Profissional

m

Desloc Trabalho

m

Desloc Trabalho

3891

Sinistro?

Sim

Sim

Sim

Não

Não

não

não

sim

sim

sim

não

sim

não

norte

oeste

oeste

centro

leste

leste

norte

sul

leste

norte

norte

sul

norte

sul

sul

2s

1c

1s

1s

1s

1c

1c

1c

2s

2s

2s

2s

2c

2c

2c

m

f

m

m

m

m

f

f

m

m

m

m

m

m

m

Profissional

Desloc Trabalho

Desloc Trabalho

Desloc Trabalho

Desloc Trabalho

Profissional

Lazer

Lazer

Lazer

Desloc Trabalho

Profissional

Profissional

Desloc Trabalho

Desloc Trabalho

Desloc Trabalho

sim

sim

sim

sim

não

sim

não

não

não

sim

sim

sim

sim

não

não

- Aplicação do Teorema de Bayes na classificação de contratos

Para utilizar o Teorema de Bayes, formaliza-se X como um conjunto de

atributos e Y como uma variável de classe. Se a variável classe Y, tem um

relacionamento com os atributos, então pode-se tratar X e Y, capturando seu

relacionamento probabilístico usando a função P(Y|X), ou seja, a probabilidade a

posteriori de Y.

Para ilustrar essa abordagem, suponha a tarefa de classificar que um

contrato de seguro, pertencente a um grupo de risco, com base nas respostas

obtidas do questionário de avaliação de perfil. O exemplo contido na tabela 2, que

utilzaremos como conjunto de treinamento que representa essa situação, com os

seguintes atributos: localização, faixa etária, estado civil, sexo e grau de uso. A

classe é a ocorrência do sinistro, classificado com “sim” ou “não”.

O classificador Naïve-Bayes estima a probabilidade condicional da

classe, assumindo que os atributos são condicionalmente independentes. A

independência condicional é formalmente expressa pela equação:

P( Xi | Y

d

P(X | Y=y) =

y)

i 1

(1.3)

onde cada X ={X1,X2,..., Xn} consiste de d atributos e Y é a classe atribuída a X.

Dessa forma, a probabilidade a posteriori para cada classe Y é:

P( Xi | Y) . P( Y ) / P( X )

d

P(Y | X) =

i 1

(1.4)

Para um conjunto fixo de atributos em X e para fins comparativos

dentro de um processo de classificação, pode-se desconsiderar o cálculo da

3892

probabilidade a posteriori envolvendo o P(X) que aparece no denominador do

Teorema de Bayes. Como se trata do mesmo contrato, os atributos utilizados são

os mesmos, e a saída é a probabilidade da hipótese de ocorrência de sinistro

dadas as evidências de localização, idade, sexo e estado civil do condutor, e o

grau de utilização do veículo. Basicamente, passando essas informações para a

fórmula do Teorema de Bayes:

P(H | X) =

P( X | H) . P(H)

P( X )

X é fixo

Į = 1 / P(X)

E sendo assim,

P(H | X) = P ( X | H) . P(H) . Į

Resultados

Para o exemplo do contrato de seguro, pode-se escrever:

P(sinistro = sim |localização=norte, faixa_etaria =1, estado_civil =c, sexo=M,

grau_uso =Desloc trabalho) = P(localização=norte |sinistro =sim) .

P(faixa_etaria =1|sinistro =sim).P(estado_civil = c|sinistro = sim).P(sexo

=M|sinistro = sim) . P(grau_uso=Desloc_trabalho|sinistro = sim) .P(sinistro = sim).

Į

P(sinistro = não|localização=norte, faixa_etaria =1, estado_civil =c, sexo=M,

grau_uso =Desloc trabalho)=P(localização=norte|sinistro= não) . P(faixa_etaria

=1|sinistro =não).P(estado_civil=c|sinistro = não).P(sexo =M|sinistro = não) .

P(grau_uso=Desloc_trabalho|sinistro = não).P(sinistro = não). ǹ

Utilizando o cenário de classificação de um contrato de seguro como

sendo ou não um contrato de alto risco, dadas as caracterísitcas contratuais,

aplica-se o Teorema de Bayes com as seguintes evidências:

Localização do veículo: Zona Sul

Faixa etária do condutor: entre 18 a 25 anos – faixa 1

Estado Civil: solteiro

3893

Sexo: Masculino

Grau de utilização: Deslocamento para Trabalho

Para esses atributos de entrada, a classificação é realizada com a

hipótese de ocorrer ou não um sinistro, com base das probablidades de

ocorrência ou não de sinistro de cada atributo. Separam-se os registros para cada

atributo, calculando a probabilidade condicional conforme ilustrado nas Tabela 3 a

9.

Tab. 4: Probabilidade a priori de sinistro

Sinistro

sim

não

Total

QTD P(sinistro)

32000

0,40

48000

0,60

80000

1,0

Tab. 5: Probabilidades de sinistro por localização

Localização Sinistro=sim Sinistro= Não

Norte

8332

9042

Sul

12012

15545

Oeste

6033

12407

Leste

4038

7856

Centro

1585

3150

Total

32000

48000

Total

17374

27557

18440

11894

4735

80000

As demais tabelas, exibem as quantidades de sinistros registradas para

cada atributo de uma Avaliação de Perfil do Segurado.

Tab.6: Probabilidades de sinistro por faixa etária do Tab.7: Probabilidades de sinistro por estado civil do

condutor

Faixa Etária

18 < X <25

X > 25

Total

condutor

Sinistro=sim Sinistro =não Total

17334

17042 34376

14666

30958 45624

32000

48000 80000

Estado Civil Sinistro= sim Sinistro =não Total

Casado

10000

24332 34332

Solteiro

22000

23668 45668

Total

32000

48000 80000

Tab. 8: Probabilidades de sinistro por sexo do Tab. 9: Probalidade de sinistro por grau de utilização

condutor

do veículo

Sexo

Sinistro=sim Sinistro=não Total

Masculino

18344

28000 46344

Feminino

13656

20000 33656

Total

32000

48000 80000

Grau de Uso Sinistro=sim Sinistro=não Total

Lazer

4533

8641 13174

Desloc Traba

15002

19932 34934

Profissional

12465

19427 31892

Total

32000

48000 80000

Tabela10: Cálculo das probabilidades de sinistro para os valores dos atributos

localização, faixa etária, estado civil e sexo do condutor e grau de utilização do

veículo.

X => "Sinistro=sim"

X => "Sinistro=não"

P(localização =norte| X)

0,26

P(localização =norte| X)

0,2

P(localização = sul| X)

0,37

P(localização = sul| X)

0,32

P(localização =oeste| X)

0,19

P(localização =oeste| X)

0,25

P(localização =leste| X)

0,13

P(localização =leste| X)

0,16

P(localização =centro| X)

0,05

P(localização =centro| X)

0,06

3894

P(faixa_etaria=1| X)

0,54

P(faixa_etaria=2| X)

0,46

P(estado_civil=casado| X)

0,31

P(estado_civil=solteiro| X)

0,68

P(sexo=masculino| X)

0,57

P(sexo=feminino| X)

0,42

P(grau_uso= lazer| X)

0,14

P(grau_uso=deslocamento trab| X) 0,47

P(grau_uso=profissional| X)

0,38

P(faixa_etaria=1| X)

P(faixa_etaria=2| X)

P(estado_civil=casado| X)

P(estado_civil=solteiro| X)

P(sexo=masculino| X)

P(sexo=feminino| X)

P(grau_uso= lazer| X)

P(grau_uso=deslocamento trab| X)

P(grau_uso=profissional| X)

0,35

0,64

0,51

0,49

0,58

0,42

0,14

0,42

0,4

Como exemplo, podemos classificar um contrato na hipótese de haver

ou não risco de sinistro a partir dos valores informados, atribuindo em X =

(localização = Sul,faixa_etaria =1, estado_civil=s, sexo = M, grau_uso=Desloc

Trabalho).

P(sinistro=sim| X) = 0,40 X 0,37 X 0,54 X 0,68 X 0,57 X 0,47 = 0,14

P(sinistro=não|X) = 0,60 X 0,32 X 0,35 X 0,49 X 0,58 X 0,42 = 0,008

Nesse exemplo, conforme a equação (1.1), o contrato representado

por X, pertence ao um grupo de risco de sinistro, pois

P(sinistro=sim| X) > P(sinistro=não|X)

O Naive Bayes é uma abordagem simples de representação, utilização

e aprendizagem baseada na inferência probabilística e embora a sua utilização

tenha sido constantemente reavaliada com a proposta de esquemas de

aprendizagens mais sofisticadas, em muitos casos, podemos verificar que a

utilização de um método mais simples traz resultados igualmente satisfatórios.

Mesmo quando o Naive Bayes não traz bons resultados, não é difícil verificar o

motivo. Como é assumida a independência entre os atributos, a adição de

atributos redundantes podem distorcer o modelo de aprendizagem. Um exemplo

do cenário abordado, a adição de um atributo com os mesmos valores da faixa

etária do condutor, faria com que o atributo faixa etária fosse considerado duas

vezes no cálculo das probabilidades, influenciando na decisão. Novamente,

citamos a importância a avaliação do modelo de dados na etapa de préprocessamento, como forma de identificar nas tabelas, os atributos cujos valores

são resultados de cálculos ou combinações de outros atributos, para evitar que as

dependências entre atributos inevitavelmente presentes nos bancos de dados,

afetem o modelo de classificação.

Conclusões

Neste trabalho apresentamos uma proposta de Processo de Extração

de Conhecimento a partir de Bancos de Dados, para formação de bases de

conhecimento para Sistemas Especialistas de Apoio à Decisão, utilizando como

base os modelos idealizados por Fayad, Piatetsky-Shapiro & Smyth (1996),

Williams & Huang (1996) e o modelo de Hipp, Güntzer & Nakhaeizadeh (2002). O

processo de extração de conhecimento utilizou o estudo de caso associado à

extração de conhecimento para análise de risco em contratos de seguros.

3895

Utilizou–se a Classificação como tarefa de Mineração de Dados, com inferência

probabilística baseada no Teorema de Bayes. Embora tenhamos utilizado uma

quantidade limitada de atributos no estudo de caso de avaliação de perfil de

segurados, o processo se mostra bastante útil, por utilizar uma ferramenta que

explora as informações históricas, e através das experiências registradas em

bancos de dados, permite extrair padrões que comumente passam despercebidos

ao usuário devido ao grande volume de informações armazenadas. Nesse

processo, é recomendável o suporte de um especialista da área de domínio,

para que sejam tratados os atributos relevantes ao problema que está sendo

modelado. A etapa inicial de pré-processamento mostrou-se mais complexa pela

necessidade de tratamento dos dados brutos para que possam ser utilizados por

uma ferramenta de data mining. Na etapa de pós-processamento, indica-se o uso

de ferramentas de visualização dos dados minerados, para avaliação do modelo

gerado. Para essa etapa, de acordo com a tarefa de data mining selecionada para

o problema, é feita uma avaliação do modelo gerado, através de testes que

definirão uma métrica para avaliar a eficiência do modelo perante novas

situações.

O problema de desempenho do modelo gerado na inferência

probabilística com o uso do Teorema de Bayes pode ser contornado com o uso

das redes probabilísticas. A utilização das redes Bayesianas será foco de estudos

futuros. Necessita-se, ainda, tratar o processo de aquisição do conhecimento

como um processo incremental, para garantir que o conhecimento armazenado

nas bases permaneça sempre atualizado.

Referências

Apte, C.; Hong, S. J. Predicting Equity Returns from Securities Data. In Advances

in Knowledge Discovery and Data Mining, 541-560, eds. U. Fayyad, G.

Piatetsky-Shapiro, P. Smyth, and R. Uthurusamy. California: AAAI Press,

1996.

Babcock, C. Parallel Processing Mines Retail Data. Computer World 6,

September 26, 1994.

Baranauskas, J. A. Extração Automática de Conhecimento por Múltiplos

Indutores, São Carlos:ICMC-USP, 2001.

Berry, M. J. A; Linoff, G. S. Data Mining Techniques: For Marketing, Sales, and

Customer Relationship Managenent, 2a edição. Indianapolis: Wiley, 2004.

Brachman, R., Anand, T. The Process of Knowledge Discovery in Databases: A

Human-Centered Approach. In Advances in Knowledge Discovery and Data

Mining, editado por U. Fayyad, G. Piatetsky-Shapiro, P. Smyth, and R.

Uthurusamy. California: AAAI Press, 1996.

Chen, M., Han, J., Yu, P. Data Mining: An Overview from a Database Perspective.

IEEE Transactions on Knowledge and Data Engineering. 8(6), 866-883, 1996

Chapman, P.; Clinton, J.; Kerber, R.; Khabaza, T.; Reinartz, T.; Shearer, C.; Wirth,

R. CRISP_DM 1.0. Disponível em www.crisp-dm.org. 2000.

De Marco, T., Strutured Analysis and System Specification. Prentice Hall, 1979.

Duda, R.; Hart, P. ; Stork, D. Pattern Classification, 2nd edtion. New York: John

Wiley and Sons: 2001.

3896

Dunkel, Brian; Sotopar, Nandit; Szaro, John, Uthurasamy, Ramasamy. Systems

for KDD: From concepts to pratice. Future Generation Computer Systems,

13, 231-242, 1997.

Fasman, K.; Cuticchia, A.; Kingsbury, D. The GDB Human Genome Database

Anno 1994. Nucl. Acid. R., 22(17): 3462-3469,1994.

Fayyad, U.; Stolorz, P. Data mining and KDD: Promise and challenges. Future

Generation Computer Systems, 13, 99-115, 1997.

Fayyad, U.; Piatetsky-Shapiro, G.; Smyth, P. From Data Mining to Knowledge

Discovery: An Overview. California: AAAI Press, 37-54, 1996.

Fayyad, U.; Djorgovski, G.; Weir, N.:. Automating the Analysis and Cataloging of

Sky Surveys. . In Advances in Knowledge Discovery and Data Mining, 471494, editado por U. Fayyad, G. Piatetsky-Shapiro, P. Smyth, and R.

Uthurusamy. California: AAAI Press,1996.

Frawley, U.; Piatetsky-Shapiro, G.; Matheus, C. Knowledge Discovery in

Databases: An Overview. In Knowledge Discovery n Databases, ed. G.

Piatetsky-Shapiro and B. Frawley. Cambridge: AAAI/MIT Press, 1991.

Jensen, F.; Olsen, K.; Andersen, S. An Algebra Bayesian Belief Universes for

Knowledge-based Systems., New York: Networks, v.20, p.637-659,1990.

Han, J.; Kamber, M. Data Mining – Concepts and Techniques, 1a edição. New

York: Morgan Kaufmann, 2000.

Hand, D. Discrimination and Classification. Chichester: John Wiley and Sons,

1981.

Hipp, J.; Güntzer,U.; Nakhaeizadeh, G. Data Mining of Association Rules and the

Process of Knowledge Discovery in Databases. In Advances in Data Mining,

editado por Petra Perner. Leipzig: Springer, 2002,15-36.

Holsheimer, M., Kersten, M., Mannila, H.;Toivonen, H. A perspective on

databases and data mining, Proc. Of the First International Conference on

Knowledge Discovery and Data Mining. California: AAAI Press,1995, 150-155.

Keogh, E.; Pazzani, M. Learning augmented bayesian classifiers: A comparison of

distribution-based and classification-based approaches. 1999.

Kurgan, Lukasz A.; Musilek, Petr. A survey of Knowledge Discovery and Data

Mining process models. The Knowledge Engineering Review, Cambridge,

vol. 21:1, 1-24, 2006.

Langrey, P.; Iba, W.; Thompson, K. An analysis os bayesian classifiers. In Tenth

National Conference on Artificial Intelligence, 223-228, 1992.

Luger, G. Inteligência Artificial: estruturas e estratégias para a solução de

problemas complexos; trad. Paulo Engel, 4ª edição. Porto Alegre: Bookmann,

2004.

McLachlan, G. Discriminant Analysis and Statistical Pattern Recognition. New

York: Wiley, 1992.

Matheus,C.; Chan, P.; Piatetsky-Shapiro,G. Systems for Knowledge Discovery in

Databases. IEEE Transaction on Knowledge and Data Engineering 5(6),

903-912, 1993

Monard, M.; Caulkins, C.; Baranauskas, J.; Oliveira, R.; Rezende, S. Data

preparation, reduction and prediction in the context of data mining: A case

study with insurance policies. Technical Report 81, ICMC-USP,1999.

Roure, J. An incremental algorithm for tree-shaped Bayesian network learning. In

F. Van Harmelen editor, Proceedings of the 10th European Conference of

Artificial Intelligence (ECAI 2002), 350,IOS Press,2002.

3897

Siebes, A. Homogeneous discoveries contain no surprises: Infering risk-profiles

from large databases. Techinical Report CS-R9430, CWI, 1994.

Tan, Pang-Ning; Steinbach, Michael; Kumar, Vipin. Introduction to Data Mining.

Boston: Addison-Wesley, 2006.

Ullman, J. Principles of Database and Knowledge-Base Systems, Vol. I,

.Maryland: Computer Science Press,1988.

Yang, Y. Discretization for Naïve Bayes Learning. PhD thesis, School of Computer

Science and Software Engineering of Monash University, 2003.

Yoon, J.; Kerschberg, L. A framework for knowledge discovery and evolution

databases. IEEE Transaction on Knowledge and Data Engineering, vol. 5, nº

6, 973-979,1993.

Weiss, S.; Kulikowski, C. Computer Systems that Learn: Classification and

Predictions Methods from Statistics, Neural Networks, Machine Learning,

and Expert Systems. California:Morgan Kaufmann,1991.

Williams, G.; Huang, Z. Modeling the KDD process: A four stage process and four

element model, Technical Report TR-DM-96013, CSIRO Division of

Information Technology, Camberra, 1-8,1996.

Williams, G.; Huang, Z. A case study in knowledge acquisition for insurance risk

assessment using a KDD methodology. PKAW96, the Pacific Rim Knowledge

Acquisition Workshop, 1-11, Sydney, 1996.

Wirth, R.; Hipp, J. When Distribution is part of the semantics: A new problem class

for distributed knowledge discovery. In Proceedings of the PKDD 2001

Workshop on Ubiquitous Data Mining for Mobile and Distributed

Environments, 56-64, Germany, 2001.

Wirth, R.; Hipp, J. CRISP-DM: Towards a standard process model for data

mining. Proceedings of the 4th International Conference on the Practical

Applications of Knowledge Discovery and Data Mining, 29-39, Manchester,

2000.

Witten, I.; Frank, E. Data Mining: Pratical machine learning tools and techniques

with Java implementations. San Diego: Academic Press, 2000.

3898