Teoria dos Conjuntos.

Um conjunto é uma coleção de elementos distinguíveis, i.e., cada elemento só aparece uma vez no

conjunto. É preciso ficar bem claro que elementos pertencem ou não pertencem ao conjunto1.

Geralmente isso é feito através de propriedades partilhadas por todos os elementos do conjunto.

Exemplo:

Seja A o conjunto de todos os elementos que possuem a propriedade P, então a sentença

x A

x possui a propriedade P.

x

x é inteiro positivo ou zero.

O conjunto vazio não possui qualquer elemento. Um conjunto finito tem um número finito de

elementos, e um conjunto infinito possui um número infinito de elementos. Dois conjuntos A e B possuem

a mesma potênica se for possível estabelecer uma relação biunívoca entre seus elementos, ou seja, a cada

elemento de A pode-se associar um, e só um, elemento de B. O conjunto pode ser enumerável [countable]

ou não enumerável. Se for enumerável o conjunto tem uma associação biunívoca com o conjnto dos

núemros naturais. Um conjunto infinito pode ser enumerável, como o dos números naturais. Todo

conjunto finito é enumerável pois podemos ordenar seus elementos e associá-los a 1, 2, 3, etc.

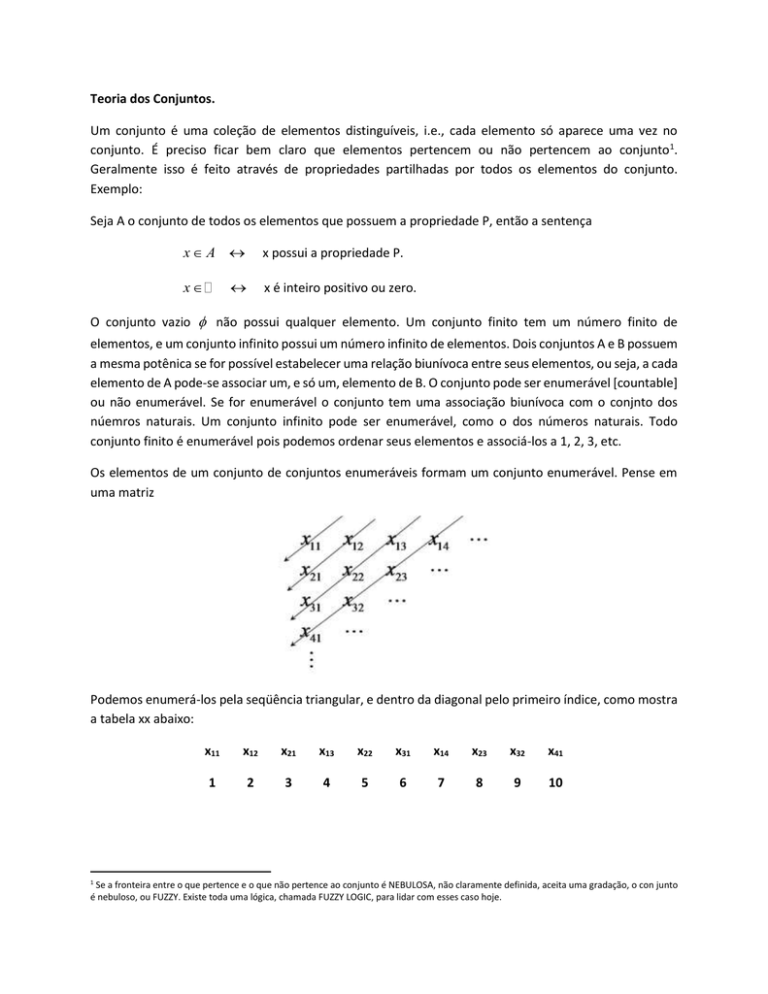

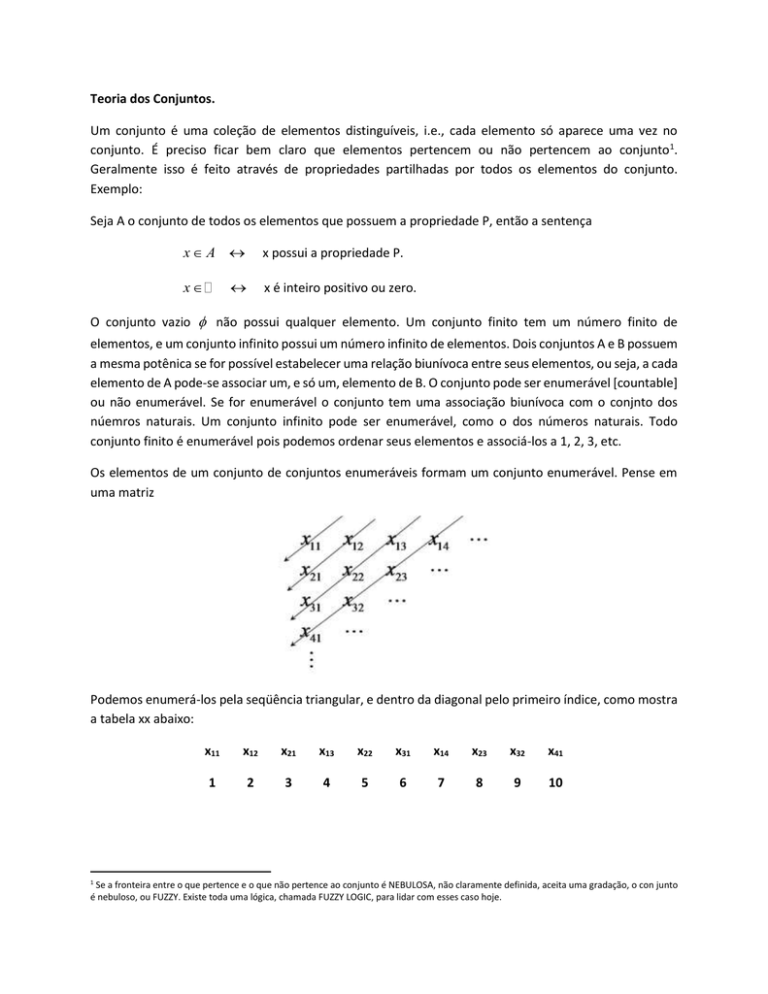

Os elementos de um conjunto de conjuntos enumeráveis formam um conjunto enumerável. Pense em

uma matriz

Podemos enumerá-los pela seqüência triangular, e dentro da diagonal pelo primeiro índice, como mostra

a tabela xx abaixo:

1

x11

x12

x21

x13

x22

x31

x14

x23

x32

x41

1

2

3

4

5

6

7

8

9

10

Se a fronteira entre o que pertence e o que não pertence ao conjunto é NEBULOSA, não claramente definida, aceita uma gradação, o con junto

é nebuloso, ou FUZZY. Existe toda uma lógica, chamada FUZZY LOGIC, para lidar com esses caso hoje.

Assim fizemos a correspondência com

racionais é enumerável, pois x

. Conseqüência dessa fato é que o conjunto dos números

n

contém dois índices, o n e o m, logo pode ser enumerado usando a

m

mesma regra acima.

Entretanto, o conjunto de todos os números em um intervalo não é enumerável. Basta trabalhar com o

intervalo 0,1 . A pergunta é: o conjunto de todos os números no intervalo 0,1 é enumerável? Vamos

provar que não por absurdo.

Suponha que seja. Então temos x1

x1 x2 x3

x2

x3

e podemos ordená-los em ordem crescente:

1 uma vez que dois números não podem ser iguais. Neste caso x

xi xi 1

é

2

tal que xi x xi 1 e x não pertence ao conjunto dado. Logo o conjunto não incluiu todos os números

entre 0 e 1. Note então que existem números racionais entre 0 e 1 e que também existem números

irracionais entre 0 e 1. Só que o conjunto dos irracionais não é enumerável, e dos racionais é enumerável,

ou seja, irr rac .

Álgebra dos conjuntos.

São duas as operações principais entre conjuntos: a UNIÃO e a INTERSEÇÃO.

Operação UNIÃO:

Seja A o conjunto dos elementos com a propriedade PA e B o conjunto dos elementos com a propriedade

PB. Se x AUB então x A ou x B . Ou seja, x ou tem a propriedade PA ou tem a propriedade PB.

Note que a operação lógica da união é OU. Vamos usar a notação 0 para falso e 1 para verdadeiro. A tabela

da verdade para essa operação é dada por:

PA

PB

AUB

1

1

1

1

0

1

0

1

1

0

0

0

Ou seja se x possui PA e PB então x AUB ; se x possui PA mas não PB então x AUB ; se x não possui PA

mas possui PB então x AUB e, finalmente, se x nem possui PA nem possui PB então x AUB . Em

linguagem de conjuntos estamos afirmando que:

x A e

x A e

x B x AUB

x B x AUB

x A e

x A e

x B x AUB

x B x AUB

Na nossa álgebra de lógica em que só existem 0 e 1, falsa ou verdadeira, então 1 1 1 , 1 0 1 ,

0 1 1 e 0 0 0 . Por isso é comum associar o sinal de + à operação lógica OU.

Ou seja AUB A B quando A e B são conjuntos.

Propriedades da operação união2.

Associativa:

A B D A B D

Comutativa:

A B B A

Elemento unitário:

A A

Observação: apesar da operação união possuir o elemento unitário e ela não admite inversa pois

A B se A ou B .

CONJUNTO UNIVERSO

O conjunto universo é definido como o conjunto contendo todos os elementos possíveis, com todas as

propriedades existentes em dado contexto e denominado por S. Note que A S sempre e que

A S S .

CONJUNTO COMPLEMENTAR A .

Se x A então x A e x S .

Propriedades:

A A ; S ; S ; se B A então A B e se A B então A B .

2

Vamos evitar a letra C para conjuntos por que é a letra usada para estar contido.

Operação DIFERENÇA A B

Se x A B então x A e x B OU x A e x B . Se A B então A B e A S A .

Operação INTERSEÇÃO:

Dizemos que x A B se x A E x B . A operação lógica nesse caso é E (AND). Ou seja, agora temos

que:

x A e

x A e

xB x A B

xB x A B

x A e

x A e

xB x A B

xB x A B

A tabela da verdade para essa operação é dada por:

PA

PB

AUB

1

1

1

1

0

0

0

1

0

0

0

0

Como 1 1 1 , 1 0 0 , 0 1 0 e 0 0 0 , usamos também a notação de multiplicação na forma

A B AB .

Propriedades da operação união.

Associativa:

AB D A BD

Comutativa:

AB BA

Distributiva frente à união:

A B D AB AD

Se A B então AB A ; AA A ; AS A ; A e A A .

Conjuntos disjuntos: se AB dizemos que A e B são disjuntos, ou mutuamente exclusivos. Se pertence

a A não pertence a B e se pertence a B não pertence a A.

Ai A , ou

PARTIÇÃO. Uma partição de um conjunto A é uma coleção de subconjuntos Ai tais que:

i

seja, A1 A2

An A , entretanto Ai Aj i j .

Algumas partições clássicas:

1.

A A S e AA

2.

A A e A

3.

SB B

4.

A B A AB AB A AB AB A AB e A AB

A A B B

AB AB B e AB AB A ABB B

Leis de De Morgan:

São leis super importantes na teoria dos conjuntos e muito úteis para demonstração de teoremas. Podem

ser apresentadas em duas formas equivalentes:

Forma 1: A B A B

Forma 2: AB A B

A estratégia para demonstrá-la e usar o fato de que se A B e B A então A B .

Forma 1: Se x A B

x A B x A e x B x A e x B x A B

Com isso demonstramos que se x A B então x A B o que significa que A B A B . Entretanto,

como todas as setas são bidirecionais também concluímos que se x A B então x A B logo

A B A B , significando que A B A B .

Forma 2: Se

x AB

x AB x A ou x B x A ou x B

x A B .

Com isso mostramos que se x AB então x A B logo que significa que AB A B . Com a

bidirecionalidade das setas concluímos que se x A B então x AB

logo A B AB , e

AB A B .

Parecem duas leis mas na realidade é uma só. Dado uma a outra será verdadeira e vice-versa. Passando

de uma forma à outra:

Na forma 2 fazer A A e B B logo A B A B A B agora tirar o complementar de ambos os

lados A B A B

A B A B a forma 1. Na forma 1 fazer A A e B B logo

A B A B AB tirar o complementar de tudo novamente A B AB AB A B .

Probabilidade.

Vocabulário:

Experimento. Na estatística designa uma atividade para a qual não se pode especificar antecipadamente

o resultado final. Jogar um dado, por exemplo, é um experimento. Jogar um dado duas vezes seguidas é

um experimento. Se é possível especificar o resultado antecipadamente se diz que estamos no campo

determinístico. Experimento nas ciências exatas possui outra conotação – é uma experiência

determinística utilizada para comprovar ou falsificar uma teoria ou modelo.

TRIAL (ensaio, tentativa). Cada performance isolada de um experimento é um trial.

Resultado (outcome). É o resultado do experimento. Exemplo, joguei o dado e obtive 5 – 5 é o resultado.

Cada trial dá origem a um resultado. Jogar dois dados, por exemplo, pode dar o resultado (2,3).

Espaço amostral S ou . O conjunto de todos os resultados do experimento é o espaço amostral. Esse

conjunto pode conter mais resultados do que os possíveis, mas não pode deixar de conter todos os

possíveis. No caso de um dado 1, 2,3, 4,5 e 6 . Agora suponha o conjunto da quantidade de gordura

no leite, x. Sabemos que x / 0 x 100% embora se saiba que x 10% é praticamente

impossível. Logo x / 0 x 20% também é um espaço amostral. Todo resultado, portanto, é

um elemento do espaço amostral. O espaço amostral pode ser finito, infinito, enumeráel ou não

enumerável.

Evento. Evento é um sub-conjunto do espaço amostral. São coleções de resultados de um experimento.

FUNÇÃO. Uma função é uma regra de associação entre elementos de um conjunto chamado domínio com

elementos de outro conjunto chamado contra-domínio. Para ser função a regra deve ser clara, sem dar

origem a impasses, deve se saber exatamente a que elemento associar e o que fazer com todos os

elementos do domínio. Não pode portanto, associar um elemento do domínio a mais de um elemento do

contra-domínio pois haveria dúvida sobre qual regra seguir. Além disso, todos os elementos do domínio

devem poder ser associados para evitar não saber o que fazer com um elemento que não se pode associar.

Estamos acostumados à funções de um conjunto de números em outro conjunto de números, mas

podemos perfeitamente associar um conjunto a uma número, ou conjuntos a conjuntos. Um exemplo de

uma função de conjunto que associa elementos de um conjunto a um número é o indicador do conjunto:

1 se x A

1A x

0 se x A

Probabilidade é uma função de conjunto, que deve associar um número real 0 P A 1 à todo evento

A do espaço amostral.

Definições de probabilidade.

Subjetiva: uma pessoa julga qual a probabilidade de ocorrência dos eventos.

Freqüência relativa. Executa um experimento N vezes e conta quantas vezes o evento A ocorreu e assim

NA

. A dificuldade dessa definição é que seria preciso repetir o

N

N

experimento inifinitas vezes. Também só seria útil se for possível provar que A estabiliza para certo

N

N

valor à medida que N cresce, ou seja, que A converge.

N

associa à probabilidade P A Lim

N

Clássica. Seja um espaço amostral finito com N resultados igualmente PROVÁVEIS e A um evento com

NA elementos, então P A

NA

. A maior dificuldade com essa definição [é que ela usou o conceito de

N

probabilidade para definir probabilidade [igualmente prováveis]. Ou seja, é uma definição circular.

Também, da forma como foi definida, seria impossível analisar o comportamento de um dado desonesto.

Finalmente restringe o estudo a espaços amostrais finitos.

Dadas todas as dificuldades apontadas acima finalmente chegou-se a conclusão que a probabilidade

deveria ser definida através de axiomas.

Definição Axiomática.

São apenas três os axiomas para uma função de conjuntos P A f : , com P A 0,1 , que

pode representar uma probabilidade:

1.

P A 0 A

2.

P 1, é chamado de evento certo.

3. Se AB então P A B P A P B

Tudo o que pode ser demonstrado através dos axiomas é teorema e não deve ser colocado na mesma

categoria de axioma. Com esses 3 axiomas podemos mostrar vários teoremas:

1.

P 0 .

Prova: A

P A P A P

mas A A , logo P A P A P e

P 0 .

2.

P A 1 P A

outro lado P A A P 1 pelo axioma 2. Então P A P A 1 e P A 1 P A .

Prova: A A e A A logo pelo axioma 3 mas A A , logo P A A P A P A . Por

a 1 b e

b 0 1 b 1 a 1 . Repetindo o argumento temos também que b 1 . Como

Corolário:

Se

a0,

b0

e

a b 1

então

a 1

e

b 1,

pois

P A P A 1 e P A 0 e P A 0 pelo axioma 1 então 0 P A 1 e 0 P A 1 .

3.

P A B P A P B P AB

Prova: B B A A B logo B AB A B . Fazendo a união com A temos A B A AB A B

entretanto AB A logo A AB A e A B A AB . Note que B AB A B e A B A AB

representam duas partições pois

AB A B A ABB B

axioma 3 nas duas partições temos:

e A AB AAB . Aplicando

P B P AB P A B e P A B P A P A B .

Extraindo P A B P B P AB da primeira partição e substituindo na segunda temos:

P A B P A P B P AB

Esse teorema implica em que a probabilidade é sub-aditiva, ou seja, a união dos conjuntos leva a uma

probabilidade menor do que a da soma das probabilidades.

4. Se

A B então P A P B .

Mas como

A B

então

então P B P A .

Prova B AB A B logo P B P AB P A B

AB A ,

então P B P A P A B

.

e como P A B 0

Eventos independentes:

Os eventos

A e B são independentes se P AB P A P B .

AeB

Daí podemos mostrar como teoremas que se

são independentes então ( A e

B ), ( A e B ) e

(

A e B ) também são independentes entre si. Isso significa que os eventos complementares também são

independentes.

P A 1 P A , percebemos que P B P AB P A B ,

Prova: Usando B AB A B e

P A B P B P AB .

logo

Como

A

B

e

são

independentes,

P A B P B P A P B P B 1 P A P B P A , provando que

A

e

então

B

A de B e vice-versa temos que A e B são independentes. Se A e B

independentes então mudando A para A temos que A e B são independentes.

independentes. Chamando

são

são

Probabilidade Condicional.

A

Pergunta: qual a probabilidade do evento

probabilidade por

sabendo que o evento

P A | B , [leia-se: p de A dado B]. Se B

restringir o espaço amostral para

B

ocorreu? Denotamos essa

ocorreu então

P B 0

e podemos

B B . Agora basta mostrar que P A | B

P AB

P B

obedece aos axiomas da probabilidade.

1.

P P B | B

2.

P A | B 0

3. Se

AD

pois

P BB

P B

P AB 0

e

P B

P B

1

P B 0

então:

P A D | B

P AB DB

P B

P AB

P B

P DB

P B

P A | B P D | B

Teorema da propabilidade total:

Seja

par A1 , A2 ,

, An uma partição de

e

B um evento arbitrário. Então:

P B P B | A1 P A1 P B | A2 P A2

P B | An P An

Prova:

BAi BAj

B B B A1 A2

An BA1 BA2

i j , logo BA1 BA2

BAn

P B P BA1 P BA2

Agora basta substituir

P BAi P B | Ai P Ai

BAn

é uma partição de

e

B . Nesse caso:

P BAn

para provar o teorema.

P B P B | A1 P A1 P B | A2 P A2

P B | An P An

Teorema de Bayes.

P Ai | B

P Ai B

1

P B | Ai P Ai

P B

P B

P Ai | B

logo:

P B | Ai P Ai

P B | A1 P A1 P B | A2 P A2

P B | An P An

Thomas Bayes [1701 – 1761] estabeleceu o teorema de Bayes em uma obra póstuma Bayes “An Essay

towards solving a Problem in the Doctrine of Chances” [1763] editada pelo seu amigo Richard Price, da

tabela Price.

A inferência de Bayes está sendo hoje, cada vez mais, considerada mais robusta do que a inferência

frequentista de Fisher.

Exemplos da utilização da inferência Bayesiana:

[extraídos do livro “The Signal and the Noise” de Nathan Silver.

Exemplo 1: Após uma viagem Ella encontra uma calcinha estranha em sua gaveta. Deseja saber a

probabilidade de estar sendo traída pelo seu parceiro dado que a calcinha foi encontrada. O evento

foi: encontrar calcinha estranha na sua gaveta. O evento

informação e o evento complementar

opções: traição

A

ou não traição

A

A

B

é estar sendo traída sem qualquer outra

é não estar sendo traída. Nesse caso o evento

A , e P A 1 P A . A probabilidade P A

A só tem duas

é chamada de

probabilidade à priori, ou prior. Sem qualquer informação extra pode-se apelar para estatísticas da

sociedade como um todo na qual se sabe que 4% dos parceiros traem durante um ano. Assim, a

probabilidade de estar sendo traída vale

P A 4%

e de não estar sendo traída vale

P A 1 P A 96% . Agora precisamos estimar P B | A , probabilidade da calcinha estranha

aparecer dado que está sendo traída, e

P B | A , a probabilidade da calcinha estranha aparecer mesmo

sem existir traição. Vamos supor que exista a traição. Mas nesse caso se espera que o parceiro fosse mais

cuidadoso em evitar que a calcinha fosse abandonada na gaveta – digamos então que seja de 50% a

chance dele não ter percebido a calcinha estranha no momento da traição. Assim P

B | A 50% .

Agora pode-se imaginar a probabilidade da calcinha estranha aparecer sem que exista traição – tipo ele

comprou a calcinha e esqueceu de contar, comprou a calcinha para ele mesmo, uma amiga em comum

confiável dormiu em casa, a empregada misturou tudo, etc. Digamos que essa probabilidade seja de

P B | A 5% . Agora pode-se calcular a probabilidade de estar sendo traída dado que a calcinha

estranha apareceu como:

P A | B

P A | B

P B | A P A

P B | A P A P B | A P A

50% 4%

2%

29%

50% 4% 5% 96% 2% 4.8%

Exemplo 2: Uma mulher na faixa dos 40 anos fez uma mamografia que deu positiva para câncer de mama.

Qual a probabilidade de ela ter câncer de mama dada a mamografia positiva. Evento

mama e

A é ter câncer de

A é não ter câncer de mama na faixa dos 40 anos. O evento B | A é a mamografia ser positiva

quando há câncer de mama, e o evento

B | A é a mamografia ser positiva quando não há câncer de

mama [são chamados falso-positivos]. Sem qualquer outra informação sabe-se que a probabilidade de

uma mulher na faixa dos 40 desenvolver câncer de mama é de apenas

P A 1.4% ,

logo

P A 98.6% . Também se sabe que a probabilidade da mamografia dar positivo na presença de

câncer de mama é de

P B | A 75% , ou seja, 25% dos cânceres de mama deixam de ser detectados

pela mamografia. Por outro lado a freqüência de falsos positivos é de

P B | A 10% .

Assim a

probabilidade dela ter câncer de mama dado que a mamografia deu positiva é de:

P A | B

75% 1.4%

9.6%

75% 1.4% 10% 98.6%

Ainda bastante baixa. Por isso só se recomenda exame periódico de mamografia depois dos 50, quando a

prior aumenta. Nathan Silver demonstra esse resultado da seguinte forma. Suponha 1000 mulheres

fazendo mamogramas. Dessas 1000 apenas 14 estarão com câncer de mama enquanto 986 não estarão

com câncer de mama. Das 986 sem câncer de mama aparecerão 99 com mamografia positiva. Das 14 com

câncer de mama aparecerão 11 com mamograma positivo e 3 cânceres não serão detectados. Ou seja, do

total de 110 mamogramas positivos apenas 11 são realmente câncer de mama.

Exemplo 3: No ataque terrorista de 2001 qual a probabilidade da primeira colisão com a world trade

center ser um ataque terrorista. Nesse caso evento A é haver um ataque terrorista e A é não haver um

ataque terrorista. Vamos chutar que a chance de haver um ataque terrorista contra um arranha céu de

Manhattan seja de 1 em 20.000, contando as tentativas que já ocorreram no passado. Trata-se de um

chute, pois só houve um atentado terrorista de sucesso contra um arranha céu de Manhattan em toda a

história da cidade, justamente o de 11 de setembro de 2001. Isso significa que a estimativa dessa

probabilidade é muito pouco precisa. Mas deixa assim mesmo. Então

P A

1

20000

e

P A

19999

. Agora, estimando o caso pior aceitamos que a probabilidade de acertar o WTC dado

20000

que é realmente um ataque terrorista seja de 100%, então P B | A 100% . Agora a probabilidade

de uma colisão não intencional de um avião com um arranha céu em Manhattan é bem precisa pois em

25000 dias de aviação sobre Manhattan antes de 2001 só existiram 2 acidentes, um no Empire State

Building em 1945 e outro em Wall Street em 1946, ou seja,

P B | A

2

25000

. Nesse caso a

probabilidade da primeira colisão ser de uma ataque terrorista é:

1

20000

P A | B

38%

1

2

19999

1

20000 25000 20000

1

Agora vamos atualizar a prior para

P A 38%

e recalcular a probabilidade do segundo ataque ser

terrorista:

P A | B

1 0.38

99.99%

2

1 0.38

0.62

25000

Inferência Bayesiana.

Fisher não gostou das estimativas da prior e das probabilidades

P B | A

e

P B | A

que lhe

pareceram muito subjetivas. No fundo o método de Fisher é estimar os parâmetros da distribuição através

das observações e com eles calcular as probabilidades.

A robustez da aparente fraqueza da metodologia de Bayes, entretanto, é o fato de que uma atualização

dos dados usando as probabilidades posteriores como prior do processo seguinte converge para a

probabilidade real. Mas para isso é necessário provar que a probabilidade converge para a probabilidade

real à medida que se atualizam as informações da inferência Bayesiana.

http://en.wikipedia.org/wiki/Bayesian_inference

Variável aleatória.

Trabalhar com funções de conjuntos é bem mais complicado do que trabalhar com funções numéricas.

Por isso pode ser interessante criar uma associação entre os conjuntos A do espaço amostral e os

númeors. Ou seja, vamos criar uma nova função de conjuntos f :

que permite associar um

número a cada evento. Assim poderemos trocar P A por P x onde x é uma variável aleatória

definida pela função de conjunto x A :

é uma função de conjunto com imagem Rx . Ou seja, a

variável aleatória não é uma variável mas uma função. Para distinguir a função de conjuntos do valor que

ela pode assumir vamos designar por xv a função e x o seu valor. Para ser uma variável aleatória a função

de conjunto precisa satisfazer poucas condições.

1. O conjunto xv x é um evento para x

2.

P xv P xv 0

Note que a um conjunto evento do espaço amostral estamos associando uma probabilidade e um valor

da variável aleatória xv . Queremos eliminar a necessidade de passar pelo estágio intermediário dos

conjuntos para chegar diretamente na probabilidade. Nossa questão então é como andar na direção

inversa. Ou seja, dado que xv x qual o conjunto A a ele associado e qual P A . Como garantir que o

mapeamento inverso xv1 x :

tenha a estrutura definida para a probabilidade?

Figura xxx. Mapeamento do conjunto dos eventos para a probabilidade e para a variável aleatória. Seta

vermelha: mapeamento direto da variável aleatória para a probabilidade.

Suponha que o conjunto de pontos B Rx seja xv1 B A / A xv1 x x B . Esse conjunto

tem que ser um evento. Assim, dado o espaço de probabilidade , , p a função xv A x é uma

função variável aleatória relativa ao campo de Borel se, e somente se, ela é uma função com domínio

e imagem Rx tais que A / xv A x, A para todo x Rx . Vamos dar um exemplo para

evitar que o tópico fique muito abstrato. Jogar uma moeda duas vezes seguidas. Qual o conjunto de

possibilidades, ou o espaço amostral? Como em português as possibilidades são CARA e COROA, ambas

começando com C, vamos chamar as possibilidades pelas iniciais H e T dos nomes em inglês, Head ou Tail.

Nesse caso o espaço amostral é dado pelo conjunto:

H , H ; H , T ; T , H ; T , T . O conjunto

de todos os possíveis subconjuntos terá 2 4 16 elementos. Vamos agora definir a variável aleatória

xv : A

como:

0 se A T , T

xv A 1 se A H , T ; T , H

2 se A H , H

Ou seja xv A é o número de vezes em que H aparece. A pergunta é xv A é uma v.a. frente a 3 dado

por:

; ; H , H ;T , T ; H , H ; T , T ; H , T ; T , H ; H , T ; T , H ; H , H ;

3

?

H

,

T

;

T

,

H

;

T

,

T

1

Vejamos quem é xv x xo .

se x 0

T , T se 0 x 1

xv1 , x

T , T ; H , T ; T , H se 1 x 2

T , T ; H , T ; T , H , H , H se x 2

Como 3 ;

T , T T , T ; H , T ; T , H

3

3

e 3 então xv é uma v.a. frente a 3

Um aspecto importante a notar aqui é que se x1 x2 então os eventos xv1 , x1 xv1 , x2

.

Função Distribuição de Probabilidade

Também chamada Função Distribuição Acumulada [Cumulative Density Function] [CDF]. Para evitar

confusão com a Função Densidade de Probabilidade vamos denotar a Função Distribuição de

Probabilidade por CDF. Sabendo que o conjunto A xv x é um evento, podemos calcular P A

para qualquer valor de x. Assim a CDF é definida por:

F x P xv x x

Exemplo: jogar uma moeda desonesta, com probabilidade p de H e q de T , p q 1 , uma vez.

Vamos criar a v.a. xv H 1 e xv T 0 . Essa distribuição é conhecida como distribuição de Bernoulli.

Nesse caso

se x 0

x , x

T se 0 x 1

T , H se x 1

1

v

0 se x 0

Como P 0 , P T q e P 1 então F x q se 0 x 1 .

1 se x 1

Figura xxx. FDA ou CDF da Distribuição de Bernoulli.

Propriedades da CDF

1.

F 1 e F 0 .

2. Se x2 x1 então F x2 F x1 .

3. Se F xo 0 então F x 0 x xo .

4.

P xv x 1 F x .

5.

F x é contínua pela direita, ou seja, F x F x .

6.

P x1 xv x2 F x2 F x1 .

7.

P xv x F x F x .

temos que P

x

v

P x xv x F x F x

x

v

x F será a descontinuidade no ponto x.

Figura xxx. Descontinuidade na Função Distribuição de Probabilidade fornece P

P x1 xv x2 F x2 F x1 .

Um aspecto importante aqui é o fato de que a distribuição pode ser

a. Contínua

b. Discreta

c. Mista

(a)

0

x F x F x . Se F é contínua, então P xv x 0 mas se F for

descontínua, nesse caso, P

8.

fazendo

(b)

(c)

Figura xxx. (a) Distribuição contínua; (b) Discreta e (c) Mista

Função Densidade de Probabilidade [fdp]

x

v

x .

Essa função é definida como a derivada da função distribuição de probabilidade: f x

dF x

. Note

dx

que dimensão da fdp é probabilidade por unidade de x, e não probabilidade. Assim também podemos

definir a CDF em termos da fdp como: F x

x

f x dx . O único problema aqui é que a F(x) pode ter

pontos de descontinuidade nos quais a função não é diferenciável. Antes de lidar com as

descontinuidades, através das funções Delta de Dirac, vamos extrair as propriedades da fdp supondo que

F é diferenciável.

Propriedades da Função Densidade de Probabilidade [fdp]

1.

F x h F x

0 uma vez que F x h F x se h 0 e

h 0

h

F x h F x se h 0 , pela propriedade (2) da CDF. Poderíamos simplesmente ter

f x 0 pois lim

afirmado que se F é sempre crescente então f x

dF

0.

dx

2.

f x dx F 1

3.

P x1 xv x2 F x2 F x1

x2

f x dx

x1

4.

P x xv x dx f x dx , ou seja, f x dx é a probabilidade de encontrar a v.a. xv

entre x e x dx .

Função Delta de Dirac ou Função Impulso

Para lidar com as derivadas das descontinuidade necessitaremos das funções Delta de Dirac. Kronecker

definiu a delta de Kronecker, muito útil no cálculo matricial e tensorial, dada por:

1 se i j

0 se i j

ij

A matriz identidade pode ser escrita em termos do delta de Kronecker como I ij ij . Em particular ela

tem a propriedade de que:

n2

a

j n1

j ij

a se i n1 , n2

i

0 se i n1 , n2

Pois o único termo não nulo do produto a j ij será o termo com j i .

Agora queremos uma função que opere da mesma forma para as integrais, ou seja, para b a :

1 se xo a, b

f x x x dx f x 1 x f x 0

b

o

o

o

a ,b

se xo a, b

o

a

Nesse caso queremos x xo 0 se x xo , entretanto a área sobre a delta tem que ser 1 pois:

xo

xo

f x x x dx f x x x dx f x

o

o

xo

o

o

xo

Em outras palavras, estamos em busca de uma função que é nula para todo x xo mas que tenha área

unitária, ou seja

x xo dx 1 . Note que a exigência de que

x x dx 1 implica em que a

o

dimensão da delta é de 1/x. Se a largura da função delta de Dirac vai a zero então a altura deve ir para o

infinito para garantir a área sobre a curva.

Como construir a Delta de Dirac

Partindo de uma função n x xo de largura limitada, ou seja, n x xo 0 quando x xo m ,

mas cuja área seja 1 e independente de n. Além disso, é preciso que n então m 0 , ou seja, a

largura da delta vai a zero. Fazendo o n tender a infinito então teremos a função Delta de Dirac como

x xo lim n x xo . Qualquer função n x xo com as propriedades acima pode ser usada

n

para construir a função Delta de Dirac.

0 se x xo

n .

Um exemplo é a função retângulo: n x xo

n se x x

o

n

xo

A área sobre a curva vale

2n

x x dx

n

o

xo

2n

n

n

dx

1 . Se n vai a infinito a largura vai a zero,

n

a altura a infinito e a área se mantém constante. Vale notar que as funções densidade de probabilidade

são excelentes candidatas à função Delta de Dirac, pela propriedade

f x dx 1 . Assim poderíamos

usar distribuições Normais, de Cauchy ou qualquer outra com a propriedade da largura ir diminuindo e

tendendo a zero quando determinado parâmetro vai a inifinito ou zero. Uma boa representação gráfica

para a função delta de Dirac é a de uma seta vertical na posição xo.

Delta de Dirac como a derivada da função Degrau.

O importante nesse ponto é o uso da delta de Dirac para obter a derivada de funções descontínuas. Vamos

considerar a função de Heaviside, ou função degrau, definida como:

1 se x xo

H x xo

0 se x xo

Essa função é descontínua em x xo e, portanto, não diferenciável. Agora considere a função logística

dada por H n x xo

x H n x xo

1

n x xo

1 e

1

e

n x xo

. Note que se x xo então x xo 0 e n x xo 0 logo para

0 . Já para x então e

n x xo

temos que H n 0 e H n 1. Para x xo H n 0

0 e Hn x xo 1 . Assim

1

. A função Hn é diferenciável

2

n x x

dH n

ne o

e essa derivada tem obviamente uma área sobre a curva igual a 1, pois

2

dx

1 e n x xo

dH n

dx H n H n 1 0 1 . Aumentando o n se percebe que a função logística se

dx

parece mais e mais com a função degrau e que a largura de sua derivada vai diminuindo. Figura xx mostra

Hn e

dH n

para n 1, 2, 4,10 e 20 .

dx

Figura xxx. Função Logística H n e e sua derivada

Daí se percebe, então, que para n , teremos:

dH n

para n 1, 2, 4,10 e 20 .

dx

d

H x xo x xo .

dx

f1 x se x xo

f 2 x se x xo

Derivando funções descontínuas3. Uma função descontínua da forma f x

pode ser escrita como f x f1 x f 2 x f1 x H x xo . Agora podemos derivar esse função

pela regra do produto como:

f x f1 x f 2 x f1 x H x xo f 2 xo f1 xo x xo

Ou seja f x f1 x f 2 x f1 x H x xo f x xo onde f é a descontinuidade em

xo .

Apêndice xxx mostra algumas propriedades da função Delta de Dirac. As duas que mais utilizaremos são:

b

1.

f x x x dx f x 1 x

o

o

a ,b

o

a

2.

d

H x xo x xo

dx

Função densidade de probabilidade de funções descontínuas.

Agora a função Delta de Dirac dá conta de todas as descontinuidades da distribuição de probabilidade e

não é mais necessário distinguir os casos discretos, mistos e contínuos e as definições: f x

3

dF x

e

dx

A função delta de Dirac só deve ser usada para descontinuidades finitas, ou seja, para funções com variações finitas. No caso das distribuições

as descontinuidades são todas finitas e a representação da derivada da descontinuidade como a funçaõ delta é sempre válida.

F x

x

f x dx

são válidas em geral. Um bom exemplo é o caso da distribuição de Bernoulli onde

F x qH x pH x 1 e f x q x p x 1 . Notem que a fdp ficou com a dimensão de

probabilidade por unidade de x após a multiplicação pelas deltas. Outro exemplo interessante é o de um

dado honesto com probabilidade 1/6 para cada face e a v.a. sendo o número da face. Nesse caso a fdp

será dada por:

f x

1

x 1 x 2 x 3 x 4 x 5 x 6

6

Note que a CDF sai automaticamente da fdp através da integração:

x

x

x

x

x

x

1

F x x 1 dx x 2 dx x 3 dx x 4 dx x 5 dx x 6 dx

6

1

que leva a F x H x 1 H x 2 H x 3 H x 4 H x 5 H x 6 pois

6

x

x x dx H x x .

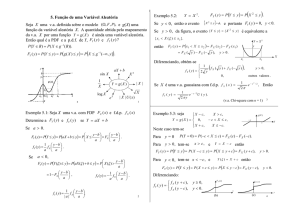

Função de uma Variável Aleatória

Uma nova v.a. y g x pode ser criada a partir de uma v.a.

x

desde que os seguintes requisitos sejam

satisfeitos:

O conjunto g x y é um evento.

Os eventos g x devem ter probabilidade nula, ou seja, g x .

Imagem de

x

está contida no domínio de

g.

Note a necessidade desses requisitos. Se g x y não é um evento não existe probabilidade associada

f y 0 , exigido para uma FDP. O terceiro é um pouco

mais sutil. Precisamos ter certeza de que ao varrer y todos os valores possíveis de x , ou seja, a imagem

ao mesmo. O segundo requisito garante que

da função de conjuntos

x xv A , estarão incluídos. Não podem faltar valores de x

superposição de intervalos de

nem pode haver

x . A ausência de superposição é garantida pelo fato de que g x é uma

função, ou seja, o mesmo valor de

calcular

x

só pode ser associado a apenas um valor de

y g x . Podemos

Fy y da seguinte forma:

Encontrar todos os intervalos de

x

para os quais g x y

Calcular a probabilidade de cada um dos intervalos e somá-los

Note que

g x

pode ser inclusive descontínua, constante, divergir, que mesmo assim poderemos

encontrar a nova distribuição de probabilidade. Vejamos um exemplo de caso patológico. Para simplificar

considere que x segue uma distribuição contínua bem comportada, como a normal da figura 17(a). Agora

vamos fazer

y sign x mostrada na figura 17(b). Note que nesse caso o conjunto g x y 1

é vazio, logo tem probabilidade nula; o conjunto

conjunto

g x y , para qualquer 0 y 1 , corresponde ao

x 0 , ou seja, com probabilidade p 0, 4

g x y

para qualquer

1 y

pelo gráfico da

F x . Note que, por outro lado,

representa todo o espaço amostral,

probabilidade 1. A função distribuição de probabilidade de

x

, logo é associado à

y nesse caso é dada pelo gráfico da figura 17

(c).

(a)

(b)

(c)

Figura 17 - F (x) de uma Normal (a), a CDF da função sign(x) (b) e a CDF da F(y) (c)

No caso especial em que

dada por fdp y

k

Prova:

g x

é diferenciável a função densidade de probabilidade da nova variável é

fdp g 1 y

g g 1 y

onde g xi y .

CDF y y CDF y

P y yv y y

,

lim

y 0

y 0

y

y

fdp y lim

ou

seja,

P y yv y y fdp y dy . A pergunta é, então, qual o conjunto de pontos de x que leva ao

conjunto para y yv y y ? É aquele em que y g x y y , como mostra a figura 20 onde

existem 3 raízes g x y . Note que o dx2 da figura é negativo por que

dg

é negativa nessa região,

dx

enquanto dx1 e dx3 são positivos.

Figura 20 - Três regiões em que y g x y y , definindo x1 , x2 e x3 . Nas regiões 1 e 3 g x é

positiva, logo dx1 e dx3 também são positivos. Já na região 2 g x é negativa então dx2 é negativo.

Note que dy g x dx , então dx

1

dy será negativo onde g x 0 . Vamos separar as raízes

g x

com g x 0 e denotá-las pelo índice

i , das raízes com g x 0 denotadas pelo índice j . Nesse

caso:

P y yv y y P xi xv xi dxi P x j dx j xv x j

i

j

com dxi 0 e dx j 0 . Usando as propriedades da fdp temos que:

P y yv y y fdp xi dxi fdp x j dx j fdp xi

i

j

i

dy

dy

fdp x j

g xi j

g x j

P y yv y y fdp xi

i

dy

dy

dy

fdp x j

fdp xk

g xi j

g xk

g x j k

Onde a somatória é feita em k tal que g xk y , independente do sinal de g x . O módulo dá conta

dos casos em que g x é positiva ou negativa. Com isso temos, no final:

fdp y

k

x

Exemplo 1: Vamos transformar a variável

fdp x

x

fdp g 1 y

g g 1 y

da distribuição normal cuja fdp é dada por

2

2

1

e 2 para y x 2 , Im y [0, ) . Note que a função inversa de x 2 y admite duas

2

raízes: x y e x y . Não há raízes para y 0 , logo fdp y 0 se

g x

y 0 . Além disso,

dy

2 x então g x1 2 y e g x2 2 y . Nesse caso, então:

dx

1

fdp y

2

y

2

2y 2

2

e

e

2 y 2 y

y

H y 1 y 12 e 2 2 H y .

2

y

, 1 . A distribuição

2

Essa é a distribuição 2

2

faz parte das distribuições Gama que será

apresentada no capítulo de aplicações e distribuições.

Exemplo 2: Distribuição log-Normal. Vamos transformar a variável

x

da distribuição normal para y e x

, x ln y . Nesse caso g x e , g x e y e a função inversa g

x

x

1

y ln y . Como a função

y e x é injetora então só há uma raiz x ln y na qual g x y . Não há raízes para y 0 . O resultado

da transformação é:

fdp y

Operação ESPERANÇA.

1

2 y

e

ln y 2

2 2

H y

Esperança de uma v.a.: E xv

x f x dx

Os físicos também gostam da notação x E x , as vezes também se usa x embora seja necessário

1

xi é a média obtida em uma amostragem e não a esperança da

n i

tomar cuidado porque x

população completa. Nem sempre x x embora se espere que sejam próximos, ou seja, x é uma boa

inferência de x E x . Note que o caso discreto sai automaticamente da utilização das funções delta

de Dirac, pois: E xv

x p x x dx p x x x dx p x

i

i

i

i

i

i

i i

pelas propriedades da

i

delta.

Esperança de uma g x onde x é uma v.a.

Vamos criar a v.a. y g x , então E y

Novamente f y dy

f x dx

i

i

y f y dy e mostrar que E g x g x f x dx .

e devemos notar que xi x j e que não há superposição dos

i

intervalos correspondentes a diferentes raízes. Assim quando y varre o eixo vertical, os intervalos de x vão

preenchendo completamente o eixo horizontal. Nesse caso y f y dy

g x f x dx

i

i

i

e

i

E y

y f y dy

g x f x dx . Daí extraímos que:

E g x

g x f x dx

Casos particulares:

1.

g x ax logo E ax

axf x dx a xf x dx aE x . Constantes entram e saem da

operação esperança.

2.

g x q x h x

E q x h x

então

E g x

q x h x f x dx ,

q x f x dx h x f x dx finalmente chegamos a que a esperança

da soma é a soma das esperanças: E q x h x E q x E h x .

Momentos de ordem n:

O momento de ordem n, se existir, é definido por: M n E[ x ]

n

x f x dx . A condição para a

n

existência do momento é que a integral acima exista. Se para valores muito grandes de

x , i.e,

comportamento assimptótico de f(x) para x , a f(x) cai com uma lei de potência do tipo

1

, então só existirão momento até ordem n m 2 . Note que se n m 1 então

xm

f x

Mn

xo

xn

dx

xm

1

x dx ln x que diverge.

xo

Algumas propriedades dos momentos são:

1.

M o 1 e M1 E x , pois M o

f x dx 1 e M 1 E[ x]

x f x dx .

Momentos Centrados de ordem n.

O momento centrado de ordem n é definido por: mn E[ x ]

n

x f x dx .

n

Os

momentos centrados possuem as propriedades:

1.

mo 1 , novamente mo

f x dx 1

2.

m1 0 , pois m1

x f x dx x f x dx f x dx 0 .

2

3. A variância é definida pelo m2 , pois m2

x f x dx .

2

4. Se f x é simétrica, ou seja, f x f x , então todos os momentos centrados

ímpares serão nulos.

f x f x , e ímpares,

a. Integração em intervalo simétrico de funções pares,

f x f x . Queremos

a

a

a

a

a

a

0

a

a

0

0

f x dx f x dx

a

a

f x f x dx .

0

a

f x dx 2 f x dx . Já se f é ímpar então

0

f x dx 0 .

x f x dx x f x dx x f x dx . Mudando, então

n

de

n

integração

z x,

para

0

mn

a

f x dx

então

a

n

No nosso caso mn

variável

x x

a

a

f x dx . Na primeira integral mudar

0

Se f é par então f x f x 2 f x e

f x f x 0 e

a

para

0

f x dx f x dx

f x dx

a

variável

a

0

f x dx

x z,

teremos

z f z dz z f z dz z f z dz z f z dz ,

n

n

n

portanto:

n

0

logo

se

0

f x f x e n é ímpar então mn

z

n

f z f z dz 0 .

0

Relação entre os Momentos Centrados e não centrados.

Podemos usar binômio de Newton a b

n

n

n!

k ! n k ! a

nk k

b para encontrar a relação entre os

k 0

momentos centrados e não centrados.

mn E[ x ]

n

x

n

n

nk

mn 1 n k M k

k 0 k

n

n

n!

nk

f x dx

1 nk x k f x dx logo

k 0 k ! n k !

Casos particulares:

1.

mo M o 1

2.

1

1

10

11

m1 1 10 M o 1 11M1 M o M1 0

0

1

3.

2

2

2

2

1

0

m2 1 2 M o 1 1M1 1 0 M 2 2 2 2 M 2 M 2 2

0

1

2

3

3

3

3

3

2

1

m3 1 3 M o 1 2 M1 1 1M 2 M 3

4.

0

1

2

3

3 3 3 3 M 2 M 3 M 3 3 M 2 2 3

5.

m4 4 M o 4 3 M1 6 2 M 2 4 M 3 M 4 M 4 4 M 3 6 2 M 2 3 4

A volta, obter os momentos não centrados em termos dos centrados, pode ser feita da seguinte forma:

n

n!

k

M n E[ x ] E[ x ] x f x dx

nk x f x dx

k 0 k ! n k !

n

n

logo: M n

n

n

k 0

k

nk

n

mk

1.

M o mo 1

2.

M1 1mo 0 m1 pois mo 1 e m1 0 .

3.

M 2 2 mo 21m1 m2 2 2

4.

M 3 3mo 3 2 m1 3 1m2 m3 3 3 2 m3

5.

M 4 4 6 2 2 4 m3 m4

Função Geradora de Momentos (FGM)

Considere a seguinte função da variável t: M (t ) E (e tx )

e

tx

f ( x ) dx . Podemos usar a expansão em

t n xn

e

n 0 n!

tx

série de Taylor:

, para obter: M (t )

com a série de Taylor da própria M t

tn

tn

n

x

f

(

x

)

dx

M n . Se comparamos

n 0 n !

n 0 n !

dn

M ( n ) (0) n

t vemos que M n n M t . Por

n!

dt

n0

t 0

M (t )

isso a função é chamada de geradora dos momentos. Para gerar os momentos centrados devemos

multiplicar a função geradora dos momento por e t , uma vez que e t M (t )

e

t x

f ( x) dx , logo

e t M (t )

n 0

d n t

mn n

tn

n

e M t .

m

.

Daí

se

percebe

que

x

f

(

x

)

dx

t

n

n !

dt n

n 0 n !

t 0

Função Característica

A grande dificuldade da função geradora dos momentos é a convergência da integral

M (t ) E (e tx ) e tx f ( x ) dx por conta do etx . Se usarmos e i tx entretanto, não teremos mais tantos

i tx

problemas de convergência uma vez que e 1 para qualquer x e t . Assim a função característica é

definida por: (t ) E (e )

e

itx

itx

f ( x) dx . Se a função geradora dos momentos existe então

t M it . Note que 0 1 . Além disso, podemos mostrar que

(t )

e

itx

f ( x) dx

e f ( x) dx

itx

(t ) 1 , pois

e

itx

f ( x)dx

f ( x)dx . A relação com os momentos só

precisa

ser

(t )

n 0

i nt n

n!

ligeiramente

modificada

x n f ( x) dx

n 0

uma

vez

que

i nt n x n

,

n!

n 0

eitx

levando

a:

inM n n

( n ) (0) n

t

t . Se comparamos com a série de Taylor (t )

n!

n!

n0

vemos que M n i

n

dn

t . Novamente, os momentos centrados podem ser obtidos

dt n

t 0

multiplicando a função característica por e i t , obtendo mn i

n

d n i t

e t .

dt n

t 0

Além da função característica ser mais poderosa do que a função geradora dos momentos a operação

para sua obtenção é conhecida desde o século XIX e chama-se Transformada de Fourier:

t FT f x

e

ixt

f x dx

A associação entre t e f x é biunívoca de modo que ela admite transformada inversa dada por:

f x FT 1 t

1

2

e

ixt

t dt

Podemos verificar a transformada inversa facilmente, substituindo a t abaixo e usando o fato de que

x x

f x

1

2

1

2

e

i x x t

dt , demonstrado no apêndice xxx:

ixt

e

ixt

e f x dxdt

1

f x dx

2

i x

e

x t

dt f x x x dx f x

Isso nos permite reconhecer a f x dada a t e vice-versa. Transformadas de Fourier, e

transformadas em geral, são uma ferramenta das ciências exatas e da matemática há longo tempo e

existem milhares de tabelas associando as funções e suas transformadas assim como um listagem extensa

de suas muitas propriedades. Uma propriedade muito importante na teoria da probabilidade é o teorema

da convolução. No apêndice apresentamos uma lista introdutória das transformadas de Fourier e

mostramos como calcular essas transformadas numericamente usando o Excel.

Transformadas

Transformadas integrais são relações entre duas funções através da equação integral

t2

( s) K ( s, t ) f (t ) dt , onde K ( s, t ) é chamado de Kernel da transformada. Note que após a integração

t1

em t a função resultante só depende de s. Entre as mais conhecidas temos a transformada de Fourier

0

( s) eist f (t ) dt , em que o Kernel é dado por K (s, t ) eist , e a de Laplace ( s ) e st f (t ) dt , em

que o Kernel é dado por K ( s, t ) e st . Note que as funções geradoras dos momentos são uma

transformada de Laplace de dois lados. Mas essas não são as únicas, existem transformadas de Cauchy,

de Hadamard, de Hankel, etc. São aplicadas em muitas áreas desde processamento de sinais e imagens

(tomografia utiliza as transformadas de Hadamard), solução de equações diferenciais até a estatística

avançada. Pode-se usar a transformada de Fourier de um sinal acústico de um tiro captado por um

microfone para distinguir que tipo de arma foi utilizada e a distância do disparo ao microfone. Com três

desses microfones saberíamos onde o disparo foi feito, com que arma e em que momento.

Análise Multivariada.

Vamos agora criar uma função vetorial de conjunto

x1 , x2 ,

, xn

assim como

em que cada

xj

xv A :

é uma v.a. Neste caso

n

que possui as componentes

xvi xi e xvj x j são dois eventos,

xvi xi xvj x j xvi xi , xvj x j . Para facilitar a compreensão e as

demonstrações vamos trabalhar apenas com o caso bivariado, ou seja, duas v.a.s, e depois generalizar

para n . Facilita, nesse estágio, chamar uma v.a. de x e a outra de y .

Distribuição conjunta [Joint Distribution]

F x, y P xv x, yv y

Propriedades:

1.

F , y F x, 0

2.

P x1 xv x2 , yv y F x2 , y F x1 , y

e

F , 1 .

3.

P x1 xv x2 , y1 yv y2 F x2 , y2 F x1 , y2 F x2 , y1 F x1 , y1

4.

2 F

P x xv x x, y yv y y

x y

xy

Densidade de probabilidade conjunta [joint density probability]

Definimos a fdp conjunta agora como:

x

O reverso é dado por: F

f x, y

2 F x, y

xy

.

y

x, y f u, v dudv

Se queremos a probabilidade de encontrar

x, y A então devemos fazer a seguinte integral múltipla:

P x, y A

x, y A

f x, y dxdy

Também exigimos aqui que:

F , f x, y dxdy 1

Para

ser

uma

densidade

de

probabilidade

multivariada,

então,

f x, y 0

e

f x, y dxdy 1.

Distribuição e Densidades Marginais:

Suponha que queremos a estatística de apenas uma das variáveis sem interessar o valor da outra.

xv x xv x, yv assim como yv y xv , yv y . Então

Fx x F x, e Fy y F , y são as distribuições marginais de x e de y . Note então

Notamos que

que:

x

x

Fx x f u, y dudy f u, y dy du

e

x

Fy y f x, v dxdv f x, v dx dv

y

Ou seja integra-se em todas as possibilidades das outras variáveis para se obter a distribuição de uma

variável independente dos valores das outras.

Nesse caso as densidades marginais serão dadas por:

fx x

d

d x

Fx x

f

u

,

y

dy

du

f x, y dy

dx

dx

e

d

d y

fy y

Fy y

f x, v dx dv f x, y dx

dy

dy

Fica claro então que:

f x x dx f x, y dxdy 1 e f y y dy f x, y dxdy 1.

Caso discreto:

De forma análoga à distribuições univariadas os casos de distribuições discretas pode ser implementado

com a função delta de Dirac generalizada para mais de uma dimensão definida como:

x xo x1 x1o x2 x2o xn xno .

Funções escalares

f x :

n

multivariadas.

Vamos criar a v.a. zv à partir das v.a.s

vetor em

2

x

e

y

a um número real em

distribuição de probabilidade de

z

. Nesse caso o evento

z

g x, y

que associa um

zv z g x, y z

g x , y z

f x, y dxdy

dada por:

fz z

z g x , y z dz

A integral pode complicar devido à restrição

f x, y dxdy

g x, y z

ou

pode ser vantajoso trocar as variáveis de integração para

z g x, y z dz . Em vários casos

u x, y

e

w x, y

através da regra do

Jacobiano:

f x, y dxdy f u, w J u , w dudw

V

V

Onde o Jacobiano é dado pela matriz:

x

u

J det

x

w

y

u

.

y

w

Operação esperança multivariada:

Agora a operação esperança de qualquer função escalar das v.a.s

x

e

y z g x, y é dada por:

E g x, y z f z z dz g x, y f x, y dxdy

Dessa definição podemos extrair as seguintes propriedades da esperança:

1.

E k k

e a

será dada por:

Fz z

enquanto a fdp da v.a.

através da função escalar zv

g x, y k

Se

é

uma

constante

então:

E k k f x, y dxdy k f x, y dxdy k

2.

E g x, y h x, y E g x, y E h x, y

E g x, y h x, y g x, y f x, y dxdy h x, y f x, y dxdy

2.1.

E x y E x E y

Momentos conjuntos:

No caso multivariado definimos os momentos por:

M kp E x k y p x k y p f x, y dxdy

A generalização para

M k1k2

kn

n

v.a.s é:

E x1k1 x2k2

xnkn

k k

x11 x22

xnkn f x1 , x2

, xn dx1dx2

dxn

Notamos imediatamente que:

M 00 m00 f x, y dxdy 1 .

possuem nomes específicos:

M10 x E x x f x, y dxdy x f x x dx

M 01 y E y y f x, y dxdy y f y y dy

Com eles podemos definir os momentos centrados por:

Alguns desses momentos

k

mkp E x x y y

p

x x

k

y y

p

f x, y dxdy

Novamente percebe-se que:

m00 f x, y dxdy 1 e que:

m10 x x f x, y dxdy x f x, y dxdy x f x, y dxdy

m10 x x 1 0 , da mesma forma que m01 0 .

Os momentos centrados com nomes específicos são as variâncias:

V x x2 m20 x x f x, y dxdy

2

V y

y2

m02 y y

2

f x, y dxdy

e a covariância:

cov x, y m11 x x y y f x, y dxdy

Nota-se então que:

V x cov x, x x x f x, y dxdy

2

V y cov y, y y y

2

f x, y dxdy .

A covariância tem as seguintes propriedades:

1.

cov x1 , x2 cov x2 , x1

2.

cov x1 x2 , x3 cov x1 , x3 cov x2 , x3 , pois:

pois

x1 1 x2 2 x2 2 x1 1

x1 x2 1 2 x3 3 x1 1 x3 3 x2 2 x3 3

3.

cov x, y E xy E x E y

cov x, y x x y y f x, y dxdy xy x y y x y x f x, y dxdy

cov x, y xy f x, y dxdy x y f x, y dxdy

y x f x, y dxdy y x f x, y dxdy

cov x, y E xy x E y y E x y x

cov x, y E xy x y y x y x E xy x y E xy E x E y

4.

cov x, y cov x, y

cov x, y E xy E x E y E xy E x E y E xy E x E y

5.

cov x, k 0

onde

k

é uma constante.

cov x, k E kx E x E k kE x kE x 0

Essas propriedades dão origem as seguintes propriedades da variância:

1.

2

V x E x 2 E x

2.

V kx k 2V x pois V kx cov kx, kx k 2 cov x, x

3.

V x 2V x

pois V

x cov x, x E x2 E x E x

V x cov x, x cov , x cov x, cov x, x 2 cov x, x

4.

V x y 2V x 2V y 2 cov x, y

Corolário: V

x y V x V y 2cov x, y

V x y cov x y, x y cov x, x cov x, y

cov y, x cov y, y 2 cov x, x cov x, y cov y, x 2 cov y, y

2 cov x, x 2 cov x, y 2 cov y, y

Variáveis aleatórias independentes:

Se

os

xv A

eventos

e

yv B

são

independentes

então

P xv A yv B P xv A P yv B . Neste caso então:

F x, y Fx x Fy y e f x, y f x x f y y

Experimentos independentes:

Suponha que o espaço dos eventos da v.a.

x

seja

x

e o espaço da v.a.

um experimento conjunto, cujos eventos pertencem ao espaço amostral

y

seja

y , e que ao realizar

x y , o resultado de

um não interfere no outro. Matematicamente estamos afirmando que:

x 1 , 2 x 1 e y 1 , 2 y 2

Então as v.a.s

x

e

y

são independentes. Exemplo de v.a.s independentes: lançar dois dados de cores

diferentes simultaneamente e definir

x

como o resultado de uma cor e

y

como o resultado da outra

cor. O resultado de um dado não interfere no resultado do outro dado. Exemplo de v.a.s não

independentes: pintar metade das faces de um dado de uma cor e a outra metade de outra cor. Nesse a

cor e a numeração do dado estão associadas e o resultado numérico interfere no resultado da cor. Por

exemplo se o resultado para

Teorema 1: Se

Prova: se

x

e

x

foi 1, o resultado para

y

jamais poderá ser 1.

y são independentes, então g x e h y

também são independentes.

xv A e yv B são independentes, quaisquer dois sub-conjuntos de xv A e

yv B serão independentes. Assim g x g xv A e h y h yv B é a

condição para poder calcular as funções

g x e h y

Teorema 2. Se

x

e

g x

e

h y . Portanto se x

e

y são independentes, então

são independentes.

y são independentes, então E xy E x E y .

E xy x y f x, y dxdy x y f x x f y y dxdy x f x x dx y f y y dy

Teorema 3. Se

x

e

y são independentes, então cov x, y 0 .

cov x, y E xy E x E y E x E y E x E y 0

A covariância, portanto, nos fornece alguma informação sobre a independência entre v.a.s. Se

cov x, y 0

então

x

e

y

são independentes. O que ocorre se

cov x, y 0

ou

cov x, y 0 ?

Note

que

os

produtos

x x y y

e

x x y y

em

um

gráfico

x x vs y y ou x x vs y y serão positivos no primeiro e terceiro quadrantes,

e , e negativos no segundo e quarto quadrantes, e .

A figura xxx (a) mostra uma nuvem de pontos com uma concentração maior de pontos no primeiro e

terceiro quadrantes, terá

xi x yi y

positiva, ou seja, com uma covariância positiva.

i

Percebe-se dessa nuvem que a v.a.

y

tende a crescer quando a v.a.

x

cresce, e a decrescer quando

x

decresce. O espalhamento da nuvem informa que essa tendência não é perfeita é que existe algum grau

de independência estatística da v.a.

y

em relação à v.a.

x . Nesse caso afirmamos que as v.a.s x

são positivamente correlacionadas. O gráfico da figura xxx(b) mostra o caso em que

e

y

y x , totalmente

dependente, ou totalmente correlacionas, e se percebe a reta perfeita em que nenhum dos pontos se

desvia da reta.

(a)

(b)

Figura xxx. (a) caso de duas variáveis positivamente, mas não perfeitamente, correlacionadas. (b) Caso de

duas variáveis positivamente e perfeitamente correlacionadas.

Já a figura xxx (a) mostra uma nuvem de pontos com uma concentração maior de pontos nos segundo e

quarto quadrantes, com

xi x yi y

negativa, ou seja, com uma covariância negativa.

i

Percebe-se dessa núvem que a v.a.

y

tende a decrescer quando a v.a.

decresce. Nessa situação afirmamos que as v.a.s

da figura xxx(b) mostra o caso em que

x

e

y

x

cresce, e a crescer quando

x

são negativamente correlacionadas. O gráfico

y x , perfeitamente anti-correlacionada, em que nenhum dos

pontos se desvia da reta negativamente inclinada.

(a)

(b)

Figura xxx. (a) caso de duas variáveis positivamente, mas não perfeitamente, correlacionadas. (b) Caso de

duas variáveis positivamente e perfeitamente correlacionadas.

Se as v.a.s são independentes então a nuvem se espalha igualmente pelos quatro quadrantes levando a

xi x yi y 0 como mostra a figura xxx.

i

Figura xxx. Caso de duas variáveis descorrelacionadas.

Coeficiente de Correlação:

A medida da covariância como uma medida da independência entre duas v.a.s, entretanto, apresenta

alguns

problemas.

Primeiro

trata-se

dim cov x, y dim x dim y . Se x

e

de

uma

medida

com

dimensão,

y têm dimensão de distância, ou massa, por exemplo,

a covariância terá dimensão de área, ou massa ao quadrado. Precisamos de uma grandeza adimensional

relacionada à covariância para ser utilizada como um grau de independência entre v.a.s. Então vamos

construir o coeficiente de correlação adimensional definido por:

rxy r x, y

cov x, y

cov x, x cov y, y

cov x, y

V x V y

Com essa definição ganhamos mais do que simplesmente a obtenção de uma grandeza adimensional

porque podemos mostrar que se trata de um número que varia entre +1 e -1, com zero significando

independência estatística, +1 correlação positiva perfeita e -1 correlação negativa, ou anti-correlação,

perfeita.

Teorema do coeficiente de correlação:

1 rxy 1 .

Prova usando a desigualdade de Schwartz:

E x x y y

2

0

pois se trata da esperança de uma quantidade

positiva. Desenvolvendo o quadrado temos:

2

x x y y 2 x x 2 2 x x y y y y

2

Logo

E x x y y

2

2

2 E x x 2 E x x y y E y y

que pode ser escrito em termos das variâncias e covariâncias como:

E x x y y

2

2V x 2 cov x, y V y

Isso nos leva à desigualda da equação quadrática em

dada por:

V x 2 2cov x, y V y 0 com V x 0 e V y 0

A desigualdade

a 2 b c 0 com a 0 só pode ser satisfeita se a 2 b c 0 não

admite raízes reais ou apenas uma raiz que toca o eixo

Agora

fazendo

a V x ,

x . Essa condição implica que b 2 4ac 0 .

b 2cov x, y

e

c V y

percebe-se

que

2

4cov

1

2

x, y 4V xV y 0

cov x, y

V x V y

ou

cov 2 x, y

seja,

V x V y

1

que

implica

em

1.

Esse teorema pode ser generalizado e utilizado para definir ortogonalidade entre v.a.s.

Teorema generalizado para independência entre v.a.s:

Basta fazer o mesmo começando com

E x2 2 2E xy E y 2 0

E xy

1

2

E x E y

2

E x y 0

e, consequentemente, a

2

1.

que nos leva diretamente à

1

E xy

2

E x E y

fato de que esse é um número entre -1 e +1 significa que sempre existirá um ângulo

E xy E x 2 E y 2 cos . Se definimos xRMS E x 2

porque utilizamos

1

2

n xk

k

E x 2

como estimador de

E xy xRMS yRMS cos

ou

Em que o coseno mede o grau de relação entre as v.a.s

E y 2 0

então

2

90o

e dizemos que

x

e

cos

2

1. O

para o qual

, ou seja root-mean-square,

, podemos afirmar então que:

E xy

xRMS yRMS

y . Se E xy 0 , mas E x 2 0 e

x

e

y

são ortogonais entre si, ou seja,

x y.

z x y

Adição de v.a.s independentes: se

fx x

Prova:

e

f y y , então a nova v.a. z

Então :

x

e

y

são v.a.s independentes com fdp´s

terá a fdp dada por f z z

f x f z x dx .

x

y

Fz z

x y z

4

em que

z x

z x

f x, y dxdy f x, y dxdy f x x dx f y y dx2

d

d zx

f z z Fz z f x x dx

f y y dx2

dz

dz

f z z f x x f y z x dx

Convolução e Correlação: A operação entre duas funções

c z

f x

e

g x

definida por

f x g z x dx

é tão importante que ganhou nome próprio: é chamada de CONVOLUÇÃO

e é simbolizada por

c z f * g . Ela tem uma prima denominada por operação CORRELAÇÃO definida

de forma um pouco diferente por C z f g

f x g x z dx . Note que a diferença está no

argumento da função

g x , o qual na convolução é z x

e na correlação é

xz.

Intuição sobre as operações convolução e correlação:

4

Estamos

usando

F u f u

a

seguinte

regra

derivar

integrais:

d s z

d

dz r z

ds

f u du

portanto

d s z

ds

dz r z

dz

f u du f s z

para

f r z

dr

dz

.

d s z

d

dz r z

dz

f u du

F s z

ds

dz

dF

dr

F s z F r z

r z

dr

dz

ou

onde

seja

Note que a operação

quantidade

função

a

f x a

para a direita. Já a

é simplesmente transladar a função

f x a

f x

no eixo horizontal pela

translada a função para a esquerda. A figura xxx mostra a

f x e x H x , preta, com a f x 2 em azul e a f x 2 em vermelho. Note que

a curva azul deslocou de 2 para a direita e a vermelha de 2 para a esquerda. Já a operação

significa uma reflexão da função em torno do eixo

f x e x1H x 1

e

y.

f x

A figura xx mostra o gráfico das curvas

f x e x1H x 1 .

Figura xxx. Gráfico das curvas f x e

x

f x 2 e

H x em preto, f x 2 e

x2

H x 2 em vermelho.

x2

H x 2 em azul e

Figura xxx. Gráfico das curvas f x e

x 1

H x 1 em preto e f x e

x 1

H x 1 em

vermelho.

Vamos analisar uma auto-convolução e uma auto-correlação da função

correlação a

f x z

z x x z

é a própria função deslocada por

a função é deslocada e refletida no eixo

Figura xxx. Multiplicação das curvas f x e

x

f x

z.

com ela mesma. Na auto-

Mas na auto-convolução

y.

H x por f z x para z 1;0;0,5;1;2 e 4

A figura xxx mostra a curva da autoconvolução c z

f x g z x dx em função de z .

Figura xxx. Autoconvolução de f x e

Já a figura xxx mostra a multiplicação de

f x

resultado da auto-correlação em função de

z.

Figura xxx. Multiplicação das curvas f x e

x

por

x

H x em função de z

f x z

da auto-correlação e a figura xxx o

H x por f x z para z 2; 1;0;1 e 2

Figura xxx. Auto-correlação de f x e

FGM e Função Característica de v.a.s independentes:

x

H x em função de z

x

Se as v.a.s

y

e

M x y t E e

são independentes então

x y t

E xy E x E y .

Nesse caso então

E e xt e yt E e xt E e yt M x t M y t

Da mesma forma:

x y t E ei x y t E eixt eiyt E eixt E eiyt x t y t

Ou seja a função geradora dos momentos e a função caraterística da v.a.

z x y

serão os produtos

das respectivas funções de cada uma das v.a.s.

Teorema da convolução: Daqui podemos extrair o teorema da convolução afirmando que:

x t e f x x

Sejam:

ixt

dx ;

y t eiyt f y y dy

e

f z z f x x f y z x dx .

Então z

t

eizt f z z dz

é dado por z

t x t y t .

O truque do logaritmo:

A expansão em série de Taylor-McLaurin da função f x ln 1 x pode ser feita notando que

f 0 ln 1 0 , e f ( x) (1 x)

calculadas

f

usando:

(k )

( x)

1

. As derivadas de ordem superior a um podem ser facilmente

d ( k 1)

dx

k 1

(1 x) 1 (1) k 1 (k 1)!(1 x) k ,

para

f ( k ) (0) (1) k 1 (k 1)! . Desse resultado mostramos que:

(1) k 1 (k 1)! k (1) k 1 x k

x 2 x3 x 4

Ln(1 x)

x

x

...

k!

k

2

3

4

k 1

k 1

obter

e:

xk

(1) k 1 (k 1)!

x 2 x3 x 4

( x) k

[ x

...] .

k

!

k

2

3

4

k 1

k 1

Ln(1 x)

O truque do logaritmo é muito útil em casos em que a convergência da série de Taylor é problemática.

Suponha o caso da função f x 1 x , com x 1 mas n 1. Melhor dizendo, com x 0 e

n

n . Se fizermos a expansão de Taylor-McLaurin para esta função, obteremos:

f ( y ) 1 ny

n(n 1) y 2 n(n 1)(n 2) y 3

2

6

1

1

2

3

ny ny

2

6

1 ny

.

Cuja convergência depende se o produto ny é maior ou menor do que 1. Em lugar de fazer a

expansão

direta

da

função

vamos

Ln (1 y ) n n Ln (1 y ) n{ y

convergência

f ( y) e

para

n( y

expandir

y 2 y3

...},

2

3

seu

logaritmo

na

forma:

que não apresenta problemas de

y 1 . Agora retorna-se à função inicial para reescreve-la como

y 2 y3

)

2 3

. O truque do logaritmo levou à definição da função geradora dos

cumulantes.

Cumulantes:

ixt

ixt

A função geradora dos cumulantes é dada por C t ln E e ln e f x dx

Note que os cumulantes se acumulam, por isso o nome cumulante. Se

x

e

y

i k ck k

t .

k 0 k !

são independentes então

x y t x t y t e:

Cx y t ln x t y t ln x t ln x t y t Cx t C y t

Comparando com a série de Taylor vemos que ck i

M k i

k

k

dk

ln t . É diferente do

dt k

t 0

dk

k

t i k 0 , por causa do logaritmo. Podemos extrair a relação entre os

k

dt

t 0

cumulantes e os momentos derivando o logaritmo pela regra da cadeia e lembrando que 0 1 :

1.

d0

ln ln ; co 0

dt 0

2.

d

ln 1 ; c1 M1

dt

3.

d2

ln 1 2 1 2 2 ; c2 M 2 2 2

2

dt

4.

d3

d3

1

2

2

3 3

logo

ln

2

2

ln 1 3 2 2 3 3

dt 3

dt 3

3

então c3 M 3 3 M 2 2 que pode ser colocado em termos dos momentos centrados como

c3 3 3 2 m3 3 2 2 2 3 m3 . Logo

5.

c3

3

m3

.

3

d4

ln 1 4 4 2 3 2 2 12 3 2 6 4 4 ,

4

dt

ou

seja:

c4 M 4 4M 1M 3 3M 22 12M 12 M 2 6M 14 . Colocando em termos dos momentos centrados

c4 m4 4 m3 4 m3 6 2 2 12 2 2 6 2 2 12 2 2 4 4 4 3 4 12 4 6 4 3 4

4

finalmente c4 m4 3 . k

c4

4

m4

4

3.

Resumo das relações entre os momentos centrados, não centrados e cumulantes até ordem 4:

Momentos não centrados

Momentos centrados

Cumulantes

Mo 1

mo 1

co 0

M1

m1 0

c1

M2 2 2

m2 M 2 2

c2 2

M 3 3 3 2 m3

m3 M 3 3 M 2 2 3

c3 m3

M 4 4 6 2 2 4 m3 m4

m4 M 4 4 M 3 6 2 M 2 3 4

c4 m4 3 4

Aplicações:

Distribuição de Bernoulli:

Jogar a moeda, só temos duas possibilidades, cara ou coroa. A v.a. será definida como cara = 1 e

coroa = 0. Qualquer jogo com apenas duas respostas, sim = 1 e não = 0, segue uma distribuição de

Bernoulli. Se a probabilidade de SIM é p , a de Não será q 1 p e a função densidade de probabilidade

é dada por: f x q x p x 1 . A função distribuição de probabilidade acumulada vale:

F x

0 x0

q 0 x 1

1 x 1

A funçao geradora dos momentos é dada por: M t

q x p x 1 e

xt

dx q pet . A

função característica t q pe .

it

Momentos:

Mk

q x p x 1 x dx q0

k

k

p1k logo M k p k , então p .

1 p t

t

pt

t

pt

qe pt pe qt .

Momentos centrados: e M t e q pe qe pe

Agora mk

dk

k

qe pt peqt q p e pt pq k e qt

k

dt

mk pq 1 p

k 1

k

k

, ou seja, mk pq 1 qp ou ainda

k

t 0

k 1

p .

Casos particulares:

1.

m1 pq qp 0 ;

2.

m2 pq 1 p p pq ;

3.

m3 pq 1 p p 2 pq 1 2 p p 2 p 2 pq 1 2 p ;

4.

m4 pq 1 p p3 pq 1 3 p 3 p 2 p3 p3 pq 1 3 p 1 p pq 1 3 pq .

2

3

Cumulantes:

ln t ln 1 p eit 1 ,

então

d

ipeit

ip

ip

ln t

it

it

it

dt

p 1 p eit

1 p e 1 e p pe

logo:

1.

2.

3.

1

d

d

ln t ip p qe it . Logo c1 i ln t p

dt

dt

t 0

2

d2

2 d

2

it

it 2

2

ln

t

i

pq

e

p

qe

c

i

,

logo

2 ln t pq .

2

dt 2

dt

3

2

3

d3

ln t i 3 pq 2qe2it p qeit eit p qeit i 3 pqeit p qeit p qe it

3

dt

logo, m3 c3 i

3

4.

d3

ln t pq q p .

dt 3

t 0

4

d4

ln t i 4 pqeit p 2qeit p qeit 3qeit qeit p p qe it . Após alguma

4

dt

álgebra

c4 i

temos

4

4

d4

ln t i 4 pqeit p 2 4 pqeit q 2e2it p qeit ,

4

dt

d4

ln t pq p 2 4 pq q 2 ou c4 pq 1 6 pq .

dt 4

t 0

logo

Distribuição Binomial:

Vamos jogar a moeda n vezes de forma independente. Nesse caso a v.a. soma são i.i.d., e a função

n

característica vale: Bin t Bern

t q peit . Sabendo a queremos a f z dada por

n

1

f z FT t

2

1

n

q peit eitz dt . Expandindo em binômio de Newton temos:

n

1

n

f z q nk p k

k 0 k

2

n n n k k

i k z t

e

dt

q p z k

k 0 k

Aqui vale a acumulação dos cumulantes ck Bin n ck Bern , então np , 2 npq , c3 npq q p e

c4 npq 1 6 pq .

Distribuição de Poisson:

Essa distribuição é um caso limite da binomial quando n , mas p 0 de tal forma que o produto

eit 1

it

np é constante. Agora Bin t 1 p pe 1

. Nesse ponto usamos o fato de

n

n

n

n

que

x

Lim 1 e x

n

n

f z

1

2

e

eitz dt e

eit 1

para

achar

2

Poisson t e

e itz

e e dt e

it

k 0

eit 1

k 1

k ! 2

.

e k

z k .

k!

k 0

Uma expressão para FPoisson z .

FPoisson z

e k

f Poisson x dx

k!

k 0

z

x k dx e

queremos

a

k

ikt itz

e

e

dt

z k

e

k!

k 0

f Poisson z

z

Agora

int z

k

k 0

k!

fdp:

Então FPoisson z e

int z

k 0

k

.

k!

Cumulantes: ln Poisson t ln e

k k

eit 1 i t , portanto todos os cumulantes valem

eit 1

k 1

k!

, daí , 2 , m3 e m4 3 2 , a skewness vale 3

a curtose k

1

, sempre leptocúrtica. Se

1

0 , skewed to the right, e

então a skewness e curtose tendem a zero.

Distribuição Normal:

Vamos fazer o limite de n tendendo a infinito na distribuição binomial e usar o truque do logaritmo. Nesse

caso:

t2

n

ln Bin t Bern

t n ln q peit n ln q p ipt p

2

x 2 x3

já sabemos que ln 1 x x

2 3

Chamando x ipt p

k 1

1

k

x k e vamos truncar a série na ordem 2.

t2

temos:

2

Logo lim ln Bin t inpt

n

Normal t e

. Mas

k 1

2

2

t2

t2

t2

2 t

ln Bin t n ipt p ipt p n ipt p p

2

2

2

2

it

t2

n

ln

1

ipt

p

2

npqt 2

2

t2

n ipt p 1 p 2

e essa é a distribuição normal, cuja função característica vale:

2t 2

2

.

ln Normal t it

Note

2t 2

2

dados pela função geradora:

que,

nesse

caso,

só

existem

dois

cumulantes,

pois

2

, c1 e c2 , todos os outros são nulos. Os momentos centrados são

k

e

it

Percebe-se

i

k 0

2k

e

it

2t 2

2

e

que

m2 k

2t 2

2

não

2t 2

k

k

1 2 k 2 k 1 2 k 2k ! t 2 k

2

.

t

k!

2k k !

2k k !

2k !

k 0

k 0

k 0

existem

momentos

t 2k

t 2k

k

.

1 m2 k

2k ! k 0

2k !

ímpares

Comparando

e

que

os

m2 k

extraímos

2k ! 2 k .

2k k !

reescrever esse resultado em termos dos fatoriais duplos z !! z z 2 z 4

2k !! 2k 2k 2 2k 4

2 1 2k 2k 2

logo 2k ! 2k !! 2k 1!! , substituindo m2 k

2k

valem

Podemos

. Notando que

2 k k 1 k 2 1 2k k ! e, além disso, que:

2 2 2

2k ! 2k 2k 1 2k 2 2k 3

simples m2k 2k 1!!

pares

2 2k 1 2k 3 1

2k !! 2k 1!! 2 k

2k !!

chegamos na expressão mais

2

4

4

6

6

. Então vemos que m2 ; m4 3!! 3 ; m6 5!! 15 e

assim por diante.

1

Falta a função densidade de probabilidade: f z

2

quadrado

e

2t 2

2

i t itz

no

e

expoente

z 2

2

2

2

e

f z

e

e

z

t i 2

2

2