Guia de Referência do Fast Track Data Warehouse para o SQL Server 2012

Artigo técnico do SQL Server

Autores: Eric Kraemer, Mike Bassett, Eric Lemoine, Dave Withers

Revisores técnicos: Claude Lorenson, Susan Price, Ralph Kemperdick, Henk van der Valk,

Alexi Khalyako, Oliver Chiu

Publicado em: março de 2012

Aplica-se a: SQL Server 2012

Resumo: este documento define um modelo de configuração de referência (conhecido

como Fast Track Data Warehouse) que usa uma abordagem equilibrada de recursos para

a implementação de uma arquitetura de sistema de banco de dados do SQL Server baseada

em SMP (multiprocessador simétrico), com desempenho e escalabilidade comprovados para

cargas de trabalho de data warehouse. A meta de uma arquitetura de referência do Fast Track

Data Warehouse é atingir um equilíbrio eficiente de recursos entre a capacidade de processamento

de dados do SQL Server e a taxa de transferência de hardware do componente.

Direitos autorais

Este documento é fornecido "no estado em que se encontra". As informações e opiniões expressas nele,

inclusive URLs e outras referências a sites da Internet, poderão ser alteradas sem aviso prévio.

Você assume integralmente o risco de usá-lo.

Este documento não fornece direitos legais a nenhuma propriedade intelectual de qualquer produto

Microsoft. Você pode copiar e usar este documento para sua referência interna.

© 2012 Microsoft. Todos os direitos reservados.

2

Sumário

Histórico de alterações do FTDW.................................................................................................................. 6

Introdução..................................................................................................................................................... 6

Público-alvo............................................................................................................................................... 6

Fast Track Data Warehouse .......................................................................................................................... 6

Fast Track .................................................................................................................................................. 7

Proposta de valor ...................................................................................................................................... 7

Metodologia .................................................................................................................................................. 7

Arquitetura de componentes holística ..................................................................................................... 7

Abordagem otimizada de carga de trabalho ............................................................................................ 8

Configurações de referência do SQL Server Fast Track validadas ............................................................ 9

Resumo ..................................................................................................................................................... 9

Carga de trabalho do FTDW .......................................................................................................................... 9

Padrões de carga de trabalho de data warehouse ................................................................................... 9

Avaliação da carga de trabalho ............................................................................................................... 10

Atributos qualitativos de carga de trabalho de data warehouse ........................................................... 12

Escolhendo uma configuração de referência do FTDW .............................................................................. 13

Opção 1: Avaliação Básica....................................................................................................................... 14

Etapa 1: Avaliar o caso de uso do cliente................................................................................................ 14

Etapa 2: Escolher uma arquitetura de referência do FTDW publicada .............................................. 15

Opção 2: Avaliação Completa ................................................................................................................. 15

Visão geral do processo ...................................................................................................................... 16

Etapa 1: Avaliar o caso de uso do cliente............................................................................................ 16

Etapa 2: Estabelecer métricas de avaliação ........................................................................................ 17

Etapa 3: Escolher uma arquitetura de referência do Fast Track Data Warehouse............................. 18

Opção 3: Arquiteturas de referência definidas pelo usuário .................................................................. 18

Etapa 1: Definir a carga de trabalho ................................................................................................... 18

Etapa 2: Estabelecer avaliações de desempenho da arquitetura de componentes........................... 18

Escolhendo um resumo de FTRA ............................................................................................................ 19

Configuração padrão do FTDW ................................................................................................................... 20

Arquitetura de componentes de hardware ............................................................................................ 20

Requisitos e configuração do componente ........................................................................................ 20

3

Configuração de aplicativos .................................................................................................................... 22

Windows Server 2008 R2 .................................................................................................................... 22

SQL Server 2012 Enterprise ................................................................................................................ 23

Sistema de armazenamento ............................................................................................................... 24

Práticas recomendadas do SQL Server para FTDW .................................................................................... 29

Arquitetura de dados .............................................................................................................................. 29

Estrutura de tabela ............................................................................................................................. 29

Particionamento de tabela ................................................................................................................. 30

Indexação ............................................................................................................................................ 31

Índices columnstore na memória xVelocity ........................................................................................ 31

Estatísticas de banco de dados ........................................................................................................... 33

Compactação ...................................................................................................................................... 34

Gerenciando a fragmentação de dados .................................................................................................. 34

Fragmentação do sistema de arquivos ............................................................................................... 35

Vários grupos de arquivos................................................................................................................... 37

Carregando dados ................................................................................................................................... 37

Cargas incrementais ............................................................................................................................ 38

Migração de dados.............................................................................................................................. 40

Avaliação de desempenho e validação ....................................................................................................... 42

Executando a validação do FTDW de linha de base................................................................................ 43

Testes de linha de base com o SQLIO ................................................................................................. 44

Executando a avaliação de desempenho de banco de dados Fast Track ............................................... 46

Calculando a MCR ............................................................................................................................... 47

Calculando a BCR ................................................................................................................................ 49

Arquiteturas de referência do FTDW publicadas........................................................................................ 52

Conclusão .................................................................................................................................................... 52

Apêndice ..................................................................................................................................................... 54

Ferramenta de dimensionamento do sistema FTDW ............................................................................. 54

Validando uma FTRA definida pelo usuário ............................................................................................ 54

Testes sintéticos de E/S....................................................................................................................... 54

Gerando arquivos de teste com o SQLIO ............................................................................................ 54

4

Testes de carga de trabalho .................................................................................................................... 57

Medindo a MCR para seu servidor (opcional) .................................................................................... 57

Medindo a BCR para sua carga de trabalho ........................................................................................ 57

Fatores que afetam a taxa de consumo da consulta .......................................................................... 61

5

Histórico de alterações do FTDW

A tabela a seguir fornece uma lista das principais alterações ou atualizações das versões do

Guia de Referência do Fast Track Data Warehouse.

Descrição

Versão

Novidade no SQL

Server 2012

4.0

Novidade no SQL

4.0

Server 2012

Novidade no SQL

4.0

Server 2012

Novidade no SQL

4.0

Server 2012

Novidade no SQL

4.0

Server 2012

Novidade no SQL

4.0

Server 2012

Novidade no SQL

4.0

Server 2012

Tabela 1: Histórico de alterações

Observação

Links para outros documentos

de práticas recomendadas do

SQL Server

Avaliação de desempenho

e validação

Local

Requisitos de memória

RAM

Índices columnstore otimizados

pela memória xVelocity

Armazenamento de estado

sólido

Validação e índices

columnstore

Validação de E/S de linha

de base

Importante

Cuidado

Índices columnstore

Estado sólido

Validação

SQLIO

Introdução

Este documento define a arquitetura de componentes e a metodologia do programa FTDW

(Fast Track Data Warehouse) do SQL Server. O resultado dessa abordagem é a validação

de uma arquitetura mínima de sistema de banco de dados do Microsoft SQL Server, incluindo

software e hardware, necessária para você obter e manter uma linha de base de desempenho

pronta para uso com muitas cargas de trabalho de data warehouse.

Público-alvo

O público-alvo deste documento inclui planejadores de TI, arquitetos, DBAs e usuários de BI

(business intelligence) interessados em escolher arquiteturas comprovadas do sistema padrão

para cargas de trabalho do SQL Server em conformidade com o FTDW.

Fast Track Data Warehouse

A iniciativa Fast Track Data Warehouse do SQL Server oferece uma metodologia básica

e exemplos concretos para a implantação de configuração equilibrada de hardware e banco

de dados para uma carga de trabalho de data warehouse. Para obter mais informações,

consulte a seção Carga de trabalho do FTDW deste documento.

6

O equilíbrio é uma medida dos principais componentes de uma instalação do SQL Server:

armazenamento, servidor, rede de armazenamento, banco de dados e sistema operacional.

Cada um desses componentes é ajustado para uma configuração ideal. A meta é atingir um

equilíbrio imediato e eficiente entre a capacidade de processamento de dados do SQL Server

e os recursos dos componentes de hardware. De modo ideal, sua configuração incluirá

hardware mínimo de sistema para atender aos requisitos de armazenamento e desempenho

para uma carga de trabalho de data warehouse.

Fast Track

A marca SQL Server Fast Track identifica uma configuração de hardware de componente que

está de acordo com os princípios da FTRA (arquitetura de referência do FTDW). Cada FTRA

é definida por uma carga de trabalho e um conjunto principal de diretrizes de práticas

recomendadas, configuração, validação e banco de dados. Veja a seguir importantes princípios

do programa Fast Track:

Avaliações de desempenho específicas à carga de trabalho. O design e a configuração

do sistema se baseiam nas cargas de trabalho reais de consultas simultâneas.

Especificações detalhadas e validadas do componente de hardware.

Equilíbrio da arquitetura de componentes entre a capacidade do banco de dados e os

principais recursos de hardware.

Proposta de valor

Os seguintes princípios criam a base da proposta de valor do FTDW:

Equilíbrio predeterminado entre os principais componentes do sistema.

Isso minimiza o risco de gasto excessivo de recursos de CPU ou armazenamento

que nunca será percebido no nível de aplicativo.

Desempenho imediato e previsível. As configurações de Fast Track são integradas

à capacidade que já é compatível com os recursos do aplicativo SQL Server para uma

carga de trabalho e um servidor selecionados.

Centrado na carga de trabalho. Em vez de ser uma abordagem única para todas as

configurações de bancos de dados, a abordagem FTDW é especificamente alinhada

a um caso de uso de data warehouse.

Metodologia

Arquitetura de componentes holística

As arquiteturas de referência do FTDW do SQL Server fornecem uma estrutura prática para

equilibrar as relações complexas entre os principais componentes da arquitetura do sistema de

banco de dados. Conhecida de forma genérica como uma pilha, a arquitetura de componentes

é ilustrada na Figura 1.

7

Figura 1: Exemplo de arquitetura de componentes de banco de dados Fast Track

Cada componente da pilha é um link em uma cadeia de operações necessárias para processar

dados no SQL Server. Avaliar a pilha como um sistema integrado permite fazer uma avaliação

de desempenho que estabelece a largura de banda real de cada componente. Isso assegura

que os componentes individuais forneçam uma taxa de transferência suficiente para os

recursos do aplicativo SQL Server da pilha prescrita.

Abordagem otimizada de carga de trabalho

As diferentes cargas de trabalho do aplicativo de banco de dados podem exigir arquiteturas

de componentes muito diferentes para atingir um equilíbrio de recursos ideal. Um exemplo

clássico disso pode ser o contraste entre cargas de trabalho OLTP (processamento de

transação online) baseadas em pesquisa com solicitações pequenas e data warehouses

analíticos com um volume intenso de exames e solicitações grandes. Os casos de uso do

OLTP foram estritamente indexados para oferecer suporte à recuperação de baixa latência

de pequenos números de linhas de conjuntos de dados que, muitas vezes, apresentam

pouco volume de dados históricos. Esses tipos de operações de banco de dados induzem um

movimento significativo do cabeçote de disco e geram padrões clássicos de exame aleatório

de E/S. Os casos de uso analíticos, como o data warehouse, podem envolver solicitações de

dados muito grandes e se beneficiam bastante do potencial aumento da taxa de transferência

total de exames de disco sequenciais.

Para esses casos de uso opostos, as implicações de uma pilha de componentes equilibrada

são significativas. Em média, as taxas de exame aleatório de E/S por disco para as unidades

de disco SAS modernas podem ser 10 vezes mais lentas quando comparadas às taxas de

exame sequencial no mesmo hardware. Com cargas de trabalho de data warehouse Fast

Track, o foco é atingir altas taxas de exame de E/S de modo consistente (medidas em MB/s),

tirando o foco mais tradicional das operações por segundo (medidas em IOPS).

8

O desafio de cargas de trabalho muito diferentes é resolvido pela definição clara de atributos

das cargas de trabalho do cliente. As cargas de trabalho Fast Track do SQL Server incluem

uma lista qualitativa de atributos que definem de modo exclusivo um caso de uso comum

do aplicativo de banco de dados. Além disso, cada carga de trabalho é representada pelas

medidas quantitativas que incluem consultas padrão de análise de desempenho. A avaliação

de desempenho específica à carga de trabalho é usada para validar a configuração do banco

de dados, as práticas recomendadas e as recomendações de hardware de componentes.

Configurações de referência do SQL Server Fast Track validadas

Todas as arquiteturas de referência Fast Track publicadas são validadas de acordo com

o conjunto de princípios e diretrizes fornecidos neste guia de referência. Exemplos desse

processo podem ser encontrados em seções posteriores deste documento.

Resumo

A especificação FTDW do SQL Server descrita neste guia de referência é centrada na carga de

trabalho e equilibrada por componente. Essa abordagem reconhece que um provisionamento

único pode ser ineficaz e oneroso para muitos casos de uso do banco de dados. Os requisitos

empresariais cada vez mais complexos combinados aos volumes de dados cada vez maiores

exigem uma abordagem mais realista. Ao apresentar uma combinação de arquiteturas de

referência prescritiva, avaliação de componentes de hardware e software e cargas de trabalho

claramente direcionadas, este documento fornece uma abordagem prática para se obter

arquiteturas de componentes equilibradas.

Carga de trabalho do FTDW

Padrões de carga de trabalho de data warehouse

Geralmente, as perguntas feitas em data warehouses exigem acesso a grandes volumes

de dados. Os data warehouses precisam dar suporte a uma variedade de consultas de um

público-alvo abrangente (por exemplo: equipes de finanças, marketing, operações e pesquisa).

Para superar as restrições de sistemas de data warehouse tradicionais, as organizações

recorreram ao uso de técnicas tradicionais de otimização do RDBMS, como criação de índices,

pré-agregação de dados e limitação de acesso a níveis de dados inferiores. As sobrecargas

de manutenção associadas a essas abordagens, muitas vezes, podem oprimir até mesmo as

janelas de lote generosas. À medida que um data warehouse se desenvolve e o público-alvo

aumenta, o suporte a essas otimizações específicas ao caso de uso torna-se cada vez mais

desafiador, principalmente no caso de dados ou correções de dados que chegam de última hora.

9

Uma solução comum para esse desafio é simplesmente adicionar unidades; não é incomum

ver centenas de discos oferecendo suporte a um data warehouse relativamente pequeno na

tentativa de superar as limitações de desempenho de E/S no mapeamento de uma infraestrutura

de E/S baseada em busca para uma carga de trabalho baseada em exame. Isso é visto com

frequência em grandes ambientes de rede SAN compartilhada que tradicionalmente são

otimizados para buscas. Vários padrões e técnicas de referência de E/S de armazenamento

incentivam o acesso aleatório de E/S, introduzindo a latência de disco e reduzindo a taxa de

transferência geral do subsistema de armazenamento para uma carga de trabalho de data

warehouse com grande volume de exames.

O Fast Track Data Warehouse é uma maneira diferente de otimizar as cargas de trabalho

do data warehouse. Ao alinhar os arquivos de banco de dados e a configuração ao acesso

eficiente de exame de disco (em vez de busca), o desempenho obtido de discos individuais

pode ser muito mais alto. O aumento do desempenho por disco resultante reduz o número

de discos necessários para gerar uma taxa de transferência de E/S suficiente para atender

à capacidade do SQL Server de processar dados para uma determinada carga de trabalho.

Além disso, você pode evitar algumas técnicas de otimização baseadas em índice usadas para

melhorar a busca no disco.

Avaliação da carga de trabalho

Ao analisar as cargas de trabalho de sistemas baseados em FTDW, é importante considerar

o ajuste em relação às práticas e configurações do sistema descritas neste documento.

Os requisitos de data warehouse podem variar de acordo com o cliente e determinados

requisitos, como a replicação do banco de dados, que podem não ser apropriados para todos

os sistemas desenvolvidos para FTDW. Os principais critérios iniciais desse tipo de avaliação

de carga de trabalho são descritos abaixo.

Alto volume de exames

As consultas em uma carga de trabalho do data warehouse frequentemente examinam

um grande número de linhas. Por esse motivo, o desempenho do exame de disco se torna

cada vez mais uma prioridade em comparação com as cargas de trabalho transacionais,

que enfatizam o tempo de busca no disco. A arquitetura de referência do FTDW otimiza

o hardware e os componentes de software do banco de dados priorizando o desempenho do

exame de disco. Isso resulta em leituras de disco mais eficientes e um aumento correlacionado

na taxa de transferência de E/S do disco por unidade.

Não volátil

Depois que os dados são gravados, eles raramente são alterados. As operações DML, como

a atualização do SQL, que movem páginas associadas à mesma tabela de banco de dados para

fora do alinhamento contíguo, devem ser cuidadosamente gerenciadas. As cargas de trabalho

que normalmente introduzem tal volatilidade podem não estar bem-alinhadas ao FTDW. Onde

ocorre a volatilidade, recomendamos a manutenção periódica para reduzir a fragmentação.

10

Menos índices

O acréscimo de índices não clusterizados costuma adicionar desempenho às pesquisas de

um ou alguns registros. Se índices não clusterizados forem aplicados às tabelas em que um

grande número de linhas deve ser recuperado, o aumento resultante nas operações de busca

aleatórias no disco poderá diminuir o desempenho geral do sistema. A manutenção dos índices

também pode adicionar sobrecarga significativa de gerenciamento de dados, o que pode

colocar em risco o SLA (contrato de nível de serviço) e a capacidade de atender às janelas

de carregamento do banco de dados.

Em contrapartida, as taxas de exames sequenciais podem ser muito mais altas (10 vezes ou

mais) do que as taxas de acesso aleatório. Um sistema que minimiza o uso de busca aleatória,

induzindo a índices secundários, geralmente obtém uma média mais alta de taxas de E/S

sustentadas. Isso significa um uso mais eficiente de recursos de E/S de armazenamento e um

desempenho mais previsível para consultas grandes do tipo exame.

A metodologia do FTDW prescreve técnicas de otimização do banco de dados que se alinham

com as características da carga de trabalho de destino. O particionamento por intervalos

e o índice clusterizado são exemplos de estruturas de dados que oferecem suporte à E/S

de disco baseada em exame, e nós os recomendamos como as principais ferramentas de

otimização baseada na arquitetura de dados para ambientes FTDW.

Alinhamento por partição

Uma característica comum das cargas de trabalho do FTDW é a capacidade de aproveitar

o particionamento do SQL Server. O particionamento pode simplificar o gerenciamento do

ciclo de vida dos dados e ajudar a minimizar a fragmentação ao longo do tempo. Além disso,

os padrões de consulta para grandes exames podem aproveitar a qualificação da partição

de intervalos e reduzir significativamente o tamanho dos exames de tabela, sem sacrificar

a fragmentação ou a taxa de transferência de E/S do disco.

Considerações adicionais

As considerações adicionais a seguir devem ser levadas em consideração durante a avaliação

de uma carga de trabalho do banco de dados:

11

A implementação e o gerenciamento de uma estratégia de otimização do banco de

dados com poucos índices é um requisito fundamental para cargas de trabalho do FTDW.

Supõe-se que seja mantida uma fragmentação de dados mínima no data warehouse.

Isso implica no seguinte:

o O tipo de fragmentação de maior preocupação pode ser medido em termos

de tamanho do fragmento. Um fragmento representa alocações contíguas de

páginas de banco de dados de 8K.

o A expansão do servidor adicionando armazenamento exige que todas as tabelas

sensíveis ao desempenho sejam novamente populadas de modo consistente

com as diretrizes descritas neste documento.

o

A implementação de estruturas de dados voláteis, como tabelas com atividade

de atualização regular no nível de linha, pode exigir manutenção frequente

(como desfragmentação ou recompilações de índice) para reduzir a fragmentação.

o O carregamento de tabelas de índice de cluster com lotes de IDs de chave

de cluster que sobrepõem intervalos existentes é uma fonte frequente de

fragmentação. Esse carregamento deve ser cuidadosamente monitorado

e gerenciado de acordo com as práticas recomendadas fornecidas neste guia

de referência.

O data warehouse pode ter significados diferentes para públicos distintos. É preciso

tomar cuidado ao avaliar as necessidades do cliente em relação aos atributos de carga

de trabalho do FTDW.

Atributos qualitativos de carga de trabalho de data warehouse

Você pode definir a carga de trabalho do FTDW usando as propriedades das áreas de assunto

a seguir relacionadas às operações de banco de dados:

Requisitos de usuário e padrão de acesso

Modelo de dados

Arquitetura de dados

Otimização do banco de dados

A tabela a seguir resume atributos de carga de trabalho de data warehouse comparados a uma

carga de trabalho OLTP ou ODS (repositório de dados operacional).

Atributo

Descrição do

caso de uso

12

Afinidade da carga de trabalho:

Data warehouse

Basicamente leitura (90%-10%)

Atualizações geralmente

limitadas aos requisitos de

qualidade de dados

Inserções em massa de alto

volume

Simultaneidade geral de consulta

de média a baixa; solicitação

máxima de consultas

simultâneas variando de 10 a 30

Taxa de transferência de consulta

simultânea caracterizada pelas

necessidades de análise

e relatório

Agregações e/ou exames de

intervalos grandes

Consultas complexas

(filtro, junção, agrupamento,

agregação)

OLTP/ODS

Proporção equilibrada de leitura

e atualização (60%-40%)

Taxa de transferência de

consulta simultânea

caracterizada pelas

necessidades operacionais

Inserções e atualizações

refinadas

Alta taxa de transferência de

transações (por exemplo,

10s K/s)

Simultaneidade geral de

usuários de média a alta;

solicitação máxima de

consultas simultâneas variando

de 50 a 100 ou mais

Transações normalmente muito

curtas (por exemplo, pesquisas

mínimas e discretas de linhas)

Atributo

Afinidade da carga de trabalho:

Data warehouse

OLTP/ODS

Modelo de dados Modelo centralizado de data

Modelo de dados operacional

warehouse altamente normalizado

altamente normalizado

Desnormalização como suporte

Desnormalização frequente

aos requisitos de relatório,

para apoio à decisão;

geralmente atendidos por

pesquisas discretas de baixa

aplicativos de BI, como o SQL

latência e alta simultaneidade

Server Analysis Services

A retenção de dados históricos

Estruturas de dados

é limitada

dimensionais hospedadas no

Modelos de dados

banco de dados com alto volume

desnormalizados extraídos

de solicitações analíticas

de outros sistemas de origem

e simultaneidade relativamente

como suporte à tomada de

baixa

decisões de eventos

Os exames de intervalos grandes

operacionais

são comuns

Casos de uso analíticos ad hoc

Arquitetura de

Uso significativo de estruturas

Uso mínimo de estruturas de

dados

de tabela heap

tabela heap

Tabelas grandes particionadas

Estruturas de tabela de índice

com índices clusterizados

clusterizado que oferecem

oferecem suporte a exames

suporte a pesquisas detalhadas

restritos por intervalo

de registros (de uma a algumas

linhas por solicitação)

Tabelas de fatos muito grandes

(por exemplo, de centenas de

Tabelas de fatos menores

gigabytes a vários terabytes)

(por exemplo, de menos de

100 GB)

Tamanhos de dados muito

grandes (por exemplo, de

Tamanhos de dados

centenas de terabytes a um

relativamente pequenos (por

petabyte)

exemplo, de alguns terabytes)

Otimização do

Uso mínimo de índices

Otimização da utilização

banco de dados

secundários (anteriormente

intensa de índices secundários

descrito como menos índice)

O particionamento é comum

Tabela 2: Atributos de carga de trabalho de data warehouse

Escolhendo uma configuração de referência do FTDW

Há três abordagens gerais para usar a metodologia FTDW descrita neste documento. As duas

primeiras são específicas ao uso de arquiteturas de referência publicadas e em conformidade

com Fast Track para data warehouse. Essas abordagens permitem a seleção de sistemas

previamente projetados publicados como parte do programa FTDW. A terceira abordagem trata

a principal metodologia Fast Track como uma diretriz para a criação de um sistema de data

warehouse definido pelo usuário. Essa abordagem final requer a criação detalhada de perfis de

carga de trabalho e a avaliação de desempenho do sistema antes da compra ou implantação.

Ela exige um alto conhecimento técnico das áreas de configuração de armazenamento

e servidor empresarial, bem como da otimização de banco de dados do SQL Server.

13

Opção 1: Avaliação Básica

Neste cenário, o cliente já escolheu uma configuração de referência do FTDW ou tem métodos

alternativos para determinar os requisitos de CPU e servidor. Ao usar esta opção, você não

precisará fazer uma avaliação completa da plataforma (ou seja, uma prova de conceito).

Etapa 1: Avaliar o caso de uso do cliente

As configurações de referência do Fast Track Data Warehouse não são configurações

únicas de software e hardware. Em vez disso, as configurações são feitas de acordo com as

características de uma carga de trabalho de data warehouse. A primeira etapa da escolha de

uma configuração é identificar essas características; comece examinando as principais áreas

de requisitos e padrões de uso do seu cliente.

Carga de trabalho

As definições de carga de trabalho do FTDW fornecem dois pontos essenciais para a avaliação

do caso de uso. O primeiro é um conjunto de princípios básicos que definem elementos

fundamentais da carga de trabalho em relação ao desempenho do SQL Server. Esses princípios

devem ser cuidadosamente medidos para um determinado caso de uso, pois os conflitos

podem indicar que uma carga de trabalho de destino não é adequada para uma arquitetura de

referência do FTDW.

O segundo componente para uma carga de trabalho é uma descrição geral do caso de uso

pretendido. Isso oferece uma descrição útil de alto nível do caso de uso, além de fornecer

um ponto de partida razoável para avaliar a adequação da carga de trabalho.

Avaliação da carga de trabalho

A lista a seguir detalha um processo básico para avaliação da carga de trabalho do cliente.

Essa é uma avaliação qualitativa e deve ser considerada uma diretriz:

1. Defina os requisitos da carga de trabalho de meta. Compare e diferencie os atributos de

carga de trabalho do FTDW. Para obter mais informações, consulte a seção Carga de

trabalho do FTDW deste documento.

2. Avalie as práticas recomendadas do FTDW. As práticas relacionadas ao gerenciamento

do banco de dados e à otimização do sistema e da arquitetura de dados devem ser

avaliadas em relação ao caso de uso e ao ambiente operacional de destino.

Tomando uma decisão

A meta dessa avaliação de carga de trabalho é garantir que uma decisão totalmente informada

possa ser tomada na escolha de uma arquitetura de referência do FTDW validada. Na realidade,

a maioria dos cenários de data warehouse representa uma mistura de atributos em conformidade

e conflitantes relativos à carga de trabalho do FTDW. Os atributos de carga de trabalho de alta

prioridade com uma forte afinidade para configurações de referência Fast Track são listados

aqui; os principais casos de uso de clientes que entram em conflito direto com qualquer um

desses atributos devem ser cuidadosamente avaliados, pois podem invalidar a metodologia

para o caso de uso.

14

Carga de trabalho

Os seguintes atributos de carga de trabalho são de alta prioridade:

As cargas de trabalho críticas apresentam padrões de acesso a dados de alto volume

de exames (isto é, aqueles que podem se beneficiar do posicionamento sequencial de

dados). Em geral, as solicitações de consultas individuais envolvem leituras de dezenas

de milhares a milhões (ou mais) de linhas.

Alta capacidade de dados e baixa simultaneidade em relação a cargas de trabalho

OLTP comuns.

Baixa volatilidade de dados. A atividade DML frequente de atualização/exclusão deve

ser limitada a uma pequena porcentagem da superfície geral do data warehouse.

Gerenciamento de bancos de dados

Inclui administração de banco de dados, arquitetura de dados (estrutura de tabela e modelo de

dados) e práticas de integração de dados:

Arquitetura de dados particionada e com poucos índices.

Gerenciamento cuidadoso da fragmentação do banco de dados com estratégias

adequadas de carregamento e ETL, além de manutenção periódica.

Requisitos previsíveis de aumento de dados. Os sistemas FTDW são preparados para

a uma capacidade totalmente equilibrada. A expansão do armazenamento requer

a migração de dados.

Etapa 2: Escolher uma arquitetura de referência do FTDW publicada

Um cliente pode ter um servidor em mente ao fazer uma avaliação simples com base no

orçamento ou na experiência. Como alternativa, o cliente já deve ter uma boa ideia da

capacidade de carga de trabalho ou de um sistema existente no qual basear a análise dos

requisitos de largura de banda. Seja qual for o caso, não execute uma avaliação completa

de plataforma em uma avaliação básica do FTDW. Em vez disso, selecione uma configuração

FTDW em conformidade que corresponda aos requisitos estimados do seu cliente.

Opção 2: Avaliação Completa

As arquiteturas de referência em conformidade com Fast Track fornecem configurações de

componentes de hardware de acordo com as cargas de trabalho definidas pelo cliente.

A metodologia a seguir permite uma abordagem otimizada para escolher uma arquitetura de

componentes de banco de dados que assegure o melhor equilíbrio imediato entre os requisitos

do caso de uso, o desempenho e a escalabilidade. Essa abordagem presume um alto grau de

experiência na arquitetura do sistema de banco de dados e na implantação do data warehouse.

Os parceiros de Fast Track e os recursos técnicos de vendas da Microsoft geralmente são

envolvidos nesse processo.

15

Visão geral do processo

O fluxo de processo a seguir resume o processo de seleção da Avaliação Completa do FTDW:

1. Avalie os atributos de carga de trabalho Fast Track em relação ao cenário de uso

de destino.

2. Identifique os requisitos de servidor e/ou largura de banda para o caso de uso do

cliente. É necessário escolher uma configuração de referência publicada do FTDW

antes de iniciar uma avaliação.

3. Identifique uma consulta que represente o requisito de carga de trabalho do cliente.

4. Calcule a BCR (taxa de consumo de avaliação de desempenho) do SQL Server para

a consulta.

5. Calcule a UDC (capacidade de dados de usuários) exigida.

6. Compare as classificações de BCR e UDC com as classificações de Capacidade

e MCR (taxa máxima de consumo de CPU) publicadas para arquiteturas de referência

Fast Track em conformidade.

A tabela a seguir descreve pontos individuais do fluxo de processo da Avaliação Completa

em detalhes.

Etapa 1: Avaliar o caso de uso do cliente

Avaliação da carga de trabalho

Esse processo é o mesmo da Opção 1: Avaliação Básica.

Selecionar o hardware de avaliação do FTDW

Antes de iniciar uma avaliação completa do sistema, você deve escolher e implantar uma

configuração de referência do FTDW publicada para teste. Você pode escolher entre vários

métodos para identificar uma configuração de referência apropriada. Veja a seguir as

abordagens comuns:

16

Orçamento. O cliente opta por comprar o sistema de capacidade mais alta e/ou

o sistema de mais alto desempenho para o orçamento disponível.

Desempenho. O cliente opta por comprar o sistema de mais alto desempenho

disponível.

Análise interna. A decisão é baseada na análise de carga de trabalho que o cliente

executou no hardware existente.

Análise ad hoc. A Ferramenta de dimensionamento do FTDW fornece uma abordagem

básica para calcular os requisitos de sistema para o FTDW com base nas suposições

básicas sobre a carga de trabalho do banco de dados de destino. Essa ferramenta de

planilha está disponível para download em

http://download.microsoft.com/download/D/F/A/DFAAD98F-0F1B-4F8B-988F22C3F94B08E0/Fast%20Track%20Core%20Calculator%20v1.2.xlsx.

Etapa 2: Estabelecer métricas de avaliação

As três métricas a seguir são importantes para uma avaliação completa do FTDW e abrangem

os principais critérios de decisão para avaliação de hardware:

MCR (taxa máxima de consumo do núcleo de CPU)

BCR (taxa de consumo de avaliação de desempenho)

UDC (capacidade de dados de usuário) exigida

Para obter mais informações sobre como calcular essas métricas, consulte a seção Avaliação

de desempenho e validação deste documento.

MCR

Essa métrica mede a taxa máxima de processamento de dados do SQL Server para uma

consulta padrão e o conjunto de dados para uma combinação específica de servidor e CPU.

Ela é fornecida como uma taxa por núcleo, sendo medida como um exame baseado em

consulta no cache de memória. A MCR é o ponto de partida inicial para design do sistema Fast

Track. Ela representa uma largura de banda de E/S máxima estimada exigida para o servidor,

a CPU e a carga de trabalho. A MCR é útil como um guia de design inicial, pois requer apenas

um armazenamento local mínimo e um esquema de banco de dados para fazer uma estimativa

da taxa de transferência potencial para uma determinada CPU. É importante reforçar que

a MCR é usada como um ponto de partida para o design do sistema – não é uma medida de

desempenho do sistema.

BCR

A BCR é medida por um conjunto de consultas que são consideradas definitivas da carga de

trabalho do FTDW. Ela é calculada em termos de largura de banda total lida no disco e no

cache, e não somente no cache, como ocorre no cálculo da MCR. A BCR pode permitir

a personalização da infraestrutura para um determinado caso de uso do cliente, sendo medida

em um conjunto de consultas correspondente aos padrões de carga de trabalho do cliente.

Ou, no caso da FTRA validada pelo parceiro, é usado um conjunto de consultas de avaliação

de desempenho, garantindo que os sistemas sejam projetados para cargas de trabalho de alta

pressão. Em resumo, a BCR é uma medida real de processamento de dados que usa várias

consultas sujeitas à carga de trabalho simultânea em volumes de dados significativos.

Capacidade de dados de usuários

Essa é a capacidade de banco de dados prevista para o banco de dados do SQL Server.

A capacidade de dados de usuários Fast Track é responsável pela compactação do banco

de dados pós-carregamento e representa uma estimativa da quantidade de fluxos ou arquivos

de dados de usuários não compactados que podem ser carregados no sistema Fast Track.

A proporção de compactação padrão usada para o FTDW é 3,5:1.

Observe que qualquer expansão de armazenamento além da implantação inicial pode exigir

a migração de dados, que efetivamente dividiria os dados existentes pelos novos locais

do arquivo de banco de dados. Por esse motivo, é importante levar em consideração

o crescimento esperado do banco de dados e a expectativa de vida do sistema ao escolher

uma arquitetura de referência apropriada.

17

Etapa 3: Escolher uma arquitetura de referência do Fast Track Data Warehouse

Depois de calculada, a BCR pode ser comparada com uma MCR publicada e com

classificações de capacidade fornecidas pelos parceiros Fast Track para cada FTRA publicada.

Para obter mais informações sobre nossos parceiros, consulte Fast Track Data Warehouse

(http://www.microsoft.com/sqlserver/pt/br/solutions-technologies/data-warehousing/fast-track.aspx).

Você pode usar a métrica BCR como um ponto de referência comum para avaliar resultados

do sistema de teste/avaliação em relação às configurações publicadas. A partir dos dados de

BCR, seu cliente pode escolher a opção Fast Track que melhor se alinhe com os resultados

do teste.

Opção 3: Arquiteturas de referência definidas pelo usuário

Essa abordagem aproveita a metodologia FTDW para adaptar um sistema a uma carga de

trabalho ou um conjunto de hardwares específico. Essa abordagem requer uma compreensão

completa tanto do SQL Server quanto dos componentes de hardware nos quais ele é executado.

As etapas a seguir descrevem a abordagem geral para desenvolver uma arquitetura de

referência definida pelo usuário que esteja em conformidade com os princípios do FTDW.

Etapa 1: Definir a carga de trabalho

Compreender o caso de uso do banco de dados de destino é fundamental para as

configurações do FTDW, e isso se aplica igualmente a qualquer aplicação personalizada

das diretrizes fornecidas neste documento. As diretrizes para FTRAs, especificamente sobre

o tópico de cargas de trabalho, pode ser usada como um modelo de referência para incorporar

a avaliação da carga de trabalho no design da arquitetura de componentes.

Etapa 2: Estabelecer avaliações de desempenho da arquitetura de componentes

A estrutura a seguir fornece uma estrutura básica para desenvolver uma arquitetura de

referência para uma carga de trabalho predefinida:

1. Estabeleça a MCR (taxa máxima de consumo do núcleo de CPU) para o servidor

e a CPU escolhidos. Use o método descrito na seção Avaliação de desempenho

e validação deste documento para calcular a MCR. Você também pode usar as

classificações de MCR publicadas para configurações do FTDW. Em geral, as CPUs

da mesma família apresentam taxas semelhantes de consumo do núcleo de CPU para

o banco de dados do SQL Server.

2. Use o valor da MCR para fazer a estimativa dos requisitos de armazenamento e rede de

armazenamento e criar um design de sistema inicial.

3. Adquira um sistema de teste baseado no design de sistema inicial. De modo ideal, isso

será a configuração completa especificada.

4. Estabeleça uma BCR (taxa de consumo de avaliação de desempenho). Com base na

avaliação da carga de trabalho, identifique uma consulta ou, no caso ideal, um conjunto

de consultas representativas. Siga as práticas descritas na seção Medindo a BCR para

sua carga de trabalho deste documento.

5. Ajuste o design do sistema com base nos resultados.

6. Estabeleça a configuração final de servidor e armazenamento.

18

Etapa 3: Validação do sistema

A meta da avaliação de desempenho do sistema deve ser a validação da configuração e da

taxa de transferência da configuração de componentes de hardware identificada na Etapa 2.

Para obter mais informações sobre esse processo, consulte a seção Validando a FTRA

definida pelo usuário deste documento. Para validar seu sistema, siga estas etapas:

1. Avalie a taxa de transferência do componente em relação aos requisitos de

desempenho estabelecidos. Isso assegura que a taxa de transferência real do sistema

corresponda às expectativas.

2. Valide a taxa de transferência do sistema recriando a configuração final e executando

avaliações de desempenho finais. Como regra geral, a BCR final deve atingir 80% ou

ser superior à MCR do sistema.

Escolhendo um resumo de FTRA

A tabela a seguir resume as três opções de seleção de FTRA.

Opção

Avaliação básica

Avaliação completa

Arquitetura de referência

definida pelo usuário

Prós

Aquisição e configuração

bem rápidas do sistema

(dias a semanas)

Custo minimizado de

design e avaliação

Menos requisitos de

habilidade de infraestrutura

Arquitetura de referência

predefinida e personalizada

para a carga de trabalho

esperada

Potencial para economia

em hardware

Maior confiança na solução

Potencial para reutilização

de hardware existente

Potencial para incorporar

hardware mais recente

Sistema altamente

personalizado para seu

caso de uso

Tabela 3: Comparação de diferentes opções de avaliação

19

Contras

Possibilidade de

armazenamento além do

especificado ou de CPU

abaixo do especificado

A avaliação demanda

esforço e tempo (semanas

a meses)

Exige conhecimento

profundo da carga de

trabalho de destino

O processo leva vários

meses

Requer experiência

significativa em

infraestrutura

Requer experiência

significativa em SQL Server

Configuração padrão do FTDW

Arquitetura de componentes de hardware

As arquiteturas de referência atuais do FTDW são baseadas em configurações de armazenamento

dedicado. As opções atualmente publicadas incluem rede SAN alternada, rede SAN de

conexão direta, SAS de conexão direta, SAS-RBOD e iSCSI. A taxa de transferência de E/S de

disco é atingida pelo uso de processadores e compartimentos independentes de armazenamento

dedicado. Os detalhes e as configurações adicionais são publicados por cada fornecedor Fast

Track. A Figura 2 ilustra os blocos de construção no nível de componente que incluem uma

arquitetura de referência do FTDW com base no armazenamento de rede SAN.

Figura 2: Exemplo de configuração de armazenamento para um servidor de dois soquetes

e 12 núcleos

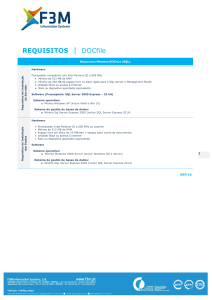

Requisitos e configuração do componente

Memória do servidor

RAM total: a alocação de RAM para FTRAs é baseada nos resultados da avaliação de

desempenho com a meta de equilibrar a taxa de transferência lógica máxima (total de páginas

lidas no disco e no buffer ao longo do tempo) com a utilização de CPU. A Tabela 4 lista

alocações de memória recomendadas para arquiteturas de referência do SQL Server 2012.

Os valores máximos de memória fornecidos não são limites de hardware, mas representam

a média de valores para sistemas validados bem-sucedidos.

20

Tamanho do servidor

Memória mínima

Memória máxima

1 soquete

64 GB

128 GB

2 soquetes

128 GB

256 GB

4 soquetes

256 GB

512 GB

8 soquetes

512 GB

768 GB

Tabela 4: Alocações de memória recomendadas para o SQL Server 2012

As considerações a seguir também são importantes na avaliação dos requisitos de memória

do sistema:

Consulta no cache: cargas de trabalho que atendem a uma grande porcentagem de

consultas no cache podem receber um benefício geral proveniente do aumento das

alocações de RAM à medida que a carga de trabalho aumenta.

Junções e classificações de hash: consultas que dependem de junções de hash

em grande escala ou executam operações de classificação em grande escala se

beneficiarão de grandes quantidades de memória física. Com uma memória menor,

essas operações são despejadas no disco e utilizam intensamente tempdb, o que

introduz um padrão de E/S aleatório nas unidades de dados no servidor.

Cargas: as inserções em massa também podem introduzir operações de classificação

que utilizam tempdb, caso não possam ser processadas na memória disponível.

Índice columnstore otimizado para a memória xVelocity: as cargas de trabalho que

favorecem intensamente os planos de consulta do índice columnstore são executadas

de modo mais eficiente com pools de memória no nível mais alto dos intervalos listados

na Tabela 4.

Rede SAN Fibre Channel

HBA – SAN: todos os componentes de rede HBA e SAN variam até certo ponto por fabricante

e modelo. Além disso, a taxa de transferência do compartimento de armazenamento pode

estar relacionada à configuração da rede SAN e aos recursos de barramento de PCIe.

Essa recomendação é uma diretriz geral e é consistente com o teste realizado durante

o desenvolvimento da configuração de referência de FTDW.

Se for usado o zoneamento, somente as portas em uso do Fast Track deverão existir na(s)

zona(s). A topologia e a configuração detalhadas da rede FC são documentadas no Guia de

Configuração Técnica fornecido por cada parceiro Fast Track e específicas a cada FTRA

publicada.

MPIO (Multipath I/O): o MPIO deve ser configurado. Cada volume hospedado em matrizes de

armazenamento dedicado deve ter pelo menos um caminho Ativo.

O rodízio com subconjunto é a política padrão usada para configurações Fast Track, mas

raramente é usado para arquiteturas de referência do parceiro, pois configurações mais

adequadas são identificadas pelas equipes de engenharia do parceiro de FTDW. DSMs e/ou

documentos específicos ao parceiro, muitas vezes, prescrevem diferentes configurações

e devem ser revisados antes da configuração.

21

Armazenamento

Disco local: uma matriz RAID1 de dois discos é a alocação mínima para a instalação do

Windows Server e do SQL Server. É necessário alocar espaço em disco suficiente para

requisitos de paginação e RAM virtual. Em geral, a RAM do sistema com mais de 250 GB ou

1,5 vez maior deve estar disponível no espaço livre em disco. A configuração de disco restante

depende do caso de uso e da preferência do cliente.

Sistema de arquivos lógico: a montagem de LUNs para caminhos de pasta do ponto de

montagem no Windows, em vez de letras de unidade, é preferível ao número de volumes em

muitos sistemas Fast Track.

Também pode ser útil entender qual atribuição de unidade do sistema operacional Windows

representa qual LUN (volume), grupo de discos RAID e ponto de montagem do Windows

Server nos compartimentos de armazenamento. Você pode adotar um esquema de

nomenclatura para os volumes e pontos de montagem ao montar LUNs para pastas do

Windows. Para obter mais informações sobre esquemas de nomenclatura de dispositivos,

consulte as diretrizes de configuração técnica do parceiro de Fast Track.

Você pode usar ferramentas específicas do fornecedor para obter o esquema de nomenclatura

de volume recomendado. Se não houver uma ferramenta adequada, você poderá disponibilizar

um disco para o Windows das matrizes de armazenamento enquanto atribui nomes de

unidades para garantir a topologia correta de físico para lógico.

Sistema de arquivos físico: para obter mais informações, incluindo instruções detalhadas,

consulte a seção Configuração de aplicativos deste documento.

Configuração do compartimento de armazenamento: todas as configurações de compartimento

permanecem em seus padrões, a menos que documentado em contrário pela documentação

técnica do parceiro Fast Track. As especificações de FTDW para configuração do sistema de

arquivos exigem compartimentos de armazenamento que permitem configuração específica

de agrupamentos RAID e atribuições de LUN. Isso deve ser levado em consideração para

qualquer configuração de referência do FTDW, substituições de hardware ou avaliações de

hardware personalizado.

Configuração de aplicativos

Windows Server 2008 R2

Salvo indicação em contrário, as configurações padrão devem ser usadas para o sistema

operacional Windows Server 2008 R2 Enterprise. Verifique se o service pack mais recente

e todas as atualizações críticas foram aplicadas. O recurso Multipath I/O é exigido para

diversas arquiteturas de referência. Para obter mais informações sobre a configuração

detalhada do MPIO, consulte o guia de instalação técnica do parceiro Fast Track para

a arquitetura de referência fornecida. Verifique se o Windows Server 2008 R2 está instalado

como uma função de Servidor de Aplicativos para garantir a instalação e os padrões

adequados do .NET Framework.

22

SQL Server 2012 Enterprise

Opções de inicialização

-E deve ser adicionado às opções de inicialização. Isso aumenta o número de extensões

contíguas em cada arquivo que são alocadas para uma tabela de banco de dados à medida

que ela cresce. Isso melhora o acesso sequencial ao disco. Para obter mais informações

sobre essa opção, consulte o artigo 329526 da Base de Dados de Conhecimento da Microsoft

(http://support.microsoft.com/kb/329526). É importante garantir que a opção -E tenha entrado

em vigor na inicialização do banco de dados. A opção diferencia letras maiúsculas de minúsculas

e o formato. O espaço em branco antes ou depois da opção pode impedir a inicialização.

-T1117 também deve ser adicionado às opções de inicialização. Esse sinalizador de

rastreamento garante o aumento de todos os arquivos em um grupo de arquivos no caso

de habilitação do aumento automático. A recomendação padrão do FTDW para aumento do

arquivo de banco de dados é a pré-alocação, em vez do aumento automático (com exceção

de tempdb). Para obter mais informações, consulte a seção Detalhes da configuração do

armazenamento deste documento.

Habilite a opção Bloquear Páginas na Memória. Para obter mais informações, consulte Como

habilitar a opção Bloquear Páginas na Memória (http://go.microsoft.com/fwlink/?LinkId=141863).

-T834 deve ser avaliado caso a caso. Esse sinalizador de rastreamento pode aumentar

as taxas de transferência para muitas cargas de trabalho do data warehouse. Ele permite

alocações de páginas grandes na memória para o pool de buffers do SQL Server. Para obter

mais informações sobre esse e outros sinalizadores de rastreamento, consulte o artigo 920093

da Base de Dados de Conhecimento da Microsoft (http://support.microsoft.com/kb/920093).

Observação: no momento, o SQL Server 2012 não oferece suporte ao uso de –T834 se os

índices columnstore estiverem em uso no banco de dados. Se você planeja usar índices

columnstore, não use esse sinalizador de rastreamento.

Memória máxima do SQL

No SQL Server 2012, não deve ser alocado para o SQL Server mais de 92% do total de RAM

do servidor. Se aplicativos adicionais forem compartilhar o servidor, a quantidade de RAM

restante disponível para o sistema operacional deverá ser ajustada adequadamente. Essa

configuração é controlada pela opção max server memory. Para obter mais informações

sobre as configurações de memória para arquiteturas de referência validadas, consulte

a documentação do parceiro FTDW.

Administrador de Recursos

As cargas de trabalho do data warehouse geralmente incluem consultas complexas que

operam em grandes volumes de dados. Essas consultas podem consumir grandes quantidades

de memória e podem ser despejadas no disco se a memória for restrita. Esse comportamento

tem implicações específicas em termos de gerenciamento de recursos. Você pode usar

a tecnologia Administrador de Recursos no SQL Server 2012 para gerenciar o uso de recursos.

23

Nas configurações padrão do SQL Server, o Administrador de Recursos fornece um máximo de

25% de recursos de memória do SQL Server para cada sessão. Isso significa que, na pior das

hipóteses, três consultas pesadas o suficiente para consumir pelo menos 25% da memória

disponível bloquearão qualquer outra consulta que consuma muita memória. Nesse estado,

todas as consultas adicionais que exigem uma grande quantidade de memória para serem

executadas serão enfileiradas até que os recursos se tornem disponíveis.

Você pode usar o Administrador de Recursos para reduzir a memória máxima consumida

por consulta. No entanto, como resultado, as consultas simultâneas que, de alguma forma,

consumiriam grandes quantidades de memória passam a usar tempdb, introduzindo mais E/S

aleatória, o que pode reduzir a taxa de transferência geral. Embora isso possa ser benéfico

para muitas cargas de trabalho de data warehouse para limitar a quantidade de recursos do

sistema disponíveis para uma sessão individual, é mais bem mensurado com a análise das

cargas de trabalho de consultas simultâneas. Para obter mais informações sobre como usar

o Administrador de Recursos, consulte Gerenciando cargas de trabalho do SQL Server com

o Administrador de Recursos (http://msdn.microsoft.com/pt-br/library/bb933866.aspx).

As diretrizes e práticas específicas ao fornecedor de soluções Fast Track também deve ser

examinadas. Especificamente, as soluções Fast Track com mais de 4 e 8 soquetes podem depender

das configurações específicas do Administrado de Recursos para atingir um bom desempenho.

Em resumo, há uma troca entre a redução de restrições que oferecem desempenho mais alto

para consultas individuais e restrições mais rigorosas que garantem o número de consultas que

podem ser executadas simultaneamente.

Para obter mais informações sobre as práticas recomendadas e os cenários comuns do

Administrador de Recursos, leia o white paper Usando o Administrador de Recursos

(http://msdn.microsoft.com/pt-br/library/ee151608.aspx).

Sistema de armazenamento

Gerenciar a fragmentação é essencial para o desempenho do sistema ao longo do tempo

para arquiteturas de referência do FTDW, que colocam o armazenamento de banco de dados

primário em HDDs (unidades de disco rígido). Por esse motivo, uma configuração detalhada do

sistema de arquivos e do armazenamento é especificada.

Componentes do sistema de armazenamento

A Figura 3 fornece uma exibição que combina as três camadas principais da configuração de

armazenamento para a pilha integrada de banco de dados. Isso deve ser considerado um caso

de referência, uma vez que a topologia específica varia muito de acordo com o parceiro Fast

Track. A pilha típica de banco de dados contém os seguintes elementos:

24

Matriz de disco físico: RAID 1+0 de 4 eixos é a abordagem padrão detalhada na Figura

3. Também são usados RAID 5 e RAID 6 em algumas arquiteturas de referência de

parceiros para o SQL Server 2008 R2 e SQL Server 2012.

Atribuição de volume do sistema operacional (LUN)

Bancos de dados: Usuário, Temp do Sistema, Log do Sistema

Figura 3: Exemplo de arquitetura de armazenamento abrangente para um sistema FTDW

baseado em três compartimentos de armazenamento com um LUN (volume) por grupo

de discos

Detalhes de configuração do armazenamento

Para cada compartimento de armazenamento, execute o procedimento a seguir.

1. Crie grupos contendo quatro discos cada um, usando RAID 1+0 (RAID 10). O número

exato de grupos de discos por compartimento de armazenamento pode variar por

fornecedor. Para obter mais informações, consulte a documentação específica ao

fornecedor. Em geral, o número é grupo de discos (2) RAID10 e (1) RAID1 para

compartimentos de fator forma grande (LFF) e grupos de discos (5) RAID10 para

compartimentos SFF (fator forma pequeno).

25

Os volumes totais usados como locais do grupo de arquivos para dados primários não

devem exceder 32. Se o número total de LUNs do sistema de armazenamento exceder

esse limite, poderão ser usados grupos de discos maiores para reduzir a contagem de

LUNs mantendo uma taxa de transferência de E/S semelhante. Por exemplo, use um

grupo de discos RAID 10 de 8 discos com 1 LUN, em vez de um grupo de discos

RAID 10 de 4 discos com 1 LUN. A taxa de transferência e a eficiência são um pouco

reduzidas com grupos de discos maiores. Isso varia de acordo com a tecnologia de

armazenamento.

2. Dedique tudo, menos um grupo de discos, aos dados de usuário primários (PRI).

Os locais dos dados de usuário primários são sinônimos dos locais de grupos de

arquivos do banco de dados do SQL Server.

Todas as FTRAs requerem um ou dois LUNs por grupo de discos PRI. Consulte

as diretrizes específicas ao fornecedor da arquitetura de referência de sua escolha.

Esses LUNs são usados para armazenar os arquivos de banco de dados do SQL

Server (arquivos .mdf e .ndf).

3. Verifique se a atribuição do processador de armazenamento primário para cada volume

de disco alocado aos dados primários em um compartimento de armazenamento

é uniformemente equilibrada. Por exemplo, um compartimento de armazenamento com

quatro volumes de disco alocados para dados primários terá dois volumes atribuídos ao

processador de armazenamento "A" e dois atribuídos ao processador de

armazenamento "B".

4. Crie um LUN no grupo de discos restante para hospedar os logs de transações do

banco de dados. Para algumas configurações Fast Track mais amplas, as alocações de

log são limitadas apenas aos primeiros compartimentos de armazenamento no sistema.

Nesse caso, os grupos de discos adicionais são usados para preparo não referente

a banco de dados ou não são populados para redução de custos.

Para cada banco de dados, siga este procedimento:

1. Crie pelo menos um grupo de arquivos que contenha um arquivo de dados por LUN

de PRI. Certifique-se de deixar todos os arquivos do mesmo tamanho. Se você planeja

usar vários grupos de arquivos dentro de um único banco de dados para separar

objetos (por exemplo, um banco de dados de preparo para oferecer suporte ao

carregamento), não se esqueça de incluir todos os LUNs de PRI como locais para cada

grupo de arquivos.

2. Ao criar os arquivos para cada grupo de arquivos, aloque-os previamente para os

respectivos tamanhos máximos previstos, com um tamanho suficiente para manter

os objetos previstos.

3. Desabilite a opção de aumento automático para arquivos de dados e aumente

manualmente todos os arquivos de dados quando o limite de tamanho atual estiver

se aproximando.

4. Para obter mais informações sobre recomendações para bancos de dados de usuários

e grupos de arquivos, consulte a seção Gerenciando a fragmentação de dados deste

documento.

26

Para tempdb, siga este procedimento:

1. Pré-aloque espaço e adicione um único arquivo de dados por LUN. Certifique-se de

deixar todos os arquivos do mesmo tamanho.

2. Atribua arquivos de log temporários em um dos LUNs dedicados aos arquivos de log.

3. Habilite o aumento automático; em geral, o uso de um grande incremento de

crescimento é apropriado para cargas de trabalho de data warehouse. Um valor

equivalente a 10% do tamanho do arquivo inicial é um ponto de partida razoável.

4. Siga as práticas recomendadas padrão do SQL Server para o banco de dados e as

considerações de dimensionamento de tempdb. A alocação de um espaço maior pode

ser necessária durante a fase de migração ou durante a carga de dados inicial do data

warehouse. Para obter mais informações, consulte Planejamento de capacidade para

tempdb (http://msdn.microsoft.com/pt-br/library/ms345368.aspx) nos Manuais Online do

SQL Server.

Para o log de transações, siga este procedimento:

1. Crie um único arquivo de log de transações por banco de dados em um dos LUNs

atribuídos ao espaço de log de transações. Distribua arquivos de log por diferentes

bancos de dados nos LUNs disponíveis ou use vários arquivos de log para o aumento

do log, conforme a necessidade.

2. Habilite a opção de aumento automático para arquivos de log.

3. Verifique se a capacidade de log se alinha aos requisitos fornecidos na Tabela 5.

Alguma variação é aceitável, dependendo das características específicas de design

do sistema.

RAM do sistema (GB)

Capacidade classificada

de FT (terabytes)

<= 96

<=10

<= 128

>10

<=40

Alocação mínima

de log recomendada

Espaço livre espelhado

em GB

Volume de 300 GB x 1

Volume de 300 GB x 2

ou

Volume de 600 GB x 1

Tabela 5: Recomendações de alocação de log

Consulte as práticas recomendadas existentes para alocação e gerenciamento do log de

transações do SQL Server.

Armazenamento de estado sólido

As arquiteturas de referência do FTDW que usam o armazenamento de estado sólido para PRI

(dados primários) têm muitas vantagens, incluindo gerenciamento simplificado, redução dos

custos operacionais e manutenção previsível.

27

Gerenciamento simplificado: o armazenamento de estado sólido não exige gerenciamento

de fragmentação. A opção de inicialização – E do SQL Server ainda deve ser usada, mas não

há necessidade de otimização ou gerenciamento de alocação de página. Essa simplificação

facilita consideravelmente o gerenciamento de longo prazo de ambientes FTDW. Além disso,

os grupos de discos maiores e as contagens mais baixas de volume/LUN podem ser usados

sem nenhuma implicação negativa de desempenho. Essa alteração simplifica a criação

e a manutenção do grupo de arquivos.

Resiliência de E/S: o armazenamento de estado sólido apresenta degradação mínima de

desempenho sob alta simultaneidade ou fragmentação de página. Além disso, a carga de

trabalho de leitura (busca) aleatória combinada não afeta negativamente os padrões de E/S

de uma solicitação (exame) grande.

Manutenção previsível: muitas opções de armazenamento de estado sólido fornecem

monitoramento da vida útil da gravação com menor frequência de falhas físicas que são

difíceis de prever.

Redução dos custos operacionais: embora mais caro no preço de lista, o armazenamento

de estado sólido oferece um equilíbrio mais eficiente entre a taxa de transferência de E/S

e a capacidade por unidade. As taxas efetivas de E/S de carga de trabalho do FTDW para HDD

SAS de 10k com 300 GB são em média de 50 MBs. O SSD MLC empresarial oferece entre

150 e 200 MBs em uma capacidade de 600 GB. Além disso, o armazenamento de estado

sólido consome significativamente menos energia, gera menos calor e, muitas vezes, oferece

suporte a soluções de densidade mais alta.

Configuração do armazenamento de estado sólido

Os ajustes a seguir podem ser feitos nas diretrizes de configuração do armazenamento padrão

do FTDW caso o armazenamento de estado sólido seja usado para volumes de PRI.

28

Se houver necessidade de espelhamento, você poderá usar RAID1+0 ou RAID5.

O RAID5 oferece a melhor capacidade sem impacto no desempenho para cargas de

trabalho do FTDW no estado sólido.

A contagem de LUNs e volumes pode ser reduzida para apenas um volume de PRI por

unidade de armazenamento. É útil, em alguns casos, que a contagem de volumes de

PRI seja um múltiplo da contagem de núcleos de CPU. A contagem mínima de volumes

de PRI é dois.

O log de transações também pode ser colocado em estado sólido, mas as cargas de

trabalho do FTDW geralmente não são associadas ao log. O custo pode ser reduzido

quando se coloca o log em um HDD tradicional. O mesmo vale para o armazenamento

local da instalação do Windows Server e do SQL Server.

As recomendações para o gerenciamento da fragmentação de páginas e o carregamento

paralelo de índices de cluster podem ser ignoradas, pois a fragmentação lógica do

banco de dados não afeta o desempenho de E/S de estado sólido.

Práticas recomendadas do SQL Server para FTDW

As práticas para cargas de trabalho Fast Track são validadas e documentadas em dois casos.

O primeiro ocorrerá se uma prática Fast Track for substancialmente diferente das práticas

recomendadas estabelecidas para o SQL Server. O segundo caso ocorrerá em cenários em

que práticas existentes estiverem ausentes ou não puderem ser acessadas com facilidade.

As práticas fornecidas aqui não pretendem ser abrangentes, pois existe uma extensa

documentação para a implantação de bancos de dados do SQL Server. A documentação

técnica e as práticas recomendadas existentes do SQL Server devem ser referenciadas em

vários tópicos relacionados a uma implantação do FTDW.

Importante: há vários links para a documentação escrita para o SQL Server 2008 R2 neste

guia. Acreditamos que a maioria dessas diretrizes ainda seja útil para o SQL Server 2012,

mas você deve procurar as versões constantemente atualizadas desses documentos.

As versões futuras deste guia de referência atualizarão os links à medida que eles se

tornarem disponíveis.

Arquitetura de dados

Estrutura de tabela

O tipo de tabela que é usado para armazenar dados no banco de dados tem um efeito

significativo no desempenho do acesso sequencial. É muito importante desenvolver o esquema

físico com isso em mente, para permitir que os planos de consulta induzam a E/S sequencial

na medida do possível.

A escolha de um tipo de tabela se reduz à maneira como os dados na tabela serão acessados

na maioria das vezes. As informações a seguir podem ser usadas para ajudar a determinar

que tipo de tabela deve ser considerado, com base nos detalhes dos dados que estão sendo

armazenados.

Tabelas heap

As tabelas heap fornecem E/S sequencial limpa para exames de tabela e, geralmente,

diminuem a sobrecarga relacionada à fragmentação da tabela. Intrinsecamente, elas não

permitem exames baseados em intervalos (acesso direto) otimizados, como acontece com

uma tabela de índice clusterizado. Em uma situação de exame de intervalo, uma tabela

heap examina a tabela inteira (ou a partição de intervalo apropriada, se o particionamento

for aplicado).

O exame de tabelas heap atinge a taxa de transferência máxima em 32 arquivos, de modo

que o uso de heaps para tabelas de fatos grandes em sistemas com números elevados de

LUNs (mais de 32) ou núcleos (mais de 16) pode exigir o uso do Administrador de Recursos,

restrições DOP ou alterações na alocação de arquivos do banco de dados Fast Track padrão.

29

É melhor usar as tabelas heap onde:

A maioria das consultas de alta prioridade na referência de tabela contém predicados

que referenciam uma série de colunas distintas ou não tem nenhum predicado de coluna.

As consultas geralmente executam exames grandes, ao contrário dos exames restritos

a intervalos, como as tabelas usadas exclusivamente para popular cubos do Analysis

Services. (Nesses casos, a tabela heap deve ser particionada com a mesma

granularidade que o cubo do Analysis Services que está sendo populado.)

Os requisitos de carga de trabalho de consulta são atendidos sem a sobrecarga

incremental do gerenciamento de índice ou o desempenho da carga – o carregamento

de tabelas heap é mais rápido.

Tabelas de índice clusterizado

No ambiente de data warehouse, um índice clusterizado é mais eficiente quando a chave

é uma coluna qualificada por intervalo (como a de data), que geralmente é usada em restrições

da carga de trabalho de consulta relevante. Nesse caso, o índice pode ser usado para restringir

e otimizar significativamente os dados a serem examinados.

É melhor usar tabelas de índice clusterizado quando:

A tabela contém colunas qualificadas por intervalo que são usadas em restrições de

consulta na maioria dos cenários de carga de trabalho de consulta de alta prioridade

da tabela. Para configurações do FTDW, a coluna de data particionada de um índice

clusterizado também deve ser a chave do índice clusterizado.

Observação: em alguns casos, pode ser vantajoso escolher uma chave de índice

clusterizado que não seja a coluna de partição de data para uma tabela de índice

clusterizado. No entanto, isso pode resultar em fragmentação, a menos que partições

completas sejam carregadas, pois os dados novos que sobrepõem intervalos de chave

de índice clusterizado existentes criam divisões de página.

As consultas na tabela normalmente fazem pesquisas granulares ou restritas ao

intervalo, e não exames grandes de vários intervalos ou da tabela inteira.

Particionamento de tabela

O particionamento de tabela pode ser uma importante ferramenta para gerenciar a fragmentação

em bancos de dados do FTDW. Por exemplo, é possível usar o particionamento para atualizar

ou excluir de uma tabela grandes blocos de dados de usuário baseados em intervalos, sem

afetar outras partes da tabela. Em contrapartida, excluir linha por linha de um índice de cluster

pode provocar uma fragmentação significativa da extensão. Um cenário comum é recriar

partições mais novas quando elas se tornam antigas e a frequência de operações DML para

o intervalo de dados diminui. Agora a partição está estável em relação às operações DML

e apresenta fragmentação mínima da extensão.

30

Além disso, as tabelas grandes que são usadas principalmente para popular cubos do

SQL Server Analysis Services podem ser criadas como tabelas heap particionadas, com

o particionamento de tabela alinhado ao particionamento do cubo. Quando acessadas,

somente as partições relevantes da tabela grande são examinadas. (As partições que oferecem

suporte ao modo ROLAP do Analysis Services podem ser mais bem estruturadas como índices

clusterizados.)

Para obter mais informações sobre particionamento de tabela, leia o white paper Estratégias de

tabelas e índices particionados usando o SQL Server 2008 (http://msdn.microsoft.com/ptbr/library/dd578580(v=SQL.100).aspx).

Indexação

Considere as seguintes diretrizes na criação de índices do FTDW:

Use um índice clusterizado para intervalos de datas ou restrições comuns.

Use um índice columnstore sempre que possível. A seção a seguir aborda as práticas

recomendadas para se trabalhar com índices columnstore em ambientes do FTDW.

Reserve a indexação não clusterizada para situações em que a pesquisa granular for

necessária e o particionamento de tabela não oferecer um desempenho suficiente.

Se possível, use um índice columnstore como uma alternativa ao índice não clusterizado.

Os índices de cobertura não clusterizados podem proporcionar valor a algumas cargas

de trabalho do data warehouse. Eles devem ser avaliados caso a caso e comparados

com o índice columnstore.

Índices columnstore na memória xVelocity

O SQL Server 2012 inclui um novo recurso de aceleração de consultas de data warehouse que