OBS:

As informações aqui contidas foram extraídas, modificadas e/ou adaptadas de diversas

fontes bibliográficas, dentre as quais destacam-se Arquitetura de Sistemas Operacionais

(Francis B. Machado e Luiz Paulo Maia), Sistemas Operacionais (Deitel & Deitel) e

Sistemas Operacionais Modernos (A. Tanenbaum) e de vários sites com propósitos

educativos voltados para uma disciplina, dentro de um particular contexto educacional. O

propósito desse material é puramente educativo e NÃO se destina a qualquer tipo ou

forma de comércio e/ou fins promocionais de qualquer espécie.

[email protected]

1

Siglas

ENIAC

ENIAC – Fotos

005

006

007

1.0

1.1

1.2

1.3

1.4

Visão Geral

Recursos do Sistema Computacional

Compartilhamento de Recursos

Máquina de Níveis

Breve Histórico

011

012

013

013

014

2.0

2.1

2.1.1

2.1.2

2.1.2.1

2.1.2.2

2.1.2.3

2.2

2.2.1

2.2.2

2.2.3

2.2.4

2.2.5

Componentes de um Sistema Operacional

Tipos de Sistemas Operacionais

Sistema Monogramável/Monotarefa

Sistema Multiprogramável/Multitarefa

Sistemas em Lotes (Batches)

Sistemas de Tempo Compartilhado

Sistemas de Tempo Real : Críticos e Não Críticos

Sistemas com Múltiplos Processadores

Sistemas Fortemente Acoplados: Simétricos e Não Simétricos

Sistemas Fracamente Acoplados: de Rede e Distribuídos

Sistemas em Cluster

Sistemas Embarcados

Sistemas de Cartões Inteligentes

018

020

020

021

022

022

023

024

025

027

028

028

028

3.0

3.1

3.2

3.3

3.4

Arquitetura de Sistemas Operacionais

Sistema Monolítico

Sistema em Camadas

Sistema Micronúcleo (Microkernel)

Características de um Sistema Operacional

030

030

031

032

033

4.0

4.1

4.2

4.2.1

4.2.2

4.2.3

4.2.4

4.2.5

4.2.6

4.2.7

4.2.8

4.3

4.4

4.5

Concorrência

Interrupções

Operacões de Entrada e Saída (E/S)

E/S Controlada por Programa

Polling

E/S Controlada por Interrupção

DMA (Direct Memory Access)

Canal de E/S

Processador de E/S

Buffer

Spooling

Reentrância

Proteção ao Sistema

Modos de Execução

035

035

037

037

037

037

037

037

038

038

038

038

039

039

5.0

5.1

5.2

5.3

5.3.1

5.3.2

5.3.3

CPU – Unidade Central de Processamento

Registradores Visíveis

Registradores Invisíveis

CPU, Comunicação e Periféricos

Loop de Status

Interrupções

Via DMA

040

040

040

041

042

042

043

2

6.0

6.1

6.2

6.3

6.4

6.5

6.5.1

6.5.2

6.5.3

6.5.4

Processos

Componentes de Processo

Contexto de um Processo

Estados Básicos de um Processo

Mudanças de Estado

Tipos de Processos

Processo CPU Bound

Processo I/O Bound

Processo em Foreground

Processo em Background

045

045

045

048

050

050

050

050

051

051

7.0

7.1

7.2

7.2.1

7.2.2

7.2.3

7.2.4

7.3

7.3.1

7.3.2

7.3.3

7.3.4

7.3.5

7.3.6

7.3.7

7.3.8

7.3.9

7.4

7.5

Gerenciamento da CPU

Algoritmos de Escalonamento

Critérios de Escalonamento

Utilização da CPU

Eficiência

Tempo de Turnaround

Tempo de Resposta

Tipos de Escalonamento

Escalonamento FIFO

Escalonamento Shortest Job First (SJF)

Escalonamento Shortest Remaining Time (SRT)

Escalonamento Cooperativo

Escalonamento Circular (Round Robin)

Escalonamento por Prioridades

Escalonamento por Múltiplas Filas

Escalonamento por Múltiplas Filas com Realimentação

Escalonamento por Fração Justa (Fair Share)

Escalonamento em Sistemas de Tempo Real

Escalonamento com Múltiplos Processadores (CPUs)

052

053

054

054

054

054

054

054

054

055

055

056

056

057

058

058

059

059

061

8.0

8.1

8.2

8.3

8.4

8.5

8.6

8.7

8.8

8.9

8.10

8.10.1

8.10.2

8.10.3

8.10.4

8.10.5

8.10.6

Gerenciamento de Memória

Introdução

Funções

Alocação Contígua Simples

Segmentação de Programas

Alocação Particionada Estática

Alocação Particionada Dinâmica

Estratégias de Alocação de Partição

Swapping

Memória Virtual

Algoritmos de Substituição de Páginas

Algoritmo Ótimo

Algoritmo Aleatório

Algoritmo FIFO

Algoritmo LFU

Algoritmo LRU

Algoritmo NRU

062

062

062

062

063

064

066

066

067

068

070

070

070

070

070

071

071

3

9.0

9.1

9.1.1

9.1.2

9.1.3

9.2

9.2.1

9.2.2

9.2.3

9.3

9.4

Gerenciamento de Sistemas de Arquivos

Estrutura de Diretórios

Nìvel Único

Diretório Pessoal

Múltiplos Níveis

Sistemas de Alocação de Arquivos

FAT

FAT32

NTFS

Gerência de Espaço Livre

Proteção de Acesso

072

072

072

072

072

072

072

072

072

072

073

10.0

10.1

10.2

10.3

10.4

10.5

10.6

Exemplos de Sistemas Operacionais

DOS

UNIX

OS/2

Windows

Windows NT

Linux

075

075

076

077

077

079

081

11.0

Bibliografia

082

12.0

Dicionário de Termos (Glossário)

083

4

Siglas

ALU

ASCII

CDC

CISC

CPU

DEC

DMA

DRAM

ENIAC

EEPROM

EPROM

HD

IBM

I/O

IOP

IP

IRQ

E/S

LAN

MAN

PROM

RAM

RISC

ROM

SRAM

TCP

UCP

ULA

WAN

WWW

-

Aritmethic Logical Unit

American Standard Code for Information Interchange

Control Data Corporation

Complex Instruction Set Computer

Central Processing Unit

Digital Equipment Corporation

Direct Memory Acess

Dinamic RAM

Electronic Numerical Intregator and Computer

Electricaly Erasable Programmable Read Only Memory

Erasable Programmable Read Only Memory

Hard Disk

International Business Machines

Input and Output

Input and Output Processor

Internet Protocol

Interrupt Request

Entrada e Saída

Local Area Network

Metropolitan Area Network

Programmable Read Only Memory

Random Access Memory

Reduced Instruction Set Computer

Read Only Memory

Static RAM

Transport Control Protocol

Unidade Central de Processamento

Unidade Lógica Aritmética

Wide Area Network

Wide World Web

5

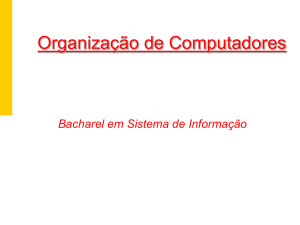

ENIAC (Electronic Numerical Intregator and Computer)

O 1º computador, o Harvard Mark I, foi projetado por Aiken, da universidade de Harvard em 1939 e

foi implementado com relés pela IBM em 1944 e , por isso mesmo não é considerado o primeiro

computador eletrônico do mundo.

O 1º computador eletrônico, o ENIAC (Electronic Numerical Intregator and Computer), teve seu

projeto iniciado em 1943, com a aplicação específica de efetuar os cálculos para a geração de tabelas

balísticas para tiros de canhões, tendo ficado operacional em 1946, ou seja, logo após o término da

2ª Grande Guerra Mundial. Ele pesava cerca de 30 toneladas e suas partes ocupavam várias salas do

prédio onde ele estava sendo construído. O computador media 5,50 m de altura e 25 m de

comprimento e ocupava 180 m² de área construída. Foi construído sobre estruturas metálicas com

2,75 m de altura e contava com 70 mil resistores e entre 17.468 e 18.000 válvulas a vácuo ocupando

a área de um ginásio desportivo.

Segundo Tom Forester, quando acionado pela primeira vez, o ENIAC consumiu tanta energia que as

luzes de Filadélfia piscaram várias vezes. As milhares de válvulas consumiam uma quantidade

enorme de eletricidade e dissipavam muito calor, sendo necessários vários aparelhos de ar

condicionado para refrigerá-lo. No ENIAC, a programação era efetuada por chaves e pela colocação

de vários fios em soquetes específicos (plugboard wiring). Esta máquina não tinha um sistema

operacional e seu funcionamento era parecido com uma calculadora simples de hoje. O ENIAC,

assim como uma calculadora, tinha de ser operado manualmente. A calculadora efetua os cálculos a

partir das teclas pressionadas, fazendo interação direta com o hardware.

No ENIAC era preciso conectar fios, relês e seqüências de chaves para que se determinasse a tarefa

a ser executada. À cada tarefa diferente o processo deveria ser refeito. A resposta era dada por uma

seqüencia de lâmpadas. Não era nada fácil mudar o programa e, através dessa experiência negativa,

evoluiu-se para o conceito de programa armazenado (stored program concept), cuja idéia foi

apresentada ainda em 1946 pelos pesquisadores Burks, Goldstine e Von Neumann, tendo este último

emprestado seu nome para o que conhecemos como a clássica “máquina tipo Von Neumann”.

Abaixo podem ser observadas algumas fotos de partes do ENIAC acessadas e obtidas em 18 de

Março de 2009, para fins didáticos e não comerciais, a partir dos links abaixo relacionados:

http://pt.wikipedia.org/wiki/ENIAC

;

http://www.google.com.br/imgres?imgurl=http://www.enciclopedia.com.pt/images/eniac.jpg&imgre

furl=http://www.enciclopedia.com.pt/articles.php%3Farticle_id%3D536&h=440&w=629&sz=160&

tbnid=FCp-056MiXZ8AM::&tbnh=96&tbnw=137&prev=/images%3Fq%3Deniac&hl=ptBR&usg=__yNVCmHPFVCJf_o6fnpQiCGnkHAs=&ei=J3HKSfzrOobpnQezzp2OAw&sa=X&oi=i

mage_result&resnum=4&ct=image&cd=1 ;

http://images.google.com.br/images?hl=ptBR&q=fotos+eniac&revid=932243387&ei=J3HKSfzrOobpnQezzp2OAw&resnum=0&um=1&ie=U

TF-&ei=FXLKSZvTH5LsnQeZt7SSAw&sa=X&oi=image_result_group&resnum=4&ct=title

6

7

http://news.cnet.com/Photos-ENIAC-in-the-works/2009-1006_3-6038088.html?tag=txt

8

http://news.cnet.com/Photos-ENIAC-in-the-works---page-2/2009-1006_3-6038088-2.html?tag=txt

9

http://news.cnet.com/Photos-ENIAC-in-the-works---page-4/2009-1006_3-6038088-4.html?tag=txt

http://news.cnet.com/Photos-ENIAC-in-the-works---page-8/2009-1006_3-6038088-8.html?tag=txt

10

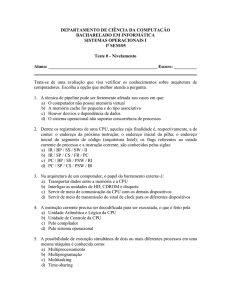

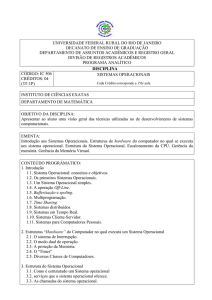

SISTEMAS OPERACIONAIS

1.0 Visão Geral

Um sistema operacional pode ser entendido (ou “visto”) como um programa que atua como

intermediário entre um ou mais usuários e o hardware de um computador. O propósito básico de um

sistema operacional é propiciar um ambiente no qual os usuários possam executar programas de

forma conveniente e eficiente. Compreender as razões que estão por trás do desenvolvimento dos

sistemas operacionais nos dá uma melhor compreensao das tarefas que eles executam e da forma

como o fazem.

.

Um sistema operacional, em seu sentido mais amplo, deve ser capaz de garantir a operação correta

de um sistema computacional, partilhando os recursos disponíveis (memória, CPU e dispositivos de

E/S (entrada e saída) da melhor forma possível. Os serviços fornecidos, é claro, diferem de um

sistema operacional para outro, mas nosso objetivo é explorar classes comuns à maioria dos sistemas

operacionais (S.O.), não nos atendo à particularidades deste ou daquele.

Sistemas de computadores evoluíram dos primeiros que não continham nenhum sistema operacional

como o ENIAC, por exemplo, para máquinas de multiprogramação, e dessas para máquinas de

tempo compartilhado, e depois para computadores pessoais e, por fim, para sistemas

verdadeiramente distribudos. À medida que a demanda por novas características e melhor eficiencia

cresciam e o hardware mudava. os sistemas operacionais evoluíram para cumprir novos papéis.

Por mais complexo que possa parecer, um sistema operacional é apenas um conjunto de rotinas

sendo executadas “harmoniosamente” pela CPU (processador), da mesma forma que qualquer outro

programa. Sua principal função é gerenciar os diversos recursos existentes no sistema

computacional, i.e., memória, CPU, e dispositivos de entrada e saída (E/S).

Atualmente, o usuário pode interagir com os sistemas operacionais via comandos fornecidos

diretamente a este ou via operações do tipo “click” (click) ou “duplo-click” (double click), onde um

dispositivo de apontamento (pointing device) é utilizado para percorrer a tela no sentido vertical e

horizontal de forma a permitir ao usuário “apontar” para o aplicativo a ser executado.

No caso de comandos fornecidos via operações de “clicks”, torna-se necessária a existência de uma

interface gráfica com a qual o usuário possa interagir de forma fácil e intuitiva. As interfaces que

possuem essa propriedade recebem o nome de GUIs (Graphic User Interface) sendo normalmente

bastante amigáveis quanto à sua utilização, o que contribui em muito para o aumento da

produtividade dos usuários que dela fazem uso. As interações com os usuários normalmente se dá

via caixas de diálogos (dialog boxes) com botões e campos de texto, como mostrado abaixo.

11

No caso de comandos fornecidos pela linha de comando há um aplicativo denominado interpretador

de linha de comando, ou CLI (Command Line Interpreter) que é responsável pela validação da

sintaxe do comando, i.e., se a grafia do comando está correta assim como os eventuais parametros

passados juntamente com o comando como, por exemplo, nos comandos do DOS fornecidos abaixo,

onde alguns comandos são válidados e executados e outros, escritos erroneamente, são descartados.

A utilização de linhas de comando é bastante tediosa visto que exige do usuário o conhecimento dos

comandos, seus parametros e de suas respectivas sintaxes, porém é ainda bastante comum em

ambientes do tipo mainframe ou em plataformas do tipo UNIX,com seu Shell , seus comandos e sua

conhecida verbose.

O nome sistema operacional nao é unico para designar esse conjunto de programas. Nomes como

monitor, executivo, supervisor ou controlador possuem, normalmente, o mesmo significado. Um

sistema operacional possui inúmeras funções, mas para efeitos didáticos, resumiremos em apenas 2:

a facilidade de acesso aos recursos e o compartilhamento desses recursos de forma organizada.

1.1 Recursos do Sistema Computacional

Um sistema de computação possui, normalmente, diversos elementos que o constituem, tais como

unidades de disco, monitores (vídeos/terminais), impressoras, fitas etc. Quando um desses

dispositivos é utilizado, sobre a ótica/perspectiva do usuário, não há a preocupação sobre como essa

utilização será realizada, assim como os detalhes técnicos envolvidos.

Por exemplo, uma operação cotidiana como a leitura de um arquivo em disco ou disquete pode

parecer simples mas, na verdade, nessa operação “simples”, foi utilizado um grande conjunto de

rotinas especificas, todas elas controladas pelo sistema operacional, Foi o sistema operacional que

acionou a cabeça de leitura e gravação da unidade de disco, posicionou-a na trilha e setor onde estão

os dados, transferiu os dados do disco para a memória e, finalmente, comunicou ao aplicativo que

solicitou a operação que esta foi concluída com exito, entregando ao aplicativo solicitante os dados.

O exemplo acima ilustra como o sistema operacional age de interface entre os usuários e os recursos

disponíveis no sistema, tornando esta comunicação transparente e permitindo aos usuários um

trabalho mais eficiente e com menores chances de erros. Este conceito de ambiente simulado, criado

pelo sistema operacional, é denominado de máquina estendida/expandida ou máquina virtual

(virtual machine) e está presente, de alguma forma, na maioria dos sistemas atuais.

12

É comum ter-se a idéia que aplicativos tais como os compiladores, depuradores, linkers e outras

ferramentas fazem parte do sistema operacional, mas na verdade, esses aplicativos são apenas

utilitarios, destinados a ajudar a interação do usuário com o computador. Eles podem estar ou

não presentes em um sistema computacional qualquer, sem que o sistema operacional necessite

deles. Sob a ótica do sistema, esses aplicativos são apenas mais alguns processos que serão

executados.

1.2 Compartilhamento de Recursos

Em sistemas do tipo multiusuário, onde vários usuários podem estar compartilhando os mesmos

recursos, como, por exemplo, CPU, memória e periféricos, é necessário que todos tenham a

oportunidade de ter acesso a esses recursos, de forma tal que um usuário não venha a interferir no

trabalho do outro. Por exemplo, uma impressora que pode ser utilizada por vários usuários do

sistema, deverá possuir algum nível de controle para impedir que a impressao de um usuário

interrompa a impressão de outros. Novamente, o sistema operacional é responsável por permitir o

acesso concorrente à impressora e a outros recursos eventualmente disponíveis, de forma

organizada e protegida, dando ao usuario a impressao de ser o único a utilizá-los.

O compartilhamento de recursos permite, tambem, a diminuição drástica dos custos, na medida

em que mais de um usuário pode utilizar as mesmas facilidades concorrentemente, como discos,

impressoras, recursos de rede etc. Nao é somente em sistemas do tipo multiusuário que o sistema

operacional é importante. Em um computador pessoal do tipo desktop ou laptop é o sistema

operacional neles residente (Windows, Linux etc.) que permite a execução de várias tarefas, como

por exemplo, a impressão de um documento, uma sessão de conversação via web com imagens e

sons, a cópia de um arquivo pela Internet ou a execução de uma planilha eletrônica.

1.3 Máquina de Níveis

Um sistema computacional qualquer, visto somente como um ou mais gabinetes compostos de

circuitos eletrônicos, cabos, fios e fontes de alimentação (hardware), nao tem nenhuma utilidade.

É através da utilização dos programas (software) que o computador consegue armazenar dados

em discos, imprimir relatórios, gerar gráficos, realizar cálculos dentre tantas outras funções. O

hardware é o responsável final pela execução das instruções de um programa, com a finalidade

de se realizar alguma tarefa.

Uma operação efetuada pelo software pode ser implementada em hardware e, análogamente, uma

instrução executada pelo hardware pode ser simulada via software. Esta decisão fica a cargo dos

projetistas de computadores em função de aspectos tais como custo, confiabilidade e

desempenho. Tanto o hardware quanto o software são lógicamente equivalentes, interagindo de

uma forma única para o usuário. Nos primeiros computadores, a programação era realizada em

painéis, através de fios, plugs e cabos, exigindo um grande conhecimento do hardware e de sua

linguagem de máquina. Isso era uma grande dificuldade para os programadores da época. A

solução para esse problema foi o surgimento do sistema operacional, que tornou a interação entre

usuário e computador mais simples, confiável e eficiente. A partir desse acontecimento, nao

existia mais a necessidade de o programador se envolver com a complexidade do hardware para

poder trabalhar; ou seja, a parte física do computador tomou-se transparente para o usuário.

Partindo desse principio, podemos considerar o computador como uma máquina de niveis ou

camadas, onde inicialmente existem dois niveis: o nível 0 (hardware) e o nível 1 (sistema

operacional - software). Sendo assim, o usuário leigo pode ver a máquina como sendo apenas

constituída do sistema operacional, com quem realmente interage, como se o hardware não

existisse. Reforça-se aqui o conceito de que se dá à essa visão abstrata o nome de máquina

virtual ou máquina estendida/expandida já abordado anteriormente.

13

Um sistema computacional qualquer evidentemente não é constituído de apenas 2 níveis, mas de

quantos níveis forem necessários para que o usuário possa interagir com o hardware – essa é uma

abstração normalmente empregue do ponto de vista didático – sendo que o usuário não precisa

saber de em qual camada ele se encontra.

1.4 Breve Histórico

A evolução dos sistemas operacionais sempre esteve ligada à história da evolução do hardware. O

ENIAC não dispunha de um sistema operacional ou qualquer outro tipo de software tal como o

conhecemos atualmente. A programação era feita mediante a utilização de cabos elétricos

especiais que eram conectados em diferentes partes da máquina. Esse trabalho era executado por

pessoas capacitadas para fazê-lo, como por exemplo, cientistas e engenheiros, ou pessoas

especialmente treinadas por estes. Com o desenvolvimento do transistor e consequente

susbstituição das válvulas por estes novos componentes, a miniaturização teve início e, com ela, a

drástica diminuição do tamanho dos computadores.

Com o contínuo avanço da tecnologia, o conceito de Von Neumann, pode ser implementado em

uma máquina eletrônica, dando origem aos computadores programáveis e, juntamente com eles o

desenvolvimento dos primeiros programas para serem executados. À medida que os empresários

e os governos foram se apercebendo da enorme aplicabilidade dessas máquinas, mais e mais

aplicações foram sendo desenvolvidas até que foi sentida a necessidade de se ter um programa

maior e mais complexo capaz de coordenar todas essas diferentes tarefas de uma forma mais fácil

e coordenada do que aquela que vinha sendo executada. Dessa necessidade crescente nasceram os

primeiros sistemas operacionais, que foram sendo instalados nos grandes computadores

comerciais.

Os primeiros sistemas operacionais eram do tipo monousuário (monouser) e monotarefa

(monotask) e, com isso, as tarefas eram executadas de forma sequencial, i.e., uma após outra. As

tarefas podiam ser agrupadas e executadas em lotes (batches), cada lote pertencendo à uma

determinada empresa, que pagava os custos decorrentes do processamento. O conceito de

datacenters ,i.e., empresas especializadas em processar os dados de outras empresas, acabara de

nascer e já estava se desenvolvendo.

As crescentes necessidades comerciais fizeram com que um novo tipo de sistema operacional

fosse desenvolvido e entrasse nesse cenário. Nascia o conceito de sistema operacional do tipo

multitarefa (multi-task) que era capaz de executar e controlar várias tarefas simultaneamente,

tornando ainda maior a aplicabilidade dessas máquinas.

O próximo passo foi o desenvolvimento de sistemas operacionais do tipo multi-usuário (multiuser), onde vários usuários diferentes podiam utilizar o mesmo computador e seus diferentes

recursos. Além disso, cada usuário podia ter o seu próprio conjunto de tarefas sendo executadas.

Quanto mais recursos da máquina eram alocados por determinado usuário (e suas tarefas), maior

era o preço do processamento decorrente, fazendo com que somente grandes empresas e governos

pudessem pagar por esses serviços. O total da conta era de certa forma proporcional à quantidade

de recursos utilizados por aquele usuário (e suas tarefas). Itens como quantidade de memória,

tempo de CPU, espaço em disco e em fitas magnéticas etc., eram inicialmente calculados por

pessoas treinadas para esse serviço, porém com o passar do tempo, essa tarefa passou também a

ser executada por processos especificamente desenvolvidos para esse fim.

14

O ínicio da era dos grandes computadores, constituídos por dezenas de placas contendo milhares

de componentes eletrônicos e dispositivos de armazenamento de dados (discos e fitas magnéticas)

havia começado e ainda perdura até nos dias de hoje.

Somente no ínicio da década de 1980, com o desenvolvimento e amadurecimento do conceito de

circuitos integrados e, posteriormente, com o desenvolvimento da tecnologia que permitiu a sua

criação e disseminação, apareceram os primeiros computadores pessoais. Novamente a história

iria se repetir, só que desta vez na escala residencial e não mais na empresarial.

O primeiro sistema operacional, por assim dizer, voltado para os recém chegados PCs, foi o DOS

(Disk Operating System) desenvolvido em regime de parceira pela IBM e pela Microsoft. Não

tardou para que os novos usuários domésticos também passassem a demandar novos serviços e

com eles um novo sistema operacional, o MS-Windows.

As primeiras versões do MS-Windows não foram bem sucedidas comercialmente devido ao

excessivo processamento que este novo sistema demandava da CPU e que esta não conseguia

suprir adequadamente. Somente com uma nova linha de CPUs, mais rápidas e poderosas,

desenvolvida pela Intel é que o sistema Windows começou a ganhar mercado e a se impor como

padrão.

Exemplos de sistemas operacionais para máquinas de grande porte (mainframes) são o UNIX, o

Open VMS, o MPX-32, o Sun OS e o OS/370, dentre tantos outros. Atualmente, há várias

versões do UNIX, cada qual adaptada e desenvolvida por fabricantes diferentes, tais como o HPUX, o AIX (IBM), o SOLARIS (SUN) e o Tru-64 (DEC/HP).

Atualmente, há vários tipos de sistemas operacionais voltados para os PCs (desktops e laptops)

derivados do UNIX, como por exemplo o Linux, o Librix, o Xenix, o QNX, o Fedora, o Suse etc.

Plataformas mainframes de alto desempenho podem apresentar mais de uma CPU em sua

arquitetura, o que demanda sistemas operacionais ainda mais complexos, capazes de tirar proveito

do grande poder de processamento dessas CPUs.

Resumindo :

a) O sistema operacional separa as diversas aplicações sendo executadas em um computador

do hardware por elas acessado. Ele pode ser visto como uma camada de software (SW)

envolvendo o hardware (HW), de forma a tornar este último transparente ao usuário

comum.

b) Cabe ainda ao Sistema Operacional, primordialmente, gerenciar os diversos recursos

pertencentes não somente ao reino do hardware tais como processadores, memória,

dispositivos de entrada/saída; dispositivos de comunicação, mas também ao reino do

software tais como as mais diversas aplicações de software que o usuário utiliza.

c) Os sistemas operacionais passaram por diversas fases de evolução ao longo dessas 6

últimas décadas

15

A evolução dos Sistemas Operacionais, sempre em sincronia com a evolução de um hardware

cada mais melhor e mais rápido pode ser vista, década à década, abaixo :

Década de 1940 (utilizavam-se válvulas, plugs e relés)

Os primeiros computadores não dispunham de sistemas operacionais.

Década de 1950 (utilizavam-se válvulas, plugs e relés)

Executavam um serviço (job) por vez.

Dispunham de tecnologias que facilitavam a transição de um job para outro.

Eram chamados de sistemas de processamento em lote de fluxo único.

Os programas e dados eram submetidos consecutivamente em uma fita magnética.

Década de 1960 (aparecimento dos transistores)

Permanecem como sistemas de processamento em lote

Processam vários serviços (jobs) simultaneamente

Multiprogramação

Um job podia usar o processador enquanto outros utilizavam os dispositivos

periféricos.

Desenvolveram-se sistemas operacionais avançados para atender a diversos usuários

de forma interativa

Esses sistemas foram desenvolvidos para apoiar usuários interativos simultâneos.

O tempo de retorno foi reduzido a minutos ou segundos.

Aparecem os primeiros sistemas de tempo real

Fornecem respostas dentro de um prazo determinado.

O tempo e os métodos de desenvolvimento foram aperfeiçoados.

O MIT usou o sistema CTSS para desenvolver seu próprio sucessor, o Multics.

Os sistemas TSS, Multics e CP/CMS, incorporavam memória virtual, endereçam mais

localizações de memória do que as realmente existentes.

Década de 1970 (apareceram os primeiros circuitos integrados)

Os sistemas de tempo compartilhado eram primordialmente multimodais, isto é, suportavam

processamento em lote, tempo compartilhado e aplicações de tempo real.

A computação pessoal estava apenas em seu estágio inicial, tendo sido favorecida por

desenvolvimentos anteriores à tecnologia de multiprocessadores.

O Departamento de Defesa Americano patrocinou o desenvolvimento do TCP/IP, inicialmente

denominado de ARPANET (Advanced Research Projects Agency NETwork), que pretendia-se

ser utilizado como protocolo de comunicação padrão. Esse protocolo passou a ser amplamente

usado em ambientes militares e universitários, porém, apresentava alguns problemas de

segurança, dado que crescentes volumes de informação eram transmitidos por linhas vulneráveis.

Década de 1980 (apareceram os primeiros circuitos integrados de baixa escala)

Foi a década do surgimento dos computadores pessoais e das estações de trabalho.

A computação era distribuída aos locais em que era necessária, gerando demanda.

Era relativamente fácil aprender a usar um computador pessoal.

Apareceram as primeiras interfaces gráficas com o usuário (GUI)

A transferência de informações entre computadores interconectados em rede tornou-se mais

econômica e prática.

O modelo de computação cliente/servidor se disseminou e com isso, os clientes são os

próprios computadores que solicitam serviços variados e os servidores são os computadores que

executam os serviços solicitados.

O campo da engenharia de software continuou a evoluir, recebendo grande impulso do

governo dos Estados Unidos, que visava controlar de modo mais rígido os projetos de software do

16

Departamento de Defesa. Uma das metas era a reutilização de códigos o que podia ser obtido pelo

maior grau de abstração nos idiomas de programação. Vários threads de instrução podiam ser

executados independentemente.

Década de 1990 (apareceram os primeiros circuitos integrados de larga escala)

O desempenho do hardware melhorou exponencialmente, com uma crescente capacidade de

processamento e armazenamento cada vez mais acessível. A execução de programas grandes e

complexos passou a poder ser feita em computadores pessoais. Teve início o desenvolvimento

dos serviços extensivos aos banco de dados e processamento remoto. A computação distribuída

ganhou ímpeto e com isso, inúmeros computadores independentes podiam executar tarefas

comuns.

O suporte a sistemas operacionais para tarefas de rede tornaram-se padrão, com grande

aumento da produtividade e comunicação.

A Microsoft Corporation tornou-se dominante no mercado, com suas várias versões dos seus

sistemas operacionais Windows, que empregava vários conceitos usados nos primeiros sistemas

operacionais Macintosh e que permitia que os usários executassem várias aplicações concorrentes

com facilidade.

A tecnologia de objeto tornou-se popular em várias áreas da computação, com diversas

aplicações sendo desenvolvidas em linguagens de programação orientadas a objetos, como por

exemplo, o C++ e o Java. Apareceram alguns sistemas operacionais orientados a objetos

(SOOO), onde os objetos representavam componentes do sistema operacional.

A maioria dos softwares comerciais era vendida como código-objeto e o código-fonte não era

incluído, permitindo aos fabricantes que ocultassem informações e técnicas de programação

patenteadas.

Os softwares gratuitos e de fonte aberto tornaram-se muito comuns na década de 1990. O

software de fonte aberto era distribuído com o código-fonte, permitindo que outras pessoas

examinassem e modificassem o software. O sistema operacional Linux e o servidor Web Apache

são ambos software de fonte aberto.

Richard Stallman lançou o projeto GNU, que recriava e ampliava as ferramentas do sistema

operacional UNIX da AT&T. Stallman discordava do conceito de pagar licença para usar um

software.

Grande porte (mainframes)

1990

1950

1960

1º Sistema Operacional

Monoprogramável

Monotarefa

1970

Sistemas

Multitarefa

Introduzido o

conceito de

Memória Virtual

1980

Sistemas

Multiprogramáveis

Multitarefa

Microcomputadores

17

2.0 Componentes de um Sistema Operacional

Conforme já visto anteriormente, um usuário interage com o sistema operacional via uma ou mais

aplicações de usuário e, muitas vezes, por meio de uma aplicação especial denominada Shell ou

CLI, ou interpretador de comandos. A maioria dos interpretadores de comando atuais é

implementada como interfaces de texto que habilitam o usuário a emitir comandos por meio de

um tec1ado, ou como GUIs (Graphic User Interface) que permitem que o usuario 'aponte-eclique' e 'arraste-e-solte' ícones para requisitar serviços ao sistema operacional, como por

exemplo, para abrir uma aplicação como um editor de textos, um aplicativo para apresentações ou

mesmo uma planilha eletrônica.

O Microsoft Windows XP, por exemplo, fornece uma GUI por meio da qual os usuários podem

fornecer comandos. O usuário pode abrir alternativamente uma janela de comandos (Command

Prompt (antigo DOS)) que aceite os comandos fornecidos pelo usuário.

O software que contém os componentes centrais do sistema operacional chama-se núcleo do

sistema, ou kernel (em alemão). Os principais componentes centrais de um sistema operacional

são:

a) o escalonador de processo, que determina quando e por quanto tempo um

processo é executado em um processador.

b) o gerenciador de memória, que determina quando e como a memória é alocada

aos processos e quais ações tomar quando a memória principal estiver toda ela

ocupada.

c) o gerenciador de E/S, que atende as solicitações de E/S de e para dispositivos de

hardware, respectivamente.

d) o gerenciador de comunicação interprocessos, IPC (Inter Process

Communication), que permite que os processos se comuniquem uns com os

outros.

e) o gerenciador de sistema de arquivos, que organiza coleções nomeadas de dados

em dispositivos de armazenamento e fornece uma interface para acessar os dados

nesses dispositivos.

Quase todos os sistemas operacionais atuais suportam um ambiente de multiprogramação no qual

várias aplicações podem ser executadas concorrentemente. Uma das responsabilidades mais

fundamentais de um sistema operacional é deterrninar qual processador executa um processo e

durante quanto tempo esse processo será executado.

Um programa pode conter diversos elementos que compartilhem dados e que podem ser

executados concorrentemente. Por exemplo, um navegador Web pode conter componentes

isolados para ler a HTML de uma página Web, recuperar a mídia da página (ou seja, imagens,

texto e vídeo) e exibir esta página apresentando seu conteúdo na janela do navegador. Esses

componentes de programa, executados independentemente, mas que realizam seu trabalho em um

espaço de memória comum, sao chamados de threads (fluxos de execução). Normalmente,

muitos processos competem para usar o processador e o escalonador de processos pode basear

suas decisões em diversos critérios, como a importância atribuída a um processo, o tempo

estimado de execução etc.

O gerenciador de memória aloca memória para o sistema operacional e para os processos. Com a

tarefa de garantir que os processos nãoo interfiram na operação normal do sistema operacional ou

uns nos outros, o gerenciador de memória impede que cada processador acesse memória que não

lhe tenha sido alocada. Quase todos os sistemas operacionais atuais suportam memória virtual.

18

Uma outra função central do sistema operacional é gerenciar os dispositivos de E/S

(entrada/saída) do computador. São exemplos de dispositivos de entrada os teclados, mouses,

microfones e scanners. São exemplos de dispositivos de saída os monitores, impressoras e altofalantes.

Dispositivos de armazenamento (por exemplo, discos rígidos, fitas, discos óticos regraváveis ou

não) e placas de rede funcionam como dispositivos de entrada e saída. Quando um processo quer

acessar um dispositivo de E/S, deve emitir uma chamada ao sistema operacional. Aquela

chamada é subseqiientemente utilizada por um driver de dispositivo, que é um componente de

software que interage diretamente com o hardware e, em geral, contém comandos e outras

instruções específicas do dispositivo para realizar as operações de E/S requisitadas.

A rnaioria dos sistemas de computador pode armazenar dados persistentemente (isto e, após o

computador ter sido desligado). Como a memória principal (RAM) é geralmente relativamente

pequena e perde seus dados quando a fonte de energia é desligada (memórias voláteis), são

usados dispositivos secundários de armazenamento persistente (não voláteis), mais comumente

discos rígidos. Um operação de E/S no disco - uma das formas mais comuns de E/S - ocorre

quando um processo requisita acesso à informações que estão em um dispositivo de disco.

Entretanto, o armazenamento secundário é muito mais lento do que os processadores e a memória

principal. O escalonador de disco de um sistema operacional é responsável pela reordenação das

requisições de E/S por disco para maximizar o desempenho e minimizar a quantidade de tempo

que um processo espera pelo tpermino das operações de E/S por disco.

Os sistemas de arranjo redundante de discos independentes, RAID, (Redundant Array of

Independent Disks) tentam reduzir o tempo que um processo espera pela operação de E/S por

disco, utilizando vários discos ao mesmo tempo para atender às requisições de E/S. Existem

vários algoritmos de escalonamento de discos e sistemas RAID, todos objetivando o ganho de

performance.

Os sistemas operacionais usam sistemas de arquivo para organizar e acessar eficientemente

coleções nomeadas de dados, denominadas arquivos e localizadas em dispositivos de

armazenamento. Esses arquivos por sua vez, podem encontrar-se agrupados em áreas

denominadas diretórios, onde um diretório pode apresentar vários subdiretórios e estes outros

mais, sucessivamente em uma estrutura de árvore.

Com frequência, os processos (threads) cooperam para cumprir uma meta comum. Assim, muitos

sistemas operacionais proporcionam comunicação entre processos (IPC) e mecanismos de

sincronização para simplificar essas programações concorrentes. A comunicação entre processos

habilita os processos a se comunicarem via mensagens enviadas entre eles (e entre as threads). A

sincronização fornece estruturas que podem ser usadas para assegurar que processos (e threads)

compartilhem os dados adequadamente.

19

2.1 Tipos de Sistemas Operacionais

Tipos de

Sistemas Operacionais

Sistemas

Monoprogramável/

Monotarefa

Sistemas

Multiprogramável/

Multitarefa

Sistemas

Com Múltiplos

Processadores

2.1.1 Sistemas Monoprogramável/Monotarefa

Os primeiros sistemas operacionais eram voltados tipicamente para a execução de um único

programa. Qualquer outra aplicação, para ser executada, deveria aguardar o término do programa

corrente. Neste tipo de sistema, o processador, a memória e os periféricos permanecem

exclusivamente dedicados à execução de um único programa. Esse único programa monopoliza a

CPU.

Os sistemas monoprogramáveis estão diretamente ligados ao surgimento, na década de 50/60, dos

primeiros computadores. Embora os sistemas operacionais já tivessem evoluído com as

tecnologias de multitarefa e multiprogramáveis, os sistemas monoprogramáveis voltaram a ser

utilizados na plataforma de microcomputadores pessoais e estações de trabalho devido à baixa

capacidade de armazenamento destas máquinas, na época.

Era muito clara a desvantagem deste tipo de sistema, no que diz respeito à limitação de tarefas

(uma de cada vez), o que provocava um grande desperdício de recursos de hardware.

_______

_______

_______

_______

_______

CPU

Memória

Principal

(RAM)

Dispositivos

E/S

Programa/Tarefa

Sistema Monoprogramável/Monotarefa

20

Comparados a outros sistemas, os monoprogramáveis são de simples implementação, não

existindo muita preocupação com problemas decorrentes do compartilhamento de recursos como

memória, processador e dispositivos de E/S.

2.1.2 Sistemas Multiprogramável/Multitarefa

Constituindo-se uma evolução dos sistemas monoprogramáveis, neste tipo de sistema os recursos

computacionais são compartilhados entre os diversos usuários e aplicações: enquanto um

programa espera por um evento, outros programas podem estar processando neste mesmo

intervalo de tempo. Neste caso, podemos observar o compartilhamento da memória e do

processador. O sistema operacional se incumbe de gerenciar o acesso concorrente aos seus

diversos recursos, como processador, memória e periféricos, de forma ordenada e protegida, entre

os diversos programas.

As vantagens do uso deste tipo de sistema são a redução do tempo de resposta das aplicações,

além dos custos reduzidos devido ao compartilhamento dos recursos do sistema entre as

diferentes aplicações. Apesar de mais eficientes que os monoprogramáveis, os sistemas

multiprogramáveis são de implementação muito mais complexa.

Programa_1/Tarefa_1

Programa_4/Tarefa_4

_______

_______

_______

_______

_______

_______

_______

_______

_______

_______

_______

_______

_______

_______

_______

CPU

Memória

Principal

(RAM)

Dispositivos E/S

_______

_______

_______

_______

_______

Programa_3/Tarefa_3

Programa_2/Tarefa_2

Sistema Multiprogramável/Multitarefa

21

Os sistemas multiprogramáveis/multitarefa podem ser classificados de acordo com a

forma com que suas aplicações são gerenciadas, podendo ser divididos em sistemas

batch, de tempo compartilhado e de tempo real, de acordo com a figura abaixo.

Sistemas

Multiprogramáveis/

Multitarefa

Sistemas em

Lotes

Sistemas de

Tempo Compartilhado

Sistemas de

Tempo Real

2.1.2.1 Sistemas em Lotes (Batches)

Foram os primeiros sistemas multiprogramáveis a serem implementados na década de 60. Nesta

modalidade, os programas eram submetidos para execução através de cartões perfurados e

armazenados em disco ou fita, para posterior execução. Vem daí o nome batch (lote de cartões).

O processamento em batch tem como característica não exigir interação do usuário com o sistema

ou com a aplicação. Todas as entradas ou saídas são implementadas por meio de algum tipo de

memória secundária, geralmente disco ou fita. Aplicações deste tipo eram utilizadas em cálculo

numérico, compilações, back-ups, etc.

Estes sistemas, se bem projetados, podem ser bastante eficientes devido à melhor utilização do

processador, mas podem oferecer tempos de resposta bastante longos. Atualmente, os sistemas

operacionais simulam este tipo de processamento, não havendo sistemas dedicados a este tipo de

execução.

2.1.2.2 Sistemas de Tempo Compartilhado

Também chamados sistemas de time-sharing, são sistemas que permitem que diversos programas

sejam executados a partir da divisão de tempo da CPU em pequenos intervalos, denominados

fatia de tempo (time slices) ou quantum. Caso a fatia de tempo não seja suficiente para a

conclusão do programa, este é interrompido pelo sistema operacional e substituído na CPU por

outro, enquanto aguarda uma nova fatia de tempo. Neste tipo de processamento, cada usuário tem

a impressão de que a máquina está dedicada ao seu programa, como se ele fosse o único usuário a

se utilizar do sistema.

Geralmente permitem interação do usuário com a aplicação através de terminais compostos por

monitor, teclado e mouse. Estes sistemas possuem uma linguagem de controle que permite ao

usuário interagir com o sistema operacional através de comandos. Assim, é possível verificar

arquivos armazenados em disco ou cancelar execução de programas. Normalmente, o sistema

responde em apenas alguns segundos à maioria destes comandos, o que se levou a chamá-los

também de sistemas on-line.

A maioria das aplicações comerciais atualmente é processada em ambiente de tempo

compartilhado, que oferece tempos baixos de respostas a seus usuários e menores custos, em

função do alto grau de compartilhamento dos diversos recursos do sistema.

22

2.1.2.3 Sistemas Operacionais de Tempo Real : Críticos e Não Críticos

Este tipo de sistema é implementado de forma bastante semelhante ao de tempo compartilhado. O

que caracteriza a diferença entre eles é o tempo exigido no processamento das aplicações.

Enquanto nos sistemas de tempo compartilhado o tempo de processamento pode variar sem

comprometer as aplicações em execução, nos sistemas de tempo real os tempos de execução

devem estar dentro de limites rígidos, que devem ser obedecidos, caso contrário poderão ocorrer

problemas irreparáveis.

No sistema de tempo real não existe a idéia de fatia de tempo como nos sistemas de tempo

compartilhado. Um programa ocupa o processador o tempo que for necessário ou até que apareça

um outro com um nível de prioridade maior. Esta prioridade de execução é definida pela própria

aplicação e não pelo sistema operacional, como nos sistemas de tempo compartilhado.

Estes sistemas são utilizados em aplicações de controle de processos, como monitoramento de

refinarias de petróleo, controle de tráfego aéreo, de usinas, ou em qualquer aplicação onde o

tempo de processamento é fator fundamental.

Um sistema desse tipo é utilizado quando existem requisitos rígidos de tempo na operação de um

processador ou no fIuxo de dados no sistema. Ele é normalmente utilizado em aplicações

dedicadas e críticas no tempo, como por exemplo, no controle de usinas nucleares, usinas

elétricas, no controle de aeronaves, controle de experimentos científicos, sistemas de imagens

médicas, sistemas de controle industrial, sistemas de injeção eletrônica de combustivel em

motores de veículos, controladores de eletrodomésticos e sistemas bélicos. Um sistema de tempo

real tem limitações de tempo bem definidas, rígidas e fixas.

O processamento tem de ser feito dentro dos limites definidos ou o sistema poderá falhar, como

por exemplo no controle de braços robóticos na construção de carros em uma linha de montagem

automatizada – aqui, o tempo é fator decisivo, diferentemente do que ocorre com um sistema de

tempo compartilhado, em que é desejável , mas não obrigatório, uma resposta rápida. Existem 2

tipos de sistema de tempo real : o crítico e o não crítico.

Um sistema de tempo real crítico procura garantir que as tarefas críticas sejam executadas a

tempo. Essa meta requer que todos os atrasos no sistema sejam limitados, desde a recuperação

dos dados armazenados até o tempo que o sistema operacional precisa para terminar qualquer

solicitação realizada. As limitações de tempo inerentes em aplicações críticas incluem o acesso

aos diferentes tipos de memórias, voláteis ou não, de acesso aleatório ou sequencial. Claramente

pode-se ver que a utilização de armazenamento secundário de qualquer tipo geralmente é muito

limitado e normalmente ausente, sendo desejável que os dados sejam armazenados em memórias

de acesso aleatórias de alta velocidade.

Outros recursos mais avançados, existentes na maioria dos sistemas operacionais também estão

ausentes, como por exemplo a utilização de memória virtual. Essa caracterísitica quase nunca é

encontrada nos sistemas de tempo real, pelos motivos relacionados e, portanto, os sistemas de

tempo real crítico não são compatíveis com a operação dos sistemas de tempo compartilhado, e os

dois não devem ser combinados.

.

Um tipo menos restritivo de sistema de tempo real é o sistema de tempo real não-crítico, no qual

uma tarefa considerada crítica recebe prioridade sobre as demais tarefas não críticas, mantendo

essa prioridade até ser concluída. Como ocorre com os sistema de tempo real crítico, os atrasos

internos ao kernel precisam ser limitados: uma tarefa de tempo real não pode ficar esperando

23

indefinidamente para ser executada.. O tempo real não-crítico é uma meta alcançável que pode

ser combinada com outros tipos de sistemas.

Os sistemas de tempo real não-crítico, no entanto, tem utilidade mais limitada do que os sistema

de tempo real crítico. Considerando sua arquitetura e projeto, eles não são apropriados para

controle industrial, como por exemplo, aplicações robóticas. No entanto, existem várias áreas nas

quais são úteis, incluindo-se aplicações com multimídia, realidade virtual e projetos cientificos

avançados, tais como explorações submarinas e astronáuticas. Esses sistemas precisam de

recursos avançados presentes em sistemas operacionais e que não são apropriados para sistemas

de tempo real crítico. As diferentes versões baseadas no sistema operacional UNIX constituem

bons exemplos de sistemas de tempo real não críticos, assim como o QNX e o VxWorks.

2.2 Sistemas com Múltiplos Processadores

Os sistemas com múltiplos processadores caracterizam-se por possuir duas ou mais CPUs

interligadas e trabalhando em conjunto. A vantagem deste tipo de sistema é permitir que vários

programas sejam executados ao mesmo tempo ou que um mesmo programa seja subdividido em

várias partes para serem executadas simultaneamente em mais de um processador.

Esta técnica permitiu a criação de sistemas computacionais voltados para processamento

científico, prospecção de petróleo, simulações, processamento de imagens e CAD.

Um fator chave no desenvolvimento dos sistemas multiprocessados é a forma de comunicação

entre as CPUs e o grau de compartilhamento da memória e dos dispositivos de E/S. Em função

destes fatores, podemos classificar os sistemas multiprocessados de acordo com a figura a seguir:

Sistemas

com

Múltiplos

Processadores

Sistemas

Fortemente

Acoplados

Simétricos

Sistemas

Fracamente

Acoplados

Assimétricos

Redes

Distribuídos

Tipos de Sistemas com Múltiplos Processadores

24

2.2.1 Sistemas Fortemente Acoplados : Simétricos e Não Simétricos

Na figura anterior pode-se perceber a divisão dos sistemas multiprocessados em duas categorias

iniciais: sistemas fortemente acoplados e fracamente acoplados. A grande diferença entre estas

duas categorias é que nos sistemas fortemente acoplados existe apenas uma memória e um

barramento a ser compartilhada pelos processadores do conjunto, enquanto que nos sistemas

fracamente acoplados cada sistema tem sua própria memória individual. A taxa de transferência

de dados entre CPUs e memória em sistemas fortemente acoplados é muito maior que nos

fracamente acoplados.

Nos sistemas fortemente acoplados a memória principal e os dispositivos de E/S são gerenciados

por um único sistema operacional. Quando todos os processadores na arquitetura são iguais e as

funções também são iguais, diz-se que o sistema é simétrico. No entanto, quando os

processadores são iguais, porém com funções diferentes, a arquitetura denomina-se assimétrica .

A maioria dos sistemas atuais são sistemas de um único processador, ou seja, com somente uma

CPU principal. No entanto, existe uma forte tendência em direção aos sistemas com mais de uma

CPU, os assim chamados sistemas multiprocessados. Tais sistemas tem mais de um processador

em comunicação ativa, compartilhando elementos comuns, tais como o barramento, o relógio do

sistema (clock) e, as vezes, a memória e alguns dispositivos periféricos. A esses sistemas dá-se o

nome de sistemas fortemente acoplados (tightly coupled systems).

Há vários motivos para a existência desses sistemas, como por exemplo uma maior eficiência

(throughput) na execução dos vários processos. Ao se aumentar o número de processadores,

espera-se realizar mais trabalho em menos tempo, mas isso não ocorre. A taxa de aumento de

velocidade com n processadores, entretanto, não é n, mas menor que n, ou seja não é uma relação

linear. Quando vários processadores cooperam em uma tarefa, uma determinada quantidade de

esforço é necessária para manter todas as partes trabalhando corretamente. Esse esforço, em

adição à constante disputa por recursos compartilhados, diminui o ganho esperado dos

processadores adicionais. Da mesma forma que um grupo de n programadores trabalhando em

conjunto não redunda em n vezes a quantidade de trabalho sendo realizada.

Outro motivo para a existência de sistemas com múltiplos processadores é o aumento da

confiabilidade. Se as funções forem distribuídas adequadamente entre os vários processadores, a

falha de um processador não irá interromper o funcionamento de todo o sistema, mas apenas

reduzir a sua velocidade como um todo. Por exemplo, no caso de haver 8 processadores e um

dentre eles vier a falhar, cada um dos outros 7 processadores poderá arcar com o trabalho extra

que estava sendo executado pelo processador defeituoso. O usuário poderá perceber ou não um

pequeno aumento na lentidão do sistema.

À capacidade de continuar a fornecer serviços proporcionais, em sistemas multiprocessados, dáse o nome de degradação normal e, os sistemas projetados para degradação normal tambem são

conhecidos como sistemas tolerantes a falhas. A operação continuada, mesmo com falhas exige

um mecanismo para permitir que a falha seja detectada, diagnosticada e corrigida, se possível for.

Um exemplo dessa arquitetura é o sistema Tandem que utiliza hardware e software duplicados

para garantir a operação contínua, apesar das falhas. O sistema consiste de 2 processadores

idênticos, cada qual com sua própria memória local. Os 2 processadores são conectados por um

barramento comum, sendo que um dos processadores é o primário e o outro, o back-up. Cada

processo sendo executado possui 2 cópias, uma no processador primário e outra no back-up. Em

pontos de verificação previamente estabelecidos (checkpoints), durante a execução normal do

sistema, as informações sobre o status de cada processo (incluindo cópia da imagem da memoria)

são copiadas da máquina primária para a back-up e, se uma falha é detectada, a cópia reserva é

25

ativada e reiniciada a partir do ponto de verificação mais recente. É fácil de se perceber que

sistemas tolerantes à falhas são inerentemente mais caros que sistemas tradicionais.

Os sistemas com 2 ou mais processadores mais comuns utilizam-se do multiprocessamento

simétrico, onde cada processador executa sua própria cópia do sistema operacional, sendo que

essas cópias comunicam-se entre si toda vez que for necessário fazê-lo. Outros sistemas podem

valer-se de multiprocessamento assimétrico, onde cada processador recebe sua própria tarefa

para ser executada. Um processador principal (master) controla todo o sistema e todos os outros

processadores escravos (slaves) procuram o mestre para receber instruções ou continuam a

executar suas tarefas pré definidas. Esse esquema define uma relação do tipo mestre-escravo

(master-slave relationship), onde o processador mestre escalona e aloca trabalho para os

processadores escravos.

Já no multiprocessamento simétrico , SMP (symmetric multiprocessing), todos os processadores

são iguais, não existindo uma relação do tipo mestre-escravo entre os processadores. Cada

processador executa uma cópia do sistema operacional de forma concorrente, partilhando um

barramento (bus) e uma memória, ambos comuns. Nesse modelo de arquitetura operacional,

deve-se ter muito cuidado com as operações de E/S de forma a garantir que as informações

(dados) cheguem ao processador correto. Como as CPUs são independentes, uma pode estar

ociosa enquanto outra está sobrecarregada, resultando em um sistema ineficiente, o que pode ser

minimizado se os processadores compartilharem determinadas estruturas de dados. Um sistema

multiprocessado desse tipo permitirá que processos e recursos, como a memória, sejam compartilhados de forma dinâmica entre vários processadores, podendo diminuir a diferença entre os

processadores. Um sistema desse tipo deve ser cuidadosamente elaborado, como sera visto no

Capitulo 7. Praticamente todos os sistemas operacionais modernos - incluindo o Windows NT,

Solaris, Digital UNIX, OS/2 e Linux agora fornecem suporte a SMP.

A diferença entre multiprocessamento simétrico e assimétrico pode ser resultado de hardware ou

software específicos. Um hardware especial pode diferenciar os múltiplos processadores, ou

então o software pode ser escrito de forma a permitir um mestre e vários escravos. Exemplos : o

sistema operacional SunOS versão 4 da Sun, fornece multiprocessamento assimétrico, enquanto a

versao 5 (Solaris 2) é simétrica, valendo-se do mesmo hardware.

CPU1

CPU2

CPU3

CPU4

CPU5

Barramento Compartilhado

Controlador de memória

Memória compartilhada

Arquitetura de multiprocessamento simétrico

26

2.2.2 Sistemas Fracamente Acoplados : de Rede e Distribuídos

O grande crescimento das redes de computadores e, em especial, da Internet teve um impacto

profundo no desenvolvimento recente dos sistemas operacionais. Quando os PCs surgiram no

final dos anos 70 com a finalidade de serem utilizados para uso "pessoal", eles eram considerados

computadores independentes. Com o uso mais e mais generalizado da Internet no ínicio dos anos

90, os PCs passaram a poder se conectar à redes de computadores. Com a massiva popularização

da WWW (Wide World Web), ou simplesmente Web, em meados da década de 1990, a

conectividade de rede passou a ser considerada um componente essencial de um sistema de

computação, incluindo-se aí os computadores pessoais.

Praticamente todos os PCs e estações de trabalho modernas são capazes de executar browsers

(Netscape, Internet Explorer, FireFox etc.) para acessar documentos to tipo hipertexto na Web.

Sistemas operacionais como o Windows, MacOS, Linux e UNIX, dentre tantos outros agora

também incluem o software de comunicação utilizado na Web, como por exemplo o TCP/IP que

permite a um computador acessar a Internet via uma rede local ou conexão telefônica (dial up).

Nos sistemas fracamente acoplados, como os processadores estão em arquiteturas diferentes,

somente interligados por cabos de interconexão, cada CPU constitui uma máquina independente,

com memória própria, dispositivos de E/S e sistemas operacionais independentes. Nesta

subdivisão, temos como exemplo as redes e os sistemas distribuídos.

No ambiente de rede, existem dois ou mais sistemas independentes (hosts), interligados por linhas

telefônicas, que oferecem algum tipo de serviço aos demais, permitindo que um host compartilhe

seus recursos, como impressora e diretórios, com os outros hosts da rede. Enquanto nos sistemas

em rede os usuários têm conhecimento dos hosts e seus serviços, nos sistemas distribuídos os

sistema operacional esconde os detalhes dos hosts individuais e passa a tratá-los como um

conjunto único, como se fosse um sistema só, fortemente acoplado. Os sistemas distribuídos

permitem, por exemplo, que uma aplicação seja dividida em partes e que cada parte seja

executada por hosts diferentes na rede. Para os usuários e suas aplicações é como se não existisse

a rede, mas um único sistema centralizado.

27

2.2.3 Sistemas em Clusters

Outros exemplos de sistemas distribuídos são os clusters. Em um cluster podem existir dois ou

mais servidores ligados por algum tipo de conexão de alto desempenho, e o usuário não conhece

os nomes dos membros do cluster e nem quantos são. Quando é necessário algum serviço, basta

solicitar ao cluster para obtê-lo, sem se preocupar com quem vai dispor e oferecer tal serviço.

Clusters são muito utilizados em servidores de bancos de dados e Web. Em cada servidor, cujo

hardware é identico, o software também deve ser idêntico, i.e., existe um sistema operacional

exatamente igual, com a mesma versão, mesmo firmware, mesmas quotas de disco, quotas de

memória, mesmos usuários e mesmos privilégios, mesmas tarefas/processos sendo executados

etc.

2.2.4 Sistemas Embarcados

Continuando a descer na escala de tamanho dos sistemas operacionais, vemos os sistemas de

computadores de mão e embarcados. Um computador de mão, também conhecido como PDA

(Personal Digital Assistant), é um pequeno computador que cabe em um bolso de camisa e

realiza um pequeno número de funções como por exemplo, atuar como agenda eletrônica ou um

livro de endereços. Sistemas embarcados são executados em computadores que controlam

dispositivos que geralmente não são considerados computadores tais como aparelhos de TV,

fornos de microondas e telefones móveis. Eles tem, muitas vezes, características de sistemas de

tempo real, mas tambem apresentam restrições de tamanho, memória e de consumo de energia

que os fazem especiais. Exemplos desses sistemas operacionais sao o PalmOS e o Windows CE

(Consumer Electronics).

Os telefones celulares também constituem exemplos de sistemas operacionais embarcados, visto

que as várias possibilidades oferecidas por esses aparelhos necessitam de um controle operacional

e, em especial, aqueles com recursos multimídia e possibilidades de acesso à Internet. O sistema

operacional embarcado mais comum é o Symbian, criado para rodar nos celulares "multimídia"

com suporte para cameras fotográficas, MMS, wireless, bluetooth dentre outras funções. Este

sistema operacional é predominantemente baseado em um ambiente gráfico bastante simples. Por

ser pequeno, robusto e modular, como a maioria dos sistemas embarcados, a grande preocupação

do Symbian é evitar ao máximo o desperdício dos recursos do celular, como bateria e memória.

Para isso ele conta com diversos mecanismos que são eficientes ao tratar com esses problemas.

Em sua versão mais nova, a 9.5, foi reduzido o consumo de memória em 30% em relação a

versão anterior. Atualmente o Symbian lidera como sendo o SO mais utilizado em smartphones, á

frente do Linux e do Windows Mobile, entre outros.

2.2.5 Sistemas de Cartões Inteligentes

Os menores sistemas operacionais estão presentes nos assim chamados cartões inteligentes (smart

cards) - dispositivos do tamanho de cartões de crédito que contém um chip de CPU, que na

maioria das vezes é um microcontrolador. Esses sistemas possuem restrições severas de consumo

de energia elétrica e de memória. Alguns deles podem realizar apenas uma única função, como

por exemplo pagamentos eletrônicos, mas outros podem efetuar múltiplas funções no mesmo

cartao inteligente. Esses sistemas são normalmente sistemas proprietários.

Alguns desses cartões inteligentes são orientados à Java, o que significa dizer que a ROM do

cartao inteligente contém um interpretador para a máquina virtual Java (Java Virtual Machine JVM). As pequenas aplicações Java denominadas applets são carregadas no cartão e interpretadas

pelo JVM. Alguns desses cartões podem tratar várias applets Java ao mesmo tempo, gerando um

28

ambiente de multiprogramação (multitask) e a conseqüente necessidade de escalonamento dessas

tarefas (processos).

O gerenciamento de recursos e os aspectos relacionados à proteção, quando 2 ou mais applets

estão presentes simultaneamente, podem se transformar em problemas potenciais, problemas

esses que devem ser tratados pelo sistema operacional contido no cartão.

29

3.0 Arquiteturas de Sistemas Operacionais

3.1 Sistema Monolítico

Um sistema operacional é dito ser monolítico quando todos os seus componentes estão contidos

no seu próprio kernel , i.e, dentro do próprio sistema operacional e, em assim sendo, todo

componente pode comunicar-se diretamente com qualquer outro de maneira rápida, ainda que não

de forma modular e estruturada.

Tal abordagem tende a ser altamente eficaz, dado que muito pouco tempo é gasto nas chamadas

internas ao próprio sistema, entretanto a grande desvantagem dessa abordagem é que por não ser

uma concepção modular, fica muito mais difícil a determinação e correção dos erros mais sutis.

Aplicação

Aplicação

Modo Usuário

Modo Kernel

System Call

Núcleo

do

Sistema

Hardware

30

3.2 Sistemas em Camadas

Na tentativa de se fugir do conceito e da implementação de um sistema operacional monolítico,

tentou-se um outra abordagem, de conceituação mais modular, i.e, o agrupamento de

componentes que executam funções semelhantes.

Nessa nova abordagem, cada camada comunica-se apenas com as camadas imediatamente acima

ou abaixo dela. Dessa forma, as solicitações dos processos devem passar por várias camadas para

serem concluídas e, com certeza, o desempenho (rendimento) do sistema pode ser menor do que o

dos núcleos monolíticos, mas ganha-se na modularidade no projeto, o que é, por si só, uma

enorme vantagem em caso de se depurar o sistema operacional, ainda em seus estágios mais

preliminares. Além disso, outros métodos precisam ser chamados para transmitir dados e

controle, obedecendo-se à uma hierarquia, tal qual a hierarquia existente em uma empresa.

Um dos primeiros sistemas operacionais a abordar o conceito “em camadas” foi o sistema

operacional THE (Technische Hogeschool Eindhoven), elaborado por Dijkstra na Holanda em

1968 e esquematizado abaixo:

Um outro exemplo comumente mencionado ao se tratar de sistemas operacionais em camadas é o

sistema operacional da antiga DEC (Digital Equipment Corporation, que foi comprada pela

Compaq, atual HP), o Open VMS. Este sistema se tornou extremamente aceito no mercado em

função da sua estabilidade operacional, rapidez e pelo baixo número de problemas decorrentes da

utilização dos seus aplicativos (e do seu kernel).

31

3.3 Sistema de Micronúcleo (Microkernel)

Um sistema operacional de micronúcleo fornece, como seu próprio nome sugere, somente um

número pequeno de serviços e com isso, manter seu kernel pequeno e coeso, porém mantendo um

alto grau de modularidade.

Esses sistemas operacionais são normalmente extensíveis, portáteis e escaláveis,o quer requer um

maior nível de comunicação entre módulos, o que, em contrapartida, acarreta uma diminuição do

desempenho do sistema.

Servidor

Arquivo

Servidor

Memória

Servidor

Processo

Servidor

Impressão

Servidor

Rede

Modo Usuário

Modo Kernel

Microkernel

Hardware

32

3.4 Características de um Sistema Operacional

De uma forma geral, algumas das principais características desejáveis nos sistemas operacionais,

do ponto de vista dos usuários (U) e dos projetistas (P) de Sistemas Operacionais são :

eficiência

modularidade

robustez

escalabilidade

extensibilidade

portabilidade

usabilidade

segurança

estabilidade operacional

velocidade operacional

interatividade

preço acessível

boa documentação

(U, P)

(P)

(U, P)

(U, P)

(U, P)

(U, P)

(U, P)

(U, P)

(U, P)

(U, P)

(U)

(U)

(U, P)

Um sistema computacional qualquer é composto pelo Hardware (HW), como por exemplo,

pela(s) CPU(s), pela mais diversos tipos de memória, dispositivos de E/S (impressoras, vídeo,

placas de comunicação), controladores, fios, componentes eletrônicos, conectores etc. e pelo

Software(SW), que pode ser subdividido em aplicativos (comprados e/ou desenvolvidos pelos

usuários) e pelo próprio sistema operacional, normalmente adquirido de um fabricante

especializado.

Considerando-se os tipos de sistemas operacionais descritos anteriormente, reforça-se o conceito

de que multiprogramação é nome dado às técnicas que possibilitam que um sistema

computacional qualquer dotado de uma única CPU seja compartilhado entre os diferentes

processos ativados pelo usuário.

Um sistema operacional eficiente alcança alto rendimento e baixo tempo de retorno. O

rendimento mede a quantidade de trabalbo que um processador pode conduir em um certo

período de tempo. Um dos papeis de um sistema operacional é fornecer serviços a muitas

aplicações. Um sistema operacional eficiente minimiza o tempo gasto oferecendo esses serviços.

Um sistema operacional robusto é tolerante á falhas e confiável - o sistema não falhará devido a

erros isolados de aplicações ou de hardware e, se falhar, ele o fará de forma gradual, minimizando

perda de trabalho e evitando danos ao hardware do sistema. Determinado sistema operacional

fornecerá serviços à cada aplicação, a menos que o hardware venha a falhar.

Um sistema operacional escalável é capaz de usar recursos na medida em que vão sendo

acrescentados ao computador. Se um sistema operacional nao for escalável, rapidamente chegará

a um ponto em que recursos adicionais não serão utilizados totalmente. Um sistema operacional

escalavel pode ajustar imediatamente seu grau de multiprogramação. A escalabilidade é um

atributo particularmente importante dos sistemas multiprocessadores na medida em que são

adicionados mais processadores ao sistema.

33

Idealmente a capacidade de processamento deve crescer proporcionalmente ao número de

processos, embora, na prática, isso nao aconteça. Um sistema operacional extensivel adapta-se

bem às novas tecnologias e fornece capacidades de estender o sistema operacional para executar

tarefas que vão além de seu projeto original.

Um sistema operacional portável é projetado de modo tal que possa operar em muitas

configurações de hardware. A portabilidade de aplicações tambem é importante porque

desenvolver aplicações custa caro - a mesma aplicação deve rodar em uma variedade de

configurações de hardware para reduzir os custos de desenvolvimento. O sistema operacional é

crucial para se obter esse tipo de portabilidade.

Um sistema operacional seguro impede que usuários e software acessem serviços e recursos sem

autorização. A proteção refere-se aos mecanismos que implementam a política de segurança do

sistema.

Um sistema operacional interativo permite que aplicações respondam rapidamente às ações do

usuário ou aos eventos que venham a ocorrer. Um sistema operacional utilizável é aquele que

tem o potencial de atender à uma base significativa de usuários. Esses sistemas operacionais

geralmente fornecem uma interface com o usuario fácil de usar. Sistemas operacionais como o

Linux, Windows XP e MacOS são caracterizados como utilizáveis porque cada um suporta um

grande conjunto de aplicações e fomece as interfaces-padrao com o usuario. Muitos sistemas

operacionais experimentais e acadêmicos não suportam um grande número de aplicações e nem

fornecem interfaces amigáveis com o usuario e, portanto, não são considerados utilizáveis.

34

4.0 Concorrência

Os sistemas monoprogramáveis sub-utilizam os recursos do sistema computacional como um

todo, i.e., a CPU (processador), a utilização da memória principal e todos os periféricos

associados a tal sistema.

Sistema Monoprogramável

x

Sistema Multiprogramável

Ao realizar uma operação qualquer de E/S (I/O) o processo perde o uso da CPU temporáriamente

para retornar, após a operação de E/S ter sido terminada, para o estado em que se encontrava

anteriormente. Observe que nos gráficos acima representados, no sistema monoprogramável,

enquanto uma determinada operação de E/S ocorre, a CPU fica ociosa, ao passo que no sistema

multiprogramável, isso já não ocorre, ou seja, a operação de E/S ocorre em paralelo com a

execução do processo 2.

Há situações em que alguns processos fazem uso mais intensivo da CPU do que de operações de

E/S e, portanto, a utilização da CPU para esses processos torna-se prioritária e essencial – dá-se o

nome de processos polarizados na CPU para tais processos (CPU biased process ou CPU

bounded process), como por exemplo, durante a execução de cálculos matemáticos simulando um

determinado processo físico (simulações financeiras, previsão numérica de tempo etc.).

Por outro lado, há situações em que há uma demanda maior de operações de E/S ao invés de CPU

e, portanto, dá-se o nome de processos polarizados em E/S (I/O biased process ou I/O bounded

process), como por exemplo, durante o processo de desfragmentação de um disco ou de cópia de

arquivos de um disco para outro. Nesses casos, a CPU é utilizada de forma bem menos intensiva,

o que a torna disponível para executar mais processos.

4.1 Interrupções

As interrupções podem ser vistas como intervenções do sistema operacional devido à ocorrência

de algum evento previsto ou imprevisto. Elas podem ocorrer de forma síncrona, i.e., interrupções

que são previstas para ocorrer em intervalos regulares e periódicos, como por exemplo, a

interrupção do relógio do sistema (system clock), que não devem ser confundidas com o relógio

do computador, mostrado abaixo, e que nos informa do dia, mês, ano, hora e minuto.

Já as interrupções assíncronas não tem um tempo certo para ocorrer, podendo ocorrer ou não

durante um determinado período de tempo, como por exemplo, o que ocorre com as chamadas

35

telefônicas oriundas de um telefone fixo ou celular. Elas podem ocorrer ou não ao longo de um

determinado período de tempo e, se ocorrerem, não há como prever quando elas ocorrerão,

quanto tempo durarão e quantas vezes elas acontecerão. Isso confere um caráter aleatório a esses

acontecimentos, sendo portanto chamados de assíncronos.

As interrupções, quando ocorrem, desviam o fluxo de execução anteriormente sendo executado

pela CPU para uma rotina de tratamento da interrupção própria para aquele tipo de interrupção,

sendo necessário para isso que a interrupção traga consigo a informação de quem a gerou. As

interrupções podem ser geradas internamente a um programa, pelo próprio sistema operacional ou

por um evento externo, tal como por exemplo, uma interrupção gerada pelo hardware. Cada

interrupção possui uma rotina de tratamento associada, e a associação entre elas é mantida em

uma estrutura denominada vetor de interrupção.

As interrupções ainda podem ser do tipo internas e externas:

a)Internas: há instruções de máquina que são vistas como sendo interrupções internas, como

por exemplo a instrução INT das CPUs Intel 8080 e 8085. Essas instruções ao serem executadas

pela CPU gera um efeito semelhante à de uma interrupção externa. Uma exceção é um tipo de

interrupção normalmente associada à um erro como por exemplo um estouro de capacidade

(overflow) ou por uma tentativa de divisão por zero.

b)Externas: interrupções externas são aquelas geradas pelo SO ou por algum dispositivo

periférico (HW) pertencente ao sistema computacional, como por exemplo, o término de uma

dterminada operação de E/S em disco ou impressora, ou o clickar de algum dos botões do mouse,

dentre tantos outros exemplos.

Para que uma interrupção possa ser atendida pela CPU, algumas condições essenciais devem

ocorrer, como por exemplo as macro-ações dadas acima (salvamento dos registradores,

identificação da causa da interrupção, processamento do código inerente ao atendimento daquela

interrupção em particular, a restauração dos conteúdos dos registradores anteriormente salvos e o

retorno ao ponto em que a interrupão ocorrreu.

36