Aplicações de

Hadoop em Big Data

Inscrições Abertas

Início das Aulas: 01/04/2016

Dias e horários das aulas:

Quarta-Feira 19h00 às 23h00 Semanal

Sexta-Feira 19h00 às 23h00 Semanal

Carga horária: 136 Horas

Duração: 5 meses

*As informações podem sofrer alterações

Apresentação

As empresas geram a cada dia um volume muito grande de dados. Este volume cresce rapidamente e existe a

necessidade da análise dessa grande massa de dados. O Hadoop e seu ecossistema proporcionam uma forma

rápida e segura para a manipulação de grandes bases de dados estruturados e não estruturados utilizadas em

aplicações de Big Data.

Este curso apresenta como gerar informações de forma rápida e inteligente de Bases de Dados extremamente

grandes.

Objetivo

• Introduzir o conceito de Big Data, apresentando as vantagens, softwares e metodologia para a

análise e extração de informações;

• Extrair rápidas informações de grandes bases de dados utilizadas em problemas de Big Data;

• Apresentar uma visão abrangente da arquitetura e tecnologias de Big Data;

• Introduzir os conceitos de Hadoop;

• Apresentar as vantagens de trabalhar em computação distribuída;

• Apresentar exemplos, aulas práticas e casos de utilização do Hadoop para resolução de problemas

de Big Data.

Diferencial

Este curso é ministrado por professores altamente qualificados e em todas as aulas são utilizados computadores

para a realização de exercícios e aplicações dos conceitos ministrados. Durante o curso são apresentados

exemplos e resolvidos problemas reais de Big Data por meio do Hadoop e seu ecossistema.

Corpo Docente

O corpo docente conta com professores altamente capacitados. Nos critérios de seleção do corpo

docente, são priorizadas as qualificações e experiências profissionais nas distintas matérias, de

maneira que o curso permita não somente a transmissão de conhecimentos, mas também de critérios e

experiências enriquecedoras para os alunos.

Metodologia

Os conceitos são apresentados por meio de aulas teóricas, exercícios de fixação com laboratório e

apresentação de casos reais. São realizados exercícios monitorados por professores.

Perfil do Aluno

Profissionais das áreas: TI, analytics, engenharia de computação, estatísticos, analistas de sistemas,

profissionais do mercado que manipulam e precisam tomar rápidas decisões por meio de grandes

bases de dados.

Programa

Disciplina 1 – Tecnologias para Big Data 1 - 40 horas

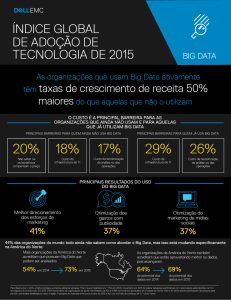

• Introdução ao Big Data

Introdução ao curso;

Definição de Big Data;

5 Vs do Big Data;

Dados estruturados e não estruturados;

Programas e tecnologias para analisar e manipular Big Data.

Análise do mercado de Hadoop;

Vantagens da utilização das técnicas de Big Data;

Organização Apache.

• Computação em nuvem

Conceitos de computação em nuvens (Cloud Computing);

Conceito NIST de Cloud Computing;

Características de Cloud Computing;

Entidades do Ecosistema de Nuvem;

Aspectos de segurança;

O conceito e aplicações de utility computing;

O conceito de Data Center;

Repositório de recursos computacionais;

Amazon Web Services (AWS);

Exemplo de empresas que utilizam Cloud Computing;

O conceito de nuvem pública, nuvem privada, nuvem comunitária, nuvem hibrida;

SaaS: Software-as-a-Service;

PaaS: Platform-as-a-Service;

IaaS: Infrastructure-as-a-Service;

• Fundamentos de programação em JAVA para aplicação em Hadoop

Manipulação de dados;

Visualização de dados;

Aplicações em R;

Disciplina 2 – Tecnologias para Big Data 2 – 48 horas

• Utilização do Hadoop para manipulação de Big Data

Introdução ao Hadoop;

Arquitetura do HDFS;

Estrutura e arquitetura do HDFS;

Manipulação de dados no HDFS;

Estrutura de arquivo distribuído e tolerante a falhas;

Estrutura de sistemas de arquivos distribuído e tolerante a falhas;

Arquitetura do MapReduce;

Programação em MapReduce;

Funções: Map e Reduce;

Administração de um cluster Hadoop;

Exemplos de aplicação do Hadoop.

• Banco de Dados MySQL (preparação para análise de dados em Hive)

Conceitos de Bancos de dados;

SGBD;

Otimização de queries.

• Aplicação de Hive em Big Data

Introdução ao Hive;

Arquitetura e manipulação de dados com Hive;

Hive Metadados (Metastore);

Armazenamento colunar e orientado a linha;

Tabela particionada;

Otimização de query hive.

• Integração e aplicações de R com Hive.

Introdução a integração de R com Hive;

Processamento de dados distribuído de R por meio de queries Hive.

• Aplicação de Yarn em Big Data

Introdução ao Yarn;

Arquitetura do MapReduce 2.0 (MRv2) – YARN;

• Aplicações de Hadoop Zookeeper em Big Data

Funções do Zookeeper;

Gerenciamento de locks;

Gerenciamento de dados;

Computação distribuída e tolerante a falhas;

Disciplina 3 – Tecnologias para Big Data 3 – 48 horas

• Aplicações de Mahaout em Big Data

Introdução ao Mahaout;

Manipulação de dados com Mahaout;

• Banco de Dados NoSQL

Conceito de banco de dados NoSQL;

Manipulação de banco de dados NoSQL;

Arquitetura e aplicações em HBASE;

• Ingestão de dados estruturados no HDFS utilizando Sqoop

Introdução ao Sqoop;

Processo de Import/export de dados com Sqoop;

Otimização de processos de import/export.

• Ingestão de dados semi-estruturados no HDFS utilizando Flume

Introdução a arquitetura do Flume;

Processo de import de dados com Flume;

Processamento streaming (real time) com Flume.

• Ingestão de dados com Kafka

Introdução ao Kafka;

Arquitetura do Kafka;

Aplicações de ingestão de dados estruturados/semi-estruturados com Kafka.

• Distribuições para Big Data

Distribuição Linux/Hadoop para Big Data;

HortonWorks;

Cloudera;

MapR;

• Ingestão de dados com Spark Streaming

Introdução ao Spark Streaming;

Arquitetura e manipulação de dados com Spark Streaming;

Processamento real time com Spark Streaming.

• Ingestão de dados com Storm

Introdução ao Storm;

Arquitetura e manipulação de dados com Storm;

Processamento real time com Storm.

• Aplicações de Spark em Big Data

Introdução ao Spark;

Arquitetura e manipulação de dados com Spark.

• Distribuições Hadoop para Big Data

Distribuições Hadoop para Big Data;

HortonWorks;

Cloudera;

MapR.

Unidade Educacional Vila Olímpia

Rua do Rocio, 109 – CEP 04552-000 – Vila Olímpia - São Paulo/SP

Tel.: (11) 3847-3706 com Jemima