pentaho_

Open Source

Business

Intelligence com

Conheça o ambiente de BI livre mais

utilizado no Brasil e saiba como essa

poderosa ferramenta foi construída sobre

a plataforma Java

Givanildo Santana do Nascimento | [email protected]

é graduado em Sistemas de Informação, especialista em Melhoria de Processos de Software e mestre em Ciência da Computação.

Possui as certificações Certified Function Point Specialist, Sun Certified Java 2 Platform Programmer e Sun Certified Web Component

Developer for J2EE Platform. Trabalha como analista de Sistemas na Petrobras, desenvolvendo soluções de TIC para Exploração e

Produção de Petróleo. É sócio-diretor da empresa MPS Soluções em Tecnologia da Informação, na qual atua como consultor em TI

e conduz um projeto de Bussiness Intelligence para o Poder Judiciário brasileiro. É membro da equipe técnica da Revista MundoJ,

escrevendo e revisando artigos e cobrindo eventos de tecnologia no Brasil e no exterior.

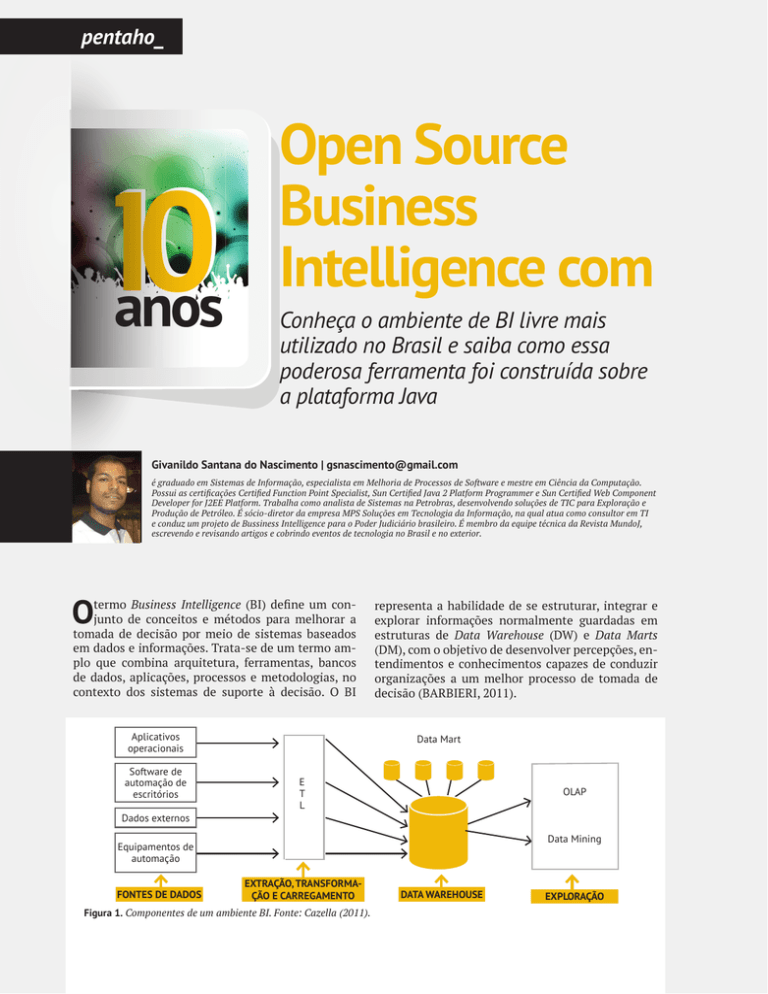

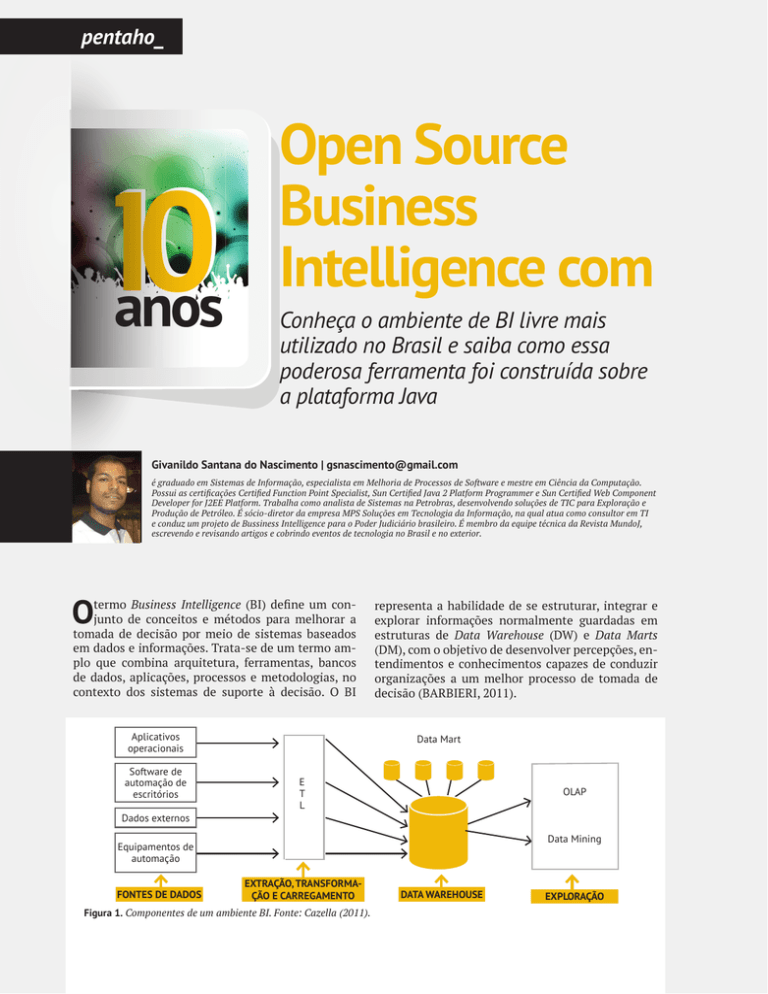

O

termo Business Intelligence (BI) define um conjunto de conceitos e métodos para melhorar a

tomada de decisão por meio de sistemas baseados

em dados e informações. Trata-se de um termo amplo que combina arquitetura, ferramentas, bancos

de dados, aplicações, processos e metodologias, no

contexto dos sistemas de suporte à decisão. O BI

Aplicativos

operacionais

Software de

automação de

escritórios

representa a habilidade de se estruturar, integrar e

explorar informações normalmente guardadas em

estruturas de Data Warehouse (DW) e Data Marts

(DM), com o objetivo de desenvolver percepções, entendimentos e conhecimentos capazes de conduzir

organizações a um melhor processo de tomada de

decisão (BARBIERI, 2011).

Data Mart

E

T

L

OLAP

Dados externos

Data Mining

Equipamentos de

automação

FONTES DE DADOS

EXTRAÇÃO, TRANSFORMAÇÃO E CARREGAMENTO

Figura 1. Componentes de um ambiente BI. Fonte: Cazella (2011).

/ 20

DATA WAREHOUSE

EXPLORAÇÃO

Java

e Pentaho BI Suite

Community Edition

A maioria das ferramentas e aplicações de Business Intelligence são

tidas como custosas e complexas. De fato, integrar um grande volume de dados e deles extrair informações que suportem a tomada de

decisões não é uma tarefa simples. Porém muitos projetos de BI não

dispõem de orçamentos capazes de patrocinar a aquisição de ferramentas comerciais com custos expressos em quatro ou mais dígitos,

em dólares. Esses custos elevados impediriam o início de muitos projetos executados por empresas de pequeno e médio porte. Por outro

lado, os recursos de integração de dados e análise de informações

oferecidos pelas ferramentas comerciais são muito importantes no

desenvolvimento de aplicações de BI profissionais. A solução desse

problema técnico-econômico pode ser encontrada nas ferramentas

livres de BI. Este artigo apresenta o Pentaho BI Suite Community

Edition, a ferramenta de BI livre mais utilizada no Brasil, desenvolvida sobre a plataforma Java.

O ambiente de BI, ilustrado na figura 1, é composto pelas fontes de dados operacionais, pelos processos de Extração, Transformação e Carregamento

(ETL), pelo DW, DM e pelos métodos de exploração.

Os dados operacionais são carregados nas bases DW

e DM por processos ETL. Durante a carga, os processos ETL também realizam operações de limpeza,

preenchimento e correção nos dados. Após serem

carregados no DW, os dados preenchem os DM modelados de forma dimensional, orientados a assuntos ou processos de negócio. O DW e os DM são então explorados pelo usuário utilizando ferramentas

de processamento analítico OLAP e técnicas de mineração de dados (CAZELLA, 2011).

O número de projetos de BI cresceu rapidamente

em todo o mundo, de acordo com os relatórios anuais

do Gartner Group. A tabela 1 mostra que o BI integra

a lista das dez maiores prioridades em Tecnologia da

Informação (TI) desde 2005 e esteve no topo dessa

lista por quatro anos consecutivos, de 2006 a 2009.

De uma forma mais ampla, as empresas priorizaram

a melhoria dos processos de negócios, entendendo

que as informações e o conhecimento fornecidos pelas aplicações de BI são elementos essenciais para

o aumento da eficiência e da efetividade, suporte à

competitividade e à inovação. Assim, investimentos em aplicações de BI focadas em mineração de

dados aumentaram 4,8% de 2005 para 2006 e 11,2%

de 2007 para 2008 (GARTNER GROUP, 2005a, 2005b,

2006, 2007, 2008, 2009, 2010, 2011).

21 \

NEW ANALYSIS VIEW

NEW REPORT

MANAGE CONTENT

NEW DATA SOURCE

Figura 2. Componentes do Pentaho integrados. Fonte: http://community.pentaho.com/.

Tabela 1. Prioridade das aplicações de BI de 2005 a 2011. aplicação desenvolvida não atenderia aos recursos de

ANO

PRIORIDADE MELHORAR

PROCESSOS DE

NEGÓCIO

PRIORIDADE

BI

2005

1ª

2ª

2006

1ª

1ª

2007

1ª

1ª

2008

1ª

1ª

2009

1ª

1ª

2010

1ª

5ª

5ª

5ª

2011

Fonte: Gartner Group (2005b, 2006, 2007, 2008, 2009, 2010, 2011).

Contudo, o agravamento da crise financeira internacional provocou cortes significativos nos orçamentos de TI a partir de 2009. Isto fez com que o

BI deixasse de ocupar o primeiro lugar na lista das

maiores prioridades em TI e, em 2010 e 2011, caísse

para a quinta posição. Em seu lugar, foram priorizadas tecnologias de maior produtividade, menor risco

e retorno de investimento mais rápido (GARTNER

GROUP, 2005a, 2005b, 2006, 2007, 2008, 2009, 2010,

2011).

Nesse contexto, as ferramentas Open Source Business Intelligence (OSBI) desempenham um papel

essencial para a viabilização de muitos projetos de

BI que não dispõem de dezenas ou centenas de milhares de dólares para investirem em ferramentas

comerciais já em seu início. Os recursos poupados

podem ser investimentos em hardware, treinamento

e serviços de desenvolvimento. Porém não é possível abrir mão da qualidade, da funcionalidade, da riqueza de recursos e da produtividade conferida pelas

ferramentas tradicionais de BI. Sem esses atributos, a

/ 22

informação e usabilidade do cliente.

O Pentaho é uma plataforma de BI livre desenvolvida em Java e mantida pela empresa Pentaho

Corporation, com o apoio de uma comunidade crescente de desenvolvedores no Brasil e em todo o mundo. Os componentes do Pentaho contemplam ferramentas de integração de dados (ETL) e metadados,

relatórios, dashboards, análises OLAP, gestão de conteúdo e mineração de dados. A figura 2 mostra como

esses componentes são combinados em um ambiente

orientado à analise de dados e informações. Ao integrar esses componentes, a plataforma Pentaho possibilita o desenvolvimento de soluções complexas para

problemas de negócios que demandam o processamento de grandes volumes de dados.

O Pentaho é distribuído em três edições diferentes: Community Professional e Enterprise. A edição

Community, está disponível gratuitamente no site

http://community.pentaho.com/. As edições Professional e Enterprise possuem recursos adicionais e

planos de suporte prestados pela Pentaho Corporation e seus parceiros, mas são licenciadas mediante

subscrição anual. Os recursos adicionais das edições

pagas incluem suporte a Mobile e ferramentas avançadas de integração de dados e relatórios.

Este artigo tem o objetivo de apresentar uma visão geral do ambiente Pentaho BI Suite Community

Edition, descrevendo os seus principais componentes. Antes de descrever o ambiente Pentaho serão

apresentadas as técnicas fundamentais de Data Warehousing, as diferenças entre aplicações transacionais e analíticas e os fundamentos da mineração de

dados. O entendimento dessas técnicas é essencial

para o aprendizado pleno do Pentaho BI Suíte.

OPERACIONAL

DATA WAREHOUSE

ACESSAR

INCLUIR

EXCLUIR

EXCLUIR

CARREGAR

INCLUIR

ACESSAR

ALTERAR

Carregamento e acesso a

grandes quantidades de dados

Tratamento de dados registro

por registro

Figura 4. Operações sobre os dados no OLTP e no OLAP. Fonte: Cazella (2011).

Data Warehousing

Os Sistemas de Online Transaction Processing

(OLTP) suportam a execução dos processos de negócio, coletam e armazenam os dados em bancos de dados estruturados, na maior parte dos casos, de acordo

com a modelagem relacional normalizada. Estruturas

de dados relacionais normalizadas são eficientes para

a atualização e o armazenamento de dados, entre

outros motivos, por minimizarem redundâncias. No

entanto, na medida em que o volume de dados armazenados aumenta, a eficiência para a realização de

processamento analítico diminui, pois é necessário

obter as informações desejadas em múltiplas tabelas, frequentemente localizadas em bancos de dados

distintos. As alternativas existentes para se melhorar

o desempenho da execução de consultas em bases

OLTP, como criação de índices e desnormalização de

banco de dados, terminam por prejudicar o desempenho da atualização de dados (NASCIMENTO, 2012).

Já os Sistemas OLAP normalmente acessam dados

em estruturas informacionais como o DW, tendo como

principais propriedades:

1. orientação a assuntos ou processos de negócio;

2. integração;

3. não volatilidade;

4. variação no tempo e

5. suporte à decisão.

A integração de dados é considerada a característica mais importante do DW. Esta característica

garante a unicidade na representação dos dados que

passam do ambiente operacional para o DW. Os dados que populam o DW são originários de diversos

sistemas operacionais, documentos semi-estruturados e fontes de dados externas. Cada um desses ambientes apresenta características específicas, como,

por exemplo, tipos e domínios de dados, unidades de

medidas e convenções internas. Um exemplo clássico

é a notação para o gênero (masculino ou feminino);

nos sistemas operacionais, o gênero pode ser representado por valores como “M” ou “F”, “m” ou “f”, “1”

ou “2”. No DW esses valores precisam ser integrados

em domínio único, por isso durante o processo de integração eles são convertidos para um estado uniforme, como ilustra a figura 3.

AMBIENTE OPERACIONAL

DATA WAREHOUSE

Aplicação A–M,F

Aplicação B–H,M

Aplicação C–0,1

M,F

Figura 3. Integração de dados de gênero no DW.

Em geral, a passagem de dados das bases operacionais para o DW não é tão simples quanto uma

mera extração e carga de registros. Muitas vezes é

necessário realizar transformações, conversões, integração e consolidação de dados. Os processos ETL são

responsáveis pela realização dessas tarefas.

As operações realizadas nos bancos de dados

operacionais incluem inserção, atualização, exclusão

e consulta, geralmente de um registro por vez. Já no

DW, são realizadas operações de carga e acesso aos

dados em grandes lotes, como mostra a figura 4.

A granularidade é o nível de detalhamento dos

dados no DW. Quanto maior for o nível de detalhes

que se deseja armazenar, menor será a granularidade.

O nível de granularidade afeta diretamente o volume

de dados armazenados e o tipo de informações que

poderão ser obtidas nas consultas. Quando se tem um

nível de granularidade muito alto, há uma economia

de espaço de armazenamento, mas também há uma

limitação quanto à utilização dos dados para atender

a consultas mais detalhadas. Quando se tem um nível

de granularidade muito baixo, há uma maior disponibilidade de dados para as operações de consulta, em

23 \

Data Mart

Data Mart

COMPRAS

VENDAS

Data Mart

ESTOQUE

DATA WAREHOUSE

Figura 5. Relação entre os Data Marts e o Data Warehouse corporativo.

Um exemplo de modelo dimensional do DM Vendas é apresentado na figura 7. A tabela-fato representa as vendas de produtos. As dimensões representam

o cliente que comprou os produtos (Quem), os produtos vendidos (O Quê), a data da venda (Quando) e o

armazém é o local onde os produtos foram vendidos

(Onde). As medidas são o valor e a quantidade de unidades vendidas.

A modelagem dimensional se contrapõe à modelagem normalizada, pois utiliza a redundância dos

dados como forma de facilitar e acelerar a recuperação de informações.

Mineração de dados

A Descoberta de Conhecimento em Bases de Dadetrimento de uma maior necessidade de espaço de dos (DCBD) é o processo de busca e extração de coarmazenamento e recursos computacionais para pro- nhecimento em bases de dados. Fayyad et al. (1996)

cessamento.

definiram DCBD como o processo não trivial de identificação de padrões válidos e potencialmente úteis,

Data Marts

perceptíveis a partir dos dados. Nesta concepção, a

Na visão de Kimball e Ross (2002) um Data Mart DCBD refere-se a todo processo de extração de coconstitui-se em um subconjunto lógico de um DW nhecimento útil oculto em bancos de dados. O cocorporativo. Um DM também pode ser considerado nhecimento a ser descoberto deve satisfazer a três

um repositório de dados relacionados a um proces- propriedades: deve ser correto (tan­to quanto possíso de negócio ou a um elemento da cadeia de valor vel); compreensível por usuários humanos e também

organizacional, geralmente modelado de forma di- deve ser interessante, útil ou novo. Além disso, o mémensional (BOUMAN e DONGEN, 2009). A figura 5 todo de descoberta do conhecimento deve apresenilustra três Data Marts relacionados aos processos de tar três características: deve ser eficiente (acura­do),

Vendas, Compras e Estoque, extraídos de um DW cor- genérico (aplicável a vários tipos de dados) e flexível

porativo central.

(facilmente modificável).

A modelagem dimensional é uma forma de moJá a Mineração de Dados (MD) é a busca por redelagem de dados em termos de fatos, dimensões e lacionamentos e padrões distintos que existem, mas

medidas, visando oferecer maior suporte à análise. A que estão ocultos em grandes volumes de dados. Até

figura 6 apresenta o esquema de um modelo dimen- 1995, muitos autores conside­ravam os termos DCBD e

sional composto por um fato e quatro dimensões. Os MD como sinônimos, mas a DCBD é mais abrangente

fatos representam eventos ou transações do negócio, do que a MD. A MD é o processo de pesquisa em grancomo pedidos, compras, vendas, entre outros exem- des volumes de dados para extração de conhecimenplos. Dimensões são entidades envolvidas nos fatos, to utilizando técnicas de Estatística, Probabilidade e

descrevendo: o quê, quem, onde e quando um fato Inteligência Computacional, para procurar relações

aconteceu. Uma medida é um atributo ou variável de similaridade ou discordância entre dados, com o

numérica acerca de um fato que expressa grandezas objetivo de encontrar padrões, irregularidades e recomo quantidade, valor e custo (KIMBALL e ROSS, gras. Seu intuito é transformar dados aparentemente

2002).

desprovidos de conexão em informações relevantes

para a tomada de decisão e avaliação de resultados.

O QUÊ

A principal motivação para a utilização de MD é

a grande disponibilidade de dados armazenados eletronicamente, com informações úteis, porém ocultas,

podendo auxiliar na previsão de um conhecimento

QUEM

ONDE

FATO

futuro. Em outras palavras, a MD é utilizada para se

descobrir informações sem uma prévia formulação de

hipóteses e buscar por algo não intuitivo, tornando

dados inexpressivos em conhecimento valioso e estratégico.

QUANDO

Existem diversos métodos de MD para encontrar

respostas ou extrair conhecimento em repositórios

Figura 6. Esquema estrela com um fato e suas dimensões.

de dados, sendo os mais importantes para a DCBD:

/ 24

Dimensão tempo

Id_tempo (PK)

dara_SQL

dia_da_semana

numero_semana

mes

etc.

»»

»»

»»

»»

Tabela fato

Id_tempo (PK)

Id_produto (FK)

Id_armazem(FK)

Id_cliente (FK)

venda_dolar

unidades_vendidas

custo_dolar

Dimensão cliente

Id_cliente (PK)

nome_cliente

perfil_cliente

endereço

etc.

Descreve as características da dimensão

Chave primária simples

Atributos textuais e discretos

Fontes de restrições às consultas

»»

»»

»»

»»

Grande quantidade de dados

Chave primária composta pelas FKs

Atributos numéricos e valores

Contém as medições do negócio

Dimensão produto

Id_produto (PK)

codigo

descricao

marca

categoria

etc.

Dimensão armazém

Id_armazem (PK)

nome_armazem

endereço

distrito

etc.

Figura 7. Modelo dimensional do DM Vendas. Fonte: Cazella (2011).

Classificação, Modelos de Relacionamento entre Variáveis, Análise de Agrupamento, Sumarização, Modelo de Dependência, Regras de Associação e Análise

de Séries Temporais (FAYYAD et al., 1996).

As técnicas de Mineração de Dados desempenham as tarefas de classificação ou agrupamento dos

dados e de descoberta de regras de associação entre

os dados. Entre os métodos de Mineração de Dados

capazes de fazer o re­conhecimento de padrões destacam-se as árvores de decisão, as máquinas de vetores

de suporte, os métodos estatísticos, as redes neurais,

os algoritmos genéticos e as meta-heurísticas de uma

forma geral. Estas técnicas vêm sendo amplamente

exploradas na literatura e são atualmente suportadas

por ferramentas que disponibilizam os diversos algoritmos já implementados, testados e otimizados, para

uso em uma série de aplicações.

Tanto o BI quanto a DCBD têm como finalidade

transformar dados em informações e conhecimento,

visando dar suporte à tomada de decisão. Para isso,

utilizam-se de técnicas como DW e DM para preparação dos dados, para permitir que o usuário explore os

dados por meio de ferramentas de análise e realizam

MD para reconhecer padrões e regras por meio da Inteligência Computacional. A disponibilidade de um

DW ajuda no processo de DCBD porque: (1) os dados

são submetidos a limpeza antes de serem carregados

no DW e (2) o acesso aos dados no DW é muito mais

eficiente devido à forma como eles são estruturados.

Desta forma, uma tabela-fato de um DM dimensional

tem condições favoráveis à DCBD, pois armazena dados limpos, íntegros e de acesso facilitado. A tabela-fato representa uma matriz multidimensional na

qual todas as variáveis que serão submetidas à MD

encontram-se presentes.

Pentaho BI Suite Community Edition

O ambiente Pentaho BI Suite integra as principais ferramentas, tecnologias e disciplinas do BI. O

alicerce de toda a suíte é a Plataforma Java Standard

Edition. Desta forma, o Pentaho roda sobre a máquina virtual Java, portanto se beneficia de todas as

vantagens conferidas pelo Java, como portabilidade

(write once, run anywhere), extensibilidade e robustez. É possível integrar o Pentaho a outras aplicações

Java, executando processos ETL, acionando relatórios

e dashboards diretamente a partir de outras aplicações. Por exemplo, a Listagem 1 apresenta o código

Java para execução de uma transformação de dados

desenvolvida no Pentaho Data Integration.

Listagem 1. Código Java para execução de uma transformação de dados desenvolvida no Pentaho Data

Integration.

public static void runTransformation(String filename) {

try {

StepLoader.init();

EnvUtil.environmentInit();

TransMeta transMeta = new TransMeta(filename);

Trans trans = new Trans(transMeta);

}

trans.execute(null); // É possível passar parâmetros

// para a transformação ao invés de null.

trans.waitUntilFinished();

if ( trans.getErrors() > 0 ) {

throw new RuntimeException( “Ocorreram erros

na execução da transformação.” );

}

} catch ( KettleException e ) {

// TODO Tratar exceção.

System.out.println(e);

}

25 \

Figura 8. Componentes do ambiente em uma visão de camadas.

A figura 8 apresenta os componentes do ambiente

em uma visão de camadas. A camada de integração

de dados e aplicações oferece ferramentas ETL, gestão de metadados e de integração entre aplicações.

A camada de Business Intelligence Plataform oferece

os recursos de segurança, administração, lógica de

negócios e gestão de repositórios. Sobre essa camada

rodam os serviços de relatórios construídos em tempo de projeto, relatórios e análises ad-hoc criadas

pelo próprio usuário de acordo com as suas necessidades de informação, análises (OLAP), mineração de

dados, dashboards e gestão de processos. Esses serviços são expostos ao usuário final por uma camada

de apresentação que suporta os navegadores Web,

portais, suítes de escritórios, Web services e e-mail.

Portanto o ambiente Pentaho compreende todos os

principais recursos esperados de um ambiente de BI

profissional.

O primeiro passo para a utilização do Pentaho é

baixar os seus componentes a partir do site http://

community.pentaho.com/. Como acontece com muitas ferramentas gratuitas, o caminho entre o download da ferramenta e o seu funcionamento pleno requer

leituras de sites e fóruns especializados como o Planeta Pentaho (ver referências). Este artigo não tem a

proposta de ser um tutorial detalhado sobre a configuração do Pentaho, mas uma referência de alto nível

sobre os seus componentes.

A suíte Pentaho surgiu a partir da integração de

diversos projetos open-source em um ambiente ra/ 26

zoavelmente integrado. O Pentaho Reporting foi desenvolvido

a partir do JfreeReport; o Pentaho Analysis engine a partir

do Mondrian; o Pentaho Analysis client teve o projeto jPivot

como ponto de partida; Pentaho

Data Integration é o nome dado

à incorporação do Kettle à suíte

Pentaho; o Weka deu origem ao

Pentaho Data Mining; entre outros exemplos. Por isso, a política de licenciamento do Pentaho

é complexa e confusa, composta

por uma miríade de licenças,

sendo umas pouco permissivas

e outras mais liberais. Entre as

principais licenças da suíte pode-se destacar:

»» Eclipse Public License Version 1.0 (EPLv1)

»» Mozilla Public License 1.1

(MPLv1.1)

»» GNU General Public License Version 2 (GPLv2)

»» GNU Lesser General Public License Version 2.1

(LGPLv2.1)

»» Eclipse Public License Version 1.0 (EPLv1)

»» Apache License, Version 2.0

»» GNU General Public License Version 3 (GPLv3)

De forma geral, a política de licenciamento permite a utilização do Pentaho Community Edition

para o desenvolvimento e execução de aplicações da

mesma forma como se desenvolvem aplicações utilizando Eclipse, Tomcat, Hibernate e JFreeReport. Porém se qualquer alteração for feita nos componentes

da suíte, a aplicação desenvolvida passa a estar sujeita às mesmas regras de licenciamento do componente original, muitas vezes levando à necessidade de

abertura do código-fonte. Mais informações sobre as

licenças podem ser encontradas nos links disponíveis

nas referências deste artigo.

Pentaho BI Platform and Server

O Pentaho BI Platform Community Edition é

composto principalmente por duas aplicações Web, a

Pentaho Administration Console (PAC) e a Pentaho

User Console (PUC). A PAC é a interface para o gerenciamento do status do servidor Pentaho, dos usuários

e perfis de acesso às aplicações. A PAC também permite a configuração de Data Sources e o agendamento de serviços de integração de dados e relatórios. Essas funcionalidades da PAC estão ilustradas na figura

9. Em sua distribuição padrão, a PAC é uma aplicação

Web empacotada como um WAR e publicada em um

container Web Jetty.

Figura 9. Pentaho Administration Console (PAC).

Já a PUC é a interface por meio da qual o usuário

tem acesso às aplicações de BI publicadas no servidor

Pentaho. A figura 10 apresenta a tela inicial do PUC.

Após a autenticação do usuário, a PUC apresenta as

aplicações de BI, análises OLAP e dashboards para

os quais lhe foram autorizados os acessos. A figura

11 apresenta a PUC exibindo um conjunto de análises OLAP disponíveis para o usuário e uma janela de

boas-vindas.

ção, Transformação e Carga (ETL). O PDI admite uma

grande variedade de fontes de dados, oferece muitas

possibilidades de transformação, validação e saídas

para os dados transformados. A figura 12 ilustra um

processo ETL para uma tabela de produtos. Os dados

são extraídos de uma tabela de produtos e inseridos

no fluxo, no qual passam por cálculos, adição de outras informações, até serem inseridos ou atualizados na tabela de destino. Como se pode observar, o

processo é gráfico e bastante intuitivo. Os recursos

oferecidos gratuitamente pelo PDI são compatíveis

com os das ferramentas ETL comerciais disponíveis

no mercado.

O PDI foi desenvolvido sobre a plataforma Eclipse. Ele oferece as perspectivas Data Integration,

Model e Visualize (ver figura 12). Todo o desenvolvimento ETL é feito na perspectiva Data Integration.

As perspectivas Model e Visualize são destinadas ao

desenvolvimento na abordagem Agile BI. Esta abordagem permite que uma transformação ETL seja

o ponto de partida para a construção de um Cubo

OLAP, o Model, e a visualização das análises OLAP

diretamente no PDI (Visualize). O Pentaho Agile BI

permite o desenvolvimento BI de uma forma muito

flexível, indo do dado bruto à informação agregada

com muita rapidez.

Figura 10. Pentaho User Console (PUC).

Figura 12. Pentaho Data Integration (PDI), também conhecido

como Kettle.

Pentaho Analysis Services (Mondrian)

O Mondrian é o servidor OLAP que permite aos

usuários do Pentaho analisarem grandes volumes de

informações. Ele oferece recursos de exploração de

dados tradicionais em OLAP como drill, slice e dice.

Na edição Community, a interface com o usuário é

provida pelos plugins JPivot e Saiku Analytics. As edições Professional e Enterprise possuem também um

plugin proprietário que oferece uma experiência com

Figura 11. Aplicações e arquivos apresentados na PUC.

o usuário final superior à do JPivot e do Saiku, comparável à usabilidade encontrada nas ferramentas

Pentaho Data Integration (Kettle)

comerciais líderes de mercado. A figura 13 apresenta

O Pentaho Data Integration (PDI), também co- uma janela de análise de lucros por país, utilizando

nhecido como Kettle, é uma ferramenta de integra- os recursos disponíveis nas versões comerciais do

ção de dados para construção de processos de Extra- Pentaho.

27 \

Figura 13. Pentaho Analysis Services (Mondrian).

Pentaho Reporting

O Pentaho Reporting Community Edition inclui

o Pentaho Report Designer (figura 14), o Pentaho Report Engine e o Pentaho Reporting SDK. Trata-se de

um ambiente completo para a construção de relatórios desenvolvido sobre o JFreeReport. Esse ambiente

suporta diversas fontes de dados e exporta os relatórios para PDF, Excel, HTML, texto, texto formatado,

XML e csv. O funcionamento do Pentaho Report Designer é parecido com o da maioria das ferramentas

de construção de relatórios. Existem bandas específicas para as áreas de cabeçalho, corpo e rodapé dos

relatórios. O que chama a atenção é a fidelidade com

a qual os dados são exportados para os diversos formatos. Um relatório apresentado em HTML pode ser

visto em Excel ou PDF com a mesma formatação.

Figura 15. Exemplo de dashboard interativo criado no Community

Dashboard Framework (CDF).

Pentaho Data Mining (Weka)

O Pentaho Data Mining corresponde à ferramenta a Waikato Environment for Knowledge Analysis

(Weka). O Weka oferece uma série de algoritmos clássicos de mineração de dados implementados e disponíveis para realização de análises avançadas nos dados. A figura 16 apresenta regras de associação entre

os dados reconhecidas por meio do algoritmo Apriori.

A figura 17 ilustra em um gráfico 3D as mesmas regras

de associação reconhecidas pelo algoritmo Apriori.

Figura 16. Regras de associação entre os dados reconhecidas por

meio do algoritmo Apriori.

Figura 14. Pentaho Report Designer.

Community Dashboard Framework

Um requisito muito comum em aplicações de BI

é a construção de painéis gerenciais (ou dashboards).

Para essa finalidade, o Pentaho utiliza do Community

Dashboard Framework (CDF). A figura 15 apresenta

um exemplo de dashboard interativo criado no CDF. Figura 17. Regras de associação exibidas em um gráfico 3D.

/ 28

Considerações Finais

Este artigo apresentou uma visão geral do ambiente Pentaho BI Suite Community Edition, descrevendo os seus principais componentes. Também

foram apresentados conceitos fundamentais de Data

Warehousing, OLTP, OLAP e mineração de dados.

Em tempos de crise financeira internacional,

muitos projetos de BI, especialmente os executados

por empresas de pequeno e médio porte, não dispõem de orçamentos capazes de patrocinar a aquisi-

ção de ferramentas comerciais com custos elevados.

Por outro lado, os recursos de integração de dados e

análise de informações oferecidos pelas ferramentas

comerciais são muito importantes no desenvolvimento de aplicações de BI profissionais. O Pentaho

BI Suite Community Edition apresenta-se como uma

solução econômica e eficiente para esse problema. A

comunidade Pentaho no Brasil é muito forte e existem casos de sucesso muito significativos de aplicações profissionais desenvolvidas no Pentaho.

/referências

> BARBIERI, C. BI2 - Business Intelligence: modelagem e

qualidade. Rio de Janeiro: Campus, 2011.

> BOUMAN, R.; DONGEN, J. Pentaho Solutions: Business

Intelligence and Data Warehousing with Pentaho and

MySQL. Wiley Publishing. Indianapolis. 2009.

> CAZELLA, S. C. Tecnologias para Inteligência

Competitiva. 1. ed. São Leopoldo: Editora Unisinos. 2011.

> FAYYAD, U.; PIATETSKY-SHAPIRO, G.; SMYTH, P.;

UTHURUSAMY, R. Advances in Knowledge Discovery and

Data Mining. 1996. AAAIPress, The Mit Press.

> ______. Gartner EXP Worldwide Survey of Nearly 1,600

CIOs Shows IT Budgets in 2010 to be at 2005 Levels.

2010. Disponível em http://www.gartner.com/it/page.

jsp?id=1283413. Acesso em 01 out. 2011.

_> _____. Gartner Executive Programs Worldwide Survey of

More Than 2,000 CIOs Identifies Cloud Computing as Top

Technology Priority for CIOs in 2011. 2011. Disponível em

> GARTNER GROUP. Gartner says more than 50 percent

http://www.gartner.com/it/page.jsp?id=1526414. Acesso

of data warehouse projects will have limited acceptance or

em 01 out. 2011.

will be failures through 2007. 2005a. Disponível em http://

www.gartner.com/press_releases/asset_121817_11.html.

Acesso em 01 out. 2011.

> ______. Gartner Survey of 1,300 CIOs Shows IT Budgets

to Increase by 2.5 Percent in 2005. 2005b. Disponível em

http://www.gartner.com/press_releases/asset_117739_11.

html. Acesso em 01 out. 2011.

> ______. Gartner Survey of 1,400 CIOs Shows

Transformation of IT Organisation is Accelerating. 2006.

Disponível em http://www.gartner.com/press_releases/

asset_143678_11.html. Acesso em 01 out. 2011.

> ______. Gartner EXP Survey of More than 1,400 CIOs

> KIMBALL, R.; ROSS, M. Data warehouse toolkit: o guia

completo para modelagem dimensional. Rio de Janeiro:

Campus, 2002. 494p.

> NASCIMENTO, GIVANILDO SANTANA. AgileKDD: um

processo ágil para a engenharia de sistemas de descoberta

do conhecimento. Dissertação (Mestrado em Ciência da

Computação) - Universidade Federal de Sergipe, 2012.

> Pentaho Analysis Services (Mondrian) - http://

mondrian.pentaho.com/

> Pentaho BI Platform License FAQ - http://community.

pentaho.com/faq/platform_licensing.php

Shows CIOs Must Create Leverage to Remain Relevant to

> Pentaho BI Suite Community Edition - http://

the Business. 2007. Disponível em http://www.gartner.com/

community.pentaho.com/

it/page.jsp?id=501189. Acesso em 01 out. 2011.

> Pentaho Data Integration (Kettle) - http://kettle.

> ______. Gartner EXP Worldwide Survey of 1,500 CIOs

pentaho.com/

Shows 85 Percent of CIOs Expect “Significant Change” Over

> Pentaho Data Mining (Weka) - http://weka.pentaho.

Next Three Years. 2008. Disponível em http://www.gartner.

com/it/page.jsp?id=587309. Acesso em 01 out. 2011.

> ______. Gartner EXP Worldwide Survey of More than

1,500 CIOs Shows IT Spending to Be Flat in 2009.

com/

> Pentaho Open Source Projects Licenses - http://www.

pentaho.com/license/

2009. Disponível em http://www.gartner.com/it/page.

> Pentaho Reporting - http://reporting.pentaho.com/

jsp?id=855612. Acesso em 01 out. 2011.

> Planeta Pentaho - http://planetapentaho.com.br/

29 \