CitationFinder: Um Sistema Baseado em Conhecimento para

Classificação de Páginas de Publicações na Web

Mariana Lara Neves, Flávia de Almeida Barros

Centro de Informática - Universidade Federal de Pernambuco

Caixa Postal 7851 – 50.732-970 - Recife - PE - Brazil

{mln, fab}@cin.ufpe.br

http://www.cin.ufpe.br/{~mln, ~fab}

Abstract. This regularity allows the automatic identification of such pages by

computational systems based on domain knowledge. The work presented here

describes the CitationFinder, a knowledge-based system for the automatic

classification of Web pages which contain citations of technical and scientific

publications. The systems counts on a knowledge base of production rules with

associated certainty factors, to improve the system's precision. This knowledge

base was constructed by analyzing a corpus of 1.000 pages. The system's

performance was very satisfactory: 88,6% precision and 97% recall for a test

corpus of 300 pages.

Resumo. Este trabalho descreve um sistema baseado em conhecimento para a

classificação automática de páginas Web contendo citações de publicações

técnicas e científicas, o CitationFinder. O sistema conta com uma base de

regras de produção com fatores de certeza associados, a fim de melhorar a

precisão dos resultados. Esta base foi construída a partir da análise de um

corpus de 1.000 páginas Web. O desempenho do sistema foi bastante

satisfatório: 88,6% de precisão e 97% de cobertura para um corpus de teste

de 300 páginas.

1. Introdução

O aumento vertiginoso, nas últimas duas décadas, da quantidade de repositórios de

documentos digitalizados, tais como bibliotecas digitais, Intranets e a Internet, facilitou

imensamente o rápido acesso a informações atualizadas sobre os mais diversos assuntos.

Contudo, este crescimento descontrolado e desordenado trouxe problemas inexistentes

nos antigos sistemas para armazenamento e recuperação de informação. Uma

dificuldade séria a se enfrentar é a localização de documentos relevantes na Internet (em

especial, na World Wide Web). Como sabemos, a precisão dos sistemas de busca

existentes (e.g., Radix , Altavista ) não é muito boa, levando o usuário, algumas vezes, a

perder horas para localizar documentos de seu interesse.

Para facilitar as buscas, uma solução seria a adoção de hierarquias de classes, de

forma que os documentos indexados pelos engenhos de busca estivessem associados a

uma ou mais classes pré-fixadas, como é o caso das bibliotecas digitais. Até o momento,

contudo, tal solução não se mostrou viável, devido a [Barros et al. 1998]: imensa

quantidade de assuntos presentes nas páginas Web; dificuldade em se identificar

automaticamente a(s) classe(s) de cada documento, falta de uma hierarquia geral de

consenso.

Contudo, é possível a identificação de classes (domínios) de documentos na

Web que exibem alguma regularidade no formato e no conteúdo apresentados,

possibilitando, ainda que árdua, a tarefa de classificá-los automaticamente. Exemplos

desses domínios são: páginas de hotéis, de restaurantes, de universidades, de chamadas

de conferências, de produção científica, entre outras.

Este trabalho apresenta um sistema para a classificação automática de páginas

Web contendo citações de publicações técnicas e científicas, o CitationFinder [Neves

2001]. Páginas recuperadas a partir de consultas a engenhos de busca existentes na Web

são classificadas e armazenadas em um banco de dados, ficando disponíveis para acesso

via Web. A escolha deste domínio deveu-se, principalmente, a três fatores: (1) existe

uma grande quantidade desse tipo de página na Web, o que demonstra o interesse dos

usuários pelo tópico; (2) essas páginas exibem alguma regularidade no seu formato de

apresentação dos dados, o que possibilita o seu reconhecimento automático.

O sistema foi implementado como um plug-in para engenhos de busca, a fim de

não duplicar esforços na indexação dos documentos disponíveis na Web. O classificador

foi construído com base em técnicas da Inteligência Artificial Simbólica, contando com

uma base de regras de produção com fatores de certeza associados, a fim de melhorar a

precisão dos resultados. A base de conhecimento foi construída a partir de um corpus de

1000 documentos coletados e etiquetados manualmente.

O sistema construído possui diversas vantagens, como a portabilidade,

modularidade, extensibilidade (reusabilidade) e facilidade de uso. O protótipo foi

implementado em Java e a base de regras é executada pela máquina de inferência

JEOPS [Figueira Filho & Ramalho 2000], implementada também em Java. O

CitationFinder apresentou resultados muito satisfatórios: 88,6% de precisão e 97% de

cobertura. De moda a melhor avaliar os resultados, foram realizados experimentos

comparativos com três algoritmos de aprendizagem de máquina (Árvores de Decisão,

Regras de Indução e Naive Bayes).Os resultados obtidos com estes algoritmos foram

equivalentes ou inferiores às taxas obtidas com o CitationFinder, o que comprova a

eficiência da abordagem adotada.

A próxima seção descreve alguns trabalhos relacionados, seguida da seção 3 que

apresenta, de forma sucinta, o estado da arte em classificação automática de texto. A

seção 4 apresenta o sistema CitationFinder, seguida da seção 5, com detalhes de

implementação do protótipo. A seção 6 mostra a avaliação do protótipo e descreve os

experimentos com aprendizagem de máquina, detalhando os resultados obtidos em cada

abordagem. Finalmente, a seção 7 traz conclusões e indicações de trabalhos futuros.

2. Trabalhos Relacionados

Apesar da grande demanda, poucos são os sistemas disponíveis na Internet que lidam

com publicações científicas. Foram identificados quatro sistemas para este fim: o

WebFind [Monge & Elkan 1996], o Cora [McCallum et al. 2000], o CiteSeer [Bollacker

et al. 1998] e o CiFi [Loke et al. 1996].

O WebFind é um sistema para localização na Internet de documentos científicos

a partir dos nomes dos autores. Ele utiliza duas fontes externas de informação: o

MELVYL, um serviço de biblioteca da Universidade de Califórnia e o NetFind, um

serviço que oferece o provedor de Internet e o endereço eletrônico do autor. Primeiro, o

usuário informa o artigo desejado (por uma combinação dos nomes dos autores,

palavras do título, etc.), então o WebFind faz uma consulta ao INSPEC para recuperar a

afiliação institucional do(s) autor(es), e finalmente usa o NetFind para localizar o

endereço na Internet desta afiliação. Uma vez que o servidor foi identificado, WebFind

segue os links até o artigo desejado seja localizado. A principal desvantagem do

WebFind é que ele só cobre documentos cujas as afiliações de autores estejam presentes

no banco de dados de MELVYL.

O Cora é um engenho de busca específico para a localização de produção

científica da área de Ciência da Computação. Ele utiliza um robô que percorre a Web a

partir das páginas dos departamentos e laboratórios de Ciência da Computação, e coleta

todos os documentos no formato Postscript. Estes documentos são analisados para a

extração de informação (título, nomes de autores e afiliações, resumo e referências).

Cada referência individual é isolada e todas as citações para o mesmo artigos e são

associadas ao mesmo. Os documentos coletados são classificados sob uma hierarquia de

categorias da Ciência da Computação, e são armazenados em um banco de dados

específico, disponível por para busca por palavras-chave. O sistema é limitado à área da

Ciência da Computação e aos arquivos dos artigos, ignorando aquelas citações que não

contêm um link para o arquivo correspondente.

O CiteSeer consiste em três componentes principais: um agente para

automaticamente localizar e coletar publicações no formato Postscript ou HTML por

meio de consultas aos engenhos de busca tradicionais; um parser para a extração de

algumas informações (URL, cabeçalho, resumo, introdução, citações) dos documentos

carregados; e uma interface de acesso à base de dados do sistema. Adicionalmente, este

sistema agrupa citações para um mesmo artigo e tenta localizar documentos

relacionados ao mesmo assunto. Diferentemente do Cora, o CiteSeer permite não só a

busca por documentos que possuem seu respectivo arquivo, mas também pelas citações

que aparecem nesses documentos, mesmo que o sistema não possua o arquivo desta

citação em sua base.

O CiFi utiliza um agente inteligente para a busca de citação de publicações na

área de Ciência da Computação. O usuário tem que informar o autor e o título do artigo

e então o CiFi executa quatro estratégias alternativas: procura a versão em HTML do

artigo (por meio de consulta ao Lycos); procura a página pessoal do autor (também

através do Lycos); procura a página do departamento de Ciência da Computação do

autor; ou procura arquivos de relatório técnicos (o Unified Computer Science Technical

Reports e o Networked Computer Science Technical Reports Library ). A principal

desvantagem do CiFi é que ele requer o título e o autor do artigo, não permitindo a

busca por documentos relacionados a um determinado assunto, sendo ainda limitado à

área da Ciência da Computação.

3. Classificação Automática de Documentos

Duas são as técnicas existentes para a construção de classificadores: a criação manual

de sistemas baseados em conhecimento, ou por aprendizagem automática. Em geral, os

sistemas baseados em conhecimento são compostos de dois elementos principais: uma

base de conhecimento e um motor de inferência [Russell & Norvig 1995].

Vários são os experimentos e sistemas de classificação de documentos baseados

em técnicas de aprendizagem, como por exemplo: as árvores de decisão [Lewis &

Ringuette 1994], e a aprendizagem de regras [Apté et al. 1994]. A aprendizagem

Bayesiana também já foi aplicada à classificação de documentos [McCallum et al.

2000], assim como as Redes Neurais Artificiais [Wiener et al. 1995].

Dentre as abordagens de aprendizagem de máquina, a indução de regras é uma

das mais aplicadas à tarefa de classificação de documentos, devido a sua boa precisão.

As regras (manual ou automaticamente construídas) possuem vantagens potenciais,

como melhor capacidade de explanação, um modelo teórico mais forte e o fato de não

serem mutuamente excludentes (como ocorre nas árvores de decisão).

4. CitationFinder

Esta seção apresenta detalhes sobre o CitationFinder, um sistema para meta-busca e

classificação de páginas Web de citações de publicações. Como já comentado, trata-se

de um sistema baseado em conhecimento construído manualmente. A escolha da

abordagem baseada em conhecimento deveu-se, principalmente, a dois aspectos: (1)

trabalhos anteriores na área de classificação de documentos mostravam que os sistemas

baseados em conhecimento [Hayes & Weinstein 1990] conseguiam obter resultados

superiores aos de sistemas construídos automaticamente por aprendizagem [Lewis &

Ringuette 1994; Wiener et al. 1995; Apté et al. 1994]; e (2) a consideração de relações

estruturais (ordem de palavras, localização de termos em tags específicas) é mais

facilmente implementada por meio de regras escritas manualmente, uma vez que a

aprendizagem automática dessas características só é possível por meio da lógica de

primeira ordem, que demanda o uso de algoritmos de ordem exponencial [Zucker &

Ganascia 1998].

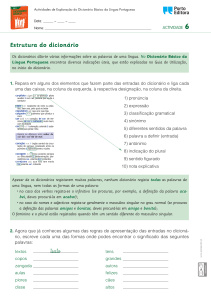

O CitationFinder objetiva a busca de páginas Web de publicação, isto é, páginas

HTML que contenham citações de publicações, independente da presença ou não de

seus respectivos arquivos (Postscript ou PDF) e da área de pesquisa relacionada. Todo o

processamentos dos documentos é feito off-line, de modo que o único processo on-line é

a busca na sua base de índices. A fim de evitar o trabalho e o custo de indexar a Web

diretamente, o CitationFinder realiza "meta buscas" através de engenhos de busca

disponíveis (e.g., Yahoo, Radix). Assim sendo, o classificador executa consultas

baseadas em palavras-chave do domínio, e classifica as páginas eletrônicas (em HTML)

retornadas (cf. Figura 1), armazenando-as em uma base de índices específica, e,

portanto, devolvendo ao usuário apenas as páginas que contêm citações de publicações

(cf. Figura 2).

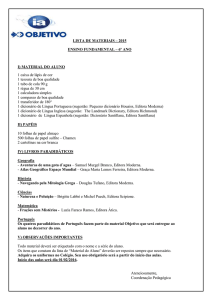

Web

Consulta

Engenhos de Busca

tradicionais

Base de Índices

Específica

Busca por

palavras-chave do domínio

CitationFinder

URLs reconhecidas

positivamente

)LJXUD$UTXLWHWXUDJHUDOGDVROXomRDGRWDGD

Como todo sistema baseado em conhecimento, a construção do CitationFinder

seguiu quatro etapas de desenvolvimento [Turban 1992]: aquisição de conhecimento,

formalização da base de conhecimento, implementação e testes (validação). Veremos a

seguir detalhes sobre as três primeiras etapas de desenvolvimento.

4.1 Aquisição do Conhecimento

A aquisição do conhecimento necessária para a construção das bases de conhecimento

foi realizada com base em um corpus de 1000 páginas eletrônicas, sendo 700 positivas

(páginas de publicação) e 300 negativas. Este corpus foi manualmente coletado através

da análise de páginas retornadas por meta-buscas a engenhos de busca disponíveis na

Web. Em seguida, foi feita uma análise das páginas selecionadas, a fim de

identificarem-se suas regularidades (que permitiriam a identificação automática de tais

páginas).

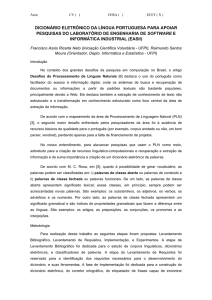

A principal característica identificada foi a presença de blocos de citação,

geralmente dispostos como uma lista numerada ou não (cf. Figura 2). Casos onde os

blocos de citações estão separados apenas por parágrafos também são bastante

encontrados, e, menos freqüentemente, encontram-se blocos inseridos em uma tabela,

onde cada linha corresponde a um bloco.

)LJXUD ([HPSOR GH XPD SiJLQD GH SXEOLFDomR FRP EORFRV GH FLWDo}HV

DSUHVHQWDGRVVREDIRUPDGHXPDOLVWDQXPHUDGD

4.2 Formalização e Implementação das Bases de Conhecimento

O processamento das páginas no CitationFinder pode ser feito em duas etapas, sendo a

primeira obrigatória e a segunda opcional (ver seção 4). As bases de conhecimento do

sistema foram formalizadas e implementadas como um conjunto de regras de produção.

Este conhecimento adquirido norteou a construção de três bases de conhecimento:

1. uma base de fatos composta por um dicionário de termos do domínio e padrões

sintáticos;

2. uma base de regras para o reconhecimento dos blocos de citação (primeira etapa de

processamento);

3. uma base de regras (com fatores de certeza associados) para a verificação de termos

específicos em grupos de palavras (segunda etapa de processamento).

Dicionário do Domínio

O dicionário de termos do domínio é utilizado nas duas etapas de

reconhecimento das páginas, e constitui peça essencial de conhecimento do domínio.

Através da observação dos exemplos coletados, foram definidas 11 classes de palavras

indicativas de termos usualmente encontrados em páginas de publicações [Neves 2001]:

Geral, Trabalho Impresso, Iniciais, Arquivo, Editora, Data, Volume da Edição, Número

da Edição, Intervalo de Páginas, Localidade e Tipo de Evento.

O dicionário do domínio foi escrito apenas para as línguas portuguesa e inglesa,

com exceção dos nomes de localidades, que foram escritos também na língua de origem

da localidade. Além dessas 11 classes, 6 padrões de termos são verificados, isto é,

cadeias geralmente formadas por uma composição de caracteres específicos e

algarismos: Arquivo (e.g., 1.5MB), Data (e.g., 11-fev-98), Número da Edição (e.g.,

no60), Páginas da Publicação (e.g., pp228-233), Tipo de Evento (e.g., AAAI'90) e

Volume da Edição (e.g., vol60, v22). Estes padrões são tão importantes para o

reconhecimento das páginas quanto as palavras listadas no dicionário do domínio, e por

isso, também podem ser considerados como parte da base de fatos.

Bases de Regras

Como já comentado, duas são as etapas de processamento do sistema, cada uma

com sua base de regras construída para fins específicos. A primeira etapa é responsável

pelo reconhecimento das páginas de publicações através da identificação de cada bloco

de citação isoladamente. Esses blocos podem ser reconhecidos por regras que utilizam

combinações das possíveis cadeias que compõem uma citação (cf. Figura 3).

SE

houver uma cadeia de Tipo de Evento

E houver uma cadeia de Intervalo de Páginas

E houver uma cadeia de Data

ENTÃO o texto é uma citação

)LJXUD([HPSORGHUHJUDSDUDRUHFRQKHFLPHQWRGHXPEORFRGHFLWDomR

A segunda etapa de classificação é responsável pela identificação de termos do

dicionário em grupos de textos, definidos a partir das tags do documento [Neves 2001].

A verificação desses termos é realizada por meio de um conjunto de regras específicas

(cf. Figura 4) que contabilizam quantas palavras de uma mesma classe do dicionário do

domínio estão presentes em cada grupo de texto considerado. Diferentemente das regras

da primeira etapa, essas regras têm fatores de certeza (positivos ou negativos)

associados, que indicam a chance da página ser classificada como positiva. O valor

final obtido pela combinação dos fatores em cada regra disparada é comparado a um

limiar, de modo a efetuar uma decisão binária de classificação.

SE

a freqüência da classe Geral no grupo

Especial for de 1 a 20

ENTÃO o documento é positivo (0.83)

)LJXUD([HPSORGHUHJUDSDUDDFODVVLILFDomRGHGRFXPHQWRV

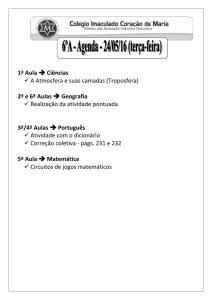

5. Protótipo Implementado

Como comentado, o reconhecimento das páginas no sistema CitationFinder é realizado

em duas etapas, cuja arquitetura é apresentada na Figura 5. A primeira etapa classifica a

página pelo reconhecimento da presença de blocos de citação. As páginas classificadas

como negativas nesta etapa são passadas para a etapa 2. Aqui temos páginas que não

contêm qualquer citação, sendo de fato negativas, e páginas onde as citações não estão

organizadas em blocos característicos do domínio. Esta etapa tenta, portanto, identificar

as páginas que possuem citações em formatos diversos.

JEOPS

documento

HTML

Isolamento

dos blocos de

citações

Base de

Regras 1

Dicionário

do domínio

Classificador

-

_

_

_

__

_

_

_

Separação

dos grupos

de texto

Base de

Regras 2

Dicionário

do domínio

+

limiar

Base de

Índices

Classificador

+

)LJXUD$UTXLWHWXUDGDVVXDVHWDSDVGHSURFHVVDPHQWRGR&LWDWLRQ)LQGHU

Primeiramente, um parser é responsável pela identificação e pelo isolamento dos

trechos de texto relevantes contidos no documento. Uma estrutura em forma de árvore é

construída a partir da página HTML de acordo com as tags identificadas. A partir daí, o

sistema tenta isolar os blocos de citações, observando as tags identificadores de listas

(numeradas ou não), tabelas, e em último caso, parágrafos. Em seguida, é efetuada uma

verificação dos termos do dicionário do domínio e dos padrões sintáticos, não havendo a

necessidade de uma separação de cada cadeia que compõe o bloco de citação.

Tampouco há a necessidade de se diferenciar termos pertencentes a uma mesma classe

do dicionário do domínio ou a um mesmo padrão. O reconhecimento final da página é

realizado por meio de regras que verificam algumas combinações de cadeias de uma

citação (cf. seção 4.2), e se classificada positivamente, sua URL é enviada a uma base

de índices. Se classificada negativamente, a páginas será processada pela segunda etapa

do sistema.

Embora a maioria das páginas de publicações seja satisfatoriamente reconhecida

na primeira etapa de processamento (91% dos exemplos positivos na fase de

construção), algumas páginas contêm citações compostas de poucas cadeias que

necessitariam de regras muito gerais. A segunda fase do sistema CitationFinder visa

aumentar a cobertura do sistema, por meio da identificação de termos do dicionário do

domínio em alguns grupos de texto do documento. Esses seis grupos de textos (Título,

Comum, Especial, Lista, Tabela e Link) são criados pelo parser da segunda fase do

sistema, a partir da natureza das tags em que o texto se encontra [Neves 2001]. Em

seguida, é realizada uma verificação da presença dos termos do dicionário nos grupos

considerados por meio de um conjunto de regras específicas (cf. seção 4.2).

Analogamente ao que ocorre na primeira etapa, se classificada positivamente, a página

será armazenada na base de índices, senão será classificada como negativa e descartada

pelo sistema.

Todo o conhecimento utilizado para a classificação dos documentos está contido

no dicionário do domínio, e nas bases de regras. Implementadas como regras JEOPS

(Java Embedded Object Production System) [Figueira Filho & Ramalho 2000], as

regras de produção estão agrupadas em diferentes módulos, portanto, são de fácil

compreensão, manutenção e extensão. O JEOPS é um motor de inferência para sistemas

baseados em regras de produção de primeira ordem, facilitando a criação de aplicativos

Java voltados à área de Inteligência Artificial.

6. Avaliação do Sistema

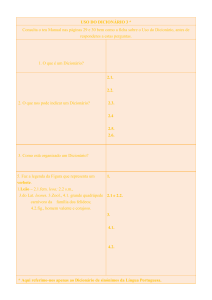

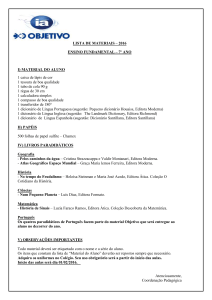

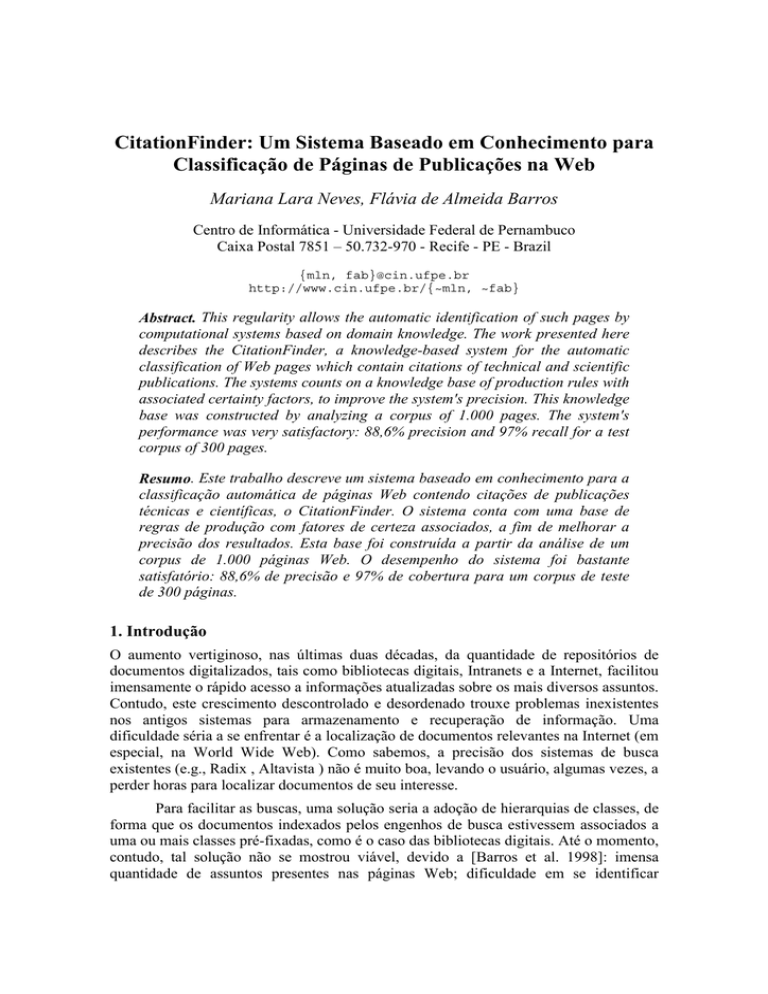

O CitationFinder foi avaliado com um corpus de teste composto por 300 páginas, sendo

200 positivas e 100 negativas. Vale frisar que este corpus é diferente do usado na

construção do sistema, a fim de permitir uma avaliação mais realista do sistema

construído. O desempenho foi medido através do cálculo dos parâmetros de precisão,

cobertura e F-Measure [van Rijsbergen 1979]. Para o corpus usado na construção do

CitationFinder (cf. Figura 6a), foram obtidos os valores de 91,1%, 96,7% e 93,8% para

os parâmetros de precisão, cobertura e F-Measure, respectivamente. Para o corpus de

teste (cf. Figura 6b), foram obtidos os valores de 88,6%, 97,0% e 92,6% para os

mesmos parâmetros anteriores.

Página

Positiva

Página

Negativa

677

66

23

234

Classificada

positivamente

Classificada

negativamente

(a)

Classificada

positivamente

Classificada

negativamente

Página

Positiva

Página

Negativa

194

25

6

75

(b)

)LJXUD0DWUL]HVGHFRQWLQJrQFLDSDUDRVcorporaGHDTXLVLomRDHGHWHVWHE

Experimentos adicionais com algoritmos de aprendizagem foram realizados

visando uma comparação entre o desempenho do sistema CitationFinder e de

classificadores construídos automaticamente. Foram testadas três abordagens: árvore de

decisão, indutor de regras, e a técnica Naive Bayes. Esses classificadores foram

construídos com o uso da ferramenta Weka (Waikato Environment for Knowledge

Analysis), desenvolvida pela University of Waikato da Nova Zelândia.

Os experimentos foram realizados com os mesmos corpora utilizados na

construção e teste do CitationFinder. Um pré-processamento dos documentos foi

realizado pela exclusão de palavras irrelevantes [Neves 2001] e eliminação de símbolos

e sinais de pontuação. A seleção dos termos a serem considerados nesses experimentos

foi realizada de acordo com três diferentes técnicas: pela medida da entropia [Maron

1961], pelo coeficiente de correlação [Ng et al. 1997] e pela técnica do χ2 [Ng et al.

1997]. O número de características adotado foram de 50, 100, 150 e 200, visando a

obtenção da melhor configuração para cada um dos três classificadores considerados.

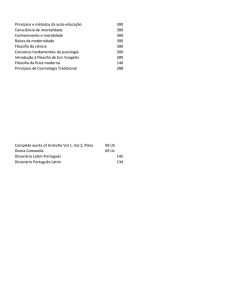

Os valores obtidos (cf. Figura 7) mostram que o CitationFinder e os

experimentos com Indução de Regras e Naive Bayes obtiveram resultados muito

próximos, de acordo com o parâmetro do F-Measure. O bom resultado obtido pelo

CitationFinder se deve à qualidade do conhecimento obtido durante a fase de aquisição,

representado por meio de um dicionário do domínio e de bases de regras específicas

para o reconhecimento de páginas de citação. Suas maiores vantagens em relação ao

experimento de melhor desempenho (Indução de Regras) são modularidade,

extensibilidade e facilidade de uso.

Indução de Regras

Árvores de Decisão

Naive Bayes

CitationFinder

Precisão

Cobertura

F-Measure

95%

87%

93%

88,6%

92%

90%

91%

97%

93,5%

88,5%

92%

92,6%

)LJXUD&RPSDUDomRGRGHVHPSHQKRGDVDERUGDJHQVXWLOL]DGDV

7. Considerações Finais

Este trabalho apresentou o sistema CitationFinder, construído para a classificação de

páginas de citações de publicação na Web. Trata-se de um sistema baseado em

conhecimento que dispõe de um dicionário de termos do domínio e de duas bases de

regras de produção para auxiliar a tarefa de classificação. As bases de conhecimento

foram manualmente construídas através da análise detalhada de um corpus de 1000

documentos.

As maiores contribuições deste trabalho foram: (1) a coleta de um corpus de

900 páginas de citações de publicações e 400 páginas negativas; (2) a criação de um

dicionário do domínio e regras de produção para a classificação das páginas; (3) a

criação de um sistema original, sem equivalente na literatura disponível; e (4) a

realização de experimentos comparativos com aprendizagem.

Algumas extensões a este trabalho poderiam ser efetuadas de modo a torná-lo

ainda mais eficiente: (1) o reconhecimento de nomes próprios; (2) a coleta de novas

páginas e extensão das bases de regras e do dicionário do domínio; (3) a busca

automática de nomes próprios e de localidades (em sites geográficos); e (4) a integração

do CitationFinder com o sistema ProdExt [Nunes 2000], cujo objetivo é o

preenchimento automático de banco de dados específicos de produção científica.

Referências Bibliográficas

Apté, C.; Damerau, F. & Weiss, S. (1994) “Automated Learning of Decision Rules for

Text Categorization”. ACM Transactions on Information Systems, Vol. 12(3), pp.

233-151.

Barros, F. A. Gonçalves, P. F. & Santos, T. L. V. L. (1998) “Providing Context to Web

Searches: the Use of Ontologies to Enhance Web Search Engines' Accuracy”. In

Journal of the Brazilian Computer Society. Vol. 5(2), pp. 45-55.

Bollacker, K. D.; Lawrence, S. & Giles, L. (1998) “CiteSeer: An Autonomous Web

Agent for Automatic Retrieval and Identification of Interesting Publications”. Proc.

of the 2nd International Conference on Autonomous Agents. ACM Press, New York,

pp. 116-123.

Figueira Filho, C. S. & Ramalho, G. L. (2000) “JEOPS - The Java Embedded Object

Production System”. Lecture Notes in Artificial Intelligence, n.1952, Advances in

Artificial Intelligence, pp. 53-62.

Hayes, P. J. & Weinstein, S. P. (1990) “Construe-TIS: A System for Content-Based

Indexing of a Database of News Stories”. Second Annual Conference on Innovative

Applications of Artificial Intelligence, pp. 48-64.

Lewis, D. D. & Ringuette, M. (1994) “A Comparison of Two Learning Algorithms for

Text Categorization”. In Third Annual Symposium on Document Analysis and

Information Retrieval, pp. 81-93.

Loke, S. W.; Davison, A. & Sterling, L. (1996) “CiFi: An Intelligent Agent for Citation

Finding on the World-Wide Web”. In: Foo N, Goebel R (eds) Lecture Notes on

Artificial Intelligence Series, no. 1114. Springer-Verlag, London, pp. 580-591

Maron, M. E. (1961) “Automatic Indexing: An Experimental Inquiry”. Journal of ACM,

Vol. 8, pp. 404-417.

McCallum, A. K.; Nigam, K.; Rennie, J. & Seymore, K. (2000) “Automating the

Construction of Internet Portals with Machine Learning”. Information Retrieval

Journal, Vol. 3, pp. 127-163.

Monge, A. E. & Elkan, C. P. (1996) “The WebFind Tool for Finding Scientific Papers

over the World Wide Web”. Proceedings of the Third International Congress on

Computer Science Research, Tijuana, Mexico.

Neves, M. L. (2001) “CitationFinder: Um Sistema de Meta-busca e Classificação de

Páginas de Publicações na Web”. Dissertação de Mestrado, Centro de Informática,

UFPE. (http://www.cin.ufpe.br/~mln/)

Ng, H. T.; Goh, W. B. & Low, K. L. (1997) “Feature Selection, Perceptron learning and

a Usability Case Study for Text Categorization”. Proceedings of SIGIR-97, 20th

ACM International Conference on Research and Development in Information

Retrieval, pp. 67-73, Philadelphia, PA, USA.

Nunes, C. C. R. (2000) “ProdExt: Um Wrapper para Extração de Produção Técnica e

Científica de Páginas Eletrônicas”. Dissertação de Mestrado, Centro de Informática,

UFPE.

Russell, S. & Norvig, P. (1995) Artificial Intelligence: A Modern Approach. Prentice

Hall.

van Rijsbergen, C. J. (1979) Information Retrieval. Department of Computer Science,

University of Glasgow.

Turban, E. (1992) Expert Systems and Applied Artificial Intelligence. Macmillan Pub.

Co.

Wiener, E.; Pedersen, J. O. & Weigend, A. S. (1995) “A Neural Network Approach to

Topic Spotting”. In Proceedings of the 4th Symposium on Document Analysis and

Information Retrieval, pp. 317-332, Las Vegas, NV, USA, April 24-26.

Zucker, J. -D, & Ganascia, J. -G. (1996) “Changes of Representation for Efficient

Learning in Structural Domains”. In International Conference in Machine Learning,

Bary, Italie: Morgan Kauffman.