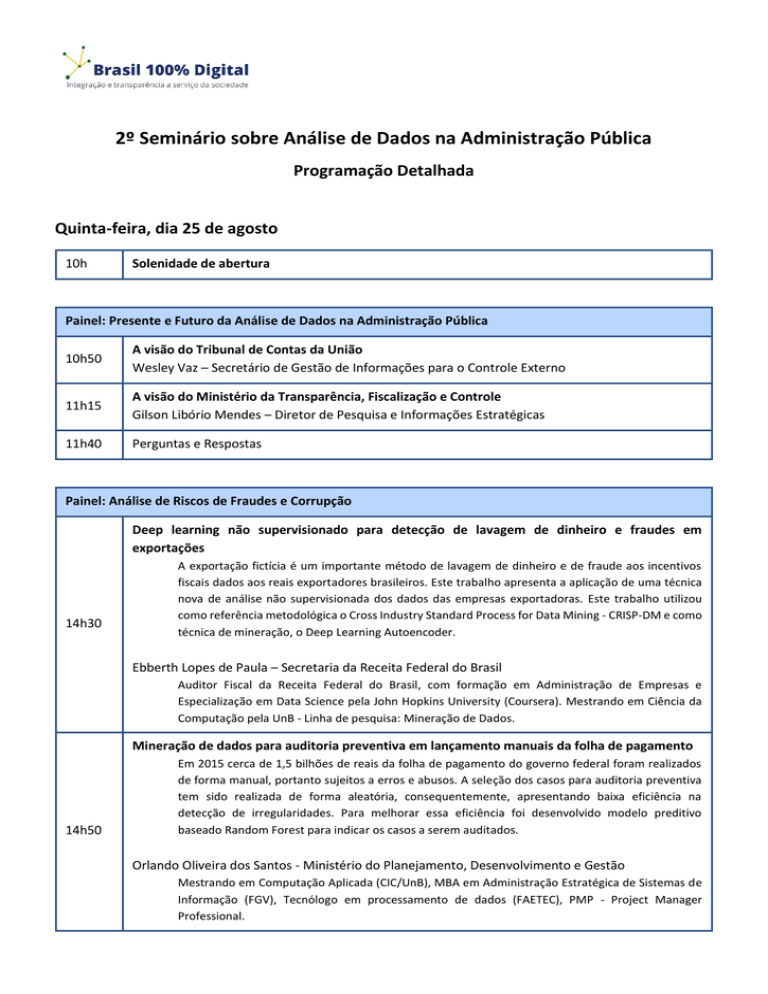

2º Seminário sobre Análise de Dados na Administração Pública

Programação Detalhada

Quinta-feira, dia 25 de agosto

10h

Solenidade de abertura

Painel: Presente e Futuro da Análise de Dados na Administração Pública

10h50

A visão do Tribunal de Contas da União

Wesley Vaz – Secretário de Gestão de Informações para o Controle Externo

11h15

A visão do Ministério da Transparência, Fiscalização e Controle

Gilson Libório Mendes – Diretor de Pesquisa e Informações Estratégicas

11h40

Perguntas e Respostas

Painel: Análise de Riscos de Fraudes e Corrupção

Deep learning não supervisionado para detecção de lavagem de dinheiro e fraudes em

exportações

14h30

A exportação fictícia é um importante método de lavagem de dinheiro e de fraude aos incentivos

fiscais dados aos reais exportadores brasileiros. Este trabalho apresenta a aplicação de uma técnica

nova de análise não supervisionada dos dados das empresas exportadoras. Este trabalho utilizou

como referência metodológica o Cross Industry Standard Process for Data Mining - CRISP-DM e como

técnica de mineração, o Deep Learning Autoencoder.

Ebberth Lopes de Paula – Secretaria da Receita Federal do Brasil

Auditor Fiscal da Receita Federal do Brasil, com formação em Administração de Empresas e

Especialização em Data Science pela John Hopkins University (Coursera). Mestrando em Ciência da

Computação pela UnB - Linha de pesquisa: Mineração de Dados.

Mineração de dados para auditoria preventiva em lançamento manuais da folha de pagamento

14h50

Em 2015 cerca de 1,5 bilhões de reais da folha de pagamento do governo federal foram realizados

de forma manual, portanto sujeitos a erros e abusos. A seleção dos casos para auditoria preventiva

tem sido realizada de forma aleatória, consequentemente, apresentando baixa eficiência na

detecção de irregularidades. Para melhorar essa eficiência foi desenvolvido modelo preditivo

baseado Random Forest para indicar os casos a serem auditados.

Orlando Oliveira dos Santos - Ministério do Planejamento, Desenvolvimento e Gestão

Mestrando em Computação Aplicada (CIC/UnB), MBA em Administração Estratégica de Sistemas de

Informação (FGV), Tecnólogo em processamento de dados (FAETEC), PMP - Project Manager

Professional.

Análise de riscos de declarações retidas em malha fiscal utilizando redes bayesianas

15h10

O número de declarações de IRPF em malha é cada vez maior. A quantidade de Auditores, no entanto,

tem reduzido drasticamente. Dessa forma, se faz necessária a utilização de técnicas de mineração de

dados para identificar grupos de risco para focalizar nas declarações mais importantes. A partir de

dados com declarações já trabalhadas pelos Auditores foi possível aplicar uma análise supervisionada

utilizando redes bayesianas de modo a facilitar a seleção das declarações de maior risco.

Leon Sólon da Silva - Secretaria da Receita Federal do Brasil

Auditor-Fiscal da RFB, atuando como analista de dados para combate a fraudes tributárias. Bacharel

em Ciência da Computação e Mestre em Computação Aplicada pela UnB.

Mapeamento de risco de corrupção na administração pública federal

15h30

O Ministério da Transparência (CGU) tem, entre suas atribuições, investigar possíveis irregularidades

cometidas por servidores públicos federais. Nesse contexto, nasceu o projeto MARA, que aplica

mineração de dados para gerar modelos preditivos com a finalidade de avaliar risco de corrupção de

servidores públicos federais a partir de diversas bases de dados governamentais. Esse trabalho

possibilitou o uso mais eficiente e eficaz de recursos e pessoal da CGU; com impacto nacional;

incremento na metodologia de priorização de trabalhos; e o fortalecimento do controle prévio.

Rommel Novaes Carvalho - Ministério da Transparência, Fiscalização e Controle

Coordenador-Geral do Observatório da Despesa Pública (ODP), lidera equipe de aproximadamente

15 Cientistas de Dados responsáveis por monitorar gastos públicos, identificar fraudes e combater a

corrupção. Além disso, é Professor do Mestrado Profissional em Computação Aplicada da UnB.

15h50

Perguntas e Respostas

Sessões Interativas (Espaço de Convivência / Salão Nobre)

DWJuris - unificação e tratamento das bases processuais do TJDFT

O projeto denominado DWJURIS busca consolidar as informações dos sistemas de 1ª instância (SISTJ,

SISTJWEB, VIJ e PJE) e 2ª instância (SISPL) em uma única base de dados destinada a pesquisa ou

geração de relatórios tendo como referência as interfaces do Modelo Nacional de Interoperabilidade

publicadas pelo Conselho Nacional de Justiça. Foram utilizadas ferramentas como Oracle, Power

Center e Data Quality, além de ferramentas open source Hadoop e Hive.

Jairo Simão Santana Melo - Tribunal de Justiça do Distrito Federal e Territórios

16h10

Graduado em Ciência da Computação (UCB), Mestre em Gestão do Conhecimento e Tecnologia (UCB)

e Doutor em Engenharia Elétrica (PGEA/UnB). Supervisor da área de normatização e administração

de dados do TJDFT, com foco em data warehouse, business intelligence e sistemas de qualidade.

Automação de processos de acompanhamento da gestão fiscal no Distrito Federal

Josdeyvi Magalhães Russi - Tribunal de Contas do Distrito Federal

Três histórias sobre o uso de análise de dados para fomento ao controle social

Quanto mais envolvida estiver a população, maior a capacidade de fiscalização da gestão pública.

Descreveremos três iniciativas que utilizam técnicas de análise de padrões, análise descritiva, textual

e comparativa para permitir à sociedade: i) acompanhar o destino das verbas de emendas

parlamentares; ii) avaliar comparativamente como uma cidade gasta esses recursos; e iii) fornecer

parâmetros para discutir a eficiência da execução de recursos em políticas educacionais.

João Arthur Brunet - Universidade Federal de Campina Grande

Professor adjunto de Ciência da Computação na Universidade Federal de Campina Grande, tendo

realizado estágio na Microsoft Research e na University of British Columbia.

Mineração de dados abertos governamentais para identificação de indícios de desvios de recursos

Exposição de estudo de caso de técnica simplificada de mineração de dados que objetivou conhecer

o potencial de produção de conhecimento útil ao controle social da execução orçamentária a partir

da exploração de dados disponíveis nos portais de transparência. Servindo-se de métodos estatísticos

de distribuição de frequência, séries temporais, gráficos dinâmicos e filtros interativos de variáveis,

o trabalho criado com simples planilhas eletrônicas produziu resultados além das expectativas.

Walter Junior Cabral de Lima - Ministério Público de Contas do Estado do Espírito Santo

Formado em Eletrônica e em Direito, é advogado público estadual e chefe de gabinete da 3ª

Procuradoria do Ministério Público de Contas do Estado do Espírito Santo.

Painel: Melhoria de Processos de Gestão

Descoberta de fluxos e análise de desempenho por meio de técnicas de mineração de processos

16h45

Os processos de gestão de serviços de TI apresentam grande desafio de gerenciamento decorrentes

da diversidade do catálogo de serviços, das tecnologias utilizadas e da quantidade de atores

envolvidos na sua execução. Nesse contexto as técnicas de mineração de processos, minerador fuzzy

e análise de gráficos de pontos, foram utilizadas, respectivamente, para fazer a descoberta fluxo e

para avaliar o desempenho processo.

Orlando Oliveira dos Santos - Ministério do Planejamento, Desenvolvimento e Gestão

Mestrando em Computação Aplicada (CIC/UnB), MBA em Administração Estratégica de Sistemas de

Informação (FGV), Tecnólogo em processamento de dados (FAETEC) e PMP.

Modelo preditivo para apoio a análise de risco em projetos de TIC

17h05

Aplicação de aprendizado de máquina para construir um modelo preditivo que identifica, dentre os

projetos de TIC em andamento na Câmara dos Deputados, aqueles que devem ser priorizados para

análise de risco. O modelo foi implementado com a biblioteca Scikit-learn e compara o desempenho

de algoritmos de classificação como Support Vector Machines, Random Forests e Redes Bayesianas.

Finalmente, serão apresentadas métricas de avaliação (curva ROC) que confirmam a boa

generalização do modelo nos dados de testes.

Marcio Rodrigo Fernandes Fonseca - Câmara dos Deputados

Graduado em Engenharia da Computação pelo Instituto Militar de Engenharia (IME). Analista de

Informática Legislativa na Câmara dos Deputados, atuando na gestão de processos e serviços de

Tecnologia da Informação.

Mineração de dados para predição da regularização de operações de crédito em atraso

17h25

Com o objetivo de apoiar a abordagem aos clientes com operações de crédito em atraso, foram

elaborados modelos preditivos para identificação daqueles com o maior potencial de regularização

de suas operações, utilizando técnicas de ensemble learning (multiclassificadores) e deep learning

(aprendizagem profunda), comparando-os sob as perspectivas de eficácia, eficiência e escalabilidade.

Rogerio Gomes Lopes - Banco do Brasil

Possui graduação em Computação (UnB-2008), MBA em Gestão de Projetos (Unieuro-2009) e cursa

Mestrado em Computação Aplicada na UnB. É Analista de TI do Banco do Brasil e Professor da

Faculdade SENAC.

17h45

Perguntas e Respostas

Sexta-feira, dia 26 de agosto

Painel: Análise de Riscos em Licitações e Contratos

Avaliação de riscos em licitações com técnicas não supervisionadas

9h10

O trabalho consistiu em prova de conceito da aplicação de técnicas de mineração de dados no

processo de identificação do risco de ocorrência de irregularidades em licitações; especificamente

mediante a identificação de licitantes que participam em conjunto de licitações com muita frequência

com uso de regras de associação ou via formação de cartel ou utilização de rodízio de empresas em

licitações com o uso de análise de redes sociais, ambas técnicas exploratórias não supervisionadas.

Marcos Ferreira da Silva - Tribunal de Contas do Estado do Rio de Janeiro

Técnico de Controle Externo do TCE-RJ há mais de 20 anos. Graduado em Estatística pela Escola

Nacional de Ciências Estatísticas – ENCE e pós graduado em controle externo pela Fundação Getúlio

Vargas – FGV. Professor da Escola de Contas e Gestão do TCE-RJ.

Técnicas automáticas para detecção de indícios de fraudes em licitações

Apresentação sobre o sistema de Licitação e Contratos (LICON) do TCE-AC. Seu principal diferencial

está no uso de dados abertos em mecanismos de gerenciamento e controle das informações. Dois

robôs fiscalizam dois pontos de maior atenção no âmbito de licitações e contratos: busca por indícios

de sobrepreço, através de análise de dados do SICRO/DNIT e SINAPI/Caixa; e monitoramento do DOEAC, de modo a assegurar que todos os editais publicados estejam devidamente cadastrados.

9h30

Gerson da Silva Januario - Tribunal de Contas do Estado do Acre

Analista de Controle Externo e Instrutor da Escola de Contas Públicas do TCE-AC. Também é professor

em Ciências Contábeis da UNINORTE, com MBA em Controladoria, Auditoria e Gestão Financeira pela

FGV.

Maxwell Guimarães de Oliveira - Universidade Federal de Campina Grande

Doutorando em Ciência da Computação na UFCG, pesquisador em Informação Geográfica Voluntária

(VGI) e mineração de mídias sociais no Laboratório de Sistemas de Informação (LSI).

9h50

Proposta de modelo de classificação de riscos de contratos públicos

Leonardo Jorge Sales - Ministério da Transparência, Fiscalização e Controle

Sessões Interativas (Espaço de Convivência / Salão Nobre)

Controle social de obras públicas com mineração de opinião, plataformas móveis e

geoprocessamento

O GeoObras, desenvolvido pela UFCG e TCE-AC, permite aos cidadãos contribuírem na denúncia e

monitoramento de obras públicas. Seu principal diferencial está na utilização de dados multimídia

georeferenciados, inseridos diretamente na ferramenta ou recuperados de redes sociais por meio de

técnicas de aprendizado de máquina baseadas em ontologia de domínio e mineração de opinião com

análise de sentimentos. O GeoObras provê um efetivo controle social no tocante à qualidade de obras

públicas.

Cláudio de Souza Baptista - Universidade Federal de Campina Grande

PhD em Ciência da Computação pela University of Kent-UK, é Professor Associado da UFCG, atua na

pós-graduação e graduação em Ciência da Computação. É Coordenador do LSI/UFCG.

Classificação de despesas públicas com análise de componentes independentes e redes neurais

10h10

Identificar características das despesas públicas através da inteligência artificial é importante pois

costuma ser eficiente em comparação ao processo manual. Este trabalho avalia o aprendizado das

redes neurais diante de componentes extraídas por algoritmos de Análise de Componentes

Independentes. Foi realizado um experimento com análise estatística no portal da transparência do

Tribunal de Contas do Estado de Sergipe. Os resultados mostraram como reduzir a taxa de erro das

redes neurais.

Hallan Cosmo dos Santos - Tribunal de Contas do Estado de Sergipe

Analista de Controle Externo II no Tribunal de Contas do Estado de Sergipe. Mestre em Ciências da

Computação pela Universidade Federal de Sergipe.

Como se comportam as doações para as campanhas eleitorais dos governadores?

Jhonatan Ferreira - SAS

Transparência política: visualização de dados sobre as influências econômicas nas eleições

Wagner Oliveira - Diretoria de Análise de Políticas Públicas da Fundação Getulio Vargas

Painel: Análise de Riscos em Licitações e Contratos (continuação)

10h50

Priorização e seleção de processos licitatórios, dispensas e inexigibilidades para análise do TCEGO

Vitor Gobato - Tribunal de Contas do Estado de Goiás

Extraindo o valor estimado em editais de licitações públicas

11h10

A verificação de indícios de irregularidades em uma licitação pode ser mais efetiva se feita assim que

seu edital for publicado. Deste modo, pode-se atribuir tempestivamente um fator de risco a este

certame, considerando a gravidade dos indícios encontrados e a materialidade da licitação. Este

trabalho aborda técnicas de mineração de texto e aprendizado de máquina que permitem extrair do

texto de um edital o valor que foi estimado pelo órgão. O método obteve eficácia maior que 90%.

Edans Flávius de Oliveira Sandes – Tribunal de Contas da União

Auditor do TCU desde 2008 e Doutor em Informática desde 2015 pela UnB. Seus tópicos de interesse

incluem Análise de dados e Computação Paralela.

11h30

Perguntas e Respostas

Painel: Análise e Mineração de Textos

14h30

Categorização de achados em auditorias de TI com modelos supervisionados e não

supervisionados

Patrícia Helena Maia Alves de Andrade - Ministério da Transparência, Fiscalização e Controle

14h50

Serviços cognitivos e machine learning para extração de informações de bases não estruturadas

Luís André Dutra e Silva – Tribunal de Contas da União

Identificação automática de produtos a partir de registros de compras em portais de

transparência

15h10

Os portais de transparência são importantes canais de comunicação entre o governo e a população.

No entanto, nem sempre o formato das informações apresentadas é o mais apropriado. Por exemplo,

a descrição de compras em formato de texto dificulta a comparação de compras similares. Esse

trabalho propõe uma metodologia capaz de gerar regras de identificação de produtos em descrições

textuais de compras, através da utilização de uma técnica de mineração de frases e com o emprego

do Apache Spark.

Eduardo Soares de Paiva - Ministério da Transparência, Fiscalização e Controle

Engenheiro de Computação, mestrando em Informática. Auditor Federal de Finanças e Controle, atua

no tratamento e integração dos dados do Portal da Transparência do Governo Federal.

15h30

Perguntas e Respostas

Sessões Interativas (Espaço de Convivência / Salão Nobre)

Inferência de tópicos por mineração de textos em dados abertos governamentais

Nádia Félix Felipe da Silva - Universidade Federal de Goiás

15h50

Análise de dados textuais em auditoria sobre dados abertos educacionais

Luisa Helena Santos Franco - Tribunal de Contas da União

Extraindo conhecimento do cadastro único de programas sociais com data mining e nosql

Em março de 2016 existiam mais de 26 milhões de famílias no Cadastro Único, sendo que 13 milhões

fazem parte do programa Bolsa Família. Há uma agenda de monitoramento em busca de falhas, como

a concessão de benefícios para quem possui renda familiar per capita maior que meio salário mínimo.

Este trabalho é realizado pela Averiguação Cadastral, por meio do batimento com outros registros

administrativos, a fim de identificar possíveis indícios de inconsistências cadastrais e, assim,

promover sua atualização.

Caio Nakashima - Ministério do Desenvolvimento Social e Combate à Fome

Diretor do Departamento de Gestão da Informação da Secretaria da Avaliação e Gestão da

Informação do Ministério do Desenvolvimento Social e Agrário

Painel: Análise de Políticas Públicas e Programas Sociais

Bolsa família e jovens trabalhadores: análise de grandes bases de dados com abordagem de

computação paralela

16h30

O presente trabalho apresenta uma avaliação de impacto do Programa Bolsa Família na inserção de

jovens no mercado formal de trabalho, por meio da abordagem não experimental Regression

Discontinuity Design (RDD), utilizando as bases de dados do Cadastro Único, Folha de Pagamento do

Bolsa Família e RAIS. Considerando o tamanho das bases envolvidas, será também apresentada uma

versão otimizada de um algoritmo de estimação RDD, voltada para análise de grandes bases de dados

utilizando processamento paralelo.

Aloísio Dourado Neto – Tribunal de Contas da União

Graduado em Engenharia Elétrica pela UFBA, com pós-graduação em Sistemas Distribuídos e MBA

em Gestão de Negócios. Mestrando em Computação Aplicada da UnB. Atualmente, é auditor do TCU

e integra o núcleo de análise de dados da Secex Previdência.

Descobrindo um novo padrão no desempenho dos estudantes de escolas públicas no Distrito

Federal

16h50

Através da metodologia CRISP-DM, do algoritmo de classificação GBM e utilizando-se da ferramenta

de Mineração de Dados H2O, foi possível descobrir um novo padrão em relação ao desempenho

acadêmico dos alunos do ensino médio das escolas públicas do DF no início de cada ano letivo, sendo

capaz de alcançar um maior conhecimento em relação a quais são os outros atributos, além das

notas/ausências, que são altamente relevantes para impedir o insucesso escolar dos alunos ao final

de cada ano letivo.

Eduardo Pires Fernandes - Secretaria de Estado de Educação do Distrito Federal

Além de Gerente de Estratégia e Apoio de Dados na Secretaria de Estado de Educação do Distrito

Federal – SEDF, é Mestrando em Computação Aplicada (Mineração de Dados) da Universidade de

Brasília – UnB.

O uso de geoprocessamento para identificação de áreas carentes de escolas de ensino infantil

17h10

Aplicação de Geoprocessamento utilizando dados do Censo do IBGE e do Censo Escolar. Foi utilizado

o software Arc Gis 10.1, onde se utilizou o método dasimétrico para a geração de mapas necessários

ao estudo. Dessa forma, foi possível identificar quais as áreas de uma determinada região de Porto

Alegre/RS estão com maior necessidade de implantação de equipamentos públicos de ensino infantil.

Por fim, foram utilizadas as diretrizes do Plano Nacional de Educação para balizar os resultados.

Pedro Godinho Verran - Universidade Federal do Rio Grande do Sul

Possui Graduação em Geografia (Bacharelado) pela UFRGS desde 2014. É mestrando em Geografia

com ênfase em Análise Territorial pelo POSGEA-UFRGS, com previsão de conclusão em 2017. É

Técnico em Monitoramento e Controle Ambiental pelo Instituto Federal do Rio Grande do Sul desde

2010. Atualmente trabalha como Fiscal Ambiental na Secretaria de Meio Ambiente de Alvorada/RS

desde 2015.

17h30

Perguntas e Respostas

17h50

Encerramento