Variáveis aleatórias

Definição 1 (Variável Aleatória (v.a.)):

Estimação e Filtragem Estocástica

Programa de Pós-Graduação em Engenharia de Sistemas Eletrônicos e de Automação

Departamento de Engenharia Elétrica

Universidade de Brasília

Uma função real X(·) definida no espaço de probabilidades Ω é dita uma variável

aleatória (v.a.) se para todo número x ∈ <, a inequação

X(ω) ≤ x

representa um conjunto (eventos) cuja probabilidade de ocorrência é definida.

F UNDAMENTOS DE PROBABILIDADE E

ESTATÍSTICA

Geovany A. Borges

[email protected]

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

1

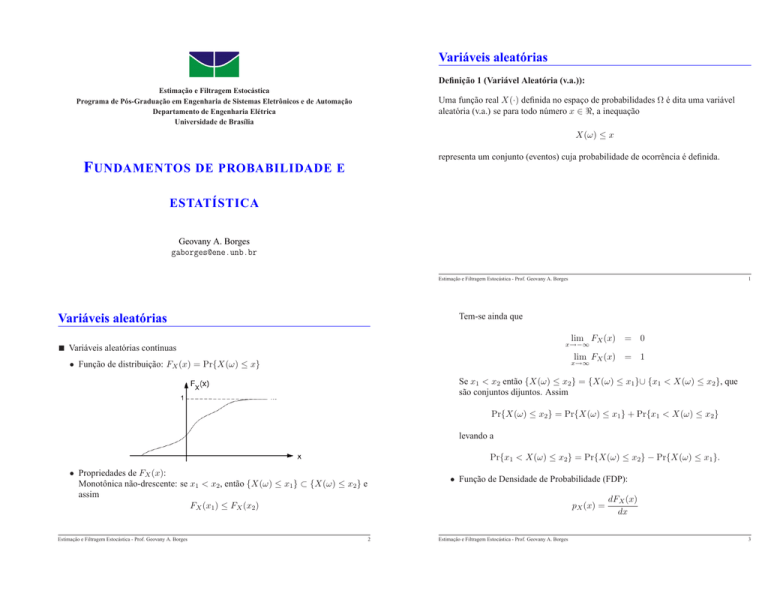

Tem-se ainda que

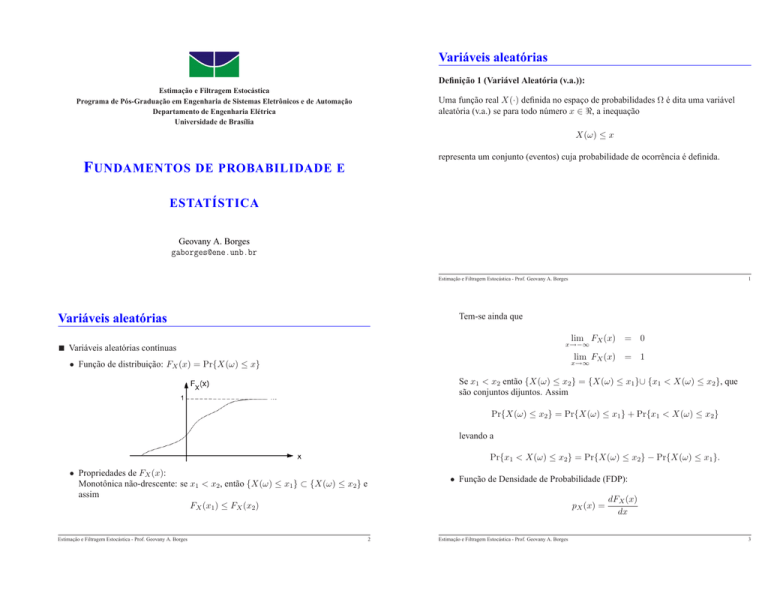

Variáveis aleatórias

lim FX (x) = 0

x→−∞

Variáveis aleatórias contínuas

lim FX (x) = 1

x→∞

• Função de distribuição: FX (x) = Pr{X(ω) ≤ x}

Se x1 < x2 então {X(ω) ≤ x2} = {X(ω) ≤ x1}∪ {x1 < X(ω) ≤ x2}, que

são conjuntos dijuntos. Assim

Pr{X(ω) ≤ x2} = Pr{X(ω) ≤ x1} + Pr{x1 < X(ω) ≤ x2}

levando a

Pr{x1 < X(ω) ≤ x2} = Pr{X(ω) ≤ x2} − Pr{X(ω) ≤ x1}.

• Propriedades de FX (x):

Monotônica não-drescente: se x1 < x2, então {X(ω) ≤ x1} ⊂ {X(ω) ≤ x2} e

assim

FX (x1) ≤ FX (x2)

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

• Função de Densidade de Probabilidade (FDP):

pX (x) =

2

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

dFX (x)

dx

3

Como FX (x) é monotônica não-drescente, então pX (x) ≥ 0.

E ainda

Z x

pX (ξ)dξ

FX (x) =

Variáveis aleatórias

−∞

com

FX (∞) =

Z

∞

Variáveis aleatórias discretas (número contável de valores)

• Função de massa: mX (x) > 0 tal que

pX (ξ)dξ = 1.

FX (x) = Pr{X(ω) ≤ x}

X

=

mX (ξ)

−∞

Tem-se ainda que

pX (−∞) = pX (∞) = 0.

(2)

(3)

ξ≤x

Considerando o intervalo x ≤ X(ω) ≤ x + ∆x, tem-se

Pr{x ≤ X(ω) ≤ x + ∆x} =

≈ pX (x)∆x

Z

x+∆x

pX (ξ)dξ

x

(1)

se ∆x suficientemente pequeno.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

4

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

5

A partir de então, pode-se demonstrar que

Caracterização de variáveis aleatórias

pY (y) = pX (f

Assim

E{X(w)} =

Z

∞

xpX (x)dx

(4)

−∞

• Caso discreto:

E{X(w)} =

X

ξmX (ξ)

(5)

ξ∈Ω

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

E{Y } =

Z

∞

−∞

ypY (y)dy =

Z

∞

(7)

f (x)pX (x)dx

(8)

−∞

– Sendo X = c, com c sendo uma constante, ou seja, pX (x) = δ(x − c), então

E{X} = c.

– Sendo Y = a · g1(X) + b · g2(X), com a e b sendo constantes, então

E{Y } = a · E{g1(X)} + b · E{g2(X)}

• Propriedades:

– Se y = f (x) com f (·) sendo uma função escalar monotônica no intervalo

x1 ≤ x ≤ x2. Tem-se que

Pr{y1 ≤ y ≤ y2} = Pr{x1 ≤ x ≤ x2}.

−1

dy (y)) dx

x=f −1 (y)

Expectância (esperança, média ou primeiro momento)

• Caso contínuo:

−1

(9)

(6)

6

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

7

Caracterização de variáveis aleatórias

Define-se também σ{X} =

Mediana

n -ésimo momento (momento de ordem n )

E{X n} =

Z

∞

med{X} = argxmed FX {xmed} =

Moda: máximos locais da FDP pX (x), ou seja mod{X} deve satisfazer a ambas as

relações abaixo:

n -ésimo momento central (momento central de ordem n )

n

E {(X − E{X}) } =

∞

−∞

1

2

xnpX (x)dx

−∞

Z

p

var{X} como desvio padrão da v.a. X.

∂pX (x) = 0

∂x x=mod{X}

∂ 2pX (x) < 0

∂x2 x=mod{X}

(x − E{X})npX (x)dx

Caso especial: para n = 2 o momento central é chamado de variância

2

var{X} = E{(X − E{X}) }

Se pX (x) tiver apenas uma moda, diz-se que ela é monomodal. Uma FDP com

duas ou mais modas é dita multimodal.

= E{X 2} − E{X}2

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

8

Se pX (x) for monomodal e simétrica com relação à média E{X}, então

med{X} = mod{X} = E{X}.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

9

Distribuições unidimensionais discretas

Distribuição de Bernoulli

Nesta distribuição Ω = {0, 1} representa a ocorrência ou não de um evento. A

função de massa é dada por

mX (x) =

1 − p, x = 0

p,

x=1

(10)

em que p é a probabilidade de ocorrência do evento (x = 1).

Distribuição Binomial

Uma v.a. Y com distribuição Binomial representa a soma de n v.a.s Xk de

Bernoulli com parâmetro p

n

X

Xk .

Y =

(11)

k=1

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

10

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

11

Sendo assim, Ω = {0, 1, 2, . . . , n} e

mY (k) =

com

Distribuições unidimensionais contínuas

n

k

=

n!

k!(n − k)!

n

k

pk (1 − p)n−k

Uma v.a. X de distribuição uniforme com parâmetros b ≥ a possui Ω = [a, b] e

FDP

1

b−a , a ≤ x ≤ b

(12)

pX (x) =

0, caso contrário.

Usada na contagem de eventos.

Distribuição Uniforme

Distribuição Uniforme:

Notação: X ∼ U (a, b).

Uma v.a. discreta uniforme X possui espaço amostral Ω = {a, a + 1, . . . , b − 1, b}

tal que b ≥ a são parâmetros que definem um intervalo e

Tem-se ainda que

mX (k) =

1

b−a+1 ,

0,

k = a, . . . , b

caso contrário.

FX (x) =

Usada quando os elementos de Ω forem equiprováveis.

E{X} =

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

12

Distribuição Normal (ou Gaussiana)

0,

x−a

b−a ,

1,

b−a

2

x<a

a≤x<b

x≥b

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

(13)

(14)

13

em que G (·) é denominada de função de Gauss sendo dada por

2

Uma v.a. X de distribuição Gaussiana com parâmetros µ e σ possui Ω = < e FDP

pX (x) = √

1 (x − µ)2

exp −

.

2 σ2

2πσ 2

1

1

G(u) = √

2π

(15)

2

v

exp −

dv

2

−∞

Z

u

Deve ser observado que sendo G(∞) = FX (∞) = 1, então

2

√

√

v

exp −

dv = 2π · G(∞) = 2π

2

−∞

Z

Notação: X ∼ N (µ, σ 2)

Tem-se ainda que

∞

• Interpretação gráfica da FDP: monomodal e simétrica com relação à média.

E{X} = µ,

E{(X − E{X})2} = σ 2.

A função de distribuição de X é dada por

FX (x) = √

1

2πσ 2

1 (u − µ)2

x−µ

exp −

du = G

2 σ2

σ

−∞

Z

x

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

14

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

15

Exemplo 1 (Transformação afim de uma v.a. Gaussiana):

Distribuições unidimensionais contínuas

N (µX , σ 2X ),

Se X ∼

qual seria a distribuição da v.a. Y = aX + b, sendo a 6= 0 e

b constantes reais? Solução: aplicar a eq. (7).

Distribuição χ2n (Qui-quadrado com n graus de liberdade)

Uma v.a. X de distribuição χ2n com parâmetro n ≥ 1 inteiro possui Ω = [0, ∞) e

FDP

(

xn/2−1

exp(−x/2),

x≥0

2n/2 Γ(n/2)

pX (x) =

(16)

0

caso contrário

com

Z ∞

xu−1 exp(−x)dx,

Γ(u) =

0

u > 0, sendo função Gama. Esta função possui as seguintes propriedades:

Γ(u) = (u − 1)Γ(u − 1) = (u − 1)!

se u é um inteiro e Γ(1/2) =

Notação: X ∼

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

16

Tem-se ainda que

√

π.

χ2n

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

17

Variáveis aleatórias de distribuição conjunta

E{X} = n

var{X} = 2n

Exemplo 2 (Transformação quadrática de uma v.a. Gaussiana):

Se as v.a.s X1, X2, . . . , Xn estão definidas no mesmo espaço Ω, então elas são

ditas de distribuição conjunta com distribuição dada por

FX1,X2,...,Xn (x1, x2, . . . , xn) = Pr{X1 ≤ x1, X2 ≤ x2, . . . , Xn ≤ xn}

Z xn

Z x1 Z x2

pX1,X2,...,Xn (u1, u2, . . . , un)du1du2 · · · dun

···

=

2

Se V ∼ N (0, 1), é uma v.a. de distribuição normal, então W = V é uma v.a. de

distribuição χ21.

−∞

−∞

−∞

com pX1,X2,...,Xn (x1, x2, . . . , xn) sendo a FDP conjunta tal que

pX1,X2,...,Xn (x1, x2, . . . , xn) =

∂ nFX1,X2,...,Xn (x1, x2, . . . , xn)

∂x1∂x2 · · · ∂xn

(17)

Propriedades de FX1,X2,...,Xn (x1, x2, . . . , xn):

FX1,...,Xi,...,Xn (x1, . . . , xi = −∞, . . . , xn) = 0

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

18

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

19

uma vez que Pr{Xi ≤ −∞} = 0.

Variáveis aleatórias de distribuição conjunta

FX1,...,Xn (−∞, . . . , −∞) = 0

FX1,...,Xn (∞, . . . , ∞) = 1

pX1,X2,...,Xn (x1, x2, . . . , xn) ≥ 0

Função de distribuição conjunta de um subconjunto de v.a.s: sendo m < n

FX1,...,Xm (x1, . . . , xm) = FX1,...,Xm,...,Xn (x1, . . . , xm, ∞, . . . , ∞)

Z ∞

Z xm Z ∞

Z x1

···

···

=

pX1,X2,...,Xn (u1, u2, . . . , un)du1du2 · · · dun

−∞

| −∞ {z −∞} −∞

m

|

{z

}

Pr{xa < X1 ≤ xb, X2 ≤ x2, . . . , Xn ≤ xn} =

FX1,X2,...,Xn (xb, x2, . . . , xn) − FX1,X2,...,Xn (xa, x2, . . . , xn)

n

Pr{x1 < X1 ≤ x1 + ∆x1, . . . , xn < Xn ≤ xn + ∆xn} ≈

FX1,...,Xm (x1, . . . , xm) é chamada de distribuição marginal das v.a.s X1, . . . , Xm.

pX1,X2,...,Xn (x1, x2, . . . , xn) · ∆x1 · · · ∆xn

Se n = 2, então tem-se uma distribuição Bivariável

Se n > 2, então tem-se uma distribuição Multivariável

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

20

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

Portanto

Expectância marginal E{Xk }, com 1 ≤ k ≤ n: partindo de

E{Xk } =

Z

∞

−∞

E{Xk } =

Z ∞

Z

···

xk · pXk (xk )dxk

−∞

∞

−∞

xk · pX1,...,Xk ,...,Xn (u1, . . . , xk , . . . , un)du1, . . . , dxk , . . . , dun

=

Z

∞

−∞

Com

∞

−∞

uk · pX1,...,Xn (u1, . . . , un)du1, . . . , dun

Independência: duas v.a.s de distribuição conjunta Xi e Xj , i 6= j, são ditas

independentes se os eventos {Xi ≤ xi} e {Xj ≤ xj } forem indepentes. Isto leva a

(18)

e em conseqüência

pXi,Xj (xi, xj ) =

−∞

du1, . . . , duk−1, duk+1, . . . , dun

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

···

Z

FXi,Xj (xi, xj ) = FXi (xi)FXj (xj )

dFXk (xk )

∂

=

FX ,...,Xk−1,Xk ,Xk+1,...,Xn (∞, . . . , xk . . . , ∞)

pXk (xk ) =

dxk

∂xk 1

Z ∞

Z ∞

=

···

pX1,...,Xk−1,Xk ,Xk+1,...,Xn (u1, . . . , uk−1, xk , uk+1, . . . , un)×

−∞

21

22

∂ 2FXi,Xj (xi, xj )

= pXi (xi)pXj (xj )

∂xi∂xj

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

(19)

23

Variáveis aleatórias de distribuição conjunta

Variáveis aleatórias de distribuição conjunta

Exemplo 3 (Distribuição conjunta bivariável uniforme):

Considerando X e Y v.a.s distribuídas conjuntamente tal que

pX,Y (x, y) =

1

TX TY

0,

, no espaço [0, TX ] × [0, TY ]

caso contrário

V.A.s mutuamente independentes: as v.a.s X1, · · · , Xn são mutuamente

independentes se

n

Y

FXi (xi)

FX1,··· ,Xn (x1, · · · , xn) =

e em conseqüência

determinar as densidades marginais de X e Y e verificar se estas v.a.s são

independentes.

pX1,··· ,Xn (x1, · · · , xn) =

Exercício 1 (Independência de v.a.s Gaussianas):

Considerando X e Y v.a.s gaussianas distribuídas conjuntamente tal que

24

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

=

−∞

∞

Z

−∞

Intuitivamente, se cov{Xi, Xj } 6= 0 existe alguma relação (linear ou não) entre

elas.

Expectância de uma função aleatória multivariável: sendo Y = f (X1, · · · , Xn),

então

Coeficiente de correlação:

ρ(Xi, Xj ) =

y · pY (y)dy

···

Z

∞

−∞

25

com cov{Xi, Xi} = var{Xi}.

Variáveis aleatórias de distribuição conjunta

E{Y } =

(21)

pX1,··· ,Xi (x1, · · · , xi) · pXi+1,··· ,Xn (xi+1 · · · , xn)

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

∞

pXi (xi)

i=1

pX1,··· ,Xi,Xi+1,··· ,Xn (x1, · · · , xi, xi+1 · · · , xn) =

determinar as condições necessárias para que X e Y sejam estatisticamente

independentes.

Z

n

Y

De forma similar, X1, · · · , Xi e Xi+1, · · · , Xn são independentes se

1 36x − y 2 − 9x2 − 36

pX,Y (x, y) = c exp

18

(20)

i=1

(22)

f (x1, · · · , xn)pX1,...,Xn (x1, · · · , xn)dx1 · · · dxn(23)

cov{Xi, Xj }

σ{Xi}σ{Xj }

(25)

tal que −1 ≤ ρ(Xi, Xj ) ≤ 1.

Covariância: se Xi e Xj , i 6= j, são duas v.a.s, define-se a covariância entre elas

como

cov{Xi, Xj } = E{(Xi − E{Xi}) · (Xj − E{Xj })}

(24)

= E{Xi · Xj } − E{Xi}E{Xj }

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

26

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

27

Exemplo 4 (Covariância de v.a.s independentes):

Vetores de variáveis aleatórias

Se Xi e Xj são independentes, demonstrar que

cov{Xi, Xj } = E{Xi · Xj } − E{Xi}E{Xj } = 0

(26)

o que significa que Xi e Xj são não-correlacionadas e portanto

E{Xi · Xj } = E{Xi}E{Xj }

Um vetor aleatório é formado a partir de v.a.s X1, X2, . . . , Xn de distribuição

conjunta, e dado por

X1

X2 T

X=

.. = X1 X2 · · · Xn

Xn

simpificando a notação, a PDF associada é dada por

E ainda, ρ(Xi, Xj ) = 0 se ρ{Xi}ρ{Xj } 6= 0.

pX1,X2,...,Xn (x1, x2, . . . , xn) = pX (x)

xn ]T é um vetor e

em que x =[ x1 x2 · · ·

R

pX (x)dx = 1

Observa-se que pX (x) é um escalar. De forma similar

E{X} =

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

28

Matriz de covariâncias de X:

PX

Portanto,

PX

= E{(X − E{X}) · (X

X1 − E{X1}

X

2 − E{X2 }

= E

.

Xn − E{Xn}

E{X1} E{X2} · · ·

E{Xn}

T

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

29

Vetores de variáveis aleatórias

− E{X})T }

T

· [•]

var{X1}

cov{X1, X2} · · ·

cov{X2, X1}

var{X2}

···

=

..

..

...

cov{Xn, X1} cov{Xn, X2}

Distribuição Gaussiana Multivariada

1

1

−1

T

pX (x) =

exp − (x − E{X}) · PX · (x − E{X})

2

(2π)n/2|PX |1/2

com |PX | sendo o determinande de PX .

cov{X1, Xn}

cov{X2, Xn}

var{Xn}

sendo simétrica uma vez que cov{Xi, Xj } = cov{Xj , Xi} e positiva semidefinida

pois uT PX u ≥ 0 para todo u 6= 0.

• Notação: X ∼ N (E{X}, PX )

• Se os elementos de X forem não-correlacionados, ou seja, cov{Xi, Xj } = 0,

i 6= j, então pode-se mostrar que

pX (x) =

n

Y

i=1

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

30

pXi (xi) =

n

Y

1

1 (xi − E{Xi})2

exp

−

2 var{Xi}

(2π)1/2var{Xi}1/2

i=1

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

31

uma vez que |PX | =

Qn

ι=1 var{Xi }

P−1

X =

1

var{X1 }

0

1

var{X2 }

0

..

0

No mais, se X é Gaussiana, então Y também o será. Para comprovar esta última

afirmação, faz-se necessário determinar pY (y).

• Simulação de uma v.a. Gaussiana multivariável: usando o resultado acima, se

X ∼ N (0, In), com In sendo a matriz identidade de dimensão n, então

Y ∼ N (b, AAT ). Isto significa que, se for desejado obter Y ∼ N (E{Y }, PY ),

então basta escolher

e

..

0

···

···

...

0

0

1

var{Xn }

Neste caso, como X é formado por elementos independentes e de mesma

distribuição (embora de diferentes parâmetros E{Xi} e var{Xi}), diz-se que X

é formado por elementos i.i.d. (independentes e identicamente distribuídos).

• Pode-se verificar que, para A e b sendo contantes tais que dim{A} = m × n e

dim{b} = m × 1 e X sendo uma v.a. de distribuição multivariada, então a

transformação afin

Y = AX + b

(27)

resulta em

E{Y } = AE{X} + b

PY

= APX A

é χ2n. Para verificar este resultado, considera-se a v.a.

tal que

−1/2

PX

=

1/2

P−1

X

=

1/2

PX

simétrica e positiva semidefinida, e

simétrica). Pode-se verificar que

−1

1/2

PX

, uma vez que PX =

(32)

1/2 1/2

PX PX

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

é

q ≤ χ2n(1 − r)

com 1 − r sendo o percentual da distribuição χ2n. Geralmente escolhe-se

1 − r = 0, 95. Consultando a tabela χ2n, montada para valores de 1 − r,

obtem-se [1]

= In

significando que os elementos de U são i.i.d. Gaussianos de média nula e

variância unitária. Por outro lado, Q pode ser decomposta em

Q = UTU =

Ui2

33

q = (x − E{X})T · P−1

X · (x − E{X})

é sua matriz raiz-quadrada (também

n

X

(31)

é comumente usada para testar a hipótese do vetor x pertencer a uma

distribuição N (E{X}, PX ), considerada verdadeira se

E{U } = 0

PU

= PY ,

(30)

Q = (X − E{X})T · P−1

X · (X − E{X})

• A função

− E{X})

T

Para determinar a matriz A tal que eq.(31) seja resolvida, usa-se a fatoração de

Cholesky. Pela fatoração de Cholesky, obtém-se a matriz triangular superior R

tal que PY = RT R. Portanto, tem-se A = RT .

• A variável aleatória

(29)

32

U=

AA

(28)

T

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

−1/2

PX (X

b = E{Y },

(1 − r) = 0, 95 com n = 1 =⇒ χ21(1 − r) = 3, 841

(1 − r) = 0, 95 com n = 2 =⇒ χ22(1 − r) = 5, 991

(33)

(1 − r) = 0, 95 com n = 3 =⇒ χ23(1 − r) = 7, 815

i=1

que é a definição de uma v.a. de distribuição χ2n.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

34

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

35

Vetores de variáveis aleatórias

não considera as incertezas devido às distribuições.

Exemplo 5 (Casamento probabilístico de padrões):

Para todo 1 ≤ k ≤ K, determinar a medida

Existe uma classe de problemas de reconhecimento de padrões que se apresentam da

seguinte forma [2]. Dispõe-se de K vetores de características x1, · · · , xK , cada qual

assumido de distribuição Gaussiana de média E{Xk } e matriz de covariâncias PXk .

Deseja-se verificar qual destes vetores corresponde (com maior probabilidade) a um

vetor de referência y suposto N (E{Y }, PY ). Neste problema, encontrar a boa

correspondência significa determinar o par {xk∗ , y} tal que a distância

(probabilística) xk∗ e y seja a menor.

que segue χ2n. É comum também assumir que a correpondência é verdadeira, e assim

E{Y } = E{Xk }, resultando em

Solução:

e neste caso, esta medida é chamada de Distância de Mahalanobis.

Para todo 1 ≤ k ≤ K, determinar o vetor de diferença

O par {xk∗ , y} de menor distância estatística é aquele cujo índice k ∗ satisfaz a

qk = (εk − E{εk })T · P−1

εk · (εk − E{εk })

−1

qk = (y − xk )T · (PY +PXk )

εk = y − xk

k ∗ = argk min qk

para

q o qual E{εk } = E{Y } − E{Xk } e Pεk = PY + PXk . Pode-se observar que

εTk εk é a distância euclidiana entre y e xk . No entanto, esta métrica de distância

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

e a correspondência será aceita se qk∗ ≤ χ2n(1 − r).

36

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

37

• FDP conjunta: para um dado x = [x1, x2]T

Vetores de variáveis aleatórias

1

com

• Considera-se o caso de uma distribuição Gaussiana com n = 2:

X

=

E{X1} E{X2}

σ 2X1

σ X1 X2

=

2

σ X1 X 2

σ X2

E{X} =

PX

X1 X2

T

q

T

=

(

2

1

x1 − E{X1}

1 − ρ2

σ X1

2 )

x2 − E{X2}

x2 − E{X2}

x1 − E{X1}

+

−2ρ

σ X1

σ X2

σ X2

Fazendo u1 = (x1 − E{X1})/σ X1 e u2 = (x2 − E{X2})/σ X2 , q pode ser

re-escrita como

em que cov{X1, X2} = cov{X2, X1} = σ X1X2 = ρ σ X1 σ X2 . Como PX é

simétrica, ela pode ser decomposta em

1 2

u1 − 2u1u2ρ + u22

q = uT P−1

u u=

2

1−ρ

1 ρ

T

em que u = [u1, u2] e Pu =

.

ρ 1

PX = e1v1v1T + e2v2v2T

com e1 e e2 sendo os autovalores de PX e v1e v2 sendo seus autovetores.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

1

p

pX (x) =

exp − q

2

2

2πσ X1 σ X2 1 − ρ

Distribuição Gaussiana Bivariada

· (y − xk )

38

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

39

• Representação gráfica.

No plano x1× x2, uma forma de representar gráficamente a distribuição

bivariada é por meio da curva de nível correspondentes a uma densidade

constante, ou seja, pX (x) =const. Isto implica em

q=

1 2

u1 − 2u1u2ρ + u22 = c

2

1−ρ

Dado que |ρ| ≤ 1, a eq. (34) corresponde a uma elipse com os seguintes

parâmetros:

– Centro:

E{X} = [E{X1}, E{X2}]T

(35)

– Ângulo com relação ao eixo x1:

(34)

1

θ = arctan

2

com c sendo uma constante cujo significado ficará logo claro.

2ρσ X1 σ X2

σ 2X1 − σ 2X2

!

– Eixos principais : r1 (menor) e r2 (maior)

r12 =

r22 =

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

40

Assim, no plano x1× x2 tem-se abaixo um exemplo com ρ > 0.

cσ 2X1 σ 2X2 (1 − ρ2)

(36)

cσ 2X1 σ 2X2 (1 − ρ2)

(37)

σ 2X2 cos2(θ) − 2ρσ X1 σ X2 sin(θ) cos(θ) + σ 2X1 sin2(θ)

σ 2X2

2

sin (θ) + 2ρσ X1 σ X2 sin(θ) cos(θ) + σ 2X1 cos2(θ)

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

41

Verifique você mesmo: se n = 3, então pX (x) =const. implica em uma

elipsóide.

Exemplo 6 (Elipse 3-sigma de uma distribuição gaussiana bivariada):

Simulação gaussiana bivariada realizada considerando E{X1} = 5, E{X2} = 2 e

diferentes valores de PX .

√

Esta elipse é comumente chamada de “Elipse de incerteza c−sigma”, cujo

interior incorpora uma determinada porcentagem p da distribuição de X.

Pode-se demonstrar que

1

p = 1 − √ c.

(38)

e

√

No caso especial de c = 3, tem-se a chamada elipse 3-sigma, que incorpora

p = 98, 9981% da distribuição de X.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

42

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

43

Probabilidade condicional de variáveis aleatórias

FDP condicional

pX|Y (x|y) ,

Considerando A e B eventos, a probabilidade condicional é dada por

Pr{A|B} =

=

Pr{A ∩ B}

Pr{B}

=

Se associarmos estes eventos a variáveis aleatórias X e Y de distribuição contínua,

pode-se considerar

A = {X ≤ x},

lim Pr{X ≤ x|y < Y < y + ∆y}

Rx

pX,Y (u, y)du

∂FX,Y (x, y) dFY (y)

= −∞

.

∂y

dy

pY (y)

∆y→0

=

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

E{X} =

E{X|Y } ,

xpX|Y (x|y)dx

(43)

=

−∞

E{g(Y )|Y } =

Como E{X|Y } e pX|Y (x|y) são funções da v.a. Y , elas são portanto v.a.s.

(41)

pY |X (y|x)pX (x)

pY (y)

(42)

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

Expectância condicional:

∞

mX,Y (x, y)

mY (y)

Regra de Bayes para FDPs de variáveis aleatórias:

pX|Y (x|y) =

44

Z

pX,Y (x, y)

p

(x, y)dx

−∞ X,Y

mX|Y (x, y) =

(39)

(40)

R∞

No caso discreto:

B = {y < Y < y + ∆y},

com ∆y > 0. Então, pode-se mostrar que

FX|Y (x|y) =

dFX|Y (x|y)

dx

pX,Y (x, y)

pY (y)

Z

∞

45

xpX (x)dx =

−∞

∞ Z ∞

Z

−∞

∞

Z

−∞

= g(Y )

−∞

Z

∞

−∞

x

Z

∞

pX|Y (x|y)pY (y)dydx (48)

−∞

xpX|Y (x|y)dx pY (y)dy = EY {E{X|Y }}

g(Y )pX|Y (x|y)dx

(49)

Z

(50)

∞

pX|Y (x|y)dx = g(Y )

−∞

Propriedades:

pX|Y (x|y) ≥ 0

Z

FX|Y (∞|y) =

pX (x) =

com g(Y ) sendo uma função escalar, ou seja, g(Y ) : <m → <.

(44)

∞

−∞

∞

Z

−∞

pX|Y (x|y)dx = 1

pX,Y (x, y)dy =

= EY {pX|Y (x|y)}

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

Matriz de covariâncias condicional

(45)

Z

∞

pX|Y (x|y)pY (y)dy

(46)

PX|Y = E{(X − E{X}) · (X − E{X})T |Y }

(51)

−∞

(47)

46

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

47

Probabilidade condicional de variáveis aleatórias

Exercício 4 (Distribuição bivariada gaussiana):

Exercício 2 (Condicional de distribuição exponencial):

Considere X, Y vetores de v.a.s Gaussianas dos quais se obtém

Considere X, Y v.a.s cuja distribuição conjunta seja

−y

e

0<x<y<∞

pX,Y (x, y) =

.

0

caso contrário

Z = X + g(Y ).

em que g(.) é uma transformação não-linear. Determine pZ|Y (z|y), E{Z|Y } e

E{(Z − E{Z|Y })(Z − E{Z|Y })T |Y }.

Determine: (i) a fdp marginal de X, (ii) a fdp condicional de Y dado X = x e (iii) a

esperança e variância de Y dado X = x.

Exercício 3 (Distribuição bivariada gaussiana):

Considere X, Y v.a.s Gaussianas cuja distribuição conjunta seja

pX,Y (x, y) =

1

(2x2 − 6xy + 5y 2)

exp −

.

2π

2

Determine pY (y) e pX|Y (x|y). Sugestão: complete os quadrados da função

f (x, y) = (2x2 − 6xy + 5y 2) de forma a obter f (x, y) = g(x, y) + h(y).

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

48

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

Estatística amostral

Esta estimativa é polarizada pois E{P̄X } 6= PX . Pode-se mostrar que

P̄X =

Estimação da média, matriz de covariâncias e FDP de uma v.a. X a partir de M

amostras x1, · · · , xM .

M

1 X

(xi − x̄)(xi − x̄)T

M − 1 i=1

(54)

é uma estimativa não polarizada (chamada de matriz de covariâncias amostral

não-polarizada).

Média amostral:

x̄ =

M

1 X

xi

M i=1

(52)

Esta estimativa é não-polarizada pois E{x̄} = E{X} e consistente uma vez que

Px̄ → 0 com M → ∞.

49

M

1 X

(xi − x̄)(xi − x̄)T

M i=1

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

FDP a partir de histograma

• Caso escalar: dadas amostras x1, · · · , xM , obtém-se um histograma, que nada

mais é que um gráfico do número de amostras pertencentes a intervalos. Os

intervalos possuem espaçamentos ∆x iguais entre os limites

xmin = min(x1, · · · , xM ) e xmax = max(x1, · · · , xM ) :

Covariância amostral:

P̄X =

(53)

xmin, xmin + ∆x, , xmin, · · · , xk−1, xk , · · · , xmax − ∆x, xmax.

com o k-ésimo intervalo sendo dado por [xk−1, xk [. Denomina-se nk o número

50

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

51

de amostras neste intervalo. Assim, tem-se que

inseridas nos intervalos bidimensionais

Ii,j = [x1,i−1, x1,i[×[x2,j−1, x2,j [

nk

M

≈ pX (xk−1)∆x

Pr{xk−1 ≤ X < xk } ≈

para os quais i e j os índices do intervalo nas dimensões 1 e 2, respectivamente.

Denomina-se nIi,j o número de amostras em cada intervalo Ii,j . Assim, tem-se

que

Portanto, pode-se obter uma estimativa para a PDF em pX (xk−1) através de

pX (xk−1) =

Pr{{x1,k−1 ≤ X1 < x1,k }, {x2,k−1 ≤ X2 < x2,k }} ≈

nk

M ∆x

≈ pX (xij = [ x1,i−1 x2,j−1 ]T )∆x1∆x2

Deve-se observar que esta é uma forma não paramétrica da PDF pX (x).

• Caso bivariável: dadas amostras x1, · · · , xM , obtém-se um histograma

bidimensional, que é um gráfico do número de amostras pertencentes a

intervalos em duas dimensões. Os intervalos possuem espaçamento

∆x = [∆x1, ∆x2]T igual entre os limites xd,min = min(xd,1, · · · , xd,M ) e

xd,max = max(xd,1, · · · , xd,M ), para d = 1, 2 (no caso N = 2 é a dimensão da

v.a. amostrada). O histograma é portanto um gráfico de contagens de amostras

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

52

Portanto, pode-se obter uma estimativa para a PDF em pX (xij ) através de

pX (xij ) =

nIi,j

M ∆x1∆x2

• Caso multi-variável: extensão para N variáveis a partir do caso bivariável.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

53

Exemplo 7 (Transformação linear):

Funções de variáveis aleatórias

nIi,j

M

Conceitos básicos: seja Y = g(X) tal que g(X) : <n → <m é um mapeamento de

domínio DX e imagem IY . O problema consiste em determinar a distribuição de Y

a partir da distribuição de X.

Considere Y = aX + b com a, b constantes, e X e Y v.a.s unidimensionais. Sendo

esta função monotônica, pode-se verificar que

y−b

,a > 0

FX ( a )

FY (y) =

)

,a < 0

1 − FX ( y−b

a

1(y − b)

,a = 0

y−b

pX ( a ) a1

1

pY (y) =

−pX ( y−b

a )a

δ(y − b)

,a > 0

,a < 0

,a = 0

em que 1(u) é a função degrau em u = 0, e δ(u) é a função impulso em u = 0. Se

a 6= 0, pY (y) pode ser escrito como

pY (y) = pX (

Este problema resolve-se a partir de

y−b 1

)

a |a|

que é o mesmo resultado obtido pela eq. (7).

Pr{IY } = Pr{CX }

em que CX é o contra-domínio de g(X), determinado a partir de IY e g −1(X)

(função inversa).

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

54

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

55

Exemplo 8 (Transformação quadrática):

• Caso escalar: g −1(Y ) pode ter um ou mais mapeamentos.

Considere Y = X 2 com X e Y v.a.s unidimensionais. Pode-se verificar que CX

somente existe para Y ≥ 0. Neste caso,

IY = {0 ≤ Y ≤ y} =⇒ CX

pX (x1)

pX (xn)

+ ··· + 0

|g 0(x1)|

|g (xn)|

n

X

dg(y) −1

pX (xi) =

dx

x=xi

i=1

pY (y) =

√

√

= {− y ≤ X ≤ y}

Portanto,

√

√

FX ( y) − FX (− y) , y ≥ 0

0

, caso contrário.

1 √ √

√

,y ≥ 0

2 y pX ( y) + pX (− y)

pY (y) =

0

, caso contrário.

FY (y) =

(55)

(56)

em que x1, · · · , xn são as soluções para a variável x em g −1(y) = x.

Exercício 5 (Transformação escalar raiz-quadrada):

Considere Y = X 1/2 com X e Y v.a.s unidimensionais. Sendo X ∼ N (µ, σ 2X ) com

parâmetros µ e σ 2 tais que Pr{X ≤ 0} ≈ 0. Determinar pY (y).

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

Determinação direta da FDP

56

Determinação direta da FDP

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

57

em que as funções gi(x) são obtidas de g(x)

g1(x)

..

.

g(x) =

gn(x)

• Caso vetorial com g(X) monotônica, g(X) : <n → <n. (atenção: X e Y são

de mesma dimensão)

pY (y) = pX (g −1(y)) det(J−1)

=

pX (g −1(y))

|det(J)|

(59)

Exemplo 9 (Conversão coordenadas cartesianas em coordenadas polares):

(57)

Considere um ponto P de coordenadas cartesianas (X, Y ) tal que X ∼ N (x0, σ 2) e

Y ∼ N (y0, σ 2) são independentes. Determinar a fdp conjunta das coordenadas

polares de P. Quais as distribuições marginais de tais coordenadas?

com det(J−1) = 1/ det(J) e J sendo a Jacobiana da transformação, de

dimensão n × n, dada por

J=

∂g1 (x)

∂x1

..

∂gn (x)

∂x1

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

···

∂g1 (x)

∂xn

···

∂gn (x)

∂xn

..

(58)

x=g−1 (y)

58

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

59

Propagação de incertezas

Propagação de incertezas

Definição do problema: determinar a média e a matriz de covariâncias da v.a.

• Simulação de Monte Carlo:

Gera-se S amostras {xi}Si=1, das quais obtém-se yi = g(xi). Assim, estimativas

para a média e matriz de covariâncias de Y são dadas por

Y = g(X)

em que X é uma v.a. de média E{X} e matriz de covariâncias PX . Nesse caso,

g(X) : <n → <l em que não necessariamente l = n.

S

E{Y } ≈ ȳ =

Solução fechada para g(X) = AX + b:

E{Y } = AE{X} + b

PY

Aproximações para g(X) sendo uma função não-linear

PY ≈ P̄Y =

T

= APX A .

1X

yi

S i=1

S

1 X

(yi − ȳ)(yi − ȳ)T

S − 1 i=1

(60)

(61)

Observa-se que nada é necessário ser afirmado sobre a distribuição de Y ou de X.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

60

• Aproximação de primeira ordem (linearização):

Se g(x) for sufientemente suave em torno do suporte da distribuição de X,

pode-se mostrar que sendo X gaussiano, Y será aproximadamente gaussiano.

Para demonstrar isto, conseidera-se a seguinte parametrização de

X ∼ N (E{X}, PX }:

E{Y } ≈ g(E{X})

!

∂g(u) PX

PY ≈

∂u u=E{X}

com ∆X ∼ N (0, PX }. Por expansão em série de Taylor, truncada em primeira

ordem,

= E{Y } + ∆Y =

= g(E{X} + ∆X ) ≈ g(E{X}) +

61

gaussiana ∆X . Pode-se então obter

X = E{X} + ∆X

Y

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

!T

∂g(u) ∂u u=E{X}

• Propagação implícita:

Técnica proposta em [3] para estimação de matriz de covariâncias de parâmetros

estimados por minimização de função de custo. A ser detalhado mais à frente no

curso.

∂g(u) ∆X

∂u u=E{X}

Então, Y é aproximadamente obtido por uma transofmação afim sobre a v.a.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

62

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

63

• Unscented Transform (UT):

Forma simplificada da simulação de Monte Carlo em que são geradas amostras

consideradas relevantes de X.

S−1

Em suma, de acordo com [4], gera-se S = 2n + 1 amostras {xi}i=0

(ou

também denominados de pontos-sigma) segundo as regras abaixo:

E{X},

q

n

P

E{X}

+

X

1−w

0

xi =

q

i

n

P

E{X} −

X

1−w0

A partir dos ponto-sigma obtém-se yi = g(xi). As estimativas para a média e

matriz de covariâncias de Y são dadas por

para i = 0

para i = 1, . . . , n

PY ≈ P̄Y =

para i = n + 1, . . . , 2n

64

Gerador de números aleatórios: algoritmo que gera amostras

x1, x2, x3, . . .

(63)

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

65

K = 231 − 2

– Gerador com K0 ≈ 230

a = 1103515245

Geradores de distribuições uniformes

– Gerador U (0, 1):

• Fórmula genérica de geradores lineares congluentes:

xi =

xi = (a · xi−1 + b) mod(K + 1)

b = 12345

K = 232 − 1

a · xi−1 + b

mod(1)

K +1

de onde verifica-se que os geradores funcionam se a seqüência discreta

que gera números com as seguintes propriedades:

I. Valores gerados entre 0 e K.

II. K é um número primo muito grande

III. xi é uma seqüência periódica, com periodicidade K0 ≤ K

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

wi(yi − ȳ)(yi − ȳ)T

Simulação propagacao incertezas para avaliar a escolha entre raiz quadrada

matricial e decomposição de Cholesky na propagação pela UT com diferentes

valores de PX .

de uma v.a. X a partir de pX ou de FX .

i=0

IV. x0 é chamado de semente do gerador

V. a, b e K devem ser bem escolhidos

• Alguns geradores:

– Park & Miller:

a = 75

b=0

Geração de números aleatórios

(62)

i=0

Exemplo 10 (Propagação em um caso de distribuição gaussiana bivariada):

i−n

em que (·)i é um operador que corresponde à i-ésima coluna da matriz

√

argumento. Deve ser observado que é a raiz quadrada matricial, sendo que em

alguns casos usa-se também a decomposição de Cholesky.

0

Associado a cada ponto-sigma tem-se um peso wi = 1−w

2n para i 6= 0, e w0 é um

parâmetro de entrada. Supondo-se que a distribuição de X seja Gaussiana, de

acordo com [4] recomenda-se w0 = 31 .

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

S−1

X

S−1

X

wiyi

E{Y } ≈ ȳ =

xi =

a

b

· xi−1 +

K +1

K +1

for instável.

66

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

67

média e variância de Y são dados por

Geradores de distribuições não-uniformes

• Método da inversa generalizada

Sendo FX (x) uma função de distribuição, define-se a inversa generalizada como

sendo

E{Y } = Ȳ =

Portanto, para se obter uma amostra xi da distribuição FX , utiliza-se o seguinte

algoritmo:

I. Gera-se u ∼ U (0, 1)

−1

II. Obtem-se uma amostra xi = FX

(u)

• Gerador normal usando o teorema do limite central

Pelo teorema do limite central, a soma

m

X

68

Assim, se for de interesse gerar Z ∼ N (0, 1) basta fazer

(Y − m/2)

Z= p

m/12

pX (x) =

m

X

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

69

si =

i

X

ωj

j=1

III. Como resultado, obtém-se uma amostra de pi(x)

NãoP

seria a mesma coisa se fossem gerados xi ∼ pi(x) e a amostra final dada

m

por i=1 ω ixi?

ω ipi(x)

i=1

com pi(x) sendo FDP da qual pode-se gerar amostras e

m

X

que se torna fácil de resolver se m = 12.

com

• Método da mistura

Se a FDP de X puder ser escrita sob a forma

i=1

m m

Y ∼ N( , )

2 12

i=1

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

σ 2Xi

Sendo Xi ∼ U (0, 1), obtém-se Ȳ = m/2 e σ 2Y = m/12. Com m → ∞, pelo

teorema do limite central obtém-se

Xi

com os Xi sendo i.i.d., tende a uma distribuição Gaussiana quando m → ∞. A

E{Xi}

i=1

m

X

E{(Y − E{Y })2} = σ 2Y =

−1

FX

(u) = inf {x; FX (x) ≥ u}

Y =

m

X

ωi = 1

i=1

de foma a satisfazer FX (∞) = 1. De posse deste modelo, uma amostra de

pX (x) é obtida da distribuição pi(x) com probabilidade ω i. Ou seja, segue-se o

seguinte algoritmo

I. Gera-se u ∼ U (0, 1)

II. Determina-se o índice j que satisfaz a

si−1 ≤ u ≤ si

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

70

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

71

• Método da amostragem por rejeição (rejection sampling)

Considera-se o caso de pX (·) ser uma fdp da qual se deseja obter amostras. Seja

pA(·) uma fdp auxiliar da qual obtém-se amostras mais facilmente, e uma

constante M tal que

pX (x) ≤ M pA(x)

Observa-se que as áreas sobre as curvas se relacionam por

Área{M1p1(x)}

Área{pX (x)}

Algoritmo de amostragem:

I. Gera-se x ∼ pA e u ∼ U (0, 1)

II. Se

Por exemplo, sendo p1 gaussiana e p2 uniforme:

= M1

pX (x)

≥u

M pA(x)

então x deve ser aceito como amostra de pX (·). Caso contrário, retornar ao

passo 1.

Exemplo 11 (Simulação de números aleatórios):

Ver simulação geradores aleatorios.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

72

Referências

[1] MEYER, P. Probabilidade - aplicações à estatística. Segunda edição. [S.l.]: Livros

Técnicos e Científicos (LTC), 2003.

[2] DUDA, R. O.; HART, P. E.; STORK, D. G. Pattern Classification. 2nd. ed. [S.l.]:

Wiley Interscience, 2000.

[3] HARALICK, R. Propagating covariances in computer vision. In: International

Conference on Pattern Recognition. [S.l.: s.n.], 1994. p. 493–498.

[4] JULIER, S. J.; UHLMANN, J. Unscented filtering and nonlinear estimation.

Proceedings of the IEEE, v. 92, n. 3, p. 401–422, 2004.

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

74

Estimação e Filtragem Estocástica - Prof. Geovany A. Borges

73