1

1. Introdução.

Este trabalho tem como objetivo apresentar o tema das Radiações Ultravioleta e Seus Efeitos

na Saúde Humana, numa tratamento de divulgação científica, estabelecendo sempre que

possível uma relação de interdisciplinaridade. A elaboração desta monografia, tal qual

documentação contendo elementos tratados em produção de material didático, também

agrega a utilização das ferramentas e aplicativos de internet, trabalhadas na disciplina

tecnologias de ensino, todas estas aplicadas em mídia eletrônica, pensamos poder permitir

expandir a potencialidade da divulgação científica. A divulgação científica é, também, uma

forma de desmistificar as Ciências permitindo popularização do conhecimento científico,

utilizando multimeios. Segundo Cáudio Zaki Dib; “Sistemas de multimeios: área

interdisciplinar de pesquisa e desenvolvimento. A utilização de tecnologia da educação na

aprendizagem de física adquire excepcional importância no momento em que a sociedade

requer, mais do que nunca, ensino eficiente de física que possa ser oferecido a um elevado

número de pessoas”

(1)

pg203.

O tema escolhido, a ser abordado, foi o de Radiação Ultravioleta e Seus Efeitos na Saúde

Humana, sendo um assunto importante, atual e tendo como preocupação fundamental

disponibilizar informações técnicas, orientações, riscos e cuidados sobre os efeitos da

radiação na saude. A natureza física da radioatividade e das radiações foram estudadas em

efeitos biológicos das radiações ionizantes e não-ionizantes que serão aqui abordadas para

apresentar os princípios físicos necessários. Estes princípios físicos básicos sobre a natureza

da radiação são considerados didaticamente necessários pois, nosso público alvo será aberto,

sendo que disponibilizado nosso material a todos os interessados, independente de seu nível

de conhecimento sobre o tema abordado. Nosso material informativo poderá ser acessado

entre pessoas leigas e até colaboradores especializados no tema.

A motivação que envolve a elaboração deste trabalho atenta para o fato de que nos dias de

hoje, estamos imersos em um mar de campos e radiações. Divulgar a natureza das radiações,

2

noções sobre seus princípios físicos e a preocupação aos danos causados à saúde humana,

justificada pelos problemas causados, especificamente, pela radiação ultravioleta, natural ou

artificial. O Sol nossa principal fonte de energia e de vida é também fonte de radiação com

diversos comprimentos de onda, inclusive, como fonte natural, a radiação UV aqui estudada.

A radiações UV pode ser produzida artificialmente, tais como a utilizada nas câmaras de

bronzeamento artificial, ou nos ambientes de produção das diversas indústrias e fornecedores

de equipamentos de solda.

Ampliar a potencialidade da divulgação de informação de forma a atingir um maior publico

não é tarefa simples, porém, pensamos estar indo além da publicação de um documento

escrito e publicado de forma estática, sem interação com o leitor, na qualidade de um

compêndio disponibilizado em uma biblioteca ou como uma página truncada em um site de

internet. Na Internet os aplicativos de publicação, como o WordPress, que disponibilizam

entre seus recursos de interação a criação de Blog, é em sí um recurso que

interdisciplinaridade, porque os interlocurores, praticamente,

opera a

estarão abordando o tema

central com toda amplitude de um diálogo. Esta possibilidade de mão-dupla, dando interação

entre os o curador do site e seus usuários, ou também entre os próprios usuários do site.

Deste modo ao utilizarmos este meio de comunicação, esperamos provocar transformações

positivas na dinâmica da divulgação científica.

Estas ferramentas e aplicações disponíveis para a internet, estão disponíveis sob a forma de

software gratuito e livre, o que amplia a possibilidade de uso por ter seu custo inicial nulo.

Acreditamos que estas potencialidades possam ser exploradas colaborativamente na

construção de alternativas para a divulgação científica, ampliando e disponibilizando

informação e fomento ao conhecimento para um crescente número de pessoas.

Embora não estejamos explorando e implementando neste trabalho dicionários dinâmicos de

linguas, vale lembrar que é uma facilidade que merece destaque, a possibilidade de interação

e leitura do conteúdo disponibilizado na forma de divulgação científica, pode estar sendo

3

lida e recebendo interação em outro idioma, já que pela internet atualmente é oferecido como

potencialidade de âmbito global ferramenta tradução dinâmica do idioma local, e da

composição em outros boxes. Certamente com a disponibilidade atual de diversos recursos

em mídias eletrônicas, poderemos encontrar meios complementares que oferecem melhor

eficiência aos canais de comunicação, não broadcast, como recurso para divulgação

científica.

No âmbito da utilização do conceito de interdiciplinaridade, tão discutida e teorizada nos

meios acadêmicos, mas muito pouco percebida de maneira clara, como prática, vai aqui uma

tímida abordagem do conceito. Desta forma, aqui se pretende uma abordagem prática

simplificada que possa caracterizar alguns aspectos de prática catalizadora dos

conhecimentos adquiridos nas multiplas disciplinas frequentadas. Algumas destas disciplinas,

com ênfases diferentes, buscam dar um contexto universalidade ao conhecimento e

concomitantemente formar um cidadão com competências nas suas àreas e habilidades para a

pesquisa, produção e divulgação de temas de interesse pela sociedade.

2. A ESTRUTURA DA MATÉRIA.

Durante a história do Homem muitos pensadores e filósofos se ocuparam com a natureza das

coisas, da matéria e da vida. Muitas foram as explicações e os modelos que os pensadores e

cientistas elaboraram para explicar o funcionamento na natureza. O conhecimento atual é

produto da contribuição destes ilustres pesquisadores e da evolução de suas idéias e modelos

resultou no vasto conhecimento que, hoje, detemos a respeito da matéria, sua composição e

suas formas de manifestação. Hoje aceita-se que todas as coisas materiais existentes na

natureza são constituídas de átomos ou de suas diversas possibilidades de combinações, as

moléculas. Os átomos por sua vez, agora, são divisíveis em partículas ainda menores, e estas,

dependendo da sua interação e relação com o meio, podem apresentar natureza corpuscular

ou natureza ondulatória, que são mutuamente excludente, na sua forma de manifestação (de

4

Broglie 1924). O conjunto de átomos diversos, ligados a outros átomos irão compor as

moléculas que assim apresentam as propriedades não só de um elemento químico, mas irão

compor todas as formas de manifestação da matéria na natureza.

Já obtvemos evidências experimentais da existência de anti-matéria, inicialmente pela

partícula antí-elétron, proposta por Dirac, o pósitron. Experimentos nos grandes aceleradores

e observações de interações dos raios cósmicos mostraram a aniquilação de pares de elétronpósitron dando origem à um fóton.

Isto posto, faremos uma breve incursão por alguns temas da física os quais servirão como

referencia para melhor compreendermos o tema objeto deste trabalho.

2.1. O ÁTOMO.

O átomo depois de ter sua concepção divulgada pelos cientistas atomistas, inicialmente com

relutância, foi aceita pela comunidade cienfica da época (Thompson 1904, Bohr 1913). A

estrutura de um átomo, no conceito da mecânica clássica, como descrito no modelo de Bohr

para o átomo de Hidrogênio, levou em conta os resultados obtidos por Plank, Einstein e

Rutherford e era compatível com os espectros observados. O elétron se move, sob ação das

forças coulombiana do núcleo positivo em órbitas circulares ou elípticas sendo estas

semelhante ao do Sistema Solar.(4)pg.28

O modelo de Bohr do átomo nuclear em 1913, e a descoberta do nêutron em 1932, tornou

claro que o átomo e mesmo o núcleo era composto por partículas menores, influenciando

interpretações e representações do modelo do átomo (figura 10), consistindo em um núcleo,

onde fica concentrada a massa, análogo ao Sol e que estará com carga elétrica positiva, e

partículas diminutas em relação ao núcleo, estes girando em seu redor, em órbitas circulares,

por simplicidade de representação,

denominadas elétrons que tem carga elétrica negativa,

neste nosso modelo, por analogia, seriam equivalentes aos planetas. Como no Sistema Solar,

o átomo possui grandes espaços vazios entre seus constituintes, que podem ser atravessados

5

por partículas menores do que ele. Após o modelo do “Pudim de passas” proposto por

J.J.Thomson, do modelo planetário de Rutherford, para o qual sabia-se que haviam falhas

devido ao movimento acelerado do elétron na sua órbita emitindo radiação e de acordo com a

teoria do eletromagnetismo de Maxwell, perdendo energia , assim, seu raio diminuiria

fazendo com que o elétron colidisse com o núcleo. Todas estas descobertas associadas

resultaram em reformulações do modelo de Thomson, Rutherford e Bohr para o átomo.

Atualmente, sabemos que o átomo não é indivisível e também não é a menor parte estrutural

da matéria, pois a física moderna comprovou que o àtomo é divisível e, além, demonstrou a

existência de diversas outras partículas, tais como os quarks e anti-quarks. Na mecânica

quântica já se demonstra a natureza corpuscular e ondulatória destas partículas fundamentais.

O cientista Louis Victor de Broglie, em 1923, propôs a natureza ondulatória das partículas

(matéria). A expressão matemática, por ele proposta foi, 𝜆 =

ℎ

𝑚𝑣

, pela qual recebeu o prêmio

Nobel em 1929. “...because photons have wave and particle characteristics, and electrons

have particle caracteristics and properties typical of waves, perhaps all forms of matter have

wave as well as particle properties. ”(3)pg818. Experimentos de difração, realizadas com

feixe de eletrons, comprovaram seu comportamento ondulatório.

.

Figura 10- Analogia entre a estrutura Atômica e o Sistema Solar.

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia

6

2.2. ESTRUTURA DO NÚCLEO.

O núcleo do átomo é formado núcleons, basicamente, por partículas de carga positiva,

chamadas prótons, e de partículas de aproximadamente mesma massa e mesmas dimensões,

porém sem carga elétrica, denominadas neutrons (figura 11).

Figura 11: Elementos químicos naturais

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia.

Os Próton e Nêutron que compõe o do núcleo são também compostos de outras partículas, os

quarks. Os quarks, aceita-se hoje, são os componentes primordiais da matéria. Eles possuem

diversas propriedades, entre elas carga e spin, estas combinadas em certo número dão origem

as outras partículas. Por exemplo os Barions, Prótons são formados por dois quarks-U e um

quark-D e os Nêutrons por são formados por dois quarks-D e um quark-U (3)pg919.

O número de prótons, indica o número atômico (Z), que identifica um elemento químico,

comandando seu comportamento em relação aos outros elementos.

O elemento natural mais simples, o hidrogênio, possui apenas um próton; um dos mais

complexos, o urânio, tem 92 prótons, sendo um dos elementos químicos natural mais pesado,

que assume grande importância nos estudos do núcleo.

Quanto mais prótons um átomo possuir em seu núcleo, maior a densidade de energia que ele

comporta. A energia está dito de forma simplista armazenada nas ligações nucleares que

mantém o núcleo coeso. Seria impossível manter o núcleo, geralmente, estável sendo seus

constituintes, prótons, possuidores de cargas idênticas (positivas), “separadas”, em alguns

7

casos, os de Z menores, por neutrons, se somente a força columbiana agisse entre estas

partículas. Sabemos que a força eletrostática entre cargas de mesmo sinal é repulsiva.

No interior do núcleo, prótons e nêutrons, os núcleons, As interações nucleares forte e fraca,

também conhecida como força hadrônica, é muito mais intensa do que a força columbiana,

porém tem um raio de ação muito reduzido quando comparado às forças eletrostáticas. A

interação nuclear forte tem aproximadamente a mesma intensidade entre dois prótons, entre

um próton e um nêutron.

Estas forças, como mencionamos, são responsáveis pela estabilidade do núcleo, são

favorecidas quando o número de prótons e nêutrons são aproximadamentes iguais. Com a

presença de maior números de nêutrons a estabilidade seja favorecida (Figura-12), este fato é

de relevada inportância quando se estuda o decaimento nuclear.

Percebemos que quanto mais pesado for o átomo, número A grande, existirá uma tendência

de ocorrer a presença de um maior número de nêutrons do que de prótons. No caso de

núcleos mais pesados, geralmente com Z > 55 (ferro), haverá uma maior instabilidade

causada pela energia de repulsão eletrostática entre os prótons (proporcional à Z2). Nos

elementos com Z< 55 a força repulsiva é minimizada pela igual presença de nêutros e

prótons (4)pg126.

Outro fato importante à saber é que a massa de um núcleo é menor do que a massa de seus

constituíntes, isto é evidência de que parte da massa dos núcleos átomicos que se associam

em um processo de fusão para compor um novo núcleo estará sendo convertida em energia e

liberada. A diferença entre as massas inicial e final, ou seja, Δ𝐸/𝑐 2 corresponde ao total da

energia liberada. Assim, em um processo de fissão, para desintegrar um núcleo, é preciso

fornecer energia ao sistema e essa energia precisa ser igual ou maior do que a energia de

ligação para que ocorra a fissão.

8

Figura 12: Gráfico de estabilidade dos Núcleos

Fonte: Introdução à Física Atômica e Nuclear.Oldenberg&Holladay.

2.3. AS MOLÉCULAS.

As móléculas são conjuntos de átomos ligados, na sua manifestação mínima, estarão

caracterizando uma dada substância. Dependendo de como estas ligações variem o seu

arranjo, as moléculas que estarão sendo formadas poderão estar caracterizando as diversas

substâncias básicas que formam os corpos materias que nos rodeiam. A suposição de que

quandos os átomos se combinam os núcleos permanecem inalterados é correta, esta é a

explicação do porque a massa se conserva nas reações químicas. Outras características nas

reações químicas se alteram pela reação química, sendo as ligações químicas entre átomos

adjascentes que compõe moléculas complexas. As possíveis ligações entre átomos (iônicas,

covalentes) são determinadas pela polaridade, eletronegatividade e saturação de valência

9

entre os átomos que compões mesmo as moléculas mais simples. Estas diversas

possibilidades de se fazer as ligações entre os elétrons de valência dos átomos formando as

moléculas também determinam a estrutura geométrica que estas moléculas ganham forma.

No caso dos elétrons compartilhados em moléculas, estes deixam de pertencer, num dado

momento, à um único átomo e passam a pertencer aos orbitais moleculares. Basicamente, a

teoria dos orbitais moleculares admite que, quando as moléculas são formadas, os elétrons

mais externos não ocupam mais os níveis de energia que ocupavam nos átomos isolados.

Estas características são, de certa forma, responsáveis pela formação de cadeias longas de

moléculas compostas pelos memos elementos atômicos, que se agrupam em diferentes

quantidades (5)pg73.

Figura 13: Molécula tetraédricade CH4

Fonte: Química, Sienko e Plane.

2.4. OS ISÓTOPOS E AS EMISSÕES RADIOTIVAS

Como o nome indica (isos = mesmo; topos = lugar), os isótopos ocupam o mesmo lugar na

classificação periódica dos elemento e possuem obrigatoriamente o mesmo número de

prótons, mas o número de neutrons no núcleo pode ser variável, pois eles não têm carga

elétrica. Com isso, um mesmo elemento químico pode ter massas diferentes átomos de um

mesmo elemento químico com massas diferentes são denominados isótopos.

10

O hidrogênio tem 3 isótopos: o hidrogênio, o deuterio e o trício (ou trítio) (figura12). As

emissões primárias de Matéria e Energia que são emitidos pêlos radionucleidos que serão

discutidos são a radiação alfa, beta e gama.

Figura 12: Elementos atômica do Hidrogênio, Deuterio e o Trítio

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia

2.5. PARTÍCULAS, ONDAS ELETROMAGNÉTICAS E FÓTOS.

Conforme foi descrito as radiações nucleares podem ser de dois tipos:

a) partículas, possuindo massa, carga elétrica e velocidade, esta dependente do valor de sua

energia;

b) ondas eletromagnéticas, que não possuem massa e se propagam com a velocidade de

300.000 km/s, para qualquer valor de sua energia. São da mesma natureza da luz e das ondas

de transmissão de radio e TV. A identificação desses tipos de radiação (fig. 16) foi feita

utilizando-se uma porção de material radioativo, com o feixe de radiações passando por

entre duas placas polarizadas com um forte campo elétrico. O feixe defletia para a esquerda

ou direita dependendo da natureza de sua carga elétrica, que sofria repulsão pela placa de

sinal oposto e atração pela placa de sinal de carga contrário. Já aquelas que não sofriam

deflexão eram vistas com neutras quanto a sua carga, até mesmo sem massa, como era o caso

das radiações gama. A natureza destas partículas que não sofriam interação com o campo

eletromagnético era também eletromagnética.

Einstein estudando a luz, além de propôr o efeito fotoelétrico, conceituou o fóton como

pacote de energia eletromagnética. Segundo a teroria de Einstein a onda eletromagnética

11

transporta energia em pequenos pacotes de energia (E), que possuem frequência () e

comprimento de onda () e utilizando a sua equação de energia pode-se determinar a energia

de cada fóton, como segue;

𝐸 = ℎ𝜈 = ℎ

𝑐

𝜆

Mais tarde o efeito foi comprovado, estudado e quantificado como pacotes de interação da

luz sobre superfícies metálicas em válvulas termoiônicas.

Figura 16: Caracterização das radiações utilizando duas placas polarizadas.

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia

2.4. ATIVIDADE DE UMA AMOSTRA

Os núcleos instáveis de uma mesma espécie (mesmo elemento químico) e de massas

diferentes, denominados radioisótopos, não realizam todas as mudanças ao mesmo tempo.

As emissões de radiação são feitas de modo imprevisto e não se pode adivinhar o momento

em que um determinado núcleo irá emitir radiação.

Entretanto, para a grande quantidade de átomos existente em uma amostra é razoável esperarse um certo número de emissões ou transformações em cada segundo. Essa taxa de

transformações é denominada atividade da amostra.

Como foi visto, um núcleo com excesso de energia tende a estabilizar-se, emitindo partículas

alfa ou beta. Em cada emissão de uma dessas partículas, há uma variação do número de

12

prótons no núcleo, isto é, o elemento se transforma ou se transmuta em outro, de

comportamento químico diferente.

Essa transmutação também é conhecida como desintegração radioativa, designação não

muito adequada, porque dá idéia de desagregação total do átomo e não apenas da perda de

sua integridade. Um termo mais apropriado é decaimento radioativo, que sugere a

diminuição gradual de massa e atividade.

2.5. MEIA-VIDA (P)

É o período de tempo necessário para que a metade dos átomos presentes num elemento

radioativo, seja natural ou obtido artificialmente se desintegre (se transmute ou decai). O

tempo de meia vida é uma característica de cada isótopo radioativo e não depende da

quantidade inicial do isótopo nem de fatores como pressão e temperatura.

Para se acompanhar a duração (ou a vida) de um elemento radioativo foi preciso estabelecer

uma forma de comparação. Por exemplo, quanto tempo leva para um elemento radioativo ter

sua atividade reduzida á metade da atividade inicial ? Esse tempo foi denominado meia vida

do elemento.

Figura 17: Gráfico de decaimento radioativo (meias-vidas)

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia.

Após o primeiro período de meia-vida, somente a metade dos átomos radioativos originais

permanecem radioativos. No segundo período, somente 1/4 , e assim por diante (figura 17).

Alguns elementos possuem meia-vida de frações de segundos. Outros, de bilhões de anos.

13

O número de mols de átomos não desintegrados pode ser calculado pela seguinte relação:

n= n0/2x

onde:

n0 = nº inicial de mols

n = nº final de mols

x= nº de períodos de meia vida.

O tempo de decaimento ou transmutação radioativa pode ser calculado:

t=x.P

3. PRINCÍPIOS BÁSICOS DE ELETROMAGNETISMO.

Quando uma onda mecânica passa por um ponto, a partícula que se encontra nesse ponto

oscila com a mesma freqüência (f) e o mesmo período (T) da onda. No caso da onda

eletromagnética são os campos elétrico e magnético que aumentam e diminuem

periodicamente suas intensidades, ora no sentido positivo, ora no sentido negativo (por

analogia com as ondas mecânicas, diz-se que os campos oscilam). Para ilustrar esse fato,

considera-se uma onda senoidal de período T e fixa-se a atenção no comportamento do

campo elétrico ( E ), num ponto P atingido por essa onda (esqueça-se provisoriamente o

campo magnético). Para tanto, escolhemos o instante t = 0 como sendo um instante em que

|E| = 0 .

O comportamento de B é semelhante ao de E : ambos oscilam com o mesmo período, em

fase, mas em direções perpendiculares. A figura 18, ilustra a partícula (elétron) oscilando

entre um máximo positivo e uma máximo negativo, com uma correspondente variação

simultânea dos campos E e B num ponto P, pelo qual passa uma onda eletromagnética.

14

Fig. 18: Plano eletromagnético.

Fonte: Física 3 – Halliday, D.; Resnick, R.. e Krane, K..S.

A direção de propagação de uma onda eletromagnética é simultaneamente perpendicular as

direções de oscilação de E e B , isto significa que as ondas eletromagnéticas são sempre

transversais.

Sendo v a velocidade de propagação de uma onda eletromagnética, os vetores v , E e B

devem ter, a cada instante (que não seja um instante em que E e B se anulam), sentidos tais

que obedeçam a regra da mão esquerda representada na figura abaixo.

Fig. 2: Regra da mão esquerda

Fonte: Física 3 – Halliday, D.; Resnick, R.. e Krane, K.S.

Ondas eletromagnéticas se propagam no vácuo e, dependendo do caso, também em meios

materiais. Nesse ponto diferem das ondas mecânicas, as quais não se propagam no vácuo.

Considera-se uma onda eletromagnética de freqüência f, que se propaga com velocidade v

em um meio qualquer. Sendo λ o seu comprimento de onda, do mesmo modo que para as

ondas mecânicas, temos:

v f

15

Um dos resultados de maior importância obtidos por Maxwell, a partir de sua teoria sobre as

ondas eletromagnéticas, foi a determinação do valor da velocidade de propagação dessas

ondas. Ele deduzir que no vácuo (ou no ar), uma onda eletromagnética deveria se propagar

com: v = 300.000 km/s.

Como, naquela época, a velocidade da luz no ar já havia sido determinada

experimentalmente com boa precisão, Maxwell percebeu, com grande surpresa, que: a

velocidade de propagação de uma onda eletromagnética coincidia com a velocidade da luz.

Esta constatação levou o cientista a propor a seguinte idéia: a luz deve ser uma onda

eletromagnética. Experiências posteriores confirmaram a hipótese de Maxwell unificando a

óptica e a eletricidade.

Sabemos que uma carga elétrica em repouso produz um padrão de linhas de campo elétrico, e

ao ser colocada em movimento, em velocidade constante aparecem também linhas de

campo magnético. Estabelecida uma condição estável no movimento, definido o espaço (S),

nota-se associado aos campos elétrico (E) e magnético (B) uma dada densidade de energia,

ou melhor há evidências de sua presença, nenhum sinal, radiação eletromagnética, transporte

de energia ou momento pode ser observado transportando a carga de um dado ponto a outro,

em outras palavras uma carga em movimento uniforme produz uma corrente elétrica (i) que

não varia no tempo (fig. 19).

Fig. 19:Fluxo de cargas no condutor = corrente.

Fonte: Principles of Phisics – Serway, R.A.

16

Porém, ao condicionarmos a carga a um movimento oscilatório “de ir e vir” , ou seja

imprimirmos descontinuidade ao movimento,

acelerando e desacelerando a carga, esse

movimento vibratório, isto é uma corrente que com o tempo produz uma onda

eletromagnética, assim as cargas passam a irradiar .

A figura 19 mostra um circuito RLC oscilador, que mantido constantemente alimentado e

acoplado a um circuito irradiante (antena dipolo), produzindo ondas eletromagneticas que

viajam no espaço.

Fig. 19: Um dispositivo capaz de gerar uma onda eletromagnética progressiva

(no caso, uma onda curta de radio)

Fonte: Física 3 – Halliday, D.; Resnick, R.. e Krane, K.S.

Na figura 20 mostramos o plano do campo elétrico, numa sequência de momentos onde

observamos a frente de onda eletromagnética produzida pela alternância de polaridade das

cargas no dispositivo antena dipolo elétrico.

Fig. 20: Sequência de uma onda progressiva, como gerada pela antena da fig.4.

17

Fonte: Física 3 – Halliday, D.; Resnick, R.. e Krane, K.S.

A figura 21 contempla também o campo magnético que é ortogonal ao plano do campo

elétrico, por essa razão esta representado por sinais “de flecha” o (ponta da flecha)

significando que as linhas de campo está saindo da superfície do plano campo elétrico, e o

(aleta da flecha) significando que as linhas de campo magnético estão entrando no plano do

campo elétrico. Como resultado dessa alternância de polaridade no dipolo e da mútua

interação dos campos elétrico e magnético, a antena dipolo se torna uma fonte emissora de

radiação.

Fig. 21: Os campos E e B irradiados por um dipolo elétrico.

Fonte: Física 3 – Halliday, D.; Resnick, R. e Krane, K.S.

Em detalhe na figura 22, colocamos um observador no ponto P, sentido de propagação da

frente de onda eletromagnética, este observador obteria uma visão da frente de onda

hipoteticamente muito próxima de uma caixa retangular que transporta energia, a essa região

denomina-se campo de radiação. Uma onda eletromagnética pode então transportar energia

de um lado para outro, a exemplo do calor irradiado por uma fogueira, do calor que se

percebe irradiado de uma lâmpada incandescente, bem como do calor do sol que chega até a

terra na forma de luz, atravessando um grande distâncias no vácuo

O fluxo de energia em uma onda eletromagnética pode ser medido pela taxa de variação do

18

fluxo de energia por area. A magnitude e direção do fluxo de energia pode ser descrito por

um vetor chamado de vetor de Poynting (S) que é definido por:

Pelo produto vetorial ExB, utilizando a regra da mão direita podemos notar que a direção e

sentido de S é perpendicular ao plano de ExB apontando na direção positiva do eixo x,

passando pelo ponto P do nosso hipotético observador.

Fig22: Onda plana. e o vetorde Pointing P = E X B de propagação da onda.

Fonte: Física 3 – Halliday, D.; Resnick, R. e Krane, K.S.

Assim a radiação e consequentemente a energia transportada pelas ondas eletromagnéticas

estarão sendo utilizadas por diversos processos em tecnologias com as mais diversas

finalidades.

4. RADIAÇÃO E RADIOATIVIDADE.

A radiação pode ser de natureza ondulatória ou corpuscular, seja qual for sua natureza ela estará

transportando energia. A radiação de natureza ondulatória sãon constituidas por um campos

magnéticos e campos elétricos oscilantes e perpendiculares entre sí. Assim como a luz, que tem

também a natureza ondulatória, a radiação tem sua velocidade igual a da luz (c=3,0x108 m/s),

podendo ser refletida, difratada e absorvida dependendo da sua energia.

As radiações corpusculares são compostas por partículas atômicas ou sub-atômicas energéticas,

tais como as partículas alfa (dois prótons e dois nêutrons), que podem ter origem no decaimento

de átomos instáveis, ou de núcleos de hélio sem elétrons, elétrons (beta negativo), pósitrons

(beta positivo) que também podem ser emitidos de decaimentos nuclear.

19

A radioatividade é um fenômeno físico-químico que ocorre expontaneamente em alguns

elementos químicos. Todos os elementos químicos com Z maior que 82 são radioativos e se

desintegram, passando de um núcleo a outros até se transformar em um isótopo estável de

chumbo (Pb) com Z=82. Todos os estes elementos químicos levam um tempo para sofrerem

esses decaimentos ao que se dá o nome de meia-vida do elemento. Estas transições geralmente

ocorrem liberando radiação na forma corpuscular, ondulatória ou ambas.

4.1.O SOL, FONTE DE ENERGIA RADIANTE.

Para entendermos um pouco mais sobre radiações e como ela, de certa forma invisível, nos

envolve e afeta a vida, interfere construtiva ou destrutivamente com o meio ambiente, com

nossa tecnologia, nossos equipamentos e o cotidiano da vida na Terra, vamos recorrer à alguns

conhecimentos sobre o nosso Sol. O Sol, centro do nosso sistema planetário é a fonte de energia

que chega a todos os pontos na forma de radiação. É o Sol que promove a vida na Terra, tal qual

a conhecemos e é necessário sabermos como nos relacionar com ele, para vivermos bem.

Por milênios os povos da Terra reconhecem o Sol como um astro de relevância para a vida.

Deuses foram incorporados na figura do Sol. Muito já foi questionado pelos diversos cientistas

que dedicaram suas pesquisas para que pudessemos saber mais sobre o Sol e sobre o como ele

passa a eternidade queimando.

Para explorar um pouco mais sobre o Sol, olhando para o aspecto da energia e radiação, vamos

abordar os estudos feitos por Bethe (1906-2005), que desenvolveu a teoria da fusão termonuclear e como ela poderia produzir a energia que faz as estrelas brilharem. Seu estudo lhe

valeu o prêmio Nobel em 1967.

Para que uma reação de fusão ocorra as partículas dos núcleos dos átomos devem vencer a

barreira Coulombiana repulsiva entre as partículas, dada por:

20

onde o raio médio de um núcleo tem diâmentro estimado de 1 fermi (fentometro), que equivale

a 10-15m, enquanto que a energia cinética entre as partículas é determinada por uma distribuição

de velocidades de Maxwell-Boltzmann correspondente à sua energia térmica.

A temperatura no núcleo do Sol é da ordem de 1,5x107K, e para estrelas distantes mais

massivas, é da ordem de 5,0 x107K. A energia média das partículas dos núcleos interagentes, de

1,2 a 43 keV, é de muitas ordens de grandesa menor do que a barreira Coulombiana que as

separa. As reações ocorrem pelo efeito da probabilidade de ocorrência de tunelamento quântico,

onde a equação de onda da partícula, regida pelo princípio da incerteza, propõe que partículas

poderão vencer uma barreira de potencial com energia maior do que a energia da partícula. As

partículas com maior probabilidade de penetrar a barreira são aquelas com a máxima energia na

distribuição de Maxwell-Boltzmann.

Bethe propôs que as reações nucleares de fusão ocorrecem com quatro prótons que poderiam ser

unidos e transformados em um núcleo de hélio. Resultante deste processo haveria liberação de

energia. O processo de Bethe, conhecido atualmente como o ciclo do carbono, envolve uma

cadeia complexa de seis reações nucleares em que átomos de carbono e nitrogênio agem como

catalisadores para a fusão nuclear. Naquela época, os astrônomos calculavam que a temperatura

no interior do Sol fosse de cerca de 1,9 x107K, e Bethe demonstrou que àquela temperatura, o

ciclo do carbono (figura 23) seria o modo dominante de produção de energia.

21

Figura 23: Energia do Sol – Ciclo do carbono de Berthe .

Fonte: Review of Modern Physics.

A liberação de energia pelo ciclo do carbono é proporcional à 20a potência da temperatura para

temperaturas da ordem de 1,5x107K , como se sabe hoje ser no interior do sol.

Atualmente, o valor aceito para a temperatura do núcleo do Sol é de 1,5 x107K, e à esta

temperatura, o ciclo próton-próton (figura 24) domina. Para a ocorrência do ciclo próton-próton,

como descrito, necessita-se ter temperatura superior à 8,0 x107K para estar ocorrendo.

Figura 23: Energia do Sol – Ciclo do Próton-Próton .

Fonte: : Review of Modern Physics.

22

Já para o ciclo próton-próton, a dependência é muito menor, com a quarta potência da

temperatura,

Atualmente sabe-se que o ciclo do carbono contribui pouco para a geração de energia para

estrelas de baixa massa como o sol, porque suas temperaturas centrais são baixas, mas domina

para estrelas mais massivas. A estrela Rigel, por exemplo, tem temperatura central da ordem de

4,0x109K. Quanto maior for a temperatura central, mais veloz será o próton, e maior sua energia

cinética, suficiente para penetrar a repulsão coulombiana de núcleos com maior número de

prótons, isto é, maior peso atômico.

A astrofísica demonstrou que as leis físicas que conhecemos em nossa limitada experiência na

Terra são suficientes para estudar completamente o interior das estrelas. Desde as descobertas

de Bethe, o cálculo de evolução estelar através da união da estrutura estelar com as taxas de

reações nucleares tornou-se um campo bem desenvolvido, e astrônomos calculam com

confiança o fim de uma estrela como nosso sol daqui a 6,5 bilhões de anos como uma anã

branca, após a queima do hélio em carbono pela reação triplo-

:

E a explosão de estrelas massivas como supernovas. três átomos de Hélio colidem, formando

um carbono e liberando fótons. Esta reação só ocorre eficientemente para t>1,0x107K. O 8Be

formado na colisão de duas partículas α, tem um rápido decaimento de 2,6×10-16s, novamente

em dois núcleos de He.

23

Figura 24: Representação de três partículas Alpha .

Fonte: : Review of Modern Physics.

Sabemos com certeza que o sol converte aproximadamente 6,0x107 toneladas de Hidrogênio em

Hélio por segundo, mantendo a vida aqui na terra. Esta energia produzida pelo Sol, de

3,847x1033 ergs/s é equivalente a 5 trilhões de bombas de Hidrogênio por segundo. Para

comparar, a primeira bomba atômica, de Urânio, chamada de Little Boy e que explodiu sobre a

cidade de Hiroshima, tinha uma potência de 20 000 toneladas de TNT (tri-nitro-tolueno, ou

nitroglicerina). Uma bomba de Hidrogênio tem uma potência de 20 milhões de toneladas de

TNT. Toda esta transformação de massa em energia ocorre e se dá por radiação.

A composição química Sol tem como principais elementos o Hidrogênio (91,2%) e Hélio

(8.7%), que estão sofrendo processos de fusão, gerando uma temperatura efetiva na sua

superfície de Tef = 5785K.

Examinando a borda do Sol com um espectroscópio, durante um eclipse, temos a oportunidade

de ver por alguns instantes o espectro da cromosfera, feito de linhas brilhantes, as quais

mostram que a cromosfera é constituída de gases quentes que emitem luz na forma de linhas de

emissão (figura 25). Essas linhas são difíceis de serem observadas contra a luz brilhante da

fotosfera, por isso não as vemos no espectro solar normal. Uma das linhas cromosféricas de

emissão mais brilhantes é a linha de Balmer

, no comprimento de onda 6563 Å, que no

espectro solar normal aparece em absorção. A linha

cromosfera tem cor avermelhada.

está no vermelho, por isso a

24

Fig. 25: Foto de Espectro do Sol com filtro.

Fonte: National Solar Observatory, EUA.

O espectro da coroa mostra linhas muito brilhantes produzidas por átomos de ferro, níquel,

neônio e cálcio altamente ionizados e não por algum elemento estranho, como anteriormente foi

pensado. O fato de existirem esses elementos várias vezes ionizados na coroa implica que sua

temperatura deve ser muito alta, pois é necessária muita energia para arrancar muitos elétrons de

um átomo. A coroa solar tem sua temperatura média em torno de 1,0x106K.

Fig. 25: Foto de Espectro do Sol com filtro.

Fonte: Satélite TRACE (Transition Region and Coronal Explorer), NASA.

A elevação da temperatura na coroa deve ter origem no mesmo processo físico que aquece a

cromosfera: transporte de energia por correntes elétricas induzidas por campos magnéticos

variáveis. Da coroa emana o vento solar, um fluxo contínuo de partículas emitidas da coroa do

25

sol que atinge a Terra (aproximadamente 7 prótons/cm3 viajando a cerca de 400 km/s) é

capturado pelo campo magnético da Terra, formando o cinturão de Van Allen (figura 26), na

magnetosfera terrestre. Além das partículas do vento solar, existem grandes ejeções de massa

associadas às proeminências, que quando atingem a Terra causam danos às redes elétricas, aos

satélites, e demais sistemas elétricos. Em 1994, o satélite de comunicações E2 teve alguns

circuitos queimados por uma sobrecarga estática, também associada com a ejecção de uma

nuvem de plasma solar. O máximo deste ciclo solar ocorreu em 15 de fevereiro de 2001, quando

o campo magético solar reverteu de polaridade. Embora estejamos em 2009 ainda no mínimo

deste ciclo solar, com poucas tempestades, em 5 de dezembro de 2006 ocorreu um flare no Sol,

com índice X9, o mais alto, que chegou a danificar alguns píxeis da câmara do GOES 13, e

saturou todos os satélites GPS que estavam do lado iluminado da Terra. Normalmente as

partículas carregadas são desviadas pelo campo magnético da Terra para o Cinturão de Van

Allen, e somente chegam à Terra próximas aos pólos (23).

Fig. 26: Figura ilustrativa do Cinturão de Van Allen.

.

Este cinturão, descoberto pelo físico americano James Alfred Van Allen (1914-2006) em 1958,

só permite que as partículas carregadas do vento solar entrem na atmosfera da Terra pelos pólos,

causando as auroras (figura 27), fenômenos luminosos de excitação e des-excitação dos átomos

de oxigênio presentes na atmosfera da Terra. O vento solar, composto de partículas carregadas

26

desprendidas da coroa solar, viaja a aproximadente 250 a 1000 km/s, provocando as auroras,

normalmente entre 60 e 80° de latitude. Entretanto as auroras podem ocorrer também em baixas

latitudes, como por exemplo a observada em 1909 em Singapura, no equador geomagnético. As

auroras foram observadas na antiguidade pelos gregos e chineses, mas somente em 1896 o

físico norueguês Kristian Birkeland (1867-1917) deduziu que fluxos de elétrons provenientes do

Sol eram canalizados pelo campo geomagnético aos pólos e, quando colidiam com a alta

atmosfera, estimulavam os átomos de oxigênio e nitrogênio. As auroras são causadas pela

interação de partículas de alta energia, principalmente elétrons, com os átomos neutros da alta

atmosfera da Terra. Estas partículas de alta energia podem excitar, através de colisões, os

elétrons de valença que estão ligados aos átomos neutros. Estes elétrons excitados então se

desexcitam, retornando ao estado inicial, de mais baixa energia. Aos se desexcitar, eles emitem

um fóton, isto é luz. A combinação destes fótons, emitidos por muitos átomos, resulta na aurora

que vemos. As auroras acontecem a alturas acima de 60 km, têm correntes acima de

100 000 volts e geram energia acima de 1 milhão de megawatts.

Fig. 27: Figura ilustrativa da Aurora Boreal.

Entretanto o campo magnético terrestre não é um simples dipolo e existe uma depressão no

campo, no Atlântico Sul, que faz com que alto fluxo de elétrons com energia acima de 30 KeV

cheguem próximo ao solo na região conhecida como Anomalia Geomagnética do Atlântico Sul

representada na região vermelha da figura 28..

27

Fig. 28: Figura ilustrativa da Anomalia geomagnética do Atlântico Sul.

A Anomalia Geomagnética do Atlântico Sul é uma mancha de fluxo invertido, isto é, uma

mancha com fluxo magnético direcionado para dentro no hemisfério de fluxo direcionado para

fora. Existem outras manchas menores, tanto no hemisfério norte quanto no hemisfério sul, de

acordo com as medições de campo magnético efetuadas pelos satélites Magsat em 1980 e

Ørsted em 2000 (23).

Estas inversões de fluxo são similares às que causam as manchas solares: o fluxo de material

líquido e ionizado no núcleo da Terra é convectivo, turbulento e distorcido também por rotação

diferencial do núcleo externo, líquido (2900 km a 5100 km de profundidade), sobre o núcleo

sólido interno, cristalizado e que libera calor latente na cristalização das camadas externas e de

separação de elementos menos densos, como sultefo de ferro e óxido de ferro. Estas manchas

mudam de tamanho com o tempo e, quando aumentam até dominar o hemisfério, causam a

reversão do campo magnético da Terra. A última reversão ocorreu há 780 mil anos.

Quando manchas solares de polaridades magnéticas opostas colidem, há cancelamento do

campo magnético que pode provocar um flare, um aumento significativo da emissão de

radiação eletromagnética no local, principalmente no ultravioleta e raio-X.

28

Fig. 29: Fluxo Magnético na Terra e Regiões de Anomalia geomagnética.

Um aumento do fluxo de raios-X detectado pelo satélite Goes 8 após um grande flare solar ao

atingir a Terra, como radiação, provocou um aumento na fotoioniozação da atmosfera, com um

aumento súbito no número de elétrons livres, que perturbaram as ondas de rádio, inclusive as

usadas pelo GPS. As ejeções coronais de massas são bolhas de gás quente (plasma), de cerca de

1 a 10 bilhões de toneladas, aquecidas pelos campos magnéticos do Sol. Os campos magnéticos

do Sol se enrolam devido ao movimento turbulento de convecção mas também devido à rotação

diferencial, que faz com que o equador solar complete uma volta em 25 dias, enquanto que as

regiões próximas aos pólos completam uma volta em 36 dias. A desconexão do campo

magnético solar pode ocorrer em alguns minutos e tem uma energia equivalente a milhares de

bombas atômicas. As ejeções coronais de massa viajam a aproximadamente 1 milhão km/hr e

29

levam de um a quatro dias para alcançar a Terra. Quando atingem a Terra, têm milhões de

quilômetros de extensão e podem causar:

danos a satélites, também causados pelo aumento da fricção causada pela expansão da

atmosfera,

erro no posicionamento de navios e aviões de vários quilômetros, tanto pelo sistema

GPS (Global Positioning System) quanto pelos sistemas Loran e Omega (8 transmisores

distribuídos pela Terra), por instabilidades no plasma da ionosfera terrestre, causando

cintilação na amplitude e fase do sinal e reduzindo o número de satélites disponíveis de

8 a 10 para até 4. Em geral estas instabilidades duram menos de 10 minutos, mas já

ocorreram casos em que o sistema ficou fora do ar por até 13 horas,

danos às redes de energia elétrica, induzindo voltagens de milhares de volts e queimando

transformadores.

danos nas tubulações metálicas de gaseodutos, já que as correntes induzidas aumentam

drasticamente a corrosão,

Aumentam também a incidência de radiação ionizante nas pessoas, principalmente em

vôos de alta altitude, como vôos supersônicos e astronáuticos.

Em termos de radiação que atinge a Terra, normalmente é de 360 milirem/ano (3,6 mili

sievert/ano). A exposição recomendada é 1 mSy/ano. Para os astronautas na Estação Espacial,

atinge em média 6 rem/ano (60 mili sievert/ano), mas em único evento em 1989 atingiu 216

milirem/dia (2,16 mili sievert/dia) após uma tempestade solar. Durante uma ejeção coronal de

massa a radiação na superfície da Lua chega a 7000 rem/min (70 sievert/min), o que é fatal.

30

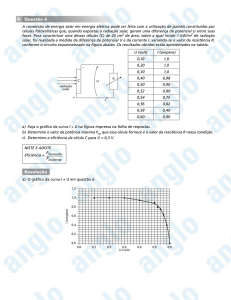

Fig. 30: Gráfico ilustrativo da dose de radiação/dia pela altura.

No Sol mínimo, a exposição é da ordem de 3,6 mSy/ano, enquanto a exposição recomendada é

1 mSy/ano. No Sol máximo, a exposição é mais que o dobro.

No sistema internacional de medidas, a dose é medida em gray (Gy=1Joule/kg) é a quantidade

de energia transferida pela radiação, eletromagnética ou corpuscular, para um objeto e 100

rad=1 Gy. Um pessoa na Terra recebe em média 450 µGy/ano de raios cósmicos. O limite de

dose equivalente para a população em geral é de 0,1 rem/ano (1 mSv/ano). O limite para

trabalhadores ocupacionalmente expostos é de 2 rem/ano (20 mSv/ano). (ICRP-60: International

Commission on Radiological Protection, Report 60, 1991). Para passar de dose (D), medida em

Gy, para exposição (E), medida em Sv, precisamos levar em conta a qualidade (Q) da radiação e

o especro (N) da mesma.

E=D Q N

A qualidade Q, tem valores numéricos que variam de 1 para a radiação eletromagnética, até 20

para partículas ionizadas de alta energia, embora com menor poder de penetração e interação

nos meios materiais os danos causado pelas partículas ionizadas (Alpha e Beta) é maior do que

o da radiação eletromagnética.

31

Para podermos avaliar melhor estes e outros valores das grandezas físicas, as quais não estamos

rotineiramente acostumados, fazeremos uso do recurso de analogias. Exemplificando; Uma

tomografia de crânio tem uma exposição recomendada de 50 mGy, e uma mamografia de 10

mGy. Os sobreviventes da bomba de Hiroshima, no Japão, tiveram uma exposição média de

230 mGy (4 Gy a 1000 metros). Exposições acima de 200 rems já causam danos sérios, e acima

de 600 rems causam a morte em menos de 2 meses em 80% dos casos (25).

O meio ambiente é suceptível à alterações decorrentes dos eventos que ocorrem no Sol.

Atualmente vários satélites estão monitorando eventos cosmológicos que poderão afetar o clima

Estes satélites podem receber notificação da chegada de uma ejeção coronal de massa solar com

aproximadamente 3 horas de antecedência, propiciando às agências científicas meios de

disparar planos de contenção que possam minimizar os efeitos danosos destes eventos. No

endereço URL http://www.sec.noaa.gov, pode-se ter acesso a dados destas observações. Notase que nos anos de máximo de um ciclo solar, podem ocorrer de 2 a 60 eventos. Essas ejeções

podem causar diversos danos nos sistemas eletrônicos e ainda, severos às linhas de transmissão

de energia. Em princípio, as linhas de transmissão dentro das cidades sofrem menos efeitos, por

serem melhor protegidas e de curtas distâncias. Uma ejeção coronal de massa do Sol, que

podem estar relacionadas com o aquecimento da coroa nas camadas externas, também pode

causar grandes efeitos nos oceanos, tais como, grandes ondas (tsunami) (23).

O Sol está continuamente produzindo energia decorrente da fissão nuclear em seu interior, esta

energia atravessa o espaço em forma de ondas eletromagnéticas, como radiação irradiante e

alguma porção de partículas. No espectro da figura 29, podemos ver a distribuição das ondas

eletromagnéticas em comprimento de onda () sua relação com a denominação destas.

32

Fig. 29: Comprimento de Onda das Ondas Eletromagnéticas.

A radiação ultravioleta tem comprimentos de onda menores do que a radiação visível,

posicionada à esquerda no espectro acima, é normalmente dividida em três faixas (figura-31):

UV-A, UV-B e UV-C. O UV-B, com comprimentos de onda entre 120nm (1200Å) e 380nm

(3800Å) é a faixa mais perigosa da energia irradiada pelo Sol que alcança a superfície da Terra.

Grande parte dos efeitos nocívos à saude humana podem ser causados pela radiação Ultravioleta

com estes comprimentos de onda, sendo principal fator de melanoma (cancêr de pele). A Terra

possui algumas formas natural de proteção para os seres vivos em sua superfície. Uma

importante proteção é o campo mafnático da Terra que se manifesta como proteção em forma de

campo denominado Cinturão de Van Hallen e já nas camadas superiores da atmosfera a camada

de ozônio (O3) promove uma forma eficiente de escudo anti-radiação Ultra Vioteta. O ozônio

(O3) atmosférico, além do próprio oxigênio molecular (O2) e do nitrogênio (N2), protege os

viventes na superfície das componentes mais danosas (com maior energia) da radiação solar.

A poluição do ar advinda de diversos processos químicos naturais e antropogênicos, estão

continuamente produzindo reações químicas com substancial redução das moléculas de ozônio

33

(O3) da atmosfera. Essa camada de ozônio (figura-30) é responsável pera redução dos fótons de

radiação UV enérgéticos que chegariam à superfície da Terra.

Fig. 31: Ilustração da Radiação Ultravioleta CBA e sua Penetração na Atmosfera.

Desde 1979 tem-se monitorado e detectado aumento na falha na camada de ozônio sobre a

Antártica (figura-34). Este buraco na camada de ozônio que pode provocar o câncer de pele e

opacidade no cristalino dos olhos (cataratas) nos seres humanos.

Fig. 31: Foto de satélite da camada de ozônio na região Antartida.

fonte:

O ozônio da atmosfera e seus aerosóis operam como um filtro protetor da dadiação neste

comprimento de onda. Essa redução na intensidade (quantidade de fótons) espalhados ou

absorvidos pela camada de ozônio, tem-se reduzido de forma que no final da década de 90 tem

ficado, em média, muito próximo ao valor de mínimo (figura-32).

34

Fig. 32: Histograma do burraco na camada de ozônio e o valor mínimo da radiação.

fonte:

A energia do sol medida na superfície terrestre mostra que cada metro quadrado recebe uma

potência (energia/segundo) de cerca de 1400 watts, ou seja, a potência de 14 lâmpadas de 100

watts/m2. O valor mais preciso da constante solar é 1367,5 w/m2, o qual tem variado cerca de

0,3% durante o ciclo solar de 11 anos. A irradiação solar pode variar, dependendo da época no

ciclo de 11 anos, de 1364,55 a 1367,86 watts/m2(figura-33).

Considerando-se um comprimento de onda efetivo de 550nm (5500Å), podemos calcular a

intensidade (I) de fótons que atinge a superfície da Terra.

n = fótons m2s-1

h = Constante de Plank (6,63x10-34 J s)

c = Velocidade da luz (3,0x108 m/s)

(comprimento de onda) = 550nm ou 5500Å

n=1366 W m2/(hc/5500Å ) = 1366 J s-1 m2/(3,6 × 10-19 J) =

3,78×1021 fótons m2s-1

35

Fig. 33: Taxa anual Energia Irradiada pelo Sol.

fonte:

Enquanto o Sol irradia energia isotrópicamente de sua superfície, inúmeras reações nucleares

estão ocorrendo no seu núcleo, transformando massa em energia que estarão sendo irradiada na

forma de ondas eletromagnética ou sendo ejetada na forma de partículas ionizadas em altíssima

velocidade. Os astrifísicos utilizam modelos de evolução estelar, para predizer a velocidade

destas transformações. Calcula-se que daqui a cerca de 1,1 bilhão de anos o brilho do sol

aumentará em cerca de 10%, que causará a elevação da temperatura aqui na terra, aumentando o

vapor de água na atmosfera. O vapor de água é um dos fatores que causa o efeito estufa, fator de

alteração do albedo (relação entre energia radiante absorvida e trasnmitida pela Terra). Estimase que daqui a 3,5 bilhões de anos, o brilho do sol já será cerca de 40% maior do que o atual, e o

calor será tão forte que os oceanos secarão completamente, acelerando e maximizando o efeito

estufa. Embora o sol venha a se tornar uma gigante vermelha após terminar o hidrogênio no

núcleo, combustível da reação de fusão nuclear, ocorrerá perda de massa gradual do sol,

possivelmente afastando a terra do sol até aproximadamente a órbita de marte, mas exposta a

uma temperatura de cerca de 1600 k (1327 c).

36

4.2.

HISTÓRIA E CONCEITO DAS RADIAÇÕES.

Em 1896, acidentalmente, o francês Henri Becquerel (1852-1909) descobriu a radioatividade

natural, ao observar que o sulfato duplo de potássio e uranila: K2(UO2)(SO4)2 , conseguia

impressionar chapas fotográficas. O fenômeno foi denominado radioatividade e os elementos

que apresentavam essa propriedade foram chamados de elementos radioativos.

A radioatividade foi descoberta poucos meses depois da descoberta dos raios X. Também foram

descobertos que outros elementos pesados, com massas próximas do urânio, também tinham a

mesma propriedade e em 1898, os poloneses Pierre e Marie Curie identificaram o urânio, o

polônio (400 vezes mais radioativo que o urânio) e depois, o rádio (900 vezes mais radioativo

que o urânio).

Radioatividade é a capacidade que certos átomos possuem de emitir radiações eletromagnéticas

e partículas de seus núcleos instáveis com o objetivo de adquirir estabilidade. A emissão de

partículas faz com que o átomo radioativo de determinado elemento químico se transforme num

átomo de outro elemento químico diferente.

Novas descobertas demonstraram que os elementos radioativos naturais emitem três tipos de

radiações: a , b e g . No começo do século XX, Rutherford criou uma aparelhagem para estudar

estas radiações (figura 8). As radiações eram emitidas pelo material radioativo, contido no

interior de um bloco de chumbo e submetidas a um campo magnético. Sua trajetória era

desviada:

Figura 8: Câmara RBS de Rutherford para estudar as radiações.

Fonte: www.soaresoliveira.br/chrisrios

37

Comprovou-se que um núcleo muito energético, por ter excesso de partículas ou de carga

(figura 9), tende a estabilizar-se, emitindo algumas partículas.

Figura 9: Tipos de radiações.

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia.

As unidades para Radioatividade no Sistema Internacional podem ser visto na tabela1 abaixo:

Grandeza

Nome

Símbolo Definição

Atividade na qual se produz uma desintegração nuclear

Atividade

becquerel

Bq

por segundo.

Exposição tal que a carga total de íons de mesmo sinal

Exposição

coulomb/Kg

C/kg

produzidos em 1 quilograma de ar é de 1 coulomb em

valor absoluto.

Dose de radiação ionizante absorvida uniformemente

Dose

gray

Gy

por uma porção de matéria, à razão de 1 joule por

absorvida

quilograma de sua massa.

Equivalente de dose de uma radiação igual a 1 joule

Equivalente de

sievert

Sv

por quilograma. Nome especial para a unidade SI

dose

adotada pela 16a CGPM/1979.

Tabela 1: Unidades do Sistema Internacional para Radioatividade

Fonte: http://www.fisica.net/denis/rad2.htm

38

O efeito da radiação sobre a matéria pode ser benéfico ou destrutivo, o grau deste efeito

dependerá da energia do fóton, da intensidade da radiação envolvida e do tipo de interação que

esses fótons estarão provocando no meio da interação. Veremos, com maiores detalhes, mais

adinante, os efeitos da radiação ultraviotela que será neste trabalho o nosso objeteto de

divulgação.

4.3.

RADIAÇÃO IONIZANTE.

As radiações são denominadas ionizantes,

quando possuem energia suficiente para ejetar

elétrons dos átomos durante seu trajeto. Na sua interação com o meio material esta radiação

estará produzindo ionização. Ionização é então, o processo de produção de íons, que é a

formação de àtomos ou moléculas não neutras eletricamente, isto é, estas partículas estarão

carregadas eletricamente podendo ser com cargas positivas ou negativas, dependendo da ação

da radiação na sua interação. Quando a radiação atravessa um meio material ela pode interagir

com átomos ou moléculas deste meio e no processo ela poderá depositar energia nos elétrons

dos átomos sem ejetá-los, retirando-los do seu nível energético ou arrancá-los. Os átomos e

moléculas que perderam estes elétrons, perderam uma quantia de carga negativa para cada

elétron ejetado, ficando eletricamente positivo, isto é, foram inonizados positivamente,

tornando-se íons positivos. Uma vez livres os elétrons por sua vez, estarão interagindo com o

meio e poderão ser capturados por alguma outra molécula ou átomo ficando à estes ligados.

Estas moléculas ou átomos que receberam estes elétrons estarão recebendo uma quantidade de

carga negativa referente a cada novo elétron ligado, passando assim a estarem negativamente

ionizados, sendo identificados como íons negativos, como veremos.

4.3.1. RADIAÇÃO ALFA OU PARTÍCULA ALFA

Os processos de radiação podem ocorrer dentro do núcleo de átomos instáveis ou pela interação

de troca de energia entre seus elétrons, com outras partículas ou ondas eletromagnéticas. Um

dos processos de estabilização de um núcleo com excesso de energia é o da emissão de um

39

grupo de partículas positivas, constituídas por dois prótons e dois neutrons, e da energia a elas

associada. São as radiações alfa ou partículas alfa, a radiação alfa é uma partícula formada por

um átomo de hélio (He) com carga positiva (figura 13). O hélio um gás chamado nobre por não

reagir quimicamente com os demais elementos.

(A)

(B)

Figura 13: (A) Partícula Alfa é uma formada pelo núcleo de um átomo de hélio.

(B)Interação de partículas alfa com numa folha de alumínio.

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia.

A distância que uma partícula percorre antes de parar é chamada alcance. Num dado meio,

partículas alfa de igual energia têm o mesmo alcance. O alcance das partículas alfa é muito

pequeno, o que faz que elas sejam facilmente blindadas. Uma folha fina de alumínio barra

completamente um feixe de partículas de 5MeV. A inalação ou ingestão de partículas alfa é

muito perigosa.

Ela possui as seguintes características:

Velocidade média : 20000 km/s .

Poder de penetração : pequeno, são detidas por pele, folha de papel ou 7 cm de ar.

Poder ionizante ao ar : elevado, por onde passam capturam elétrons, transformando-se em

átomos de Hélio.

4.3.2. RADIAÇÃO BETA OU PARTÍCULA BETA

Outra forma de estabilização, quando existe no núcleo um excesso de neutrons em relação a

prótons, é através da emissão de uma partícula negativa, um elétron, resultante da conversão de

um neutron em um próton é a partícula beta negativa ou, simplesmente, partícula beta.

40

No caso de existir excesso de cargas positivas (prótons), é emitida uma partícula beta positiva,

chamada pósitron, resultante da conversão de um próton em um neutron.

Portanto, a radiação beta é constituída de partículas emitidas por um núcleo (fig.14), quando da

transformação de neutrons em prótons (partículas beta) ou de prótons em neutrons (pósitrons).

Figura 14: A partícula beta (elétron)tem carga negativa e a partícula beta positiva ( pósitron).

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia.

Ela possui as seguintes características:

Velocidade média: 95% da velocidade da luz.

Poder de penetração : 50 a 100 vezes mais penetrantes que as partículas alfa. São detidas por 1

cm de alumínio (Al) ou 2 mm de chumbo (Pb).

Danos os organismos : maiores do que as emissões alfa, podem penetrar até 2 cm do corpo

humano e causar danos sérios.

4.3.3. RADIAÇÃO OU FÓTON GAMA.

Geralmente após a emissão de uma partícula alfa ( ) ou beta ( ), o núcleo resultante desse

processo ainda com excesso de energia, procura estabilizar-se, emitindo esse excesso em forma

de onda eletromagnética, da mesma natureza da luz, denominada radiação gama.

Ela possui as seguintes características:

Velocidade: igual à da luz = 300 000 km/s.

Poder de penetração: alto, são mais penetrantes que raios X (fig. 15) são detidas por 5 cm de

chumbo (Pb).

Danos à saúde: máximo, pois podem atravessar o corpo humano, causando danos irreparáveis.

41

(A)

(B)

Figura 15: (A) Partícula gama de origem nuclear.

(B) Relação entre as radiações e seu poder de penetração.

Fonte: Comissão Nacional de Energia Nuclear- Ministério da Ciência e Tecnologia

4.3.4. RAIOS X.

Nos últimos meses do ano de 1895, W.C.Roentegen pesquisava descargas elétricas em tubos de

ráios catódicos, quando, para seu espanto, descobriu um agente que era capaz de atravessar

placas de madeira e de metal com muita facilidade, imprimindo, ainda imagens em filmes

fotográficos. Desta forma Roentgen, professor de física da universidade de Wurzburg na

Alemanha deu o nome de raios X a esta descoberta que foi uma revolução na área da radiologia

diagnóstica(10). Os raios X fazem parte do espectro eletromagnético e é classificado como uma

radiação ionizante, igual que as radiações as quais possuem uma característica importante que

são a de ter a energia suficiente para ionizar a matéria. Existem atualmente equipamentos com

capacidade de produzir raios X mais energéticos que raios . Em laboratórios de pesquisa

espalhados pelo mundo, aceleradores de elétrons produzem raios X de muito alta energia. O raio

X produzido nestes laboratórios são originados da desaceleração dos elétrons que compõe o

feixe, quando freados por ação campo columbiano do núcleo que compõe os átomos do anodo

de metal do equipamento. Os raios X assim gerados são chamados de radiação de freamento

(bremsstrahlung), desta forma poderão ter qualquer energia, a qual dependerá do grau de

aproximação do elétron com o núcleo. Os fótos de raio X assim produzidos, podendo ter

42

qualquer energia, irão compor o espectro de raios X contínuo, podendo existir fótons com

energia próximos de zero até os fótons de máxima energia. Este valor de máxima energia do

fóton pode ser calculado por (9):

𝐸𝑚á𝑥 𝑑𝑜 𝑓ó𝑡𝑜𝑛 = ℎ𝜈𝑚á𝑥 =

ℎ𝑐

𝜆𝑚𝑖𝑛

Nas interações do elétron energético do feixe com os elétrons das camadas mais internas dos

átomos, particularmente quando ocorre a remoção de elétrons da camada K provocando a falta

desse elétron, existirá a necessidade de seu preenchimento por um elétron de um elétron de uma

camada superior existente. Quando um elétron da camada L ou M faz a transição para preencher

o que chamamos de lacuna, ele deve perder energia. Essa energia será liberada na forma de um

fóton com a energia dada pela diferença das energias entre os níveis de energia da camada que

ele transitou.

𝐸𝑓ó𝑡𝑜𝑛 = 𝐸𝑐𝑎𝑚𝑎𝑑𝑎

𝑖𝑛𝑖𝑐𝑖𝑎𝑙

− 𝐸𝑐𝑎𝑚𝑎𝑑𝑎

𝑓𝑖𝑛𝑎𝑙

Estes fótons são de grande importância nos estudos de caracterização de materiais pois as suas

energias são quantizadas, únicas e particulares relacionadas com o elemento químico pela qual

eles foram emitidos, funcionando como assinatuda deste elemento químico, por isso são

denominados de fótons de raio X característicos.

Pode-se verificar o intervalo do comprimento de onda eletromagnética dos raios X (figura 38)

que estão na faixa de 30nm até aproximadamente 0,1nm.

0,01

0,1

RAD

10

30 180

Comprimento de onda-nanômetros

(sem escala)

UV

Rx

Fig. 38: Espectro das Radiações Ionizantes.

Fonte: Fonte: Biofísica Básica – Heneine, Ibrahim Felippe.

400

43

4.4. RADIAÇÃO NÃO-IONIZANTE.

As radiações são denominadas não-ionizantes, não possuem energia suficiente para arrancar

elétrons dos átomos em seu trajeto. Sua interação com o meio material poderá produzir aumento

da energia cinética nos átomos do meio material por onde este tipo de radiação estiver

interagindo resultando em excitação ou aquecimento. Determinar a fronteira de conceito para

radiações ionizantes e não ionizantes não é tão simples.

Quando a radiação interage com a matéria, quer seja com o nosso corpo, se ela não tiver energia

suficiente para arrancar elétrons dos átomos ou moléculas, não irá produzir íons. Para fótons de

radiação arrancarem os elétrons mais fracamente ligados, os da última camada de átomos ou

moléculas, podendo assim formar íons, deveria ter energia de no máximo 24,6 eV no caso de

átomos de hidrogênio. Esta energia necessária para arrancar elétrons da última camada irá variar

de átomo para átomo, pois dependerá da relação e interação eletrostática entre os elétrons com

o núcleo e com os demais elétrons da vizinhança, o que fará variar, de forma discreta,

quantizada, a energia necessária para a ejeção do elétron para torná-lo um elétron livre.

Na interação onde ocorre a excitação, entenda-se que não há remoção de elétrons pela interação

de fóton, os elétrons permanecem ligados aos átomos com um maior nível de energia, deixando

seu estado fundamental de energia. Estes elétrons acabarão estando com mais energia cinética,

simplesmente aumentando seu estado rotaciona e vibracional, porém eles não permanecerão

neste estado indefinidamente, voltando ao seu estado fundamental em um tempo da ordem de

10-8s, emitindo um fóton de luz (11)pg17.

4.4.1. RADIAÇÃO INFRAVERMELHO.

O espectro eletromagnético (figura 39) aponta os comprimentos de onda da luz, onde acima

dos 800nm encontramos a radiação do Infravermelho. O Infravermelho está fora do espectro de

luz visível pelo olho humano.

44

Fig. 39: Espectro Eletromagnético.

Fonte:.

A radiação Infravermelho também é separada em 3 faixas de comprimento de onda o IVA

(780nm até 1,4um), o IVB (1,4um até 3,0um) e o IVC (3,0um até 1,0mm), seus fótons tem

energia muito baixa, por isso não causam ejeção de elétrons de nenhum material. Como a

radiação Infravemelho não arranca elétrons de átomos nos quais ele esteja ligado, diz-se que o

Infravermelho é uma radiação não-ionizante.

A radiação Infravermelho, através da troca de energia de seus fótons, causa aqucimento do meio

material no qual ela está interagindo, devido ao aumento da energia cinética das moléculas. A

máxima penetração do infravermelho no tecido humano é de 3mme ocorre com o comprimento

de onda do IVA, diminuindo ligeiramente para os comprimentos de onda do IVB e IVC(10).

4.4.2. RADIAÇÃO ULTRAVIOLETA.

O sol é imprescindível para a vida na Terra. É uma fonte inestimável de energia, bem-estar e

saúde. A luz solar proporciona efeitos benéficos, tanto fisiológicos como psicológicos, mas

também pode causar efeitos danosos, o que exige de nós como sociedade, orientação e

conhecimento para que se possa aproveitar dos benefícios sem se deixar ser pego pelos fatores

que colocam a saúde humana em perigo. A radiação ultravioleta, conhecida como UV, faz parte

da luz solar que atinge o nosso planeta e é essencial para a preservação do calor e a existência

da vida. A radiação UV (figura 39), está localizada logo acima do espectro de luz vivível (de

45

400nm até 100nm) e embora seus fótos sejam mais energéticos é classificada como uma

radiação excitante. Embora bastante energético, a radiação UV tem menor penetração no tecido

(pele) do que a luz visível e radiação Infravermelho. A profundidade de penetração da radiação

Ultravioleta na pele será tanto menor quanto maior for a energia de seu fóton, mas não é a única

e preponderante relação (11)pg3.

A radiação Ultravioleta é muito importante como catalizador de vitamina D na saúde humana, a

vitamina D é também conhecida como vitamina anti-raquítismo, pois controla o aproveitamento

do fósforo e do cálcio, importantes para o perfeito desenvolvimento dos ossos e dos dentes.

Mesmo quando se ingerem alimentos que contenham fósforo e cálcio, essas substâncias não se

fixam nos ossos quando há deficiência de vitamina D. Nosso organismo pode aproveitar

diretamente a vitamina D proveniente de certos alimentos ou sintetizá-la nas células de nossa

pele a partir de uma provitamina: o ergosterol. Esta provitamina na presença dos raios

ultravioleta do Sol, que agem como sintetizador, transformando o ergosterol em vitamina D.

Muito já foi divulgado sobre os benefícios de estar exposto a luz solar, porém precisamos estar

atentos em relação à dose a qual se está exposto. O Sol tem efeito hormético(11), que é a porção

saudável, que trás benefícios ao se estar exposto a radiação solar em tempo não superior a duas

horas diárias e que esta exposição esteja sendo em horário de excessão, de menor intensidade

radiante. Não é recomendável ficar exposto ao Sol nos horários entre 10:00h e 16:00h, porém

quando necessário utilizar protetor solar, adequando o grau de filtro. A proteção utilizando filtro

solar é insdispensável para se evitar danos à saúde.

4.4.

PRODUÇÃO DE RADIAÇÃO ULTRAVIOLETA.

As fontes de produção de radiação UV, como mencionamos, podem ser natural e artificial. O

Sol é a principal fonte natural de produção de UV. Dentre as fontes artificiais de produção da

radiação UV, podemos citar as lâmpadas germicidas utilizadas em hospitais e centros clínicos

para assepcia de instrumentos cirúrgicos, Equipamentos para solda industrial de metais, que

46

operam com elevadas diferença de potencial, produzem um arco voltáico luminoso no qual

existe emissão da radiação ultravioleta. As lâmpadas negras que os jovens encontram nas

baladas também produzem radiação Ultravioleta.

4.5. RADIAÇÃO UV E PRINCIPAIS EFEITOS NA SAÚDE HUMANA.

A luz do Sol, desde a antiguidade, é conhecida como necessária e benéfica para a vida na Terra,

pois ela ilumina e aquece os ambientes, além de ser necessária para dar suporte à vida vegetal

nos processos de fotosíntese. O Sol fonte da radiação que permite secar e preservar alimentos,

também serviu de inspiração para que os cientistas desenvolvessem equipamentos que tem sido

utilizado em medicina, na fototerapia, fotoquimioterapia, terapia fotodinâmica e laserterapia

(11)

pag.36.

A radiação UVA (fótons com energia entre 3,10eV e 3,94eV) tem penetração de até 1% no

tecido sub-cutâneo, com aproximadamente 300um, Já a radiação UVB (fótons com energia

entre 3,94eV e 4,42eV), tem sua penetração máxima em torno dos 200um atingindo a derme

com 9,5% da sua energia radiante e a UVC (fótons com energia entre 4,42eV e 12,42eV),

consegue penetrar até a epiderme atingindo 80um em profundidade. A radiação UV que

demonstrou ser a mais eficiente em ações bactericídas se encontra na faixa de comprimento de

onda entre 300nm e 250nm. Os principais efeitos das radiações ultravioleta no corpo humano

são as seguintes:

Cancer de pele.

A pele é o maior orgão do corpo humano, corresponde a 15% do peso corpóreo(11), operando

como camada protetora, é uma interface que evita o contato das partes e orgãos mais frágeis

com o ambiente inóspito. A pele evita a perda de água que é vital para o equilíbrio químico dos

fluídos corpóreos e das demais reações químicas que se processam na fisiologia do corpo, além

de regular a temperatura do corpo.

47

A radiação ultravioleta, em doses adequadas, na fototerapia, já foi utilizada para tratamento para

a tuberculose de pele. incidência de câncer de pele supera em ocorrência todos as outras

manifestações carcinogênicas. A Organização Mundial de Saúde, vem alertando que não só no

Brasil mas mundialmemte este tipo de câncer tem aumentando de maneira preocupante.

Pesquisadores tem alertado sobre a existência de uma relação direta entre a exposição a radiação

ultravioleta e o câncer de pele.

A radiação UV que não sofreu interação com a camada de ozônio, o qual possa ter sido

espalhado, absorvido, pode chegar até a superfície e é esta porção que pode afetar nossa saúde.

No entanto, em função do aumento dos buracos na camada de ozônio, originados de ações

antropogênicas, tem contribuido para o aumento dos índices de radiação aos quais estamos

sujeitos em um mesmo periodo de exposição. Os raios UV podem causar queimaduras,

fotoalergias, envelhecimento cutâneo e até o câncer de pele, a camada de ozônio tem forte

influência redutiva na intensidade do UV, reduzindo o risco de se estar exposto ao Sol.

Segundo o dr. Roberto B. Lima(26) , médico-dermatologista, “A radiação ultravioleta (UV) ao

atingir nossa pele penetra profundamente e desencadeia reações imediatas, como as

queimaduras solares, as fotoalergias (alergias desencadeadas pela luz solar) e o bronzeamento,

provoca também reações tardias, devido ao efeito acumulativo da radiação durante a vida,

causando o envelhecimento cutâneo e as alterações celulares que, através de mutações

genéticas, predispõem ao câncer da pele". O alerta do médico encontra respaldo nas diversas

campanhas promovidas pela WHO (World Health Organization).

O câncer da pele é um tumor formado por células da pele que sofreram uma transformação e

multiplicam-se de maneira desordenada e anormal dando origem a um novo tecido (neoplasia).

Os especialistas afirmam que, entre as causas que predispõem ao início desta transformação

celular, aparece como principal agente à exposição prolongada e repetida à radiação ultravioleta

do sol. Os mais atingidos pelo câncer de pele são principalmente as pessoas de pele branca, que

se queimam com facilidade e nunca se bronzeiam ou se bronzeiam com dificuldade. Os médicos

48

indicam que cerca de 90% das lesões localizam-se nas áreas da pele que ficam expostas ao sol,

o que demonstra a importância da exposição solar para o surgimento do tumor.

Os tipos mais comuns de câncer de pele.

São três os tipos mais frequentes. Eles se originam de diferentes células que compõem pele.

- carcinoma basocelular: originado das células da camada basal, é o mais frequente e com o

menor potencial de malignidade. Seu crescimento é lento e muito raramente se dissemina à

distância. Ele pode se manifestar de várias maneiras, uma delas está ilustrada na foto abaixo.

Fig. 39: Carcinoma basocelular.

Fonte:www.dermatologistas.net.

É possível perceber sua ocorrência pelas feridas que nao cicatrizam ou lesões que sangram com

facilidade devido a pequenos traumatismos, tal qual o uso da toalha, podem ser um carcinoma

basocelular.

O carcinoma basocelular (basalioma ou epitelioma basocelular) é um tumor maligno da pele. É

o câncer da pele mais frequente, representando cerca de 70% de todos os tipos. Sua ocorrência é

mais comum após os 40 anos de idade, nas pessoas de pele clara e seu surgimento tem relação

direta com a exposição acumulativa da pele à radiação solar durante a vida. A proteção da

radiação solar é a melhor forma de prevenir o seu surgimento.

Por ser um tumor de crescimento muito lento e que não dá metástases (não envia células para

outros órgãos), é o de melhor prognóstico entre os cânceres da pele. No entanto, pode apresentar

49

característica invasiva e, com o seu crescimento, destruir os tecidos que o rodeiam atingindo até

a cartilagem e os ossos.

A grande maioria das lesões aparece na face. O basalioma pode se manifestar de diversas

formas mas em sua apresentação mais típica inicia-se como pequena lesão consistente, de cor

rósea ou translúcida e aspecto "perolado", liso e brilhante, com finos vasos sanguíneos na

superfície e que cresce progressiva e lentamente.

Na sua evolução pode ulcerar (formar ferida) ou sangrar, podendo, com isso, apresentar uma

crosta escura (sangue coagulado) na sua superfície.

Algumas lesões podem ser pigmentadas, com as mesmas características descritas acima porém

de coloração escura (basocelular pigmentado), outras crescem em extensão atingindo vários

centímetros sem contudo aprofundar-se nos tecidos abaixo dela (basocelular plano-cicatricial).

A forma mais agressiva acontece quando o tumor invade os tecidos em profundidade

(basocelular terebrante), com grande potencial destrutivo principalmente se atingir o nariz ou os

olhos.

O tratamento do carcinoma basocelular é na maioria das vezes cirúrgico, seja pela eletrocirurgia

(lesões pequenas) ou pela cirurgia convencional. O tumor também pode ser tratado pela

criocirurgia com nitrogênio líquido. Alguns tipos superficiais podem ser tratados pela terapia

fotodinâmica.

Fig. 40: Carcinoma basocelular e cirurgia reparadora.

Fonte:www.dermatologistas.net.

50

- carcinoma espinocelular: originado das células da camada espinhosa, tem crescimento mais

rápido e as lesões maiores podem enviar metástases à distância. Também conhecido como

carcinoma epidermóide, é bem menos frequente que o basocelular. É comum acometer áreas de

mucosa aparente, como a boca ou o lábio, cicatrizes de queimaduras antigas ou áreas que