Pág 1/14

Implementação de Big Data com NewSQL

Rodolfo Sousa Viana, Hélio Rubens Soares

Instituto de Informática – Centro Universitário do Triângulo (UNITRI)

Caixa Postal 309 – 38.411-106 – Uberlândia – MG – Brasil

[email protected], [email protected]

Resumo. Este artigo tem como finalidade demostrar o funcionamento de

plataformas de Big Data com o novo modelo de banco de dados NewSQL. Para

exemplificar, foi implementada uma solução preditiva para uma academia de

atletas, com o intuito de prever, usando o método estatístico de análise

discriminante, qual a melhor modalidade de esporte para cada atleta da

academia. A implementação de Big Data com NewSQL permite entregar maior

desempenho e resultados com maior confiabilidade. Desta feita, sua

aplicabilidade é ampla e pouco utilizada, possibilitando outros estudos sobre o

tema.

1. Introdução

Com o aumento das aplicações, sendo grande parte na web, surgiu a necessidade de se ter

maior desempenho dos bancos de dados relacionais, pois houve aumento no fluxo de

dados e necessidade de maior velocidade no tempo de resposta. Para que esses bancos

possam atender a essa demanda, são necessárias algumas melhorias.

Para atender essas necessidades, foram desenvolvidos novos SGBD (Sistemas de

Gerenciamento de Banco de Dados) com maior escalabilidade, baixo custo operacional e

com suporte transações ACID (Atomicidade, Consistência, Isolamento e Durabilidade)

denominado de modelo de banco de dados NewSQL.

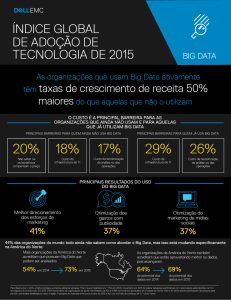

Com o grande volume de dados disponíveis, analisando e aplicando técnicas

necessárias, é possível gerar informações mais rápidas, assertivas e consistentes

facilitando as empresas a tomarem decisões rápidas, permitindo as empresas a

entenderem melhor o perfil de cada cliente, inovando e melhorando produtos e serviços,

melhorando seus processos operacionais e mantendo as empresas cada vez mais

competitiva no mercado. O Big Data surgiu com uma solução, e vem crescendo

rapidamente, abrindo novas oportunidades, necessitando de novos profissionais capazes

de explorarem grandes volumes de dados. [IBM, 2013]

O objetivo deste projeto e implementar uma solução de Big Data, juntamente com

um SGBD NewSQL, mostrando suas definições, conceitos e algumas ferramentas, sendo

duas em específico de ambas tecnologias, para mais detalhes e para o estudo de caso, que

são o RapidMiner e o NuoDB.

Na seção 2, serão apresentados os conceitos, características e exemplos das

ferramentas de Big Data e NewSQL. Na seção 3, serão apresentadas as ferramentas

RapidMiner Studio e NuoDB e o método estatístico de análise discriminante. Na seção 4

será realizado um estudo de caso de uma academia de atletas e implementado uma solução

utilizando Big Data com NewSQL. Já na seção 5, será mostrado a conclusão deste artigo,

destacando a viabilidade da integração das tecnologias de Big Data com modelos de

banco de dados NewSQL e levantada a possibilidade para trabalhos futuros.

Pág 2/14

2. Big Data e NewSQL

Nas subseções seguintes, são apresentados os conceitos de Big Data e NewSQL, suas

características, e algumas ferramentas que utilizam tais tecnologias.

2.1. Big Data

O termo Big Data refere-se a um grande conjunto de dados, voláteis ou não,

extremamente amplos que, através de aplicação de ferramentas capazes de suportar e

grandes volumes de dados, possam ser extraídas qualquer informação que, depois de

analisada, possa ser aproveitada em tempo hábil. A solução de Big Data oferece uma

abordagem mais ampla para tratar os dados, que são gerados em maior volume e

variedades, tornando as informações provenientes desses dados mais precisas e

consistentes [OREILLY, 2012].

Segundo a IBM, Big Data baseia-se em cinco V’s, isto é, possuem cinco

características que são [IBM, 2012]:

Volume: Refere-se ao aumento de dados que são constantemente gerados.

Variedade: Refere-se aos diferentes tipos de dados que são gerados e que se pode

usar. Podem ter sidos gerados a partir de banco de dados tradicionais, e-mail,

textos de mídias social, vídeos, sensores que coletam dados, áudio, dados de

transações financeiras. Com isso, estes dados devem ser incluídos em análises.

Velocidade: É a rapidez em que os dados vêm sendo gerados e a rapidez em que

esses devem ser tratados para que possa atender as demandas do mercado.

Veracidade: Garantir o máximo possível a consistência dos dados. É

extremamente importante garantir a veracidade dos dados, uma vez que a

variedade de dados é maior, esse fator impacta na qualidade dos dados, que na

maioria das vezes são baixas.

Valor: Refere-se a transformar em valor os grandes volumes de dados. As

empresas têm que ter a clareza dos custos e dos benefícios de uma iniciativa de

Big Data antes de implanta-las, fazendo business case para qualquer tentativa de

coletar e utilizar grandes volumes de dados. É o “V” mais importante do Big Data.

Na próxima subseção é mostrado o conceito e as características do modelo de

banco de dados NewSQL.

2.2. NewSQL

O NewSQL foi criado pela empresa de análise chamada The 451 Group e sua proposta

foi desenvolver uma nova classe de sistemas de gerenciamento de banco de dados que

pudessem oferecer o mesmo desempenho e escalabilidade dos bancos de dados NoSQL,

utilizando os mesmos padrões e as propriedades ACID para transações que possuem os

bancos de dados relacionais [ROUSE, 2014].

O NewSQL é um novo método, pois ele visa atender necessidades específicas

para cada sistema desenvolvido. O que não acontece nos bancos de dados relacionais que

atendiam qualquer tipo de aplicação. Segundo Stonebraker, M. (2011) um banco de dados

NewSQL possuem cinco características [STONEBRAKER, 2011]:

Suporte para transações ACID.

Linguagem SQL como principal mecanismo de interação entre a aplicação e o

SGBD.

Pág 3/14

Controle de concorrência não bloqueante em tempo real, para que as escritas e

leituras não causem conflitos entre si mesmas.

Arquitetura que ofereça desempenho superior por nó de processamento.

Possui arquitetura escalável, com memória distribuída e capaz de suportar grande

número de nó.

ACID (Atomicidade, Consistência, Isolamento e Durabilidade) é uma

característica de transação em bancos de dados. Cada uma dessas propriedades possui

suas características que são [MICROSOFT, 2015]:

Atomicidade: Uma transação deve ser uma unidade atômica de trabalho. Se uma

transação falhar, deve-se garantir que será feito o rollback. Se a transação for

concluída com sucesso, não podendo haver nenhum erro, deve-se fazer o commit;

Consistência: Uma transação, após ser concluída, deve manter todos os dados em

um estado de consistência. Todas as regras e restrições existentes no banco de

dados devem ser obedecidas;

Isolamento: Uma transação só estará disponível às outras após a sua conclusão.

Enquanto a transação não for confirmada, outras transações não terão visibilidade

sobre esta.

Durabilidade: Todas a transações que forem concluídas sem falhas, seus

resultados deverão ser mantidos no banco de dados sem correr o risco de perda.

Nas próximas subseções serão exemplificadas duas ferramentas que são utilizadas

para Big Data e para o modelo de banco de dados NewSQL, destacando as principais

características para cada uma.

2.3. Hadoop

O Hadoop é uma plataforma open source, escalável, desenvolvida para processamento e

análise de grandes volumes de dados, podendo ser dados estruturados ou não. O projeto

teve início em meados de 2003, quando o Google desenvolveu um modelo de

programação, o MapReduce, que distribui o processamento entre vários computadores

com o objetivo de ajudar seu mecanismo de busca a ficar mais rápido, não sendo

necessário servidores com grande poder de processamento e com custo alto. Algum tempo

depois, o próprio Google apresentou o Google File System (GFS), que é um sistema de

arquivos preparados para lidar com processamento distribuído e grande volume de dados.

Esse sistema trabalha com um conjunto de instruções que determino como os dados dever

sem armazenados, acessados e manipulados [IBM, 2011].

O GFS foi incorporado ao Nutch, um projeto de motor de busca para web, que

possuía problemas de escala. Essa combinação resultou numa solução nomeada Nutch

Distributed Filesystem (NDFS). No ano seguinte, o NDFS recebeu a implementação do

MapReduce. O Nutch foi implementado como parte de um projeto de maior escala

chamado Lucene, que visava implementar uma biblioteca para indexação de páginas.

Com a percepção de que a ferramenta Lucene poderia ser usado em outras aplicações de

busca na web, foi desenvolvido um novo projeto que tinha as características do Nutch e

do Lucene chamado Hadoop, onde sua implementação do sistema de arquivos recebeu o

nome de Hadoop Distributed File System (HDFS) [IBM, 2011].

Pág 4/14

Na próxima subseção foi destacado um SGBD que utiliza o modelo de banco de

dados NewSQL, e que vem sendo utilizado pelas empresas pelo seu desempenho e

facilidade de implantação.

2.4. MemSQL

O MemSQL é um sistema de gerenciamento de banco de dados, distribuído, in-memory.

Seu funcionamento consiste em gerar código C++ através do SQL (Structured Query

Language). O início do desenvolvimento do MemSQL foi no começo de 2011, por Eric

Frenkiel e Nikita Shamgunov, que são CEO e CTO da empresa MemSQL Inc [MEMSQL,

2015]

O MemSQL possui uma arquitetura distribuída, organizada e escalável,

oferecendo maior desempenho em dois níveis de nós denominados Agregador e

Agregador Mestre [MEMSQL, 2015].

O Agregador Mestre é um motor responsável pelo monitoramento do cluster e

failover. Ele administra as operações de cluster em toda base de dados e também as

operações DDL (Data Definition Language) [MEMSQL, 2015].

O Agregador é um nó cujo função é distribuir as consultas para os nós das folhas,

adicionando os resultados e combinando-os, para retorno ao cliente. O MemSQL possui

as seguintes características [MEMSQL, 2015]:

Suporte ANSI SQL;

Consultas compiladas;

Transações Multi-Declaradas;

JOINs totalmente distribuídos;

Tabelas em memória;

Tabelas em disco;

Durabilidade completa em disco;

Bloqueio de estruturas de dados gratuito;

Suporte Geospatial;

Gerenciamento de Cluster;

Suporte JSON;

Execução massivamente paralela.

Apresentados os conceitos, as características e alguns exemplos de ferramentas de

Big Data e NewSQL, na próxima seção será apresentada a integração destas tecnologias,

utilizando as ferramentas RapidMiner Studio e NuoDB, utilizando o método estatístico

análise discriminante.

3. Integração entre ferramentas Big Data e NewSQL

Nas próximas subseções, serão mostradas as ferramentas que serão utilizadas para a

implementação de uma solução de Big Data com banco de dados NewSQL e o método

estatístico que será utilizado na solução.

3.1. RapidMiner Studio

O RapidMiner Studio é um software que fornece ao usuário um ambiente integrado para

mineração de dados, mineração de texto, mineração na web, análise preditiva, análise de

negócios e aprendizagem de máquina. É comum ver a utilização dessa ferramenta em

Pág 5/14

aplicações comerciais e industriais, na educação, investigação policial, prototipagem

rápida e desenvolvimento de aplicações que suportam todas as etapas do processo de

mineração de dados, permitindo a visualização dos resultados, validação e otimização.

Foi desenvolvida em 2001 por Ralf Klinkenberg, Simon Fisher e Ingo Mierswa, na

unidade de inteligência artificial da Universidade Técnica de Dortmund, na Alemanha, e

era denominada YALE (Yet Another Ambiente Learning) [RAPIDMINER, 2015].

O software usa o modelo cliente/servidor oferecido como modelo SaaS (Software

as a Service) ou em infraestrutura de nuvem. De acordo com a instituição Bloor Research,

a ferramenta fornece 99% de uma solução analítica avançada, baseados em modelos que

entregam alta performance e reduz erros por quase não haver a necessidade de se escrever

código. A ferramenta também oferece mineração de dados e aprendizado de máquina,

incluindo alguns procedimentos como [RAPIDMINER, 2015]:

Extração, carregamento e transformação de dados;

Pré-processamento e visualização de dados;

Analise preditiva, Analise Quantitativa e Qualitativa;

Modelagem estatística.

O RapidMiner possui interface gráfica, permitindo o usuário projetar e executar

fluxos de trabalhos analíticos. Esses fluxos são denominados de “processos” e eles

consistem em alguns nós denominados de “operadores”. Cada operador executa uma

única tarefa em todo o processos e sua saída constitui a entrada do próximo operador. O

processo projetado pode ser usado por outras aplicações ou ser usado como uma API. A

ferramenta também disponibiliza esquemas, modelos e algoritmos de aprendizagem

Weka e scripts em linguagem R. A figura 1 apresenta um processo desenvolvido no

RapidMiner Studio [RAPIDMINER, 2015].

Pág 6/14

Figura 1 – Interface gráfica da ferramenta RapidMiner Studio (PCQUEST, 2015).

3.2. NuoDB

NuoDB é um SGBD distribuído em memória, desenvolvido pela empresa NimbusDB em

2008, que teve seu nome substituído por NuoDB, em 2011. Possui uma arquitetura

distribuída que, por sua vez, é dividida em três camadas [NUODB, 2015]:

Camada administrativa;

Camada transacional;

Camada de armazenamento;

A camada transacional é responsável pela atomicidade, consistência e isolamento.

Na camada transacional se encontra o TE (Transaction Engine), que é o motor das

transações [NUODB, 2015].

A camada de armazenamento possui outro motor denominado SM (Storage

Managers), que é o gerente de armazenamento. Esses SM têm acesso a um espaço no

disco, que é replicado em toda base de dados, com a finalidade de se comunicarem caso

haja mais instâncias [NUODB, 2015].

A camada administrativa é responsável pela distribuição dos dados, nessa camada,

existem os Brokers. Um Broker é uma classe acima dos agentes, são eles os responsáveis

por iniciar, encerrar a sessão, obter os logs e gerenciar toda a base de dados. [NUODB,

2015]. A figura 2 mostra a arquitetura do NuoDB.

Pág 7/14

Figura 2 – Arquitetura do SGBD NuoDB (NuoDB Glance, 2015).

3.2. Análise Discriminante

A análise discriminante é um método estatístico multivariado utilizado para discriminar

e classificar objetos. A primeira etapa da discriminação consiste em explorar as

características capazes de serem utilizadas para alocar objetos em grupos diferentes e

previamente definidos. Esta técnica foi desenvolvida na botânica e tinha como objetivo

fazer a distinção de grupos de plantas, tomando como base o tamanho e o tipo de folhas

e com isso classificar novas espécies encontradas futuramente [VARELLA, 2008].

A discriminação e classificação consiste em obter um combinação linear de

características destacadas que apresentam maior destaque de discriminação entre

populações. Essa combinação linear é denominada função discriminante e tem como

propriedade reduzir a probabilidade de erro na classificação. Isto ocorre quando as

populações são distribuídas com media µ e variância ∑ conhecidas. Mas essa situação

não ocorre pois a média e a variância das populações não são conhecidas, sendo assim,

havendo necessidade de estimação destes parâmetros. Pode-se atribuir que as populações

tem uma mesma matriz de covariâncias ou não. De acordo com a seleção, a função

discriminante é denominada lineares ou quadráticas [VARELLA, 2008].

As regiões de alocação são um conjunto de valores separados por uma função

discriminante qualquer. Essa função é obtida a partir de amostras de treinamento, tendo

como base modelos estatísticos ou não, assim como redes neurais e logica fuzzy. Portanto,

uma observação pode ser alocada para a população π1 ou para a população π2.

Após serem apresentados os conceitos das ferramentas RapidMiner, NuoDB e

Análise Discriminante, foi exposto um estudo de caso utilizando as ferramentas e o

método destacados nessa seção.

4. Estudo de Caso

Foi realizado um estudo com intuito de implementar uma solução de Big Data com SGBD

NewSQL para analisar os dados de academia esportiva que oferece o serviço de

desenvolvimento de jovens atletas do ensino médio escolar. Essa academia trabalha com

atletas do sexo masculino e seu foco está voltado para quatro modalidades de esporte:

Pág 8/14

Futebol, hóquei, basquete e beisebol. Com a experiência de mercado, pode-se observar

que, apesar de alguns atletas praticarem uma série de modalidade no ensino médio, a

grande maioria procuram seguir carreira profissionalmente em apenas uma modalidade.

Essa empresa possui uma ampla base de dados que adquiriu ao longo do tempo e ela

precisa realizar uma análise para ajudar os atletas a escolher a melhor modalidade de

esporte de acordo com o perfil de cada um.

Para implementar uma solução de Big Data, utilizando SGBD NewSQL, foi

utilizado as ferramentas RapidMiner e NuoDB, respectivamente, aplicando o modelo

estatístico de análise discriminante.

4.1. Ambiente de desenvolvimento

Foi usado para a implementação da solução de Big Data usando SGBD NewSQL, um

computador com as seguintes configurações:

Sistema Operacional Windows 7 Professional 64 Bits

4 GB de memória RAM

500 GB de disco rígido

Processador Intel® Core™ i3 CPU

4.2. Criação do banco de dados

Para a criação do banco de dados foi preciso entrar na interface de administrador no menu

de “Admin Center Home” e clicar na opção “SQL QuickStart” do SGBD NuoDB. Esta

opção permitiu criar um novo banco de dados após preenchimentos dos campos

obrigatórios, sinalizados com “*”. A figura 3 mostra a tela onde foi criado um novo banco

de dados denominado “db_avaliacoes_atletas”.

Figura 3 – Tela de criação de novos bancos de dados

Na próxima subseção foram mostradas as criações das tabelas e carga dos dados

através de um processo desenvolvido no RapidMiner.

Pág 9/14

4.2.1. Criação das tabelas e carregamento de dados

A criação das tabelas e carga de dados no banco de dados foi realizado pelo processo

desenvolvido no RapidMiner. Os dados dos atletas fornecido pela academia esportiva

estão em dois arquivos denominados “Scoring” [MATTHEW, 2012], onde estão os dados

a serem analisados, e “Training” [MATTHEW, 2012], que são os dados que já possuem

alguns resultados do atributo de previsão denominado “Esporte_Primario”. A Figura 4

ilustra o processo criado no RapidMiner para realizar esta tarefa. Foram criadas duas

tabelas, denominadas “TB_SCORING” e “TB_TRAINING”, no banco de dados após a

execução do processo.

Na próxima seção foi feito o processo no RapidMiner, aplicando o método

estatístico análise discriminante, para analisar e apontar, para cada atleta, qual é a melhor

modalidade de esporte que ele deve seguir carreira profissionalmente.

Figura 4 – Processo criado no RapidMiner para carga de dados no banco de dados

4.3. Criação do processo para aplicar a análise discriminante

A base de dados possui valores de testes realizados ao longo do tempo em atletas que

passaram pela academia de esportes. Pode-se observar que na base de dados existem 9

atributos [MATTHEW, 2012]:

Idade: É a idade do atleta com precisão decimal para a parte do ano desde o último

aniversário.

Força: É a força do atleta, em escala de 0 a 10, medida através de exercícios de

levantamento de peso.

Rapidez: É o desempenho do atleta, em escala de 0 a 6, através uma série de testes

cronometrados de capacidade de resposta.

Lesão: Este atributo indica se o atleta já sofreu lesão grave, que exigisse

intervenção cirúrgica ou outro procedimento médico complexo. Os valores são

marcados por 0 quando negativo e 1 quando positivo.

Visão: São valores, em escala de 0 a 3, que mostra a aptidão ocular do atleta

através de testes com objetos que se moviam rapidamente no campo de visão do

atleta.

Pág 10/14

Resistência: Este atributo indica a resistência do atleta, em escala de 0 a 6. Os

valores foram obtidos através de testes de aptidão física realizados.

Agilidade: Este atributo indica a agilidade do atleta em se mover com precisão e

agilidade em uma série de direções. Os atletas foram classificados em escala de 0

a 100 porém na base de dados foram encontrados valores em escala de 13 a 80.

Tomada de Decisão: São valores, em escala de 0 a 100, que mostra a aptidão do

atleta em tomar decisões rápidas e assertivas através de testes que expunha o atleta

a algumas situações exigidas nos jogos. Na base foram encontrados valores na

escala de 3 a 100, porém há atletas que possuem valores maiores que 100, sendo

assim, preciso tratar este dado.

Esporte Primário: É o esporte que cada atleta se especializou profissionalmente

após sair da academia.

Para que a análise discriminante possa ter resultado satisfatório, é preciso utilizar

dados existentes do passo disponibiliza-los para que o modelo possa treinar antes de ser

aplicado nos dados recentes. Esses dados histórico se encontram na “TB_ TRAINING”.

Para obter esses dados foi utilizado o operador “Read Database”. Foi aplicado o operador

“Filter Examples”, configurando o atributo “Tomada_de_Decisão” para considerar

valores iguais ou maiores que 3 e valores menores ou iguais a 100, pois foi observado que

na base havia valores maiores que 100, violando a regra de negócio da academia. Com

os dados devidamente tratado, foi preciso rotular a variável, pois ao aplicar a análise

discriminante, o modelo deve saber qual é a variável de previsão que ele irá trabalhar. A

variável de previsão utilizada foi a “Esporte_Primário”, configurada no operador

denominado “Set Role” e em seguida foi usado o operador com o algoritmo de análise

discriminante denominado “LDA”.

Com o modelo estatístico previamente treinado e apto a ser aplicado nos dados,

da tabela “TB_ SCORING”, foi utilizado o operador “Read Database” para se obter esses

dados e aplicado os mesmos operadores utilizados no fluxo anterior. Após tratamento, foi

aplicado o modelo nos dados da base atual utilizando o operador denominado “Apply

Model”. A figura 5 ilustra o processo desenvolvido.

Figura 5 – Processo criado para aplicar analise discriminante na base de dados.

Pág 11/14

Para a apresentação do resultado da análise discriminante aplicada nos dados foi

disponibilizado, no próprio ambiente de desenvolvimento, um arquivo de relatório com

extensão xlsx.

A Figura 6 mostra os resultados obtidos com o processo desenvolvido no

RapidMiner aplicando análise discriminante.

Figura 6 – Resultado da análise discriminante

A figura 7 representa o histograma gerado, mostrando o resultado obtido da

análise aplicada, para cada modalidade de esporte.

Figura 7 – Histograma Análise Preditiva

Pág 12/14

Na próxima subseção, serão apresentados os resultados da implementação da

solução de Big Data com NewSQL.

4.4. Análise de resultados

A implementação de Big Data com NewSQL resolveu, de forma satisfatória, o estudo de

caso proposto neste artigo. Nesta solução, pode-se observar que é possível e viável

integrar Big Data e NewSQL. Embora ambas tecnologias são recentes no mercado, o

cenário no mundo dos negócios é favorável para que Big Data e NewSQL seja mais

comum no dia a dia empresarial.

Para este estudo de caso, as ferramentas RapidMiner Studio e NuoDB se

mostraram aptas a serem utilizadas em problemas mais complexos, pois as mesmas não

apresentaram falhas no desenvolvimento da solução, sendo possível a se chegar a um

resultado mais assertivo.

O RapidMiner Studio é uma ferramenta completa, que entrega ao usuário interface

amigável, documentação completa e de fácil entendimento, suporte, facilidade de

integração com outros SGBDs, simultaneidade e dinamismo. Mesmo sendo uma

ferramenta nova no mercado, há diversas outras aplicabilidades em negócios distintos

desta ferramenta, permitindo a ferramenta adquirir maior eficiência. Neste estudo de caso

a ferramenta se comportou de forma satisfatória, sendo possível observar que as

características da ferramenta ajudou no processo de desenvolvimento da solução,

tornando a implementação menos complexa.

A integração com o NuoDB foi amigável, sendo possível encontrar na

documentação de ambas as ferramentas todo o procedimento a ser feito para que esse

processo fosse concluído.

O NuoDB se mostrou eficiente pois ele cumpre com o seu objetivo de entregar ao

usuário escalabilidade, sem deixar de se preocupar com as transações ACID. É um SGBD

que possui interface amigável, documentação completa e de fácil entendimento, boa

capacidade de armazenamento, possibilidade de alocação nas nuvens computacionais,

suporte e dinamismo. O uso do NuoDB é viável pois é uma ferramenta open source,

permite instalação em diversas plataformas computacionais e é confiável, pois, mesmo

sendo nova no mercado, há diversos casos de uso da ferramenta, permitindo observar que

a ferramenta possui boa adaptação e aceitação em negócios distintos.

O uso da análise discriminante no estudo de caso foi um fator importante. É um

método estatístico eficaz e já usado por outras soluções, o que torna o seu uso confiável.

Na ferramenta RapidMiner, o algoritmo já vem implementado, sendo possível mais

agilidade e reduz drasticamente a possibilidade de haver erros na implementação do

algoritmo.

Com base no estudo de caso, utilizar Big Data com modelos de banco de dados

NewSQL é viável pois, para ambas tecnologias, há diversas ferramentas que não possui

custo para adquiri-las, podendo ser usadas por empresas pequenas, médias e grandes, sem

haver preocupação com o volume de dados, acesso rápido e simultâneo, segurança e

maior confiabilidade nos resultados gerados por esta utilização destas tecnologias.

Pág 13/14

5. Conclusão

Após a realização dos estudos sobre Big Data e modelos de bancos de dados NewSQL,

chega-se à conclusão de que a integração dessas duas tecnologias é viável e que na

maioria das vezes ajudam as empresas na melhoria de processos, produtos e resultados

financeiros, permitindo a elas aumentar os lucros e sua competitividade no mercado.

Com os estudos finalizados, nota-se que este tipo de implementação possui um

grande potencial de crescimento, pois une duas tecnologias úteis para a melhoria e

crescimento das empresas. O Big Data possui a facilidade de processamento ágil de

grandes volumes de dados, permitindo o acesso rápido a informações mais confiáveis,

permitindo a tomada de decisão mais assertiva. Os modelos de banco de dados NewSQL

possui escalabilidade e transações ACID, porém está tecnologia não vem substituir os

modelos de banco de dados relacionais, pois foi criado para atender necessidades

especificas para cada sistema desenvolvido. Concluiu-se que as ferramentas de Big Data

e NewSQL, RapidMiner e NuoDB, respectivamente, se mostraram bem eficientes e

cumpriram com o propósito que são assertividade e transações mais rápidas. Já a análise

discriminante não apresentou dificuldades no entendimento deste método e permitiu ao

RapidMiner entregar uma análise assertiva.

Com base nesta pesquisa e estudo de caso, pode-se realizar trabalhos futuros de

implementação de outras soluções de Big Data utilizando outros SGBDs no modelo

NewSQL ou implementar uma solução de Business Intelligence com Big Data e SGBD

NewSQL para mercado de agronegócios.

6. Referências

MEMSQL DOCS. (2015). MemSQL Docs

<http://docs.memsql.com>. Acesso em: 10 set. 2015

Home.

Disponível

em:

NUODB.

(2013),

Technical

Whitepaper.

Disponível

em:

<http://go.nuodb.com/rs/nuodb/images/NuoDB%2520White%2520Paper_7_7_12.pd

f>. Acesso em: 07 set. 2015

NUODB GLANCE. (2015), NuoDB at a Glance. Disponível em

<http://doc.nuodb.com/display/doc/NuoDB+at+a+Glance>. Acesso em: 05 out. 2015.

STONEBRAKER, M. 2010, SQL Databases v. NoSQL Databases, Communications

of the ACM

STONEBRAKER, M. (2011). ACM. Disponível em: <http://cacm.acm.org/blogs/blogcacm/109710-new-sql-an-alternative-to-nosql-and-old-sql-for-new-oltpapps/fulltext>. Acesso em: 01 set. 2015.

MATTHEW, N. Data Mining For the Masses. Orlando: Amazon, 2012. 264 p.

VARELLA, C. (2008) Análise Multivariada Aplicada as Ciencias Agrárias.

Disponível

em:

<http://www.ufrrj.br/institutos/it/deng/varella/Downloads/multivariada%20aplicada

%20as%20ciencias%20agrarias/Aulas/ANALISE%20DISCRIMINANTE.pdf>.

Acesso em: 16 out. 2015.

RAPIDMINER DOCS. (2006), RapidMiner Documentation. Disponível em:

<http://docs.rapidminer.com/studio/>. Acesso em: 07 out. 2015.

Pág 14/14

OREILLY.

(2012),

What

is

Big

data.

Disponível

<https://beta.oreilly.com/ideas/what-is-big-data>. Acesso em: 18 set. 2015.

em:

PCQUEST. (2015), 10 Free Business Process Management & Analysis Tools.

Disponível

em:

<http://www.pcquest.com/10-free-business-process-managementanalysis-tools/>. Acesso em: 22 out. 2015.

IBM.

(2011),

Conhecendo

o

Hadoop.

Disponível

em:

<https://www.ibm.com/developerworks/community/blogs/ctaurion/entry/conhecendo

_hadoop?lang=en>. Acesso em: 24 set. 2015.

IBM. (2012), Você realmente sabe o que é Big Data? Disponível em:

<https://www.ibm.com/developerworks/community/blogs/ctaurion/entry/voce_realm

ente_sabe_o_que_e_big_data?lang=en>. Acesso em: 18 set. 2015.

MICROSOFT.

(2015),

ACID

Properties.

Disponível

em:

<https://msdn.microsoft.com/en-us/library/aa719484(v=vs.71).aspx>. Acesso em: 03

out. 2015.

TECHTARGET.

(2014),

NewSQL

definition.

Disponível

em:

<http://searchdatamanagement.techtarget.com/definition/NewSQL>. Acesso em: 01 set.

2015.

IBM. (2013), Big Data: expectativa, benefícios e barreiras. Disponível em:

<https://www.ibm.com/developerworks/community/blogs/ctaurion/entry/big_data_e

xpectativas_beneficios_e_barreiras?lang=en>. Acesso em: 28 set. 2015.